Text

ОПТИМИЗАЦИЯ

И ИССЛЕДОВАНИЕ

ОПЕРАЦИЙ

Редактор серии

Н. Н. МОИСЕЕВ

МОСКВА «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

1982

Ю. Г. ЕВТУШЕНКО

МЕТОДЫ РЕШЕНИЯ

ЭКСТРЕМАЛЬНЫХ ЗАДАЧ

И ИХ ПРИМЕНЕНИЕ

В СИСТЕМАХ

ОПТИМИЗАЦИИ

МОСКВА «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

1982

22.18

Е 13

УДК 519.6

Евтушенко Ю. Г. Методы решения экстремальных задач

и их применение в системах оптимизации. — М.: Наука, Главная

редакция физико-математической литературы, 1982 (Оптимизация и

исследование операций).—432 с.

Книга посвящена созданию диалоговых человеко-машинных систем

оптимизации. Основное внимание уделяется систематическому описа-

описанию алгоритмов решения задач нелинейного программирования и оп-

оптимального управления. На модельных примерах проводится сравни-

сравнительный анализ алгоритмов. Показано, что наиболее высокую эффек-

эффективность использования методов оптимизации можно получить путем

последовательного применения разных алгоритмов. Обсуждаются воп-

вопросы организации человеко-машинного процесса расчетов, даны при-

примеры реализации диалоговых систем оптимизации.

Книга предназначается для специалистов в области математичес-

математического программирования, теории оптимального управления, инжене-

инженеров, студентов старших курсов, аспирантов, применяющих и разви-

развивающих методы оптимизации.

Илл. 19, библ. 237 назв.

Юрий Гаврилович Евтушенко

МЕТОДЫ РЕШЕНИЯ ЭКСТРЕМАЛЬНЫХ ЗАДАЧ

И ИХ ПРИМЕНЕНИЕ В СИСТЕМАХ ОПТИМИЗАЦИИ

(Серия: «Оптимизация и исследование операций»)

Редактор И. Е. Морозова

Техн. редактор Л. В. Лихачева. Корректоры Е. В. Сидоркина, В. Я. Сорокина

ИБ № 12119

Сдано в набор 11.01.82. Подписано к печати 20 05.82. Т-11679. Формат

84X108V32* Бумага тип. № 1. Литературная гарнитура. Высокая печать.

Условн. печ. л. 22,68. Уч.-изд. л. 23,32. Тираж 9000 экз. Заказ № 3671.

Цена 2 р. 10 к.

Издательство «Наука»

Главная редакция физико-математической литературы

117071, Москва, В-71, Ленинский проспект, 15

Ордена Октябрьской Революции и ордена Трудового Красного Знамени

Первая Образцовая типография имени А. А. Жданова Союзполиграфпрома

при Государственном комитете СССР по делам издательств, полиграфии и

книжной торговли. Москва, М-54, Валовая, 28

Отпечатано во 2-ой типографии изд-ва «Наука».

Москва, Шубинский пер., 10 Зак.1705.

17П0П7ПППП ПЯ1 ® Издательство «Наука».

17UzU/UUUU — Uo 1 -- м Главная редакция

9 физико-математической

2 литературы, 1982

ОГЛАВЛЕНИЕ

Предисловие 7

Основные обозначения 10

Глава I. Введение в теорию оптимизации 13

§ 1. Выпуклые множества и выпуклые функции 13

§ 2. Дифференцируемость выпуклых функций 21

#§ 3. Необходимые и достаточные условия локального экстре-

экстремума функций многих переменных 29

§ 4. Необходимые и достаточные условия минимума функ-

функций на множествах 34

§ 5. Свойства минимаксных задач 38

§ 6. Условия минимума в задачах нелинейного програм-

программирования, не использующие дифференцируемость . . 52

§ 7. Условия минимума в задачах нелинейного программи-

программирования, использующие дифференцируемость .... 64

§ 8. Необходимые условия минимума в задачах оптималь-

оптимального управления 78

Глава П. Теоремы о сходимости и их приложения к иссле-

исследованию численных методов 88

§ 1. Устойчивость по первому приближению 88

§ 2. Метод функций Ляпунова 94

§ 3. Теоремы о сходимости итеративных процессов .... 104

§ 4. Сходимость процессов, порожденных многозначными

отображениями 116

§ 5. Методы решения систем нелинейных уравнений ... 122

§ 6. Численные методы отыскания минимакса 141

Глава III. Метод штрафных функций 159

§ 1. Метод внешних штрафных функций 159

§ 2. Оценки точности метода штрафных функций 173

§ 3. Метод параметризации целевой функции 185

§ 4. Метод внутренних штрафных функций 193

§ 5. Метод линеаризации 199

Глава IV. Численные методы решения задач нелинейного

программирования, основанные на использовании

модифицированных функций Лагранжа .... 206

§ 1. Простейшая модификация функции Лагранжа .... 207

§ 2. Модифицированные функции Лагранжа 218

§ 3. Обоснование сходимости метода простой итерации . . 224

6 ОГЛАВЛЕНИЕ

§ 4. Решение задач выпуклого программирования .... 236

§ 5. Редукция к максиминной задаче 242

§ 6. Редукция к минимаксной задаче 250

Глава V. Релаксационные методы решения задач нелиней-

нелинейного программирования 258

§ 1. Применение метода приведенного градиента для реше-

решения задач с ограничениями типа равенства 258

§ 2. Обобщение метода приведенного градиента 262

§ 3. Дискретный вариант метода приведенного градиента 273

§ 4. Метод условного градиента 277

§ 5. Метод проекции градиента 281

Глава VI. Численные методы решения задач оптимального

управления 284

§ 1. Основные расчетные формулы 287

§ 2. Необходимые и достаточные условия минимума . . . 300

§ 3. Численные методы, основанные на редукции к задачам

нелинейного программирования 304

§ 4. Дискретные принципы минимума 312

§ 5. Численные методы, основанные на использовании дис-

дискретных принципов минимума 329

§ 6. Некоторые обобщения 333

§ 7. Примеры численных расчетов - 341

§ 8. Приложение к дифференциальным играм 363

Глава VII. Диалоговые системы оптимизации 372

§ 1. Общие принципы построения диалоговых систем . . . 372

§ 2. Библиотека программ решения задач безусловной

минимизации 384

§ 3. Примеры численных расчетов задачи безусловной

минимизации 387

§ 4. Библиотека программ для решения задач нелинейного

программирования 391

§ 5. Примеры численных расчетов задачи нелинейного про-

программирования -. 395

Приложение I. Дифференцируемость 404

Приложение II. Некоторые свойства матриц 407

Приложение III. Некоторые свойства отображений ... 412

Комментарии и библиография 414

Литература 419

ПРЕДИСЛОВИЕ

Методы оптимизации находят все более широкое при-

применение в науке и технике. К ним обращаются инженеры-

конструкторы, разработчики систем автоматизированного

проектирования, создатели автоматизированных систем

управления, экономисты, физики-экспериментаторы, зани-

занимающиеся обработкой наблюдений, специалисты в области

исследования операций и многие другие. Обширные при-

приложения способствуют бурному развитию вычислительных

методов оптимизации, созданию новых разнообразных нап-

направлений исследований. Практическая реализация многих

численных методов требует огромного объема вычислений,

поэтому широкое применение эти методы нашли в послед-

последние годы в связи с появлением мощных быстродействую-

быстродействующих электронно-вычислительных машин. Опыт показы-

показывает, что наиболее эффективно решение оптимизационных

задач можно проводить с помощью диалоговых человеко-

машинных систем, дающих возможность в процессе рас-

расчетов каждой конкретной задачи использовать разнообраз-

разнообразные оптимизационные методы.

Данная книга посвящена описанию вычислительных

методов решения задач нелинейного программирования,

задач оптимального управления при наличии смешанных

ограничений и применению этих методов в диалоговых

человеко-машинных системах оптимизации.

Книга состоит из семи глав. В первой главе приве-

приведены основные сведения из выпуклого анализа, изложены

необходимые и достаточные условия экстремума в задачах

нелинейного программирования, оптимального управле-

управления. Во второй главе описаны численные методы решения

систем нелинейных уравнений и отыскания минимакса;

эти методы, имеющие самостоятельный интерес, исполь-

используются в дальнейшем. Третья, четвертая и пятая главы

посвящены численным методам решения задач нелинейного

8 ПРЕДИСЛОВИЕ

программирования. В третьей главе приведены различные

модификации метода штрафных функций. В четвертой

главе излагаются методы, основанные на использовании

различных модификаций функции Лагранжа. В пятой гла-

главе описаны релаксационные методы. Глава шестая посвя-

посвящена численным методам решения задач оптимального

управления. Изложенные методы базируются на примене-

применении методов нелинейного программирования. Такой подход

позволил достичь значительных результатов: он дал воз-

возможность сравнительно просто и эффективно решать задачи

с фазовыми ограничениями, с простейшими недифференци-

руемыми функционалами, проводить оптимизацию не только

по управлению, но и по управляющим параметрам. Для

решения задач оптимального управления появилась возмож-

возможность использовать методы, основанные на применении

модифицированных функций Лагранжа, метод условного

градиента, проекций градиентов, метод Ньютона и многие

другие. Седьмая глава посвящена вопросам создания и

эксплуатации диалоговых человеко-машинных вычислитель-

вычислительных систем оптимизации. Такие системы оснащены обшир-

обширными библиотеками программ оптимизации, предусмотрен-

предусмотренный в них диалоговый сервис дает возможность пользова-

пользователю управлять процессом решения задач на ЭВМ, в зависи-

зависимости от текущих результатов расчетов выбирать наиболее

рациональную последовательность применяемых методов,

корректируя в случае необходимости параметры методов,

вносить изменения в постановку решаемых задач. Диалого-

Диалоговые системы позволяют создать универсальный инстру-

инструмент решения разнообразных практических задач. Дана

краткая информация о некоторых существующих систе-

системах оптимизации, более подробно описана диалоговая

система оптимизации ДИСО, приведены результаты ее ис-

использования для решения двух тестовых задач.

В приложениях приведены некоторые необходимые для

изложения сведения из математического анализа, линей-

линейной алгебры и теории точечно-множественных отображе-

отображений.

По темам, затронутым в книге, существует обширная

библиография (полное количество работ значительно пре-

превосходит тысячу наименований). Приведенный в конце

книги список литературы не претендует на полноту. В него

включены в основном лишь те статьи и монографии, кото-

ПРЕДИСЛОВИЕ 9

рые непосредственно использовались при написании этой

книги. Основное внимание в книге было уделено тем мето-

методам, которые были апробированы и на протяжении послед-

последних лет развивались в Вычислительном центре АН СССР.

Автор выражает глубокую признательность Н. Н. Мои-

Моисееву, который поддержал идею написания этой книги,

проявил внимание к работе. Профессор О. Геллман пре-

предоставил автору возможность работать в библиотеке уни-

университета г. Турку, что позволило широко использовать

в книге результаты зарубежных исследований. Сотруд-

Сотрудники ВЦ АН СССР О. П. Бурдаков, А. И. Голиков,

Н. И. Грачев, В. Г. Жадан, В. А. Пуртов прочитали отдель-

отдельные части рукописи, сделали целый ряд полезных заме-

замечаний, которые были с благодарностью приняты.

В написании § 5 гл. II принимал участие О. П. Бур-

Бурдаков, вместе с Н. И. Грачевым был написан § 7 гл. VI.

/О. Г. Евтушенко

ОСНОВНЫЕ ОБОЗНАЧЕНИЯ

Теоремы, леммы и определения нумеруются тремя числами: пер-

первое из них — номер главы, второе—номер параграфа, а третье —

порядковый номер самой теоремы, леммы, определения в параграфе.

Формулы нумеруются двумя числами: первое из них — номер параг-

параграфа, второе—номер формулы в параграфе. Если ссылка производится

на формулу из другой главы, то к ней слева добавляется еще один

индекс, указывающий номер главы.

х ? X—х является элементом множества X;

хфХ—х не является элементом множества X;

XczY—множество X составляет часть или совпадает с множе-

множеством Y;

X = Y—множества X и Y совпадают;

X[)Y—объединение множеств X и К;

X[\Y—пересечение (общая часть) множеств X и К;

X\Y—разность множеств X и К, т. е. совокупность всех х ¦? X

таких, что х ф. Y;

XxY—декартово произведение множеств X и К, т. е. совокуп-

совокупность пар х, у, где x?Xt y?Y;

intX—совокупность внутренних точек множества X (см. опре-

определение 1.1.2);

X—замыкание множества X (см. определение 1.1.3);

Х = 0—множество А' пусто;

{х:Т} — множество всех точек х, удовлетворяющих условию Т;

^) — число X удовлетворяет условию а < X < Ь;

[а, Ь]—число X удовлетворяет условию а^Х^Ь;

/: X -> Y—однозначное отображение из X в Y;

W: X -+2Y—многозначное отображение из X в Y (см. Прило-

Приложение III);

Vx —читается «для всех *»;

За: —читается «существует х».

dis (л:, у) —расстояние между двумя точками х и у;

dis (л:, Х)~ infdis(*, у) — расстояние между точкой х и множе-

Х

ством X;

G(q) — открытая окрестность точки q;

ОСНОВНЫЕ ОБОЗНАЧЕНИЯ Ц

G (X)—открытая окрестность множества X;

Ge (X) — е-окрестность множества Х\ G8 (X) = {х: dis (х, X) < е};

Rn—вещественное линейное нормированное л-мерное простран-

пространство;

Еп— евклидово л-мерное пространство;

ЕЧ — положительный ортант из Еп, т. е. совокупность всех век-

векторов из Еп, все координаты которых неотрицательны;

х?Еп—вектор х является элементом пространства Еп\

х1 — i-я координата вектора х\ в некоторых местах для большей

ясности пишется также *(/);

е1—единичный i-ik орт, вектор-столбец, i-я координата которого

равна единице, остальные координаты—лули;

рт—транспонированный вектор;

Вт — транспонированная матрица;

||*||—норма вектора xf в большинстве мест имеется в виду евкли-

евклидова норма (более подробно см.- Приложение II);

|| Л ||—норма матрицы Л, согласованная с нормой векторов;

| Л | —определитель матрицы Л;

р^О—все координаты вектора р неотрицательные;

В > О—симметричная матрица В порядка п положительно опре-

определена, т. е. для любых х?Еп и таких, что ||д:|)^0, величина

хтВх > 0;

В^О—симметричная матрица В порядка п положительно полу-

полуопределена, т. е. для любых х?Еп величина хтВх^0;

?>(z)—диагональная матрица, у которой 1-й диагональный эле-

элемент есть i-я координата вектора г, размер матрицы D определя-

определяется размерностью вектора z;

Is — единичная матрица порядка s;

/+—совокупность неотрицательных действительных чисел;

О»,» — нулевая матрица пХш (во многих местах, где это не при-

приводит к недоразумениям, индексы ппг опускаются);

(а, Ь) Ф 0 — по крайней мере у одного из векторов a?Rc или

Rm норма не равна нулю;

z = fa, b]—вектор 2$Rc+m является объединением векторов а

и Ь;

<а, &> — скалярное произведение векторов а и Ь\

h+ (x)y h_ (x)~вектор-функции, у которых 1-е компоненты опре-

определяются по формулам:

hl+ (*) = тах [0, Ы (*)], hL (*) = min [0, hl (x)],

если A, v?Ec, to (h + v)% =У] [max [0,

12 ОСНОВНЫЕ ОБОЗНАЧЕНИЯ

* / ч - • df(x)

/х \х)—-«-мерный вектор, i-я компонента которого равна •¦' у- ;

/ххМ— квадратная матрица порядка п> (i, /)-й элемент которой

д2/ (х)

равен ¦ ;

gx(x) — прямоугольная матрица, (i, /)-й элемент которой равен

vS'(^)—производная функции S по скалярному аргументу^;

Re г—действительная часть комплексного числа z;

Imz — мнимая часть комплексного числа г;

z—число, сопряженное числу z;

\z\ — модуль числа г;

Нтл:^ — верхний предел последовательности {х^}\

Аг-»-оо

Птд:^—нижний предел последовательности {дс^};

i—дифференцирование по независимой переменной t\

df (x) — множество субградиентов функции / в точке х (см. опре-

определения 1.2.1 и 1.2.2);

Qi(x)—оценки скорости сходимости (их определение дано в § 3

гл. II);

о (х) — множество активных ограничений типа неравенства в точ-

точке х (см. формулу A.7.3));

L(x> w, v)—функция Лагранжа в задаче нелинейного програм-

программирования A.6.1) (см. формулу A.6.4));

Argmin/(*)—совокупность всех тех точек х?Х, в которых до-

хех

стигается минимум функции / на X;

sup—точная верхняя грань;

inf—точная нижняя грань;

¦—доказательство окончено.

ГЛАВА1

ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ

В этой главе даны определения и основные теорети-

теоретические результаты, используемые при разработке и обо-

обосновании численных методов решения экстремальных за-

задач. Приводятся также необходимые и достаточные условия

экстремума в разнообразных оптимизационных задачах.

Собранный материал носит вспомогательный характер

и важен для понимания последующих глав.

§ 1. Выпуклые множества и выпуклые функции

1. Основные определения. Пусть х, у?Еп. Отрезком,

соединяющим точки х и у, называется совокупность всех

точек, представимых в видеЯд: + A—Х)у, где O^X^Cl.

Определение 1.1.1. Множество ХаЕп называется

выпуклым, если отрезок, соединяющий любые две точки

из X, принадлежит X.

Определение 1.1.2. Точка х?X называется внут-

внутренней точкой множества X, если для любого конечного

у?Еп найдется такое число % > О, что х-\-Ху€Х для

всехО<Я<Я. Совокупность всех внутренних точек мно-

множества X обозначается intX.

Из выпуклости множества X вытекает выпуклость

intX.

Множество называется открытым, если каждая его

точка внутренняя. Множество X называется замкнутым

в Еп, если его дополнение в Еп, т. е. множество Еп\Х>

является открытым.

Определение 1.1.3. Точка х называется предельной

точкой множества X, если существует последовательность

точек xk ? X, сходящаяся к х. Совокупность всех предель-

предельных точек множества X называется его замыканием и

обозначается X.

14 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Определение 1.1.4. Множество X называется ком-

компактным, если любая последовательность его точек со-

содержит подпоследовательность, сходящуюся к некоторой

точке из X.

В пространстве Еп термин «компактное множество»

является синонимом «ограниченного замкнутого множе-

множества».

Определение 1.1.5. Функция f(x), определенная

на множестве Ху называется выпуклой на X, если для

любых двух точек х, у?Х и любых значений Х^Е1 та-

таких, что O^X^l и^д: + A —Х)у?Х> выполнено условие

f(bx + (l-X)y)^Xf(x) + (l-X)f(y). A.1)

Если дополнительно потребовать, чтобы при Я=^0,

\ и хфу в этом неравенстве знак ^ можно заменить

на <, то функция f(x) будет называться строго выпук-

выпуклой на X.

Если в формуле A.1) знак ^ можно заменить на ^,

то функция f(x) будет называться вогнутой на X. Если

функция f(x) выпуклая, то функция—/ (х) вогнутая.

Благодаря этому все свойства выпуклых функций легко

переносятся на вогнутые функции.

Функция f{x)y определенная на выпуклом множестве X,

будет выпуклой, если для любых х, у?Х п любых зна-

значений К ? Е1 таких, что 0 ^ X <; 1, выполнено условие A.1).

Если f(x)—выпуклая функция х на всем простран-

пространстве Еп, то будем говорить, что функция f(x) выпуклая.

Простейшим примером выпуклой на Еп функции является

евклидова норма вектора Цх|| = !/*<#» *>• Действительно,

воспользовавшись неравенством треугольника

свойством нормы||Я*||-= | К11|а:||, |A — X) у\\ = \ 1 — Я,| |у\\, для

О <! X ^ 1 получим

\\Xx+(l-X)y\\^Xlx\\+(l-X)\\yl

откуда следует выпуклость функции \\x\\.

В качестве примера открытого выпуклого множества

можно указать множество точек, лежащих внутри п-мер-

ной сферы радиуса 8 с центром в точке х:

»: \\х-х\\<г].

|!] ВЫПУКЛЫЕ ФУНКЦИИ И МНОЖЕСТВА 15

Если Ху y?Ge(x)9 то, согласно неравенству треугольника,

откуда следует выпуклость множества Ge(x).

В дальнейшем множество Ge(x) будем называть 8-о/с-

рестностью точки х.

Определение 1.1.6. Определенная на Еп функция

f(x) называется бесконечно большой, если для любого

положительного числа М существует такое число R(M),

что при всех Ху удовлетворяющих условию Jx|> R, имеет

место неравенство f(x) > М.

Расстояние между точкой х и множеством X будем

обозначать dis(x, X):

dis«(A:, Х)

Если множество X выпукло и замкнуто, то в этом вы-

выражении достигается минимум в единственной точке

р(х)&Ху которая называется проекцией точки х на мно-

множество X и определяется из условия

р (х) = Arg min || х—р ||. A.2)

рех

Покажем, что dis(x, X) является выпуклой функцией х.

Пусть хх и хг — произвольные точки из Еп и 0 ^ X ^ 1.

Тогда для любого z 6 X имеет место неравенство

—X)x2—zl A.3)

Используя определение A.2), обозначим рг = р (хг)у р2 =

= р(х2)у причем р1У р2?Х. В силу выпуклости множе-

множества X ему принадлежат все точки отрезка, соединяю-

соединяющего рг и р2у поэтому, положив в неравенстве A.3) г —

Х|AК)р2у получим

2y X).

Отсюда следует выпуклость иа Еп функции dis(x, X)-

Очевидно также, что для компактного множества X эта

функция является бесконечно^ большой.

16 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ ^ГЛ- 1

Определение 1.1.7. Эпиграфом (надграфиком)

выпуклой функции f(x), обозначаемым epi/, называется

множество конечных точек из ?w+1, расположенных на

графике и выше графика /:

Определение 1.1.8. Эффективной областью вы-

выпуклой функции /, обозначаемой dom/, называется мно-

множество точек из Еп, в которых / принимает конечные

значения или значение —оо:

Множество dom/ есть проекция epi/ на ?я, 'т. е.

dom f = {x?En: ЗрёЕ1 такое, что [л:, HjGepi/}.

Определение 1.1.9. Выпуклая функция /назы-

/называется собственной, если множество dom/ не пусто и

/(*)> — оо V*?dom/.

Другими словами, собственная функция не принимает

значения —оо и не равна тождественно +оо. В даль-

дальнейшем, занимаясь выпуклыми функциями, будем считать

их собственными, не оговаривая специально это свойство.

Выпуклая функция непрерывна во всех внутренних

точках множества, на котором она определена.

Определение 1.1.10. Непустое множество КсЕп

называется выпуклым конусом, если выполнены условия:

1) х+У€К при любых х, у?К\

2) кх?К при любом х?К и всяком Я^О.

Оба эти условия эквивалентны требованию, чтобы

ах+$у?К для любых х, у?К и всяких а^О, р^О.

Неотрицательный ортант El является выпуклым ко-

конусом. Если А—матрица тхп и х?Епу либо х?Е1У то

множество всех решений системы Л#<0 представляет

собой многогранный конус.

Гиперплоскостью в Еп называется множество

где с?Еп, ||с 1=7^0, а—-действительное число. Это множе-

множество выпукло и всегда не пусто. Если точка хт ? Г, то

гиперплоскость Г можно представить в виде

х—*«> =

§1] ВЫПУКЛЫЕ ФУНКЦИИ И МНОЖЕСТВА 17

т. е. Г состоит из тех и только тех точек ху для кото-

которых вектор х—х* ортогонален вектору с. Вектор с назы-

называют нормальным вектором гиперплоскости Г.

Будем говорить, что гиперплоскость Г с нормальным

вектором с отделяет два непустых множества ХиУ, если

существует такое число у, что для любых х?Х, y?Y

выполнены неравенства

Определение 1.1.11. Гиперплоскость Г называется

опорной к множеству X, если <с, ху^а при всех х?Х

и <С) у> = а для некоторой точки у?Х. Если у?Х, то

вектор с называется опорным вектором множества X

в точке у у одновременно с есть нормальный вектор опор-

опорной к X гиперплоскости, проходящей через точку у.

Теорема 1.1.1 (об отделимости). Пусть ХаЕп —

непустое, выпуклое множество, не содержащее начала

координат. Тогда существует гиперплоскость, отделяю-

отделяющая мнооюество X и начало координат.

Доказательство теоремы можно найти во многих кни-

книгах по выпуклому анализу (см., например, X. Никайдо

[1], О. Мангасарян [1], Р. Рокафеллар [1]).

2. Свойства выпуклых функций, не использующие

дифференцируемость.

Теорема 1.1.2. Пусть строго выпуклая функция f (x)

достигает наименьшего на Еп значения в некоторой

точке х*. Тогда f(x)—бесконечно большая функция.

Доказательство. Пусть S — поверхность сферы

единичного радиуса с центром в точке х*у хг — произволь-

произвольная точка, лежащая снаружи S. Соединим х* и хг прямой

линией, точку пересечения этой линии с 5 обозначим х.

Можно записать

К)х1у 0 < Л, < 1.

Величину коэффициента Я, зависящую от выбора точки х1у

определим из условия |)? — лг*Ц=1, получим

lg ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ

Из условия выпуклости / (х) по х следует, что / (л:)

Х/() + A^)/() Отсюда находим

~f {х*]'

Если [*i|—*oof то 1—M#i)—*0, и из этих неравенств

заключаем, что / (х±) —*оо, т. е. / (#) — бесконечно большая

функция. Щ

Теорема 1.1.3. Функция /, определенная на выпук-

выпуклом множестве Ху выпукла на X тогда и только тогда,

когда ее эпиграф есть выпуклое множество в Еп+1.

Доказательство. Пусть множество epi/ выпукло,

Ху у?Х, тогда

[х, /(*)]€ epi/, [у, / ДО] € epi Л

Из условия выпуклости эпиграфа следует, что для любого

0<Х1

-^)/ДО] € epi/.

Согласно определению эпиграфа отсюда следует, что

т. е. / выпукла на X.

Докажем необходимость. Пусть / выпукла на Х\

[х, |x]€epi/, [у, v]^epi/. Из свойства выпуклости / для

любых 0<^<1 имеем/(и+A— X)у)<^Щ(х)+A— Х)/ДО<

^ k\i + A — К) v. Следовательно,

при любых O^X^l, т. е. множество epi/ выпукло

в Еп+1. В

Теорема 1.1.4. Функция f(x) выпукла на Еп тогда

и только тогда, когда для любых х, у?Еп функция

выпукла при любых 0 ^ К ^ 1.

Доказательство. Пусть / выпукла, х, у — произ-

произвольные точки из Еп. Покажем, что эпиграф функции ty(k)y

определяемый условием

§ ,] ВЫПУКЛЫЕ ФУНКЦИИ И МНОЖЕСТВА 19

есть выпуклое множество. Пусть [A,lf aj^epiij), [X2, а2]?

€ epi i|>,

Тогда имеем

/(*.) =

Следовательно, [гХ) a,], [г2, a2]?epi/. Множество epi/

выпуклое, поэтому для любого О <I v ^ 1 имеем

— v)a2]€epi/,

откуда следует, что

Учитывая определение функции i]>, получим

Поэтому эпиграф функции г|) есть выпуклое множество и,

следовательно, функция о|? выпукла. Аналогично доказы-

доказывается обратное утверждение. §|

Теорема 1.1.5. Если выпуклая функция f принимает

в точке а?Еп конечное значение, то множество X, опре-

определяемое условием

не пусто и выпукло.

Доказательство. Множество X не пусто, так как

оно заведомо содержит точку а. Для любых точек х9

у?Еп и O^Ji^l выполнено условие A.1). Будем счи-

считать дополнительно, что х, у?Х, тогда

В силу произвольности числа К из интервала [0, 1] при-

приходим к выводу, что замкнутый сегмент прямой линии,

соединяющей две точки х и у из X, принадлежит X.

Поэтому множество X выпуклое.

20

ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Теорема 1.1.6. Пусть ft(x)—семейство выпуклых

функций ig[l:m]. Тогда при любых а?.>0, i?[l:m],

выпуклыми также будут следующие функции:

) = max

Ф.(х)= max [0, ft(x)].

ie[l]

Доказательство. Для любых #, у?Еп,

имеют место неравенства

2

t=l

где/—некоторое число из множества [1:т]. Поэтому

Отсюда следует выпуклость Ф2(л:). Добавляя к набору

функций /,.(*) выпуклую функцию fm+1(x) =0, приходим

к выпуклости ЦK(х). Щ

Теорема 1.1.7. Пусть функция f(x) выпукла и

функция скалярного аргумента ф (г) монотонно возрастаю-

возрастающая выпуклая функция z. Тогда сложная функция ф (/ (х))

выпукла по х.

До к а з а тельство. Воспользуемся неравенством A.1).

Из монотонности ф следует, что

В силу выпуклости ф имеем

V(Xf(x) + (l-k)fm<

что доказывает выпуклость сложной функции.

2] ДИФФЕРЕНЦИРУЕМОСТЬ ВЫПУКЛЫХ ФУНКЦИЙ 21

§ 2. Дифференцируемость выпуклых функций

1. Дифференцируемость по направлению.

Теорем]а 1.2.1. Если f{t)—выпуклая функция ска-

скалярного аргумента t, то функция

ф(/)^/(О-/(*о)

t—/0

при t > t0 ограничена снизу и не убывает с возрастанием t.

Доказательство. Пусть to<it1<Ci2t тогда

Из свойства выпуклости /(/) следует

2<я°тж12-ь)т) =

tx—г

t2—i

откуда получаем, что

^=ф(Ц| BЛ)

т. е. ф является монотонной, не убывающей функцией t

при t>t0. Покажем ее ограниченность при t—>+?0.

Пусть tm < t0 < t. Несложно получить неравенство, ана-

аналогичное B.1):

о * о

Таким образом, монотонно убывающая при t—++t0 функ-

функция ф(/) ограничена снизу и, следовательно, существует

предел

@

который можно назвать производной функции / (t) справа

в точке t0. Аналогично доказывается, что выпуклая функ-

функция f(t) имеет производную слева в точке t0. Щ

Теорема 1.2.2. Пусть выпуклая функция f(x) при-

принимает конечное значение в точке х?Еп. Тогда для лю-

любого направления q ? Еп, \\ q \ — 1 существует производная f

по направлению q:

3^3 — mil

22

ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Доказательство. Рассмотрим отрезок, соединяю-

соединяющий точку х и y = x + q. Определим функцию скалярного

аргумента t:

Из теоремы 1.1.4 следует, что функция г|)(/) выпукла

при любых 0 ^ t ^ 1. Согласно предыдущей теореме при

этих же значениях t она имеет производные слева и справа.

Поэтому существует предел

что и требовалось доказать. Щ

В приведенной теореме не существенно, чтобы вектор

направления q был единичный, им может быть любой

м-мерный вектор. В дальнейшем производную функции /

в точке х по направлению вектора q ?Еп будем обозначать

Символ + обозначает, что производная берется право-

правосторонняя. Аналогично можно определить левостороннюю

производную по направлению q:

Несложно убедиться в том, что

Используя предыдущие теоремы, можно показать, что

в каждой точке х> в которой значение выпуклой функции /

конечно, существуют левосторонние и правосторонние

производные по произвольному направлению q, причем

D+f(x,q)>D-f(x,q).

2. Свойства субградиентов.

Определение 1.2.1. Пусть функция f(x) опреде-

определена веюду на Еп, Каждой точке x?dom/ поставим в со-

соответствие множество

»}, B.2)

которое будем называть множеством субградиентов или

обобщенных градиентов функции / в точке х. Конкрет-

Конкретный элемент из df (x) называется субградиентом или обоб-

обобщенным градиентом функции f(x) в точке х.

2] ДИФФЕРЕНЦИРУЕМОСТЬ ВЫПУКЛЫХ ФУНКЦИЙ 23

Теорема 1.2.3. Пусть выпуклая функция f(x) при-

принимает конечное значение в точке х. Вектор z?df (x)

тогда и только тогда, когда

/p) B.3)

для любого вектора р?Еп.

Доказательство. Пусть субградиент г удовлетво-

удовлетворяет B.2), положим y = x + tp, где t > 0. При» этом для

любого р

t^f( + t)f(x). B.4)

Разделим это неравенство на /, тогда

Устремляя t к нулю, получим требуемое неравенство B.3).

Обратно, пусть имеет место B.3). Несложно показать,

что для любого вектора р выпуклая функция / (х) удов-

удовлетворяет условию

D+f(x, p) =

Поэтому из этого условия и из B.3) следует; что нера-

неравенство B.4) имеет место при любом р. Обозначив у =

= x + tp, приходим к B.2), откуда следует, что г—суб-

г—субградиент функции / в точке х. Щ

Теорема 1.2.4. Мнооюество субградиентов df(x)

выпуклой, определенной всюду на Еп функции f выпукло

и замкнуто в каждой точке x^&omf.

Доказательство. Пусть г1$ z2?df(x), тогда для

любых у?Еп имеем

<г19 y-x>^f(y)-f(x)9 B.5)

<z2, y-x>^f(y)-f(x). B.6)

Умножим B.5) на X, B.6) на A-Я), где 0<А,<1, и

сложим, получим

Так как это неравенство имеет место для любых у?Епу

приходим к выводу, что

откуда следует выпуклость множества субградиентов.

24

ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Докажем замкнутость df (х) в точке х. Пусть последо-

последовательность zk?df(x), {zk\-+z%, причем z*?df (x). Тогда

существуют такие у?Еп и е > О, что

<г*, y-x> = f(y)-f (*) + *• B.7)

Для любого элемента zk последовательности {zk\ должно

выполняться условие

B.8)

Вычитая из B.8) равенство B.7), получим

e<<z.—z*, # —*><lz* — гЛ-Цу—лг||.

Отсюда следует, что для любого k > О

но это противоречит сходимости последовательности {zk}

к г*. Поэтому заключаем, что z#?df (x) и множество суб-

градиентов, таким образом, замкнуто. Щ

Из этой и предыдущей теорем следует, что если в точке

х не пусто множество субградиентов функции / (л:), то

D+f(x, p)= max <z, p>.

zedf(x)

Понятие субградиента переносится на тот случай, когда

функция / определена только на некотором множестве X.

Определение 1.2.2. Пусть функция f (х) определена

на множестве X, внутренняя часть которого не пуста. Для

точки х?Х определим множество df(x), которое есть

объединение всех векторов z g En, удовлетворяющих для

любых у?Х условию

Множество df (x) называется множеством субградиентов

или обобщенных градиентов функции / в точке х.

Для выпуклой функции множество субградиентов не

пусто, ограничено, выпукло в любой внутренней точке

области определения.

gJj] ДИФФЕРЕНЦИРУЕМОСТЬ ВЫПУКЛЫХ ФУНКЦИЙ 25

3. Свойства выпуклых дифференцируемых функций.

Теорема 1.2.5. Пусть выпуклая на открытом мно-

множестве X<= Еп функция.f дифференцируема в точке х?Х.

Тогда для любых х?Х имеет место неравенство

<fx(x),x-x><f(x)-f&). B.9)

Доказательство. Так как х принадлежит откры-

открытому множеству X, существует такая окрестность Ge(x)

точки х, что Ge (л:) целиком принадлежит X. Пусть х ? X

и хф~х. Соединим точки х и х прямой линией, положим

у = х+р(х—х), 0<|i<l. B.10)

Если 0 < \i < г/\\х—*||, то

Из выпуклости / (х) на выпуклом множестве Ge (x) сле-

следует, что

Воспользуемся условием дифференцируемости / в точке

х (см. Приложение I), получим

-Х)). B.11)

Здесь функция а удовлетворяет условию

Нтсф, Х(у—х)) = 0.

Перейдем в B.11) к пределу при Я,—>0, получим

B.12)

Точка у принадлежит выпуклому множеству, поэтому,

используя B.10) и A.1), получим

f (У)Ч (x)^f (x + ii(x~x))-f (x)^ii[f (х) -f (хI

Подставив это выражение вжB.12) и, приняв во внимание

B.10), придем к требуемому результату B.9). Щ

26 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Теорема 1.2.6. Пусть функция f дифференцируема

на открытом выпуклом мнооюестве X. В этом случае f

выпукла на X тогда и только тогда, когда для любых

х1У х2?Х выполнено неравенство

<M*l). *•-*!> </(*¦)-/(*!)¦ B.13)

Доказательство. Необходимость следует из пре-

предыдущей теоремы. Докажем достаточность. Если х19 х2? X,

ОХ^ 1, то из выпуклости X следует, что х^+Х (х2—хг) ?

Из формулы B.13) получим

умножая первое из этих неравенств на A—X), второе —

на К и, складывая, приходим к неравенству

откуда следует выпуклость функции /. Щ

Если в формуле B.13) поменять местами хг и л:2, то

получим следующую формулу:

<M*i). x%—Xi><*f(x*)-f(Xi)«f*(**)* хш-хг>. B.14)

Теорема 1.2.7. Пусть функция f дифференцируема

на открытом выпуклом множестве X. В этом случае f

выпукла на X тогда и только тогда, когда для любых хи

х2?Х выполнено неравенство

0<<М*»)—M*i). *а—*i>. B.15)

Доказательство. Пусть f (x) выпукла на X и xlt

х2?Х. Согласно предыдущей теореме имеют место нера-

неравенства

Складывая эти неравенства приходим к формуле B.15).

Докажем достаточность. Пусть хи х2$Х. Тогда для

любых 0 ^ % ^ 1 имеем хг + ^ (х2—хх) g X. По теореме

о среднем значении (см. Приложение I) существует такое

число 0 < X < 1, что

-*i))t *.-*!>. B.16)

2] ДИФФЕРЕНЦИРУЕМОСТЬ ВЫПУКЛЫХ ФУНКЦИЙ 27

Согласно условию B.15) имеем

откуда следует, что

Учитывая B.16), получим

Согласно предыдущей теореме отсюда следует выпуклость

функции f(x). Щ

Аналогичным образом доказываются следующие две

теоремы.

Теорема 1.2.8. Пусть строго выпуклая на откры-

открытом множестве ХаЕп функция f (x) дифференцируема

в точке х?Х. Тогда для любых х? X, хфх имеет место

неравенство

</*(*). x-x><f{x)—f(x).

Теорема 1.2.9. Если функция f дифференцируема на

открытом выпуклом множестве X, то f строго выпукла

на X тогда и только тогда, когда для любых х19 Х2?Х,

Xi?=x2, выполнено неравенство

<fx (*i)» хш—хг> < f {х%)—1(хг).

Утверждения приведенных теорем переносятся на вогну-

вогнутые функции, при этом в формулировках теорем знаки

^, < заменяются соответственно на ^, >.

4. Свойства дважды дифференцируемых выпуклых

функций.

Теорема 1.2.10. Пусть выпуклая на открытом мно-

множестве ХаЕп функция f дважды дифференцируема в точке

х?Х. Тогда матрица fxx(x) положительно полу опреде-

определена, т. е. для любых у?Еп имеет место неравенство

xx(x)y. B.17)

Доказательство. Для любого у существует такое

число Я^О, что при каждом О^Я^А, точки

и, согласно теореме 1.2.5,

23 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

С другой стороны, учитывая свойство дифференцируе-

мости, получим

где lim р (х, Ц) = 0.

Поэтому 0<^±-yTfxx(x)y + \\yl*$(x, Xy). Устремляя Я

к нулю, приходим к B.17).

Теорема 1.2.11. Если функция f дважды дифферен-

дифференцируема на открытом выпуклом множестве X, то f

выпукла на X тогда и только тогда, когда матрица fxx (x)

положительно полуопределена на X.

Доказательство. Необходимость следует из пре-

предыдущей теоремы. Докажем достаточность. Если хг, х2?X,

то, согласно формуле Тейлора (см. Приложение I), для

некоторого 0 < т < 1 имеет место равенство

^j{x2—x1)Tfxx (х1 + %(х2—х1)) (хг—хг).

Правая часть этого равенства неотрицательная, поэтому

левая часть также неотрицательна и, согласно теоре-

теореме 1.2.6, функция / выпукла на X. Щ

Так же просто доказывается следующая теорема.

Теорема 1.2.12. Пусть функция f дважды диффе-

дифференцируема на открытом выпуклом множесп.ве X. Для

того чтобы функция f была строга выпукла на X, до-

достаточно, чтоды матрица fxx{x) была положительно

определена на X.

5. Псевдовыпуклые функции.

Определение 1.2.3. Пусть функция / определена

на некотором открытом множестве из Еп, содержащем

множество X, функция / называется псевдовыпуклой в точ-

точке х относительно множества X, если / дифференцируема

в точке х и из выполнимости для любых х 6 X условия

0<</*(*)> х-х> B.18)

следует, что f(x)^.f(x) для всех х?Х.

§3] УСЛОВИЯ ЛОКАЛЬНОГО ЭКСТРЕМУМА 29

Если функция^/ определена всюду на Еп, дифферен-

дифференцируема в точке х и из выполнимости неравенства B.18)

для всех х?Еп следует, что /(*)</(*) для любых х, то

функцию / будем называть псевдовыпуклой в точке х.

Предположим, что функция / выпукла на выпуклом

множестве X, дифференцируема в точке х$Ху в которой

функция / принимает наименьшее на X значение. Тогда

функция / псевдовыпукла в точке х относительно множе-

множества X. Действительно, в этом случае имеет место нера-

неравенство B.9), поэтому из выполнения B.18) автоматически

следует, что f{x)^.f(x) для любых х?Х.

§ 3. Необходимые и достаточные условия

локального экстремума функций многих переменных

1. Основные определения. Пусть функция / определена

на некотором множестве ХсЕп. Будем говорить, что х*

является точкой локального минимума функции / на мно-

множестве X, если существует такая окрестность G (х*) точки

х*, что для всех х> принадлежащих пересечению множеств

X и G (х%), имеет место неравенство

/(*•)</(*)¦ C.1)

Если для всех х ? X Г) G (х*), х Ф х* имеет место строгое

неравенство

/(*•)</(*). C-2)

то будем говорить, что х* является точкой локального изо-

изолированного или строгого минимума функции / (х).

Если неравенство C.1) имеет место для любых х?Х,

то х* называется точкой минимума функции / на X.

Задача об отыскании минимума функции / на множестве

X обозначается символом

min/(x). C.3)

х

Совокупность всех точек #«,?Х, удовлетворяющих при

любых х?Х условию C.1), обозначается

Хф = Arg min / (х)

хеХ

и называется множеством решений задачи C.3). Обычно

в задачах минимизации достаточно найти хотя бы одну

точку х* 6 Х%.

30 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

В тех случаях, когда X совпадает со всем простран-

пространством Епу C.3) называется задачей безусловной миними-

минимизации функции /, точка хт, удовлетворяющая C.1) при

любых х 6 Еп, называется глобальным минимумом функции

f (х). Если C.1) имеет место для всех x?G(xJ)y то х,

называется точкой безусловного локального минимума функ-

функции f(x). В случае выполнимости C.2) для всех x?G(x#),

хфх* точка х* называется точкой локального изолирован-

изолированного или строгого минимума функции f(x).

2. Необходимые и достаточные условия локального

минимума.

Определение 1.3.1. Точка хт называется стацио-

стационарной точкой дифференцируемой функции f (x), если имеет

место условие

/*(*.)-= 0. C.4)

Теорема 1.3.1 (необходимые условия минимума).

Пусть локальный минимум функции f на множестве X

достигается в точке *»€intX. Тогда:

1) если функция f дифференцируема в х*, то х* явля-

является стационарной точкой функции /;

2) если функция f дважды дифференцируема в точке

х*, то матрица fxx{x*) положительно полуопределена.

Доказательство. Из определения 1.1.2 следует,

что для произвольного вектора у?Еп существует такое

число X > 0, что при любых 0 ^ X < X точка х* + Ху?

€G(x*)c:X. Используя дифференцируемость /, запишем

условие C.1) в виде

(**Лу), C.5)

где функция а такова, что lima (л:», Ху) =^0. С учетом

этого свойства из C.5) находим

lim f<b+W-fM =<fAx.), y>.

Поэтому из C.5) следует

Для выполнения этого неравенства при произвольном у

необходимо, чтобы выполнялось условие C.4).

§3j УСЛОВИЯ ЛОКАЛЬНОГО ЭКСТРЕМУМА 31

Если функция / дважды дифференцируема в точке хф9

то вместо C.5) воспользуемся следующей формулой:

f(x.) = .

=jyTfxAx.)y+»№mx., ty). C.6)

где HmP(x., Xy)=Q.

Устремляя К к нулю, получим

±yf xx(

В силу произвольности вектора у?Еп отсюда следует

положительная полуопределенность матрицы fxx(x*), что

завершает доказательство. Щ

Теорема 1.3.2 (достаточное условие локального ми-

минимума). Пусть определенная на X функция f дважды

дифференцируема в точке х* ? int X, в ней выполнено уело-

вие стационарности C.4) и матрица fxx (x*) положительно

определена. Тогда х* является точкой безусловного локаль-

локального изолированного минимума функции /.

Доказательство. Из положительной определен-

определенности матрицы fxx (x*) следует существование такого числа

С>0, что yTfxx{x*)y^2C\y\2 при всех У&Еп. Обозна-

Обозначим Ах = х—хт> тогда из определения второй производной

с учетом C.4) и C.6) получим, что

Функция р(л:%, Дл:) такова, что существует окрестность

G(x*)y в которой С+Р(#*> Дл:) > 0 для всех x?G(x*).

Поэтому приходим к неравенству C.2), справедливому для

любых x?G(xm), хфх+i что и требовалось доказать. Щ

3. Необходимые и достаточные условия локального

максимума. Можно рассмотреть задачу об отыскании мак-

максимума дифференцируемой функции / на множестве X:

maxf(x). C.7)

ех

Если максимум в этой задаче достигается во внутрен-

внутренней точке х* множества X, то необходимо, чтобы в этой

точке выполнялось условие C.4) и, если функция / дважды

32 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

дифференцируема в л:*, то матрица fxx(x*) должна быть

отрицательно полуопределена, т. е. для любых у?Еп имеет

место неравенство

Достаточное условие строгого локального максимума функ-

функции / в точке х#, удовлетворяющей C.4), состоит в отри-

отрицательной определенности матрицы fxx(x*).

Таким образом, если во внутренней точке х* множества

X достигается локальный максимум или минимум диффе-

дифференцируемой функции /, то в ней выполнено условие C.4).

Поэтому при решении экстремальных задач полезно бывает

найти стационарные точки. Задача отыскания стационар-

стационарных точек дифференцируемой функции / совпадает с зада-

задачей решения системы уравнений fx(x) = 0. Поэтому для

решения задач C.3) и C.7) могут быть использованы

методы решения систем уравнений, некоторые из них будут

приведены в следующей главе.

4. Критерий Сильвестра. Обозначим Дх (х), Д2 (х), .. ¦

..., Ая(х) последовательные главные миноры матрицы

Теорема 1.3.3 (критерий Сильвестра). Для того чтобы

матрица fxx (x) была положительно определенной, необхо-

необходимо и достаточно, чтобы выполнялись условия

Ах (х) > О, Д2 (х) > 0, ..., Д„ (х) > 0. C.8)

Для того чтобы матрица fxx (x) была отрицательно опре-

определенной, необходимо и достаточно, чтобы выполнялись

условия

Дх (х) < 0, Д2 (х) > 0, ..., (-1)» Д„ (х) > 0. C.9)

Доказательство критерия можно найти в многочислен-

многочисленных книгах по линейной алгебре. С каждой симметричной

матрицей fxx(x) можно связать квадратичную форму

Неравенства C.8) и C.9) дают необходимые и доста-

достаточные условия положительной и отрицательной опреде-

определенности квадратичной формы Ф(х). В курсах математи-

математического анализа (см., например, Г. М. Фихтенгольц [1])

рассматриваются только те случаи, в которых выполнены

условия C.8) и C.9), все другие возможности относятся

§3] УСЛОВИЯ ЛОКАЛЬНОГО ЭКСТРЕМУМА 33

к «неопределенным», так как они не дают достаточных

условий экстремума функций. Ниже, в § 5, будет показано,

что случаи, когда в C.8) и C.9) имеют место противо-

противоположные строгие неравенства, будут соответствовать до-

достаточным условиям локального максимина и минимакса.

5. Случай выпуклых функций.

Теорема 1.3.4. Пусть функция f выпукла на Еп.

Тогда всякий локальный минимум функции f является

одновременно \глобальным на Еп минимумом, множество

точек минимума функции f выпукло. Если функция f

строго выпукла, то X* состоит из единственной точки.

Доказательство. Пусть для всех х ? G (хш) выпол-

выполнено условие C.1). Возьмем произвольную точку у?Еп,

тогда для достаточно малых 0 < А,< 1 имеем х*+Х(у—##) ?

?G(x*). Используя выпуклость /, получим

Отсюда следует, что f (x*)^f(y). В силу произвольности

точки у?Еп заключаем, что х* является точкой глобаль-

глобального минимума функции f. Q

Обозначим c = f(x*), тогда, согласно теореме 1.1.5,

выпуклым будет множество минимумов

Предположим, что минимум строго выпуклой функции

f достигается в двух различных точках х19 х2?Х. Тогда

из выпуклости Х# и строгой выпуклости / следует, что

при любом 0 < X < 1

Из противоречия следует единственность точки минимума.

Теорема 1.3.5. Пусть f—выпуклая на Еп функция.

Условие 0 ?д/ (х*) имеет место тогда и только тогда,

когда f достигает своего глобального на Еп минимума

в точке хш.

Доказательство. Из определения множества суб-

субградиентов следует, что O?df(x*) тогда и только тогда,

когда f(x)^f (хт) для любых х6Еп. Отсюда заключаем,

что х*—глобальный минимум f(x).

Если функция f выпукла на Еп и дифференцируема

в точке X; то fx(xm) = O тогда и только тогда, когда х*

является точкой глобального минимума функции /. Щ

2 Ю. Г. Евтушенко

34 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. Г

§ 4. Необходимые и достаточные условия

минимума функций на множествах

1. Основные определения. Предположим, что функ-

функция / определена на некотором открытом множестве, со-

содержащем множество X, и множество

не пусто. В тех точках х?Х, где функция / дифферен-

дифференцируема, можно определить точечно-множественное ото-

отображение

x), у-х>. D.1)

Отсюда следует, что W{x)aX. Если функция / диф-

дифференцируема всюду на Ху то условие D.1) каждой точке

х?Х ставит в соответствие множество W(x)c:X. Таким

образом, W осуществляет точечно-множественное отобра-

отображение множества X в себя. Говоря о неподвижных точках

отображения W(x), будем считать, что эти точки таковы,

что

х?Х, x?W(x). D.2)

Если x(fcW(x), то существует точка у?Х такая, что

<fx(x), y-xXO.

Если x?W(x), то имеет место неравенство

О<</*(*)> У-*> Vy?X. D.3)

Это условие иногда называют вариационным неравенством]

всякую точку х? X, в которой выполнено D.3), называют

решением вариационного неравенства. Для того чтобы х

была неподвижной точкой отображения W> необходимо и

достаточно, чтобы она была решением вариационного не-

неравенства D.3).

В каждой фиксированной точке х ? Еп% где fx (x) Ф О,

множество

представляет собой гиперплоскость, проходящую через

точку ху с вектором нормали fx(x). Вместе с тем К(х)

является касательной гиперплоскостью к гиперповерхности

§41

УСЛОВИЯ МИНИМУМА ФУНКЦИЙ НА МНОЖЕСТВАХ 35

в точке х. Множество Г (л:) является линией уровня функ-

функции /(*)» градиент fx(x) направлен по нормали к линии

уровня, внутрь множества

«: f(y)>f(x)\.

Гиперплоскость К (х) порождает два полупространства:

О <</*(*)> y—x>, <fx(x), */-*>< 0.

Пусть точка х?К такова, что в ней выполнено усло-

условие D.3). Тогда в первом из приведенных полупространств

содержится множество X. Поэтому D.3) можно интерпре-

интерпретировать как условие того, что множество X целиком

содержится в одном из двух замкнутых полупространств,

определяемых касательной гиперплоскостью К {х). Согласно

определению 1.1.11 в такой ситуации касательная гипер-

гиперплоскость К (х) является опорной к множеству X в точке х,

вектор fx {x) есть опорный вектор множества X в точке х.

2. Условия минимума второго порядка.

Теорема 1.4.1. Пусть функция f определена на от-

открытом множестве в Еп> содержащем выпуклое множе-

множество X, и существует точка х ? X*, в которой функция f

дифференцируема. Тогда необходимо, чтобы х была не-

неподвижной точкой отображения W(x).

Доказательство. Пусть х—произвольная точка

множества X. Согласно определению 1.1.1 из выпуклости

множества X следует, что для любых чисел А,? [0, 1] имеет

место включение х + К(х—х)?Х. Так как / дифферен-

дифференцируема в точке х и х?Х%> имеем

= *.</,(*). х—Х> + Цх—х\а{х, Ь(х—х)),

где

М*—*))=•¦ 0.

Отсюда получим, что для любых 1?[0, 1]

0<</,W, x—x>+\x—xla(xt X(x—x)).

2*

35 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Устремляя К к нулю, приходим к неравенству

О<</*(*), х-х>, D.4)

справедливому при любых х?Ху откуда следует, что

щ) а

щ) а

Приведенная теорема дает необходимое условие гло-

глобального минимума функции / на выпуклом множестве X.

Как будет показано ниже (в § 4 гл. VI), это необходи-

необходимое условие тесно связано с полученным в теории опти-

оптимального управления дискретным вариантом принципа

максимума Л. С. Понтрягина.

Введенное в теореме требование выпуклости множе-

множества X существенно. Легко привести примеры, где нару-

нарушение этого требования делает утверждение теоремы не-

неверным. Тем не менее возможен локальный вариант тео-

теоремы, где не требуется выпуклость X. Неравенство D.3)

при этом будет иметь место лишь для векторов уу при-

принадлежащих пересечению X и некоторой окрестности мно-

множества Х«.

Теорема 1.4.2. Пусть функция f определена на от-

открытом множестве в Еп, содержащем X, множество Х«

не пусто и выпукло, существует точка х?Хф, в которой

функция f дифференцируема. Тогда существует такая

окрестность G(Xj) множества X*, что для всехх? X f| G(X*)

имеет место неравенство D.4).

Из определения 1.2.3 псевдовыпуклости вытекает сле-

следующая теорема, дающая достаточные условия глобаль-

глобального минимума функции / на множестве X.

Теорема 1.4.3. Пусть функция f псевдовыпукла в

точке х относительно множества X и х является непод-

неподвижной точкой отображения Wy тогда х?Х*.

3. Случай выпуклых функций. Предположим вначале,

что функция / (х) определена и выпукла на открытом мно-

множестве, содержащем множество X, существует точка х* ? X»

и функция / дифференцируема в точке х?Х. Тогда из

формулы B.14) следует неравенство

О </(*)-/(*.)<</*(*), *-**>, D.5)

справедливое для всех х, принадлежащих множеству X.

„1 УСЛОВИЯ МИНИМУМА ФУНКЦИЙ НА МНОЖЕСТВАХ 37

§4J

Для *€*, *€

имеем

Поэтому D.5) можно представить в виде

/ (*)—/ (*•) < <fx(х), х—х> Чх. € **, VJe W(x). D.6)

Это неравенство будет неоднократно использовано ниже.

Пусть х?Х, x?W(x)f тогда

О = </*(*), x—x> Vx?W(x)

и для любых у?Х выполнено D.3). Из неравенства D.6)

заключаем, что в этом случае х?Хф. Для любых ?Х

х ?Х, согласно D.5), имеем

<f*(x), х*—х><0.

Неравенство D.3), таким образом, нарушено при у = х*.

Мы приходим к следующему результату:

Для того чтобы выпуклая дифференцируемая в точке

х?Х функция f достигала в х наименьшего значения на

выпуклом мнооюестве X, необходимо и достаточно, чтобы

имело место условие D.3) (т. е. точка х была неподвиж-

неподвижной точкой отображения W(x) или градиент fx{x) был

опорным вектором множества X в точке х).

4. Необходимое условие минимума второго порядка.

Может оказаться, что в точке х?Х выполнено условие

стационарности

/,W = 0. D.7)

Если функция / выпуклая, то отсюда следует, что л;?Х«.

В общем случае свойство D.7) делает малосодержательным

условие D.4). Поэтому приходится вводить необходимые

условия более высоких порядков.

Теорема 1.4.4 (необходимое условие минимума вто-

второго порядка). Пусть функция f определена на откры-

открытом множестве из Еп, содержащем выпуклое множество X,

функция f дважды дифференцируема в точке х ? X», в ко-

шорой выполнено D.7). Тогда необходимо, чтобы для любых

х?Х имело место неравенство

О <(*-*)*7« (*)<*-*)• D-8)

38

ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Доказательство. Пусть я—произвольная точка

множества X. Из выпуклости X следует, что для любых

^[0, 1] имеет место включение

Используя условие, что функция / дважды дифференци-

дифференцируема в точке х?Х, получим

Здесь НтC(л:, X (х—л:)) = 0. Устремляя Я к нулю, прихо-

дим к неравенству D.8). Щ

Подобно тому как это было сделано выше, в стаци-

стационарной точке х можно определить точечно-множественное

отображение Хх (х) = Arg min (x—х)т fxx (х) (х—х).

хеХ

Здесь для отыскания множества Хг(х) приходится ре-

решать задачу минимизации квадратичной формы на мно-

множестве X. Можно поставить задачу об отыскании непод-

вижных точек этого отображения или о решении квадра-

квадратичных вариационных неравенств

определяя тем самым точки, удовлетворяющие условию

минимума второго порядка.

§ 5. Свойства минимаксных задач

1. Постановка минимаксных задач. Пусть F (х, у) —

определенная для всех х g En и у?Ет непрерывная функ-

функция. Ставятся задачи нахождения безусловного максимина

и минимакса

min F(xy у), E.1)

= min max F(x, у). E.2)

?ЕП вЕт

На примере второй задачи разъясним смысл, вкладывае-

вкладываемый в приведенную запись. При каждом фиксированном

3 СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 39

х?Еп находится образ точечно-множественного отображе-

отображения В(х):

B(x)^ArgmaxF(x, у). E.3)

еЕ*

После этого определяется функция максимума

<p(*) = F(*f B(x)). E.4)

Здесь выражение F(x, B(x)) обозначает, что вычисляется

значение F (х, ~у), где ~у?В(х). Из определения E.3) сле-

следует, что F (х, у) принимает одно и то же значение для

любых ~у?В(х), что оправдывает такую форму записи-

Определим далее множество

Множество Х% и точечно-множественное отображение

В(х) назовем синтезом задачи E.2), хотя бы одну пару

точек [**, #«,], где хт$Хт, у*?В(х*), назовем решением

(глобальным) минимаксной задачи E.2). Величину V2 =

=F (jc«, t/«) назовем минимаксной гарантированной оценкой.

Нахождение для каждого х хотя бы одного элемента

из множества В(х) будем называть внутренней задачей.

Определение хотя бы одной точки из X* назовем внешней

задачей.

Чтобы упростить изложение, в этом параграфе будем

считать, что все встречающиеся операции поиска экстре-

экстремумов имеют решения. В E.2) это означает, что много-

многозначное отображение В определено при любых х, множе-

множество X* не пусто.

Теорема 1.5.1. Если задачи E.1) и E.2) имеют ре-

решения, то

V^Vt. E.5)

Доказательство. Для любого фиксированного

У$Ет выполнено неравенство

min F(x9 yXF(x, у).

Еп

Аналогично для всякого фиксированного х

F(x9 y)^maxF(x, у).

SE

40 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Поэтому для любых у?Ет и х € Еп

m\nF(x, y)^maxF(х> у),

Еп Ем

В силу произвольности х и у получим окончательно

max minF(x, у) <!minmax F (х, у). Щ

Ет €Еп ЕпЕт

2. Задачи на условный минимакс. В задачах E.1) и

E.2) никаких условий на х и у не накладывалось, поэтому

их можно назвать задачами о поиске безусловного макси-

мина и минимакса. Рассмотрим случай, когда на х и у

наложены ограничения:

^, у), E.6)

V2 = min max F (x, у). E.7)

Определение решения этих задач дается аналогично тому,

как это делалось выше (см. E.3) и E.4)):

:, у), <p(x)=--F(x, B(x))f

E 8)

Для приложений весьма важен вопрос: какие свойства

функции F(x, у) изменяются и какие сохраняются после

осуществления операции максимизации по у, т. е. при

переходе от F (х, у) к ф (*)? Чтобы ответить на этот вопрос,

рассмотрим вначале свойства непрерывности, выпуклости

и выполнимости условия Липшица.

Для сокращения записи обозначим

Будем говорить, что функция F (г) удовлетворяет условию

Липшица на Z с константой /, функция ф(л:) удовлетво-

удовлетворяет условию Липшица на X с константой /, если для

любых ги z2?Z и х19 х2?Х выполнены соответственно

условия

?5] СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 41

Теорема 1.5.2. Если функция F(xt у) непрерывна

на прямом произведении компактных множеств Z=XxY,

то функция ф (л:) также непрерывна на X. Если функция

p(z) удовлетворяет условию Липшица на Z, то функция

Ф (х) также удовлетворяет условию Липшица на X с той

же константой. Если при каждом у^У функция F(x, у)

выпукла по х на выпуклом множестве X, то и q>(x) вы-

выпукла на X.

Доказательство. Функция F(x, у), будучи непре-

непрерывной на компактном множестве Z, равномерно непре-

непрерывна на этом множестве. Поэтому для любого е > 0 су-

существует такое 6(е), что если Цл^—*2||<6(е), хи х2?Х,

то

1/4*1, y)-F{x%%y)\<*

для любого у ? Y. Рассмотрим выражение

| ф to)—ф (*2)| = | F {xu y!)—F{x2, y2)\.

Здесь обозначено у1^В(х1I у2?В(х2). Рассмотрим два

случая. В первом имеем

Учитывая определение множества В(х), получим

Если функция jF (г) удовлетворяет условию Липшица по г,

то она удовлетворяет и условию Липшица по ху равно-

равномерно по у у поэтому

Во втором случае

0<ф(л;2)—ф(хх).

Аналогичным образом получаем, что

0<Ф(*,)—Ф^Х/Ч*,, yJ—F(xl9 у2)

и если F удовлетворяет условию Липшица, то

Объединяя эти два случая, приходим к выводу, что при

любых хг и х2? X, таких, что \хг—х2\ < б(е), имеет место

неравенство |ф(#!)—ф(аг2)|<6, т.е. функция ц>(х) непре-

непрерывна на компактном множестве X. Если F удовлетворяет

условию Липшица, то имеет место E.9).

42 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Если F выпукла по х, то для любых х1У х2?Х,

О ^ А, ^ 1 имеют место оценки

= maxF(Xx1 + {l — к)х2, #)<

yeY

[XF(xu y) + (l-

что доказывает выпуклость функции ф. Щ

Свойство дифференцируемости функции F не сохра-

сохраняется при переходе к функции ф. Имеет место следующая

Теорема 1.5.3 (Данскина—Демьянова). Пусть X —

открытое множество в Еп, Y—компактное множество

в Ету функция F непрерывна вместе с Fx(x, у) по сово-

совокупности переменных в XxY. Тогда определяемая из

E.8) функция ф(лг) имеет в каждой точке х?Х произ-

производную по любому направлению g?Ent ||g|=l, причем

^= max </>,(*,*),*>.

Доказательство теоремы можно найти в книгах Дж.

Данскина [1], В. Ф. Демьянова и В. Н. Малоземова [1].

В последней книге доказана также и следующая теорема,

являющаяся обобщением теоремы 1.4.1 на случай мини-

минимизации функции максимума.

Теорема 1.5.4. Пусть X—замкнутое выпуклое мно-

множество в Епу Y—компактное множество в Ету функция F

непрерывна вместе с Fx (я, у) по совокупности переменных

в XxY. Тогда, для того чтобы функция <р(х) достигала

минимального на X значения в точке х* ? X, необходимо,

а в случае выпуклости ф(лг) на X—и достаточно, чтобы

inf max <Fx(x*, у), х—#«,>^=0.

х в{)

В заключение приведем теорему о существовании реше-

решений задач E.6) и E.7).

Теорема 1.5.5. Если функция F(x, у) непрерывна

на произведении компактных множеств X и Y, то реше-

решения задач E.6) и E.7) существуют и имеет место нера-

неравенство

= maxminF(A:, у) ^ V2 = min max F (xy у). E.10)

Y xex xex Y

§ 5]

СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 43

Доказательство теоремы почти дословно повторяет до-

доказательство теоремы 1.5.1.

3. Седловые точки. Точка г, = [лг„ у*] называется сед-

ловой точкой функции F (х, у) в задачах E.6) и E.7), если

х*€^> У*?У и Для любых х?Х, y?Y имеют место не-

неравенства

F (*•. У)<Р (*•, У*) < F (*, у*). E.11)

Лемма 1.5.1. Если задачи E.6) и E.7) имеют реше-

решения, то, для того чтобы имело место равенство

V1 = F(x,, y*) = V2, E.12)

необходимо и достаточно, чтобы zm была седловой точкой

функции F(x, у).

Доказательство. Пусть \хш, уш]—седловая точка

функции F(x, у). Тогда

maxF(x«,

Очевидны следующие неравенства:

minmaxF(#, у) ^ max F (#„, у),

ех sY eY

minFfx, Уф)^: max mini7 (x, у),

x v x

Объединяя последние три группы неравенств, получаем,

что

minmaxF(A:, y)^F(x*, #«)<!maxniinF(A;, у),

xsx yeY yeY xex

Сравнивая это неравенство с E.10), приходим к выводу,

что справедливо равенство E.12).

Пусть имеет место E.12). Покажем, что точка \хт, #«] —

седловая. Из E.12) следует

F (*• • у%) = min max F (х, у) = max F (xm, y)>F (*., у),

ex Y yeY

(, y) = minF(x,

xex ex

Объединяя эти неравенства, получаем, что имеет место

E.11), т. е. [хт, у*] есть седловая точка функции F (л:, у). Щ

Определение 1.5.1. Функция F(x9 у) называется

выпукло-вогнутой, если F(x9 у) выпукла по х для всех

44 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

фиксированных у?Y и F(х, у) вогнута по у для всех

фиксированных х?Х. Функция F (х, у) называется строго

выпукло-вогнутой, если при любом фиксированном у она

строго выпукла по л: и при любом фиксированном х строго

вогнута по у.

Теорема 1.5.6 (Неймана). Пусть выпукло-вогнутая

функция F(x, у) непрерывна на прямом произведении

выпуклых компактных множеств X и Y. Тогда функция

F(x, у) имеет седловую точку.

Доказательство теоремы можно найти, например, в

книгах Д. Неймана и О. Моргенштерна [1], Э. Г. Давы-

Давыдова [2].

4. Понятие локальных решений. Если решения внут-

внутренней и внешней задач трактовать как нахождение ло-

локальных экстремумов, то придем к понятию локальных

решений минимаксных и максиминных задач. Такие реше-

решения получаются, например, если мы попытаемся численно

решить задачу E.2), используя лишь методы локальной

безусловной минимизации и максимизации.

Определение 1.5.2. Пусть точки х* и ут обладают

соответственно окрестностями G (х*) и G(y#) такими, что

для любых векторов х ? G (х*) условие

g(x) = Avg max F(x, у)

определяет однозначную вектор-функцию g(x)> причем х*

является точкой строгого минимума функции F(x, g(x))

на G(x*) и y* — g(x*). Тогда г* = [х*> #*] называется точ-

точкой строгого локального минимакса в задаче E.2).

Если гш—точка строгого локального минимакса, то для

любых хбG(л:*), хфх«, y€G(ym), уФё{х), выполнены

строгие неравенства

F(x,, g(x.))<F(x9 g(x))9 E.13)

F(x,y)<F{x, g(x)). E.14)

Последнее неравенство выполнено и при х=хф, y=?g(xm).

Аналогичным образом можно определить локальные

или глобальные по ху локальные или глобальные по у,

строгие или не строгие по х, строгие или не строгие по у

решения задач E.1) и E.2). Приведенные определения

§5j СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 45

локальных решений являются обобщением известных поня-

понятий о локальных экстремумах. Минимаксная задача E.2)

может иметь несколько локальных решений. Однако после

их нахождения нельзя утверждать, что среди этих реше-

решений есть глобальное: необходимо еще рассмотреть все

глобальные по у, локальные по х решения и выбрать из

них то, для которого значение F(x> у) наименьшее. Изу-

Изучение и отыскание локальных решений важно для опре-

определенного ниже класса функций, у которых точки локаль-

локального минимакса являются одновременно и точками глобаль-

глобального минимакса. Для максиминных задач E.1) локальные

решения определяются аналогично.

Определение 1.5.3. Пусть точки х% и у« обладают

соответственно окрестностями G(x#) и G(y*) такими, что

для любых векторов у€О{у*) условие

d(y).= Arg. min F(x, у)

G()

определяет однозначную вектор-функцию d{y)> причем ут

является точкой строгого максимума функции F(d(y)9 у)

на G(y«) и d (#«) = #*. Тогда z* = \x#, t/«] называется точ-

точкой строгого локального максимина в задаче E.1).

Неравенства E.13), E.14) в этом случае заменяются

следующими:

F(d(y), y)<

y)<F(x,y).

Определение 1.5.4. Функция F(xy у) имеет в точ-

точке z* строгое локальное седло, если z« является одновре-

одновременно точкой строгого локального минимакса и макси-

мина.

Объединяя неравенства E.13)—E.15), получаем, что

в седловой точке выполнены неравенства

F fa, y)<F (хФУ уф) < F (х, */,), ,- lfi.

F (d(y), y)<F (х., у,) < F (x; g(x)). 1°ло'

Здесь y?G(yt), у Фу., x^G(x.)f хфх..

46 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. J

5. Необходимые и достаточные условия локального

минимакса. Введем квадратную симметричную матрицу

размера /г2:

Ф(*. У) = рхх(*> y)—Fxy(x, У)Руу(х, y)Fyx(*> У)-

Теорема 1.5.7. Пусть функция F(г) дважды непре-

непрерывно дифференцируема в некоторой окрестности G(zJ

точки zm. Для того чтобы в задаче E.2) вектор г* был

точкой строгого локального минимакса, достаточно, чтобы

выполнялись условия

Fyy(z.)<0, Ф(г,)>0. [ОЛ/)

Если в задаче E.2) вектор г* является точкой строгого

локального минимакса, то необходимо, чтобы было

(*•) - 0л1, Fx (г.) = 0я1э F (z.) < 0, а если F (z<) < О,

Ф()>0

Доказательство достаточных условий основано на

анализе неравенств E.13) и E.14). Из условий Fy(zm)=Omlf

Fyy(z*) <0, следует, что ут является точкой строгого ло-

локального максимума функции ^(л:,, у) по у. Так как мат-

матрица Fyy(zm) отрицательно определена, существует неко-

некоторая окрестность G (z*) = G(xt)xG (ут) точки г«, где

матрица Fyy (z) также отрицательно определена и для всех

# € G (Хщ) неявное уравнение Fy (x, у) = 0 определяет одно-

однозначным образом непрерывно дифференцируемую функцию

У==ё(х)> причем y*=g(x9). Эта функция может быть

получена как решение задачи Коши для следующей системы

квазилинейных уравнений

S

E.18)

с п независимыми переменными [х1, ..., хп] и начальным

условием g(x*) = ym.

Обозначим g(x) решение системы E.18), определенное

на G (хт), принимающее значение из G (у9). Значения век-

вектор-функции y = g(x) являются точками локального мак-

максимума функции F (х, у) по у. Неравенство E.14), таким

образом, имеет место. Подставим y = g(x)bF(x, у), полу-

получим функцию максимума, которую обозначим

§5] СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 47

Дифференцируя ф как сложную функцию х с учетом E.18)

получим

, ч dF (x, g (х)) г, / i w

Vx(*)= dx ~РЛ*> g(x))>

t g(x))Fyx(*t

В частности, при x = x* будет g(x*) = y*, поэтому мат-

матрица ухх (*¦) положительно определена и л:» является точкой

строгого локального минимума функции ер (я) и имеет

место E.13). Из аналогичных рассуждений следуют сфор-

сформулированные в теореме необходимые условия локального

минимакса. В . ¦

Достаточные условия теоремы можно сформулировать

как достаточные условия глобального решения E.2). При

этом следует наложить на ^(л:, у) более жесткие требо-

требования. Считая, что при каждом х?Еп внутренняя задача

в E.2) имеет решение и разрешима внешняя задача, сформу-

сформулируем следующее достаточное условие глобального мини-

минимакса.

Теорема 1.5.8. Пусть функция F(л:, у) при каж-

каждом фиксированном х?Еп строго вогнута по у и функция

F(x, B(x)) строго выпукла по х. Тогда точка локального

минимакса в E.2) является одновременно и глобальным

решением задачи E.2).

Аналогичным образом формулируются необходимые и

достаточные условия максимина в задаче E.1).

Теорема 1.5.9. Пусть функция F(z) дважды непре-

непрерывно дифференцируема в окрестности точки г*. Для того

чтобы в задаче E.1) z, была точкой строгого локального

максимина, достаточно, чтобы выполнялись условия

М**) = 0, F9(z.) = 0, Fxx(z.)>Ot

N (г.) = Fyx (г.) F?x (г.) Fxy (z,)-Fyy (z,) > 0.

6. Критерий минимаксной определенности. Если функ-

функция F (х9 у) всюду дифференцируема по х и у, то усло-

условия теоремы 1.5.8 можно записать в аналитической форме,

для любых хг и х2 из ?", ххфх% и уи у2 из Ет, уг Ф у2:

48 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

должны выполняться неравенства

<Fx(xl9g(x1))9 *¦—*i>< *¦(*!. g(*i))— F(xug(xJ), - 19v

<Fy(x> Уж), У2—У1>>Р(х, y2)—F(x, у±), к *

здесь г(л:1) = Arg max F(xu y)t g(x2) = Arg max F (x2, y).

Если функция F(x, у) дифференцируема и строго вы-

выпукло-вогнута, то условия E.19) заведомо выполняются.

Действительно, для таких функций второе неравенство

имеет место, а первое следует из неравенств

max F (x2, y)—F (xly g(xt))=F (x2,g(x%))—F (xlf g(xx)).

Если функция F (xy у) дважды непрерывно дифферен-

дифференцируема, то достаточное условие записывается так: для

любых х 6 Еп и у?Ет выполнены условия

Fyy(x, y)<Q, Ф(х9 g(x))>0.

Последнее требование будет заведомо выполняться, если

имеет место более сильное условие, проверка которого не

требует знания функции g(x): для любых х?Еп, у?Ет

выполнены условия

FV9(x, y)<0, Ф(х, у)>0.

Придадим этим условиям иной вид. Введем квадратную

симметрическую матрицу

Здесь использовано разбиение матрицы R(z) на четыре

матрицы-клетки. Последовательные главные миноры мат-

матрицы R(z) обозначим Ax(z), A2(z), ..-, &n+m{z). В част-

частности, Ae(«) = |Fw(z)|, A»+e = |/?B)|.

Докажем следующий

Критерий. Для того чтобы матрицыФ(г), —Fyy(z)

были положительно определены, необходимо и достаточно,

чтобы для последовательных главных миноров матрицы

R(z) имели место неравенства

(-l)'A,(z)>Of *€[l:/n], E.20)

г)>0э /€[1:п]. E.21)

§5] СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 49

Эквивалентность неравенств E.20) отрицательной опре-

определенности матрицы Fyy (z) следует из критерия Сильвестра.

Чтобы доказать E.21)v представим главный минор Am+/(z)

матрицы R (z) в виде

WJ^W. F.22)

Здесь FyX/—матрица размером mx/, Т7*.^.—матрица /х/.

На пересечении t-й строки и /г-го столбца этих матриц

d2F d*F лг

находятся и соответственно. Умножим верх-

нюю строку блочной матрицы E.22) слева на матрицу

Fx.yFyy размером jxrn и вычтем ее из нижней строки.

Определитель Ада+у, как известно, при этом не изменится,

получим

А.+/ (г)-1 РуУ(г) |• |FXjXj{z)-FXjy(z)F~yy (z)FyXj (z)\. E.23)

Обозначим 8j (z), /€[1:я], последовательные главные

миноры матрицы Ф(г). Из E.23) следует, что 6/(z) свя-

связаны с последовательными главными минорами матрицы

R(z) формулами

Таким образом, если неравенства E.20) и E.21) имеют

место, то последовательные главные миноры матрицы Ф (z)

положительны и, следовательно, матрица Ф(г) положи-

положительно определена. Верно и обратное —из положительной

определенности Ф(г) и —Fvv(z) следуют условия E.20),

E.21). ¦

Интересен один частный случай, когда у—скаляр (т= 1).

Условия E.20) и E.21) в этом случае будут иметь вид

Согласно результатам § 3, для того чтобы стационарная

точка z функции F (z) была точкой безусловного локаль-

локального минимума, достаточно, чтобы последовательные глав-

главные миноры матрицы R(z) были строго положительны:

50 ВВЕДЕНИЕ В ТЕОРИЮ ОПТИМИЗАЦИИ [ГЛ. I

Для того чтобы стационарная точка z была точкой

безусловного локального максимума функции F (z), доста-

достаточно выполнение условий

(-1)'А, (*)><>, /€[1:л+1].

Оставшийся четвертый вариант условий

(-1)'А, (*)<<>, *g[l: /i+l]f

соответствует достаточным условиям максимина в задаче

max min F (х> у).

Еп Е1

Рассмотренный случай показывает тесную связь доказан-

доказанного критерия с критерием Сильвестра. Эту связь можно

развить и далее, введя понятия, аналогичные положитель-

положительной и отрицательной определенности. Например, квадра-

квадратичную форму

2*7? (г.) г - xTFxx (г.) х+2y^Fyx (г.) х + yTFyy (г.) у

можно назвать минимаксно определенной в точке z«, если

для любых х ф 0, уфО имеют место неравенства

уУ

< max [xTFxx (z*)x + 2xTFxy (г.) у+ yTFyy (г.) у].

Максимум правой части неравенства по у достигается при

ук= — Fyy(z*)Fyx(z*)x. Поэтому приведенное неравенство

эквивалентно следующему:

Доказанный выше критерий дает необходимые и доста-

достаточные условия минимаксной определенности квадратичной

формы. Функцию F (z) можно назвать строго минимаксной,

если для всех z, z 6 Еп+т квадратичная форма zTR(z)z

минимаксно определена. Для таких функций выполнены

условия теоремы 1.5.8, и их локальное минимаксное реше-

решение одновременно является глобальным.

Введенный таким образом класс функций можно поста-

поставить в один ряд с известными классами выпуклых и вы-

выпукло-вогнутых функций. Действительно, у строго выпук-

выпуклых функций, если существует локальный минимум, то

он единственный и совпадает с глобальным. У строго

?5] СВОЙСТВА МИНИМАКСНЫХ ЗАДАЧ 51

выпукло-вогнутых функций, если существует локальное

седло, то оно единственно и совпадает с глобальным.

У строго минимаксных функций, если существует локаль-

локальный минимакс, то он единственный и является вместе

с тем глобальным. Введенный класс богаче класса строго

выпукло-вогнутых функций (у которых yTFyy(z)y<0,

xTFxx (z) x > 0), так как содержит в себе последний. Важ-

Важность введения такого класса функций связана, с тем, что

для них решение задач E.2) можно проводить, используя

итеративные локальные численные методы.

Рассмотрим два простейших примера, иллюстрирующих получен-

полученные свойства минимаксных задач. Будем считать, что х и у скаляры.

Пример 1. Пусть

F(x, y) = e

В силу периодичности функции по у можно ограничиться интервалом

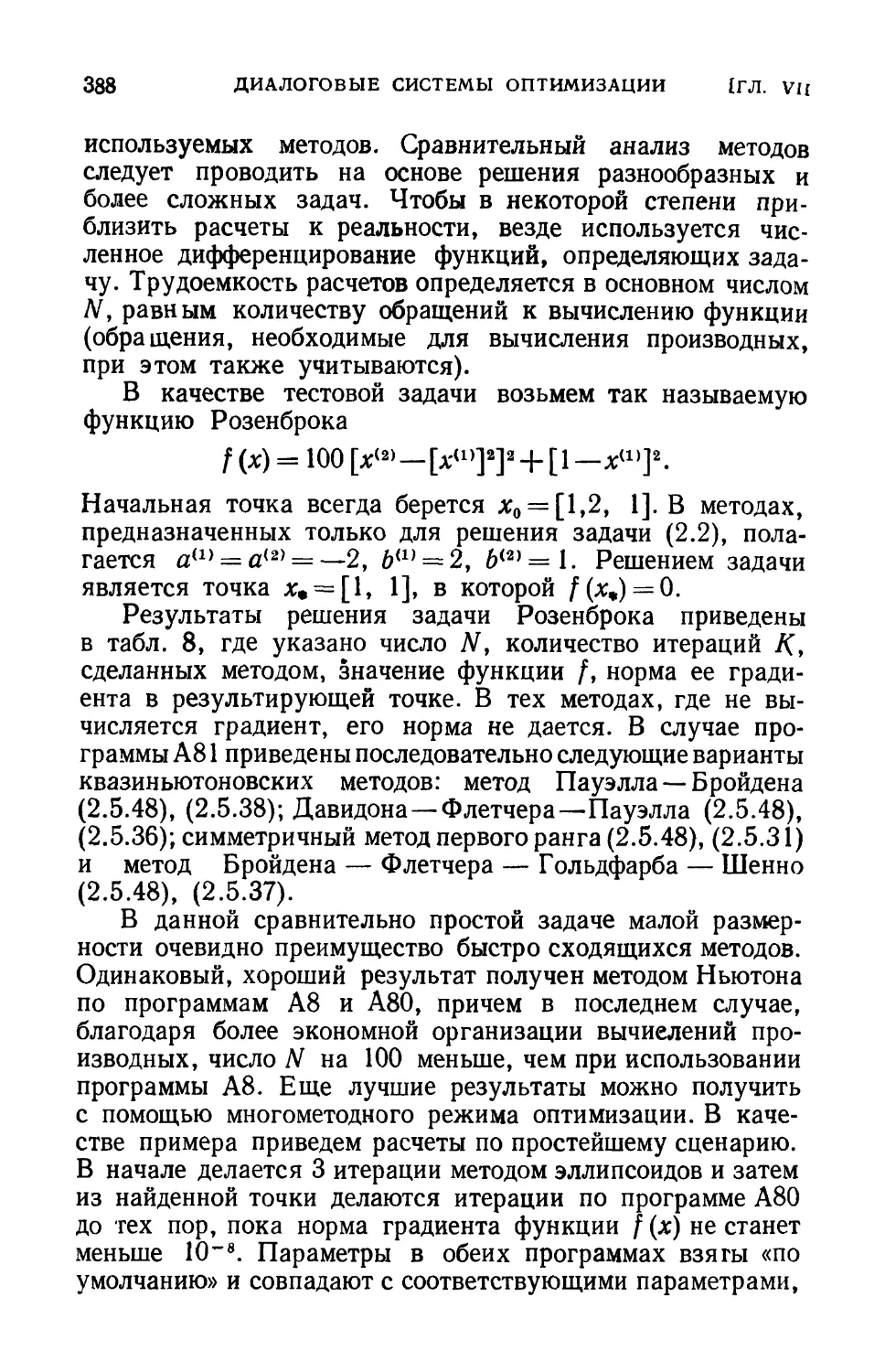

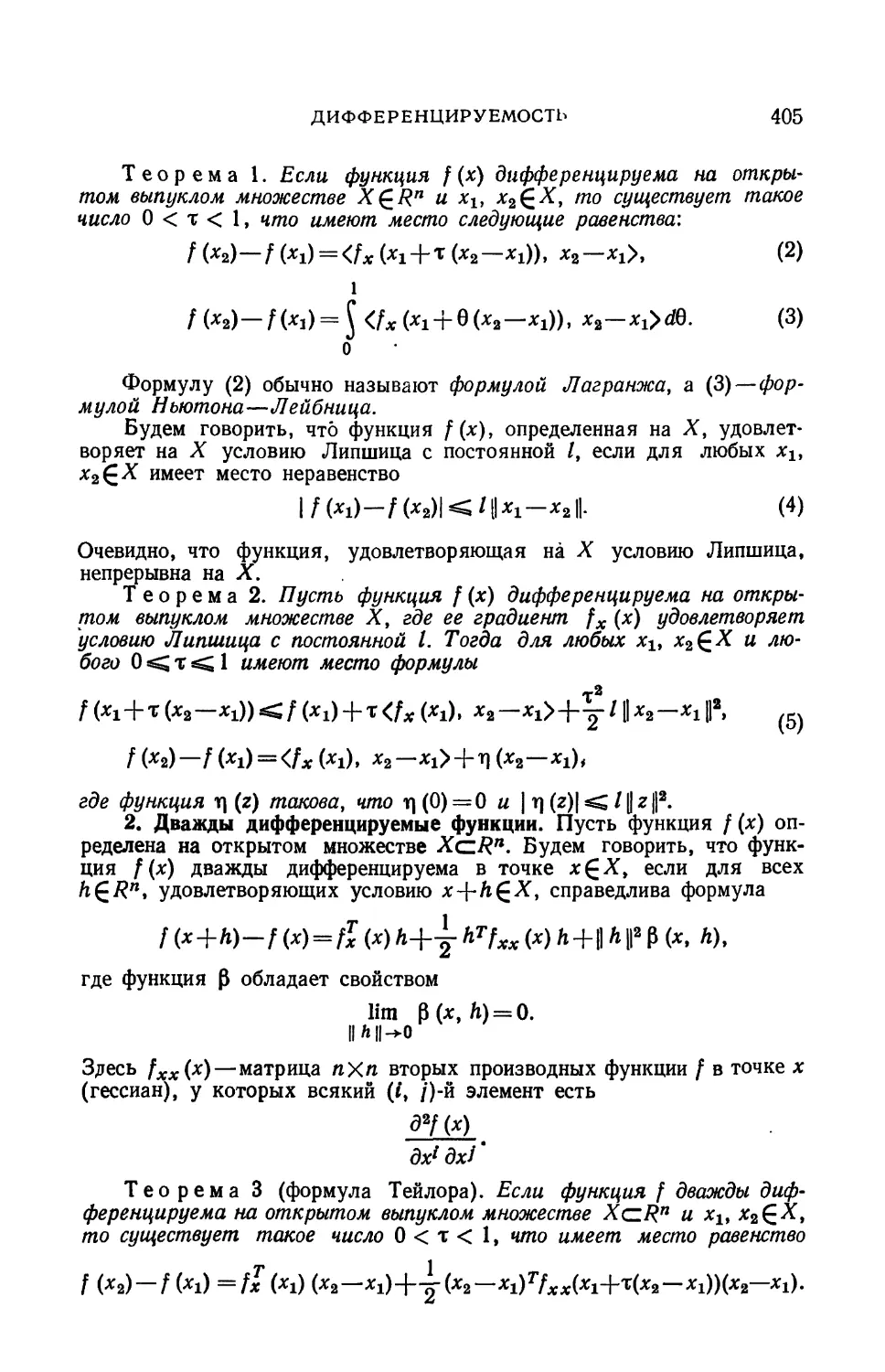

0<#<1. Стационарными точками будут х = 0, у = 0,25 и х = 09