Author: Дейтел Х.М. Дейтел П.Дж. Чофенс Д.Р.

Tags: программирование операционные системы компьютерные науки переводная литература издательство бином

ISBN: 978-5-9518-0290-3

Year: 2009

Text

Opera ting Sys tems

Th ird Edition

N.M. Deitel

Deitel & Associates, Inc.

P.J. Deitel

Deitel & Associates, Inc.

D.R. Choffnes

Deitel & Associates, Inc.

Prentice <,,

Hall

Upper Saddle, NJ 0745

Х.М. Деите/i, П.Дэ/с. Дейтел, Д.Р. Чофнес

Операционные

системы

Третье издание

Том 1

Основы и принципы

Перевод с английского

под редакцией

С.М. Молявко

Москва

Издательство БИНОМ

2009

1евод с английского

гкоА.В., Гемба О. В., Молявко А.С., Пугач Д.В.

М. Дейтел, П.Дж. Дейтел, Д.Р. Чофнес

Операционные системы. Основы и принципы: Третье издание. Пер. с англ. —

.: ООО «Бином-Пресс», 2009 г. — 1024 с.: ил.

В книге подробно рассмотрены основные принципы построения и функционирования

грационных систем. Для иллюстрации излагаемых основ приводятся многочисленные

>имеры из наиболее популярных сегодня операционных систем Linux и Microsoft Win-

>ws ХР. Разбираются используемые в ОС принципы управления процессами и потока-

и, реальной и виртуальной памятью, дисками и файлами. Подробно анализируются

вменяемые алгоритмы асинхронного параллельного выполнения, опасности взаимо-

юкировок и бесконечного откладывания, механизмы планирования загрузки процессора

; том числе и в мультипроцессорных системах). Контрольные вопросы, учебные приме-

fi и проекты позволяют использовать эту книгу в качестве пособия по университетскому

рсу операционных систем.

Рекомендуется студентам и специалистам, желающим поднять свой профессиональ-

_1Й уровень. Второй том книги посвящен сетям, безопасности и подробному разбору

ринципов построения Linux и Windows ХР.

Все права защищены. Никакая часть этой книги не может быть воспроизведена в любой форме

или любыми средствами, электронными или механическими, включая фотографирование, маг-

нитную запись или иные средства копирования или сохранения информации без письменного раз-

решения издательства.

Authorized translation from the English language edition, entitled Operating Systems, 3rd Edition by

Deitel, Harvey M.; Deitel, Paul J.; and Chofthes, David R., published by Pearson Education, Inc.,

publishing as Prentice Hall, Copyright ©.

ISBN 978-5-9518-0290-3 (pyc.)

ISBN 0-13-182827-4 (англ.)

© Pearson Education Inc.

© Издание на русском языке.

Издательство Бином, 2009

Содержание

Предисловие..............................................................13

Часть L Введение в аппаратные средства, программное обеспечение

и операционные системы...................................................38

Глава 1. Введение в операционные системы.................................41

1.1 Введение..........................................................43

1.2 Что такое операционная система?...................................44

1.3 Ранняя история; 40-е и 50-е годы..................................45

1.4 60-е годы.........................................................46

1.5 70-е годы.........................................................52

1.6 80-е годы.........................................................54

1.7 История сети Интернет и Всемирной Паутины.........................56

1.8 90-е годы.........................................................60

1.9 2000-й год и позже................................................66

1.10 Базы приложений..................................................68

1.11 Среда операционной системы.......................................69

1.12 Компоненты и задачи операционной системы.........................73

1.12.1 Ключевые компоненты операционной системы....................73

1.12.2 Задачи операционной системы.................................76

1.13 Архитектура операционных систем..................................78

1.13.1 Монолитная архитектура......................................79

1.13.2 Многоуровневая архитектура..................................81

1.13.3 Архитектура на основе микроядра........................... 83

1.13.4 Сетевые и распределенные операционные сйстемы...............85

Глава 2. Концепции аппаратных средств и программного обеспечения . . . 109

2.1 Введение....................................................... 112

2.2 Развитие аппаратных устройств....................................113

2.3 Аппаратные компоненты............................................116

2.3.1 Материнские платы...........................................116

2.3.2 Процессоры..................................................118

2.3.3 Системный таймер............................................120

2.3.4 Иерархия памяти.............................................121

2.3.5 Основная память.............................................123

2.3.6 Вторичные запоминающие устройства...........................125

2.3.7 Шины........................................................127

2.3.8 Прямой доступ к памяти......................................128

2.3.9 Периферийные устройства.....................................130

2.4 Поддержка функций операционных систем аппаратными средствами. . . 133

2.4.1 Процессор...................................................133

2.4.2 Таймеры и часы..............................................138

2.4.3 Начальная загрузка..........................................138

2.4.4 Технология Plug-and-Play....................................140

2.5 Кэширование и буферизация........................................141

2.6 Обзор программного обеспечения...................................143

2.6.1 Машинный язык и язык ассемблера . .'........................143

2.6.2 Интерпретаторы и компиляторы................................144

2.6.3 Языки программирования высокого уровня......................146

2.6.4 Структурное программирование................................147

2.6.5 Объектно-ориентированное программирование...................148

2.7 Интерфейсы прикладного программирования..........................149

2.8 Процессы компиляции, связывания и загрузки.......................151

2.8.1 Компиляция..................................................151

2.8.2 Связывание..................................................152

2.8.3 Загрузка....................................................158

6

Операциенные еиетемы (Удержание

7

2.9 Встроенное программное обеспечение...........................

2.10 Межплатформное программное обеспечение.....................161

Чисть II. Прбъгсеы з потоки. .....................................

Глава 3. Концепции процесса.............................................

3.1 Введение.........................................................

3.1.1 Определение процесса.........................................

3.2 Состояния процессов: жизненный цикл процесса.....................

3.3 Управление процессом.............................................

3.3.1 Переход процесса из состояния в состояние....................

3^2 Блоки управления процессом и дескрипторы процессов.............

3^3 Операции над процессами........................................

3.3.4 Приостановка и возобновление работы процесса.................

З^з'б Переключение контекста.......................................

3.4 Прерывания . ....................................................

3.4.1 Обработка прерываний.........................................

3.4.2 Классы прерываний............................................

3.5 Взаимодействие процессов.........................................

3.5.1 Сигналы......................................................

3.5.2 Передача сообщений...........................................

3.6 Учебный пример: процессы в UNIX..................................

Глава 4. Концепции потока...............................................

4.1 Введение.........................................................

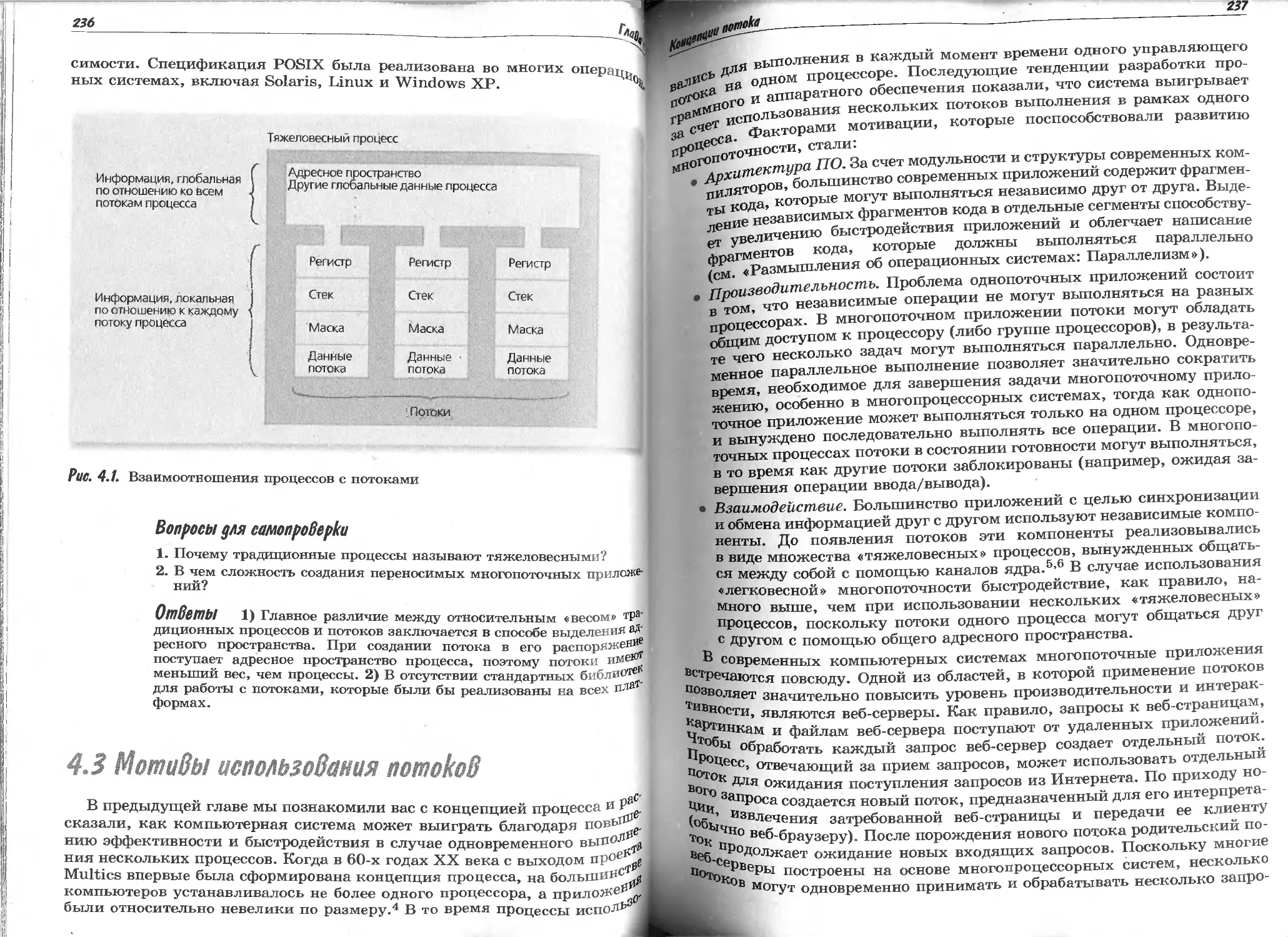

4.2 Определение потока...............................................

4.3 Мотивы использования потоков.....................................

4.4 Состояния потока: жизненный цикл потока..........................

4.5 Операции над потоками............................................

4.6 Модели потока....................................................

4.6.1 Потоки уровня пользователя...................................

4.6.2 Потоки уровня ядра...........................................

4.6.3 Совместное использование потоков уровня пользователя и уровня ядра . . . .

4.7 Вопросы реализации потоков.......................................

4.7.1 Доставка сигналов потоков....................................

4.7.2 Завершение работы потоков....................................

4.8 . POSIX и Pthread-потоки.........................................

4.9 Потоки в Linux..................................................

4.10 Потоки в Windows ХР............................................

4.11 Многозадачность в Java. Учебный пример, часть 1: знакомство

с потоками Java......................................................

183

185

186

188

189

190

192

194

196

199

200

202

205

208

208

209

212

231

233

235

236

239

241

243

243

245

247

251

251

255

255

258

260

264

Глава 5. Асинхронное параллельное выполнение............................

5.1 Введение.........................................................

5.2 Взаимоисключение.................................................

5.2.1 Многозадачность в Java. Учебный пример, часть 2: отношение

производитель-потребитель в Java..................................

5.2.2 Критические участки.........................................

5.2.3 Примитивы взаимоисключения..................................

5.3 Реализация примитивов взаимоисключения...........................

5.4 Программные решения проблемы взаимоисключения....................

5.4.1 Алгоритм Деккера............................................

5.4.2 Алгоритм Питерсона..........................................

5.4.3 Взаимоисключение для п потоков: алгоритм Лэмпорта...........

5.5 Аппаратные решения проблемы взаимоисключения.....................

5.5.1 Запрет прерываний...........................................

5.5.2 Команда Test-and-Set........................................

5.5.3 Команда Swap................................................

5.6 Семафоры.........................................................

5.6.1 Реализация взаимоисключения с помощью семафоров.............

5.6.2 Синхронизация потоков с помощью семафоров............... .

5.6.3 Считающие семафоры...................................... .

5.6.4 Реализация семафоров........................................

281

283

283

285

293

205

296

29?

297

308

313

319

319

320

323

326

327

328

330

331

Глава 6. Параллельное программирование...................................349

6.1 Введение..........................................................351

6.2 Мониторы..........................................................354

6.2.1 Переменные-условия...........................................356

6.2.2 Простое распределение ресурсов с помощью мониторов...........358

6.2.3 Пример монитора: кольцевой буфер.............................359

6.2.4 Пример монитора: читатели и писатели.........................363

6.3 Мониторы на языке Java............................................366

6.4 Многозадачность в Java. Учебный пример, часть 3: отношение

производитель-потребитель в Java......................................368

6.5 Многозадачность в Java. Учебный пример, часть 4: кольцевой буфер в Java. . 376

Глава 7. Взаимоблокировки и бесконечное откладывание..................

7.1 Введение.......................................................

7.2 Примеры взаимоблокировок.......................................

7.2.1 Транспортная пробка как пример взаимоблокировки............

7.2.2 Простой пример взаимоблокировки при распределении ресурсов . . .

7.2.3 Взаимоблокировки в системах спулинга.......................

7.2.4 Пример: Обедающие философы...................................

7.3 Похожая проблема — бесконечное откладывание....................

7.4 Концепция ресурсов.............................................

7.5 Четыре необходимых условия возникновения взаимоблокировки. . . .

7.6 Решения проблемы взаимоблокировок..............................

7.7 Предотвращение взаимоблокировок................................

7.7.1 Нарушение условия ожидания дополнительных ресурсов.........

7.7.2 Нарушение условия неперераспределяемости...................

7.7.3 Нарушение условия кругового ожидания.......................

7.8 Обход взаимоблокировок с помощью алгоритма банкира.............

7.8.1 Пример надежного состояния.................................

7.8.2 Пример ненадежного состояния...............................

7.8.3 Пример перехода из надежного состояния в ненадежное........

7.8.4 Распределение ресурсов согласно алгоритму банкира..........

7.8.5 Недостатки алгоритма банкира...............................

7.9 Обнаружение взаимоблокировок...................................

7.9.1 Графы распределения ресурсов...............................

7.9.2 Приведение графов распределения ресурсов...................

7.10 Восстановление после взаимоблокировок.........................

7.11 Стратегии борьбы с взаимоблокировками в современных

и будущих системах.................................................

Глава 8. Планирование работы процессора...............................

8.1 Введение........................................

8.2 Уровни планирования............................................

8.3 Планирование с приоритетным вытеснением и без него.............

8.4 Приоритеты......................................

8.5 . Цели планирования............................................

8.6 Критерии планирования..........................................

8-7 Алгоритмы планирования.........................................

о'1'l Планирование по принципу FIFO (первым-пришел-первым-ушел) . . . .

R 7 2 Циклическое планирование (RR)..............................

8 7 4 Планирование по принципу SPF (кратчайший процесс первым) . . . .

.4 Планирование по принципу HRRN (по наибольшему относительному

395

397

398

398

401

402

404

406

407

409

410

411

412

414

415

418

420

421

422

423

424

425

426

427

429

. 432

455

. 457

. 458

. 460

. 463

. 464

. 467

. 469

. 469

. 470

. 474

8 7 к Дремеии реакции).......................Г. ''.7.Г7Г..''. . . 476

8* 7 к Л?аниРование по принципу SRT (по наименьшему остающемуся времени) . . 476

о?- Многоуровневые очереди с обратной связью.........................478

8 8 IT ' Планирование по принципу FSS (справедливого раздела)...........482

8 0 ггланиР°вание по сроку завершения ..................................485

8 1 л 1ланировйние реального времени....................................487

Планирование потоков Java..........................................490

8

Операционные системы

Содержание

9

Я2

515

517

517

518

521

523

524

525

526

527

529

530

537

537

541

543

561

563

566

570

574

578

Часть III. Реальная и Виртуальная память.................. ..............

Глава 9. Оперативная память. Организация и управление.................;

9.1 Введение..........................................................

9.2 Организация памяти................................................

9.3 Управление памятью................................................

9.4 Иерархия памяти...................................................

9.5 . Стратегии управления памятью....................................

9.6 Выделение непрерывных и фрагментированных участков памяти ....

9.7 Выделение непрерывных блоков в однопользовательских системах ....

9.7.1 Оверлеи......................................................

9.7.2 Защита в однопользовательских системах.......................

9.7.3. Однопоточные пакетные системы...............................

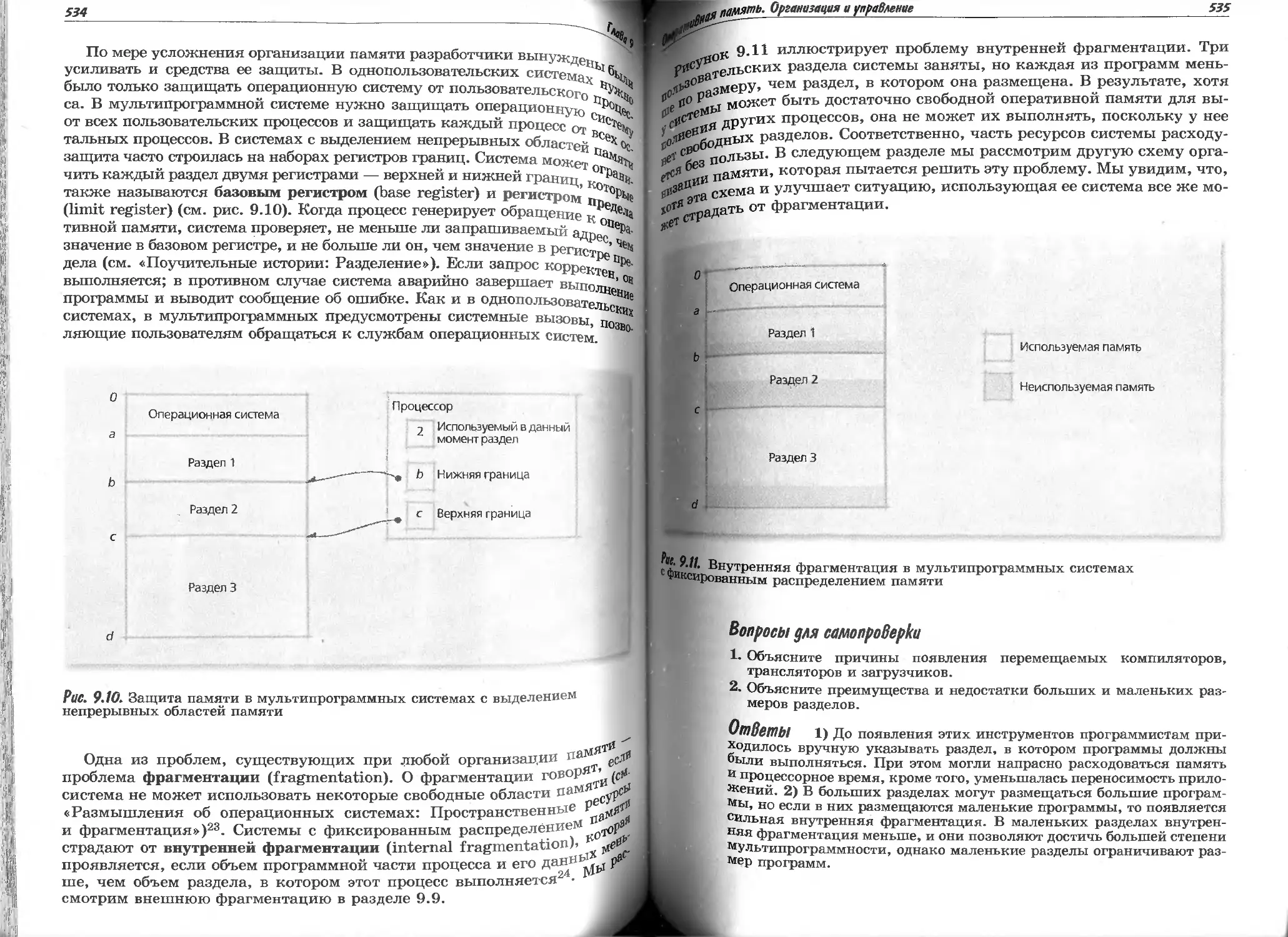

9.8 Мультипрограммные системы с фиксированным распределением памяти. .

9.9 Мультипрограммные системы с изменяемым распределением памяти. . .

9.9.1 Характеристики изменяемых разделов...........................

9.9.2 Стратегии размещения в памяти................................

9.10 Мультипрограммные системы с подкачкой............................

Глава 10. Организация виртуальной памяти.................................

10.1 Введение.........................................................

10.2 Виртуальная память: основные понятия.......>.....................

10.3 . Размещение блоков..............................................

10.4 Страничные системы...............................................

10.4.1 Трансляция адресов прямым отображением в страничных системах. . .

10.4.2 Трансляция адресов ассоциативным отображением в страничных

системах..........................................................

10.4.3 Трансляция адресов смешанным прямым/ассоциативным

отображением в страничных системах................................

10.4.4 Многоуровневые страничные таблицы...........................

10.4.5 Обращенные страничные таблицы ..............................

10.4.6 Разделение ресурсов в страничной системе....................

10.5 Сегментация.....................................................

10.5.1 Трансляция адресов прямым отображением в сегментных системах. . .

10.5.2 Разделение ресурсов в сегментных системах...................

10.5.3 Защита и контроль доступа в сегментных системах.............

10.6 Сегментно-страничные системы....................................

10.6.1 Динамическая трансляция адресов в сегментно-страничных системах . »

10.6.2 Разделение ресурсов и защита в сегментно-страничной системе.

10.7 Практический пример: Виртуальная память архитектуры

IA-32 фирмы Intel...................................................

Глава 11. Управление виртуальной памятью.................................

11.1 Введение........................................................

11.2 Локальность.....................................................

11.3 Подкачка по требованию..........................................

11.4 Предварительная подкачка........................................

11.5 Замена страниц..................................................

11.6 Стратегии замены страниц........................................

11.6.1 Замена случайных страниц...................................

11.6.2 Стратегия замены «первый вошел — первый вышел» (FIFO)......

11.6.3 Аномалия FIFO..............................................

11.6.4 Стратегия замены дольше всего не использовавшихся страниц (LRU) . .

11.6.5 Стратегия замены реже всего используемых страниц (LFU).....

11.6.6 Стратегия замены давно не используемых страниц (NUR)... . .

11.6.7 Модификации стратегии FIFO: стратегия «второго шанса»

и круговая стратегия.............................................

11.6.8 Стратегия замены дальней страницы..........................

11.7 Модель рабочих наборов.........................................

11.8 Стратегия замены страниц по частоте страничных

промахов (PFF).....................................................

11.9 Освобождение страниц..............................’............

11.10 Размер страниц................................................

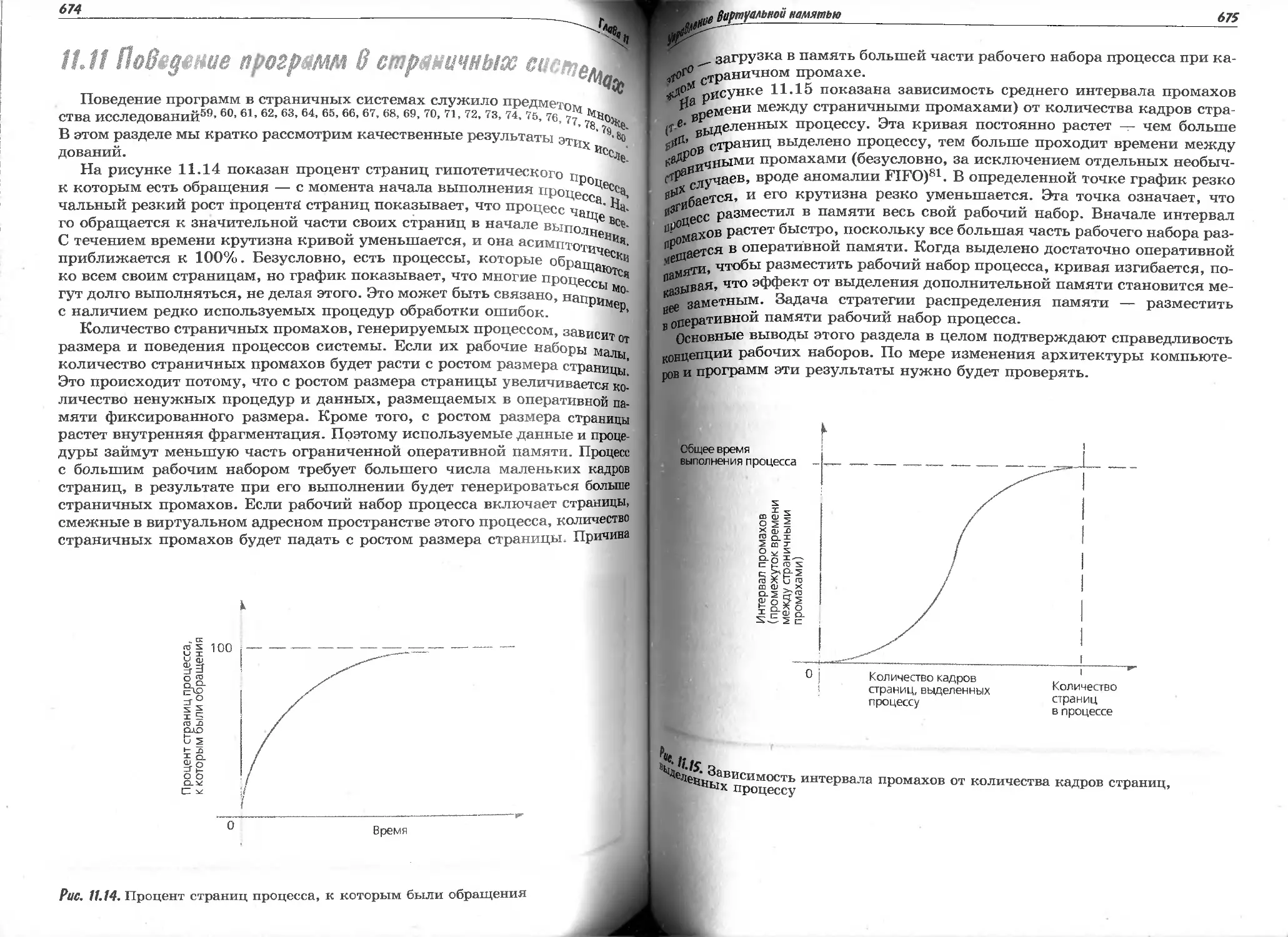

11.11 Поведение программ в страничных системах......................

580

581

584

587

591

594

597

599

601

604

605

609

611

641

643

644

645

648

650

651

652

652

654

655

657

657

660

661

662

668

670

670

674

уровня 0 (разделение данных)...................

уровня 1 (зеркальное отображение)..............

уровня 2 (побитовый контроль с коррекцией

уровня 3 (побитовый XOR-контроль и коррекция)

______Л а/!!.—-- "

11.12 Глобальная и локальная замена страниц........................

11.13 Практический пример: замена страниц в Linux..................

Часть IV. Внешние накопители, файлы и базы данных. ...»................

Глава 12. Оптимизация производительности дисковых накопителей . .

12.1 Введение...........................•_.....................

12.2 Развитие вторичных запоминающих устройств................

12.3 Характеристики накопителей с подвижными головками.........

12.4 Почему необходима диспетчеризация дисковых операций ....

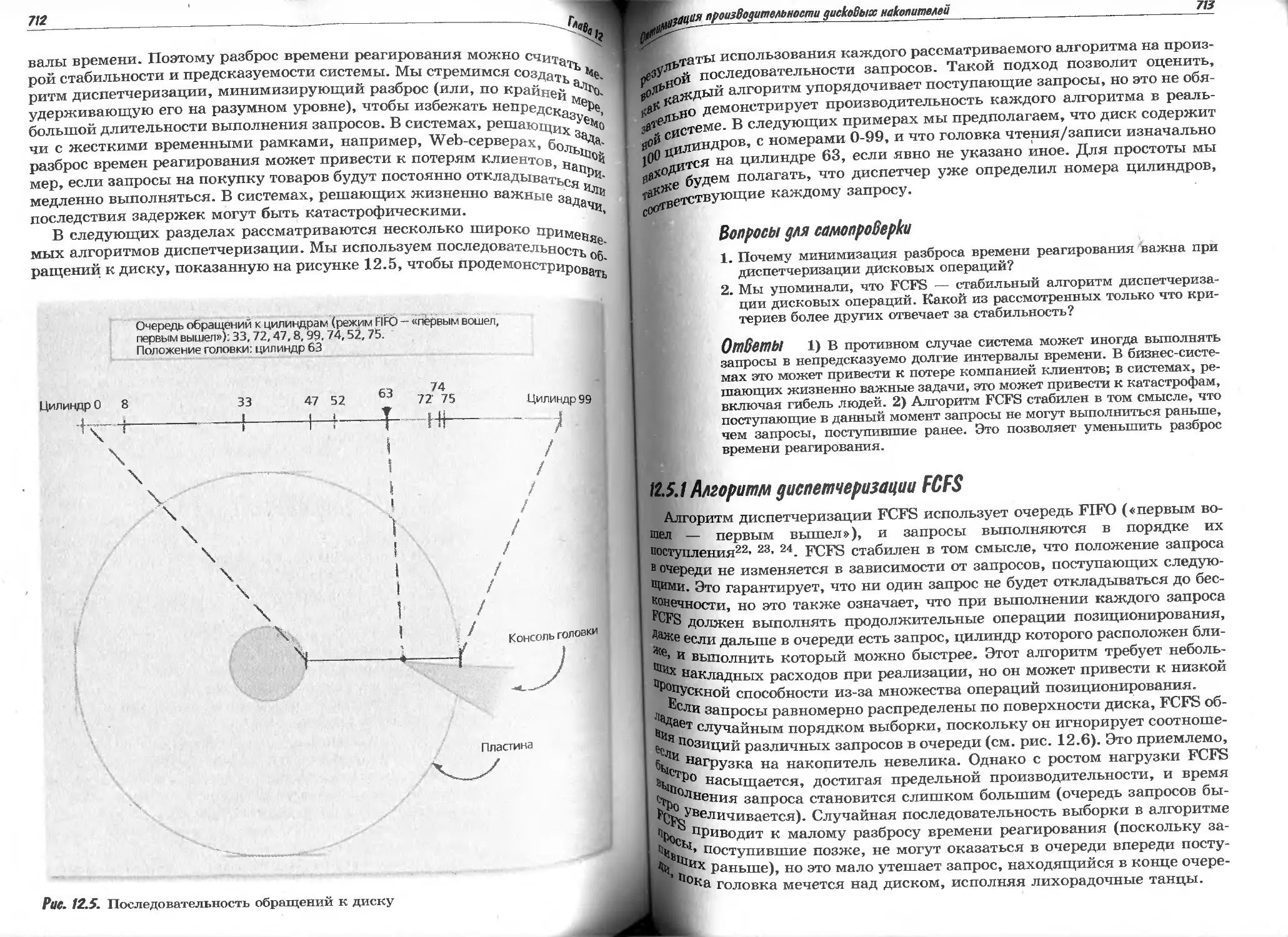

12.5 Диспетчеризация дисковых операций........................

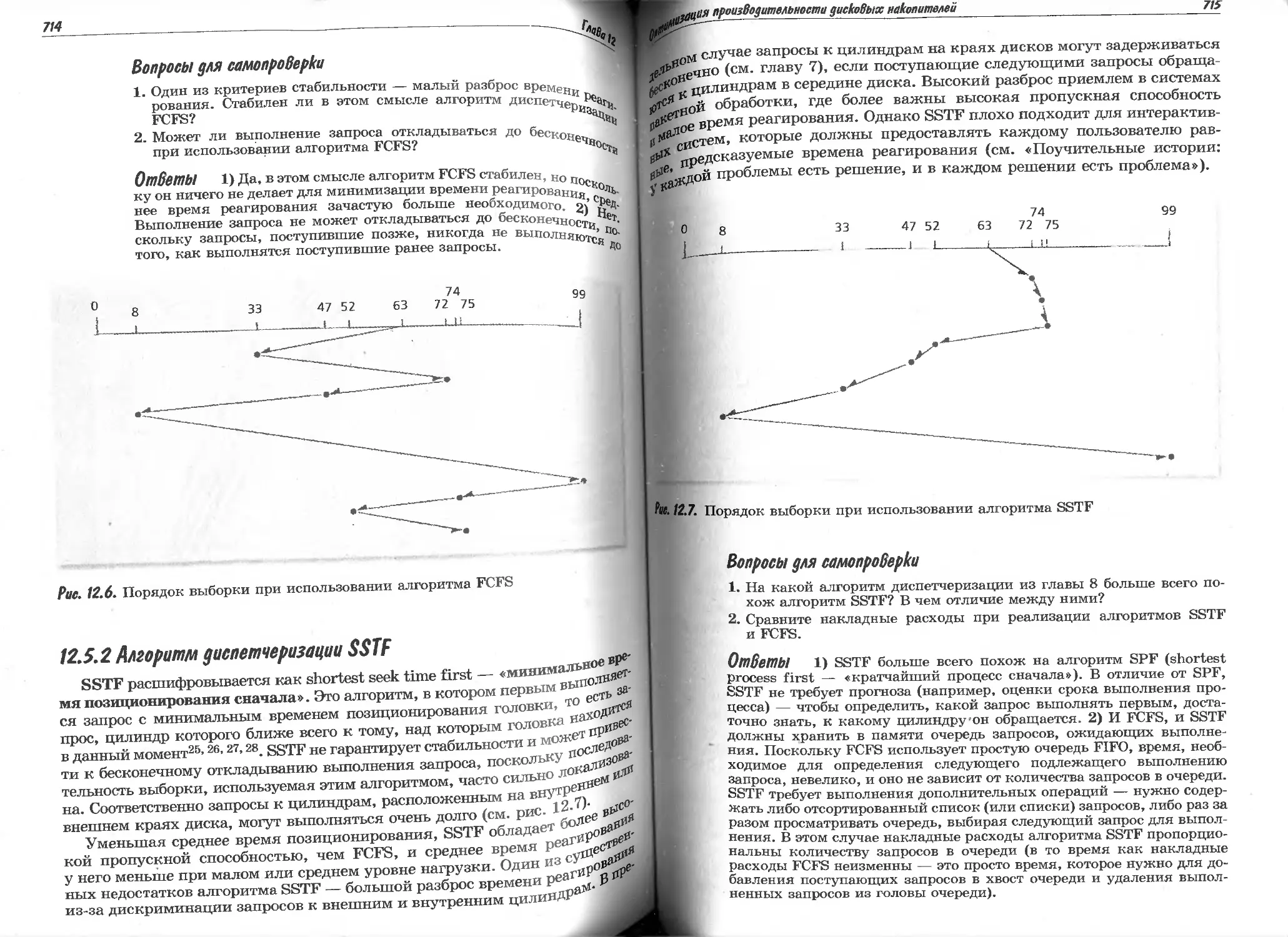

12.5.1 Алгоритм диспетчеризации FCFS........................

12.5.2 Алгоритм диспетчеризации SSTF........................

12.5.3 Алгоритм диспетчеризации SCAN...........................

12.5.4 Алгоритм диспетчеризации C-SCAN......................

12.5.5 Алгоритм диспетчеризации FSCAN и N-шаговый SCAN......

12.5.6 Алгоритм диспетчеризации LOOK и C-LOOK...............

12.6 Оптимизация по вращению..................................

12.6.1 Алгоритм диспетчеризации SLTF........................

12.6.2 Алгоритмы диспетчеризации SPTF и SATF................

12.7 Системные соображения....................................

12.8 Кэширование и буферизация................................

12.9 Другие приемы повышения производительности накопителей ....

12.10 RAID-массивы............................................

12.10.1 Обзор RAID-массивов.................................

12.10.2 RAID-массивы

12.10.3 RAID-массивы

12.10.4 RAID-массивы

по Хеммингу)

12.10.5 RAID-массивы ______v_________. .._

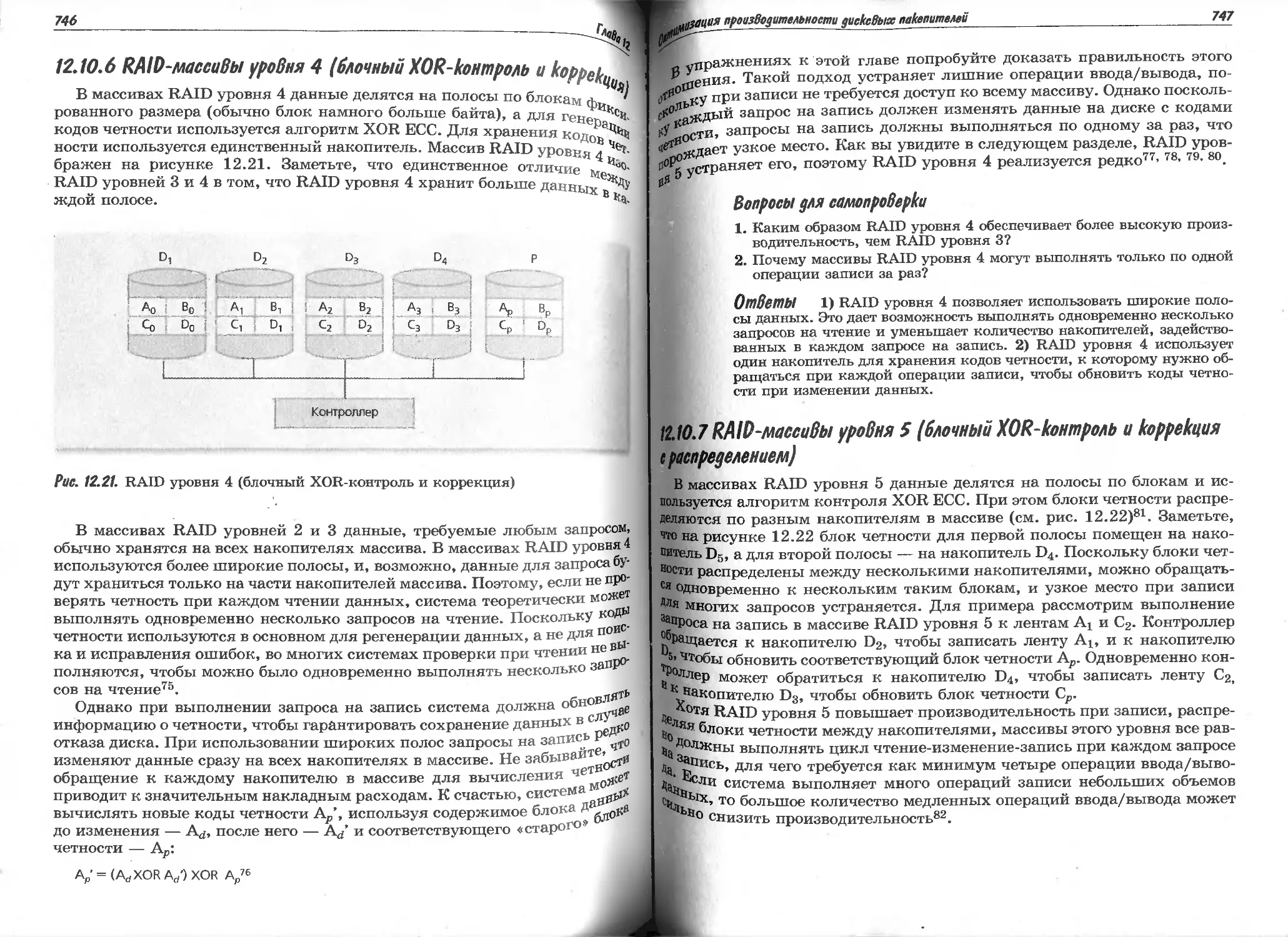

12.10.6 RAID-массивы уровня 4 (блочный XOR-контроль и коррекция) .

12.10.7 RAID-массивы уровня 5 (блочный XOR-контроль и коррекция

с распределением)...........................................

Глава 13. Файловые системы и базы данных..........................

13.1 Введение..................................................

13.2 Иерархия данных...........................................

13.3 Файлы.....................................................

13.4 Файловые системы..........................................

13.4.1 Директории............................................

13.4.2 Метаданные............................................

13.4.3 Монтирование..........................................

13.5 Организация файлов........................................

13.6 Размещение файлов.........................................

13.6.1 Непрерывное размещение файлов.........................

13.6.2 Размещение файлов в виде связных списков..............

13.6.3 Табличное фрагментированное размещение................

13.6.4. Индексированное фрагментированное размещение.........

13.7 Управление свободным пространством........................

13.8 Контроль доступа к файлам.................................

13.8.1 Матрица контроля доступа..............................

13.8.2 Контроль доступа по классам пользователей.............

13.9 Методы доступа к данным...................................

13.10 Защита целостности данных................................

13.10.1 Резервное копирование и восстановление...............

13-10.2 Целостность данных и журнальные файловые системы.....

13.11 Файловые серверы и распределенные системы................

13.12 Системы баз данных.......................................

13.12.1 Преимущества систем баз данных.......................

13.12.2 Доступ к данным......................................

13.12.3 Реляционная модель базы данных.......................

13.12.4 Операционные системы и системы баз данных............

676

677

700

703

705

705

706

710

711

713

714

716

717

719

720

722

722

723

726

728

730

734

734

738

739

741

744

746

. 747

. 777

. 779

. 779

. 781

. 782

. 784

. 789

. 791

. 793

. 794

. 795

. 796

. 798

. 801

. 805

. 807

. 807

. 809

. 810

. 811

. 811

. 814

. 818

. 819

. 819

. 820

. 821

. 824

to

Операционные системы

848

851

853

853

855

856

859

859

860

862

864

865

867

868

870

871

872

873

873

874

875

877

880

883

907

910

912

913

915

922

924

924

925

926

928

929

930

931

933

934

936

937

939

942

944

945

950

951

952

953

955

956

958

962

962

Часть И Производительность, процессоры мультипроцессорные системы.........

Глава 14. Производительность и архитектура процессоров....................

14.1 Введение.........................................................

14.2 Тенденции, влияющие на результирующую производительность.........

14.3 Назначение мониторинга и оценки производительности...............

14.4 Показатели производительности....................................

14.5 Методы оценки производительности.................................

14.5.1 Трассировка и профилирование.................................

14.5.2 Хронометраж и контрольные задачи микроуровня.................

14.5.3 Оценка производительности относительно приложения............

14.5.4 Аналитические модели.........................................

14.5.5 Наборы контрольных задач.....................................

14.5.6 Синтетические программы......................................

14.5.7 Моделирование................................................

14.5.8 Мониторинг производительности................................

14.6 Узкие места и насыщение..........................................

14.7 Обратные связи..............................................

14.7.1 Отрицательная обратная связь.................................

14.7.2 Положительная обратная связь.................................

14.8 Параметры производительности и архитектура процессора............

14.8.1 Полный набор команд..........................................

14.8.2 Архитектура процессоров с сокращенным набором команд.........

14.8.3 Второе поколение RISC-процессоров............................

14.8.4 Технология параллельной обработки команд с явным

параллелизмом (EPIC)................................................

Глава 15. Многопроцессорность.............................................

15.1 Введение.........................................................

15.2 Многопроцессорные архитектуры....................................

15.2.1 Классификация последовательных и параллельных архитектур.....

15.2.2 Схемы соединений процессоров.................................

15.2.3 Тесносвязанные и слабосвязанные системы......................

15.3 Организации многопроцессорных операционных систем................

15.3.1 Схема ведущий/ведомый........................................

15.3.2 Схема с раздельными ядрами...................................

15.3.3 Симметричная схема...........................................

15.4 Архитектуры доступа к памяти.....................................

15.4.1 Архитектура однородного доступа к памяти (UMA)...............

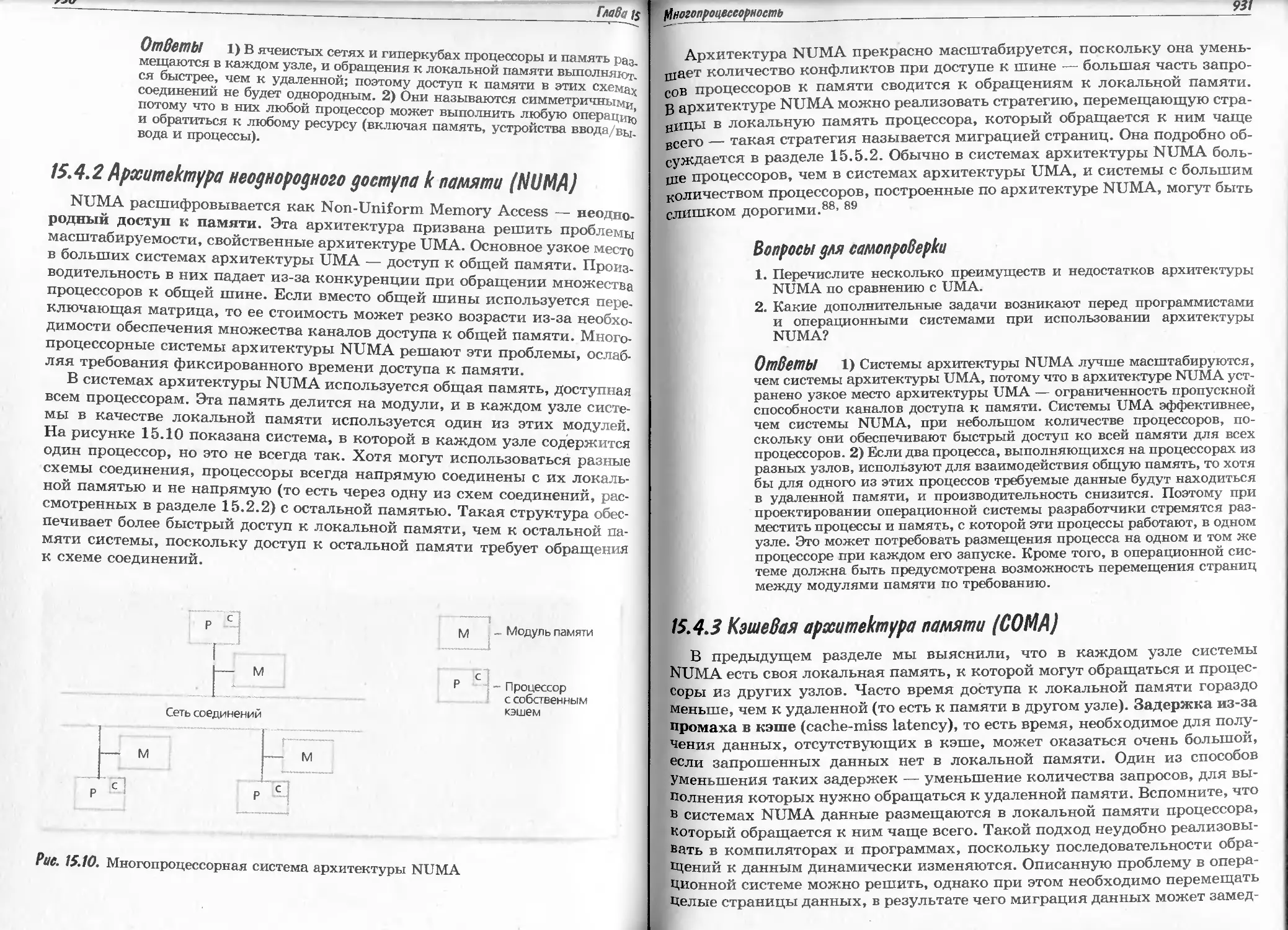

15.4.2 Архитектура неоднородного доступа к памяти (NUMA)............

15.4.3 Кэшевая архитектура памяти (СОМА)............................

15.4.4 Архитектура без доступа к удаленной памяти NORMA.............

15.5 Разделение памяти в многопроцессорных системах...................

15.5.1 Когерентность кэша...........................................

15.5.2 Репликация и миграция страниц................................

15.5.3 Общая виртуальная память.....................................

15.6 Планирование в многопроцессорных системах........................

15.6.1 Задачно-независимые алгоритмы планирования...................

15.6.2 Задачно-ориентированные алгоритмы планирования...............

15.7 Миграция процессов...............................................

15.7.1 Процедура миграции процесса . ...............................

15.7.2 Концепции миграции процессов ................................

15.7.3 Стратегии миграции процессов.................................

15.8 Балансировка нагрузки............................................

15.8.1 Статическая балансировка нагрузки............................

15.8.2 Динамическая балансировка нагрузки.............'.............

15.9 Взаимное исключение в многопроцессорных системах.................

15.9.1 Спин-блокировки..............................................

15.9.2 Блокировки с усыплением/пробуждением.........................

15.9.3 Блокировки чтения/записи.....................................

Предметный указатель....................................98$

Предисловие редактора

перевода

Учебник, который можно смело рекомендовать в качестве

базового курса для отечественных университетов

по специальности «Операционные системы».

Хороших книг всегда мало. Хороших учебников мало вдвойне. Эта кни-

га, безусловно, представляет собой хороший учебник по операционным

системам. Авторы поставили перед собой трудную цель и успешно ее дос-

тигли. Они рассмотрели в этой книге практически все вопросы из области

проектирования операционных систем. И речь идет не просто о том, что

подробно разбираются с теоретической точки зрения принципы функцио-

нирования компонентов и техника выбора подходящих алгоритмов. Суще-

ственным достоинством книги является наличие большого числа приме-

ров, иллюстрирующих теорию построения операционных систем на двух

наиболее популярных сегодня операционным системах конкурирующих

лагерей: Linux и Microsoft Windows ХР. К достоинствам книги следует от-

нести не только ее «ширину» в плане охвата различных программных ре-

шений, но и «глубину»: авторы внимательно рассматривают аппаратный

и микропрограммный фундамент реализации операционных систем —

стык между «железом» и программами — то узкое место, которое часто

сводит на нет преимущества отдельных программных решений, принятых

без учета возможностей аппаратуры.

Любой преподаватель университета, обучающий студентов информатике

и вычислительной технике, знает, что придумать подходящий пример про-

гРаммы, схемы, алгоритма или базы данных не сложно. Гораздо сложнее

найти иллюстрирующее проблему реальное проектное решение, которое при-

меняется на практике в бизнесе или в науке. Такое решение должно подтвер-

дить свою жизнеспособность, послужить предметом придирчивого изучения

со стороны конкурентов, проявить хорошие и плохие стороны, т.е. действи-

тельно стать сконцентрированным выражением человеческого интеллекта

11 Достижений технологии. Находить такие примеры трудно даже для препо-

давателей, отслеживающих передний фронт прогресса в своей области, а что

УЛсе говорить о студентах, которые зачастую даже не знают направления по-

иска. Здесь предлагаемая книга может оказать им существенную помощь,

каждая глава снабжена богатым списком рекомендуемой литературы,

Онерацаониые систем^

а ссылки на соответствующие первоисточники введены в основной текст глу

вы. В список литературы входят как фундаментальные работы классику

(Дейкстры, Кнута, Мура), так и свежие статьи и технические отчеты о по

следних достижениях в области операционных систем. Самые последние све

дения доступны, конечно, в Интернете, и каждая глава завершается списков

полезных Web-ссылок.

Предисловие

Нельзя не отметить тщательную методическую проработку материалу,

книги. Процесс изучения любого предмета предусматривает контроль (ид^

самоконтроль) знаний. Авторы книги знают об этом и позаботились

о включении в каждую главу списка контрольных вопросов. Кроме этоц

списка каждый параграф завершается парой вопросов, позволяющих сис.

Довольно жить частями. Только объединять...

тематизировать приобретенные знания. Авторы книги также помня, Эдвард Морган Форстер

о том, что знания приобретаются для практического применения, поэтому

во все главы включены учебные и программные проекты, которые могу,

в отечественной учебной традиции рассматриваться как аналоги курсовы?

работ и проектов.

Учиться по хорошей книге интересно, но это труд, причем часто труд

нелегкий. Авторы позаботились о том, чтобы «скрасить тяжелые будни»

учащихся: в книгу наряду с основными сведениями включены биографии

корифеев вычислительной техники, размышления о правильности прин Добро пожаловать в мир операционных систем. Эта книга предназначе-

ципов построения операционных систем, исторические иллюстрации раз- на в основном для использования как пособие в одно- и двухсеместровых

личных взглядов на прогресс, цивилизацию и технологию. курсах по операционным системам (согласно определению этих курсов

Возможно, это предисловие выглядит как восторженная ода, но книга в самой свежей версии учебных планов АСМ/IEEE), изучаемым в универ-

того заслуживает: редактору уже давно не приходилось держать в руках ситетах студентами младших, старших и выпускных курсов. Кроме того,

переводной учебник, который можно было бы смело рекомендовать в каче- эта книга может пригодиться в качестве справочника системным програм-

стве базового курса для отечественных университетов по специальности мистам и разработчикам операционных систем.

«Операционные системы». В книге содержатся подробные обзоры двух наиболее важных операци-

В русском переводе книга выходит в двух томах. Первым том содержи: онных систем современности — Linux (глава 20) и Windows ХР (глава 21).

главы, посвященные общим вопросам и принципам: аппаратура и програм Эти операционные системы воплощают две противоположные парадигмы

мы, процессы и потоки, асинхронное параллельное выполнение и парал- развития операционных систем — соответственно, открытое, нелицензи-

лельное программирование, взаимоблокировки и бесконечное откладыва онное и закрытое, корпоративное. В обзоре Linux приведена история раз-

нив, планирование загрузки процессора, управление физической и вирту- вития ядра вплоть до версии 2.6. В обзоре Windows ХР описаны состав-

альной памятью, управление дисками и файлами, оптимизацш ляющие новейшей версии самой распространенной операционной системы

производительности, мультипроцессорные системы. Второй том включае! Для персональных компьютеров. Эти обзоры позволят вам сравнить раз-

в себя главы, посвященные сетевым и распределенным системам, вопросам Личные философии проектирования и реализации, используемые в реаль-

безопасности и подробному разбору принципов построения систем LinuJ но существующих операционных системах.

и Windows ХР.

И Linux, и Windows ХР представляют собой сложные, объемистые опе-

рационные системы с миллионами строк исходных кодов. Мы рассмотрим

С.М. МолявнС основные компоненты каждой из этих операционных систем. В обзорах

Рассматриваются вопросы, возникающие при работе с персональными

компьютерами, рабочими станциями, многопроцессорными машинами,

Распределенными и встраиваемыми системами, а также детально обсужда-

ется причины популярности Linux и других Unix-образных операцион-

ных систем с открытым исходным кодом в корпоративной среде.

В данном введении излагается подход к обучению, используемый

в третьем издании «Операционных систем», а также описаны ключевые

элементы содержимого книги и ее оформления. Мы рассмотрим вспомога-

тельные материалы, включенные в книгу. В разделе «Обзор книги» кратко

°писаны аспекты операционных систем, рассматриваемые в книге.

14

Операционныесистемы

Третье издание «Операционных систем» рецензировалось многими из.

вестными учеными и специалистами промышленности; имена этих люде?}

и должности, занимаемые ими, перечислены в разделе «Благодарности».

Если при чтении этой книги у вас возникнут какие-либо вопросы, пожа-

луйста, свяжитесь с нами по электронной почте deitel@deitel.com; мы бу.

дем отвечать на письма по мере возможности. Кроме того, посетите нагц

сайт в Интернете, www.deitel.com, и подпишитесь на новостной бюллетень

Deitel® Buzz Online ПО адресу www.deitel.com/newsletter/subscribe.html.

С помощью нашего сайта и новостного бюллетеня мы сообщаем нашим читате-

лям о новых публикациях и услугах. Раздел сайта www. deitel. com/books/os3e

посвящен третьему изданию «Операционных систем». В этом разделе мы

регулярно публикуем различные вспомогательные материалы, полезные

для преподавателей и учащихся, включая схемы, обновления, сведения

о найденных ошибках, предлагаемые исследовательские проекты (группо-

вые проекты, проекты для исследований под руководством предподавате-

лей и тезисы) и библиографию к отдельным главам книги. Издательство

Prentice Hall также поддерживает в Интернете страницу, посвященную этой

книге, по адресу www.prenhall.com/deitel.

Оформление книги

В третьем издании «Операционных систем» используется совершенно

новый двухцветный стиль оформления, основой для которого послужили

работы Леонардо да Винчи. Определения ключевых терминов выделяются

полужирным шрифтом, чтобы их легко было заметить в тексте.

Особенности третьего издания ((Операционных

система

В третьем издании «Операционных систем» включено множество новых

сведений. Кроме того, мы пересмотрели и обновили материалы, присутство-

вавшие в предыдущих изданиях. Повышенное внимание, уделенное в книге

новым технологиям и проблемам, связанным с распределенными вычисле-

ниями, выделяет книгу на фоне других, посвященных операционным систе-

мам. В книгу добавлено несколько новых разделов, посвященных встраи-

ваемым системам, системам реального времени и распределенным систе-

мам. Ключевые элементы и особенности этого издания перечислены ниже-

• Содержимое книги соответствует всем требованиям курсов АСМ/1ЕЕЕ

СС2001 по операционным системам.

• Рассмотрены все упомянутые в СС2001 темы, касающиеся операцион-

ных систем, за исключением языков сценариев для оболочек.

Обновлено введение в аппаратуру, в него включены вопросы исполь-

зования новейших технологий и их влияния на развитие операцион-

ных систем.

15

Описаны задачи управления процессами, потоками, памятью и дис-

ковыми накопителями, отражающие потребности современных при-

ложений.

Рассмотрены системы общего назначения и концепции, существен-

ные для систем реального времени, встраиваемых и суперскалярных

архитектур.

Изложены основные методики оценки, позволяющие эффективно

проводить сравнительный анализ компонентов операционных систем.

Подробно рассмотрены сетевые концепции.

Всесторонне обсуждаются вопросы, связанные с безопасностью,

включая последние достижения в области механизмов аутентифика-

ции, протоколов безопасности, антивирусных средств, методов кон-

троля доступа и безопасности беспроводных сетей.

Приведен подробный обзор распределенных вычислительных систем

и отдана дань грандиозному влиянию Интернета и World Wide Web

на вычисления и операционные системы.

Рассмотрены элементы архитектуры Intel®.

Книга включает множество диаграмм, таблиц, примеров работающих

программ, фрагментов псевдокода и алгоритмов.

Отдельная глава посвящена потокам.

Многие примеры в книге написаны на псевдокоде с синтаксисом, по-

хожим на язык Java. Авторы учитывают широкое распространение

языков C/C++/Java — предполагается, что большинство изучающих

операционные системы владеют хотя бы одним из этих языков.

В книгу включены задачи по потокам с решениями в виде фрагментов

псевдокода и программ на языке Java, демонстрирующие основные

моменты, связанные с многопоточностью. Эти решения позволяют

преподавателям излагать материал так, как они сочтут необходимым.

Java впервые используется в этом издании книги, и ее применение

в обучении необязательно. Чтобы получить самую свежую версию

Java, посетите страницу java.sun.com/j2se/downloads.htnil. На

этой странице содержится ссылка на инструкции по установке Java

на компьютер.

Рассмотрены вопросы управления многопроцессорными системами.

Книга содержит новые разделы по диспетчеризации потоков и дис-

петчеризации в реальном времени.

Рассмотрены RAID-системы.

Приведен практический пример по процессам UNIX.

В книгу включены разделы с новейшими сведениями по стратегиям

диспетчеризации памяти и дисковых накопителей.

Важная тема ввода/вывода рассматривается во многих главах — пре-

жде всего в главах 2, 12, 13 и главах, посвященных отдельным опера-

ционным системам (20 и 21).

730 вопросов для самопроверки с ответами (обычно по 2 вопроса на

Раздел), позволяющих немедленно проверить усвоение прочитанного.

Обширный список использованных источников в конце каждой главы.

Операционные системы

16

Подход к ofy “шию

Книга разделена на восемь частей, и каждая часть состоит из взаимо-

связанных глав. Вот список частей:

1. Введение в аппаратные средства, программное обеспечение и опера-

ционные системы

2. Процессы и потоки

3. Реальная и виртуальная память

4. Внешние накопители, файлы и базы данных

5. Производительность, процессоры и мультипроцессорные системы

6. Сети и распределенные вычисления

7. Безопасность

8. Учебные примеры по операционным системам

Цитаты

В начале каждой главы приводится несколько цитат. Некоторые цита-

ты носят юмористический характер, некоторые — философский, а некото-

рые представляют собой подсказки к содержимому главы. Многие читате-

ли сообщали нам, что им нравится искать взаимосвязь между цитатами

и материалом глав. Смысл некоторых цитат может стать понятным вам

только после прочтения главы.

Цели

После цитат в начале каждой главы кратко описываются цели, пресле-

дуемые в этой главе. Прочтя главу, еще раз взгляните на список целей

и попытайтесь определить, достигли ли вы их.

Краткое содержание главы

Содержание главы позволяет разобраться, какой материал содержится

в главе и выбрать оптимальную последовательность его изучения.

Разделы и вопросы для самопроверки

Каждая глава состоит из небольших по размеру разделов, каждый из

которых посвящен какому-нибудь вопросу, имеющему отношение к опера-

ционным системам. В конце почти каждого раздела приведены два вопроса

для самопроверки с ответами. Эти вопросы позволят вам проверить свой

знания и убедиться в усвоении материала раздела. Кроме того, эти вопро-

сы готовят вас к упражнениям, предлагаемым в конце главы, и к тес-

там/экзаменам по курсу. На некоторые из вопросов нельзя ответить, ис-

пользуя только материал, изложенный в соответствующих разделах; что-

бы ответить на них, вам понадобится найти дополнительную информацию.

Предисловие

17

Ключевые термины

При первом упоминании каждого термина он выделяется полужирным

шрифтом. Кроме того, в каждой главе есть терминологический словарь,

котором собраны все ключевые термины из этой главы с их определения-

ми (в книге определено более 1800 терминов). В конце книги есть общий

словарь, в котором термины расположены в алфавитном порядке. Этот

словарь — превосходный справочный материал.

Рисунки

В тексте книги более 300 схем, диаграмм, примеров и иллюстраций, по-

ясняющих изложенные в ней концепции.

Веб-ресурсы

В каждой главе есть список веб-ресурсов — сайтов, на которых можно

найти ценные материалы по темам, рассматриваемым в этой главе.

Чтоги

В конце каждой главы есть раздел, в котором подводится краткий итог

всему изложенному в этой главе. Этот раздел позволяет быстро вспомнить

ключевые моменты главы.

Упражнения, проекты, исследования

В каждой главе предлагается множество упражнений разного уровня

сложности — от простейших вопросов, для ответа на которые нужно

вспомнить изложенный в главе материал, до задач, требующих долгих

размышлений и поиска информации (всего в книге более 900 упражне-

ний). Многие преподаватели задают учащимся курсовые проекты, поэтому

в книге есть разделы «Рекомендуемые исследовательские учебные проек-

ты» и «Рекомендуемые программные учебные проекты».

Рекомендуемая литература

В каждой главе есть список использованной литературы, а также крат-

кое описание наиболее важных источников, позволяющее выбрать литера-

ТУРУ для получения дополнительной информации.

Библиография

£ написании этой книги мы пользовались множеством источников,

лом СТе книги есть множество ссылок на литературные источники (в це-

O(l более 2300 ссылок). Каждая ссылка в тексте обозначается номером,

Ной МЛеННЫМ Как веРхний индекс. Это номер пункта в списке использован-

ют ЛИт®РатУРы в конце главы. Многие источники литературы представля-

с°бой веб-страницы. В предыдущих изданиях этой книги использова-

18

Операционные системь

лись только печатные источники; их часто было трудно найти, если чита-

тель желал к ним обратиться. Теперь ко многим источникам можно быстро

обратиться через Интернет; кроме того, с помощью поисковых систем мож

но найти дополнительную информацию по интересующим вопросам. Мно-

гие научные журналы доступны в Интернете — некоторые бесплатно, неко

торые — по подписке, причем подписка часто предоставляется членам опре-

деленных организаций или обществ. Интернет — богатейший источник

информации, оказывающий неоценимую помощь в учебе.

Врезки

Во втором издании «Операционных систем» присутствовала глава, по-

священная аналитическому моделированию, теории очередей и марков-

ским процессам. В этом издании такой главы нет — мы считаем, что опе-

рационные системы не относятся к математическим дисциплинам. В осно-

ве операционных систем лежит то, что мы предпочитаем называть

«системным мышлением» — проще говоря, операционные системы явля

ются в значительной степени областью эмпирических изысканий. Дабы

подчеркнуть это, мы включили в книгу ряд врезок (четырех разновидно-

стей), содержащих интересные материалы, которые, возможно, вас разве-

селят или заинтригуют.

Биографии

В книге приведены краткие жизнеописания людей, внесших существен-

ный вклад в развитие операционных систем: Эдсгер Дейкстра (Edsger

Dijkstra), Линус Торвальдс (Linus Torvalds), Дэвид Катлер (David Cutler),

Кен Томпсон (Ken Thompson), Деннис Ритчи (Dennis Ritchie), Дуг Энгель-

барт (Doug Engelbart), Тим Бернерс-Ли (Tim Berners-Lee), Ричард Стол-

лмен (Richard Stallman), Гордон Мур (Gordon Moore), Фернандо X. Корбато

(Fernando J. Corbato), Лесли Лэмпорт (Leslie Lamport), Пер Бринч Хансен

(Per Brinch Hansen), Питер Деннинг (Peter Denning), Сеймур Крей

(Seymour Cray), Билл Гейтс (Bill Gates), Рональд Ривест (Ronald Rivest),

Ади Шамир (Adi Shamir), Леонард Адлман (Leonard Adleman).

Учебные и практические примеры

Кроме подробных обзоров операционных систем Linux и Windows ХР,

в книге содержится 14 небольших примеров, описывающих другие опера

ционные системы, представляющие учебный, практический или историче-

ский интерес. Это Mach, CTSS и Multics, UNIX Systems, Операционные

системы реального времени, Atlas, Операционные системы мэйнфреймов

IBM, Ранняя история операционной системы VM, MS-DOS, Суперкомпью

теры, ОС Symbian, OpenBSD, Macintosh, User-Mode Linux (UML) и OS/2

19

Мучительные истории

Один из авторов книги, Харви Дейтел (HMD), собрал за свою долгую

карьеру огромную коллекцию анекдотов. Мы включили в текст 16 из них.

Некоторые из них — просто юмористические, а некоторые заставляют за-

думаться и носят философский характер. Каждый такой анекдот (мы наде-

емся на это) позволит вам немного отвлечься от технических дискуссий, а

в конце поучительной истории приведен вывод из нее, важный для разра-

ботчиков операционных систем.

Размышления об операционных системах

Ученые могут позволить себе роскошь изучать только интересующие их

части операционных систем, особенно эффективные алгоритмы, структу-

ры данных или, реже, области, хорошо поддающиеся анализу математиче-

скими методами. Практические специалисты вынуждены заниматься соз-

данием реальных, работоспособных систем, соответствующих предъявляе-

мым потребителями требованиям по стоимости, производительности

и надежности. Оба подхода обладают интересными особенностями. В мыш-

лении ученых и разработчиков есть и много общего, и существенные раз-

личия. Эта книга пытается выдержать баланс между академическими

и прикладными сторонами теории и практики операционных систем.

Что представляют собой «размышления об операционных системах»?

В книге есть 43 врезки с таким названием. Некоторые аспекты операцион-

ных систем поддаются анализу с помощью изощренных математических

методов. Но опыт работы автора (HMD) в компьютерной промышленно-

сти — 42 года, в том числе участие (в молодые годы) в создании больших

операционных систем в IBM и MIT, написание двух предыдущих изданий

этой книги и чтение десятков курсов по операционным системам — пока-

зал, что эти инструменты слишком сложны и мало пригодны для широко-

го применения студентами без глубоких фундаментальных знаний. Даже для

студентов старших курсов операционные системы (за исключением узких об-

ластей) слишком сложны, чтобы поддаваться математическому анализу.

Если невозможно оценивать аспекты операционных систем математиче-

ски, как можно вообще их оценить? Ответ — с помощью «системного

мышления», и именно этот подход используется в данной книге. Врезки

«Размышления об операционных системах» — это попытки выделить клю-

чевые концепции, особенно важные в проектировании и реализации опера-

ционных систем.

Вот список этих врезок: Изобретения и открытия; Относительная стои-

мость человеческих и компьютерных ресурсов; Производительность; При-

Рживаемся простоты; Архитектура; Кэширование; Унаследованное про-

аммное обеспечение и аппаратные средства; Принцип наименьшего

ЛО°ВНЯ пРивилегий; Защита; Эвристика; Пользователей интересуют при-

МеЖеНИЯ; СтРУктУРЬ1 данных ОС; Синхронность и асинхронность; Одновре-

Ма Н°е выполнение операций; Параллелизм; Соответствие стандартов;

ки СШтабиРуемость; Сокрытие информации; Ожидание, взаимоблокиров-

р и бесконечное откладывание; Накладные расходы; Предсказуемость;

н°Правие; Интенсивность управления ресурсами с учетом их относи-

20

Операциенныв системы

тельной стоимости; Безграничность роста вычислительной мощности, объ-

емов памяти и пропускной способности; Изменение — это правило, а не ис-

ключение; Пространственные ресурсы и фрагментация; Виртуализация;

Эмпирические результаты — локальность; Позднее выделение; Компью-

терная теория и операционные системы; Баланс между пространством

и временем; Насыщение и узкие места; Сжатие и распаковка данных; Из-

быточность; Жизненно важные системы; Отказоустойчивость; Шифрование

и дешифрование; Безопасность; Резервное копирование и восстановление;

Закон Мерфи и робастные системы; Плавное снижение эффективности; Реп-

ликация данных и когерентность; Вопрос этики разработки систем.

Учебные примеры

В главах 20 и 21 подробно рассматриваются соответственно операцион-

ные системы Linux и Windows ХР. Эти обзоры тщательно изучались веду-

щими разработчиками Linux и Windows ХР. Структура этих обзоров соот-

ветствует идее книги — описываются только принципы; практические

примеры демонстрируют, как эти принципы применяются в двух самых

распространенных операционных системах современности. В Linux рас-

сматривается самая свежая версия ядра (2.6); обзор снабжен 262 ссылками

на литературу. Обзор Windows ХР описывает возможности новейшей вер-

сии этой операционной системы и снабжен 485 ссылками.

Обзор книги

В этом разделе кратко описано содержание каждой части и главы

третьего издания «Операционных систем».

Часть 1 — «Введение в аппаратные средства, программное обеспечение

и операционные системы» — состоит из двух глав, в которых объяснено

назначение операционных систем, изложена история их развития и основ-

ные концепции построения программных и аппаратных элементов, рас-

сматриваемых в книге.

Глава 1 — «Введение в операционные системы» — содержит определе-

ние понятия «операционная система» и объясняет, почему операционные

системы стали необходимыми. В этой главе также описывается история

развития операционных систем, десятилетие за десятилетием, всю вторую

половину XX века. Упомянуты системы пакетной обработки 1950-х годов.

Мы рассмотрим появление параллелизма в 1960-х годах — зарождение

многопрограммных систем и интерактивных систем с разделением време-

ни. Вы узнаете историю создания важных операционных систем, включая

CTSS, Multics, СР/CMS и UNIX. В этой главе рассказывается о стиле мыш-

ления создателей операционных систем эпохи, в которую человеческие ре-

сурсы стоили куда дешевле, чем машинные (сегодня человеческие ресурсы

намного дороже машинных). Вы узнаете, как зарождались в 1970-х годах

компьютерные сети, Интернет и протоколы TGP/IP и как появились пер-

21

персональные компьютеры. Персональные компьютеры получили ши-

Bbie е распространение в начале 1980-х годов, когда на этот рынок вышли

Р°к ацИИ IBM и Apple. В компьютере Apple Macintosh был использован

КО’Х1ческий пользовательский интерфейс (Graphical User Interface —

ГТТП позже ставший общепринятым. Вы узнаете, как зарождались рас-

тленные вычислительные системы, и как появилась модель кли-

П₽е/сервер. В 1990-х годах произошел лавинный рост популярности Ин-

еН нета, причиной которого стало рождение World Wide Web. Компания

Microsoft стала доминирующим производителем программных продуктов

мире и выпустила свою операционную систему Windows NT (предшест-

венницу Windows ХР, рассматриваемой в главе 21). Объектная технология

стала основной парадигмой программирования, и широкое распростране-

ние получили, например, языки C++ и Java. Быстрое распространение

программного обеспечения с открытым исходным кодом стало причиной

феноменального успеха операционной системы Linux, которой посвящена

глава 20. Мы рассмотрим роль операционных систем в качестве платформ

для разработки приложений. Будут рассмотрены встраиваемые системы.

Мы выясним, почему для систем, выполняющих жизненно важные зада-

чи, прежде всего необходима исключительная надежность. Мы опишем ос-

новные компоненты операционных систем и задачи, которые должны ре-

шать операционные системы (практически во всех разделах книги особое

внимание уделяется достижению максимальной производительности в ка-

ждом компоненте операционных систем). Будут описаны различные архи-

тектуры операционных систем, включая монолитные, многоуровневые,

микроядерные и распределенные системы.

В главе 2 — «Концепции аппаратных средств и программного обеспече-

ния» — описаны аппаратные и программные ресурсы, с которыми должны

работать операционные системы. В этой главе рассказывается, как повлиял

на эволюцию операционных систем процесс развития аппаратных

средств — в первую очередь, феноменальный рост вычислительной мощно-

сти, емкости памяти и пропускной способности каналов связи. Будут рас-

смотрены основные аппаратные компоненты систем, включая материнские

платы, процессоры, таймеры, оперативную память, вторичные устройства

хранения, шины, механизмы прямого доступа к памяти и периферийные

устройства. Мы рассмотрим недавно появившиеся технологии и техноло-

гии, которые еще находятся в процессе становления, и обсудим необходи-

мость поддержки аппаратных возможностей в операционных системах,

включая разные режимы выполнения инструкций, привилегированные ин-

стРУкции, таймеры, тактовые генераторы, загрузчики и возможности горя-

чего подключения. Будут описаны методики повышения производительно-

сти, например, кэширование и буферизация. Описаны такие понятия про-

граммирования, как, например, компиляция, компоновка, загрузка,

инные языки, ассемблеры, интерпретаторы и компиляторы, языки вы-

Ние°Г° УР°ВНЯ’ структурное и объектно-ориентированное программирова-

j , ’ интерфейсы программирования приложений (Application Programming

г 1асе — API). Кроме того, в главе описано встроенное и системное про-

Раммное обеспечение.

Часть 2 — «Процессы и потоки» — состоит иЗ шести глав, описываю-

щих процессы, потоки, изменения состояний процессов и потоков, преры-

вания, переключения контекстов, асинхронность, взаимные исключения,

мониторы, взаимоблокировки и бесконечное откладывание, а также про-

цессорное планирование процессов и потоков.

С главы 3 — «Концепции процесса» — начинается изучение базовые

элементов операционной системы. В этой главе определено понятие про-

цесса. Мы рассмотрим жизненный цикл процесса как последовательность

переходов процесса из одних состояний в другие. Будет описано представ,

ление процесса его управляющим блоком или дескриптором, и особое вни-

мание будет уделено важности структур данных в операционных системах.

В главе изложены причины использования структур описания процессов

в операционной системе, и операции, которые можно выполнять над про-

цессами, например, приостановку и возобновление их выполнения. Кратко

описаны понятия, важные для многопрограммных систем, включая приос-

тановку выполнения процессов и переключение контекстов. В главе также

описаны прерывания — ключевой элемент реализации любой многопро-

граммной среды. Мы рассмотрим обработку прерываний и классы прерыва-

ний, а также межпроцессное взаимодействие с помощью сигналов и переда-

чи сообщений. Глава заканчивается описанием процессов системы UNIX.

Глава 4 — «Концепции потока» — продолжает обсуждение процессов.

В ней мы перейдем к более мелким элементам параллельно выполняемых

программ — потокам. В главе объяснено, что такое Лоток и как потоки со-

относятся с процессами. Описаны жизненные циклы потоков и переходы

потоков из одних состояний в другие. Также описаны различные варианты

потоковых архитектур, включая потоки пользовательского уровня, уровня

ядра и сочетания потоков разных уровней. Мы рассмотрим соображения,

касающиеся реализаций потоков, включая передачу сигналов потокам

и завершение потоков. Мы обсудим стандарт POSIX и его спецификацию

потоков, Pthreads. Глава завершается описанием реализаций потоков

в Linux, Windows ХР и Java. Описание потоков Java сопровождается лис-

тингами полностью работоспособных программ и примерами результатов

их выполнения. [Примечание: Исходный код всех программ на языке Java

из этой книги доступен по адресу www.deitel.com/books/os3e].

В главе 5 — «Асинхронное параллельное выполнение» — обсуждаются

вопросы, связанные с параллельным выполнением программ в многопро-

граммных системах. В этой главе излагается суть проблемы взаимных ис-

ключений и объясняется, как потоки должны управлять доступом к об-

щим ресурсам. В этой главе есть учебный пример многозадачной ситуаций

на Java — проблема отношения производитель-потребитель. В этом приме-

ре приведена готовая программа на Java и различные варианты результа-

тов ее выполнения, демонстрирующие, что может произойти, когда потоки

обращаются к общедоступным данным без синхронизации. Пример четко

показывает, что иногда параллельно выполняемые программы будут рабо-

тать правильно, а иногда — давать ошибочные результаты. В главе 6 мЫ

покажем, как решить эту проблему. Описана концепция критического

участка кода программы. Описаны несколько программных механизмов

защиты доступа к критическим участкам, включая алгоритм Деккера, ал-

горитм Питерсона и алгоритм Лэмпорта со взаимоисключением для п по-

ов. В этой главе также описаны аппаратные механизмы, позволяющие

Т°ализовать алгоритмы взаимного исключения — включая маскирование

Ре оь1Ваний, инструкции проверки-и-записи и инструкции обмена. И на-

ец, в главе описаны семафоры — высокоуровневый механизм реализа-

к° Симных исключений и синхронизации потоков. Описаны как двоич-

так и считающие семафоры.

Н В главе 6 — «Параллельное программирование» — вводится понятие

онйторов (высокоуровневых конструкций взаимных исключений). Затем

этой главе описано решение нескольких классических проблем парал-

лельного программирования. Сначала приводятся решения с мониторами,

записанные псевдокодом, а затем — готовые программы на Java с приме-

пами результатов работы. Описания мониторов приведены в виде псевдо-

кода с синтаксисом, похожим на синтаксис языков C/C++/Java. Мы объ-

ясним, как использование мониторов позволяет скрывать информацию,

и в чем переменные состояния мониторов отличаются от «обыкновенных»

переменных. В главе показано, как простой монитор можно применить

для контроля доступа к ресурсу, требующему строго упорядоченного дос-

тупа. Рассматриваются две классических проблемы параллельного про-

граммирования — кольцевой буфер и читатели-писатели — с псевдокода-

ми мониторов для их решения. Описаны также мониторы на языке Java

и различия между ними и мониторами, описанными в классической лите-

ратуре. В главе содержится продолжение примера на языке Java из преды-

дущей главы — задача отношения производитель-потребитель решена

с применением кольцевого буфера. Студенты могут воспользоваться этой

программой как основой для программы, решающей задачу взаимоотно-

шений читателей и писателей.

В главе 7 — «Взаимоблокировки и бесконечное откладывание» — опи-

саны два возможных следствия ожидания, которые могут оказаться ката-

строфическими — взаимоблокировки и бесконечное откладывание. Клю-

чевой вывод: системы, в которых существуют ожидающие объекты, нужно

проектировать очень тщательно, чтобы избежать упомянутых проблем.

В главе приведено несколько примеров взаимоблокировок, включая взаи-

моблокировку в транспортной пробке, взаимоблокировку на мосту с одно-

полосным движением, взаимоблокировку при распределении ресурсов,

взаимоблокировку в системах спулинга и взаимоблокировку в задаче

Дейкстры об обедающих философах. Рассмотрены основные принципы

Управления ресурсами, включая перераспределяемость, разделение досту-

па, реентерабельность и последовательное многократное использование,

главе формально определено понятие взаимоблокировки и описаны ме-

тоды обнаружения и предотвращения взаимоблокировок, а также методы

выхода из взаимоблокировок (как правило, сопряженные с потерями).

Исаны четыре необходимых условия возникновения взаимоблокировок,

Именно: взаимное исключение, ожидание дополнительных ресурсов, не-

перераспределяемость и круговое ожидание. Мы рассмотрим методы Ха-

Из Для пРеД°твращения взаимоблокировок за счет устранения одного

Последних трех условий. Избегание взаимоблокировок позволяет более

ко распределять ресурсы, чем устранение взаимоблокировок. В главе

На Сано избегание взаимоблокировок по алгоритму банкира с примерами

'межных и ненадежных состояний, а также переходов между этими со-

Операционные системы

стояниями. Обсуждаются слабые места алгоритма банкира. Мы разберем

методы обнаружения взаимоблокировок с помощью приведения графов

распределения ресурсов. Главу завершает обсуждение методик борьбы со

взаимоблокировками в современных и будущих системах.

Глава 8 — «Планирование работы процессора» — содержит описанце

концепций и алгоритмов выделения процессорного времени различны^

процессам и потокам. Описаны уровни планирования, его цели и Крите-

рии. Проведено сравнение вытесняющих и невытесняющих подходов

к планированию. Мы объясним, как правильно выбирать приоритеты

и размер кванта (минимального неделимого интервала процессорного вре-

мени) в алгоритмах планирования. Описаны несколько классических и со-

временных алгоритмов планирования, включая алгоритм FIFO

(first-in-first-out — «первым-пришел-первым-вышел»), циклический ал-

горитм (RR), алгоритм «кратчайший процесс — первым» (SPF), алгоритм

«следующим — процесс с максимальным временем реакции» (HRRN), ал-

горитм «с наименьшим остающимся временем» (SRT), многоуровневые

очереди и планирование по принципу справедливого раздела. Каждый ал-

горитм оценивается по таким критериям, как пропускная способность,

среднее время реагирования и разброс этого времени. Мы обсудим плани-

рование потоков в языке Java, планирование в мягком и жестком реаль-

ном времени и планирование по сроку завершения.

Часть 3 — «Реальная и виртуальная память» — состоит из трех глав,

в которых описана организация памяти в системах реальной и виртуаль-

ной памяти.

Глава 9 — «Оперативная память. Организация и управление» — начи-

нается с изложения истории организации оперативной памяти и управле-

ния этой памятью. Системы оперативной памяти развивались от простей-

ших до весьма замысловатых, причем целью всегда было максимально эф-

фективное использование относительно дорогой памяти. Мы рассмотрим

иерархию памяти, включая кэши, оперативную память и вторичные

(внешние) устройства хранения. Затем рассмотрим три категории страте-

гий управления памятью — стратегии загрузки, стратегии размещения

и стратегии замены. Мы рассмотрим схемы выделения непрерывных

и фрагментированных участков памяти. Будет рассмотрена однопользова-

тельская система с выделением непрерывных участков памяти, включая

оверлеи, защиту и однопоточную пакетную обработку. Мы проследим эво-

люцию организации памяти в многопрограммных системах — от систем

с фиксированным распределением памяти к системам с изменяемым рас-

пределением. Мы изучим проблемы внешней и внутренней фрагментации

и методы борьбы с ней, включая сращение и уплотнение памяти. В главе

описываются стратегии размещения в первых подходящих участках,

в наиболее подходящих участках и наименее подходящих участках.

Глава 10 — «Организация виртуальной памяти» — посвящена основ-

ным принципам построения виртуальной памяти и возможностям аппа-

ратных устройств, необходимым для организации виртуальной памяти.

В этой главе объясняются причины, по которым виртуальная память необ-

ходима, и описываются ее типичные реализации. В главе также описаны

ключевые подходы к организации виртуальной памяти — страничный

и сегментный — и их сильные и слабые стороны. Мы рассмотрим странич-

числеВие

е системы, трансляцию адресов прямым отображением и ассоциатив-

ным отображением, сочетание прямого и ассоциативного отображения,

Й ногоуровневые страничные таблицы, обращенные страничные таблицы

М пазделение ресурсов в страничных системах. Рассматривая сегментные

0исТемы, мы разберем трансляцию адресов прямым отображением, разде-

С ние ресурсов, защиту и контроль доступа в сегментных системах. Мы

также рассмотрим гибридные сегментно-страничные системы, обсудим ди-

намическую трансляцию адресов, разделение ресурсов и механизмы защи-

ты в таких системах. Завершает главу обзор реализации системы вирту-

альной памяти в популярной архитектуре IA-32 фирмы Intel.

Глава 11 — «Управление виртуальной памятью» — продолжает тему

виртуальной памяти. В этой главе рассказывается, как операционные сис-

темы пытаются оптимизировать производительность виртуальной памяти.

Поскольку наибольшее распространение получили страничные системы,

мы тщательно изучим вопрос распределения страниц, особенно стратегии

замены страниц. В главе описывается один из наиболее важных эмпириче-

ских результатов в области операционных систем — феномен локальности.

Мы рассмотрим эффекты как временной, так и пространственной локаль-

ности и обсудим, когда страницы нужно перемещать в оперативную па-

мять (предварительная подкачка и подкачка по требованию). Когда объем

доступной памяти уменьшается, закачиваемые в нее страницы приходится

записывать вместо уже находящихся в памяти. Стратегия, по которой сис-

тема определяет, какие страницы заменить новыми, может оказать огром-

ное влияние на производительность. В главе рассмотрено множество стра-

тегий замены страниц, в том числе: случайная, «первый вошел — первый

вышел» (FIFO) — включая аномалию FIFO, стратегия замены дольше все-

го не использовавшихся страниц (LRU), реже всего использовавшихся

(LFU) и давно не использовавшихся (NUR), стратегия второго шанса, стра-

тегия круговой замены, стратегии замены дальних страниц и замены по

частоте страничных промахов. Описана классическая модель рабочих на-

боров Деннинга и попытки реализовать ее с помощью различных страте-

гий замены страниц. В главе также описана возможность добровольного

освобождения страниц. Мы тщательно изучим аргументы в пользу стра-

ниц маленького и большого размеров, а также поведение программ в стра-

ничных системах. Главу завершают обзор стратегии замены страниц в опе-

рационной системе Linux и сравнение глобальных и локальных стратегий

замены страниц.

Часть 4 — «Внешние накопители, файлы и базы данных» —' состоит из

^Вух глав, в которых описаны методы, применяемые в операционных сис-

Мах для управления данными на вторичных устройствах хранения. 06-

Ках Даетвя оптимизация производительности накопителей на жестких дис-

д , ’ а также файловые системы и базы данных. Обсуждение систем вво-

уд 1воДа рассредоточено по всей книге, но более всего внимания ему

и vv- ° в главах 2, 12, 13 и обзорах операционных систем Linux

Гла °WS ХР (главы 20 и 21, соответственно).

лей» ЙВа — «Оптимизация производительности дисковых накопите-

г°лов ПосвяЩена характеристикам дисковых накопителей с подвижными

Мах рЯМИ „И Оптимизации их производительности в операционных систе-

этои главе рассматривается эволюция вторичных устройств хране-

I

26

Операционные систем)»

дрдисловие^

27

ния, и описываются основные характеристики накопителей с подвижным^

головками. Технологии дисковых накопителей с подвижными головкалщ

быстрыми темпами развиваются уже полвека, и при этом накопители это,

го класса остаются самыми распространенными. Мы объясним, почему не,

обходима диспетчеризация обращений к накопителям и покажем, почему

она должна использоваться для достижения высокой производительности.

Описана эволюция стратегий диспетчеризации доступа, включая FCFg

SSTF, SCAN, C-SCAN, FSCAN, N-шаговый SCAN, LOOK, C-LOOK и VSCA\

(эта стратегия описана в упражнениях), а также стратегии вращательно^

оптимизации, включая SLTF, SPTF и SATF. Обсуждаются и другие попу,

лярные методики оптимизации производительности, включая кэширова-

ние, буферизацию, дефрагментацию, сжатие данных и блокирование.

Одно из самых важных дополнений в третьем издании «Операционных

систем» — подробное описание систем RAID в этой главе. RAID (Redun.

dant Array of Independent Disks — избыточный массив независимых дис-

ков) — это набор технологий, позволяющих дисковым системам достичь

более высоких отказоустойчивости и производительности. В главе описа-

ны различные «уровни» RAID, включая уровни О (разделение дан-

ных), 1 (зеркальное отображение), 2 (побитовый контроль с коррекцией по

Хеммингу), 3 (побитовый XOR-контроль и коррекция), 4 (блочный

XOR-контроль и коррекция) и 5 (блочный XOR-контроль и коррекция

с распределением).

В главе 13 — «Файловые системы и базы данных» — описаны организа-

ция и управление данными в операционных системах, включая файлы

и базы данных. Мы рассмотрим ключевые концепции, включая иерархию

данных, файлы, файловые системы, директории, ссылки, метаданные

и монтирование. В главе рассказывается о различных организациях фай-

лов, разбираются файлы с последовательным, прямым, индексированным

прямым доступом и фрагментированные файлы. Описаны методики разме-

щения файлов, включая непрерывное размещение, размещение в виде

связных списков, табличное фрагментированное размещение и индексиро-

ванное фрагментированное размещение. Мы объясним методы контроля

доступа к файлам с помощью классов и матриц контроля доступа, опишем

методики доступа к данным в контексте простейших методов доступа и ме-

тодов с поддержкой очередей, а также разберем предварительную буфери-

зацию и отображение файлов в память. Мы рассмотрим методы обеспече-

ния целостности, включая защиту, резервное копирование и восстановле-

ние, ведение журналов, атомарные транзакции, откаты, фиксации,

создание контрольных точек, теневое копирование и журнальные файло-

вые системы. В главе описаны файловые серверы и распределенные систе-

мы, читателю предлагается подробнее изучить эти и другие темы в гла-

вах 16—18. Кроме того, в главе кратко рассказывается о базах данных, ана-

лизируются их преимущества, техника доступа к данным, реляционна^

модель баз данных, а также механизмы операционных систем, обеспечи-

вающие поддержку систем баз данных.

Часть 5 — «Производительность, процессоры и мультипроцессорный

системы» — состоит из двух глав, посвященных контролю производитель'

ности, методам ее измерения и оценки, а также вопросам повышения про-

изводительности за счет использования многопроцессорных систем.

Глава 14 — «Производительность и архитектура процессоров» — посвя-

на одной из самых важных целей разработки операционных систем,

°^.тижению максимальной производительности. В этой главе обсуждается

выбора разновидности процессора в достижении высокой производи-

Р° ьности. В главе рассматриваются показатели производительности,

Т также такие вопросы, как абсолютная производительность, простота ис-

аользования оценок, оборотное время, время отклика, время реакции сис-

ПеМы, разброс времени реакции, пропускная способность, рабочая нагруз-

ка мощность и степень загрузки. Мы обсудим методы измерения произво-

ительности, включая профилирование, хронометраж, тестирование на

микроуровне, оценку производительности для конкретных приложений,

аналитическое моделирование, тестовые программы, синтетические тесты,

моделирование и мониторинг производительности. Описаны узкие места

и насыщение. Производительность системы сильно зависит от производи-

тельности ее процессора (или процессоров), которая, в свою очередь, опре-

деляется наборами используемых инструкций. Мы рассмотрим основные

решения, включая архитектуры с полным набором инструкций (CISC —

Complex Instruction Set Computing), с сокращенным набором (RISC —

Reduced Instruction Set Computing) и новые архитектуры. Завершает главу

описание параллельной обработки команд с явным параллелизмом

(EPIC — Explicitly Parallel Instruction Computing).