Author: Дейтел Г.

Tags: компьютерные технологии программирование программное обеспечение операционные системы компьютерные науки

Year: 1987

Text

Введение

в операционные

системы

Том I

An Introduction to Operating Systems

Revised First Edition

Harvey M. Deitel

Boston College

1984

Addison-Wesley Publishing Company

Reading, Massachussetts*Menlo Park, California

London* Amsterdam «Don Mills, Ontario-Sydney

Г Дейтел

Введение

в операционные

системы

В двух томах

Том 1

Перевод с английского

Л. А. Теплицкого, А. Б. Ходулева,

Вс. С. Штаркмана

под редакцией

Вс. С. Штаркмана

Москва «Мир» 1987

ББК 32.973

Д27

УДК 681.325.5

Дейтел Г.

Д27 Введение в операционные системы: В 2-х т.

Т. 1. Пер. с англ.— М.: Мир, 1987.—359 с., ил.

Монография учебного характера, написанная американским спе¬

циалистом и охватывающая современные проблемы операционных си¬

стем: управление процессами, работу с памятью, мультипроцессор¬

ные средства, сетевые операционные системы, защиту системы. В ней

описаны пять основных операционных систем, используемых в мире

в настоящее время. Изложение методически продумано, снабжено

большим числом упражнений, диаграмм, рисунков.

В русском переводе книга выходит в двух томах. В первый том

включены гл. 1 —11.

Для разработчиков операционных систем, программистов, препо¬

давателей и студентов вузов.

1702070000-273

Д 041(01)-87

35-87, ч. 1

ББК 32.973

Редакция литературы по математическим наукам

© 1984 by Addison-Wesley

Publishing Company, Inc.

© перевод на русский язык, «Мир», 1987

Предисловие редактора перевода

Нарастающие темпы компьютеризации стремительно прибли¬

жают время, когда в контакте с компьютерами окажутся не только

относительно немногочисленные профессионалы по обработке ин¬

формации, а практически все члены общества. Контакт с компью¬

тером — это контакт с его программным обеспечением и, прежде

всего, с операционной системой (ОС). Именно она формирует ин¬

терфейс между аппаратурой компьютера и человеком, причем за¬

дача создателей ОС состоит в том, чтобы сделать этот интерфейс,

как теперь принято говорить, как можно более дружественным.

Свойства ОС зачастую оказываются не менее важными, чем

свойства аппаратуры. Известны случаи, когда переход с одной ОС

на другую (с OS/MVT на VM) на одной и той же машине (ЕС-1045)

приводил почти к пятикратному ускорению разработки программ.

На «голой» машине в современном мире не работает практически

никто, и именно это определяет интерес к операционным системам.

В нашем предисловии мы не будем подробно останавливаться на

назначении книги, ее структуре и содержании отдельных глав,

поскольку об этом подробно сказано в предисловии автора; остано¬

вимся лишь на некоторых особенностях книги.

Если считать, что ОС появились как первые системы для упро¬

щения и автоматизации процесса перехода от одной выполняемой

на компьютере работы к следующей, т. е. еще в 50-е годы, то ока¬

жется, что они не намного моложе самих компьютеров и имеют

за плечами более чем 30-летнюю историю.

И, тем не менее, эта история связана со столь бурным развитием

и машин и программирования, что, вероятно, лишь в последнее

время можно говорить о начале некоторой стабилизации основных

концепций, целей и оценок в области ОС. По-видимому, предлагае¬

мая читателю книга самая полная по охвату материала из послед¬

них книг по ОС.

Большая часть текста посвящена, так сказать* анатомии операци¬

онных систем, т. е. рассмотрению отдельных компонент и механиз¬

мов (управление процессами, управление памятью, управление

данными, планирование и т. п.). Изложение ведется в общем виде

без привязки к какой-либо одной конкретной ОС или семейству ОС.

6

Предисловие редактора перевода

«Анатомический» материал очень хорошо дополняют примеры

для изучения — конкретные ОС, описанные в последних главах

книги. Отбор ОС сделан удачно. Рассмотрены наиболее распростра¬

ненные и в чем-то наиболее поучительные системы- UNIX, VAX,

СР/М, MVS и VM. Здесь читатель не только может почувствовать,

как из «анатомических» деталей строятся архитектурно завершенные

ОС, но и получит массу интересных сведений об истории создания

каждой ОС, о современном положении их на рынке сбыта, о пер¬

спективах дальнейшего развития и т. п. Этот материал не тради¬

ционен и может служить убедительной иллюстрацией той мысли,

что многочисленность коллектива разработчиков, большие финансо¬

вые затраты и амбициозность целей проекта далеко не всегда служат

гарантией его успеха.

Примеры успешных разработок, выполненных «малыми силами

энтузиастов», говорят о том, что главное — это наличие стратеги¬

чески правильной ключевой идеи в сочетании с хорошим инженер¬

ным вкусом, позволяющим построить ясную концептуальную мо¬

дель, четко выделить базисные функции и, по возможности, отбро¬

сить все лишнее.

Не менее важно здесь иметь адекватные инструментальные сред¬

ства разработки, с помощью которых работу действительно может

выполнить небольшое число людей (идейных единомышленников)

в обозримое время. И что, видимо, еще важнее— изделие оказы¬

вается доводимым, адаптируемым к разнообразным конкретным

условиям — в конечном счете, переносимым.

Несколько слов о стиле автора. Книга написана просто и по¬

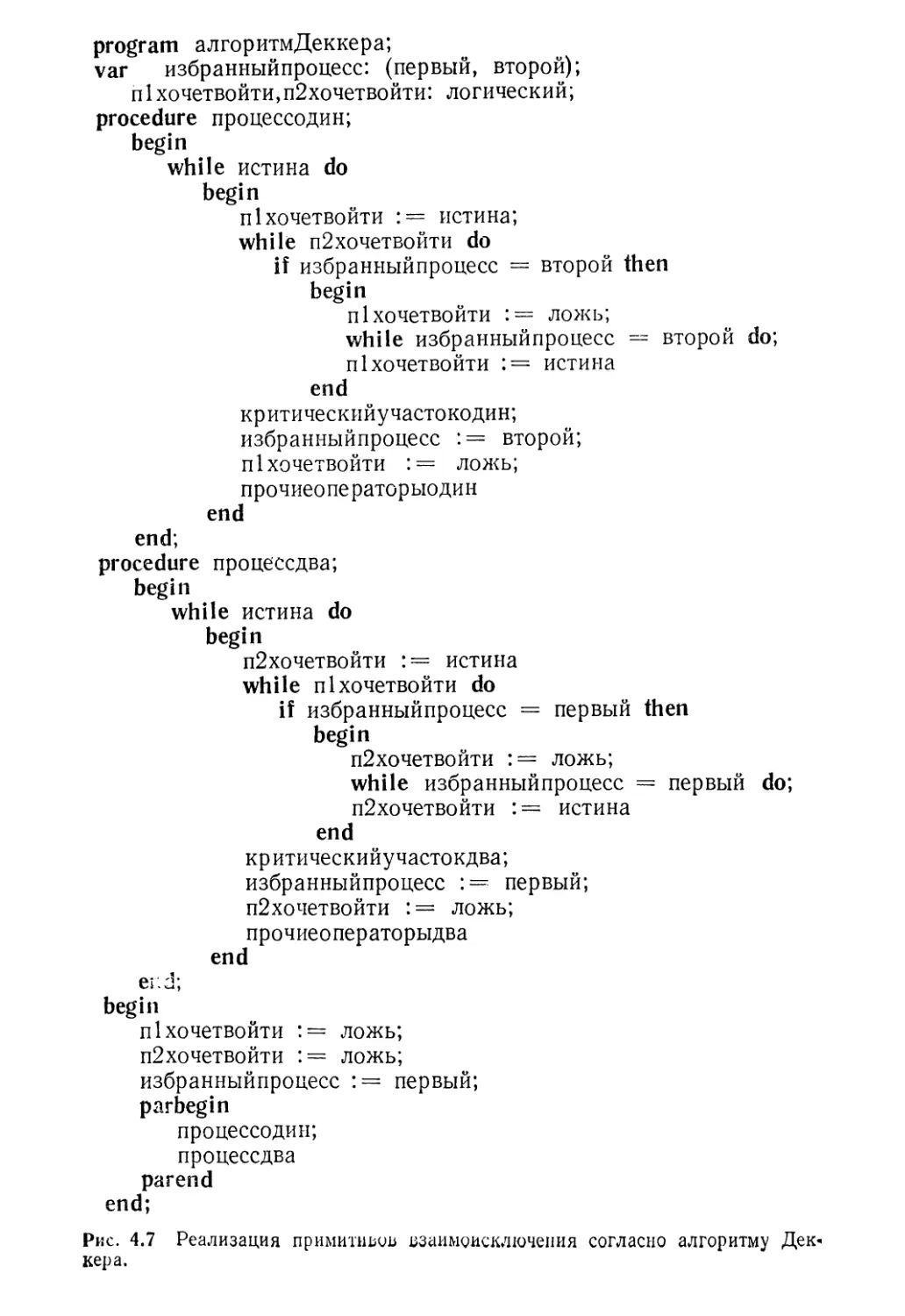

нятно. Непосредственно к программам (на Паскале и Аде) автор при¬

бегает только, рассказывая об алгоритмах взаимоисключения при

работе параллельных процессов с общими ресурсами, к математи¬

ческому аппарату — только в главе об аналитическом моделиро¬

вании. В остальном все излагается, как говорится, на пальцах.

К числу удачных педагогических приемов следует отнести за¬

ключительные разделы в конце каждой главы. Они позволяют чита¬

телю более четко выделить главные идеи на фоне менее существен¬

ных деталей.

Предлагаемая книга будет полезна не только учащимся, но и спе¬

циалистам в области операционных систем.

Книга в переводе разбита на 2 тома. Предисловие и гл. 1—13

переведены Л. А. Теплицким, гл. 14—15, 17, 19 и приложение —

А. Б. Ходулевым, гл. 16, 18, 20—22 — Вс. С. Штаркманом.

Вс, С. Штаркман

Моей жене Барбаре, детям Полу и Эбби —

украшению моей жизни.

Предисловие

Эта книга задумана в первую очередь как учебник для одно¬

семестрового курса по операционным системам, который универ-

ситеты предлагают студентам младших и старших курсов и аспи¬

рантам первого года обучения, специализирующимся в области ин¬

форматики. Книга содержит достаточно полный материал, чтобы

с успехом служить основным учебником по курсам CS6 и CS10

Программы-78 ACM (Association for Computing Machinery, Inc.).

Глава 15, «Аналитическое моделирование» содержит много матема¬

тических рассуждений; она должна быть включена в курс «базовых»

лекций учебных заведений по информатике, однако ее можно без

особого ущерба опускать в менее специализированных учебных

программах.

В книге содержится около 300 схем, диаграмм и иллюстраций,

504 упражнения, 22 главы и разобрано пять подробных примеров.

В конце каждой главы дан обширный список литературы —

577 книг и статей. В терминологических разделах в конце глав

приводится свыше 1200 терминов — ключевых слов.

В пяти подробных примерах описываются операционные систе¬

мы, которые будут играть наиболее важную роль в 80-х годах,

а именно системы Unix, VAX/VMS, СР/М, MVS и VM. Каждая

из этих систем имеет свой неповторимый «аромат» — и мне пришлось

немало потрудиться, чтобы попытаться передать его. Каждая из

перечисленных операционных систем предназначается для различ¬

ных сфер рынка операционных систем.

Книга состоит из восьми частей, каждая из которых содержит

по несколько тематически связанных глав. В книге много иллю¬

страций (которые удачно выполнила Сью Мишенер, искусный

художник издательства Addison-Wesley). В начале каждой главы

приведено содержание, так что читатель может осваивать материал

по «нисходящему» принципу. В качестве эпиграфов к каждой главе

используется одна или несколько цитат — некоторые из них носят

юмористический характер, некоторые заставляют читателя заду¬

маться — и все они призваны сделать книгу более приятной для

чтения и придать ей некий налет философичности.

Ключевые термины, основные концепции и важные утверждения

в тексте выделяются курсивом. В конце каждой главы еще раз

8

Предисловие

перечисляются наиболее важные концепции и идеи. Раздел терми¬

нологии, входящий в каждую главу, содержит ключевые термины,

расположенные в алфавитном порядке. В каждой главе дается много

различных по сложности упражнений — от простых вопросов для

повторения материала до серьезных заданий, требующих способно¬

сти логически мыслить с использованием основных изложенных

принципов. Библиографические указатели, представляющие само¬

стоятельные разделы в конце каждой главы, содержат списки книг

и статей по излагаемому материалу. В конце книги приведен имен¬

ной указатель, в котором перечисляются авторы и соавторы литера¬

турных источников, упомянутых в тексте; обширный предметный

указатель, построенный традиционным образом, позволяет быстро

найти практически любую нужную часть книги по ключевому

слову.

В части 1 вводится понятие «операционная система», приводятся

факты из истории развития операционных систем и обсуждаются

аппаратные, программные и микропрограммные средства. Глава 2

содержит пример принципа микропрограммирования; это особенно

важно для студента, изучающего операционные системы, поскольку

в вычислительных машинах новых поколений значительная часть

модулей операционной системы (а в некоторых случаях и вся опе¬

рационная система) будет реализовываться при помощи микрокода.

В гл. 1 частично использован материал статьи Weizer N. A History

of Operating Systems, Datamation, January, 1981. Этот материал пе¬

репечатывается с разрешения журнала Datamation, © Copyright

by Technical Publishing Company,; A Dun & Bradstreet Company,

1981, all rights reserved.

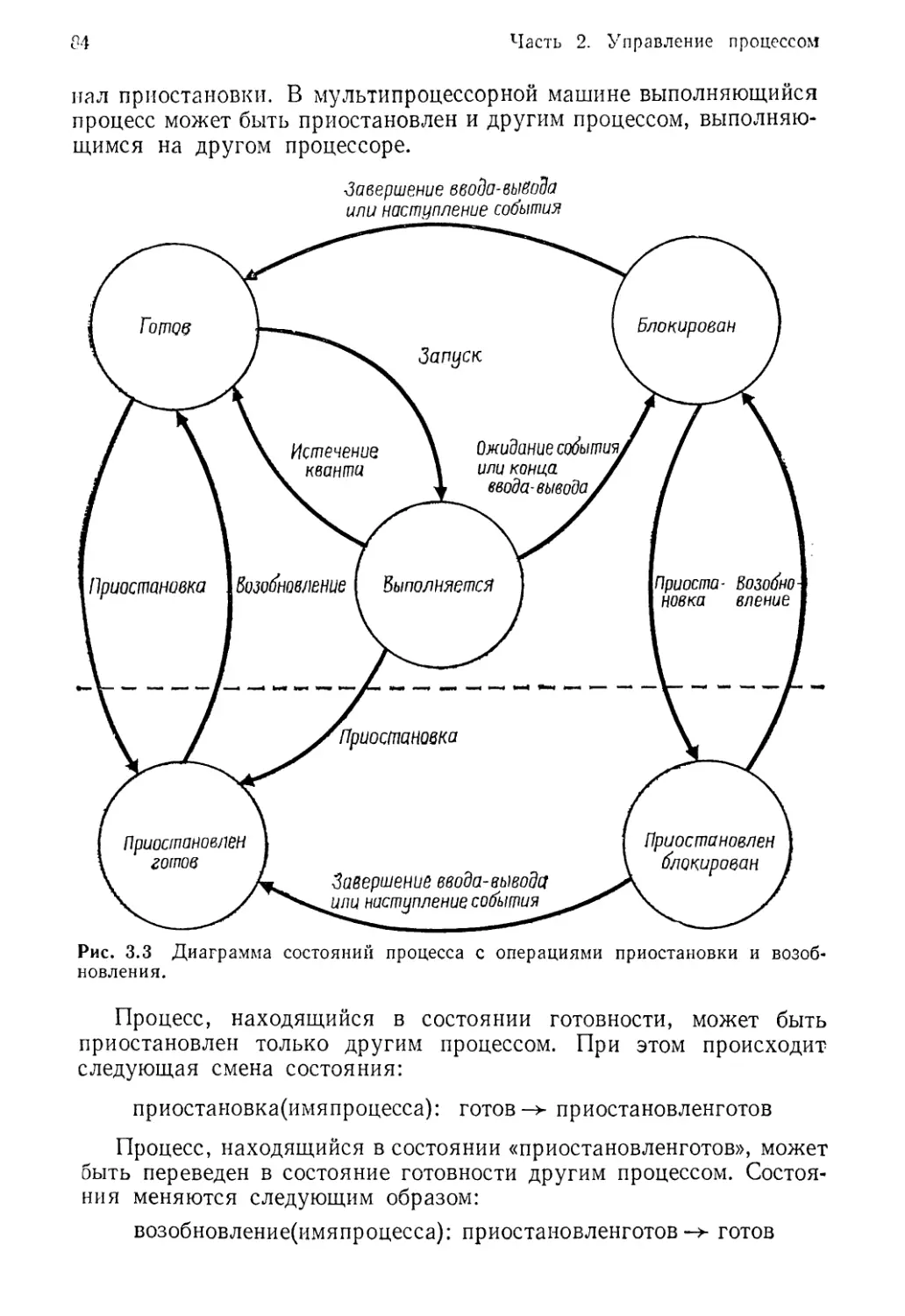

В части 2 даются понятия процесса, перехода процесса из состоя¬

ния в состояние, прерывания, переключения контекста, структуры

операционных систем, асинхронности, взаимоисключения, монито¬

ров и тупиков (дедлоков). В гл. 3 вводятся различные концепции,

связанные с управлением процессами, и рассматривается организа¬

ция прерываний в крупных процессорах фирмы IBM; этот материал

понадобится в дальнейшем (в конце книги) при описании операци¬

онных систем MVS и VM. В гл. 4 введено понятие асинхронности.

Здесь обсуждаются проблемы, возникающие в случае совместного

доступа к разделяемым ресурсам, а также описаны различные спо¬

собы взаимоисключения,— как аппаратные, так и программные,—

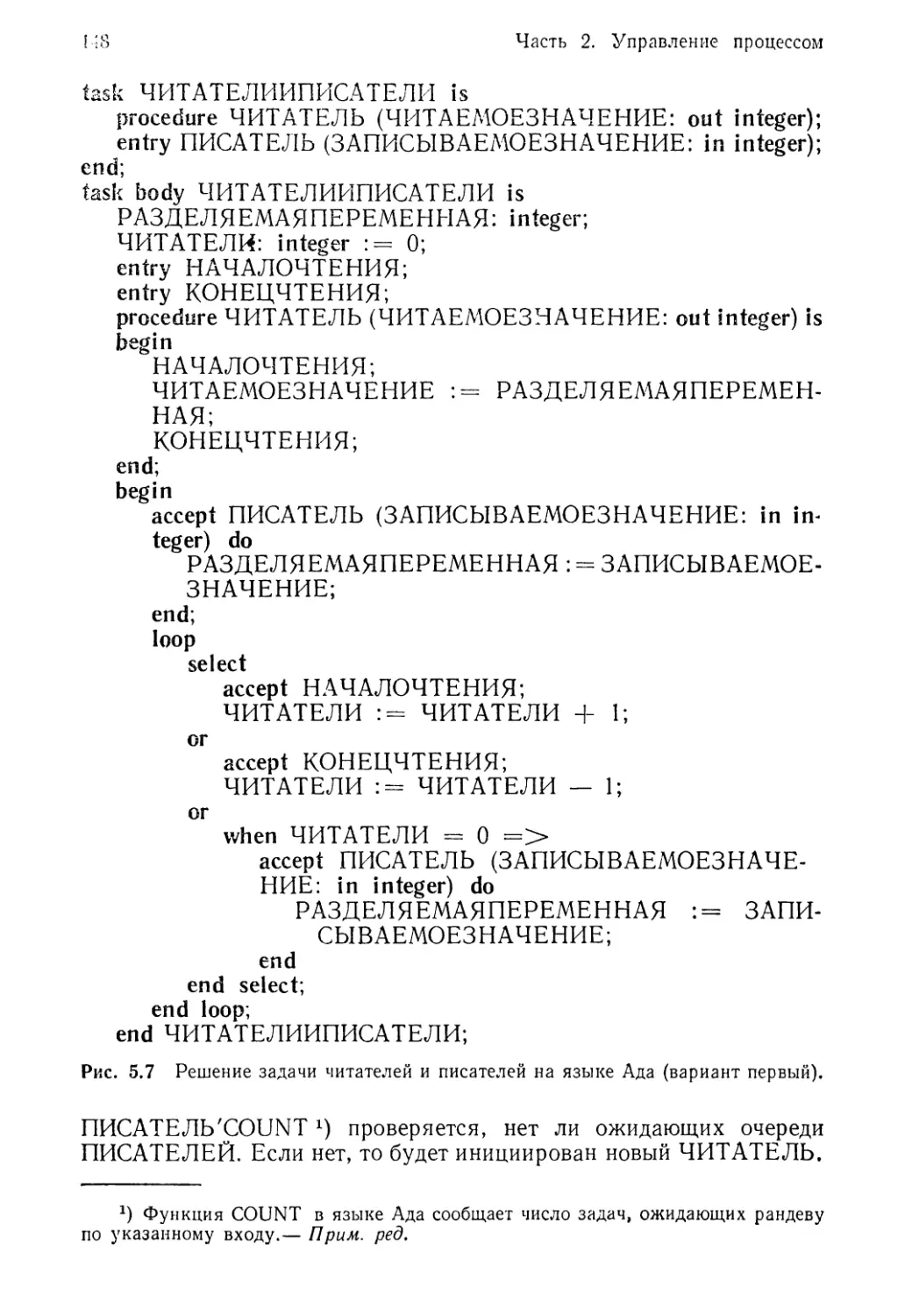

обеспечивающие решение этих проблем. В гл. 5 речь идет о монито¬

рах и о том, каким образом их можно использовать для решения

классических проблем параллелизма; приведено описание механиз¬

мов «кольцевой буфер» и «читатели и писатели», реализуемых при

помощи мониторов. В конце главы описывается параллельное про¬

граммирование на языке Ада, новом языке, разработанном по за¬

данию правительства Соединенных Штатов.

Многие из приведенных в книге отрывков программ на языке

Ада построены на основе примеров, взятых из Preliminary Ada

Предисловие

9

Reference Manual1), SIGPLAN NOTICES, vol. 14, № 6, June 1979,

part А, и Ichbiah J. D., Heliard J. C., RoubineO., Barnes J. G. P.,

Krieg-Brueckner B., Wichman B. A., Rational for the Design of the

Ada Programming Language, SIGPLAN NOTICES, vol. 14, № 6,

June 1979, part В. («Правительство Соединенных Штатов Америки

предоставляет бесплатное разрешение на перепечатку настоящего

документа с целью оценки и применения языка Ада»). (Ада —

это зарегистрированное торговое название языка правительствен¬

ной организации США Ada Joint Program Office.)

В гл. 6 объясняется, что такое тупик (дедлок), при .котором вы¬

полнение различных процессов не может продолжаться — по¬

скольку они ожидают событий, которые никогда не произойдут.

В этой главе обсуждаются основные направления исследователь¬

ских работ по проблеме тупиков и представлены различные сред¬

ства решения этой проблемы и близкой проблемы бесконечного от¬

кладывания процесса. Глава содержит подробное описание алгорит¬

ма банкира; этот алгоритм, который предложил Дейкстра, позволяет

избежать тупиков.

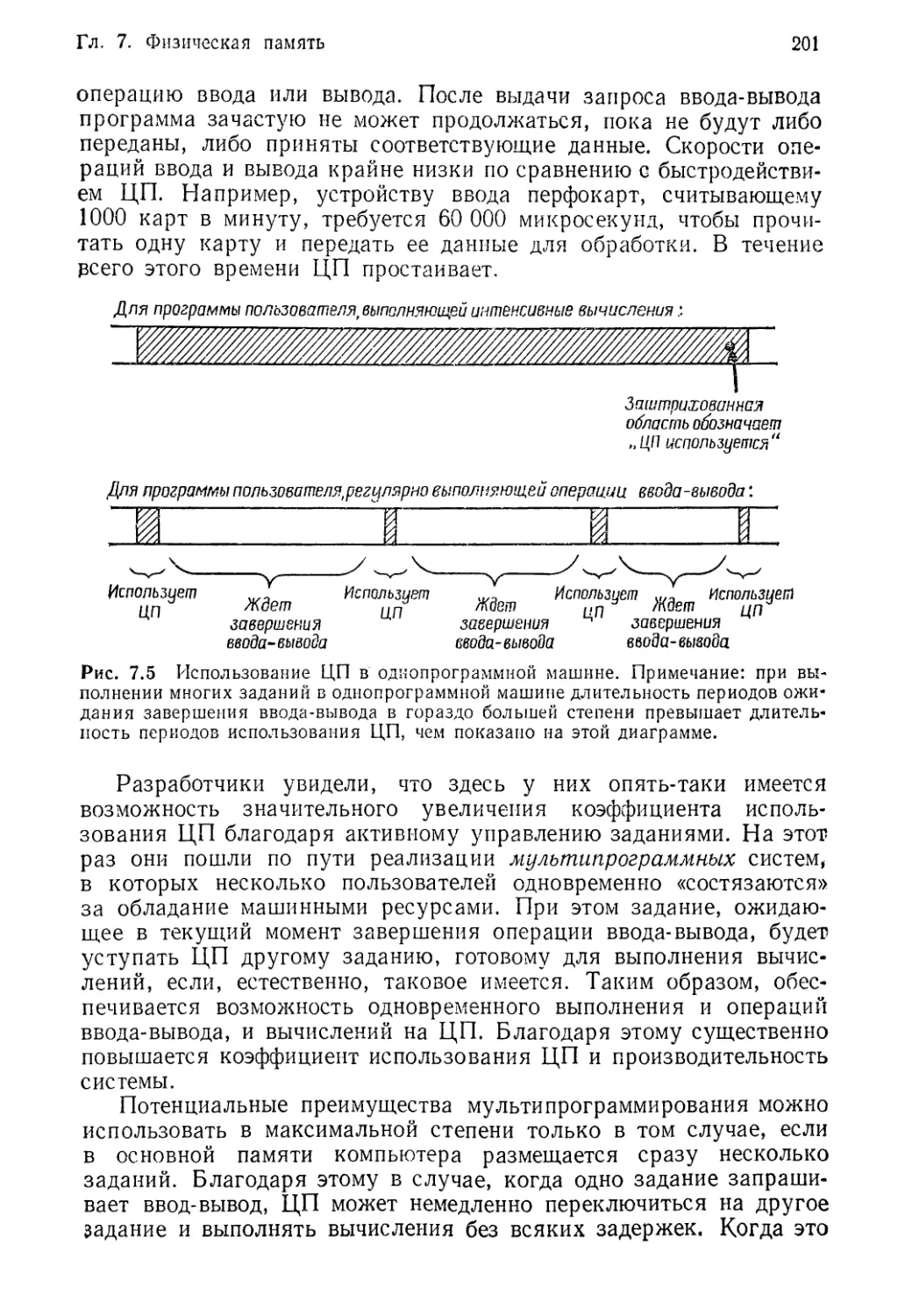

В части 3 обсуждаются проблемы управления памятью в систе¬

мах физической (реальной) и виртуальной памяти. В гл. 7 просле¬

живается развитие систем реальной памяти — от систем, где вся

память предоставлялась в распоряжение одного пользователя, до

мультипрограммных систем с различными видами распределения

памяти. В гл. 8 и 9 описываются организация и управление вирту¬

альной памятью соответственно. В гл. 8 объясняется концепция вир¬

туальной памяти и показано, каким образом благодаря применению

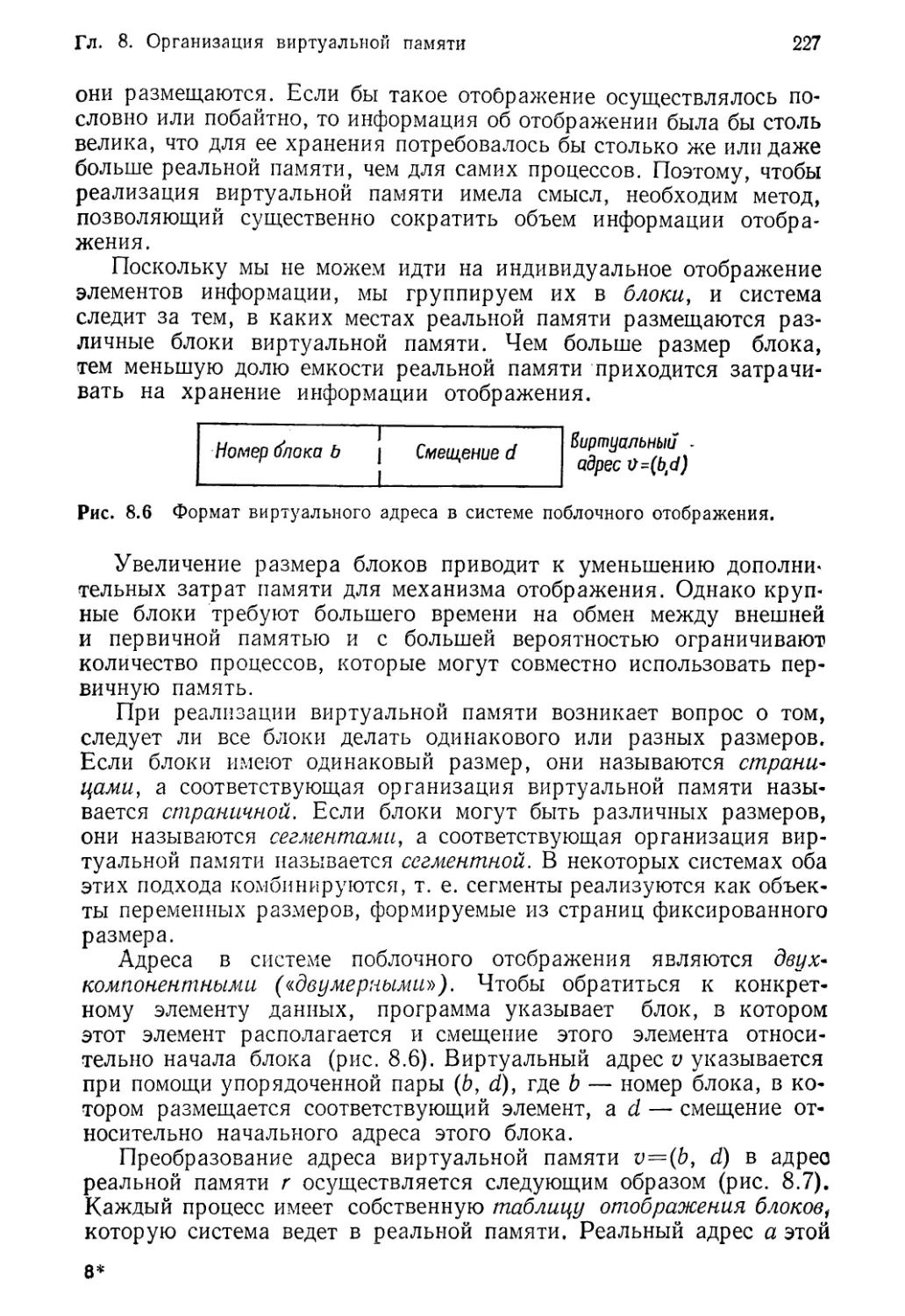

методов поблочного отображения, страничной организации и сегмен¬

тации памяти можно уменьшить объем информации отображения.

Приводится подробное описание реализации виртуальной памяти

и преобразования адресов в системах со страничной организацией

и сегментацией памяти. В гл. 9 обсуждаются различные стратегии

управления системами виртуальной памяти. Рассматриваются втал¬

кивания, размещения и выталкивания данных, причем обсуждаются

стратегии вталкивания по требованию и упреждающего вталкивания.

Основное внимание в этой главе уделяется стратегиям выталкива¬

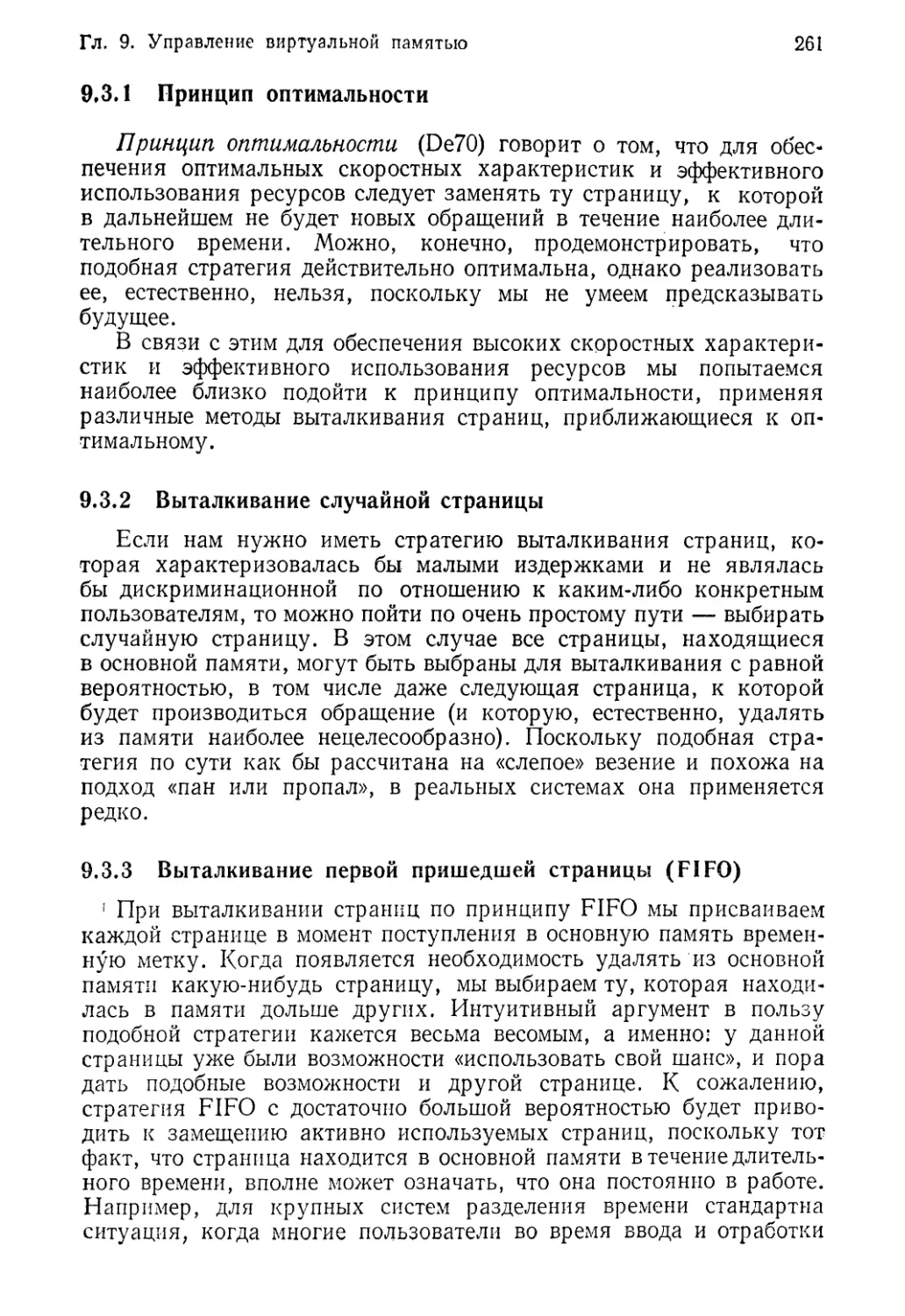

ния (подкачки) страниц; рассматриваются принцип оптимальности

и стратегии выталкивания страниц по случайному закону, по прин¬

ципу FIFO, LRU, LFU и NUR. Затем рассказывается о предложен¬

ной Деннингом теории поведения программ с рабочим множеством

страниц и анализируется выталкивание страниц рабочего мно¬

жества.

В части 4 идет речь об управлении процессорами, в частности

о проблемах планирования загрузки процессоров и о мультипро¬

цессорном режиме. В гл. 10 основное внимание сосредоточено на

пеРев°Д: Язык программирования Ада (предварительное описа¬

ние;.— м.: Финансы и статистика, 1982.— Прим. ред.

10

Предисловие

стратегиях планирования; здесь обсуждается планирование на

верхнем уровне, промежуточном и нижнем уровне, цели и критерии

планирования, приоритетное планирование, статические и динами*

ческие приоритеты, «заслуженные» или «купленные» приоритеты,

а также планирование по предельному сроку. Представлены раз¬

личные алгоритмы планирования, в том числе FIFO, RR (цикличе¬

ский), SJF, SRT и HRN. Эта глава заканчивается подробным ана¬

лизом механизмов многоуровневых очередей с обратными связями.

В гл. 11 обсуждаются мультипроцессорные системы, разработанные

как средство повышения производительности и надежности машин.

Рассматривается использование достоинств параллелизма; обсуж¬

даются методы автоматического распараллеливания и правило «ни¬

когда не ждать». Анализируются различные мультипроцессорные

аппаратные архитектуры и варианты организации операционных

систем. Эти вопросы во многом перекликаются с материалом по

вычислительным сетям, который приводится в гл. 16.

Часть 5 посвящена управлению внешней памятью. В гл. 12 об¬

суждаются вопросы планирования работы с магнитными дисками;

здесь идет речь о том, как функционирует накопитель на диске с дви¬

жущимися магнитными головками, излагаются причины, обуслав¬

ливающие необходимость планирования работы с дисками, а также

представляются наиболее распространенные стратегии планирова¬

ния обращений к дисковой памяти, в том числе FCFS, SSTF, SCAN,

N-шаговый SCAN, C-SCAN, схема Эшенбаха и оптимизация по вре¬

мени ожидания записи. Приводится ряд системных соображений,

которые могут повлиять на эффективность планирования работы

с дисками.

В гл. 13 рассматриваются системы управления файлами и базами

данных. В этой главе обсуждаются функции и принципы работы

файловой системы; иерархия данных; объединение записей в блоки

и буферизация: варианты организации файлов с последовательным,

индексно-последовательным, прямым и библиотечным доступом;

базовые методы доступа и методы доступа с очередями; иерархиче¬

ская структура файловой системы; связное и несвязное распределе¬

ние памяти; поблочное распределение при помощи списков и таблиц

отображения, дескрипторы файлов, управление доступом; копиро¬

вание и восстановление информации. Подчеркивается важное значе¬

ние баз данных, особенно с точки зрения операционных систем;

обсуждаются преимущества баз данных, независимость данных,

языки баз данных, понятие администратора базы данных, распре¬

деленной базы данных, словаря данных. Глава заканчивается об¬

суждением иерархической, сетевой и реляционной моделей баз дан¬

ных.

Часть 6 посвящена проблемам производительности и эффектив¬

ности вычислительных машин. В гл. 14 рассматриваются вопросы

измерения, контроля и оценки производительности и эффективно¬

сти. Обсуждаются такие средства и методы оценки скоростных

Предисловие

11

характеристик, как элементарные времена, смеси команд, образцо¬

вые программы, аналитические модели, измерительные программы,

синтетические программы, моделирование и контроль производи¬

тельности. Анализируются проблемы локализации и исключения

узких мест. Рассматриваются механизмы с отрицательной и поло¬

жительной обратной связью. Эта глава включает очень большой

набор упражнений, многие из которых могут послужить темами для

курсовых проектов, в частности для учащихся, интересующихся

моделированием.

В гл. 15 представлен математический аппарат для аналитиче¬

ского моделирования; здесь рассматриваются модели теории очере¬

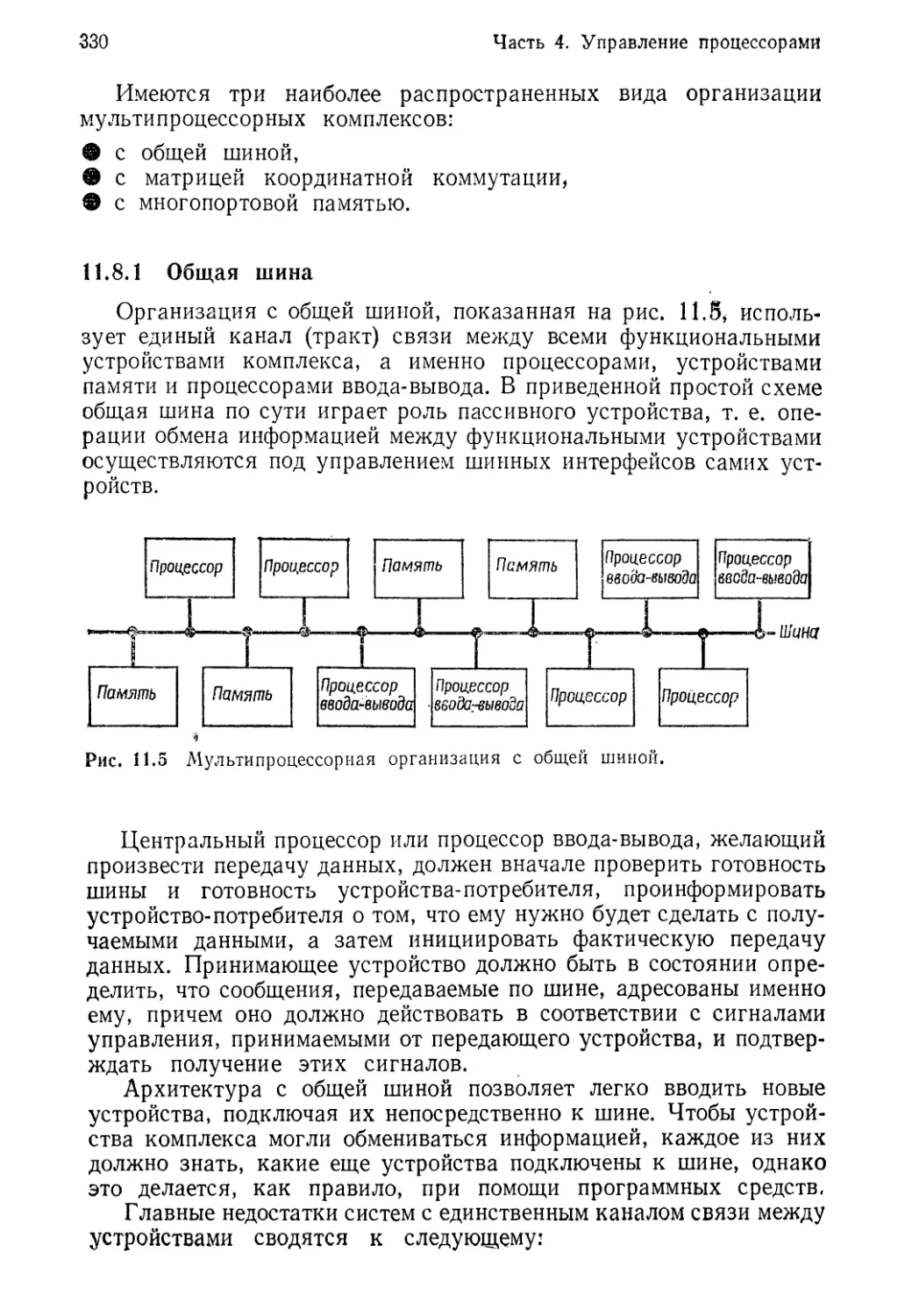

дей и марковские процессы. Эту главу в принципе можно опустить

без ущерба для целостности курса, однако ее настоятельно рекомен¬

дуется изучить тем студентам, которые уже в определенной степени

освоили теорию вероятностей и методы статистических вычислений.

В той части главы, которая относится к теории очередей, обсуж¬

даются такие понятия, как источник требований* входящий поток,

пуассоновский входящий поток, времена обслуживания, размеры

очередей, количество обслуживающих устройств, дисциплины оче¬

редей, приведенная интенсивность, загрузка обслуживающего уст¬

ройства, установившееся и переходное состояния, а также резуль¬

тат Литтла. Приведены два примера для изучения: анализ систем

массового обслуживания М/М/1 и М/М/С. В части главы, посвящен¬

ной марковским процессам, рассматривается специальный вариант

моделей «размножения и гибели»; в качестве примера достаточно под¬

робно анализируются скоростные характеристики дисковой под¬

системы.

В части 7 рассматриваются вычислительные сети и проблемы

защиты. В гл. 16 под названием «Сетевые операционные системы»

обсуждаются сети различных типов, в том числе сети разделения

ресурсов, распределенных вычислений и сети удаленного доступа.

Приведено подробное обсуждение сетей с коммутацией пакетов;

в главе описана семиуровневая архитектура эталонной модели сое¬

динения открытых систем Международной организации по стан¬

дартизации (ISO OSI), стандарт Х.25, а также модели с дейтаграм¬

мами и виртуальными каналами. Обсуждаются сетевые операцион¬

ные системы, а также примитивы, необходимые для их работы,—

примитивы обмена данными между пользователями, пересылки

заданий, пересылки данных и управляющие примитивы. Анализи¬

руются распространенные варианты организации сетей, в том числе

топологии типа звезда, кольцо и произвольный граф. Вводятся

понятия защиты, секретности, шифрования и контроля права до¬

ступа; более подробно они обсуждаются в гл. 17. Детально рас¬

сматриваются вопросы построения локальных сетей; объясняются

методы CSMA/CD. Описывается работа сети Ethernet. В конце главы

в качестве примера для изучения описывается сеть DECnet фирмы

Digital Equipment Corp, и ее сетевая архитектура DNA. В этом

12

Предисловие

примере особое внимание уделяется функциям и возможностям,

предусмотренным в главной сетевой операционной системе, особенно

средствам управления файлами и обеспечения взаимодействия меж¬

ду процессами.

Глава 17 посвящена проблеме безопасности (защиты) компьюте¬

ров и подчеркивает, насколько важно учитывать эту проблему

при создании операционных систем. В главе обсуждаются требо¬

вания по защите, необходимость комплексного подхода к защите,

а также такие понятия, как внешняя безопасность, операционная

безопасность, надзор, профилактический контроль, расширение

прав доступа, защита при помощи паролей, ревизия, контроль до¬

ступа, безопасные ядра, аппаратная защита и живучие системы.

В главе рассмотрены объектно-ориентированные системы с меха¬

низмами полномочий (мандатов); в настоящее время этим средствам

уделяется большое внимание, поскольку они дают возможность

создания систем повышенной секретности, В качестве примера опи¬

сана объектно-ориентированная архитектура System/38 фирмы

IBM. Рассказывается о криптографии; описывается криптографи¬

ческая система обеспечения секретности; объясняется, что такое

криптоанализ, системы шифрования открытым ключом, цифровые

подписи (сигнатуры), а также схемы шифрования (дешифрования)

данных DES и RSA; указываются многочисленные применения

криптографии. Стандарт на шифрование данных DES, опублико¬

ванный правительством Соединенных Штатов, приводится в прило¬

жении к настоящей книге. Подробно рассмотрена проблема взлома

защиты операционной системы; перечисляются наиболее распро¬

страненные категории принципиальных недостатков систем и наи¬

более распространенные способы проникновения через защиту

операционных систем. Глава завершается примером, в котором

рассказывается об успешном взломе защиты одной из существую¬

щих операционных систем.

В части 8 приводятся пять примеров, где подробно рассматри¬

ваются некоторые важные операционные системы, а именно Unix,

VAX/VMS, СР/М, MVS и VM. Если в основном тексте книги рас¬

сматриваются общие принципы, то в этих примерах речь идет о ре¬

альных проблемах реальных операционных систем.

В гл. 18 рассматривается операционная система Unix, разрабо¬

танная фирмой Bell Laboratories. Систему Unix можно считать пря¬

мо-таки чудом нашего времени. Ее разработали практически два

специалиста для собственных нужд. Сейчас ее используют в универ¬

ситетах и в промышленных организациях во всем мире. Довольно

большую популярность приобретают и ее версии, разработанные

для персональных компьютеров; некоторые энтузиасты считают, что

система Unix в конце концов вытеснит систему СР/М и станет де-

факто стандартной операционной системой для персональных

компьютеров. (Этот вопрос обсуждается также в гл. 20.) При опи¬

сании системы Unix особое внимание уделяется оригинальной сис¬

Предисловие

13

теме ввода-вывода и впервые реализованным в Unix концепциям

программных транспортеров, конвейеров и фильтров. В этой же

главе приводится еще один пример — описывается операционная

система XENIX, версия системы Unix, разработанная фирмой

Microsoft для 16-битовых микрокомпьютеров. Фирма Microsoft

поставляет операционную систему XENIX для персонального

компьютера PC фирмы IBM.

В гл. 19 рассматривается наиболее известная операционная сис¬

тема фирмы Digital Equipment Corp., VAX/VMS. Система VAX —

результат перехода от 16-битовой архитектуры известных мини¬

компьютеров серии PDP-11 фирмы DEC к популярным в настоящее

время 32-битовым машинам с виртуальной памятью. В данной главе

основное внимание уделяется таким вопросам, как управление па¬

мятью, планирование процессов, ввод-вывод, управление записями,

взаимодействие между процессами и синхронизация процессов.

Семейство VAX может служить довольно типичным примером уси¬

лий сегодняшних изготовителей миникомпьютеров по созданию

машин, по вычислительной мощности соперничающих с крупными

ЭВМ. В главе по миникомпьютерам VAX широко использованы

сведения, взятые из книг Computer Programming and Architecture:

The VAX-11, H. M. Levy, R. H. Eckhouse, Jr., Digital Press, 1980

и VAX-11 Software Handbook, Digital Equipment Corporation,

1981. Автор выражает благодарность за разрешение использовать

эти материалы.

В гл. 20 обсуждается операционная система СР/М фирмы Digital

Research для микрокомпьютеров. Система СР/М вначале была раз¬

работана для 8-битовых микропроцессоров, которые использовались

в качестве центральных процессоров таких первых персональных

компьютеров, как TRS-80 Model 1 фирмы Radio Shack; в даль¬

нейшем разработчики существенно расширили возможности систе¬

мы СР/М для применения в области 16-битовых компьютеров —

и сейчас ее версия СР/М-86 предлагается для 16-битового персональ¬

ного компьютера PC фирмы IBM. В данной главе описывается язык

PL/М, проблема мобильности программ, системы с табличным уп¬

равлением, распределение памяти, отображение логических уст¬

ройств на физические, процессор команд консоли (ССР), базовая

система ввода-вывода (BIOS), базовая дисковая операционная сис¬

тема (BDOS) и файловая система. В главе приведены два «встроен¬

ных» примера для изучения: описывается система МР/М, много¬

абонентская система разделения времени, выполненная на базе

СР/М; и система СР/NET, сетевая операционная система для мик¬

рокомпьютеров, работающих под управлением операционных сис¬

тем СР/М и МР/М.

В гл. 21 описывается мощная операционная система MVS фирмы

IBM, разработанная для очень крупных процессоров. В этой главе

прослеживается история развития операционных систем фирмы

IBM, начиная с момента анонсирования System/360. Дается обзор

14

Предисловие

важных аспектов аппаратной архитектуры машин фирмы IBM.

Затем подробно описываются многие средства и методы, реализо¬

ванные в системе MVS, в том числе такие функциональные компо¬

ненты системы, как супервизор, главный планировщик, подсистема

ввода заданий, средства управления системой и средства регистра¬

ции событий в системе, подсистема разделения времени TSO, сред¬

ства управления данными, менеджер реальной памяти RSM, ме¬

неджер вспомогательной памяти ASM, менеджер виртуальной

памяти VSM, менеджер ресурсов системы SRM, а также органи¬

зация памяти, управление ресурсами, замки, примитивы захвата

ресурсов Enqueue и Reserve, задачи, запросы oбcлyживaнияj

мультипроцессорный режим, вопросы производительности и эф¬

фективности и контроль событий в системе.

В гл. 22 рассказывается об операционной системе, которая яв¬

ляется, по-видимому, самой оригинальной из всех систем, приве¬

денных в качестве примеров, а именно об операционной системе

виртуальных машин VM фирмы IBM. Эта операционная система

дает возможность одной вычислительной машине работать одновре¬

менно с несколькими операционными системами, причем на машине

могут использоваться либо совершенно различные версии одной и

той же системы — что позволяет, например, отлаживать новый

вариант системы, в то время как рабочая система продолжает ис¬

пользоваться для производственного счета. Принципы, реализован¬

ные в операционной системе VM, находят, в частности, интересные

применения в вычислительных сетях,— свидетельством тому может

служить концепция машины Hydra фирмы IBM и системы Kangaroo

фирмы Spartacus Computers (Datamation, August 1981). В данной

главе описана история развития системы VM, управляющая про¬

грамма СР, вталкивание страниц по запросу, минидиски, управле¬

ние с пульта, классы привилегированности пользователей, директо¬

рий системы VM, интерактивная мониторная система CMS, система

пересылки файлов между компьютерами и удаленного ввода-вы¬

вода (RSCS); рассмотрены факторы, определяющие производи¬

тельность, микропрограммные поддержки виртуальной машины,

расширенные средства поддержки управляющей программы, сред¬

ства измерения и анализа производительности, вопросы надежности,

готовности и удобства эксплуатации. В конце главы обсуждается

вопрос о том, почему операционная система VM может стать основ¬

ной операционной системой фирмы IBM для крупных машин в пе¬

риод с середины до конца 80-х годов.

Обширный материал по пяти операционным системам, выбран¬

ным в качестве примера, позволяет сравнивать достоинства и не¬

достатки различных конструкций и принципов реализации, приме¬

няемых в современных операционных системах. Приведенные при¬

меры охватывают весь диапазон операционных систем, от «крошеч¬

ной» системы СР/М до громадных систем типа MVS. Здесь описы¬

ваются операционные системы для крупных компьютеров, такие.

Предисловие

15

как MVS и VM, миникомпьютерные операционные системы VAX/

/VMS и Unix и микрокомпьютерные операционные системы СРАМ

и XENIX. Читатель может получить представление о системах

реальной памяти и системах виртуальной памяти, системах реаль¬

ных машин и системах виртуальных машин, одноабонентских и

многоабонентских системах, автономных системах, многопроцес¬

сорных системах и сетевых системах.

Я считаю своим приятным долгом выразить признательность тем

многим людям, которые помогли мне в работе над настоящей кни¬

гой. Особенно благодарен я сотням авторов, перечисленных в биб¬

лиографических разделах в конце каждой главы; их превосходные

статьи и книги содержат множество разнообразного и интересного

материала, который делает операционные системы столь заниматель¬

ным предметом. Эту книгу рецензировали специалисты во многих

областях. Главными рецензентами были Джеймс Петерсон (Техас¬

ский университет в Остине), Ричард Вексельблатт (фирма Sperry

Univac), Пол Росс (Миллерсвильский государственный колледж)

и Энтони Люсидо (фирма Intercomp).

Те разделы книги, где говорится об аппаратуре компьютеров,

микропрограммировании и защите компьютеров, рецензировал

Стив Перис (фирма Prime Computer). Барт Гуэррери, президент

фирмы DSD Laboratories, существенно помог мне своими ценными

советами по аппаратным средствам. Натан Тобол, инженер-кон¬

сультант фирмы Codex Corporation и председатель подкомитета

IEEE 802 Local-Area Networking, рецензировал гл. 16 «Сетевые

операционные системы» и предоставил для нее ценный материал из

одной из своих будущих статей. Ларри Нельсон, руководитель от¬

дела сопровождения систем фирмы AVCO Services, предоставил

основную часть материала, приведенного в описании операционной

системы MVS, а также еще много полезных предложений по системе

VM. Барри Шейн, выполняющий функции администратора систем

UNIX и VAX в Гарвардском университете, дал много важных

рекомендаций, которые помогли мне исправить отдельные слабые

места в описании этих систем. Вильям Блохер, президент фирмы The

Bit Bucket, предоставил ценные сведения по системе СР/М.

Элизер Гафни (МТИ), Анат Гафни и Джозефина Бондок (Бос¬

тонский университет) тщательно проверили гл. 15 «Аналитическое

моделирование»; этот материал по теории очередей и марковским

процессам был значительно переработан по их многочисленным

рекомендациям.

В числе тех, кто оказывал мне помощь и поддержку на протя¬

жении всей работы над книгой, я хотел бы поблагодарить Юлиуса

оигманщ Мириам Зигман, Стефани Гуэррери, Эрика Шумейкера,

Мэри Уайлс, Стивена Бредрика, Ричарда Майлса и Ширли Спэс.

Мои издательский редактор Уильям Искэмп (Addison-Wesley)

проделал громадную работу по подготовке настоящей книги к вы¬

пуску. Он без всяких колебаний преданно участвовал в работе над

16

Предисловие

книгой, оказал очень большое влияние на форму и стиль изложе¬

ния, причем сыграл решающую роль в своевременном выпуске го¬

товой книги.

Моя жена Барбара и дети Пол и Эбби проявили удивительное

понимание и оказали мне громадную помощь, без чего эта книга

просто не могла бы быть написана. Все вместе они затратили при¬

близительно 2000 часов на поиск, сортировку, переписывание,

редактирование и корректорскую правку материала. Их усилия

помогли мне закончить работу над книгой на год раньше заплани¬

рованного срока.

Уильям Б. Тренер, главный редактор по вычислительной техни¬

ке (Addison-Wesley), является моим руководителем и наставником

по издательскому делу с 1978 г. Только благодаря Биллу стал

возможен сам факт издания этой книги. Он и издательство Addison-

Wesley предоставили в мое распоряжение колоссальные ресурсы.

Я надеюсь, что эта работа оправдает то доверие и те надежды, кото¬

рые они возлагали на меня.

Безусловно, работа такого масштаба не может быть свободна от

недостатков. Я принимаю на себя полную ответственность за любые

невыявленные ошибки. В настоящее время я собираю дополнитель¬

ный материал и готовлю следующую редакцию настоящей книги,

поэтому я буду весьма благодарен за все предложения, критические

замечания и поправки.

Фреймингем, шт. Массачусетс

август, 1983

Г. м. д.

Об авторе

Др. Гарви М. Дейтел имеет 22-х летний стаж работы в области

информатики. За это время он принял участие в разработке не¬

скольких крупных операционных систем, а также в разработке и вне¬

дрении большого числа коммерческих систем. Степень бакалавра,

а затем магистра он получил в Массачусетском технологическом

институте (МТИ), где принимал активное участие в создании опе¬

рационной системы Multics. Степень доктора наук он получил в

Бостонском университете. Его докторская диссертация была по¬

священа проблемам разработки очень больших структурированных

систем программного обеспечения.

Разработкой операционных систем др. Дейтел занимается

с 1965 г. Он участвовал в разработках систем OS и TSS в фирме

IBM и системы Multics в МТИ. Одновременно он консультировал

фирмы Epson, Advanced Computer Techniques Corporation, Computer

Usage Corporation, Harbridge House, Inc., American Express, IBM

Systems Development Division, IBM Advanced Systems Development

Division, IBM Thomas J. Watson Research Center, Project MAC

в МТИ и многочисленные энергетические компании и компании,

занимающиеся операциями с недвижимым имуществом.

В настоящее время др. Дейтел работает на факультете информа¬

тики Бостонского университета, где читает курсы лекций по систем¬

ному программированию, архитектуре компьютеров, операционным

системам, технологии программирования и компьютерным сетям.

Преподавательская деятельность др. Дейтела неоднократно отме¬

чалась и сейчас он является одним из наиболее известных в США

преподавателей в области информатики.

Др. Дейтел — член нескольких почетных научных обществ,

в том числе Таи Beta Pi, Eta Карра Nu и Sigma Xi. Он является

обладателем профессионального аттестата ICCP (Института атте¬

стации специалистов по электронным вычислительным машинам)

и состоит членом множества научных обществ, включая АСМ (Ас-

TFPpU/T? П° К0МпьютеРн°й технике) и компьютерное общество

12 (Института инженеров по электротехнике и электронике),

реди научных публикаций др. Дейтела — такие работы: Absentee

computations in a Multiple-Access Computer System, MAC-TR-52

18 Об авторе

1968 Advanced Research Projects Agency, Department of Defense

(Управление перспективных исследовательских программ мини¬

стерства обороны США); Introduction to Computer Programming

with the BASIC Language, Prentice-Hall, 1977i Structured Software

Development, докторская диссертация, опубликована University

Microfilms, 1980; Operating Systems (в соавторстве e Гарольдом

Лорином из IBM Systems Research Institute), Addison-Wesley,

1980, и Functions of Operating Systems (в соавторстве с Гарольдом

Лорином) Software World, Vol. 12, No. 2, pp. 2—13, 1981.

ЧАСТЬ 1

Обзор

Глава 1

Краткий обзор1)

Лишь в конце работы мы обычно узнаем, с чег»

нужно было ее начать,

Блез Паскаль

«С чего начинать, Ваше Величество?» — спросил он,

«Начни с начала,— важно ответил Король,— и продол¬

жай, пока не дойдешь до конца. Как дойдешь — кончай!»

Приключения Алисы в стране чудес

Льюис Кэрролл 2)

Кусочек подлинной истории — это такая редкая

вещь, что им надо очень дорожить.

Томас Джефферсон

1.1 Введение

1.2 Поколения операционных систем

1.2.1 Нулевое поколение (40-е годы)

1.2.2 Первое поколение (50-е годы)

1.2.3 Второе поколение (начало 60-х годов)

1.2.4 Третье поколение (середина 60-х — середина 70-х годов)

1.2.5 Четвертое поколение (от середины 70-х годов до насто¬

ящего времени)

1.3 Первые операционные системы

1.4 Разработки начала 60-х годов

1.5 Компьютеры семейства System/360 фирмы IBM

1.6 Реакция промышленности на появление System/360

1.7 Системы с разделением времени

1.8 Появление новой инженерной дисциплины — технологии кон¬

струирования программ

1.9 Разделение цен на аппаратуру и программное обеспечение

1.10 Перспективы

1.1 Введение

Лишь немногие из тех, кто будет читать эту книгу, могут вспом¬

нить время, когда операционных систем вообще не существовало.

Сегодня операционные системы применяются практически на всех

вычислительных машинах — от гигантских супер-ЭВМ до миниа¬

тюрных персональных компьютеров. Операционные системы за¬

частую даже в большей степени определяют представление пользо-

вателя о машине, чем сама аппаратура этой машины. Например, в

т) Настоящая глава включает некоторые факты и мысли из статьи Н. Вайцера

об истории операционных систем (N. Weizer, «А History of Operating Systems»,

Datamation magazine (January 1981). Copyright © 1981 by Technical Publishing.

A г?Пп Bradstreet Company. All rights reserved. Adapted with permission).

) В переводе H. Демуровой.

20

Часть 1. Обзор

сфере персональных компьютеров де-факто стандартной стала

операционная система СР/М (см. гл. 21), так что очень многие

фирмы — изготовители компьютеров создают новые аппаратные

средства с ориентацией на эту операционную систему. Пользователь

видит аппаратуру компьютера — скажем дисплей на электронно¬

лучевой трубке и клавиатуру,— однако функциональные возмож¬

ности машины ему обеспечивает операционная система СР/М *)•

В 1960-х годах операционную систему можно было определить

как «программные средства, обеспечивающие управление аппарату-

рой». В настоящее время, однако, наблюдается явная тенденция

к миграции многих функций от традиционных программ к микро¬

программам, т. е. к микрокоду (см. гл. 2). Эта тенденция сейчас

становится практически общепринятой — поэтому с большой веро¬

ятностью можно полагать, что в некоторых системах микрокод

по объему реализуемых функций вскоре превзойдет обычные про¬

граммные средства.

Очевидно, что необходимо иметь более четкое и адекватное

определение операционной системы. Мы считаем, что операцион¬

ная система — это набор программ, как обычных, так и микро¬

программ, которые обеспечивают возможность использования ап¬

паратуры компьютера. При этом аппаратура компьютера предо¬

ставляет «сырую» вычислительную мощность, а задача операционных

систем заключается в том, чтобы сделать аппаратуру доступной

и по возможности удобной для пользователей. Операционные систе¬

мы обеспечивают также рациональное и координированное управ¬

ление аппаратурой для достижения высокой производительности

(см. ч. 6).

Однако независимо от того, какое именно определение мы вы¬

берем для операционной системы, ясно одно: она является неотъ¬

емлемой частью вычислительного комплекса, и поэтому каждый

пользователь компьютера должен в той или иной степени представ¬

лять себе ее функции.

Некоторые из существующих в настоящее время операционных

систем для своей работы требуют очень большой части ресурсов

компьютера. Пользователи часто рассматривают это как своего

рода «тайный заговор» изготовителей аппаратуры для увеличения

объема продажи выпускаемых ими изделий. В то же время боль¬

шинство изготовителей аппаратуры рассматривают операционные

системы как неизбежное зло — поскольку без них аппаратуру

вообще нельзя было бы продавать. Эти крайние позиции сейчас

несколько сближаются благодаря появлению микро-ЭВМ и персо¬

нальных компьютеров с относительно простыми операционными

системами. Вместо того чтобы предлагать только крупные универ¬

сальные операционные системы с максимальными возможностями,

9 СР/М — зарегистрированное торговое название системы фирмы Digital

Research.

Гл. 1. Краткий обзор

21

что считали для себя обязательным промышленные фирмы в 60-х и

начале 70-х годов, поставщики (в том числе независимые компании)

сейчас предлагают также более простые операционные системы,

которые позволяют создать удобные условия для вычислений

(вычислительную обстановку) в соответствии с конкретными тре¬

бованиями индивидуальных пользователей.

Главное назначение операционной системы—это управление

ресурсами, а главные ресурсы, которыми она управляет,— это

аппаратура компьютера. Операционная система реализует мно¬

жество различных функций, в том числе:

• определяет так называемый «интерфейс пользователя»;

• обеспечивает разделение аппаратных ресурсов между пользо¬

вателями;

• дает возможность работать с общими данными в режиме коллек¬

тивного пользования;

• планирует доступ пользователей к общим ресурсам;

• обеспечивает эффективное выполнение операций ввода-вывода;

• осуществляет восстановление информации и вычислительного

процесса в случае ошибок.

Операционная система управляет следующими основными ре¬

сурсами:

• процессорами;

• памятью;

• устройствами ввода-вывода;

• данными.

Операционная система взаимодействует с

• операторами ЭВМ;

• прикладными программистами;

• системными программистами;

• административным персоналом;

• программами;

• аппаратными средствами;

• пользователями (например, банковскими кассирами).

Пользователи — это абоненты вычислительного комплекса, ко¬

торые применяют компьютер для выполнения полезной работы.

Операторы ЭВМ — это специально подготовленные люди, которые

следят за работой операционной системы, по запросам системы

вмешиваются в работу компьютера для устранения каких-либо

препятствий, устанавливают и снимают кассеты магнитных лент

и пакеты магнитных дисков, ставят и вынимают колоды перфокарт,

обеспечивают правильную заправку в печатающие устройства бу¬

маги нужного формата и т. д. Операторы ЭВМ играют очень важную

роль с точки зрения обеспечения нормальной работы машины. Они

22

Часть 1. Обзор

выполняют те функции, которые пока что не удается автоматизи¬

ровать.

Системные программисты занимаются обычно сопровождением

операционной системы, осуществляют ее настройку применительно

к требованиям конкретной машины и при необходимости доработку

для обслуживания новых типов устройств.

Администраторы систем — это люди, которые устанавливают

принципы и порядок работы на ЭВ/М и взаимодействуют с опера¬

ционной системой, чтобы обеспечить соблюдение принятого порядка.

Программы обращаются к операционным системам при помощи

специальных команд, известных под различными названиями: вызов

супервизора, вызов монитора, запрос исполнительной программы

и т. д. Эти команды дают пользователям возможность прибегать

к услугам, предоставляемым операционной системой, не нарушая ее

целостности и работоспособности.

Операционной системе, как правило, присваивается статус

самого полномочного пользователя. Она имеет возможность доступа

ко всем видам аппаратных ресурсов, всем программам пользователя^

данным и т. д. В некоторых случаях определенные части операцион¬

ном системы получают более узкие полномочия, поскольку людям

и программам, работающим с этими частями, не требуется свобод¬

ного доступа к ресурсам для выполнения любых операций, и по¬

этому лучше им его не предоставлять (см. гл. 17).

1.2 Поколения операционных систем

Операционные системы, подобно аппаратуре компьютеров, на

пути своего развития прошли через ряд радикальных изменений,

так называемых поколений. Для аппаратных средств смена поколе¬

ний связана с принципиальными достижениями в области электрон¬

ных компонент: вначале вычислительные машины строились на

электронных лампах (первое поколение ЭВМ), затем на транзисто¬

рах (второе поколение), интегральных микросхемах (третье поколе¬

ние), а сейчас — по преимуществу на больших и сверхбольших

интегральных схемах (четвертое поколение). Появление каждого

из этих последовательных поколений аппаратных средств сопро¬

вождалось резким уменьшением стоимости, габаритов, потребляе¬

мой мощности и тепловыделения и столь же резким повышением

быстродействия и объемов памяти компьютеров.

1.2.1 Нулевое поколение (40-е годы)

В первых вычислительных машинах операционных систем не

было. Пользователи имели полный доступ к машинному языку, и

все программы писали непосредственно в машинных командах.

23

Гл. 1. Краткий обзор

1.2.2 Первое поколение (50-е годы)

Операционные системы 50-х годов были разработаны с целью

ускорения и упрощения перехода с задачи на задачу. До создания

этих операционных систем много машинного времени терялось

в промежутках между завершением выполнения одной задачи и

вводом в решение следующей. Это было начало систем пакетной

обработки, которые предусматривали объединение отдельных задач

в группы, или пакеты. Запущенная в решение задача получала

в свое полное распоряжение все ресурсы машины. После заверше¬

ния каждой задачи (либо нормального, либо аварийного) управле¬

ние ресурсами возвращалось операционной системе, которая «про¬

чищала машину после данной задачи» и обеспечивала ввод и запуск

в решение следующей задачи.

1.2.3 Второе поколение (начало 60-х годов)

Характерной особенностью операционных систем второго по¬

коления было то, что они создавались как системы коллективного

пользования с мультипрограммным режимом работы (см. гл. 7)

и как первые системы мультипроцессорного типа (см. гл. 11). В муль¬

типрограммных системах несколько пользовательских программ

одновременно находятся в основной памяти компьютера, а цент¬

ральный процессор быстро переключается с задачи на задачу.

В случае мультипроцессорных систем единый вычислительный

комплекс содержит несколько процессоров, что повышает вычисли¬

тельную мощность этого комплекса.

В то время начали появляться методы, обеспечивающие незави¬

симость программирования от (внешних) устройств. Если в систе¬

мах первого поколения пользователю, желающему произвести

запись данных на магнитную ленту, приходилось в программе за¬

давать конкретный номер физического лентопротяжного устрой¬

ства, то в системах второго поколения программа пользователя

только задавала, что файл должен быть записан на устройстве,

имеющем определенное число дорожек и определенную плотность

записи. Операционная система сама находила свободное устройство

с требуемыми характеристиками и давала оператору ЭВМ указание

установить кассету магнитной ленты на это устройство.

Были разработаны системы с разделением времени, которые

предоставляли пользователю возможность непосредственно взаи¬

модействовать с компьютером при помощи пультов-терминалов

телетайпного типа. С системой разделения времени пользователи

работают в диалоговом, или интерактивном, режиме. Пользователь

печатает запрос для компьютера на своем терминале, компьютер

обрабатывает этот запрос с максимально возможной скоростью

(часто в течение секунды или менее) и выдает ответ (если требуется)

на терминал пользователя. Диалоговый режим работы позволил

24

Часть 1. Обзор

в значительной степени повысить эффективность процесса разработ¬

ки и отладки программ. Пользователь системы разделения времени

получил возможность обнаруживать и исправлять ошибки букваль¬

но за считанные секунды или минуты — вместо того чтобы ждать,

зачастую несколько часов или даже дней, пока будут получены

результаты пакетной обработки.

Появились первые системы реального времени, в которых ком¬

пьютеры применялись для управления технологическими процес¬

сами производства, например на предприятиях по переработке

нефти. Были созданы военные системы реального времени, которые

обеспечивали постоянный контроль сразу нескольких тысяч пунктов

для защиты от внезапного воздушного нападения. Для систем

реального времени характерно то, что они обеспечивают немедлен¬

ную реакцию на предусмотренные события. Если, например, от

датчиков системы управления нефтеперерабатывающего предприя¬

тия поступят сигналы о том, что температура становится слишком

высокой, то может потребоваться немедленное принятие соответ¬

ствующих мер для предотвращения взрыва. Системы реального

времени часто работают со значительной недогрузкой — поскольку

для подобных систем гораздо важнее быть в состоянии постоянной

готовности и быстро реагировать на предусмотренные события, чем

просто быть занятыми большую часть времени. Этот факт по¬

зволяет понять, почему такие системы обычно стоят столь дорого.

1.2.4 Третье поколение (середина 60-х — середина 70-х годов)

Третье поколение операционных систем фактически появилось

с представлением фирмой IBM в 1964 г. семейства компьютеров

System/360. Эти компьютеры третьего поколения были разработаны

как машины общего назначения. Это были громоздкие, как правило,

неэффективные компьютеры, которые предназначались для решения

любых задач из любых областей приложения. Подобный подход

позволил продать множество компьютеров, однако имел серьезные

негативные стороны. Пользователям, которые решали конкретные

прикладные задачи, не требующие всех функциональных возмож¬

ностей подобных компьютеров, приходилось нести большие допол¬

нительные расходы, поскольку они по сути оплачивали увеличенные

затраты машинного времени, времени обучения, времени отладки,

технического обслуживания и т. д.

Операционные системы третьего поколения были многорежим¬

ными системами. Некоторые из них обеспечивали работу сразу

во всех известных режимах: пакетную обработку, разделение вре¬

мени, режим реального времени и мультипроцессорный режим. Они

были громоздкими и дорогостоящими. Поскольку ранее подобные

системы не создавались, многие из разработок заканчивались со

значительным превышением выделенных ассигнований и значительно

позже первоначально запланированных сроков. (Примечательным

Гл. 1. Краткий обзор

25

исключением в этом смысле является операционная система Unix,

разработанная фирмой Bell Laboratories. Системы Unix различных

версий подробно рассматриваются в гл. 18.)

Операционные системы третьего поколения привели к сильному

усложнению вычислительной обстановки — и поначалу пользова¬

тели оказались не готовы к работе в новых условиях. Операционные

системы стали как бы программной прослойкой между пользователя¬

ми и аппаратурой ЭВМ. Эта программная прослойка часто была

настолько «толстой», что пользователь просто терял из виду аппа¬

ратуру и видел только то ее отображение, которое создавало для

него программное обеспечение. Для того чтобы заставить одну из

подобных систем выполнить для него простейшую полезную задачу,

пользователю приходилось изучать сложные языки управления

заданиями — чтобы уметь описывать задания и требуемые для них

ресурсы. Операционные системы третьего поколения представляли

собой значительный шаг вперед в развитии средств программного

обеспечения, однако этот шаг оказался для многих пользователей

весьма болезненным.

1.2.5 Четвертое поколение (от середины 70-х годов

до настоящего времени)

Операционные системы четвертого поколения — это наиболее

совершенные системы настоящего времени (см. примеры современ¬

ных операционных систем, гл. 18—22). Многие разработчики и

пользователи еще помнят печальный опыт операционных систем

третьего поколения и весьма осторожно относятся к переходу на

более сложные операционные системы.

Благодаря широкому распространению вычислительных сетей

(см. гл. 16) и средств оперативной обработки данных (в режиме

он-лайн) пользователи получают возможность доступа к террито¬

риально распределенным компьютерам при помощи терминалов

различных типов. Появление микропроцессора создало условия для

разработки персонального компьютера, который с точки зрения

социальных последствий стал одним из наиболее важных достижений

вычислительной техники за несколько последних десятилетий.

Сейчас многие пользователи имеют у себя собственные компьюте¬

ры, на которых они могут работать в любое время дня и ночи. Сей¬

час менее чем за тысячу долларов можно приобрести машину, ко¬

торая по своей вычислительной мощности соответствует компью¬

терам, стоившим в начале 60-х годов сотни тысяч долларов.

Персональные компьютеры зачастую оснащаются интерфейсны¬

ми средствами приема-передачи данных и могут использоваться

также в качестве терминалов мощных вычислительных систем.

Возможности пользователя системы четвертого поколения больше

не ограничиваются взаимодействием с одним компьютером в режиме

разделения времени — он может обращаться к территориально рас¬

26

Часть 1. Обзор

пределенным машинам вычислительной сети. Поскольку это требует

передачи информации по линиям связи различных видов, суще¬

ственно усложнились проблемы защиты информации от возможного

несанкционированного доступа (см. гл. 17). Сейчас уделяется боль¬

шое внимание шифрованию данных, поскольку стало обязательным

кодировать секретные или личные данные таким образом, чтобы

даже в случае их незаконного получения никто, кроме адресатов,

которым они предназначались (или обладателей ключей, дешифрова¬

ния), не мог бы их использовать.

Число людей, имеющих возможность доступа к компьютерам,

в 80-х годах в процентном отношении оказалось гораздо большим,

чем когда-либо ранее, и продолжает быстро увеличиваться. Сейчас

часто употребляют термины дружественная, удобная для пользова¬

теля, ориентированная на неподготовленного пользователя — они

обозначают системы, которые предоставляют пользователям со

средним уровнем квалификации простой доступ к вычислительным

ресурсам. Если в 60-х и 70-х годах пользователям приходилось

работать на языках программирования, включающих множество

символических, мнемонических обозначений и сокращений, то

в 70-х годах появились системы с управлением при помощи меню,

предоставляющие пользователю ряд различных альтернатив вы¬

бора, причем выраженных на простом английском языке.

Начала широко распространяться концепция виртуальных ма¬

шин (см. гл. 22). Пользователь получил возможность более не

задумываться о физических деталях построения вычислительных

машин (или сетей), с которыми он работает. Вместо этого пользова¬

тель имеет дело с функциональным эквивалентом компьютера,

создаваемым для него операционной системой и называемым вирту¬

альной машиной. Современный пользователь хочет, чтобы машина

помогала ему эффективно выполнять его работу, и, как правило, не

интересуется внутренними деталями устройства этой машины и ее

функционированием.

Исключительно важную роль начали играть системы баз дан¬

ных. Наше общество зиждется на информации, так что задача систем

баз данных — обеспечивать возможность удобного и управляемого

доступа к информации для тех, кто имеет на это право. За последнее

время появились тысячи баз данных, предусматривающих опера¬

тивный доступ при помощи терминалов через сети связи.

Широкое внедрение получила концепция распределенной об¬

работки данных (см. гл. 16). Сейчас мы считаем, что гораздо целе¬

сообразнее иметь вычислительные мощности непосредственно там,

где они необходимы, вместо того чтобы передавать данные для об¬

работки в какие-либо вычислительные центры.

Гл. 1. Краткий обзор 27

1.3 Первые операционные системы

Считается, что первую операционную систему создала в начале

50-х годов для своих компьютеров IBM-701 Исследовательская ла¬

боратория фирмы General Motors. В 1955 г. эта фирма и North Ame¬

rican Aviation совместно разработали операционную систему для

компьютера IBM-704. Создание ассоциации пользователей (SHARE),

работающих на машинах фирмы IBM, способствовало широкому

обсуждению и выработке основных требований к операционным

системам —и к 1957 г. появилось много операционных систем для

модели 704, разработанных самими пользователями.

Эти первые операционные системы были ориентированы преиму¬

щественно на сокращение времени, которое обычно тратилось на

запуск задач в решение на компьютере (так называемое подготови¬

тельное время) и на удаление их из машины (заключительное время).

Пока эти операционные системы не были созданы, задачи загру*

жались в машину индивидуально, обычно с перфокарт, причем во

время своего выполнения занимали все ресурсы машины. При этом

каждая задача либо выполнялась до конца, либо ее выполнение

аварийно прекращалось из-за возникновения какой-либо ошибки.

Затем оператор ЭВМ загружал программу, осуществляющую дам-

пинг основной памяти, снимал кассеты магнитных лент, вынимал

колоды перфокарт и распечатывал результаты. Наконец, загружа¬

лась следующая задача и цикл начинался заново. В подготовитель¬

ное и заключительное время машина фактически простаивала.

Разработчики самых первых операционных систем пытались

свести к минимуму такие простои, делая переход с задачи на за¬

дачу более плавным. Эти операционные системы повышали про¬

пускную способность машины благодаря тому, что они организо¬

вывали групповую, или пакетную, обработку задач вместо инди¬

видуальной. Задачи загружались на магнитную ленту обычно при

помощи небольшой периферийной машины (сателлита), а затем ре¬

шались на более крупном компьютере. По окончании каждой задачи

управление передавалось назад специальному блоку операционной

системы, обеспечивающему загрузку следующей задачи. Благодаря

этому время переключения с задачи на задачу значительно умень¬

шалось.

Уже в первых операционных системах появилась концепция

имен системных файлов как средства достижения определенной

степени независимости программ от аппаратуры. Это дало пользо¬

вателю возможность не задавать непосредственно в программе

конкретные номера физических устройств, а указывать стандарт¬

ный системный файл ввода как устройство, с которого как бы счи¬

тываются управляющие перфокарты, или стандартный системный

файл вывода как устройство для распечатки результатов. Стандарт¬

ные имена файлов позволили обеспечить более эффективное взаимо¬

28

Часть I. Обзор

действие ассемблеров и компиляторов с редакторами связей и за¬

грузчиками, работающими с их выходными модулями.

К концу 50-х годов ведущие фирмы — изготовители компьютеров

поставляли операционные системы со следующими характеристи¬

ками:

© пакетная обработка одного потока задач;

© наличие стандартных подпрограмм ввода-вывода, с тем чтобы

пользователю не приходилось касаться деталей программирова¬

ния процессов ввода и вывода на машинном языке;

в возможности автоматического перехода от программы к програм¬

ме, позволяющие сократить накладные расходы на запуск новой

задачи в решение;

® средства восстановления после ошибок, обеспечивающие авто¬

матическую «очистку» машины в случае аварийного завершения

очередной задачи и позволяющие запускать следующую задачу

при минимальном вмешательстве оператора ЭВМ;

© языки управления заданиями, предоставляющие пользователям

возможность достаточно подробно описывать свои задания и

ресурсы, требуемые для их выполнения

В то время операционные системы использовались главным

образом на крупных ЭВМ. Многие из малых машин общего назначе¬

ния, например компьютеры серии IBM-1400, работали без операци¬

онной системы. Пользователи подобных малых машин, как правило,

сами производили загрузку собственной системы управления вво¬

дом-выводом (IOCS), небольшого пакета программ, управляющего

осуществлением операций ввода-вывода. Фактически IOCS, при¬

меняемая на этих первых машинах, явилась прообразом той опера¬

ционной системы, которую мы видим сегодня. Некоторые функции

первых операционных систем обеспечивали более эффективное

использование аппаратных ресурсов, однако в целом пакеты IOCS

были нацелены на упрощение программирования и уменьшение

количества времени, необходимого для написания сложных про¬

грамм ввода-вывода. Разработчики современных операционных

систем основное внимание уделяют тому, чтобы сделать работу

пользователей и программистов более эффективной, поскольку

трудозатраты квалифицированных специалистов представляют сей¬

час гораздо большую долю общей стоимости вычислительных систем

и комплексов, чем аппаратные средства.

1.4 Разработки начала 60-х годов

В начале 60-х годов фирмы — изготовители компьютеров вместе

с аппаратурой начали поставлять операционные системы, обладаю¬

щие гораздо более широкими возможностями В то время в области

вычислительной техники наибольшую роль играли следующие

фирмы:

Гл. 1 Краткий обзор

29

• Bendix

• Control Data Corporation

• Honeywell

• NCR

• RCA

• Burroughs

• General Electric

• IBM

• Philco

• Sperry Univac

Операционные системы этого периода были ориентированы на

пакетную обработку и нацелены главным образом на повышение

пропускной способности дорогостоящей аппаратуры (т. е. на уве¬

личение числа работ, выполняемых в единицу времени). Эти сис¬

темы предусматривали мультипрограммный режим, при котором

в основной памяти машины размещается несколько программ одно¬

временно, а центральный процессор быстро переключается с про¬

граммы на программу. Главный фактор, способствующий успешному

внедрению концепции мультипрограммирования в качестве средства

повышения пропускной способности машины, был связан с существен¬

ным различием в скоростных характеристиках (быстродействие)

устройств ввода-вывода и центрального процессора. Программа,

которая формирует запрос ввода-вывода и не может продолжить свое

выполнение, пока требуемая операция ввода-вывода не завершится,

в однопрограммной машине вызывала перевод центрального про¬

цессора (ЦП) в режим ожидания результата операции ввода-вы¬

вода. Таким образом терялся самый драгоценный ресурс системы —•

время ЦП, причем зачастую система могла потерять 50 000 тактов

процессора, ожидающего завершения операции ввода-вывода. Раз¬

работчики осознали, что, разместив в основной памяти машины

сразу несколько программ, можно с пользой занять это время

процессора, для этого нужно только обеспечить переключение

процессора на очередную программу, готовую к выполнению (и не

ожидающую завершения операции ввода-вывода).

Затем появились мультипроцессорные системы и комплексы

(см. гл. 11), в которых одновременно работают несколько процес¬

соров — иногда как независимые машины, обменивающиеся дан¬

ными друг с другом, а иногда как ряд взаимодействующих процес¬

соров с общей памятью. Подобные системы по производительности

существенно превосходят машины с одним центральным процес¬

сором.

Одним из наиболее значительных достижений того периода

было создание и успешное внедрение системы бронирования и

предварительной продажи билетов на самолеты американских авиа¬

линий. Эта система (под названием SABRE) стала первой крупной

системой обработки транзакций, в которой пользователи, находя¬

щиеся на удалении от центральной ЭВМ, взаимодействовали с ней

при помощи терминалов телетайпного типа. Системы обработки

транзакций предусматривают диалог между пользователем и ма¬

шиной, причем пользователь задает относительно простые вопросы

(например, «Есть ли место на сегодняшний рейс 404?»), а машина

30

Часть 1 Обзор

быстро отвечает на них. Про подобные терминалы пользователя

говорят, что они работают в оперативном режиме (режиме он-лайн).

Обработка транзакций потребовала, чтобы при разработке опе¬

рационных систем учитывался целый ряд новых соображений.

Появилась необходимость обеспечить возможность диалога компью¬

теров со своими пользователями, а это в свою очередь привело к

тому, что существенно возросло значение таких человеческих фак¬

торов, как время ответа и простота и удобство интерфейса «чело¬

век, — машина». Вместо того чтобы просто выполнять одно или не¬

сколько пакетных заданий одновременно, компьютерам пришлось

быстро реагировать на запросы, которые поступают с, быть может,

сотен или даже тысяч терминалов, расположенных в различных

местах. Поэтому большое внимание начали уделять организации

подсистем внешней памяти с прямым доступом (см. гл. 12 и 13),

обеспечивающих быстрый обмен данными. Важное значение при¬

обрело сопряжение компьютеров с телефонными линиями связи

и с высокоскоростными каналами передачи данных. Самым значи¬

тельным достижением того периода можно, по-видимому, считать

именно стыковку компьютеров и средств передачи данных.

В 1963 г. фирма Burroughs для своих компьютеров В5000 разра¬

ботала операционную систему МСР («Главная управляющая про¬

грамма»), в которой были реализованы многие концепции и режимы,

практически стандартные для современных операционных систем:

• мультипрограммирование;

• мультипроцессорная обработка;

• виртуальная память;

• написание операционной системы на языке высокого уровня;

• возможность отладки программ на исходном языке.

1.5 Компьютеры семейства System/360 фирмы IBM

В апреле 1964 г. фирма IBM анонсировала свое семейство ком¬

пьютеров под названиехм System/360, что можно, по-видимому,

расценивать как самое важное событие в истории операционных

систем.

У пользователей компьютеров того периода аппетиты казались

ненасытными — они требовали все больших и больших ресурсов и

функциональных возможностей компьютеров. Когда очередная

машина переставала их удовлетворять, им приходилось переходить

на более мощную машину, причем зачастую совершенно отличную

по конструкции и набору команд и содержащую другую опера¬

ционную систему. Переход с машины на машину осуществлялся

медленно и трудно, поскольку необходимо было преодолевать проб¬

лемы несовместимости.

Учитывая эти трудности, разработчики фирмы IBM сделали

компьютеры System/360 совместимыми по архитектуре, предусмот¬

Гл. 1. Краткий обзор

31

рели в них возможность применения одной и той же операционной

системы (OS/360) и увеличение вычислительной мощности при

переходе от младших к старшим моделям семейства. Эта концепция

семейства совместимых компьютеров стала затем практически стан¬

дартной для всех фирм промышленности. Если пользователь выби¬

рал серию 360, он получал возможность в течение, многих лет

работать с компьютерами этой серии. Однако сразу же возникла

очевидная проблема — каким образом заставить пользователя впер¬

вые выбрать серию 360, если компьютеры этого семейства были

несовместимыми с другими машинами того периода.

Фирма IBM решала эту проблему, предложив самый широкий

набор имитаторов и эмуляторов за всю историю вычислительной

техники. Имитаторы и эмуляторы — это средства, позволяющие

одному компьютеру имитировать другой компьютер. Например,

пользователь компьютера IBM-1401 мог теперь легко перейти на

System/360, поскольку была обеспечена возможность выполнять

на System/360 программы модели 1401 без всяких доработок. Ими¬

таторы — это, как правило, чисто программные средства модели¬

рования, а эмуляторы на практике требуют и некоторых модифика¬

ций аппаратных средств. Имитаторы обычно работают очень мед¬

ленно, однако их создание обходится относительно дешево. Эмуля¬

торы стоят дороже, однако позволяют гораздо быстрее выполнять

старые программы. Благодаря имитаторам и эмуляторам пользо¬

ватели получили возможность немедленно переходить на компью¬

теры System/360, с тем чтобы впоследствии перевести свои програм¬

мы в формат System/360 в удобные для себя сроки.

Несмотря на то что машины System/360 не содержали некоторых

из новых возможностей, уже реализованных в то время в компьюте¬

рах других фирм, например Burroughs, эти машины оказались

непревзойденными в одном очень важном аспекте, а именно в от¬

ношении удовлетворения разнообразных практических нужд

пользователя. Имитаторы и эмуляторы оказались очень удобными

для пользователя, а операционная система OS/360 содержала самый

обширный из когда-либо поставляемых набор программ-утилит, что

существенно упрощало применение компьютеров.

1.6 Реакция промышленности на появление System/360

Анонсирование System/360 явилось для других фирм — изгото¬

вителей компьютеров серьезным ударом, заставившим их активи¬

зировать свои усилия по разработке новых изделий. Руководители

и главные конструкторы фирм сразу поняли, что им придется менять

стратегические принципы своей технической политики, чтобы обес¬

печить для своих изделий способность конкурировать с этим се¬

мейством.

Одним из стратегических принципов стало буквальное копиро¬

вание архитектуры System/360 и разработка операционных систем,

32

Часть 1. Обзор

аналогичных OS/360, с последующей продажей подобных машин

по гораздо более низким ценам, чем устанавливала фирма IBM.

Такую стратегию выбрала фирма RCA (США) при создании своей

серии компьютеров Spectra/70, а также гигантские промышленные

компании Siemens (ФРГ) и Hitachi (Япония).

Эти компании считали, что таким образом им удастся привлечь

на свою сторону часть заказчиков из громадного контингента поль¬

зователей фирмы IBM. Однако их стратегия потерпела неудачу.

В частности, подобные попытки фирмы RCA провалились с таким

треском, что ей вскоре пришлось вообще прекратить работы в об¬

ласти вычислительной техники; при этом она списала затраты

в сумме 500 млн. долл.— это была наибольшая статья убытков в ис¬

тории фирмы до того момента. Почему же на первый взгляд рацио¬

нальная стратегия корпорации RCA привела к такому провалу?

Эта фирма, несмотря на свои громадные размеры и прочное положе¬

ние в промышленности, не завоевала достаточного доверия в кругах

потенциальных пользователей, где решения об ориентации на те

или иные компьютеры принимали осторожные финансисты и руко¬

водители подразделений по обработке данных. Кроме того, разра¬

ботчики фирмы RCA слишком поздно обнаружили, что задача ко¬

пирования операционной системы OS/360 и связанных с ней про¬

грамм является почти неразрешимой. Фирма оказалась в состоянии

скопировать аппаратные средства, однако существенно недооценила,

с какими трудностями и затратами ей придется столкнуться при

создании операционной системы, подобной OS/360. Операционная

система фирмы RCA в некоторых отношениях даже превосходила

OS/360, однако надежность системы была низкой; кроме того, фирма

не наладила хорошего сопровождения своих систем в эксплуатации

на объектах заказчиков.

Другую стратегию в тот период приняли такие фирмы — изго¬

товители компьютеров, как Burroughs и General Electric; они разра¬

батывали машины, не совместимые с компьютерами серии 360, но

более мощные и более экономичные. Эта стратегия также выглядела

весьма дальновидной, однако разработка новых машин оказалась

гораздо более сложной задачей, чем предполагали руководители

фирмы General Electric, и вскоре эта фирма вслед за RCA прекрати¬

ла работы в области вычислительной техники.

Некоторые из фирм-изготовителей того времени действовали

более осторожно. Они разрабатывали усовершенствованные ком¬

пьютеры, напоминающие машины фирмы IBM серий 1400 и 7000.

Эти поставщики надеялись привлечь тех заказчиков фирмы IBM,

которые хотели бы избежать трудностей перехода на System/360.

Фирмы Univac и Control Data добились определенных успехов

в привлечении некоторых прежних заказчиков компьютеров фирмы

IBM серии 7000, а компания Honeywell начала поставлять свои

машины многим пользователям компьютеров серии 1400.

Надежды разработчиков фирмы IBM на то, что им удастся огра¬

Гл. 1. Краткий обзор

33

ничиться одной операционной системой для всего своего семейства

IBM/360, оказались несостоятельными из-за различных требований,

предъявляемых различными пользователями. Так, пользователям

малых компьютеров не нужна была сложная операционная система

с бесконечным набором возможностей. Фактически производитель¬

ность малых компьютеров при работе под управлением OS/360

существенно снижалась.

Пользователям более крупных компьютеров требовались опе¬

рационные системы с расширенными функциональными возмож¬

ностями. Кроме того, более мощные машины могли работать с

большим числом операционных систем — и поэтому вместо одной

операционной системы, OS/360, фирма IBM в конце концов создала

четыре основные операционные системы, которые она поставляла

в течение 60-х годов:

® DOS/360 (дисковая операционная система) для младших моде¬

лей системы System/360;

® OS/MFT (мультипрограммирование с фиксированным числом

задач) для средних и старших моделей System/360;

© OS/MVT (мультипрограммирование с переменным числом задач)

для старших моделей System/360;

® CP-67/CMS (управляющая программа-67/диалоговая монитор¬

ная система) для мощной модели 360/67, имеющей виртуальную

память и предусматривающей работу в режиме разделения

времени.

1.7 Системы с разделением времени

В конце 50-х и в начале 60-х годов разработчики промышленных

фирм и университетов создали ряд систем с разделением времени.

Эти системы дают возможность нескольким пользователям, рабо¬

тающим на терминалах, вести непосредственный диалог с компью¬

тером. От систем обработки транзакций, например системы SABRE

американских авиалиний, они отличаются тем, что являются по

сути вычислительными комплексами универсального типа и пре¬

доставляют своим пользователям полный набор вычислительных

средств. Пользователи систем разделения времени, как правило,

занимаются разработкой программ или работают со специально

разработанными пакетами прикладных программ.

Быть может, наиболее известной системой разделения времени

того периода стала система CTSS (совместимая система разделения

времени), разработанная в Массачусетском технологическом ин¬

ституте (МТИ) при финансовой поддержке правительства группой

научных сотрудников под названием Project МАС. Система CTSS

работала на компьютере IBM-7094 со специально модифицирован¬

ными аппаратными средствами. С 1961 до конца 1960-х годов в

диалоговом режиме ее эксплуатировало большое число пользова-

2 Зак. 583

34

Часть 1. Обзор