Text

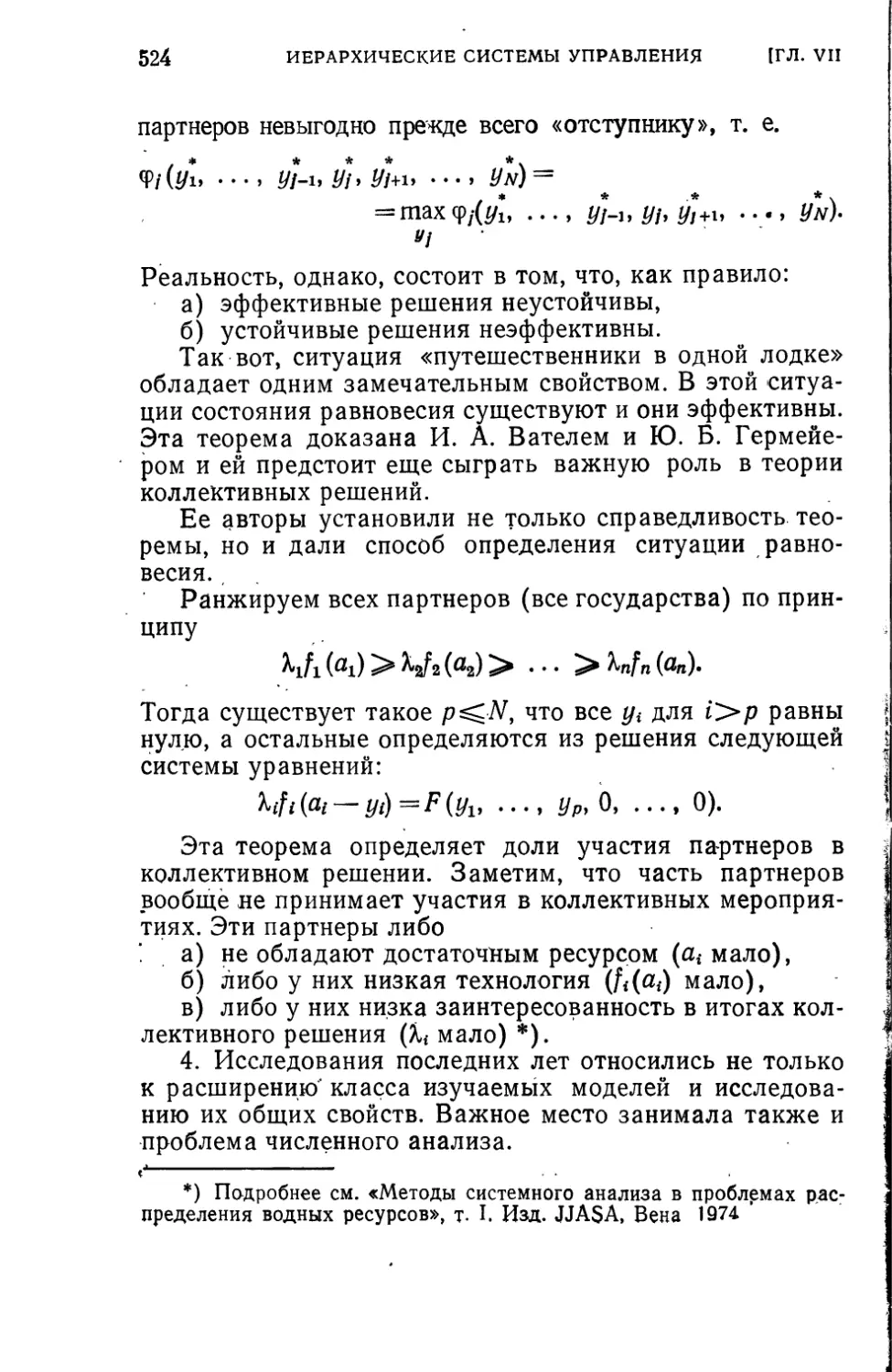

ОПТИМ ИЗАЦИЯ

И ИССЛЕДОВАНИЕ

ОПЕРАЦИИ

Элементы теории

оптимальных

систем

ОПТИМИЗАЦИЯ

И ИССЛЕДОВАНИЕ

ОПЕРАЦИЙ

Редактор серии

Н. Н. МОИСЕЕВ

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1975

Н. Н. МОИСЕЕВ

ЭЛЕМЕНТЫ ТЕОРИИ

ОПТИМАЛЬНЫХ

СИСТЕМ

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1975

518

М74

УДК 519.95

Элементы теории оптимальных систем.

Моисеев Н. Н., Главная редакция физи-

ко-математической литературы изд-ва «Нау-

ка», 1974.

В первой части дается систематическое

изложение численных методов теории оп-

тимальных управлений. Сначала описыва-

ются методы, использующие необходимые

условия экстремума функционала. Далее

рассматриваются численные методы, исполь-

зующие идеи последовательного анализа ва-

риантов и динамического программирования.

Вторая часть (главы IV, V и VI) по-

священа вопросам синтеза систем управле-

ния объектами, подверженными действшо

внешних возмущений разного типа. Сначала

подробно обсуждается математическое со-

держание проблемы синтеза и приводятся

разнообразные методы синтеза, основанные

на эвристических соображениях. Затем из-

лагаются строгие методы теории линейного

синтеза.

В заключение этой части обсуждается

проблема синтеза в условиях неопределен-

ности и приводится решение простых задач,

иллюстрирующих роль информированности

при построении оператора управления.

В последней главе обсуждается поста-

новка задач теории иерархических систем

управления.

Илл. 39.

20204—044

М -------------

053(02)-75

73-74

© Главная редакция

физико-математической литературы

издательства «Наука», 1975 г.

ОГЛАВЛЕНИЕ

Предисловие.................................................. 7

Глава I. Оптимальные программы (теория оптимального

управления)................................................11

§1.0 постановке задач теории оптимального управления 13

§ 2. Необходимые условия в задачах классического вариа-

ционного исчисления....................................26

§ 3. Принцип максимума Л. С. Понтрягина .... 45

§ 4. Условия оптимальности в системах с дискретным вре-

менем .................................................79

§ 5. Задачи оптимального управления на бесконечном ин-

тервале времени........................................89

Глава II. Численные методы расчета оптимальных про-

грамм,.использующие, необходимые условия эк-

стремума .................................................114

§ 1. Простейшие способы решения краевых задач . . 115

§ 2. Задачи оптимального управления, сводящиеся к крае-

вым задачам для систем линейных дифференциальных

уравнений. Перенос граничных условий .... 124

§ 3. Применение метода переноса граничных условий для

построения итерационных схем..........................140

§ 4. Методы теории оптимального управления, использую-

щие процедуру решения задач со свободным концом 147

§ 5. Методы, использующие функции штрафа . . . 166

§ 6. Задачи с нефиксированным временем и задачи на

быстродействие........................................175

§ 7. Методы теории возмущений. Возможный способ реше-

ния краевых задач.....................................183

Глава III. Прямые методы теории оптимального управления 193

§ 1. Конечномерные аналоги задач теории оптимального

управления............................................194

§ 2. Методы нелинейного программирования в задачах оп-

тимального управления.................................210

§ 3. Последовательный анализ вариантов. Схемы динами-

ческого программирования.........................229

§ 4. Элементарная операция. Некоторые примеры . . 253

§ 5. Проблемы устойчивости.......................267

§ 6. Некоторые задачи для систем е дискретным временем 279

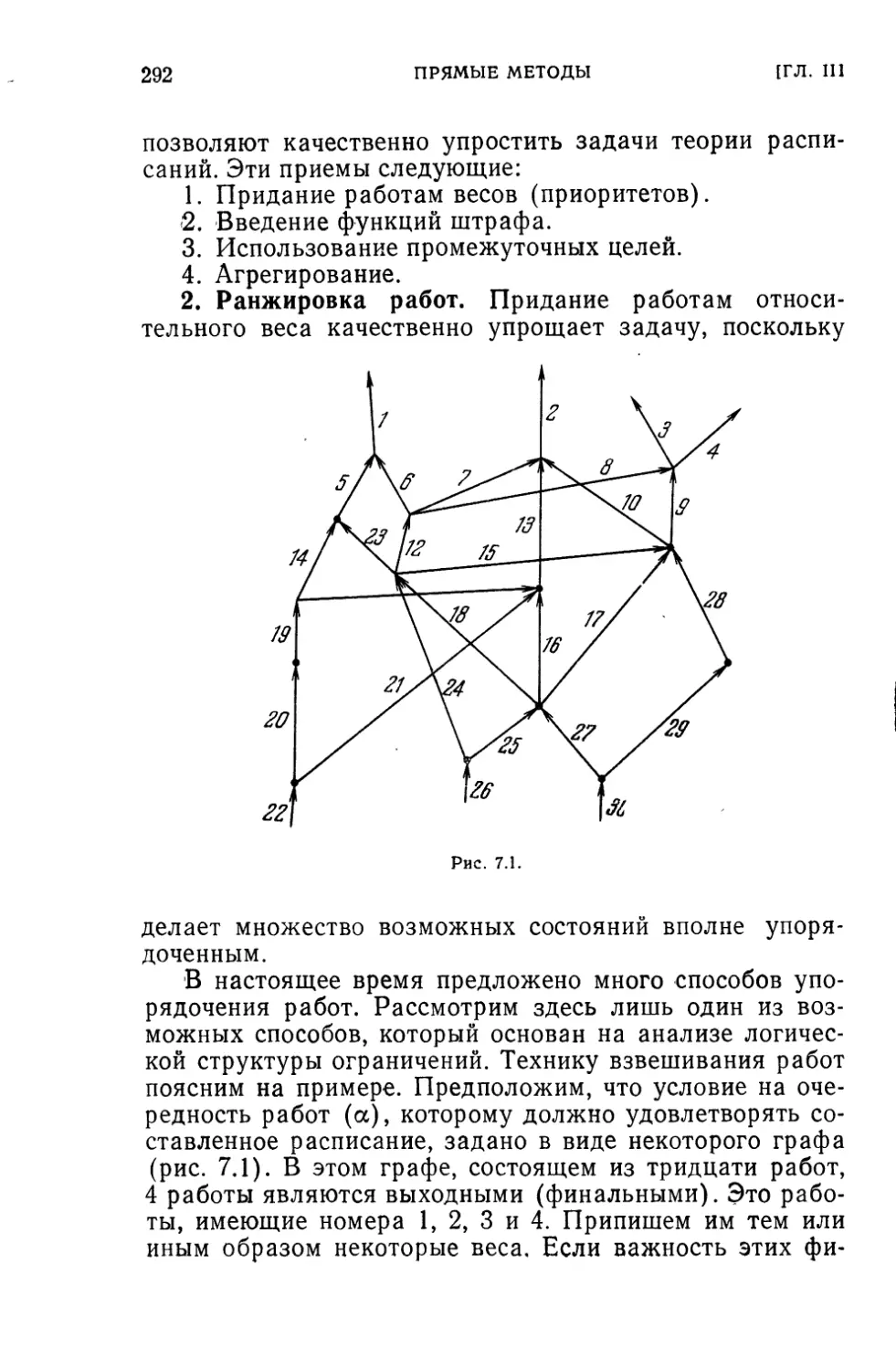

§ 7. Задачи теории расписаний......................... 290

ОГЛАВЛЕНИЕ

Глава IV. Проблема синтеза оптимальных систем управле-

ния ........................................ , . . . 304

§ 1. О постановке задач синтеза оптимальных систем

управления.................................. 306

§ 2. Детерминированные задачи синтеза...............323

§ 3. Применение динамического программирования для

задач синтеза .... ..............................334

§ 4. Методы динамического программирования в задачах

синтеза с неполной информацией и при наличии оши-

бок измерений.........................................351

Глава V. Задачи синтеза, сводящиеся к задачам оптималь-

ного управления...........................................368

§ »1 . Задачи линейного синтеза.......................369

§ 2. Линейный синтез с ограничениями. Принцип макси-

мума .................................................396

Г пава VI. Проблема разделения задач и игровые постанов-

ки задач синтеза оптимальных систем . . . 415

§ 1. Проблема разделения ......... 415

§ 2. Гарантирующие стратегии и задачи синтеза . . . 434

§ 3. Использование канонических разложений фазового

вектора в задачах линейного синтеза...................446

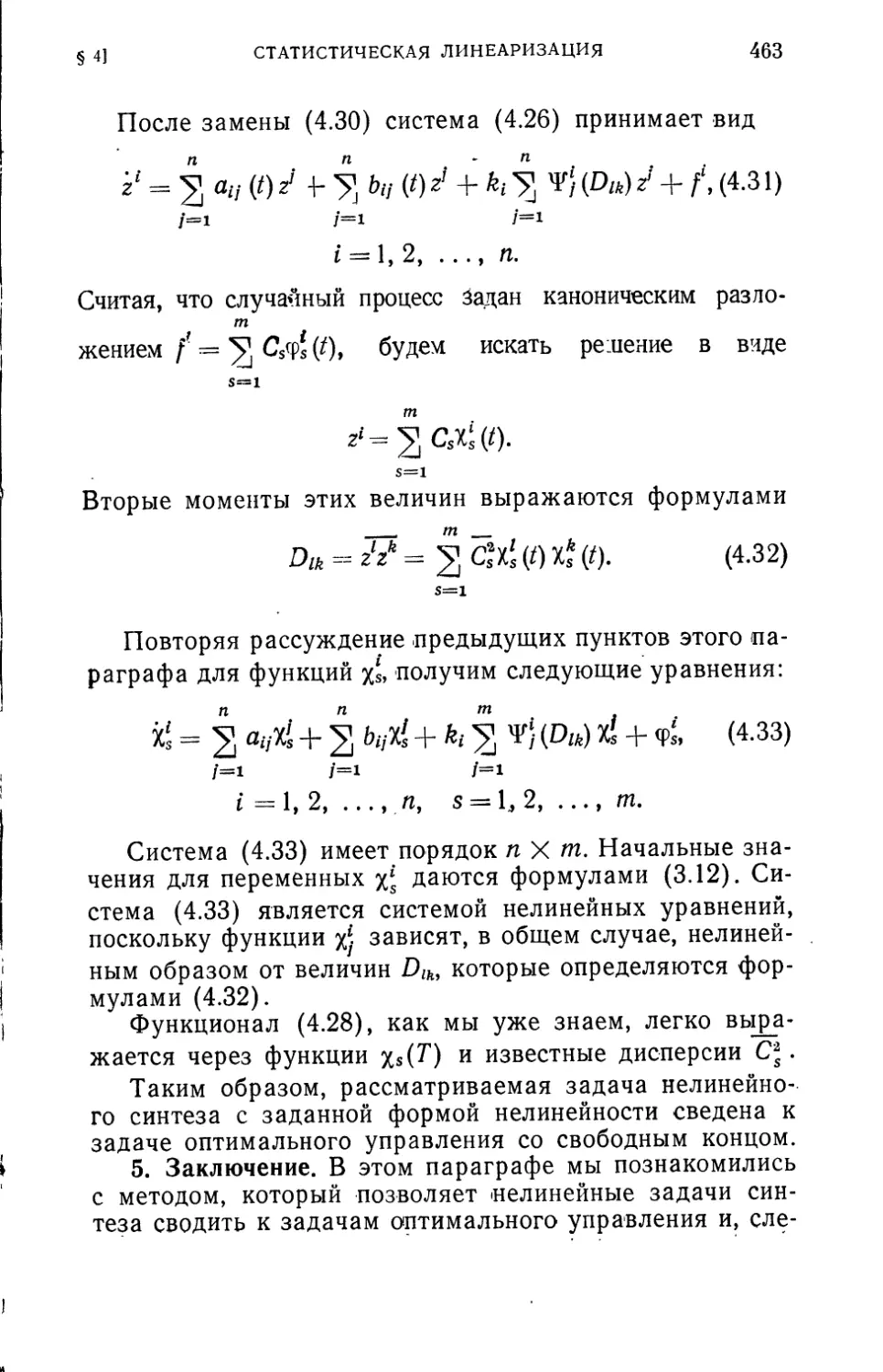

§ 4. Статистическая линеаризация и синтез нелинейных си-

стем управления . 455

Глава VII. Иерархические системы управления . 465

§ 1. Обсуждение некоторых понятий ...... 466

§ 2. Предварительный анализ...........................474

§ 3. Динамические системы с двухступенчатой иерархией 490

§ 4. Один пример трехуровневой системы................503

§ 5. Заключительные замечания.................. . . 514

§ 6. Некоторые новые исследования.....................520

ПРЕДИСЛОВИЕ

«Элементы теории оптимальных систем» написаны на

основе книги «Численные методы в теории оптимальных

систем». Несмотря на то, что со времени ее издания

(1971 г.) прошло сравнительно немного времени, в тео-

рии управления появилось немало новых идей и резуль-

татов, которые потребовали переработки книги и много-

численных дополнений.

Мне кажется, что наиболее значительным из того, что

произошло за эти годы, было возникновение новой боль-

шой главы, посвященной изучению систем, обладающих

иерархической организацией. Это обстоятельство означа-

ет, по существу говоря, постепенное перемещение цент-

ра тяжести интересов теории управления в сторону

изучения действительных сложных систем. По-видимо-

му, все управляемые системы естественно разбить на

простые, которые для достижения своих целей не нуж-

даются в иерархической организации, и сложные,

для которых иерархия управления является необходи-

мостью.

Переход к изучению сложных систем, требующих

иерархической структуры, приведет, вероятно, к значи-

тельному обогащению и пересмотру традиционных идей,

методов и объектов исследования в теории управления.

В частности, он позволит распространить многие из ре-

зультатов, найденных при изучении технических систем,

на задачи управления процессами более общей природы

и, прежде всего, экономическими. Фрагментарному изло-

жению элементов этой теории посвящена новая седьмая

глава.

Таким образом, схема книги приобрела следующий

вид. Первые три главы посвящены тому, что теперь при-

нято называть «теорией оптимального управления», т. е.

вариационному исчислению при дифференциальных свя-

зях и ограничениях на управляющие воздействия. Цент-

ральное место здесь занимают задачи Лагранжа и

8

ПРЕДИСЛОВИЕ

Л. С. Понтрягина. Рассмотрение ограничивается только

кусочно-непрерывными управлениями. Это обстоятельст-

во позволило получить очень простое доказательство

принципа максимума. Помимо традиционного материала

в первую главу книги включена, также задача об асимп-

тотике оптимального управления на бесконечном интер-

вале времени.

Две следующие главы содержат изложение числен-

ных методов теории оптимального управления в той фор-

ме, как они изучались и использовались в Вычислитель-

ном центре Академии наук. Последующие три главы по-

священы проблемам синтеза оптимальных управлений.

Сложность задачи, отсутствие надежного математическо-

го аппарата не позволили дать систематического изложе-

ния теории синтеза. Оно носит фрагментарный характер.

Неизбежность использования эвристических приемов и

апелляции к интуиции заставила автора подробно обсуж-

дать техническое содержание обсуждаемых проблем тео-

рии синтеза и приемы анализа, основанные на интуитив-

ной базе.

Завершается книга, как уже было сказано, главой о

иерархических системах, где любое решение задачи необ-

ходимо носит характер синтеза.

Эта книга ни в коей мере не претендует на роль энцик-

лопедии методов теории оптимальных систем. Она напи-

сана на основе опыта, приобретенного в Вычислительном

центре Академии наук СССР и отражает прежде всего

опыт автора данной монографии и его взгляды на сущест-

во изучаемой проблемы.

Необходимо заметить, что в последние. годы значи-

тельно обогатился не только идейный базис теории

управления, но и ее аппарат. Прежде всего, появился ряд

первоклассных исследований алгоритмов оптимизации.

Новые способы доказательства сходимости, предложен-

ные В. Г. Кармановым, идеи ускорения сходимости

Н. 3. Шора, Б. Н. Пшеничного и их учеников, методы

стохастического программирования Ю. М. Ермольева и

многие другие работы, выполненные в традиционном сти-

ле, составляют, конечно, замечательную новую главу

прикладной математики.

Тем не менее эти результаты не нашли своего места

в книге. И тому много причин.

ПРЕДИСЛОВИЕ

9

Во-первых, их изложение потребовало бы значитель-

ного расширения объема и в какой-то степени дублиро-

вало бы выходящие в данной серии книгу Б. Н. Пшенич-

ного и Ю. М. Данилина и книгу Ю. М. Ермольева.

Во-вторых, как уже говорилось, автор старался вклю-

чить в книгу лишь те разделы, в развитие которых он сам

внес определенную лепту.

Но третье и главное — это стремление сохранить

«физический уровень» строгости и не перегружать книгу

чисто математическими исследованиями. Это стремление

отражено и в заглавии. Сам термин «оптимальные систе-

мы» очень нечеток, и благодаря этому он отражает суще-

ство дела.

Когда речь идет о любой реальной системе техничес-

кой, экономической, военной,— то процесс ее проектиро-

вания никогда не может быть четко сформулирован и

сведен к решению какой-либо одной задачи или даже це-

почки математических задач. Противоречивость требова-

ний к конструкции и наличие ряда других неопределен-

ностей, с которыми неизбежно сталкивается человек, про-

ектирующий систему, приводит к тому, что неформаль-

ный анализ, поиск компромисса занимает значительное

место в процессе проектирования. В результате именно

такого неформального анализа в проектировании и уда-

ется эффективно использовать оптимизационные методы

(как некоторый вспомогательный элемент), дающие пре-

дельные оценки конструкции.

Поэтому в предлагаемой книге автор хотел изложить

не только математическую теорию оптимального управ-

ления, которая, конечно, занимает большое место в кни-

ге, но и показать место оптимизационных задач в проб-

лемах проектирования систем управления.

И, наконец, последнее. В книгах по методам оптими-

зации стало традиционным особенное внимание уделять

проблемам сходимости алгоритмов. Студент, окончив-

ший математический факультет, глубоко убежден в том,

что сходящийся алгоритм — это хороший алгоритм, а

расходящийся — плохой. А строго говоря, свойство схо-

димости алгоритма в общем случае не является ни необ-

ходимым, ни достаточным для того, чтобы его можно

было рекомендовать для окончательной оценки алго-

ритма. Существует много примеров, когда реализация

10

ПРЕДИСЛОВИЕ

сложных вычислений была осуществлена с помощью за-

ведомо расходящихся алгоритмов и, наоборот, устойчи-

вые сходящиеся алгоритмы приводили уже на одной из

первых итераций к машинной бесконечности.

Эти примеры ничего не опровергают. Они просто по-

казывают недостаточность традиционных представлений.

Постепенно начинает возникать понимание того фак-

та, что математика не так уж существенно отличается от

других естественных наук и, во всяком случае, имеет та-

кое же эмпирическое начало. После работ Геделя, изо-

бретения ЭВМ и опыта работы математиков в приклад-

ных областях этот тезис становится все более распрост-

раненным. Как и любое другое знание, любая другая

наука, математика нужна человеку для решения опреде-

ленных практических задач, достижения определенных

целей. И каждый раз требования к этим знаниям, к ана-

лизу должны находиться в определенном соответствии с

этими целями.

При подготовке рукописи я пользовался советами и

помощью многих лиц. Гермейеру Ю. Б., Ермольеву Ю.М.,

Крылову И. А., Ринго Н. И., Пшеничному Б. Н., Шевчен-

ко Е. М. я обязан советами, вниманием и помощью. Вап-

нярский И. Б., Ватель И. А. и Ерешко Ф. И. прочли руко-

пись в черновике и внесли целый ряд изменений, значи-

тельно усовершенствовавших первоначальное изложение.

Всех указанных лиц я прошу принять мою глубокую

благодарность.

ГЛАВА I

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

(ТЕОРИЯ ОПТИМАЛЬНОГО УПРАВЛЕНИЯ)

Даже на фоне общего прогресса естественных и тех-

нических наук теория управления в послевоенные годы

выделялась особым богатством новых- идей и методов.

Расцвет теории управления, подготовленный всей пред-

историей ее развития, тесно связан с появлением элект-

ронно-вычислительной техники, благодаря которой обре-

ло смысл создание сложных алгоритмов управления.

Центральной идеей, определявшей развитие теории

управления в последние десятилетия, безусловно, была

идея оптимизации. Сама эта идея не нова. Уже в пред-

военные годы большое значение стали приобретать рабо-

ты, в которых изучалось качество управления. Основной

задачей теории управления в предвоенный период была,

по общему мнению, задача отыскания устойчивых управ-

лений. Но свойство устойчивости еще не выделяет единст-

венного решения. Поэтому естественно поставить вопрос

о том, как можно воспользоваться произволом, который

мы здесь имеем. Задачи нахождения управления, обла-

дающего в некотором смысле «лучшим качеством», уже

содержали оптимизационную точку зрения. В середине

40-х годов стали актуальными задачи расчета траекто-

рий ракет, решавших проблему достижения заданной вы-

соты или дальности, вывода на орбиту и т. д. при мини-

мальном расходе горючего.

Количество работ, посвященных этим проблемам, в

настоящее время исчисляется десятками. Среди них

я считаю необходимым выделить работу Д. Е. Охоцим-

ского «К теории движения ракет» (ПММ, 10, № 2, 1946).

В этой статье уже содержалась (с точностью до терми-

нологии) современная постановка задач теории опти-

мального управления.

Задачи, возникшие в теории летательных аппаратов,

снабженных ракетными двигателями, значительно отли-

чались от традиционных задач автоматического уп-

равления. В те годы усилия специалистов по теории

12

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

(ГЛ. I

регулирования (синоним автоматического управления)

были главным образом направлены на изучение способов

управления стационарными движениями на бесконечном

интервале времени. Задачи же динамики ракет — это су-,

щественно нестационарные задачи, поскольку время про-'

текания процесса (работы двигателей) относительно ма-

ло. Кроме того, в традиционных задачах теории регулиро-

вания вопрос об отыскании программного движения, кото-

рым мы собираемся управлять, обычно не ставился. Это

движение было либо задано заранее, например, заданная

скорость вращения турбины, либо его определение было

тривиальным. В теории регулирования решалась другая

задача отыскания оператора обратной связи, управления

как функции фазовых координат системы, а не как функ-

ции времени.

Поэтому, несмотря на то, что в динамике ракет изу-

чался один из классов управляемых движений, эта тео-

рия вначале развивалась независимо от теории автома-

тического управления. Слияние обеих теорий произошло

уже в пятидесятые годы, когда оптимизационные поста-

новки задач управления начинают занимать внимание и

специалистов по теории автоматического управления.

Начало этим исследованиям положили работы, посвящен-

ные исследованию быстродействий (А. А. Фельдбаум

и др.). Класс оптимизационных задач, возникших в тео-

рии управления, не сводился к классическим задачам

вариационного исчисления и требовал создания специаль-

ного аппарата. Несмотря на то, что к началу пятидеся-

тых годов целый ряд конкретных задач такого типа был

уже решен, в теории управления еще не был выработан

единообразный подход к их анализу.

Выдающуюся роль в развитии теории оптимального

управления сыграл Л. С. Понтрягин, который сформули-

ровал принцип максимума, позволяющий с помощью

множителей Лагранжа свести задачу оптимального

управления к некоторой специальной краевой задаче для

обыкновенных дифференциальных уравнений.

После работ Л. С. Понтрягина и его школы в теории

оптимального управления произошла та канонизация

методов и языка, которая свидетельствует о появлении

новой дисциплины. Она получила название теории опти-

мального управления.

ПОСТАНОВКА ЗАДАЧ

13

§ И

В настоящее время теория оптимального управления

и оптимизационная идеология глубоко проникли во все

исследования конкретного характера и конструкторские

разработки, и можно сказать без преувеличения, что

язык теории оптимальных процессов сделался общим

языком современной теории управления.

В технике возник термин «оптимальные системы».

Это очень расплывчатое понятие, которое не имеет еще

четкого математического содержания. Однако когда ин-

женеры говорят о конструировании оптимальных систем,

то всем более или менее ясно, что это означает. Это озна-

чает, что на разных этапах конструирования системы вы-

бор ее элементов определяется теми или другими оптими-

зационными соображениями.

Как мы это увидим ниже, одна из особенностей зада-

чи проектирования «оптимальных систем» управления

состоит в том, что систему нельзя охарактеризовать

одним числом — одним критерием. Поэтому процесс кон-

струирования оптимальной системы — это целая цепочка

оптимизационных задач.

В этой главе мы будем рассматривать первую из тех

задач, с которой встречается инженер (или экономист),

проектирующий оптимальную систему управления. Эта

задача носит название задачи расчета оптимальной про-

граммы (или оптимального плана). Мы будем изучать ее

только для динамических систем (эволюция которых опи-

сывается дифференциальными или разностными уравне-

ниями). В этом частном случае задача расчета програм-

мных движений совпадает с задачей теории оптимально-

го управления. Место этой задачи в общем процессе

конструирования системы управления динамическим объ-

ектом будет раскрыто в последующих главах этой книги.

§1.0 постановке задач теории

оптимального управления

1. Обсуждение технического содержания задач рас-

чета программных движений *). Во введении говорилось,

что один из первых вопросов, с которым сталкиваются

*) Ряд дисциплин, занимающихся отысканием оптимальных ре-

шений: линейное программирование, нелинейное программирование,

теория оптимального управления, динамическое программирование

14

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

(ГЛ. I

при разработке системы управления динамическим объ-

ектом,—это вопрос о выборе программного движения.

Поясним содержание этой задачи.

Предположим, что речь идет об объекте, движение

которого описывается некоторой системой дифференци-

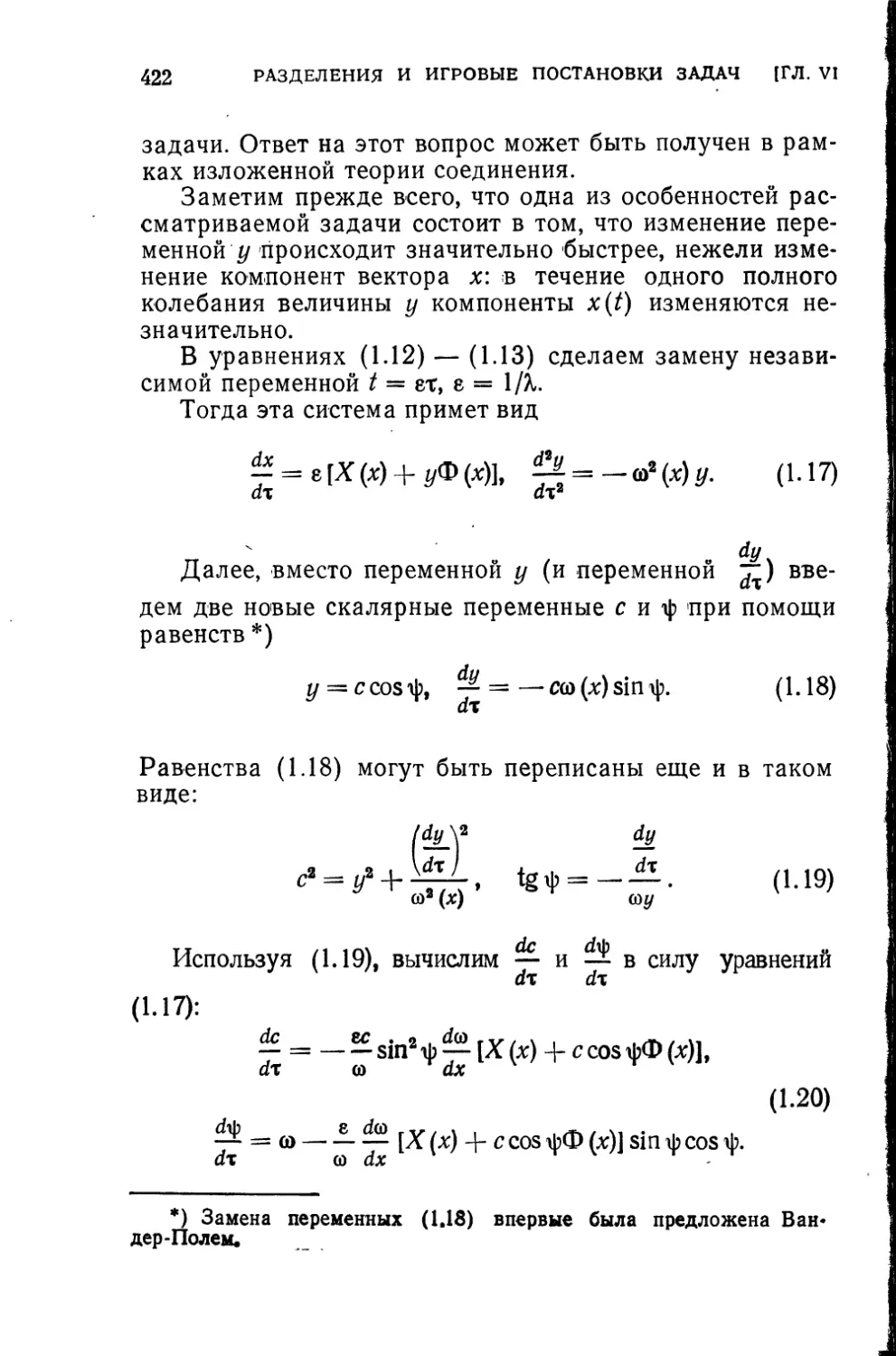

альных уравнений. Эту систему будем записывать в век-

торном виде

х — f (х, и, t), (1.1)

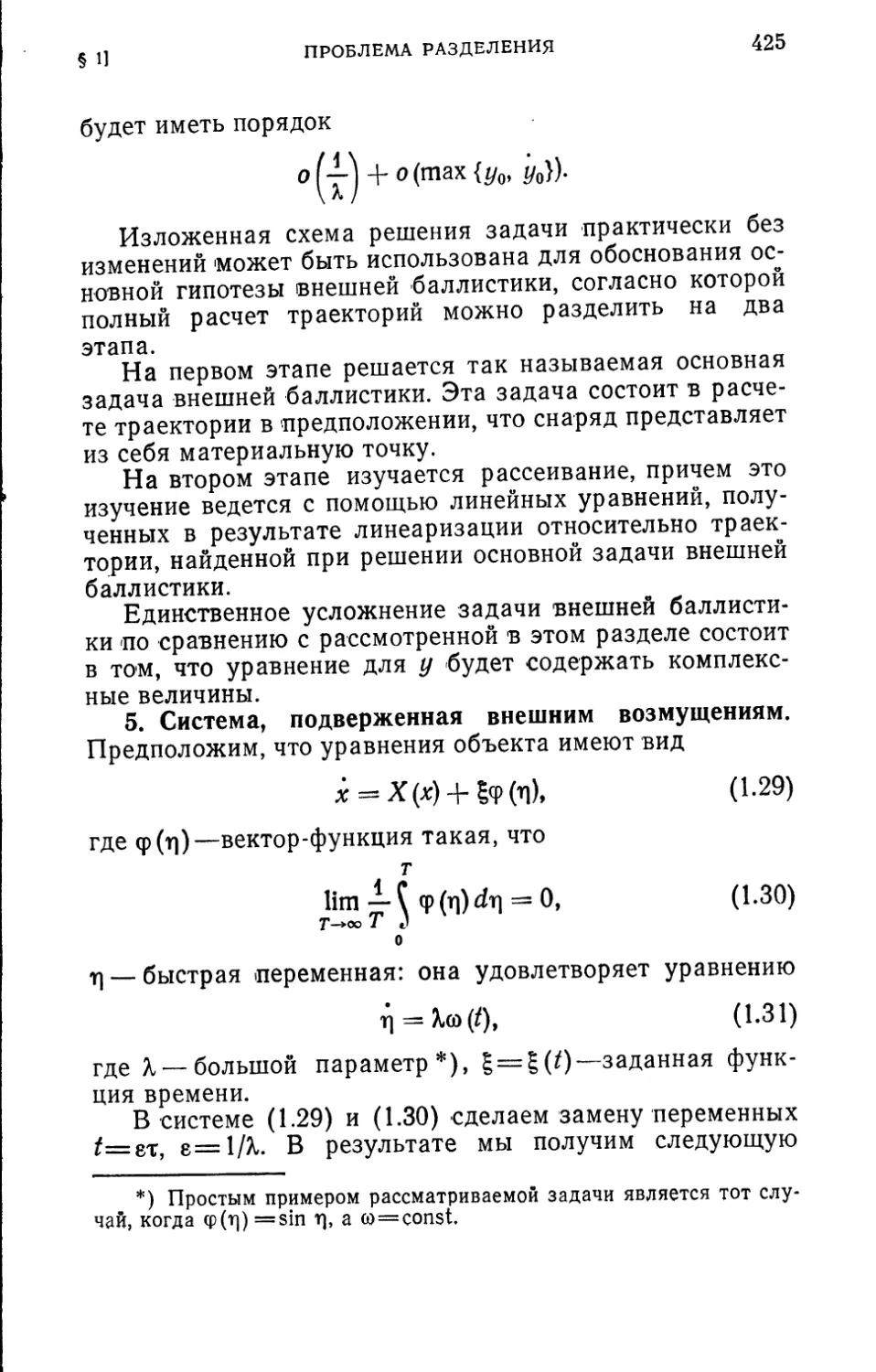

где х, и п f — векторы с компонентами х‘, и* и соответст-

венно, х(/) —называется фазовым вектором (или векто-

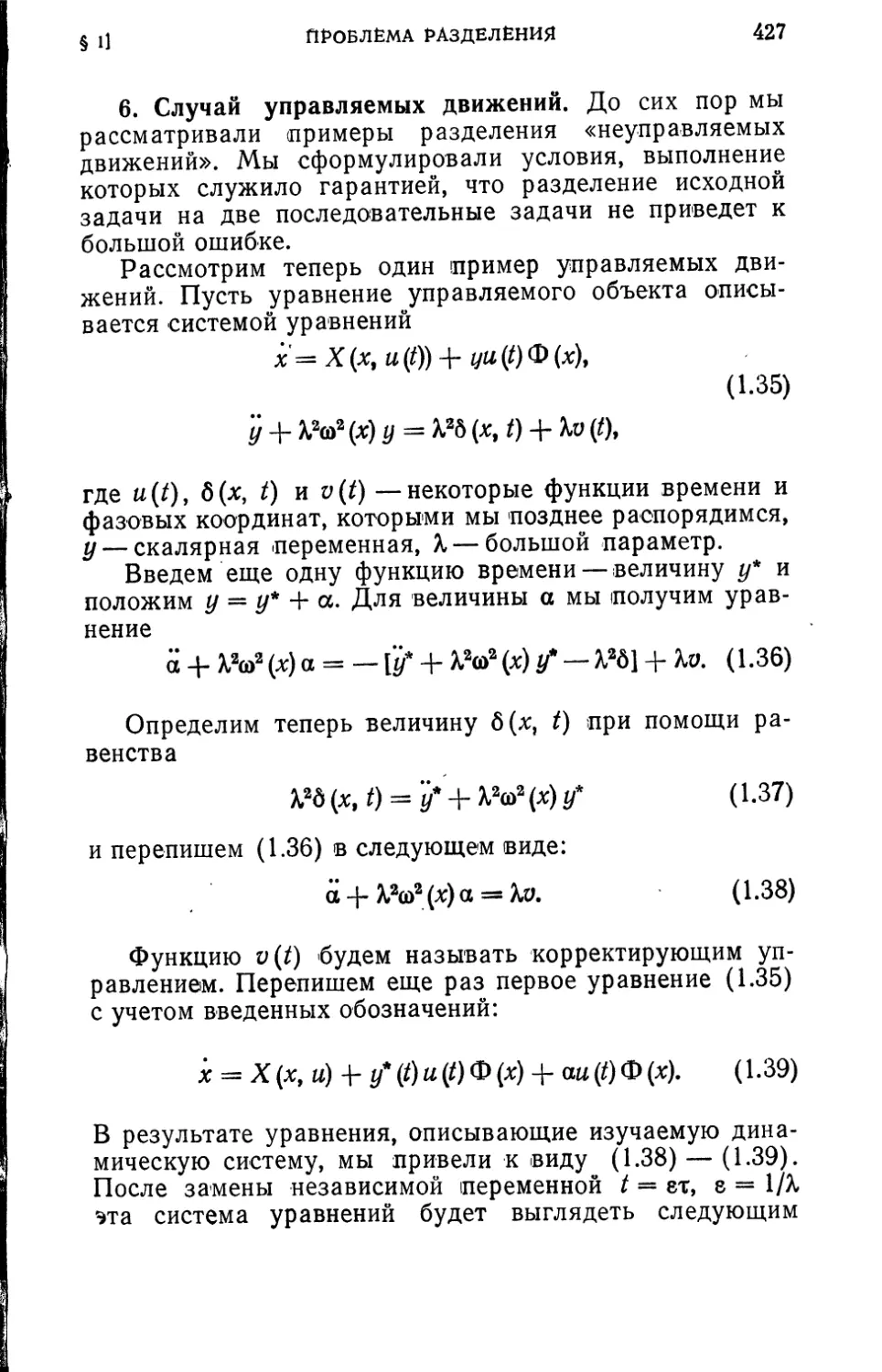

ром состояний), он определяет состояние системы в мо-

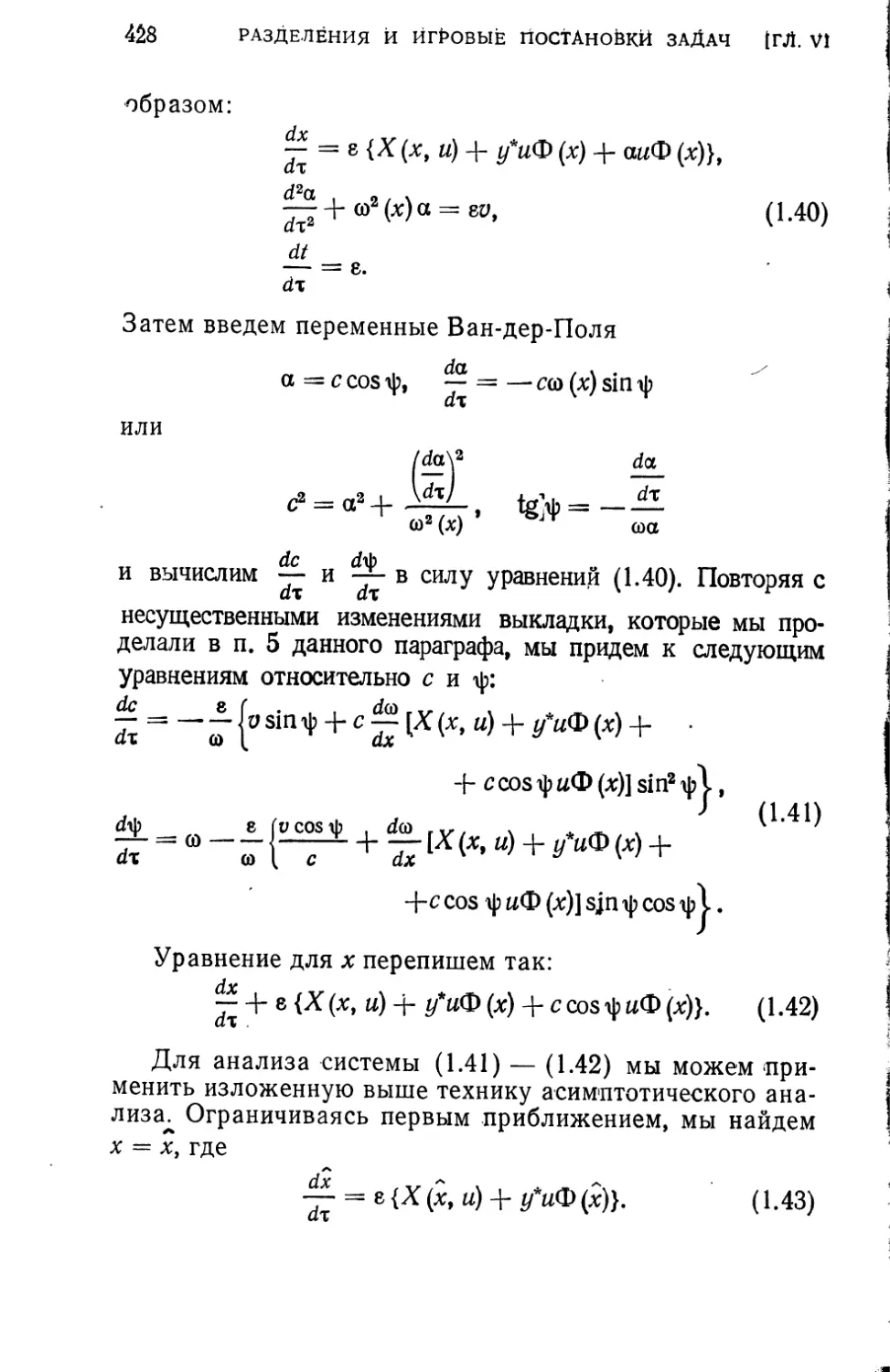

мент времени —управляющим вектором или управ-

лением. Их размерности могут совпадать или быть

различными. Предполагается, что векторы x(t) и u(t)

могут изменяться лишь в некоторой допустимой области

x(t)sGXl (1.2)

u(0eG„. (1.2')

Условие (1.2) называется фазовым ограничением, (1.2') —

ограничением на управление. Gx и Gu—некоторые задан-

ные множества.

Например, если описывается движение ракеты, запус-

каемой в космос, то векторное уравнение (1.1) может

быть представлено в виде системы

у! -• 4гЗ у2 _

/V — Л J Л - /V I

X3 = — (ф1 + u1 cos и2),

т (11')

х4 — — (ф2 4- u1 sin и2),

т

_______________ т — — F (и1),

и т. д., объединяют обычно одним термином — математическое про-

граммирование. Этот термин неудачный, поскольку математическим

программированием называют одновременно совокупность дисциплин,

связанных с переводом алгоритмов на язык машины (и в том числе

алгоритмические языки). В последнее время вопросы, связанные с

построением оптимальных решений, стали объединять общим терми-

ном— программатика, оставляя за математическим программирова-

нием только вопросы, связанные с процессом трансляции алгоритма

на внутренние языки машины. Согласно этой терминологии первые

главы данной монографии содержат краткое изложение методов про-

грамматики, используемых в теории управления динамическими объ-

ектами.

ПОСТАНОВКА ЗАДАЧ

15

§ 1]

в которой х1, х2—координаты положения, х3, Xs—коор-

динаты скорости, т — масса ракеты, м1— величина тяги,

и2—угол между направлением тяги и осью х1, F(ul) —

секундный расход массы. Кроме силы тяги на ракету

действуют сила тяжести, сопротивление атмосферы и т. д.

Суммарные проекции этих сил на координатные оси обо-

значены через ф1 и ф2.

Для рассматриваемой задачи множество Gx— это

некоторая заданная область пространства, окружающего

Землю. Траектория ракеты не может пересекать поверх-

ность Земли, не должна заходить в зону радиационных

поясов и т. п.

Управление полетом ракеты осуществляется за счет

регулирования величины и направления вектора тяги

двигателя: управляющие функции — это тяга и1 и угол и2.

Тогда множество Gu— это множество всех тех значений

«=(«*, и2), которые допустимы из конструктивных сооб-

ражений.

Движение динамического объекта стеснено некоторы-

ми начальными и конечными условиями, которые мы

будем обозначать следующим образом:

х (/0) <= й’о,

(1-3)

X (Т) €=

Например, могут быть заданы начальное положение, ско-

рость и масса ракеты. В этом случае первое из условий

(1.3) запишется так:

х1 (Q = xj, х2 (Q = Хо,

Х3(/0) = Х3, Х4(/0) = Хо,

/п (Q = т0,

где xj, х%, х2, х*,тй—фиксированные числа. Предполо-

жим, что ракета должна быть выведена на круговую

орбиту заданного радиуса R. Тогда второе из условий

(1.3) будет таким:

(?(7))*+(?(Т))а = /?,

х3 (Т) х1 (Г) + х4 (Т) х2 (Т) = 0, (1.3')

(x3(T))2 + (x4(T))2-v«.

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

где va—это скорость соответствующего кругового дви-

жения.

Первое из этих условий означает, что точка с коорди-

натами (х‘, х*) в момент времени t=T находится на ок-

ружности заданного радиуса 7?. Второе условие означает,

что векторы f и г>, имеющие соответственно компоненты

(х1, хг) и (Xs, х4), ортогональны, т. е. скорость точки в мо-

мент t=T направлена по касательной к окружности

заданного радиуса. Из третьего условия следует, что

скорость точки должна равняться скорости движения по

круговой орбите. Условие (1.3') гарантируют, что если

при t=T двигатель будет выключен, то последующее сво-

бодное движение будет движением по окружности.

Второе из условий (1.3) называется целью управле-

ния. Достижение системой (1.1) за заданное время Т не-

которого конечного состояния (например, достижение

аппаратом заданной высоты, или выход аппарата на ор-

биту) может быть реализовано, вообще говоря, бесчис-

ленным множеством способов, каждый из которых име-

нуется программой (или программным движением).

В технических задачах обычно возникает вопрос об оты-

скании наиболее «экономной» программы. Например, в

случае ракеты программа будет тем более экономной,

чем меньшее количество топлива будет израсходовано.

Математическое выражение этого факта, согласно по-

следнему уравнению (1.1')» состоит в том, что управле-

ние u(t) должно быть выбрано из условия минимума

интеграла:

т

Ци)= §F(uP)dl. (1.4)

г.

Функцию и(0, которая удовлетворяет всем ограничени-

ям, обеспечивает достижение объектом цели управления

и доставляет минимальное значение интегралу (1.4), мы

будем называть оптимальной программой или оптималь-

ным управлением.

Не менее часто встречается и другая постановка зада-

чи. Например, при заданной энергии, которая может

быть израсходована для вывода ракеты, заданном време-

ни вывода и заданном расстоянии до перигея мы должны

так построить программу управления — так выбрать

ПОСТАНОВКА ЗАДАЧ

17

$1]

функцию u(t) и соответствующую ей траекторию x(t), что-

бы расстояние до апогея было максимальным. При соот-

ветствующем выборе переменных эта техническая поста-

новка задачи сводится к отысканию управления, макси-

мизирующего функционал

J(x, и) = х1(Т), (1.5)

где xi— некоторая компонента вектора х.

Первая из задач называется задачей Лагранжа, вто-

рая— задачей Майера, функционал (1.4) (или (1.5))

часто называют целевой функцией или функцией цели.

Он определяет «стоимость» достижения цели .управления.

2. Математическая формулировка задач определения

оптимальных программ. В предыдущем разделе на при-

мере движения ракеты мы пояснили содержание, задач

отыскания оптимальных программ. Теперь мы дадим ма-

тематическую формулировку тех задач, которые будут

рассматриваться в первых главах этой книги.

В достаточно общем виде задача оптимального управ-

ления может быть сформулирована следующим образом.

Определить вектор-функции x(t)^Rn, u(t)^Rm при

te[/0, TJ, доставляющие минимум (максимум) функцио-

налу

J = J(x,u) (1.6)

при дифференциальных связях

x = f(_x, и, 0, (1.7)

ограничениях вдоль траектории

(х, и, (1.8)

и краевых условиях

(*Л)е=£0, (1.9)

(х, Т) <= ST.

Будем считать, что функции f непрерывны и дифферен-

цируемы по совокупности переменных х и и. Множество

G — некоторая область пространства /?“Х/?тХ#‘, а мно-

жества ЙГо и ST — некоторые многообразия в /?ПХ₽’.

Конкретизация выражений (1.6) — (1.9) порождает раз-

личные типы задач оптимального управления.

18

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

Принятая ниже классификация задач оптимального

управления является весьма условной, однако она помо-

жет читателю ориентироваться в литературе по данному

вопросу.

Типы задач можно разбить на три группы. В каждой

из групп определяющей характеристикой являются спосо-

бы, с помощью которых задаются соответственно

1. Функционал (1.6).

2. Ограничения вдоль траектории (1.8). ।

3. Краевые условия (1.9).

1. Способы задания функционала.

а) Интегральный функционал. Задача

Лагранжа. Интегральным функционалом называется

функционал вида

т

J(x,u) = ^F(x,u,t}dt, (1.10)

^0

где F предполагается дифференцируемой функцией своих

переменных.

В случае отсутствия ограничений (1.8) задача о ми-

нимуме (1.10) при условиях (1.7). и (1.9) традиционно

называется задачей Лагранжа. Она является классиче-

ской задачей вариационного исчисления *).

б) Задача Майера. В этом случае минимизи-

руемым функционалом является

J (х, и) = Ф (х (Т), Т). (1.11) |

Например, для системы (1.1х) можно поставить следую-

щую задачу Майера: определить управление и=(и1,и2)

так, чтобы за заданное время Т достичь максимальной

дальности х1{Т) при условии, что х2(7’)=0, т. е. чтобы

ракета в момент времени t—T оказалась на поверхности

Земли.

Можно также рассматривать задачу Майера, в кото- >

рой функционал зависит от краевых значений фазовых

координат на обоих концах.

*) Мы сформулировали задачу Лагранжа, несколько сузив ее по-

становку по сравнению с классическими курсами вариационного ис-

числения, записав дифференциальные связи (1.7) в нормальной фор-

ме Коши.

ПОСТАНОВКА ЗАДАЧ

19

§ II

Формально задача Майера является более общей, чем

задача Лагранжа: любая задача Лагранжа может рас-

сматриваться как частный случай задачи Майера. В са-

мом деле, рассмотрим задачу Лагранжа (1.7) — (1.10)

и введем новую скалярную переменную хп+‘ при помощи

уравнения

‘xn+1=F(x, и, t).

Введем еще новый фазовый вектор х и вектор /:

х{ — х1, i = 1, 2, ..., п + 1,

j = 1,2, ..., п,

р

Теперь задачу (1.7) — (1-Ю) мы можем переформулиро-

вать следующим образом. Определить вектор-функции

u(t) и x(t), доставляющие минимум функционалу

J (х, и) — хп+1(Т)

при условиях

х =*f (х, и, t).

В некоторых частных случаях задача Майера, в свою оче-

редь, может быть сведена к задаче Лагранжа.

Рассмотрим задачу Майера с функционалом (1.11)

и предположим дополнительно, что левый конец фазовой

траектории фиксирован

Я (Q ~ Хд.

Вместо функционала (1.11) рассмотрим следующий:

А (х, и) = Ф (х (Т), Т) - Ф (х (Q, t0). (1.12)

Поскольку Ф(х(М, t0) —величина известная, то функции

x(t) и м(0> доставляющие минимум функционалу (1.12),

доставляют также минимум функционалу (1.11) и об-

ратно.

Но нетрудно видеть, что

А (х, и) = f i^dt = J f (х, и, О) + ^-] dt,

^0 ^0

20

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

т. е. задача с функционалом (1.12)—это некоторая зада-

ча Лагранжа.

в) Задача Больца. Функционал смешан-

ного типа. Определить векторы u(t) и х(/), достав-

ляющие минимум функционалу

т

J (х, и) = J F (х, и, /) dt + Ф (х (/0), /0, х (Г), Т) (1.13)

to

при ограничениях (1.7) — (1.9).

Легко видеть, что задача с функционалом (1.13) мо-

жет быть сведена к задаче Майера.

г) Задачи на быстродействие. Этим тер-

мином объединяются задачи, в которых функционалом

(объектом минимизации) является время. Предположим,

что концы траектории фиксированы. Тогда задача на

быстродействие формулируется следующим образом: оп-

ределить управление, которое переводит систему из со-

стояния х0 в состояние хт за минимум времени. Задачи

на быстродействие являются важным классом задач тео-

рии оптимального управления.

2. Способы задания ограничений вдоль траектории.

а) Ограничение на управление. Пусть огра-

ничение (1.8) имеет вид

u(t)<=Gtt(t), (1.14)

где Gu— некоторое замкнутое множество из Rm. В част-

ном случае, когда GM совпадает со всем пространством

Rm, а функционал задан в виде (1.10), мы получаем зада-

чу Лагранжа.

Задачи с ограничениями на управление типа (1.14)

более адекватны вариационным задачам, возникающим

в технике: возможности управления всегда ограничены.

Например, часто встречаются ограничения типа

|м(0|<а(/). • (1.15)

Классические методы, развитые для решения задачи Ла-

гранжа, оказываются в общем случае неприменимыми

при наличии ограничений вида (1.14). Для подобных за-

дач в конце 50-х годов был разработан принцип максиму-

ма Л. С. Понтрягина, который будет подробно рассмот-

рен в § 3.

ПОСТАНОВКА ЗАДАЧ

21

§ И

б) Ограничения на фазовые перемен-

ные. Это ограничения (1.8) в следующей форме:

x(t)<=r(jx(t). (1.16)

Смысл подобных ограничений был уже пояснен на при-

мере, который мы рассмотрели в начале параграфа.

Применимость того или иного метода решения задач

с ограничениями на фазовые координаты существенно

зависит от вида ограничений (1.16). Обычно здесь разли-

чают ограничения типа равенств

Q1 0=0, / = 1, 2...k^n, (1Л7)

и ограничения типа неравенств

<У(х(0,О<О. (1.18)

в) Совместные ограничения на управле-

ние и фазовые переменные. Иногда огра-

ничения на управление и на фазовые координаты не

могут быть разделены, и тогда мы сталкиваемся с зада-

чей на «узкие места», в которой ограничения имеют вид

(1.8). Подобные задачи часто встречаются в экономике.

Здесь также различают ограничения в виде равенств

и (О, 0 = 0, / = 1, 2.. k^n + m, (1.19)

и неравенств

o!(x(t), u(0,0<0. (1.20)

г) Изопериметрическая задача (задача с

интегральными ограничениями). Определить

минимум функционала (1.6) при следующих ограниче-

ниях:

т

f¥z(x(O, = /=1,2, (1.21)

м

где —некоторые скалярные функции, а U—заданные

числа. Название этому классу задач дала следующая

«историческая» задача, изучавшаяся еще в концеXVII ве-

ка: определить кривую данной длины, которая ограничи-

вает максимальную площадь.

Класс изопериметрических задач играет большую

роль как в технике, так и в экономике, когда задан сум-

22

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

марный объем некоторого ресурса, которым мы вправе

распоряжаться. (Например, когда задан запас горючего,

который должен быть использован для управления реак-

тивным аппаратом или самолетом.) Изопериметрическая

задача может быть сведена к задаче Лагранжа увеличе-

нием размерности фазового вектора х. В самом деле, для

этого достаточно ввести новые скалярные переменные

при помощи уравнений

х»+/= ¥(х,и,/), /=1, 2, k.

Функции xn+i(t) должны, кроме того, удовлетворять ус-

ловиям

х"+^о) = О,

х"+/(Т)= //.

Таким образом, изопериметрическая задача сводится

к задаче Лагранжа (или Майера — в зависимости от

структуры исходного функционала), но для векторалграз-

мерности n+k.

3. Способы задания краевых условий.

В общем случае многообразия и в (1.9) —это

некоторые гиперповерхности в пространстве (х,t)

ПОСТАНОВКА ЗАДАЧ

23

§ И

(рис. 1.1), задаваемые уравнениями

Xl(x(/0Uo) = 0, 1 = 0,1..s^n, (-1.22)

Ф/(х(Т), Т) = 0, / = 0, 1, ..4, р^п. (1.23)

а) Задача с фиксированными концами.

Этот термин используется в задачах, в которых x(f0) и

х(Т) заданы. Различают также задачи с фиксированным

временем (t0, Т — заданы) и нефиксированным (либо /0,

либо Г не задано).

б) Задача со свободным концом. Если

х(/0) (или х(Т)) не задано, то мы имеем задачу со сво-

бодным левым (правым) концом. Здесь также различа-

ют задачи с фиксированным и нефиксированным време-

нем. Задачи со свободным концом, как мы увидим ниже,

играют важную роль при построении численных методов.

в) Задача с подвижными концами. Ес-

ли t0, Т — фиксированы, а векторы x(t0) и х(Т) лежат на

гиперповерхностях, определяемых уравнениями (1.22) и

(1.23), то говорят о задаче с подвижными концами и фик-

сированным временем. Если либо t0, либо Т в (1.22),

(1.23) не фиксировано, то мы получаем задачу с «переме-

щающимся многообразием» на соответствующем конце.

Перечисленные задачи не исчерпывают перечня задач,

которые принято относить к теории оптимального управ-

ления. Существует, например, важный класс задач, в ко-

тором в качестве функционала выступает величина

J (и) = max ф (х (ff), t е [/0 Г].

t

Задача управления — минимизировать эту величину.

Примечание. Эта задача может быть переформу-

лирована, если ввести скаляр у, такой, что

Ф(х(0)<Ш (*)

Тогда задача с функционалом у(и) сведется к отысканию

управления, которое минимизирует величину у(и) при

фазовом ограничении (*).

3. Задачи с дискретным временем. До сих пор мы го-

ворили о системах с «непрерывным временем», т. е. о

системах, эволюция которых описывается дифференци-

альными уравнениями. Но не менее важное значение

24

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

имеют системы с «дискретным временем». Их роль опре-

деляется не только тем, что при построении вычислитель-

ных процедур мы всегда проводим дискретизацию нашей

задачи—заменяем дифференциальные уравнения конеч-

норазностными. Существует обширный класс технических

и экономических задач, которые являются по существу

дискретными. Это прежде всего многошаговые задачи

принятия решений. Практически всегда развитие эконо-

мической системы описывается конечно-разностными

уравнениями. Шаг дискретизации определяется циклом

экономического процесса. Например, в системах, которые

описывают развитие сельскохозяйственного производст-

ва, таким циклом является год. Поэтому, наряду с дина-

мическими системами типа (1.1), мы будем рассматри-

вать системы конечноразностных уравнений вида

= fn(xn, Un), (1.24)

где

ДХл — Хп+i Хп,

хп— по-прежнему называется фазовым вектором, ип —

управлением.

Ограничения (1.2) и (1.2') сохраняют свой вид, если

заменить x(t) и u(t) на хп и ип соответственно.

Начальные и конечные условия мы будем записывать

в виде

хое^о, xNf=$N, (1.25)

где М— число шагов многошагового процесса (1.24).

Мы можем сформулировать аналоги задач Лагранжа

и Майера:

а) Задача Лагранжа. Определить векторы

«о, Ui,..., uN-i и xit хг,..., хя, доставляющие минимум

(максимум) скалярной функции

N-1

J (х, и) = Fl (xit ut) (1.26)

Z—О

при условиях (1.24), (1.2), (1.2х) и (1.25).

б) Задача Майера. Определить векторы и0,...

..., «w-j и %!.xN, доставляющие минимум (максимум)

§ 1] ПОСТАНОВКА ЗАДАЧ 25

скалярной функции

J(x, u) = <D(xw) (1.27)

при условиях (1.24), (1.2), (1.2') и (1.25).

Точно так же, как и в случае задач с непрерывным

временем, существует взаимосвязь обеих сформулирован-

ных задач (см. стр. 18). Подобно тому, как мы определи-

ли конечномерые аналоги задач Лагранжа и Майера,

могут быть определены дискретные аналоги всех тех

задач, которые были сформулированы в предыдущем

пункте. Например, изопериметрическими условиями в за-

дачах с дискретным временем мы будем называть усло-

вия вида

N-1

(1.28)

/=о

В этой книге мы будем рассматривать задачи оптими-

зации, возникающие в динамических системах, которые

описываются либо дифференциальными уравнениями

(1.1), либо конечноразностными уравнениями (1.24). Эти

два класса, конечно, далеко не исчерпывают всего мно-

жества задач, которые относятся к программатике.

Примечания.

1. В экономике часто имеют дело с задачами, в кото-

рых уравнение (1.7') имеет вид

х (0 = f (х (/), и (/ — т), t). (1.7')

Структура уравнения (1.7) отражает тот факт, что инве-

стиции, вложенные в момент времени т, начинают давать

результат только по прошествии определенного времени.

В самом деле, капитал, вложенный в строительство заво-

да, начнет давать отдачу только тогда, когда он превра-

тится в здания, станки, когда будет налажен технологи-

ческий процесс и т. д.

Таким образом, теория управления динамическими

процессами (1.7') имеет важное значение. К сожалению,

из-за отсутствия места она не может быть включена в

книгу.

2. Формулируя задачи определения оптимальных про-

грамм, мы выделяли три элемента. Цель управления, ог-

раничения и критерий качества — функционал. Однако

26

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

формально все эти элементы эквивалентны. В самом

деле, второе из условий (1.9) мы можем заменить усло-

вием минимума функционала /*, где

( 0, если (х, Т) е <St,

J* = 4 _

+°о, если (х, Т) е й’т.

Аналогично можно поступить и с остальными ограни-

чивающими условиями, в том числе и с управлением дви-

жения (1.7).

Таким образом, задача, которая формулируется в

данном параграфе есть частный случай следующей зада-

чи: определить функцию y(f), доставляющую минимум

функционалам

Л(Н0) i=l,2, ...

В общем случае подобная задача не имеет решения и

тогда возникает проблема свертывания критерия — заме-

на системы критериев .......Jh другими критериями.

Операция свертывания критериев не является формаль-

ной и мы с ней встретимся в последних главах книги.

Задача оптимального управления может рассматри-

ваться как частный случай задачи со многими критерия-

ми, который допускает решение. Последнее означает,

в частности, что пересечение множеств G^y), состоящее

из элементов, реализующих минимум функционалов

/<(«/), не пусто.

§ 2. Необходимые условия в задачах

классического вариационного исчисления

1. Задача Лагранжа. В предыдущем параграфе мы

подробно обсудили постановку и терминологию различ-

ных вариационных задач, относящихся к теории опти-

мального управления. Для их эффективного решения мо-

гут быть использованы различные методы. Обширный

класс методов расчета оптимальных программ доставля-

ют методы, опирающиеся на необходимые условия опти-

мальности.

Мы переходим теперь к изложению некоторых усло-

вий такого рода — они будут использованы в дальнейшем

для построения вычислительных методов.

§21 О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ 27

В предыдущем параграфе, формулируя задачи, мы

не акцентировали наше внимание на свойствах гладко-

сти, которыми должны обладать искомые функции. По-

этому теперь, прежде чем переходить к отысканию необ-

ходимых условий экстремума, мы несколько уточним

постановку рассматриваемой задачи.

В этом параграфе мы будем изучать следующую зада-

чу Лагранжа:

определить непрерывную вектор-функцию u(f) и диф-

ференцируемую вектор-функцию x(t) со значениями из

Rm и Rn соответственно, доставляющие минимум функ-

ционалу

т

J (х, и) = J F (х, и, t) di, (2.1)

to

где F — скалярная, непрерывно дифференцируемая функ-

ция своих аргументов, при условиях

x = f(x,u,t), (2.2)

(x(f0), /0)<=£0,

(x(T),Ds?r; { '

f — непрерывно дифференцируемая вектор-функция, <F0

и <ГТ—заданные множества из Rn+l, структура которых

будет уточнена ниже.

Сразу же оговоримся, что развиваемые здесь методы

для задачи Лагранжа могут применяться и для исследо-

вания задач Майера и Больца. Кроме того, мы ограни-

чимся исследованием частного вида ограничений (2.3).

Необходимые условия для задачи Майера и Больца, а

также для случая ограничения (2.3) более общего вида

будут сформулированы и кратко обсуждены в п. 7 этого

параграфа.

Для дальнейшего нам удобно несколько изменить

обозначения. Обозначим Г(х, и, t) =f*(x, и, t) и введем

скалярную величину x°(t), удовлетворяющую уравнению

x°=f°(x, и, i). Тогда функционал (2.1) равен конечному

значению

J (х,. и) = х° (Т).

(2.1') ,

28

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

Введем также расширенный фазовый вектор х= (х°, х1*,...

хп\ ss (х°, х) и расширенный вектор правых частей

7= (Г >f‘> ?>•••> Тогда вектор х будет удов-

летворять уравнению

х =7(х, и, t), (2.2')

т. е. 7 не зависит от х°.

Теперь задачу (2.1—2.3) мы можем сформулировать

следующим образом: определить непрерывную вектор-

функцию u{t) и дифференцируемую вектор-функцию

x(t) со значениями из Rm и Rn соответственно, доставля-

ющих минимум функционалу (2.1') при условиях (2.2')

и (2.3).

2. Вспомогательная лемма. Для дальнейшего нам по-

надобится следующая.

Лемма. Пусть f(t) — непрерывная вектор-функция.

Если интеграл

т

I = J(f, фИ

равен нулю для любой непрерывной вектор-функции ф(/),

то необходимо f=0.

Доказательство. Пусть f^O, тогда существует

такая точка ?, что f(f)=#O, и, следовательно, существует

интервал (Г—8, Г + е), где хотя бы одна из компонент

т^о.

Построим функции

I _ [?(*)(!* — 8 — ОТ + 8~О8, если 8,Г+8],

10, если t е [Г—е, f + 8],

<р/ = 0, если / =7=

Так как произведение ф'(0/г(0 на этом интервале неот-

рицательно и обращается в нуль только на концах, то

интеграл I положителен. Полученное противоречие дока-

зывает утверждение.

3. Вариации управления и траектории. Сейчас мы

приступаем к выводу необходимых условий. Рассмотре-

ние будем вести для случая фиксированного левого

конца.

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

29

5 2]

Обозначим через й некоторое управление, тогда соот-

ветствующая траектория х определится как решение за-

дачи Коши для уравнения (2.2). Далее обозначим через

8 некоторый скаляр (в может быть как положительным,

так и отрицательным), через би-произвольную непрерыв-

ную функцию и наряду с управлением й рассмотрим

управление и,:

и8 = и + еби.

Через х* обозначим вектор х, который будет удовлет-

ворять уравнению

*8 = 7 (*е. и +g$«, t).

Вариацией вектора х будем называть векторную произвол’

— / дх \

ную h = —- . Вектор-функция h (f) удовлетворяет

X &

уравнению

*=м+м“- м

Поскольку начальное значение вектора х не зависит

от 8, то

ЗД = 0. (2.4')

В уравнении (2.4) принят^! обозначения fx = ,

II дх1 ||

/„ = -^1, i = 0, 1,2, ..., п, / = 0, 1,2, .... n, 6 =

duk ||

/ fix \

= 1,2, ..., т. Величину h = — будем называть вариа-

X /е=о

цией фазовой траектории, a h°(T), где h°(T) = (— । ,

' ^8 / g=0

— вариацией функционала. Величина h°(t) удовлетворяет

уравнению

ft°=(fU)+(ftt0,6u)' (2.5)

с начальным условием

/i°(U = 0.

(2.5')

30

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

(ГЛ. I

4. Сопряженные (двойственные) переменные. В даль-

нейшем мы часто будем использовать понятие сопряжен-

ной системы уравнений.

Пусть мы имеем линейное неоднородное уравнение

х — Лх]4- Ь, (2.6)

где А и b — матрица и вектор, элементы которых at} и

Ь{—заданные функции времени.

Системой, сопряженной (2.6), называется система

Ф = — Л’ф, (2.7)

где Л*— сопряженная (транспонированная) матрица,

элементы которой получены перестановкой строк и столб-

цов матрицы Л:

aij = ад.

Вектор ф, удовлетворяющий уравнению (2.7), называет-

ся вектором сопряженных или двойственных переменных.

Векторы х и ф обладают следующим важным свой-

ством:

А(ф, х) = (ф.Ь). (2.8)

at

Справедливость равенства (2.8) устанавливается простой

проверкой:

-А. х) = (ф, х) + (ф, х)« — (Л*ф, х) 4- (ф, Ах + Ь) =

= — (Л’ф, х) + (Л’ф, х) 4- (ф, Ь) = (ф, Ь).

Обозначим теперь через ф=(ф°, ф) вектор, сопряженный

Л, где h удовлетворяет системе (2.4). Тогда

ф=-£ф, (2.9)

или

ф=-/;ф-г;ф°, (29,}

— ф° = 0.

Здесь ф— («4-1)-мерный вектор, ф°—скаляр.

Сопряженные переменные ф0, фъ..., ф„ называются

также множителями Лагранжа или импульсами. Заме-

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

31

§ 2]

тим, что в силу однородности уравнения (2.9) определяют

сопряженные переменные с точностью до постоянного

множителя.

Используя сопряженные переменные, можно получить

выражение для вариации функционала в форме, удобной

для составления необходимых условий минимума.

Составим скалярное произведение

М (0 = (ф, й) = (ф, h) + ф°/1°. (2.10)

В силу свойств (2.8)

(2.11)

at

и, следовательно,

т

М(Т)-М (Q = J (Ф, fu 6м) dt. (2.12)

^0

5. Необходимые условия минимума в задаче со

свободным концом. Вывод необходимых условий мы нач-

нем с рассмотрения задачи со свободным правым концом,

поскольку для этого случая можно продемонстрировать

технику вывода, не усложняя ее тонкими рассуждениями,

необходимыми в общем случае.

Итак, рассмотрим задачу со следующими краевыми

условиями:

x(t9)=x0. (2.13)

На правый конец х(Т) никаких ограничений не наклады-

вается.

Из (2.10) согласно (2.4) и (2.5) при t=ta имеем

М (/0) =0, поэтому из (2.12) получаем

т

М (Г) = (ф, й)|/-г = J (ф, Ju 6u) dt-, (2.14)

to

так как (ф^ й) = (ф, h) + ф°Л°, то

т

Ф°л°=—(ф, /i)L=r + J (ф» 7«6u)dt-

to

32

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

Распорядимся вектором сопряженных переменных, под-

чинив значения -ф0(Г) и 'ф(Т) следующим условиям:

гр(Г) = 0, (2.15)

Фо(Л = -1. (2-16)

Предположим теперь, что й (I) является оптимальным

управлением. Тогда вариация функционала h°(T) долж-

на обращаться в нуль для любых бы, не стесненных ника-

кими условиями:

Л°(7’)=0. (2.17)

Отсюда согласно лемме п. 2 следует, что для Т)

2-(^J) = 0. (2.18)

Если ввести функцию Гамильтона

Н = (ф,7) = (ф,/)-Г, (2.19)

то условие (2.18) можно записать в виде

= 0. (2.20)

Итак, мы пришли к следующей теореме:

Теорема. Если функции u(t) и x(t) доставляют

минимум функционалу (2.1) при условиях (2.2) и (2ЛЗ),

то существует такая непрерывная вектор-функция ф(0>

удовлетворяющая уравнению

* = (2.21)

и условию

ф(Г) = 0, ф0(Л = - 1. (2-22)

что управление й (I) в каждый момент времени t являет-

ся стационарной точкой функции Гамильтона.

Условие (2.22) представляет собой частный случай

условий трансверсальности, общий вид которых будет

приведен в п. 7.

Сопряженные уравнения (2.21) и условия стационар-

ности (2.20) представляют собой уравнения Эйлера клас-

сического вариационного исчисления.

Итак, функции х (/) и ф(/) необходимо должны быть

решением некоторой краевой задачи для системы диффе-

ренциальных уравнений порядка 2ы, которую мы полу-

S 21

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

33

чим, если определим u(t) из условия стационарности

(2.18)

и=й(х, ф, О

и подставим функцию и в уравнения (2.2) и (2.21):

х == f(x, и (х, ф, /), /) = f (X, ф, О,

ф = —£(*,« (х, ф, t), (х, и(х, ф', /),/) = ф (X, ф, t).

Порядок этой системы равен 2п, и для отыскания интере-

сующего нас множества решений мы имеем также 2п

условий: на левом конце задано п компонент фазового

вектора x(t0), на правом конце—значения сопряженных

переменных ф (Т) =0.

Примечание. Особенность задачи со свободным

концом состоит, таким образом, в том, что на правом кон-

це траектории полностью определен вектор импульса.

Это обстоятельство (как мы увидим ниже) делает зада-

чу со свободным концом наиболее простой для численно-

го решения среди других задач оптимального управления.

6. Необходимые условия в задаче с фиксированным

временем и подвижным правым концом. Перейдем теперь

к рассмотрению более

сложной задачи. Время Т

по-прежнему будем счи-

тать фиксированным, но

на правый конец наложим

дополнительное ограниче-

ние типа (2.3): будем счи-

тать, что траектория долж-

на оканчиваться на по-

верхности ф(х)=0, т. е.

должна удовлетворять

граничным условиям

Рис. 2.1.

Х W — Хо>

Ф(х(Т)) = 0,

(2.23)

(2.24)

где Ф — вектор-функция с компонентами Ф*, &=1,2,...

...,р<п, якобиан которой имеет свой максимальный

ранг р.

Таким образом, задача состоит в отыскании управле-

ния, которое переводит систему из точки (/0, х») на по-

верхность Ф(х)=0 за заданное время Т —t0 (рис. 2.1).

2 Н. Н. Моисеев

34

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

Для изучения этой задачи мы не можем непосредст-

венно применить рассуждения предыдущего параграфа.

В самом деле, эти рассуждения основывались на том, что

функция u(t) реализует экстремум функционала на всем

множестве возможных управлений. Отсюда следовало,

что

/г°(7’)=0,

какие бы ни были вариации бы. В рассматриваемой

задаче, поскольку заданы концевые условия (2.24), ус-

ловие /i°(7’)=0 должно выполняться не для произволь-

ных вариаций 8и, а только для тех из них, которые не

разрушают концевых условий. Поэтому приведенное

доказательство необходимых условий для задачи с под-

вижным концом должно быть заменено другим. Это до-

казательство мы проведем, опираясь на схему рассуж-

дений Блисса *).

Пусть бы< (i= 1,..., р +1)—некоторые заданные

функции, а й — оптимальное управление (решение зада-

чи). Составим новое управление,

р+1

и = и + 2 Ъ1 ^и‘> (2.25)

ы=1

где е« — параметры, которыми мы можем распоряжаться.

Функция, соответствующая оптимальному управлению,

удовлетворяет условиям (2.24). Функция x(t), определен-

ная управлением (2.25), в общем случае уже не удовлет-

воряет условиям (2.24) при произвольных значениях па-

раметров Зададим некоторое число I и подберем р+1

параметров е,- так, чтобы имели место условия

J (х, и) ~ J (X, и) + I,

(2.26)

ф*(х(Т)) = 0, 6=1.......р.

Эта система имеет решение при /=0. Решением будут

нулевые значения параметров 8,-.

*) См. Г. А. Блисс, Лекции по вариационному исчислению,

ИЛ, 1950.

§ 2]

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

35

Если определитель

д = dJ d&i дФ1 д&х dJ д&2 дФ\ dJ 9 (2.27)

д8р+1 дФх

Й6р+1

дФр дФр дФр

д&1 д&1 ' Am

элементы которого вычислены при ef=0, отличен от нуля,

то система (2.26) имеет единственное непрерывное реше-

ние е,(/) (обращающееся в нуль при 1=0) для любых I

в некоторой окрестности 111 |л>0.

Очевидно, что в этом случае u(t) и x(t) не могут быть

оптимальным решением, поскольку может быть построе-

но управление

~ р+1

и = и 2 8/ (0 I О,

i=i

такое, что

J (х, и) = J (х, и) +1,1<0,

Ф(х(Л) = 0,

т. е. функционал может быть уменьшен при сохранении

граничных условий.

Итак, определитель А=0. Заметим, что элементы

этого определителя

где hs находится из уравнения — hs+ — i>us, пол-

дх ди

ностью задаются системой функций 6us. Следовательно, и

2*

36

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

ранг Д определяется этими же функциями. Пусть {&us} —

система функций, доставляющих определителю Д макси-

мальный ранг q<Zp+ 1. В этом случае, в силу линейной

зависимости строк, необходимо должны существовать числа

v0, , vp, не все равные нулю, такие, что для любо-

го s имеет место равенство

^(T)+^vkd-^- = Q, s= 1,2, ...» р+ 1.

Теперь покажем, что это равенство должно иметь место

для любых ди. В самом деле, пусть найдется вектор-функ-

ция дир+2, для которой оно не имеет места. Тогда, взяв

в качестве новой системы функций совокупность ди2,

д«з, ..., дир+1, дир+ъ (считая для определенности, что стол-

бец, соответствующий диъ есть линейная комбинация

остальных столбцов Д), мы построим определитель Д,

ранг которого будет больше q, что противоречит предпо-

ложению о том, что q есть максимальный ранг Д.

Итак, мы приходим к следующему основному необхо-

димому условию:

Теорема. Если й и х — оптимальные управление и

траектория, то необходимо должны существовать числа

v0, Vi,..., vp, не все равные нулю, и такие, что, какова бы

ни была вариация управления ди, имеет место равенство

р

voh°(T)+^vk^-h^Q. (2.28)

£==1 dx

Еще раз подчеркнем, что вариация би здесь произ-

вольна; в частности, она может разрушать граничные ус-

ловия на правом конце. При преобразовании условий

(2.28) нам понадобится формула (2.14) для вариации

функционала, которую мы запишем в виде

т

dt,

(2.29)

6

где

н = (ф, Л + ф°/°, (2.30)

§ 21

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

37

а гр° и ф= {фь ..., ф„} — сопряженные переменные,

удовлетворяющие системе

ф° = О,

{• дН

(2.31)

Положим »!>’=Vo, тогда, подставляя (2.29) в (2.28),

мы приведем необходимое условие оптимальности к виду

= 0. (2.32)

Распорядимся выбором сопряженных функций, подчи-

нив их условиям

«|Т) -2 • (2.33)

fe=l ОХ ч=т

с тем чтобы внеинтегральное слагаемое в (2.32) равня-

лось нулю для любых вариаций h(T) (в том числе и для

тех, которые приводят к разрушению граничных условий

на правом конце).

Поскольку оставшееся интегральное слагаемое в

(2.32) должно быть равно нулю при любом выборе би, из

леммы п. 2 получаем, что на оптимальной траектории

должно быть выполнено условие стационарности функ-

ции Гамильтона

— = 0. (2.34)

ди

Итак, мы получили следующую теорему:

Теорема. Если вектор-функции u(t)u x(t) достав-

ляют минимум функционалу (2.1) при условиях (2.2),

(2.23) и (2.24), то существует такая ненулевая, непрерыв-

ная вектор-функция = (ф0, ip), удовлетворяющая систе-

ме (2.31) и условию (2.33), что управление u(t) является

стационарной точкой функции Гамильтона (2.30).

Условие (2.33), наложенное на ip(T), имеет простой

геометрический смысл: вектор гр(/) ортогонален гранич-

ному многообразию Ф(х(Т))=0, т. е. для любых й(Т),

38

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

удовлетворяющих условиям

=0, k=\............р,

\ &Х / |/_7’

выполняется

Ok h) |<=г = 0.

Действительно,

(M)Ur=(s

\£=1 °Х /

Р

= 2 v*

/=Т Й=1

- 0.

t=T

Условия (2.33) называются условиями трансверсально-

сти. Сопряженные уравнения (2.31) и условия стацио-

нарности (2.34) представляют собой уравнения Эйлера.

7. Дальнейшее обобщение необходимых условий.

Рассмотрим, какие изменения возникнут в необходимых

условиях оптимальности в случае иного задания гранич-

ных условий. Если конечное время Т не закреплено, тс

для задачи Лагранжа, в которой граничные условия на

правом конце заданы в виде

Ф(х(Т), Т) = 0. k=’a\, ..., р'^п+ 1,

из основного необходимого условия, аналогичного (2.28),

после замены

h (Г) = дх (Г) — f (х (Г), и (Т), Т) дТ

получаем соотношение

т

fI дН . \ ,, . ( , . £

1 I---, бц I dt —1|) + у

J \ ди J \ Г"

/ К~

*0

/ Ч=Т

—) 6Т-0. (2,35)

dt /

р

По-прежнему, выбирая 'ф(Т) в виде (2.33) и рассматри-

вая (2.35) при дГ=О, мы приходим снова к необходимо-

му условию (2.34) стационарности Н по и. Далее, по-

скольку первые два слагаемых в равенстве (2.35) оказы-

ваются равными нулю при любом выборе вариации

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

39

§ 21

а это равенство должно выполняться и при 8Т=£=0, то для

случая нефиксированного конечного времени Т мы полу-

чаем дополнительное необходимое условие

#U=-2v^| . (2.36)

В случае, если время t не входит явно в граничные

условия и конечное время Т не фиксировано, из (2.36)

получаем условие обращения в нуль функции Гамиль-

тона

Н|/=т = 0. (2.37)

Для автономной задачи (когда время t не входит яв-

но в функционал, уравнения связи и граничные усло-

вия) при нефиксированном Т применение приведенных

рассуждений для произвольного момента времени т

(ta<_x^T) показывает, что функция Гамильтона равна

нулю на всем отрезке |70, 7]:

Н = const = 0, f е [/0, Т]. (2.38)

Последний результат важен потому, что всякую неав-

тономную задачу с помощью замены

хп+1 = t

и введения дополнительного уравнения связи ----- 1,

dt

xn+1 (/0) = t0 можно свести к автономной задаче, для ко-

торой функция Гамильтона тождественно равна нулю:

Н + фп+i -1 = 0,

откуда

фп+1 = — Н,

и сопряженное уравнение для ф„+1:

принимает вид

. (2.39)

40

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

Таким образом, функция Гамильтона удовлетворяет диф-

ференциальному уравнению (2.39). Это уравнение пона-

добится нам в дальнейшем при выводе условий Эрдма-

на — Вейерштрасса.

До сих пор все рассуждения, с помощью которых были

получены необходимые условия, проводились в предполо-

жении, что оптимальное управление и (/) является непре-

рывной функцией времени. Как будут выглядеть необхо-

димые условия, если оптимальное управление й(0

является кусочно непрерывной функцией (функцией,

имеющей конечное число разрывов первого рода) ?

Если по-прежнему рассматривать непрерывные вариа-

ции управления бм(0, то вариации фазовых координат

h(t) в случае разрывного u(t) останутся непрерывными,

но будут кусочно дифференцируемыми функциями, име-

ющими угловые точки при значениях времени t=r,

соответствующих разрывам й(/). Основное свойство (2.8)

сопряженных переменных также остается справедливым.

При этом ф(/) аналогично h(t) является непрерывной,

кусочно дифференцируемой функцией, так что в точках

t—% разрыва u(t)

фГ) = ф(т+). (2.40)

Все другие приведенные выше рассуждения дословно

проходят и для случая кусочно непрерывного управле-

ния и (0. Поэтому установленные выше результаты оста-

ются в силе. Используя, в частности, (2.39), мы получаем,

что функция Гамильтона непрерывна в точках /=т раз-

рыва

Я|/==т_ = Я|/=т+. (2.41)

Условия (2.40), (2.41) называются условиями Эрдмана—

Вейерштрасса. Они требуют непрерывности сопряжен-

ных переменных и функции Гамильтона в точках разры-

ва u(t).

До сих пор мы вели рассмотрение для задачи Лагран-

жа (задачи с интегральным функционалом). Что изме-

нится в полученных результатах, если рассматривается

задача Майера (функционал задан в виде функции конеч-

ного состояния) или задача Больца (смешанный функ-

ционал) ?

Повторение аналогичных рассуждений показывает,

что все необходимые условия, кроме условий трансвер-

О ЗАДАЧАХ ВАРИАЦИОННОГО ИСЧИСЛЕНИЯ

41

§ 2]

сальности, не изменяют своего вида. При этом функция

Гамильтона для задачи Майера записывается в форме

п

z==l

т. е. включает в себя только правые части дифференци-

альных уравнений.

Условия трансверсальности в задаче Майера с фикси-

рованным конечным временем Т и функционалом

/ = ф»(х(Т))

принимают вид

+ (2.42)

Если в задаче Майера конечное время Т не фиксиро-

вано и функционал задан в виде

J = Ф°(х(Т), Т),

то условия трансверсальности (2.42) дополняются еще

одним соотношением

= -+ 2 v^)l • (2.43)

\ 01 А=1 ot 1 1/=т

Из (2.43) видно, что если время t не входит явно в гра-

ничные условия и функционал, то должно быть

Я|/=г=0. (2.44)

Для автономной задачи Майера условие (2.44) выполня-

ется тождественно для всех t:

Н — const = 0, t е [/0, Г].

Условия трансверсальности для задачи Больца в точ-

ности совпадают с условиями трансверсальности в зада-

че Майера. Отличие только в виде функции Гамильтона,

имеющей дополнительное слагаемое ф0/°.

В самом общем случае задачи Больца, когда /0 и Т

не фиксированы, а левый и правый концы подвижны, т. е.

42

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

граничные условия заданы в виде

Xs (х (/0), /0) = 0, s = 1, ..., q п + 1,

Ф*(х(Т),Т) = 0, fe=l,...,p, р<п+1,

а функционал

т

J = Ф° (х (Т), Т) — Х° (х (Q, Q + [ /° (х, и, f) dt,

основное необходимое условие (2.28) принимает вид

s k

и схема рассуждений, аналогичная той, которая была

проведена в п. 6, приводит к условиям трансверсальности

в виде

(2Л5)

«и = -(ч>.^ + 3 + 1>О| <2-4в)

4 S=1 ' '*—*о

’ <2-47>

+ • (2-48)

k—1

Если t0 или Т закреплены, то из условий (2.45) — (2.48)

исключаются условия (2.46) или (2.48) соответственно.

Сопряженная вектор-функция, для которой сформули-

рованы приведенные необходимые условия, вообще гово-

ря, является неединственной. Во всяком случае, она опре-

делена пока с точностью до произвольного постоянного

множителя.

Выделим класс задач, в котором (после соответствую-

щей нормировки) сопряженная вектор-функция оказыва-

ется единственной. Для этого снова вернемся к выводу

§ 21

о задачах вариационного исчисления

43

основного необходимого условия (2.28), приведенного

в п. 6.

Рассмотрим определитель Д, строки которого суть ва-

риации функционала и граничных условий на выбранном

(р+1) -параметрическом семействе вариаций би3. Если

максимальный ранг матрицы, полученной из (2.27) вы-

черкиванием первой строки, в точности равен своему мак-

симально возможному значению, то будем называть этот

случай нормальным, в противном случае — анормальным.

Для нормального случая первая строка Д есть линей-

ная комбинация остальных строк. Отсюда следует, что

коэффициент Vo отличен от нуля. Поэтому в нормальном

случае систему чисел v0, , vP можно пронормиро-

вать, разделив все vk на —v0. В результате, переобозна-

чив —vA/vo на vA, получим основное необходимое условие

(2.28) в виде

р

-dJ + 2 vftM)\=r=0. (2.49)

k=l

Покажем, что в нормальном случае система чисел —1,

V1,..., vp, удовлетворяющая (2.49), является единствен-

ной. В самом деле, если существует другая система чи-

сел— 1, р,!,..., для которой при любых вариациях би (/)

выполняется условие

р

- М + 2 Щ = 0, (2.50)

k—1

то, вычитая (2.50) из (2.49), мы получим, что существует

ненулевая система чисел

а* = vfc —1, .... р,

для которой

р

2мфЧ=г=о,

k=l

т. е. строки матрицы, составленной из элементов опреде-

лителя Д вычеркиванием первой строки, линейно зависи-

мы, что противоречит определению нормального случая.

Итак, мы установили, что если управление u(t) оптималь-

44

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

If л. i

но, то существует сопряженная вектор-функция такая,

что выполняются условия трансверсальности и условия

стационарности Н по и, причем для большинства практи-

ческих задач (для нормальных случаев) сопряженная

вектор-функция после нормировки оказывается единст-

венной.

Помимо этих необходимых условий оптимальное уп-

равление должно удовлетворять еще одному условию —

необходимому условию Вейерштрасса, требующему непо-

ложительности функции Вейерштрасса

Е = Я —(2.51)

где Н и Й берутся соответственно при произвольном и

оптимальном управлениях «(/) и u(t).

Из (2.51) следует, что в каждый момент времени

функция Гамильтона Н достигает своего максимального

значения на оптимальном управлении м=и (/)*).

Мы не будем специально выводить условие Вейер-

штрасса, поскольку оно содержится в более общем- ре-

зультате—в принципе максимума Л. С. Понтрягина.

В курсах классического вариационного исчисления

устанавливается еще одно необходимое условие — усло-

вие Якоби отсутствия сопряженной точки на исследуемой

траектории. Желающим детально разобрать условие

Якоби мы рекомендуем обратиться к соответствующим

источникам **).

8. Условия типа равенств. Метод Лагранжа. Предпо-

ложим теперь, что помимо условий (2.2) и (2.3) на выбор

управлений наложены условия вида

V/: <р (х, и, 0 = 0, (2.52)

где ф(х, и, t)—непрерывно дифференцируемая вектор-

функция своих переменных размерности k<n. Для реше-

*) Нормировка Vo=+'J отличается от Vo=—1 тем, что сопря-

женная вектор-функция (—1, ф1(0, • • • > Фп(0)> соответствующая

v0=—1, умножается на —1. Поэтому при Vo= + 1 знак неравенст-

ва в условии Вейерштрасса (2.51) следует заменить на обратный.

Именно в таком виде условие Вейерштрасса приводится в курсах

классического вариационного исчисления. При выборе коэффициен-

та нормировки Vq=—1 условие Вейерштрасса совпадает по форме с

основным утверждением принципа максимума Л. С. Понтрягина.

**) См., например, Г. А. Б лисе, Лекции по вариационному ис-

числению, ИЛ, 1950.

§ з]

ПРИНЦИП МАКСИМУМА Л. С. ПОНТРЯГИНА

45

ния этой задачи можно использовать классический прием

Лагранжа.

Вместо функционала (2.1) рассмотрим функционал

т т

J = J {/° (х, ц, t) + X, <р (х, и, t)} dt = (x, u, t) dt, (2.53)

^0 ^0

где h(t) —некоторая вектор-функция размерности k.

Повторяя для функционала (2.53) рассуждения пре-

дыдущих параграфов, мы легко придем к следующему

утверждению.

Теорема. П усть вектор-функция ф (t) удовлетворя-

ет уравнению

где Н — функция Гамильтона: Н= (ф, [) — f°— (%, ср).

Тогда, для того чтобы функции x(t) и u(t) доставля-

ли минимум функционалу (2.1) при условиях (2.2) и

(2.53), необходимо, чтобы в любой момент времени функ-

ции u(t) и x(t) удовлетворяли условиям стационарности

f.'i-n -Л<ь) = О,

^7 s Ч> (*, О = О-

ал

(2.54)

Таким образом, множитель Лагранжа Л (0 играет

роль управления: разрешая систему m+k уравнений

(2.54), мы находим функции и=м(ф,х,/), Х=Х(ф,х, f)

и, следовательно, мы снова приходим к краевой задаче

для системы 2п уравнений относительно x(t) и ф(/).

§ 3. Принцип максимума Л. С. Понтрягина

1. О постановке задачи Л. С. Понтрягина. В предыду-

щем параграфе мы рассмотрели задачу Лагранжа

и установили необходимое условие оптимальности. Оно

состояло в том, что оптимальное управление должно

быть стационарной точкой функции Гамильтона, т. е.

46

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. 1

удовлетворять векторному уравнению

^. = 0.

ди

Если решение этого уравнения единственно, то мы

может определить управление

и=й(х, ф, /),

и, следовательно, получаем возможность свести вариа-

ционную задачу к решению некоторой краевой задачи

для обыкновенных дифференциальных уравнений.

Основное предположение, сделанное при изучении

задачи Лагранжа, состояло в том, что управление мо-

жет принадлежать всему пространству — на управление

не налагалось ограничений. В практических задачах,

однако, множество допустимых управлений, как правило,

имеет существенно «неклассический» вид: оно ограниче-

но, во многих случаях многосвязно, может не иметь

внутренних точек и т. д. Для таких задач необходимые

условия в том виде, как они установлены выше, естествен-

но, непригодны. Их дальнейшим и существенным расши-

рением является замечательный результат, установлен-

ный Л. С. Понтрягиным *).

Согласно теореме Л. С. Понтрягина, получившей на-

звание «принцип максимума», оптимальное управление

должно доставлять функции Гамильтона максимальное

значение.

Благодаря принципу максимума, редукция вариаци-

онной задачи к краевой получила широкое распростране-

ние и в настоящее время лежит в основе большинства

используемых алгоритмов.

Итак, рассматриваем задачу:

Определить вектор-функции u(t) и х(/), доставляю-

щие минимум функционалу

т

J (х, и) — J /° (х, и, t) dt (3.1)

*) Л. С. Понтрягин, В. Г. Болтянский, Р. В. Г а м к р е-

л и д з е, Е. Ф. Мищенко, Математическая теория оптимальных

процессов, Физматгиз, 1961.

§ 3] ПРИНЦИП МАКСИМУМА Л. С. ПОНТРЯГИНА 47

при условиях

х=/(х, и, t), (3.2)

и е Gu, (3.3)

(х(/0),/0)е^0, (х(Т),Т)е=ёт, (3.4)

где Gu—множество допустимых управлений, и <S?—

заданные многообразия (м+1)-мерного пространства

начальных и конечных условий, структура которых будет

уточнена ниже, а функции f°, f= (fl, f2,..., fn) и их част-

ные производные по х непрерывны по совокупности пере-

менных. Множество Gu может быть весьма общей приро-

ды. В частности, оно может быть замкнутым.

Управление u(t) мы будем разыскивать в классе ку-

сочно непрерывных функций.

Если не считать иных, более слабых предположений

относительно свойств непрерывности функций f°, f, то

единственное внешнее отличие рассматриваемой задачи

от задачи Лагранжа, которая изучалась в предыдущем

параграфе, состоит в появлении нового условия (3.3).

Однако именно это обстоятельство и делает задачу зна-

чительно более трудной. Осложнения, которые возникают

вследствие условия (3.3), связаны с тем, что допустимые

вариации управления должны удовлетворять условию

и — и + е Gu,

т. е. вариации управления теперь не произвольны, они

должны удовлетворять заданным ограничениям.

Исходное утверждение, которое мы использовали для

получения необходимых условий в задаче Лагранжа, со-

стояло в следующем.

Для того чтобы х, и доставляли минимум функциона-

лу J(х, и), необходимо, чтобы б/ (х, и, 8х, 6w)=0 для

любых допустимых *) вариаций бх, би.

Это условие аналогично условию обращения в нуль

линейной части приращения функции <р (х), т. е.

ф' (х) dx = О,

*) То есть таких вариаций 6х и би, которые связаны уравнениями

в вариациях и не нарушают граничных условий исходной задачи.

48

ОПТИМАЛЬНЫЕ ПРОГРАММЫ

[ГЛ. I

которое мы имеем в теории экстремума функции одной

переменной, когда х принадлежит всей числовой оси.

Предположим теперь, что минимум разыскивается на

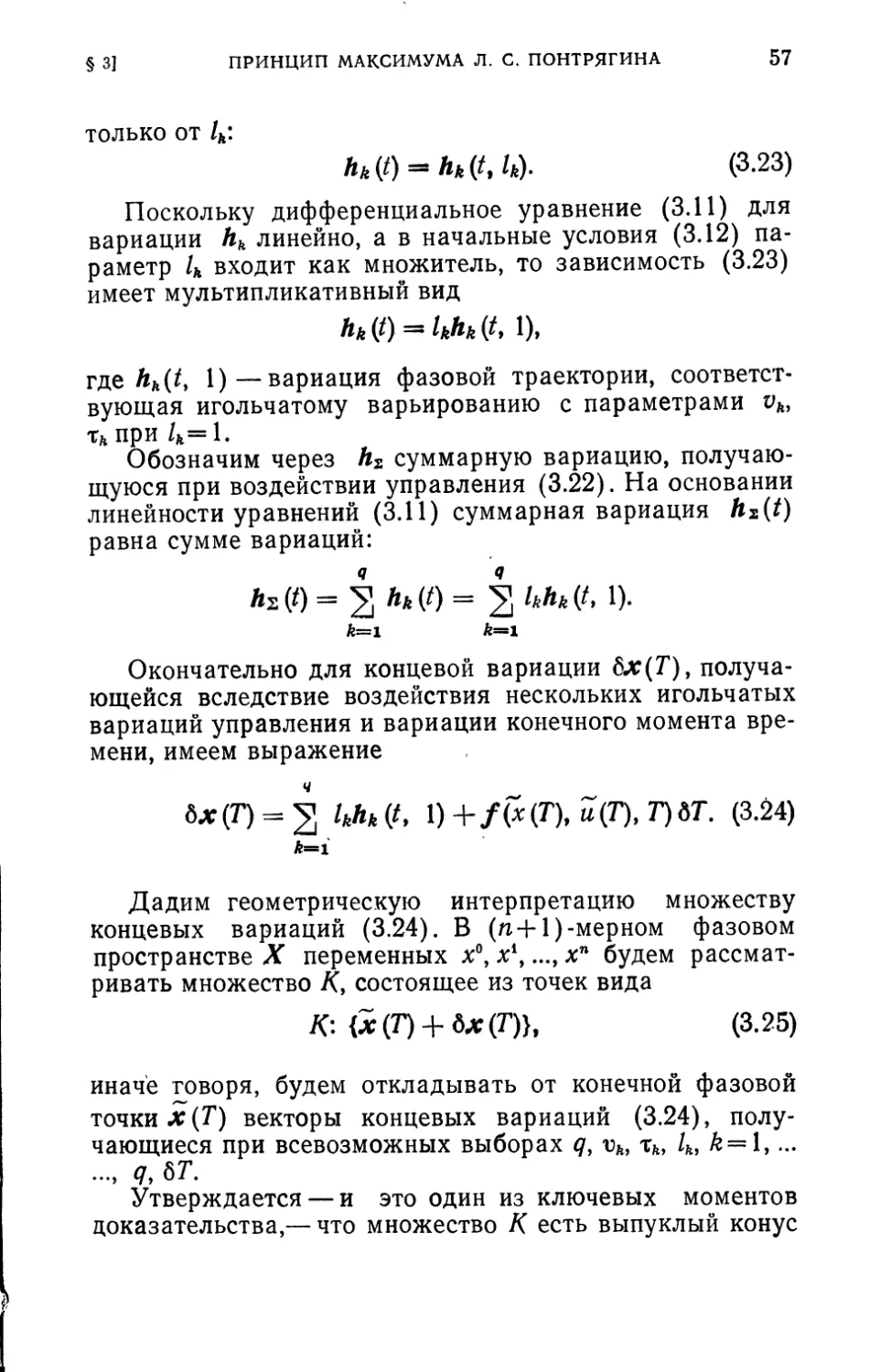

отрезке [хь х?] (рис. 3.1). Если минимум достигается в

Рис. 3.1.

граничной точке или х2, то в этом случае имеет место

необходимое условие, требующее лишь неотрицатель-

ности линейной части приращения функции

ср' (х) dx > 0.

Так же обстоит дело и в том случае, когда мы имеем

функционал J (х, и), а область допустимых значений

управления Gu замкнута. Если х, и реализуют минимум

J (х, и), то необходимо, чтобы вариация функционала

была неотрицательна

6 J (х», и, 8х, бы) > 0

для любых допустимых вариаций бх, бы.

Примечание. Заметим, что в некоторых случаях

задачу Л. С. Понтрягина можно свести к задаче, рассмот-

ренной в предыдущем параграфе. Например, если управ-

ление и — скалярная величина, удовлетворяющая нера-

венству

|ы|< 1,

то можно либо произвести замену

и = sin а,

§ 3]

ПРИНЦИП МАКСИМУМА Л. С. ПОНТРЯГИНА

49

либо дополнить число управлений новой переменной р,

определяемой условием Валентайна

P’ + (u+l)(u-l) = 0.

При этом на а в первом случае и на р во втором — не на-

кладывается ограничений типа неравенств. Далее, рас-

сматривая участки непрерывности управлений, можно,

используя технику предыдущего параграфа и принцип

Вейерштрасса, получить результаты, аналогичные прин-

ципу максимума.

Л. С. Понтрягин предложил иной путь решения постав-

ленной задачи, позволивший получить более сильные

и общие результаты, спра-

ведливые для любых

замкнутых областей уп-

равления, в частности,

для тех, которые нельзя

«раскрыть» с помощью

искусственных приемов

рассмотренного типа.

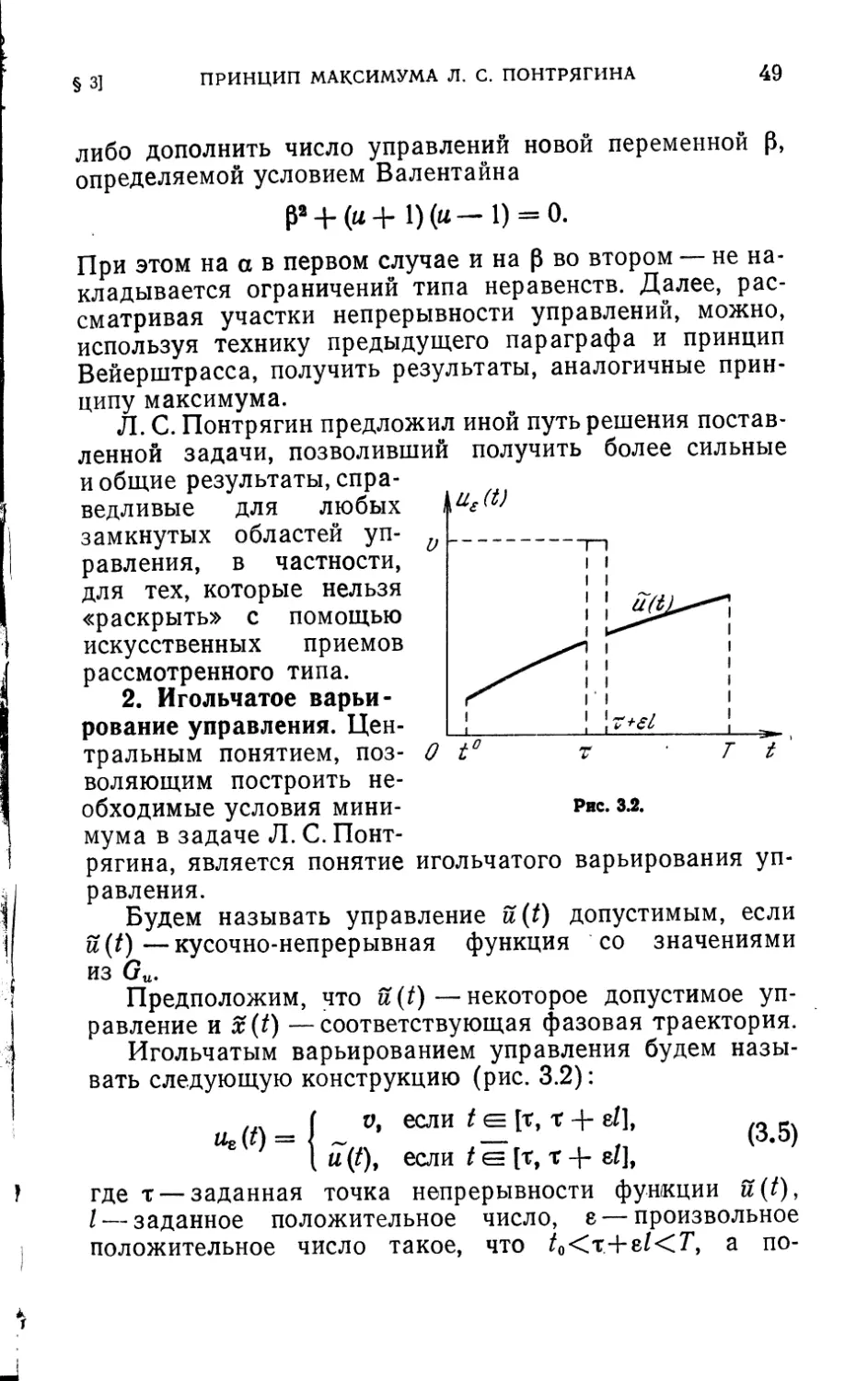

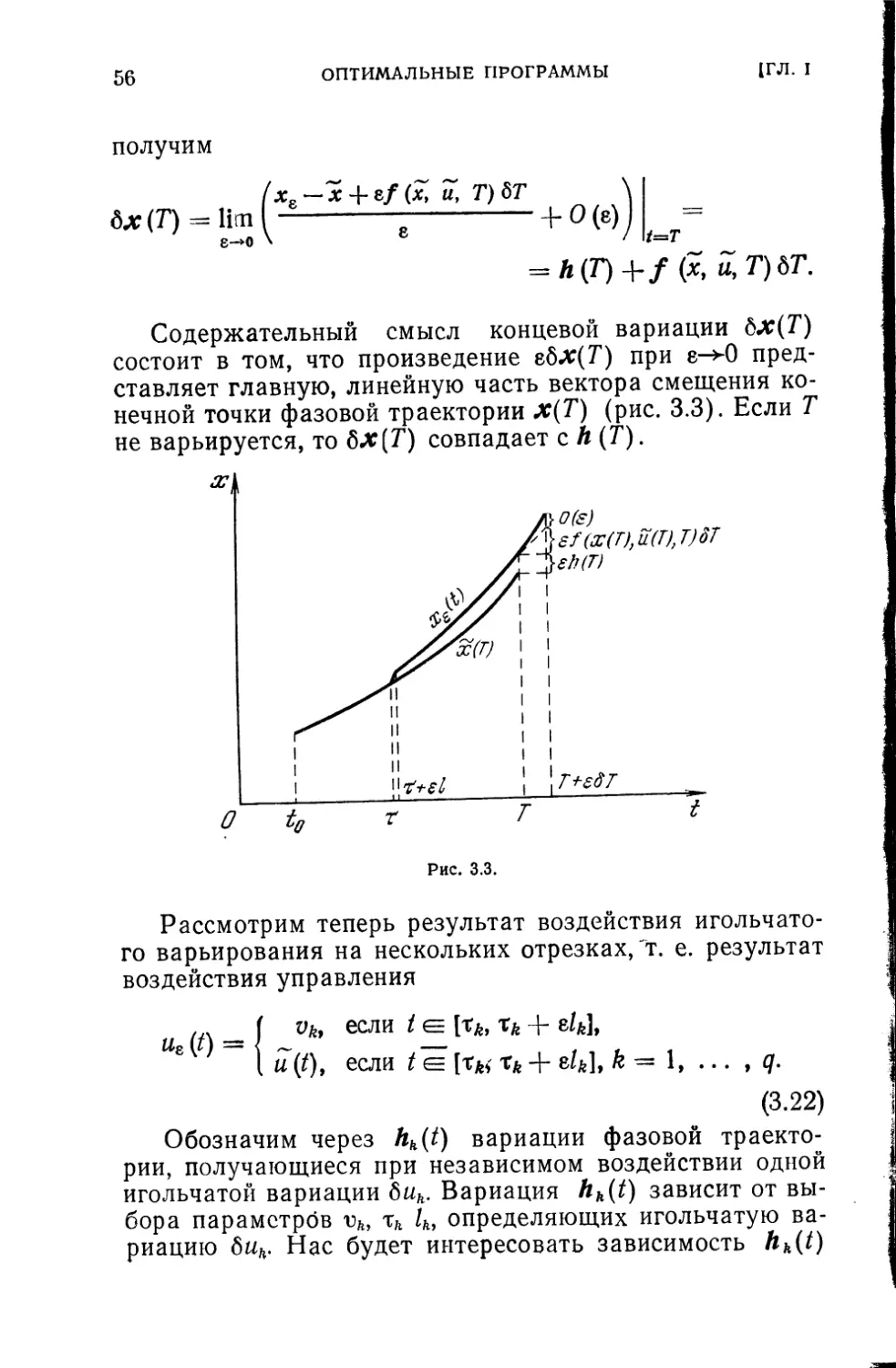

2. Игольчатое варьи-

рование управления. Цен-

тральным понятием, поз-

воляющим построить не-

обходимые условия мини-

мума в задаче Л. С. Понт-

рягина, является понятие игольчатого варьирования уп-

равления.

Будем называть управление u(t) допустимым, если

u(t)—кусочно-непрерывная функция со значениями

из Gu.

Предположим, что u(t)—некоторое допустимое уп-

равление и x(t) —соответствующая фазовая траектория.

Игольчатым варьированием управления будем назы-

вать следующую конструкцию (рис. 3.2):

если[г. г+ «/1, (3.5)

( и (Z), если t е [т, т 4- eZ],

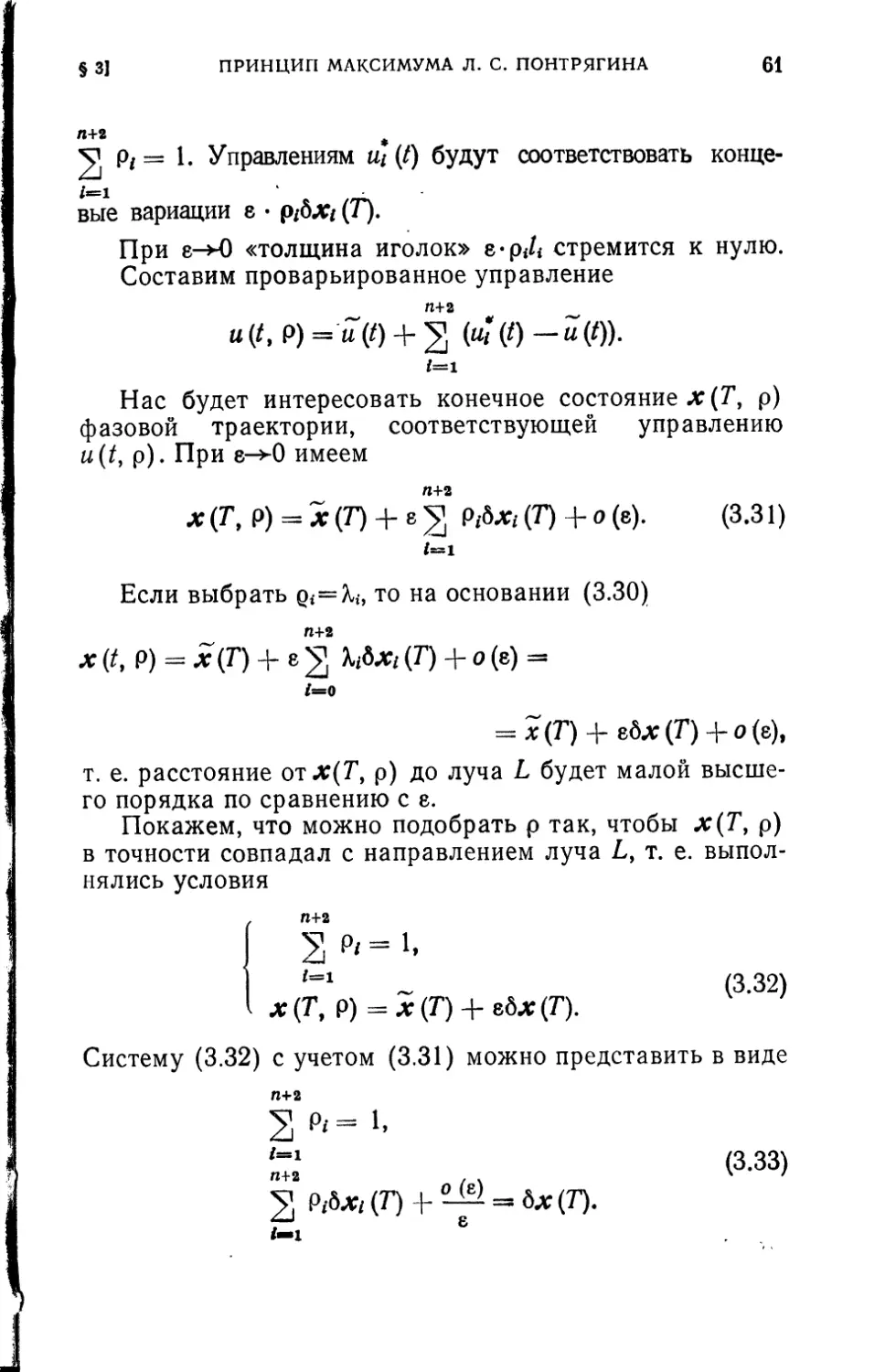

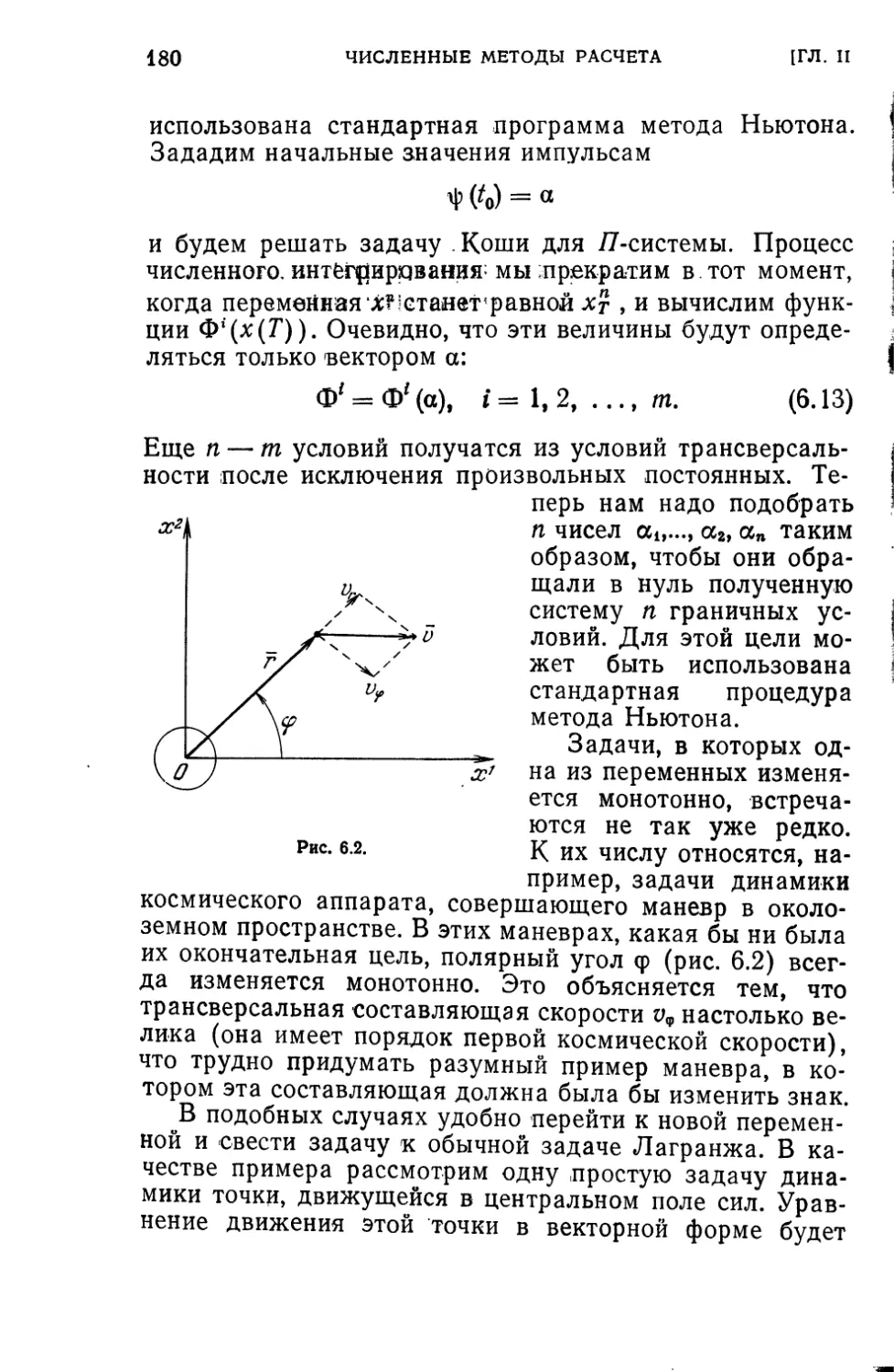

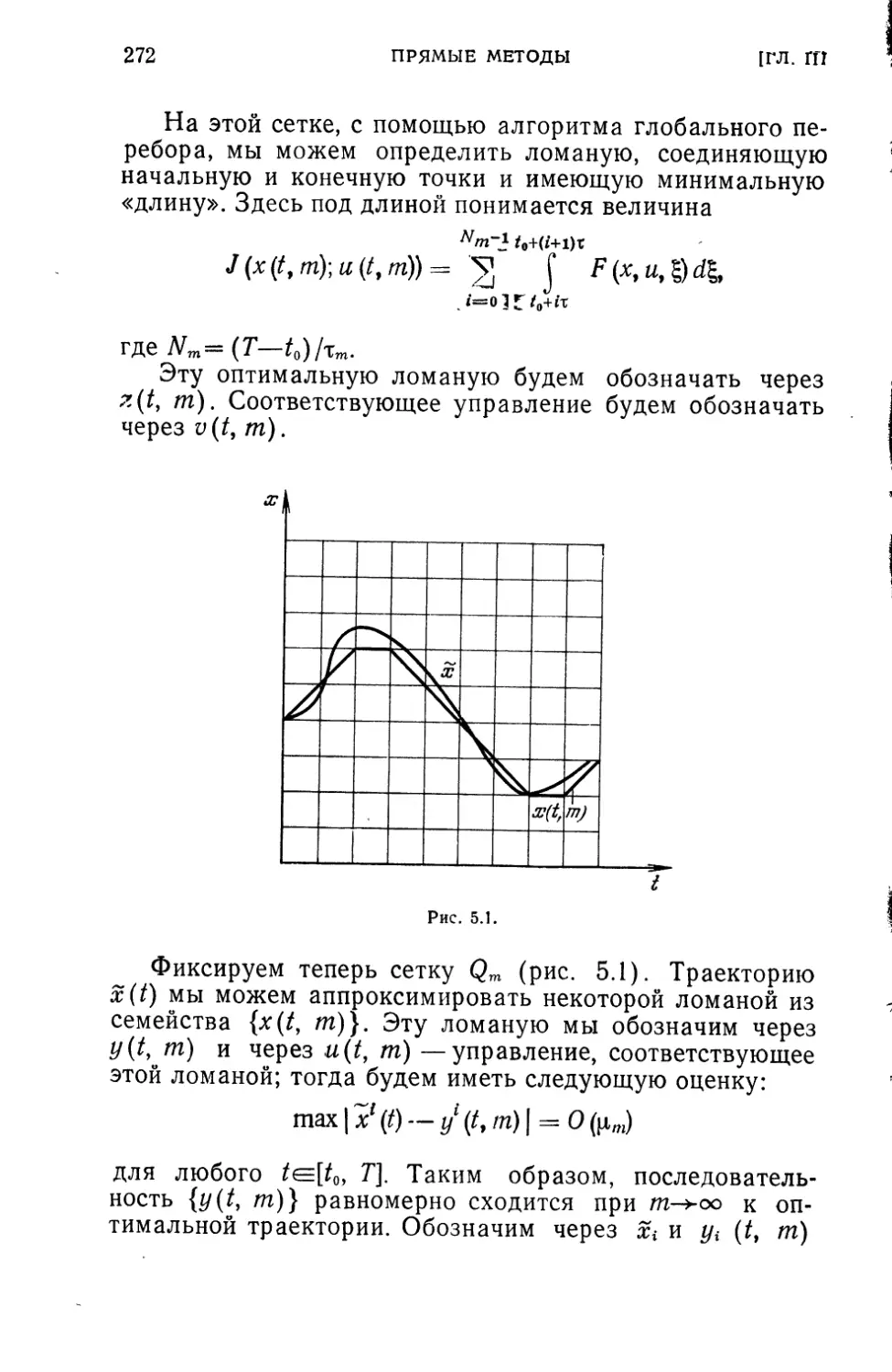

где т — заданная точка непрерывности функции u(t),