Text

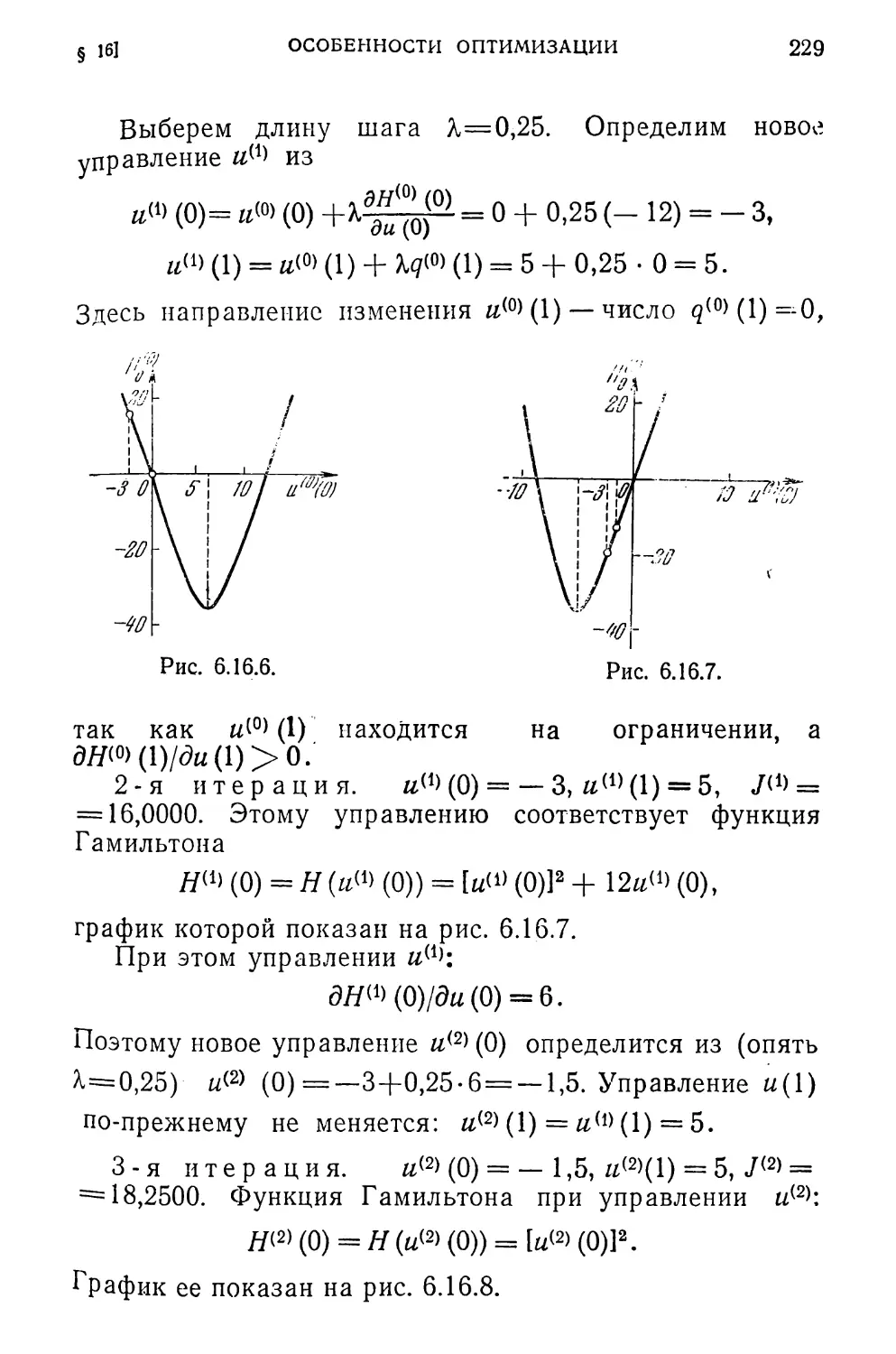

ОПТИМИЗАЦИЯ

И ИССЛЕДОВАНИЕ

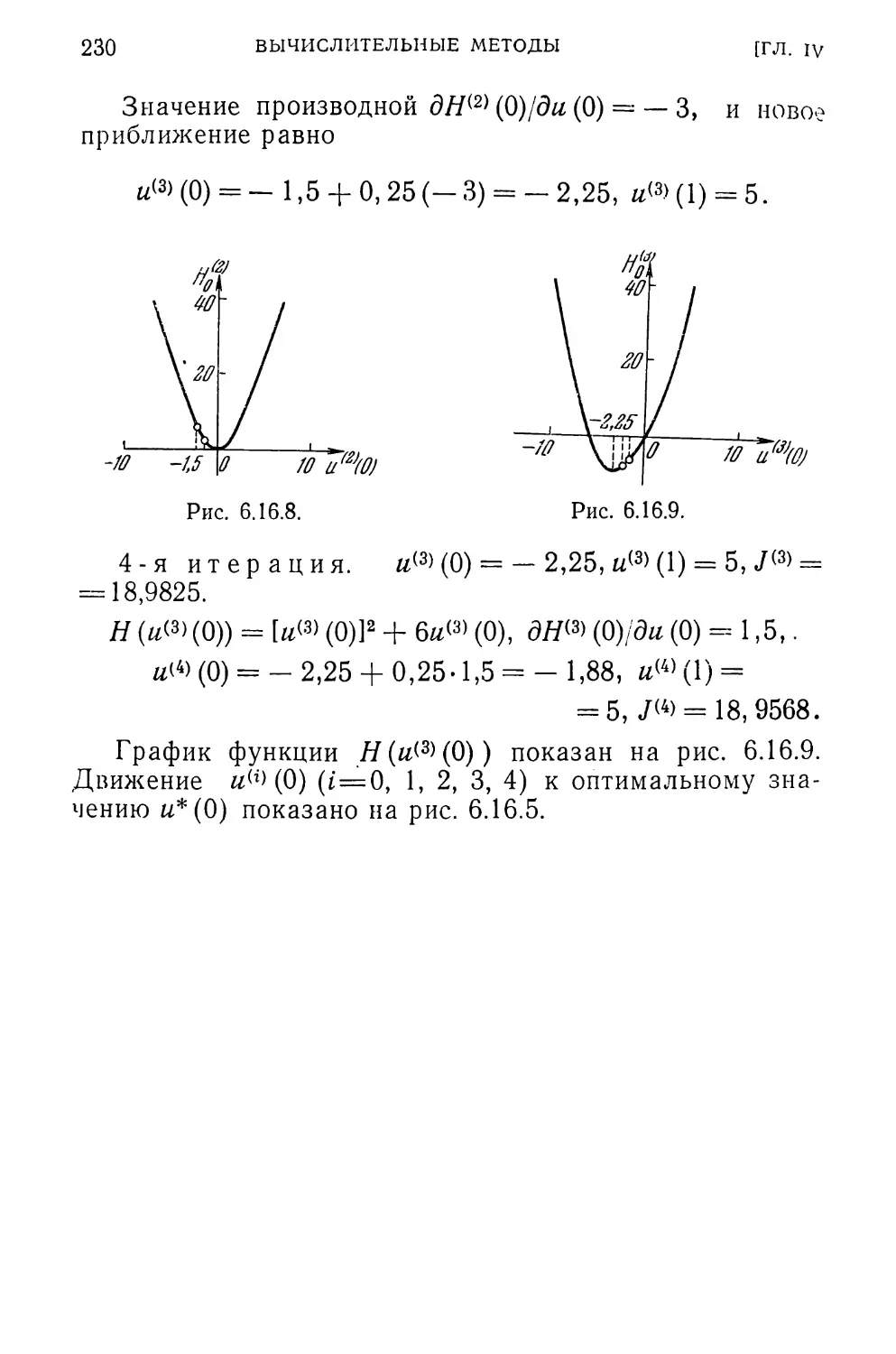

ОПЕРАЦИЙ

А. И. ПРОПОЙ

Элементы теории

оптимальных

дискретных

процессов

к

ОПТИМИЗАЦИЯ

И ИССЛЕДОВАНИЕ

ОПЕРАЦИЙ

Редактор серии

Н. Н. МОИСЕЕВ

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1973

А. И. ПРОПОЙ

ЭЛЕМЕНТЫ ТЕОРИИ

ОПТИМАЛЬНЫХ

ДИСКРЕТНЫХ

ПРОЦЕССОВ

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1973

517.8

П 81

УДК 519.95

Элементы теории оптимальных дис-

кретных процессов. А. И. Пропой.

Главная редакция физико-математиче-

ской литературы изд-ва «Наука», 1973,

стр. 256.

Задачи оптимального управления дискретными

системами возникают при текущем и перспектив-

ном планировании экономики, оптимизации слож-

ных технологических систем, в различных вопросах

организации производства и исследования опера-

ций, при управлении непрерывными процессами

с помощью цифровых вычислительных машин. До

последнего времени к таким задачам был известен

только один подход, связанный с динамическим

программированием Р. Веллмана.

В настоящей книге развивается другой под-

ход, связанный с аппаратом принципа максимума

Л. С. Понтрягина и нелинейным программирова-

нием. Рассмотрены условия оптимальности, соотно-

шения двойственности и вычислительные методы.

Исследуется связь между условиями оптимальнос-

ти для дискретных и непрерывных систем.

Библ.— 224. Илл.— 21.

П

0223—1722 „„

О 42(02)-73 67’73

ОГЛАВЛЕНИЕ

Предисловие

Глава I. Постановка задачи

§ 1. Примеры задач дискретного управления

§ 2. Общая постановка задачи

§ 3. Типы задачи.....................

§ 4. Множества достижимости

§ 5. Линейные системы ....

§ 6. Существование оптимального управления

7

11

11

16

21

27

29

31

Глава II. Одиошаговая задача оптимизации . •

§ 1. Некоторые сведения из n-мерной геометрии и тео-

рии выпуклых множеств................................. 34

§ 2. Постановка задачи........................................... • 3°

§ 3. Конусы допустимых вариаций.................

§ 4. Условия оптимальности. I...................................................................... 44

§ 5. Принцип максимума........................... ™

§ 6. Условия одноэкстремальности .... 4°

§ 7. Двойственность ............................................................. 4°

§ 8. Функция Лагранжа ................................... 30

§ 9. Седловая точка и оптимальность ... 56

§ 10. Условия оптимальности. II. Теорема Куна—Таккера 57

§ 11. Вычислительные методы. Классификация . . 59

§ 12. Оценка приближения......................................... 6Q

§ 13. Методы возможных направлений .... 63

§ 14. Ограничения в виде равенств................................ 67

§ 15. Двойственные методы ...... 68

§ 16. Методы одновременного решения прямой и двой-

ственной задач................................................................................ 73

"лава III. Условия оптимальности....................................................................... 76

§ 1. Сопряженная система............................................................................ 76

§ 2. Задача оптимизации конечного состояния . . 79

§ 3. Доказательство теоремы 2.1..................................................................... 82

§ 4. Вырожденный случай............................................................................. 89

§ 5. Задача с суммарным показателем качества . . 91

§ 6. Задача с ограничениями на переменные состояния 92

Л Принцип максимума........................................................................... 99

§ 1. Функция Гамильтона на оптимальном управлении . 99

§ 2. Задача оптимизации конечного состояния . . 102

§ 3. Задача с суммарным показателем качества . . 104

| 4- Принцип квазимаксимума........................................................................ 106

§ 5. Условия одноэкстремальности . . . , . 112

§ 6. Линейные системы.............................................................................. 115

ОГЛАВЛЕНИЕ

Глава V. Двойственность в управлении ....

§ 1. Двойственные задачи управления

§ 2. Соотношения двойственности . . . .

§ 3. Седловая точка и оптимальность . . . .

§ 4. Задача с суммарным показателем качества

§ 5. Достаточные условия оптимальности

§ 6. Двойственная задача управления . . . .

§ 7. Учет ограничений.........................

§ 8. Условия оптимальности для задачи с ограниче-

ниями на переменные состояния ....................

§ 9. Принцип максимума для задачи с ограничениями

на переменные состояния...........................

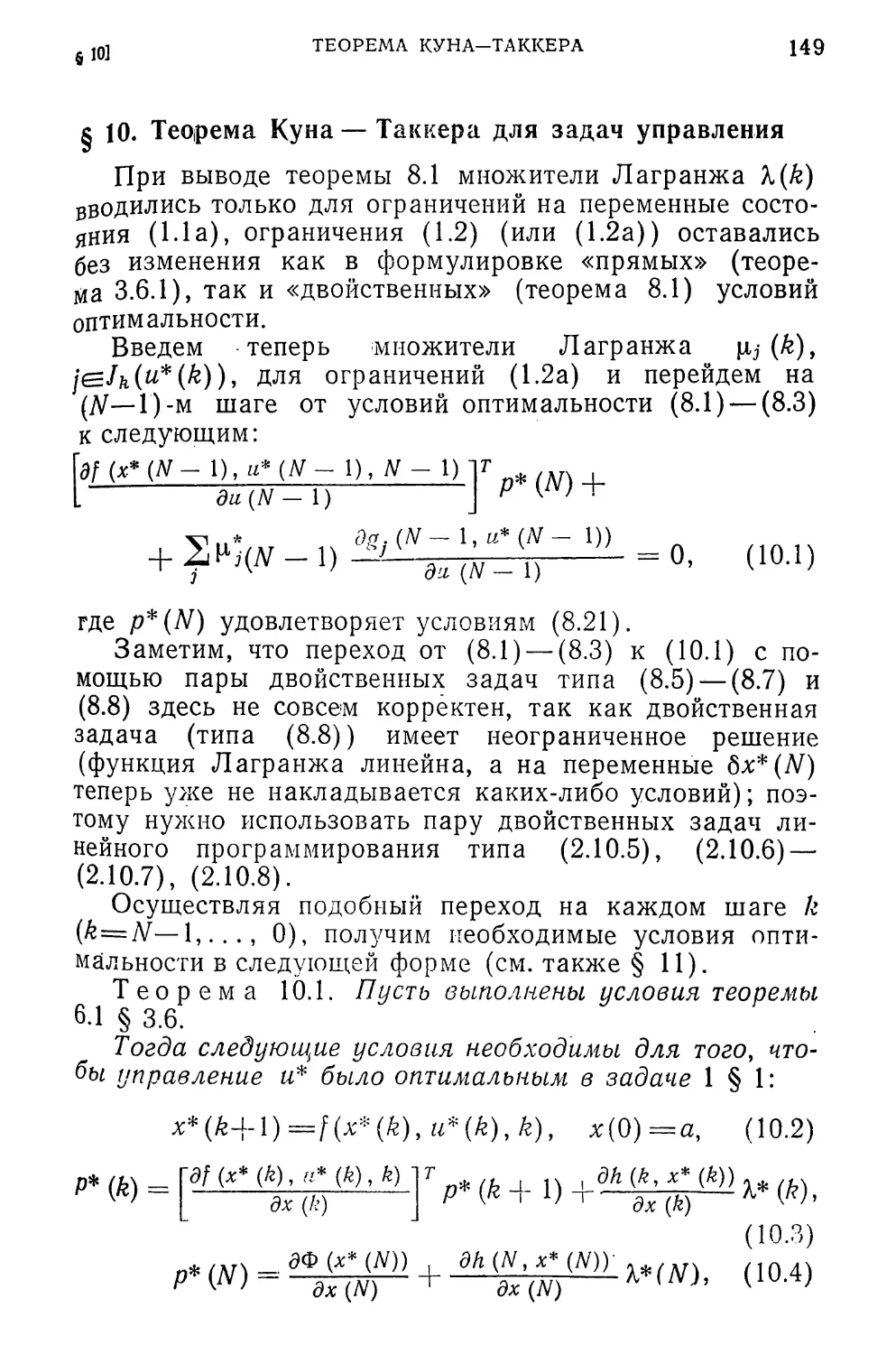

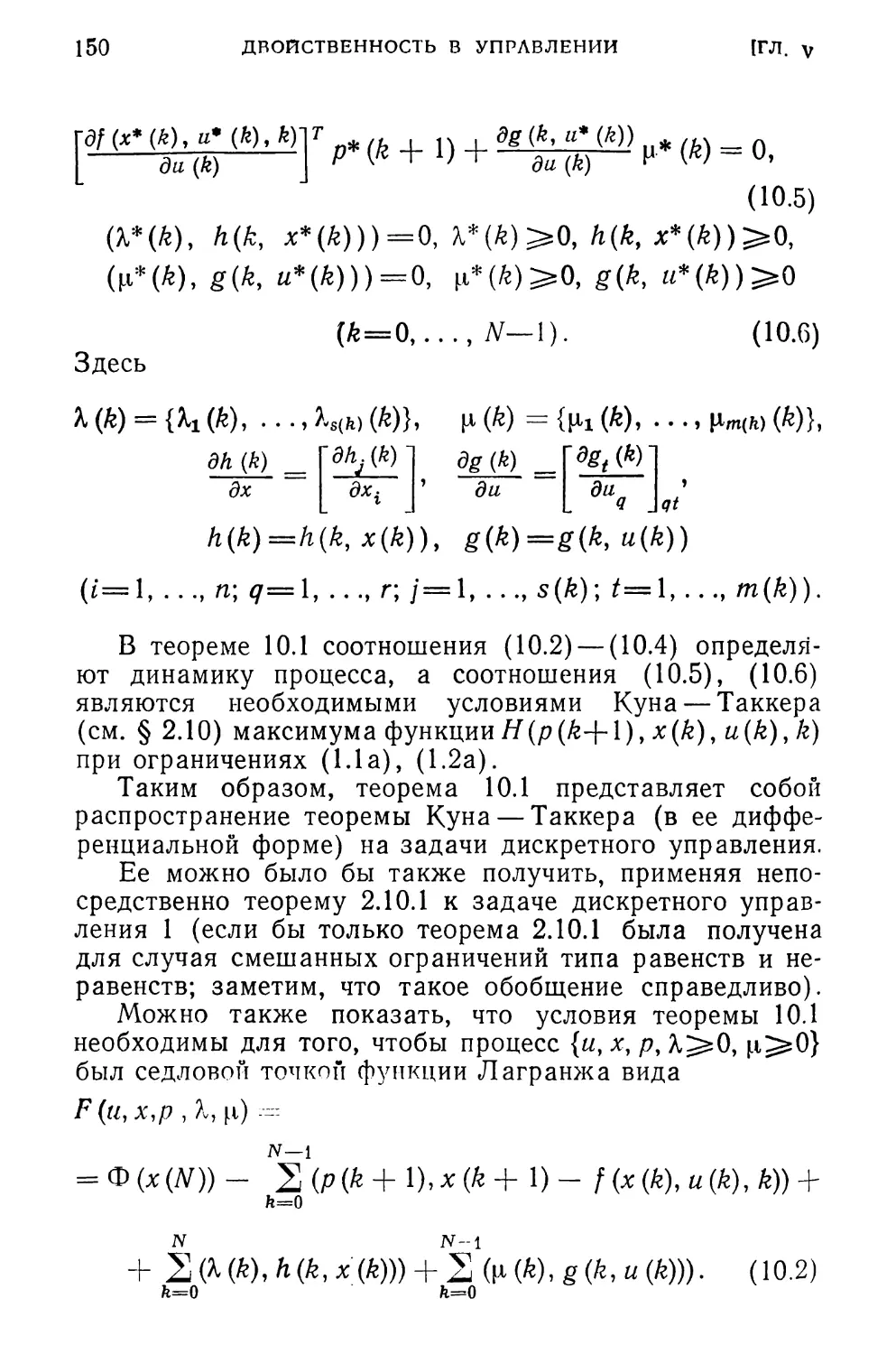

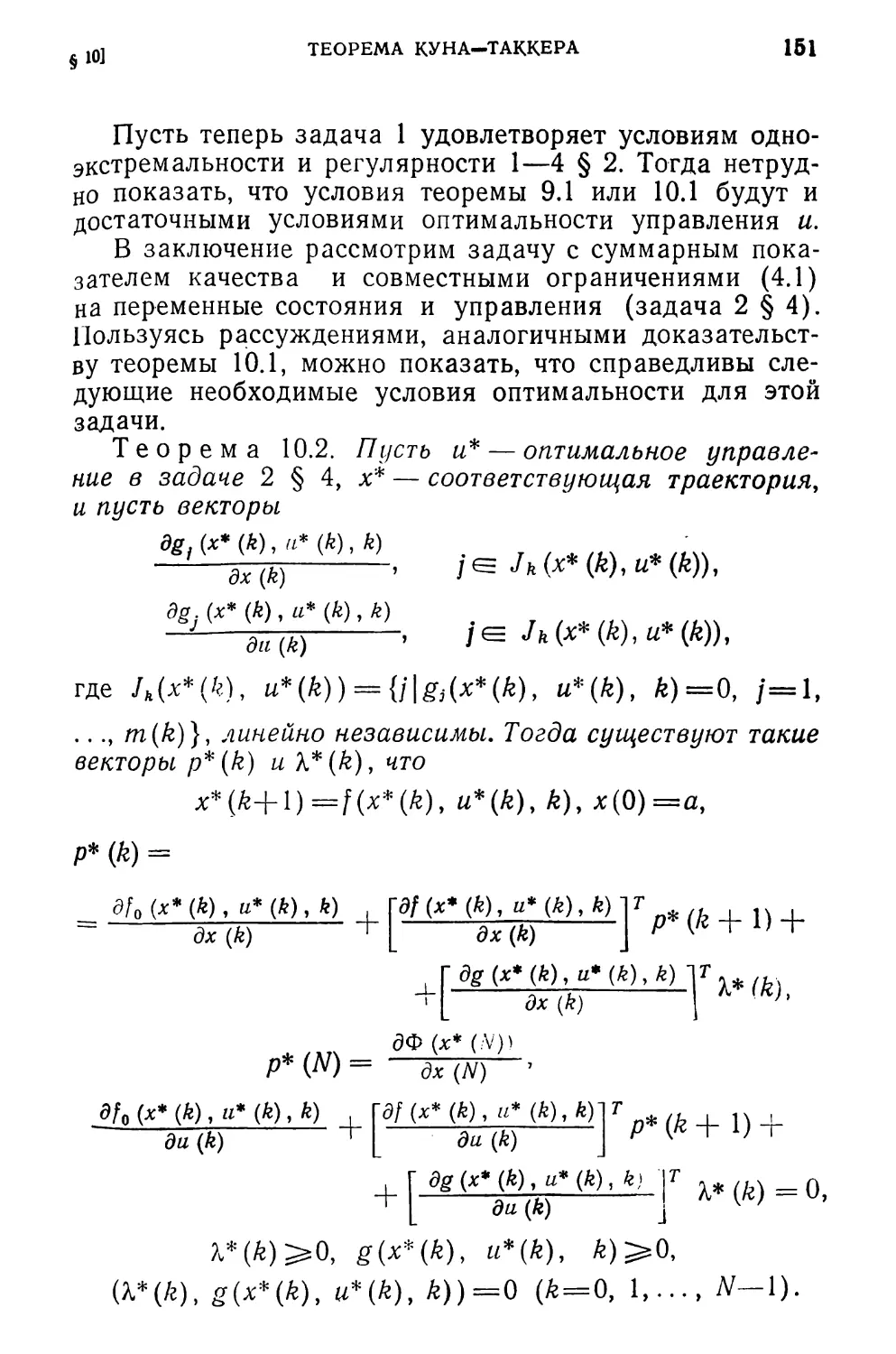

§ 10. Теорема Куна — Таккера для задач управления

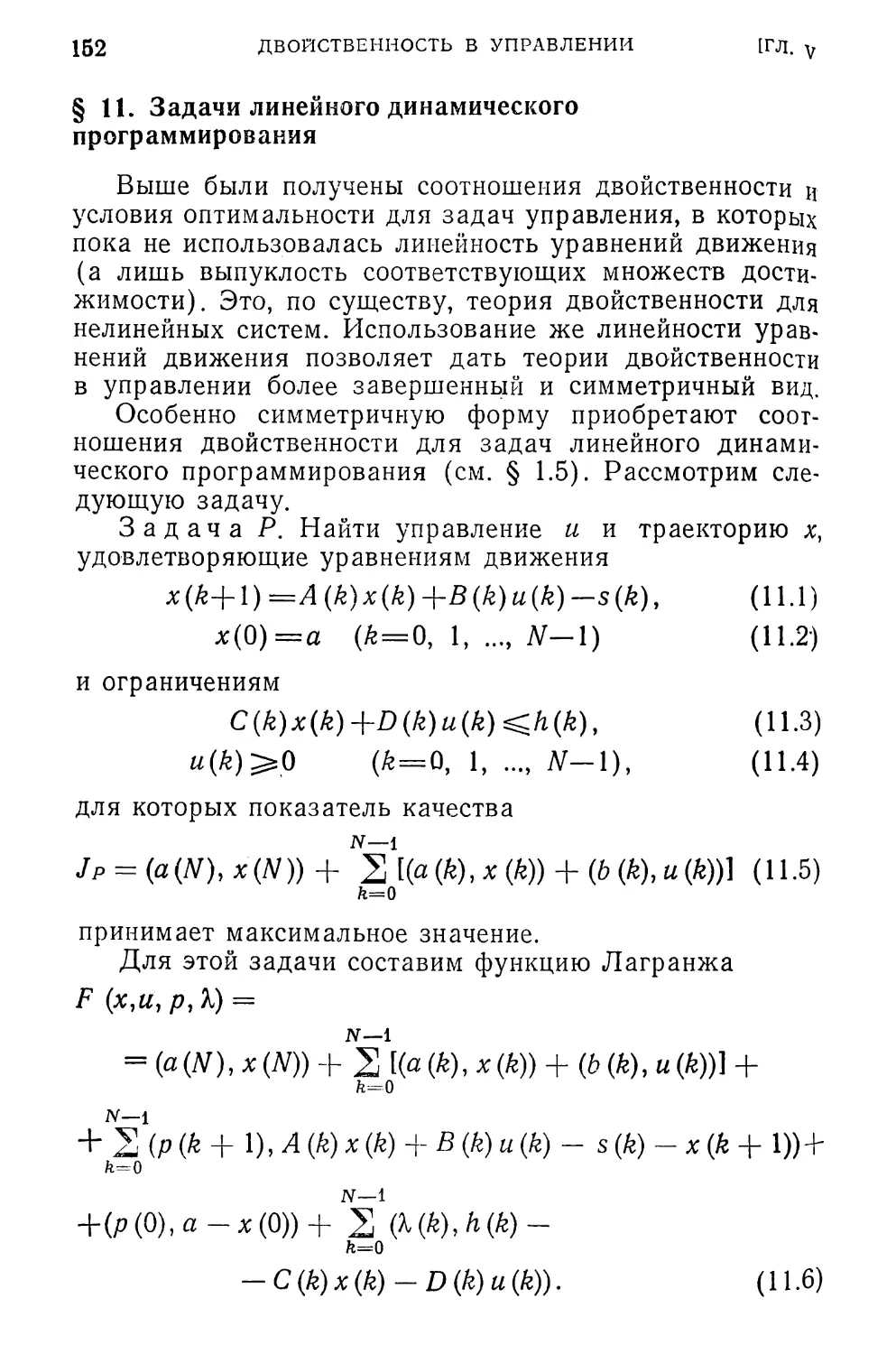

§ 11. Задачи линейного динамического программирова-

ния ..............................................

§ 12. Задачи квадратичного динамического программи-

рования .........................................

Глава VI. Вычислительные методы......................

§ 1. Оценка приближения.......................

§ 2. Методы возможных направлений .

§ 3. Случай отсутствия ограничений на переменные со-

стояния ..........................................

§ 4. Линейная система.........................

§ 5. Ограничения на переменные состояния. I . ’ .

§ 6. Линейная система.........................

§ 7. Ограничения в виде равенств ....

§ 8. Метод штрафных функций ....

§ 9. Двойственные методы....................

§ 10. Линейная система.......................

§ 11. Приближение по граничным условиям

§ 12. Ограничения на переменные состояния. II

§ 13. Приближение в пространстве управлений .

§ 14. Обсуждение методов.....................

§ 15. Системы с запаздыванием ....

§ 16. Особенности оптимизации дискретных систем

Комментарии.......................... . .

Литература

Предметный указатель

119

119

123

130

132

134

135

138

142

148

149

152

160

164

165

168

171

181

184

190

193

198

201

204

205

209

211

214

216

222

231

241

254

ПРЕДИСЛОВИЕ

Дискретные процессы управления приобретают все

большее значение в теории и практике оптимального уп-

равления. Это связано с тем, что многие задачи эконо-

мического планирования, технологии и организации

производства, исследования операций, военного дела

описываются разностными уравнениями, так как на прак-

тике чаще всего и информация о состоянии процесса,

и управление процессом осуществляются в дискретные

моменты времени, т. е. по шагам.

Для решения таких многошаговых задач возможны два

подхода.

Первый основан на принципе оптимальности Р. Велл-

мана и приводит к необходимости решать функциональ-

ные уравнения специального вида. Достоинства и воз-

можности динамического программирования, развитого

на основе этого подхода, хорошо известны, и он доста-

точно полно отражен в литературе.

Второй — вариационный — подход основан на распро-

странении идей и методов математического программиро-

вания на многошаговые задачи и смыкается с аппаратом

принципа максимума Л. С. Понтрягина, развитого для

решения задач оптимального непрерывного управления.

Этот подход иногда называют «дискретный принцип мак-

симума» (где слово «дискретный» относится, конечно,

не к принципу).

Математическое программирование связано с задача-

ми эффективного использования и распределения ограни-

ченных ресурсов, которые сводятся к нахождению экс-

тремумов функций многих переменных при ограничениях

8

ПРЕДИСЛОВИЕ

в виде равенств и неравенств. В математическом про-

граммировании созданы эффективные вычислительные

методы, позволяющие решать экстремальные задачи с

большим числом переменных и ограничений на них. В осо-

бенности это относится к задачам линейного программи-

рования, которое нашло широкое применение и оказало

сильное воздействие на другие разделы теории матема-

тического программирования.

Как для самой теории математического программиро-

вания, так и для основного круга ее приложений ха-

рактерен одноразовый, одношаговый выбор оптимального

решения (распределение программы выпуска нужной

продукции между несколькими производственными участ-

ками, определение наилучшего плана перевозок, выбор

оптимального варианта технологии, расчет различного

рода сетей, планирование размещения промышленных

предприятий, распределение средств поражения по целям

и т. п.). Такие задачи являются статистическими задача-

ми оптимизации.

Однако как только возникает вопрос о развитии си-

стемы (и не только во времени, но и в пространстве),

об управлении системой, одношаговое решение становит-

ся непригодным. В этом случае решение должно быть при-

нято на определенное число шагов вперед, и задача оп-

тимизации становится многошаговой, динамической.

К задачам такого рода относятся задачи перспективного

и оперативного планирования, составления программ

развития различных систем, задачи планирования боевых

операций, расчет многоступенчатых технологических

комплексов и т. п. Примеры некоторых таких задач при-

ведены в главе I этой книги.

С изменением характера задачи мяняется и ее про-

блематика. Если для одношаговой задачи основное значе-

ние имело нахождение оптимального решения, то для

многошаговой задачи наряду с определением самой про-

ПРЕДИСЛОВИЕ

9

граммы оптимального развития системы не меньшее зна-

чение имеет и ее практическая реализация, т. е. собствен-

но задача управления.

Таким образом, теория многошаговых задач оптими-

зации должна базироваться как на теории математиче-

ского программирования, так и на теории оптимального

управления.

Конечно, любая многошаговая задача может рассмат-

риваться и как статистическая, а для ее решения возмож-

но привлечение методов математического программирова-

ния. Однако непосредственное применение этих методов

для решения многошаговых задач обычно не приводит к

цели: получающиеся при этом задачи линейного или не-

линейного программирования часто имеют настолько боль-

шой размер, что их невозможно решить даже с помощью

современной вычислительной техники. Поэтому здесь нуж-

на разработка специальных методов, учитывающих дина-

мический характер этих задач.

Второму подходу и посвящена настоящая книга. Она

состоит из шести глав. Содержание их ясно из оглавле-

ния. Подробное и детальное изложение всех методов тео-

рии управления дискретными процессами не входило в

задачи и возможности этой книги, ее цель состояла в рас-

смотрении лишь основных идей и методов.

Книга предназначена для всех тех, кому приходится

сталкиваться с методами оптимизации, как в теоретиче-

ском, так и в прикладном плане. Для ее чтения достато-

чно знания математики в объеме втуза. Специальных зна-

ний по математическому программированию и теории оп-

тимального управления не требуется (они сообщаются по

ходу изложения), хотя некоторая предварительная ори-

ентация в этих вопросах была бы полезна.

В самом тексте ссылки на литературу даны самые не-

обходимые, в конце книги приведена сравнительно под-

робная библиография по теории дискретного управления

10

ПРЕДИСЛОВИЕ

и смежным вопросам, а также комментарии к ней и основ-

ному тексту книги.

В книге принята отдельная нумерация формул, теорем,

рисунков для каждого параграфа. При ссылках внутри

главы указывается номер параграфа и номер формулы,

теоремы, рисунка и т. п., при ссылках на результаты

других глав к этим числам добавляется слева номер со-

ответствующей главы.

Эта книга написана на основе моей диссертации по

применению методов математического программирования

в дискретном управлении. Пользуюсь случаем, чтобы вы-

разить благодарность профессору Я. 3. Цыпкину за

постоянное внимание и поддержку этой работы.

Считаю своим приятным долгом выразить признатель-

ность члену-корреспонденту АН СССР Н. Н. Моисееву за

приглашение прочесть лекции по теории дискретного упра-

вления во Второй Всесоюзной школе по методам оптими-

зации (г. Шемаха, 6—26 июня 1967 г.) и инициативу на-

писания этой книги.

Наконец, я приношу сердечную признательность

В. М. Тихомирову и А. Д. Иоффе за критические заме-

чания и дружеское участие, способствовавшие усовер-

шенствованию книги.

А. Пропой

ГЛАВА 1

ПОСТАНОВКА ЗАДАЧИ

§ 1. Примеры задач дискретного управления

Прежде чем поставить задачу в общем виде, рассмот-

рим несколько простых примеров, с тем, чтобы, не вда-

ваясь в детали, можно было бы представить специфику

некоторых типичных задач оптимального дискретного

управления.

1. Задача перспективного планирования. Рассмотрим

производство, в котором участвуют п ингредиентов (раз-

личные виды производственных факторов, сырья, про-

межуточных и конечных продуктов). Имеется т техноло-

гических способов организации этого производства. Каж-

дый из этих способов в момент времени k (&=0,..., N—1)

(£, например, месяц, квартал, год) характеризуется век-

тором {&и(&),..., bnj(k)}. Причем, если Ьг-Д^)<0, то

величина Ьц(к) определяет затраты f-ro ингредиента при

j-м способе производства в период А; если Ьц(к)>0, то

bij(k) определяет выпуск f-ro ингредиента при /-м спо-

собе. Обозначим через uj(fe) интенсивность использова-

ния /-го технологического способа в период k, через Si(k)

(i=l,..., n) —величину спроса на продукцию, выпускае-

мую в этом периоде.

Будем предполагать, что мощности производства тако-

вы, что они могут удовлетворить возникающий спрос,

т. е. всегда

т

2 bi, (k) tij (/г)—st (/?) >o (t = i,.... ti).

3=1

Обозначим через Х/(/г+1) количество продукции, образо-

вавшееся на складе к концу периода &-}-1 (запасы в пе-

риод &+1). Эта величина складывается из запасов пре-

дыдущего периода Xi(k) и образовавшихся излишков в

этот период:

х{(^ + 1) = х.(^+ (i-l,...,«)

=1

12

ПОСТАНОВКА ЗАДАЧИ

[ГЛ, I

или в векторной форме

x(k + 1) = x(k) +B(k)u(k) - s(k) (k = 0,...,N -1). (1.1)

Матрица B(k) обычно называется «технологической

матрицей».

Вообще говоря, если в начале периода & + I на складе

имелись запасы в количестве x(k), то к концу этого пе-

риода для продажи будет годна только часть, равная

A(k’)x(k), где Л(£)==[аи(£)] (i=l,..., п)—диагональ-

ная матрица, характеризующая «старение» продукции

за период. В этом случае уравнение, описывающее про-

цесс, будет

х (k + 1) = А (Л) х (k) + B(k)u (k) - s (k) (1.2)

(6 = 0,...,AT-1).

Обозначим через g(u(k),k) издержки от использова-

ния технологических способов с интенсивностями. u(k),

через f(x(fe), k) —затраты за хранение готовой продукции

на складе в количестве x(k). Тогда общие издержки про-

изводства за период планирования определяются суммой

N—1

^[f(x(k),k) + g(u(k),k)]. (1.3)

fe=0

Часто эти затраты можно представить в виде линейных

функций

N—1

j= [(а</г),х(й)) + (&(/г), «(Лг))]. (1.4)

ь=о

Таким образом, требуется найти такой план (последо-

вательность интенсивностей {«(0),..., u(N—1)}),при ко-

тором общие затраты (1.3) (или (1.4)), определяемые из

уравнений (1.2) (или (1.1)), минимальны. При этом

начальные запасы х(0) считаются заданными,в после-

дующие периоды должно быть х(6)^0 (6=1,..., N),

а значения векторов интенсивностей лежат в некоторой

допустимой области: u(k)^Uk (определяющей, напри-

мер, ограничения на мощности производства).

Заметим, что A(k), B(k), s(k), Uh, a(k) и b(k) долж-

ны быть известны заранее (например, строиться, исходя

из технических и экономических прогнозов).

§ 1]

ПРИМЕРЫ ЗАДАЧ

13

2. Задача оптимального управления запасами. Говоря

инженерным языком, задача состоит в создании системы,

оптимально следящей за спросом или за заранее опреде-

ленным для этой системы планом производства.

Рассмотрим, например, работу какого-то производ-

ственного объединения или фирмы. Пусть xk(k) =

= {xi(k),...,xn(k)}—вектор количества п видовтоваров

выпускаемых этой фирмой, имеющихся в наличии на скла-

де к концу k-ro периода, В (k) — технологическая мат-

рица — Urik)}—вектор интенсивностей

(скорость производства), s(k) — {$i(k),..., sn(k)}—век-

тор количества товаров, поставленных со склада в k-й

период. Тогда так же, как и в примере 1 § 1, уравнение,

описывающее процесс, будет иметь вид

x(k+1) =x(k) +B(k)u(k) —s(k).

Обозначим через x*(k) вектор количества товаров,

который желательно иметь к концу k-ro периода; напри-

мер, x*(k) может определяться спросом на эти товары,

либо просто быть планом производства. Ясно, что работа

системы будет тем лучше, чем ближе вектор x(k) к векто-

ру x*(k) в каждый период. С другой стороны, слишком

точное слежение за «спросом» x*(k) нежелательно, так

как оно вызвало бы чрезмерно резкие и частые, а потому

дорогие перестройки производственного процесса. Поэто-

му естественно определить качество работы системы за

плановый период N, например, величиной

N n N-1

J= s s «i (k) [х{ (k) - Xl (£)]2 + 2 Ф (« (k), k) .

k=l i=l fc=0

Здесь ai(k) >0, функция <p(u(A), k) определяет затра-

ты на производство в k-й период. Кроме того, необходи-

мо учитывать ограничения на переменные x(k) и u(k),

например, вида

Xi(k)>Q, 0<u3(^XPi(A) (i=l ,..., п; /=1 ,...,r).

3. Оптимальный расчет химических реакторов. Выше

были рассмотрены задачи управления, в которых дискрет-

ность возникает из-за того, что либо получение информа-

ции об объекте, либо подача управляющих воздействий на

объект происходит в дискретные моменты времени. Суще-

14

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. I

ствует еще большая группа задач, одна из которых будет

здесь рассмотрена, где дискретность возникает из-за

многоступенчатости процесса в пространстве. К таким

задачам относятся, например, задача об оптимальном

конструировании многоступенчатой ракеты, задачи рас-

чета химических реакторов и т. п.

Приведем простейшую задачу такого рода. Рассмот-

рим N химических реакторов с одним видом продукта,

соединенных между собой последовательно. Пусть х(£) —

концентрация продукта на входе А-го реактора, x(k+1) —

концентрация на его выходе. Эти концентрации связаны

между собой известной зависимостью (она может быть

определена либо из теоретических соображений, либо пу-

тем моделирования данной реакции на вычислительной

машине)

x(k+l) =f(x(fe), u(k), k) (fe=0,..., N — 1), (1.5)

где u(k) = {ui(£),..., ur(k)} —вектор технологических и

расчетных параметров &-го реактора (например, темпера-

тура, объем), определяющих его характеристики.

Одна из задач, связанная с расчетом такой цепочки

реакторов, состоит в том, чтобы выбрать такие значения

параметров u(k) каждого реактора, при которых выход

конечного продукта x(N) был бы максимальным. При

этом начальная концентрация х(0) считается заданной.

Другая задача состоит в том, чтобы при заданной

конечной концентрации x(N) затраты на постройку такой

последовательности реакторов были бы минимальными.

Предполагается, что эти затраты являются известной

функцией параметров каждого реактора, т. е. в этом

случае нужно минимизировать сумму

N—1

к=0

4. Транспортная задача. Часто не только динамиче-

ские, но и статистические по самой природе задачи удоб-

но представлять в виде многошагового процесса. Для

примера рассмотрим нелинейную транспортную задачу.

Имеется т пунктов производства некоторого продукта.

Объем производства f-го пункта равен сц. Весь произве-

денный продукт потребляется в п пунктах спроса. Объем

потребления /-го пункта равен

§ И

ПРИМЕРЫ ЗАДАЧ

15

Пусть Uij — количество единиц продукта, поставлен-

ного г-м производителем /-му потребителю.

Очевидно, что

= (j = 1,..(1.6)

У=1

т

= (/=!,...,«). (1.7)

г=1

Кроме того,

^•^О, (1.8)

т. е. считаем, что продукт перевозится только из пунктов

производства в пункты потребления. Система предпола-

гается замкнутой, т. е. считается, что весь произведенный

продукт потребляется:

т п

2^=2 bi-

i=l j—1

Пусть q>ij(Uij) —расходы на перевозку продукта в ко-

личестве иц от t-го производителя к /-му потребителю.

Общие расходы выразятся суммой

т п

J = 2 S Фй‘

i=l j=i

(1-9)

Требуется составить такой план перевозок иц(1— 1,..., т\

/= 1, . .., п), удовлетворяющий ограничениям (1.6) —

(1.8), при которых общие расходы (1.9) были бы мини-

мальны.

Чтобы привести эту сугубо статическую задачу плани-

рования к «динамической», будем предполагать, что со-

ставление плана перевозок потребителям осуществляется

по шагам, начиная с первого и кончая n-м (например, ус-

танавливается приоритет снабжения потребителей). Вве-

дем величину

к

—- 2 и it (k — Ъ • • •, ^)>

16

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. 1

обозначающую суммарное количество единиц продукта,

перевезенных отг-го производителя к первым k потреби-

телям. Очевидно,

— %itk—-1 ^ik (А? = 1,. . ., ZZ), (1 • 10)

где Xio=O и %in = 2 ~ ai‘

>=1

Таким образом, приходим к следующей эквивалентной

формулировке задачи: найти последовательность неотри-

цательных величин {ип ,..., uin} (i= 1 ,..., т) (управ-

ление и), которые обеспечивают показателю качества

(1.9) минимальное значение в силу уравнений «движе-

ния» (1.10) с начальным хго=О и конечным Xin=at (i=

= 1, . . ., т) условиями. Кроме того, переменные иц дол-

жны удовлетворять условию (1.7).

Отметим, что такое представление статической задачи

в виде многошаговой часто позволяет предложить про-

стой и удобный способ ее решения.

§ 2. Общая постановка задачи

В предыдущем параграфе было рассмотрено несколь-

ко характерных примеров задач дискретного управления.

Из этих примеров видно, что дискретное управление мо-

жет рассматриваться как некоторый многошаговый про-

цесс. На каждом шаге k этот процесс характеризуется

двумя наборами переменных x(k) = {%i(£), ..., xn(k)} и

u(k) = {ui(k), ..., ur(k)}. Векторы x(k) определяют co-

стояние процесса на А-м шаге и называются переменны-

ми состояния либо фазовыми переменными. Например,

состоянием процесса могут быть координаты положения и

скорости ракеты, или мощности различных технологиче-

ских способов производства какого-либо продукта, или

концентрации веществ, участвующих в химической реак-

ции, и т. п. Знание вектора x(k) полностью определяет

процесс на k-м шаге.

Вектор x(k) является элементом n-мерного веществен-

ного евклидова пространства Еп, которое будем называть

пространством состояний и обозначать через X. Часто не-

обходимо учитывать ограничения на вектор состояний. На-

пример, мощность производства или концентрации веще-

ства не может быть отрицательной, скорость ракеты огра-

ОБЩАЯ ПОСТАНОВКА ЗАДАЧИ

17

§ 2]

ничена и т. д. Таким образом, в общем случае значение

вектора x(k) должно принадлежать некоторому подмно-

жеству Хк пространства состояний Еп:

x(k)<=Xk^En (k=0, 1, .... N). (2.1)

Обычно множества Хк задаются набором неравенств

ЙДх(^), Jfe)’>0 (/=1, ... ,sk-,k=Q, 1... .,N). (2.1а)

Вектор u(k) определяет управляющие воздействия на

k-м шаге; управляющие воздействия — это, например,

изменение температуры реакции, скорости производства,

тяги ракеты и т. п. Вектор u(k) может принимать значе-

ния из некоторого заданного подмножества Uk евклидо-

ва пространства Ег (пространства управляющих воз-

действий) : ;

u(k)e=Uk^Er (k=0, I, , W—1); (2.2)

в частности,

gt(u(k), (i==l,..., m*; k=0, 1,..., TV— 1). (2.2a)

Например, температура не может быть отрицательной

.(по абсолютной шкале) и не должна превышать опреде-

ленной величины (иначе оборудование быстро выйдет из

строя); скорость производства, тяга ракеты ограничены.

Для ряда задач ограничения задаются совместно на

переменные управления и состояния

gi(x(k),u(k),k)^0 (i=l,..., mh; 6=0, 1).

Например, интенсивность производства ограничена

наличными мощностями и т. п.

Значения векторов x(k) и u(k) на k-м шаге определя-

ют состояние процесса на k+ 1-м шаге:

x(£+l)=f(x(&), u(k), k) (£=0, 1,..., N— 1), (2.3)

где f = {Л.....fn} — некоторая заданная вектор-функ-

ция, определяющая динамику процесса.

Назовем последовательность векторов {и(0), ы(1),...

...,u(N—1)) управлением процесса; соответствующую

этому управлению в силу уравнений движения (2.3) для

некоторого начального состояния х(0) последователь-

ность {х(0), х(1),..., х(Л/)} будем называть траекторией

процесса и обозначать соответственно через и и х. Оче-

А, И. Пропой

18

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. I

видно выбор управления и кля данного начального со-

стояния х(0) полностью определяет из (2.3) соответст-

вующую траекторию х} т. е. x=x(x(0),w).

Фиксируем некоторое начальное состояние х(0) и

возьмем управление и, удовлетворяющее ограничениям

(2.1). Если при этом состояния x(k) (&=1, . . . , AQ соот-

ветствующей траектории х будут удовлетворять ограниче-

ниям (2.2), то такое управление и будем называть допус-

тимым для данного начального состояния х(0).

Следует отметить, что задачи с ограничениями (2.1)

оказались значительно труднее, чем с ограничениями

только на управляющие воздействия (т. е. когда векто-

рам x(k) разрешается принимать любые значения из

пространства состояний).

Поэтому задачи, в которых учитываются еще и ог-

раничения типа (2.1) или (2.1а), обычно выделяются в

специальный класс, который получил название задач с

ограничениями на состояния (с фазовыми ограниче-

ниями) .

Для произвольного управления и и соответствующей

траектории определим функционал следующего вида:

N-1

J - Ф (N)) + 2 /о (X (6), (£), *), (2.4)

ь=о

где Ф и fo — заданные скалярные функции, которыми бу-

дем оценивать качество процесса управления. Очевидно,

j=/(x(0), и). Таким образом, для некоторого начально-

го состояния я(0) управление будет тем лучше, чем, на-

пример, больше значение функционала /. Задача опти-

мального управления состоит в том, чтобы найти наилуч-

шее (оптимальное) управление и, т. е. такое, которое

доставляет функционалу J наибольшее (в данном случае)

значение при ограничениях (2.1), (2.2) и (2.3).

Например, требуется в конце периода управления до-

стичь максимального производства товаров заданного ас-

сортимента, или максимального выхода продукта в хими-

ческой реакции, или попасть ракетой в заданную область

при минимальном расходе топлива и т. п.

Поскольку всегда min 7=—шах(—/), то любую за-

дачу оптимизации можно свести к задаче нахождения

максимального значения, и в дальнейшем для опреде-

§ 2]

ОБЩАЯ ПОСТАНОВКА ЗАДАЧИ

19

ленности всегда будет предполагаться, что требуется

найти максимальное значение функционала J.

Сформулируем теперь задачу окончательно.

Задача. Заданы уравнения, описывающие процесс

x(H-l) =f(x(k), u(k), /г) (/<=0,1,..., W-1)

и ограничения на переменные

gi(x(k),u(k), £) >0 (/=1, . . . , mh- £=0, 1, . . . , N— 1).

Задан функционал

J =Ф (х (7V)) + V f0 (х (k), и (/г), k),

h=0

характеризующий качество управления и длительность

(число шагов) N управления. Требуется для заданного на-

чального состояния х(0)=а найти такие допустимые уп-

равление и соответствующую ему траекторию, которые

доставляют показателю качества (2.4) наибольшее

значение.

Это — типичная задача оптимального дискретного уп-

равления. Представляют интерес как различные частные

случаи этой задачи, так и ее обобщения, которые будут

рассмотрены в следующем параграфе.

Отметим, что зависимость уравнений движения и ог-

раничений от номера шага k ничего принципиально ново-

го, как будет видно из дальнейшего, не дает. Поэтому да-

лее эту зависимость будем часто опускать.

Здесь же для сравнения рассмотрим непрерывный ана-

лог сформулированной выше задачи дискретного управ-

ления. Именно, рассмотрим следующую задачу управле-

ния непрерывным процессом.

Задача. Требуется найти вектор-функцию u(t), оп-

ределенную на заданном интервале Qs^t^T (управление

и) и соответствующую этому управлению в силу заданно-

го дифференциального уравнения

^=f(x(0,«(0.0 (2.5)

и начального состояния

х(0)=а, (2.6)

вектор-функцию x(f) (траекторию х), удовлет-

2*

20

ПОСТАНОВКА ЗАДАЧИ

[ГЛ, I

воряющие ограничениям

gf(x(t), u(t), Z)>0 (i=l,..., mt; (2.7)

и доставляющие показателю качества

/ = Ф(х(?)) + ]'/о(х(О, u{t\t)dt (2.8)

о

наибольшее значение.

Обычно в таких задачах предполагается, что функция

u(t) —кусочно-непрерывна, а функции fj, gi, Ф— непре-

рывны вместе со своими частными производными первого

порядка.

При решении непрерывных задач на цифровой вычис-

лительной машине или при управлении непрерывным про-

цессом дискретным управляющим устройством вместо

непрерывной задачи необходимо рассмотреть ее разност-

ную аппроксимацию.

Возможны различные, в смысле точности или просто-

ты, переходы к дискретной аппроксимации задачи (2.5)—

(2.8). Приведем здесь простейшую. Разобьем интервал

[0, 7] на N равных шагов: t0, Л,.. ., G; ^о=О, tN=T;

tk+i—th/N=A (k=0, 1, , N—1). Управление и будем

считать на каждом шаге постоянным

th^t<tk+l (k=0, 1, . .. , N— 1).

В этом случае дифференциальное уравнение (2.5) заме-

нится на разностное вида

где | о (А) |/Д->0 при А—>0 (через |о(Д) | обозначена нор-

ма вектора о (А)). Отбрасывая бесконечно малые величи-

ны выше первого порядка и учитывая, что 4=&Д, полу-

чим

х[(&+1)Д]=х(М)+Д/[х(ЛД), и(М), ЛД]. (2.9)

Аналогичным образом органичения (2.7) заменятся на

&(х(£Д), u(kh), М)>0 (2.10)

(г'= 1, . . . , mk; k—G, 1, . . ., N— 1),

а показатель качества (2.8) примет вид

J (Д) = Ф(х(УД)) + Д21/о(х(йД), «(М), ^Д). (2.11)

fe=o

ТИПЫ ЗАДАЧ

21

§ 3]

Таким образом, решение задачи (2.5) —(2.8) можно

приближенно заменить на решение задачи нахождения

последовательностей {и(0), ы(Д),..., «[ (Л1 — 1) Д]} и

{х(0), х(Д),..., x(N\)}, удовлетворяющих (2.6), (2.9),

(2.10)’ и доставляющих показателю качества (2.11) мак-

симальное значение.

§ 3. Типы задач

1. Задача оптимизации конечного состояния (зада-

ча 1). В этой задаче качество управления оценивается

только функцией от конечного состояния процесса

/=Ф(х(7У)),

и нужно найти такое допустимое управление и, для кото-

рого значения функционала J было бы максимальным.

Например, требуется, чтобы количество продукции к кон-

цу планируемого периода было максимальным.

Так как в дальнейшем мы будем постоянно ссылать-

ся на эту задачу, сформулируем ее полностью.

Задача 1 (без ограничений на переменные состоя-

ния). Найти управление и—{и(0), ..., u(N—1)}, удов-

летворяющее ограничениям

u(k)(=Uh (k=0, 1,..., N— 1), (3.1)

и соответствующую в силу уравнений движения

x(£+l)=f(x(6), u(k), k) (&—0, 1.....N— 1) (3.2)

с начальным состоянием

х(0)'=а (3.3)

траекторию х={х(0), х(1), . . . , x(N)}, для которой

показатель качества

/=Ф(х(ЛГ)) (3.4)

принимает максимальное значение.

Задача Iх (с ограничениями на переменные состоя-

ния). Найти управление и—{и(0),..., u(N—1)} и соот-

ветствующую ему в силу уравнений движения (3.2) с на-

чальным условием (3.3) траекторию х={х(0), х(1),...

• • •, х(М)}, удовлетворяющие ограничениям

gi(x(k), U(k), &)>0 (i=l, ... , mA; k=0, 1,..., X—1)

(3-5)

22

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. 1

и доставляющие показателю качества (3.4) максималь-

ное значение.

2. Задача с суммарным показателем качества (зада-

ча 2). В этом случае функционал (2.4) имеет вид

IV —1

J - У /г), (3.6)

fc-o

либо

N—1

= 2 /о (Й-Г l),^(ft),ft).

ь=о

Последний случай легко приводится к предыдущему. Дей-

ствительно, используя (2.3), получим

N-l N-1

= 2/o^(^(ft)^(ft)’ ft), ftl- /oCv(ft),^(ft),ft).

fe=0

К таким показателям качества приводят, например,

задачи управления запасами (§1). Ниже (§ 4) будет по-

казано, что задача 2 сводится к частному случаю за-

дачи 1.

3. Задача с фиксированным конечным состоянием

(задача 3). В рассмотренных выше случаях начальное

состояние х(0) было фиксировано, а на конечное состоя-

ние не налагалось никаких дополнительных ограничений.

Такие задачи получили название задач со свободным

правым концом траектории (со свободным конечным со-

стоянием). Во многих же практических задачах нужно,

чтобы конечное состояние было фиксированным:

x(N)=x*(N). Например, при управлении строительством

какого-либо объекта, помимо минимизации затрат на

строительство, естественно требовать, чтобы объект был

построен, т. е. чтобы координаты вектора состояния объек-

та принимали заданное значение в конце периода управ-

ления. Конечно, формально можно считать, что в данном

случае множество XN состоит из одной точки x*(Af), од-

нако, поскольку ограничения типа (2.1) чаще всего свя-

заны с физическим смыслом переменных состояния, а ог-

раничения типа x(N)=x*(N)—с целью управления,

удобнее выделить такие задачи в отдельный класс.

Отметим, что, в отличие от задач со свободным кон-

цом траектории, где время управления N обычно фикси-

ровано, в задачах с фиксированным концом траектории

число шагов N может быть и не заданным заранее.

§ 31

ТИПЫ ЗАДАЧ

23

Важным случаем задач этого типа является задача

об оптимальном быстродействии, когда требуется найти

управление, переводящее начальное состояние х(0) в

заданное конечное x(N) за минимальное число шагов N.

Интересно заметить, что такое управление в дискретном

случае, в отличие от непрерывного, часто не единственно

(см. § 3.2). Поэтому здесь появляется возможность еще

и оптимизировать показатель качества типа (2.4) по всем

таким управлениям.

Используя штрафные функции, задачи с фиксирован-

ным концом траектории можно свести к задаче со свобод-

ным концом. Рассмотрим, например, вместо задачи 3,

в которой должно быть x(N) =х*(Л/), задачу, в которой

на вектор x(N) не наложено никаких условий, но показа-

тель качества (который нужно максимизировать) имеет

вид

n N—1

J - ~ W - х? (ЛОР + 2 /о (* (£), и (£), /г),

i—-1 /г-О

где X — достаточно большое положительное число. Добав-

ленное выражение в показателе качества представляет

собой «штраф», который нужно «заплатить» за невыполне-

ние равенства Xi (N) = х* (N). Очевидно, решая эту зада-

чу, можно получить приближенное, а иногда и точное ре-

шение исходной задачи с фиксированным правым концом

траектории. Точно такой же прием может быть использо-

ван и при решении задачи об оптимальном быстродей-

ствии (подробнее методы штрафных функций рассмотре-

ны в § 6.8).

4. Задача со свободным начальным состоянием (з а-

дача 4). В этом случае начальное состояние х(0) за-

ранее не фиксируется, а выбирается из заданного мно-

жества XQi т. е. является, по существу, дополнительной

управляющей переменной. Такие задачи, очевидно, легко

сводятся к обычным задачам с фиксированным началь-

ным состоянием.

5. Задача с суммарными ограничениями. Часто необхо-

димо учитывать ограничения на переменные состояния и

управления,. задаваемые на весь период управления

(например, расход ресурсов за весь период управле-

ния не должен превышать имеющихся запасов). Такие

24

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. I

ограничения обычно можно задать в виде

N—1

£ q>(*)(u(fe),6)>0 (/ = ],...,/«!), (3.7)

fe=0

JV-1

2^(х(^М)>0 (/= 1,..., m2), (3.8)

h=0

или в совместной форме

N—1

v (x(^)>u > о

h=0

(/ = !,...,/»). (3.9)

Ограничения типа (3.7), (3.8) или (3.9) легко привести к

обычной задаче управления с ограничениями на конечное

состояние системы, расширив систему уравнений (2.3),

описывающих процесс.

Рассмотрим общий случай (3.9). Введем новые т

координат xn+i,..., хп+т, положив

k — 1

хп+1- (k) = фу(х(г), u(i), (j =

i=0

Очевидно,

хп+;(А+1)=хя+ДЙ)+ф,.(х(^), u(k), k) (А=0,..., 2V — 1),

x„+J(0)=0, х„+ДУ)>0 (/=1,..., m). (3.10)

Приписывая к исходной системе уравнений (2.3) урав-

нения (3.10), получим окончательно процесс, который

задается в -мерном пространстве состояний урав-

нением вида

х,(й-|-1) =Д(х(Л), u(k), k) (( = 1,..., п-\-т; k — 0,..., AT— 1)

с начальным состоянием

хг(0)=а (i=l,..., п), хг(0)=0 (i = n-|-l,..., n-j-m)

и ограничениями только на конечное состояние системы

Xi(Af)^0 (i=n-f-l,...,

Здесь

7f(xM, A)=fi(x, и, k) (t = l,..., n),

fn+j(x, и, k) =xn+j-|-(pj.(x, u, k) (1=1,..m).

ТИПЫ ЗАДАЧ

25

Заметим, что если ограничения имеют вид

"s 4>j(x(i), i)>0 = k=l,...,N),

i=0

то они заменой переменных (3.10) приводятся к ограниче-

ниям вида

xn+j(k)^0 т\ k=0, 1,..., N— 1).

Аналогичным образом задачу с суммарным показате-

лем качества (задача 2) можно свести к задаче оптимиза-

ции конечного состояния (задача 1).

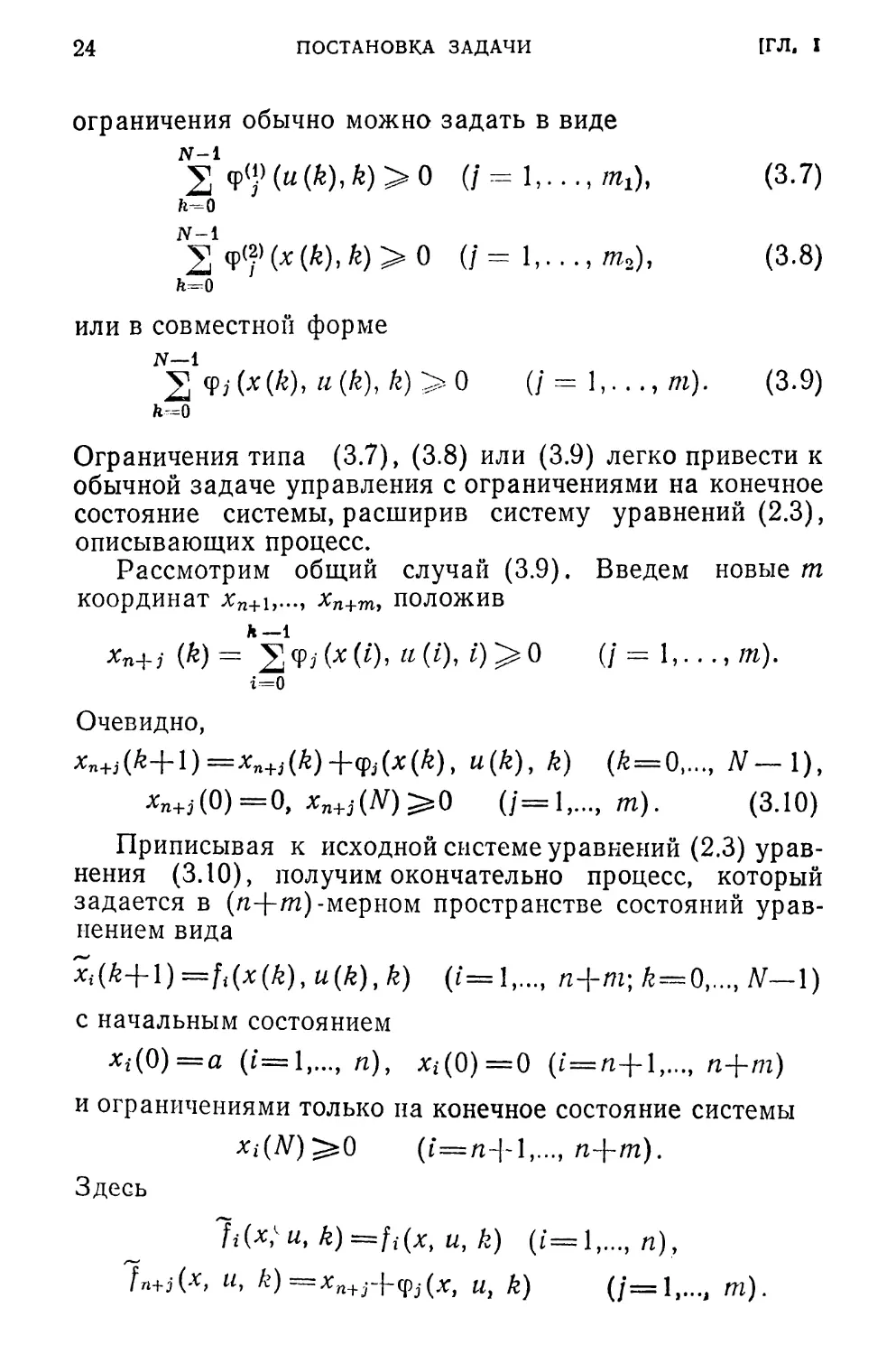

Рассмотрим задачу 2 с показателем качества (3.6).

Введем дополнительную координату — ось качества xQ.

В результате получим (п-[-1) -мерное расширенное

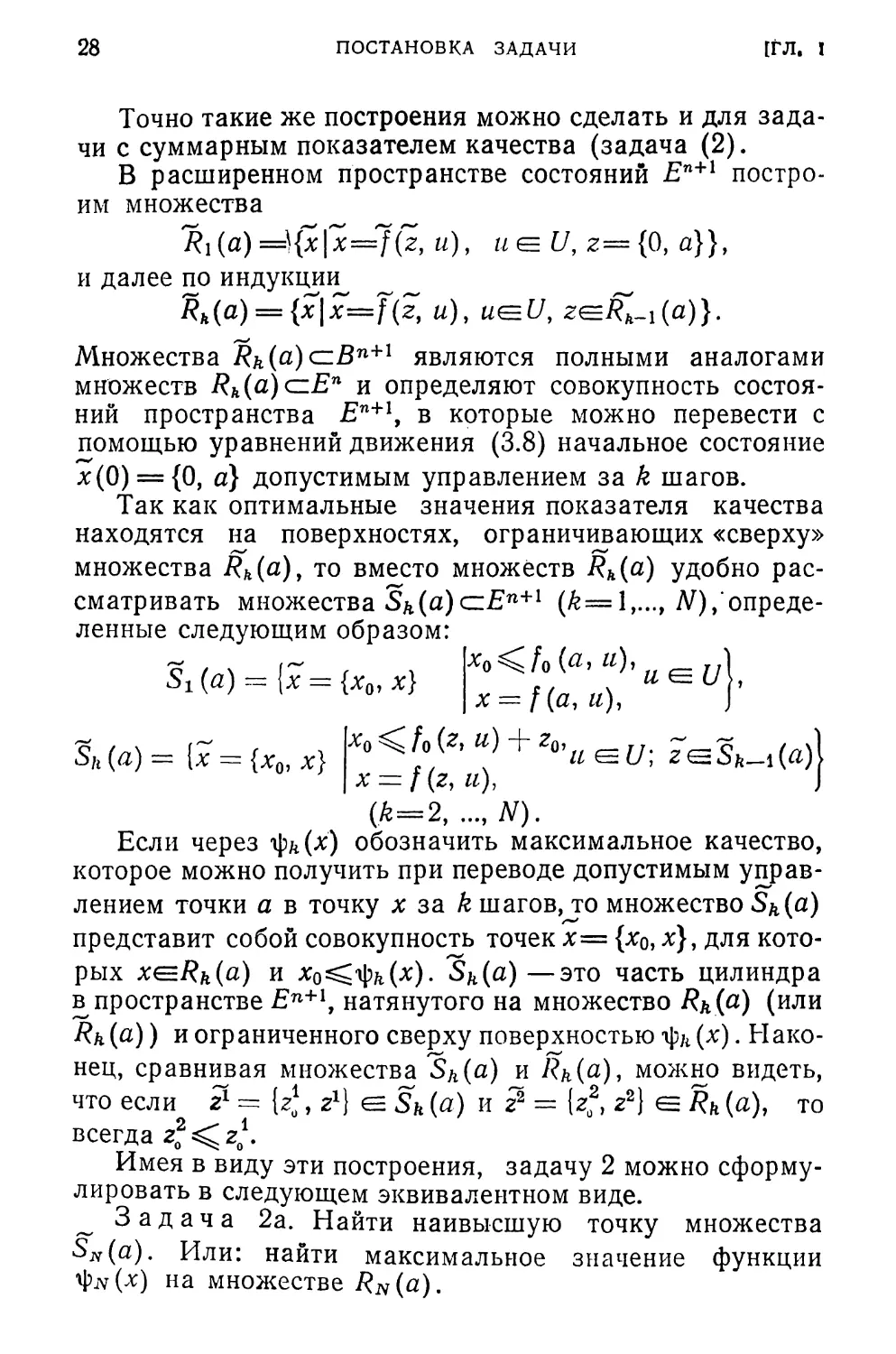

Рис. 1.3.1.

пространство состояний jE'H-1. Будем считать, что ось

качества xQ направлена «вертикально вверх», а простран-

ство состояний Еп занимает «горизонтальное» положение

(рис. 1.3.1). Положим

/г-1

/г=0

Очевидно,

Хо(/?+1)=М£)+/о(*(£), w(£), к),

л'0(0)=0, x0(N)=J.

Таким образом, теперь состояние процесса на k-м ша-

ге характеризуется дополнительной координатой — каче-

ством процесса х0(й) на этом шаге, и x(k) = {х0(&),

26

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. I

Xifk),..., xn(A)}e£n+I (все элементы, относящиеся к рас-

ширенному пространству состояний, будем отмечать

тильдой).

Обозначим

Xo(k)+fo(x(k), u(k),k) —~fQ(x(k),u(k),k). (3.11)

Тогда в расширенном пространстве состояний процесс

(2.3) с показателем качества (3.6) описывается системой

уравнений

х(6+1)=7(Г(й), u(k), k), (3.12)

где

Г={Го,А,...,М,

х(0) = {0, хДО),..., хп(0)},

x(N) = {J, х^),...^^)}.

Задачу 2 можно сформулировать теперь следующим

эквивалентным образом (рис. 1.3.1).

Задача 2а. В пространстве En+i задана начальная

точка х(0) и уравнения движения (3.12). Требуется най-

ти такое допустимое управление, которое на основании

уравнений (3.12) переводит точку х(0) в возможно более

высокую точку пространства Еп+[ за N шагов.

Положим е={1, 0}, где тогда, очевидно,

^^.^(Af) = (е, х(?/)). Здесь и далее через ( , ) будем

обозначать скалярные произведения двух векторов:

п

(а,Ь)= Таким образом, задача 2 свелась к частно-

г=1

му случаю задачи 1, когда функция Ф(х) линейна:

O(x(/V)) = (e, x(N)).

Сделаем несколько заключительных замечаний. Фор-

мально задачи дискретного управления являются полны-

ми аналогами соответствующих задач непрерывного уп-

равления. Однако область практического применения

дискретного управления связана, в основном, с задачами

экономики, организации и технологии производства, ис-

следования операций и т. п. Для таких задач характерны

наличие большого числа как переменных состояния, так

§ 4]

МНОЖЕСТВА ДОСТИЖИМОСТИ

27

и переменных управления и ограничений на них (в част-

ности, ограничений на переменные состояния), что опре-

деляет тесную связь этих задач с задачами математиче-

ского программирования.

§ 4. Множества достижимости

В этом параграфе будут введены множества, с по-

мощью которых многошаговые задачи управления могут

быть интерпретированы как задачи математического про-

граммирования в пространстве состояний X.

Для простоты обозначений будем считать, что уравне-

ния движения (2.3) и ограничения (2.1), (2.2) явно от k

не зависят. Рассмотрим сначала задачу без ограничений

на переменные состояния.

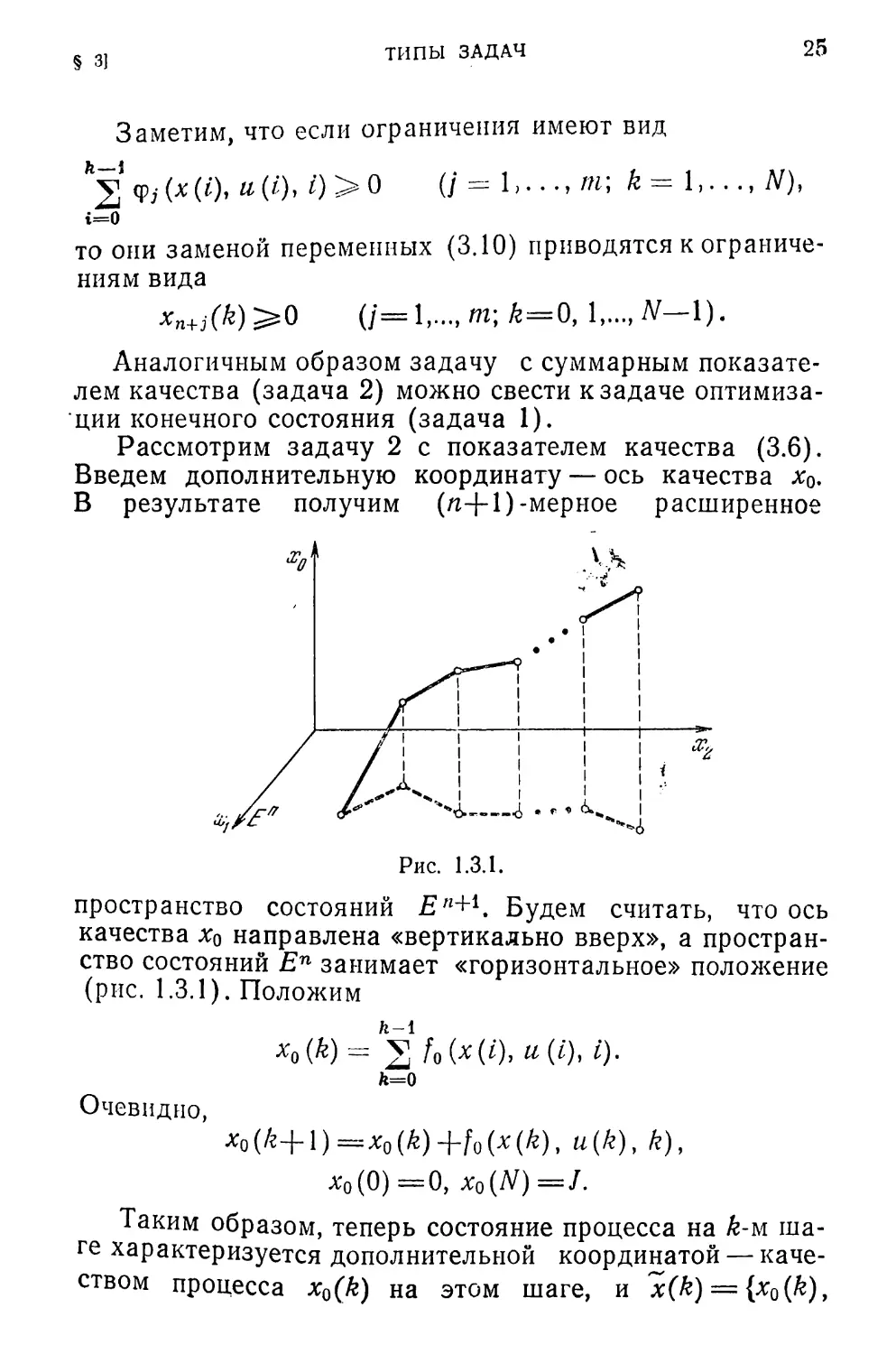

Фиксируем в пространстве Еп начальное состояние

х(0)=а и посмотрим в какие точки х^Еп можно пере-

вести х(0)=а за один шаг с помощью допустимого уп-

равления. Очевидно, эти точки будут определяться мно-

жеством

^i(a) = {xlx=f(a, «), «el/}. (4.1)

Множества при k> 1 определим по индукции

Rk(a) = {x\x=f(z, и), ti<=U, 2еДы(а)}. (4.2)

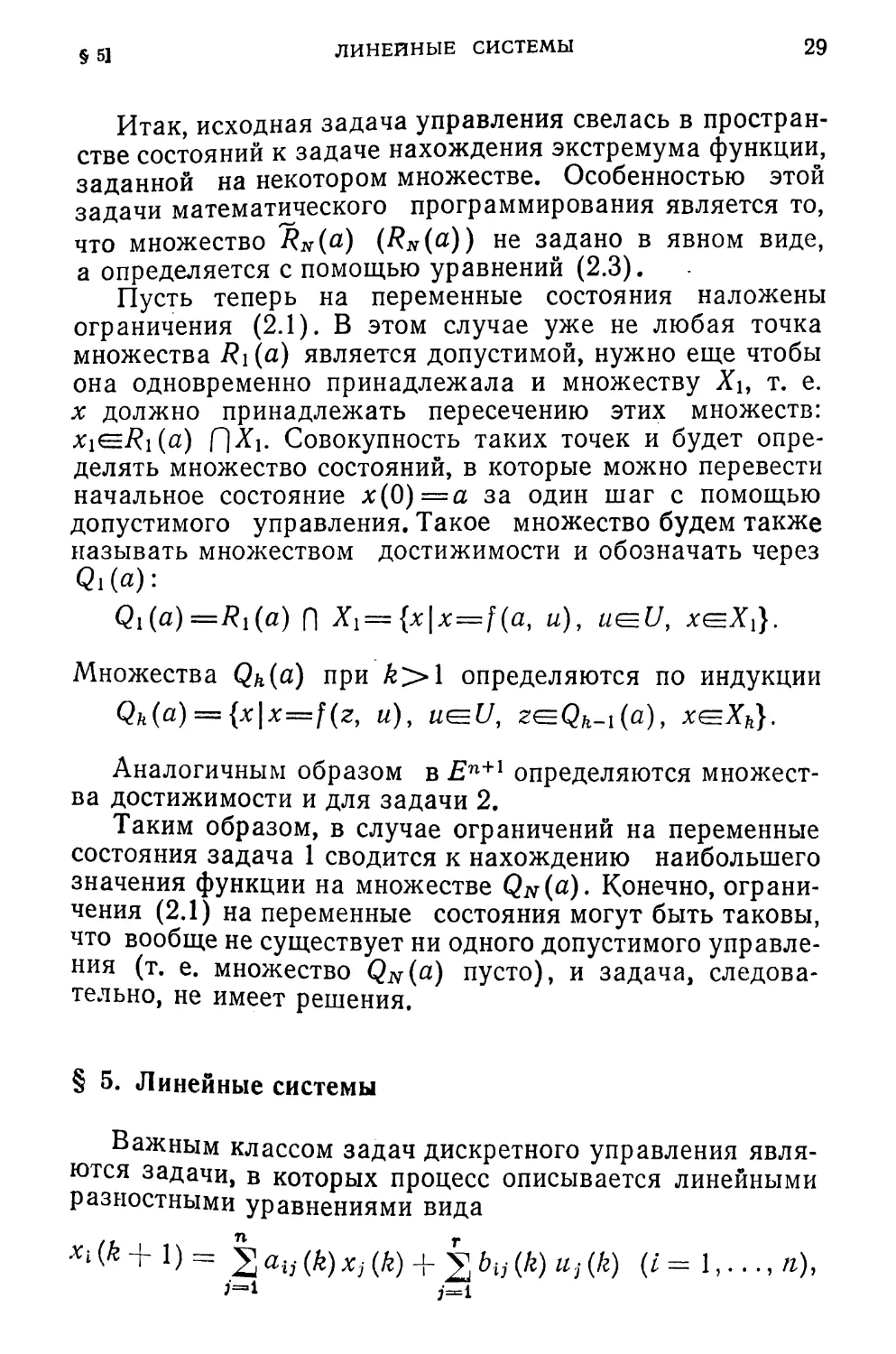

Множество ^?fe(a) (6=1, 2,...) —это множество всех со

стояний х в пространстве Еп, в которые можно переве

сти точку а за k шагов d

с помощью допустимо- ' Xj

го управления {«(0),

w(l),..., ц(&—1)} (рис.

1-4.1). Назовем 7?ь(а)

множеством достижи-

мости процесса (2.3)

(при ограничениях

(2-2)).

Используя понятия

множеств достижимо-

2

Рис. 1.4.1.

сти, задачу оптимиза-

ции конечного состояния (задача 1) можно сформули-

ровать в следующем эквивалентном виде.

Задача 1а. Найти максимальное значение функции

Ф(х) на множестве RN(a).

28

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. I

Точно такие же построения можно сделать и для зада-

чи с суммарным показателем качества (задача (2).

В расширенном пространстве состояний En+i постро-

им множества

'Ri(a) =){x\x=f(z, и), и U, z— {0, а}},

и далее по индукции^___

Rh(a) = {x\x==f\z, и), u(=U, zt=fZh_i(a)}.

Множества /?А(а)сВп+1 являются полными аналогами

множеств Rh(a)aEn и определяют совокупность состоя-

ний пространства En+i, в которые можно перевести с

помощью уравнений движения (3.8) начальное состояние

х(0) = {0, а} допустимым управлением за k шагов.

Так как оптимальные значения показателя качества

находятся на поверхностях, ограничивающих «сверху»

множества 7?ft(a), то вместо множеств Rk(d) удобно рас-

сматривать множества (a)c=£n+1 (k— 1,..., N),'опреде-

ленные следующим образом:

, x0^f0(a, и), \

SiW--[x^{x„x} х = ж,г)1

3„(я) = |3 = (Х„ х} “> + !l>’u<=U; zeSwW)

х = f (г, и), J

(k=2, ..., N).

Если через фл(х) обозначить максимальное качество,

которое можно получить при переводе допустимым управ-

лением точки а в точку х за k шагов, то множество Sk(a)

представит собой совокупность точек х= {х0, х}, для кото-

рых x^Rk(a) и х0^фй,(х). Sfe(a)—это часть цилиндра

в пространстве Еп+1, натянутого на множество Я* (с) (или

Rk(a)) и ограниченного сверху поверхностью ф/((х). Нако-

нец, сравнивая множества (а) и Rk(a), можно видеть,

что если ? = {z*, z1} е Sft(a) и z2 = (z02, z2) е Л?ь(а), то

всегда г02 г,1.

Имея в виду эти построения, задачу 2 можно сформу-

лировать в следующем эквивалентном виде.

~ Задача 2а. Найти наивысшую точку множества

SN(a). Или: найти максимальное значение функции

ф.|у(х) на множестве RN(a).

§ 5]

линейные системы

29

Итак, исходная задача управления свелась в простран-

стве состояний к задаче нахождения экстремума функции,

заданной на некотором множестве. Особенностью этой

задачи математического программирования является то,

что множество (RN(a)) не задано в явном виде,

а определяется с помощью уравнений (2.3).

Пусть теперь на переменные состояния наложены

ограничения (2.1). В этом случае уже не любая точка

множества Ri (а) является допустимой, нужно еще чтобы

она одновременно принадлежала и множеству Ху т. е.

х должно принадлежать пересечению этих множеств:

x^Ri(a) Л^ь Совокупность таких точек и будет опре-

делять множество состояний, в которые можно перевести

начальное состояние х(0)=а за один шаг с помощью

допустимого управления. Такое множество будем также

называть множеством достижимости и обозначать через

Qi(a):

Ql(a)=Rl(a) fl Х[ = {x|x=f(а, и), u<=U, хеЛ)}.

Множества Qft(a) при k>\ определяются по индукции

Qh(a) — {x\x—f(z, и), ut=U, z^.Qk_i(a), x<=Xh}.

Аналогичным образом в Еп+1 определяются множест-

ва достижимости и для задачи 2.

Таким образом, в случае ограничений на переменные

состояния задача 1 сводится к нахождению наибольшего

значения функции на множестве Qw(«). Конечно, ограни-

чения (2.1) на переменные состояния могут быть таковы,

что вообще не существует ни одного допустимого управле-

ния (т. е. множество Qw(a) пусто), и задача, следова-

тельно, не имеет решения.

§ 5. Линейные системы

Важным классом задач дискретного управления явля-

ются задачи, в которых процесс описывается линейными

разностными уравнениями вида

XL (k + 1) = 2 ai}- (k) Xj (k) + 2 bij (/г) iij (/г) (Z = 1,..., n),

30

ПОСТАНОВКА ЗАДАЧИ

[ГЛ, I

или в векторном виде

x(k+\)=A(k)x(k)+B(k)u(k) (k=0,..., N—l), (5.1)

где A(k) = [ау(^)] (*, га) и B(k) = [bij(k)]

п; г) — матрицы размера (пХ^) и

(/гХг) соответственно.

Ограничения на переменные в этом случае также

задаются в виде линейных неравенств

2 Сц (k) Xj (k) + 2 W Ui (/?) > hi W

j=i

(f= 1, . . . , W, & = 0, 1, . . . , N—1),

или в векторной форме

£(k)x(k)+D(k)u(k)^h(k) (/г-0, 1, . . . , А/--1), (5.2)

где С (k) = [Cij (k) ], D (£) = [dis (/г) ], h (k) = [/гг (k) ] (1 =

= 1, . . . , mh-, /— 1, . . . , n; s = 1, . . . , r).

Показатель качества в этом случае также обычно ап-

проксимируют:

J = 2 [ S + 5 ai (/г) xt

A=0Lm=1 i=l

Л'—1

P

Гц (k) Ui (k) Uj (/г) + 2 (fe) «i (fe)

i=l

(5-3)

или

(х(й), Q(k)x(k))^(a(k), x(k)) +

(5.4)

Здесь Q (k) = [<7Ъ- (k) ] и R (k) = [rtj (k) ] — неположительно

определенные матрицы (если ищется максимум /) разме-

ра («Х«) и (гХг) соответственно.

Часто в показатель качества входят только линейные

члены (например, во многих экономических задачах).

В этом случае он будет иметь вид

N N-1

J = 2 W- х -г 2 (&)’11 (ty- (5.5)

^0 h=Q

§ PJ

СУЩЕСТВОВАНИЕ УПРАВЛЕНИЯ

31

Задачи (5.1) —(5.3), (5.5) и (5.1) —(5.4) по аналогии со

статическими задачами можно назвать задачами дина*

мического линейного и квадратичного программирова-

ния. Их изучение имеет большое значение для разра-

ботки методов оптимизации в динамических моделях

экономики, а сами задачи могут быть непосредственно

интерпретированы в экономических терминах (см. при-

мер I в § 1 и §§ 5.11, 5.12).

§ 6. Существование оптимального управления

Прежде чем перейти к условиям оптимальности управ-

ления, установим его существование. Для этого необхо-

димо ответить на два вопроса: 1) существует ли вообще

хотя бы одно допустимое управление; 2) если такое

управление существует, то достигается ли оптимальное?

Заметим, что из утвердительного ответа на первый

вопрос еще не следует факта существования оптимально-

ного управления. Например, если требуется найти наи-

большее значение функции J(и) = arctg(l/u), причем

O^u^l, то значение н* = 0, при котором функция J (и)

имеет максимум, не достигается, хотя к нему можно при-

близиться как угодно близко.

Однако обычные требования непрерывности по извест-

ной теореме Вейерштрасса (см. § 2.1) уже обеспечат су-

ществование оптимального управления, если есть допус-

тимые управления. Именно, для задачи 1 без ограничений

на переменные состояния справедлива.

Теорема 6.1. Пусть в задаче 1 функции Ф(х) и

и, 6)(/=1,..., n; k — 0, 1,..., Af—1) непрерывны по

своим аргументам х^Еп и u<=Uh, a Uk — ограниченные

замкнутые и непустые множества.

Тогда оптимальное управление и* существует для

любого начального состояния х(0); при этом качество

соответствующее оптимальному управлению, прини-

мает конечное значение.

Замечание. Если множества Uh задаются неравен-

ствами типа (2.2), то для его замкнутости достаточно

потребовать, чтобы функции gj(u, А)(/=1,..., mh\

«=0,1,..., Д/—1) были непрерывными. Для того чтобы

Обеспечить ограниченность множеств [Д, достаточно

32

ПОСТАНОВКА ЗАДАЧИ

[ГЛ. I

прибавить к неравенствам (2.2) ограничения

(/=1,..., г), где М — достаточно большое число.

Утверждение теоремы почти очевидно. Действительно,

задача оптимального управления 1 сводится к нахожде-

нию максимального значения функции многих перемен-

ных J(x(0), и(0),..., u(N—1)), определенных через урав-

нения движения (3.2) и показатель качества (3.4),

которая задана на прямом произведении N ограниченных

и замкнутых множеств Uk (начальное состояние х(0)

считается фиксированным). В силу сделанных предполо-

жений функция /(х(0), u(0),..., u(N—1)) должна быть

непрерывна. Отсюда следует утверждение теоремы. Мы

не будем, однако, уточнять эти рассуждения, а приведем

несколько иное доказательство, связанное с геометрией

процесса и легко обобщающееся на случай фазовых

ограничений.

Доказательство. Как было показано в § 4, задача

1 сводится к нахождению наибольшего значения функции

Ф(х) на множественна). Если функция Ф(х) непрерыв-

на, а множество Rn(o) ограничено и замкнуто (т. е.

компактно), то по известной теореме Вейерштрасса

(§ 2.1) наибольшее значение функции Ф(х) на множестве

П^(а) достигается, и оно конечно. Поэтому теорема будет

доказана, если будет установлена компактность RN(a)

для любого начального состояния х(0)=а. Действитель-

но, множество Ri(a) представляет собой образ непрерыв-

ного отображения компактного множества UQ в простран-

стве Еп\ £/0, 0) и, следовательно, компактно.

Допустим теперь, что множество Rk-i(a) компактно.

Тогда компактно прямое произведение Rk-i (a)

Следовательно, множество Rk(a) =f (/?ь-1(а), Uk-ъ k—1)

также компактно. Теорема доказана.

Аналогичным образом устанавливаются условия су-

ществования оптимального управления и для задачи 2.

Заметим, что условия теоремы выполняются почти

во всех реальных задачах. Поэтому оптимальное управле-

ние существует практически для любой задачи дискрет-

ного управления без ограничений на переменные состоя-

ния.

Если же значения переменных состояния ограничены

условиями (2.1), то в этом случае приобретает значение

первый вопрос, а именно, существует ли вообще хотя бы

СУЩЕСТВОВАНИЕ управления 33

§ 6]

одно допустимое управление. Этот вопрос рассматривает-

ся в главе VI, гДе будет дана процедура, позволяющая

находить допустимые управления в этом случае (если они

есть). Здесь же отметим, что, очевидно, для существова-

ния допустимого управления вовсе недостаточно, чтобы

множества Ад и Uk были непустыми. Если же допустимое

управление существует, то достижимость оптимального

управления обеспечивается такими же условиями непре-

рывности, что и в теореме 6.1.

Сформулируем их для общей задачи с показателем

качества (2.4).

Теорема 6.2. Пусть множества Uh(k=0,..., N—1) и

Xk(k=0,..„ N) ограничены и замкнуты, а функции Ф(х),

fj(x, и, k) (j= 1,..., п; fe=0,..., N—1) непрерывны. Если при

этом для некоторого начального состояния х(0)=а

существует хотя бы одно допустимое управление, то

существует и оптимальное, при этом оптимальное качест-

во J* имеет конечное значение.

Доказательство аналогично доказательству теоремы

6.1 и следует из компактности множеств достижимости

Qk(k=l,..., N) и непрерывности функции Ф(х) для этой

задачи.

ГЛАВА II

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

Поскольку методы решения многошаговых задач

существенно используют идеи и понятия теории математи-

ческого программирования (имеется в виду теория

оптимизации статических, одношаговых задач*)), в этой

главе рассмотрены основы этой теории. При этом внима-

ние обращается не на сами результаты и их доказатель-

ства (они достаточно хорошо известны), а, скорее, на

идеи и методы, используемые при их получении.

§ 1. Некотсфые сведения из n-мерной геометрии

и теории выпуклых множеств

В дальнейшем понадобятся некоторые сведения из

n-мерной геометрии и теории выпуклых множеств.

Приведем их здесь для справок.

Рассмотрим n-мерное евклидово пространство Еп со

п

скалярным произведением двух векторов (%, у) = 2 Xiyi.

г=1

Длиной, или нормой вектора х, назовем число

/ п \ 1/2

|х| = (X, х)1/2 = 24 .

\i=l /

Шаром радиуса 8 с центром в точке х* назовем

множество точек х<=Еп для которых

| х—х* | < 8.

Будем обозначать такой шар через Se(x*). Он образует

ъ-окрестность точки х*.

Если множество RczzEn содержит вместе с точкой хи ес

е-окрестность при некотором 8>0, то назовем х внутрен-

ней точкой множества R. Если в любой окрестности х

*) Постановку одношаговой задачи оптимизации см. в § 2

этой главы.

СВЕДЕНИЯ ИЗ л-МЕРНОЙ ГЕОМЕТРИИ

35

§ И

содержатся как точки из /?, так и не принадлежащие R

точки, то назовем х граничной точкой множества R.

Множество, содержащее все свои граничные точки,

называется замкнутым. Присоединение к множеству R

его граничных точек называется замыканием множества

R и обозначается через R.

Если множество R целиком содержится в шаре радиу-

са р, где р — конечное число, то такое множество называ-

ется ограниченным.

Ограниченное и замкнутое множество в Еп является

компактным множеством. Если множество R задано с

помощью систем неравенств*)

(j=l,...,m) (1.1)

или

fi(x)<0 m), (1.2)

где fj(x) (/=1,..., m) —непрерывные функции, то оно

всегда замкнуто, хотя может быть и не ограниченным.

Можно показать, что непрерывная функция Ф(х),

заданная на компактном множестве R, достигает на нем

как верхней, так и нижней грани (теорема Вейерштрас-

са), т. е. существуют такие точки х1, х2, что

ф (%i) = sup ф (Х) = шах ф (х),

V 7 хек 4 7 x&R 4 7

ф (%2) = inf ф (Х) = min ф (х).

x^R x£=R

Возьмем произвольные две точки х1 и х2 из R. Совокуп-

ность точек вида х=%х1+(1—Х)х2, гдеО^Д^1, образует

отрезок с концами в точках х1 и х2.

Множество R называется выпуклым, если вместе с лю-

быми двумя точками х1, x2^R оно содержит и соединяю-

щий их отрезок, т. е. если х=Хх1+(1—k)x2^R при

Множество R называется выпуклым по направлению е,

если для любых х1 и х2 из существует такое число

Н^О, что х=Лх1+(1— Z)x2+pe(=/? при

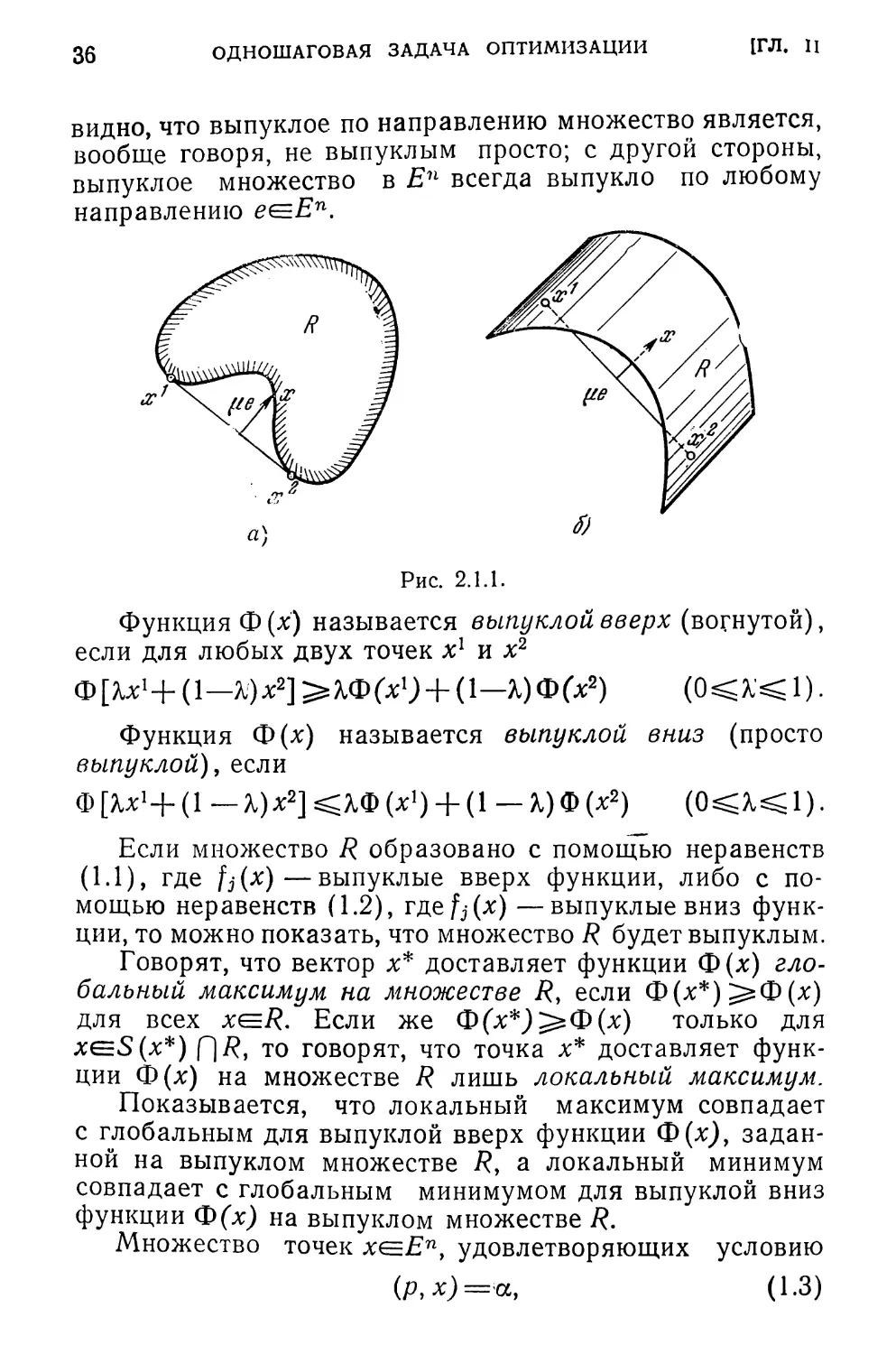

На рис. 2.1.1 а, б показаны примеры выпуклых по

направлению множеств. Из определений и этих примеров

*) Любая из этих систем неравенств сводится к другой умно*

женнем на ___1

3*

36

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

[ГЛ. II

видно, что выпуклое по направлению множество является,

вообще говоря, не выпуклым просто; с другой стороны,

выпуклое множество в Еп всегда выпукло по любому

направлению е^Еп.

Рис. 2.1.1.

Функция Ф (х) называется выпуклой вверх (вогнутой),

если для любых двух точек х1 и х2

ФЕ^Х1^ (1— ^)х2]>%Ф(х1) + (1— %)Ф(х2) (0^Х<1).

Функция Ф(х) называется выпуклой вниз (просто

выпуклой), если

Ф [Хх!+ (1 — Х)х2] ^Ф (х1) + (1 — %) Ф (х2) (О^Х^ 1).

Если множество R образовано с помощью неравенств

(1.1), где fj(x)—выпуклые вверх функции, либо с по-

мощью неравенств (1.2), где^-(х) —выпуклые вниз функ-

ции, то можно показать, что множество R будет выпуклым.

Говорят, что вектор х* доставляет функции Ф(х) гло-

бальный максимум на множестве R, если Ф(х*)^=Ф(х)

для всех x^R. Если же Ф(х*)7^Ф(х) только для

xeS(x*) С)/?, то говорят, что точка х* доставляет функ-

ции Ф(х) на множестве R лишь локальный максимум.

Показывается, что локальный максимум совпадает

с глобальным для выпуклой вверх функции Ф(х), задан-

ной на выпуклом множестве /?, а локальный минимум

совпадает с глобальным минимумом для выпуклой вниз

функции Ф(х) на выпуклом множестве R.

Множество точек удовлетворяющих условию

(р,х)=а, (1.3)

§ И

СВЕДЕНИЯ ИЗ n-МЕРНОЙ ГЕОМЕТРИИ

37

называется гиперплоскостью. Вектор р ортогонален этой

гиперплоскости.

Гиперплоскость (1.3) порождает пару полупрост-

ранств в Еп:

Е™ = {х| (р, х) хе Еп], Е” = {х| (р, х) > а, хе Еп}-

Говорят, что гиперплоскость (1.3) разделяет множест-

ва и /?2, если

(р, х) =g?a для всех x^R{

и

(р, х) для всех х<=/?2.

Если эти неравенства являются строгими, то будем

говорить, что гиперлоскость (1.3) строго разделяй

множества 7?i и /?2.

Пусть и Т?2 — произвольные замкнутые выпуклые

множества, не имеющие общих точек; при этом хотя бы

одно из них ограничено. Тогда можно доказать, что

существует гиперплоскость, строго разделяющая эти

множества (теорема о разделяющей гиперлоскости).

Гиперплоскость (р, х)=а называется опорной гипер-

плоскостью множества R в точке x*(=R, если R содержит-

ся в одном из полупространств, задаваемых этой гипер-

плоскостью, и граница R имеет с ней хотя бы одну общую

точку. Таким образом, гиперплоскость (р,х) = а является

опорной для множества R в точке х*<=7?, если

max (р, х) = (р, х*) = а,

x(=R

или, положив q = —р,

mln (q, х) = (q, х*) = — а.

x^R

Можно показать, что для любой граничной точки

выпуклого замкнутого множества существует опорная

гиперплоскость в этой точке.

Множество К(х*) называется конусом с вершиной в

точке х*, если для любых хеК(х*) и любого

х*+е(х—х*) ^К(х*).

Конус К(х*) может быть, вообще говоря, не выпук-

лым. Множество /((х*) называется выпуклым конусом

38

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

[ГЛ. Ц

с вершиной в точке х*, если для любых х, у^К(х*\

а, р^О

а(х—х*) +р (у—х*) (=К(х*).

Так, полупространство {х| (р, х—х*)^0} вЕп —вы-

пуклый конус.

Выпуклым многогранным конусом С(х*) с вершиной

в точке х* называется пересечение конечного числа полу-

пространств, образованных гиперплоскостями, проходя-

щими через эту точку х*.

Таким образом, выпуклый многогранный конус это

множество точек удовлетворяющих неравенствам

(р\х—х*)^0 (7=1,..., т).

§ 2. Постановка задачи

Формулировка одношаговой задачи оптимизации

состоит в следующем.

Задача. В пространстве Еп задано некоторое допу-

стимое множество R. Выбор решения — вектора

х= {xi,..., хп} из этого множества R характеризуется

некоторым качеством — функцией Ф(х). Требуется найти

такой вектор х* из множества R, для которого функция

Ф(х) принимает экстремальное (далее, для определен-

ности, максимальное) значение.

Будем предполагать для простоты, что R — ограничен-

ное, замкнутое и непустое множество, а Ф(Х) —непрерыв-

но дифференцируемая функция на У?*).

В этом случае максимальное значение функции Ф(х)

на множестве R достигается, и задача может быть записа-

на в виде

™ХФ(Х). (2.1)

Обычно множество R задается с помощью системы не-

равенств (см. § 1)

fi(x)>0 (2.2)

Будем считать, что fj(x) — непрерывно-дифференцируе-

мые функции, а неравенства (2.2) непротиворечивы.

*) Более точно, будем считать, что Ф (х) определена и непре-

рывно дифференцируема в некоторой области /?'=/?.

39

ПОСТАНОВКА ЗАДАЧИ

§ 21

Иногда удобно сводить задачу (2.1) к следующему

каноническому виду, вводя дополнительную ось —качест-

в0 Хо—ф(х). Определим в пространстве En+l множе-

ство R.

R={{x0, х}\х0^Ф(х), x<=R}. (2.3)

Если множество R задано с помощью системы не-

равенств (2.2), то R можно задать в виде неравенств

(j=0,...,m), (2.4)

где х= {х0, х}, f0(x) = Ф(х)—х0, %(х) =fj(x) (/=1,..., т).

Введем в пространстве Еп+* вектор е= {1, 0}.^Гогда

задача (2.1) запишется в виде: найти тах(е,х)при

ограничениях (2.4).

В зависимости от вида функций fj(x), ф(х) различа-

ют следующие типы задач оптимизации.

Если функции /у(х), Ф(х) линейны:

Ф(х) = 2 aOiXi = (а0, х),

i=i (2.5)

2^iXi=(ay, х) (/ = 1,...,/п),

1=1

то это задача линейного программирования.

Нахождение максимума квадратичной функции

ф (х) = (х, Qx) + (а0, х),

где Q = [7г?] (i, /=1,..., n)—отрицательно определен-

ная матрица, при линейных ограничениях (2.5) является

задачей квадратичного программирования.

Наконец, если функции Ф(х), fj(x) нелинейны, но вы-

пуклы вверх, то это задача выпуклого программирования.

Во всех этих задачах неравенства fj(x)^O

т) задают выпуклое замкнутое множество

(возможно, неограниченное), функция Ф(х) по условиям

выпукла вверх. Поэтому для этих задач локальный мак-

симум совпадает с глобальным. Такие задачи принято

называть одноэкстремальными. Для них необходимые

условия оптимальности (при некоторых условиях регу-

лярности) являются одновременно и достаточными

(см. § 6).

40

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

[ГЛ. п

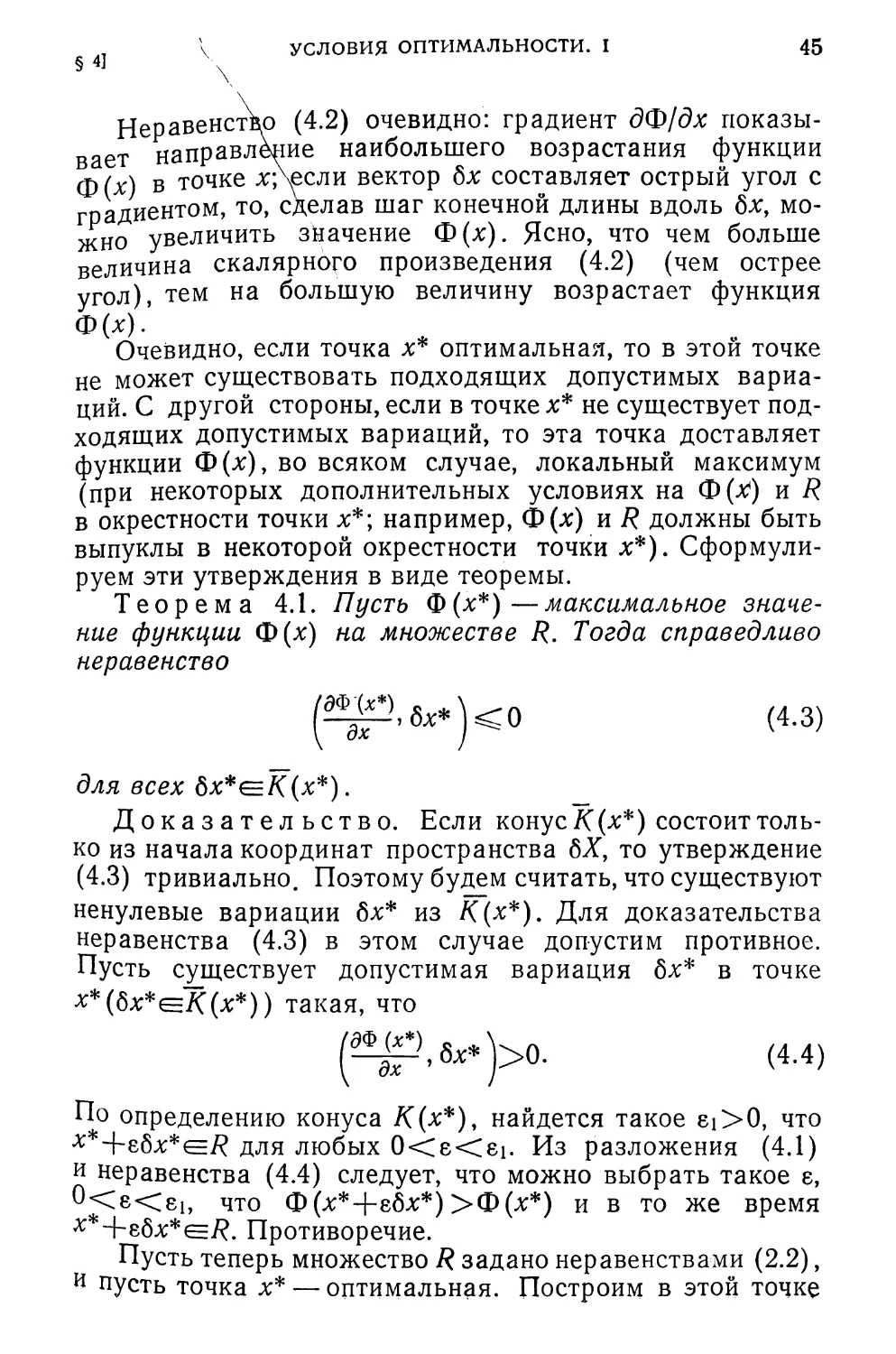

§ 3. Конусы допустимых вариаций

Пусть х — некоторая точка множества R. Рассмотрим

новый вектор х+бх, где вектор 8х имеет размерность век-

тора х и определяет вариацию 8х, Совокупность вариаций

8х= {бхь..., бхп} образует n-мерное пространство ва-

риаций 6Х. Будем считать, для наглядности, что началом

координат этого пространства является точка х. Средн

всевозможных вариаций 8х выделим такие, при которых

достаточно малые шаги вдоль вектора 8х не выводят точ-

ку х за пределы множества R, Такие вариации назовем

допустимыми.

Более точно, 8х — допустимая вариация в точке x^R,

если найдется такое число 8i>0 (зависящее от х и бх),

ЧТО х+ебхе/? ДЛЯ ЛЮбыХ 0<8<8ь

Если множество R выпукло, то для того, чтобы вари-

ация бх была допустимой, достаточно существования хо-

тя бы одного 8i>0, при котором х4-816x^7?. (В этом слу-

чае из выпуклости R следует, что точки х+ебх будут при-

надлежать множеству R для любых 0<8<еь)

Совокупность допустимых вариаций в точке х обра-

зует (в пространстве вариаций 6Х) конус К(х) с

вершиной в начале координат пространства вариаций

(рис. 2.3.1).

Этот конус будем называть конусом допустимых вари-

аций. Таким образом,

7((Х) = {бх|х+8бхе/?, 0<8<8i, x<=R}.

Отметим несколько свойств конуса К(х).

Конус К(х) —непустое множество, так как начало ко-

ординат (пространства 6Х) принадлежит конусу К(х).

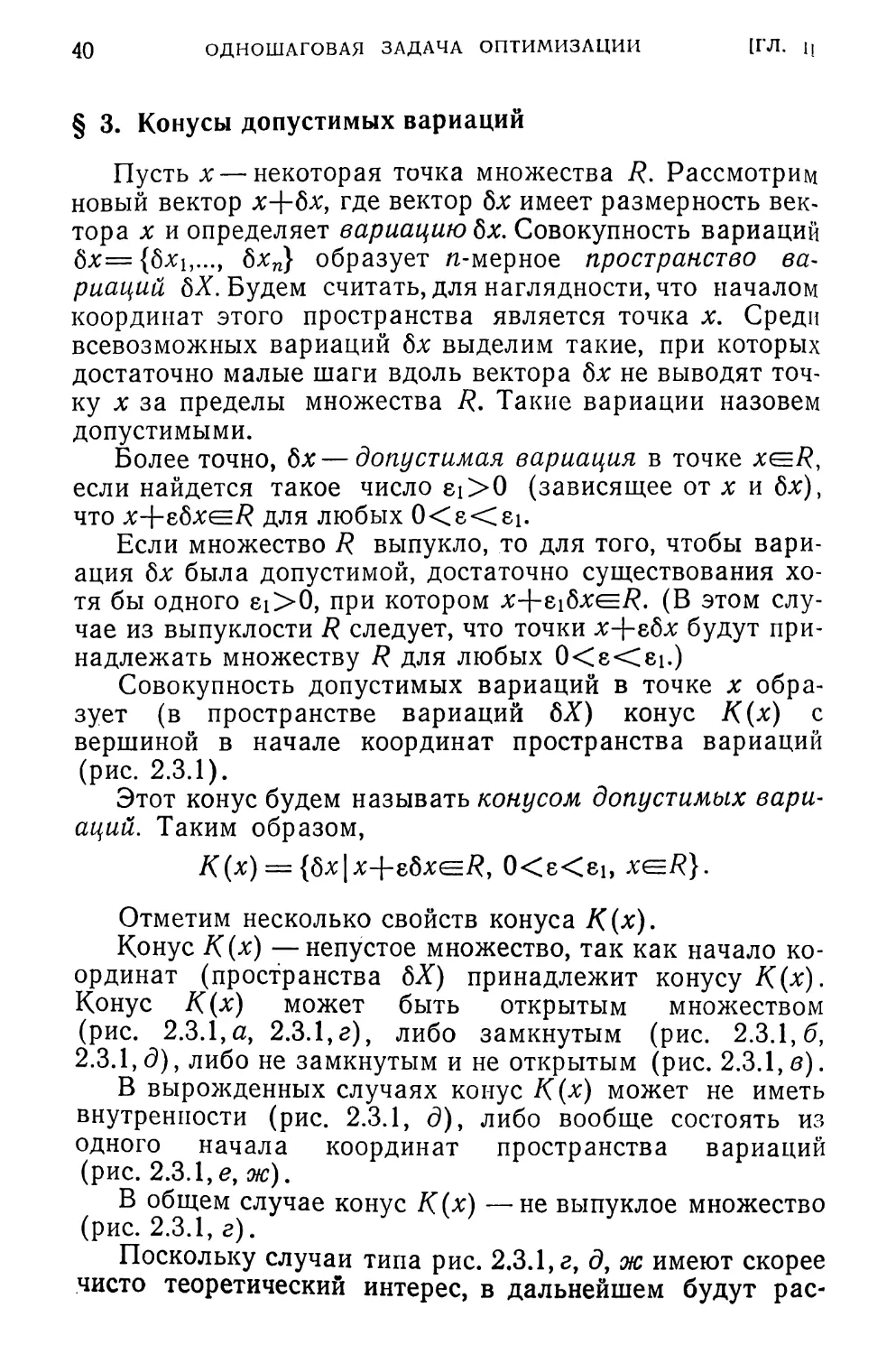

Конус К(х) может быть открытым множеством

(рис. 2.3.1,а, 2.3.1,г), либо замкнутым (рис. 2.3.1, б,

2.3.1, д), либо не замкнутым и не открытым (рис. 2.3.1, в).

В вырожденных случаях конус К(х) может не иметь

внутренности (рис. 2.3.1, д), либо вообще состоять из

одного начала координат пространства вариаций

(рис. 2.3.1, е, ж).

В общем случае конус К(х) —не выпуклое множество

(рис. 2.3.1, г).

Поскольку случаи типа рис. 2.3.1, г, д, ж имеют скорее

чисто теоретический интерес, в дальнейшем будут рас-

КОНУСЫ ДОПУСТИМЫХ ВАРИАЦИЙ

41

§ 3]

сматриваться такие конусы К(х) допустимых вариаций,

которые

1) выпуклы,

2) имеют внутренние точки.

Однако при таких условиях на конус допустимых ва-

риаций исключается и случай, когда множество R пред-

ставляет собой, например, некоторую поверхность в Еп

Рис. 2.3.1.

(точнее, некоторое многообразие размерности, меньшей

и) и, следовательно, не имеет внутренних точек в Еп

(рис. 2.3.1, е). Между тем множества достижимости, по-

строенные в главе I, могут представлять именно этот слу-

чай. Поэтому возникает необходимость ослабить ограни-

чения на определение допустимых вариаций.

Будем называть вектор 8х допустимой вариацией в

точке x^R в широком смысле слова, если для любого

ei>0 найдется такое число е (0<e<ei) и вектор

42

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

[ГЛ. II

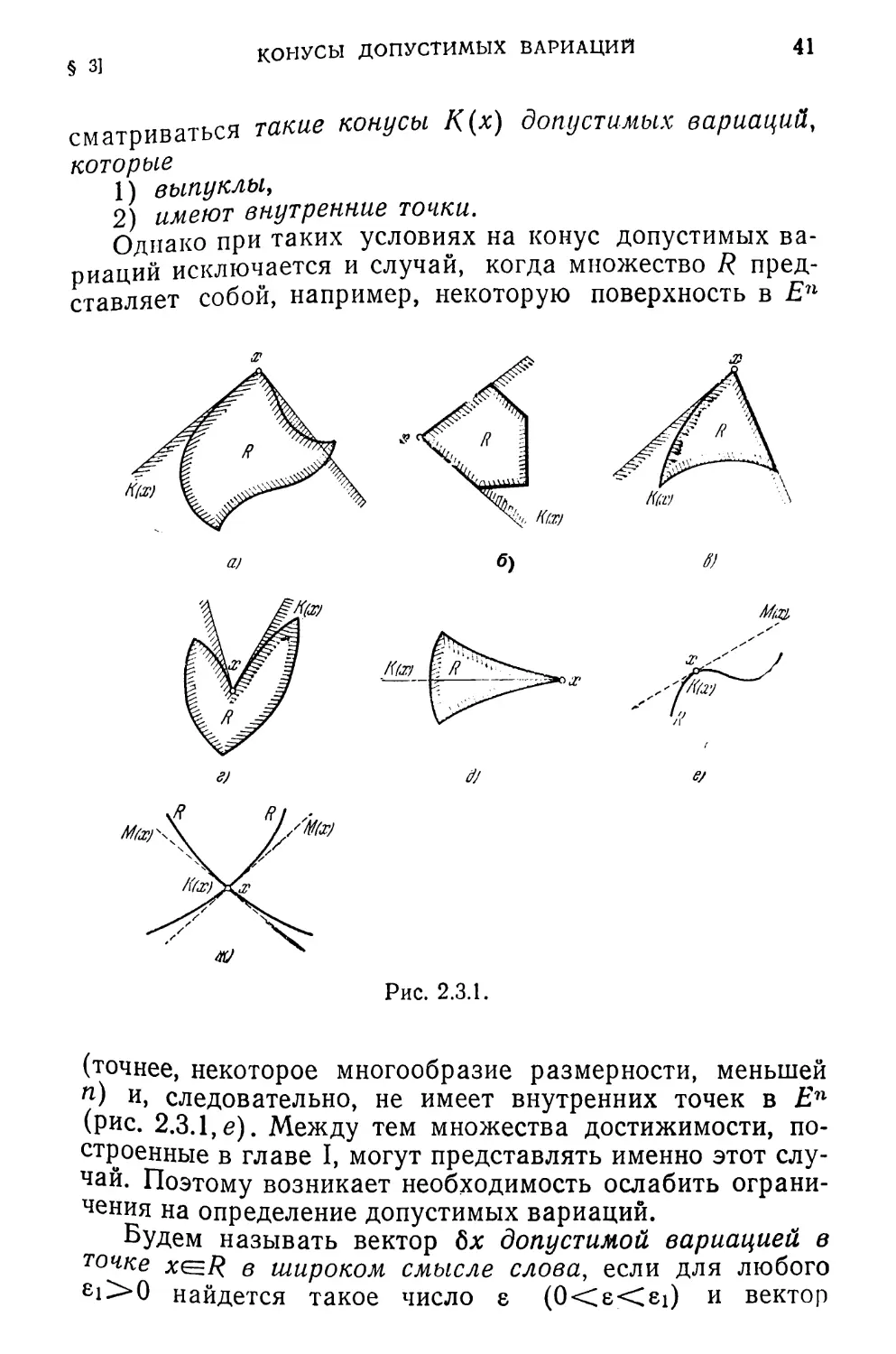

ауе5е,(бх), (где Se,(6x) —шар радиуса ei с центром

в точке бх), что л'+etae^ (см. рис. 2.3.2).

Если обозначить через v = w—8х вектор, исходящий

из начала вектора 8х (его длина, очевидно, не превосхо-

дит 81), то х+ебх+еие/?

Г XrZ при 0<е<81, где |v| <81.

у Таким образом, обобщая

несколько данное выше оп-

//I р ределение, назовем вектор

f 8х допустимым в широком

рис 232 смысле вариацией в точке

и ‘ ' x^R, если существует число

ei>0 и вектор о(е), непрерывно зависящий от 8, что

х Т8бхЦ-О(е)е/? При 0<8<8[.

Здесь и в дальнейшем через о (б) будем обозначать

величины (как векторные, так и скалярные) более высо-

кого порядка малости, чем 8, т. е. °^е- —> 0 при е->+0.

Конус допустимых в широком смысле вариаций в точ-

ке х будем обозначать через М (х):

М(х) = {6х|х+ебх+еое/?, 0<8<8i, |о| <ei, хе^}.

Можно показать, что М (х) — всегда замкнутый конус,

хотя может быть не выпуклым (рис. 2.3.1,г, ж). Если ко-

нус К(х) удовлетворяет сформулированным выше требо-

ваниям, то его замыкание совпадает с конусом А4(х)

(рис. 2.3.1, а, б, в). Если же множество R представ-

ляет гладкую гиперповерхность в пространстве Еп

(рис. 2.3.1, е), то конус М(х) —гиперплоскость, касатель-

ная к R в точке х, в то время как конус К (х) состоит

только из точки х (начала координат пространства 8Х).

Из определения конуса М(х) следует, что если

бхеМ (х), то всегда существует дуга, исходящая из точ-

ки х и целиком лежащая в R, которая дифференцируема

в точке х и для которой бх является касательным векто-

ром в этой точке.

Пусть теперь множество R задается с помощью непре-

рывно-дифференцируемых функций fj(x):

Ь(х)>0 (/=1, т).

Выберем некоторую точку х, удовлетворяющую этим не-

равенствам (по предположению такая точка существует),

КОНУСЫ ДОПУСТИМЫХ ВАРИАЦИИ

43

§ 31

и обозначим \через J(х) множество индексов из

/=1 т, при которых h(x)=0. Такие ограничения

обычно называются активными.

Of у х (dfj (х) df(x) 1

Обозначим также через —-р— = ,..., _р—

градиент функции £>(х) в этой точке.

Пусть х — граничная точка множества R (следователь-

но, множество индексов J (х) непусто). Рассмотрим мно-

жество векторов бх из пространства вариаций 8Х, удов-

летворяющих системе линейных неравенств

№^,8х\>0 (/eJ(x)). (3.1)

\ дх j

Положим 8x=z—х. Уравнение

Pfi г-х5) = 0

\ дх /

представляет собой гиперплоскость в пространстве X,

касательную к поверхности fj(x)=O в точке х. Таким об-

разом, совокупность точек, бх пространства вариаций бХ,

удовлетворяющих системе неравенств (3.1), ограничено

гиперплоскостями = 0 (j^.J (х)), пересека-

ющимися в начале координат пространства 6Х, и образу-

ет, следовательно, выпуклый конус с вершиной в начале

координат (в точке х).

Обозначим этот конус через С(х). Таким образом,

С (х) = | бх

(dfi(х), fix') > 0,

\ дх )

Наложим на него следующее условие регулярности:

существует вариация бхеС(х), при которой

МД)_;5х\>0 (3.2)

\ дх J

для всех j^J (х), т. е. конус С(х) должен иметь внутрен-

ность (следовательно, случаи типа рис. 2.3.1, д, е исклю-

чаются).

Достаточное условие для выполнения (3.2) состоит в

линейной независимости векторов dfj(x)/dx (/^7(х)).

Если конусы /((х) и С(х) удовлетворяют сформулиро-

ванным выше условиям, то можно показать, что конус

44

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

[ГЛ. п

С(х) совпадает с замыканием конуса К(х) или, что то же

самое, с конусом Af(x) (в случае, если конус Л4(х) вы-

пуклый, см. рис. 2.3.1).

Выше были наложены условия регулярности на кону,

сы допустимых направлений К(х) и Л4(х), которые обес-

печивают их эквивалентность. На само множество R ус-

ловий регулярности не налагалось.

Пусть теперь R— выпуклое множество. Потребуем,

чтобы оно имело внутренние точки, т. е. пусть существует

точка х такая, что __

Ш>0 (3.3)

для всех /=1, ..., т (условие регулярности Слейтера).

В этом случае нетрудно видеть, что условия регуляр-

ности на конусы С(х) и К(х) выполнены. Следовательно,

если множество R выпукло и удовлетворяет условию

Слейтера (или хотя бы удовлетворяет этим требованиям

в некоторой окрестности точки х), то конус С(х) совпа-

дает с замыканием конуса К(х).

§ 4. Условия оптимальности. I

Итак, конусы допустимых вариаций показывают, в ка-

ком направлении можно двигаться из точки X(=R, с тем,

чтобы получающиеся при этом новые точки были все еще

допустимыми, либо близки к ним в некотором смысле.

Выделим теперь среди допустимых вариаций точки х

подходящие, т. е. такие, которые обеспечивают возраста-

ние функции Ф(х). Назовем допустимую вариацию бх

в точке х подходящей в этой точке, если существует чис-

ло 61 >0, что

Ф(х+ебх) >Ф(х)

При ВСеХ 0<8<61.

Так как, по предположению, Ф(х) —дифференцируе-

мая функция, то

ф (х + г6х) - Ф (х) = гбФ (х) + о (г) =

= £(т-’бх) + о(£)>0- (4Л>

Следовательно, вариация 6х — подходящая, если

(4.2)

§ 4] \ УСЛОВИЯ ОПТИМАЛЬНОСТИ. I 45

Неравенство (4.2) очевидно: градиент дФ/дх показы-

вает направление наибольшего возрастания функции

ф(%) в точке х*/>если вектор 8х составляет острый угол с

градиентом, то, сделав шаг конечной длины вдоль 8х, мо-

жно увеличить значение Ф(х). Ясно, что чем больше

величина скалярного произведения (4.2) (чем острее

угол), тем на большую величину возрастает функция

Ф(х).

Очевидно, если точка х* оптимальная, то в этой точке

не может существовать подходящих допустимых вариа-

ций. С другой стороны, если в точке х* не существует под-

ходящих допустимых вариаций, то эта точка доставляет

функции Ф(х), во всяком случае, локальный максимум

(при некоторых дополнительных условиях на Ф(х*) и R

в окрестности точки х*; например, Ф(х) и R должны быть

выпуклы в некоторой окрестности точки х*). Сформули-

руем эти утверждения в виде теоремы.

Теорема 4.1. Пусть Ф(х*)—максимальное значе-

ние функции Ф(х) на множестве R. Тогда справедливо

неравенство

(4.3)

для всех 6х*е/<(х*).

Доказательство. Если конус К (х*) состоит толь-

ко из начала координат пространства 8Х, то утверждение

(4.3) тривиально. Поэтому будем считать, что существуют

ненулевые вариации 6х* из /((х*). Для доказательства

неравенства (4.3) в этом случае допустим противное.

Пусть существует допустимая вариация 6х* в точке

**(6х*е/С(х*)) такая, что

(4.4)

По определению конуса /С(х*), найдется такое ei>0, что

х*+ебх*^7? для любых 0<е<еь Из разложения (4.1)

и неравенства (4.4) следует, что можно выбрать такое е,

что Ф(х*+ебх*

**+е6х*е/?. Противоречие.

Пусть теперь множество R задано неравенствами (2.2),

и пусть точка х* — оптимальная. Построим в этой точке

)>Ф(х*) и в то же время

46

ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ

(ГЛ. И

конус допустимых вариаций С(х*). Будем/предполагать,

что он удовлетворяет условию регулярности (3.2). Тогда

можно показать (см., например, Зой/гендейк [1]),

что необходимые условия оптимальности будут иметь

следующий вид.

Теорема 4.2. Если х* — максимальное значение

функции Ф(х) при ограничениях (2.2), то

(^р,6х*)<0 (4.5)

для любых бх*, удовлетворяющих неравенствам

(df’ (х>), 8х* ) > 0, /е/(%*)• (4.6)

\ дх /

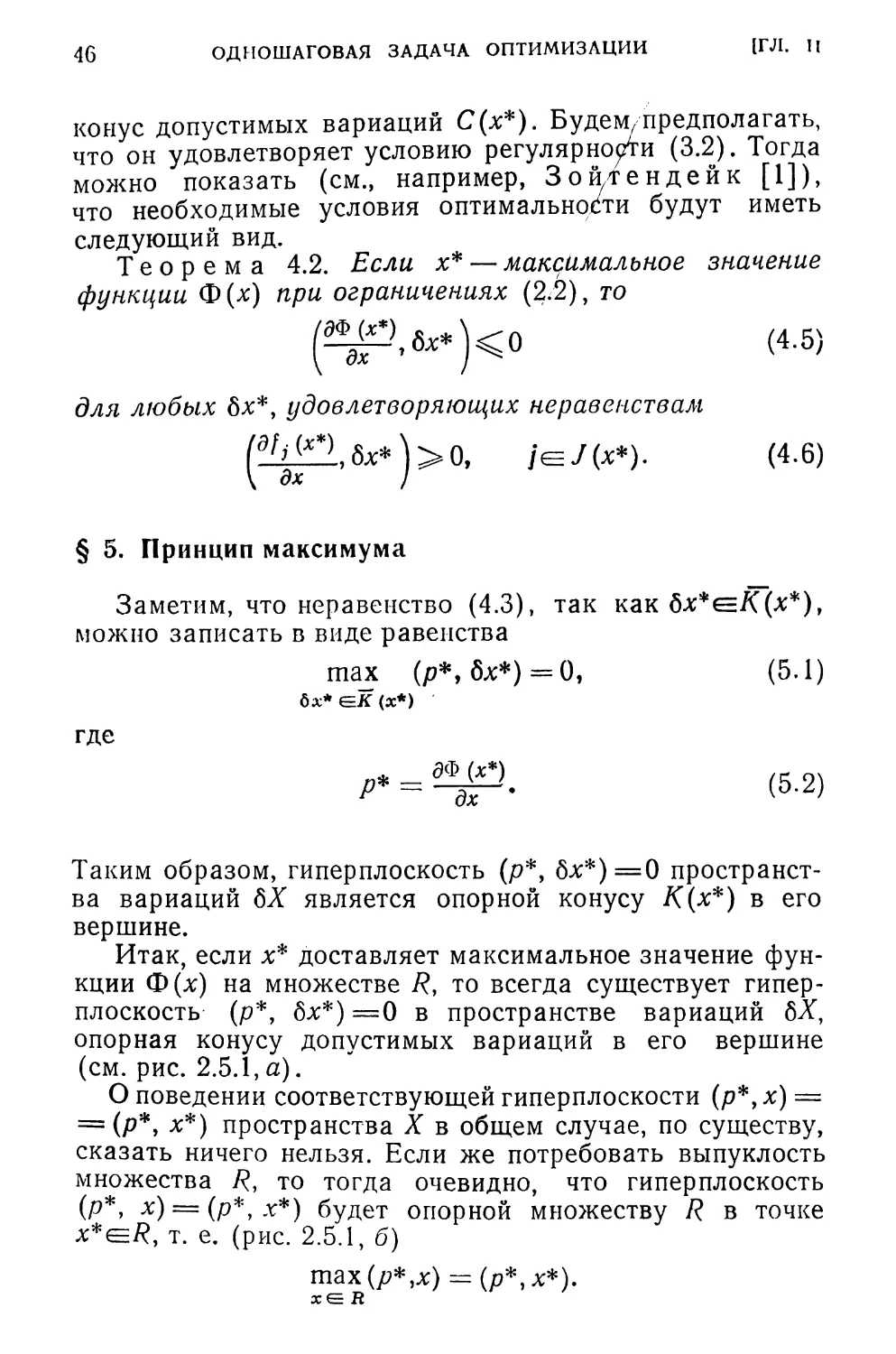

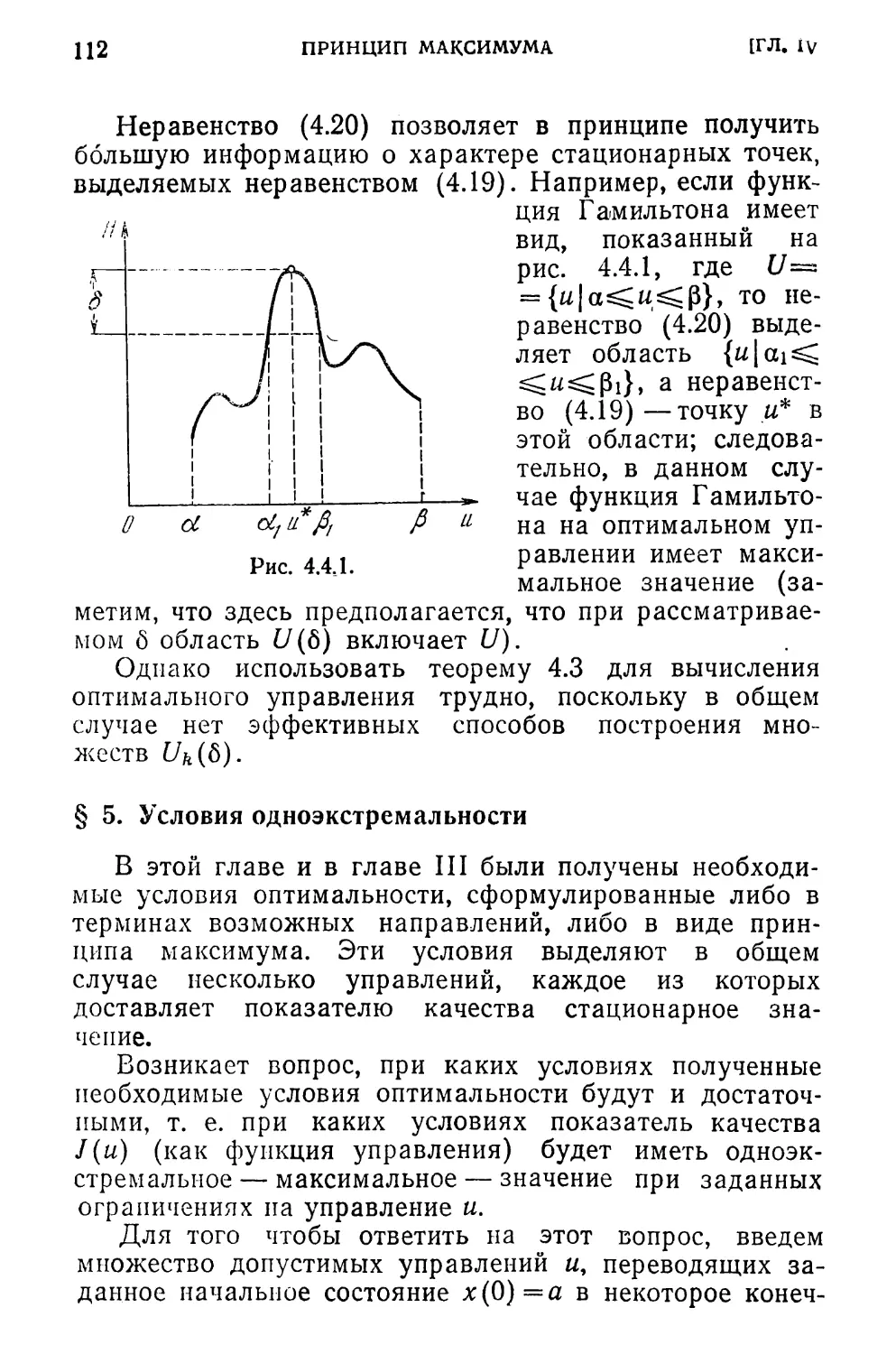

§ 5. Принцип максимума

Заметим, что неравенство (4.3), так как бх*еК(х*),

можно записать в виде равенства

ma_x (р*, бх*)=0, (5.1)

dx*GK(x*)

где

Таким образом, гиперплоскость (р*, бх*)=0 пространст-

ва вариаций 8Х является опорной конусу К(х*) в его

вершине.

Итак, если х* доставляет максимальное значение фун-

кции Ф(х) на множестве 7?, то всегда существует гипер-

плоскость (р*, бх*) =0 в пространстве вариаций 8Х,

опорная конусу допустимых вариаций в его вершине

(см. рис. 2.5.1, а).

О поведении соответствующей гиперплоскости (р*, х) =

= (р*, х*) пространства X в общем случае, по существу,

сказать ничего нельзя. Если же потребовать выпуклость

множества 7?, то тогда очевидно, что гиперплоскость

(р*, х) = (р*>х*) будет опорной множеству R в точке

х*е7?, т. е. (рис. 2.5.1, б)

шах(р*,х) = (р*,х*).

хе R

ПРИНЦИП МАКСИМУМА

47

Действительно, допустим противное. Пусть существует

ТОЧка x(=R такая, что (р*, X) > (р*, х*). Пусть 8х=х—х*,

тогда (Р*> а>х)>и\

а)

Рис. 2.5.1.

Так как множество R выпуклое, то Хх+(1—%)х* =

=х*+Лбхе/? при O^X^l. Следовательно, 8х^К(х*).

Но тогда бх — подходящая допустимая вариация

в оптимальной точке х*, что противоречит тео-

реме 4.1.

Таким образом, доказана теорема.

Теорема 5.1. Пусть функция Ф(х) в точке х* дос-

тигает максимального значения на множестве R. Тогда,

если R выпукло, в этой же точке достигает максималь-

ного значения линейная функция (р*, х), г. е.

шах (р*, х) = (р*, х*),

хев

еде вектор р* определяется из (5.2).

Заметим, что если функция Ф(х) выпукла, то в опти-

мальной точке х* гиперплоскость (р*, х) = (р*, х*) явля-

ется опорной не только к множеству R, но и к выпукло-

му множеству Q= {х|Ф(х) ^Ф(х*)}, т. е. (р*, х)^

=^(р*, х*) для всех x^R и (р*, х*) (р*, х) для всех

Таким образом, эта гиперплоскость является разделя-

ющей для выпуклых множеств R и Q.

48 ОДНОШАГОВАЯ ЗАДАЧА ОПТИМИЗАЦИИ] [ГЛ. Ц

§ 6. Условия одноэкстремальности /

Заметим, что при формулировке теоремы 5.1 не требо-

валось выпуклости функции Ф(х*). Если же ^помимо вы-

пуклости множества 7? потребовать, еще и выпуклость

вверх функции Ф (х), то в этом случае функция Ф (х) бу-

дет иметь одно экстремальное значение — максималь-

ное — на множестве 7? (хотя оно может достигаться и не

в одной точке). Очевидно, при этом необходимые условия

оптимальности, сформулированные в теоремах 4.1, 4.2,

5.1, переходят в достаточные, т. е. справедлива

Теорема 6.1. Пусть R— выпуклое множество, а

Ф(х) — выпуклая вверх функция. Тогда условия теоре-

мы 4.1 (или 5.1, что в данном случае одно и то же) до-

статочны для того, чтобы функция Ф(х) имела в точке

х* максимальное значение на множестве R. __

Действительно, пусть существует такая точка x^R,

что Ф(х)>Ф(х*). В силу выпуклости множества R

х=х+Х(х— х*)е/? при O^X^l.

В силу выпуклости функции

Ф (х) >ХФ (х) + (1—1) Ф (X*) =Ф (X*) +%[Ф (х) —Ф (х*) ]

при O^X^l.

Таким образом, в точке х* существует такая допусти-

мая вариация бх=х—х*, при которой Ф(х)>Ф(х*), т. е.

бх— подходящая вариация и, следовательно, в оптималь-

ной точке х* выполнено (4.4). Противоречие.

§ 7. Двойственность

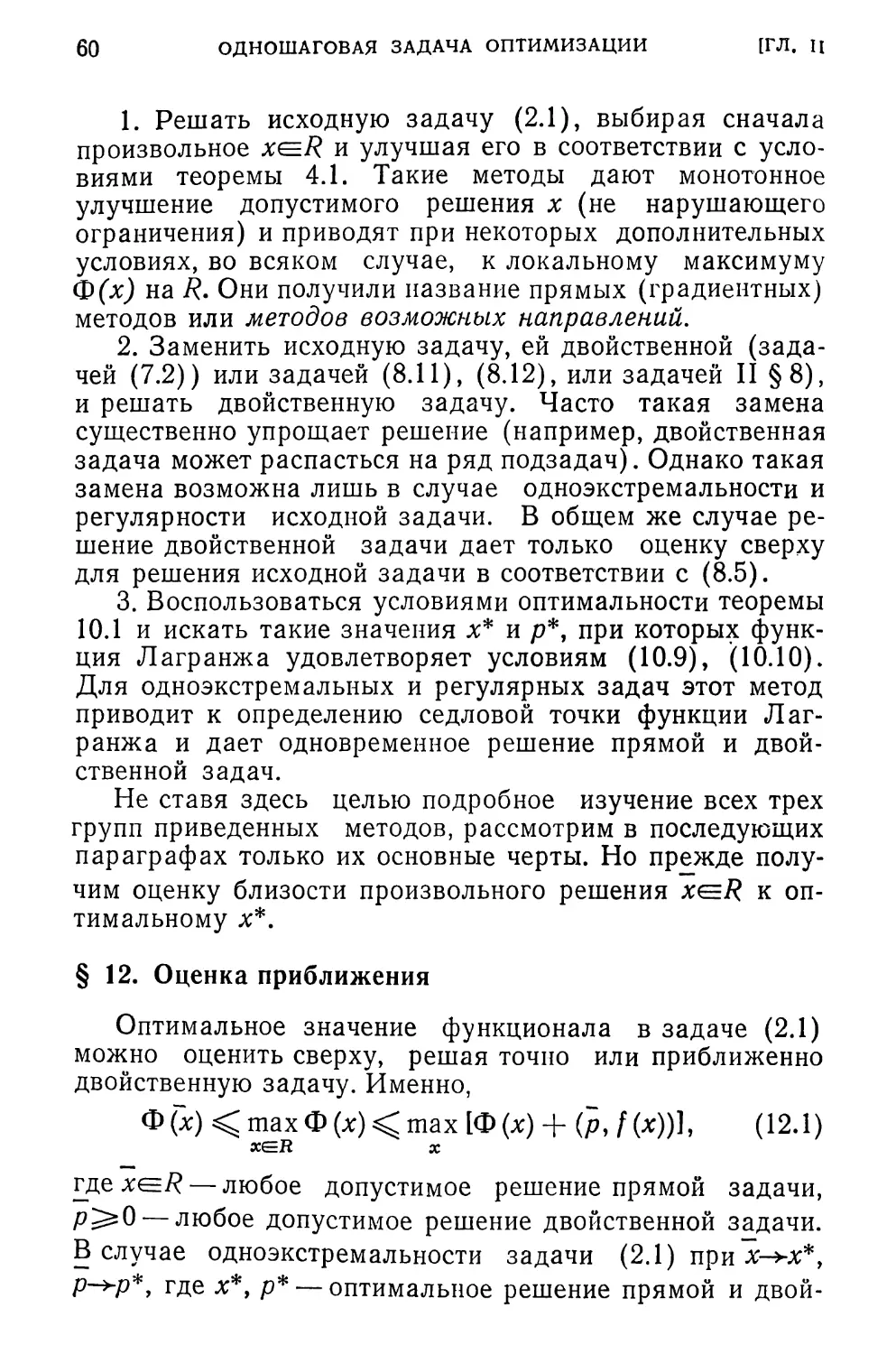

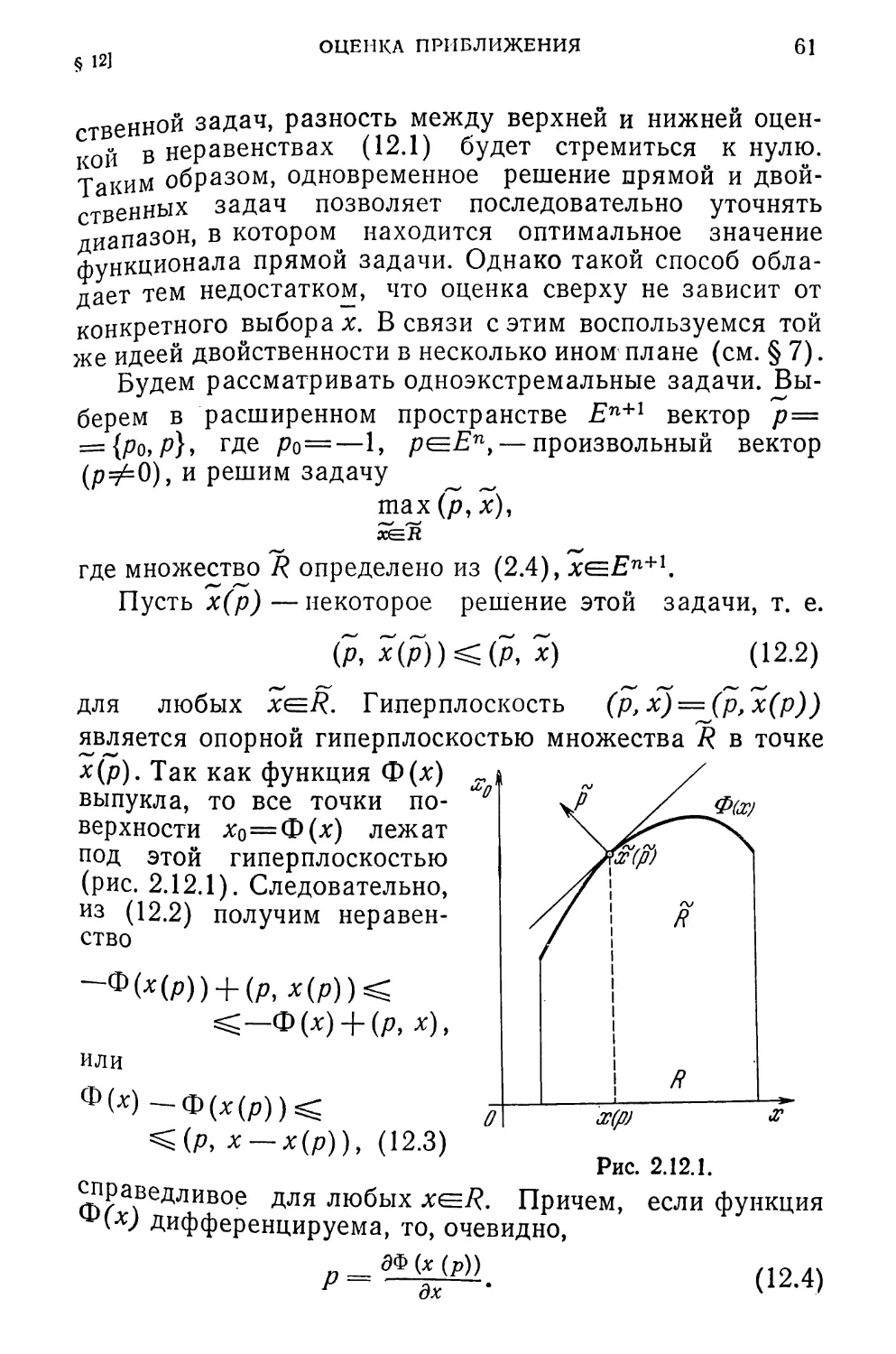

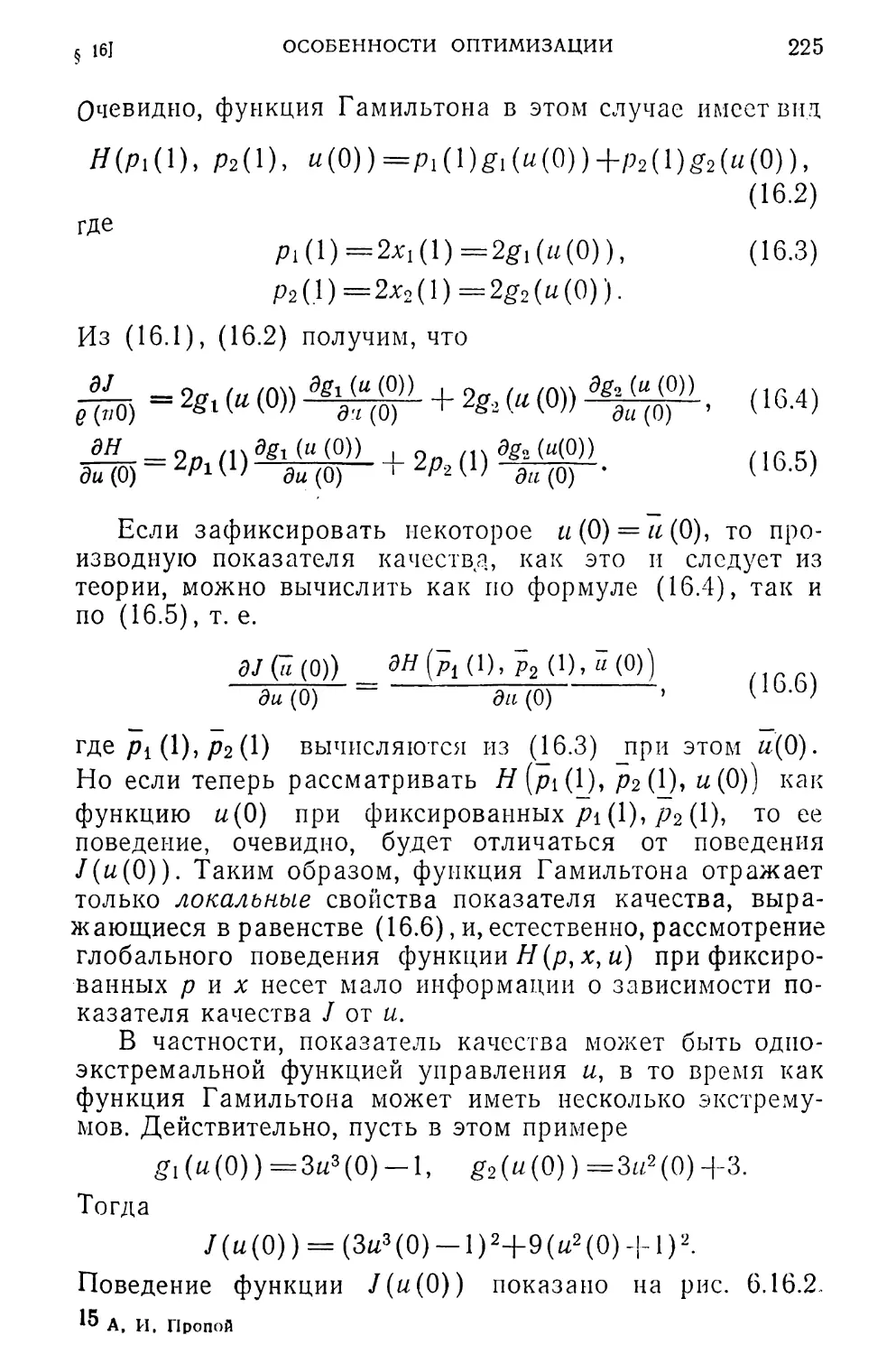

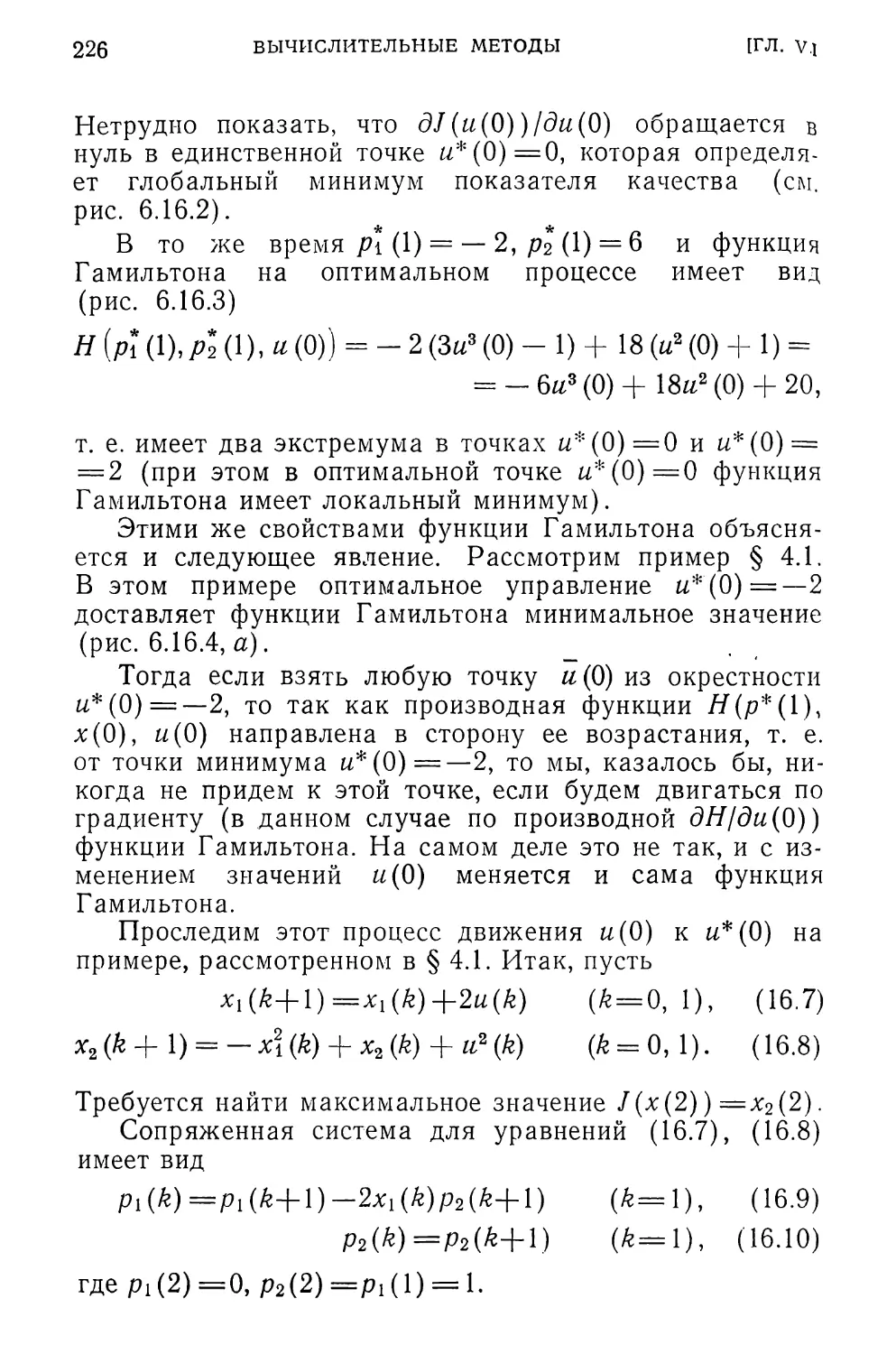

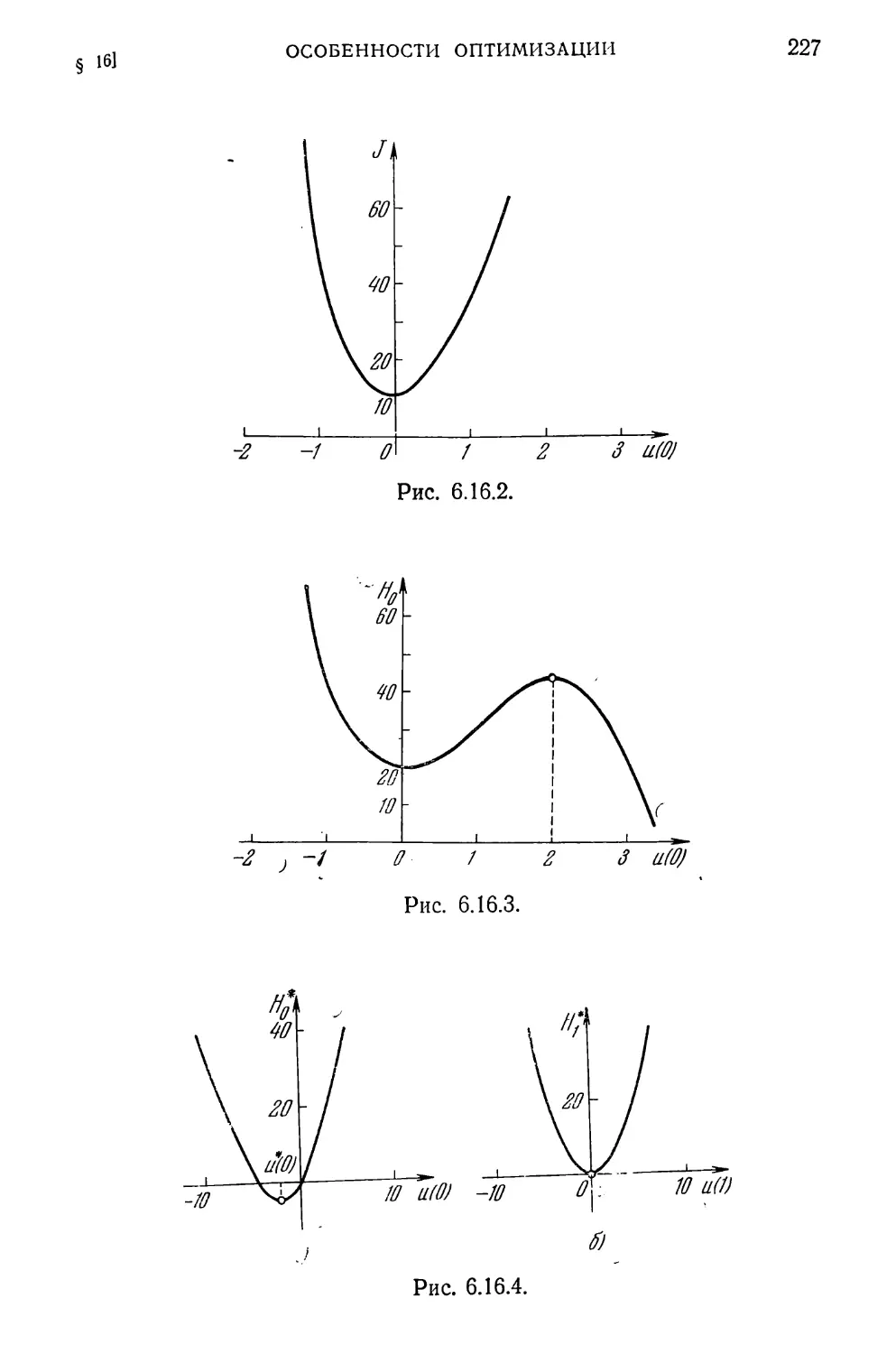

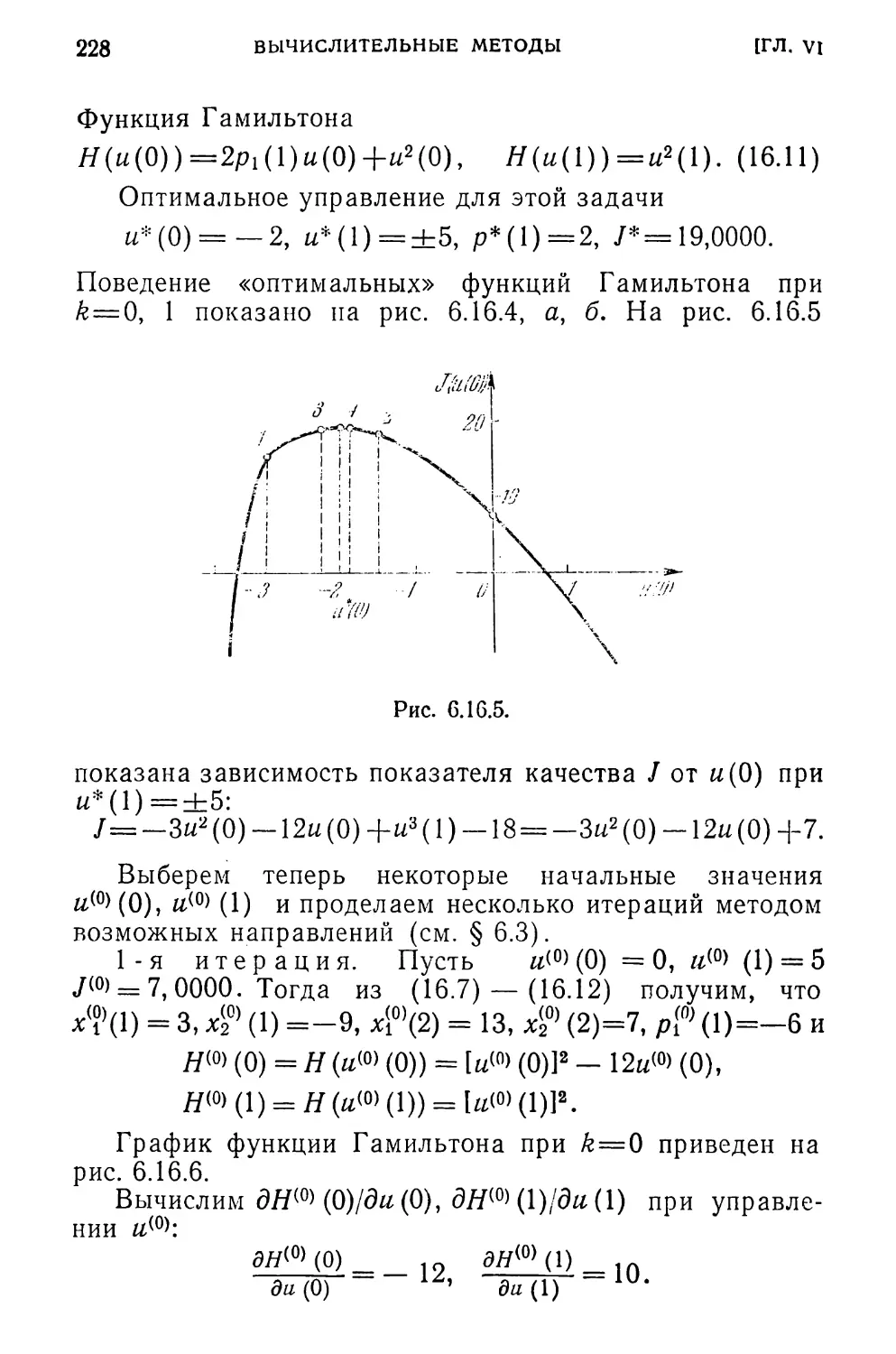

На основе полученных в предыдущих параграфах ус-