Author: Аттетков А.В. Галкин С.В. Зарубин B.C.

Tags: анализ математический анализ функциональный анализ математика

ISBN: 5-7038-1770-6

Year: 2003

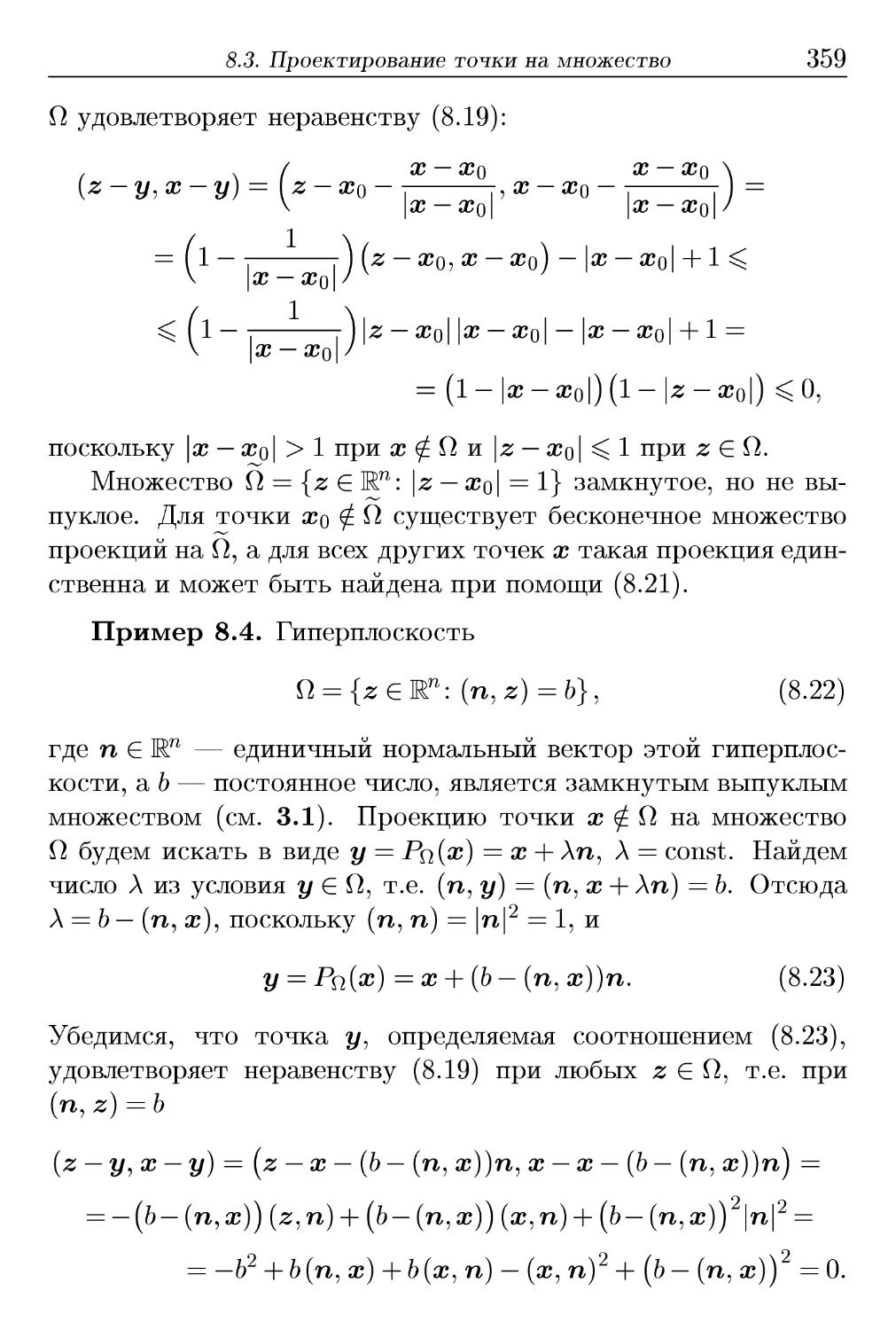

Text

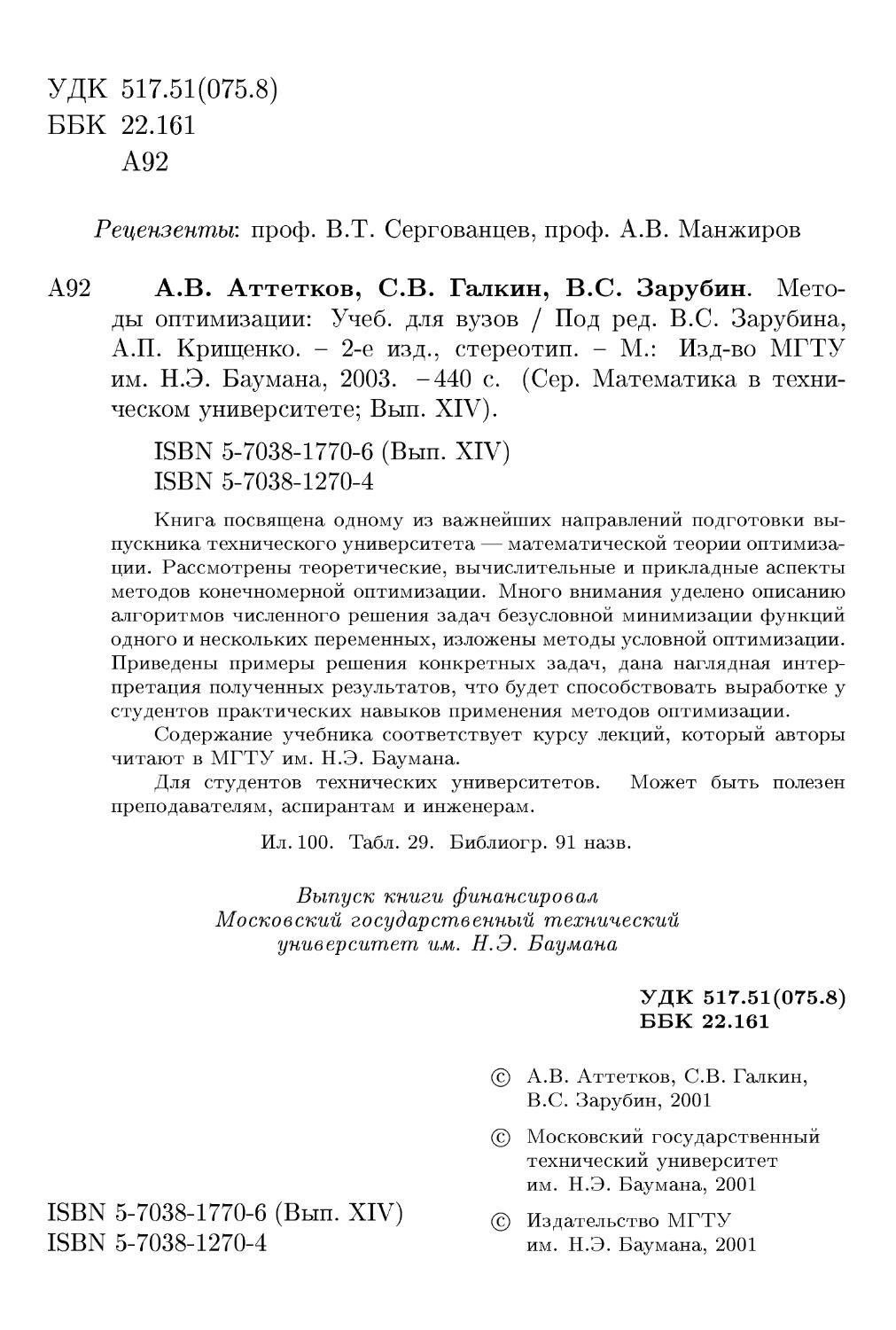

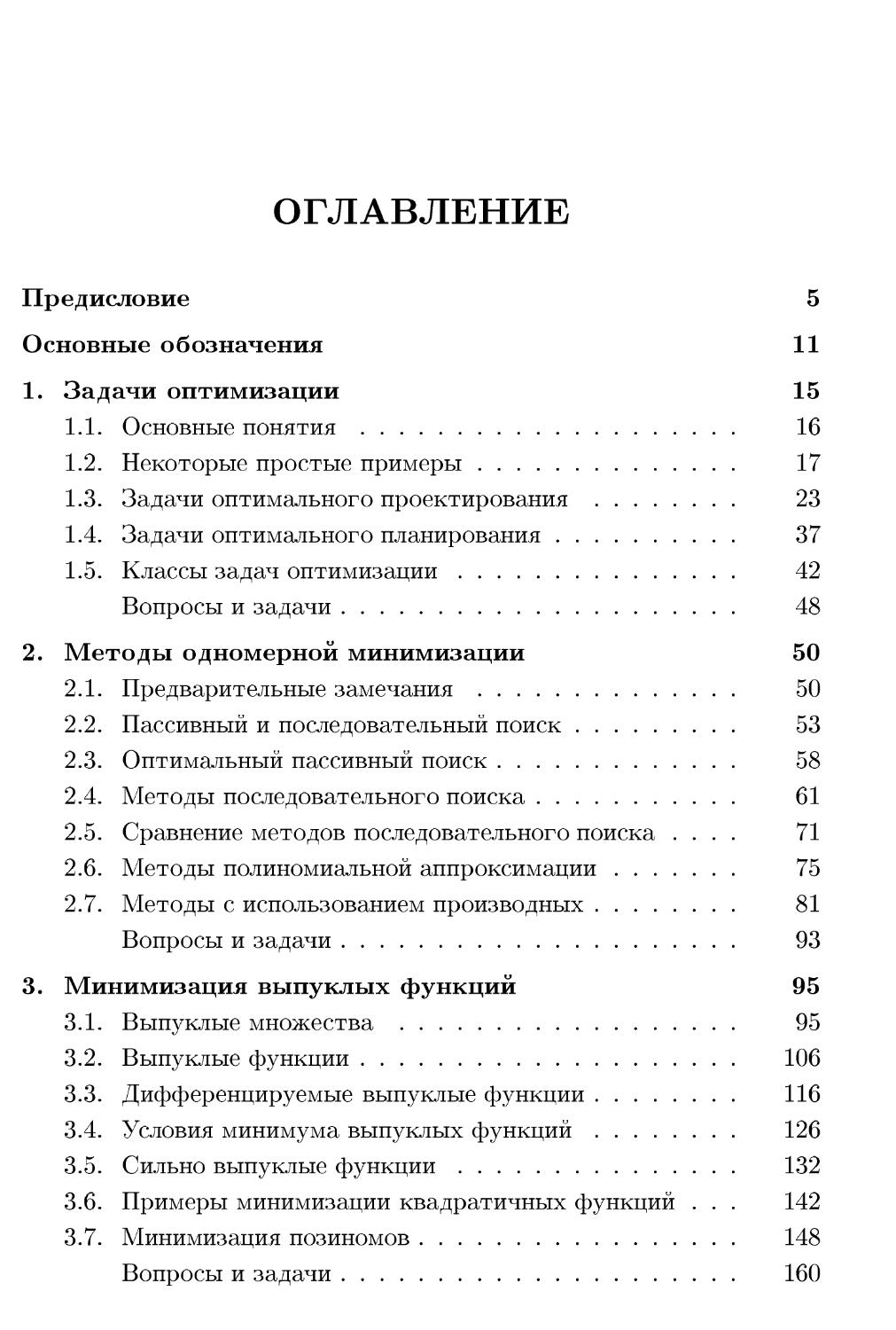

МАТЕМАТИКА

В ТЕХНИЧЕСКОМ УНИВЕРСИТЕТЕ

f(x) ->> min, х G П С IRn

XIV

А.В. Аттетков, СВ. Галкин, B.C. Зарубин

МЕТОДЫ

ОПТИМИЗАЦИИ

Издательство МГТУ им. Н. Э. Баумана

Математика в техническом

университете

Выпуск XIV

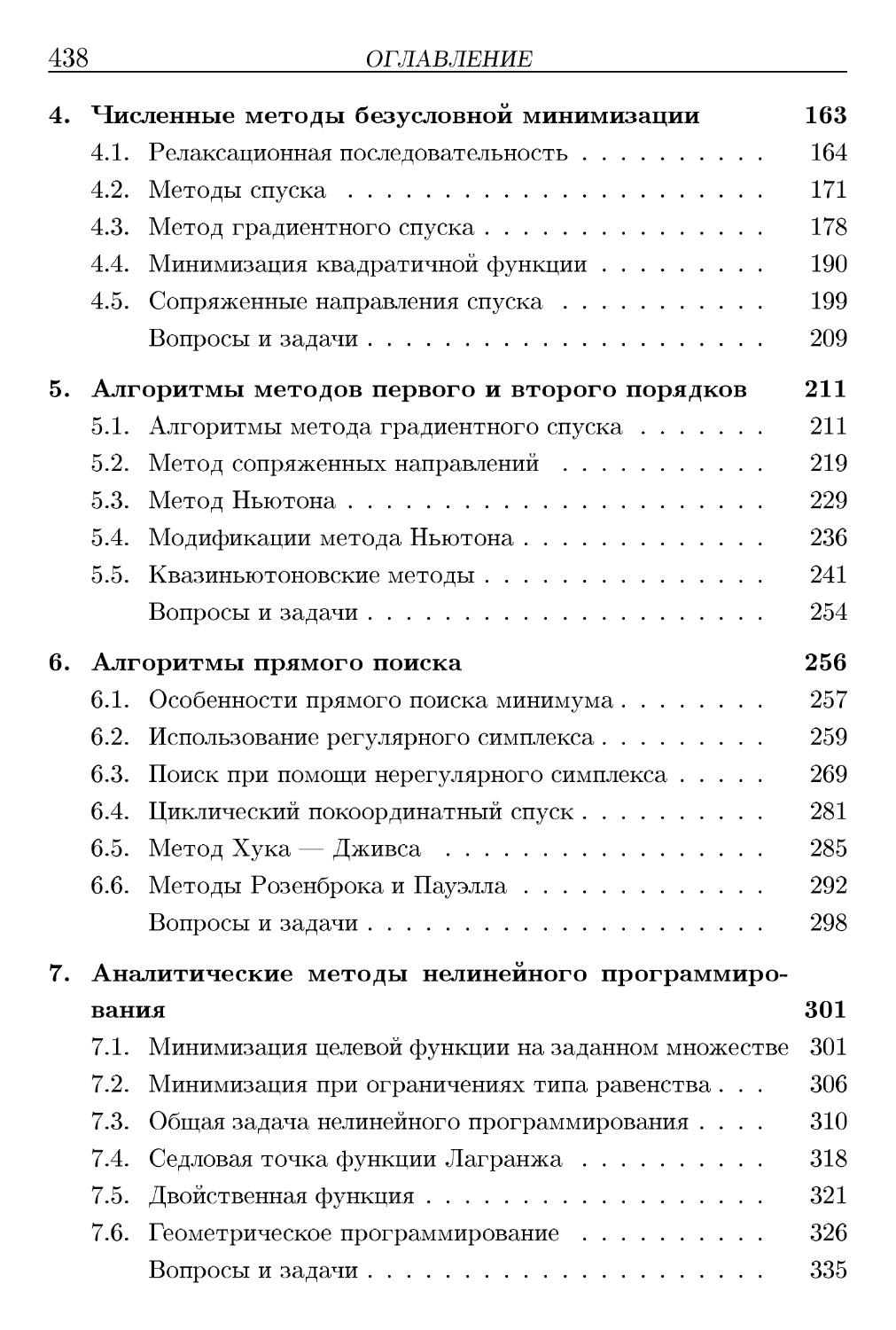

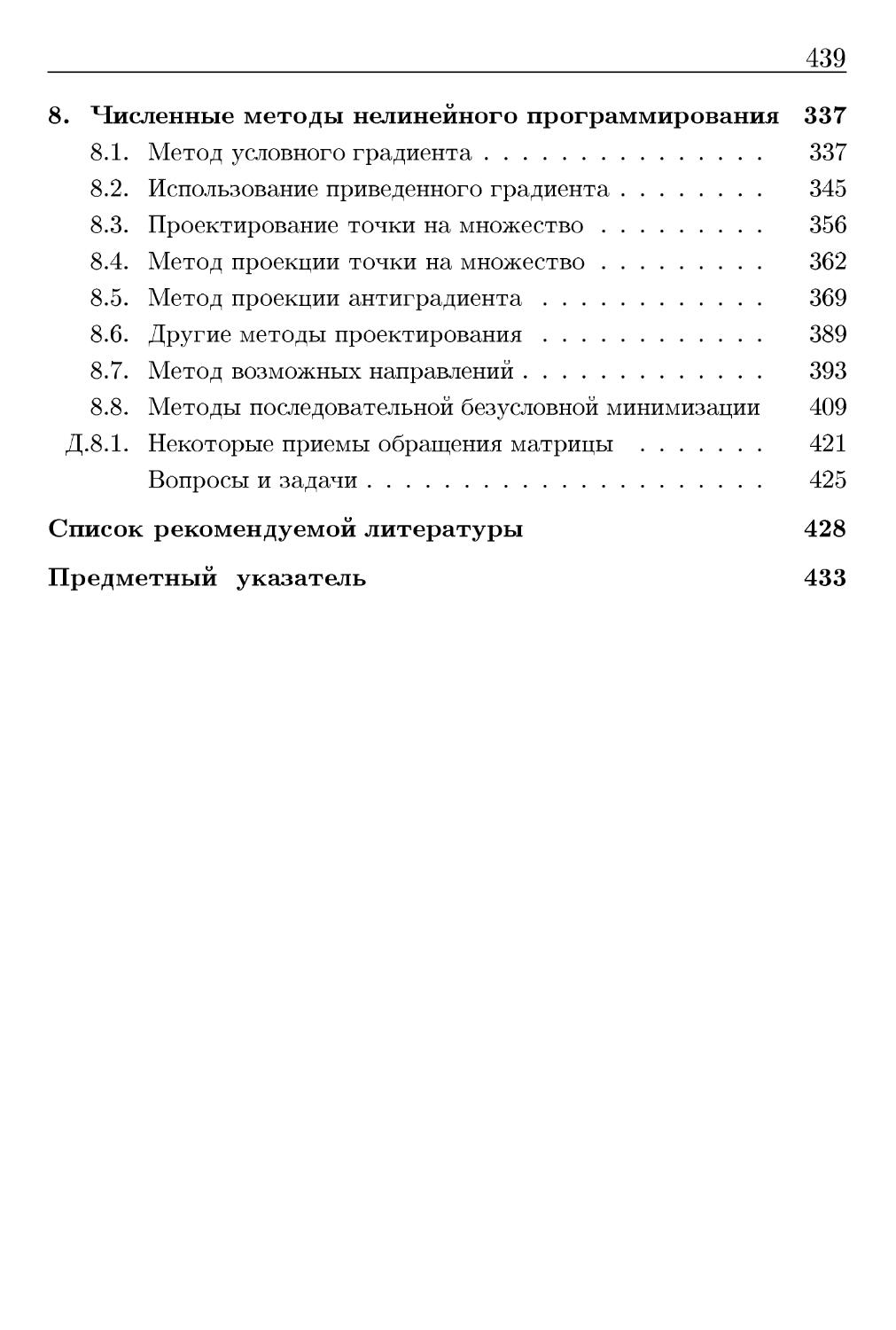

Комплекс учебников из 21 выпуска

Под редакцией В. С. Зарубина и А. П. Крищенко

I. Введение в анализ

П. Дифференциальное исчисление функций

одного переменного

III. Аналитическая геометрия

IV. Линейная алгебра

V. Дифференциальное исчисление функций

многих переменных

VI. Интегральное исчисление функций

одного переменного

VII. Кратные и криволинейные интегралы.

Элементы теории поля

VIII. Дифференциальные уравнения

IX. Ряды

X. Теория функций комплексного переменного

XI. Интегральные преобразования

и операционное исчисление

XII. Дифференциальные уравнения

математической физики

XIII. Приближенные методы математической физики

XIV. Методы оптимизации

XV. Вариационное исчисление и оптимальное управление

XVI. Теория вероятностей

XVII. Математическая статистика

XVIII. Случайные процессы

XIX. Дискретная математика

XX. Исследование операций

XXI. Математическое моделирование в технике

А.В. Аттетков, СВ. Галкин,

B.C. Зарубин

МЕТОДЫ

ОПТИМИЗАЦИИ

Под редакцией

д-ра техн. наук, профессора B.C. Зарубина

и д-ра физ.-мат. наук, профессора А.П. Крищенко

Издание второе, стереотипное

Рекомендовано

Министерством образования

Российской Федерации

в качестве учебника для студентов

высших технических учебных заведений

Москва

Издательство МГТУ им. Н. Э. Баумана

2003

УДК 517.51@75.8)

ББК 22.161

А92

Рецензенты: проф. В.Т. Сергованцев, проф. А.В. Манжиров

А92 А.В. Аттетков, СВ. Галкин, B.C. Зарубин.

Методы оптимизации: Учеб. для вузов / Под ред. B.C. Зарубина,

А.П. Крищенко. - 2-е изд., стереотип. - М.: Изд-во МГТУ

им. Н.Э. Баумана, 2003. -440 с. (Сер. Математика в

техническом университете; Вып. XIV).

ISBN 5-7038-1770-6 (Вып. XIV)

ISBN 5-7038-1270-4

Книга посвящена одному из важнейших направлений подготовки

выпускника технического университета — математической теории

оптимизации. Рассмотрены теоретические, вычислительные и прикладные аспекты

методов конечномерной оптимизации. Много внимания уделено описанию

алгоритмов численного решения задач безусловной минимизации функций

одного и нескольких переменных, изложены методы условной оптимизации.

Приведены примеры решения конкретных задач, дана наглядная

интерпретация полученных результатов, что будет способствовать выработке у

студентов практических навыков применения методов оптимизации.

Содержание учебника соответствует курсу лекций, который авторы

читают в МГТУ им. Н.Э. Баумана.

Для студентов технических университетов. Может быть полезен

преподавателям, аспирантам и инженерам.

Ил. 100. Табл. 29. Библиогр. 91 назв.

Выпуск книги финансировал

Московский государственный технический

университет им. Н.Э. Баумана

УДК 517.51@75.8)

ББК 22.161

© А.В. Аттетков, СВ. Галкин,

B.C. Зарубин, 2001

© Московский государственный

технический университет

им. Н.Э. Баумана, 2001

ISBN 5-7038-1770-6 (Вып. XIV) © издательство МГТУ

ISBN 5-7038-1270-4 им. Н.Э. Баумана, 2001

ПРЕДИСЛОВИЕ

Предлагаемая читателю книга является одним из учебников

серии „Математика в техническом университете" и

учитывает специфику математической подготовки студентов высших

технических учебных заведений.

В основу учебника положен курс лекций по методам

оптимизации, который читается на протяжении ряда лет студентам

различных специальностей МГТУ им. Н.Э. Баумана, а также

опыт проведения семинарских и лабораторных занятий по

этому курсу.

Этот выпуск серии целиком посвящен конечномерным

задачам оптимизации. Основное внимание уделено прикладным

и вычислительным аспектам оптимизации, связанным с

разработкой численных методов решения задач оптимизации и

построением алгоритмов их реализации. В книге отсутствуют

доказательства сходимости методов (исключение сделано лишь

для некоторых методов). Существует обширная литература по

этим вопросам, и „математические тонкости" доказательств

сходимости можно изучить самостоятельно с использованием

рекомендуемой литературы. В инженерной практике важнее

понимание сути методов и алгоритмов их реализации,

знание условий их применения, примеры и иллюстрации решения

типовых инженерных задач оптимизации. Наличие

большого количества примеров и задач, поясняемых графическими

иллюстрациями и интерпретацией полученных результатов,

позволяет использовать данную книгу не только как учебник, но

и как задачник при проведении семинарских и лабораторных

занятий.

Содержание учебника относится к специальным разделам

высшей математики и для работы с ним требуется хорошее

знание базового курса. В частности, предполагается, что читатель

6

ПРЕДИСЛОВИЕ

умеет оперировать основными понятиями линейной алгебры,

аналитической геометрии, теории матриц и математического

анализа.

В конце книги приведен список рекомендуемой литературы,

в который включены все цитированные источники. Ссылки в

тексте на литературу даны в виде подстрочных сносок, в

которых указаны фамилии авторов соответствующего издания. В

предметный указатель входят в алфавитном порядке (по

существительному в именительном падеже) все выделенные в тексте

полужирным курсивом термины с указанием страниц, на

которых они строго определены или описаны. Выделение

термина светлым курсивом означает, что в данном параграфе он

является одним из ключевых слов и читателю должно быть

известно значение этого термина (его можно уточнить, найдя при

помощи предметного указателя необходимую страницу).

Ссылки в тексте на номера формул, рисунков и таблиц

набраны обычным шрифтом (например, A.5) — пятая формула в

главе 1, рис. 3.1 — первый рисунок в главе 3, табл. 3.2 — вторая

таблица в главе 3), а на параграфы — полужирным (например,

1.3 — третий параграф в главе 1). В квадратных скобках

даны ссылки на другие выпуски данной серии (например, [XV] —

ссылка на пятнадцатый выпуск).

Для самоконтроля предлагаем читателю ознакомиться с

заданиями для самопроверки. В этих заданиях понятия и

термины, которые нужно знать, выделены прямым полужирным

шрифтом. После заданий для самопроверки помещен

список основных обозначений, содержащий часто встречающиеся

в тексте символы и их расшифровку.

Задания для самопроверки

1. Какие множества называют: замкнутыми,

открытыми, ограниченными, компактными? Что такое диаметр

и внутренность множества? [I]

7

2. Что такое центр и радиус окрестности точки? Что

называют отрезком, вложенным в данный отрезок? [I]

3. Из каких этапов состоят доказательства от

противного и по методу математической индукции? [I]

4. Что называют монотонной, строго монотонной,

возрастающей, убывающей, неубывающей и невозраста-

ющей последовательностями? Что такое

подпоследовательность и предельная точка последовательности? [I]

5. Что называют функцией, убывающей,

возрастающей, неубывающей и невозрастающей в промежутке

числовой прямой? Приведите примеры функций,

непрерывных в интервале (а, Ь) или в полуинтервале [а, 6), но не

являющихся непрерывными на отрезке [а, Ь]. Перечислите

свойства функции, непрерывной на отрезке. В чем различие

между точками разрыва первого и второго рода? [I]

6. Дайте определение точной верхней (нижней) грани

функции многих переменных (одного переменного) на

открытом, замкнутом множестве. В чем различие между min/(i)

Hinf/Oc)? [I], [V]

7. Каков смысл символов по малое" и пО большое"? [I]

8. Сформулируйте теоремы Ферма и Лагранжа,

напишите формулу конечных приращений. Что называют

точкой строгого локального экстремума функции одного

переменного? Сформулируйте необходимые и достаточные

условия экстремума такой функции. В чем различие между

локальным экстремумом и наибольшим (наименьшим)

значением этой функции на отрезке? [II]

9. Как проверить, является ли функция одного

действительного переменного выпуклой (строго выпуклой) вниз

(вверх) функцией? Сколько экстремумов может иметь

выпуклая (строго выпуклая) функция одного переменного на

отрезке? [II]

10. В каких точках отрезка линейная функция достигает

своих наибольшего и наименьшего значений? Как найти

точку экстремума квадратного трехчлена в интервале? [II]

8

ПРЕДИСЛОВИЕ

11. Что называют сходимостью метода вычислений и

порядком его сходимости? Запишите условия, при выполнении

которых скорость сходимости метода является линейной,

сверхлинейной, квадратичной, кубической. [II]

12. Какую матрицу называют диагональной,

единичной, симметрической, нулевой, блочной,

транспонированной по отношению к данной? Что называют

определителем квадратной матрицы, ее угловыми минорами,

невырожденной (вырожденной) матрицей? Каковы правила

разложения определителя по строке (по столбцу)?

Сформулируйте необходимое и достаточное условия существования

у квадратной матрицы обратной матрицы. Как связаны

между собой определители этих матриц? Что называют

рангом матрицы, базисным минором матрицы? Что такое

нетривиальная линейная комбинация строк (столбцов)

матрицы? [Ш], [IV]

13. В чем различие между координатной, векторной и

матричной записью системы линейных алгебраических

уравнений (СЛАУ)? Какую СЛАУ называют совместной,

неопределенной, квадратной? Чем отличаются прямые

методы решения СЛАУ от итерационных? [III]

14. Что такое линейное, линейное арифметическое,

евклидово, метрическое и нормированное пространства?

Перечислите аксиомы скалярного умножения. Как

связаны между собой скалярное произведение, норма и

метрика? Запишите неравенство Коши — Буняковского. [IV]

15. Что такое линейный оператор, матрица

линейного оператора? Как записать матрицу линейного оператора в

различных базисах? Что такое ортонормированный базис,

ортогональный и самосопряженный операторы? Какие

матрицы соответствуют этим операторам? Каковы свойства

собственных векторов и собственных значений этих

операторов в конечномерном линейном пространстве? Что

такое характеристическое уравнение матрицы и ее

собственные значения? [IV]

9

16. Что такое линейная и квадратичная формы,

матрица квадратичной формы? Обоснуйте процесс

приведения квадратичной формы к каноническому виду ссылкой

на соответствующие теоремы линейной алгебры. Какую

квадратичную форму и какую матрицу называют положительно

(отрицательно) определенной? Сформулируйте критерий

Сильвестра. Какую квадратичную форму называют

неположительно (неотрицательно) определенной,

знакопеременной? [IV]

17. Напишите формулу Тейлора с остаточным

членом в форме Лагранжа и Пеано для функции одного

действительного переменного и для функции многих

переменных. [II], [V]

18. Какую функцию многих переменных называют

непрерывной по совокупности переменных и непрерывной по

части переменных? Что такое линия (или поверхность)

уровня такой функции? Что называют координатными

функциями векторной функции многих переменных и ее

матрицей Якоби по всем или по части переменных? [V]

19. Что такое градиент функции многих переменных,

матрица Гессе? Запишите приращения дифференцируемой и

дважды дифференцируемой функции, используя эти понятия.

Сформулируйте теорему о неявной функции и теорему

об обратной функции. [V]

20. Что такое производная функции многих

переменных по направлению вектора и как она связана с

градиентом функции? Имеет ли дифференцируемая функция многих

переменных производные по всем направлениям? Верно ли

обратное? [V]

21. Какие условия надо наложить на производную

функции многих переменных по направлению, чтобы можно было

утверждать, что: а) функция непрерывна; б) функция

дифференцируема? Приведите примеры. [V]

22. В чем различие между точкой экстремума и

критической или стационарной точками скалярной функции

10

ПРЕДИСЛОВИЕ

многих переменных? Что называют строгим (нестрогим)

локальным экстремумом такой функции? [V]

23. Сформулируйте необходимые условия экстремума

скалярной функции многих переменных: а) с использованием

частных производных функции; б) с использованием градиента

функции. [V]

24. Сформулируйте достаточные условия экстремума

функции многих переменных с использованием: а) понятия

знакоопределенности второго дифференциала функции; б)

главных миноров матрицы Гессе; в) собственных чисел матрицы

Гессе. Приведите примеры. [V]

25. Может ли линейная функция многих переменных

достигать экстремума внутри замкнутой области? Может ли

квадратичная функция многих переменных достигать

экстремума внутри замкнутой области, как найти точку

экстремума? Приведите пример. [V]

26. Что называют условным экстремумом функции

многих переменных и уравнениями связи? Как найти точки

условного экстремума? Что такое множители Лагранжа

и функция Лагранжа? [V]

27. Напишите формулу Ньютона — Лейбница. [VI]

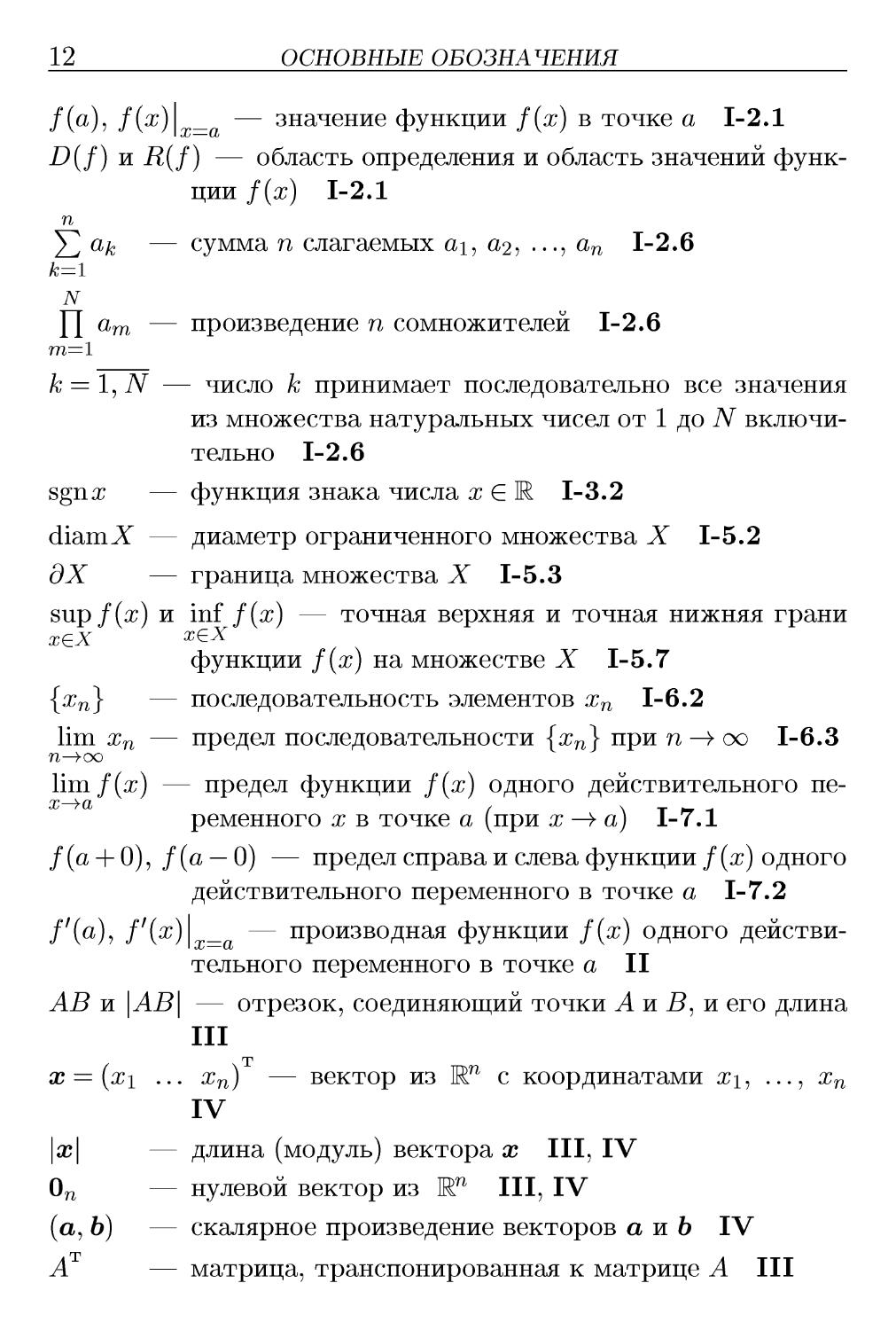

ОСНОВНЫЕ ОБОЗНАЧЕНИЯ

<4 и > — начало и окончание доказательства

Ф — окончание примера, замечания

a G А — элемент а принадлежит множеству А 1-1.1

а ^ В — элемент а не принадлежит множеству В 1-1.1

{аг}^=1 — множество из элементов ai, a2, ..., a/v 1-1.1

AG В — множество А является подмножеством множества В

1-1.2

N — множество натуральных чисел 1-1.2

Z — множество целых чисел 1-1.3

Ш — множество действительных чисел 1-1.3

1R+ — множество положительных действительных чисел

1.5

R* — множество неотрицательных действительных чисел

1.5

W1 — (декартово) произведение п множеств

действительных чисел или n-мерное евклидово арифметическое

пространство 1-2.5, IV

]Щ_ — (декартово) произведение п множеств IR+

положительных действительных чисел 1.5

Щ — (декартово) произведение п множеств R*

неотрицательных действительных чисел 1.5

[а, Ь] и (а, Ь) — отрезок и интервал с концами в точках а и b

1-1.3

[a, 6), (a, b] — полуинтервалы с концами в точках а и b 1-1.3

V и 3 — квантор всеобщности (\/ж — для любого х) и

квантор существования (Зх — существует х) 1-1.5

/: X —)> Y — отображение / множества X в множество Y

1-2.1

12

ОСНОВНЫЕ ОБОЗНАЧЕНИЯ

/(a), f(x)\ _ — значение функции f(x) в точке а 1-2.1

D(f) и R(f) — область определения и область значений

функции f(x) 1-2.1

п

^2 о-к — сумма п слагаемых ах, a2, ..., an 1-2.6

N

Y\ dm — произведение n сомножителей 1-2.6

m=l

к = 1, N — число к принимает последовательно все значения

из множества натуральных чисел от 1 до N

включительно 1-2.6

sgnrr — функция знака числа жЕ1 1-3.2

diamX — диаметр ограниченного множества X 1-5.2

дХ — граница множества X 1-5.3

sup f{x) и inf f(x) — точная верхняя и точная нижняя грани

хех хех

функции f(x) на множестве X 1-5.7

{хп} — последовательность элементов хп 1-6.2

lim хп — предел последовательности {хп\ при п —>> оо 1-6.3

п—)>оо

lim f(x) — предел функции f(x) одного действительного пе-

ременного ж в точке а (при ж —>> а) 1-7.1

/(а + 0), /(а — 0) — предел справа и слева функции /(ж) одного

действительного переменного в точке а 1-7.2

/7(а), /7(ж)| _ — производная функции f(x) одного

действительного переменного в точке а II

АВ и \АВ\ — отрезок, соединяющий точки А и В, и его длина

III

т

х = {х\ ... жп) — вектор из W1 с координатами жх, ..., хп

IV

|ж| — длина (модуль) вектора х III, IV

0П — нулевой вектор из W1 III, IV

(а, Ь) — скалярное произведение векторов а и Ь IV

А — матрица, транспонированная к матрице А III

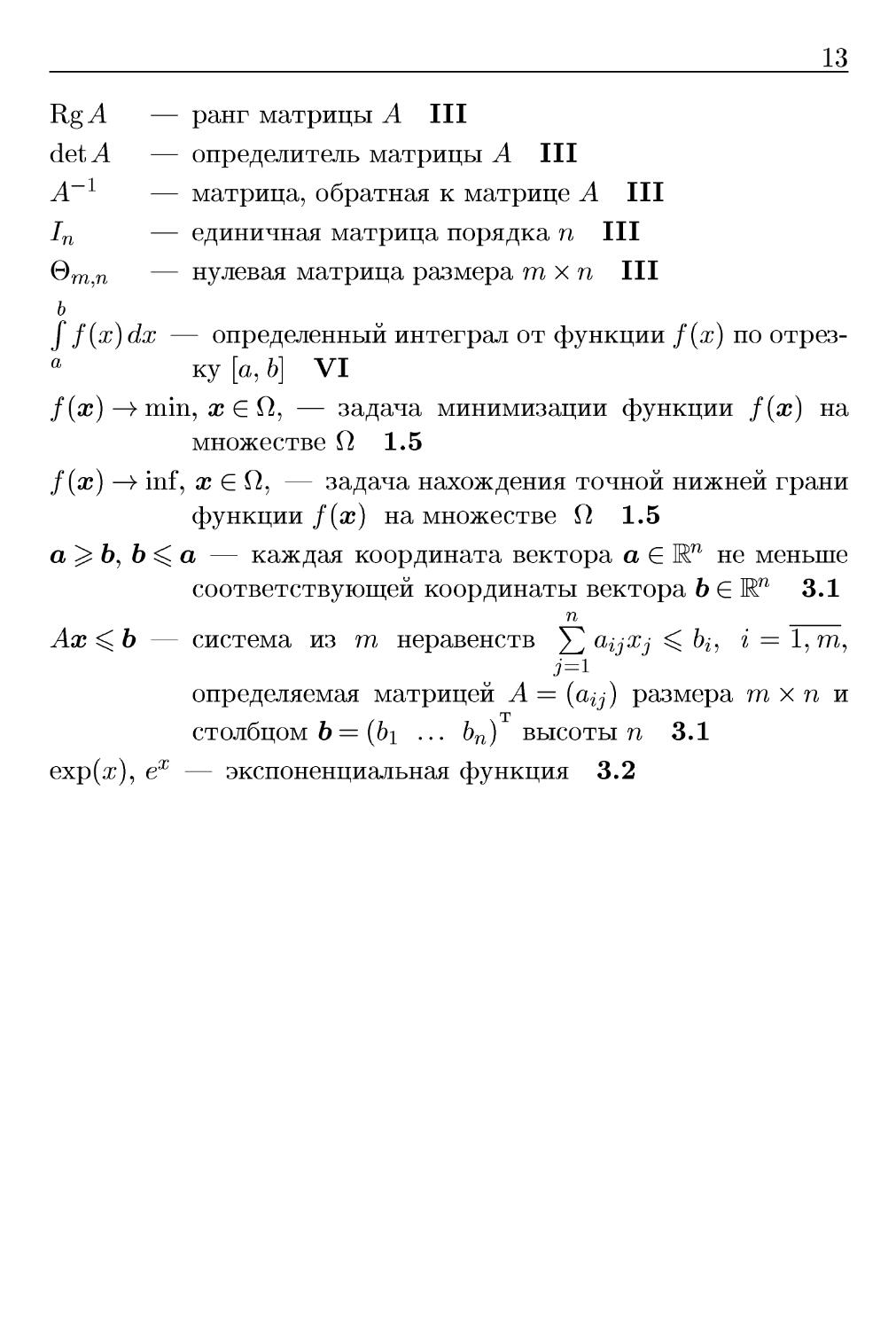

13

Kg А — ранг матрицы А III

detA — определитель матрицы А III

А~г — матрица, обратная к матрице А III

1п — единичная матрица порядка п III

®т,п — нулевая матрица размера т х п III

ь

f f(x)dx — определенный интеграл от функции f(x) по

отрезку [а, Ь] VI

f(x) —>> min, х Е О, — задача минимизации функции f(x) на

множестве О 1.5

f(x) —>> inf, жЕО, — задача нахождения точной нижней грани

функции f(x) на множестве О 1.5

а^Ъ^Ъ^а — каждая координата вектора а Е Кп не меньше

соответствующей координаты вектора b Е Rn 3.1

п

Ах ^Ъ — система из т неравенств ^ aijxj ^ ^ь i = 1,т,

определяемая матрицей А = (а^) размера ттг х п и

т

столбцом b = (&i ... Ьп) высоты п 3.1

ехр(ж), еж — экспоненциальная функция 3.2

14

ОСНОВНЫЕ ОБОЗНАЧЕНИЯ

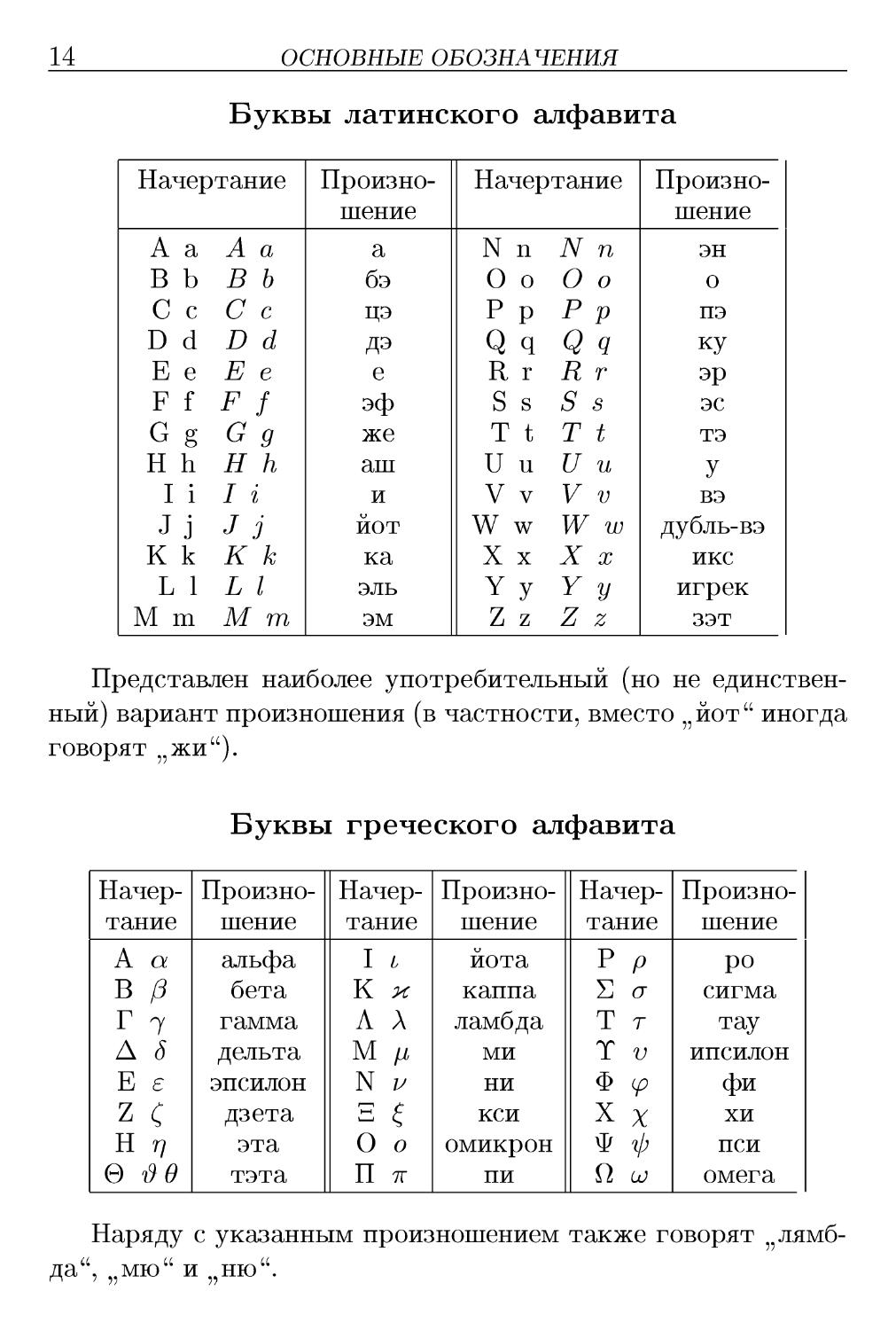

Буквы латинского алфавита

Начертание

А а

В b

С с

D d

Е е

F f

G g

Н h

I i

Jj

К k

L 1

M m

A a

В b

С с

D d

E e

F f

G g

H h

I i

J 3

К к

L I

M m

Произношение

a

бэ

цэ

ДЭ

e

эф

же

аш

и

йот

ка

эль

эм

Начертание

N п

О о

Р р

Q q

R г

S s

Т t

U и

V v

W w

X х

Y у

Z z

N п

О о

Р р

Q q

R г

S s

Т t

U и

V v

W w

X х

Y у

Z z

Произношение

эн

о

пэ

ку

эр

эс

тэ

У

вэ

дубль-вэ

икс

игрек

зэт

Представлен наиболее употребительный (но не

единственный) вариант произношения (в частности, вместо „йот" иногда

говорят 55жи").

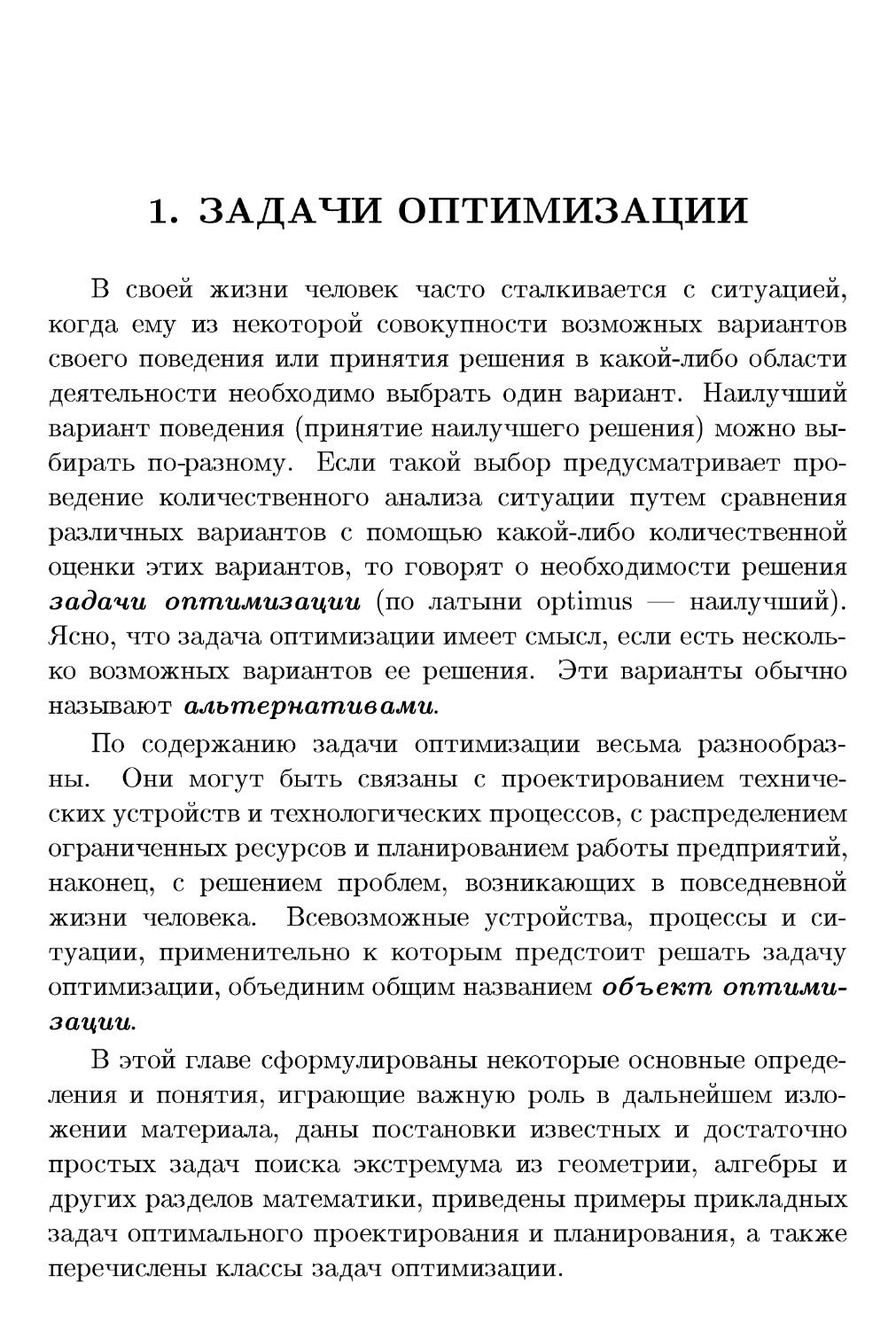

Буквы греческого алфавита

Начертание

А а

В /3

Г 7

A S

Е е

z С

Н г/

е $в

Произношение

альфа

бета

гамма

дельта

эпсилон

дзета

эта

тэта

Начертание

I L

К Ж

А А

М /i

N v

Е z

О о

П 7Г

Произношение

йота

каппа

ламбда

ми

ни

кси

омикрон

пи

Начертание

Р р

S а

Т т

Т v

Ф ip

X х

ф ф

О L0

Произношение

ро

сигма

тау

ипсилон

фи

хи

пси

омега

Наряду с указанным произношением также говорят

„лямбда", „мю" и „ню".

1. ЗАДАЧИ ОПТИМИЗАЦИИ

В своей жизни человек часто сталкивается с ситуацией,

когда ему из некоторой совокупности возможных вариантов

своего поведения или принятия решения в какой-либо области

деятельности необходимо выбрать один вариант. Наилучший

вариант поведения (принятие наилучшего решения) можно

выбирать по-разному. Если такой выбор предусматривает

проведение количественного анализа ситуации путем сравнения

различных вариантов с помощью какой-либо количественной

оценки этих вариантов, то говорят о необходимости решения

задачи оптимизации (по латыни optimus — наилучший).

Ясно, что задача оптимизации имеет смысл, если есть

несколько возможных вариантов ее решения. Эти варианты обычно

называют альтернативами.

По содержанию задачи оптимизации весьма

разнообразны. Они могут быть связаны с проектированием

технических устройств и технологических процессов, с распределением

ограниченных ресурсов и планированием работы предприятий,

наконец, с решением проблем, возникающих в повседневной

жизни человека. Всевозможные устройства, процессы и

ситуации, применительно к которым предстоит решать задачу

оптимизации, объединим общим названием объект

оптимизации.

В этой главе сформулированы некоторые основные

определения и понятия, играющие важную роль в дальнейшем

изложении материала, даны постановки известных и достаточно

простых задач поиска экстремума из геометрии, алгебры и

других разделов математики, приведены примеры прикладных

задач оптимального проектирования и планирования, а также

перечислены классы задач оптимизации.

16

1. ЗАДАЧИ ОПТИМИЗАЦИИ

1.1. Основные понятия

Обычно человек хочет сделать „как лучше", но, чтобы не

получить плохой результат при самых хороших намерениях,

для решения задачи оптимизации нужно прежде всего найти

ответы на следующие вопросы:

- Что значит „лучше"?

- Что конкретно нужно улучшить?

- За счет чего можно добиться улучшения, что можно

изменить?

- В каких пределах можно производить изменения?

Отвечая на первый вопрос, необходимо сформулировать

критерий оптимальности, т.е. определить те признаки и

предпочтения, по которым следует провести сравнительную

оценку альтернатив и выбрать среди них наилучшую с точки

зрения поставленной цели оптимизации. Именно с этой точки

зрения можно ответить на второй вопрос: что конкретно

нужно улучшить? Это может быть повышение производительности

станка или срока службы технического устройства, снижение

массы конструкции летательного аппарата или затрат на его

производство и т.п.

Для ответа на два последних вопроса необходимо

располагать математической моделью объекта оптимизации. Эта

модель описывает объект при помощи соотношений между

величинами, характеризующими его свойства. Обычно хотя бы

часть этих величин можно изменять в некоторых пределах,

что и порождает множество альтернатив, среди которых и

предстоит выбрать наилучшую. Изменяемые при

оптимизации величины, входящие в математическую модель объекта

оптимизации, называют параметрами оптимизации, а

соотношения, устанавливающие пределы возможного изменения

этих параметров, — ограничениями. Эти ограничения могут

быть заданы в форме равенств или неравенств. Их называют

соответственно ограничениями типа равенства или

ограничениями типа неравенства.

1.2. Некоторые простые примеры

17

Если множество параметров оптимизации является

подмножеством конечномерного линейного пространства, то говорят

о конечномерной задаче оптимизации в отличие от

бесконечномерных задач, которые рассматривают в вариационном

исчислении и оптимальном управлении [XV]. При этом

критерием оптимальности может быть требование достижения

наибольшего или наименьшего значения одной или несколькими

действительными (скалярными) функциями параметров

оптимизации, выражающими количественно меру достижения цели

оптимизации рассматриваемого объекта. Каждую из таких

функций принято называть целевой. Если целевая функция

единственная, то задачу конечномерной оптимизации

называют задачей математического программирования, а в

противном случае — задачей многокритериальной (векторной)

оптимизации [XX]. В дальнейшем ограничимся

рассмотрением задач математического программирования и методов их

решения.

Если целевая функция и ограничения являются линейными

относительно параметров оптимизации, то говорят о задаче

линейного программирования. Одну из первых таких задач

сформулировал и решил Л.В. Канторович*. Задача

Канторовича была связана с выбором оптимальной производственной

программы, что и объясняет появление в названии этого класса

задач слова „программирование". При нелинейной зависимости

целевой функции или ограничений от параметров оптимизации

говорят о задаче нелинейного программирования.

1.2. Некоторые простые примеры

Начнем с рассмотрения достаточно простых задач

оптимизации из геометрии, алгебры и некоторых других разделов

математики. Эти задачи обычно можно решить геометрическим

*Л.В. Канторович A912-1986) — отечественный математик и

экономист, лауреат Нобелевской премии A975 г.).

18

1. ЗАДАЧИ ОПТИМИЗАЦИИ

или алгебраическим путем, а также при помощи необходимых и

достаточных условий экстремума действительной (скалярной)

функции одного переменного [II]. Включение таких примеров

в эту книгу важно по нескольким причинам. Во-первых, эти

задачи тесно связаны с историей развития методов

оптимизации и позволяют наглядно продемонстрировать многообразие

объектов оптимизации. Во-вторых, на простой задаче можно

более четко выявить особенности построения математических

моделей таких объектов с точки зрения выбранного критерия

оптимальности и проследить этапы процесса формулировки

задачи математического программирования. В-третьих,

знание способов и результатов решения многих из этих задач

помогает при решении более сложных задач оптимизации,

например задач оптимального проектирования (см. 1.3).

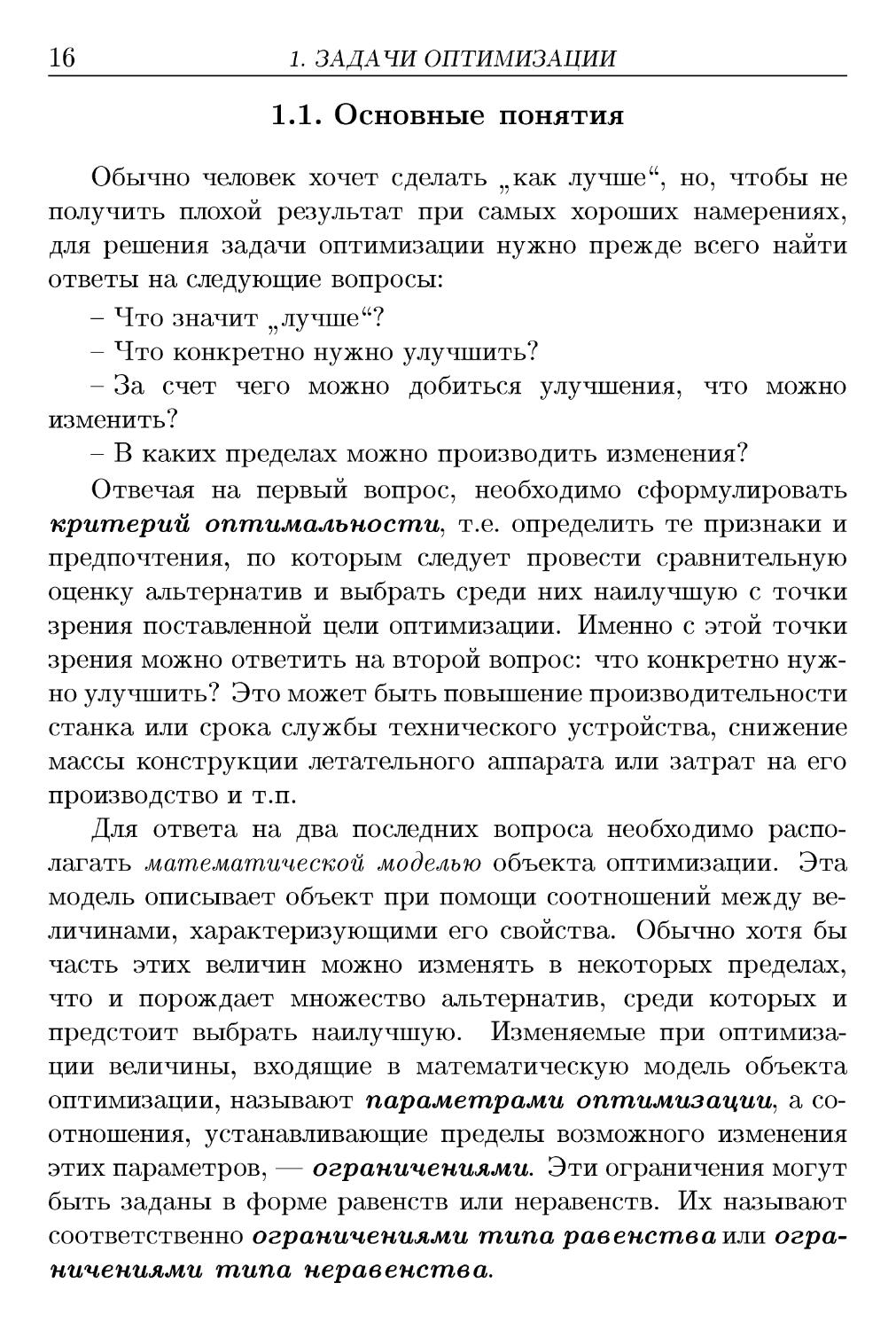

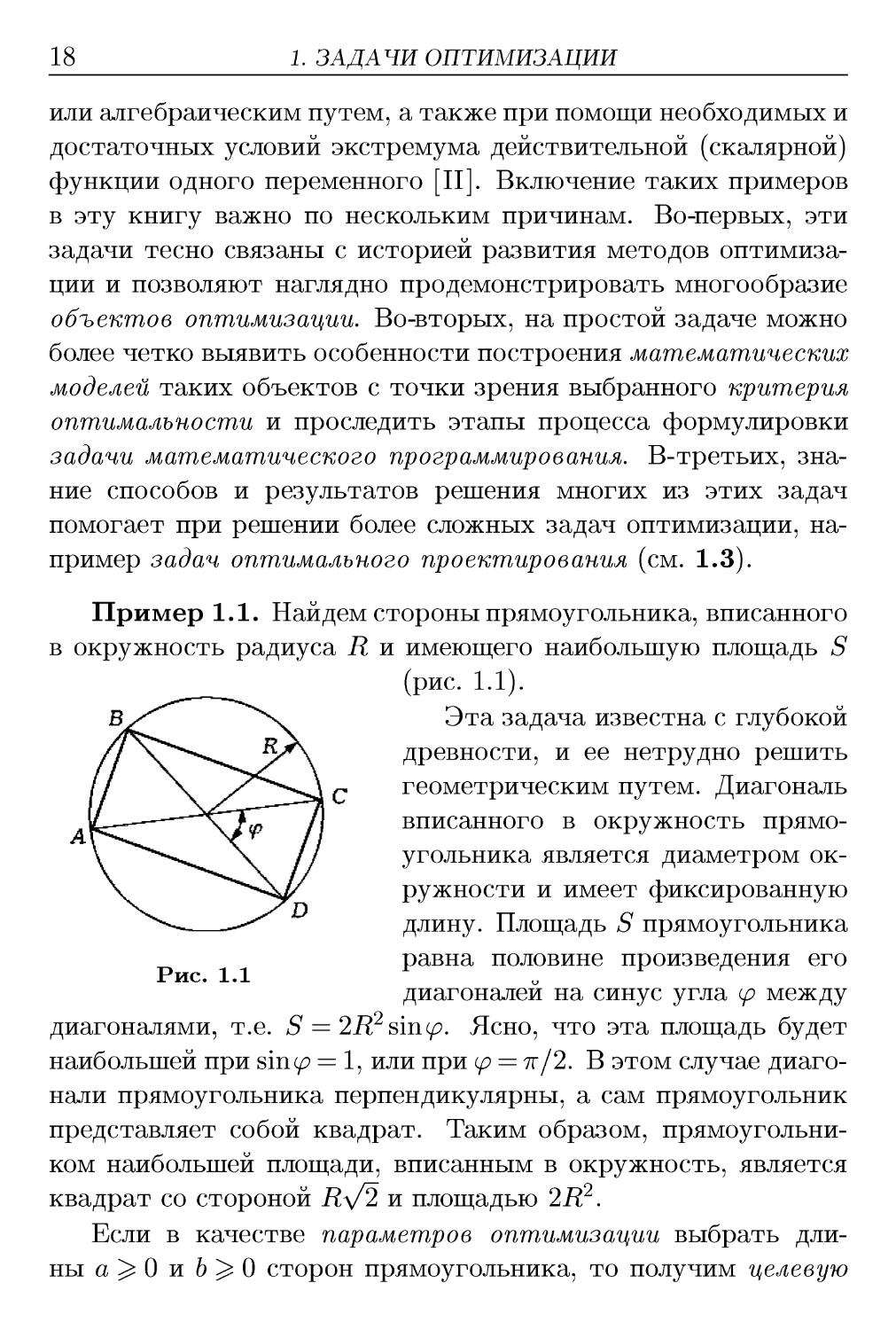

Пример 1.1. Найдем стороны прямоугольника, вписанного

в окружность радиуса R и имеющего наибольшую площадь S

(рис. 1.1).

Эта задача известна с глубокой

древности, и ее нетрудно решить

геометрическим путем. Диагональ

вписанного в окружность

прямоугольника является диаметром

окружности и имеет фиксированную

длину. Площадь S прямоугольника

равна половине произведения его

Рис. 1.1

диагоналей на синус угла ср между

диагоналями, т.е. S = 2R2 sirup. Ясно, что эта площадь будет

наибольшей при s'mcp = 1, или при ср = 7г/2. В этом случае

диагонали прямоугольника перпендикулярны, а сам прямоугольник

представляет собой квадрат. Таким образом,

прямоугольником наибольшей площади, вписанным в окружность, является

квадрат со стороной R\f2 и площадью 2R2.

Если в качестве параметров оптимизации выбрать

длины й^О и Ь^О сторон прямоугольника, то получим целевую

1.2. Некоторые простые примеры

19

функцию S = ab и ограничение \/а? + Ъ2 = 2R типа равенства,

нелинейные по отношению к этим параметрам. Поэтому

рассматриваемую задачу оптимизации следует отнести к задачам

нелинейного программирования. Ее математическую

формулировку можно представить в виде

{S = ab—> max;

а2 + 62 = 4Д2, а>0, b > 0.

Эту задачу можно решить одним из известных стандартных

путей: либо использовать формальную процедуру поиска

условного экстремума функции S = ab двух переменных с одним

уравнением связи, построив функцию Лагранжа, либо

выразить при помощи ограничения одно переменное через другое

и перейти к поиску экстремума функции одного переменного.

Отметим, что в данном случае возможен и нестандартный

способ решения, связанный с построением вспомогательного

соотношения 4R2 - 2S = а2 + Ъ2 - 2аЪ = (а - бJ, или S = 2R2- Ц^.

Отсюда следует, что S достигает наибольшего значения 5* =

= 2R2 при условии а = 6, т.е. когда прямоугольник является

квадратом, причем a = b = R\/2.

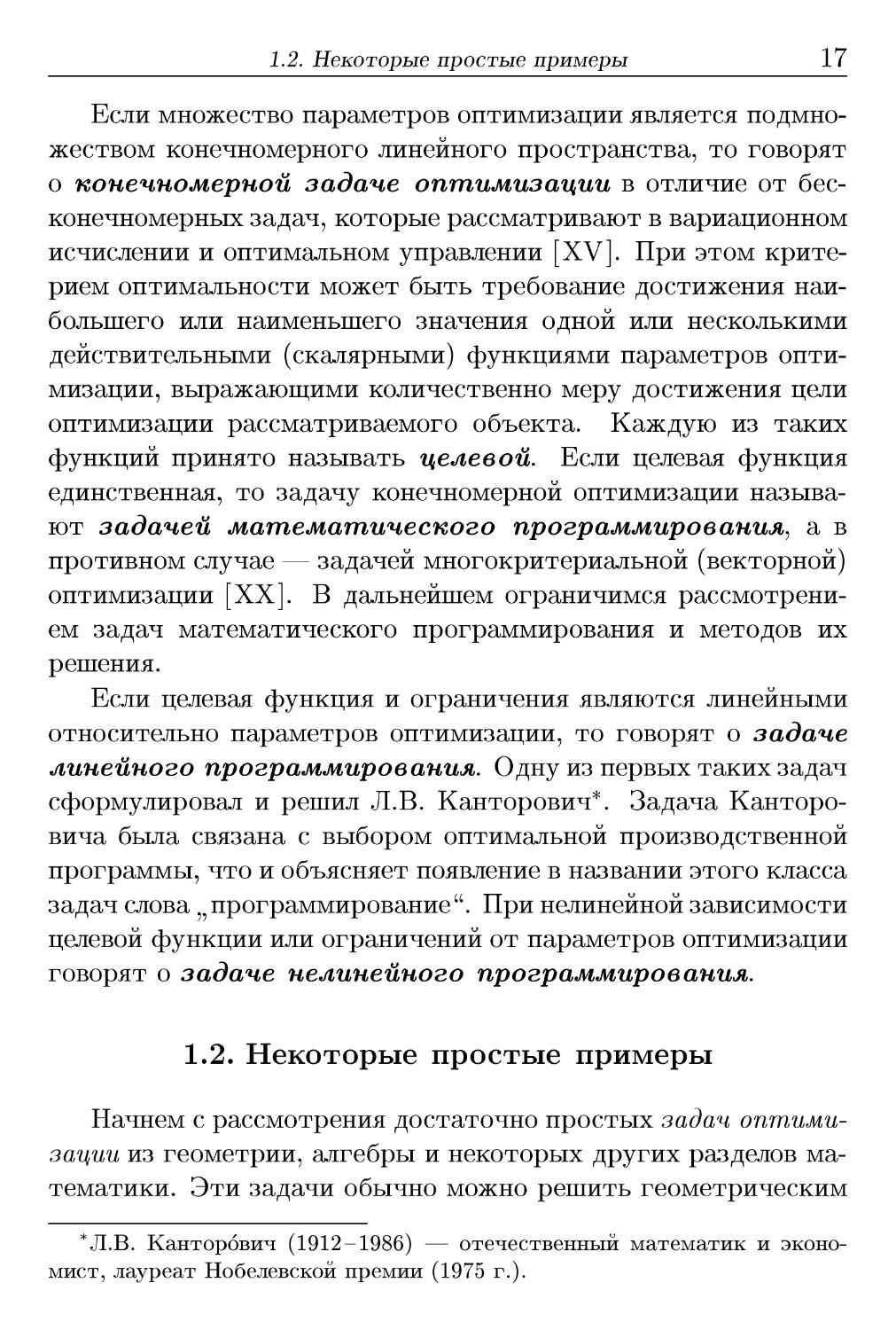

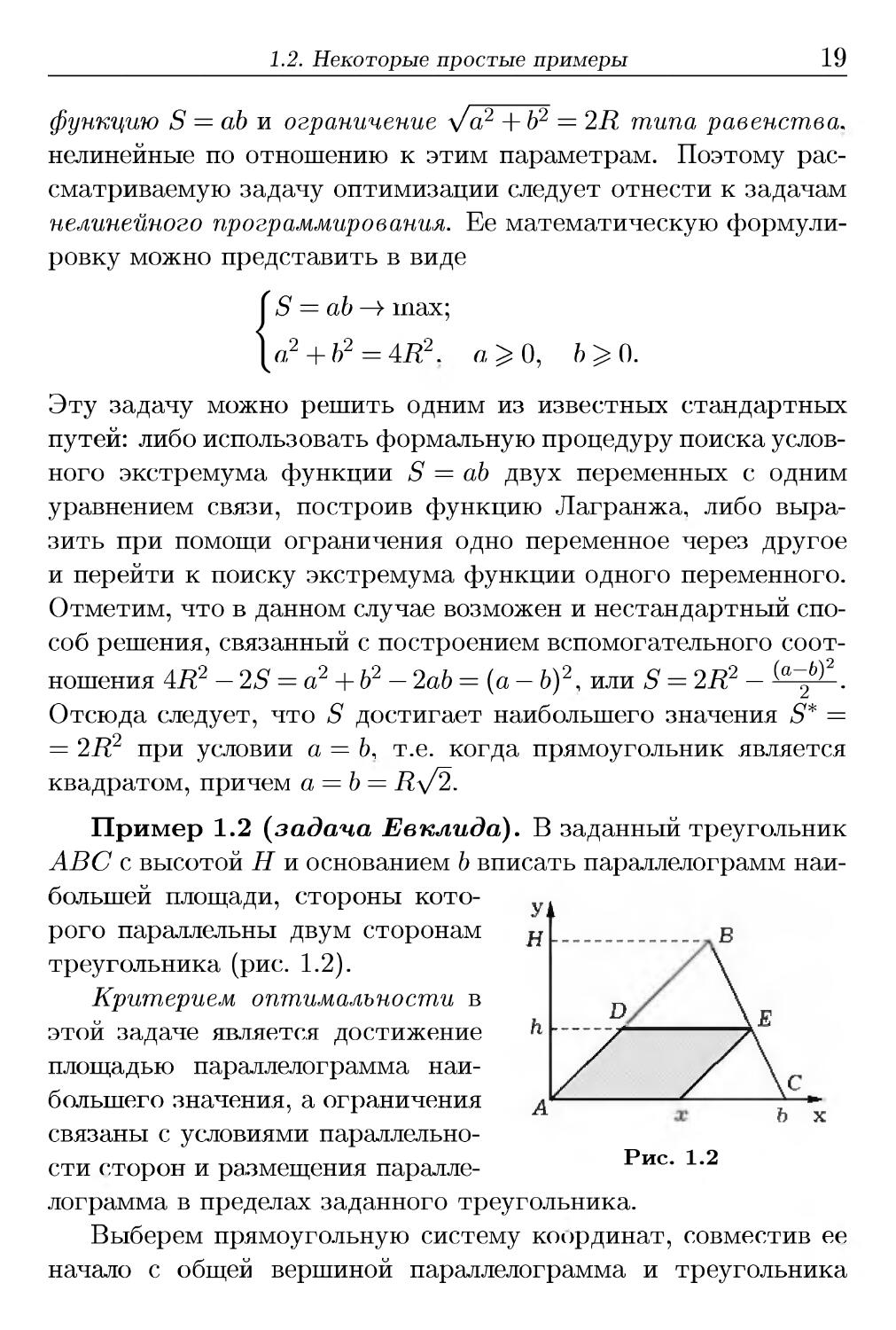

Пример 1.2 {задача Евклида). В заданный треугольник

ABC с высотой Н и основанием b вписать параллелограмм

наибольшей площади, стороны

которого параллельны двум сторонам

треугольника (рис. 1.2).

Критерием оптимальности в

этой задаче является достижение

площадью параллелограмма

наибольшего значения, а ограничения

¦Л, и Л.

связаны с условиями

параллельности сторон и размещения паралле- ис' '

лограмма в пределах заданного треугольника.

Выберем прямоугольную систему координат, совместив ее

начало с общей вершиной параллелограмма и треугольника

20

1. ЗАДАЧИ ОПТИМИЗАЦИИ

(вершина А на рис. 1.2), а ось абсцисс — с одной из сторон

треугольника. В качестве параметров оптимизации выберем

основание х параллелограмма и его высоту h. Тогда площадь

S параллелограмма можно записать в виде S = hx, а условие,

что параллелограмм вписан в треугольник, — как ограничение

типа равенства (Н — h)/H = ж/Ь, которое вытекает из подобия

треугольников DBE и ABC. Итак, имеем задачу оптимизации

[ S = hx —>> max;

Я

h х

х>0.

Эту задачу также можно решить стандартными

способами (см. пример 1.1). Ее решением является параллелограмм с

основанием х* = 6/2 и высотой h* = A — х*/Ъ)Н = Н/2.

Отметим, что выбор вершины треугольника, с которой совпадает

вершина параллелограмма, не является существенным, так как

в любом из трех вариантов выбора вершины треугольника

площадь параллелограмма максимальной площади равна половине

площади треугольника ABC.

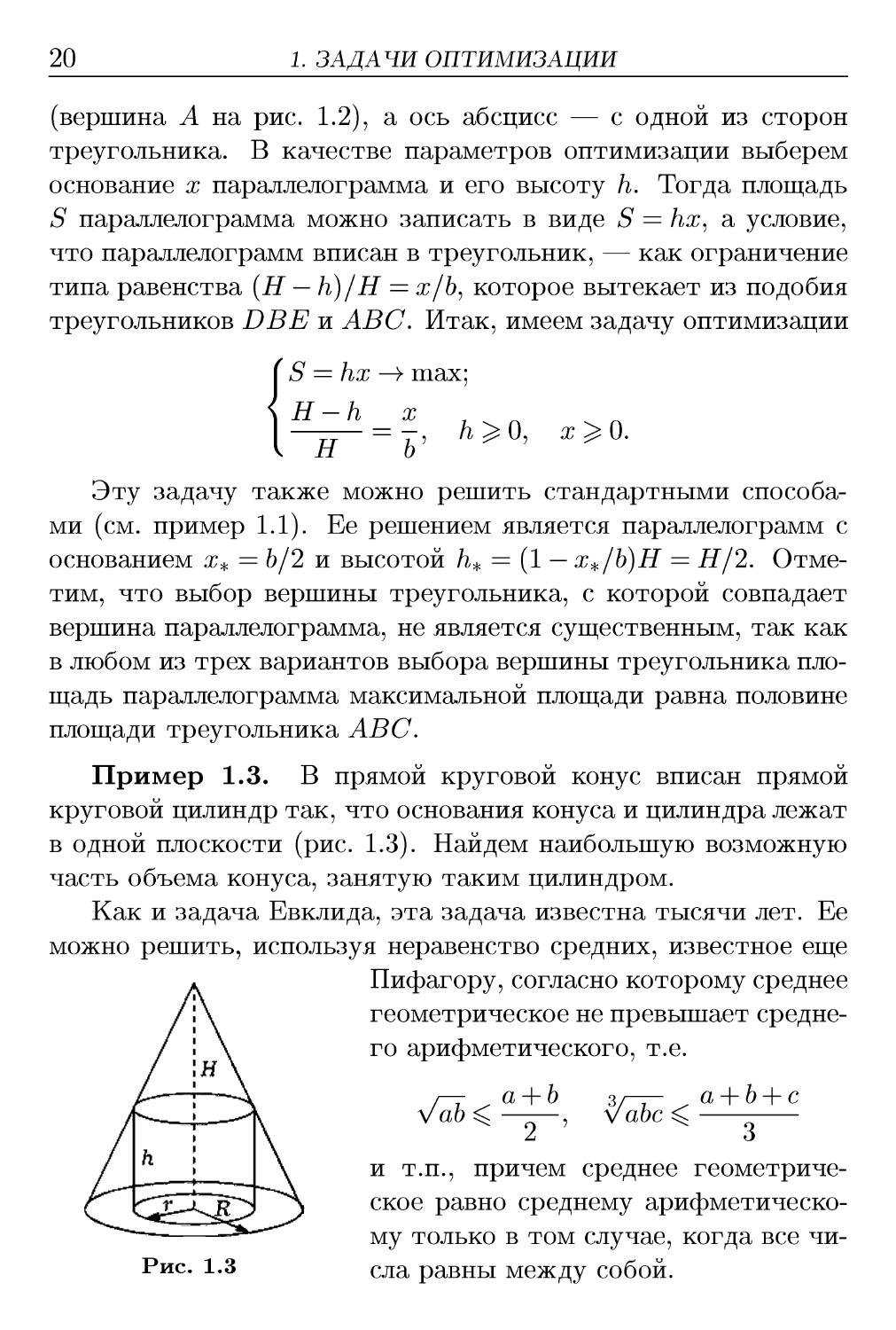

Пример 1.3. В прямой круговой конус вписан прямой

круговой цилиндр так, что основания конуса и цилиндра лежат

в одной плоскости (рис. 1.3). Найдем наибольшую возможную

часть объема конуса, занятую таким цилиндром.

Как и задача Евклида, эта задача известна тысячи лет. Ее

можно решить, используя неравенство средних, известное еще

Пифагору, согласно которому среднее

геометрическое не превышает

среднего арифметического, т.е.

ab <

а + Ь

зг~г / а + Ь + с

vabc <

Рис. 1.3

2 7 ^3

и т.п., причем среднее

геометрическое равно среднему

арифметическому только в том случае, когда все

числа равны между собой.

1.2. Некоторые простые примеры

21

Обозначим высоту и радиус основания цилиндра через h и

г, а высоту и радиус основания конуса через Н и R. Запишем

отношение их объемов

7гг2/г r2h

v= ttr2h/3= Wh'

Это равенство задает целевую функцию, в которой в качестве

параметров оптимизации можно взять отношения г / R и h/H.

Из условия задачи (цилиндр вписан в конус) вытекает

ограничение r/R= (Н — h)/H. Подставляя его в целевую функцию,

получаем

{ h\ ( h\2 h h , . /ч

<hX1-h)w я6*0-1»' <l1>

Ясно, что функция rj(h/H) достигает максимума при том

же значении отношения h/H, что и любая положительная

степень правой части этого равенства, в частности степень 1/3.

Используем неравенство для среднего геометрического таких

трех величин, чтобы правая часть этого неравенства оказалась

константой:

Максимум левой части в этом неравенстве будет достигнут при

его переходе в равенство, т.е. - — —— = —. Отсюда находим

2 2Н Н

h/H = 1/3 и, подставляя в A.1), вычисляем г/A/3) = 4/9. При

этом отношение радиусов оснований цилиндра и конуса будет

г/Д = 2/3.

Несложно проверить, что к тому же результату можно

прийти и стандартным путем поиска экстремума функции

Ф/н) при h/He [0,1].

22

1. ЗАДАЧИ ОПТИМИЗАЦИИ

Пример 1.4. Найдем значение параметра а, при котором

достигает максимума функция f(a) = expf — - (х\ + #!)) •> гДе ЖЬ

Х2 — корни квадратного уравнения х2 + ах + За — 1 = 0.

По теореме Виета* [1-4.4] имеем х\ + Х2 = — а и ж^ = За — 1.

Отсюда находим

Хл ~т~ Хп

(xi + х2J - 2xix2 = а2 - 6а + 2 = (а - ЗJ - 7,

и в итоге /(а) = ехрC,5 — 0,5(а — ЗJ). Так как (а — ЗJ > 0, a

ехр(—0,5(а — ЗJ) убывает с возрастанием (а —ЗJ, то функция

/(а) достигает своего максимума при а* = 3 и этот максимум

равен /(а*) = ехрC,5) « 33,115.

Применение теоремы Виета позволило в данном случае

упростить задачу и даже избежать использования

дифференциального исчисления для поиска экстремума функции /(а),

заданной как композиция функций.

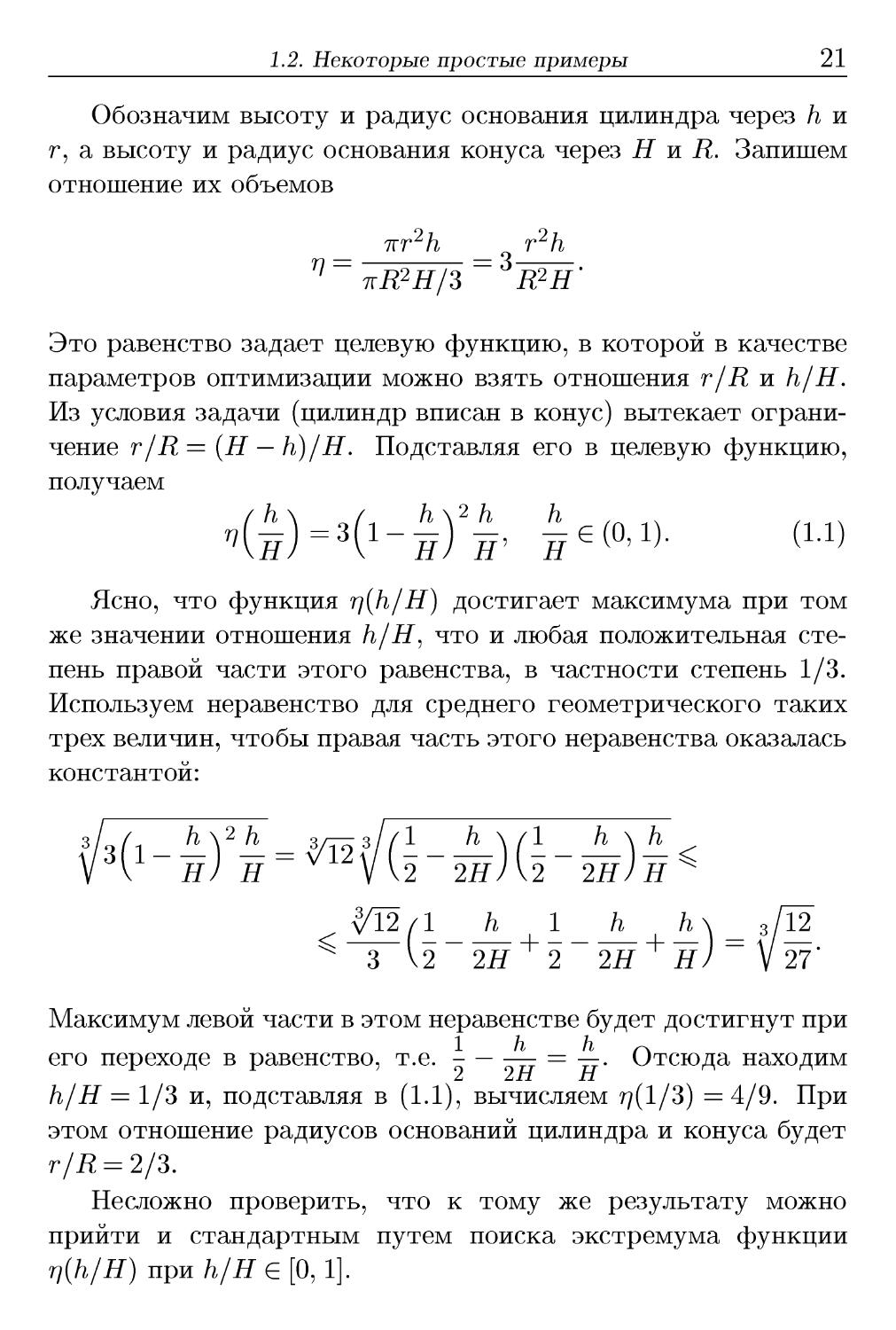

Пример 1.5. Луч света, переходя из одной однородной

среды в другую, падает на границу раздела этих сред под углом а\

к направлению нормали и

после преломления на этой

границе составляет с нормалью угол

OL2 (рис. 1.4). Требуется найти

соотношение между этими

углами.

Из курса физики известно,

что в соответствии с принципом

Ферма** геометрической

оптики свет при прохождении через среду с различными свойствами

выбирает такую траекторию, время прохождения которой

минимально.

Пусть t\ — время прохождения световым лучом отрезка

AM со скоростью с\ в среде i, х — абсцисса точки М падения

Рис. 1.4

*Ф. Виёт A540-1603) — французский математик и юрист.

**П. Ферма A601-1665) — французский математик.

1.3. Задачи оптимального проектирования 23

светового луча на границу двух сред, t<i — время прохождения

световым лучом отрезка MB со скоростью c<i в среде 2. Тогда

время прохождения света из точки А в точку В будет равно

ФО=t1+t2 = ^Э±^5 + у/ън«-х)\ (L2)

С\ С<2

Из необходимого условия экстремума функции ?(ж), который

по физическому смыслу задачи является минимумом, получаем

х

с\ л/bl + х2 sinai

С2 a~X Sin «2

у/Ъ1 + {а-х)*

Это равенство выражает закон преломления света,

установленный В. Снеллиусом*.

1.3. Задачи оптимального проектирования

При создании технического устройства различного

назначения обычно часть его параметров можно изменять в

определенных пределах. Это приводит к тому, что при

проектировании появляется некоторое множество вариантов создаваемого

устройства. В результате возникает проблема выбора из

этого множества альтернатив наилучшей альтернативы с точки

зрения критерия оптимальности. Соответствующие такому

выбору задачи оптимизации часто называют задачами

оптимального проектирования.

Пример 1.6. Одной из наиболее простых задач

оптимального проектирования является выбор размеров емкости

определенной формы, имеющей наибольший объем при

заданной площади поверхности или же наименьшую площадь при

заданном объеме.

*В. Снеллиус A580-1626) — нидерландский астроном и математик.

A.3)

24

1. ЗАДАЧИ ОПТИМИЗАЦИИ

Пусть требуется спроектировать бак горючего в виде

прямого кругового цилиндра заданного объема V, на

изготовление которого будет затрачено наименьшее количество листовой

стали. В качестве параметров оптимизации выберем радиус R

и высоту Н цилиндра. Тогда затраты материала на

изготовление бака будет определять суммарная площадь S его боковой

поверхности и двух плоских днищ. Таким образом, необходимо

минимизировать целевую функцию S = 2пR(H + R) при

ограничении типа равенства ttR2H = V, т.е. решить задачу

нелинейного программирования.

Если из целевой функции при помощи ограничения

исключить Н и записать ее в виде

V V о

ЗД = - + - + 2тгД2,

то произведение слагаемых не будет зависеть от i?, и для

нахождения ее минимального значения удобно использовать

то же неравенство между геометрическим и арифметическим

средними, что и в примере 1.3:

S(R) = \ + \ + 2тгД2 > з{/^27гД2 = 3^2тгУ2 = Я.

R R \ R R

Равенство имеет место только при равенстве слагаемых, т.е.

ПРИ ~б = 27гЛ2, тогда Д* = у —. Учитывая ограничение,

получаем

Д* =

ТгД2

т.е. высота оптимального бака равна его диаметру.

При изготовлении одного бака нужно учитывать, что для

заготовки круглого днища площадью ttR2 придется взять

квадратный лист площадью 4i?2, причем после раскроя

оставшуюся часть листа использовать будет практически невозможно.

Поэтому более обоснованно в качестве целевой минимизировать

функцию S = 2ttRH + 8R2 при прежнем ограничении ttR2H = V.

1.3. Задачи оптимального проектирования

25

Тогда в результате процедуры, аналогичной рассмотренной,

получим R* = - VV, S* = 6vl^2, if* = -i?*. Если предстоит из-

готовить крупную партию баков, то раскрой листовой стали

при заготовке днищ можно провести более рационально,

располагая соседние центры днищ в вершинах правильных

треугольников со стороной 2R. Тогда расход листа на каждое днище

будет соответствовать площади 2\/ЗЛ2 правильного

шестиугольника, описанного около окружности радиуса R. При этом

следует минимизировать целевую функцию S = 27ri?if + 4v3i?2

при том же ограничении. В итоге получим

Отметим, что при постановке задач оптимального

проектирования важно, чтобы математическая модель объекта

оптимизации достаточно полно отражала именно те свойства

объекта, улучшение которых является целью оптимизации.

Разработка такой модели обычно требует использования сведений

из соответствующих инженерных дисциплин или областей

техники.

Пример 1.7. Из курса сопротивления материалов

известно*, что допустимая нагрузка, воспринимаемая

прямолинейным стержнем, работающим на растяжение или сжатие (без

потери устойчивости прямолинейной формы равновесия),

пропорциональна площади F его поперечного сечения. При сжатии

стержень может потерять устойчивость, изгибаясь в некоторой

плоскости. Сжимающая сила, вызывающая потерю

устойчивости стержня, пропорциональна геометрическому моменту

инерции I его сечения относительно центральной оси тела,

перпендикулярной плоскости изгиба. От значения I также

зависит прогиб стержня, изгибаемого в этой плоскости, но

зависимость эта обратно пропорциональная. Допустимая нагрузка

*См.: Феодосъев В.И.

26

1. ЗАДАЧИ ОПТИМИЗАЦИИ

при изгибе стержня пропорциональна моменту сопротивления

W = I/ут его сечения, где ут — расстояние до наиболее

удаленной от центральной оси точки сечения. Эти сведения важны

для выбора критерия оптимальности при проектировании

отдельных элементов конструкций, воспринимающих нагрузку.

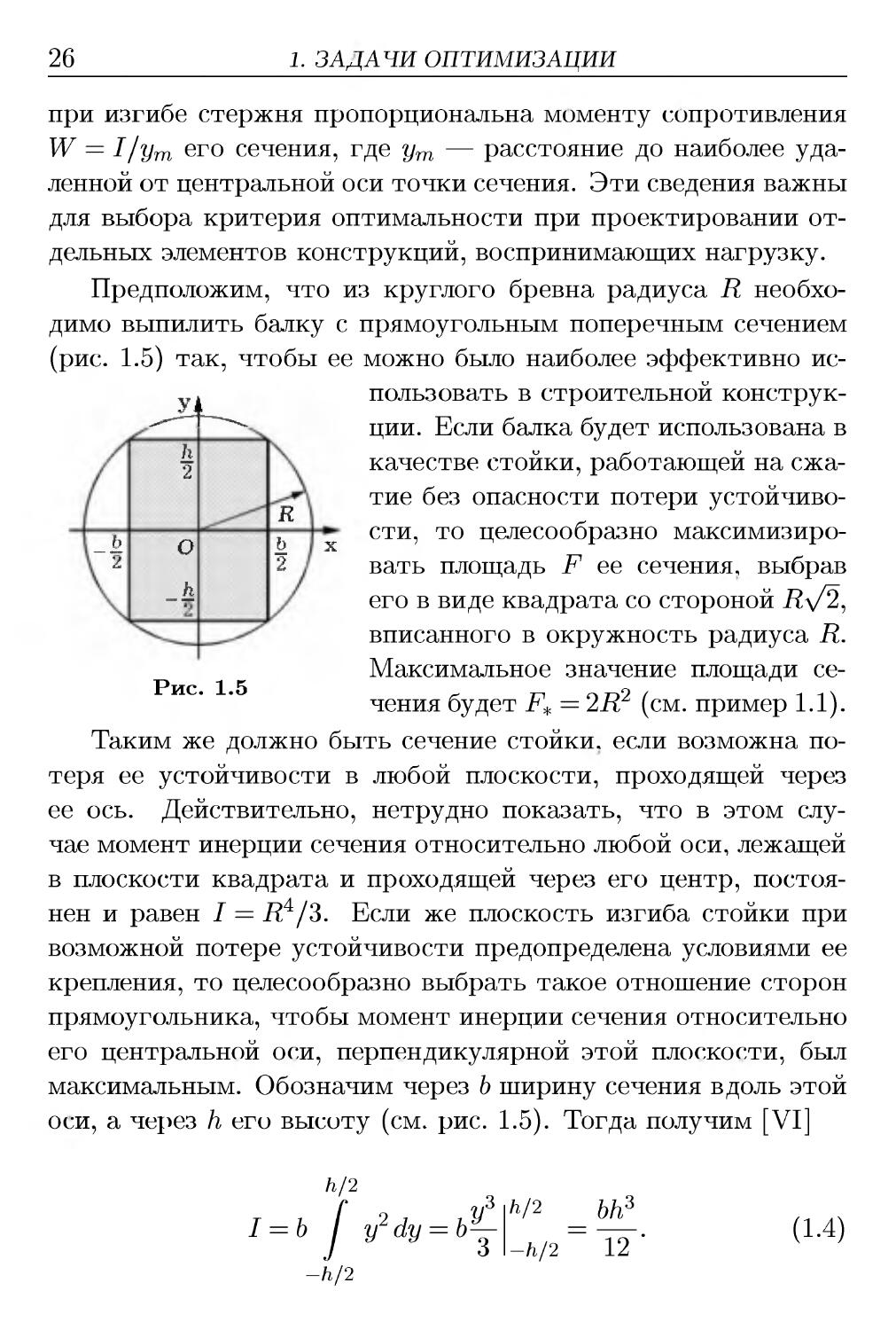

Предположим, что из круглого бревна радиуса R

необходимо выпилить балку с прямоугольным поперечным сечением

(рис. 1.5) так, чтобы ее можно было наиболее эффективно

использовать в строительной

конструкции. Если балка будет использована в

качестве стойки, работающей на

сжатие без опасности потери

устойчивости, то целесообразно

максимизировать площадь F ее сечения, выбрав

его в виде квадрата со стороной i?y2,

вписанного в окружность радиуса R.

Максимальное значение площади

сечения будет F* = 2R2 (см. пример 1.1).

Таким же должно быть сечение стойки, если возможна

потеря ее устойчивости в любой плоскости, проходящей через

ее ось. Действительно, нетрудно показать, что в этом

случае момент инерции сечения относительно любой оси, лежащей

в плоскости квадрата и проходящей через его центр,

постоянен и равен I = R4/3. Если же плоскость изгиба стойки при

возможной потере устойчивости предопределена условиями ее

крепления, то целесообразно выбрать такое отношение сторон

прямоугольника, чтобы момент инерции сечения относительно

его центральной оси, перпендикулярной этой плоскости, был

максимальным. Обозначим через b ширину сечения вдоль этой

оси, а через h его высоту (см. рис. 1.5). Тогда получим [VI]

Рис. 1.5

h/2

y2dy = by-

-h/2

h/2

-h/2

bh3

~\2'

A.4)

1.3. Задачи оптимального проектирования 27

Но стороны прямоугольника должны удовлетворять

ограничению Ъ2 + h2 ^ 4Д2. Таким образом, приходим к задаче

нелинейного программирования

<

т bh3

I = — -> max;

62 + /i2<4i?2, 6>0, h>0.

Несложно установить, что максимальное значение

будет достигнуто при оптимальных высоте h* = Л\/3 и ширине

b* = R сечения балки.

Такое же поперечное сечение балки следует выбрать,

если она нагружена в рассматриваемой плоскости изгибающей

нагрузкой. При таком выборе жесткость балки будет

максимальной, а ее прогиб — минимальным. Поскольку для

рассматриваемого прямоугольного сечения балки ут = /г/2, то для

момента сопротивления получим W = I/ут = bh2/6. В данном

случае задача нелинейного программирования принимает вид

ш bh*

W = —; > max;

о

62 + /i2^4i?2, 6^0, h^O.

Ее решением будет W* = —^= i?3, h* = —= R = у/2 Ъ*.

9л/3 л/3

Пример 1.8. Из курса физики и термодинамики известно,

что работа, затрачиваемая в компрессоре на сжатие 1 кг

воздуха от начального давления ро до давления р> ро, равна

А

jRTo

Ш)*-*)> <->

7 - -L V v.Po

где 7 — коэффициент, характеризующий процесс сжатия (при

адиабатическом процессе для воздуха 7~1,4); R — газовая

постоянная воздуха; Tq — его температура до сжатия. Чтобы

28

1. ЗАДАЧИ ОПТИМИЗАЦИИ

уменьшить затрачиваемую работу в случае высокой степени

сжатия х = р/ро, проектируют многоступенчатые

компрессорные установки, состоящие из нескольких последовательно

соединенных компрессоров (ступеней) с промежуточными

холодильными устройствами между ступенями, в которых

охлаждают воздух, нагревшийся при сжатии.

Пусть требуется спроектировать компрессорную установку

из га ступеней в предположении, что воздух, поступающий в г-ю

ступень, г = 1, га, охлажден до одинаковой температуры То и

имеет давление Рг-ъ равное давлению на выходе из предыдущей

ступени. Необходимо при заданной общей степени сжатия х

так выбрать степени сжатия отдельных ступеней щ =р^/Рг-ъ

г = 1, га, рт =р, чтобы работа, затрачиваемая на весь процесс

сжатия воздуха, была минимальной.

В соответствии с A.5) работа, затрачиваемая на сжатие в

г-й ступени, равна

7-1 \yp,-J ) 1-1\ '

а работа, затрачиваемая на весь процесс сжатия,

т- -i=i

Так как число га ступеней задано, то минимизируемую целевую

функцию можно представить в виде

7-1

А А*,7

+i = E—> A-е)

Aora Г—' 771

г=1

где Aq = jRTo/(j — 1). Правая часть этого равенства является

7-1

средним арифметическим неизвестных чисел щ = х^ 7 , г =

= 1, га. Геометрическое среднее этих чисел равно

т 7~1 тп 7~1 , „ v 7~1 -у—1

Va!a2...am = n^m7 = П(^)т7 =(~)

т7 _хт7 >

1.3. Задачи оптимального проектирования

29

Используя неравенство между геометрическим и

арифметическим средними (см. пример 1.3), получаем

А 1 Ах^~^ 2=1

hi = > — > X m7 .

Aqtu t—' m

г=1

Отсюда следует, что наименьшее значение работы при

заданной степени х сжатия 1 кг воздуха в m-ступенчатой

компрессорной установке равно

и может быть достигнуто лишь при равенстве всех слагаемых

в правой части A.6), т.е. при щ = const, i = 1, га. Это

возможно только при выборе одинаковой для всех ступеней степени

- 1 / / v \ 1/т

сжатия, равной х= х /т = — . Таким образом, затрачи-

\ро/

ваемая работа минимальна, если значения давлений на выходе

из ступеней образуют геометрическую прогрессию со

знаменателем х: pi = хро, Р2 = xpi и т.д. #

Некоторые параметры оптимизации могут принимать лишь

дискретные значения (например, целочисленные). В этом

случае дифференцирование по таким параметрам при поиске

экстремума целевой функции носит условный характер. После

формального нахождения точки экстремума в предположении

непрерывного изменения этих параметров для них следует

принять ближайшие к найденным дискретные значения. Ясно, что

это повлияет на экстремальное значение целевой функции.

Пример 1.9. Пусть требуется соединить N одинаковых

источников постоянного электрического тока в батарею

таким образом, чтобы батарея имела наибольшую электрическую

мощность, выделяемую на внешней нагрузке с сопротивлением

R. Предполагается, что каждый источник имеет

электродвижущую силу Е и внутреннее сопротивление г.

30

1. ЗАДАЧИ ОПТИМИЗАЦИИ

Если эти источники соединить последовательно, то

получим батарею с электродвижущей силой NE и внутренним

сопротивлением Nr. Тогда при подключении внешней нагрузки

сила тока J\ = — -, а передаваемая мощность W\ = J{К =

т\т2 тр2 гу

= -— —-. При параллельном соединении получим батарею с

электродвижущей силой Е и внутренним сопротивлением r/N.

В этом случае при подключении внешней нагрузки имеем J% =

Е NE тхг N2E2R

/*г ~ *.~ и Wo = 7 ттт^т- В частном случае г = R

r/N + R r + NR z (r + NRJ J

обе батареи дадут одинаковый результат, но при г < R

получим VF2 < Wi, и наоборот (естественно, считал, что N > 1).

Можно использовать комбинированную схему соединения

источников тока. Предположим, что N допустимо изменять

так, чтобы для некоторого натурального числа п число N/n

также было натуральным и больше единицы. Тогда можно

параллельно соединить N/n ветвей, каждая из которых будет

состоять из п последовательно соединенных источников тока и

иметь электродвижущую силу пЕ и внутреннее сопротивление

-п о _. пг п2г

пг. Внутреннее сопротивление такой батареи равно ——— = ——,

а электродвижущая сила равна п. При подключении внешней

7 пЕ

нагрузки сила тока составит J = 2 —-, а передаваемая

мощность будет равна

w = j2r_ (nNEfR

(n2r + NRJ'

Фиксируя N и предполагая, что п изменяется непрерывно,

попытаемся найти максимум передаваемой мощности. Если

точка п* максимума существует, то в ней достигает максимума

и сила тока, которую представим функцией

т/ ч nNE /-. ^

J(n) = —о ^ (!-7)

v } n2r + NR v )

одного переменного п. Из необходимого условия Jf(n) = 0

максимума этой функции получаем при п > 0 ее единственную

1.3. Задачи оптимального проектирования

31

стационарную точку n* = y/NR/r. Проверка достаточного

условия показывает, что, действительно, п* — точка

локального максимума функции J(n). Этой точке соответствуют

максимальные значения

Е NE2

J* = —= и W* = ——.

9 rR Аг

zVlv

Сравним силу тока батарей в зависимости от способа

соединения источников тока. Сначала рассмотрим случай г = R.

Наименьшее значение 7V, при котором имеет смысл

комбинированная схема соединения, равно 4. Тогда п* = 2 (две

параллельные ветви по два последовательно соединенных источника

тока) и^ = E/R > jD). Следующее значение 7V, позволяющее

осуществить комбинированное соединение, равно 6 (три ветви

по два источника или две ветви по три источника), но

формальное вычисление дает для п* иррациональное число между

натуральными числами 2 и 3. Если принять п = 2 или п = 3, то

из A.7) получим J = - — > jF). При N = 8 формальное

вычисление п* также приведет к иррациональному числу, но в этом

случае имеют смысл значения п = 2 или п = 4, для которых из

A.7) найдем J = - — > j(8'. Сравнение ограничим выбором зна-

3 R

чения N = 9, для которого п* = 3 и J* = - —, т.е. сила тока при

2 К

комбинированной схеме более чем в 1,5 раза превышает

значение j(9).

Так как при г < R выполняется неравенство J2 < J\, то

комбинированную схему соединения источников тока достаточно

сравнить с их последовательным соединением. Представим

отношение сил токов в следующем виде:

J* _Nr + R _ Nr + R

Л " VNrR ~ 2у/NrR

32

1. ЗАДАЧИ ОПТИМИЗАЦИИ

В правой части этого равенства стоит удвоенное отношение

среднего арифметического к среднему геометрическому двух

чисел Nr и R. Известно, что это отношение не меньше единицы,

причем оно равно единице только при Nr = R (см. пример 1.3).

Следовательно, J* ^ 2 J\ для всех приемлемых значений 7V, при

которых возможна комбинированная схема соединения.

Аналогично можно показать, что при г > R для всех приемлемых

значений N справедливо J* ^ 2J% > 2J\. #

Математическая модель объекта оптимизации может

оказаться столь сложной, что решение задачи оптимизации с

использованием такой модели потребует слишком много времени.

В таком случае следует попытаться упростить модель, но так,

чтобы в упрощенном виде она отражала свойства объекта,

существенные с точки зрения цели оптимизации, выражаемой

критерием оптимальности. После выбора значений

параметров оптимизации целесообразно провести поверочный расчет

с использованием более полной модели и оценить погрешность,

связанную с ее упрощением.

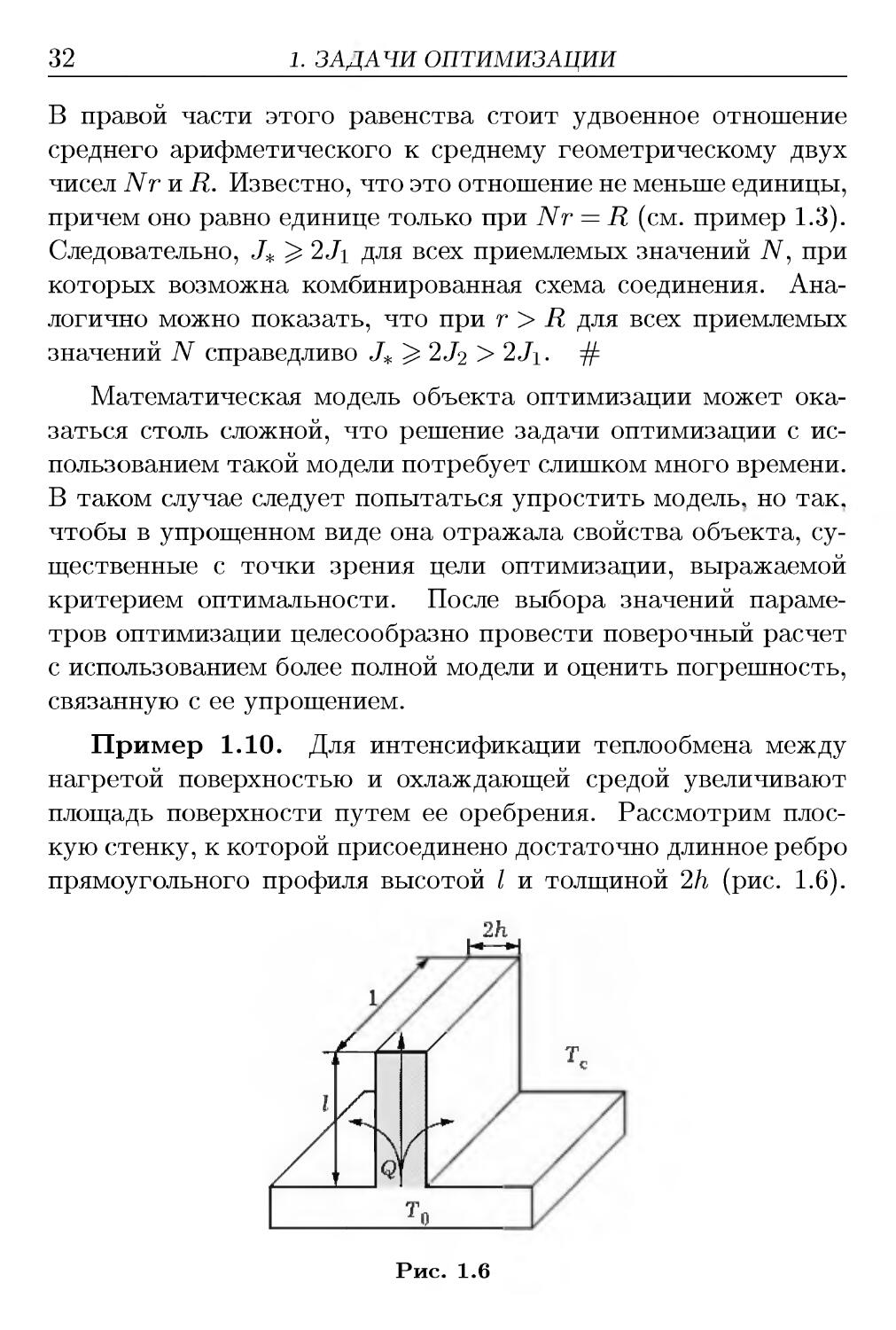

Пример 1.10. Для интенсификации теплообмена между

нагретой поверхностью и охлаждающей средой увеличивают

площадь поверхности путем ее оребрения. Рассмотрим

плоскую стенку, к которой присоединено достаточно длинное ребро

прямоугольного профиля высотой / и толщиной 2/i (рис. 1.6).

Рис. 1.6

1.3. Задачи оптимального проектирования

33

Помимо передачи теплоты охлаждающей среде с известной

температурой Тс непосредственно с поверхности стенки, имеющей

температуру То > Тс, некоторая часть теплоты

распространяется путем теплопроводности от основания ребра к его вершине

и переходит в охлаждающую среду через боковые поверхности.

Целесообразно так подобрать материал ребра и размеры / и

h его профиля, чтобы тепловой поток Q (количество теплоты

в единицу времени), передаваемый охлаждающей среде через

участок ребра единичной длины, был максимальным.

Для изготовления ребер желательно использовать

материал с достаточно большим коэффициентом теплопроводности Л.

Тогда температура боковой поверхности ребра будет в меньшей

степени отличаться от температуры его основания, что

повысит эффективность использования этой поверхности. Масса

ребра, приходящаяся на единицу его длины, пропорциональна

площади F = 2lh его сечения. Следовательно, один из

вариантов постановки задачи оптимального проектирования ребра,

изготавливаемого из выбранного материала, может быть

таким: критерием оптимальности является максимум

передаваемого через ребро теплового потока Q, а ограничением типа

неравенства будет 21 h ^ Fq, где Fq — заданное значение

площади. Параметрами оптимизации в этом случае являются / и

h. Поэтому необходимо установить связь этих параметров с

величиной Q, т.е. построить целевую функцию. Это

потребует использования математической модели

процесса передачи теплоты от стенки

через ребро охлаждающей среде.

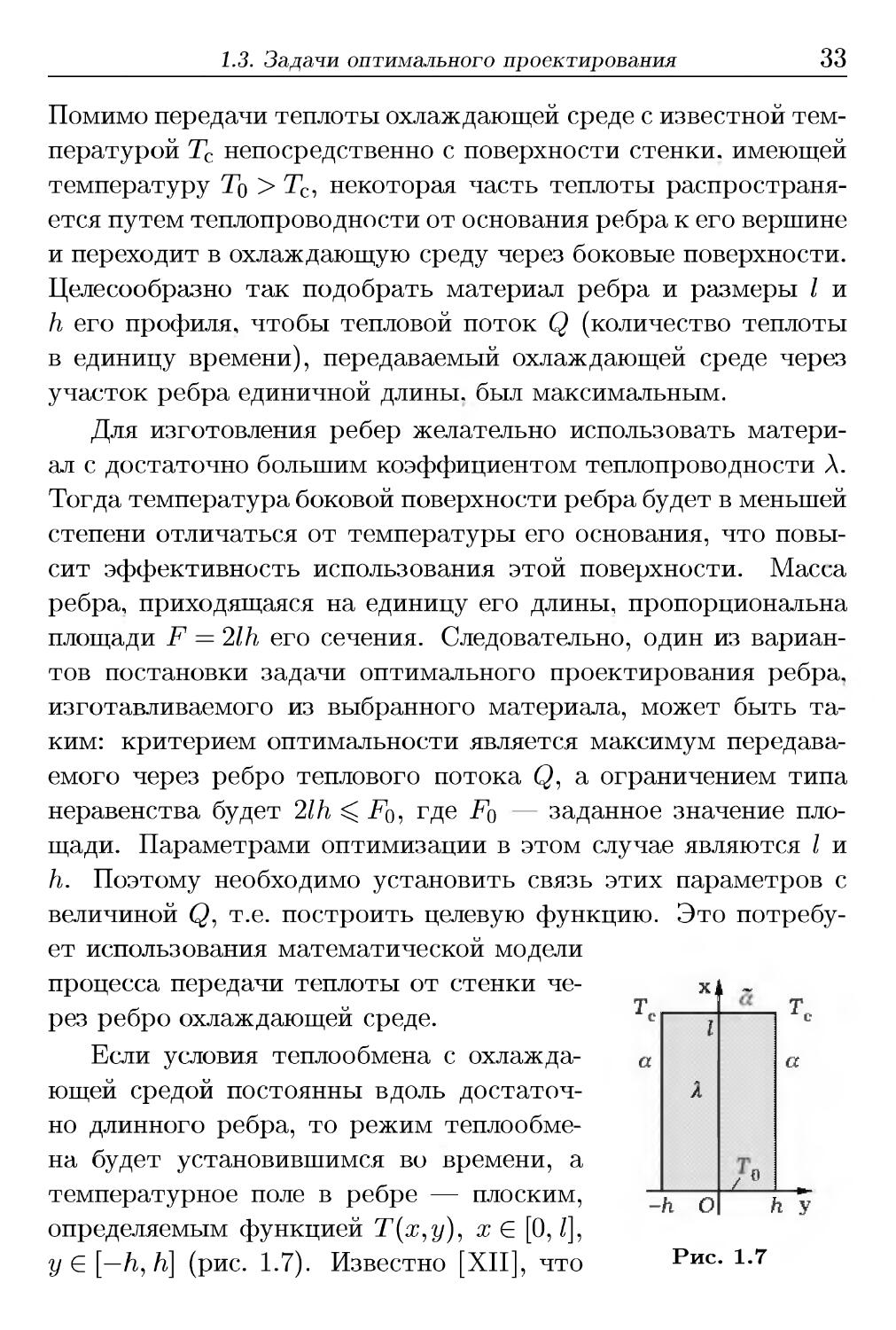

Если условия теплообмена с

охлаждающей средой постоянны вдоль

достаточно длинного ребра, то режим

теплообмена будет установившимся во времени, а

температурное поле в ребре — плоским,

определяемым функцией Т(ж,у), х Е [0, /],

у Е [—/i, h] (рис. 1.7). Известно [XII], что

т

с

a

-

Xj

г

X

k о

[ а

%

i

т

с

a

г У

Рис. 1.7

34

1. ЗАДАЧИ ОПТИМИЗАЦИИ

эта функция при Л = const удовлетворяет двумерному

уравнению Лапласа

д2Т(х,у) , д2Т(х,у)

+

= 0.

A.8)

дх2 ду2

Вследствие симметричности сечения ребра относительно оси

Ох можно рассматривать лишь половину этого сечения и

задавать граничные условия в виде

Т@,у) = Т0, А

дТ(х,у)

дТ(х,у)

ду

у=0

о, Л

дх

дТ(х,у)

Х — 1

+ аТA,у) = 5Тс, !/е[0,Л]; A.9)

дх

y=h

+ aT(x,h)=aTc, жЕ[0Д A.10)

где а ж а — коэффициенты теплообмена с охлаждающей средой

на боковой поверхности ребра и на поверхности его торца

соответственно. Решение краевой задачи A.8)-A.10), записанное в

виде двойного ряда по ортогональной системе функций [IX],

может быть найдено одним из известных методов, например

методом Фурье [XII] или с помощью интегральных

преобразований [XI]. После ее решения для теплового потока,

передаваемого через ребро охлаждающей среде и равного тепловому

потоку, проходящему через его основание, получим

д = 2

-Л

дТ(х,у)

дх

х=0

dy = -2А

п

/

дТ(х,у)

дх

х=0

dy. A.11)

Рассмотренная математическая модель является

достаточно сложной и не позволяет представить зависимость Q от

параметров оптимизации 1иЛв удобном виде. Эту модель можно

упростить, сохранив точность, достаточную для инженерных

приложений. Дело в том, что из соображений качественного

характера при ограниченной площади F = 2lh сечения ребра

целесообразно увеличить его высоту /, чтобы увеличить

площадь боковой поверхности. При этом ребро станет достаточно

1.3. Задачи оптимального проектирования

35

тонким и по его толщине 2Л, = F/l ^ Fq/1, т.е. в направлении

оси Оу, температуру можно принять практически неизменной.

Интегрируя A.8) по у в пределах от 0 до h и учитывая A.10),

находим

д2Т(х,у) | d2T(x,y)Uy

дх2

h

-!

0

ду2

д2Т(х,у) ^ЭТ(х,у)

dy +

дх2

ду

дТ(х,у)

x—h

п

I

д2Т(х,у)

дх2

dy + a

ду

х=0

¦T(x,h)

А

0.

Отсюда, полагая температурное поле в ребре одномерным,

т.е. определяемым функцией Т(ж), приходим к обыкновенному

дифференциальному уравнению (ОДУ)

d2T{x) | aTc-T(x,h) =Q

dx2 Xh

При этом граничные условия A.9) примут вид

дТ(х)

Т@)=Т0, А-

дх

Х — 1

+ aT(l) = аТс

A.12)

A.13)

Но передачей теплоты с поверхности торца ребра чаще

всего можно пренебречь по сравнению с передачей через боковую

поверхность, т.е. положить в A.13) а = 0. Это будет

соответствовать идеально теплоизолированному торцу и приведет к

несколько заниженной оценке для передаваемого через ребро

теплового потока, для которого вместо A.11) теперь получим

Q = -2A/i

dT{x)

dx

1ж=0

A.14)

36

1. ЗАДАЧИ ОПТИМИЗАЦИИ

Краевая задача A.12), A.13) при а = 0 имеет решение

Отсюда, используя A.14), находим

^ ^ЛТ/_ ^ч shra(Z — х) \ Л /——-/т тЧ , / ск 7

Q = 2\h(T0-Tc га / 7 ; = 2VaXh Т0 -Тс thW — /.

сига/ ' w х^

ж=о Y v и w" У Xh

Таким образом, мы имеем целевую функцию, зависящую от

двух параметров оптимизации / и /г, и ограничение 2lh ^ Fq.

Подставляя верхнюю оценку / = F$/Bh) для высоты ребра в

целевую функцию, получаем функцию

Fq / а

Q(h) = 2V^Xh(T()-Tc)th-2 з

одного переменного h. Необходимое условие Q'(h) = 0

максимума этой функции дает трансцендентное уравнение

которое при ( > 0 имеет единственное решение ?* « 2,8384.

Несложно проверить, что соответствующее этому решению

значение

Л. = 13М «0,4994^^

АС| ' V Л

удовлетворяет достаточному условию максимума функции Q(h).

Из ограничения получаем верхнюю оценку для оптимальной

высоты ребра

J* =\!ЫЯю1Лвир1Ы

2h* 2 V а V а

1.4. Задачи оптимального планирования

37

При этом отношение оптимальных значений высоты ребра к

толщине примет вид

а максимальное значение теплового потока —

Q, = Q(h*) = 2П«2—^ (Т0 -Тс) th^ « 1,2563^ВД(То-Тс).

1.4. Задачи оптимального планирования

Задачи математического программирования часто

возникают в экономике, при планировании производственных

процессов и количественной оценке альтернатив, связанных с

принятием управленческих решений. Постановка этих задач

обычно основана на анализе и сопоставлении расходуемых ресурсов

и полученного результата. Такой подход принято называть

методом „затраты — эффективность". Применение этого

подхода приводит, как правило, к двум связанным между собой

типам задач: либо максимизировать эффективность при

ограниченных затратах, либо обеспечивать эффективность не ниже

заданной при минимальных затратах. Таким образом,

критерием оптимальности может быть количественное выражение

затрат или эффективности. Рассмотрим несколько примеров

такого подхода.

Пример 1.11. Предположим, что предприятие может

выпускать продукцию п наименований, для производства которой

требуется т видов ресурсов (сырья, энергии, оборудования и

т.п.). Обозначим через ац затраты i-го вида ресурсов, г =

= 1, т, на производство единицы продукции j-ro наименования,

j = 1, п, а через Ь{ и Xj полные объемы располагаемых

ресурсов и планируемые объемы выпуска продукции соответственно.

Если к тому же по каждому наименованию продукции заданы

38

1. ЗАДАЧИ ОПТИМИЗАЦИИ

нижняя dj и верхняя Aj границы объема выпуска продукции,

то можно записать ограничения типа неравенства

п

2_]aijxj ^ ^Ь ^ = 1, га, aj < Xj < A/, j = 1, п.

i=i

Если эффективность производства продукции

характеризовать суммарной выручкой от продажи продукции, то

оптимальный план х = (#i, #2, •••? #п) выпуска продукции должен

удовлетворять этим ограничениям и обеспечивать максимум

целевой функции

п

S = / jdjXj,

j=i

где rfj — цена единицы продукции j-ro наименования. В данном

случае и целевая функция, и ограничения линейны

относительно параметров оптимизации х^ j = 1, п. Поэтому

рассмотренная задача оптимального планирования выпуска продукции

является задачей линейного программирования.

Пример 1.12 (транспортная задача). Пусть

необходимо составить план перевозок некоторого товара с га складов

в п магазинов так, чтобы затраты на эти перевозки были

минимальными. Предположим, что на г-м складе, г = 1, га, имеется щ

единиц товара, а j-й магазин, j = 1, п, сделал заказ на bj единиц

этого товара, причем стоимость его перевозки с i-го склада в

j-й магазин равна сц. Обозначим через хц планируемое

количество товара, перевозимое с i-го склада в j-й магазин, тогда

стоимость его перевозки составит с^хц. Общие затраты на

перевозки — это сумма затрат на перевозки со всех складов во

все магазины. Поэтому оптимальный план перевозок

соответствует минимуму целевой функции

т п

S = ^2 ^2 CiiXii ~^ min'

i=l j=l

1.4. Задачи оптимального планирования

39

что должно быть достигнуто выбором mn значений хц ^ О,

которые в данном случае являются параметрами оптимизации.

Но при этом необходимо обеспечить потребности магазинов,

т.е. должны быть выполнены ограничения типа равенства

m

г=1

Однако с любого склада нельзя вывезти товара больше, чем

там его находится. Следовательно, должны быть выполнены

ограничения типа неравенства

п

2_\xij ^ аь i — 1? m-

J=l

Отметим, что сформулированная задача оптимизации,

относящаяся к классу задач линейного программирования, имеет

решение, если сумма заказов магазинов не превышает

суммарного запаса товара на всех складах, т.е.

n m

3=1 г=1

Пример 1.13 {задача о диете). Рассмотрим задачу

построения оптимального рациона питания. Обозначим: п —

число видов пищевых продуктов; т — число видов

питательных веществ; ац — число единиц i-го питательного вещества

в единице j-ro продукта; Ъ{ — ежегодная потребность в г-м

питательном веществе; Cj — стоимость единицы j-ro

продукта. Выясним, сколько единиц каждого пищевого продукта

нужно употребить за рассматриваемый период (в данном

случае за год) таким образом, чтобы, обеспечив потребности в

каждом питательном веществе, затратить минимальное

количество денег.

40

1. ЗАДАЧИ ОПТИМИЗАЦИИ

Назовем рационом вектор х = [х\ х^ ... хп) , где Xj —

ежегодное потребление j-ro пищевого продукта. Речь идет,

таким образом, о построении рациона минимальной стоимости.

Математически эта задача может быть сформулирована

следующим образом: минимизировать целевую функцию

п

S = ^2Cjx3 A.15)

з

при ограничениях

п

> dijXj ^ bi. г = 1, га;

j A.16)

Xj>0, j = l,n-

Пример 1.14. Предположим, что предприятие может

производить п изделий, причем затраты на производство Х{

единиц г-то изделия составляют S{x\) =а^% гДе а% — затраты

на производство одного i-го изделия (при мелкосерийном или

индивидуальном производстве обычно к{ ^ 1, а при

крупносерийном — ki < 1). Предположим также, что должно быть

выполнено так называемое условие на ассортимент:

предприятие должно выпустить не менее bi единиц i-го изделия, т.е.

имеем п ограничений типа неравенства Х{^Ь{^ г = 1, п. Если

эффективность производства изделий определить как

суммарную выручку от их продажи, то получим еще одно ограничение

типа неравенства

п

^d%x%>b, A.17)

г=1

где dj, г = 1, п, — цена единицы i-го изделия, a b — заданный

нижний уровень эффективности. При этих ограничениях

необходимо минимизировать нелинейную целевую функцию

п

г=1

1.4. Задачи оптимального планирования

41

характеризующую суммарные затраты на производство

изделий. Следовательно, сформулированная задача является

задачей нелинейного программирования.

Пример 1.15. Пусть сеть газопроводов связывает между

собой га месторождений А^ г = 1, га, газа и п пунктов В^ j =

= 1, п, его потребления с известными значениями pj ^ 0 расхода

газа в единицу времени. Производительность gi i-ro

месторождения, г = 1,га, ограничена заданным значением G^, т.е.

заданы ограничения типа неравенства 0 ^ gi ^Gi. Затраты на

добычу газа на г-м месторождении, г = 1, га, являются

функцией (pi(gi) производительности д{. Сеть состоит из К участков,

причем стоимость подачи газа по к-му участку, к = 1, К,

является функцией fk(qk) расхода q^ через этот участок. В пунктах

потребления газа имеем ограничения типа равенства

кев+ кев~

где В^~ и В^ — множества участков сети с входящими в j-й

пункт и выходящими из него потоками газа соответственно.

Аналогично для месторождений газа получаем ограничения

типа равенства

9i= 5Z ^' г = 1,т.

кел-

Оптимальным планом добычи газа на месторождениях и

распределения потоков газа по участкам сети газопроводов будет

план, который удовлетворяет указанным ограничениям и

обеспечивает минимум общих затрат

m К

S = ^2(Pi(gi) + ^2fk(qk)

г=1 к=1

на добычу и подачу газа. Все ограничения в сформулированной

задаче линейные. Поэтому в частном случае линейных функций

(fi(gi) и fk(Qk) она будет задачей линейного программирования,

но в общем случае — задачей нелинейного программирования.

42

1. ЗАДАЧИ ОПТИМИЗАЦИИ

1.5. Классы задач оптимизации

Как и в любой классификации, разделение задач

оптимизации на отдельные классы достаточно условно. Отметим, что

одна и та же прикладная задача может приводить к разным

задачам оптимизации в зависимости от того, какая

математическая модель используется при рассмотрении реального

объекта оптимизации. Ясно, что желательно применять более

простые модели, но в то же время достаточно полно

отражающие свойства объекта, существенные с точки зрения

поставленной цели, выраженной в критерии оптимальности. Поэтому

при выборе либо разработке математической модели или же

при обосновании ее упрощения необходимо достаточно четко

представлять, к какому классу будет относиться поставленная

задача оптимизации и какие методы применимы для ее

решения.

Пусть /о (ж) — целевая функция, количественно

выражающая некоторый критерий оптимальности и зависящая от

координат Xj, j' = 1, п, точки х Е W1. Эти координаты являются

параметрами оптимизации (иногда их называют также

переменными задачи оптимизации или просто переменными

задачи).

При математической формулировке задачи оптимизации

целевую функцию выбирают с таким знаком, чтобы

решение задачи соответствовало поиску минимума этой функции.

Поэтому формулировку общей задачи математического

программирования обычно записывают так:

/о(ж) —>> min, х Е О, A.18)

где ficRn — множество возможных альтернатив,

рассматриваемых при поиске решения задачи.

Любую точку х Е О называют допустимым решением

задачи математического программирования, а само множество —

множеством допустимых решений или, короче, допустимым

1.5. Классы задач оптимизации

43

множеством. Точку ж* Е О, в которой функция /о (ж)

достигает своего наименьшего значения, называют оптимальным

решением задачи.

При отсутствии ограничений множество О совпадает с

областью определения D(fo) С W1 целевой функции. Если же

рассматриваемые альтернативы должны удовлетворять

некоторым ограничениям, то множество допустимых решений

сужается.

Задачу A.18) в дальнейшем будем называть задачей

минимизации целевой функции на множестве О, понимая под этим

нахождение наименьшего значения функции fo(x) на О и точек

ж Е О, в которых оно достигается. Но целевая функция может и

не достигать на О наименьшего значения. Тогда говорят о

точной нижней грани inf fo(x) функции fo(x) на этом множестве

и вместо A.18) используют запись

/0(aO->inf, жЕО. A.19)

Отличие A.18) от A.19) в том, что в первом случае

предполагают существование точки ж* Е О, в которой целевая функция

достигает своего наименьшего значения на множестве О, а во

втором случае такая точка может и не существовать.

Поэтому решение общей задачи математического программирования

состоит в том, чтобы в первом случае найти точные (или с

некоторой заданной точностью) значения координат Xj, j = 1, n,

точки ж* Е О и значение целевой функции fo(x*) — min/o(aO,

а во втором случае построить такую последовательность {хп}

точек хп Е О, которой бы соответствовала последовательность

{/о(жп)}, сходящаяся к значению inf fo(x), и вычислить это

значение с заданной точностью. Отметим, что в большинстве

прикладных задач имеет место первый случай, поэтому

использование записи вида A.19) будем оговаривать особо.

Если fo(x) — линейная функция, то ее область определения

совпадает cW1. BRn такую функцию с помощью стандартного

44

1. ЗАДАЧИ ОПТИМИЗАЦИИ

скалярного произведения можно представить в виде fo(x) =

= (с, ж), где с— (ci, ..., сп) Е Мп — известный вектор. Ясно,

что целевая функция

п

fo(x) = (c,x) = ^2cjxj

i=i

может достигать наименьшего значения /о(ж*) на множестве

О лишь в точках границы <90 этого множества. Если в задаче

нет ограничений, то О = Rn и точная нижняя грань линейной

функции равна — оо. Поэтому в случае линейной целевой

функции задача оптимизации

(с, ж)-яшп, жЕМп, A.20)

имеет смысл лишь при наличии ограничений.

В частном случае, когда заданы линейные ограничения

типа равенства

Bx = d, жеГ, A.21)

где d ЕШк, В — матрица размера к х п, а параметры

оптимизации могут принимать лишь неотрицательные значения, т.е.

Xj>0, j=I~^, A.22)

соотношения A.20)-A.22) составляют стандартную задачу

линейного программирования, или задачу линейного

программирования в стандартной форме (в литературе ее часто

называют канонической задачей линейного

программирования, или задачей линейного программирования в канонической

форме).

Условия A.22) можно представить в виде х Е Щ, где К^ —

декартово произведение п множеств R* неотрицательных

действительных чисел, называемое иногда неотрицательным

ортантом размерности п. Если к A.20)-A.22) добавить т

1.5. Классы задач оптимизации

45

ограничении типа неравенства

п

^ctijXj <6m, A.23)

где a,ij (Е М, г = 1, га, то соотношения A.20)-A.23) приведут к

формулировке общей задачи линейного

программирования. При этом ограничения A.22) могут относиться не ко всем

п параметрам оптимизации, а лишь к некоторым из них. При

отсутствии ограничений типа равенства соотношения A.20),

A.22) и A.23) составляют формулировку основной задачи

линейного программирования (иногда ее называют

естественной задачей линейного программирования).

Неравенства Xj ^ aj, Xj ^ bj и aj ^ Xj ^ bj, j = 1, п,

называют прямыми ограничениями на переменные задачи, причем

последнее относят к двусторонним, а первые два — к од-

носторонним. Таким образом, ограничения A.22) являются

прямыми односторонними. Методы решения задач

линейного программирования подробно рассмотрены и обоснованы

в [XX].

Если при линейных ограничениях минимизируемая целевая

функция помимо линейной комбинации вида A.20) включает

положительно определенную квадратичную форму, т.е.

(с, х) + - (Qx, х) ->> min, A-24)

где Q — положительно определенная матрица порядка п, то

говорят о задаче квадратичного программирования, а

функцию вида A.24) называют квадратичной. В случае,

когда целевая функция является отношением двух линейных

функций, а ограничения линейны, имеем задачу дробно-

линейного программирования. Ее формулировка включает

ограничения A.21)-A.23) и условие минимума функции

(q,x)+a .

--ишп, A-25)

(г,х)+Р

46

1. ЗАДАЧИ ОПТИМИЗАЦИИ

где g Е Mn, rGRn, ckGMh/^gM заданы. Соотношения

( п

/о (ж) = ^/ij(zj) ->> min;

j=i

J n

I 9i(x) = J^&jfaj) < 7b « = 1, m;

Uj>0, j = l,n,

где 7^ E R заданы, определяют задачу сепарабелъного

программирования. В этой задаче целевая функция fo(x) и

функции gi(x) в левой части ограничений являются суммой

функций, каждая из которых зависит только от одного параметра

оптимизации. В этом случае функции fo(x) и gi{x) называют

сепарабелъными.

В прикладных задачах целевая функция нередко имеет вид

т

у(х) = ^СгРг(х), A.27)

г=1

где х = (жх, ..., хп) Е R+, с^ Е 1R+, a R™ — декартово

произведение п множеств IR+ положительных действительных чисел,

называемое иногда положительным ортантом. При этом

функции^(ж) имеют вид

п

Рг(х) = Цх?, A.28)

J = l

где dij Е R. Требование положительности коэффициентов с^,

г = 1,771, послужило причиной того, что такой вид целевой

функции стали называть позиномом в отличие от полинома

(многочлена), в котором коэффициенты могут быть и

неположительными. Кроме того, в многочлене показатели степени

аргументов являются целыми неотрицательными числами, а в

позиноме благодаря положительности параметров оптимизации

A.26)

1.5. Классы задач оптимизации

47

выражение x-lj определено для любых действительных чисел

ctij. Если целевая функция и левые части ограничений типа

равенства и (или) неравенства в задаче минимизации являются

позиномами, то такую задачу называют задачей

геометрического программирования.

В задаче нелинейного программирования ограничения

могут быть заданы в неявном виде. Тогда множество О

возможных альтернатив приходится строить путем количественного

анализа математической модели объекта оптимизации (см.

пример 1.10). Если ограничения принадлежат к типам равенства и

(или) неравенства

Мх)=0, l = T7k; 9i(x)^0, г = Т^, A.29)

но хотя бы одна из функций fi(x), gi(x) или целевая функция не

является линейной, то говорят об общей задаче нелинейного

программирования. Ясно, что такая формулировка

включает задачи квадратичного, дробно-линейного, сепарабельного и

геометрического программирования.

Среди целевых функций достаточно широкий класс

составляют выпуклые функции. Во многих прикладных задачах

оптимизации область допустимых значений параметров

оптимизации оказывается выпуклым множеством. В такой области

целевая функция может сохранять одно и то же

направление выпуклости, т.е. выпукла либо вниз (выпукла), либо вверх

(вогнута). Например, зависимость эффективности

технического устройства от параметров оптимизации является вогнутой

функцией. Дело в том, что чем выше технические

характеристики устройства, тем труднее добиться его дальнейшего

совершенствования и существенного приращения эффективности.

Наоборот, целевые функции, выражающие массу, габариты или

стоимость технического устройства, по тем же причинам

обычно выпуклы.

Аналогичная ситуация характерна и для функций,

описывающих экономические системы. Например, рост объема

выпускаемой продукции происходит не прямо пропорционально

48

1. ЗАДАЧИ ОПТИМИЗАЦИИ

капиталовложениям или количеству используемых ресурсов, а

с замедлением, причем это замедление часто тем больше, чем

больше объем производства. Это приводит к вогнутости так

называемых производственных функций, выражающих

зависимость объема выпускаемой продукции от израсходованных

ресурсов. Наоборот, при фиксированном объеме производства

дальнейшее снижение производственных затрат и стоимости

единицы продукции по сравнению с достигнутым уровнем

также происходит с замедлением, что приводит к выпуклости

целевых функций, описывающих стоимостные характеристики

производства.

Ясно, что любую вогнутую целевую функцию, изменив знак,

можно сделать выпуклой. Задачи оптимизации, в которых

необходимо найти наименьшее значение выпуклой целевой

функции, рассматриваемой на выпуклом множестве, относят к

задачам выпуклого программирования. Частными случаями

таких задач являются задачи квадратичного и линейного

программирования. Задачи геометрического программирования

при некоторых дополнительных условиях также являются

задачами выпуклого программирования.

Если множество О допустимых решений оказывается

конечным множеством, то мы имеем задачу дискретного

программирования, а если к тому же координаты этих точек —

целые числа, то — задачу целочисленного

программирования. Такие задачи (в том числе для линейной целевой

функции) рассмотрены в [XX].

Вопросы и задачи

1.1. Решите задачи, рассмотренные в примерах 1.1 и 1.2,

как путем построения функции Лагранжа, так и исключением

из целевой функции одного из параметров оптимизации.

1.2. Получите A.3) из необходимого условия экстремума

функции A.2).

Вопросы и задачи

49

1.3. Найдите решение задач, рассмотренных в примерах 1.6

и 1.7, как путем построения функции Лагранжа, так и

исключением из целевой функции одного из параметров оптимизации.

1.4. Классифицируйте рассмотренные в 1.2-1.4 задачи,

отнеся каждую из них к тому или иному (или нескольким

сразу) классу задач оптимизации и к одному или нескольким

вариантам формулировок, рассмотренных в 1.5.

1.5. Найдите максимальное и минимальное значения

функции r](h/H) A.1) при h/H Е [0, 1] и сравните результат с

полученным в примере 1.3.

1.6. Используя необходимые и достаточные условия

экстремума функции одного переменного, убедитесь, что функция

/(а), рассмотренная в примере 1.4, достигает максимума в

точке а* = 3.

1.7. Решите задачу оптимального проектирования бака

горючего, аналогичную рассмотренной в примере 1.6, но при

заданной площади S расходуемого листового материала

максимизируйте объем бака.

1.8. Как из прямоугольной листовой заготовки с

отношением сторон 1 : 2 вырезать круговой сектор, из которого можно

было бы изготовить коническую воронку наибольшего объема?

1.9. Покажите, что геометрический момент инерции

квадратного сечения относительно любой оси, лежащей в

плоскости квадрата со стороной R\f2 и проходящей через его центр,

постоянен и равен J = i?4/3 (см. пример 1.7).

2. МЕТОДЫ ОДНОМЕРНОЙ

МИНИМИЗАЦИИ

2.1. Предварительные замечания

В некоторых случаях ограничения в задаче оптимизации

позволяют через один из параметров оптимизации выразить

остальные и исключить их из целевой функции. В результате

задача будет сведена к поиску наибольшего или

наименьшего (в зависимости от цели оптимизации) значения скалярной

действительной функции /(ж), х Е D(f) С R, выражающей

критерий оптимальности. Выбирая тот или иной знак перед этой

функцией, всегда можно ограничиться лишь поиском ее

наименьшего значения в области определения D(f), заданной с

учетом ограничений на параметр оптимизации х. Поэтому

далее в этой главе будем рассматривать задачу

f(x) -> min, х Е D(f) С R, B.1)

поиска наименьшего значения /* = f(x*) функции f(x) и точки

х* Е D(f), в которой f(x) принимает это значение. Для

краткости будем говорить об одномерной минимизации, имея в

виду нахождение наименьшего значения функции f(x) на

множестве D(f) и точек, в которых это значение достигается.

Изучение методов одномерной минимизации важно не

только для решения задачи B.1), имеющей самостоятельное

значение. Эти методы являются также существенной составной

частью методов многомерной минимизации, при помощи

которых находят наименьшее значение действительных функций

многих переменных.

Пусть область определения D(f) функции f(x) есть

промежуток числовой прямой. Напомним [II], что если D(f) —

2.1. Предварительные замечания

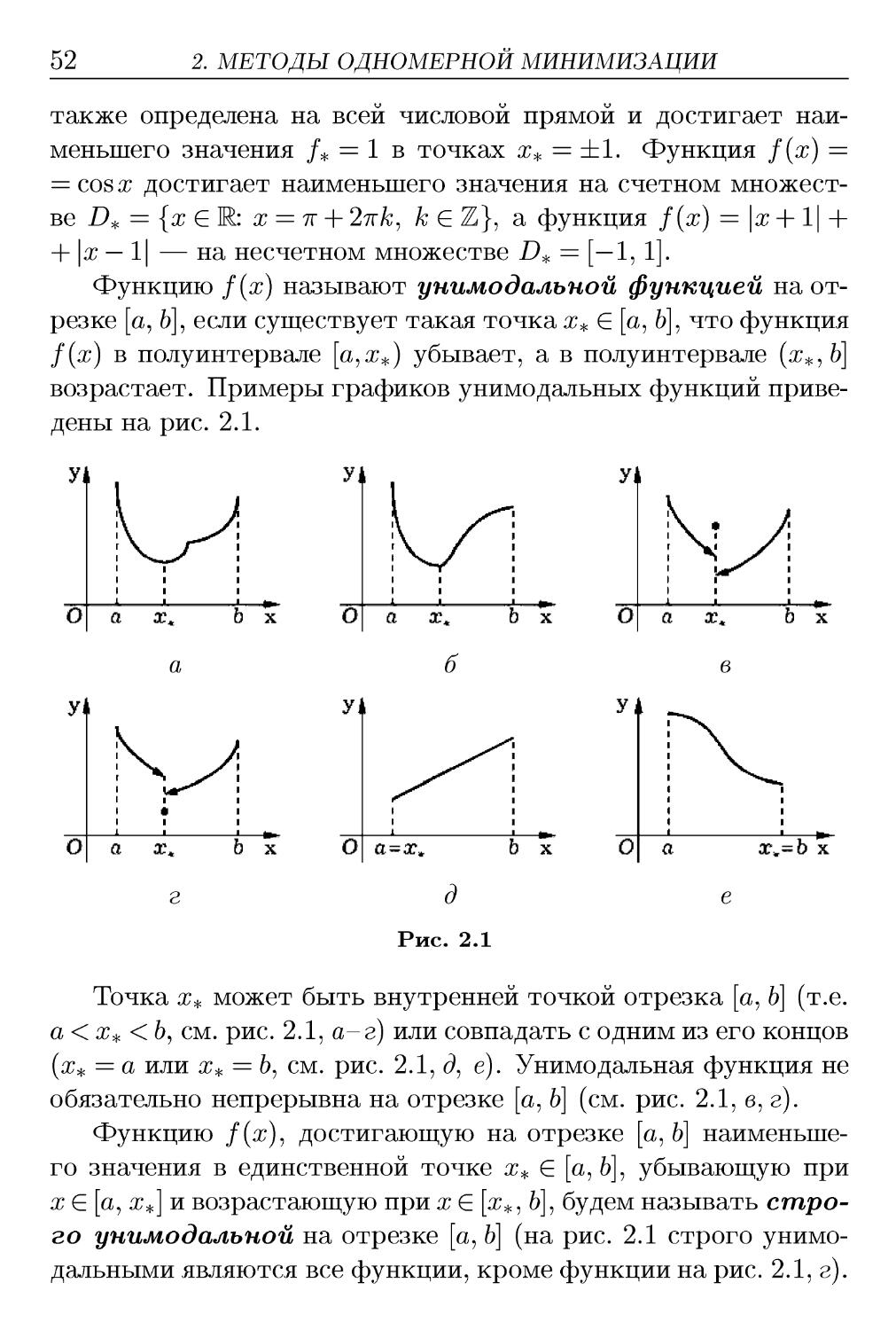

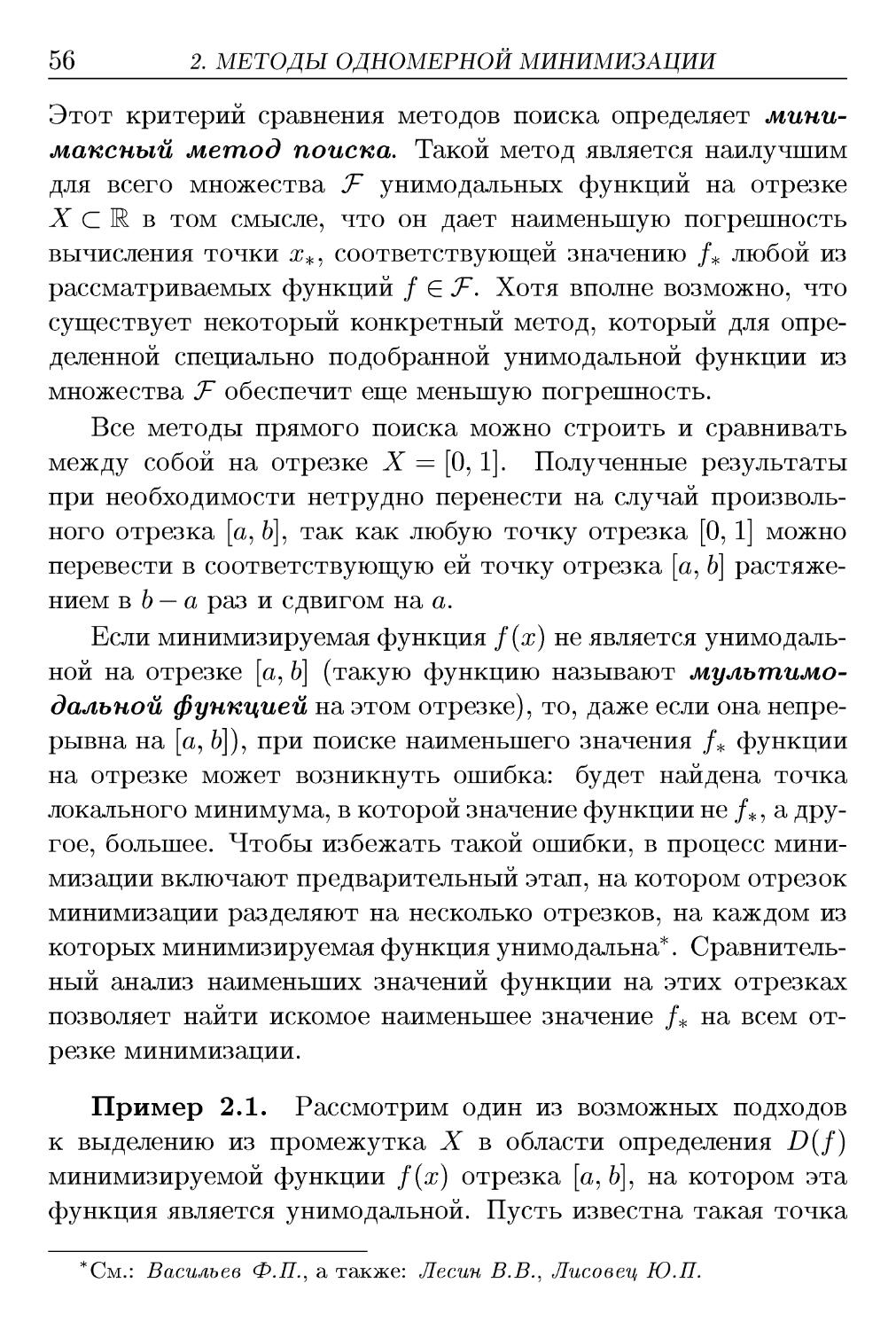

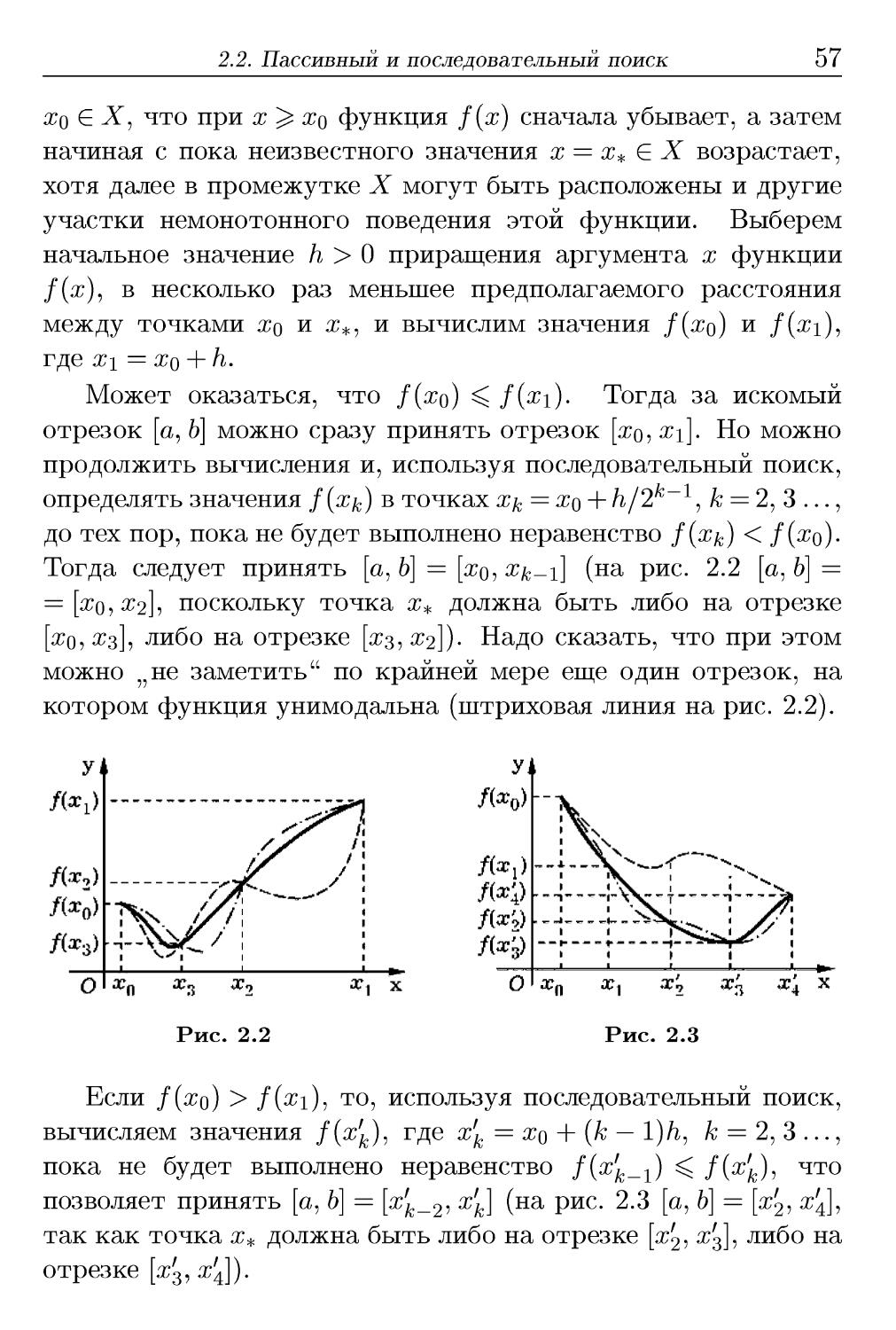

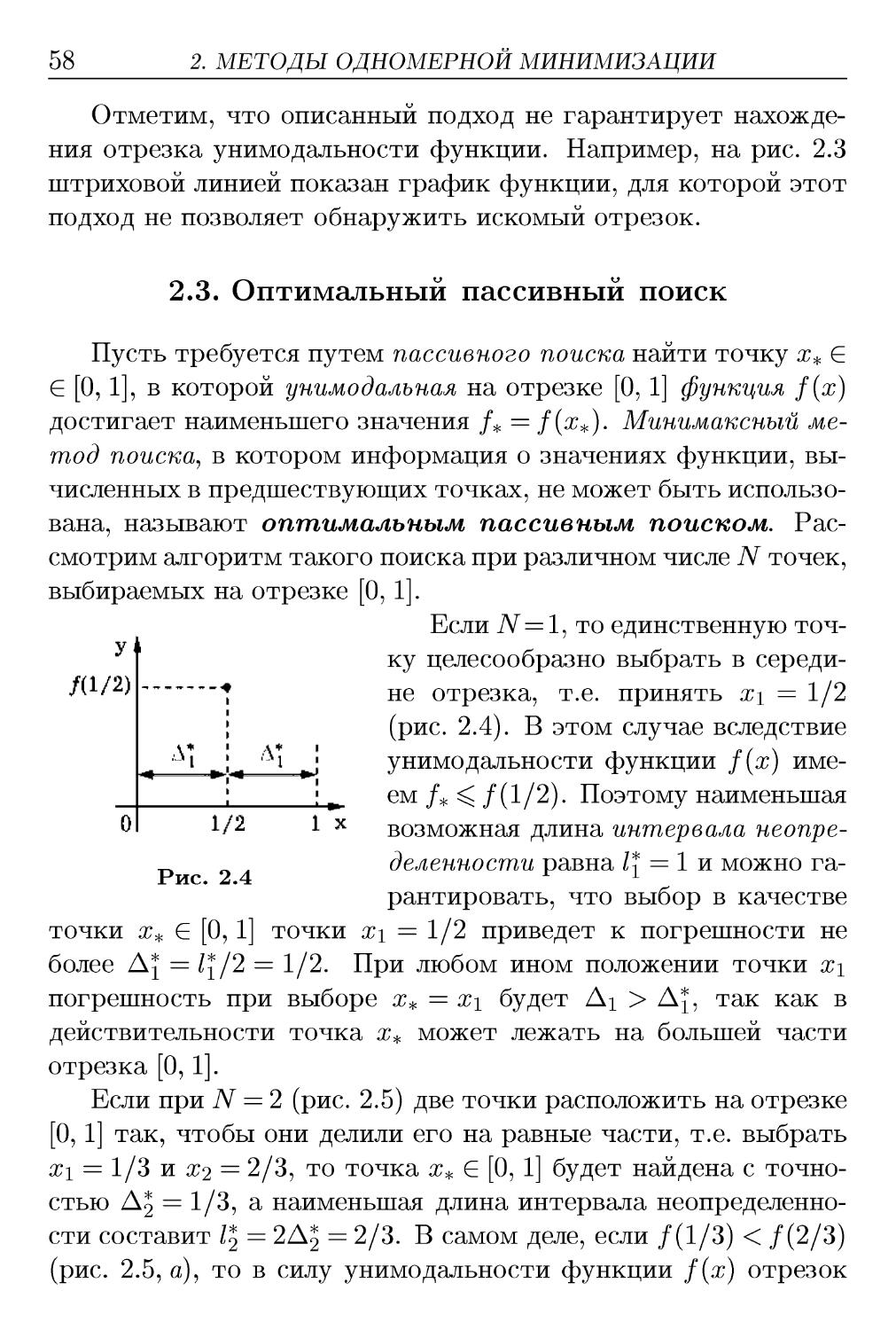

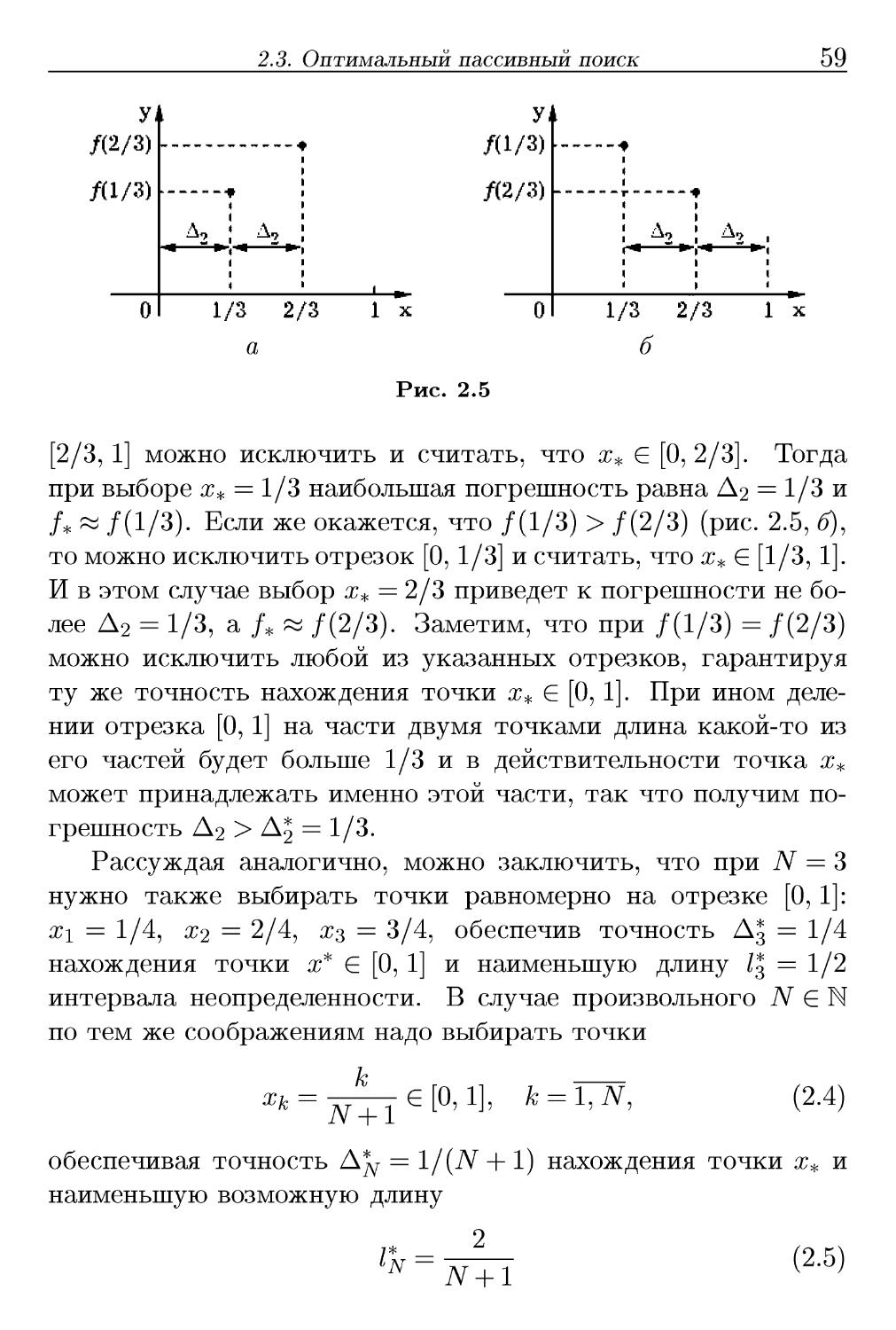

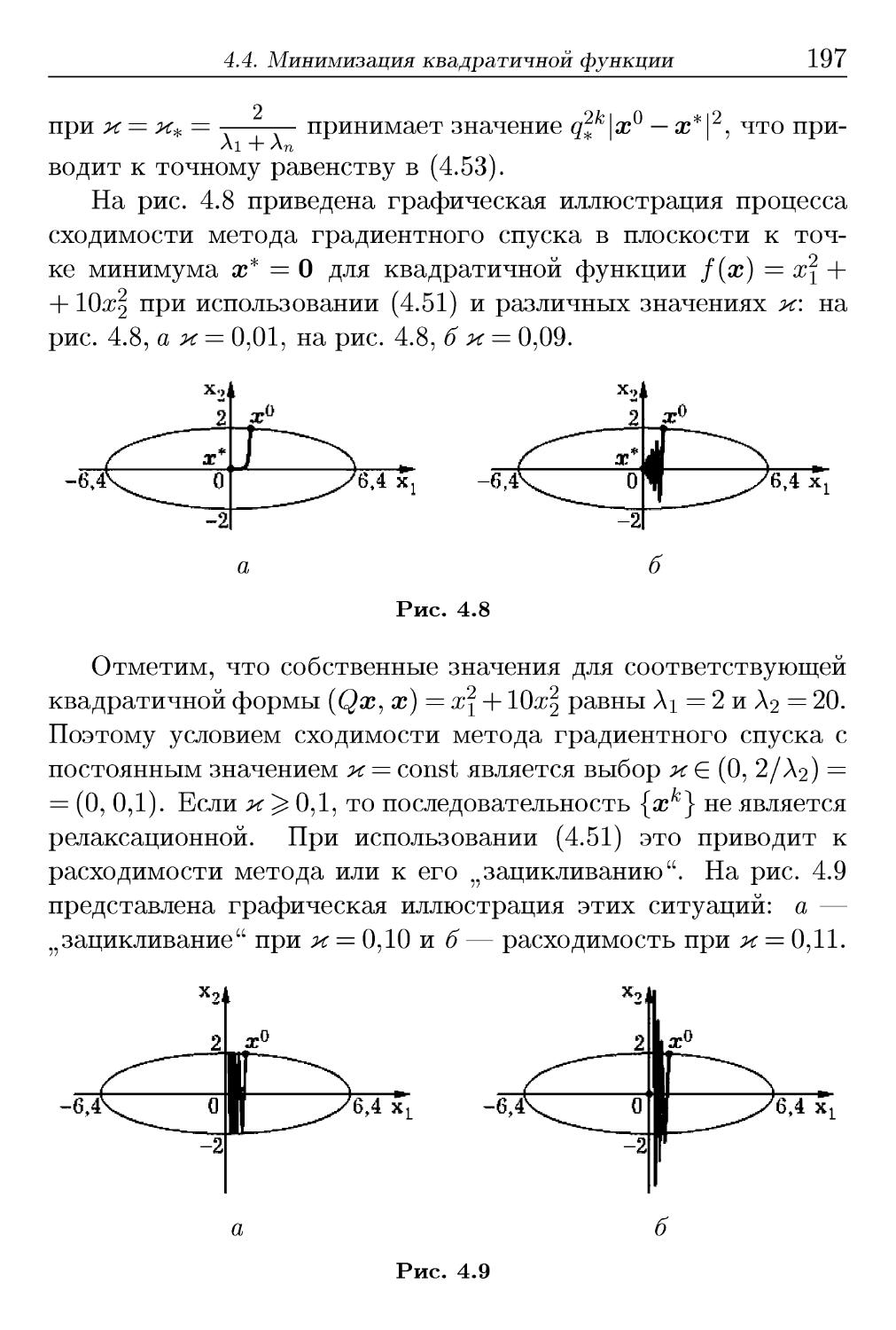

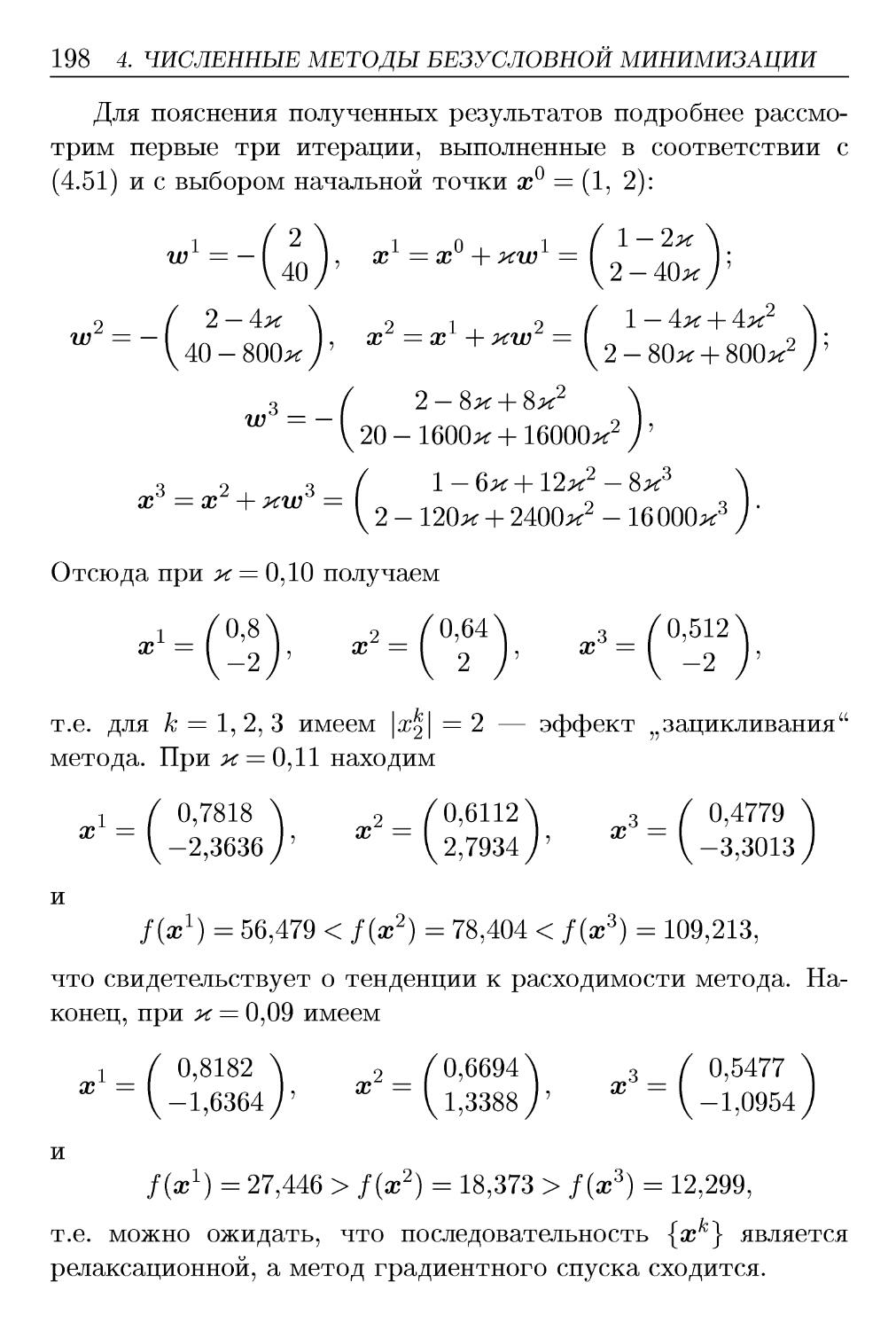

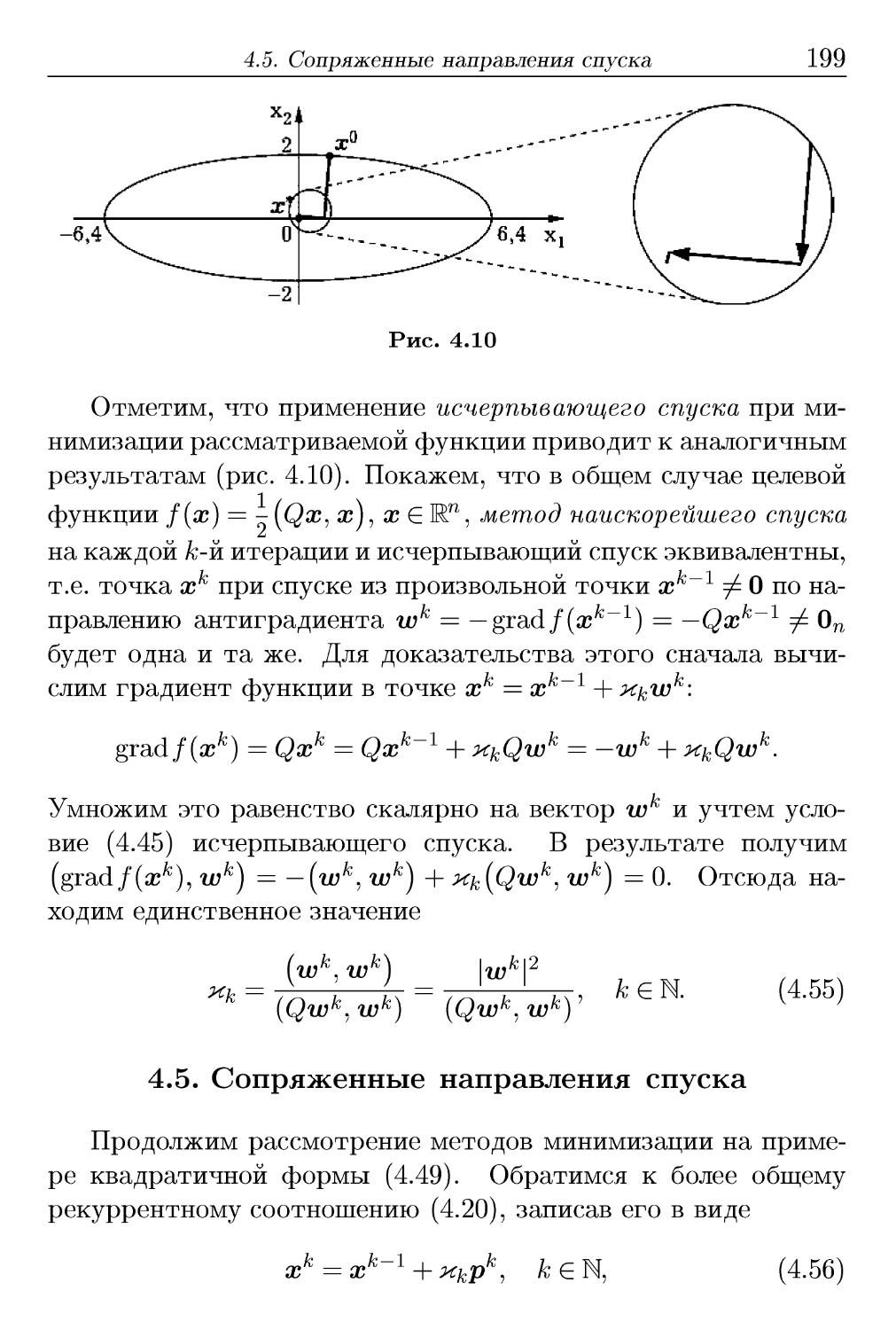

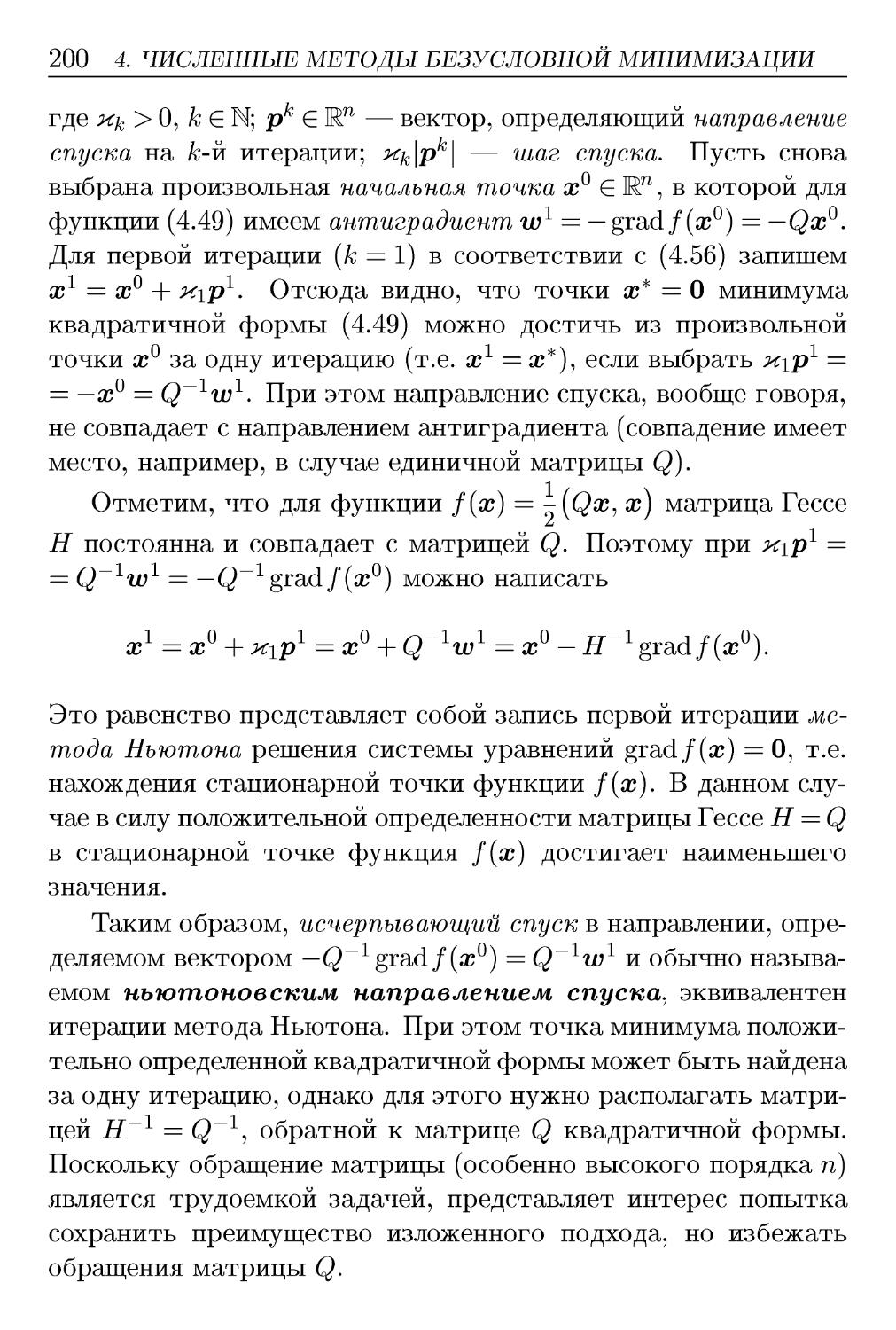

51