Author: Леондес К.Т.

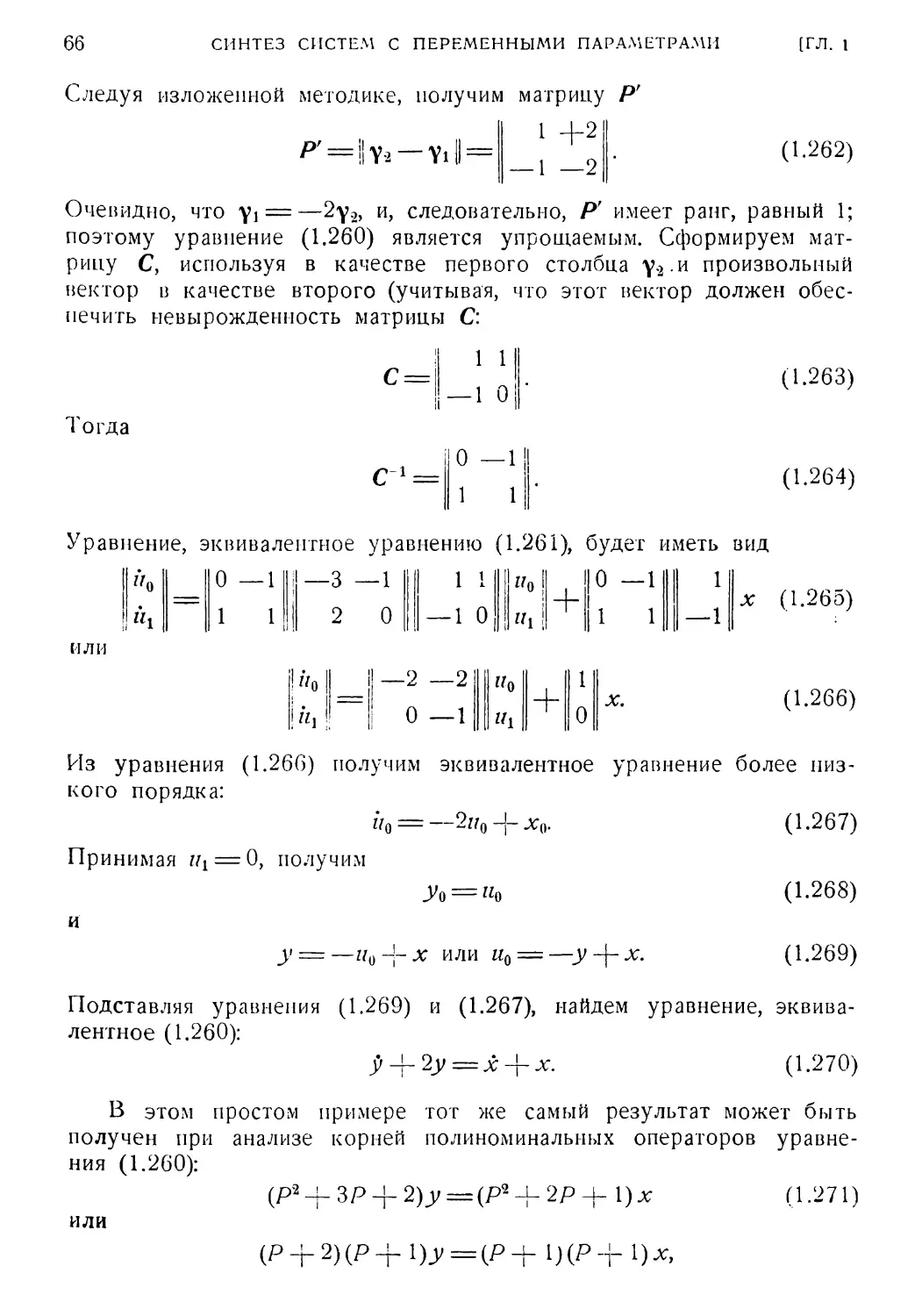

Tags: математика системы управления теория автоматического управления

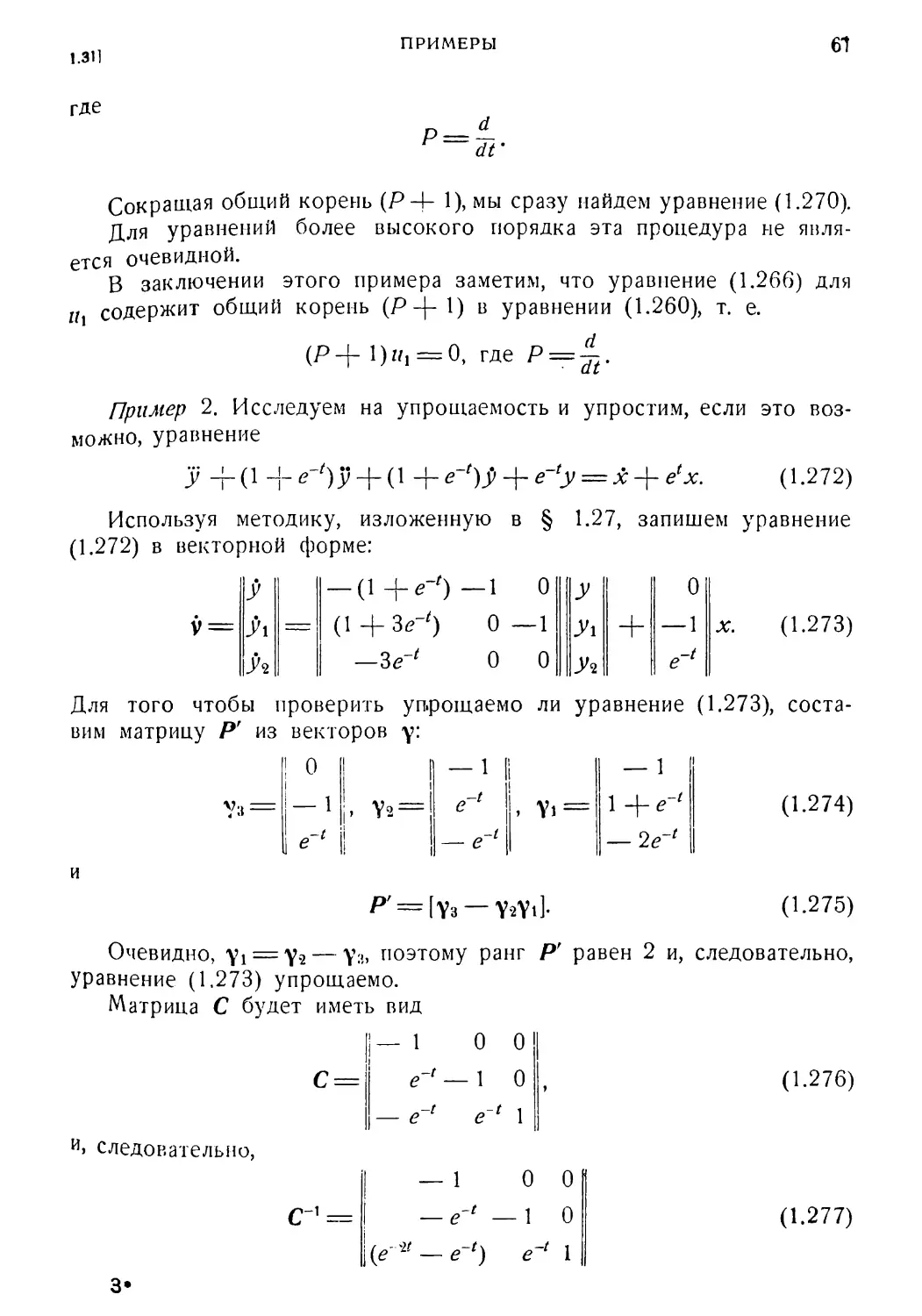

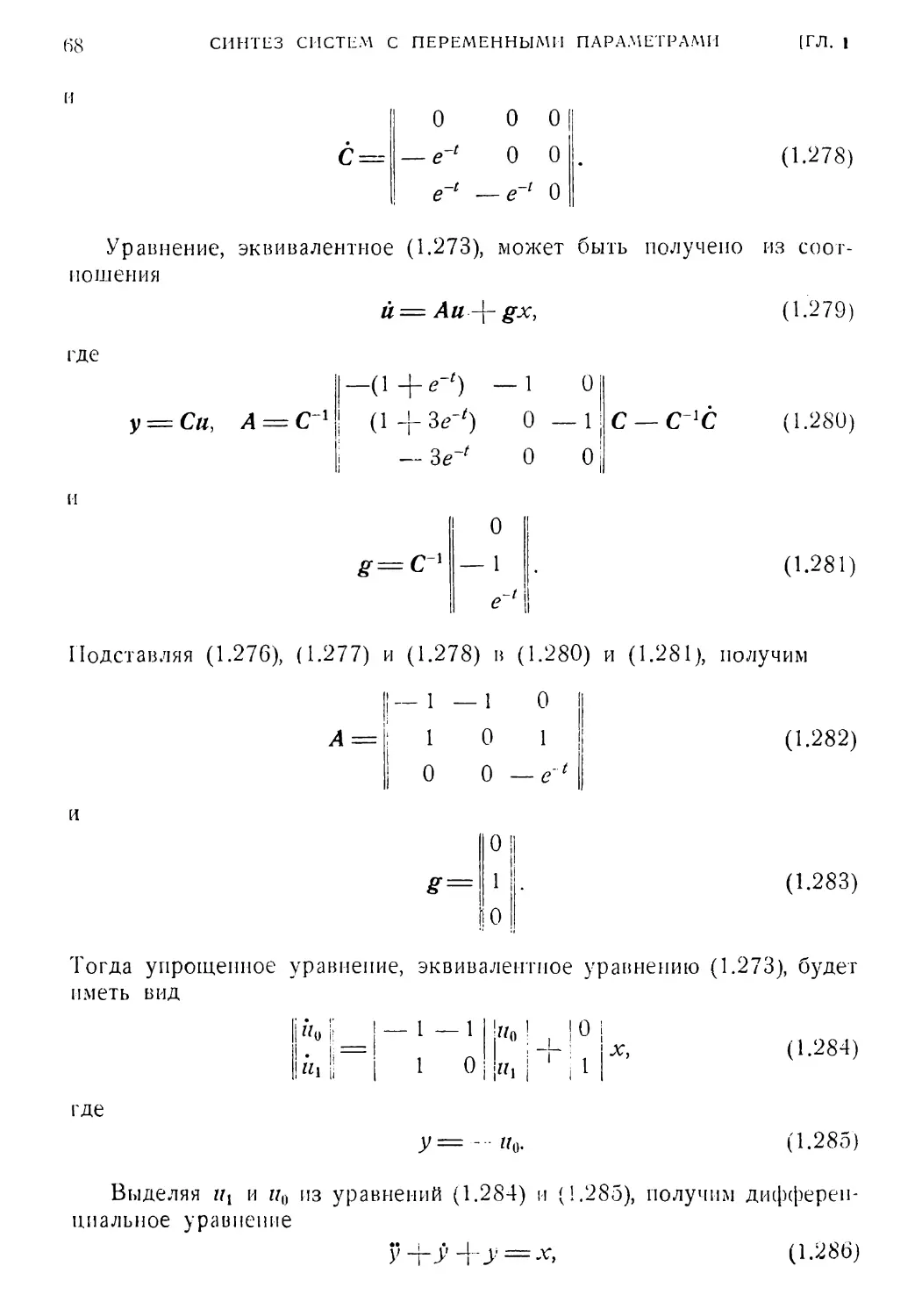

Year: 1970

Text

MODERN CONTROL

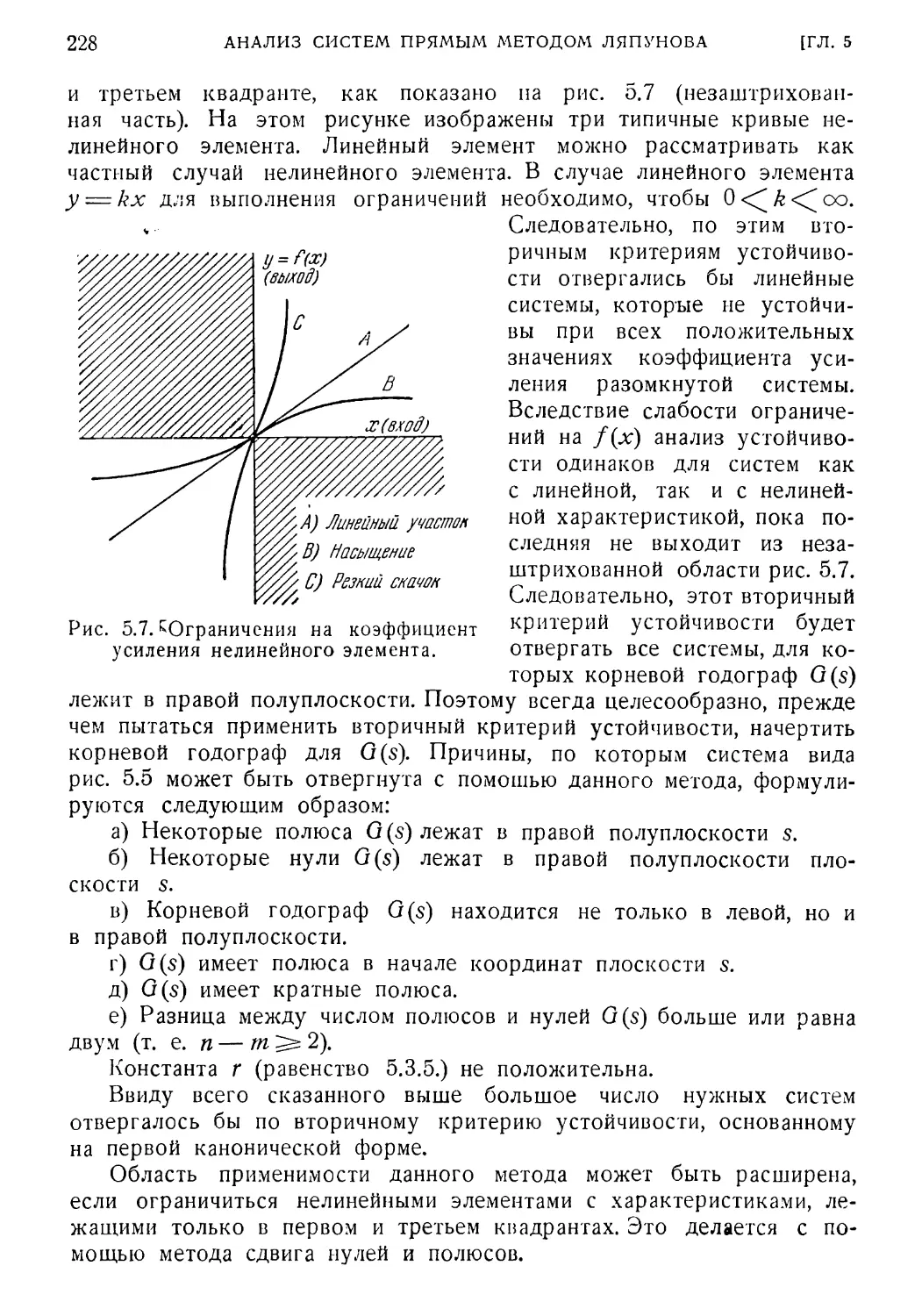

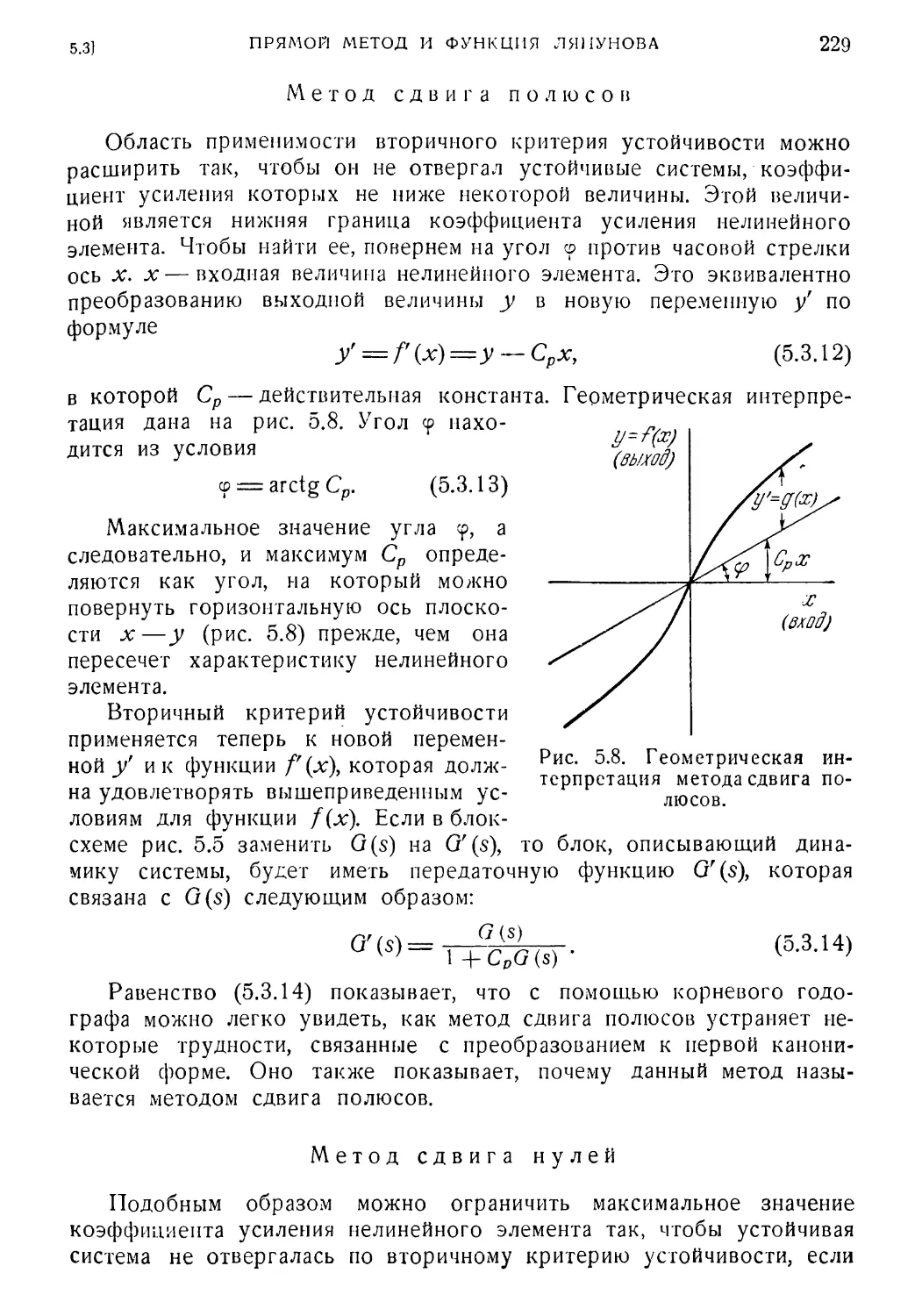

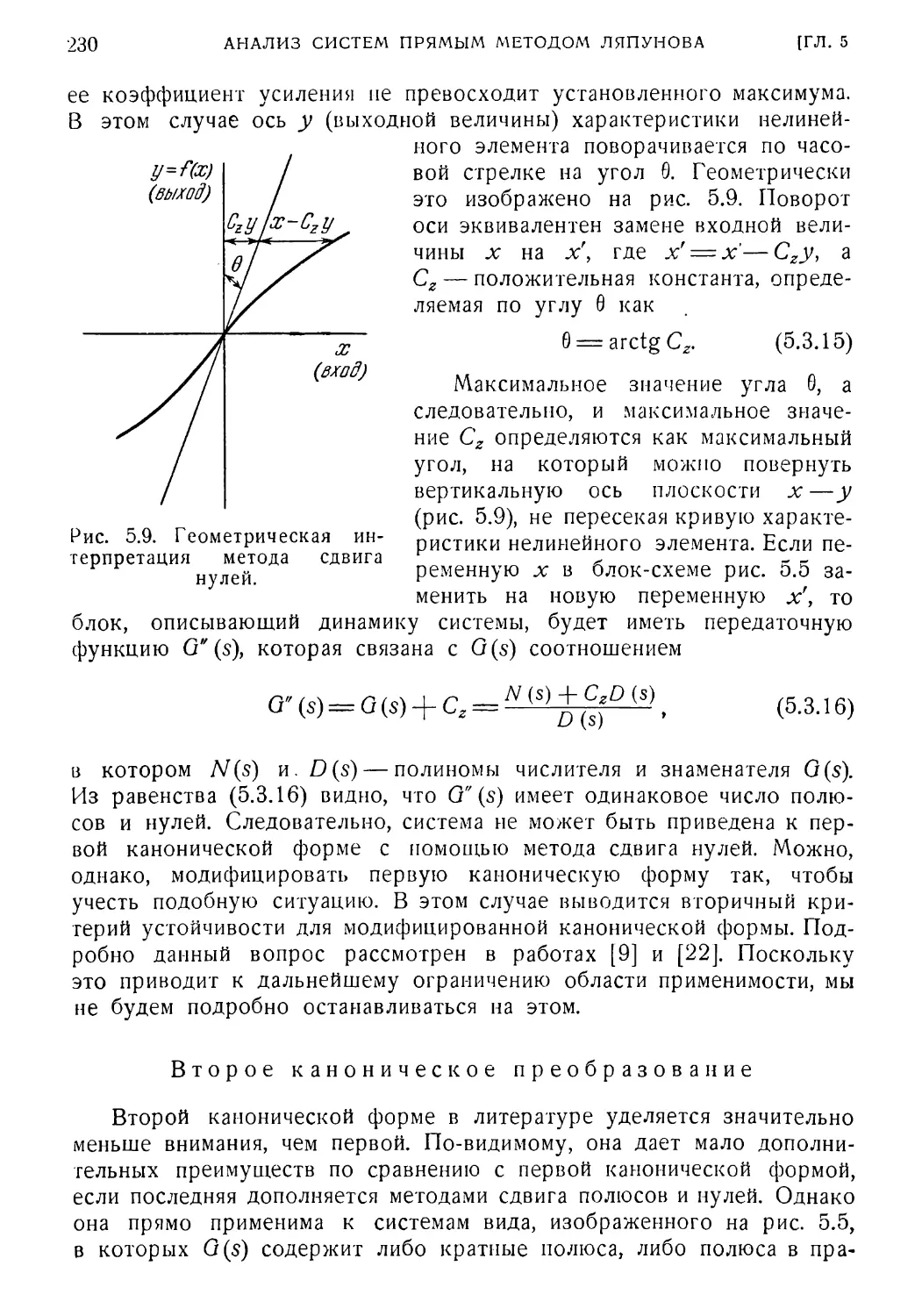

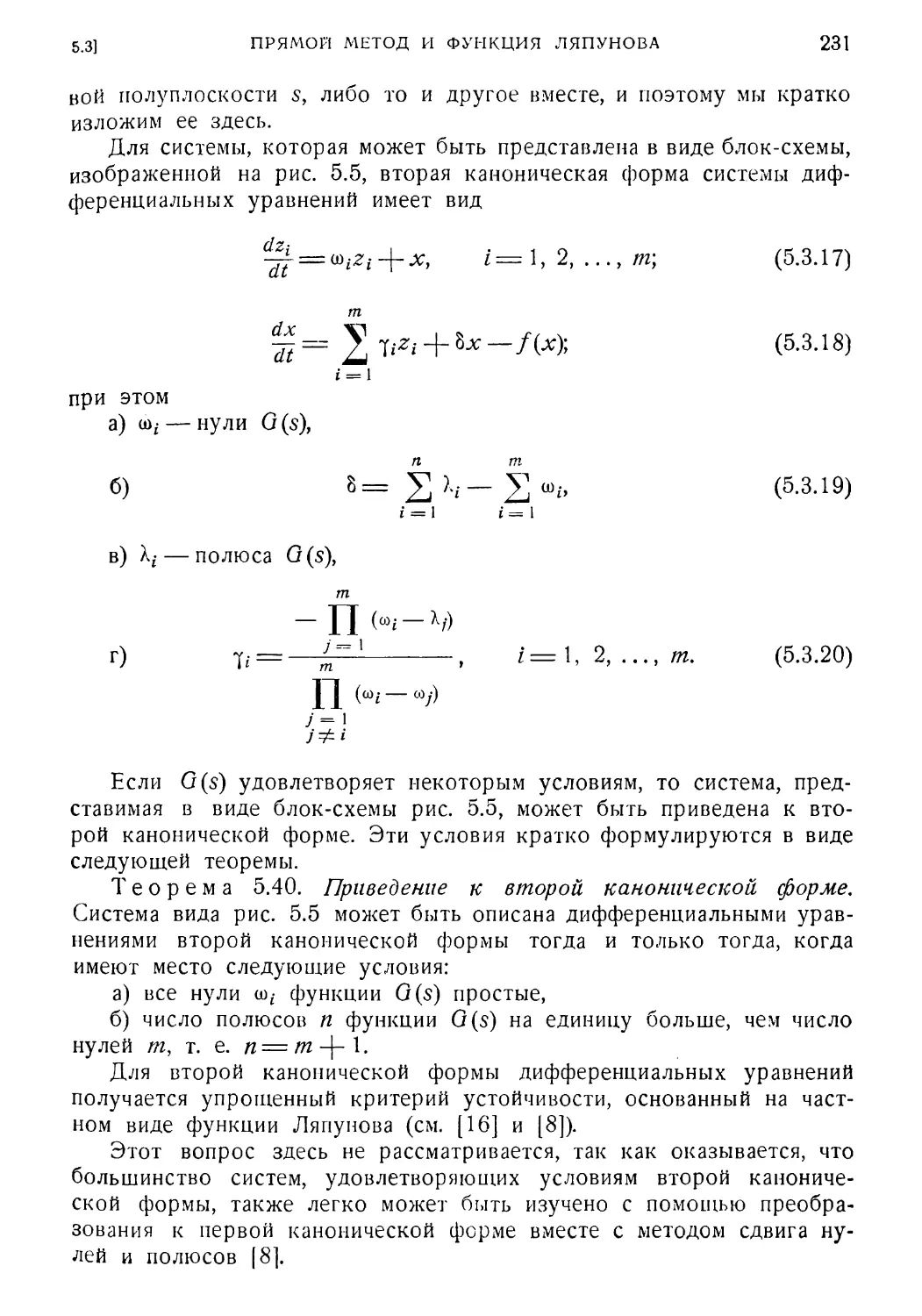

SYSTEMS THEORY

MASANAO AOK1, GEORGE A. BEKEY,

DALE D. DONALSON, H. C. HSIEN,

FRANCIS H. KISHI, JAMES S. MEDITCH,

RICHARD A. NESBIT. PETER R. SCHULTZ,

EDWIN B. STEAR, ALLEN R. STUBBERUD

Edited by

CORNELIUS T. LEONDES

Professor of Engineering

University of California, Los Angeles

McGRAW-HILL BOOK COMPANY, INC.

NEW YORK ST. LOUIS TORONTO LONDON SANFRANCISCO SYDNEY

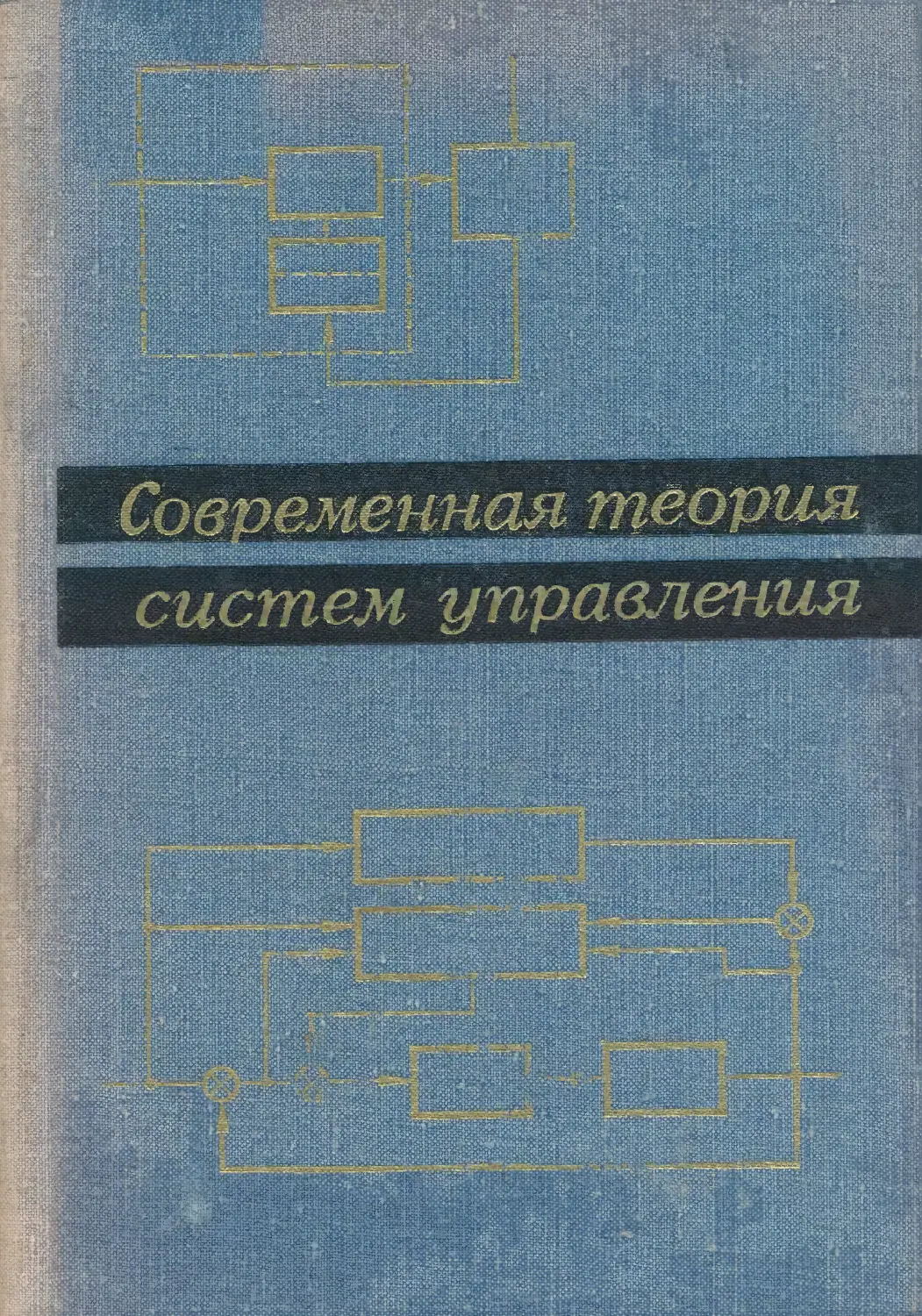

СОВРЕМЕННАЯ ТЕОРИЯ

СИСТЕМ УПРАВЛЕНИЯ

Под редакцией

К. Т. ЛЕОНДЕСА

Перевод с английского

Я. А. КОГАНА, Ю. Э. САГАЛОВА,

И. В. ТИМЕ

Под редакцией

Я. 3. ЦЫГ1КИНА

ИЗДАТЕЛЬСТВО «НАУКА*

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1970

6П2. 15

С 56

УДК 519.95

Современная теория систем управления, под редакцией К. Т. Л е о н-

дес а, Главная редакция физико-математической литературы изд-ва

«Наука», М., 1970, 512 стр.

В книге нашли отражение основные методы теории систем управления,

появившиеся к началу 60-х годов.

Основное содержание книги включает в себя вопросы, ранее не изла¬

гавшиеся в советской литературе (исключение представляют главы 7 и 11,

посвященные принципу максимума и анализу и синтезу дискретных систем,

и отчасти главы 1 и 4, в которых рассматриваются методы синтеза линейных

систем с переменными параметрами и методы построения формирующихся

фильтров для случайных процессов).

Главы 3 и 8 вводят читателя в круг идей функционального анализа.

Приводятся примеры применения методов функционального анализа к реше¬

нию прикладных задач управления. В главе 2 излагается, в частности, вывод

уравнений фильтрации Калмэна — Быоси для случая непрерывного времени.

В главе 5 изложены методы анализа нелинейных систем управления с по¬

мощью прямого метода Ляпунова. В главе 6 рассматриваются различные

методы синтеза аддитивных систем. В главе 9 сравниваются различные анали¬

тические методы синтеза оптических линейных систем управления, в частно¬

сти метод динамического программирования и принцип максимума Л. С. Пон-

трягина. Глава 10 является по существу введением в применение методов

стохастической аппроксимации к задачам автоматического управления.

В главе 12 дается описание человека-оператора в системе управления. В главе

13 современные методы анализа и синтеза применяются к системам управ¬

ления летательными аппаратами.

Илл. 93. Библ. 423 назв.

3-3-13

140-69

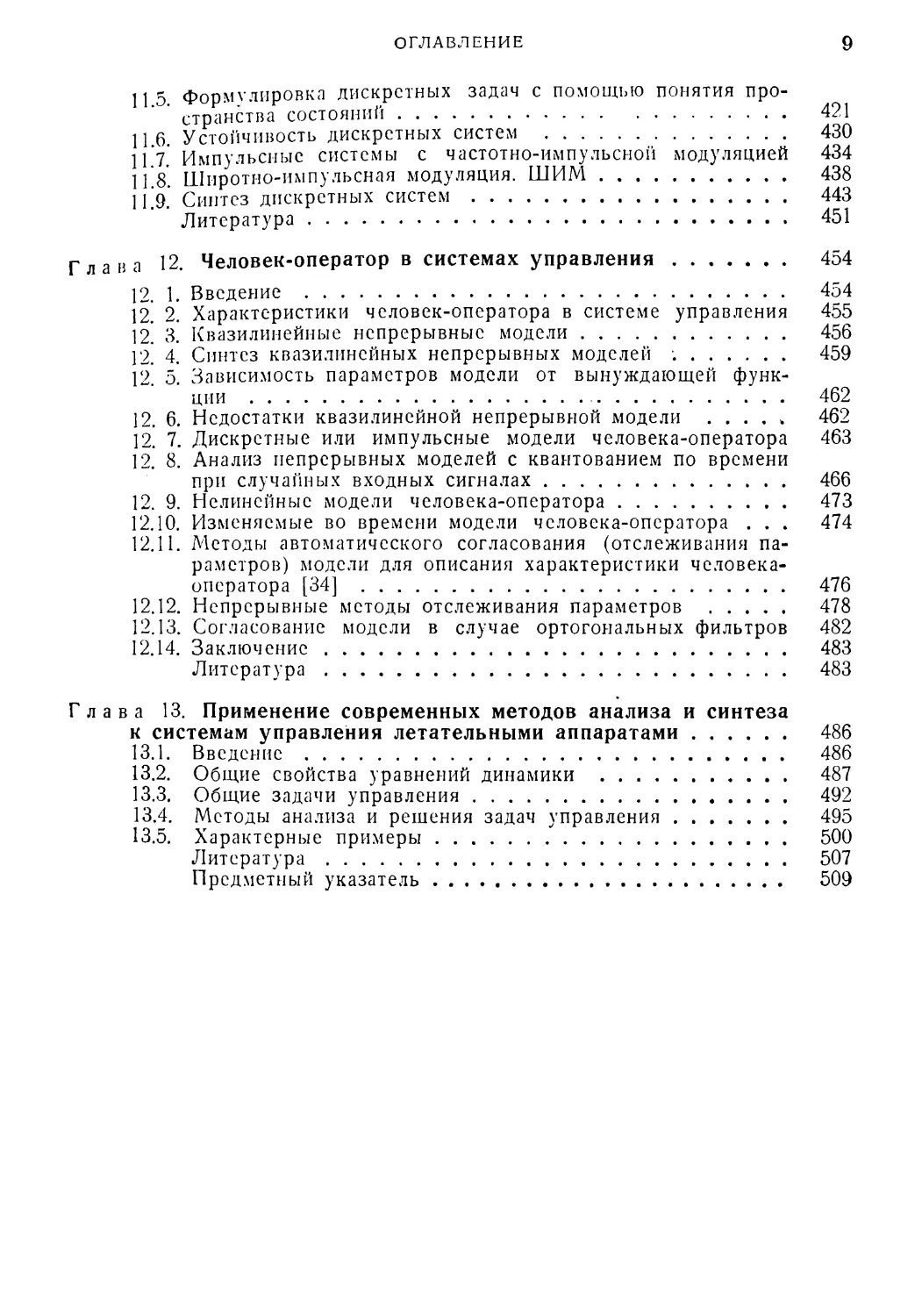

ОГЛАВЛЕНИЕ

От редактора русского перевода

Предисловие

Глава 1. Методы синтеза линейных систем автоматического

управления с переменными параметрами 17

1. 1. Некоторые характеристики линейных систем 17

1. 2. Некоторые свойства уравнения (1.1) 18

1. 3. Определение дифференциального уравнения по весовой

функции 21

1. 4. Алгебра линейных дифференциальных уравнений 23

1. 5. Необходимые операции 23

1. 6. Умножение двух дифференциальных уравнений 25

1. 7. Единичный элемент 27

1. 8. Обратный элемент операции умножения 28

1. 9. Сложение двух дифференциальных уравнений 29

1.10. Нулевой элемент 31

1.11. Обратный элемент операции сложения 31

1.12. Умножение дифференциального уравнения на скаляр ... 31

1.13. Синтез методом сокращения оператора объекта 32

1.14. Синтез системы регулирования с обратной связью при из¬

меняемом объекте 34

1.15. Синтез системы регулирования при неизменном объекте 34

1.16. Пример 35

1.17. Замечания 36

1.18. Ограничения, накладываемые на выбор дифференциального

уравнения всей системы 36

1.19. Алгебраический метод синтеза 37

1.20. Пример 40

1.21. Замечания 41

1.22. Задача аппроксимации 42

1.23. Метод аппроксимации в случае полиномиальных входных

сигналов " 42

1.24. Метод аппроксимации в случае входных сигналов неполи¬

номиального вида 45

1.25. Пример 47

1.26. Аппроксимация разложимых функций 49

1.27. Синтез дифференциальных уравнений с переменными коэф¬

фициентами при помощи аналоговых моделирующих

устройств 53

1 ос ^пР0111сние линейных систем 56

1.29. Эквивалентные системы 56

6

ОГЛАВЛЕНИЕ

1.30. Упрощасмость 60

1.31. Примеры 65

1.32. Аппроксимация линейных дифференциальных уравнений 69

1.33. Наилучшая в смысле метода наименьших квадратов

аппроксимация решений алгебраических уравнений .... 69

1.34. Аппроксимация дифференциального уравнения уравнением

более низкого порядка 70

1.35. Пример 74

1.36. Увеличение порядка интегрального и дифференциального

операторов 76

1.37. Оценка ошибки аппроксимации • 80

1.38. Пример 83

1.39. Заключение 85

Литература 85

Глава 2. Синтез систем со случайными воздействиями 87

Раздел I. Оптимальный синтез многомерных систем со стационарными

случайными воздействиями 87

2. 1. Введение 87

2. 2. Постановка задачи многомерной непрерывной фильтрации

в смысле Винера 88

2. 3. Минимизация ошибки системы 90

2. 4. Оптимальное уравнение в области изображений 92

2. 5. Нахождение оптимальной матрицы передаточных функций

методом неопределенных коэффициентов 95

2. 6. Пример синтеза многомерного фильтра 99 .

2. 7. Нахождение матрицы оптимальных передаточных функций

методом факторизации матрицы спектральных плотностей 101

2. 8. Факторизация рациональной матрицы спектральных плот¬

ностей 103

2. 9. Обсуждение методов решения задачи синтеза оптимальных

многомерных фильтров 111

2.10. Оптимальный синтез многомерных систем управления

с полужесткой структурой 111

Раздел II. Дополнительные аспекты синтеза систем со случайными

входами 114

2.11. Методы описания случайных процессов 114

2.12. Синтез систем с нестационарными входами 119

2.13. Метод моделирования сопряженной системы 125

2.14. Заключительные замечания 132

Литература 132

Глава 3. Функциональный анализ и его применение к задачам

минимума среднеквадратичной ошибки ... 137

Раздел I. Некоторые основные понятия функционального анализа . . . 137

3.1. Введение 137

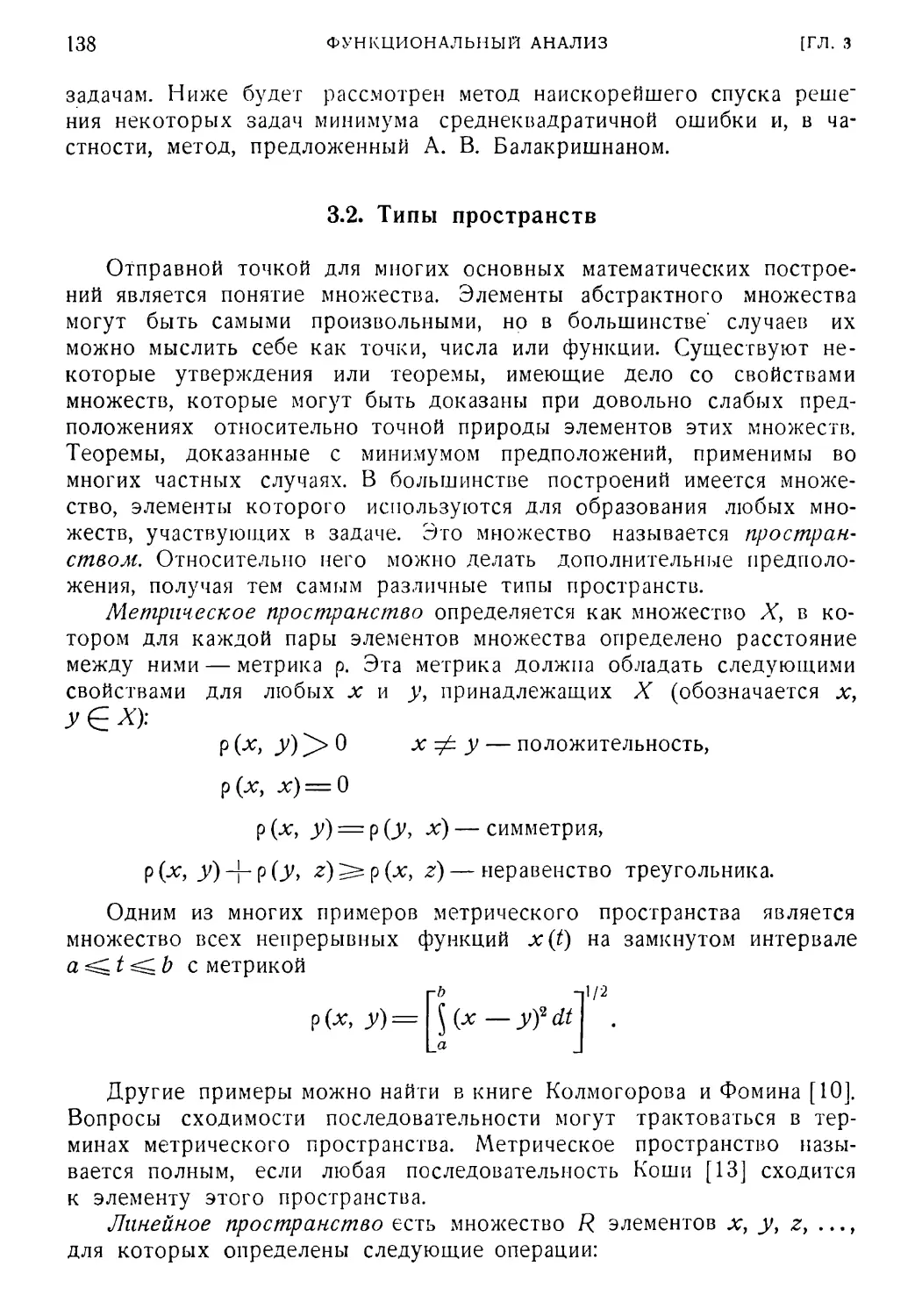

3.2. Типы пространств . . . . . 138

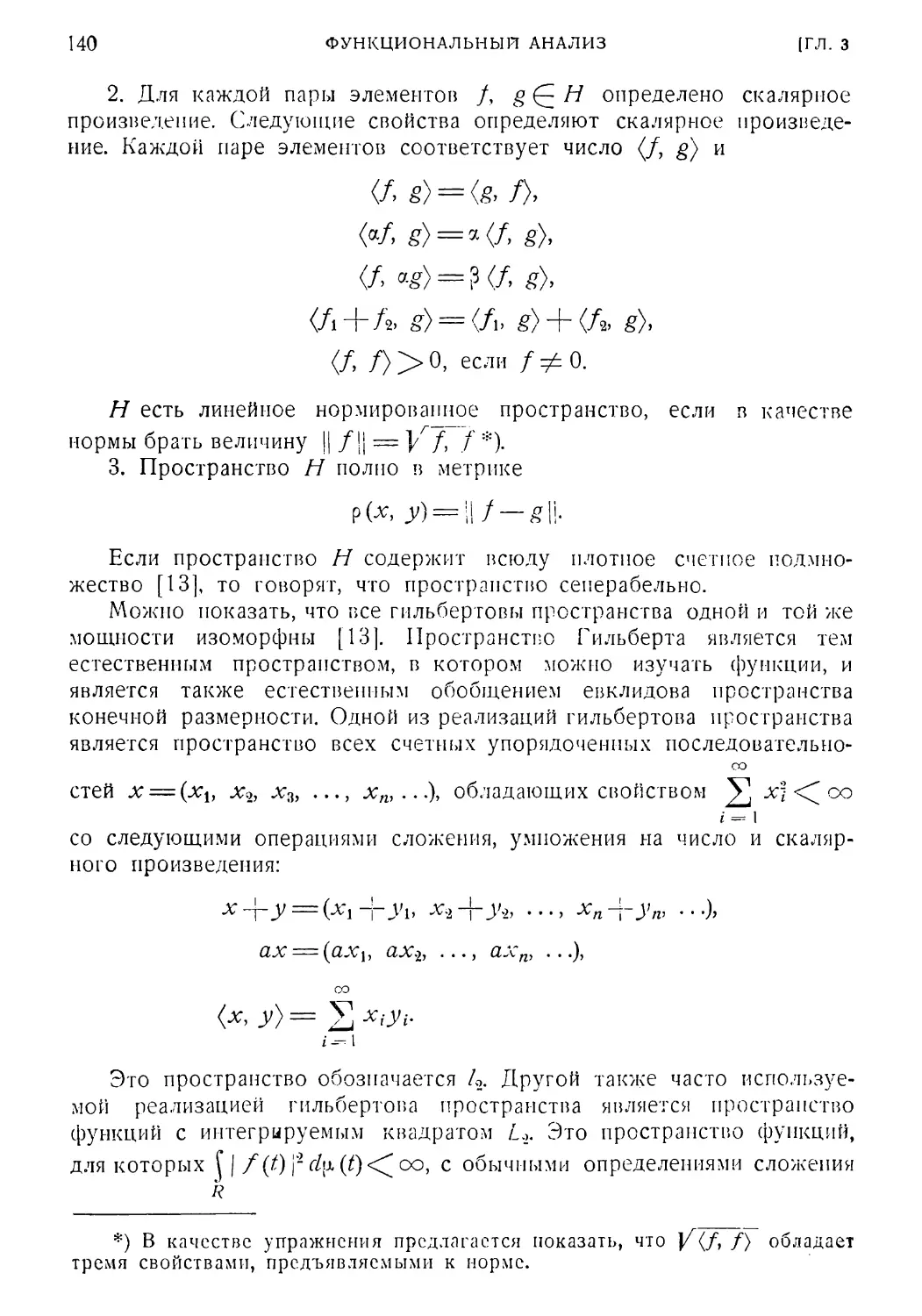

3.3. Основные неравенства 141

3.4. Ряды Фурье 141

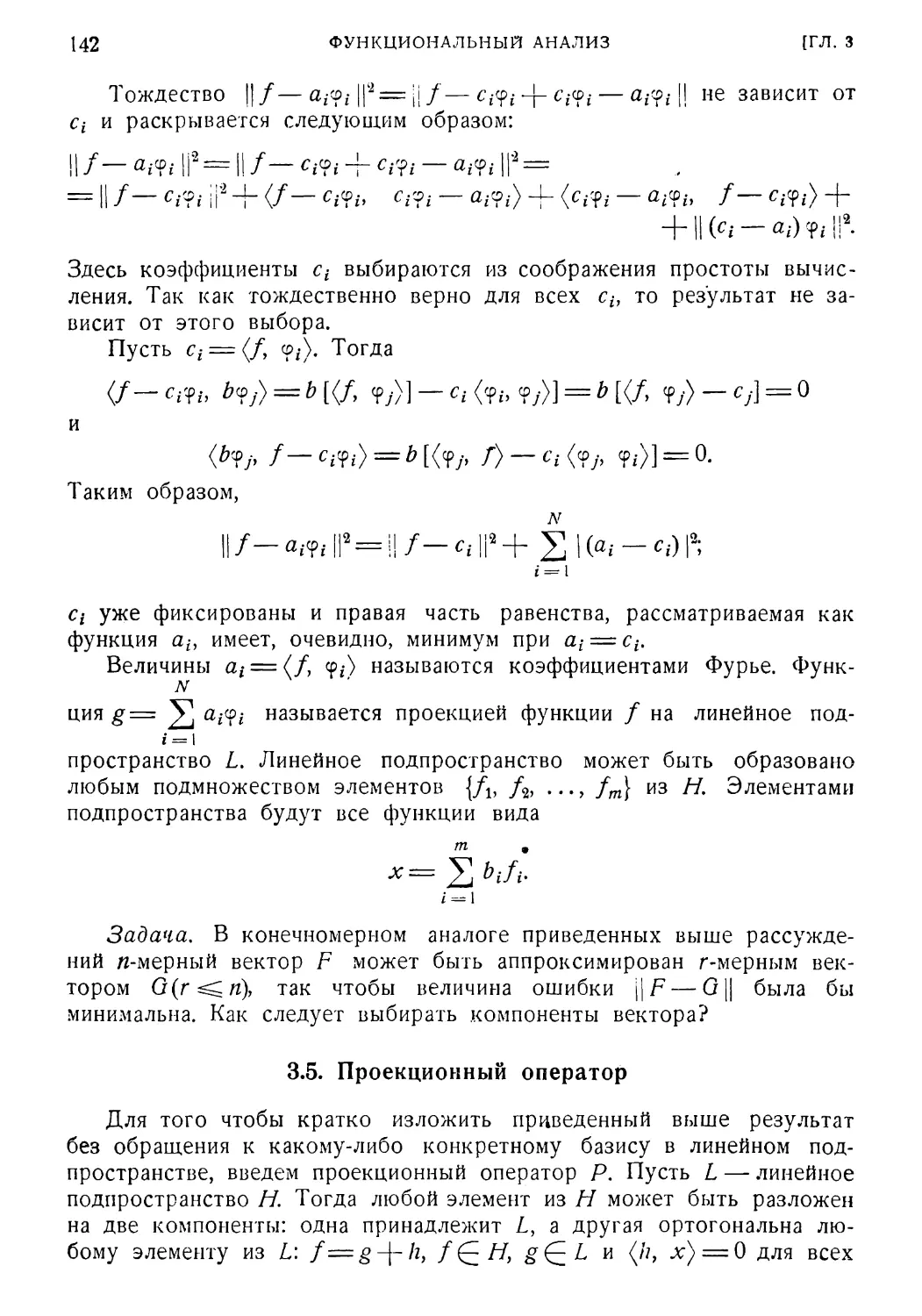

3.5. Проекционный оператор 142

3.6. Применение теории проекционных операторов для мини¬

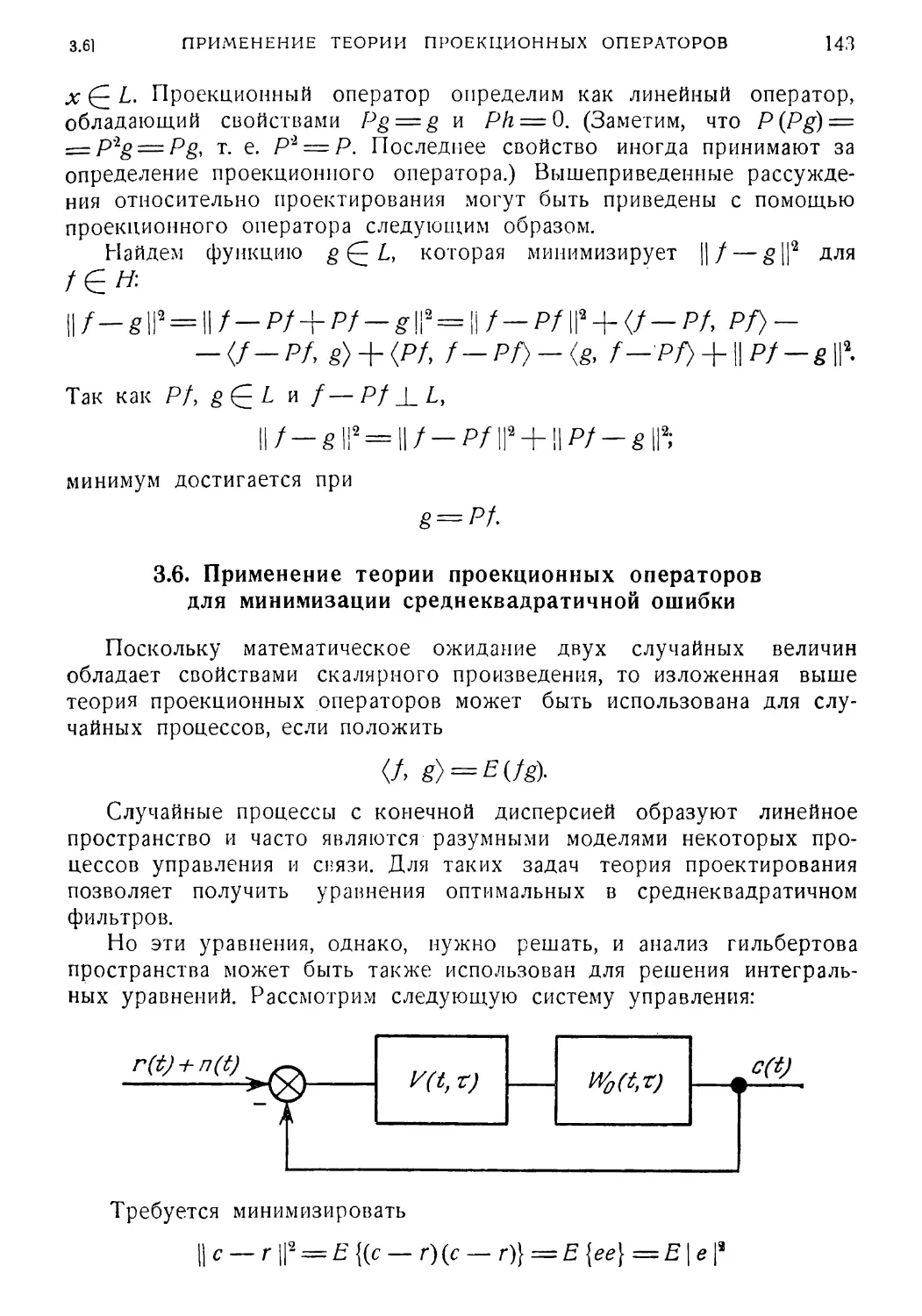

мизации среднеквадратичной ошибки 143

ОГЛАВЛЕНИЕ 7

Раздел II. Проблемы среднеквадратичной ошибки 146

3 7 Неотрицательные операторы в гильбертовом пространстве

и минимизация квадратичных функционалов 146

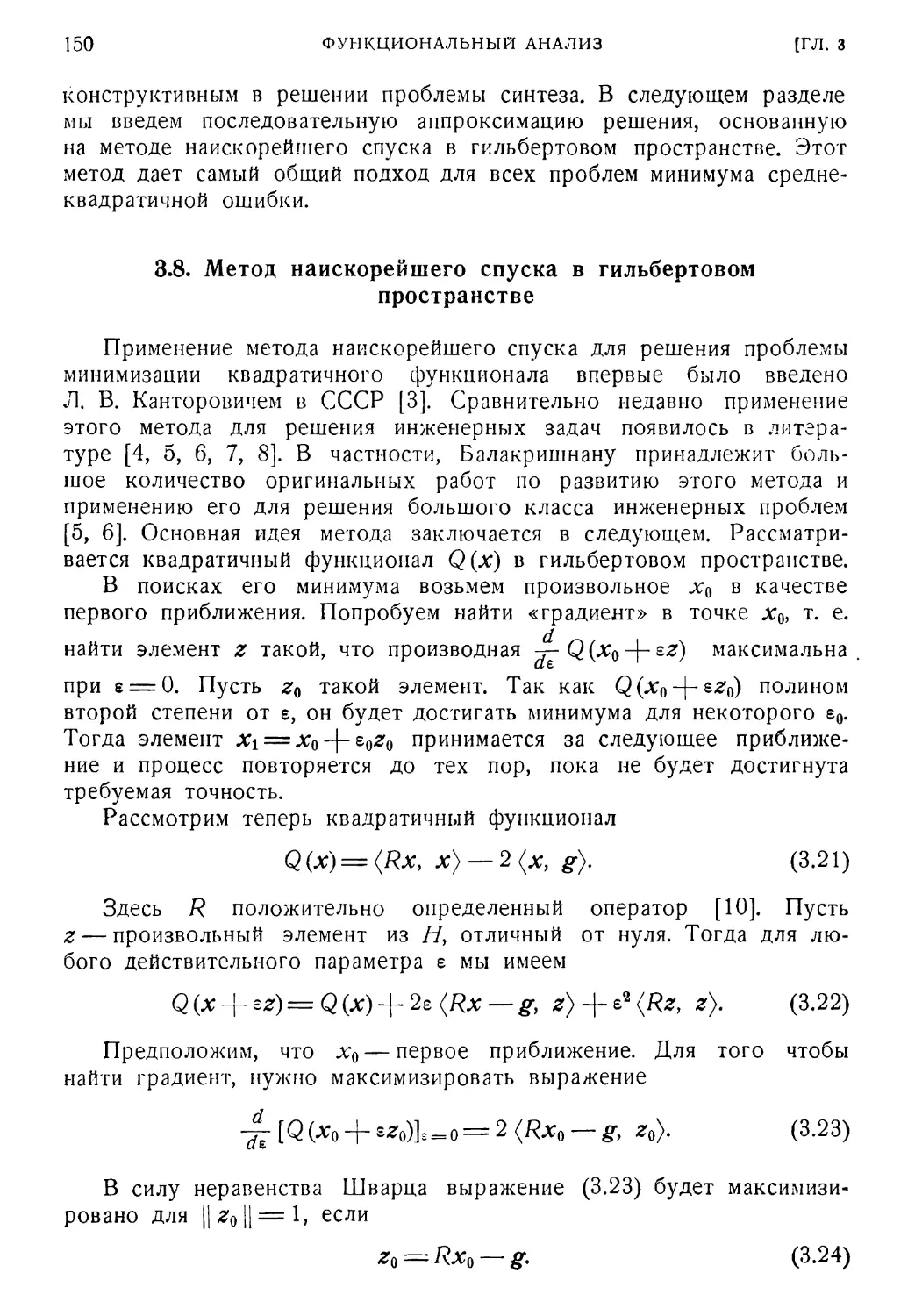

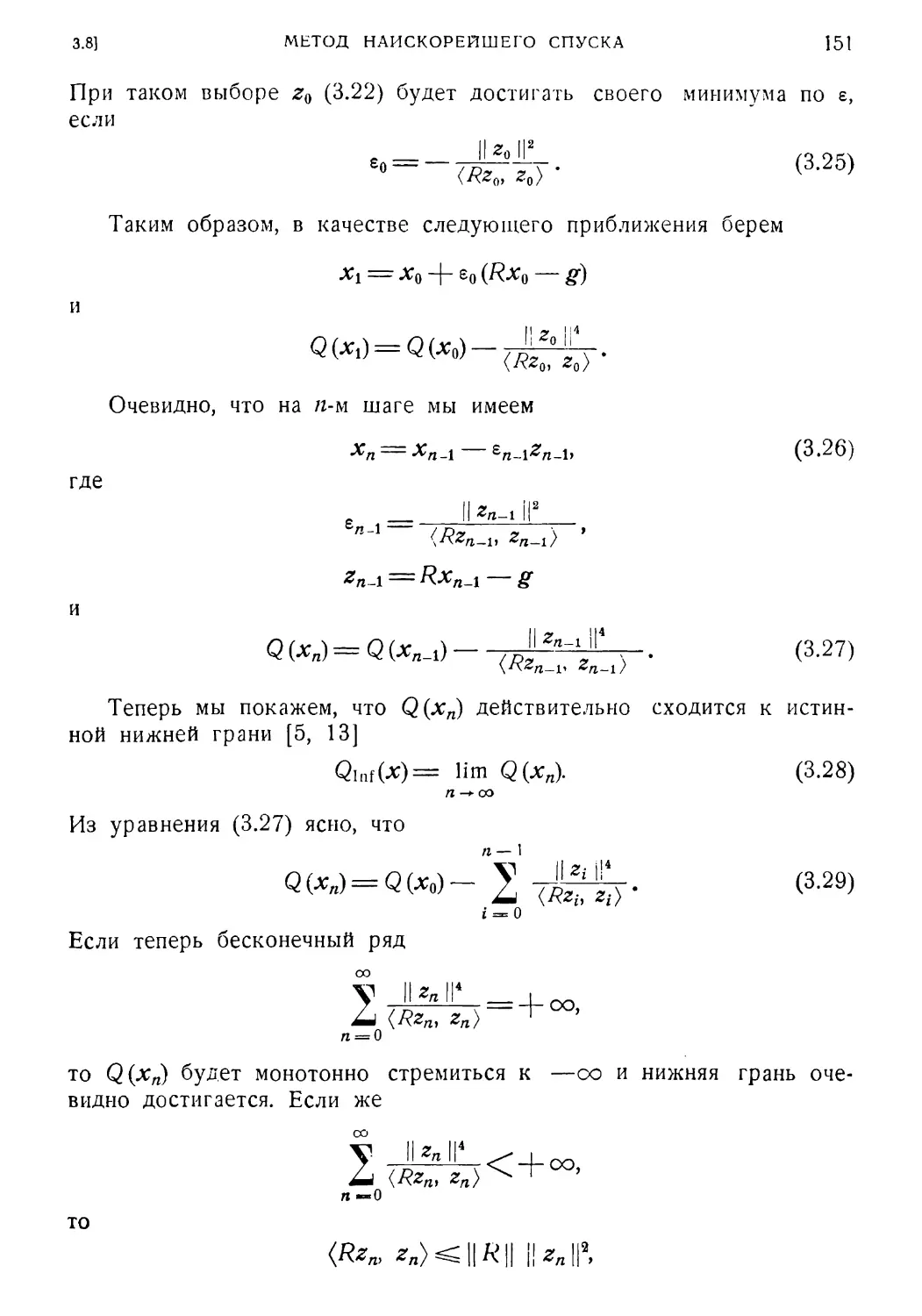

3 8. Метод наискорейшего спуска в гильбертовом пространстве 150

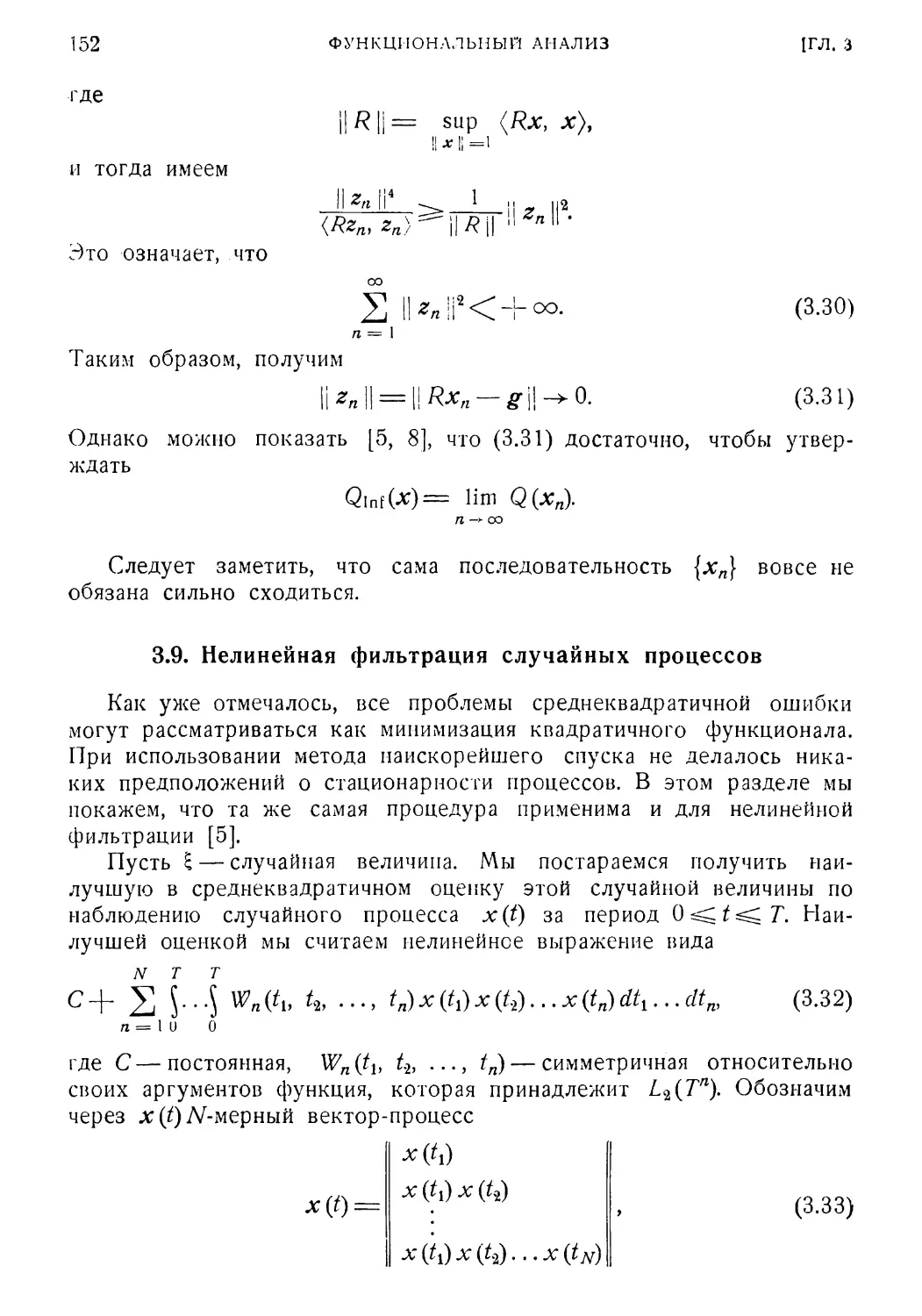

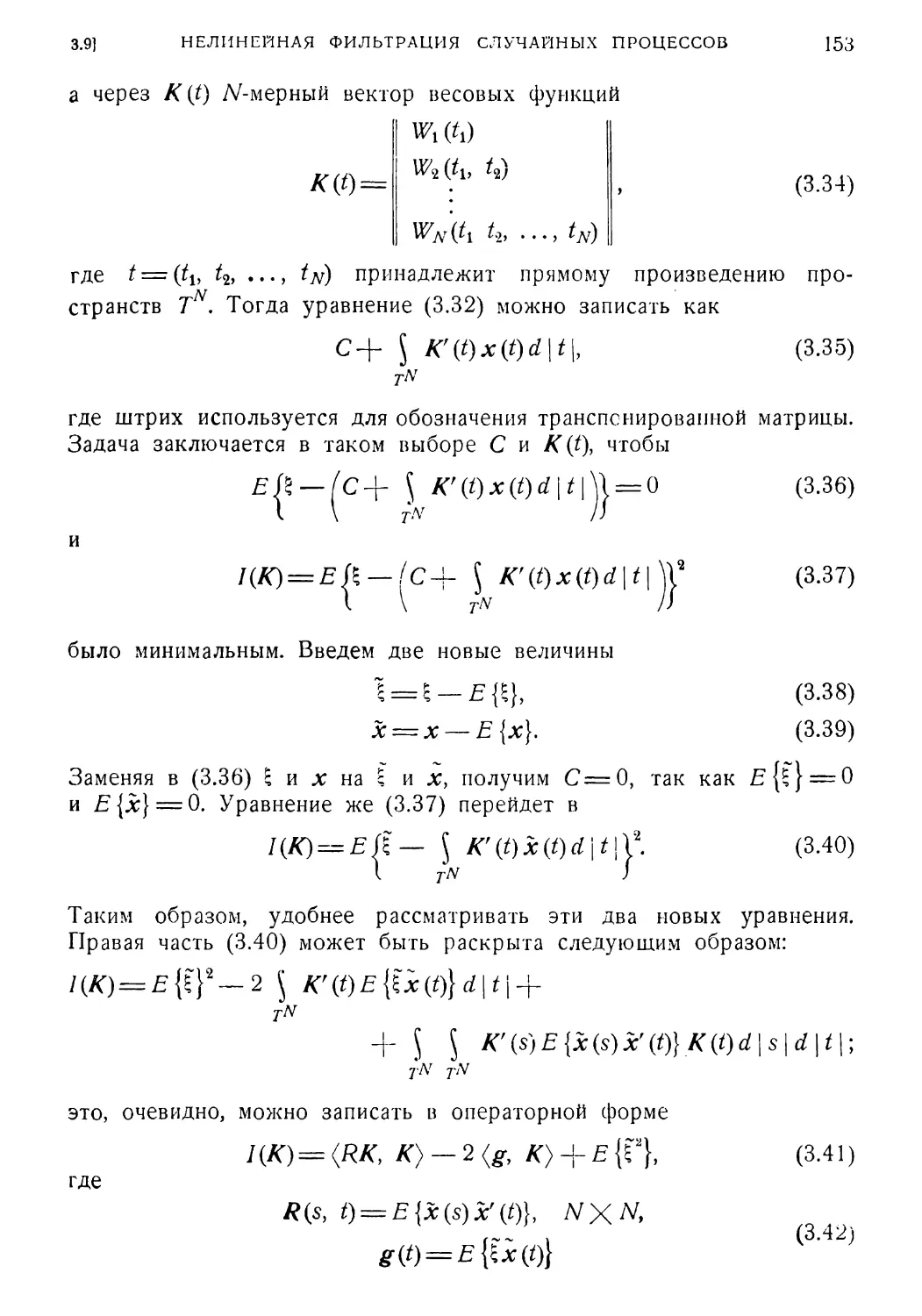

3 9 Нелинейная фильтрация случайных процессов 152

3.10.' Иллюстративный пример 154

Литература 157

Глава 4. Формирующие фильтры для случайных процессов ... 159

4.1. Причины, побуждающие заниматься задачей определения

формирующего фильтра 160

4.2. Исторический очерк 161

4.3*. Предварительные сведения из теории случайных процес¬

сов. Постановка задачи 162

4.4. Классические результаты для скалярных стационарных про¬

цессов 164

4.5.. Обобщение метода «факторизации рационального спектра»

на нестационарные процессы 168

4.6. Дальнейшее обобщение результатов 173

4.7. Некоторые фундаментальные результаты для нестационар¬

ных процессов 174

4.8. Результаты, основанные на разложениях в ряды 181

4.9. Представление векторных процессов 184

Литература 193

Глава 5. Анализ нелинейных систем управления с помощью

прямого метода Ляпунова 195

5.1. Введение . . . 195

5.2. Теоремы, определения и обозначения 204

5.3. Применение прямого метода Ляпунова и нахождение функ¬

ций Ляпунова 223

5.4. Заключение 260

Литература 262

Глава 6. Обзор теории и методов адаптивных систем управ¬

ления 264

6.1. Введение 264

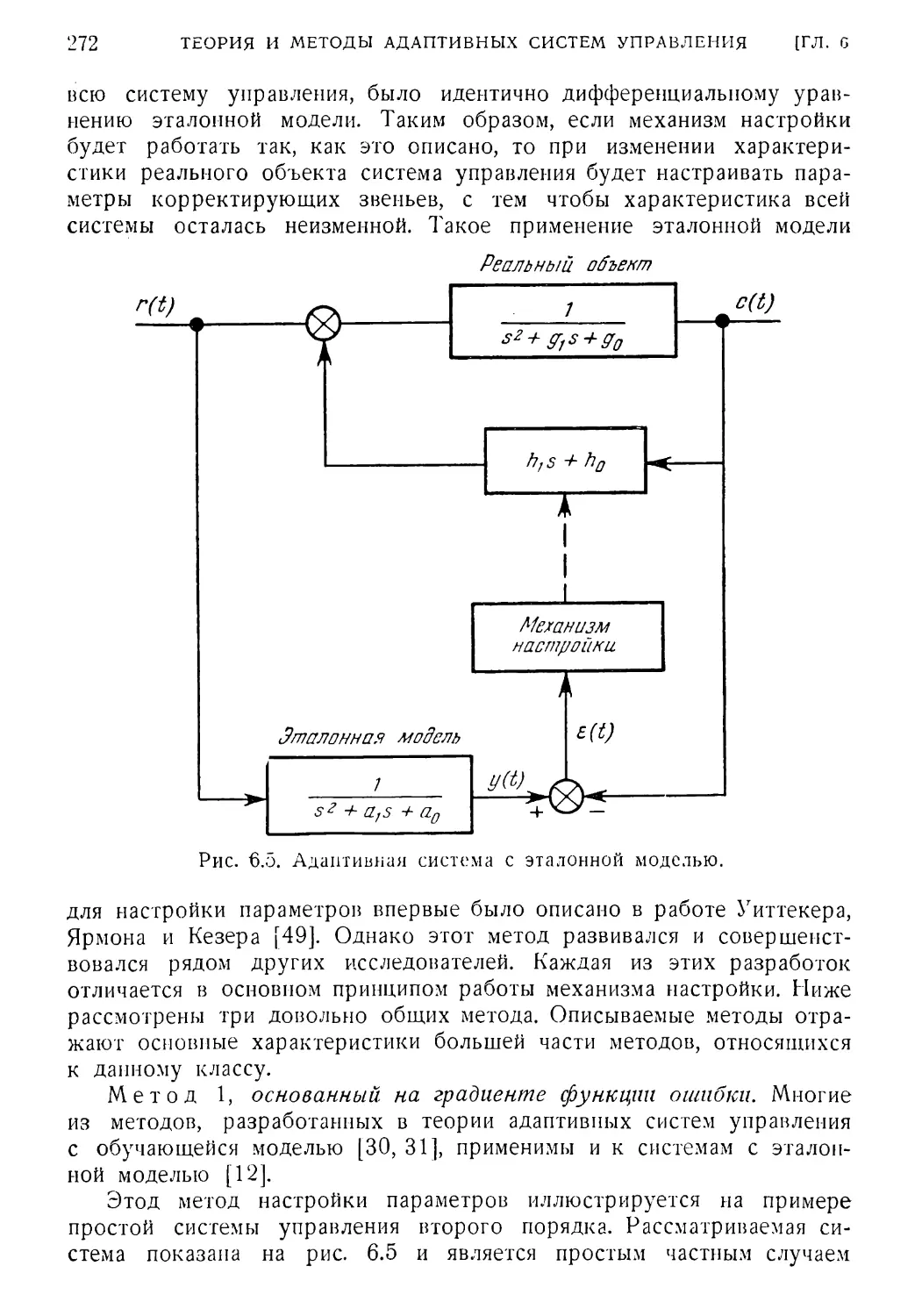

6.2. Методы построения адаптивных систем с эталонной моделью 269

6.3. Оптимальные адаптивные методы 294

6.4. Оценка параметров и состояния 307

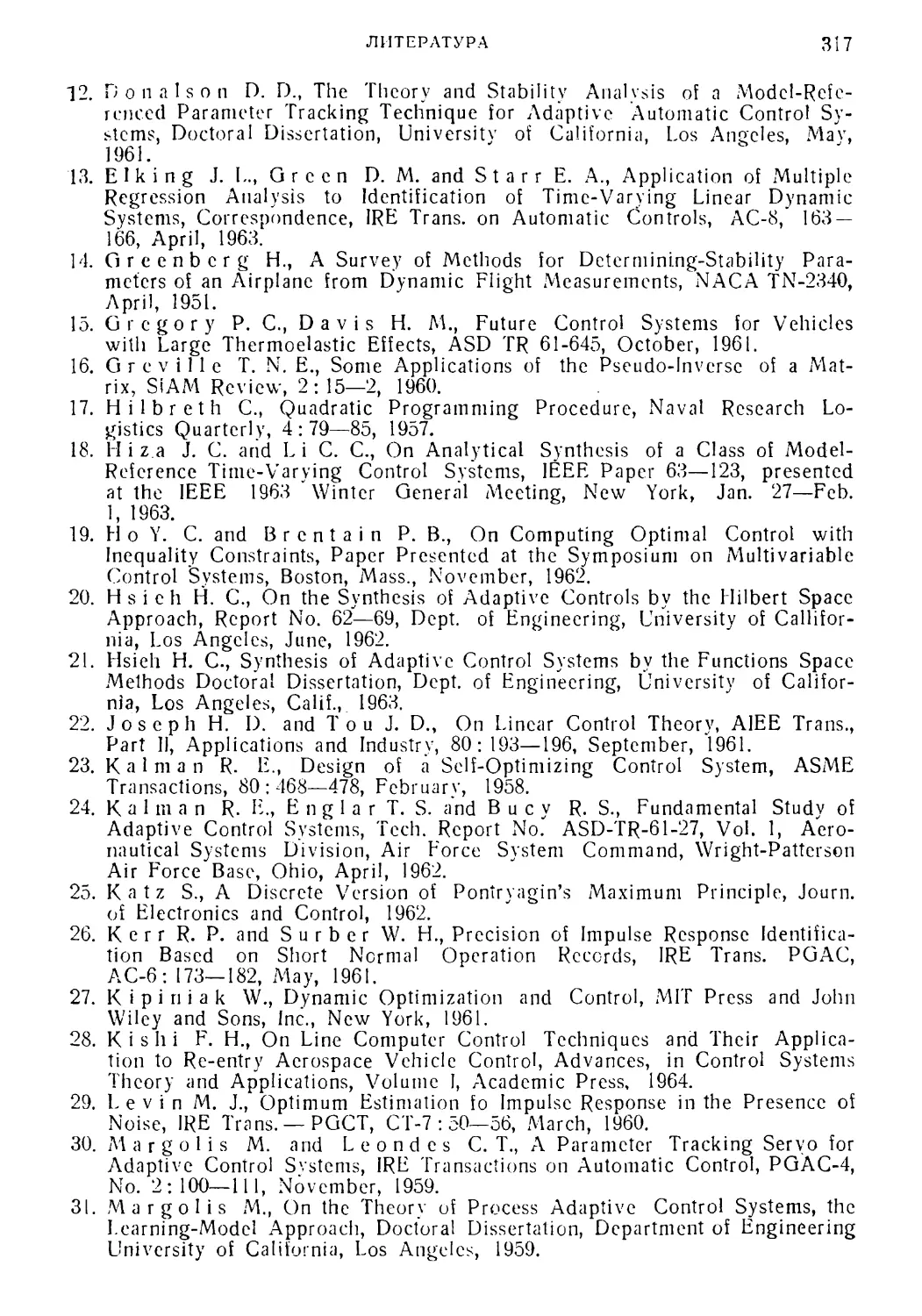

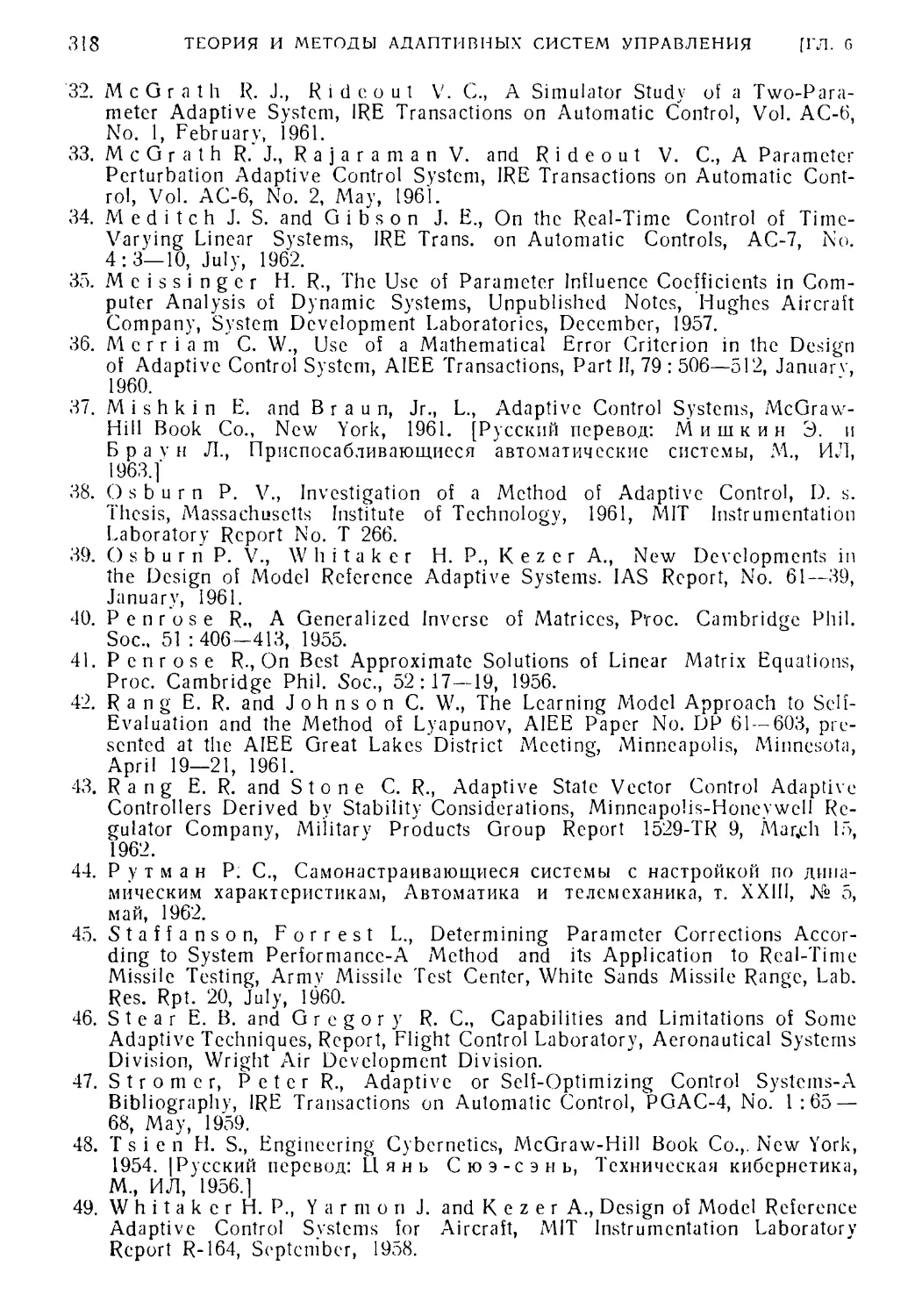

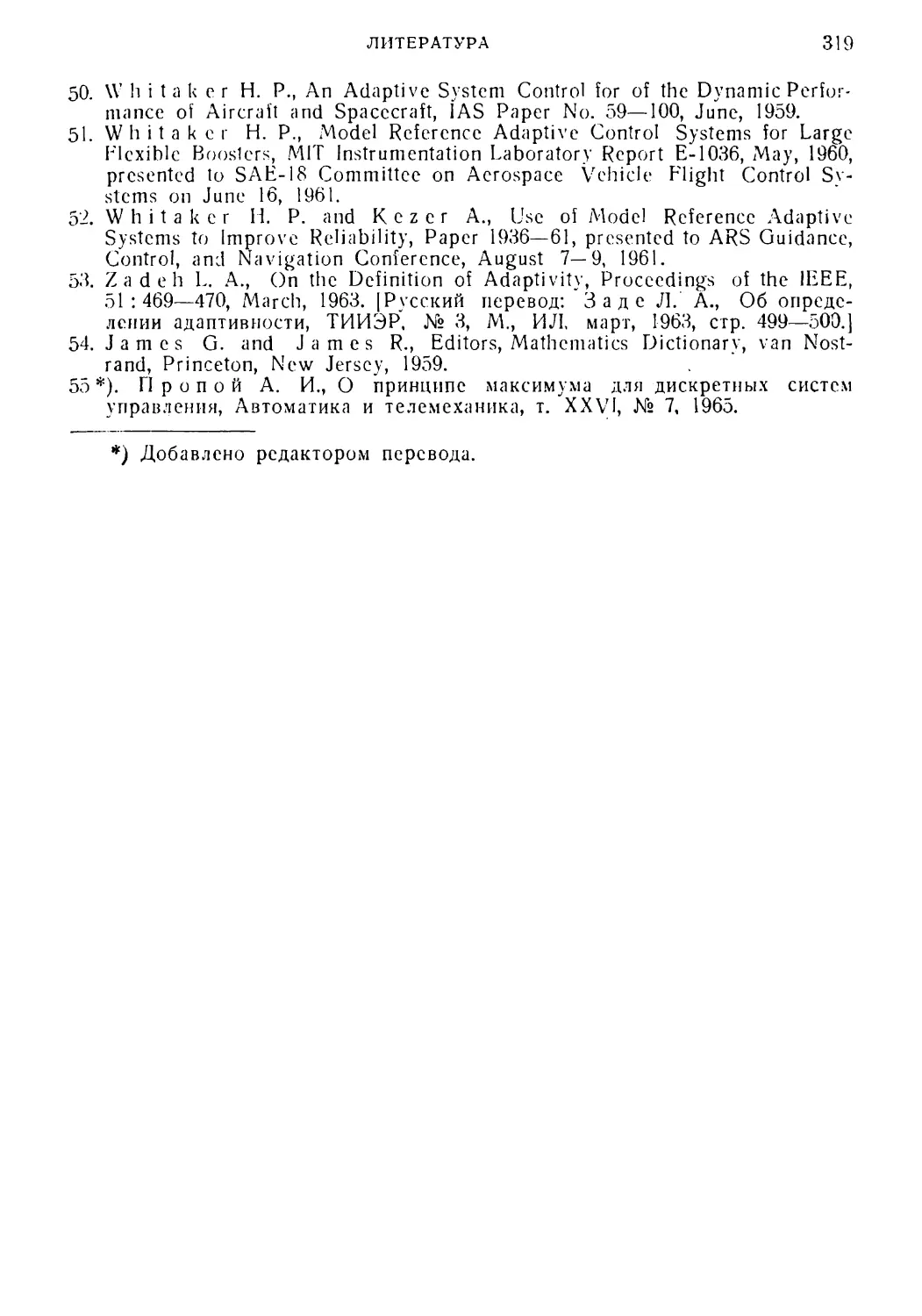

Литература 316

Глава 7. Введение в принцип максимума Л. С. Понтрягина . . . 320

7.1. Постановка задачи 320

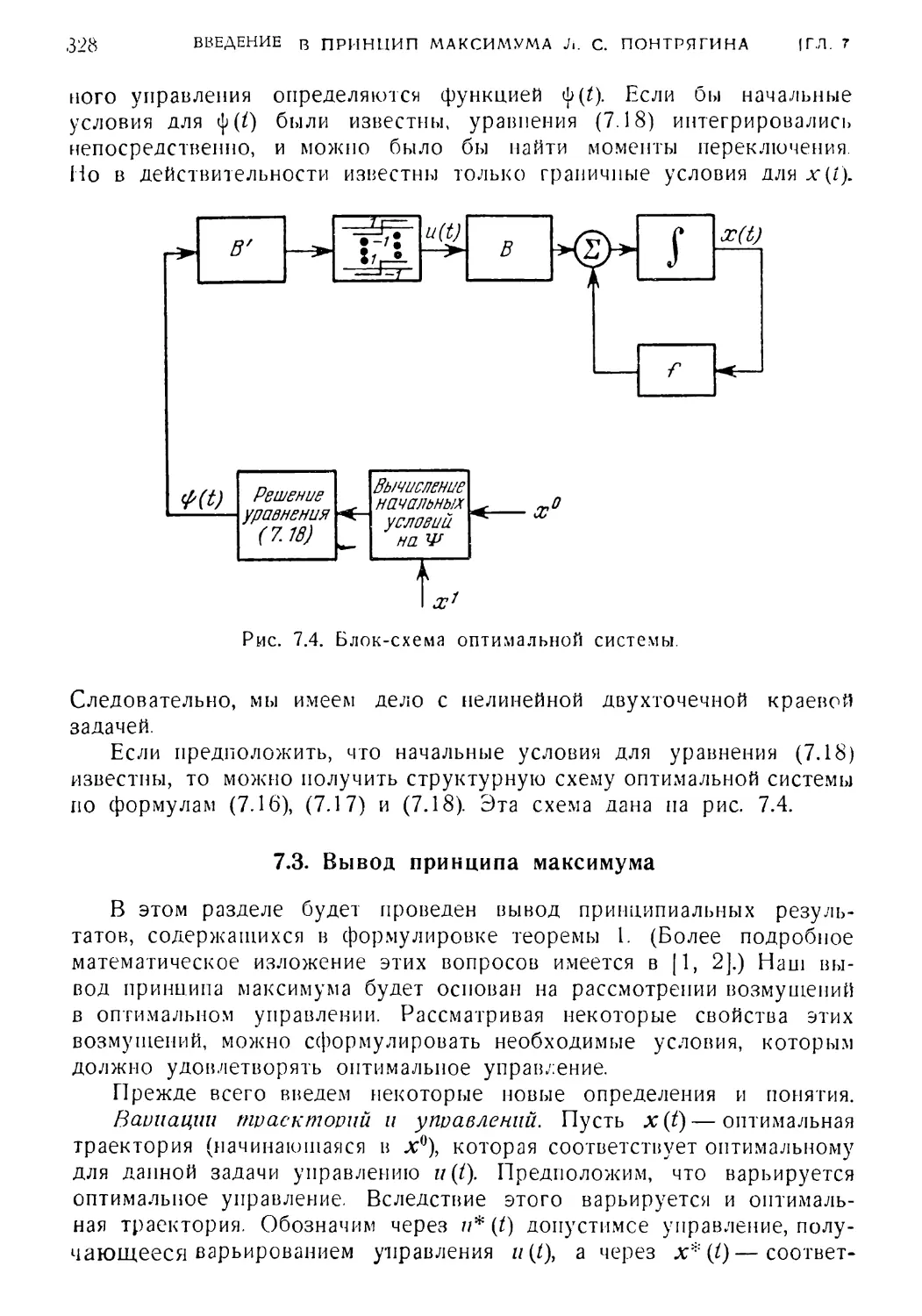

7.2. Принцип максимума 325

7.3. Вывод принципа "максимума 328

04. Обобщения принципа максимума 340

7«* ?екот°Рые приложения принципа максимума 344

'.о. Заключение " 348

Литература 349

8

ОГЛАВЛЕНИЕ

Глава 8. Проблема минимума нормы и некоторые другие методы

оптимизации систем управления 351

Раздел 1. /.-проблема и задача аппроксимации в линейном нормиро¬

ванном пространстве 352

8.1. Введение 352

8.2. Математическая формулировка 353

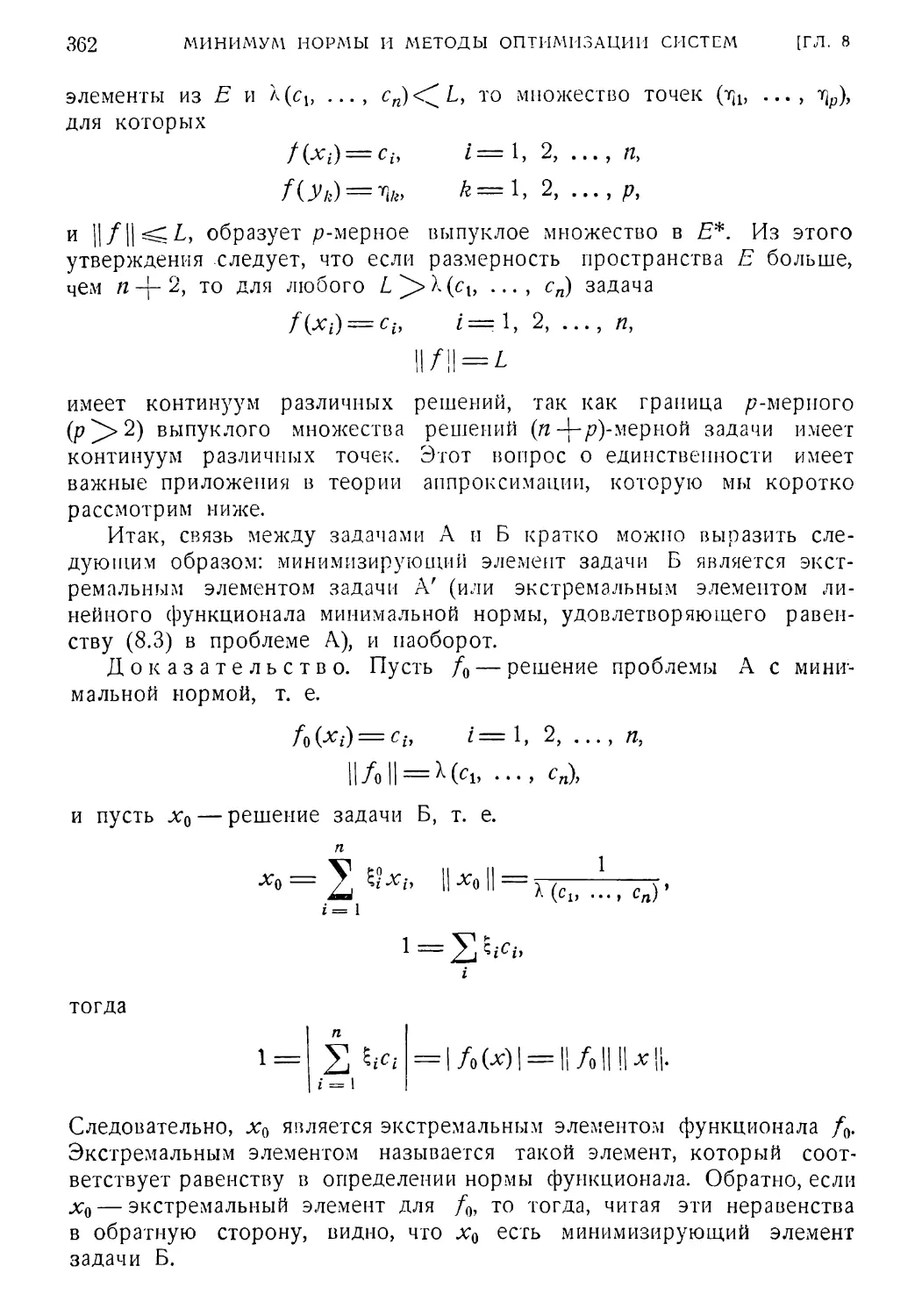

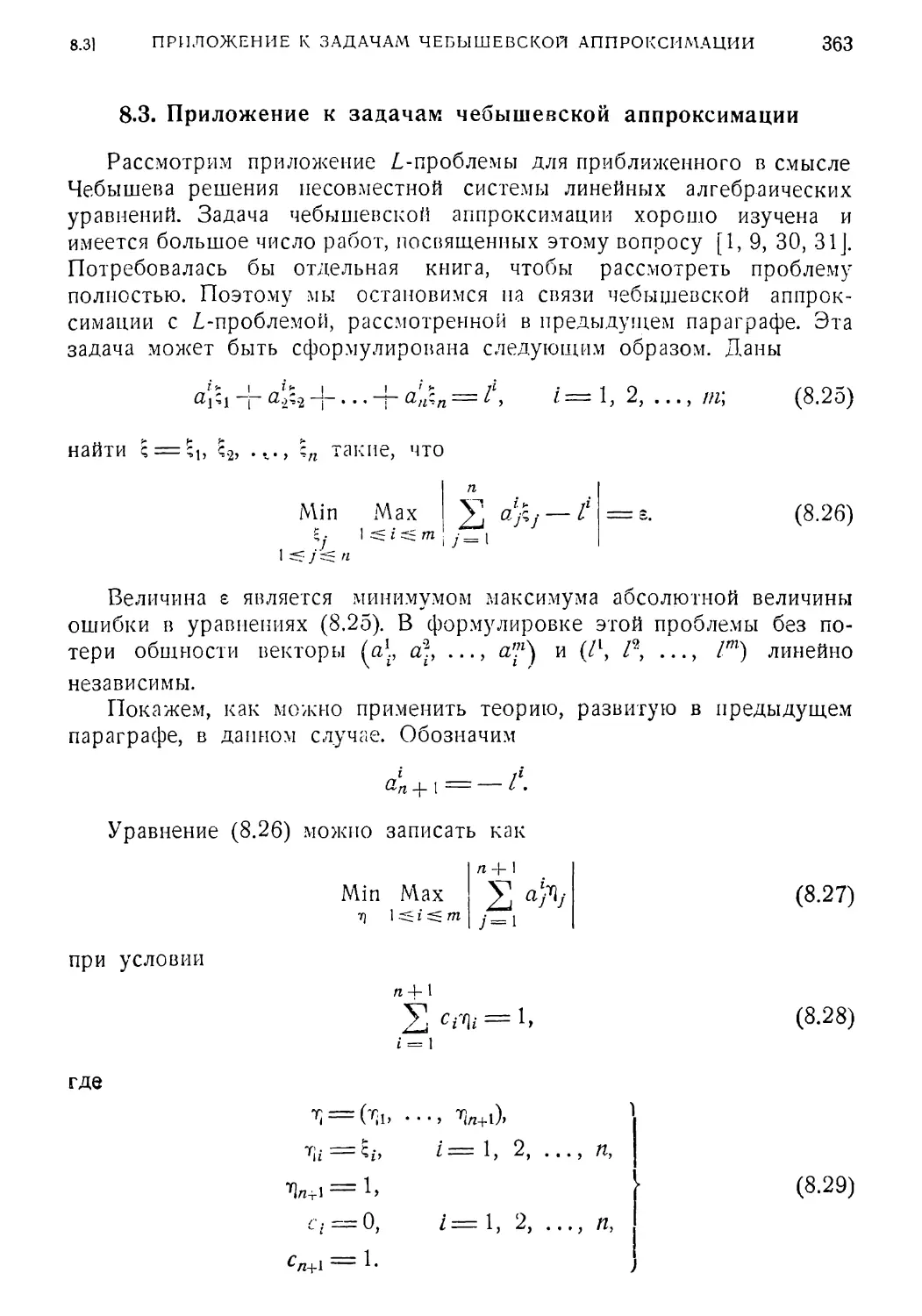

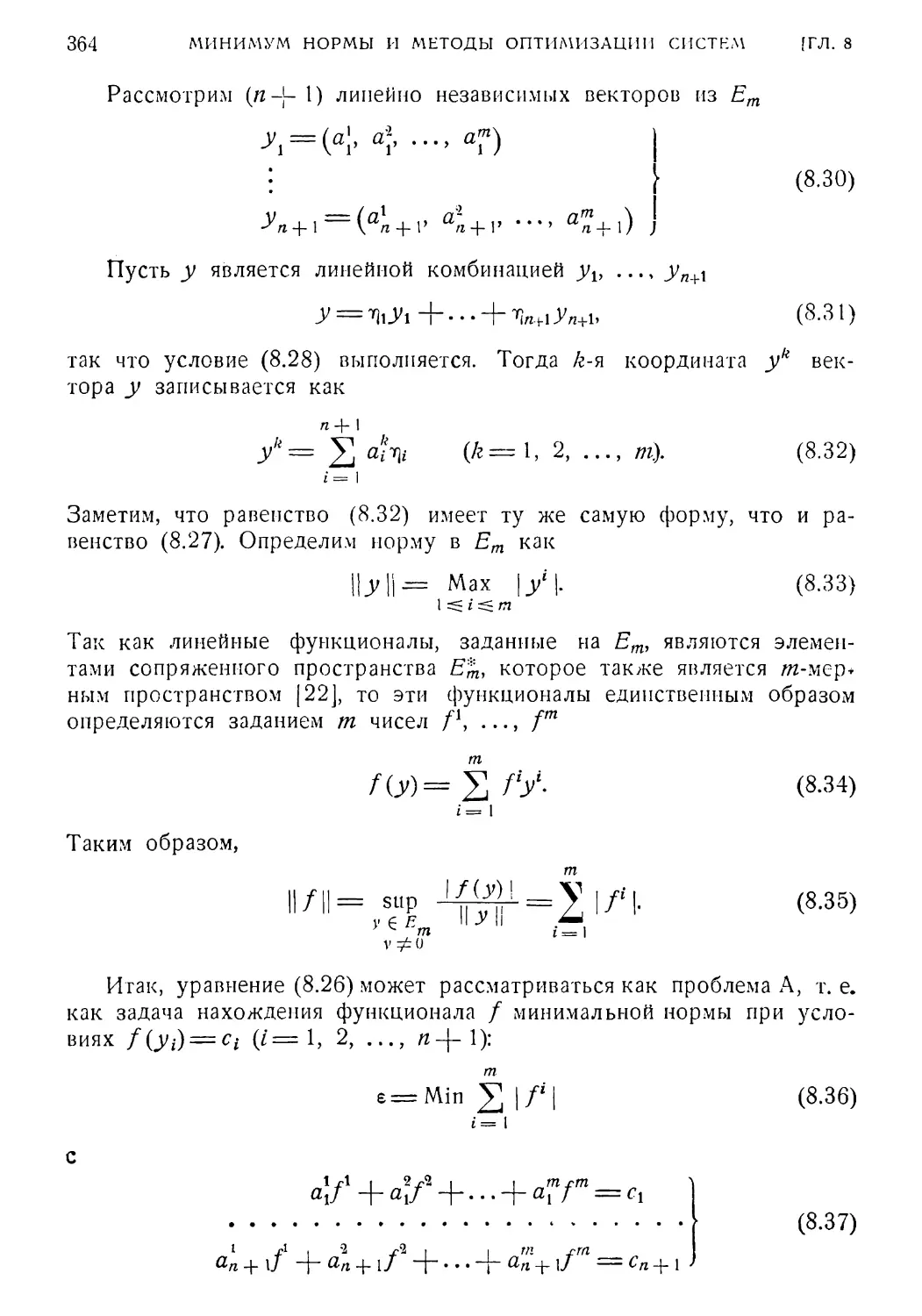

8.3. Приложение к задачам чебышевской аппроксимации . . . 363

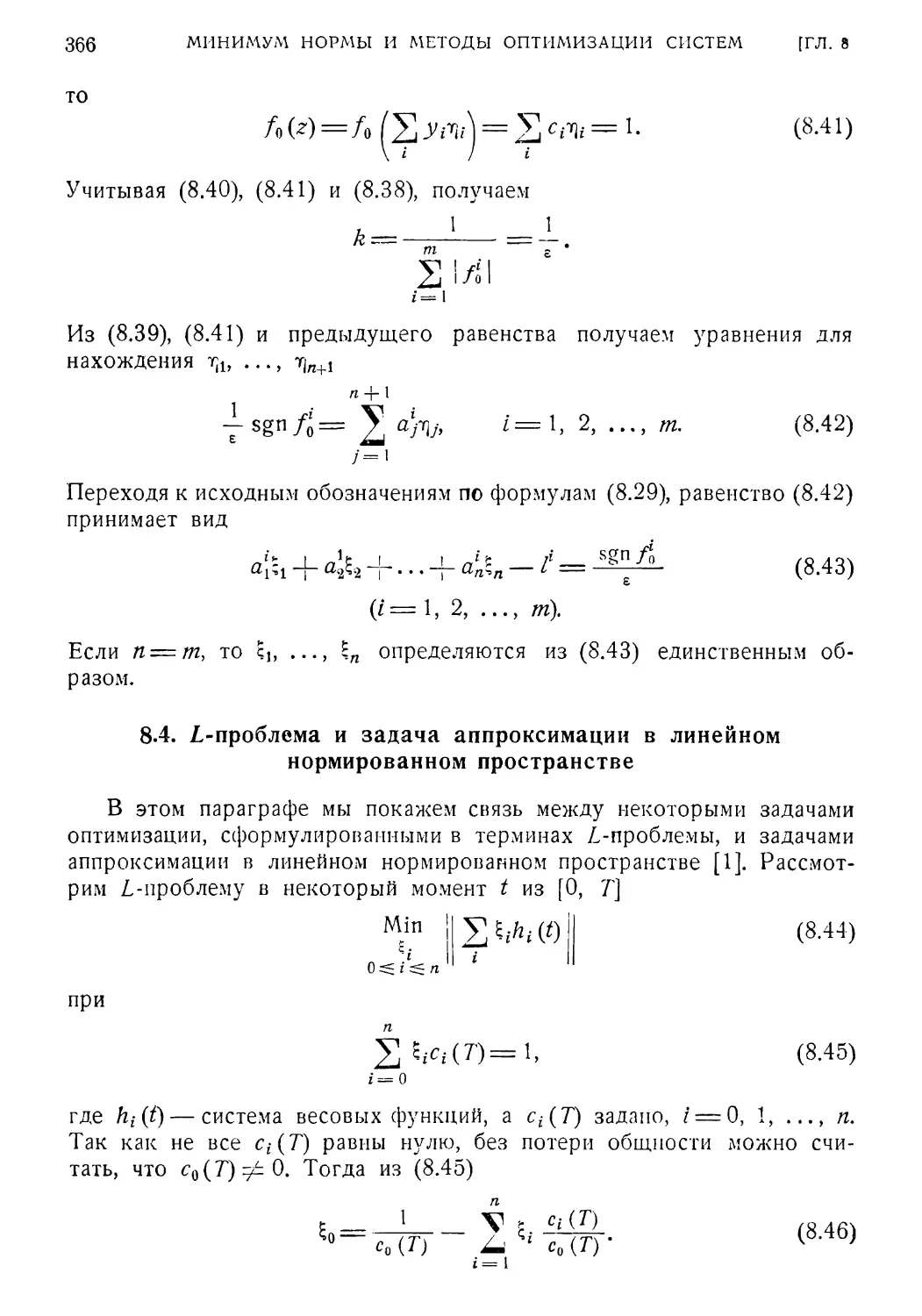

8.4. 1-проблема и задача аппроксимации в линейном нормиро¬

ванном пространстве 366

8.5. Аппроксимация в гильбертовом пространстве и определи¬

тель Грама 367

8.6. Единственность экстремального элемента и наилучшая

аппроксимация 369

Раздел II. Приближенное решение функциональных уравнений . . . 371

8. 7. Введение 371

8. 8. Обратный оператор 372

8. 9. Сходимость приближенных решений 374

8.10. Квазилинеаризация 376

Литература 382

Глава 9. Методы аналитического конструирования в задаче

оптимального управления 384

9.1. Введение 384

9.2. Формулировка задачи 385

9.3. Метод динамического программирования 386

9.4. Решение, получаемое методом динамического программи¬

рования 389

9.5. Решение задачи с помощью принципа максимума 393

9.6. Сравнение методов принципа максимума и динамического

программирования 396

9.7. Смежные вопросы 398

Литература 398

Глава 10. Некоторые элементы теории стохастической аппрокси¬

мации и ее применение к данной задаче управления .... 400

10.1. Введение 400

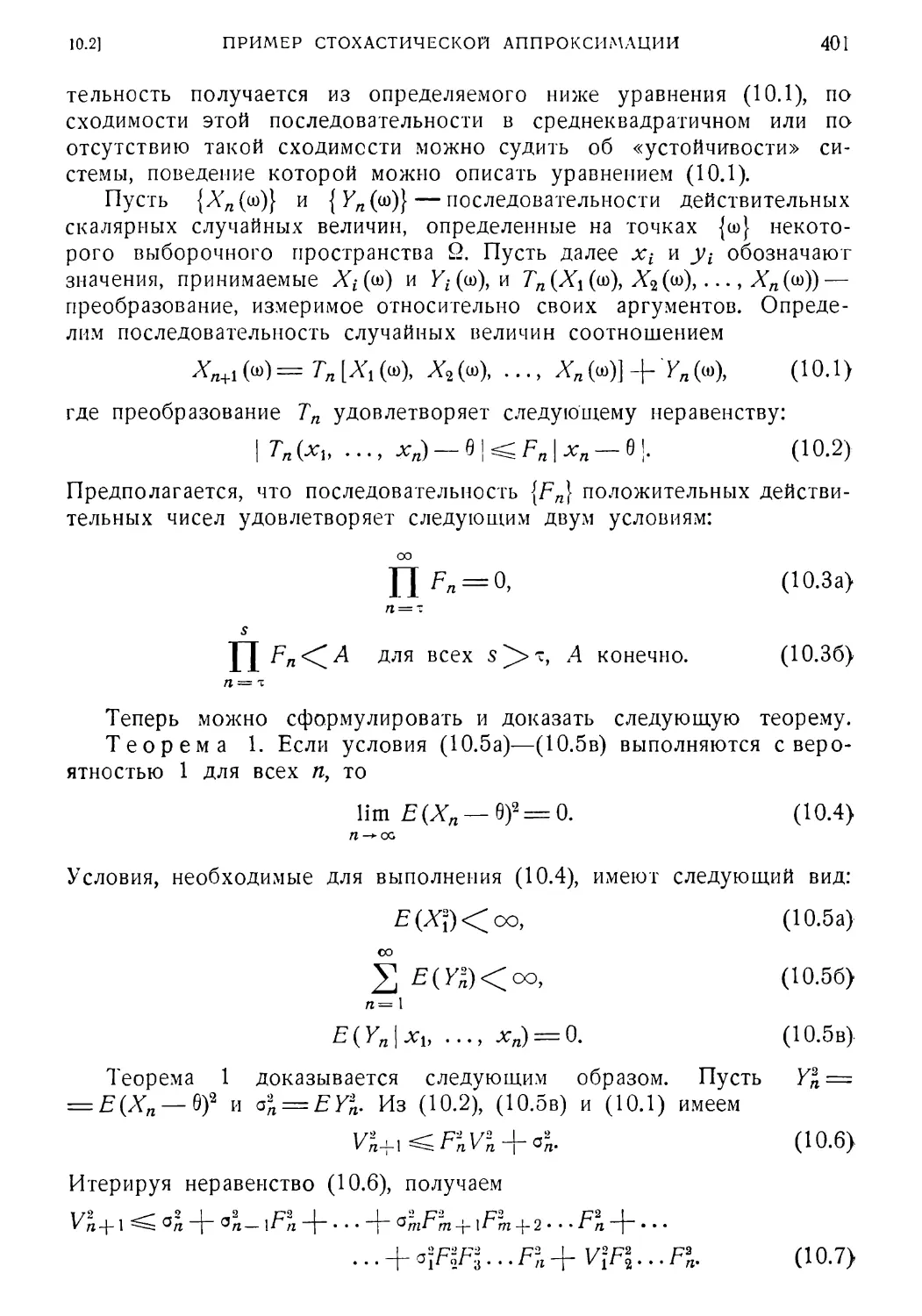

10.2. Пример стохастической аппроксимации 400

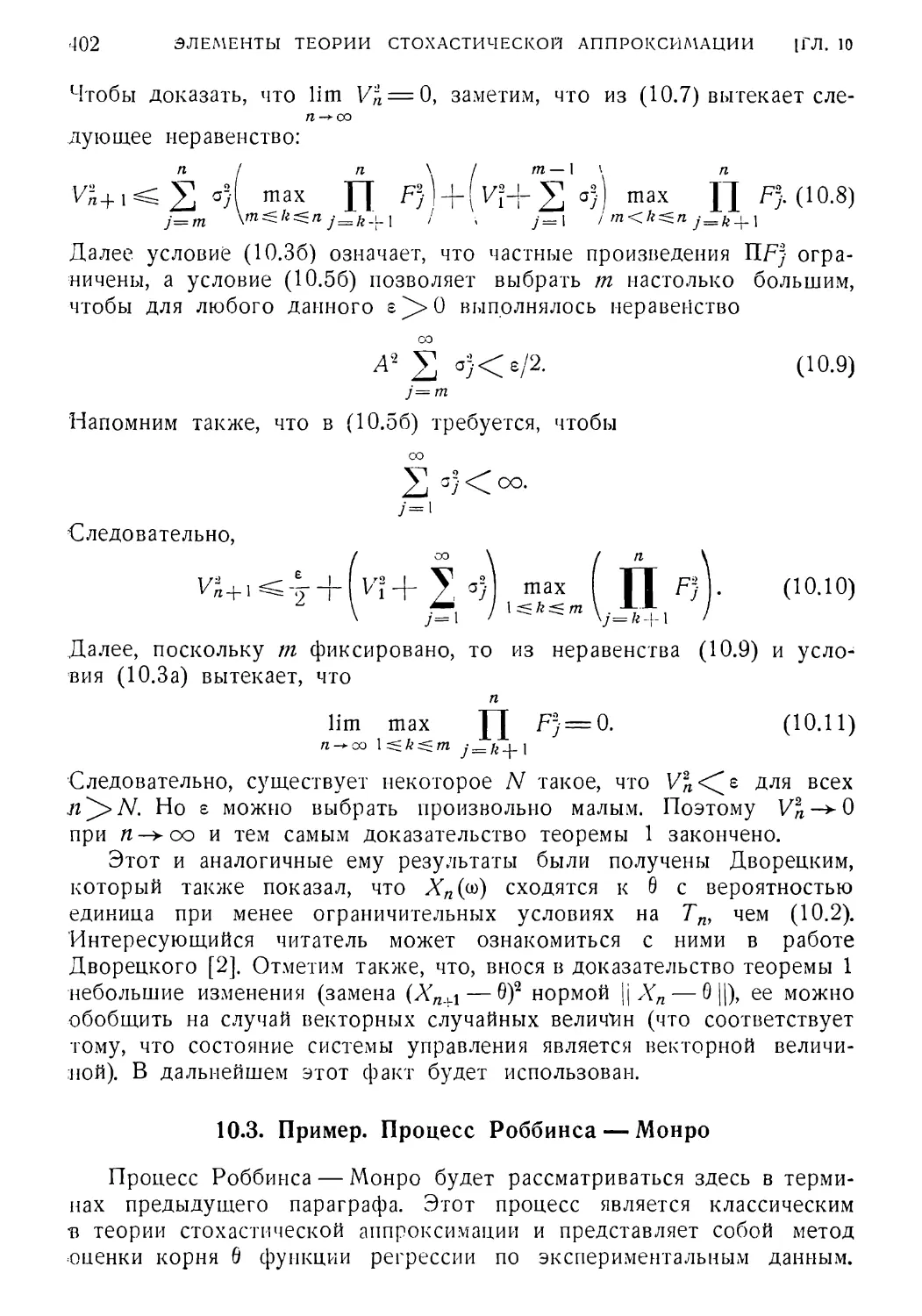

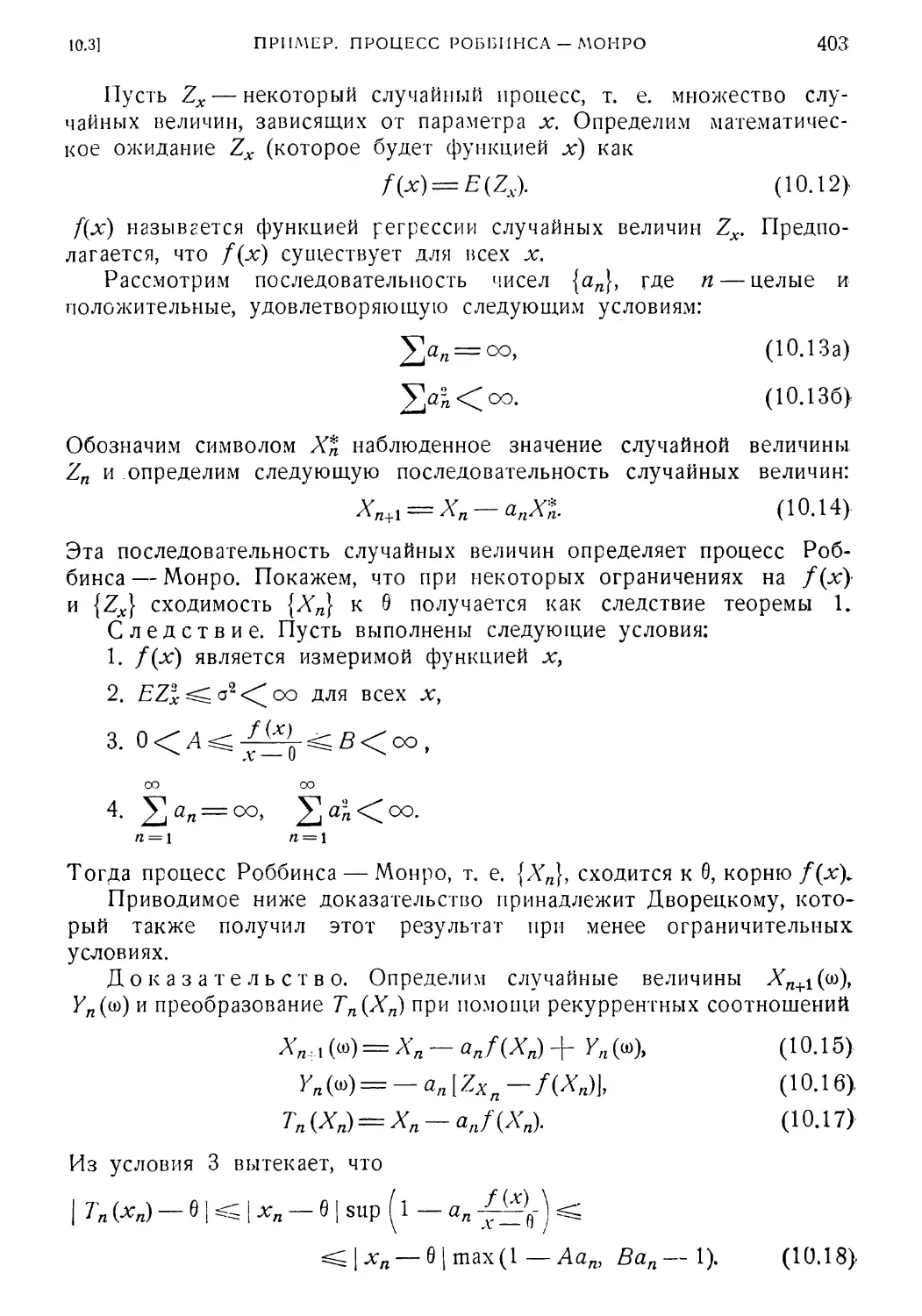

10.3. Пример. Процесс Роббинса — Монро 402

10.4. Пример. Процесс Кифера—Вольфовица 404

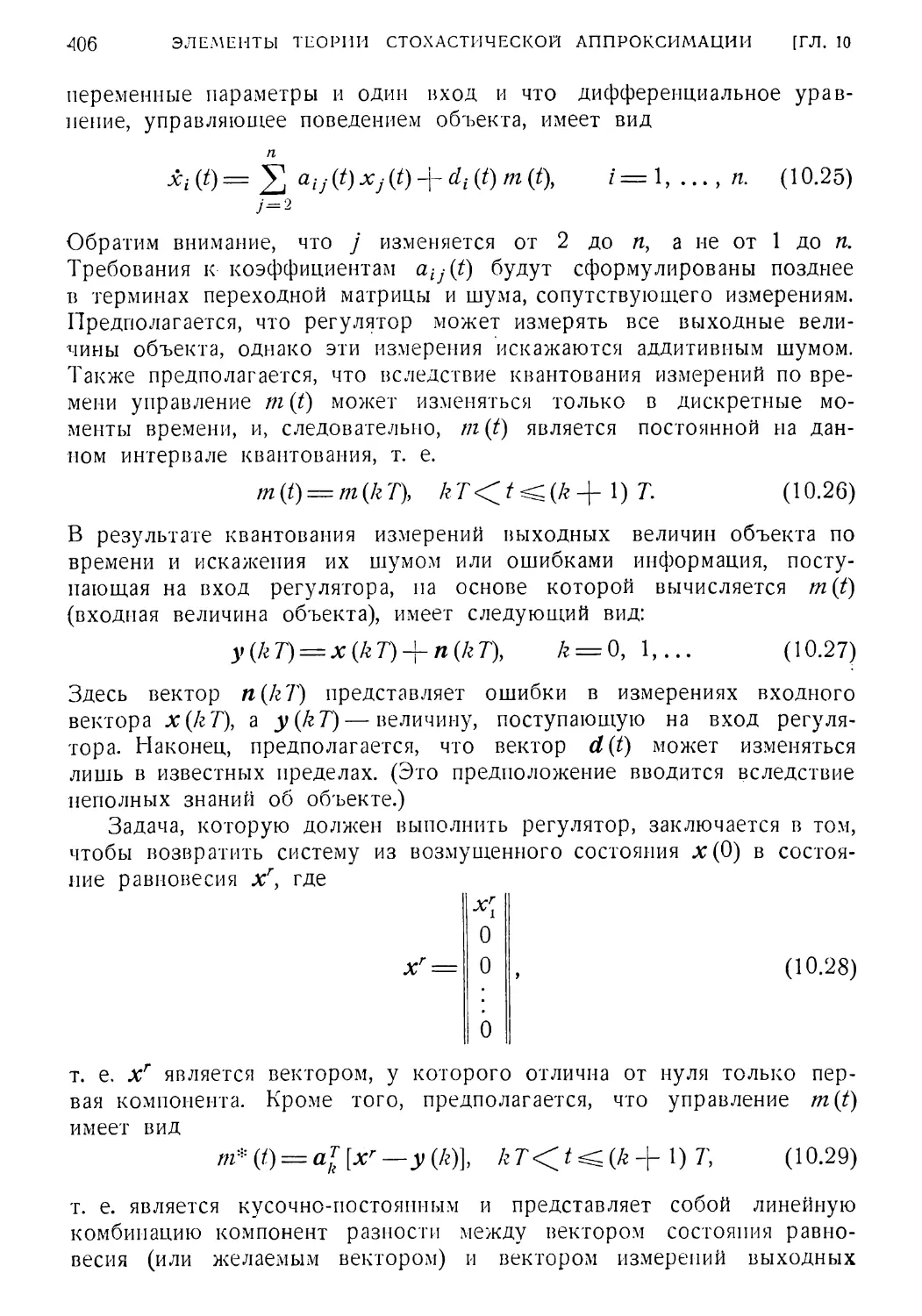

10.5. Одна задача управления 405

10.6. Применение методов стохастической аппроксимации .... 407

10.7. Заключение 410

Литература 411

Глава 11. Анализ и синтез дискретных систем 413

11.1. Введение 413

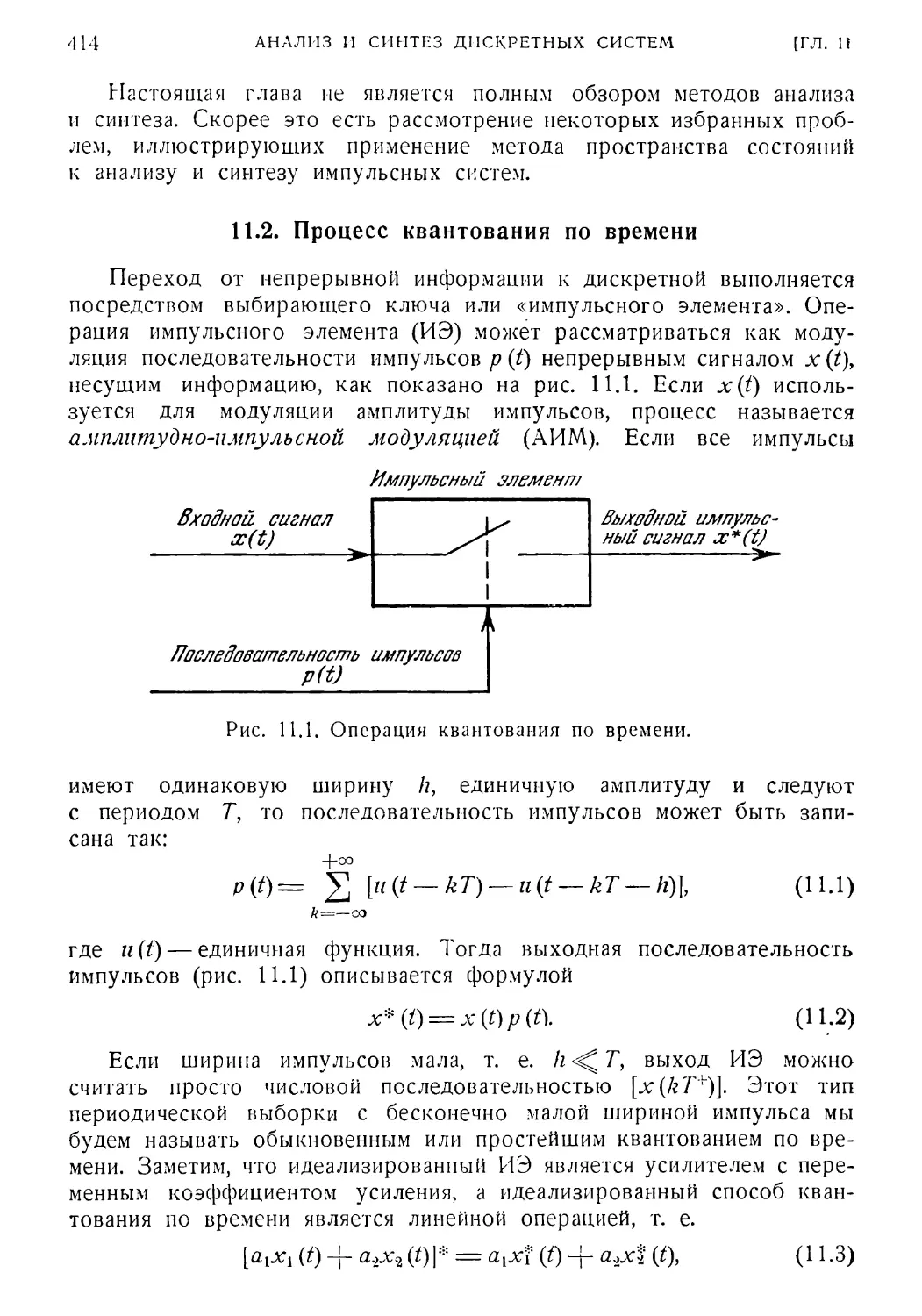

11.2. Процесс квантования по времени 414

11.3. Поведение во времени идеализированной импульсной

системы 416

11.4. Частотный анализ идеализированных линейных импульсных

систем 418

ОГЛАВЛЕНИЕ

9

115 Формулировка дискретных задач с помощью понятия про¬

странства состояний 421

116 Устойчивость дискретных систем 430

11*7.' Импульсные системы с частотно-импульсной модуляцией 434

11*8. Широтно-импульсная модуляция. ШИМ 438

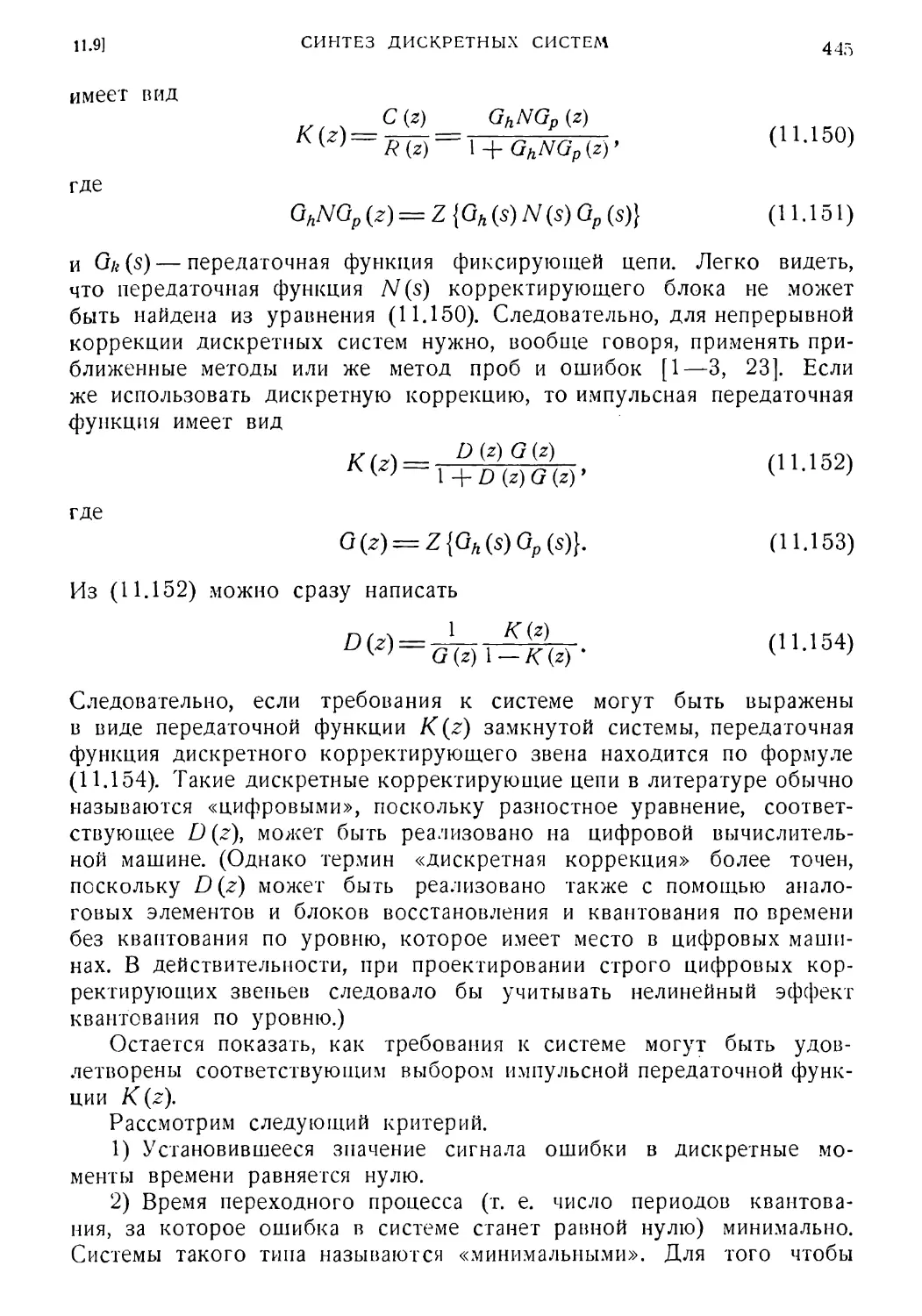

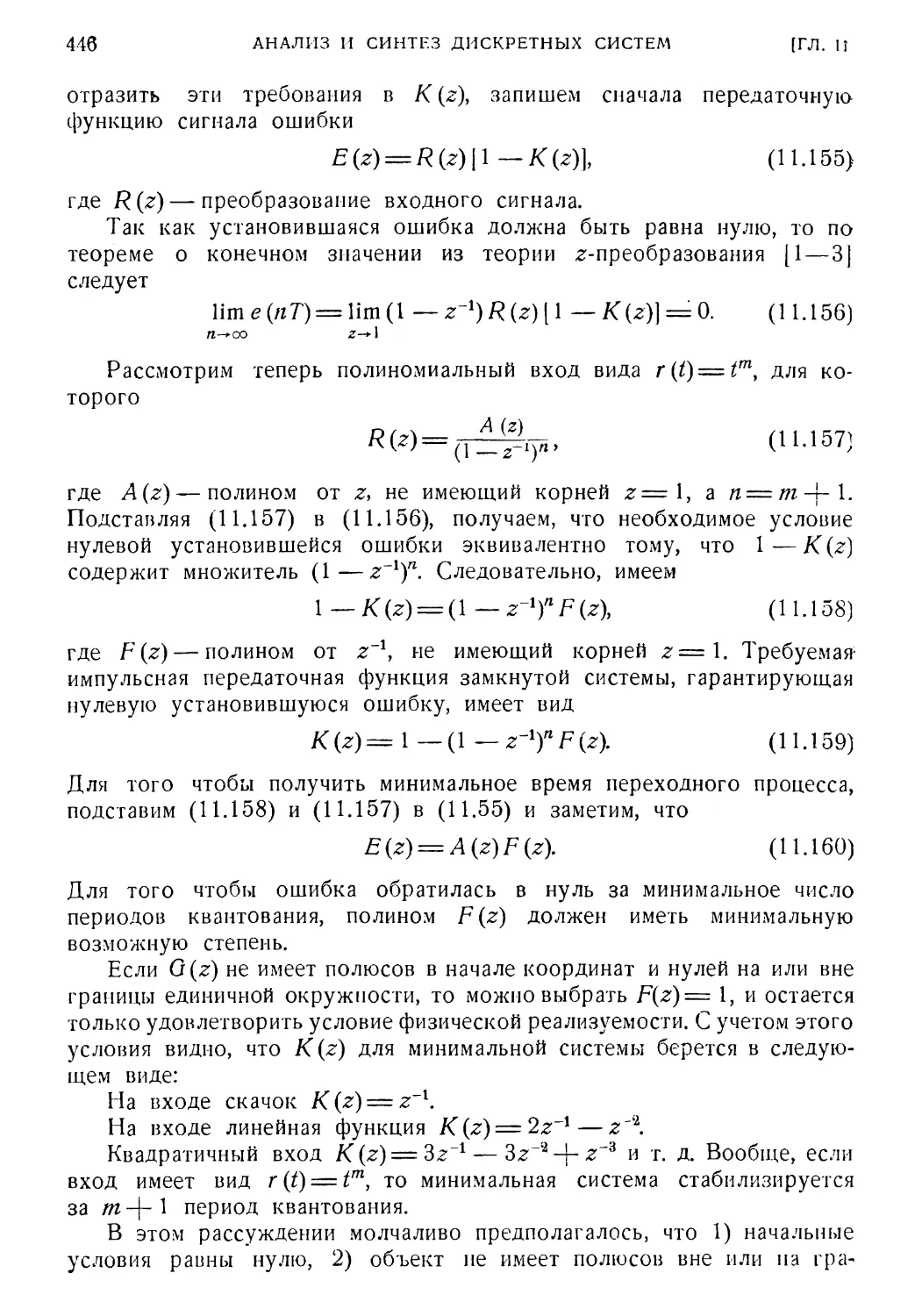

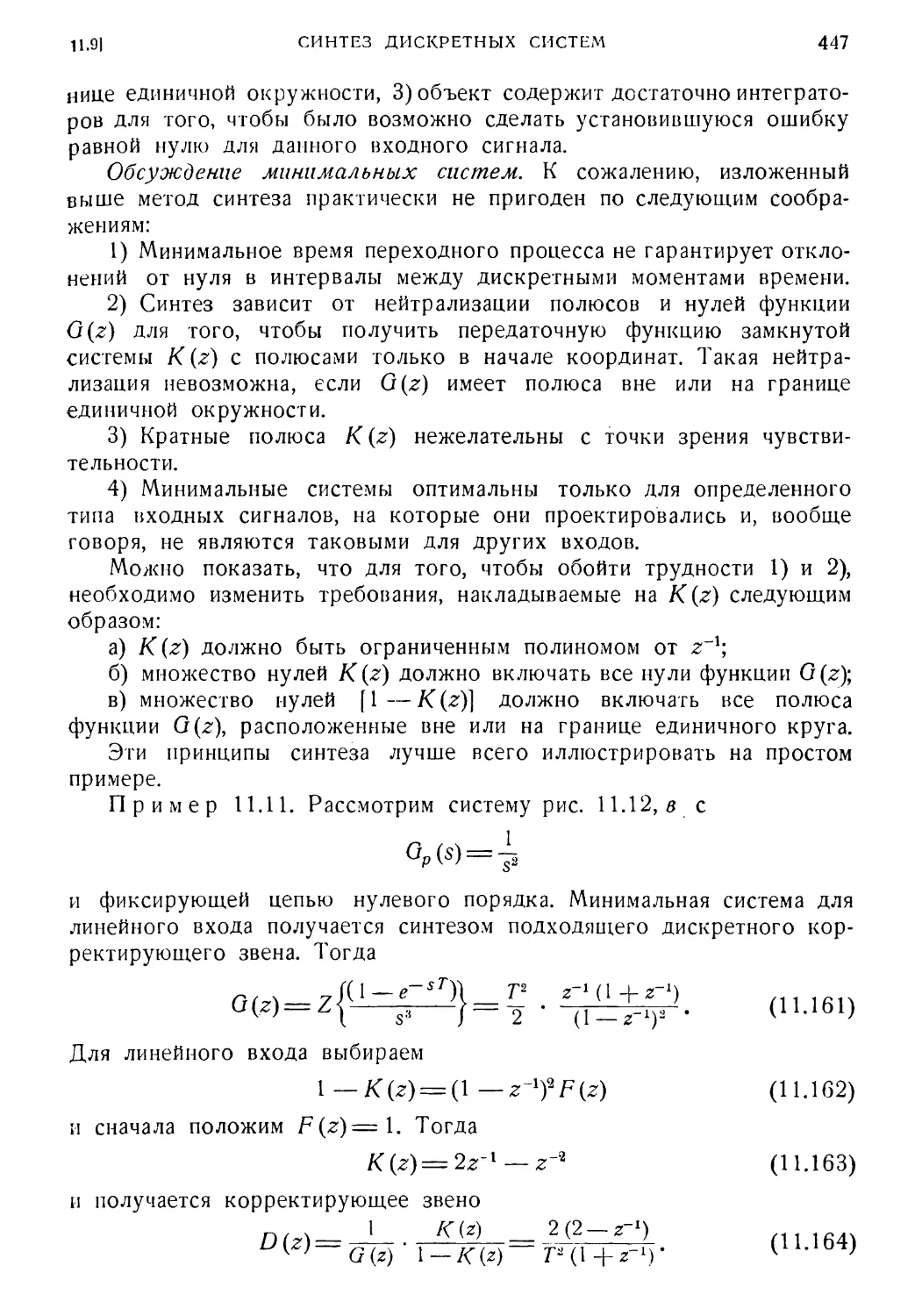

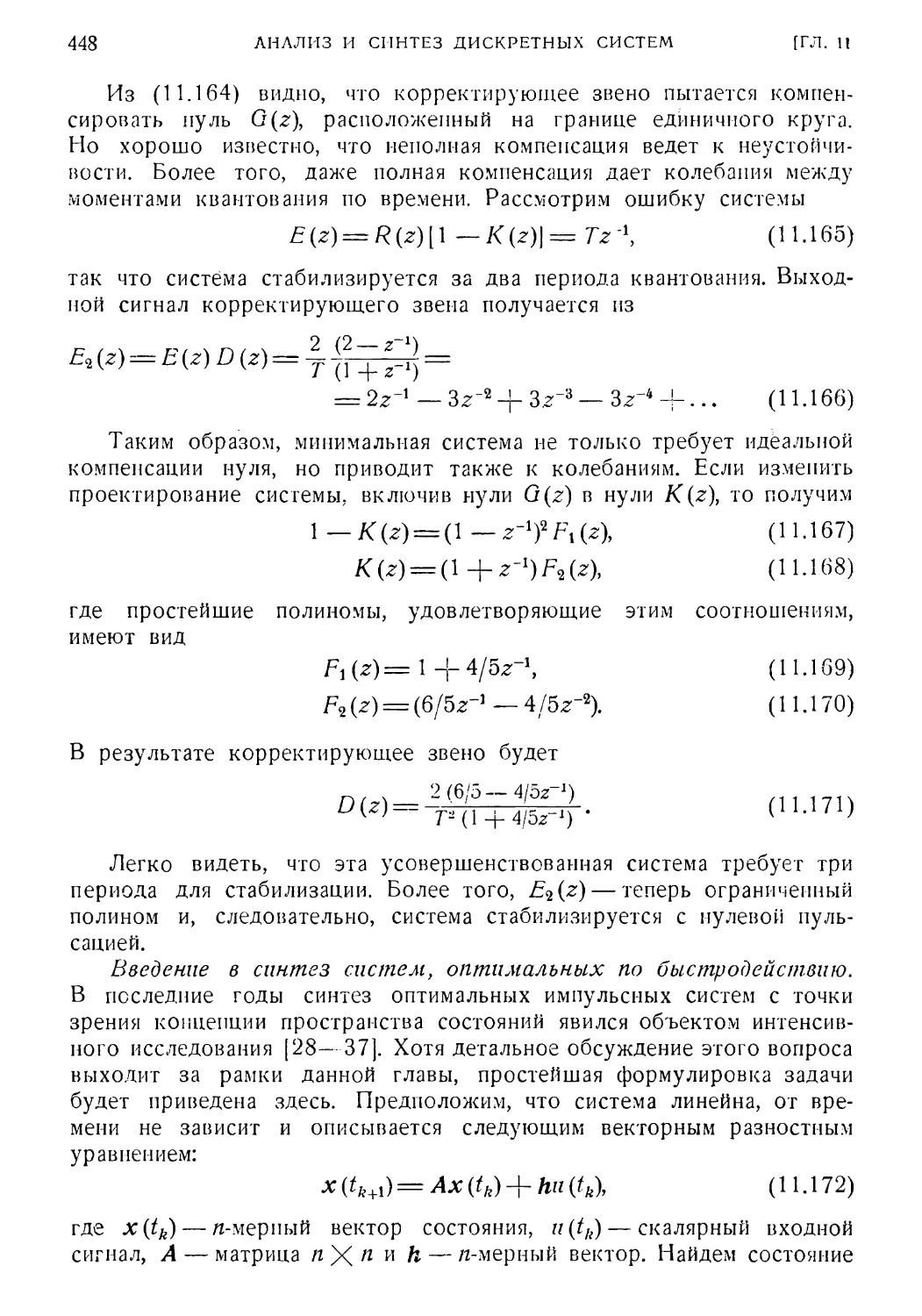

1L9.' Синтез дискретных систем 443

Литература 451

Глава 12. Человек-оператор в системах управления 454

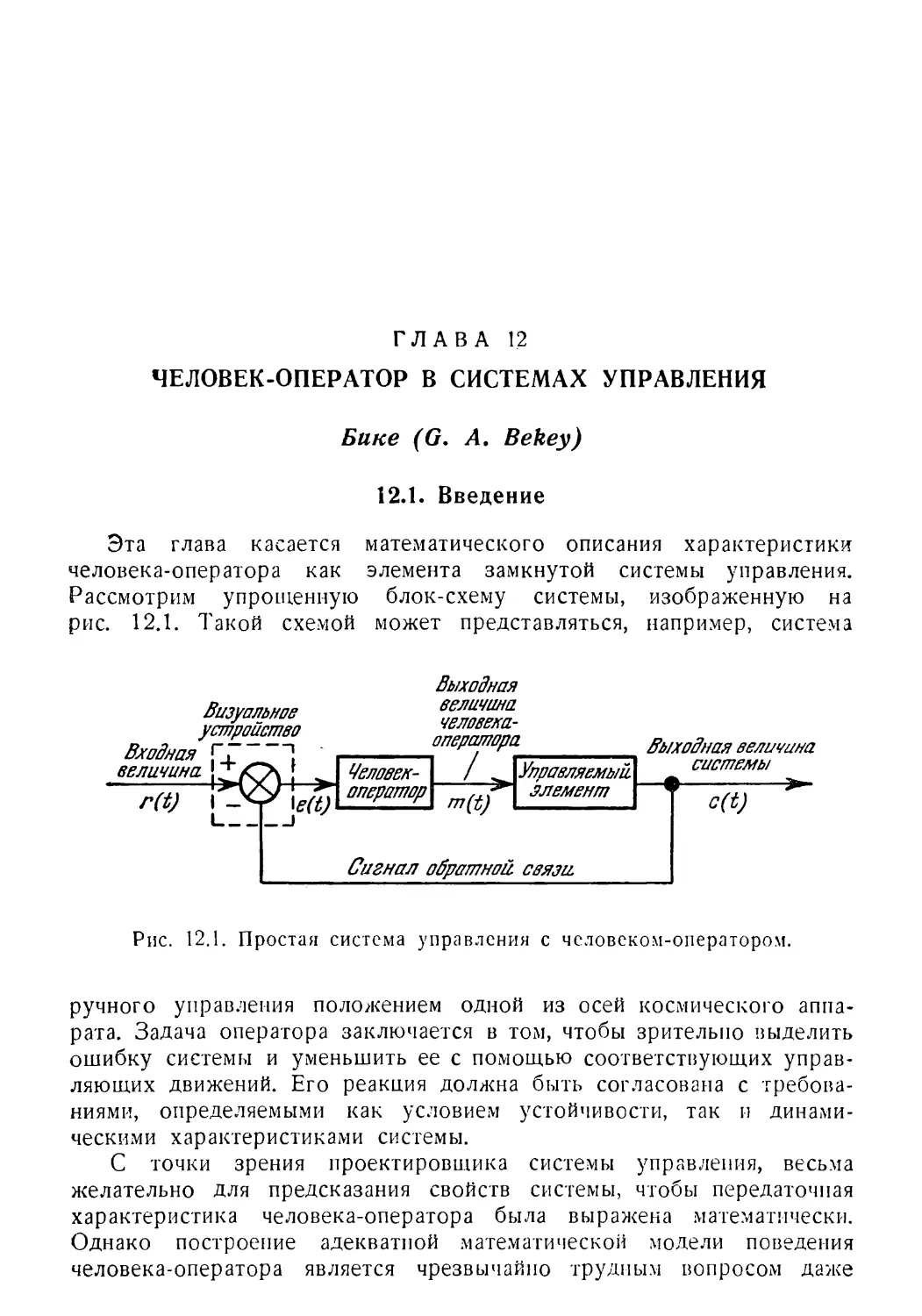

12. 1. Введение 454

12! 2. Характеристики человек-оператора в системе управления 455

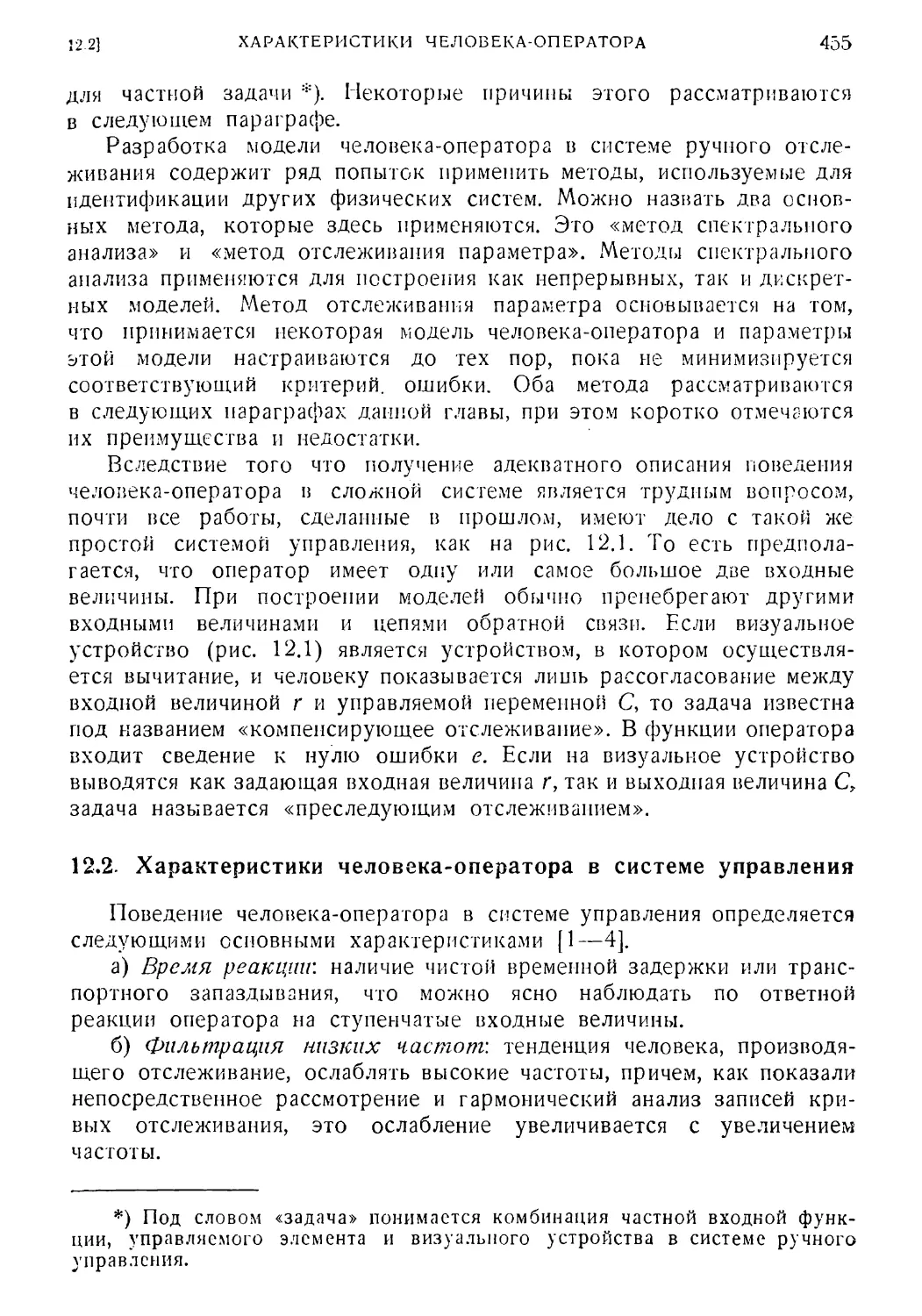

12. 3. Квазилинейные непрерывные модели 456

12. 4. Синтез квазилинейных непрерывных моделей : 459

12. 5. Зависимость параметров модели от вынуждающей функ¬

ции 462

12. 6. Недостатки квазилинейной непрерывной модели . . . . > 462

12. 7. Дискретные или импульсные модели человека-оператора 463

12. 8. Анализ непрерывных моделей с квантованием по времени

при случайных входных сигналах 466

12. 9. Нелинейные модели человека-оператора 473

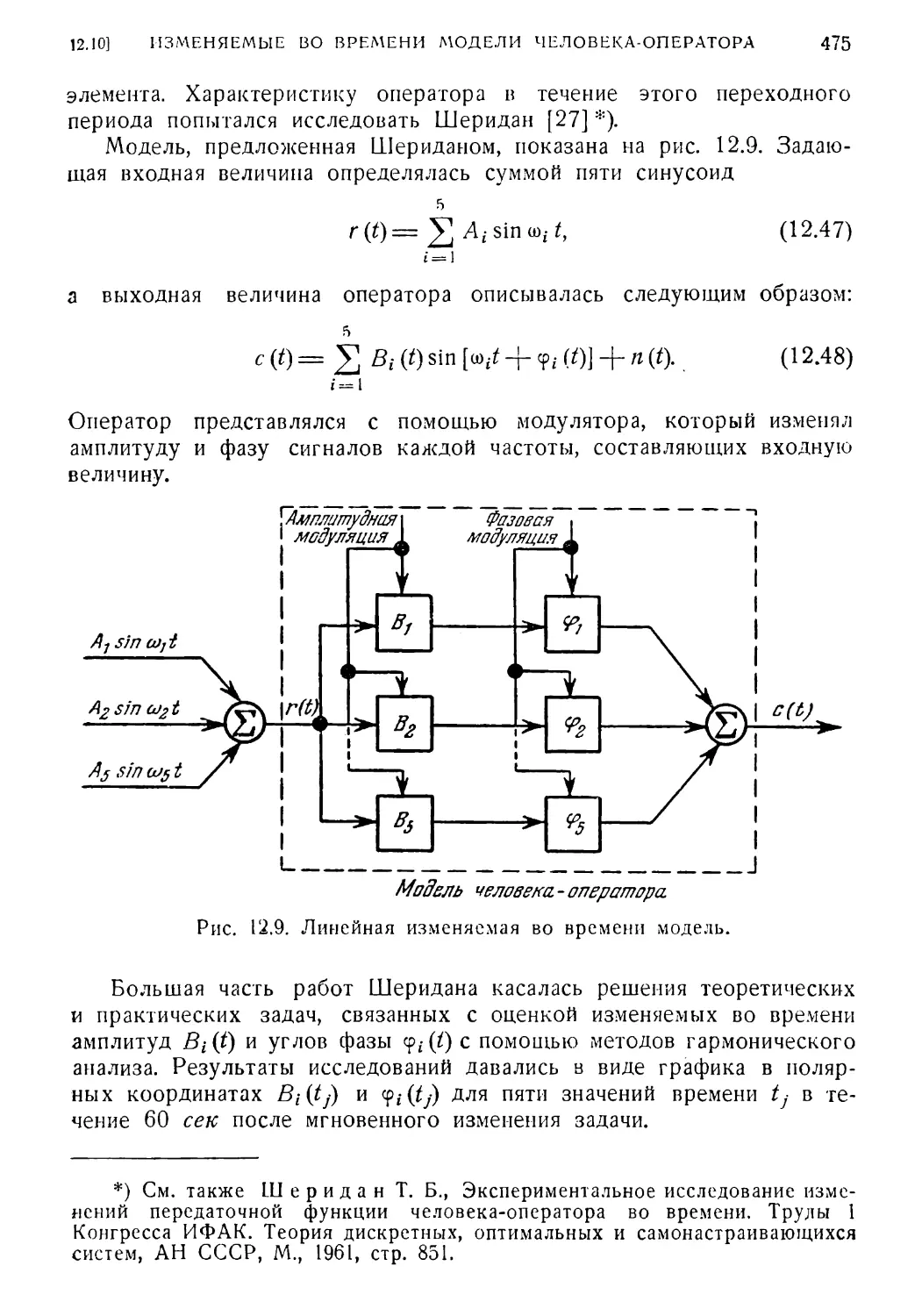

12.10. Изменяемые во времени модели человека-оператора . . . 474

12.11. Методы автоматического согласования (отслеживания па¬

раметров) модели для описания характеристики человека-

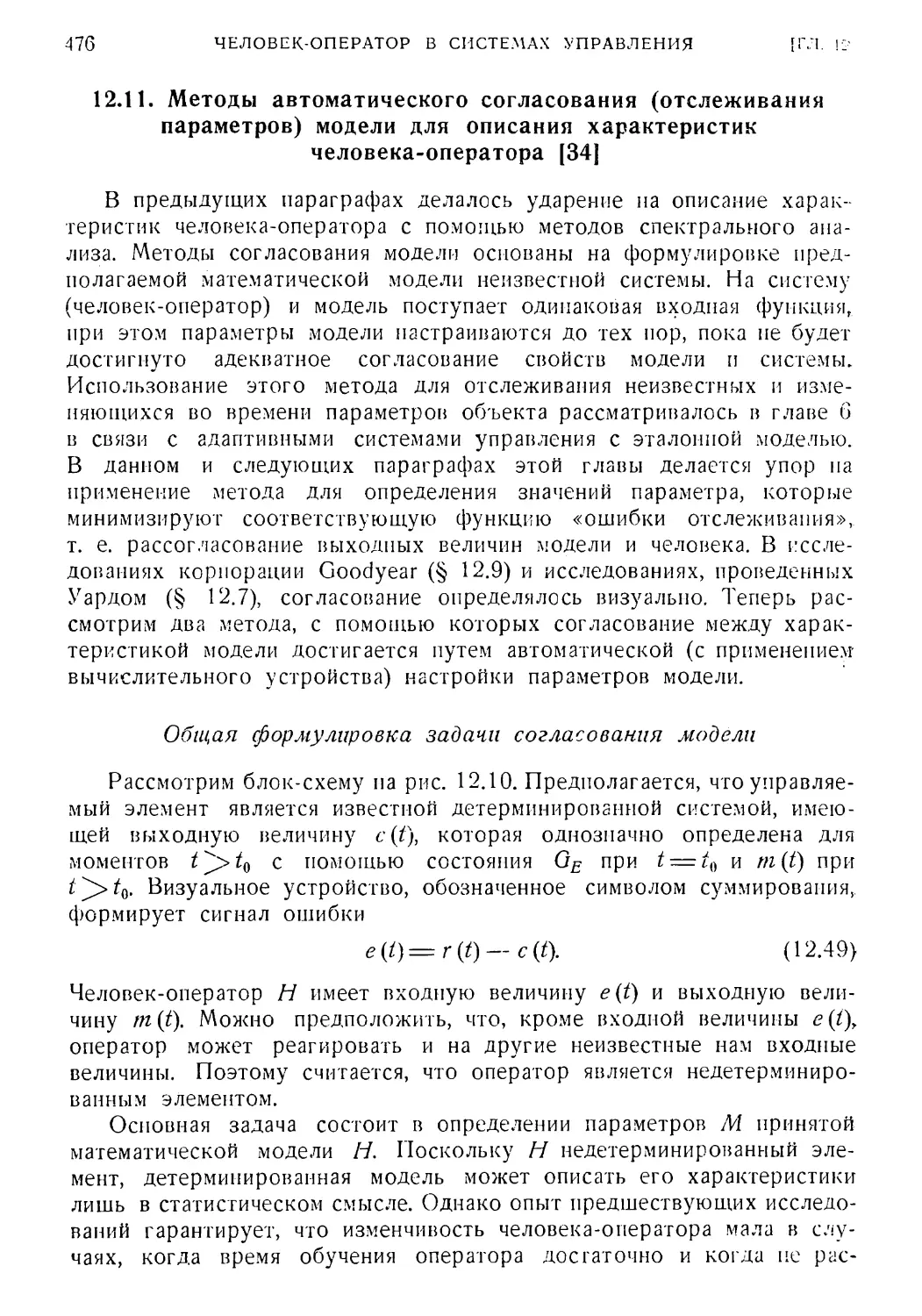

оператора [34] 476

12.12. Непрерывные методы отслеживания параметров 478

12.13. Согласование модели в случае ортогональных фильтров 482

12.14. Заключение 483

Литература 483

Глава 13. Применение современных методов анализа и синтеза

к системам управления летательными аппаратами 486

13.1. Введение 486

13.2. Общие свойства уравнений динамики 487

13.3. Общие задачи управления 492

13.4. Методы анализа и решения задач управления 495

13.5. Характерные примеры 500

Литература 507

Предметный указатель 509

ОТ РЕДАКТОРА РУССКОГО ПЕРЕВОДА

В настоящее время нет недостатка в книгах по теории и технике

автоматического управления как учебного, так и монографического

характера. В силу быстрого развития теории управления многие из

этих книг устаревают порой до выхода в свет. Поэтому особую

важность приобретают книги, в которых изложены наиболее важные

направления современной теории, созданные в последние годы. Не

перегруженные деталями, эти книги позволяют познакомиться широ¬

кому кругу специалистов с состоянием и перспективами развития этих

новых направлений.

Именно этим требованиям и удовлетворяет предлагаемый совет¬

скому читателю перевод книги «Современная теория систем управле¬

ния», написанной коллективом известных американских специалистов

под редакцией проф. Леондеса.

В книге изложено много новых вопросов, которые до самого по¬

следнего времени обсуждались только на страницах технических жур¬

налов. Это относится к новым методам анализа и синтеза систем

управления (методов функционального анализа, стохастической аппрок¬

симации), теории адаптивных систем и систем с человеком-оператором.

Ряд вопросов, относящихся к сравнительно известным разделам, таким,

как системы с переменными параметрами, поведение систем при слу¬

чайных воздействиях, нелинейные, дискретные и оптимальные системы,

изложены в четкой и ясной форме и представят большой интерес не

только для новичков, но и для специалистов.

Составленная в виде сборника отдельных работ, книга позволит

специалистам с минимальной затратой времени познакомиться с суще¬

ством интересующих его направлений, а также с библиографией ра¬

бот по этому направлению.

ОТ РЕДАКТОРА РУССКОГО ПЕРЕВОДА

1!

Ссылки на литературу, добавленную редактором в библиографию

соответствующих глав, отмечены звездочкой. По сравнению с ориги¬

налом глава 1 дополнена новыми параграфами 1.28—1.38, которые

представляют собой разделы книги [17] автора этой главы.

Книга, безусловно, будет полезна научным работникам, инженерам,

аспирантам, студентам и всем тем, кто пожелает познакомиться с но¬

выми направлениями современной теории автоматического управления.

В переводе книги принимали участие Я. А. Коган, (гл. 2,4,9,10),

Ю. Э. Сагалов (гл. 1, 6, 12, 13) и И. В. Тиме (гл. 3, 5, 7, 8, 11)

Параграфы 1.28—1.38 главы 1 переведены С. К. Арутюновым.

Я. Цыпкин

ПРЕДИСЛОВИЕ

По сравнению с сегодняшним уровнем знаний в начале 40-х го¬

дов этого столетия методов анализа и синтеза систем управления

фактически не было. В то время только начинали развиваться методы

расчета простых опережающих или запаздывающих корректирующих

звеньев с желаемыми временными характеристиками для относительно

простых линейных систем. Метод корневого годографа и связанные

с ним понятия появились всего лишь немногим более десяти лет назад.

Метод гармонического коэффициента усиления, столь полезный при

расчете и исследовании многих нелинейных систем управления, также

появился в 50-х годах. Во многих случаях задачи, возникающие

в приложениях, опережали появление методов, пригодных для их

решения.

Последнее десятилетие характеризуется весьма значительным рос¬

том числа приложений теории систем управления. Благодаря появле¬

нию все более усложняющихся разнообразных прикладных задач

сильно развилась и сама теория. Развитию теории систем управления

способствовало и то, что за это время было поставлено много хоро¬

ших задач, которые привлекли внимание математиков, физиков и инже-

неров-теоретиков. Ярким примером такого интереса к задачам теории

систем управления могут служить работы математиков Р. Велл¬

мана по динамическому программированию и Л. С. Понтрягина по

принципу максимума.

Стоит, вероятно, отметить, что если в начале 40-х годов имевшиеся

теоретические методы во многих случаях были неадекватны много¬

численным прикладным задачам, то в последние годы наблюдается

ситуация, когда многие развитые или развиваемые методы появляются

задолго до возможного их применения, если вообще это когда-либо

можно будет сделать. Однако даже в этих случаях есть примеры, в

которых теоретические результаты приводили в конечном счете к

плодотворным идеям с точки зрения приложений. Развитие теории в

любом случае неизбежно ведет к более глубокому пониманию изуча¬

емых явлений.

Эта книга является хорошим подтверждением некоторых из вы¬

сказанных выше суждений. Большинство из описанных в ней методов

ПРЕДИСЛОВИЕ

13

нпосъ менее пяти лет назад. Возможности применения этих ме-

Подов вполне ясны. Возьмем, например, главу 1 «Методы синтеза ли¬

нейных систем автоматического управления с переменными'парамет¬

рами», написанную Стабберудом. Еще несколько лет назад общие

методы синтеза линейных систем с переменными параметрами нахо¬

дились в относительно неудовлетворительном состоянии. Результаты

исследований Стабберуда за последние годы в значительной степени

способствовали изменению такой ситуации. Эти результаты имеют

многочисленные полезные практические применения, например в не¬

которых задачах управления посадкой самолета, задаче управления

снарядами класса «воздух — воздух» и многих других. К этому мож¬

но добавить, что в ряде случаев при анализе и синтезе нелинейных

систем их можно с достаточной степенью точности аппроксимировать

линейными системами с переменными параметрами. Аналогичные за¬

мечания можно сделать и почти по всему остальному материалу книги.

При выборе содержания этой книги мы исходили из следующих

соображений. Прежде всего отдавалось предпочтение тем методам,

которые, по-видимому, выдержат проверку временем. Кроме того, там,

где это было возможно и уместно, была опущена большая часть из

тех важных методов, которые уже хорошо изложены где-нибудь в

другом месте.

Например, эффективный метод динамического программирования

рассматривается Шульцем в одном из параграфов главы 9 скорее с

целью сравнения, чем с целью вывода, так как уже имеются широко

известные книги и работы, в которых он хорошо изложен. С дру¬

гой стороны, методы, представленные в книге Понтрягина и др.

«Математическая теория оптимальных процессов», довольно под¬

робно рассмотрены в главе 7.

Теперь уместно в нескольких словах обсудить каждую из глав

книги и роль, которую описанные в них методы играют при совре¬

менном состоянии теории управления. Область синтеза линейных авто¬

матических систем с переменными параметрами, рассматриваемая

в главе 1, является предельно важной в прикладной теории систем

управления, и некоторые замечания о характере этой главы были

сделаны выше.

Работы, посвященные синтезу многомерных систем или многопо¬

люсников со случайными воздействиями, появились сравнительно

недавно. Отметим также, что подходящие методы математического

описания случайных процессов, которые могут поступать на вход

систем управления, получили слабое освещение в литературе. Осо¬

бенно это касается более сложных процессов, встречающихся при

проектировании технических систем. Глава 2 поднимает эти важные

вопросы.

Можно с уверенностью сказать, что в следующем десятилетии

Довольно большое число инженеров-практиков будет хорошо знать

14

ПРЕДИСЛОВИЕ

методы функционального анализа и понимать их ценность для реше¬

ния инженерных задач теории управления. Глава 3 вводит читателя

в круг идей функционального анализа. В ней приводятся примеры

применения методов функционального анализа к решению приклад¬

ных задач управления. В последнее время появилось много прекрас¬

ных книг по функциональному анализу, которые предназначены для

инженеров. Особенно здесь стоит отметить очень хорошие учебники,

изданные в СССР.

При использовании методов моделирования, например метода

моделирования сопряженной системы, предложенного более десяти

лет назад Лэнингом и Бэттином для определения среднеквадратичной

ошибки линейной системы с переменными параметрами, на вход ко¬

торой поступает нестационарный случайный процесс, необходимо

уметь получать нестационарный случайный сигнал из стационарного

«белого шума». Кроме того, различные развитые недавно методы

синтеза оптимальных линейных фильтров с переменными параметрами,

на вход которых поступают нестационарные случайные сигналы,

существенно опираются на математическое описание формирующего

фильтра, посредством которого данный нестационарный случайный

сигнал получается из «белого шума». Уже из сказанного можно

усмотреть важность решений задачи определения формирующего

фильтра при рассмотрении довольно широкого класса задач автома¬

тического управления. Поэтому глава 4 посвящена формирующим

фильтрам для случайных процессов.

В последнее время появились достаточно хорошие учебники

по применению прямого метода Ляпунова для анализа нелинейных

систем управления. Среди них книга В. Хана, которая недавно пере¬

ведена на английский язык, и хорошо известная книга Ласаля и Леф-

шеца. Однако в обеих книгах отсутствуют некоторые очень полезные

для практики методы образования функции Ляпунова, например метод

градиента, предложенный недавно Д. Г. Шульцем. Это, конечно,

произошло из-за того, что метод Шульца был опубликован после

выхода упомянутых книг. С момента выхода этих книг появились

и другие новые результаты. Ввиду большой важности прямого метода

Ляпунова для прикладных задач, а также для того, чтобы сделать

ряд полученных недавно интересных результатов более доступными

и возможно более пригодными для инженеров, в книгу включена

глава 5. Среди методов, рассматриваемых в этой главе, отметим

весьма существенный для практики метод Ляпунова для неавтономных

систем.

Учитывая тенденцию все большего усложнения задач управления,

для их решения разрабатываются новые методы. Наиболее интересные

из них с точки зрения приложений дает теория адаптивных систем

управления. Глава б посвящена рассмотрению одного подхода к раз¬

работке различных методов синтеза адаптивных систем управления.

ПРЕДИСЛОВИЕ

15

Не затрагивая здесь вопрос определения адаптивных систем управле¬

ния, оставим дальнейшие замечания до главы 6.

О главе 7 уже говорилось выше.

Глава 8 посвящена развитию подхода к задаче оптимизации

систем, связанного с так называемой L-проблемой моментов

№ Г Крейна. Методы, применяемые здесь, основаны на функциональном

анализе и были рассмотрены ранее в главе 3. В данной главе изла¬

гается Г-проблема Крейна и показывается, как с ее помощью можно

избежать решения двухточечной краевой задачи, возникающей во мно¬

гих оптимальных задачах. Часть из них обсуждается в главе 9; хотя

при этом часто возникают другие вычислительные проблемы подобной

трудности. Указываются и другие важные приложения рассматривае¬

мого подхода.

Глава 9 посвящена рассмотрению и сравнению различных анали¬

тических методов синтеза оптимальных линейных систем управления.

Изучаемые и сравниваемые здесь методы включают динамическое

программирование и принцип максимума Понтрягина. Такое сравнение

должно оказаться весьма полезным для более ясного понимания отно¬

сительной ценности этих методов при решении рассмотренного класса

задач.

Теория стохастической аппроксимации дает один из подходов

к исследованию стохастической устойчивости систем управления.

Несмотря на то, что методы стохастической аппроксимации в настоя¬

щее время мало используются, обзор и исследование задач, которые

можно решать с помощью этих важных методов, вполне уместны,

и эти вопросы рассматриваются в главе 10.

Вычислительные машины дискретного действия играют все боль¬

шую роль в современных устройствах управления. Основой развития

этих устройств являются методы анализа и синтеза дискретных сис¬

тем. Огромная важность этой области ясна из материалов, представ¬

ленных в главе 11.

Человек-оператор присутствует во многих системах управления

либо как неотъемлемая часть, либо как элемент, включающийся в ра¬

боту в случае крайней необходимости, например при выходе из строя

основных узлов системы. В последней ситуации конструкция системы

управления обязательно должна учитывать рабочие характеристики

человека-оператора или его передаточную функцию. Такой аналитиче¬

ский подход можно использовать, например, для установления огра¬

ничений на величины параметров системы управления, чтобы гаранти¬

ровать, что человек-оператор действительно сможет управлять столь

сложной системой, как, например, космический корабль, если вне¬

запно возникнет аварийная ситуация из-за неисправности элементов

системы управления. »

Глава 12 посвящена общим вопросам математического описания

чел°века-оператора в системах управления.

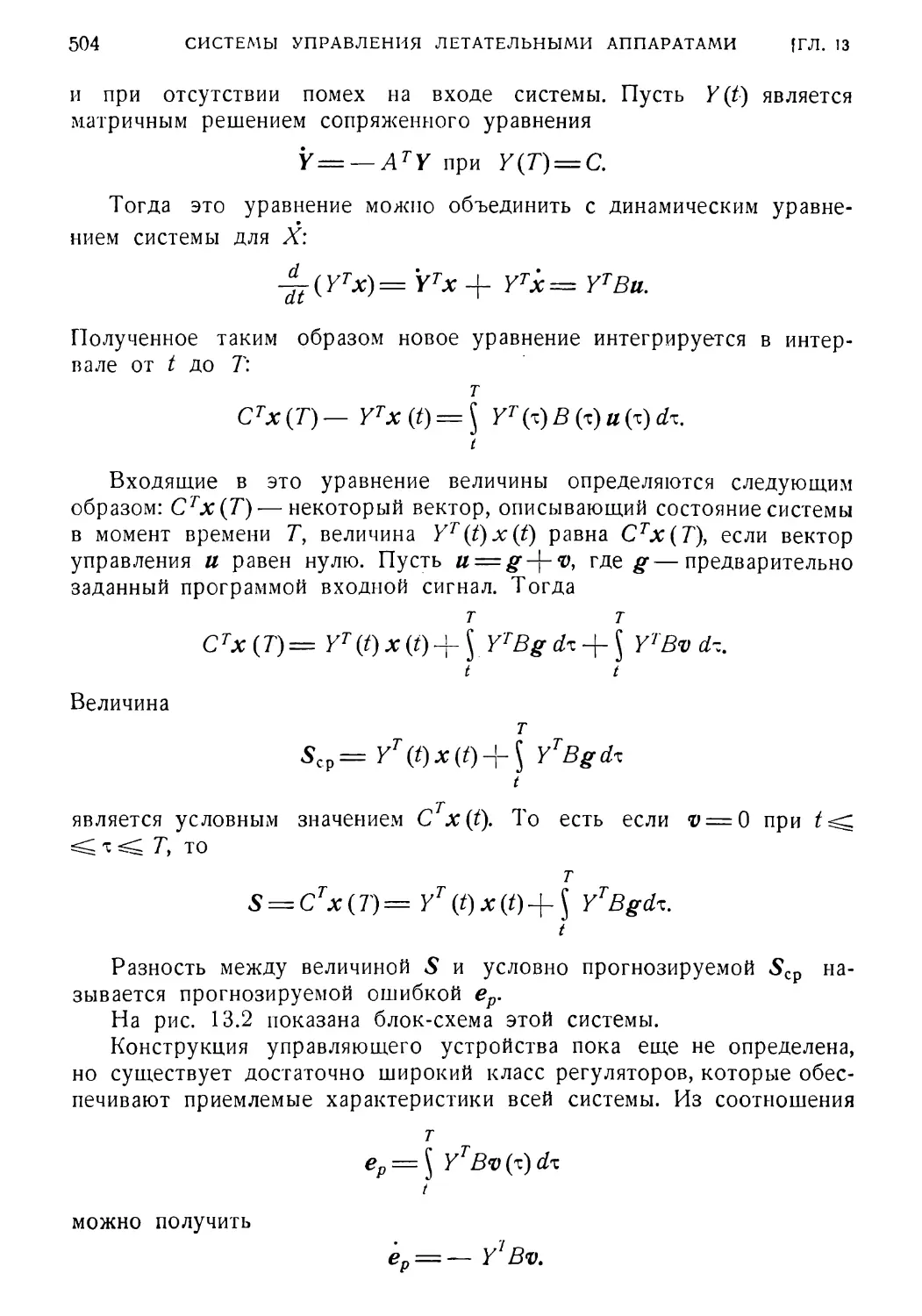

16-

ПРЕДИСЛОВИЕ

Книга заканчивается главой, в которой содержатся некоторые

замечания о применении теории и методов, изложенных в предыду¬

щих главах, к системам управления летательными аппаратами.

Теперь приятно выразить ряд благодарностей. Прежде всего редак¬

тор хотел бы поблагодарить AFORS (Научно-исследовательское управ¬

ление ВВС США) и особенно тех из этой организации, кто помог

осуществить научные исследования по теории систем управления

в UCLA (Калифорнийский университет, Лос-Анжелос) и других инсти¬

тутах, работающих в этой области. Многие результаты, изложенные

здесь, получены в UCLA и других исследовательских группах, финан¬

сируемых военными организациями. Без такого финансирования эти

результаты, целый ряд из которых имеет большое прикладное значе¬

ние, вряд ли можно было бы получить.

Эта книга создана на основе государственного двухнедельного

летнего курса, читавшегося в UCLA в течение нескольких прошлых

лет. Приятно поблагодарить слушателей, многие из которых были

опытными инженерами-практиками, за их замечания, способствовав¬

шие улучшению курса и книги.

И наконец, очень приятно выразить благодарность коллективу

авторов, которые, несмотря на большую занятость, взяли на себя

ответственность в написании этой книги. Общение с ними в этом

рискованном предприятии доставило мне огромное удовольствие.

А*. 7. Леондес

ГЛАВА Г

МЕТОДЫ СИНТЕЗА ЛИНЕЙНЫХ СИСТЕМ АВТОМАТИЧЕСКОГО

УПРАВЛЕНИЯ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

Стабберуд (A. R. Stubberud)

В теории управления хорошо разработаны общие методы анализа

и синтеза линейных систем с постоянными параметрами, но гораздо

меньше уделено внимания анализу и синтезу линейных систем с пере¬

менными параметрами и нелинейных систем. Это объясняется, во-пер¬

вых, тем, что общее решение линейных дифференциальных уравнений

с постоянными коэффициентами находится значительно легче, чем общее

решение линейных уравнений с переменными коэффициентами и тем

более нелинейных дифференциальных уравнений, и, во-вторых, тем,

что во многих случаях эти уравнения достаточно хорошо аппрокси¬

мируются линейными системами с постоянными коэффициентами.

В данной главе рассмотрены методы синтеза линейных систем

автоматического управления с переменными параметрами. Эти методы

являются вполне общими и аналогичны классическим методам синтеза

линейных систем с постоянными параметрами.

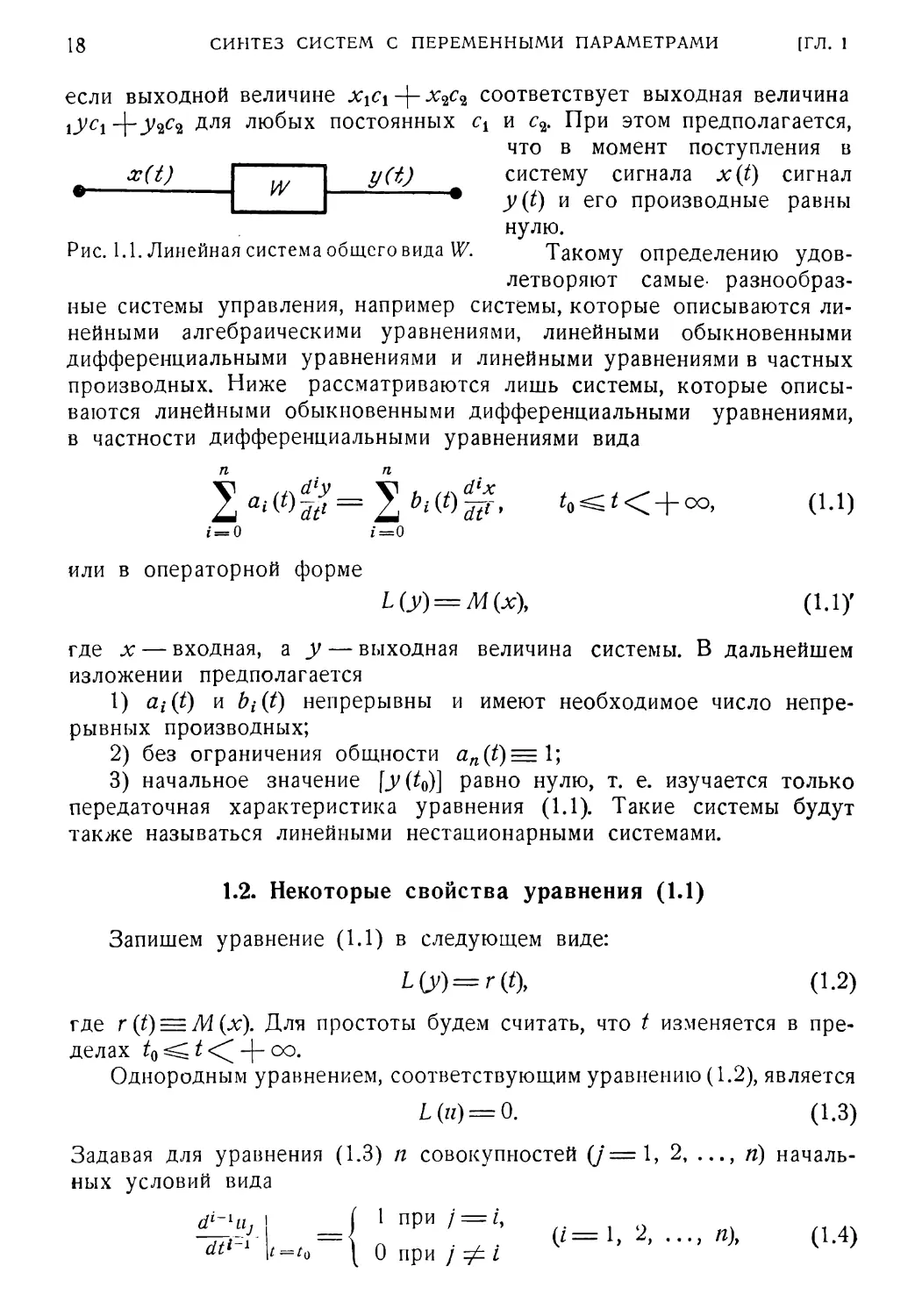

1.1. Некоторые характеристики линейных систем

На рис. 1.1 изображена линейная система общего вида. Входная

величина системы является некоторой функцией времени, обозначае¬

мой x(t), а соответствующая ей выходная величина —у (t). Вообще

говоря, x(t) и y(t) могут быть векторами, однако в данной главе

считается, что они скаляры.

Линейная система определяется следующим образом.

Определение*).

Пусть входной величине системы хх соответствует выходная вели¬

чина уь а х2— выходная величина у2. Система называется линейной,

*) Системы, удовлетворяющие этому определению, иногда называются

линейными системами с нулевыми начальными условиями, но в данной главе

мы будем называть их просто линейными.

18

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

если выходной величине ххсх~\- соответствует выходная величина

\УС\ -{“УчС* для любых постоянных сх и с2. При этом предполагается,

что в момент поступления в

y(t) систему сигнала x(t) сигнал

• y(t) и его производные равны

нулю.

Рис. 1.1. Линейная система общего вида W. Такому определению удов¬

летворяют самые- разнообраз¬

ные системы управления, например системы, которые описываются ли¬

нейными алгебраическими уравнениями, линейными обыкновенными

дифференциальными уравнениями и линейными уравнениями в частных

производных. Ниже рассматриваются лишь системы, которые описы¬

ваются линейными обыкновенными дифференциальными уравнениями,

в частности дифференциальными уравнениями вида

%a^W = %b^W’ *«<*< + «>. (1.1)

1=0 i=0

или в операторной форме

L (у) = М (х)у (1.1)'

где х — входная, а у — выходная величина системы. В дальнейшем

изложении предполагается

1) a,i(t) и bi(t) непрерывны и имеют необходимое число непре¬

рывных производных;

2) без ограничения общности an(t)= 1;

3) начальное значение \y(t^\ равно нулю, т. е. изучается только

передаточная характеристика уравнения (1.1). Такие системы будут

также называться линейными нестационарными системами.

x(t)

W

1.2. Некоторые свойства уравнения (1.1)

Запишем уравнение (1.1) в следующем виде:

L(y)=r{t\ (1.2)

где r(t) = M(x). Для простоты будем считать, что t изменяется в пре¬

делах “Не¬

однородным уравнением, соответствующим уравнению (1.2), является

L{u) = 0. (1.3)

Задавая для уравнения (1.3) п совокупностей (j = 1, 2, ..., п) началь¬

ных условий вида

dt*-1

( 1 при / = /,

= п ' . (/=1, .... «)> (1.4)

‘ =‘о ( 0 при / ф I

1.2]

НЕКОТОРЫЕ СВОЙСТВА УРАВНЕНИЯ (1.1)

19

получим п линейно независимых решений Так как уравнение

(1 3) линейное, решение n{t) для произвольных начальных условий

£Н = Н1'> (/ = 0, 1, п— 1) (1.5)

dt»'

можно записать следующим образом:

П

Н(0= 2 иу-"М/(0. (1.6)

Функции Uj{t) образуют фундаментальную систему решений уравне¬

ния (1.3). Эта система не является единственной, так как любой дру¬

гой набор п линейно независимых решений v^it) ... vn(t) представляет

также фундаментальную систему, которая может быть выражена через

первую с помощью соотношения

(1.7)

Vi (t)

an .,

Чп

И|(0

МО

аЯ1 •

• • *пп

««(0

или в матричной форме

V = || а I] иу (1.8)

где [а] — невырожденная матрица констант.

С другой стороны, если п произвольно взятых решений уравне¬

ния (1.3) линейно зависимы, то они не являются фундаментальной

системой. Достаточным условием линейной независимости системы

решений Ui(t) ... un(t) является неравенство нулю определителя

Вронского, или вронскиана

Д =

щ

Щ

un

dat

du2

dun

~dt

~dt

dt

dn-lux

dn~la2

dn~lu,

dtn~l

dtn~l *

• • dtn-l

(1.9)

Остановимся на одном важном решении уравнения (1.3), назы¬

ваемом весовой функцией, которая определяется как решение (1.3)

при начальных условиях

dlu

It1

= о,

/ = х

dn~lu

dtn~1

t = X

(/ = 0, 1, 2, ..., /z-2), (1.10)

где f-oo. С помощью произвольной фундаментальной си¬

стемы U\{t) ... un(t) это решение можно переписать как

и (9= 2 h щ (0.

i = 1

(1.11)

20

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

где (3* находятся подстановкой уравнения (1.11) в (1.10) так, что

получаются п уравнений, которые записаны в матричной форме

(1.12)

MO

PiW

0

diii

~dt ,

t = X

dun

dt t = x

MO

0

dn~1ul

dt”'1

t = X

dn~lun

" dt”~l t = k

MO

1

Так как определитель этой системы есть вронскиан, то данная си¬

стема уравнений всегда имеет решение, которое и является весовой

функцией

U(f)=Q(t, z)= 2 МО МО-

i = 1

(1.13)

Общее решение уравнения (1.2) теперь можно выразить через

•весовую функцию при помощи интеграла свертки

y(t)= ^ Q(t, z)r(z)dx.

to

(1.14)

Непосредственной подстановкой легко показать, что y(t) удовлетво¬

ряет уравнению (1.2), если вспомнить, что для

а {х)

z(x)= \ F (х, t) dt

Ь(Х)

справедливо

а {х)

d±— [

dx~ )

ь (Л-)

dF(xy t)

д{х)

db

dt + F(x, a)^-F(x, b)~.

dx'

(1.15)

(1.16)

Определение весовой функции можно обобщить, записывая r(t)

в следующем виде:

40= У bt(f)

i=0

dlx

dt19

(1.17)

Если подставить (1.13) и (1.17) в выражение (1.14), которое затем

проинтегрировать по частям, то найдем

y(t)= $ 2 щЦ){% (- iy d’[bj^ —}*<?)d' + к(0-у(0- (1.18)

/о *=1

0=0

1.3]

ОПРЕДЕЛЕНИЕ УРАВНЕНИЯ ПО ВЕСОВОЙ ФУНКЦИИ

2!

Определим теперь весовую функцию W(t, т) для уравнения (1.1) так,

чтобы при свертке ее с x(t) получалось y(t), т. е.

Из сравнения выражений (1.18) и (1.19) следует, что W(t, х) равна

Выше было показано, что каждому дифференциальному уравнению

вида (1.1) соответствует весовая функция, определяемая формулами

(1.20а) и (1.206). Изложенный метод нахождения W(t, т) для урав¬

нения (1.1) обычно очень труден. В частности, трудно найти фунда¬

ментальную систему решений произвольного линейного дифференци¬

ального уравнения с переменными коэффициентами, и не всегда эти

функции могут быть выражены в замкнутой форме. С другой сто¬

роны, как будет сейчас показано, гораздо легче восстановить диффе¬

ренциальное уравнение, зная его весовую функцию.

Пусть задана весовая функция вида (1.20) и требуется найти соот¬

ветствующее ей дифференциальное уравнение. Значения (т), кото¬

рые определяются выражением (1.21), неизвестны. Порядок дифферен¬

циального уравнения должен быть равен п, так как в W(t, т) входят

п линейно независимых решений Ui(t). Для представления искомого

уравнения в форме (1.1) надо найти аг*(£) и bi(t).

Так как Ui (t) являются решениями однородного уравнения (1.3), то

у (t) = ^ W (ty z) л; (т) dz.

(1.19)

п

W{t, х) = 2 И, (*) а, (х) ~ bn (t) 5 (t — х),

(1.20a)

i = 1

= Writ, T) + MW —т),

(1.206)

где

(1.21)

a — T) — S-функция Дирака.

1.3. Определение дифференциального уравнения

по весовой функции

п

1 */<о

= 0 (г = 1, 2, ..., п).

(1.22)

Уравнения (1.22) образуют систему п уравнений с п^\-\ неизвест-

ными. Если an(t) положить равной единице, то из этих уравнений

можно найти остальные

22

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

Найдя cij(t\ можно определить Пусть весовая функция Q(t, т),

соответствующая однородному уравнению (1.3), известна. Тогда ре¬

шение уравнения (1.1) выражается в виде (1.19) и в виде

)>(()= \ 0(1,11)

У ьлщИ.

Lk 1 w d№

Ly= О

dQ.

(1.23)

Приравнивая их, найдем

dlx (0)

d(by

dB=^ W(t,B)x(b)dB. (1.24)

to

t\ 4= о

Теперь, применяя к обеим частям равенства (1.24) дифференциаль-

п

dP

2,^ dP

ар(ч^£р, получим выражение

р = 0

п п V t

2 b<{t)ifj= 2 мо£» S w&

7=0 р = 0 L/0

Подставим (1.206) в (1.25) и для простоты записи обозначим

Fo(t) = bn(t),

(1.25)

д‘-‘ W1 (t, х)

dtl~l

д‘-1 W(t, т)

дЖ

(1.26)

Тогда производные в правой части равенства (1.25) определятся

следующим образом:

dP

dtp

t I

J W(t, B)x(B)dB = J J Wi(t, B)x(B)dB-\-

t0 J h

P

+ 2 ^[Fp-a(*)*(9] (P = 0, 1, .... П). (1.27)

k= 0

Соответственно можно записать всю правую часть равенства (1.25)

п t п р

2 мо $ 2 мо 2 ^[Fp'i<{t) (U8)

р = 0 t о

Так как

р = о А> = 0

ть t

2 5 M9-£p[^iM)]*(e)de=o-

р = 0 to

(1.29)

1.5]

НЕОБХОДИМЫЕ ОПЕРАЦИИ

23

£[/>,(0*(01 = 2 (1.30)

являются биномиальными коэффициентами, то

dk~J

(1.31)

где

2 ь>тё= 2 2 2 (•) “-‘о Si'v.wif.

у=0 p=0A=0/=0u/

Изменяя порядок суммирования в правой части равенства (1.31) сле¬

дующим образом:

п р k п р р п п р

222 = 222 = 2112. о-32»

р = 0 k = 0 у = 0 р = 0 у = 0 /г = / / = 0 p=jk = j

получим, что

мо= 2 2 '=°- '•2 * <133>

P=Jk=j

Выражение (1.33) позволяет определить bj(t) по известным ap(t)

и FM

1.4. Алгебра линейных дифференциальных уравнений

В § 1.5—1.12 вводится применение операторной алгебры линей¬

ных дифференциальных уравнений. Эта алгебра используется в после¬

дующих параграфах для разработки некоторых методов синтеза линей¬

ных автоматических систем с переменными параметрами.

1.5. Необходимые операции

Ввиду того что линейное дифференциальное уравнение вида (1.1)

является линейным преобразованием аг в у, рассматриваемая алгебра

является алгеброй линейных преобразований. В дальнейшем изложе¬

нии заглавными буквами (А, В, С,...) обозначаются дифференциаль¬

ные уравнения вида (1.1).

Алгебра линейных дифференциальных уравнений включает три

операции:

(1) Сложение двух дифференциальных уравнений, т. е.

А-{-В = С. (1.34)

(2) Умножение дифференциального уравнения на скаляр

Ap(t) = B (1.35)

24 СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ [ГЛ. 1

или р (t) А = С. (1.36)

(Если p(t) — const, то В = С.)

(3) Умножение двух дифференциальных уравнений

В А = С. (1.37)

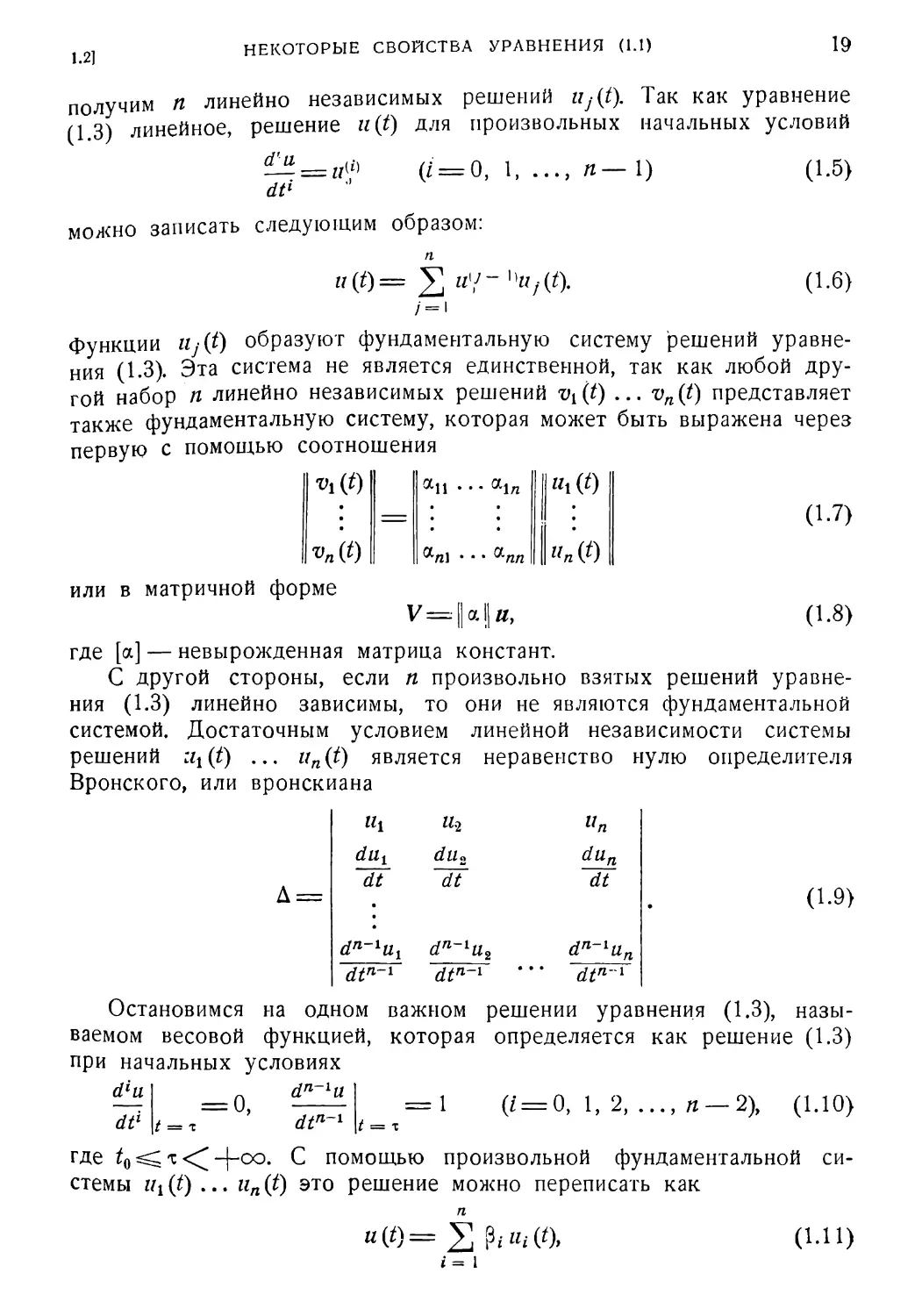

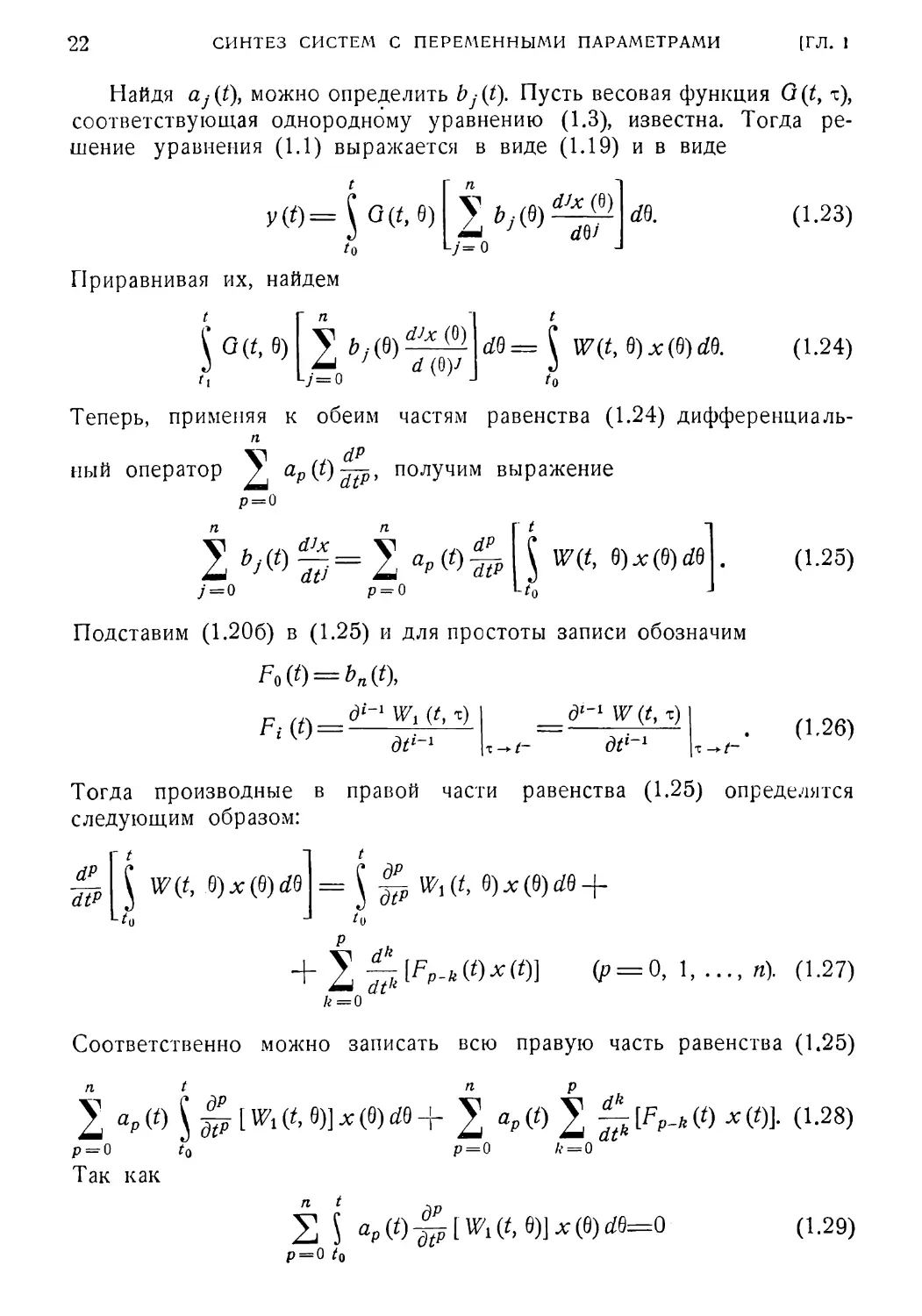

Введенные операции условно показаны с помощью блок-диаграмм

на рис. 1.2. Очевидно, для того чтобы пользоваться этой алгеброй,

а) Сложение двух дифференциальных уравнений

X

т

А

у О —о х

В

б) Умножение дифференциальных уравнений на сксдляр справа

х

А

P(t)

У o — cpL

С

6) Умножение дифференциального уравнения на скаляр слева,

г) Умножение двух дифференциальных уравнений

Рис. 1.2. Операции алгебры преобразований.

следует определить каждую из операций. Кроме того, ниже будут

определены следующие важные элементы этой алгебры:

1. Единичный элемент.

2. Нулевой элемент.

3. Обратный элемент операции сложения.

4. Обратный элемент операции умножения.

1.6]

УМНОЖЕНИЕ ДВУХ ДИФФЕРЕНЦИАЛЬНЫХ УРАВНЕНИЙ

25

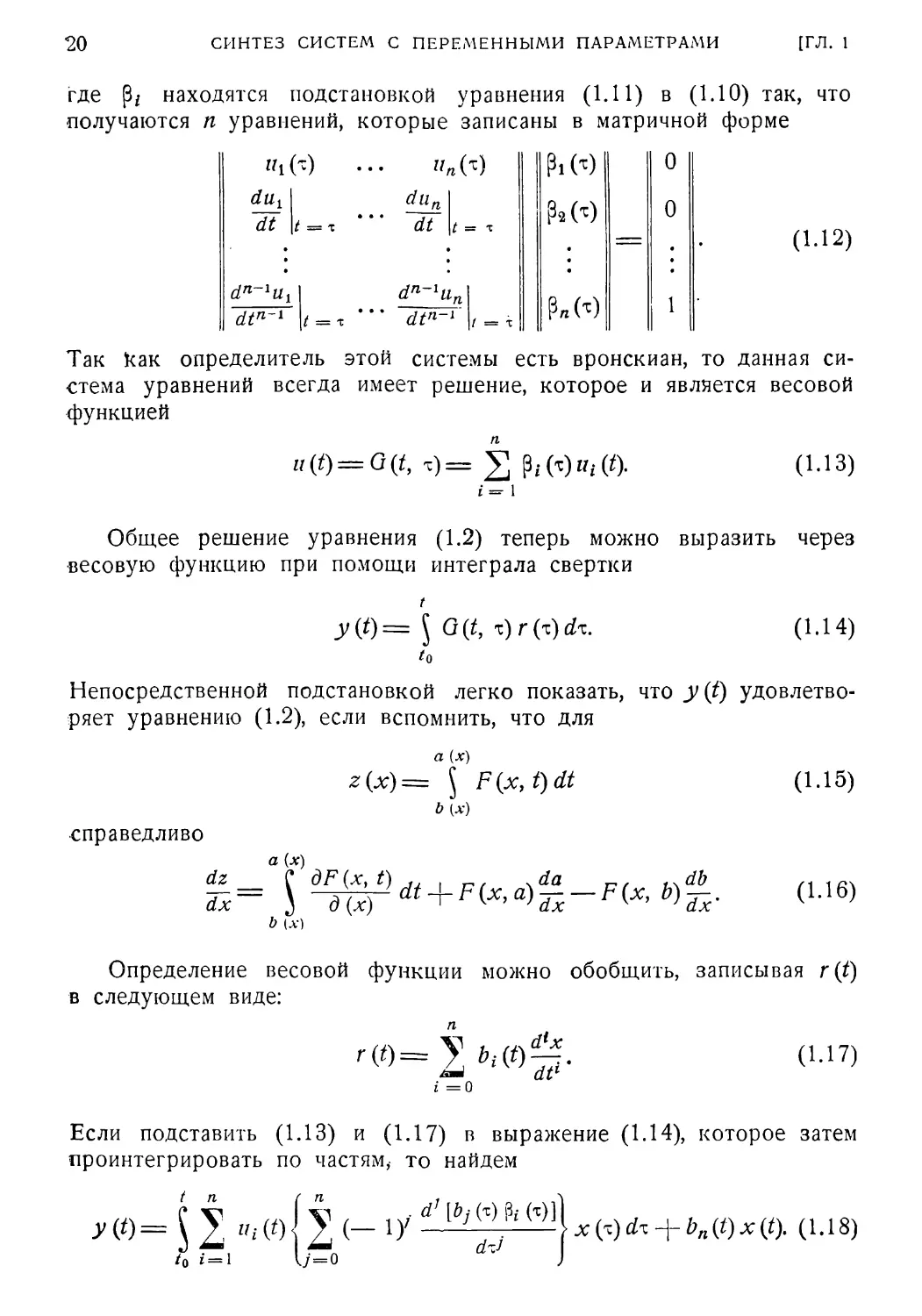

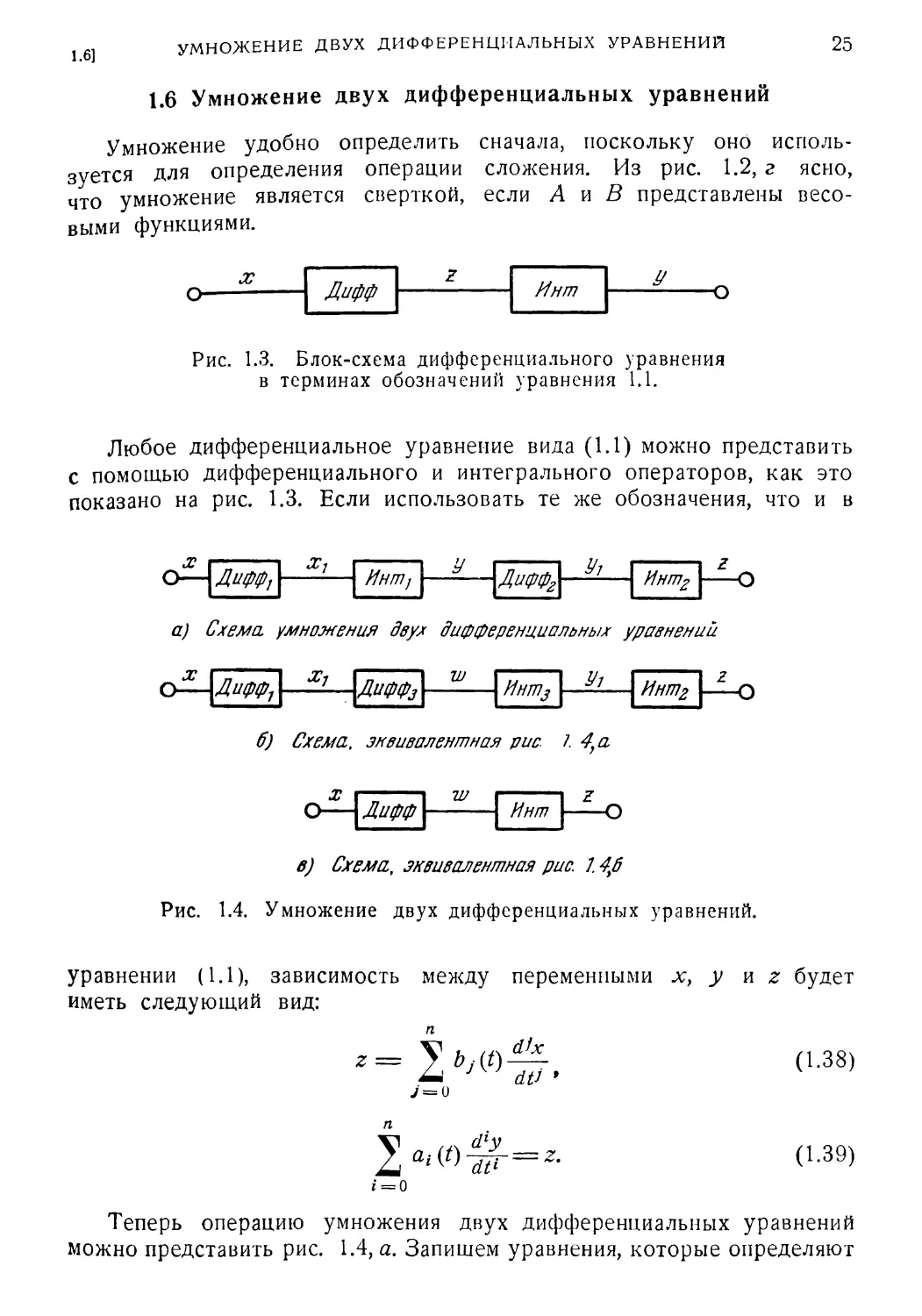

1.6 Умножение двух дифференциальных уравнений

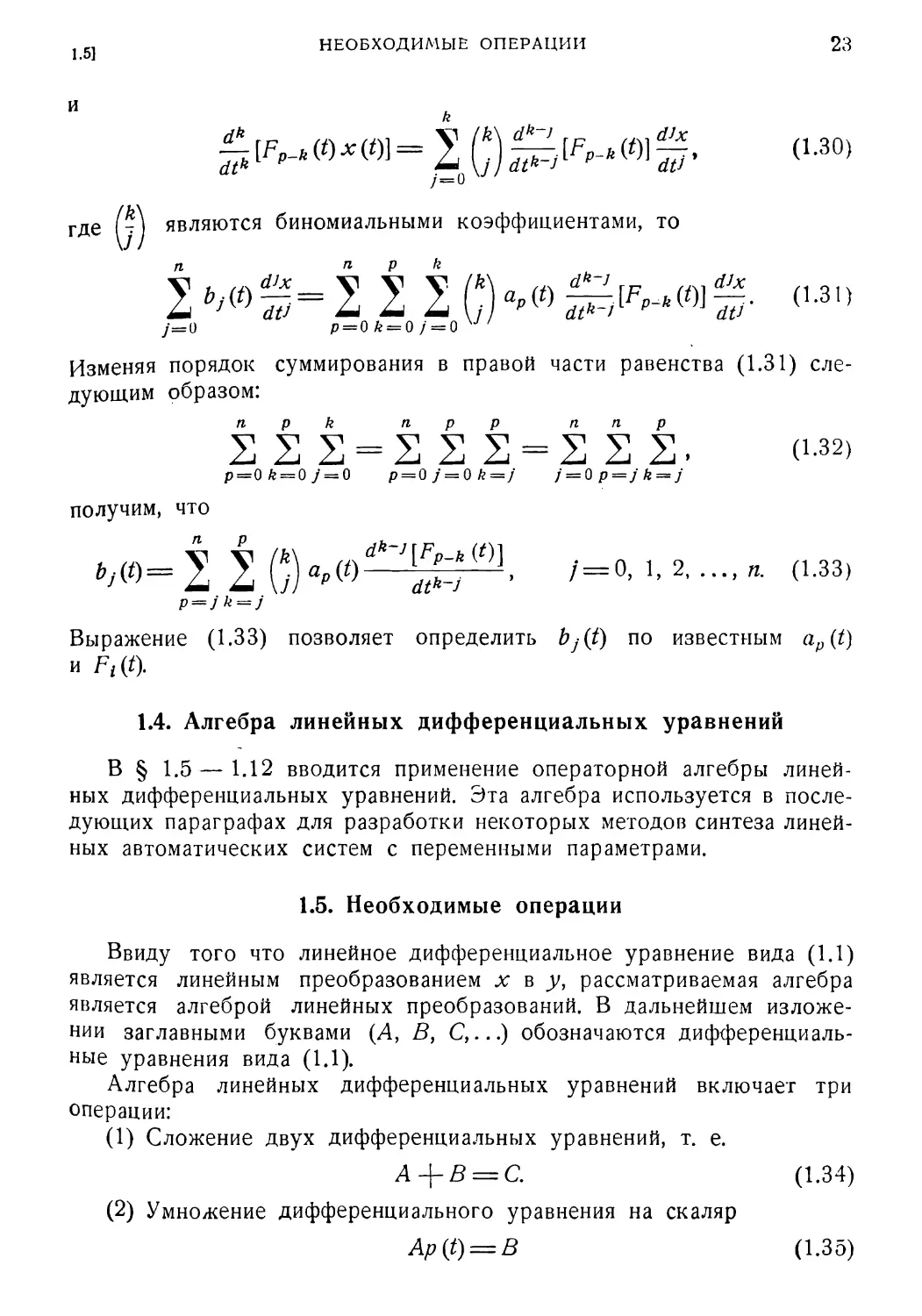

Умножение удобно определить сначала, поскольку оно исполь¬

зуется для определения операции сложения. Из рис. 1.2, г ясно,

что умножение является сверткой, если А и В представлены весо¬

выми функциями.

х

Дифф

Инт

У

Рис. 1.3. Блок-схема дифференциального уравнения

в терминах обозначений уравнения 1.1.

Любое дифференциальное уравнение вида (1.1) можно представить

с помощью дифференциального и интегрального операторов, как это

показано на рис. 1.3. Если использовать те же обозначения, что и в

Дифф,

Х7

Ингл1

У

Диффо

У;

Интр

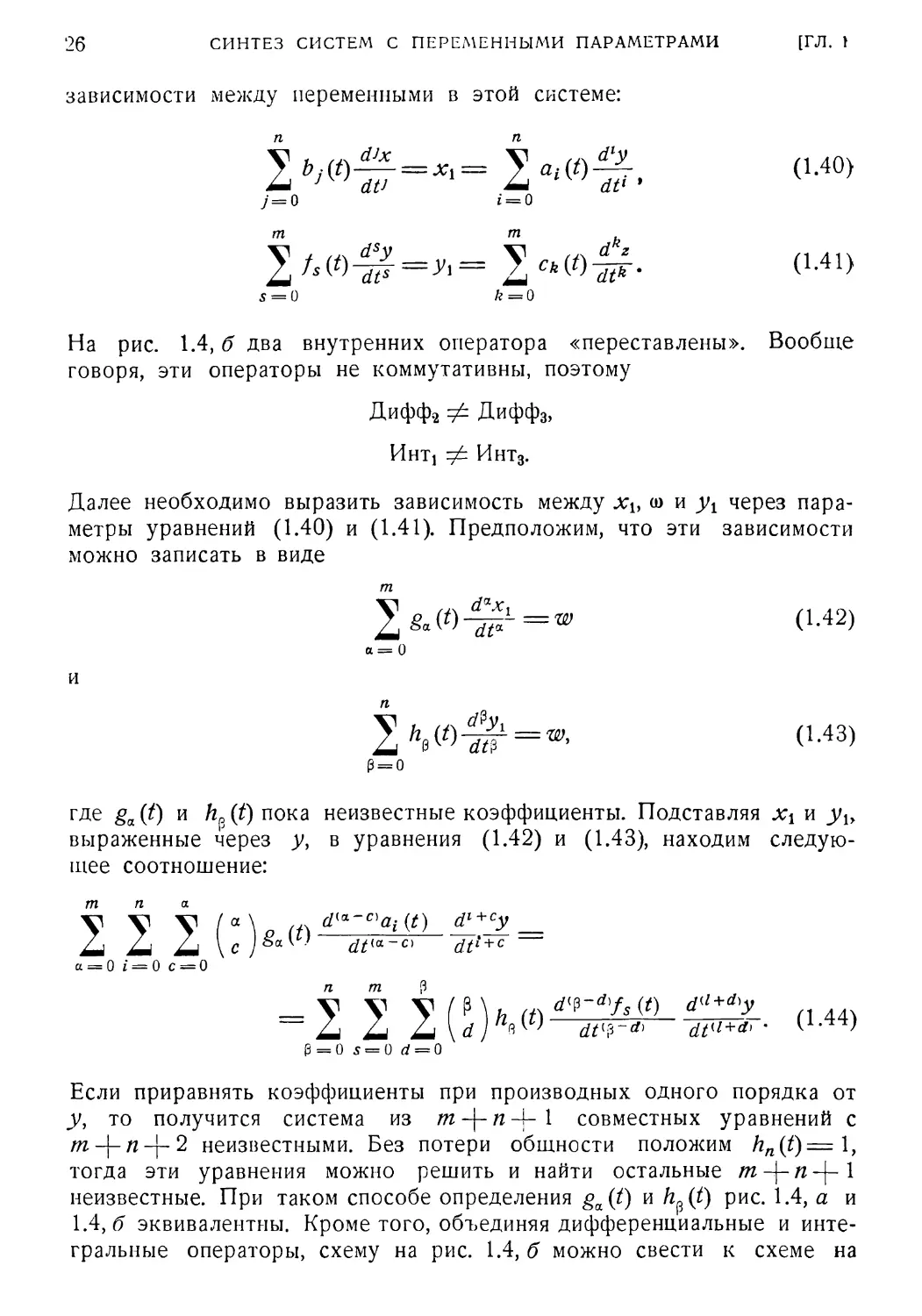

а) Схема, умножения двух дифференциальных уравнений

х

Дифф1

х,

ДифФз

Интпэ

У?

Инт2

6) Схема, знвивалентная рис. I 4У а

х

Дифф

Инт

в) Схема, эквивалентная рис. 14%б

Рис. 1.4. Умножение двух дифференциальных уравнений.

уравнении (1.1), зависимость между переменными х, у и z будет

иметь следующий вид:

= У мо—

dtJ '

J = o

(1.38)

(1.39)

i = 0

Теперь операцию умножения двух дифференциальных уравнений

можно представить рис. 1.4, а. Запишем уравнения, которые определяют

26

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. t

зависимости между переменными в этой системе:

2ь,т^ = х,= 2 «,(/>-& (1.Ю)

у = 0 i = 0

т т

2 2 (1-41)

5 = 0 /г = 0

На рис. 1.4, б два внутренних оператора «переставлены». Вообще

говоря, эти операторы не коммутативны, поэтому

Дифф2 ф Диффз,

Hhtj ф Инт3.

Далее необходимо выразить зависимость между хь (о и уг через пара¬

метры уравнений (1.40) и (1.41). Предположим, что эти зависимости

можно записать в виде

т

0-42)

а = 0

И

2А0(*>Ф=®’ (1.43)

(3 = 0

где ga(t) и hp(t) пока неизвестные коэффициенты. Подставляя хх и уь

выраженные через у, в уравнения (1.42) и (1.43), находим следую¬

щее соотношение:

т п а

2 У У I ° U (п rf(tt~c’g«(<) _

Li Li \cy®a'’ dt'*~C) dt!+c

a = 0 i = 0 С = 0

n m (3

= 2 2 2{1)кт^Р-^- (..44,

3 = 0 5 = 0 d = 0

Если приравнять коэффициенты при производных одного порядка от

у, то получится система из т-\-пА- 1 совместных уравнений с

т-\-п-\-2 неизвестными. Без потери общности положим hn(t)= 1,

тогда эти уравнения можно решить и найти остальные 1

неизвестные. При таком способе определения ga(t) и h^(t) рис. 1.4, а и

\А,б эквивалентны. Кроме того, объединяя дифференциальные и инте¬

гральные операторы, схему на рис. 1.4, б можно свести к схеме на

1.7]

ЕДИНИЧНЫЙ ЭЛЕМЕНТ

27

рис. 1.4, в. В результате получается следующее уравнение:

V V \ l*\h if\ d*+f'z

£ 2d Li \f) 9 dtm-fi dttk+f'

<3 = 0 k = 0 /=0

r m n a

= 2 2

a = 0 j = 0 r = 0

где x—входная, a z—выходная величина. Таким образом, умножение двух

дифференциальных уравнений, заданных в виде (1.40) и (1.41), может

быть выполнено с помощью последовательности действий, указанных

равенствами (1.42), (1.43), (1.44) и (1.45). Символически операция

умножения обозначается как

АВ = С, (1.46)

где буква А соответствует уравнению (1.41), буква В—(1.40),

а буква С — (1.45).

1.7. Единичный элемент

•

Единичным элементом алгебры называется такой элемент, который,

будучи примененным к функции, оставляет ее неизменной. В ал¬

гебре линейных дифференциальных уравнений единичным элементом

является любое дифференциальное уравнение вида

2 2 <М7)

i = 0 i = 0

Это можно показать, если выходную величину у записать следующим

образом:

у = х + у1. (1.48)

Подстановка (1.48) в (1.47) дает

2 M*)j2r=a (1-49)

<■-=0

Таким образом, ух представляет свободное движение системы (реше¬

ние однородного уравнения, соответствующего (1.47)), а х — вынуж¬

денное движение системы. Если положить начальное условие по у

равным нулю, У\ = 0 и у = х, то уравнение вида (1.47) будет удовле¬

творять определению единичного элемента.

28

СИНТЕЗ СИ СТЕЛА С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. I

1.8. Обратный элемент операции умножения

Обратный элемент умножения, обозначаемый А-1, определяется

как дифференциальное уравнение, которое, будучи умножено на диф¬

ференциальное уравнение А, дает единичный элемент. Символически

это записывается как

А А-1 = 7. (1.50)

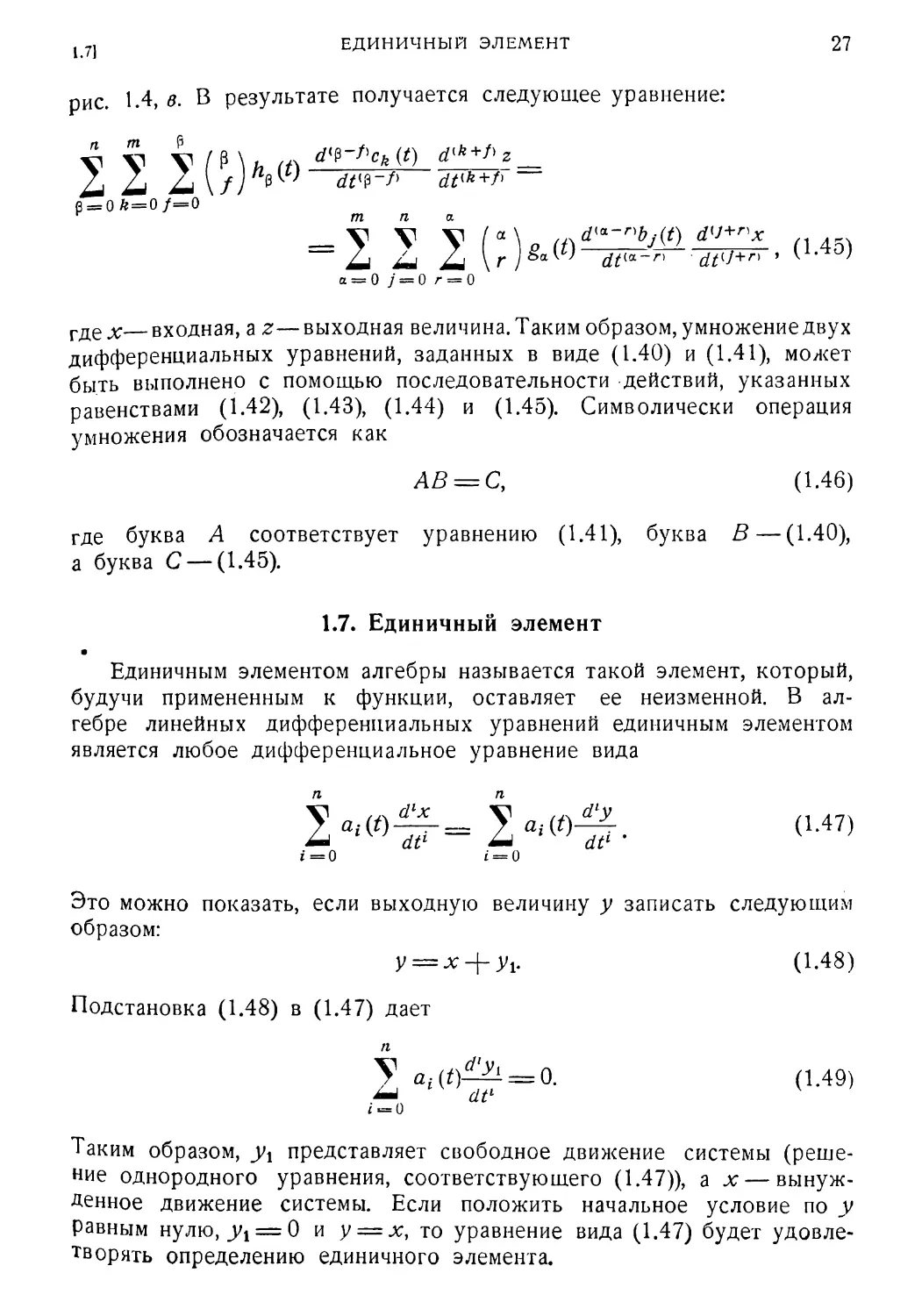

Элемент А-1 можно найти следующим образом. Рассмотрим после¬

довательность преобразований, которая изображена на рис. 1.5, а, где

Дифф1

Инт-f

Диффг

ИнгЛ‘

ги-о

а.)

X

ч

Дифф,

Z

Инт2

X

е

)

V

б)

Рис. 1.5. Пбследовательность преобразований и последова¬

тельность обратная ей.

преобразование, изображенное на рис. 1.2, г, разделено на интеграль¬

ный и дифференциальный операторы. Оператор Дифф! имеет вид

a Hhtj имеет вид

2;U &Х

’~йГз=г'

j = о

X d’y

z= / at ——

dt‘ '

(1.51)

(1.52)

i = 0

Если весовую функцию, соответствующую оператору Инть обозна¬

чить через Wx(ty т), тогда

(1.53)

где по определению весовой функции

2at

i = о

diWl (t, т)

dtl

= 0.

(1.54)

1.9]

СЛОЖЕНИЕ ДВУХ ДИФФЕРЕНЦИАЛЬНЫХ УРАВНЕНИИ

29

Применяя к y(t) дифференциальный оператор вида

п

(1.55)

получим z(i). Таким образом, дифференциальный оператор (1.55)

является обратным оператору Интп

Если оператор Дифф2 выбрать в этой дифференциальной форме,

то рис. 1.5, & можно свести к рис. 1.5, б.

Если теперь оператор Инт2 имеет вид

то рис. 1.5, б будет изображать единичный элемент, который опреде¬

ляется выражением (1.47) и применение которого необходимо, если

как входная, так и выходная величины должны быть равны аг. Таким

образом, если буква А обозначает дифференциальное уравнение

в котором х — входная, а у — выходная величина, А 1 соответствует

дифференциальное уравнение

где а: — выходная, a у —входная величина.

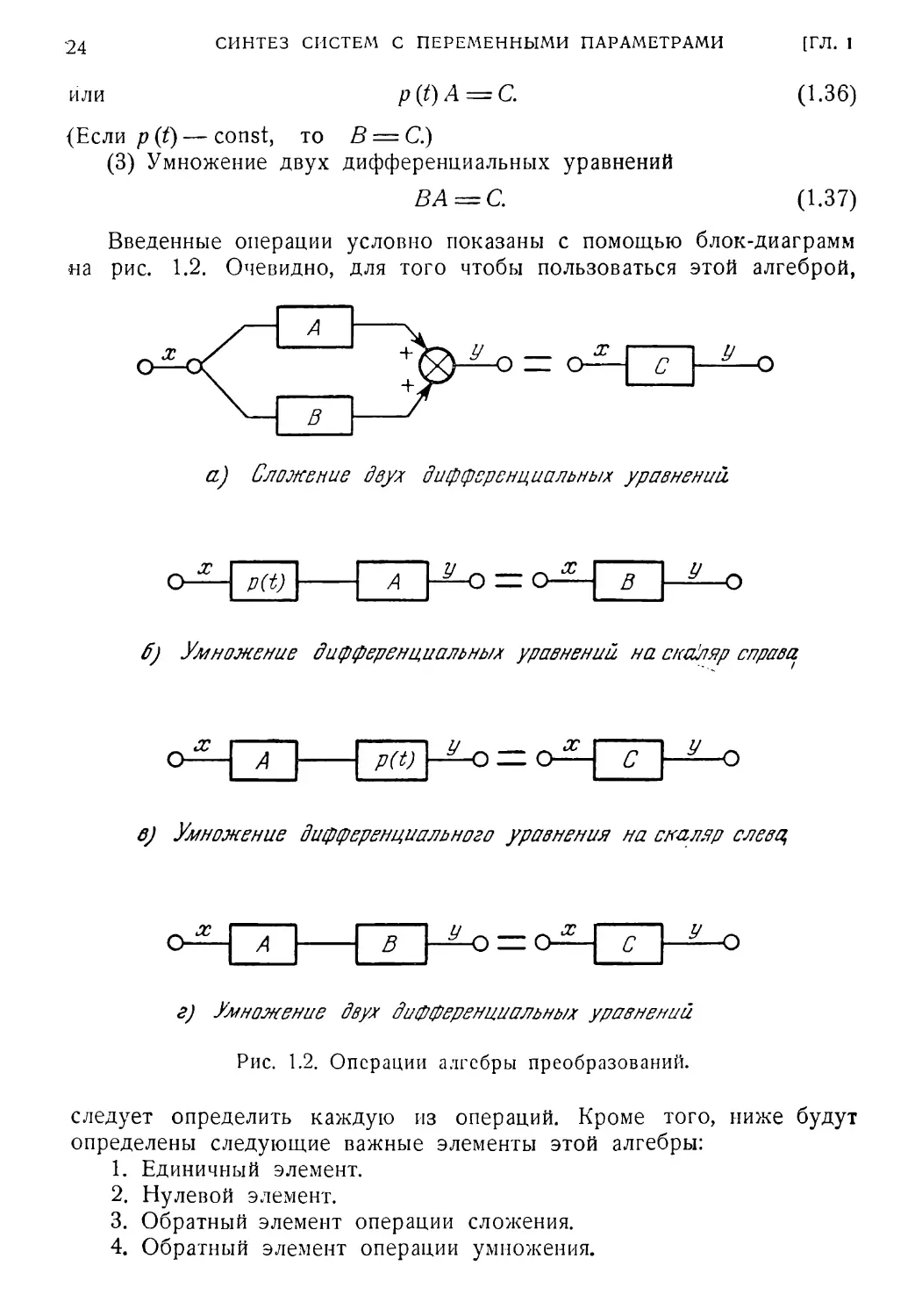

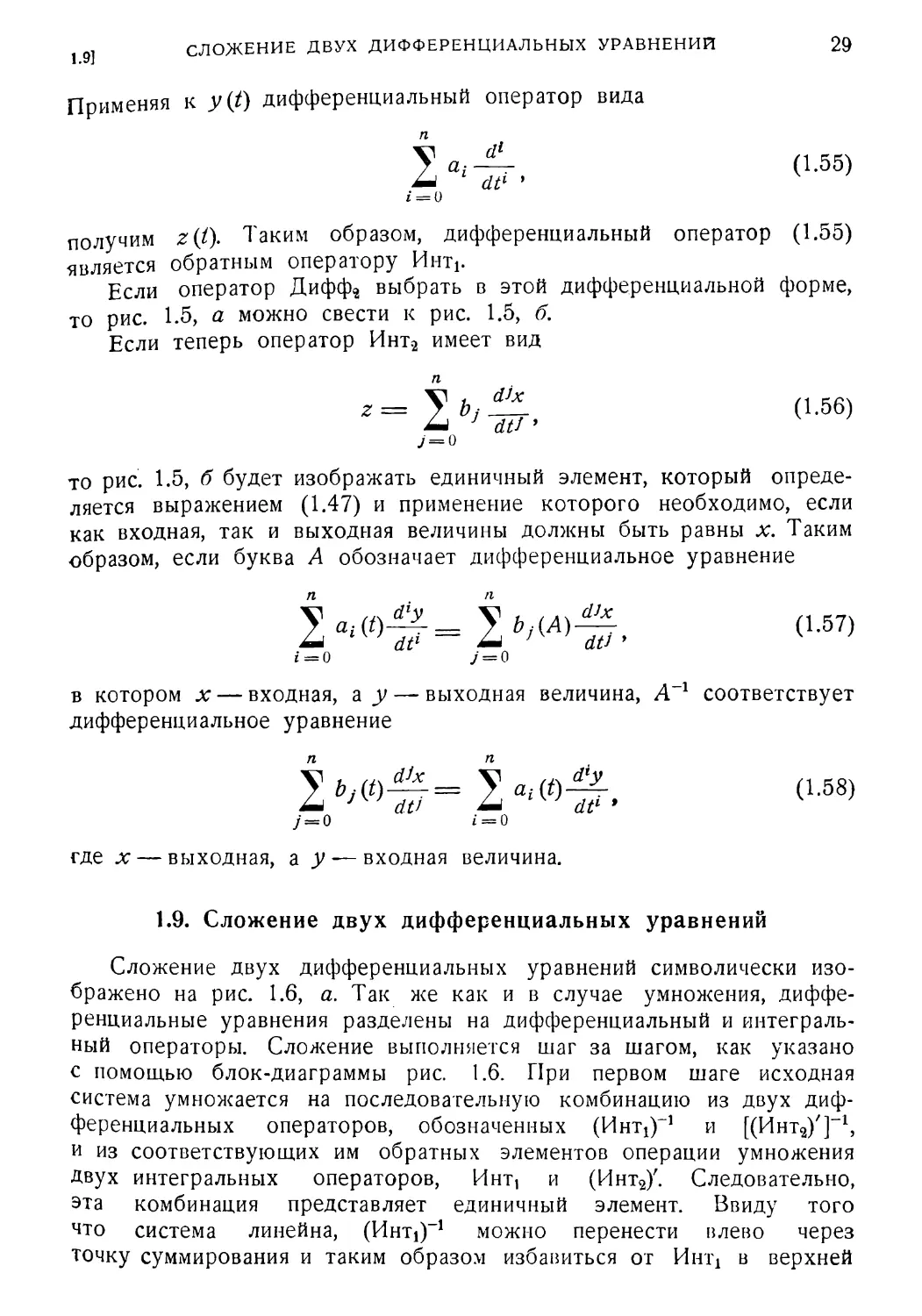

1.9. Сложение двух дифференциальных уравнений

Сложение двух дифференциальных уравнений символически изо¬

бражено на рис. 1.6, а. Так же как и в случае умножения, диффе¬

ренциальные уравнения разделены на дифференциальный и интеграль¬

ный операторы. Сложение выполняется шаг за шагом, как указано

с помощью блок-диаграммы рис. 1.6. При первом шаге исходная

система умножается на последовательную комбинацию из двух диф¬

ференциальных операторов, обозначенных (Интх)-1 и [(Инт^)']-1,

и из соответствующих им обратных элементов операции умножения

Двух интегральных операторов, Инт, и (Инт2)'. Следовательно,

эта комбинация представляет единичный элемент. Ввиду того

что система линейна, (Hhtj)-1 можно перенести влево через

точку суммирования и таким образом избавиться от Инт! в верхней

п

(1.56)

п # п

(1.57)

П

п

j

(1.58)

30

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

цепочке, как это показано на рис. 1.6, в. Далее перемножаются интег¬

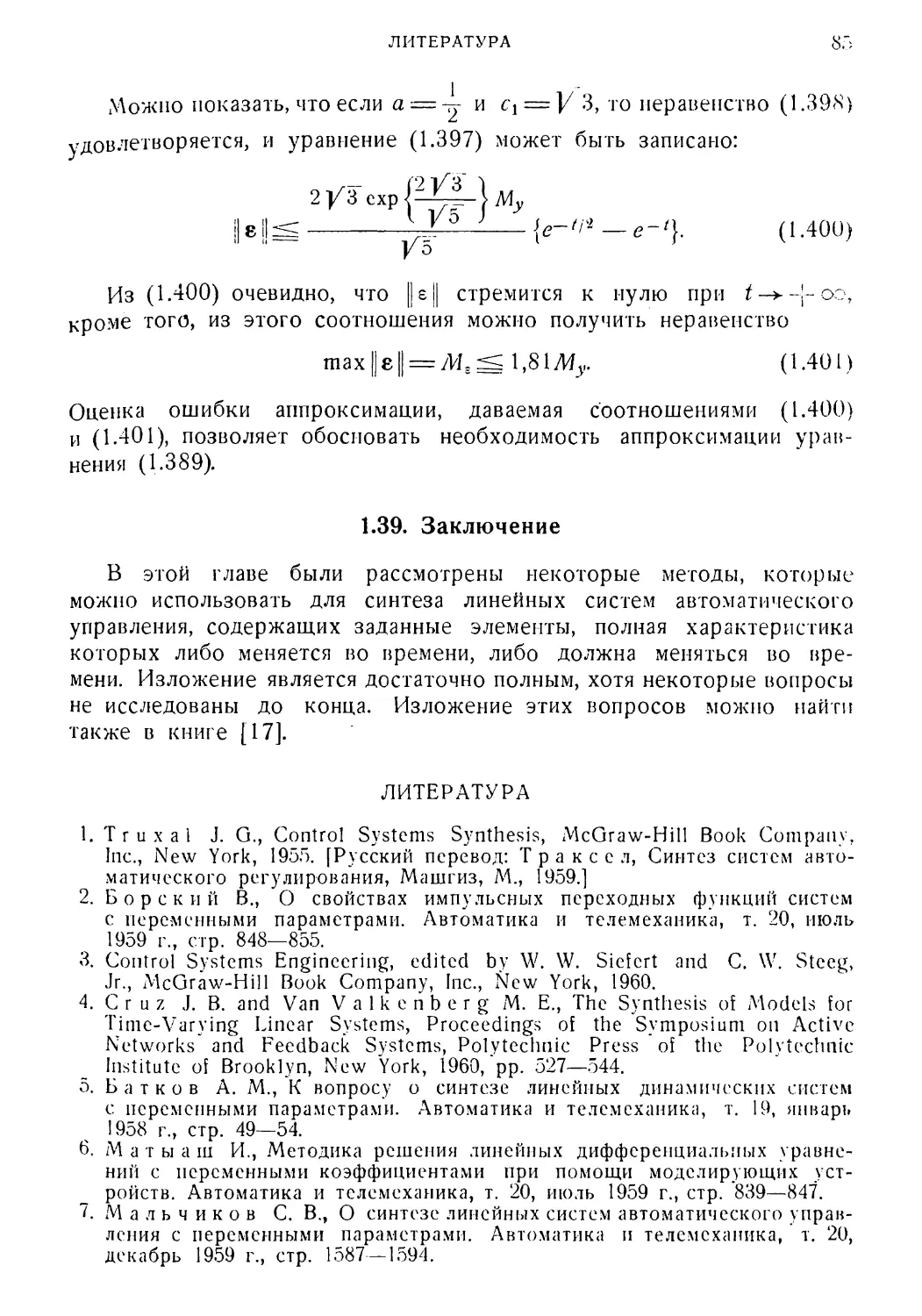

ральный оператор Инт2 и дифференциальный оператор (Инт2)-1, а

результат разделяется на новые дифференциальный и интегральный

операторы, как показано на шаге 3. Здесь новый дифференциальный

Дифф2 —I Ингл?

а) Сложение дифференциальных уравнений

'— Дафф2 — Инт2 —

Ингп1 НО

б) Пврвый. шаг

Дифф2 — Инт2 — (Интг)1

(ИнтУ

—I Инт1 fio

Дифф1

G) Второй шаг

Дифф2 -[(Инт,)'1]' - (Инт2)

>[(Ннт//!\- (Инт/ - Инн?! io

/- Дцфф,Щинтг)']-1

СЬ</ г- ,, m Т&-(#»тгг - ИнгП]

'^Диффг-[(бЩ)]'~*

Z) Третий шаг

ЙЬ

/-\ЛмФФз\-^

C><VJ

3) Четвертый шаг

Инт Йо

е) Пятый шаг

X

Дифф —

Инт I-—О

ж) Шестой шаг

Рис. 1.6. Упрощение цепи параллельной передачи сигналов.

оператор обозначен [(HuTi)"1]', а новый интегральный оператор [Инт2]'.

Теперь перенесем влево через точку суммирования оператор (Инт2)-1,

избавляясь таким образом от (Инт2)'. Слева от точки суммирования

теперь остались лишь дифференциальные, а справа лишь интеграль¬

ные операторы. Их можно объединить, как показано на шаге 5 и 6.

Таким образом, сложение дифференциальных уравнений выполнено.

1 12] УМНОЖЕНИЕ ДИФФЕРЕНЦИАЛЬНОГО УРАВНЕНИЯ НА СКАЛЯР 31

1.10. Нулевой элемент

Нулевой элемент определяется в алгебре линейных дифференци¬

альных уравнений как дифференциальное уравнение, выходная вели¬

чина которого тождественно равна нулю. Нулевой элемент обозна¬

чается через 0.

1.11. Обратный элемент операции сложения

Обратный элемент операции сложения для дифференциального

уравнения А определяется как такое дифференциальное уравнение В,

которое при сложении с А дает нулевой элемент, т. е.

А + В = 0. (1.59)

Совершенно очевидно, что если А является дифференциальным урав¬

нением

с-60»

i =• О / = 0

где х — входная, а у— выходная величина, то В имеет вид

dtl J dtJ

i = О 7=0

1.12. Умножение дифференциального уравнения на скаляр

Умножение дифференциального уравнения на скаляр можно рас¬

сматривать как частный случай умножения двух дифференциальных

уравнений, одно из которых является вырожденным уравнением у =

=p(f)x, где л; — вход, а у — выход. Поэтому методы, разработанные

для умножения двух дифференциальных уравнений, можно использо¬

вать и при умножении дифференциального уравнения на скаляр.

В добавление к упомянутым выше свойствам алгебры линейных

дифференциальных уравнений справедливо следующее:

1. Сложение коммутативно, т. е. АфВ = В-\-А.

2. Сложение ассоциативно, т. е. А ~\~(В -f- С) = (А 4- £)-|-С.

3. Умножение не коммутативно, г. е. АВ ф ВА.

(В стационарном случае умножение коммутативно.)

4. Умножение ассоциативно, т. е. А(ВС) = (АВ)С.

5. Выполняется дистрибутивность, т. е. А(В -\-С) —АВ -\- АС.

'62

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

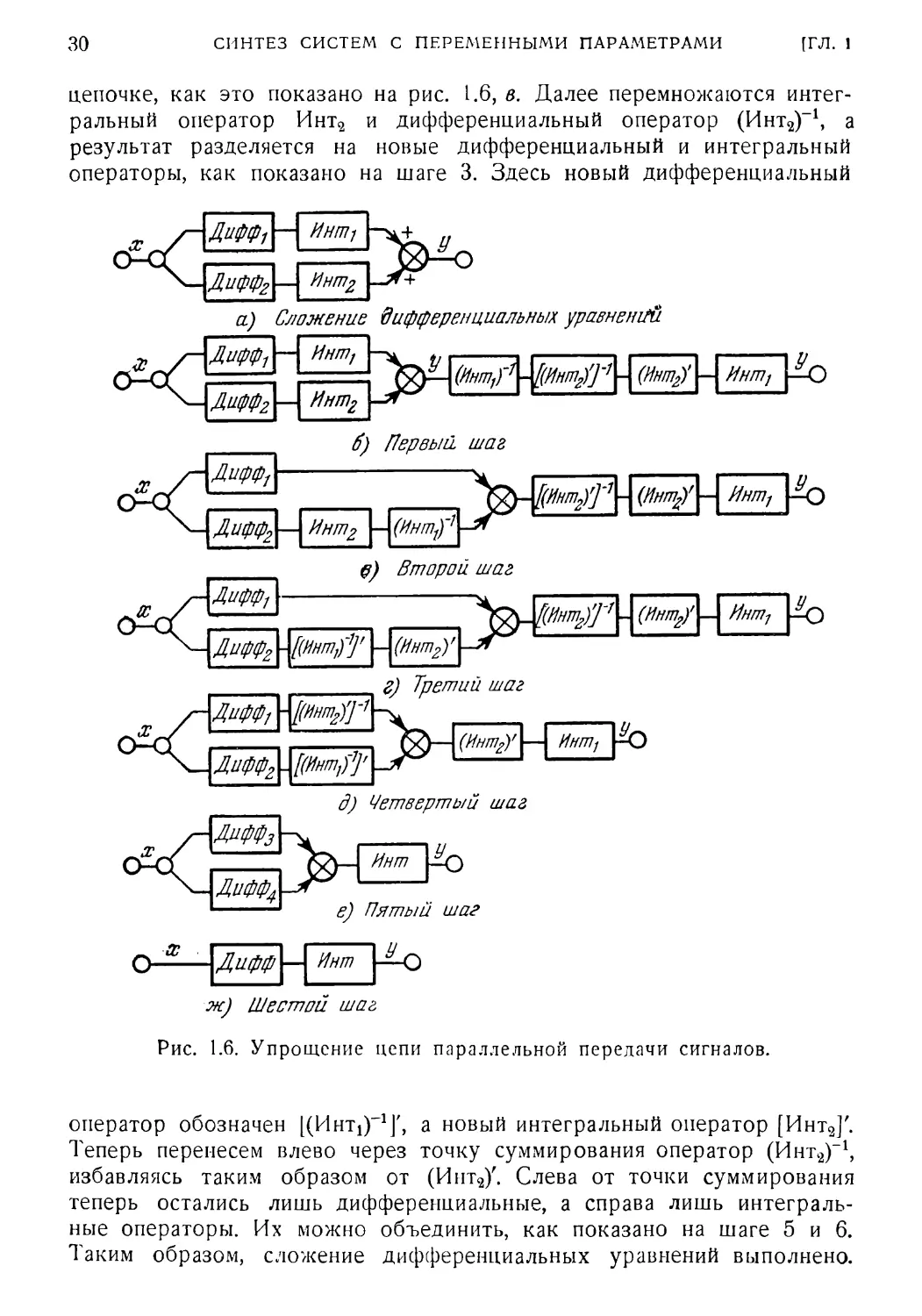

1.13. Синтез методом сокращения оператора объекта

В этом и последующих параграфах изложены два метода синтеза

линейных систем с обратной связью с переменными параметрами.

Эти методы основаны на изложенной выше алгебре линейных диффе¬

ренциальных уравнений.

Первый метод синтеза является методом сокращения оператора

объекта. При этом последовательность действий такова:

а) По техническим условиям на характеристики замкнутой системы

определяется либо ее весовая функция, либо описывающее ее дифференци¬

альное уравнение. Желательно, чтобы система задавалась весовой функ¬

цией, так как при этом для любого входа выход определяется интегралом

свертки.

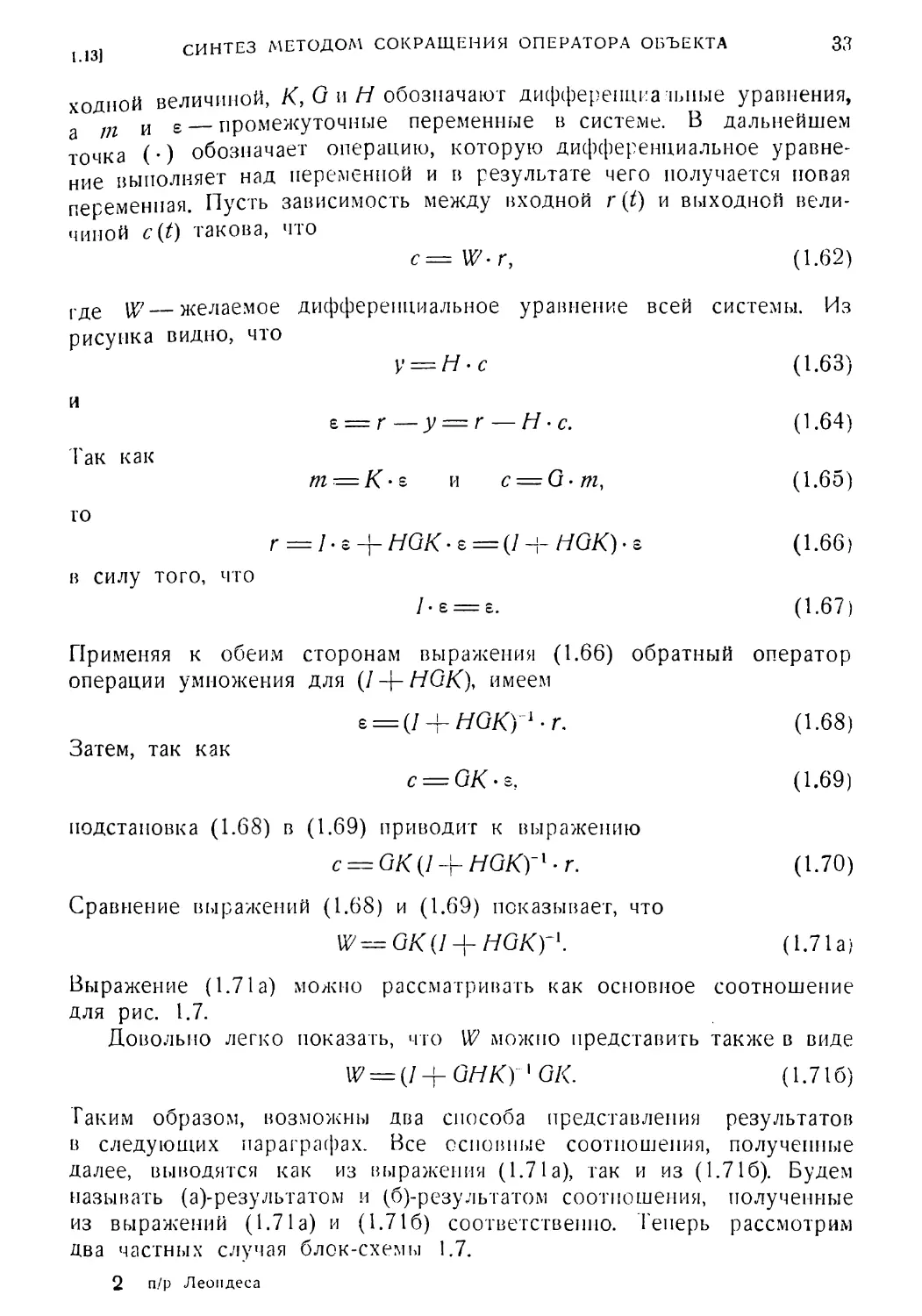

Рис. 1.7. Общая структурная схема системы с обратной

связью.

б) Если задана весовая функция замкнутой системы, то по ней

определяется дифференциальное уравнение, описывающее замкнутую

систему.

в) По дифференциальному уравнению замкнутой системы опреде¬

ляется дифференциальное уравнение разомкнутой системы.

г) Определяется дифференциальное уравнение соответствующих

корректирующих цепочек, и эти цепочки синтезируются с помощью

средств аналоговой вычислительной техники.

Для выполнения таких действий надо уметь (1) определять весовую

функцию или дифференциальное уравнение по заданным техническим

условиям на систему, (2) приводить эту весовую функцию к такому

виду, чтобы можно было спроектировать соответствующие корректи¬

рующие цепочки.

Применение алгебры дифференциальных уравнений к задаче син¬

теза с идейной стороны аналогично применению алгебры преобразо¬

вания Лапласа для синтеза линейных стационарных систем. Преиму¬

ществом такой алгебры является то, что все необходимые операции

можно выполнить символически, и лишь в конце произвести числен¬

ные выкладки.

Для изложения метода воспользуемся схемой системы с обратной

связью, изображенной на рис. 1.7. Здесь г является входной, с — вы-

СИНТЕЗ МЕТОДОМ СОКРАЩЕНИЯ ОПЕРАТОРА ОБЪЕКТА 33

1.13J

ходной величиной, К, G и/У обозначают дифференциальные уравнения,

т и е промежуточные переменные в системе. В дальнейшем

точка (•) обозначает операцию, которую дифференциальное уравне¬

ние выполняет над переменной и в результате чего получается новая

переменная. Пусть зависимость между входной г (t) и выходной вели¬

чиной c(t) такова, что

с = W- г, (1.62)

где од?—желаемое дифференциальное уравнение всей системы. Из

рисунка видно, что

у = Н-с (1.63)

и

е — г—у = г — Н • с. (1.64)

Так как

т — К • s и c = G-m, (1.65)

го

r = I-s + HGK-e = V + HQK)-& (1.66)

в силу того, что

/•£ = 8. (1.67)

Применяя к обеим сторонам выражения (1.66) обратный оператор

операции умножения для (I-\-HGK\ имеем

е = (/ + ШКГ1-г. (1.68)

Затем, так как

с = GK • s. (1.69)

подстановка (1.68) в (1.69) приводит к выражению

с = GK(l + HGK)~l - г. (1.70)

Сравнение выражений (1.68) и (1.69) показывает, что

U7 = GK (/ + HGKy\ (1.71а)

Выражение (1.71а) можно рассматривать как основное соотношение

для рис. 1.7.

Довольно легко показать, что W можно представить также в виде

W = {I+GHKy' GK. (1.716)

Таким образом, возможны два способа представления результатов

в следующих параграфах. Все основные соотношения, полученные

далее, выводятся как из выражения (1.71а), так и из (1.716). Будем

называть (а)-результатом и (б)-результатом соотношения, полученные

из выражений (1.71а) и (1.716) соответственно. Теперь рассмотрим

два частных случая блок-схемы 1.7.

2 п/р Леомдеса

34

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

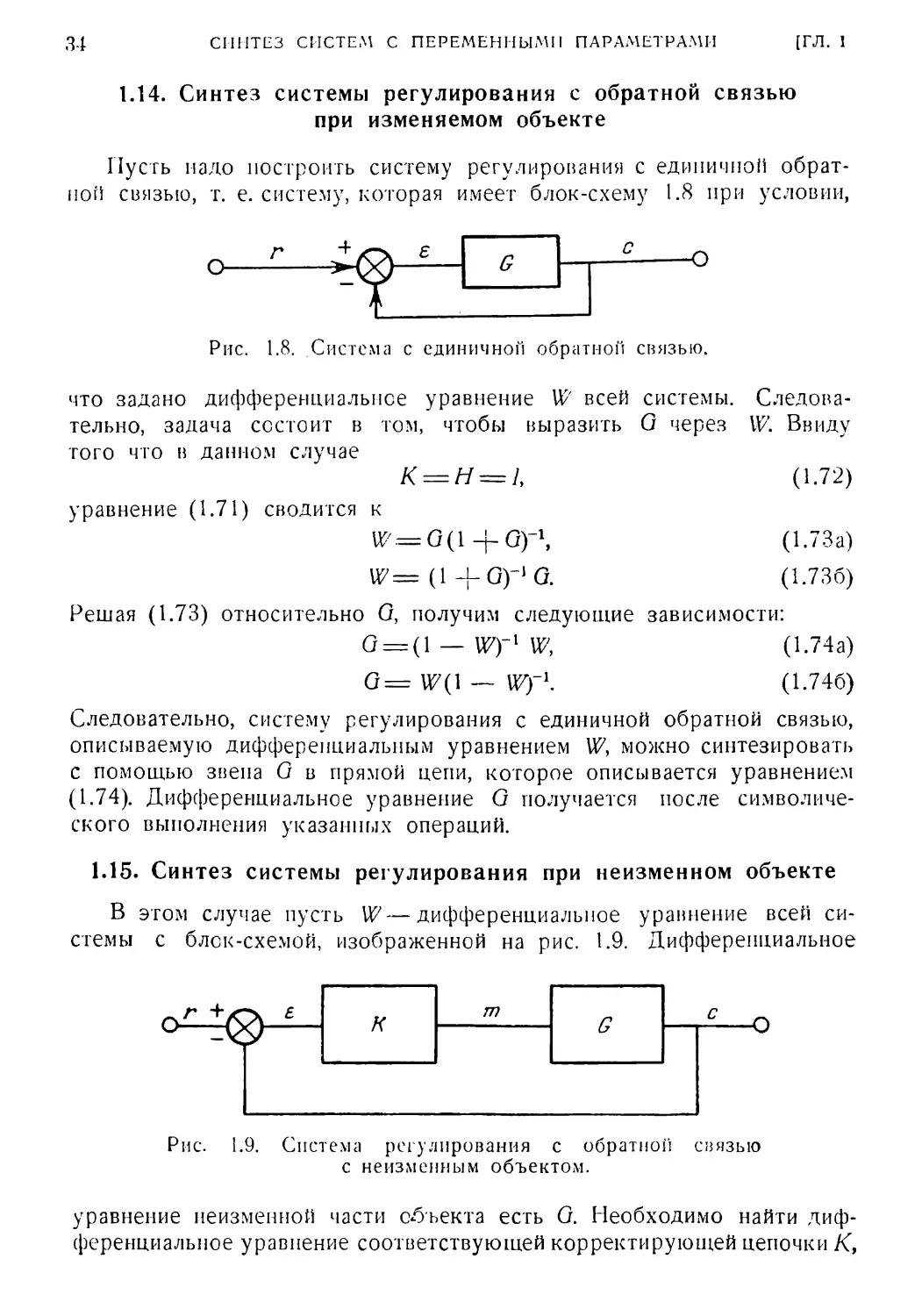

1.14. Синтез системы регулирования с обратной связью

при изменяемом объекте

Пусть надо построить систему регулирования с единичной обрат¬

ной связью, т. е. систему, которая имеет блок-схему 1.8 при условии,

О

4

->■

-О

Рис. 1.8. Система с единичной обратной связью.

что задано дифференциальное уравнение W всей системы. Следова¬

тельно, задача состоит в том, чтобы выразить G через W. Ввиду

того что в данном случае

К = Н = и (1.72)

уравнение (1.71) сводится к

W=G(\ +G)-\ (1.73а)

W = (1 +G)"1 G. (1.736)

Решая (1.73) относительно G, получим следующие зависимости:

G = (l — W)~l W, (1.74а)

G= W( 1 — Wf\ (1.746)

Следовательно, систему регулирования с единичной обратной связью,

описываемую дифференциальным уравнением U7, можно синтезировать

с помощью звена G в прямой цепи, которое описывается уравнением

(1.74). Дифференциальное уравнение G получается после символиче¬

ского выполнения указанных операций.

1.15. Синтез системы регулирования при неизменном объекте

В этом случае пусть W—дифференциальное уравнение всей си¬

стемы с блок-схемой, изображенной на рис. 1.9. Дифференциальное

к

т

G

9

Рис. 1.9. Система регулирования с обратной связью

с неизменным объектом.

уравнение неизменной части объекта есть G. Необходимо найти диф¬

ференциальное уравнение соответствующей корректирующей цепочки К,

ПРИМЕР 35

1.161

чем такое, чтобы данная система имела желаемую характеристику,

педеляемую W. Подставляя Н = / в выражения (1.71) и решая их

относительно КУ придем к следующим зависимостям:

К = G-1 (7 — U7)-1 W, (1.75а)

К = G~' 117(7— Щ~\ (1.756)

Дифференциальное уравнение для К получается после выполнения

действий, символически указанных в выражениях (1.75).

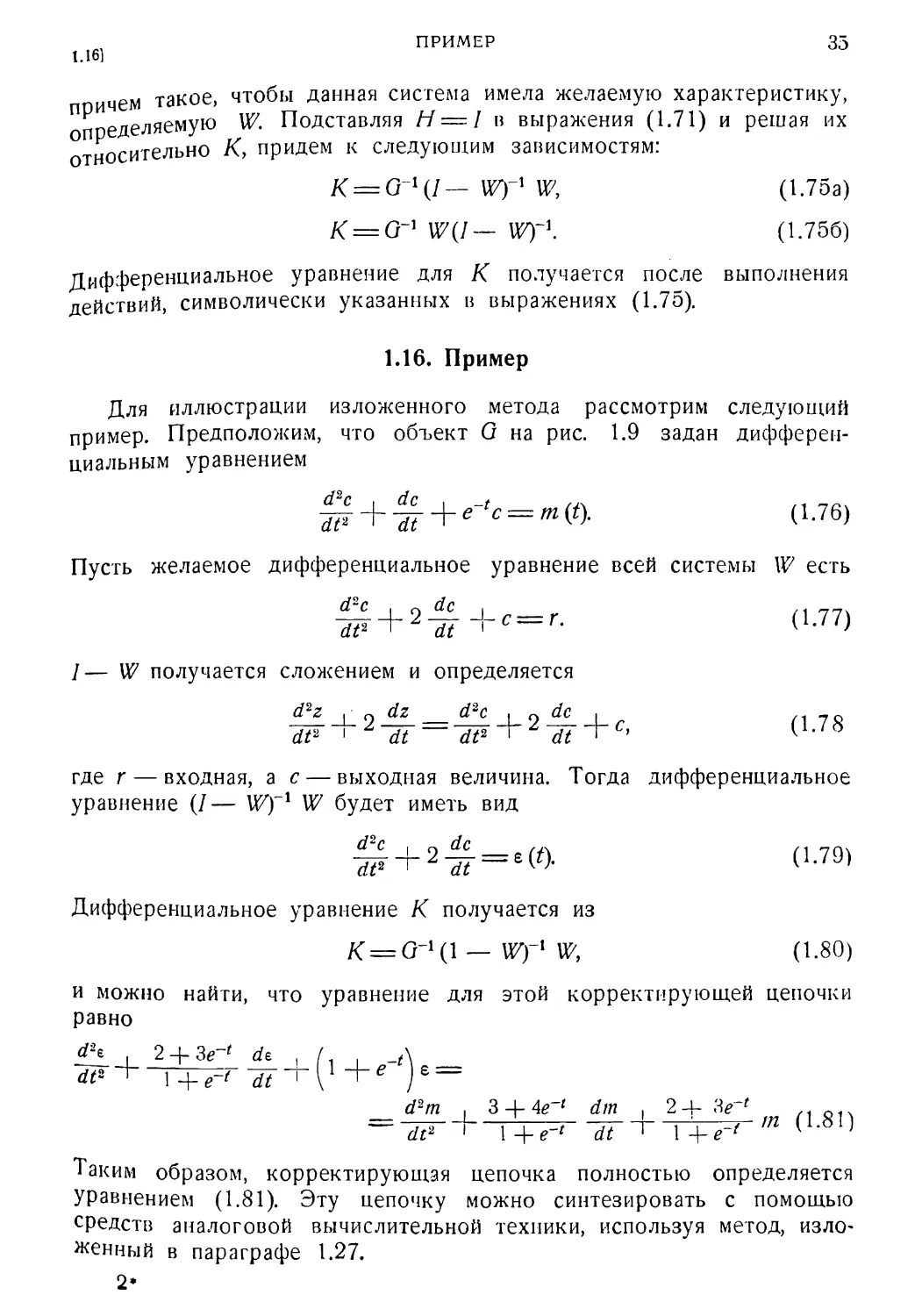

1.16. Пример

Для иллюстрации изложенного метода рассмотрим следующий

пример. Предположим, что объект G на рис. 1.9 задан дифферен¬

циальным уравнением

Пусть желаемое дифференциальное уравнение всей системы W есть

%Л-2^Л-о = г. (1.77)

7— U7 получается сложением и определяется

d2z | о dz d~c | 2 dc I /1 70

где r — входная, а с — выходная величина. Тогда дифференциальное

уравнение (/— Wfl W будет иметь вид

*£ + 2-*=.(<> (1.79)

Дифференциальное уравнение К получается из

K = G-1(1 — W)~x Wy (1.80)

и можно найти, что уравнение для этой корректирующей цепочки

равно

. 2 + Зе-' dt , , _,\

^ + -ТТ^г^^11+е )е =

d2m , 3 + Ae~l dm , 2 4- ,л

= + (Ш)

Таким образом, корректирующая цепочка полностью определяется

Уравнением (1.81). Эту цепочку можно синтезировать с помощью

средств аналоговой вычислительной техники, используя метод, изло¬

женный в параграфе 1.27.

2*

36

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

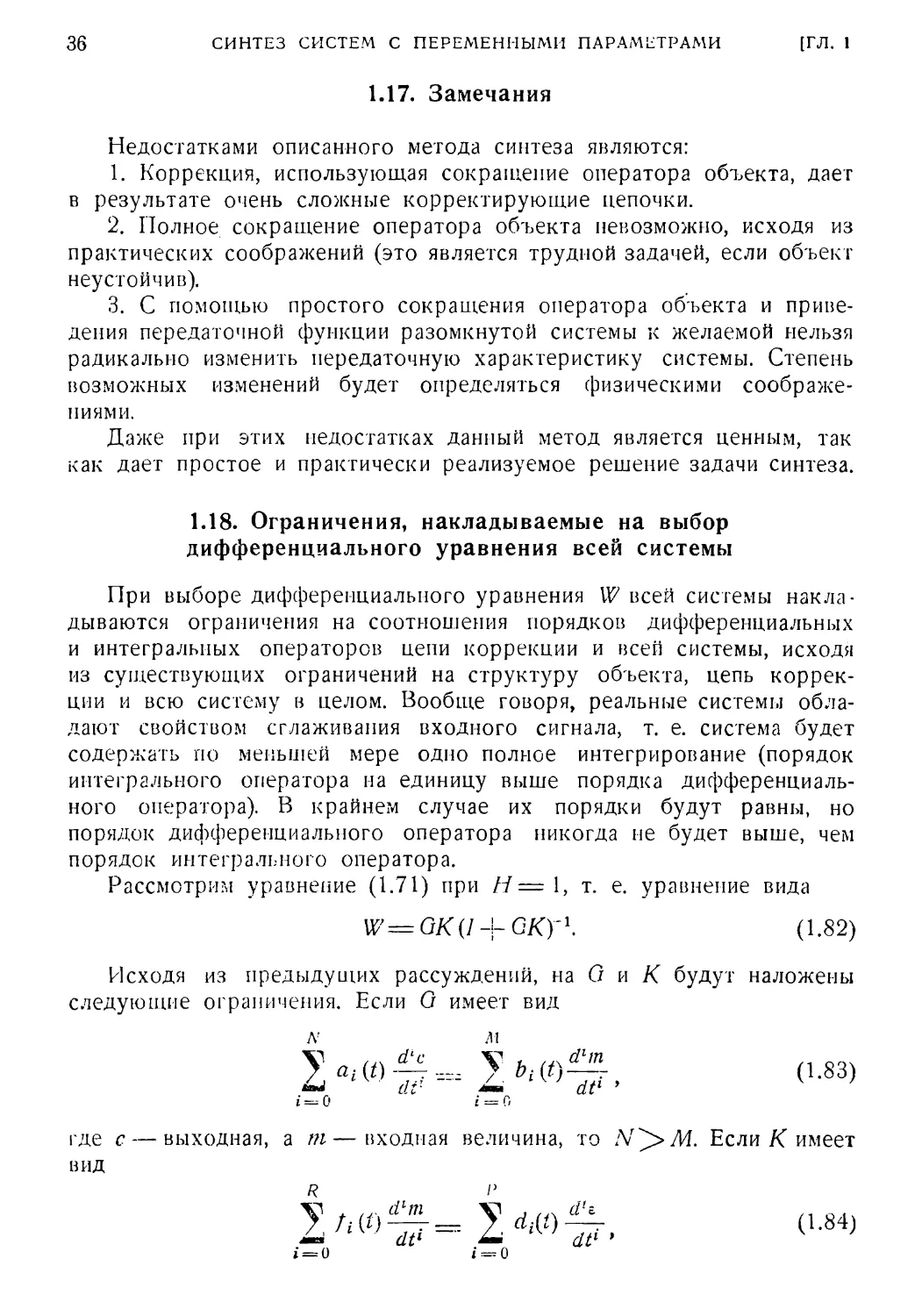

1.17. Замечания

Недостатками описанного метода синтеза являются:

1. Коррекция, использующая сокращение оператора объекта, дает

в результате очень сложные корректирующие цепочки.

2. Полное сокращение оператора объекта невозможно, исходя из

практических соображений (это является трудной задачей, если объект

неустойчив).

3. С помощью простого сокращения оператора объекта и приве¬

дения передаточной функции разомкнутой системы к желаемой нельзя

радикально изменить передаточную характеристику системы. Степень

возможных изменений будет определяться физическими соображе¬

ниями.

Даже при этих недостатках данный метод является ценным, так

как дает простое и практически реализуемое решение задачи синтеза.

При выборе дифференциального уравнения W всей системы накла¬

дываются ограничения на соотношения порядков дифференциальных

и интегральных операторов цепи коррекции и всей системы, исходя

из существующих ограничений на структуру объекта, цепь коррек¬

ции и всю систему в целом. Вообще говоря, реальные системы обла¬

дают свойством сглаживания входного сигнала, т. е. система будет

содержать по меиылей мере одно полное интегрирование (порядок

интегрального оператора на единицу выше порядка дифференциаль¬

ного оператора). В крайнем случае их порядки будут равны, но

порядок дифференциального оператора никогда не будет выше, чем

порядок интегрального оператора.

Рассмотрим уравнение (1.71) при Н = 1, т. е. уравнение вида

Исходя из предыдущих рассуждений, на О и К будут наложены

следующие ограничения. Если G имеет вид

1.18. Ограничения, накладываемые на выбор

дифференциального уравнения всей системы

W= GK (1 -|- ОКУ1.

(1.82)

(1.83)

где с — выходная, а т—входная величина, то Если К имеет

вид

1.19]

АЛГЕБРАИЧЕСКИЙ МЕТОД СИНТЕЗА

37

где //г — выходная, а в — входная величина, тогда R^P. Следова¬

тельно, произведение GK будет иметь вид

т

N-\-R М + Р

2 *<?-= 2 "85)

i = 0 i = О

где с — выходная, в — входная величина и соответственно А/Т-4- R>

В действительности, порядки операторов в уравнении

(1.85) будут определяться как N -\- R — п и М -|- Р — п, где п — поря¬

док некоторых членов, обших для обоих операторов, однако так

как разница порядков не изменяется при уменьшении их на п, то в

дальнейшем им можно пренебречь. Из выражения (1.85) запишем

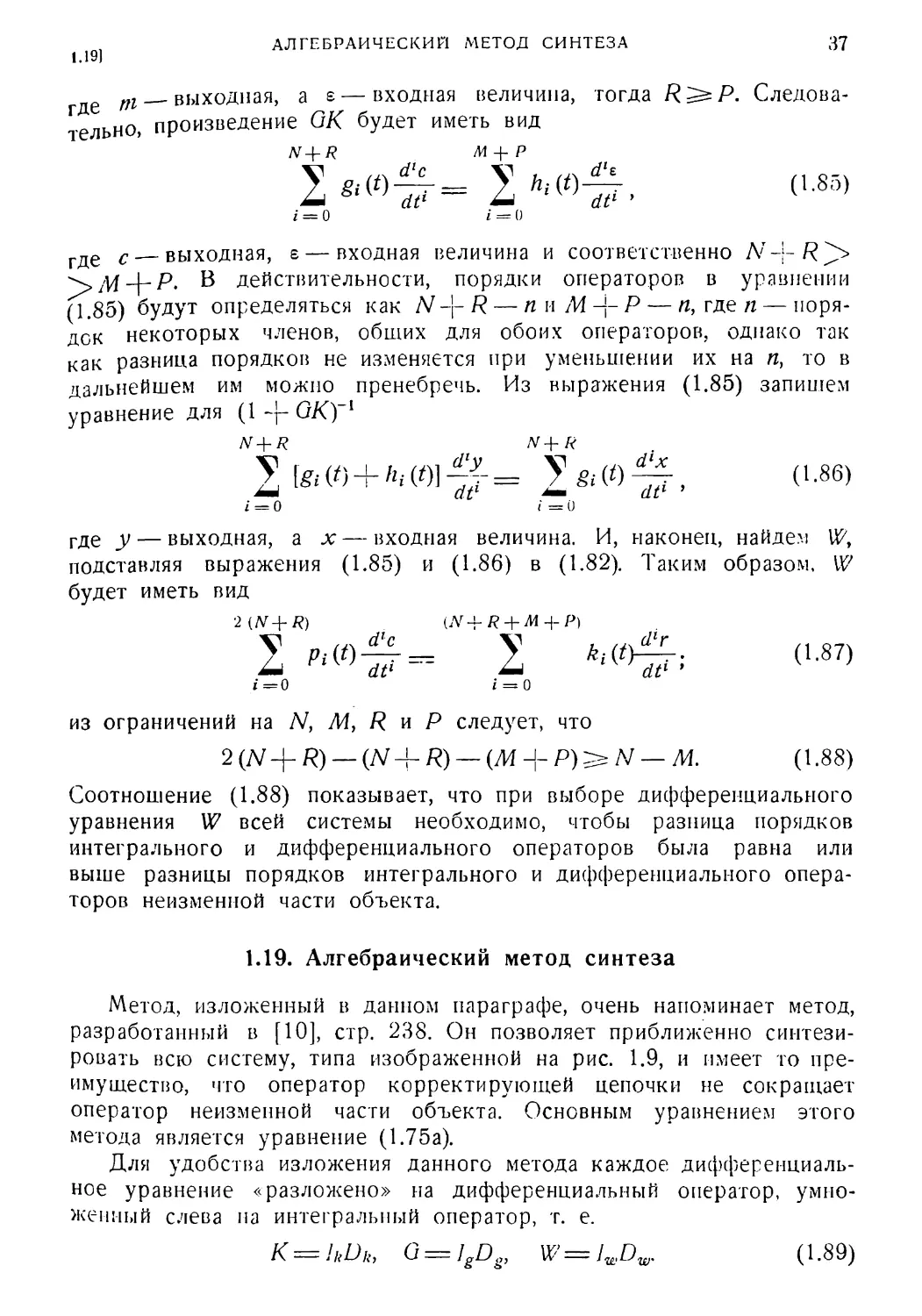

уравнение для (1 ~j- GK)~l

N+R N+R

У [gt V)+a, (oi -g- = У gt w ~, (1.86)

JmU dt1 dt1 ’

i = 0 i = 0

где у — выходная, a x — входная величина. И, наконец, найдем U?,

подставляя выражения (1.85) и (1.86) в (1.82). Таким образом, W

будет иметь вид

2 {N+R) CV-f R + M + P)

2 2 к>

1=0 1=0

из ограничений на N, М, R и Р следует, что

2 (Д/+ R) — Я) — (М + P)^N — М. (1.88)

Соотношение (1.88) показывает, что при выборе дифференциального

уравнения W всей системы необходимо, чтобы разница порядков

интегрального и дифференциального операторов была равна или

выше разницы порядков интегрального и дифференциального опера¬

торов неизменной части объекта.

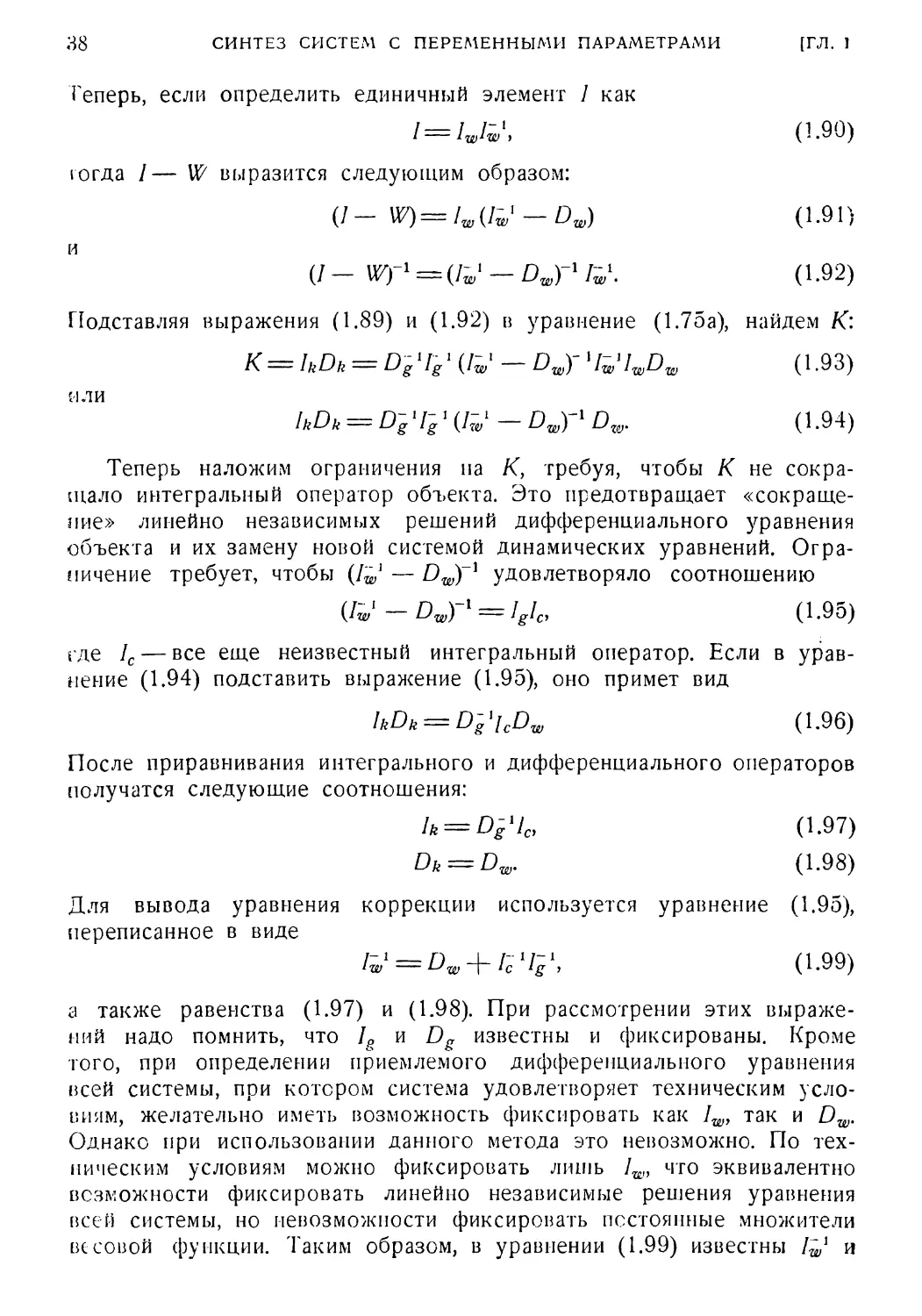

1.19. Алгебраический метод синтеза

Метод, изложенный в данном параграфе, очень напоминает метод,

разработанный в [10], стр. 238. Он позволяет приближенно синтези¬

ровать всю систему, типа изображенной на рис. 1.9, и имеет то пре¬

имущество, что оператор корректирующей цепочки не сокращает

оператор неизменной части объекта. Основным уравнением этого

метода является уравнение (1.75а).

Для удобства изложения данного метода каждое дифференциаль¬

ное уравнение «разложено» на дифференциальный оператор, умно¬

женный слева на интегральный оператор, т. е.

К = litDk, G = IgDg, W= JWDW. (1.89)

38

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

Теперь, если определить единичный элемент I как

/ = /„/;■, (1.90)

тогда / — W выразится следующим образом:

(/- W)=lw(Iw'-Dw) (1.91)

и

(/ _ Wf1 = (/~ 1 _ Dwyl rw\ (1.92)

Подставляя выражения (1.89) и (1.92) в уравнение (1.75а), найдем К:

К = hDk = D~g4gl (Iw — Dwy4w4wDw (1.93)

или

lkDk = Dg4g 1 (УУ - Dw)'1 Dw. (1.94)

Теперь наложим ограничения на К, требуя, чтобы К не сокра¬

щало интегральный оператор объекта. Это предотвращает «сокраще¬

ние» линейно независимых решений дифференциального уравнения

объекта и их замену новой системой динамических уравнений. Огра¬

ничение требует, чтобы (lwl — Dwy1 удовлетворяло соотношению

(Iwl-Dwyl = IgIcy (1.95)

где /с — все еще неизвестный интегральный оператор. Если в урав¬

нение (1.94) подставить выражение (1.95), оно примет вид

lkDk = DglicDw (1.96)

После приравнивания интегрального и дифференциального операторов

получатся следующие соотношения:

h = Dg4Ci (1.97)

Dk = Dw. (1.98)

Для вывода уравнения коррекции используется уравнение (1.95),

переписанное в виде

Iw1 = Dw + rc4g\ (1.99)

а также равенства (1.97) и (1.98). При рассмотрении этих выраже¬

ний надо помнить, что Ig и Dg известны и фиксированы. Кроме

того, при определении приемлемого дифференциального уравнения

всей системы, при котором система удовлетворяет техническим усло¬

виям, желательно иметь возможность фиксировать как Iw, так и Dw.

Однако при использовании данного метода это невозможно. По тех¬

ническим условиям можно фиксировать лишь Iw, что эквивалентно

возможности фиксировать линейно независимые решения уравнения

всей системы, но невозможности фиксировать постоянные множители

весовой функции. Таким образом, в уравнении (1.99) известны /^ и

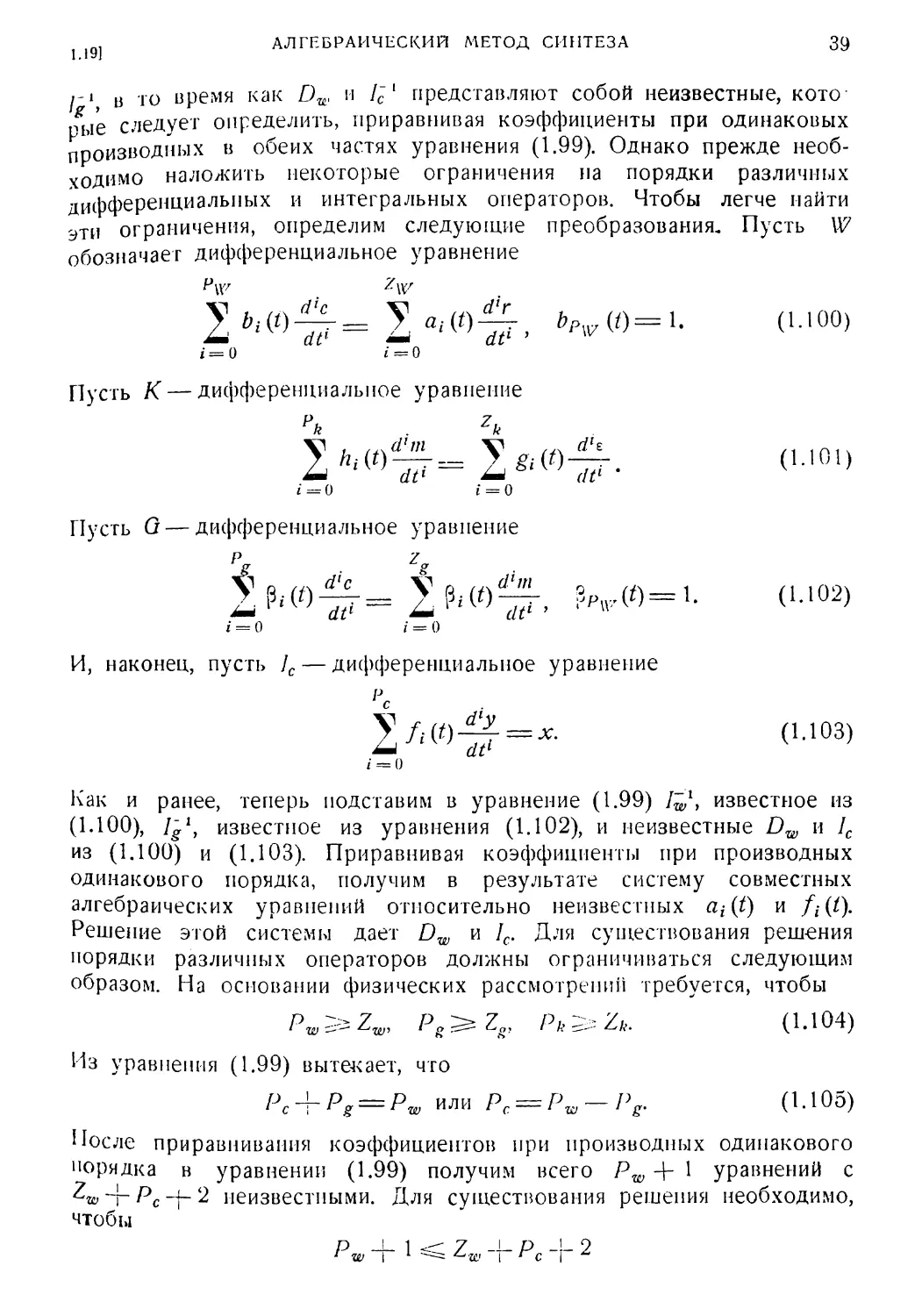

i ig] АЛГЕБРАИЧЕСКИЙ МЕТОД СИНТЕЗА 39

/-I в то время как Dw и 1ё1 представляют собой неизвестные, кото

пые следует определить, приравнивая коэффициенты при одинаковых

производных в обеих частях уравнения (1.99). Однако прежде необ¬

ходимо наложить некоторые ограничения на порядки различных

дифференциальных и интегральных операторов. Чтобы легче найти

эти ограничения, определим следующие преобразования. Пусть W

обозначает дифференциальное уравнение

?\v .

2 h (0 У а, (0 , bPw (0=1. (1 • 100)

i = 0 i = 0

Пусть К — дифференциальное уравнение

2*.< о£=2*«о-&. с..».»

i = 0 i = 0

Пусть G — дифференциальное уравнение

Зр„Д0 = 1. (1.102)

И, наконец, пусть /с — дифференциальное уравнение

1/г(0~^=*- (1Л03)

г = 0

Как и ранее, теперь подставим в уравнение (1.99) Z^1, известное из

(1.100), /-1, известное из уравнения (1.102), и неизвестные Dw и /с

из (1.100) и (1.103). Приравнивая коэффициенты при производных

одинакового порядка, получим в результате систему совместных

алгебраических уравнений относительно неизвестных at{t) и

Решение этой системы дает Dw и /с. Для существования решения

порядки различных операторов должны ограничиваться следующим

образом. На основании физических рассмотрений требуется, чтобы

Pw^Zwy Pg^Zs, Pk^Zu. (1Л04)

Из уравнения (1.99) вытекает, что

Р с “Т~ Р g === Р w или pc = pw-pg. (1.105)

После приравнивания коэффициентов при производных одинакового

порядка в уравнении (1.99) получим всего Pw + 1 уравнений с

Z‘WJrPc-\-2 неизвестными. Для существования решения необходимо,

чтобы

40

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. 1

ИЛИ

Pw<zw + Pc+1. (1.106)

В результате подстановки (1.105) в (1.106) имее!М

Zw^Pg- 1. (1.107)

Из условий (1.104) и уравнения (1.96) вытекает, что

Zg -)- Р с= Ри ^ Zk = Zw

или

Pc^Zw — Zp (1.108)

сравнивая выражения (1.105) и (1.108), получим

р Р > 7 7

1 w V ^ g

ИЛИ

Pw S* Pg + — Zg. (1.109)

Объединяя неравенства 1.107 и 1.109, найдем

pw^2Pg—Zg—\. (1.110)

Таким образом, условия (1.105), (1.107), (1.110) ограничивают порядки

операторов PWi Zw и Рс. Ограничение для Pw необходимо принимать

во внимание, когда Pw выбирается согласно техническим условиям

па систему. Условия для Zw и Рс определяют приемлемый вид Dw

и 1С в уравнении (1.99).

Если в выражениях (1.107) и (1.110) выбран знак неравенства,

то число неизвестных будет больше, чем число уравнений. Поэтому

часть неизвестных можно задать произвольным образом, например

так, чтобы оптимизировать некоторый критерий качества.

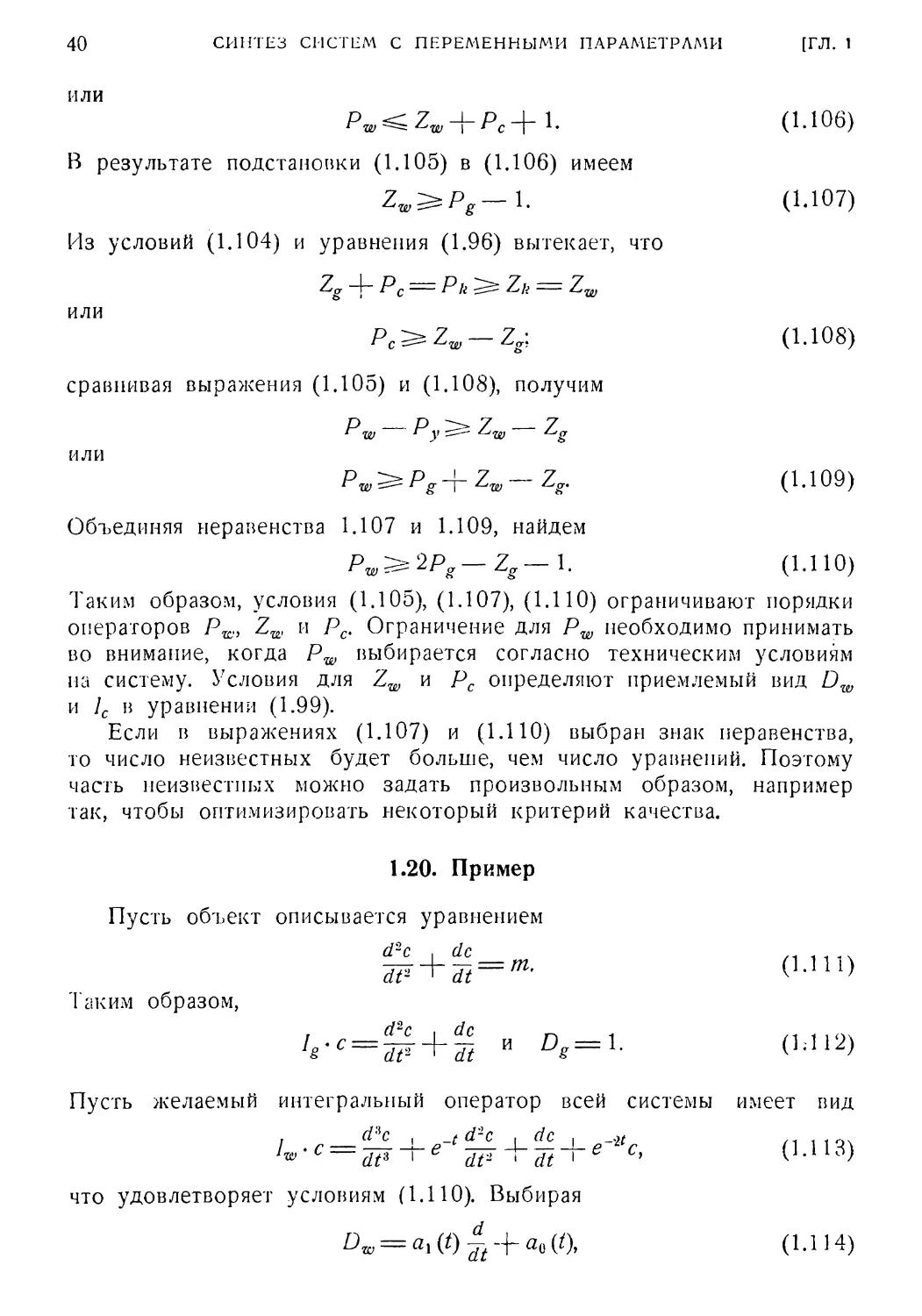

1.20. Пример

Пусть объект описывается уравнением

d2c | dc

dt*'Tt

d2c | dc /1 1 - ч

— 0-Hi)

аким образом,

/ . Z’ — ,

dt2 ^ dt

Пусть желаемый интегральный оператор всей системы имеет вид

» d с | _/ d с | dс § о/ / i 1 ■( г, \

JF + Tt + e с’ (1.113)

что удовлетворяет условиям (1.110). Выбирая

Dw = ах (t) — а<х (t\ (1.114)

(1.117)

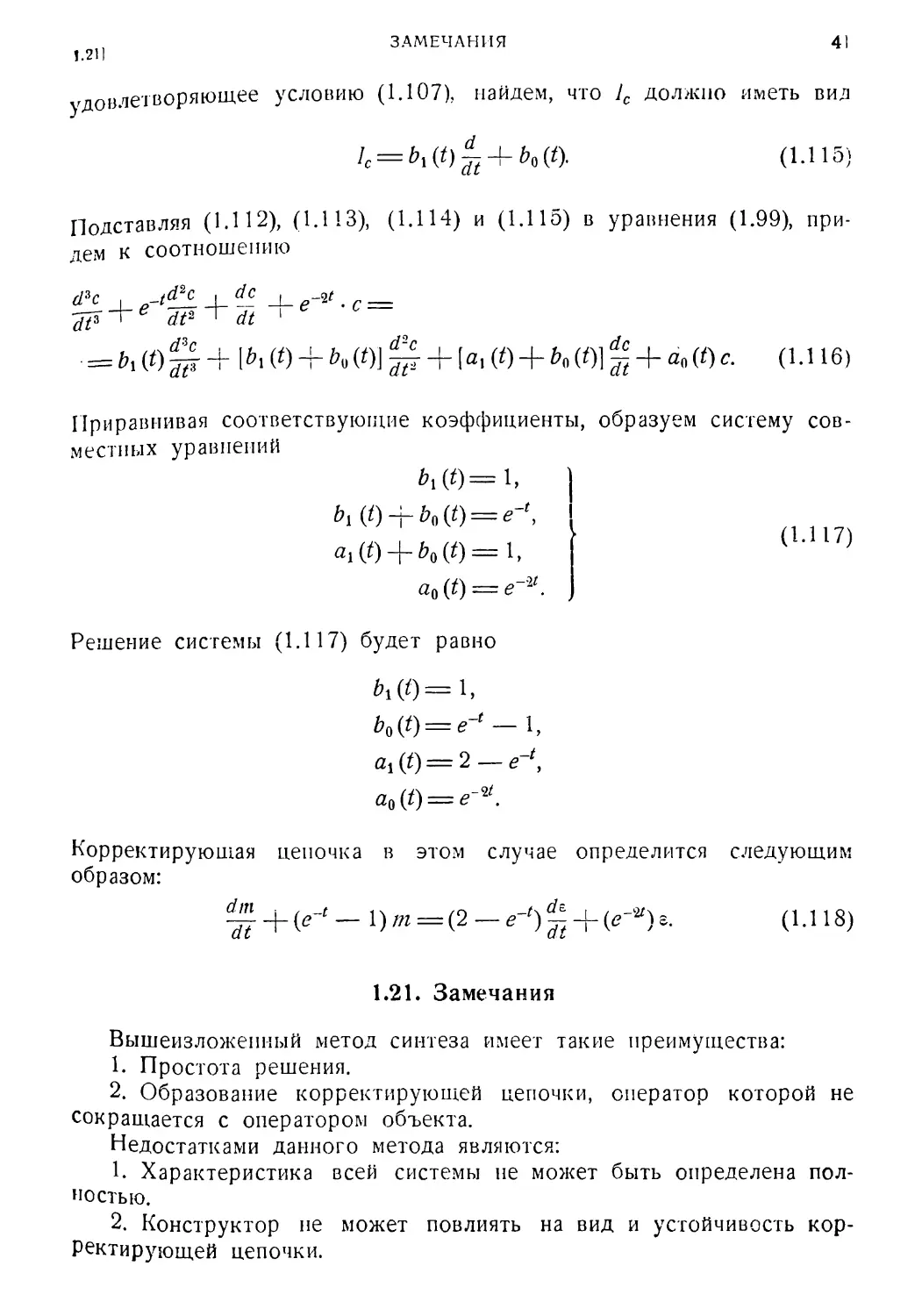

ЗАМЕЧАНИЯ 41

! .211

удовлетворяющее условию (1.107), найдем, что 1С должно иметь вид

/с = м*)^ + м*> (1-115)

Подставляя (1.112), (1.113), (1.114) и (1.115) в уравнения (1.99), при¬

дем к соотношению

<14 , _(_ Д _1_ е-* . с —

= 5. (<) § + 1^1 (0 + ь« (0] £ + [в, (0 + (01 g + «о (0 с. (1.116)

Приравнивая соответствующие коэффициенты, образуем систему сов¬

местных уравнений

М0=1,

bi (t)-r’o9{t) = e-‘,

«i(0+ 5* (0=1,

а0(0 = *-*.

Решение системы (1.117) будет равно

М0=1,

bQ(t) = e-‘-l,

a1(f) = 2—e~t,

ай (f) — e

Корректирующая цепочка в этом случае определится следующим

образом:

dJL + {e-t _ 1) т = (2 _ е-') | + (*-*) 8. (1.118)

1.21. Замечания

Вышеизложенный метод синтеза имеет такие преимущества:

1. Простота решения.

2. Образование корректирующей цепочки, оператор которой не

сокращается с оператором объекта.

Недостатками данного метода являются:

К Характеристика всей системы не может быть определена пол¬

ностью.

2. Конструктор не может повлиять на вид и устойчивость кор¬

ректирующей цепочки.

42

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. )

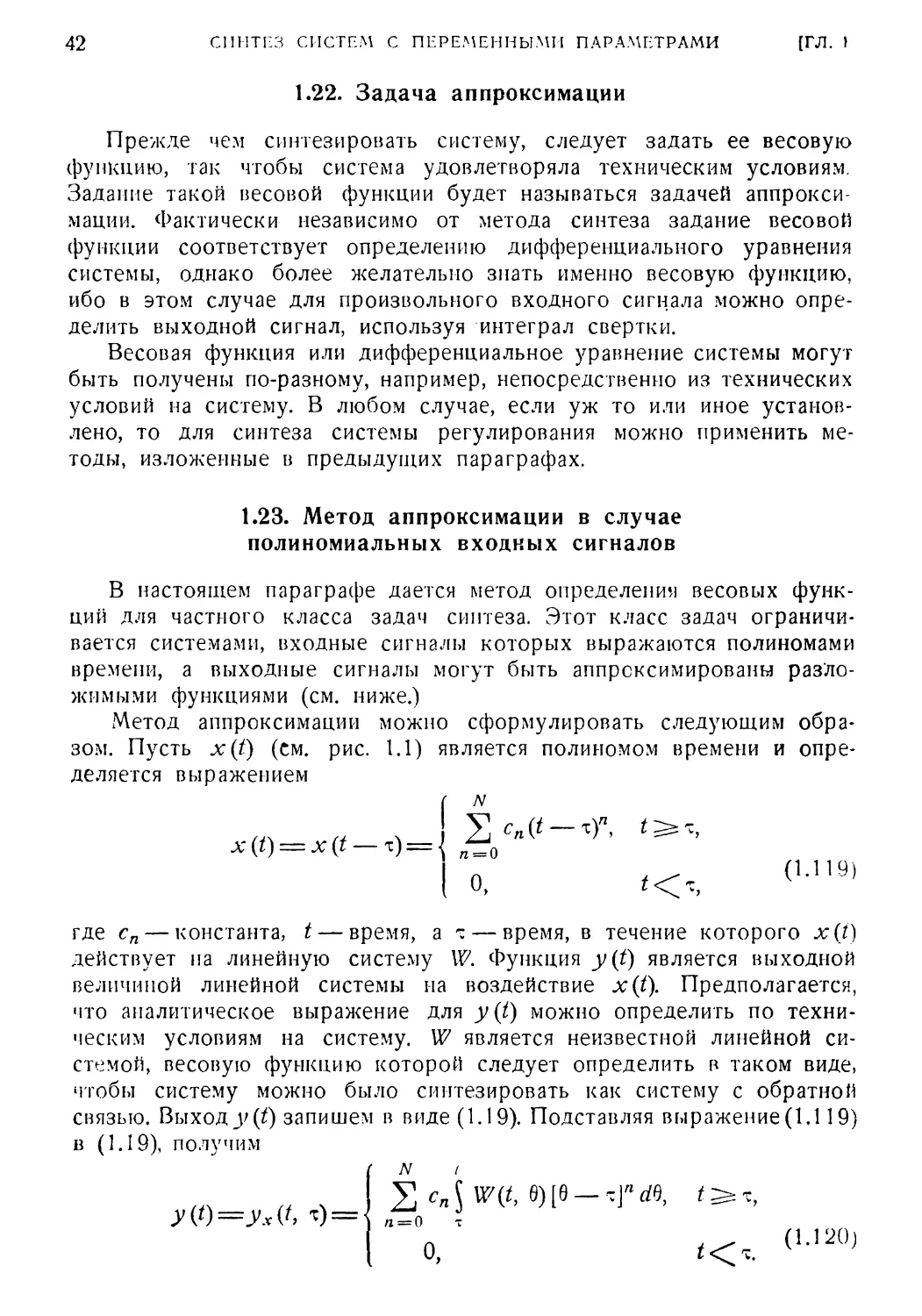

1.22. Задача аппроксимации

Прежде чем синтезировать систему, следует задать ее весовую

функцию, так чтобы система удовлетворяла техническим условиям.

Задание такой весовой функции будет называться задачей аппрокси¬

мации. Фактически независимо от метода синтеза задание весовой

функции соответствует определению дифференциального уравнения

системы, однако более желательно знать именно весовую функцию,

ибо в этом случае для произвольного входного сигнала можно опре¬

делить выходной сигнал, используя интеграл свертки.

Весовая функция или дифференциальное уравнение системы могут

быть получены по-разному, например, непосредственно из технических

условий на систему. В любом случае, если уж то или иное установ¬

лено, то для синтеза системы регулирования можно применить ме¬

тоды, изложенные в предыдущих параграфах.

В настоящем параграфе дается метод определения весовых функ¬

ций для частного класса задач синтеза. Этот класс задач ограничи¬

вается системами, входные сигналы которых выражаются полиномами

времени, а выходные сигналы могут быть аппроксимированы разло¬

жимыми функциями (см. ниже.)

Метод аппроксимации можно сформулировать следующим обра¬

зом. Пусть x(t) (см. рис. 1.1) является полиномом времени и опре¬

деляется выражением

где сп— константа, t — время, а е— время, в течение которого x(t)

действует на линейную систему W. Функция y(t) является выходной

величиной линейной системы на воздействие x(t). Предполагается,

что аналитическое выражение для y{t) можно определить по техни¬

ческим условиям на систему. W является неизвестной линейной си¬

стемой, весовую функцию которой следует определить в таком виде,

чтобы систему можно было синтезировать как систему с обратной

связью. Выход j>(f) запишем в виде (1.19). Подставляя выражение (1.119)

в (1.19), получим

1.23. Метод аппроксимации в случае

полиномиальных входных сигналов

N

х (t) = X (t — т) = ■

°,

АППРОКСИМАЦИЯ ПРИ ПОЛИНОМИАЛЬНЫХ СИГНАЛАХ 4,4

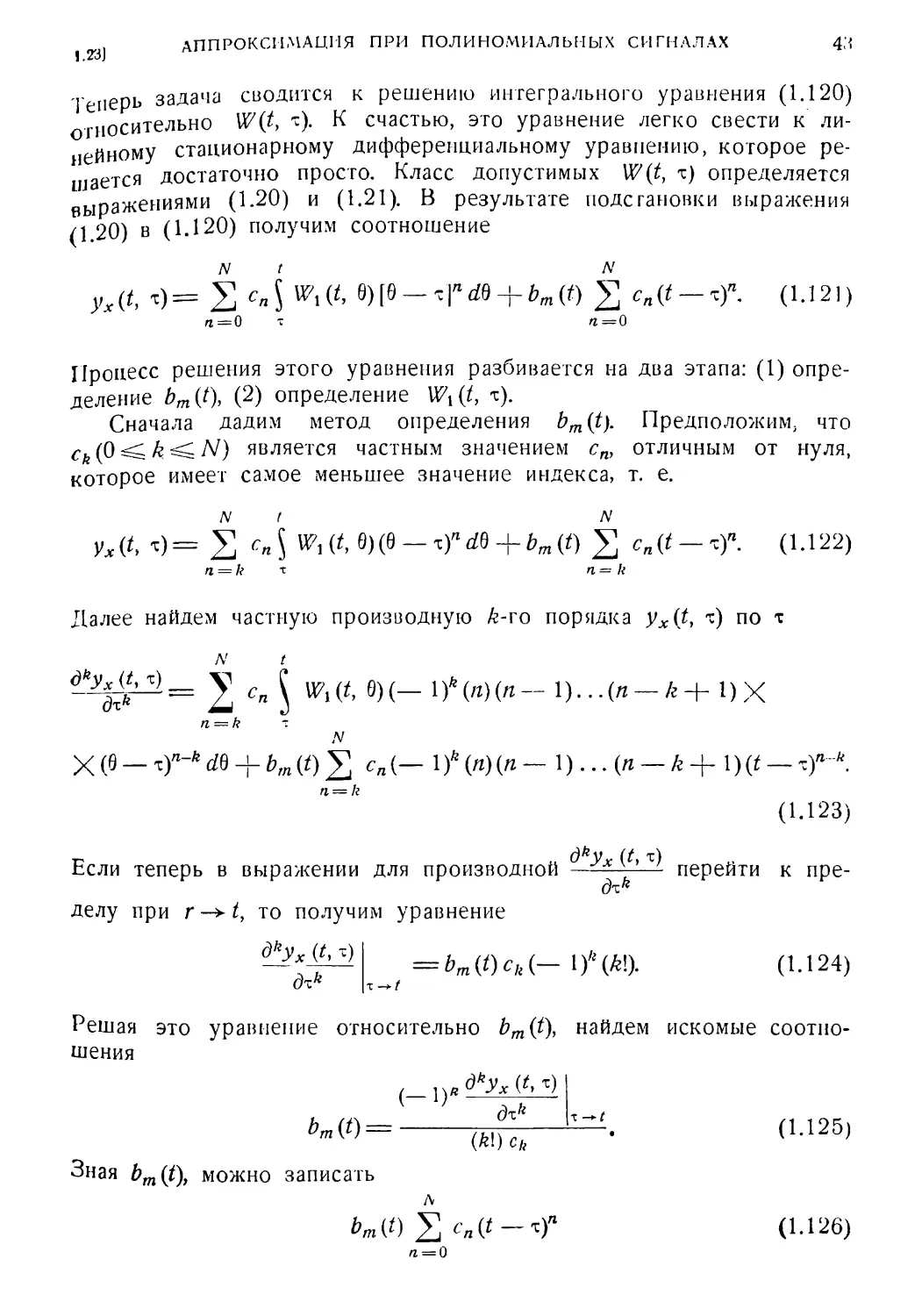

1.23 J

Теперь задача сводится к решению интегрального уравнения (1.120)

гносительно U7(t, т). К счастью, эго уравнение легко свести к ли¬

нейному стационарному дифференциальному уравнению, которое ре¬

шается достаточно просто. Класс допустимых W(t, т) определяется

выражениями (1.20) и (1.21). В результате подстановки выражения

(1 20) в (1.120) получим соотношение

N t N

yx(t, ,) = 2 Д Writ, 0)[0-Tl“dfl + bm(t) 2 cn{t-zf. (1.121)

п=0 " п — 0

Процесс решения этого уравнения разбивается на два этапа: (1) опре¬

деление bm(t), (2) определение Wx(t, т).

Сначала дадим метод определения bm(t). Предположим, что

ck(Q ^k^N) является частным значением сп, отличным от нуля,

которое имеет самое меньшее значение индекса, т. е.

N ( N

Ух#, *)= 2 им*,0)(0—тул+мо 2 cnit-'T- (i.i22)

п = k "С п= k

Далее найдем частную производную /z-го порядка yx(ty ъ) по т

N t

Wi(t' e)(—lVW(n—i)..-(n — k+l)X

n = k -

N

X (0 _ xy~* M + bm (0 2 cni— 1 f (n)(n - 1)... (Я - k + l)(f - zfk.

n = k

(1.123)

Если теперь в выражении для производной —Ух перейти к пре-

dzh

делу при г—±t, то получим уравнение

д1!Ух {t, -)

dz*

(1.124)

Решая это уравнение относительно bm(t), найдем искомые соотно¬

шения

, &ух (t, z)

(-1)

я :

и (+\

bт()~ (Щ^Г

Зная bm(t)y можно записать

(1.125)

bm{t) Ц (1.126)

п = 0

44 СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ [ГЛ. 3

и найти новую функцию yf(7, т) из уравнения (1.122)

N

у* у, т)=ух (t, х) - ьт (о 2 cn(t- xf=

п = О

N t

= 2 W71(<>9)(6-xf rfO. (1.127)

п= О

Второй вопрос состоит в определении Wi(t,z) из уравнения (1.127).

Сначала возьмем производные от y'x(t, т) по т. Первая производная

равна

лг /

^(^^(-ОпСЙ-хГЧб-^^^х). (1.128)

/г = 0 т

Производная /г-порядка ^ А/’ —1~ 1 равна

t

дкух (*, т)

= 2 Wl{t’ e)(-!)*(»)(«-в-••(«-* + 1)Х

71 = 0

fc—1

X (0 - xrfe db + v (/!)

>=о х

и N-J- 1 порядка

(А= 1. 2 /V)

(1.129)

(7, х)

**+•'

У<)'

. (—1У+1 (у!) сj -

‘V-^i(7,x)

dx'v-7

(1.130)

7 = 0

Видно, что уравнение (1.130) является линейным стационарным диф¬

ференциальным уравнением, решение которого есть Wi(t, i). Для

решения записанного уравнения необходимо задать N начальных

условий. Эти начальные условия получаются из выражений (1.129)

при т, стремящемся к t, т. е.

к — 1

дкух (t, х)

дхк

= У (—1)/+1 (j\)Cj

j — o

dk~l~JW, (t, x)

д-к-'-i

(1.131)

или

0k 1W, (t, x)

dxk 1

jX)

t'o [ dxk

x X)!

►. (— 1У: 1 (/!)О

J —1

0хк '-)

(k = i, 2, ..., /V). (1.132)

LJ

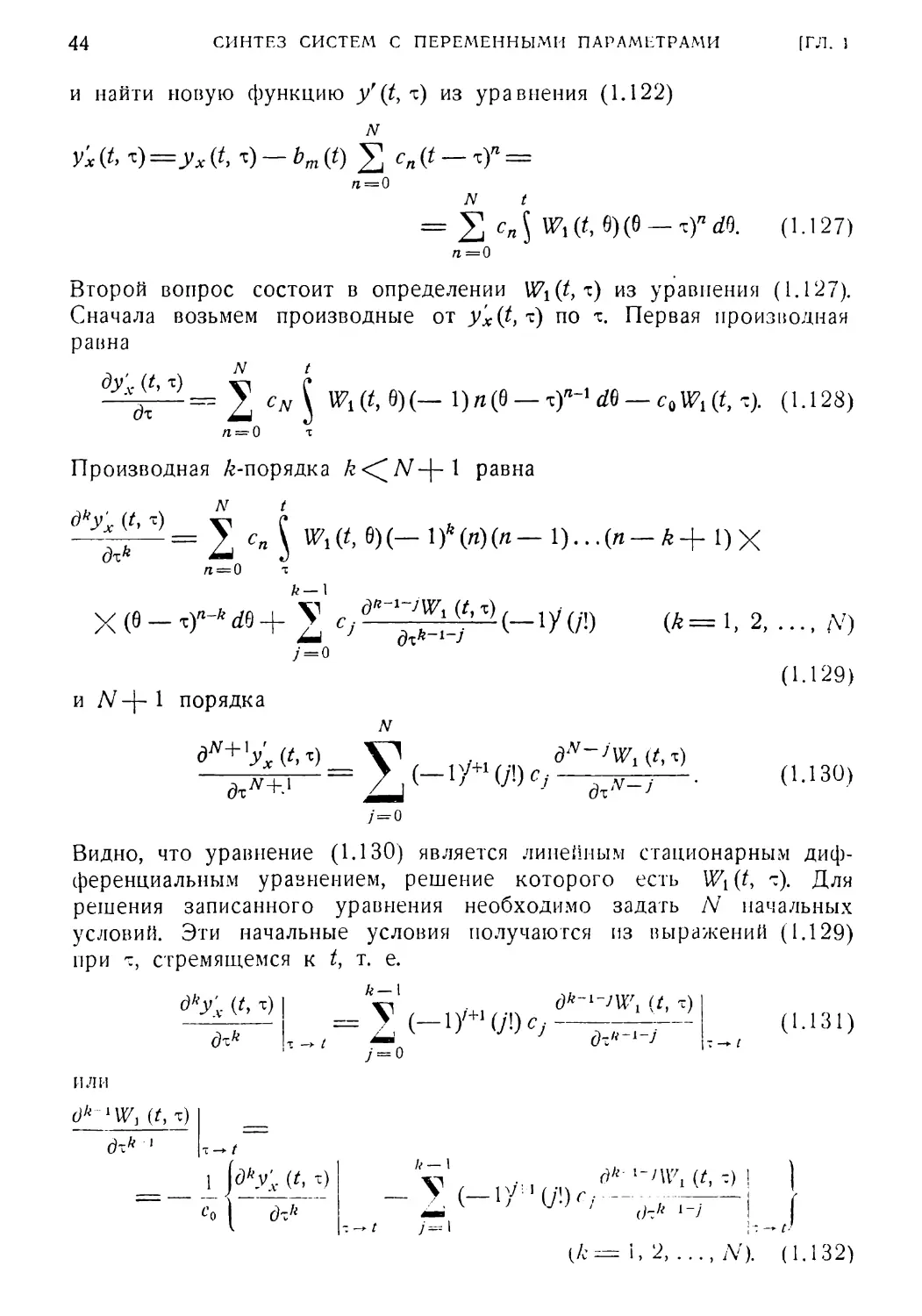

1241 АППРОКСИМАЦИЯ ПРИ НЕПОЛИНОМИАЛЬНЫХ СИГНАЛАХ 45

И тажение (1.132) определяет систему рекуррентных соотношений,

которые задают N необходимых «начальных условий». В действи¬

тельности, так как производные от (t, т) берутся по т, выражение

(1 132) определяет конечные условия. Этого неудобства легко избе¬

жать, делая подстановку

~. = t — z (1.133)

в выражениях (1.130) и (1.132). Получающиеся в результате уравне¬

ния легко решаются, после чего, делая обратную замену переменных

z — t — т, (1.134)

найдем W\(t, т).

Рассмотрим выражения (1.125) и (1.130) в частном случае, когда

полином x(t) вырождается и имеет вид

x(t — z) = cN(t — x)N. (1.135)

Тогда выражение (1.125) можно записать как

^А'^Ух OVL)

дх

(-'г -

Ьт (*) = Nfc~

а выражение (1.130) — следующим образом

д^+1у'х (t, х)

dxN+l

(1.136)

(_1)ЛГ+1(М)СЛГ Wiit,*) (1.137)

,л . (Ы38)

N\ cA,

Равенствами (1.137) и (1.138) можно пользоваться в случаях, когда

входной сигнал представляется полиномом лишь с одним ненулевым

коэффициентом. Ясно, что рассмотренный случай справедлив и для

входных сигналов, описываемых ступенчатыми функциями.

1.24. Метод аппроксимации в случае входных сигналов

неполиномиального вида

Вернемся опять к рис. 1.1. Предположим теперь, что x(t) не

полином, а некоторая разложимая функция t и т, т. е.

f Л'

*«>= ,з”'

1«; «, <1139’

46

СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

[ГЛ. !

Кроме того, пусть y(t) — также некоторая разложимая функция

(в соответствии с заданными техническими условиями на систему)

м

2 «mC0-Vm(0.

(1.140)

т= 0

о,

*<т.

Предполагая дифференцируемость сп(т), xn(t), zm(z) и ym(t) доста¬

точное число раз, можно считать, что выражения (1.139) и (1.140)

являются весовыми функциями линейной системы. Следовательно,

дифференциальные уравнения, соответствующие каждой из них, можно

определить, пользуясь методом, изложенным в параграфе 1.3.

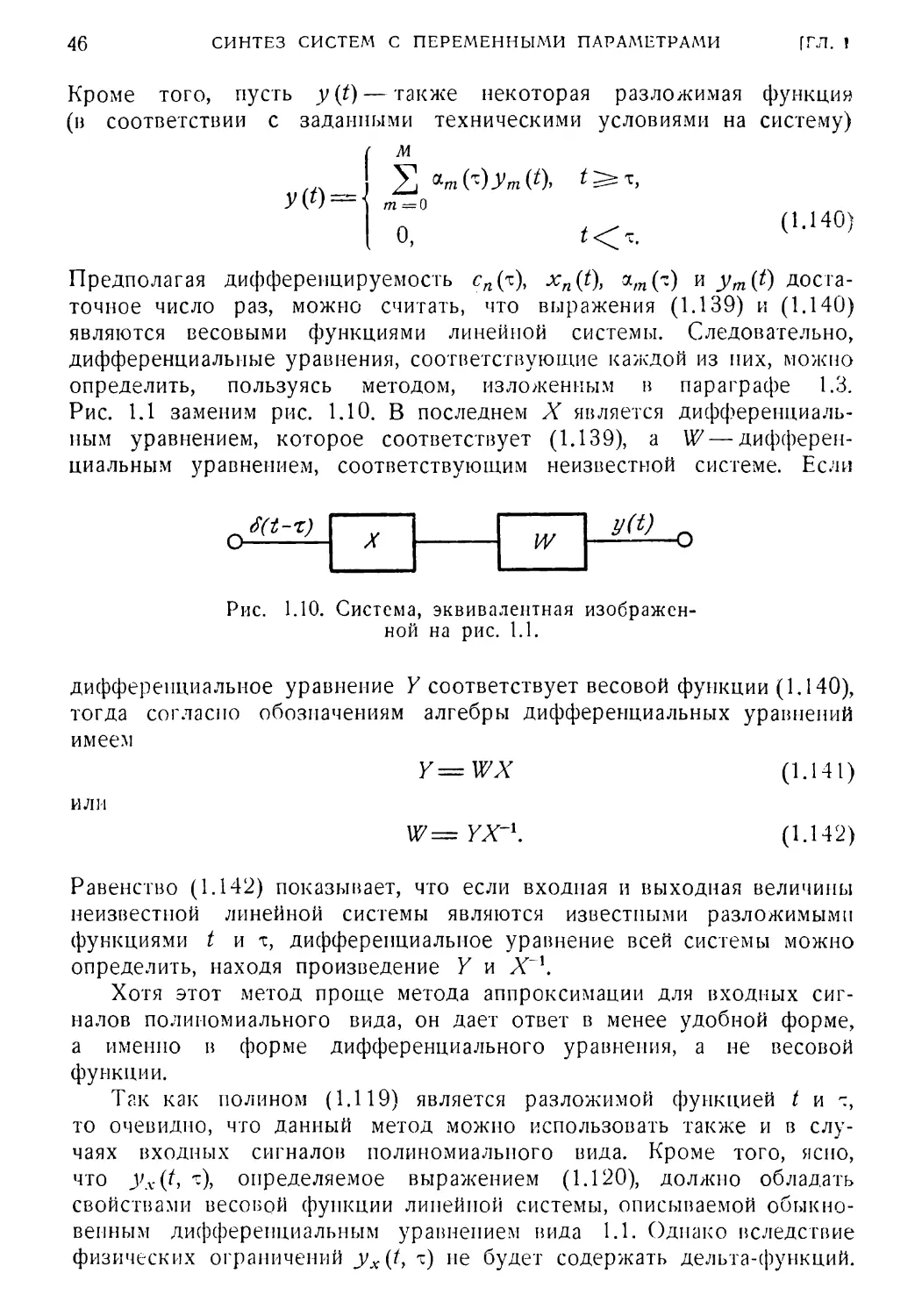

Рис. 1.1 заменим рис. 1.10. В последнем X является дифференциаль¬

ным уравнением, которое соответствует (1.139), a W — дифферен¬

циальным уравнением, соответствующим неизвестной системе. Если

J(t-z)

Y

W

y(t) ,

Л

\

Рис. 1.10. Система, эквивалентная изображен¬

ной на рис. 1.1.

дифференциальное уравнение Y соответствует весовой функции (1,140),

тогда согласно обозначениям алгебры дифференциальных уравнений

имеем

Y=WX (1.141)

или

W=YX'K (1.142)

Равенство (1.142) показывает, что если входная и выходная величины

неизвестной линейной системы являются известными разложимыми

функциями t ит, дифференциальное уравнение всей системы можно

определить, находя произведение Y и Х~л.

Хотя этот метод проще метода аппроксимации для входных сиг¬

налов полиномиального вида, он дает ответ в менее удобной форме,

а именно в форме дифференциального уравнения, а не весовой

функции.

Так как полином (1.119) является разложимой функцией t и 'г,

то очевидно, что данный метод можно использовать также и в слу¬

чаях входных сигналов полиномиального вида. Кроме того, ясно,

что yx(t, т), определяемое выражением (1.120), должно обладать

свойствами весовой функции линейной системы, описываемой обыкно¬

венным дифференциальным уравнением вида 1.1. Однако вследствие

физических ограничений yx(t, т) не будет содержать дельта-функций.

1.25]

ПРИМЕР

41

1.25. Пример

В качестве примера, иллюстрирующего метод, изложенный в § 1.23,

рассмотрим следующую задачу. Входной сигнал линейной системы

имеет вид

X(t — •z) = 2u{t — т) + 0 — т) — 2{t — т)2. (1.143)

Из технических условий на систему требуется, чтобы выходной

сигнал имел вид

у ли *)=--<4

+ 4-4

о 10

6 1 3 '

о

- --- ТВ 1

3 1

1

[-Д.-3,2

0_12 | 1 3 ' 1 ^4

1 6 * 1 6 V

(1.144)

При условии, что заданы входной сигнал x(t — т) и желаемый выход

системы, следует определить ее весовую функцию, которую должна

иметь желаемая линейная система. Выходной сигнал yx(t, т) можно

записать, пользуясь выражением (1.122), в котором N = 2, с0 = 2,

С\ = 1, а са = — 2-

Первое, что надо сделать для определения W(ty ?), это найти

bm(t). Переходя к пределу в yx(t, т) при t-+ т+, получим

\imyx(t9 т)=2z=bm(z)cQ. (1.145)

Следовательно,

(1.146)

2t

Тогда второй член в выражении (1.122) для yx(tf т) будет равен

ьт (0 2 fЛ-(t - *Г = 4- f- - fc - 21* 4- 4Л - 214. (1.147)

п — 0

Подставляя (1.147) в (1.122) и решая последнее относительно yrx (t, т),

получим

у'х (1, т) = 31* — 1:Ч — ил — 2f-z 4- 4IV

о 1 О

Далее найдем производные y'x(t, i) по т

А № _1_ _

3 1 6

гЛ-ъ?- (Ы48)

~у~=—4 i*—б!;ч.

ch 2

L°«

21* Л -f 2lV -f ^ I4 — 21- 4- 4. 14 4

= — 61* 4- 4- 414 — 214-44- 214,

r):y

4 = 4£2 4- * 4У

+ (1.149)

(1.150)

(1.151)

48 СИНТЕЗ СИСТЕМ С ПЕРЕМЕННЫМИ ПАРАМЕТРАМИ

Пользуясь выражениями (1.130) и (1.132), запишем

д»у'х (*, х)

ах3

: 4- t -f 4£т = —2с2 И?! (t, т) -j- Cj

(t, X)

dx

[ГЛ. 1

d2U7i (*, x)

w'«’

$X“ ’

(1.152)

(1.153)

dWt (f, x)

dx

г>н- <u54)

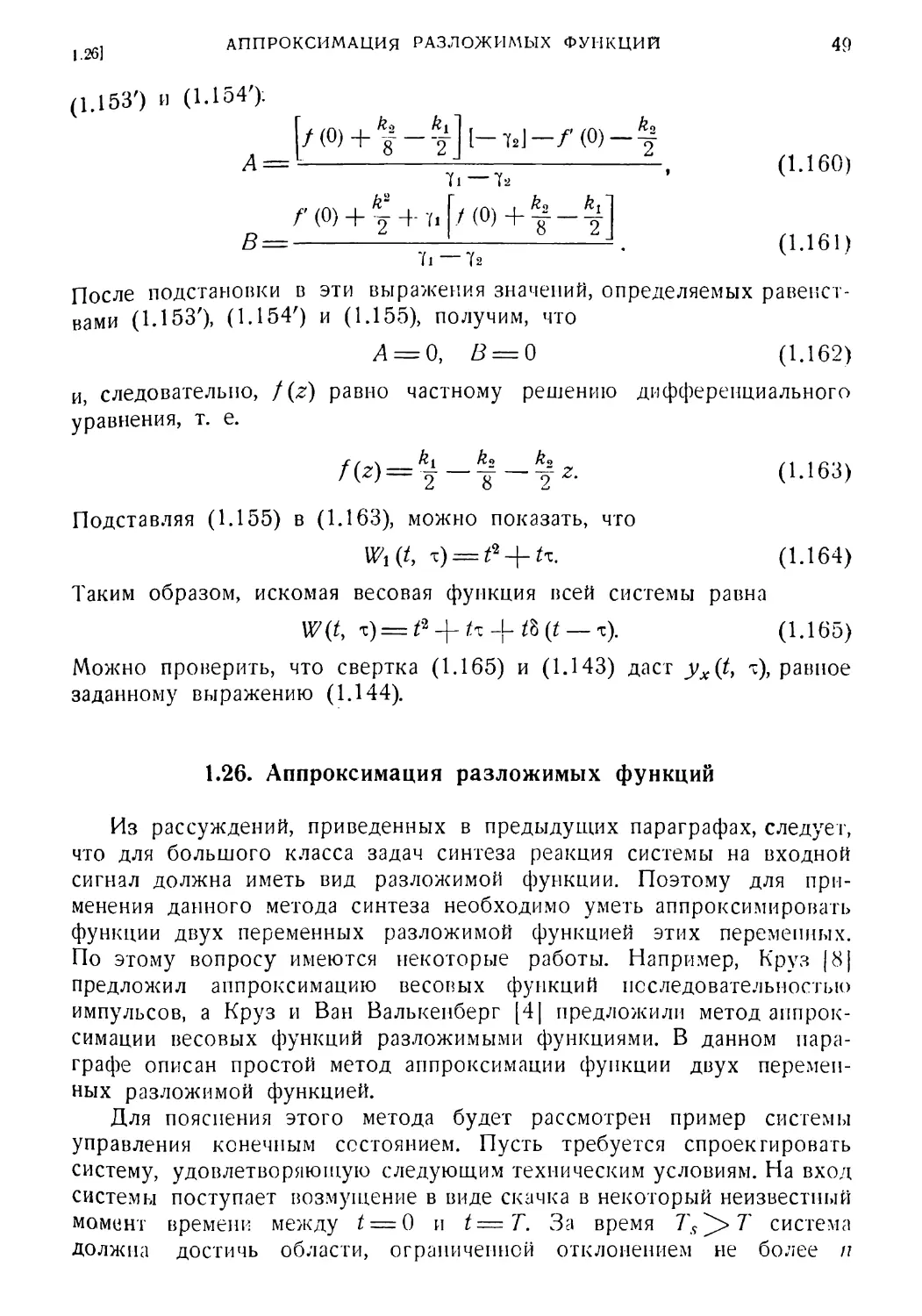

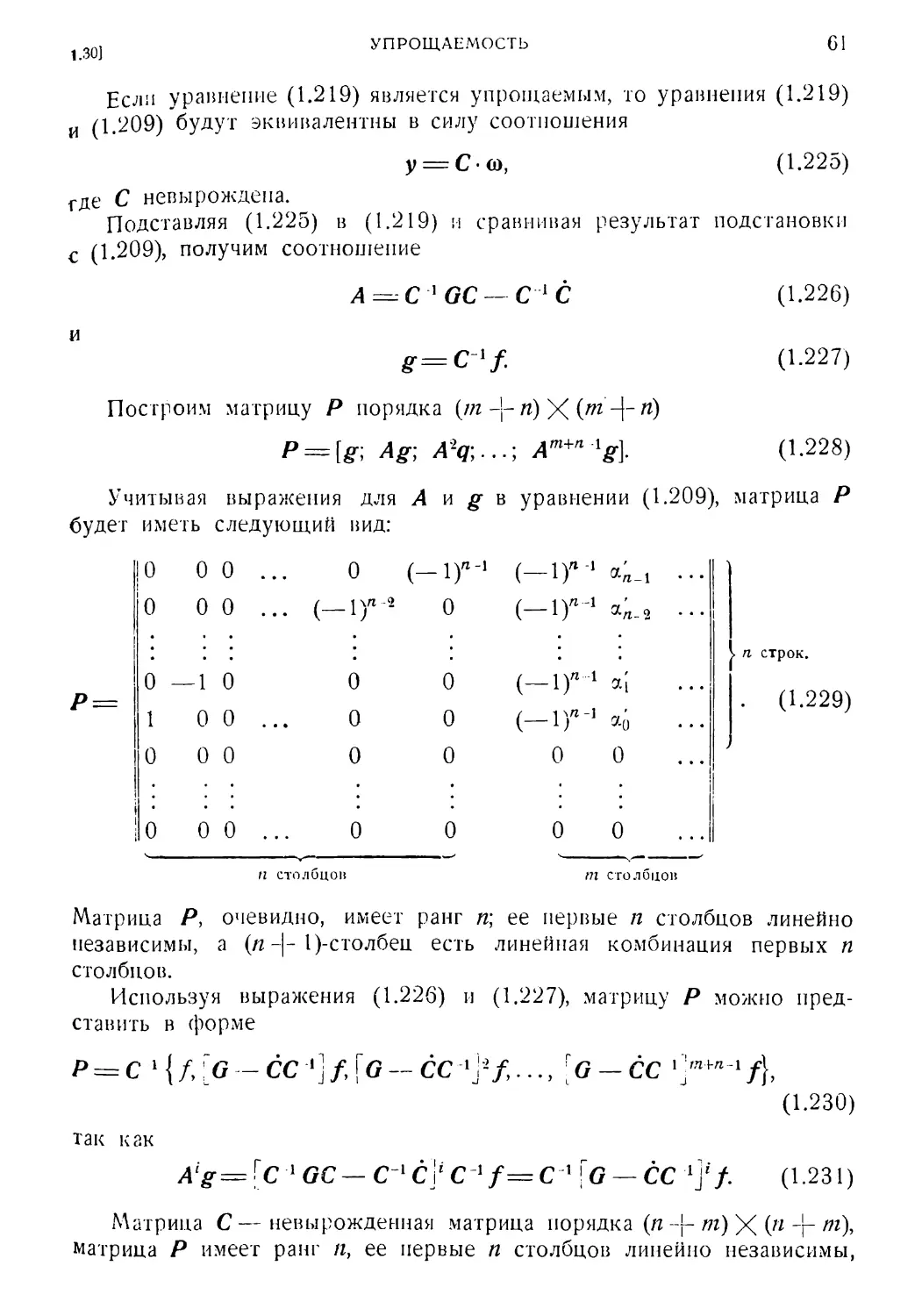

Желаемая весовая функция определяется из системы уравнений (1.152),

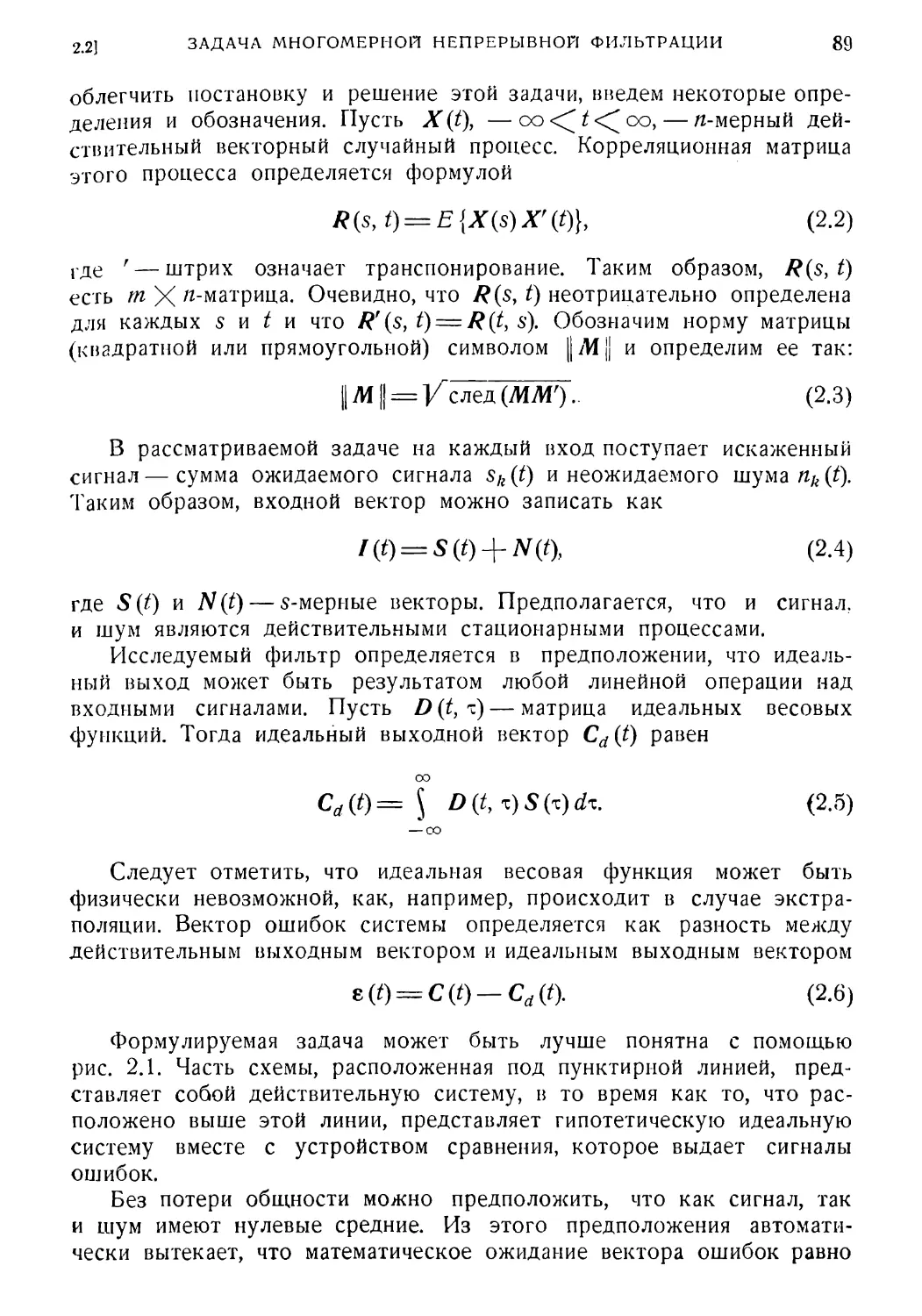

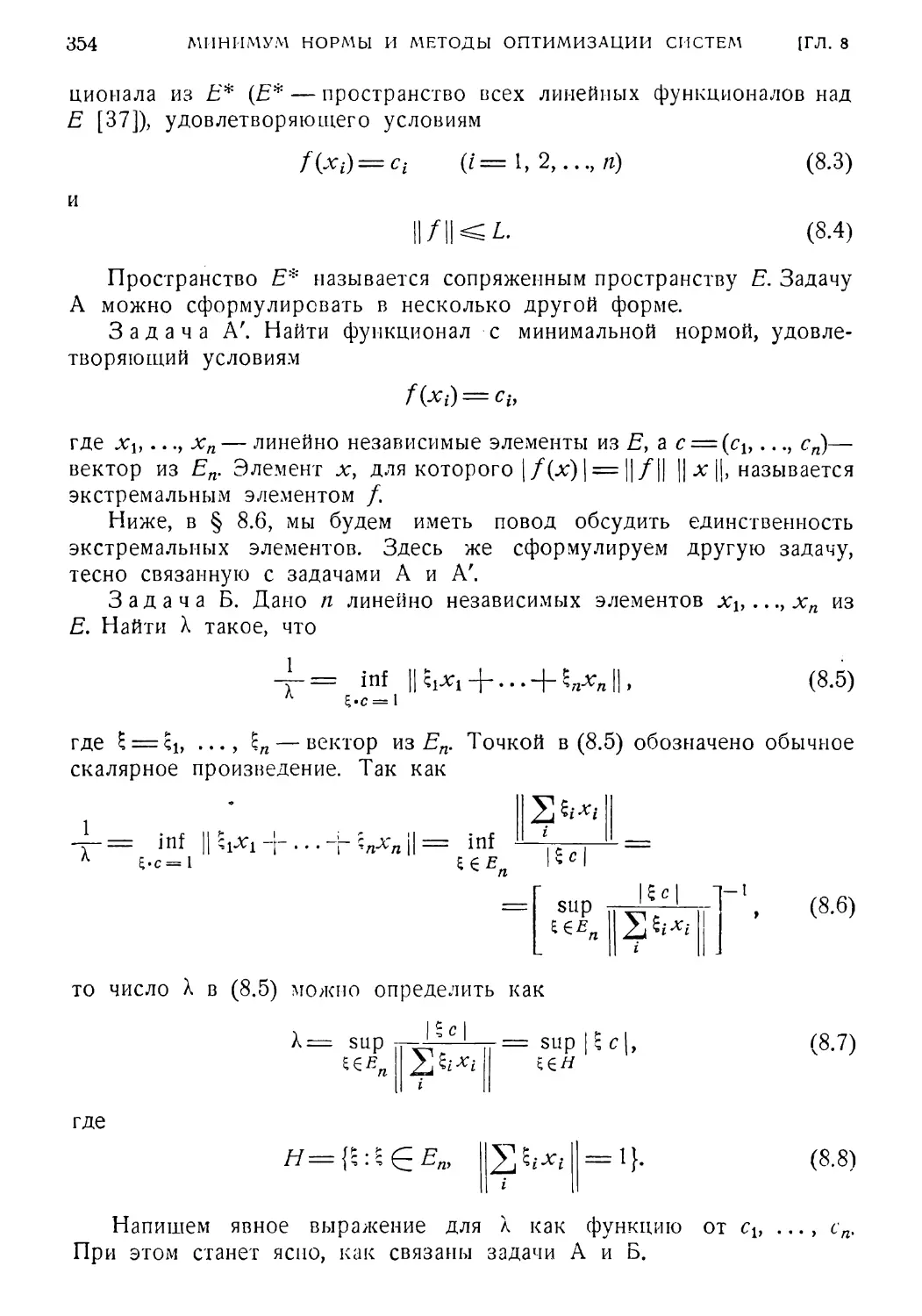

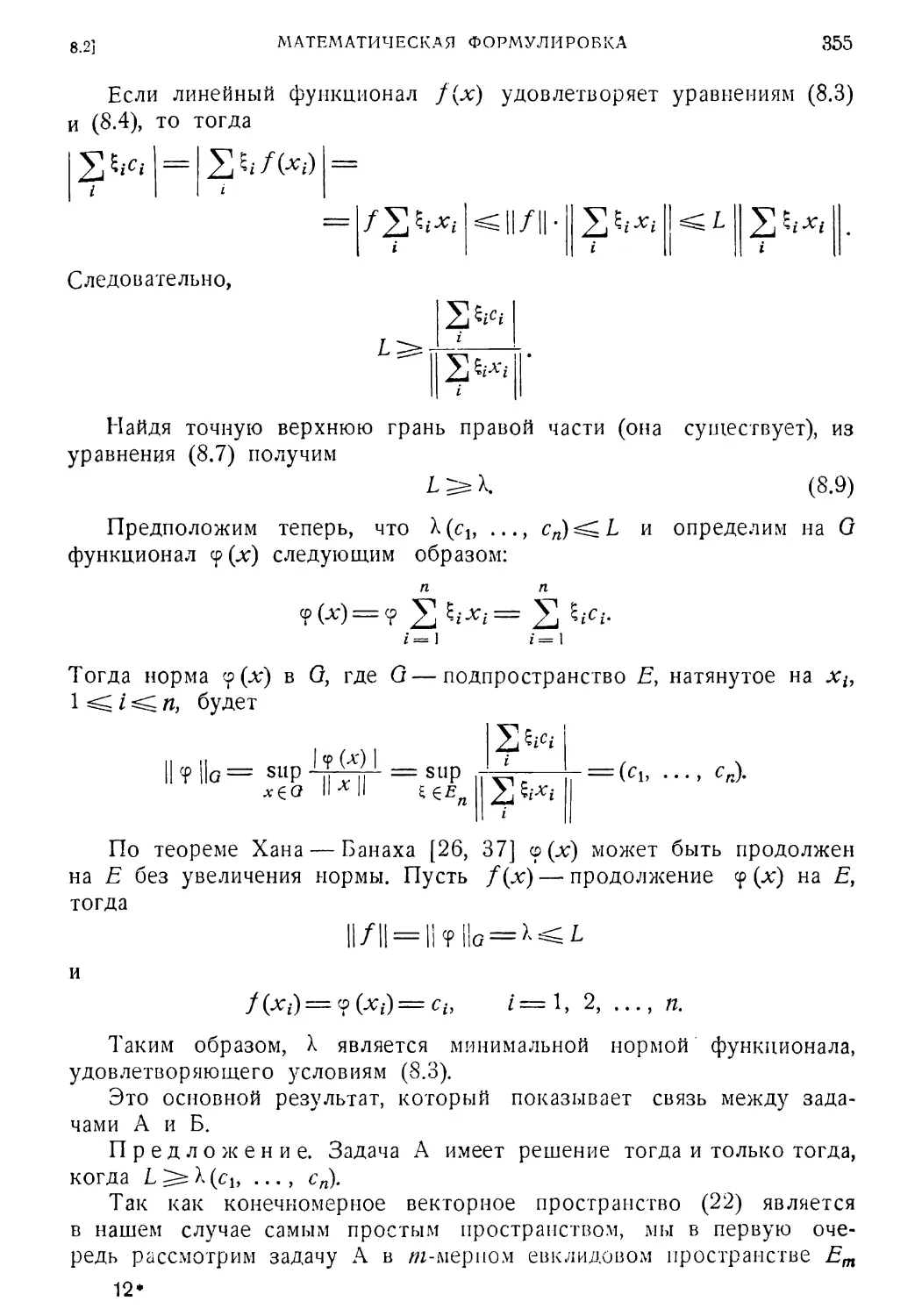

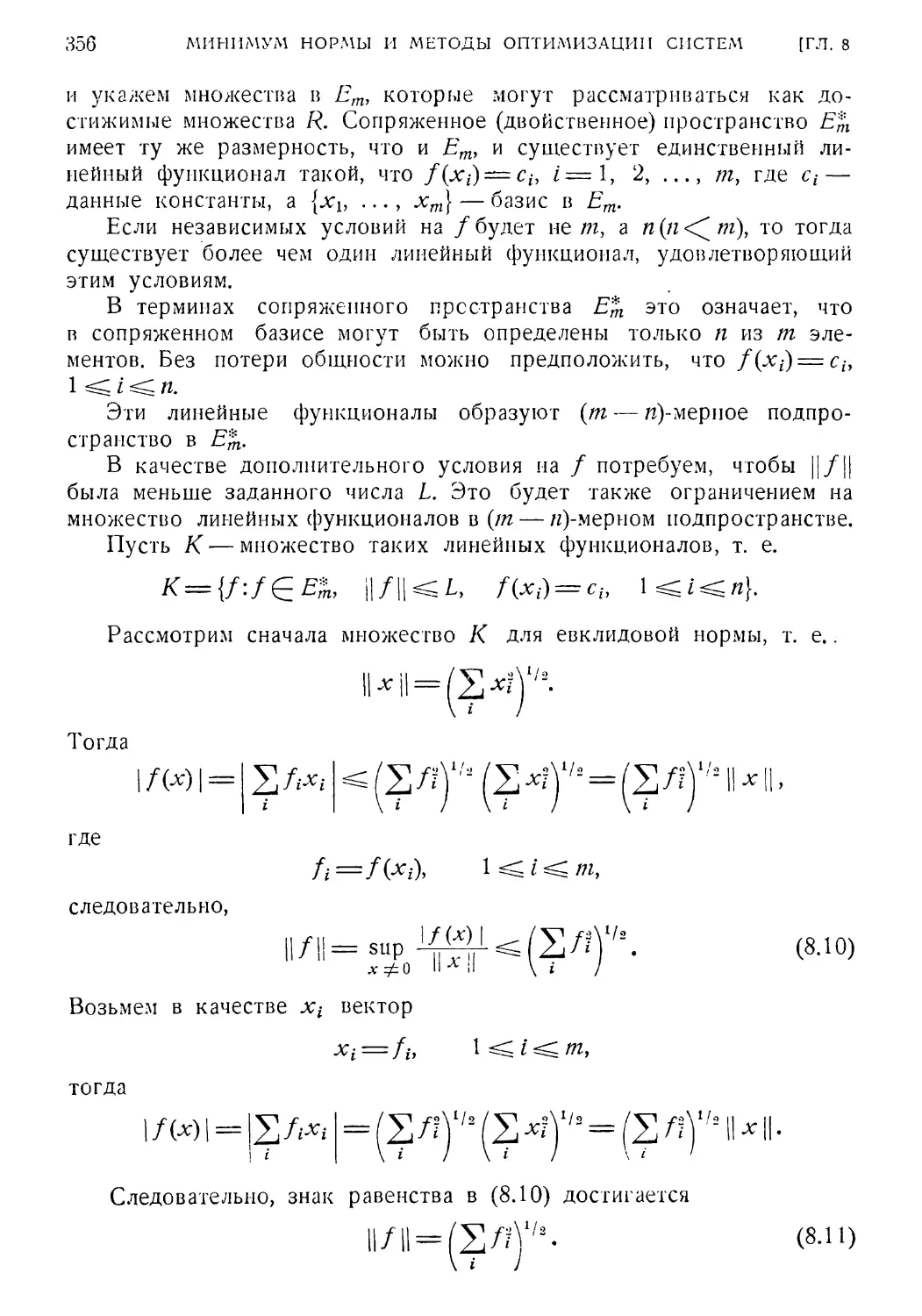

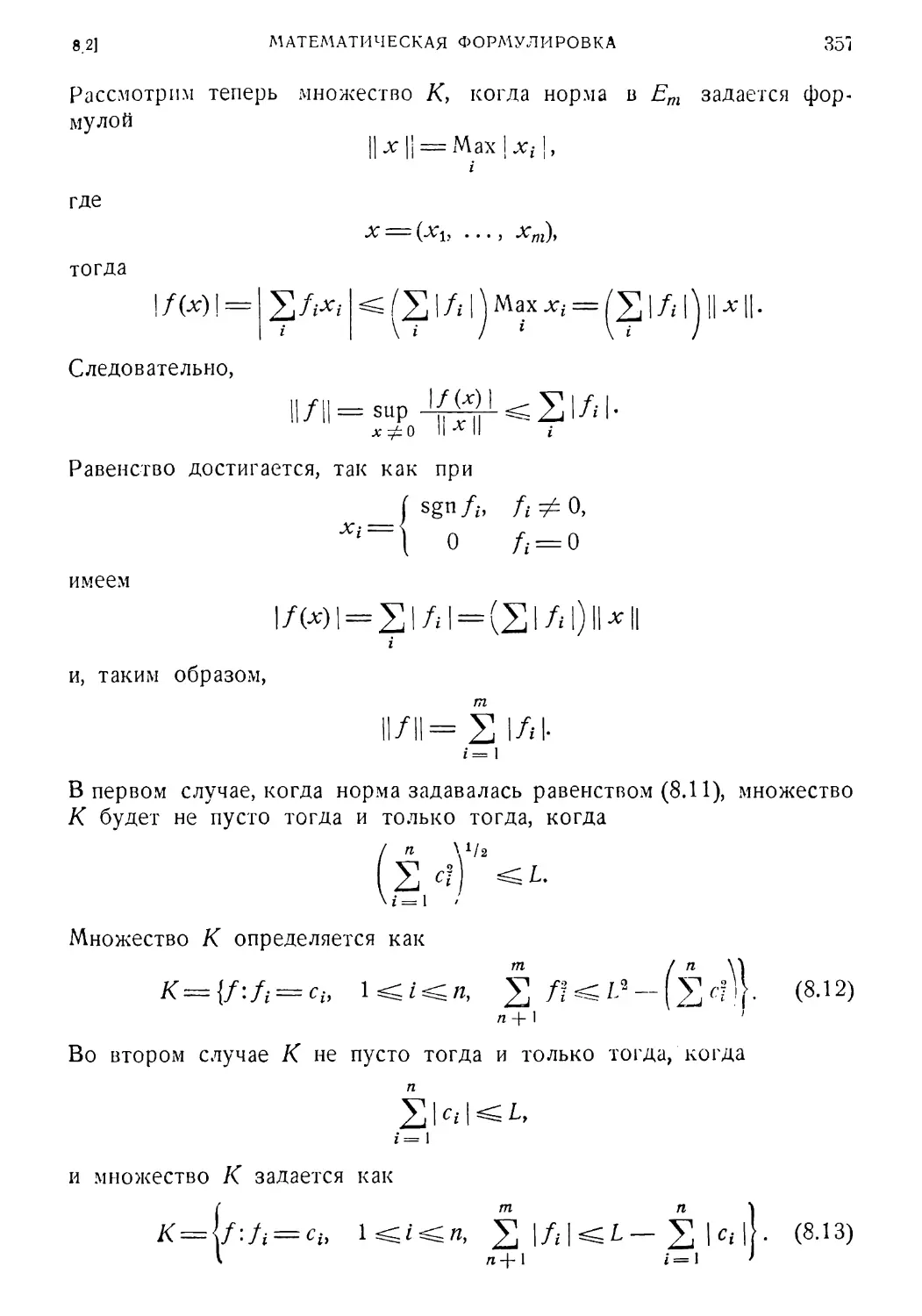

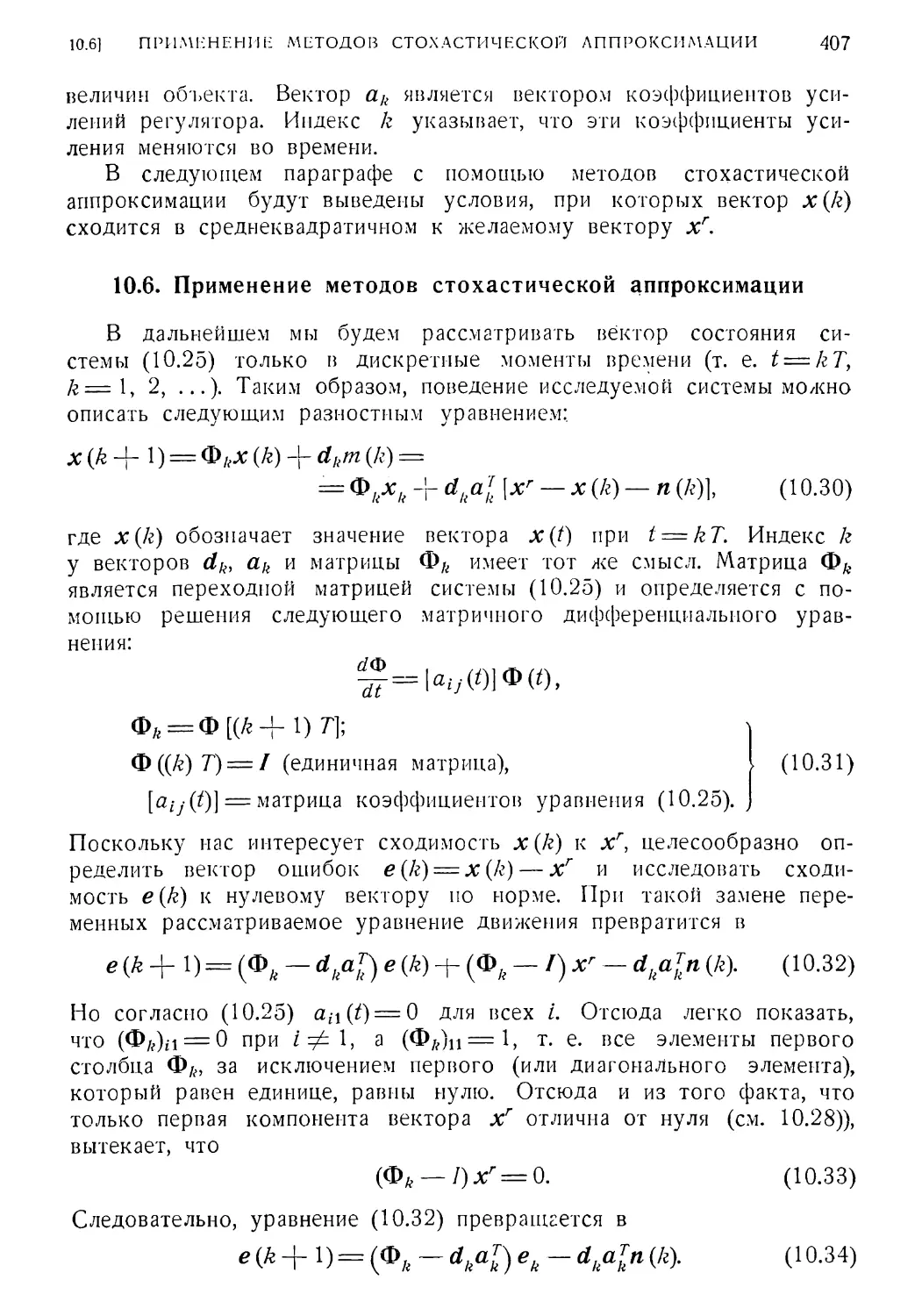

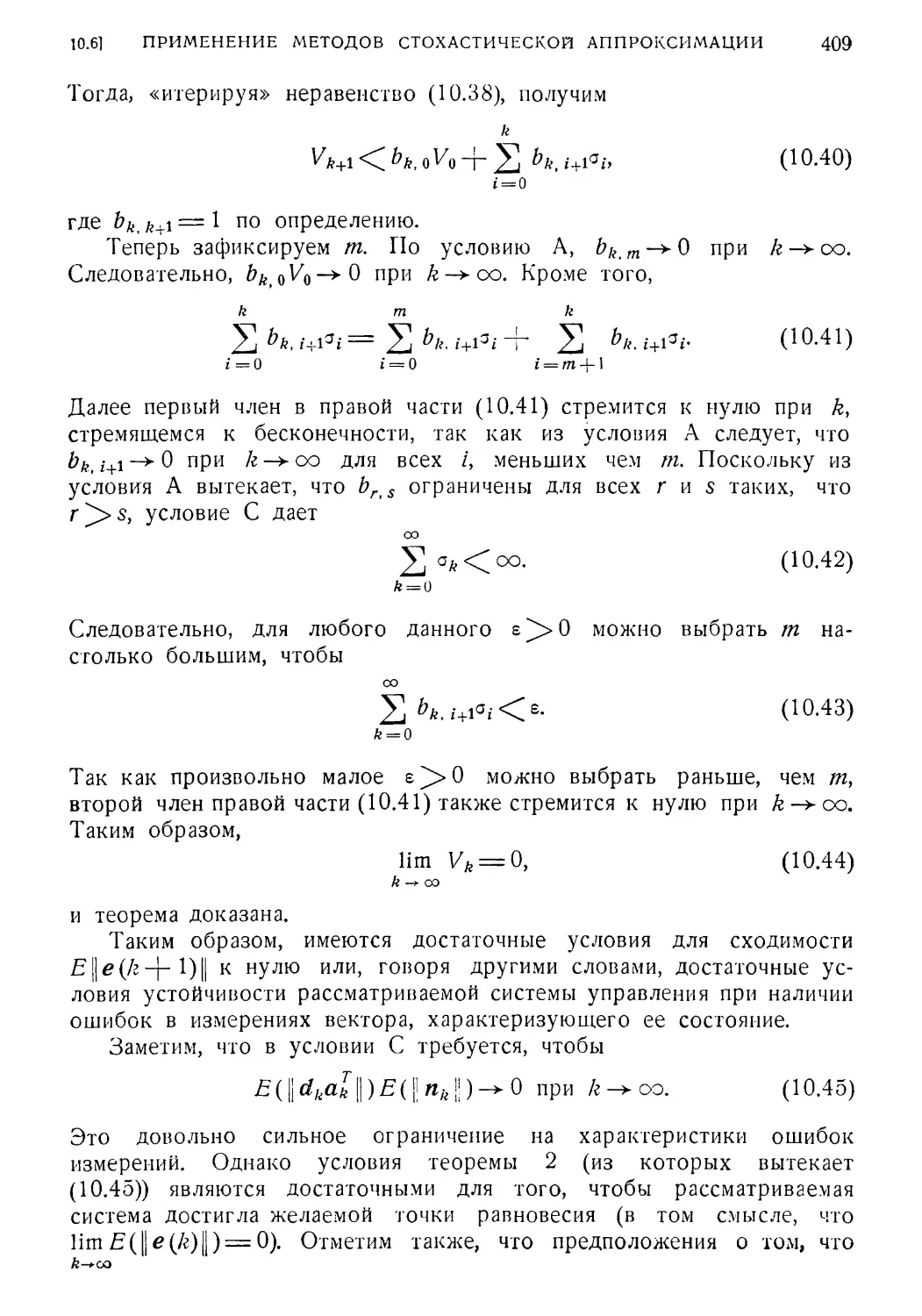

(1.153) и (1.154). Для упрощения алгебраических операций и облег¬