Author: Колемаев В.А. Калинина В.Н.

Tags: болезни животных (кроме болезней домашних животных) патология животных теория вероятностей математическая статистика комбинаторный анализ теория графов математика

ISBN: 5-86225-571-0

Year: 1997

i>

Серия «ВЫСШЕЕ ОБРАЗОВАНИЕ»

В.А. Колемаев, В.Н. Калинина

ТЕОРИЯ ВЕРОЯТНОСТЕЙ

И

МАТЕМАТИЧЕСКАЯ СТАТИСТИКА

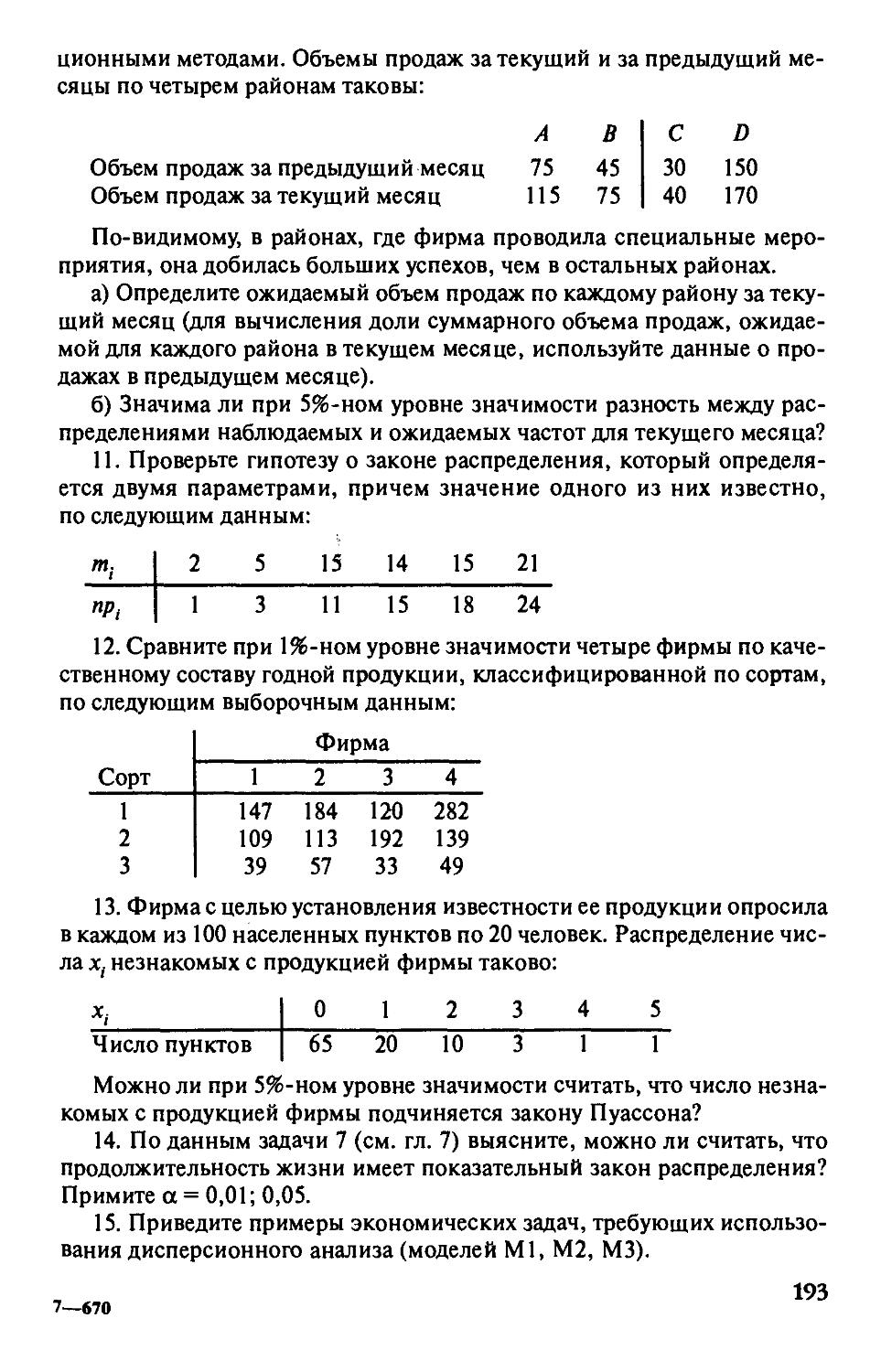

УЧЕБНИК

Под редакцией

проф. В.А. Колемаева

Рекомендовано Министерством общего

и профессионального образования

Российской Федерации в качестве учебника

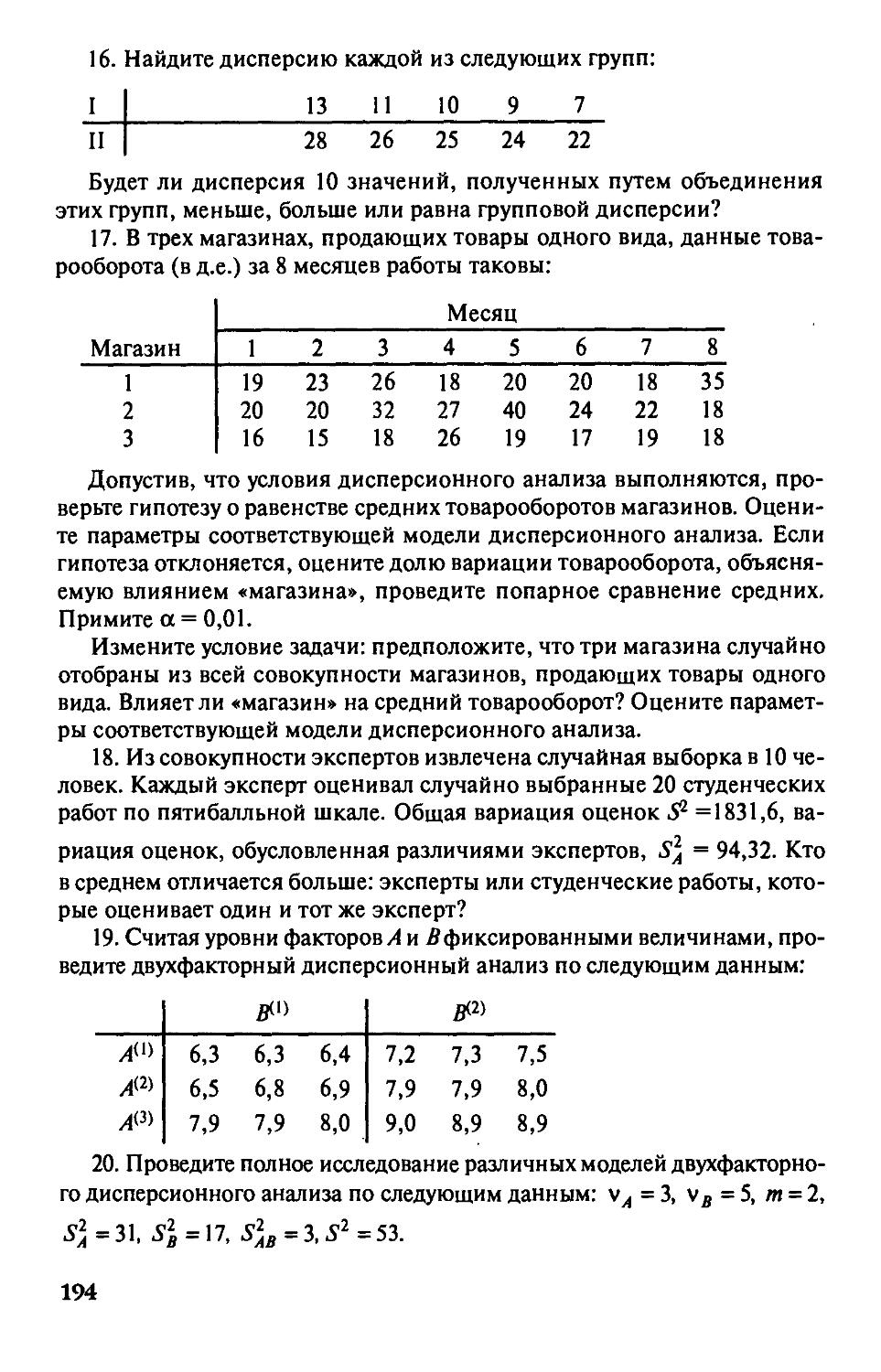

для студентов высших учебных заведений,

обучающихся по направлению и специальности

«Менеджмент»

•щ. ж -ш*

Москва

ИНФРА-М

1997

УДК 591.21(075.8)

ББК22.17Я7

К 60

Авторы: В.А. Колемаев{гл. 1—6, 9—11, Приложения 1—3);

В.Н. Калинина (гл. 7 и 8, Приложение 4)

Рецензенты: кафедра статистики

Российской экономической академии им. Г.В. Плеханова

(зав. кафедрой —д-р экон. наук, проф. Б.И. Искаков)

и д-р экон. наук, проф. Ю.П. Лукашин

Колемаев В.А., Калинина В.Н.

К 60 Теория вероятностей и математическая статистика; Учебник /

Под ред. В.А. Колемаева. - М.: ИНФРА-М, 1997. - 302 с. -

(Серия «Высшее образование»).

ISBN 5-86225-571-0

Излагаются основы теории вероятностей, теории массового

обслуживания и математической статистики согласно соответствующему разделу

программы дисциплины «Математика» для специальности «Менеджмент».

Изложение сопровождается примерами и задачами из экономической практики.

Предназначен для студентов специальности «Менеджмент» и может быть

использован и для других экономических специальностей. Будет также

полезен аспирантам и слушателям факультета магистерской подготовки,

работающим в области экономики и управления.

ISBN 5-86225-571-0 ББК22.17я7

© В.А. Колемаев, В.Н. Калинина, 1997

©ИНФРА-М, 1997

Оглавление

Предисловие 6

Введение 8

Часть 1. Теория вероятностей 10

DiaBal. Вероятностные пространства 10

§ 1,1. Классическое определение вероятности 10

§ 1.2, Конечная схема с неравновозможными исходами 15

§ 1,3. Исчисление событий 19

§ 1.4, Аксиоматическое построение теории вероятностей 22

Вопросы и задачи 25

DiaBa 2. Условные вероятности.

Последовательности испытаний 27

§ 2,1. Условные вероятности 27

§ 2.2. Последовательности испытаний 30

Вопросы и задачи 35

DiaBa 3. Случайные величины и их числовые характеристики 37

§ 3.1. Определение случайной величины

и ее функция распределения 37

§ 3.2. Дискретные случайные величины

и их важнейшие числовые характеристики 42

§ 3.3. Непрерывные случайные величины

и их важнейшие числовые характеристики 51

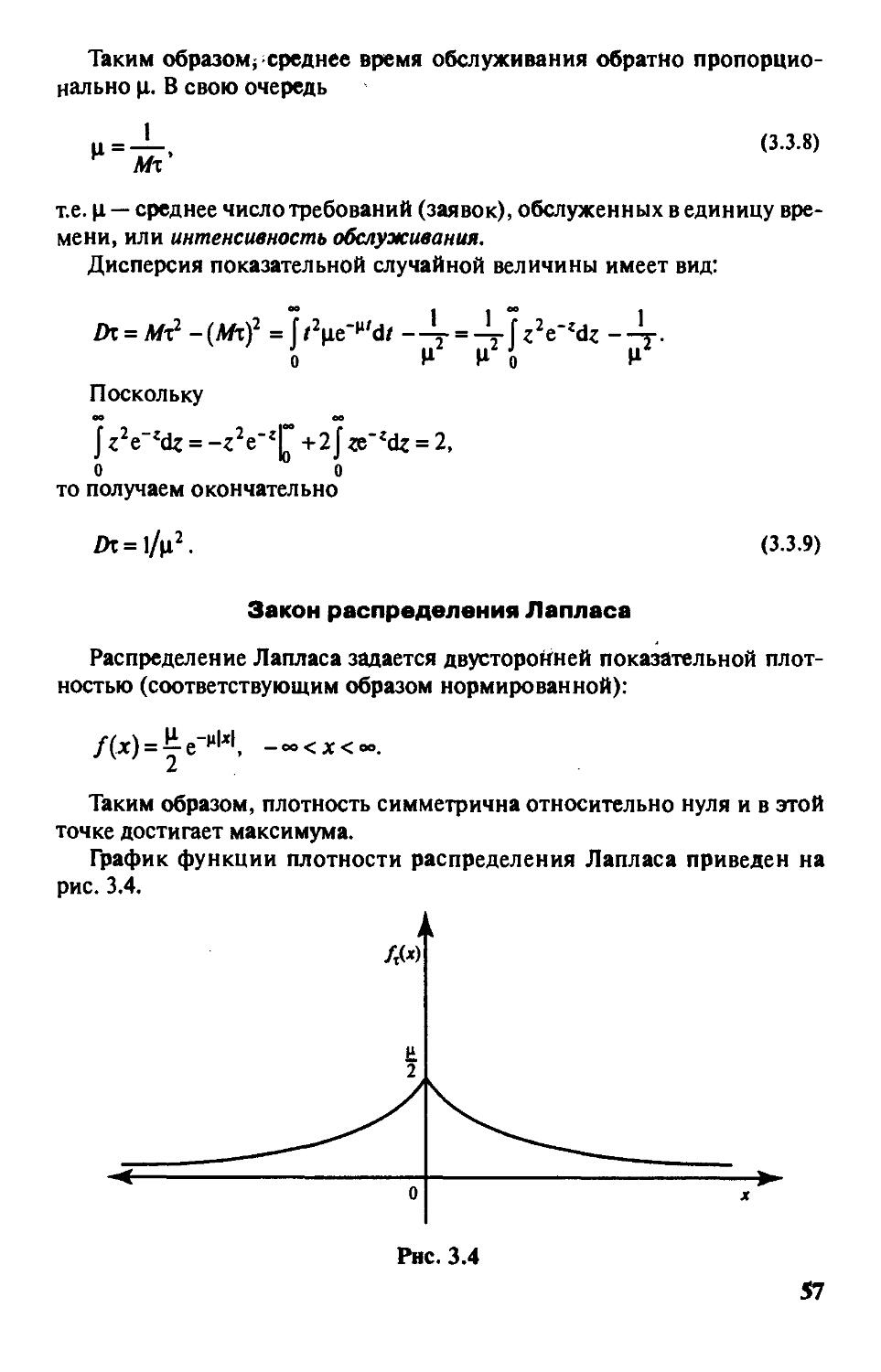

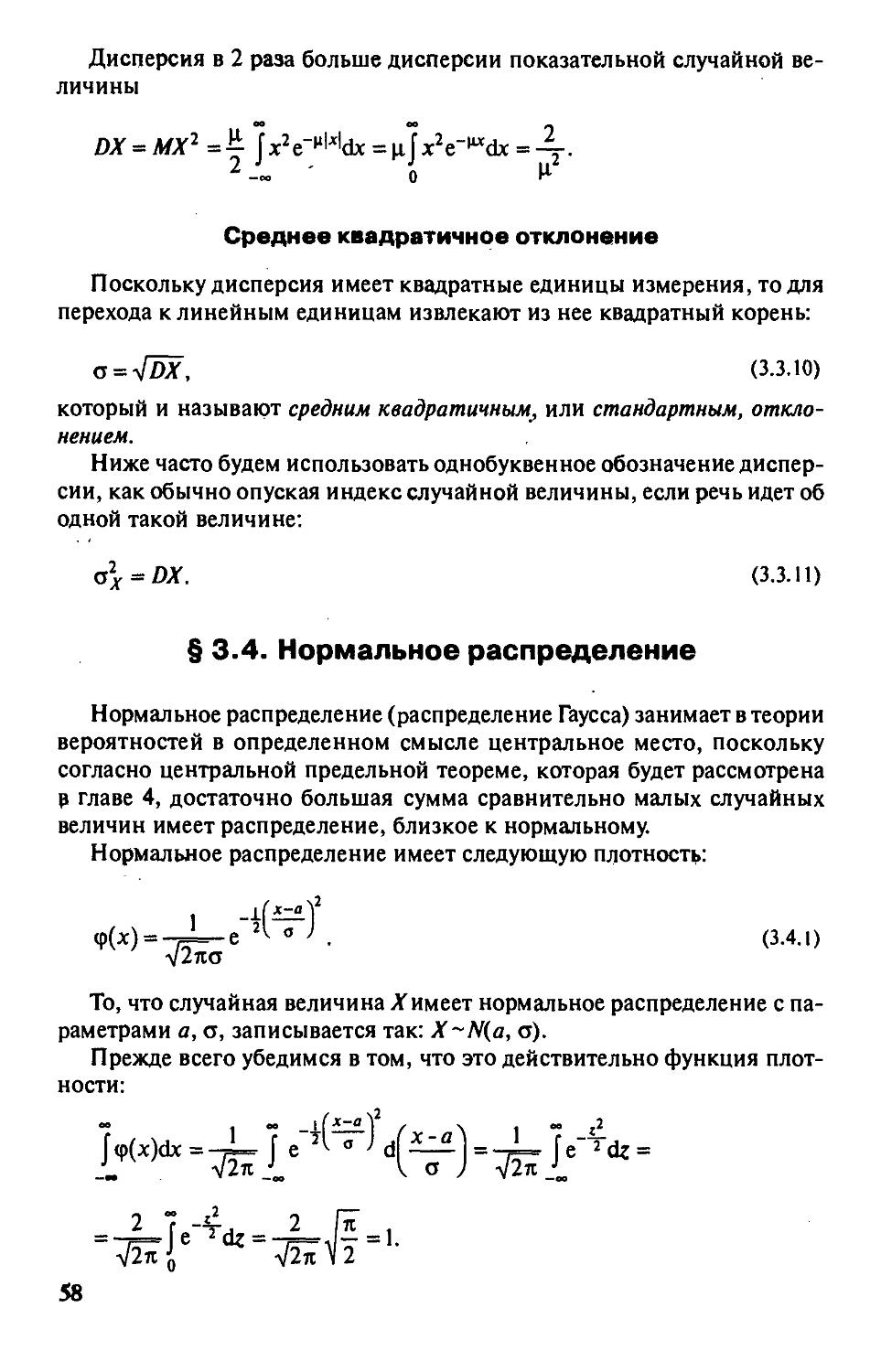

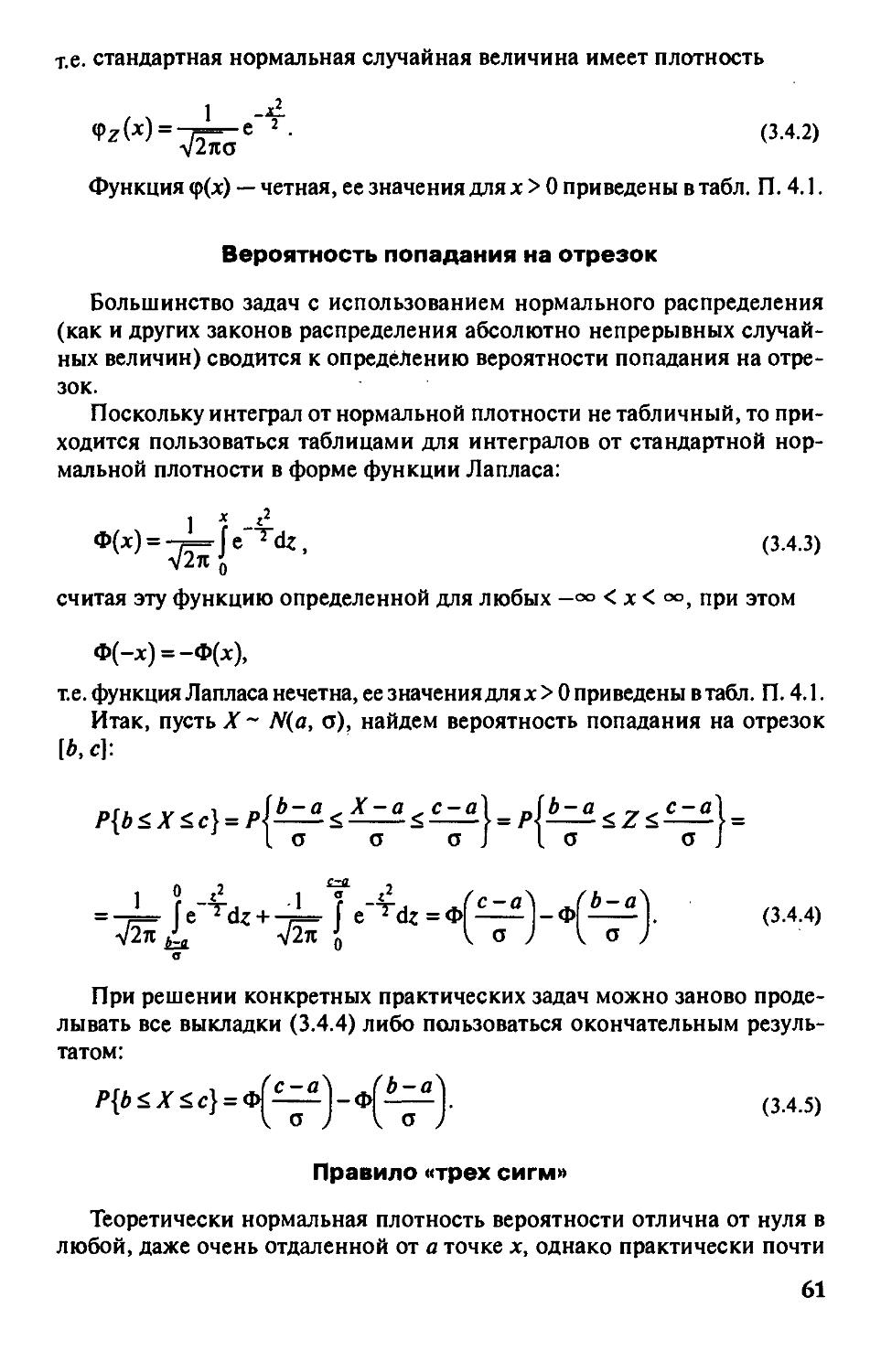

§ 3.4. Нормальное распределение 58

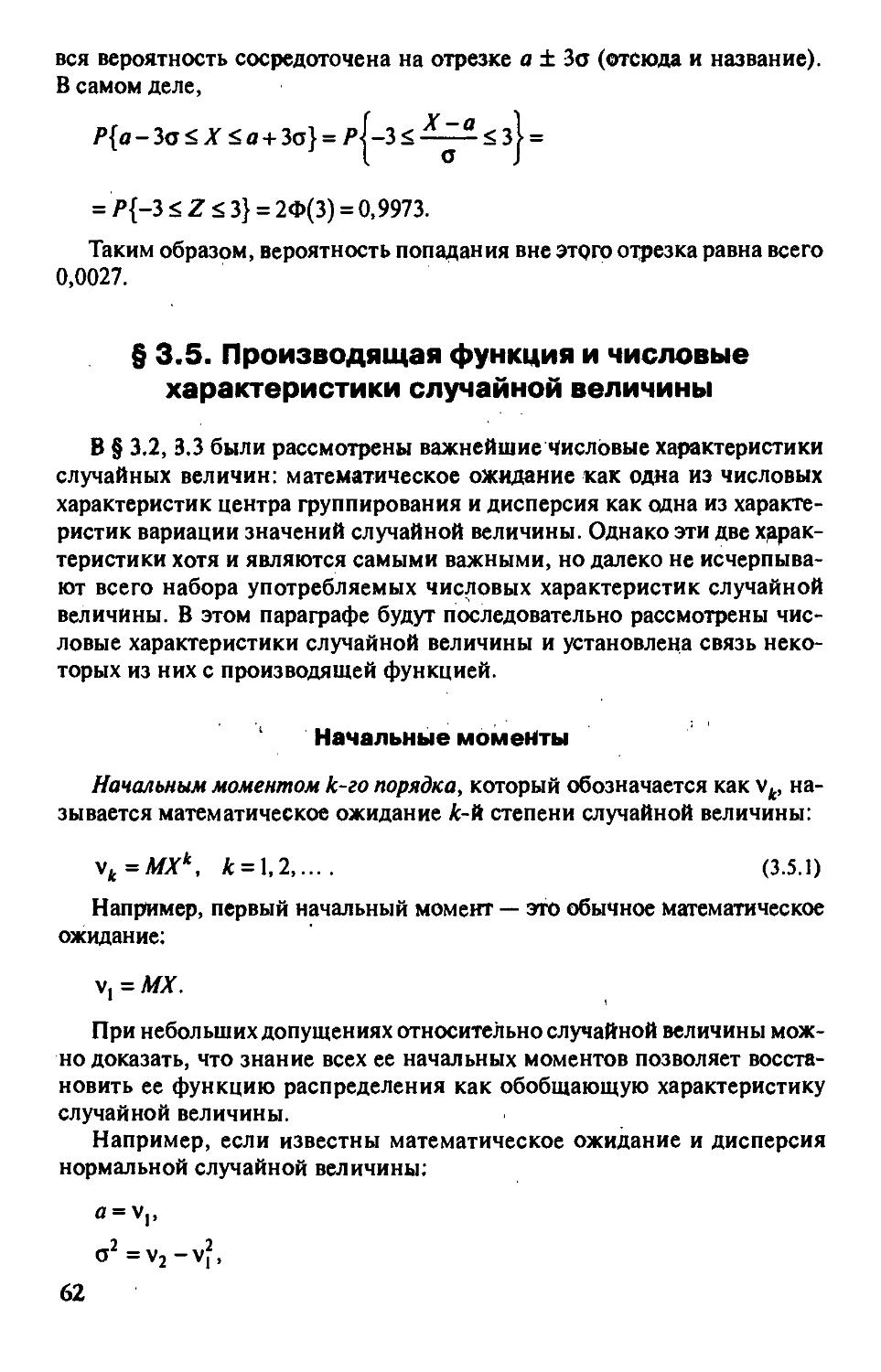

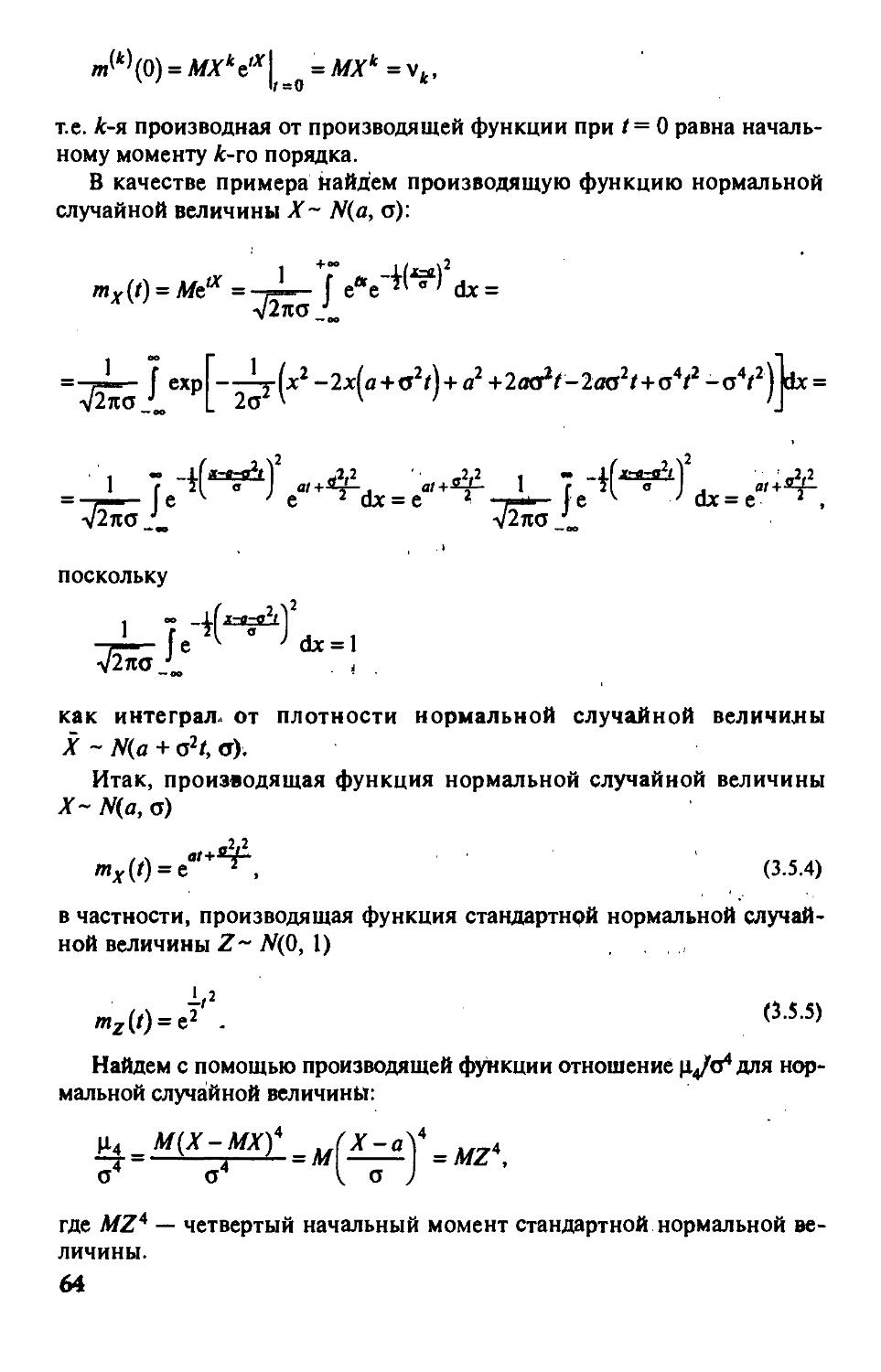

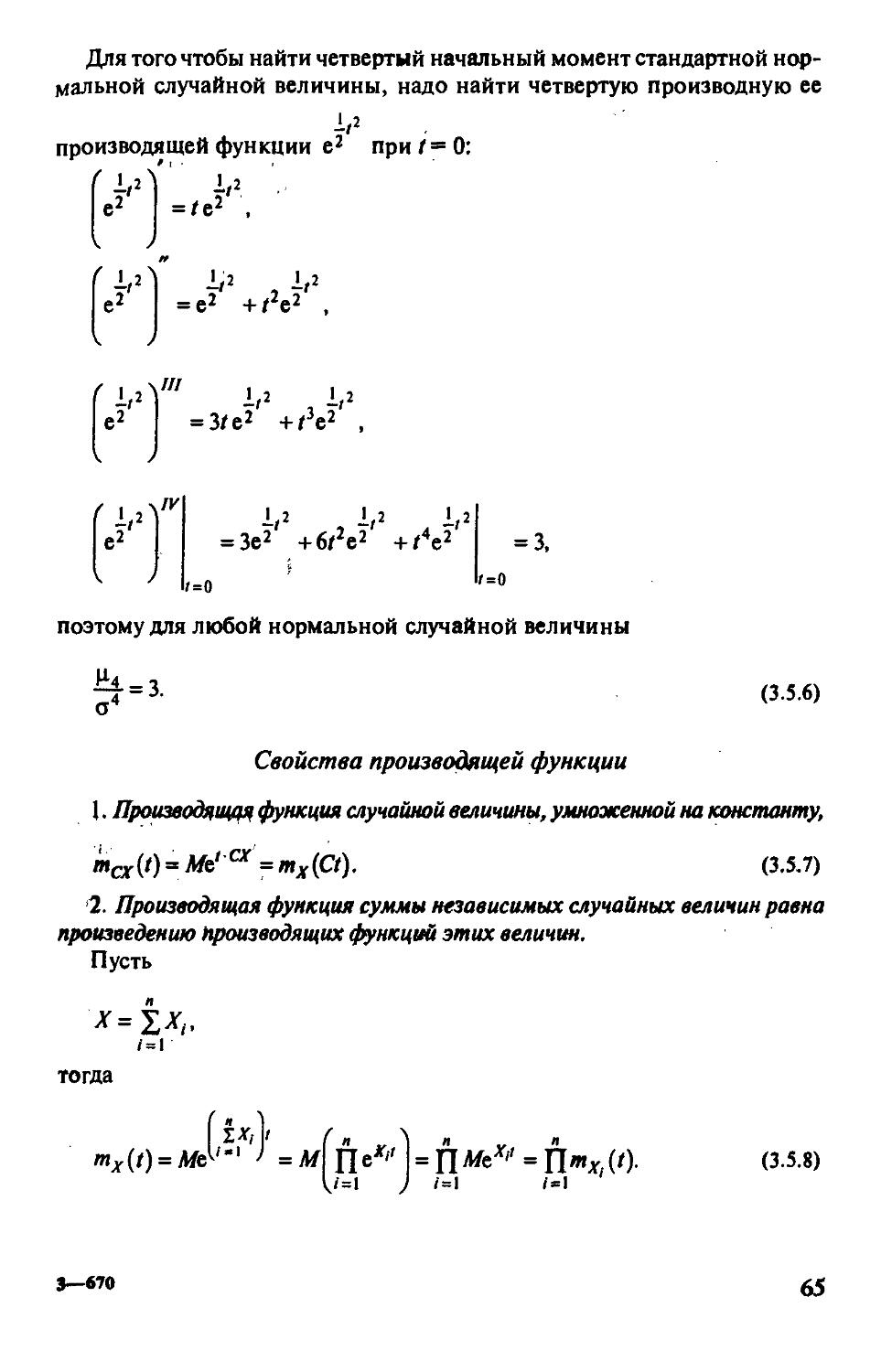

§ 3.5. Производящая функция и числовые характеристики

случайной величины 62

§ 3.6. Многомерные случайные величины 69

§ 3,7, Функции от случайных величин 80

Вопросы и задачи 86

DiaBa4. Предельные теоремы теории вероятностей 89

§4.1, Законы больших чисел 89

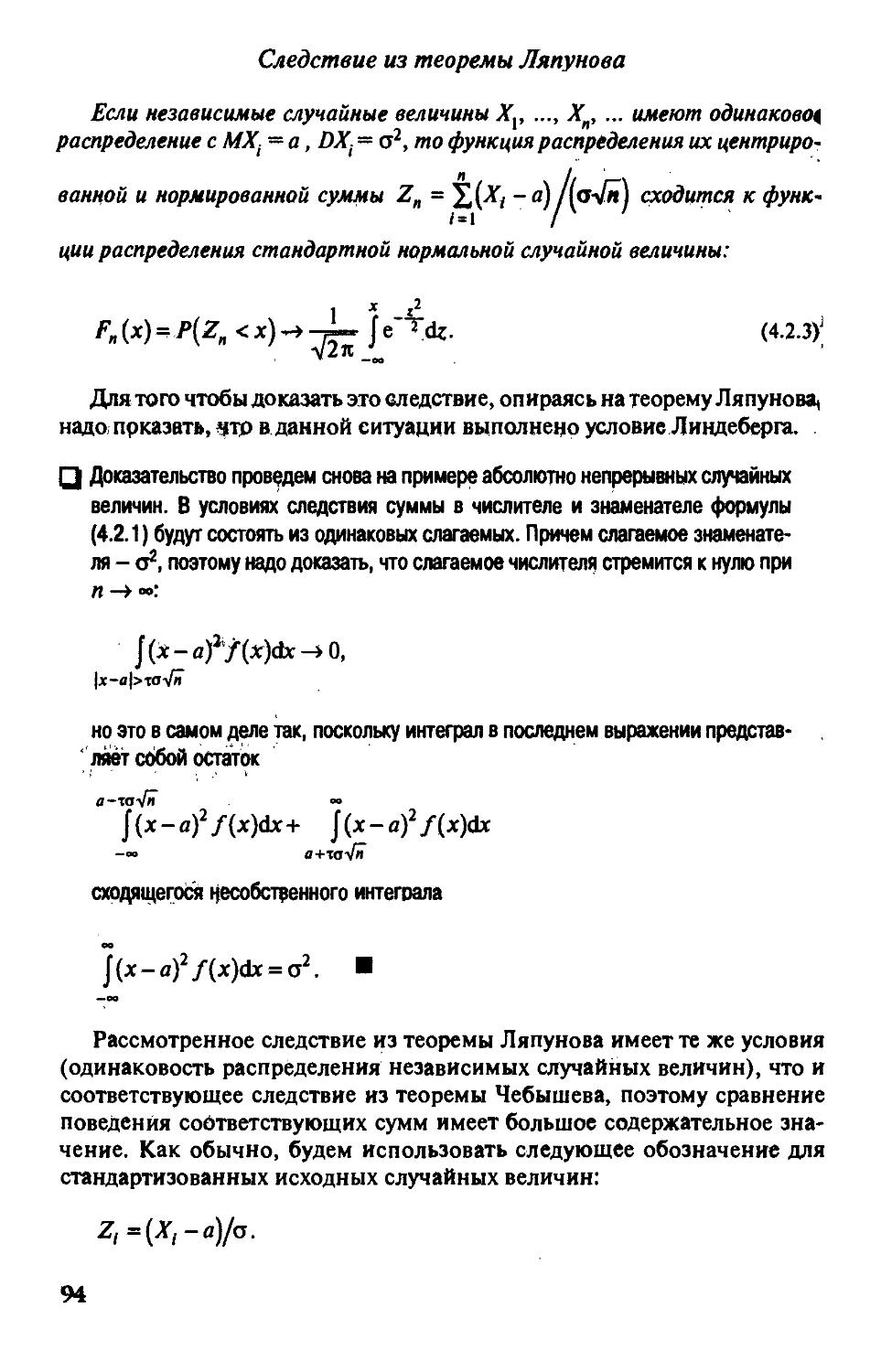

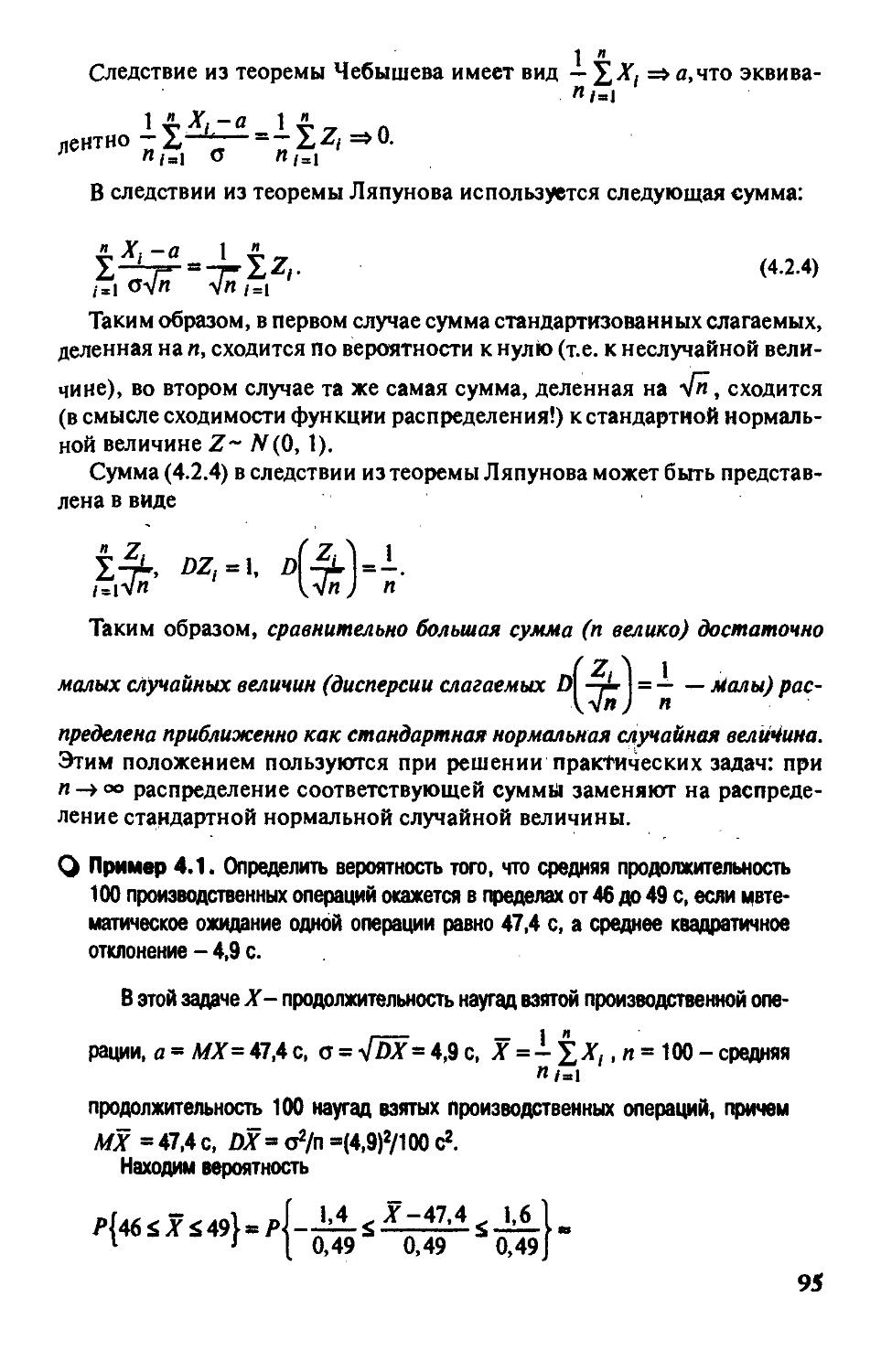

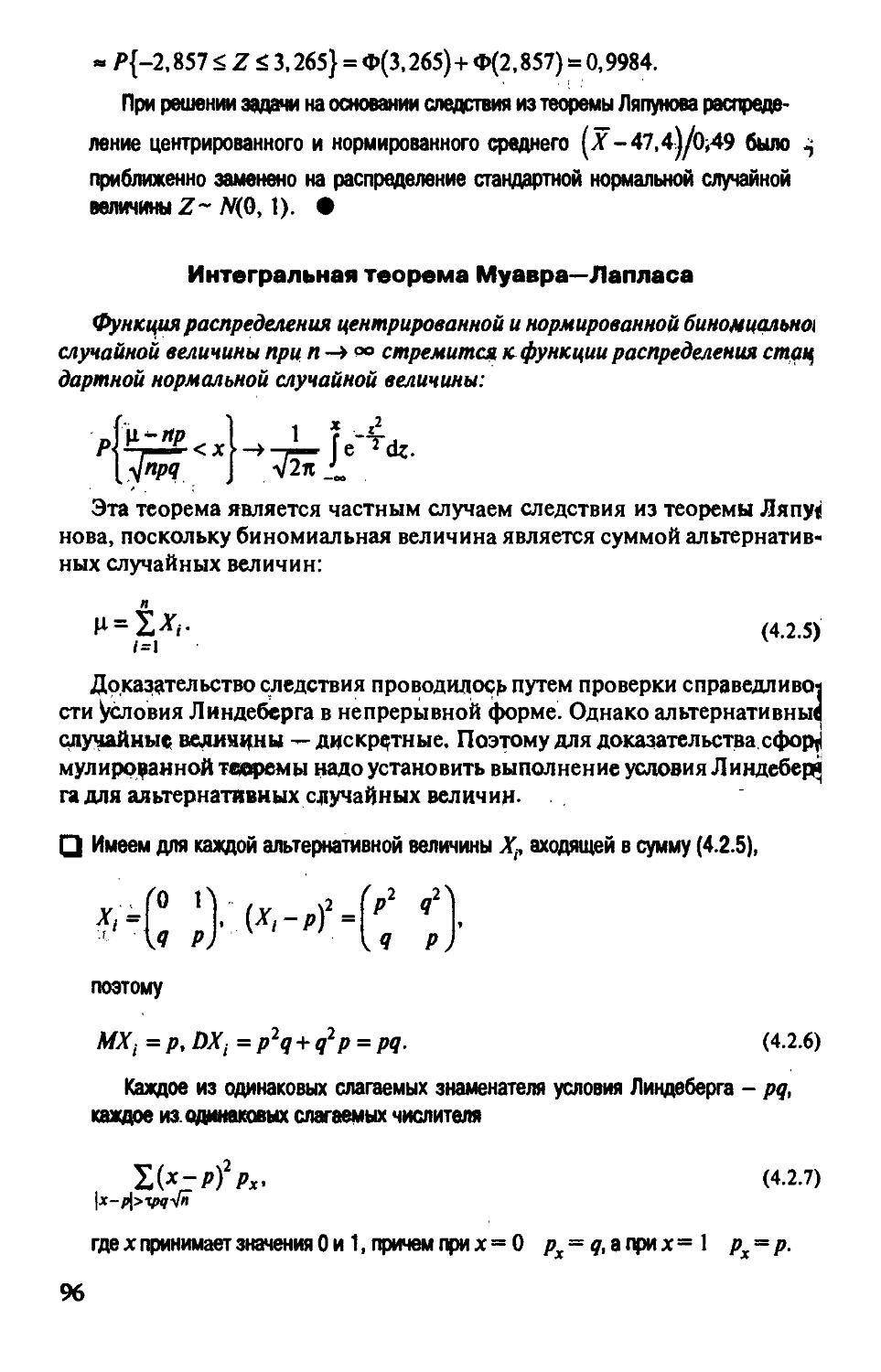

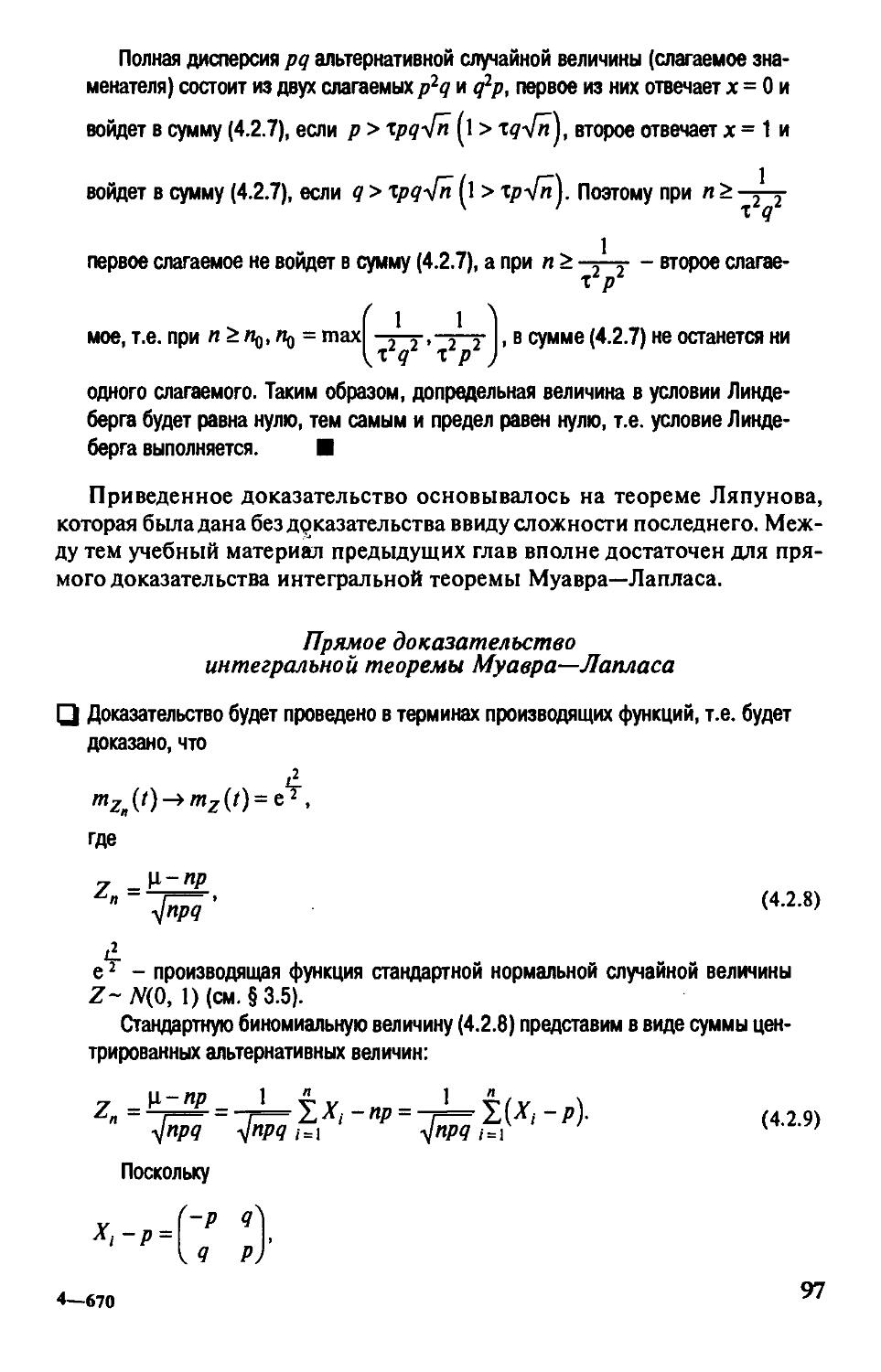

§ 4.2, Центральная предельная теорема 93

Вопросы и задачи 98

Гпава 5. Введение в теорию случайных процессов

и теорию массового обслуживания 100

§ 5,1. Случайные процессы и их виды 100

§ 5.2. Марковские случайные процессы с непрерывным временем

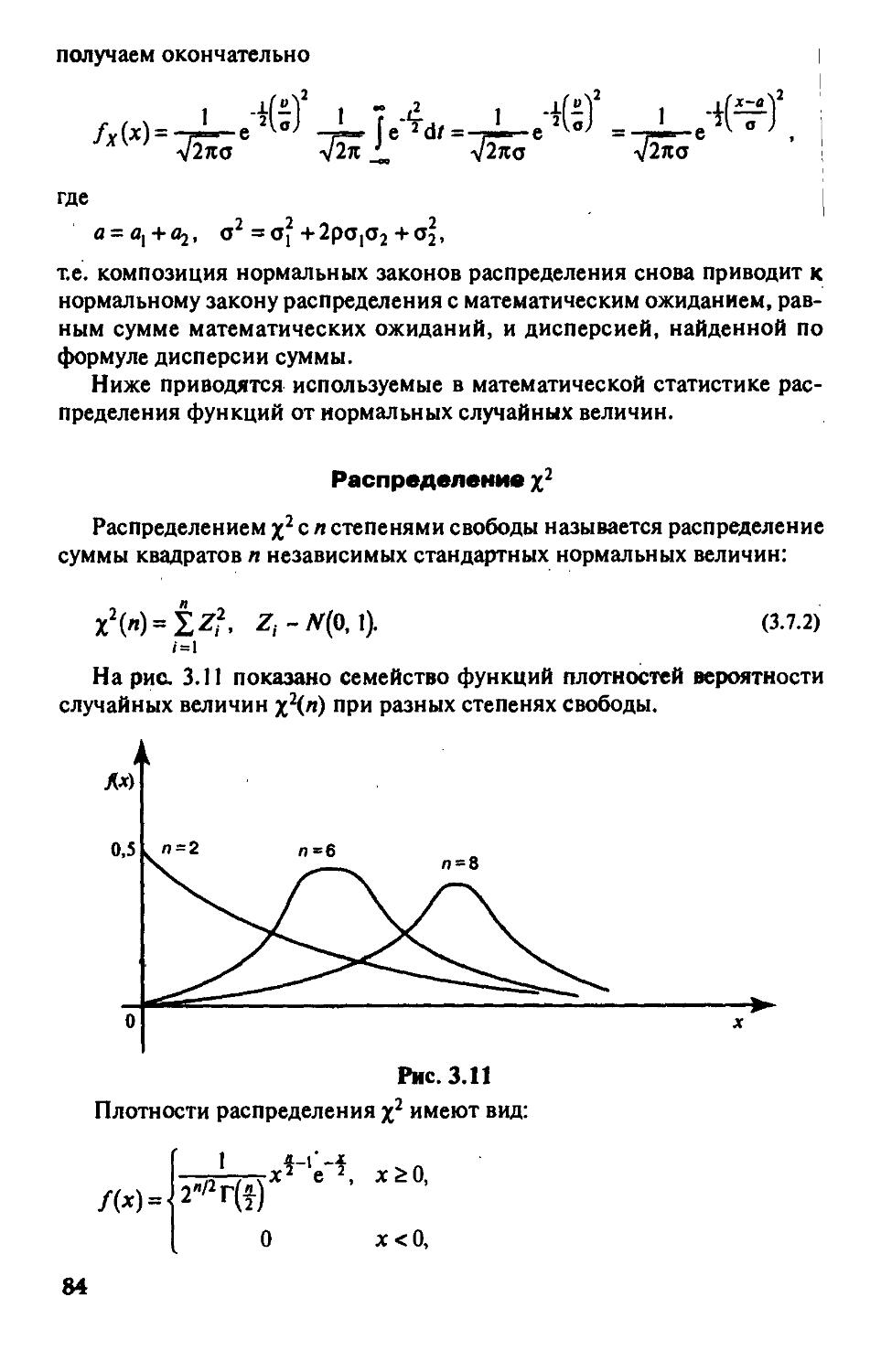

и дискретным множеством состояний 103

§ 5,3, Введение в теорию массового обслуживания 109

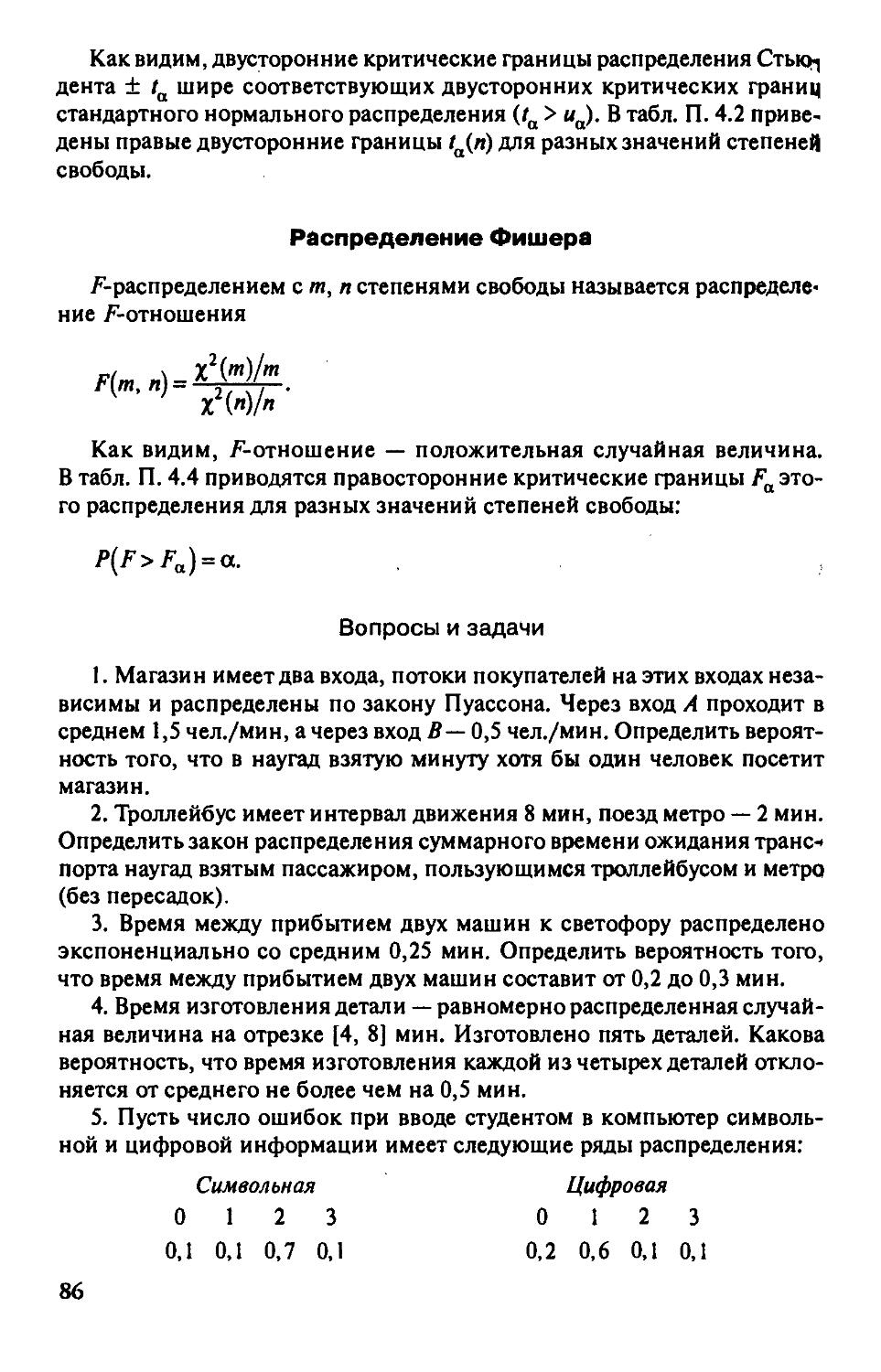

Вопросы и задачи 122

Часть 2. Математическая статистика 124

Гпава 6. Основы выборочного метода 125

§ 6.1. Оценка числовых характеристик случайных величин 125

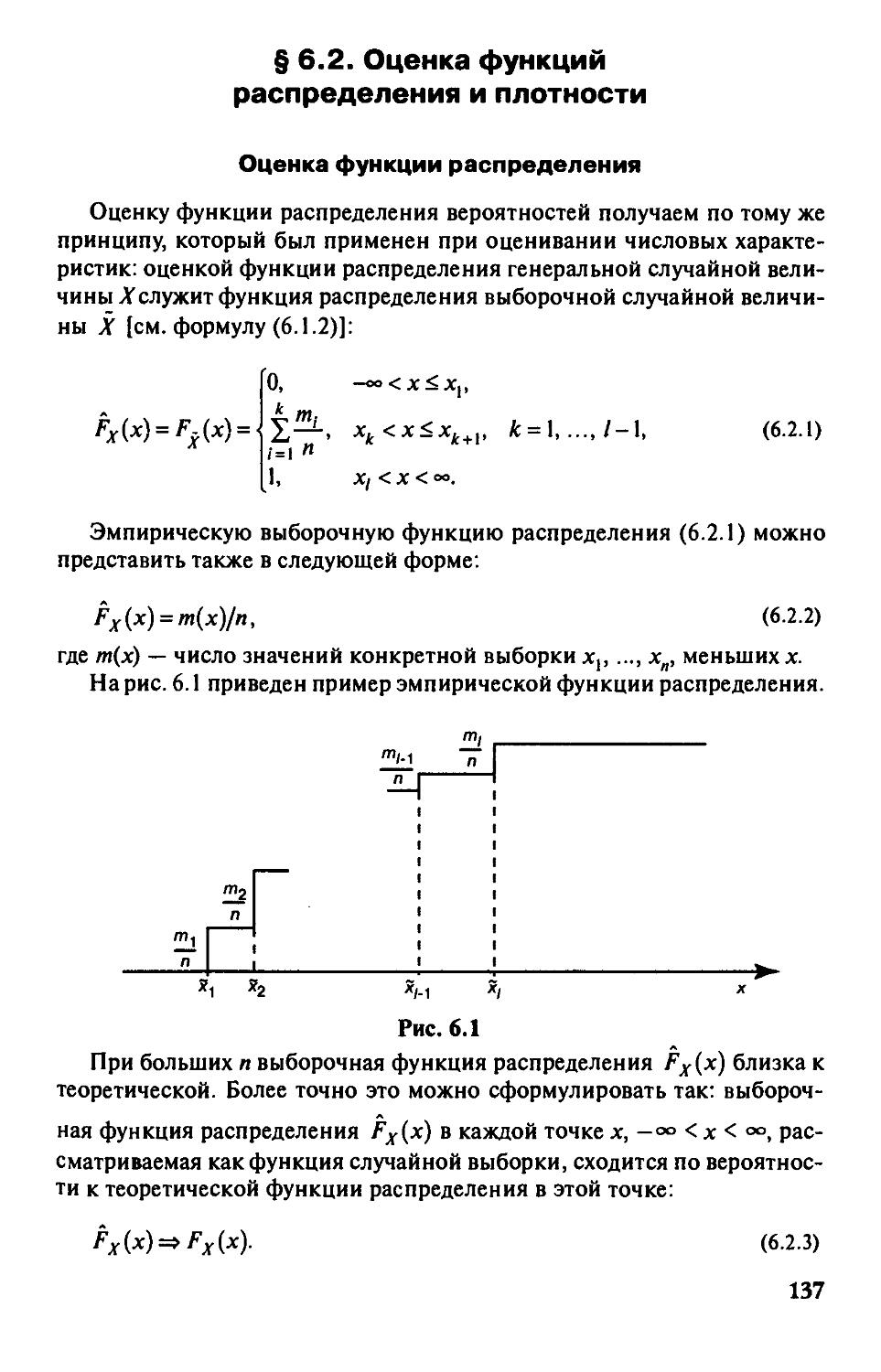

§ 6.2. Оценка функций распределения и плотности 137

Вопросы и задачи 139

Гпава 7. Точечные и интервальные оценки параметров распределений 141

§ 7.1. Метод моментов 141

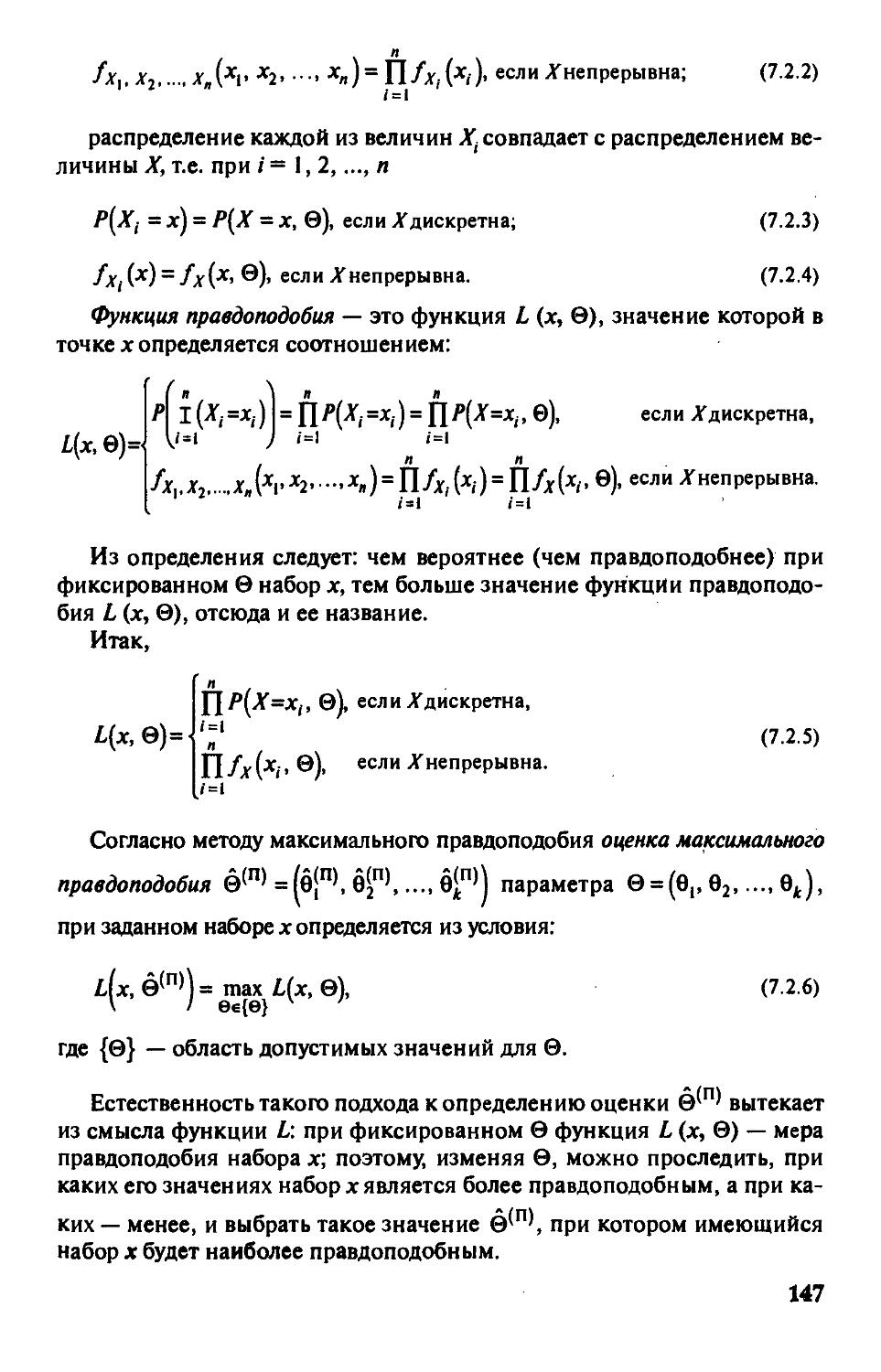

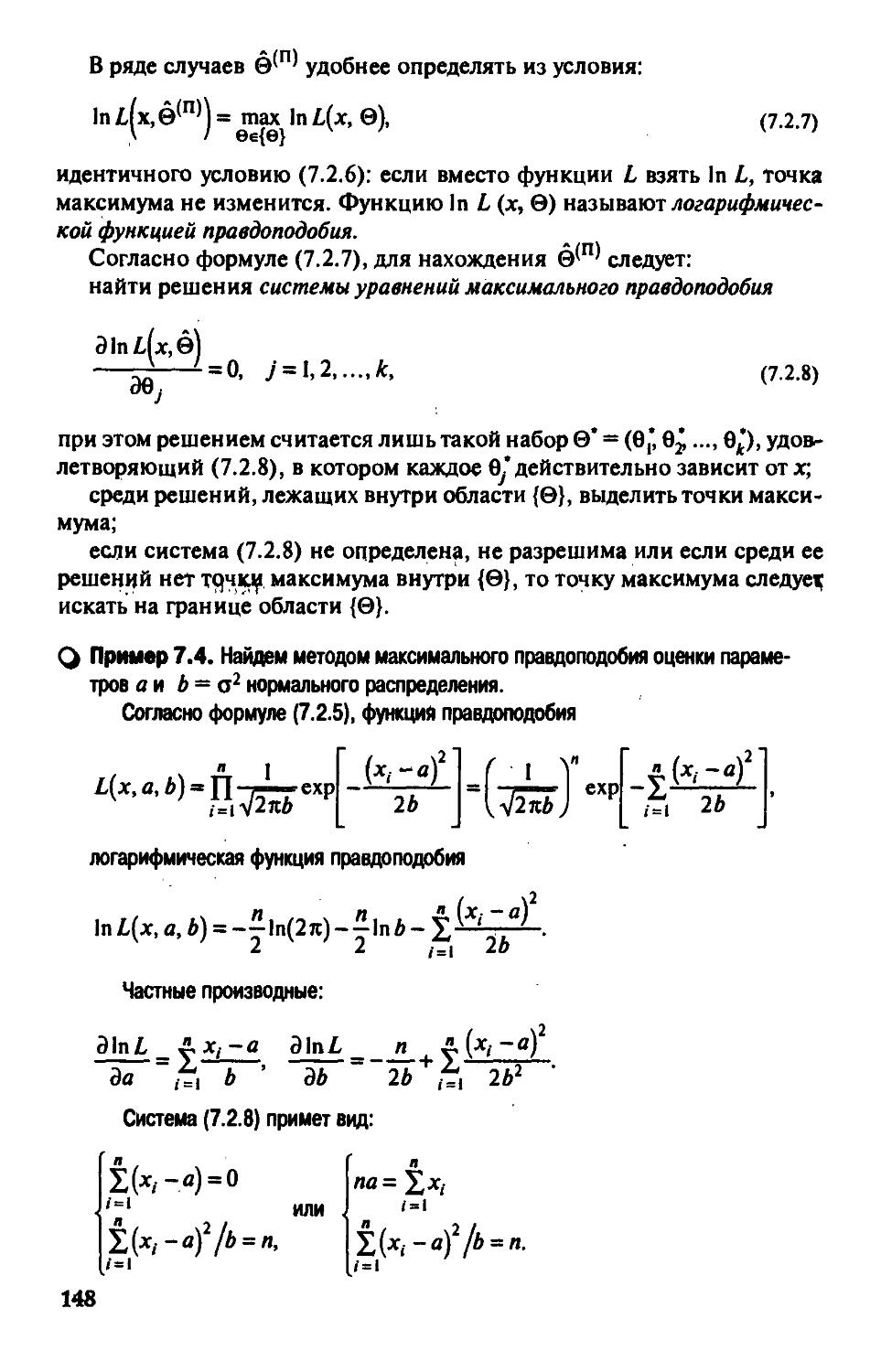

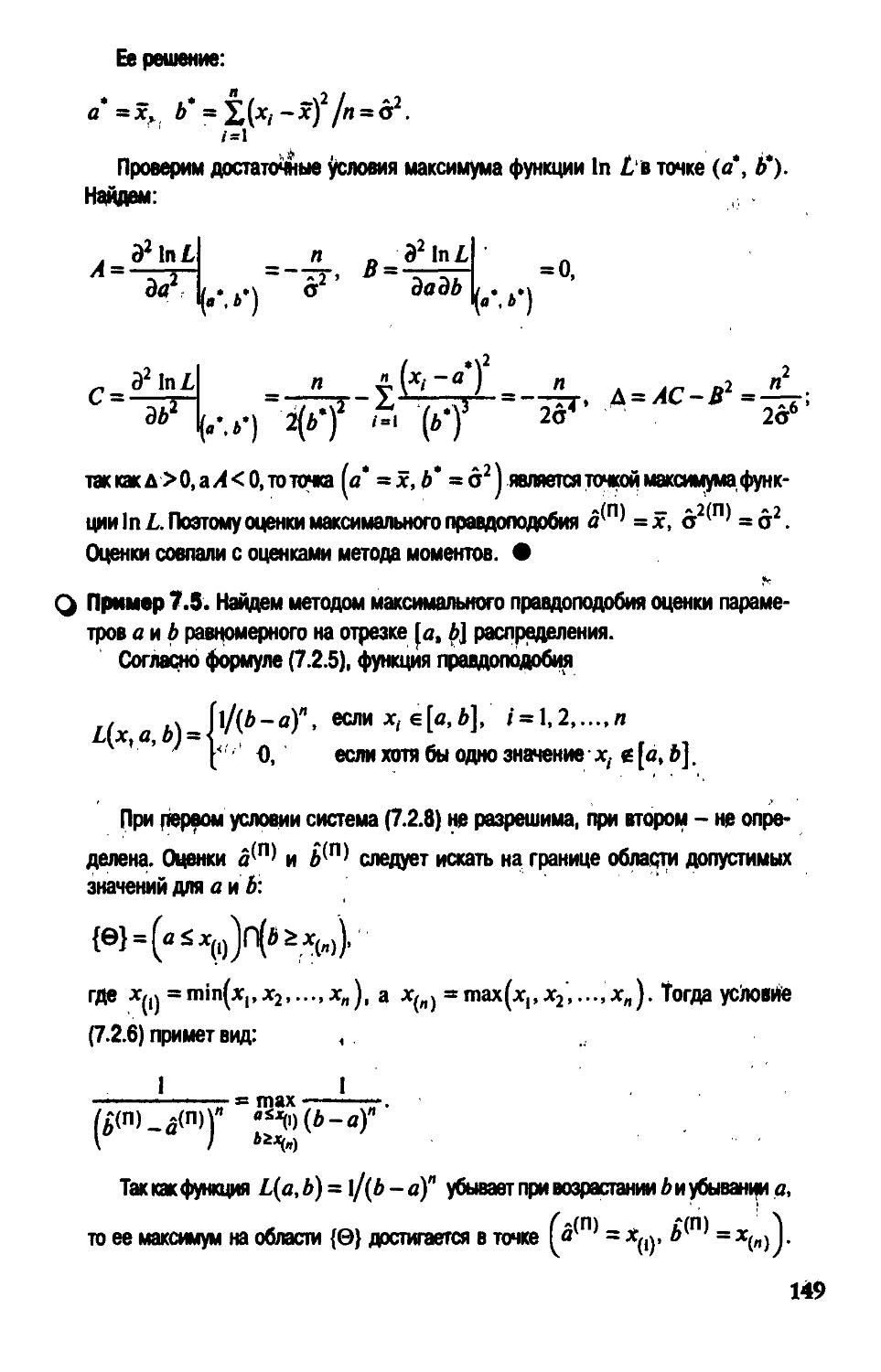

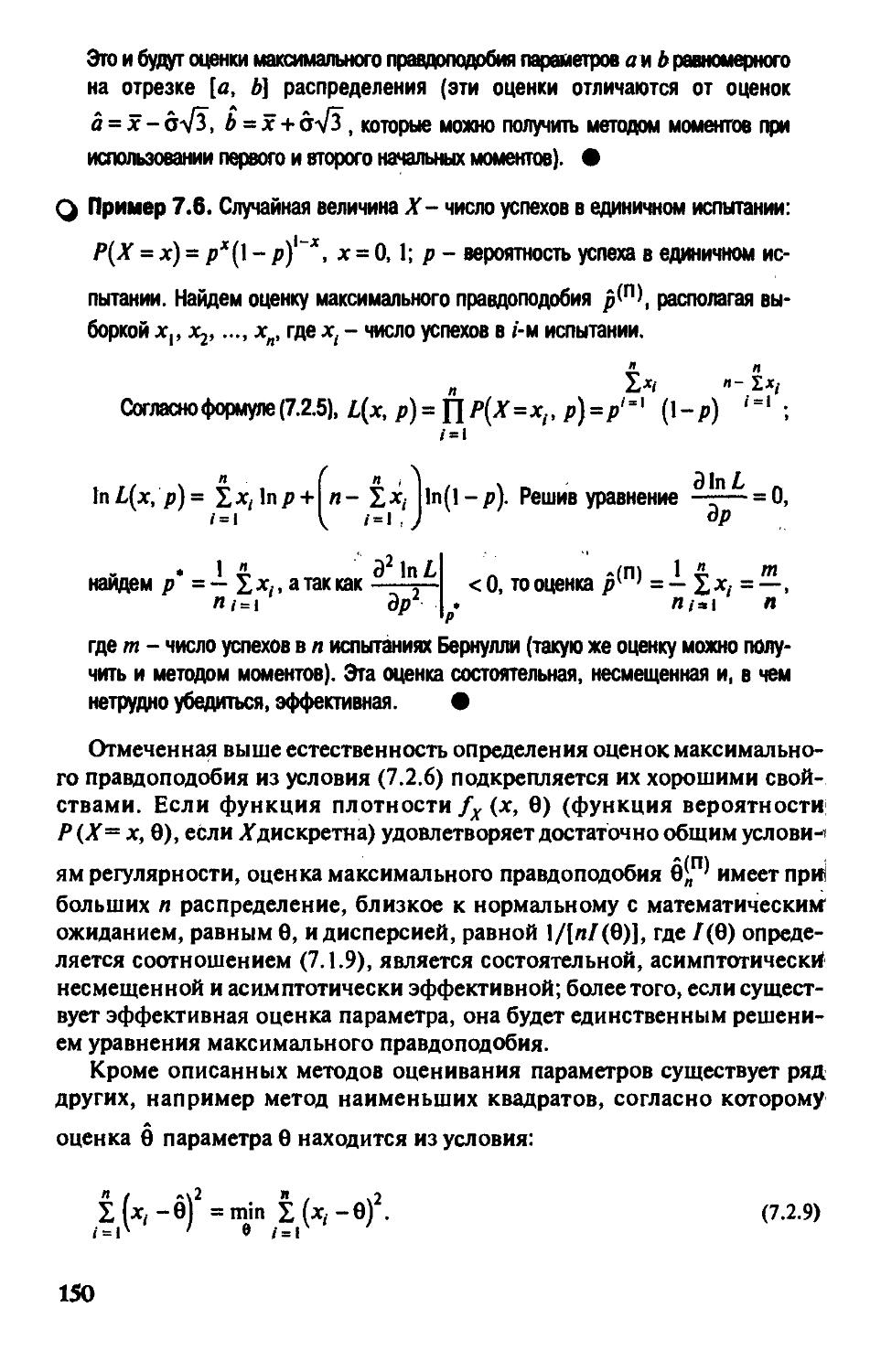

§ 7.2. Метод максимального правдоподобия 146

§ 7.3. Понятие интервальной оценки. Интервальные оценки

параметров нормального распределения 151

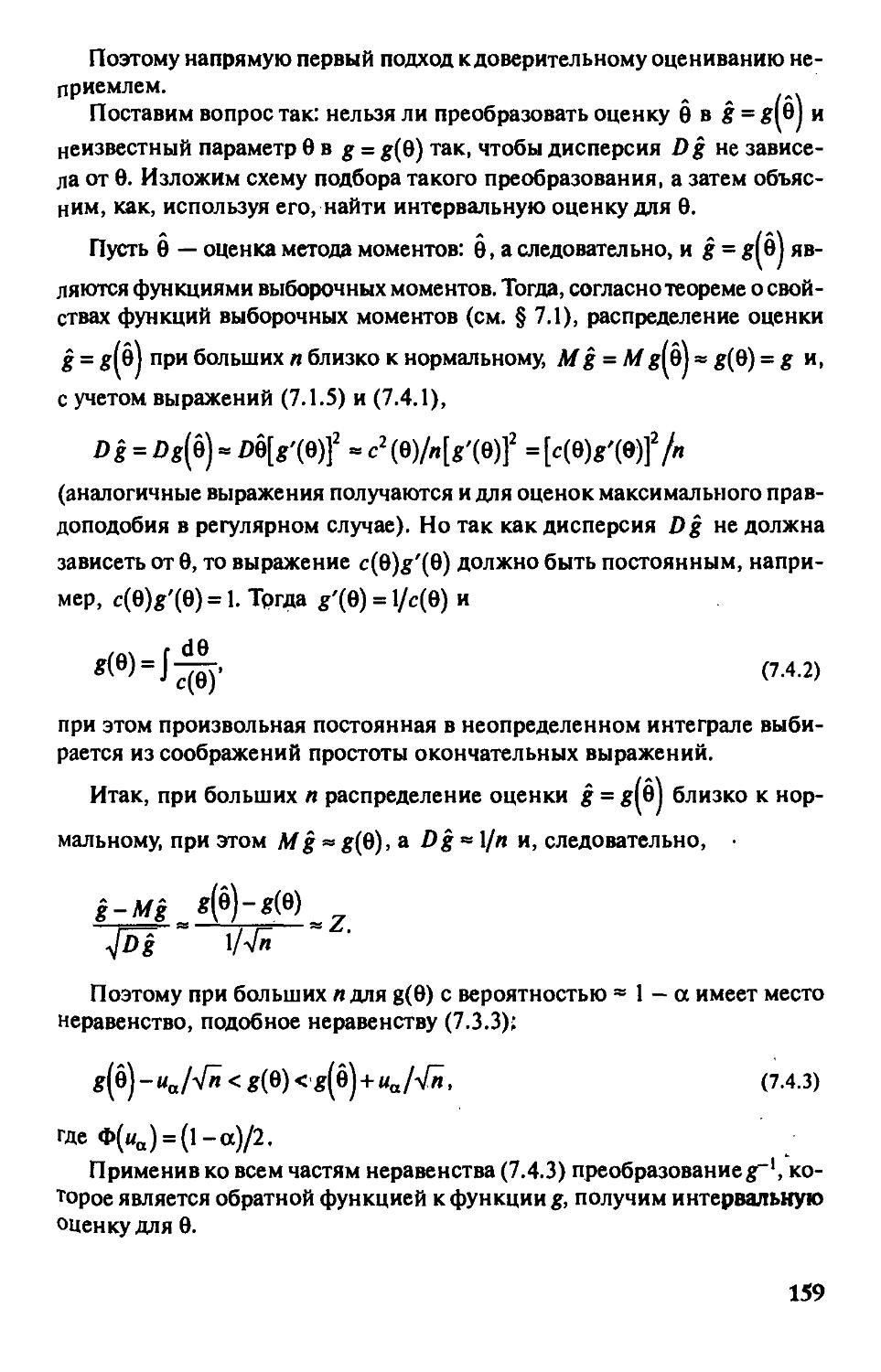

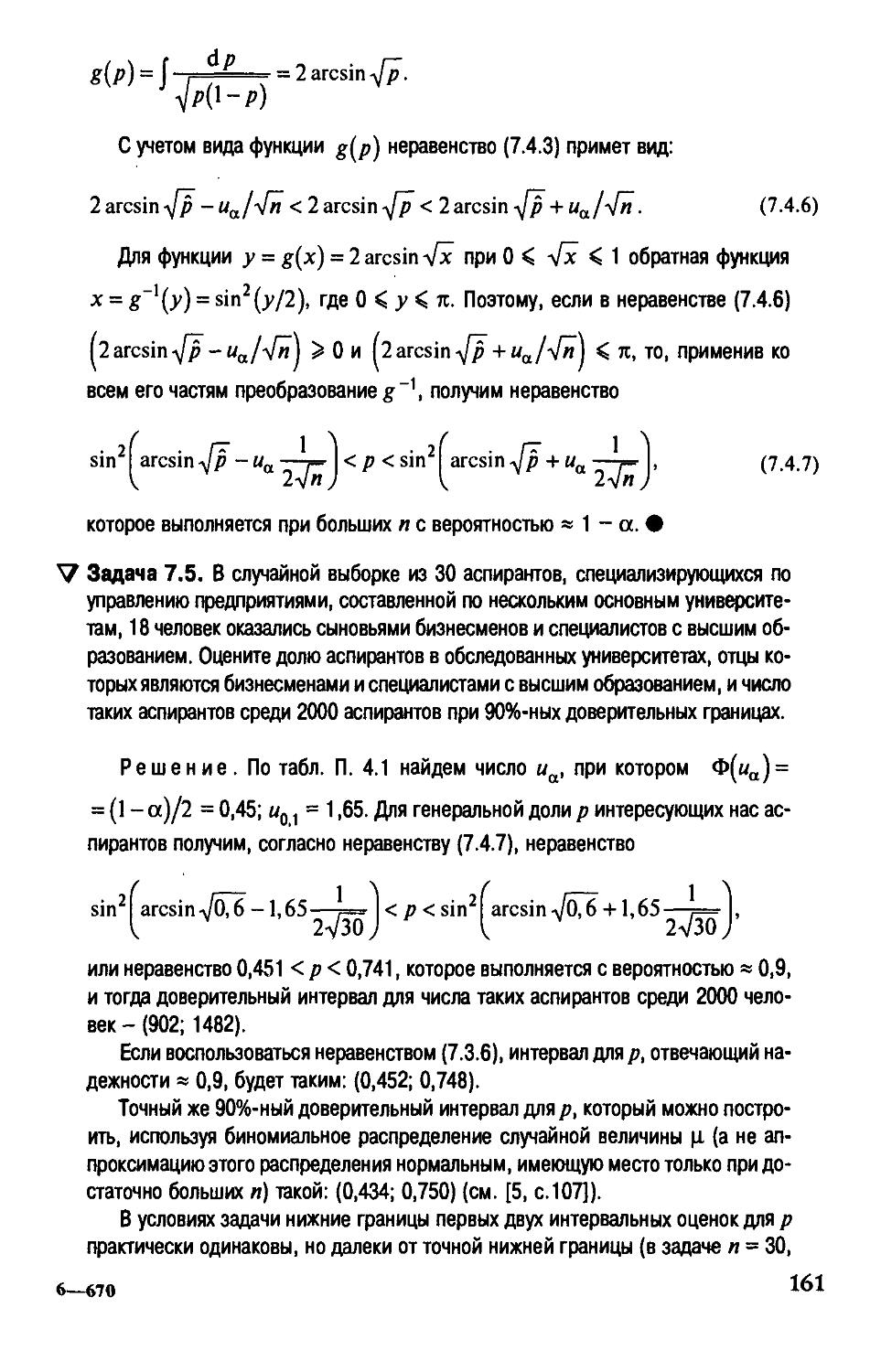

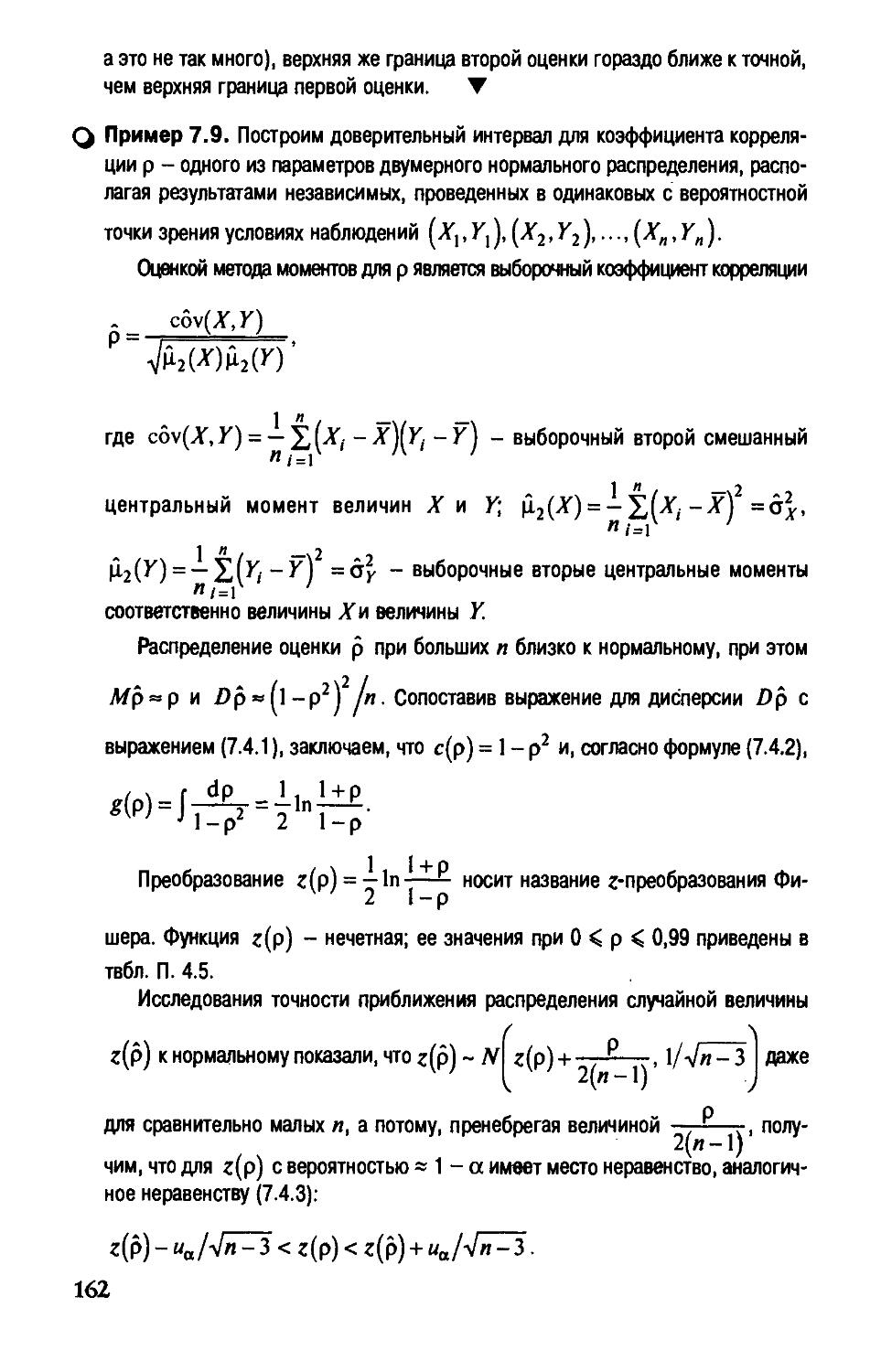

§ 7.4. Асимптотический подход к интервальному оцениванию 158

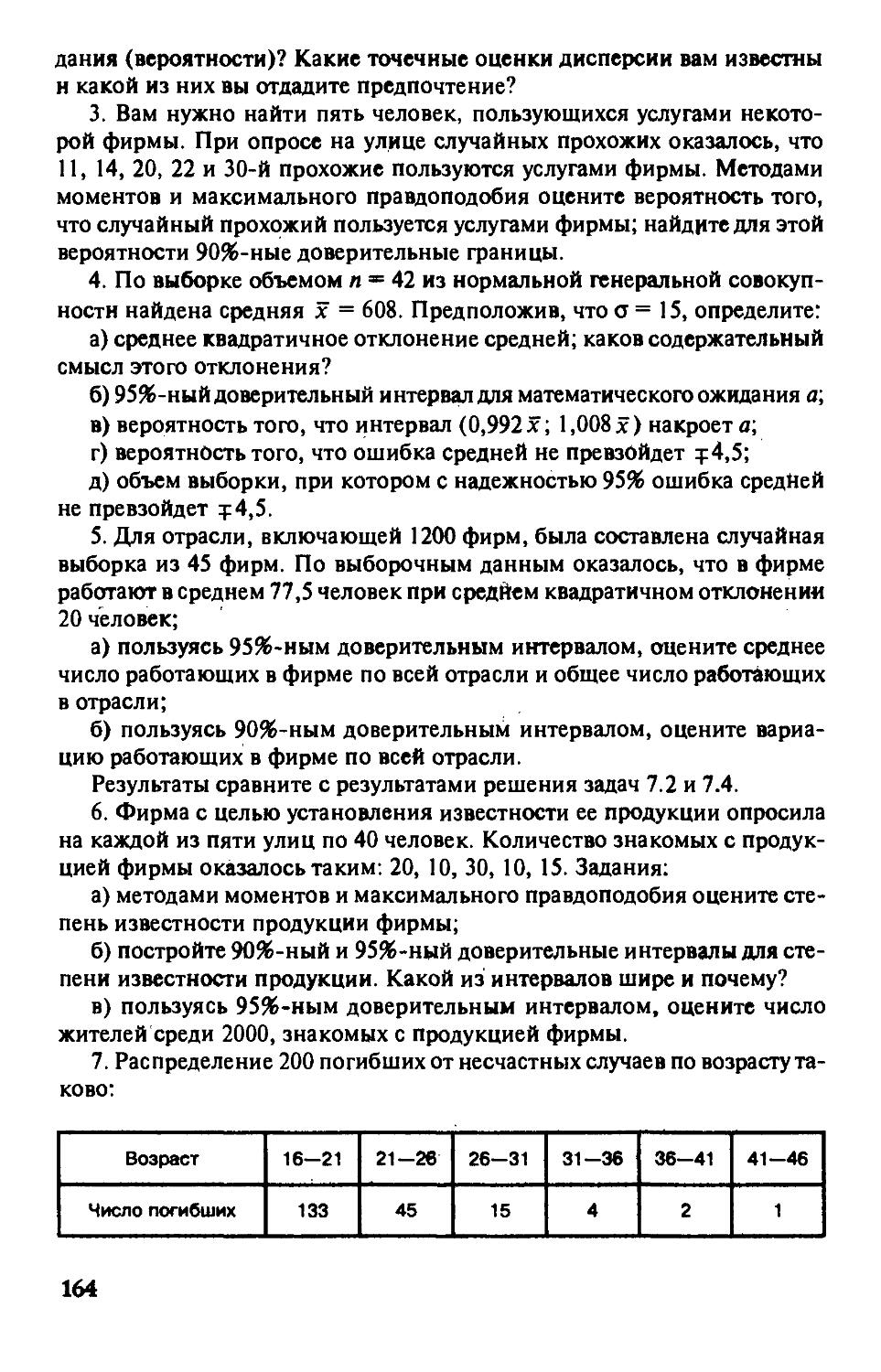

Вопросы и задачи 163

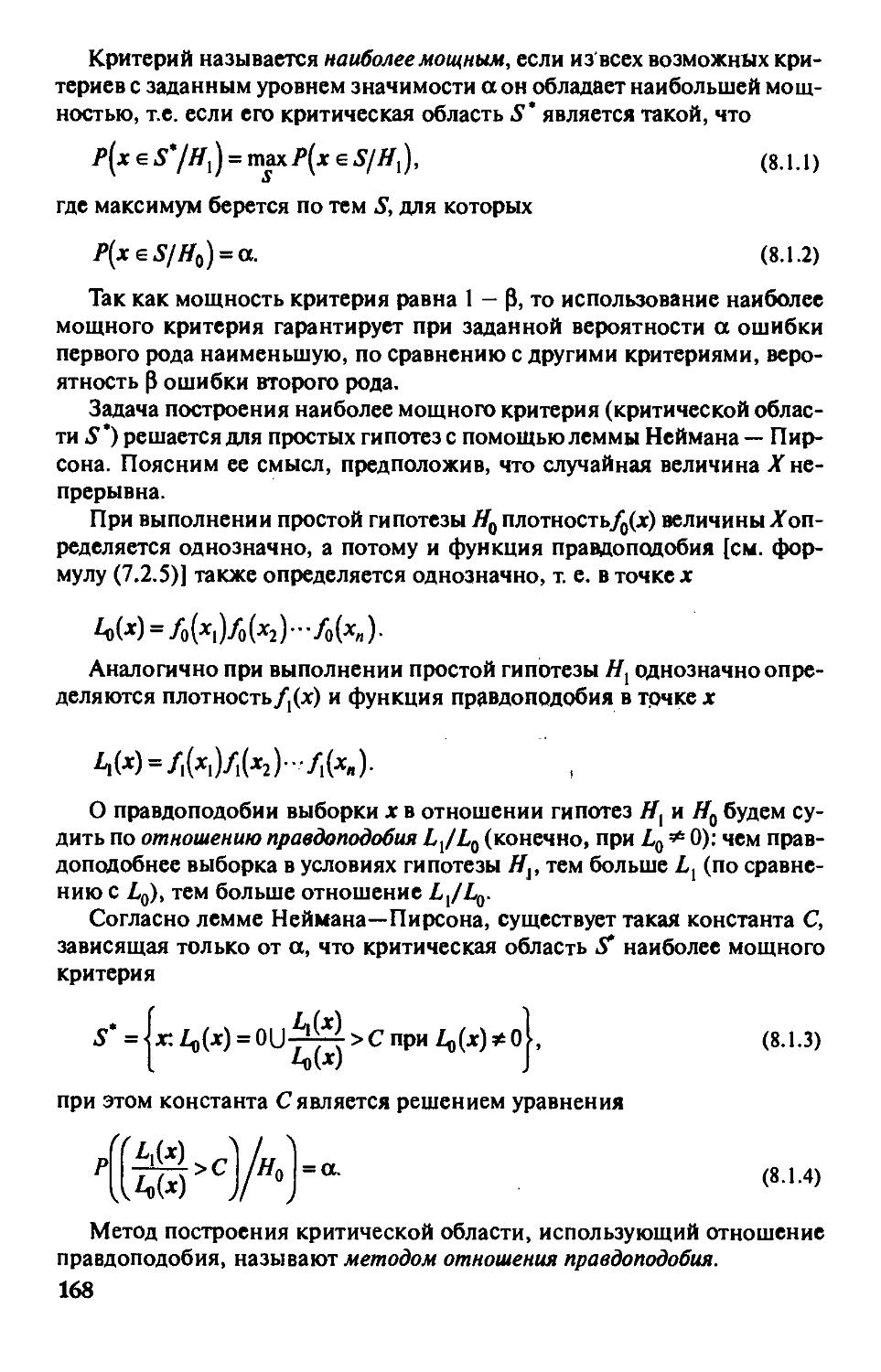

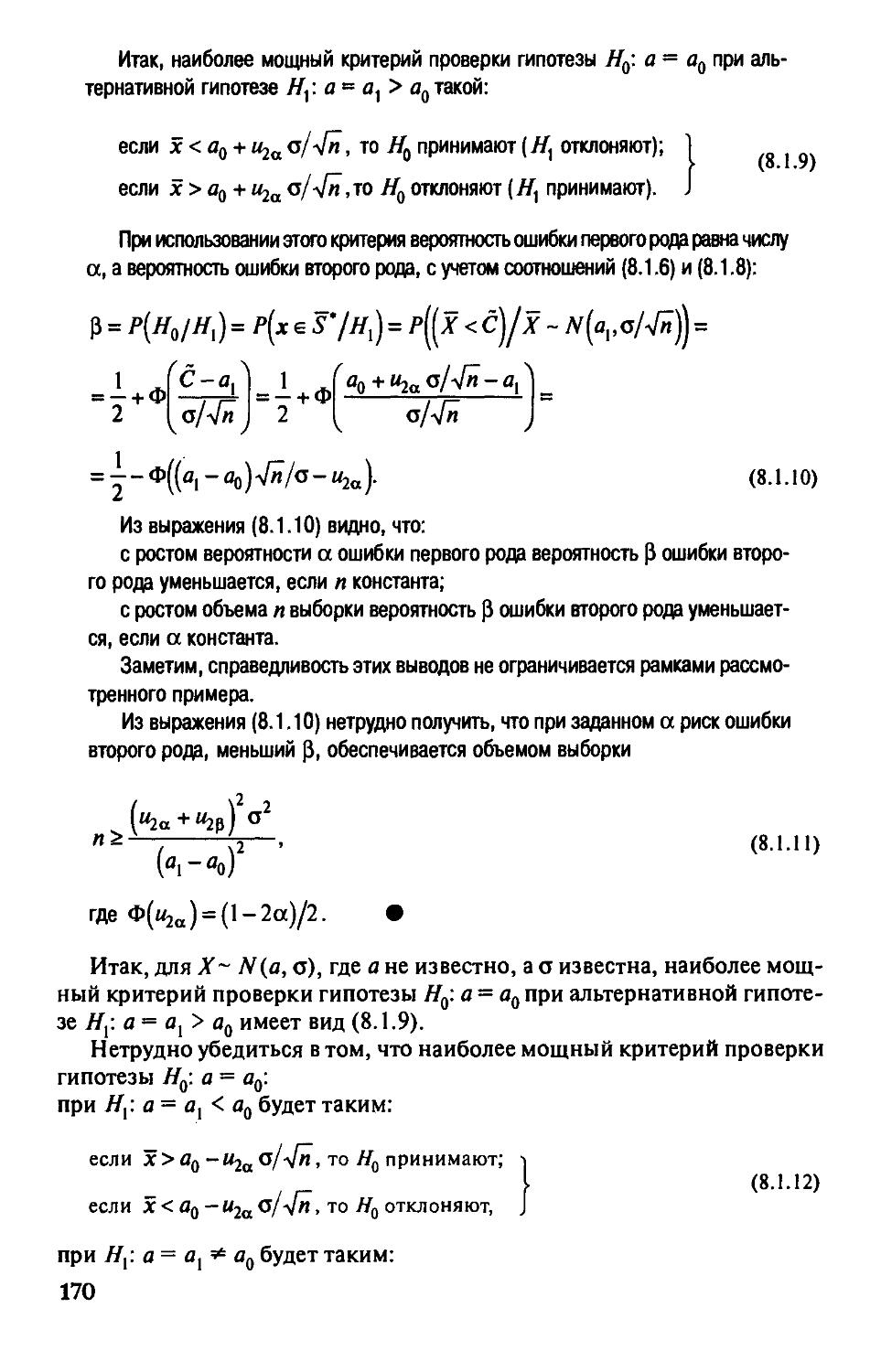

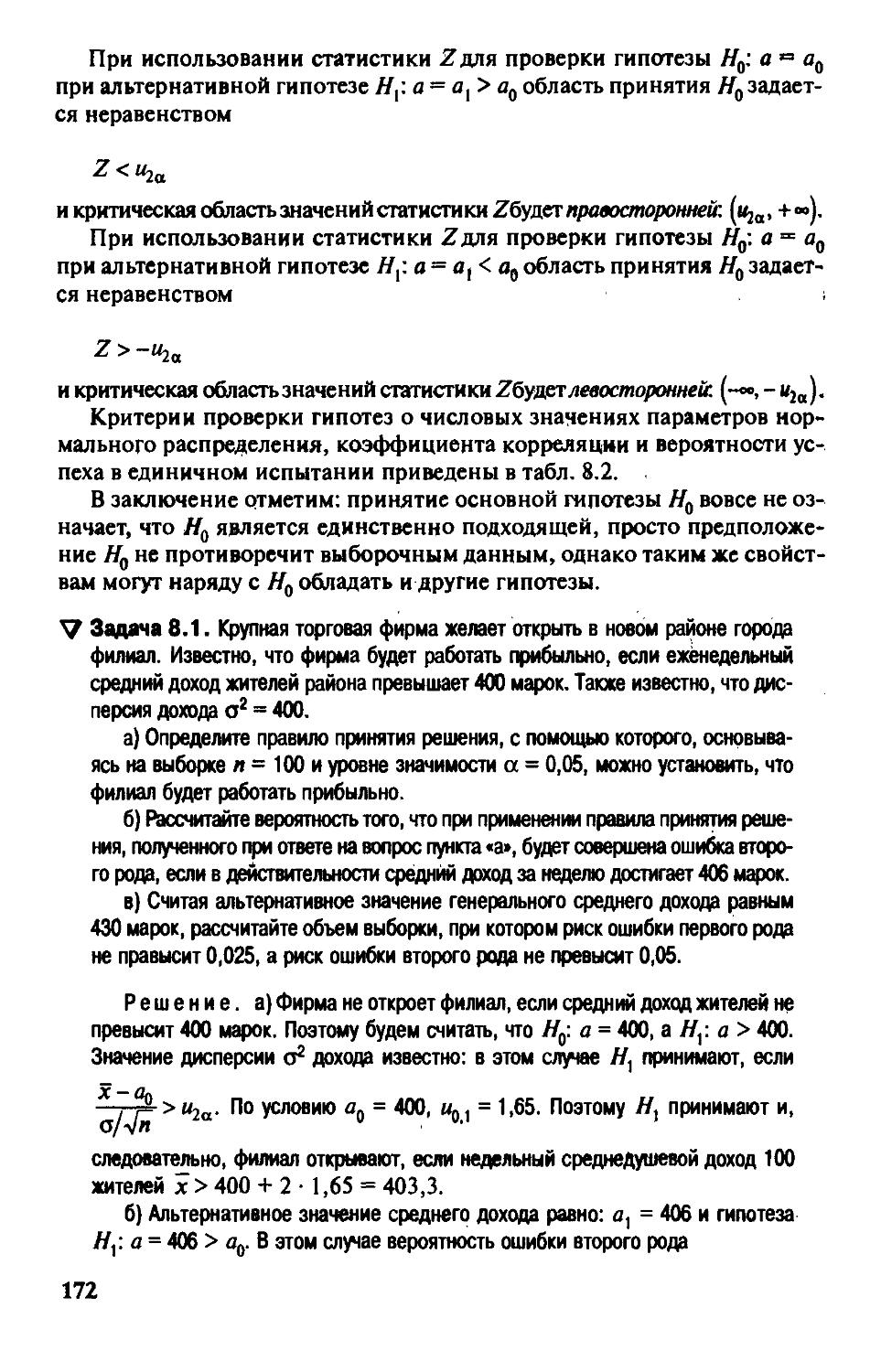

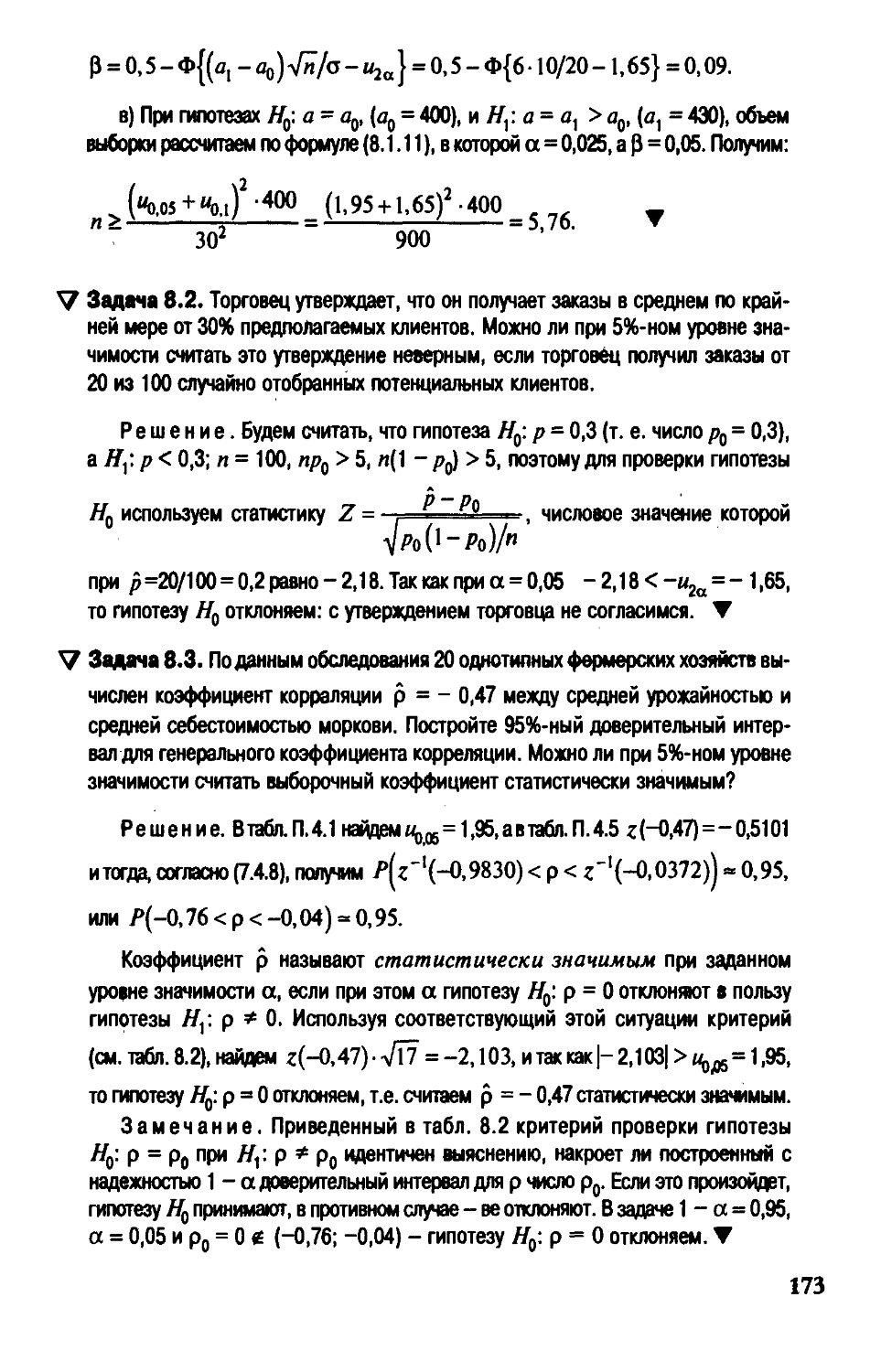

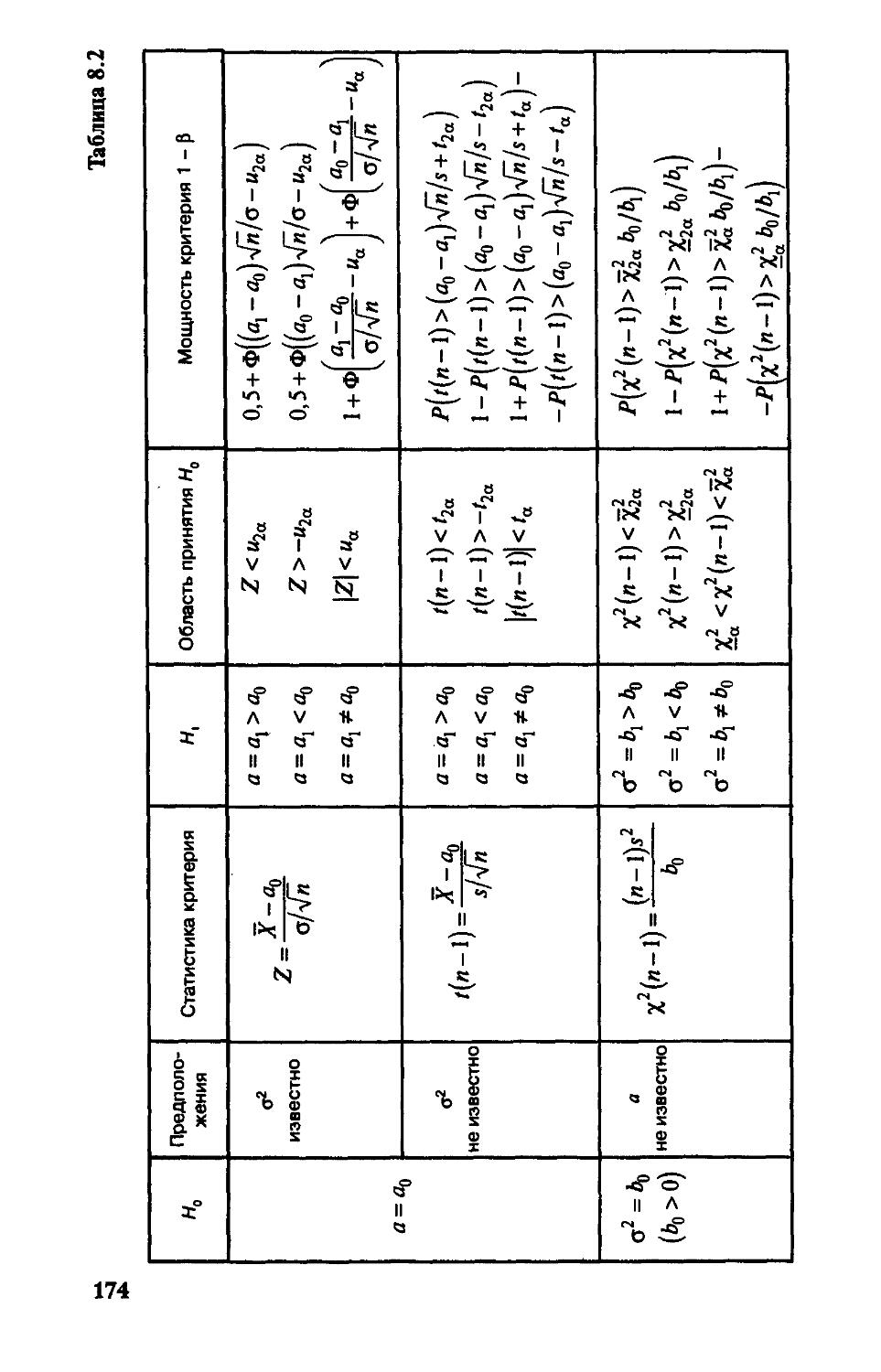

ГпаваЗ. Проверка гипотез 166

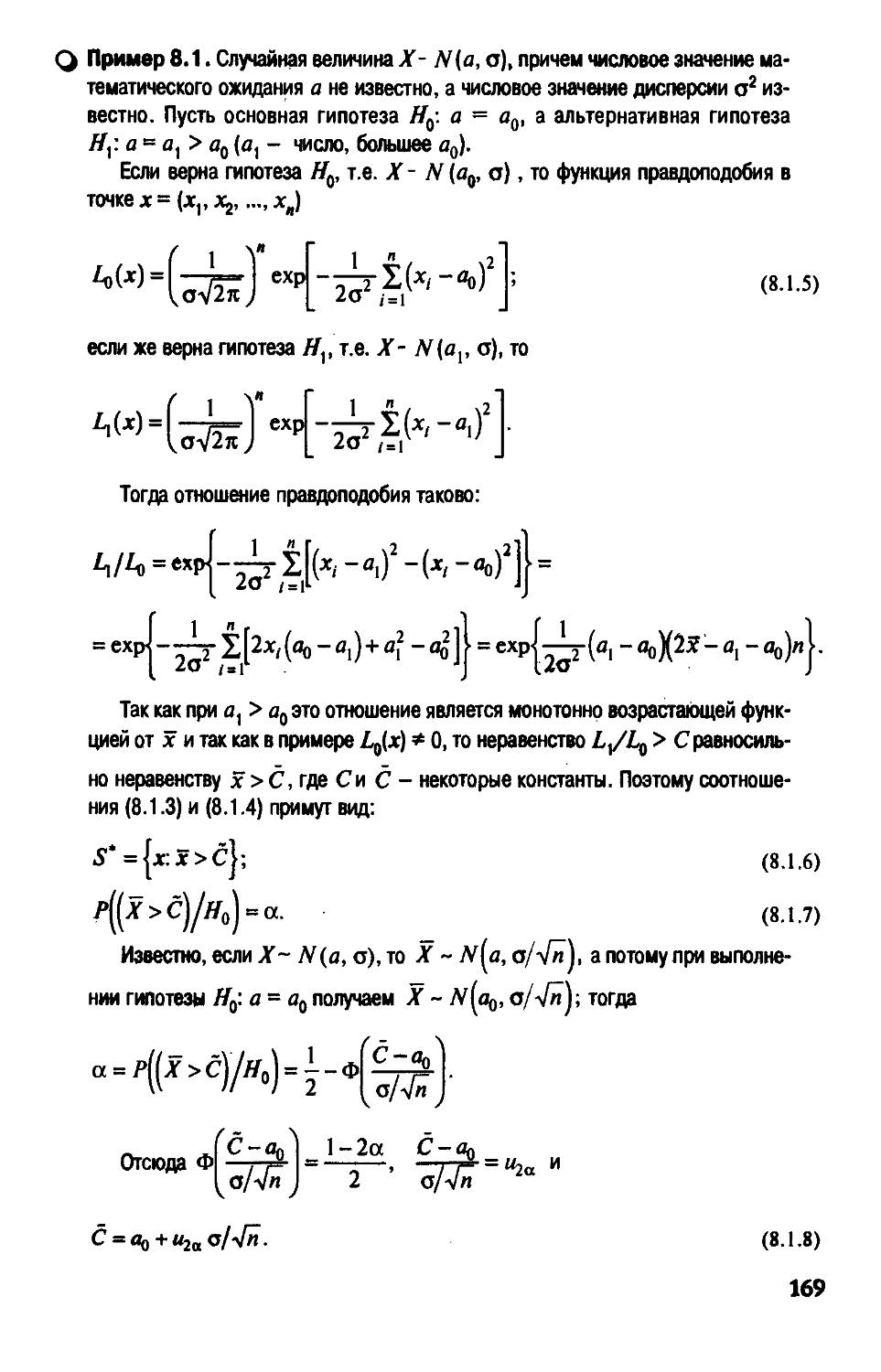

§ 8.1. Основные понятия проверки гипотез.

Гипотезы о параметрах нормального распределения 166

§ 8.2. Гипотезы о равенстве средних и дисперсий

двух нормальных распределений 176

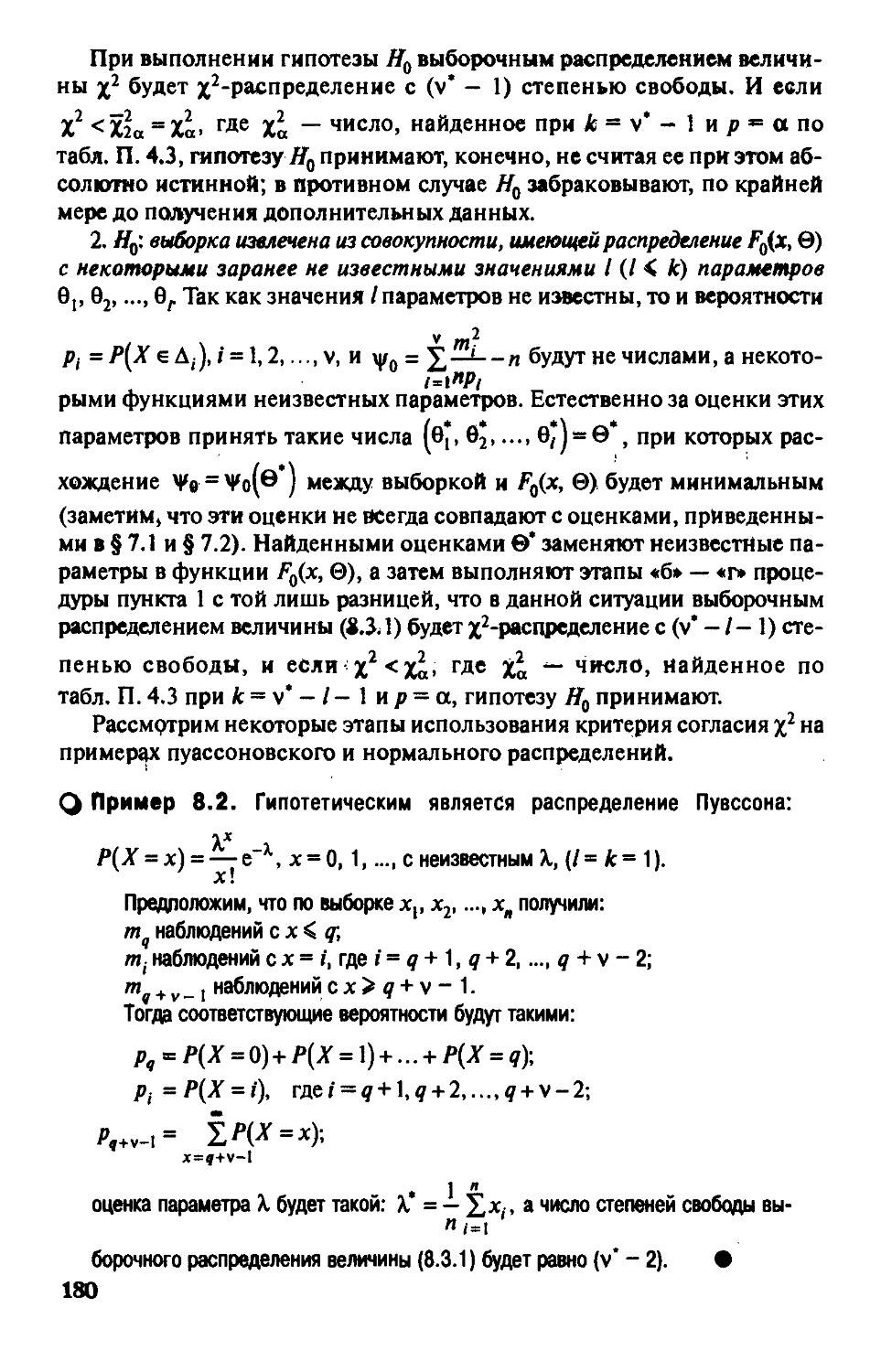

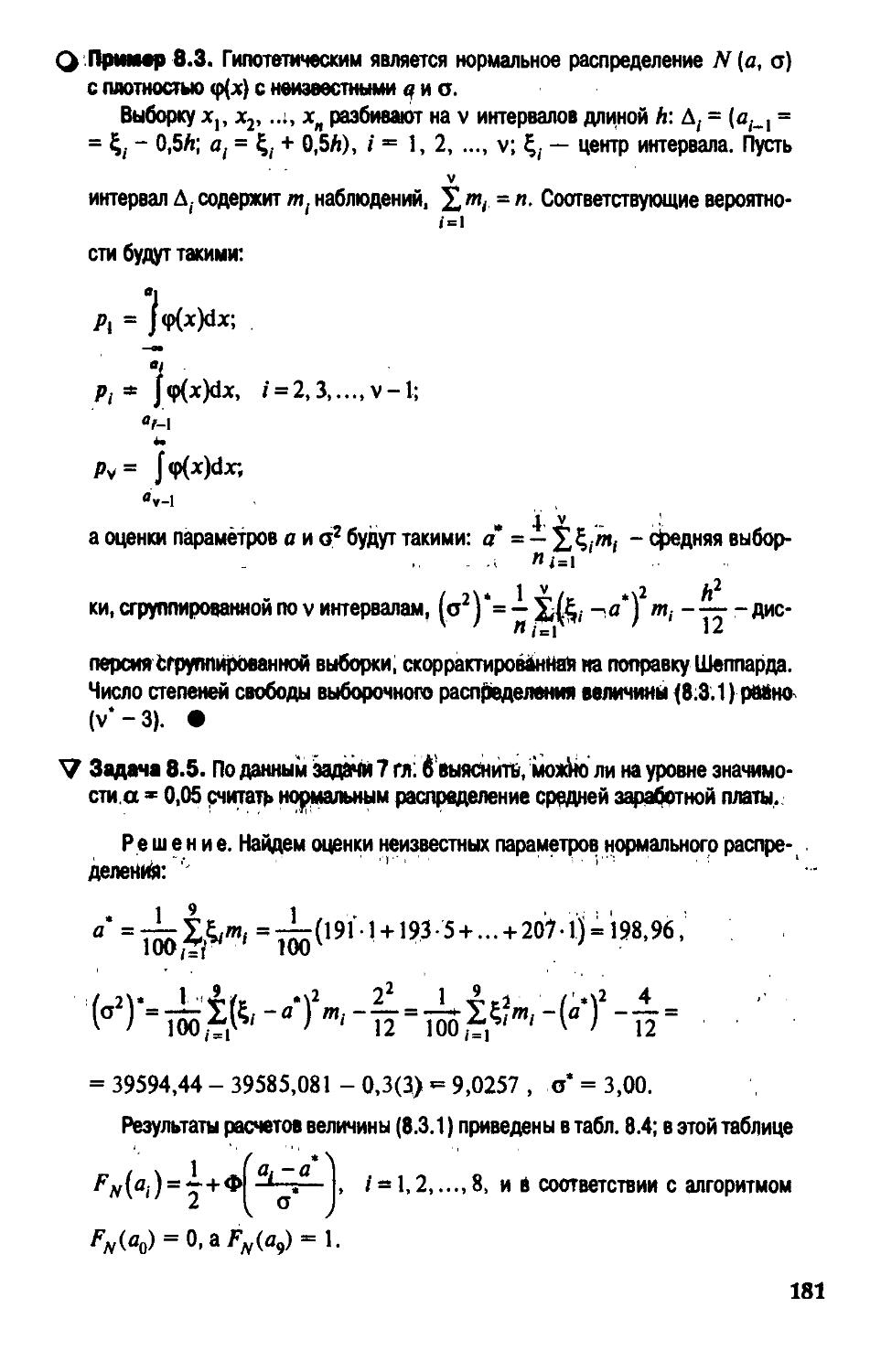

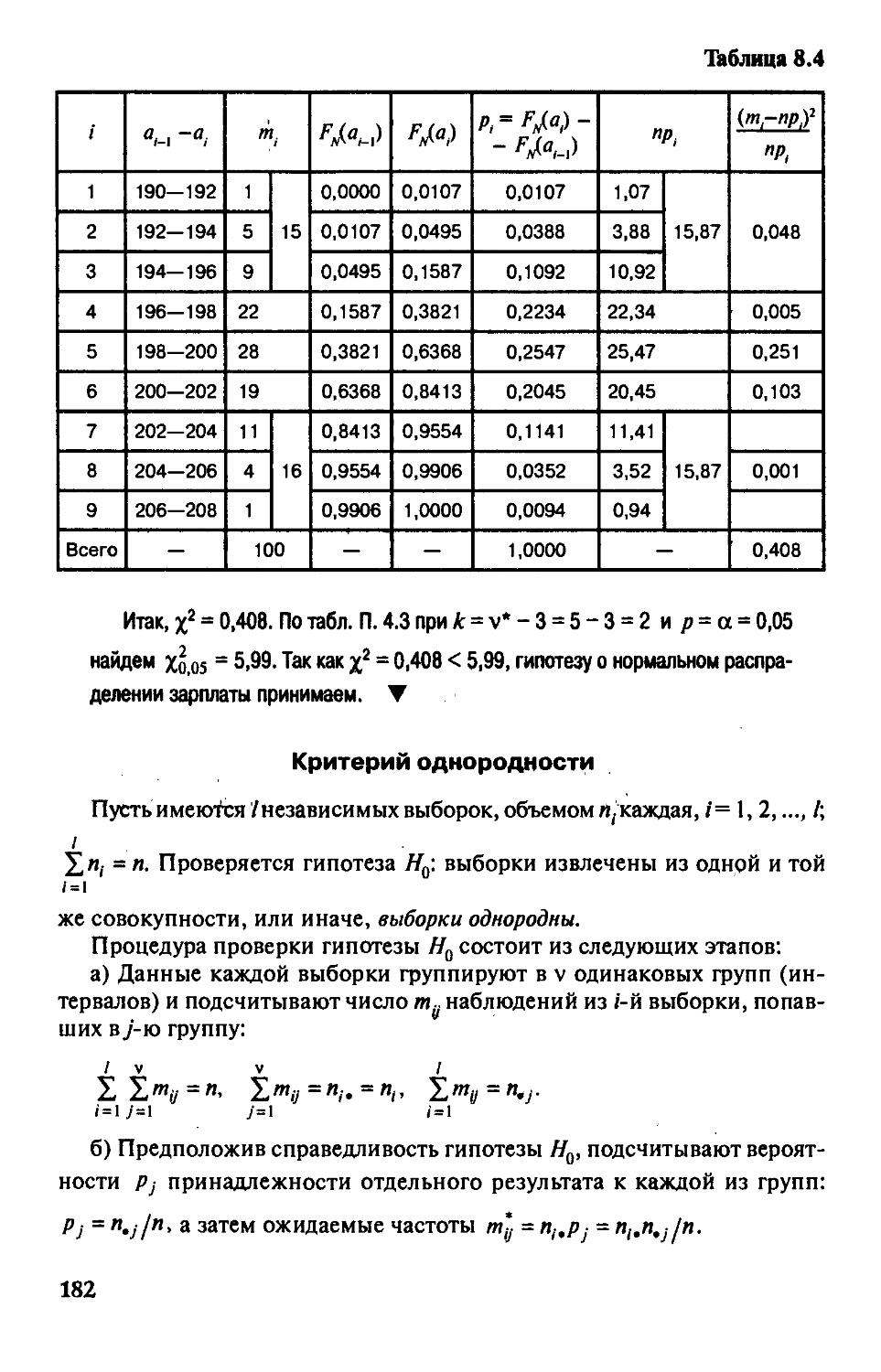

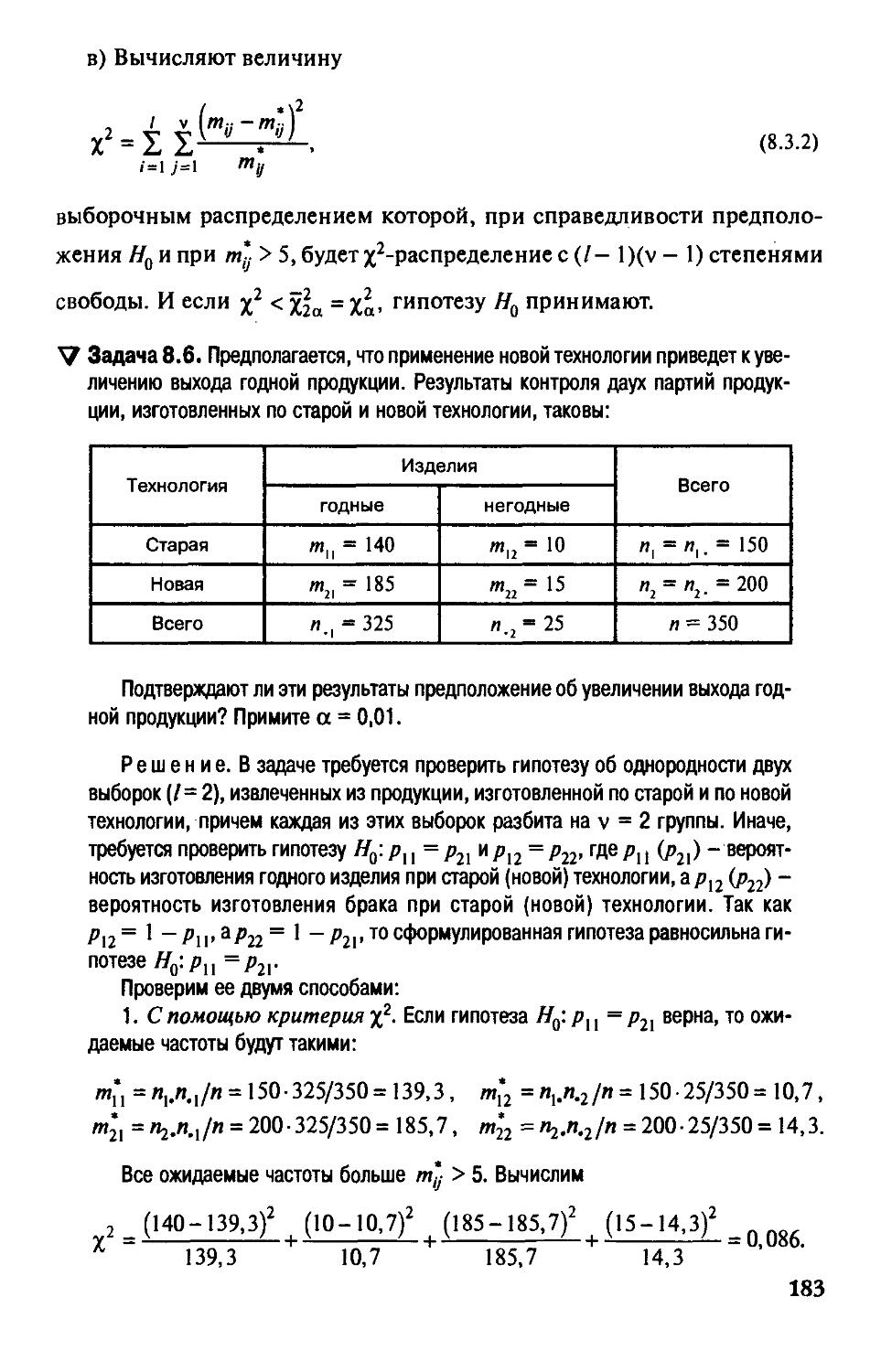

§ 8.3. Критерии согласия 179

§ 8.4. Введение в дисперсионный анализ 184

Вопросы и задачи 192

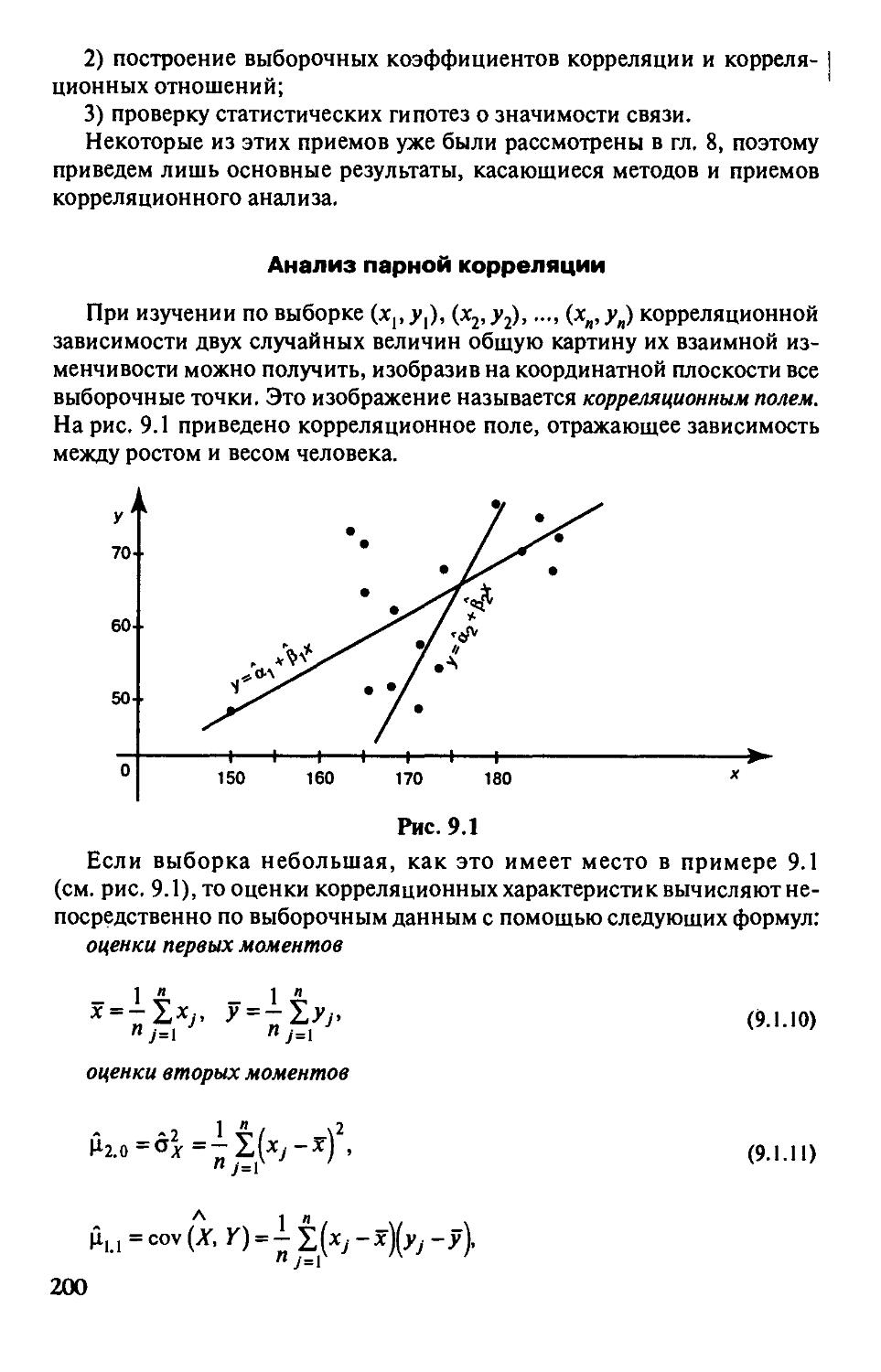

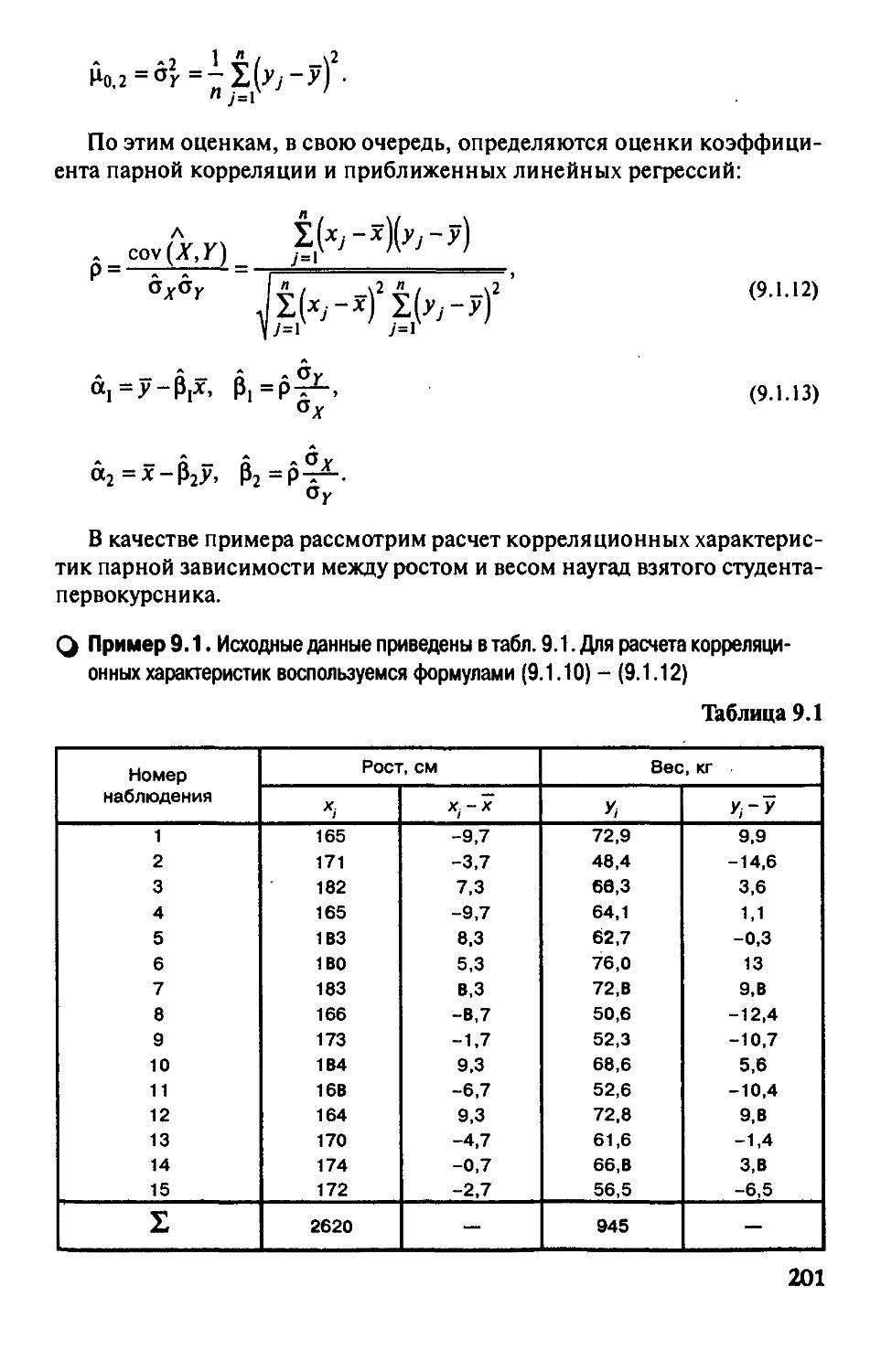

П1ава9. Корреляционный и регрессионный анализ 195

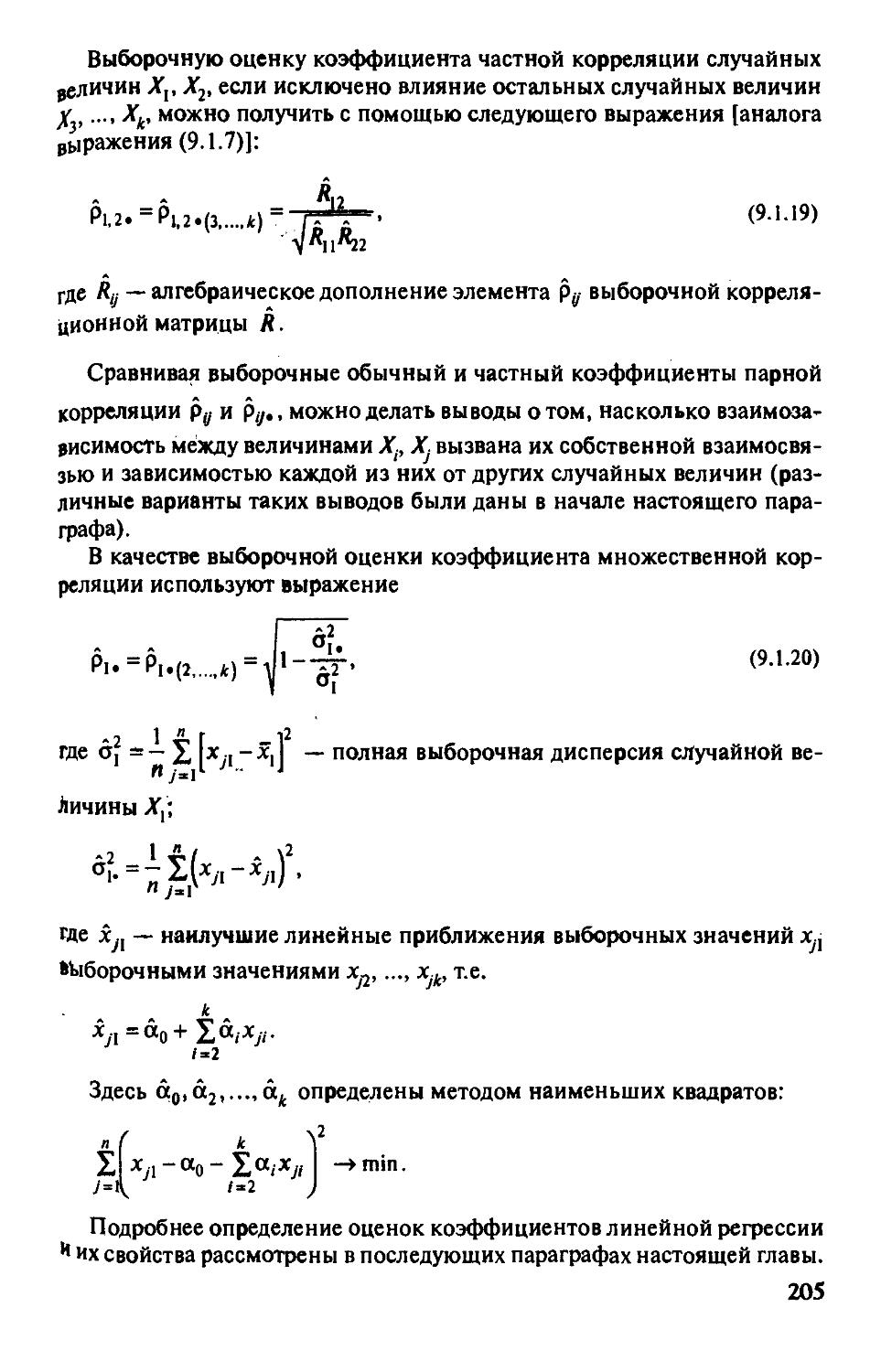

§9.1. Введение в корреляционный анализ 196

§ 9.2. Регрессионные модели как инструмент анализа

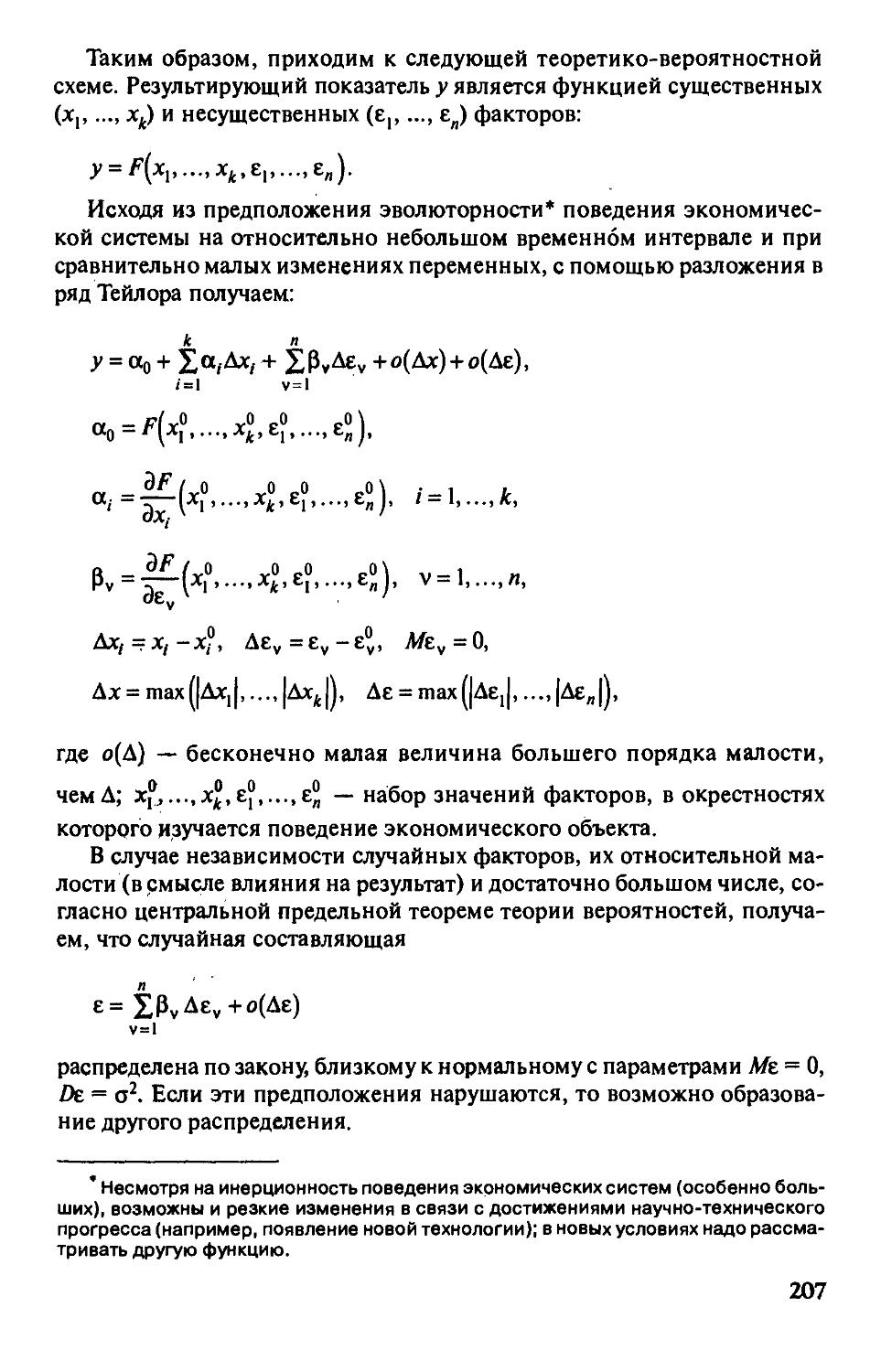

и прогнозирования экономических явлений 206

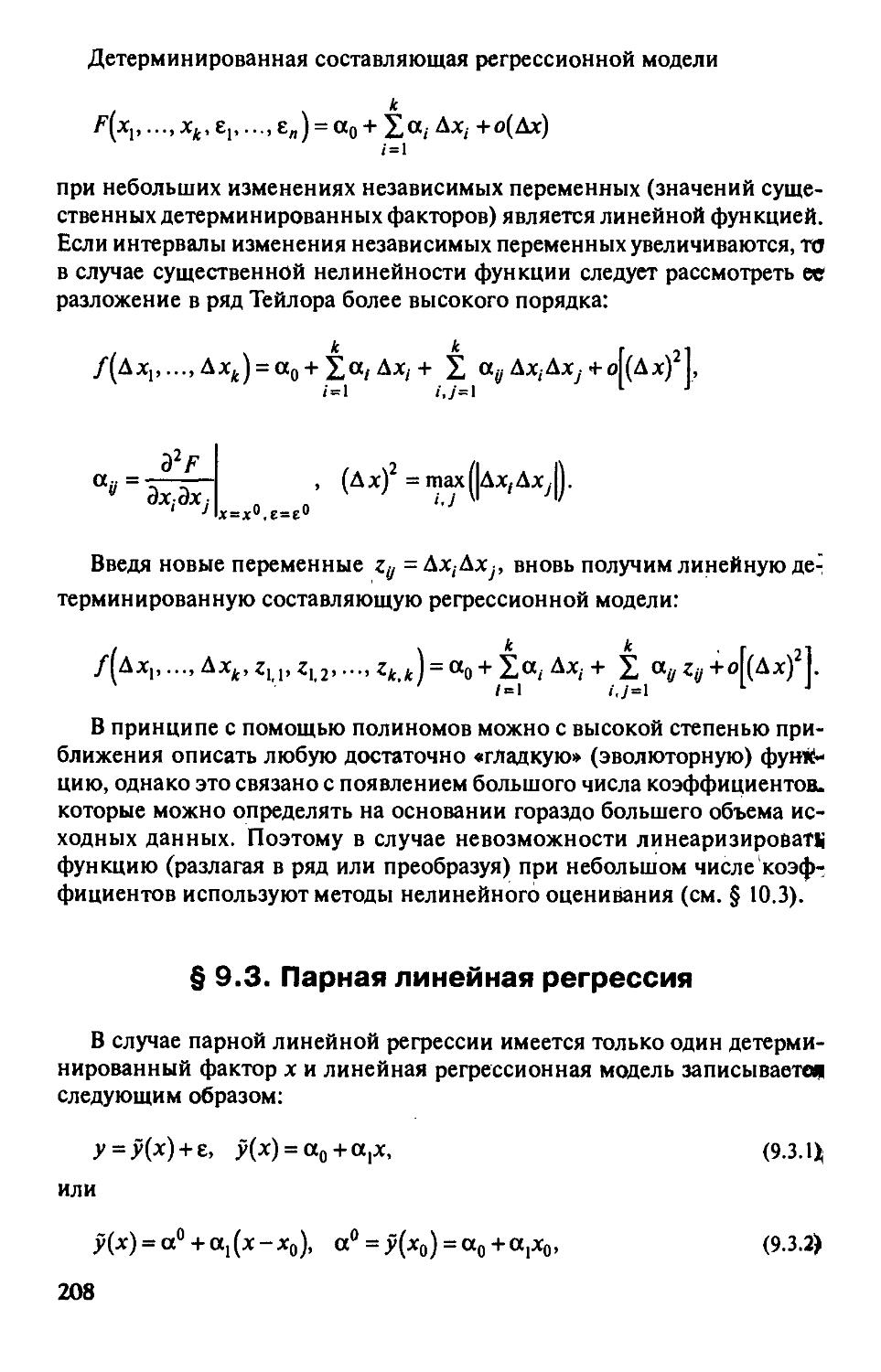

§ 9.3. Парная линейная рефессия 208

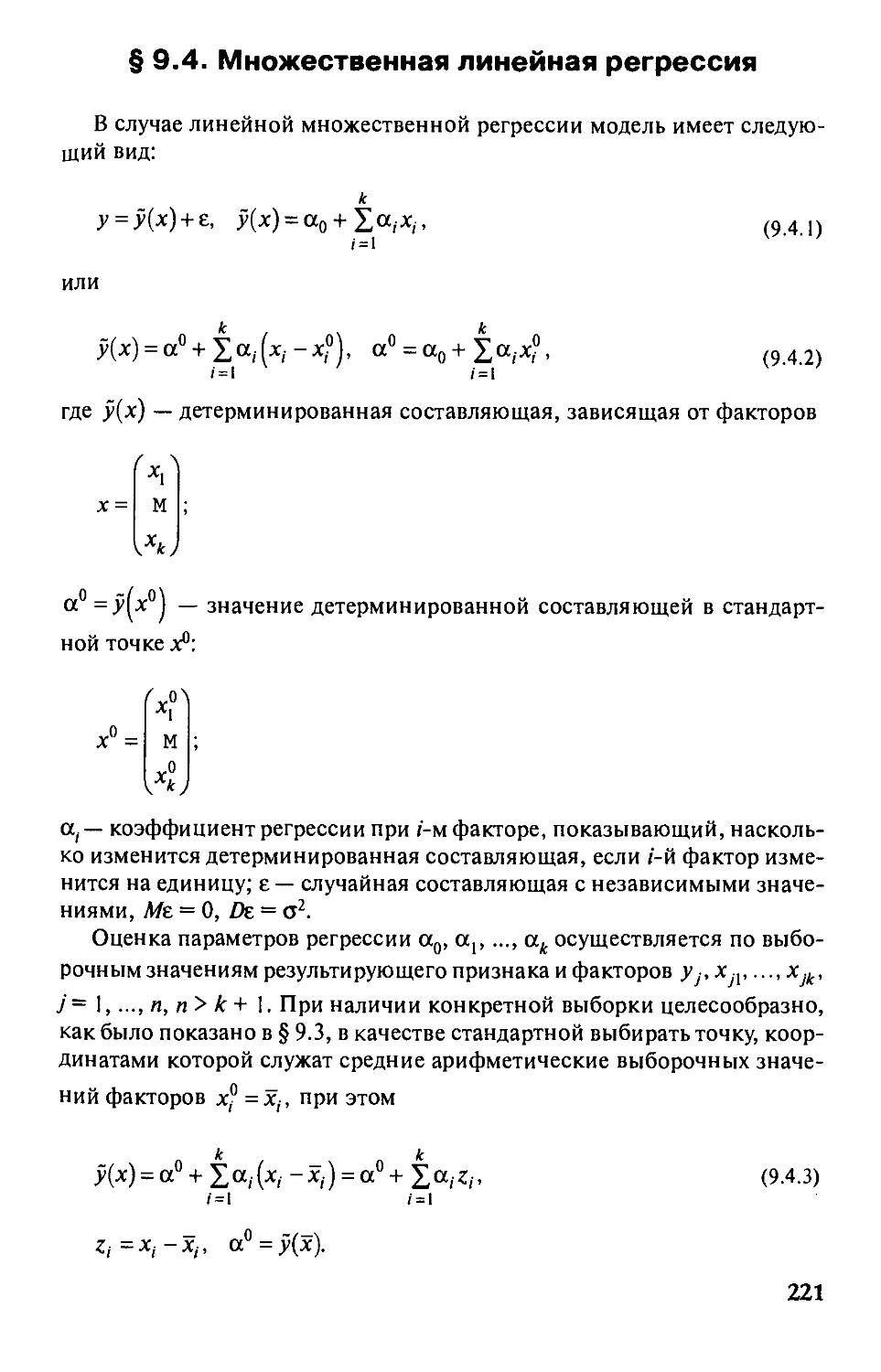

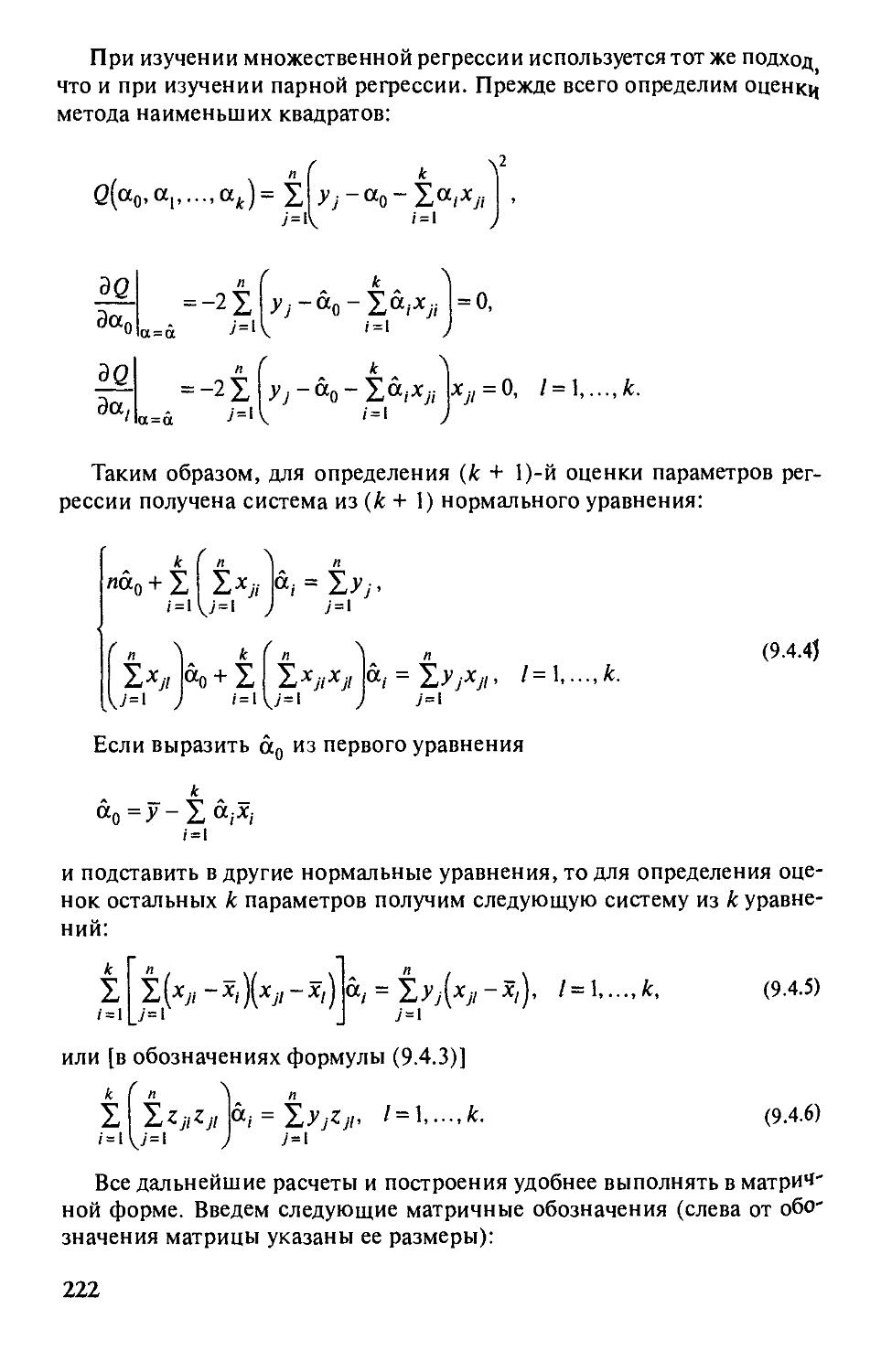

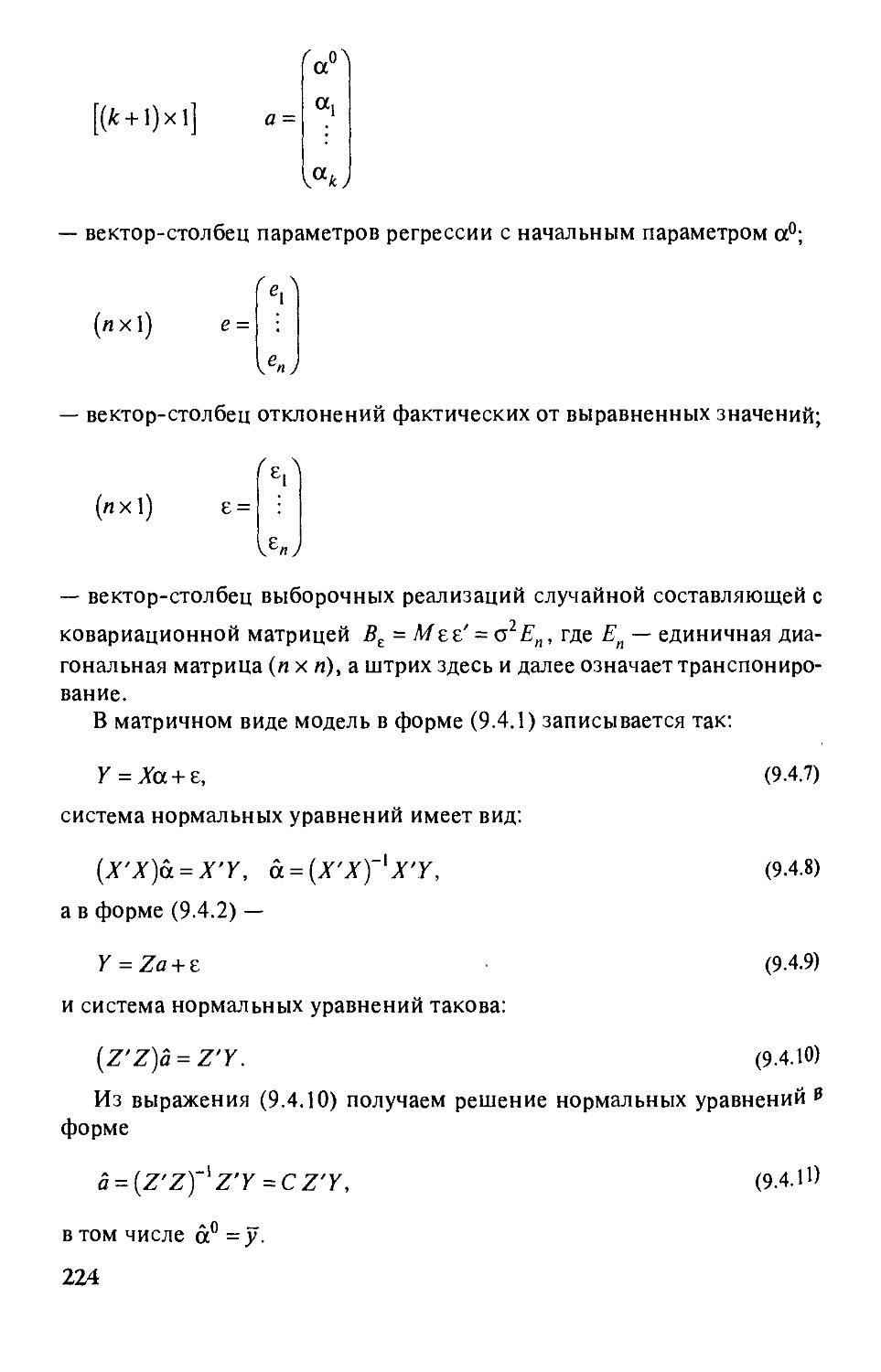

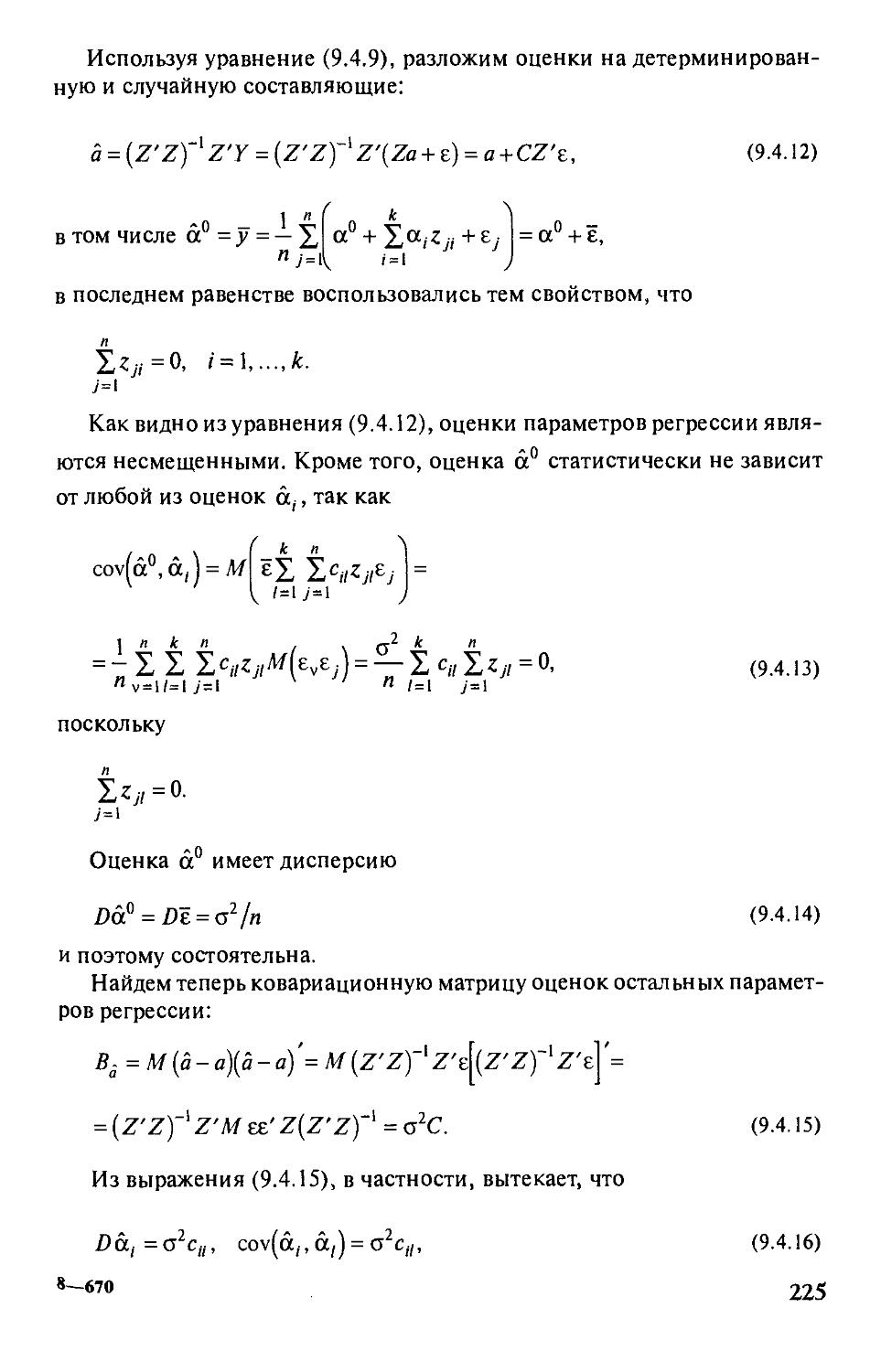

§ 9.4. Множественная линейная регрессия 221

§ 9.5. Особенности практического применения

рефессионных моделей 231

Вопросы и задачи 235

Diaea 10. Статистический анализ экономических временных рядов 237

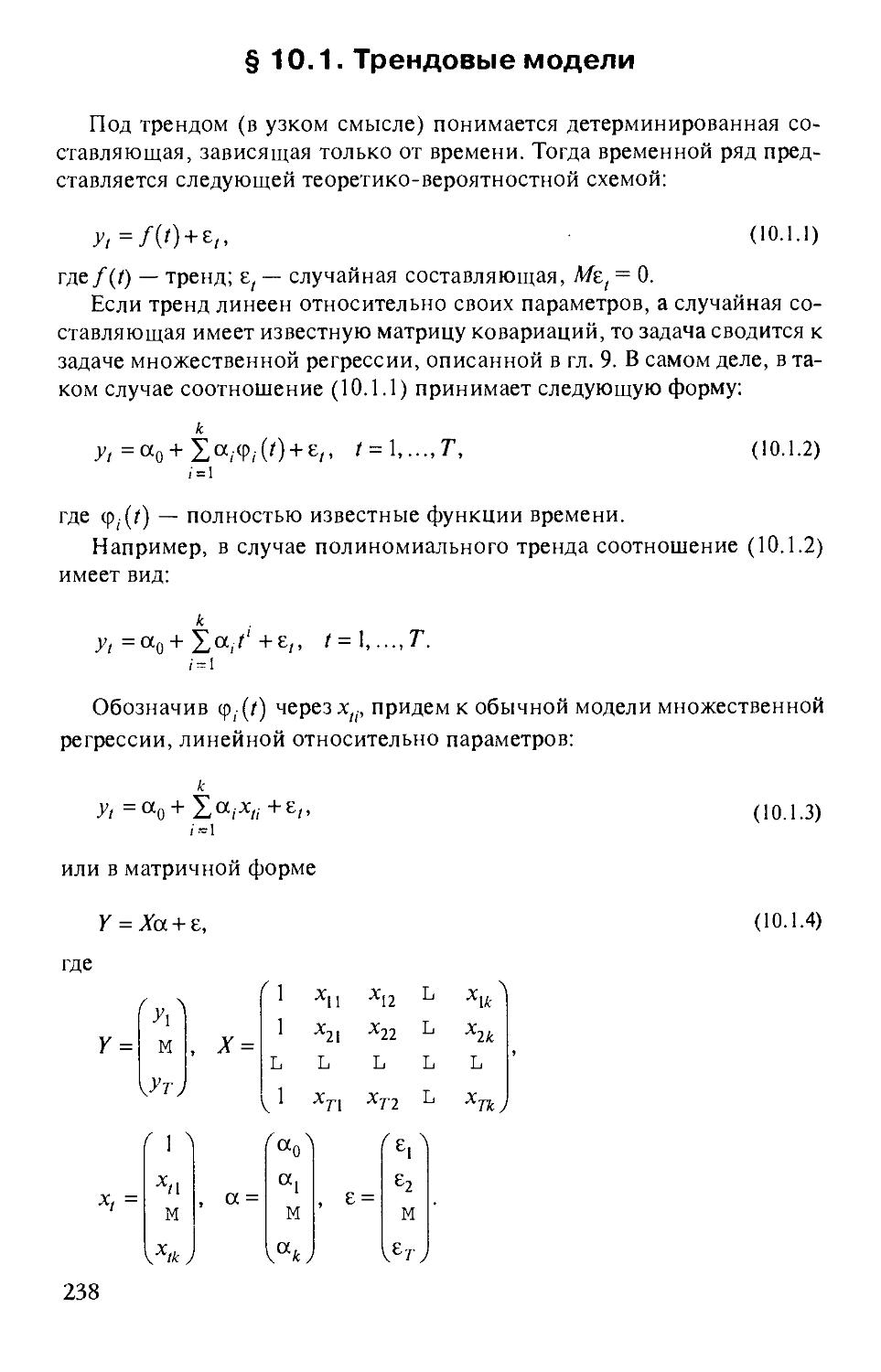

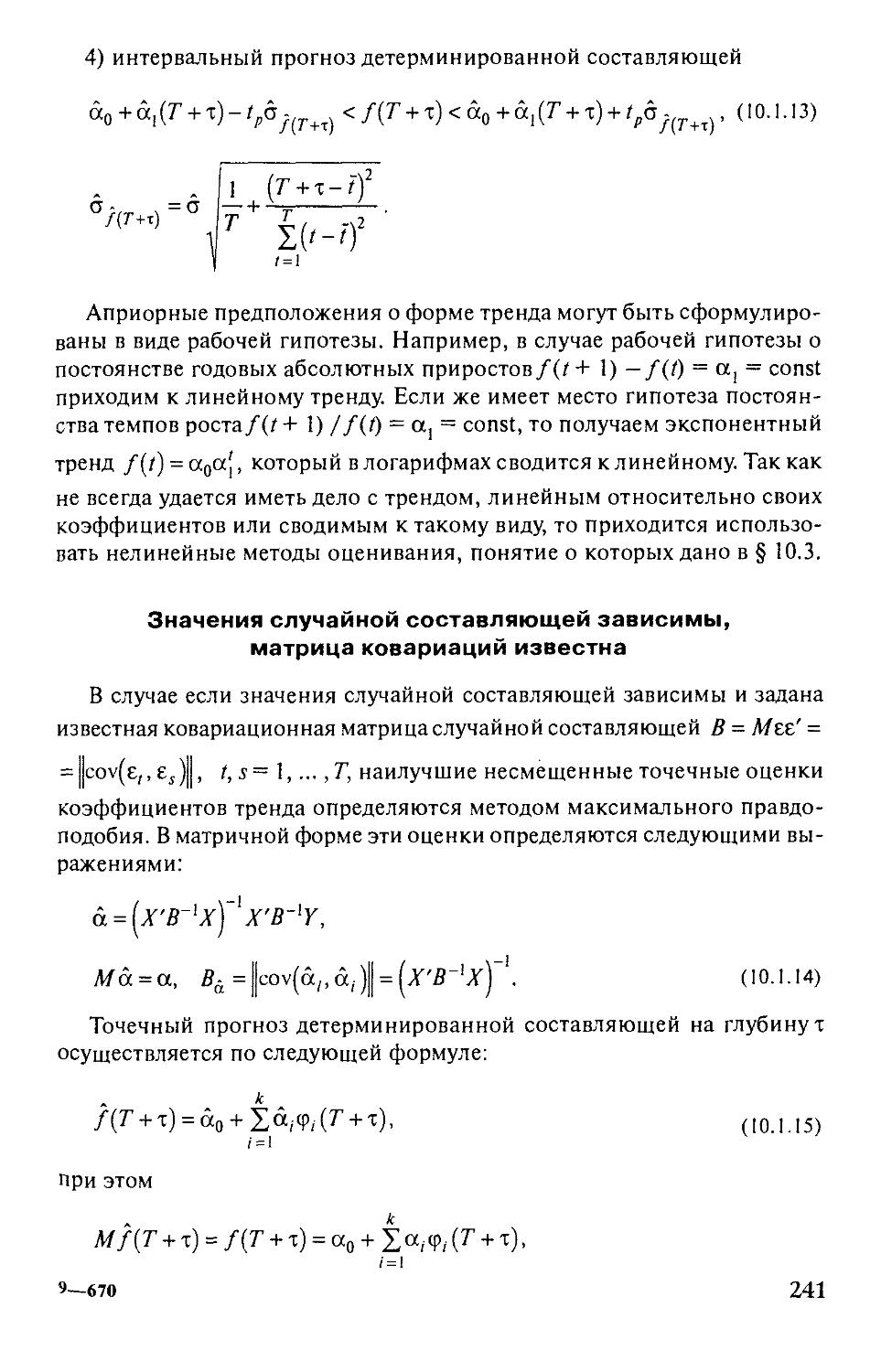

§ 10.1.Трендовые модели 238

§ 10.2. Выявление тренда в динамических рядах

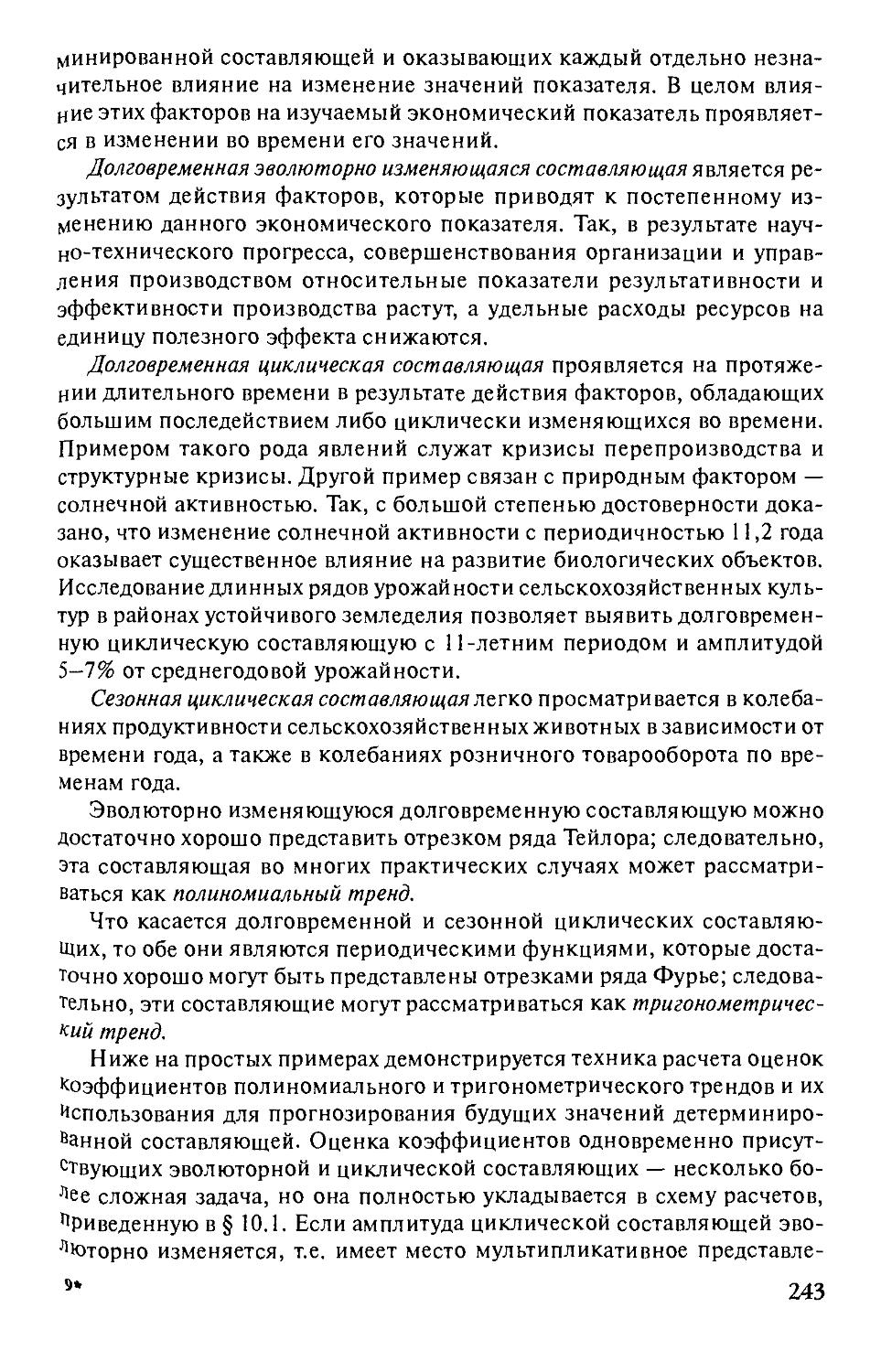

экономических показателей 242

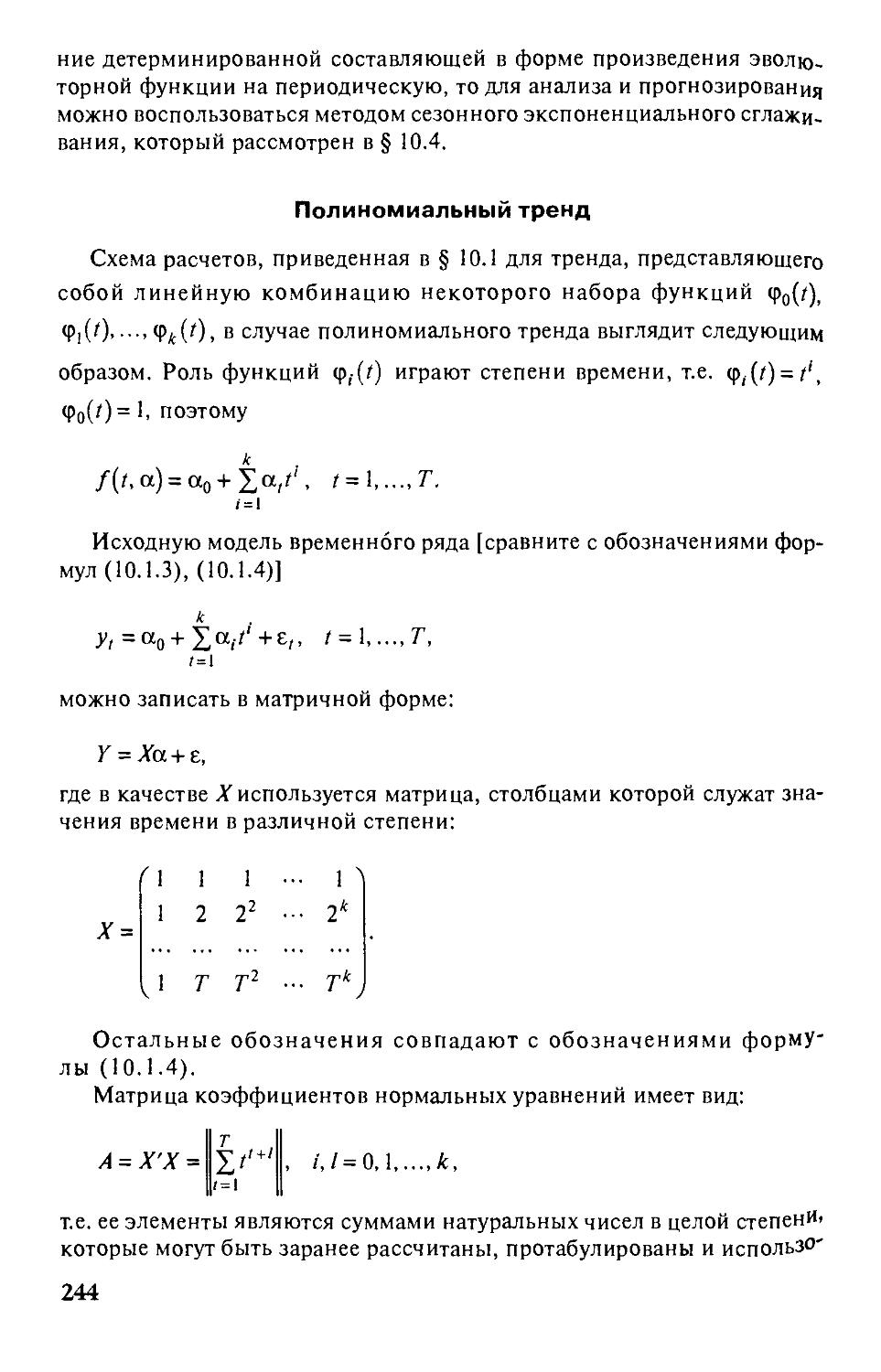

§ 10.3. Нелинейные тренды 259

§ 10.4. Экспоненциальное сглаживание 262

Вопросы и задачи 268

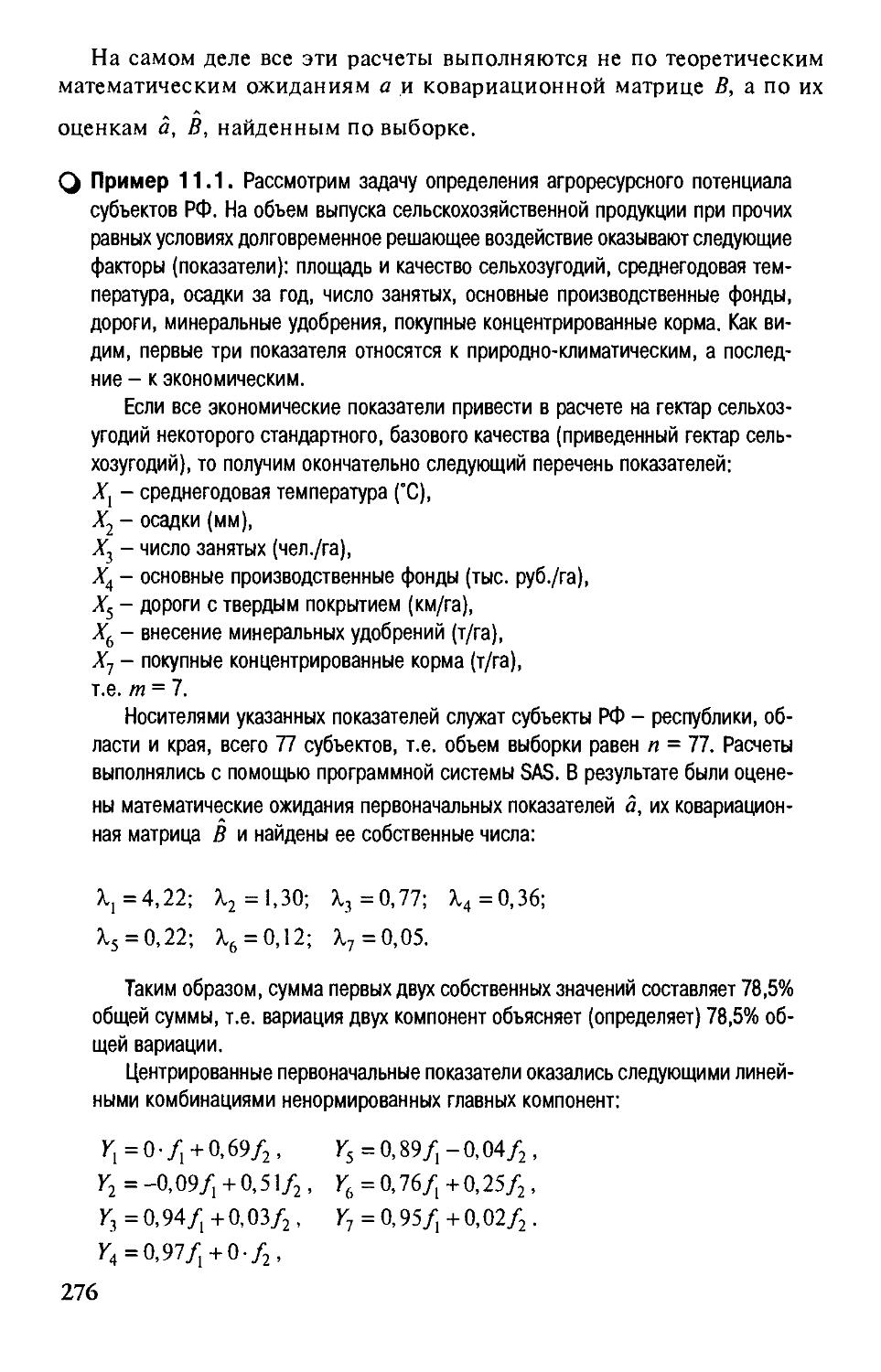

DiaBa 11. Элементы многомерного статистического анализа 270

§ 11.1. Модель факторного анализа и метод главных компонент 271

§ 11.2. Понятие омногомерной классификации 278

Вопросы и задачи 280

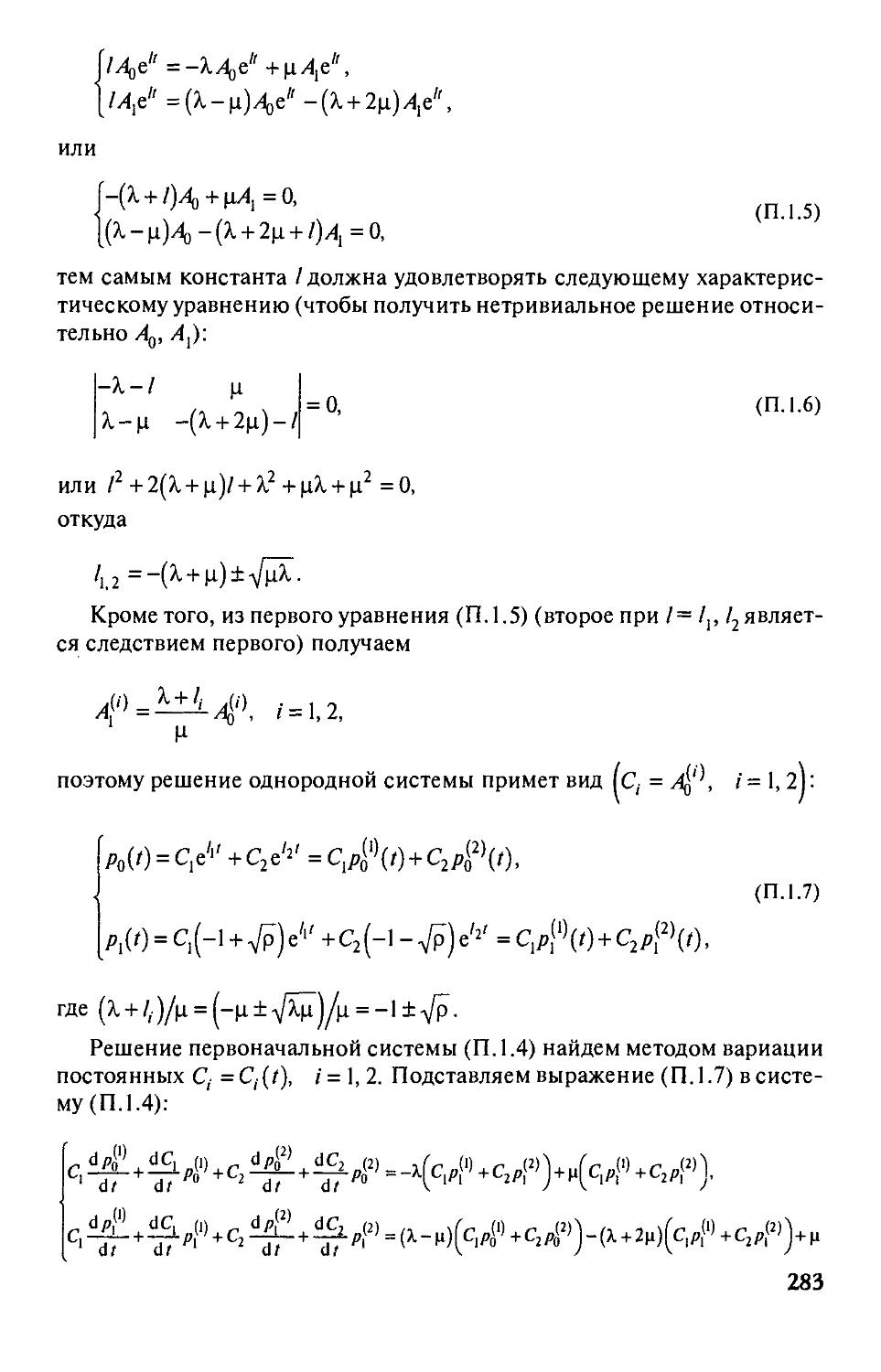

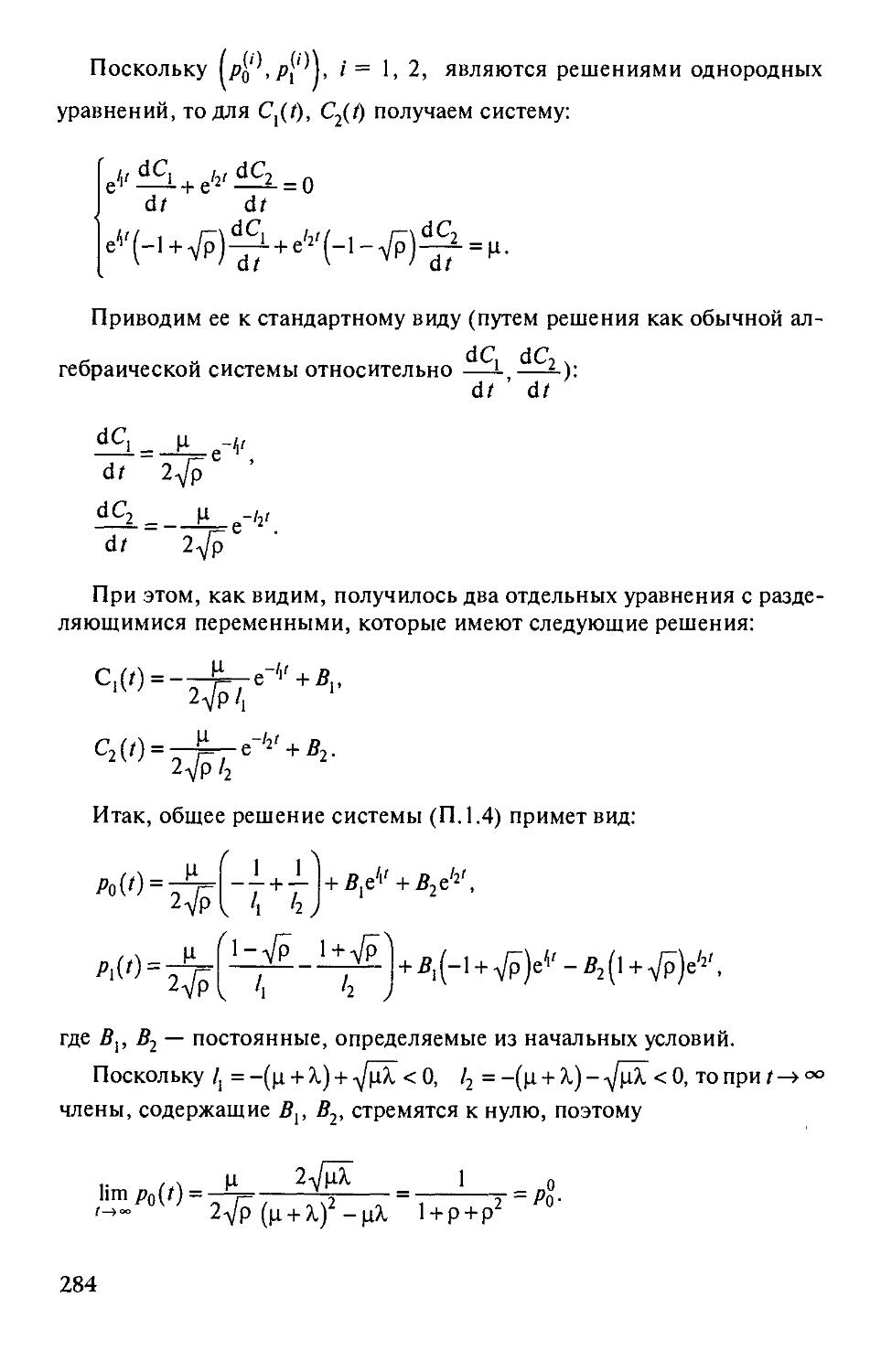

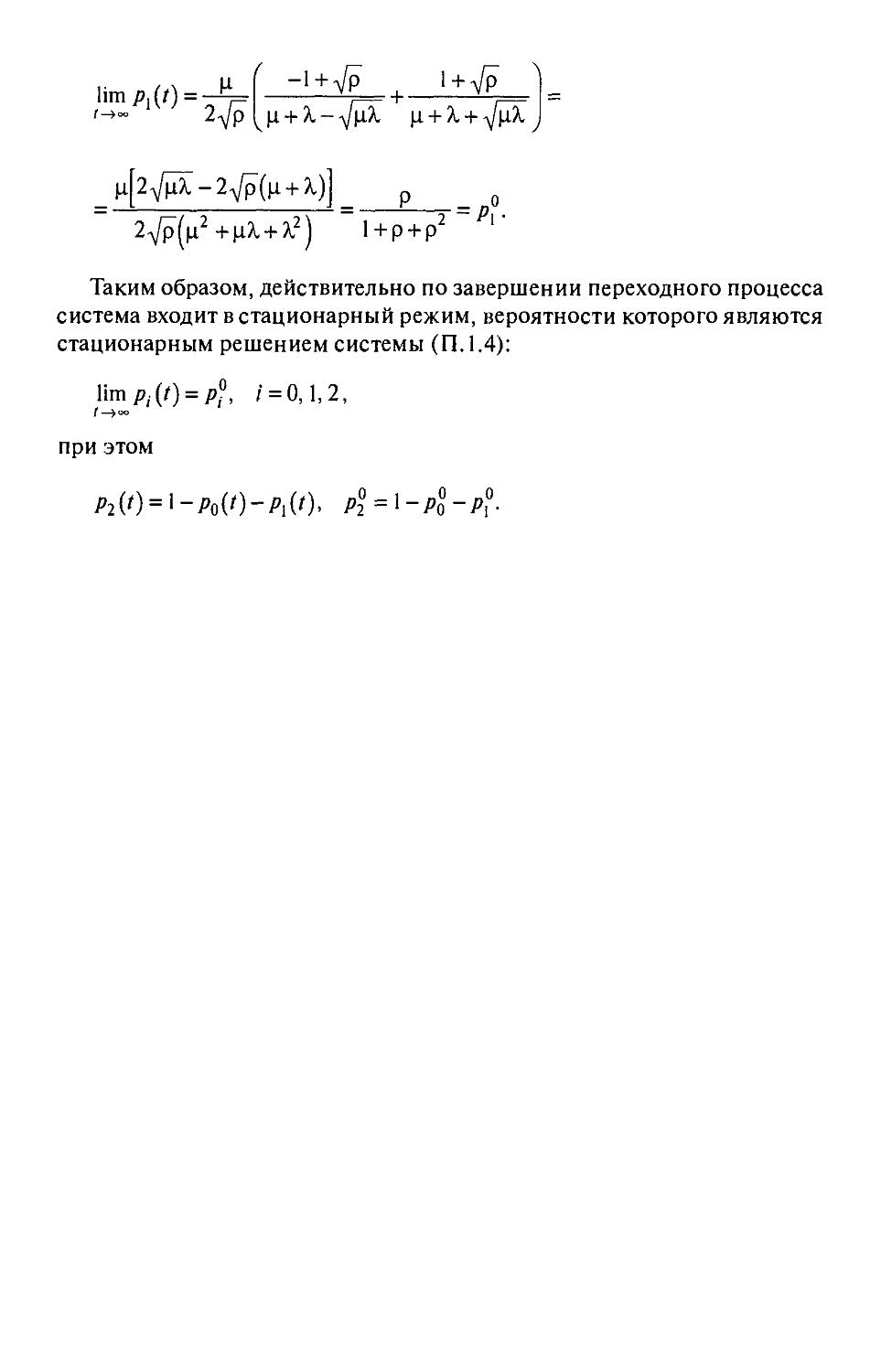

Приложение 1. Доказательство сходимости вероятностей

состояний СМО к стационарным значениям 281

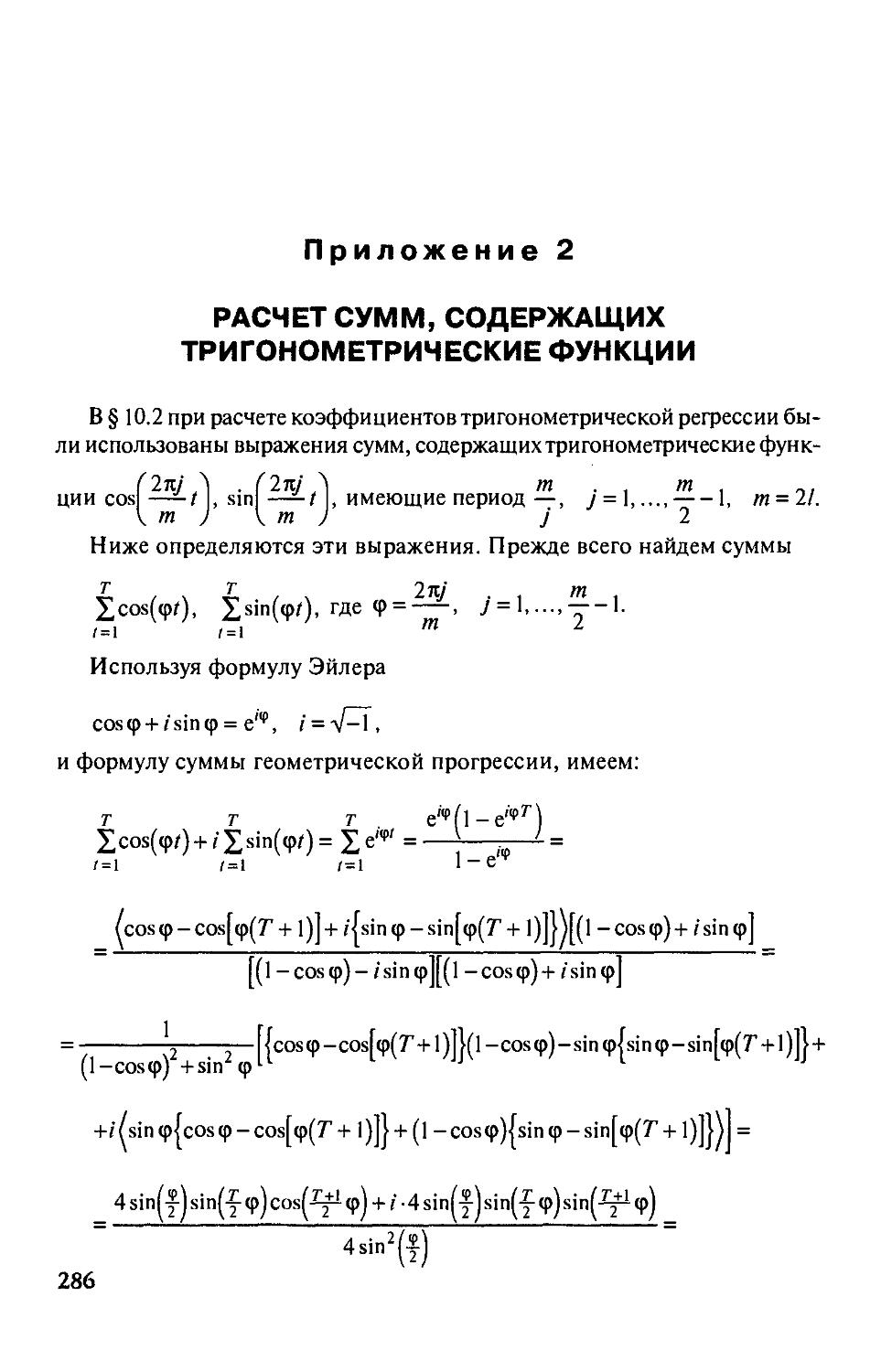

Приложение 2. Расчет сумм, содержащих

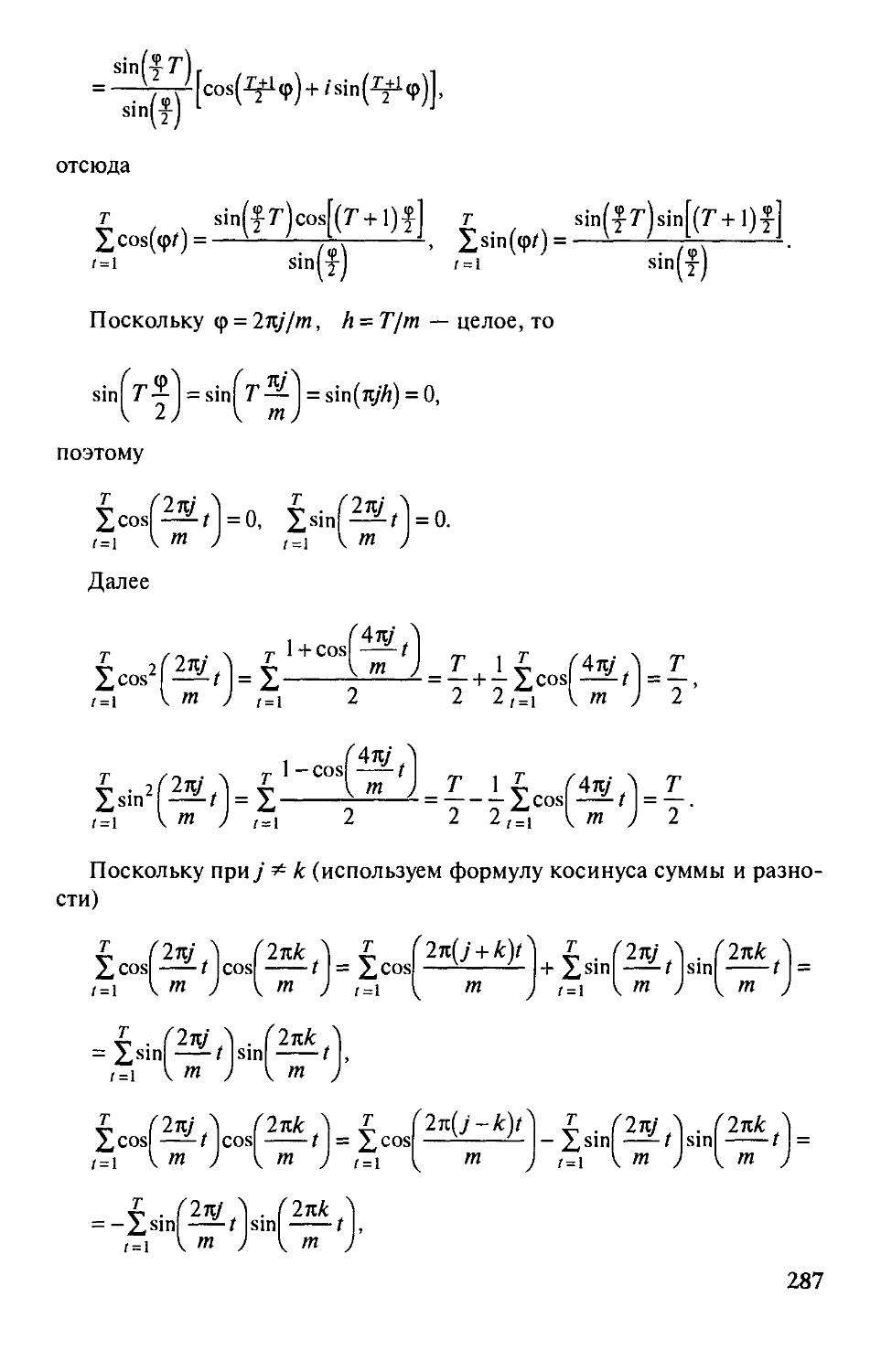

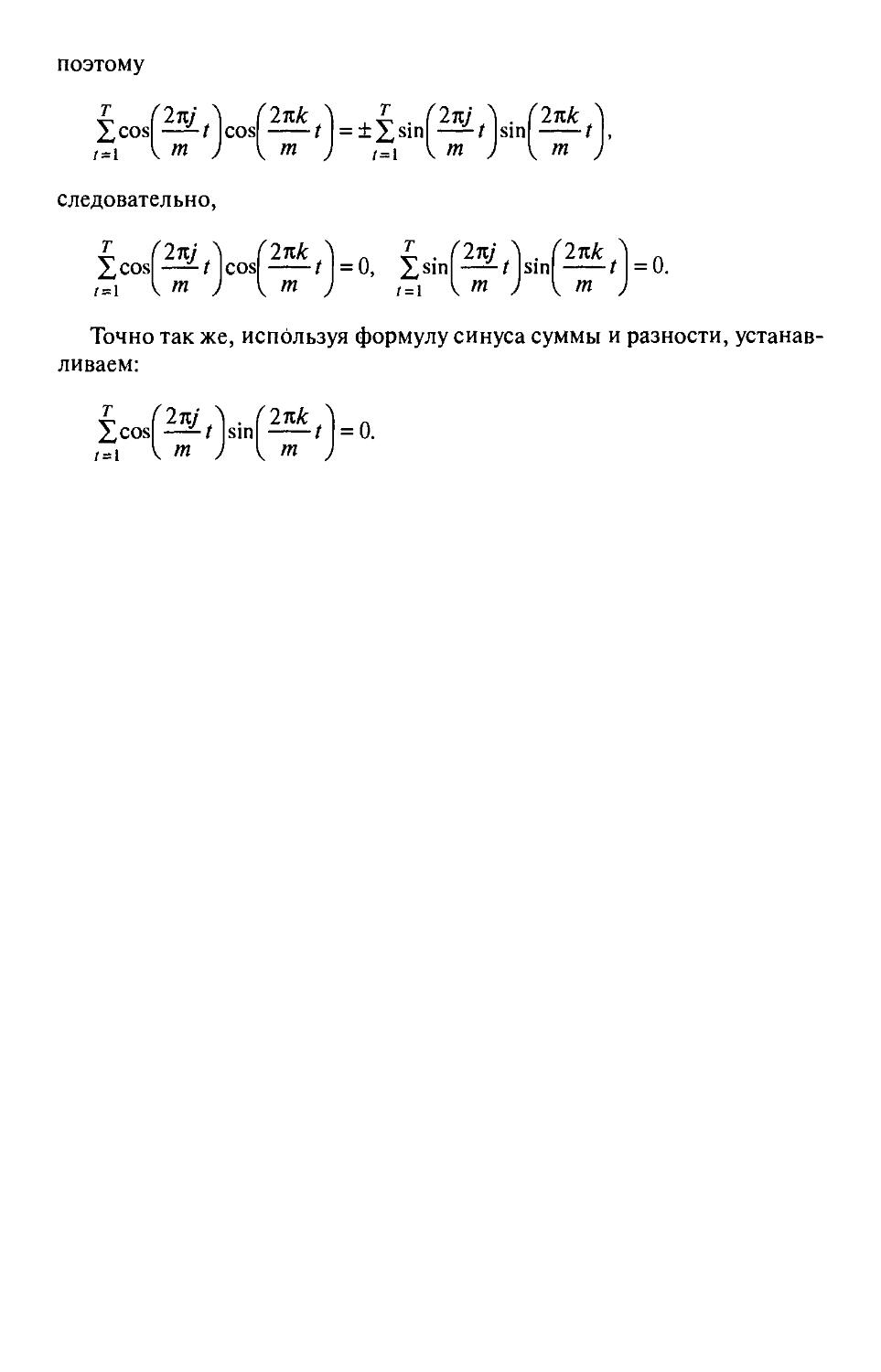

тригонометрические функции 286

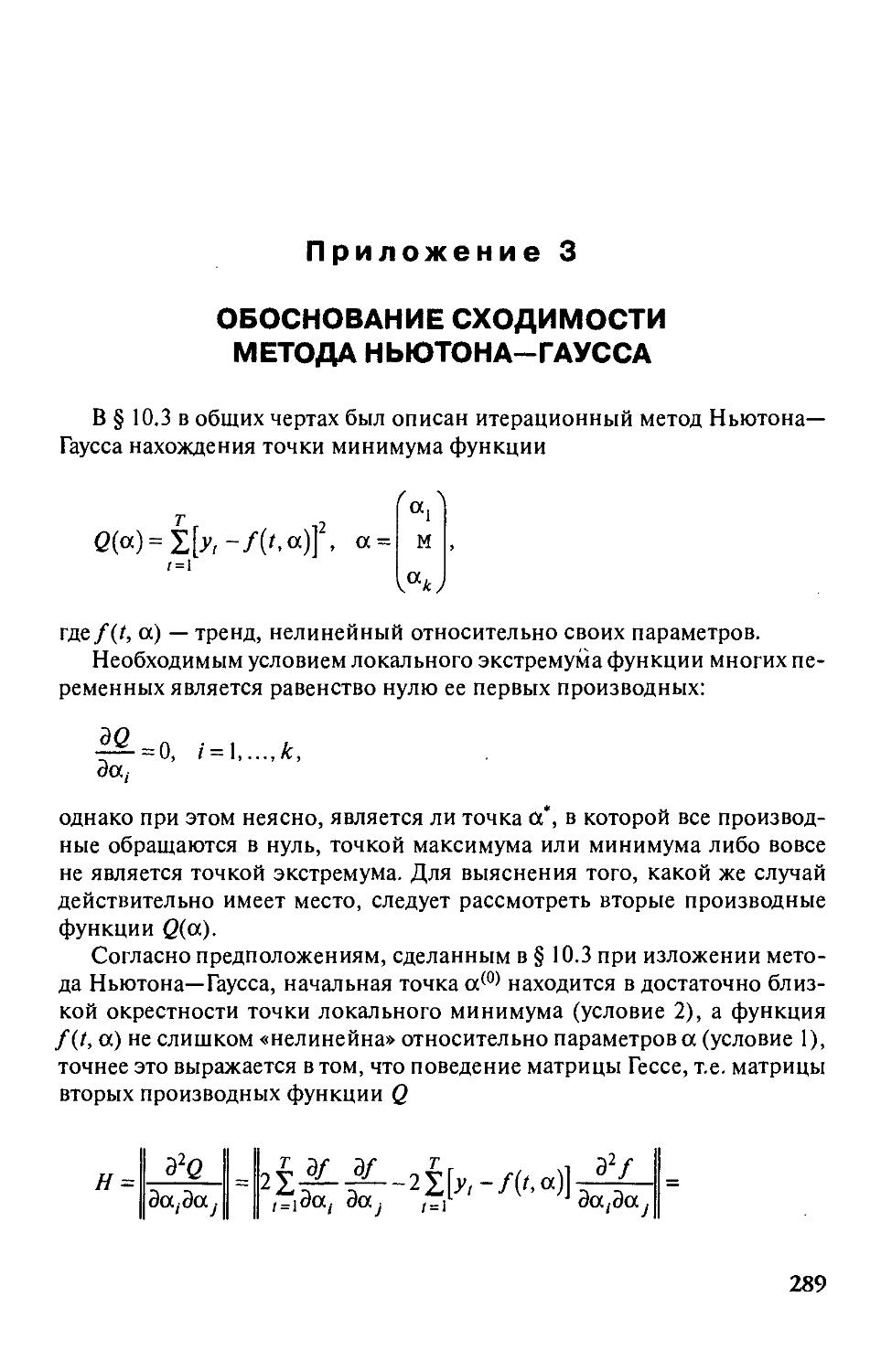

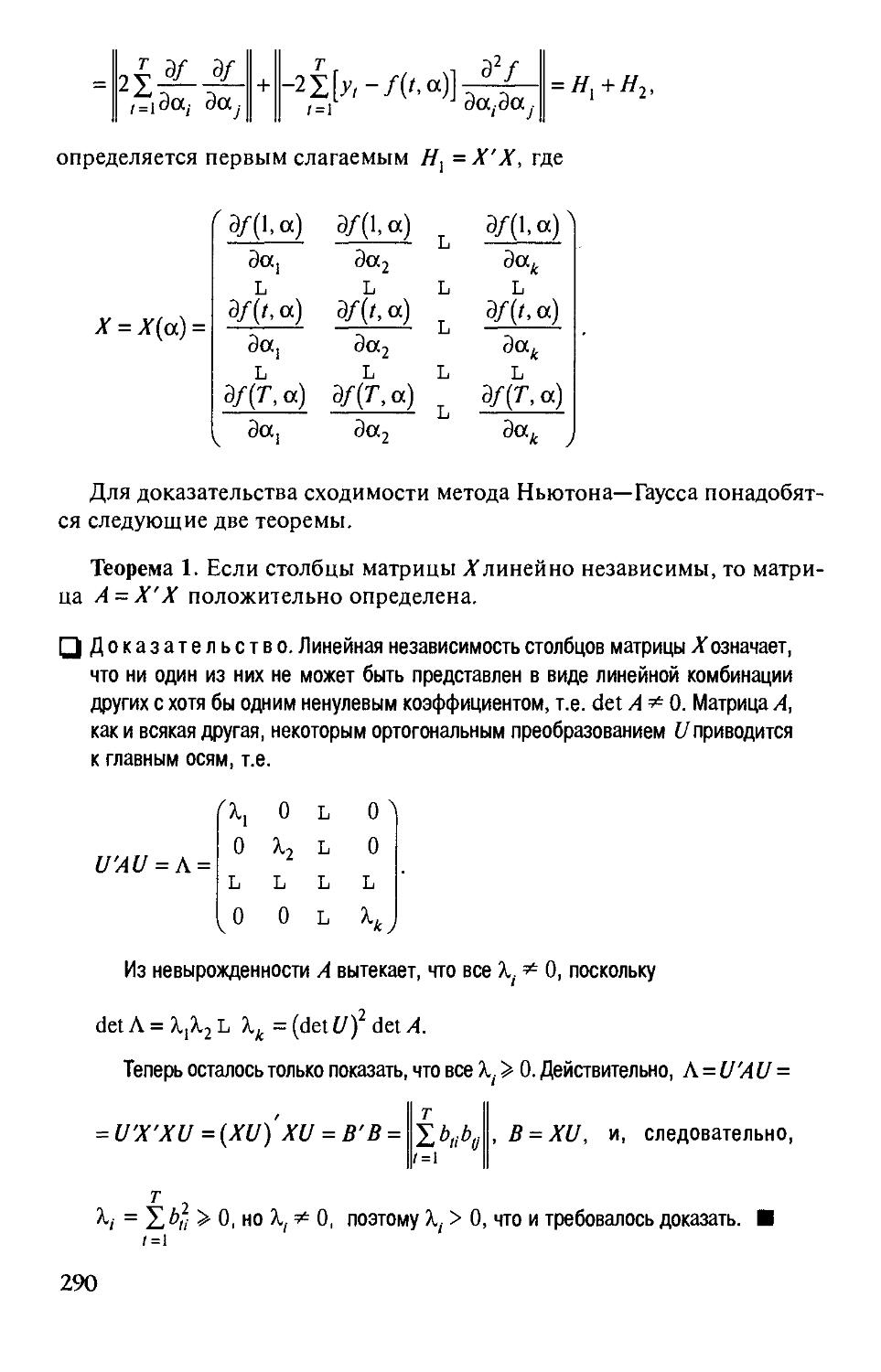

Приложение 3. Обоснование сходимости метода Ньютона—Гаусса 289

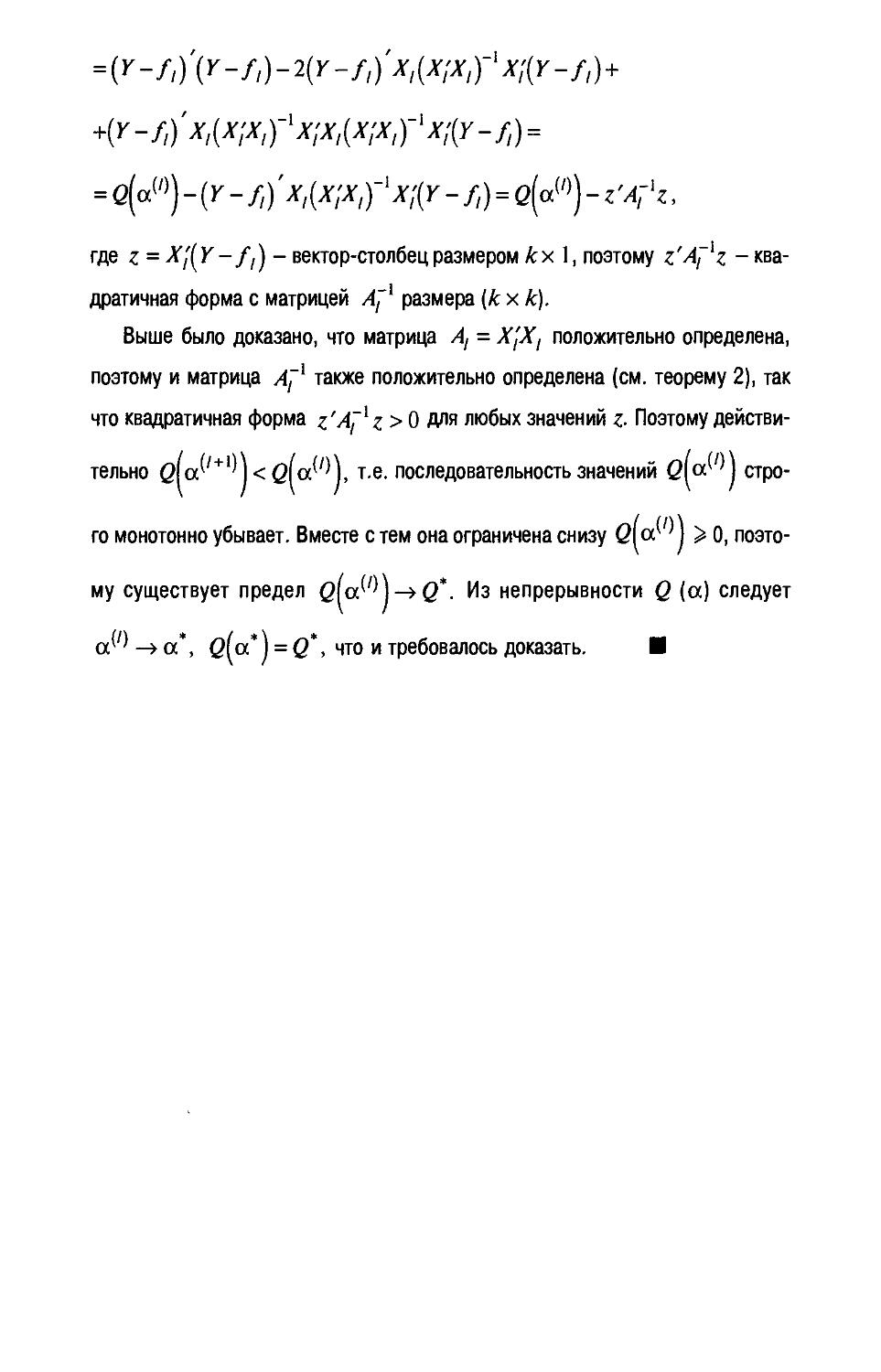

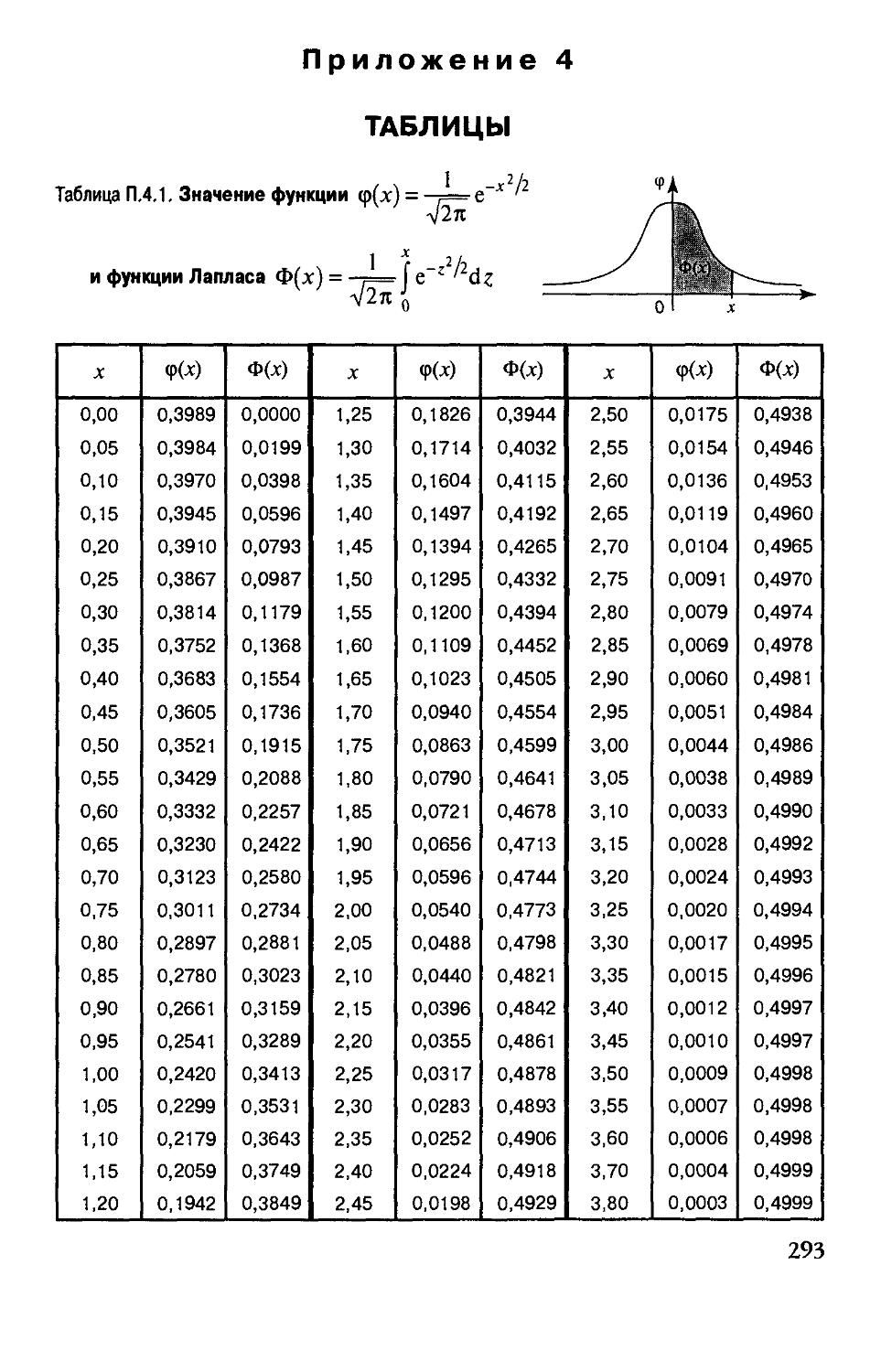

Приложение 4. Таблицы 293

Список литературы 299

ПРЕДИСЛОВИЕ

В основу книги положен многолетний опыт преподавания

дисциплины «Теория вероятностей и математическая статистика» кафедрой

Прикладной математики Государственной академии управления

им. С. Орджоникидзе (ГАУ) для студентов специальностей

«Менеджмент», «Менеджмент в социальной сфере», «Мировая экономика»,

«Национальная экономика», «Государственное и муниципальное

управление», «Маркетинг», «Бухгалтерский учет и аудит», «Социология» и

«Связи с общественностью».

При написании учебника авторы старались добиться максимальной

доступности изложения, сохраняя необходимый уровень строгости. Ведь

теория вероятностей и математическая статистика — математические

науки, построенные на аксиоматической основе. Пытаясь приблизить

материал к практическим нуждам экономики и управления, авторы

добавили соответствующие примеры и задачи.

Книга написана с учетом опыта издания учебников для

экономических и других специальностей. Наиболее тесная связь существует с

учебным пособием «Теория вероятностей и математическая статистика»,

изданным в 1991 году в издательстве «Высшая школа», членом авторского

коллектива и научным редактором которого был один из соавторов

настоящего учебника. Птавы, написанные научным редактором, вошли в

учебник с относительно небольшими изменениями. Другие главы

существенно отличаются от глав-аналогов учебного пособия, поскольку

заново написаны авторами в соответствии с профаммой «Математика» для

специальности «Менеджмент».

Предполагается, что читатель знает основы дифференциального и

интефзльного исчислений, дифференциальных уравнений,

матричного исчисления.

Книга состоит из двух частей: в первой части излагаются основы

теории вероятностей, во второй — математической статистики.

Формулы имеют трехступенчатую нумерацию: номер главы, номер

парафафа, номер формулы. Таблицы, примеры и рисунки

двухступенчатую: номер главы, номер таблицы или рисунка. Для удобства

читателей начало и конец выводов, доказательств и рассуждений, приводящих

к определенным результатам, отмечены соответственно пустым (неза-

черненным) и залитым квадратиками (Q и ■), начало и конец

примеров— соответственно пустым (Q) и залитым (•) кружками, а начало и

конец задач — треугольниками (V и Т).

Вопросы и задачи к главам намеренно расположены без

соответствия с порядком следования материала в главах.

Авторы выражают искреннюю признательность рецензентам: зав.

кафедрой статистики РЭА им. Г.В. Плеханова д-ру экон. наук, проф.

Б.И. Искакову, зав. сектором экономического моделирования ИМЭМО

д-ру экон. наук, проф. Ю.П.Лукашину

В подготовке рукописи учебника к изданию приняли участие

следующие сотрудники и студенты ГАУ: Гончарова Л.В., Сынкова А.В.,

Синельникова М.Н., Стружкин Н.П., Боярский Н., Осадчук Е.,

Петров Д., Путинцев е., Рыбаков И., Смирнов Р.

ВВЕДЕНИЕ

По форме проявления причинных связей законы природы и

общества делятся на два класса: детерминированные и статистические.

Например, на основании законов небесной механики по известному

в настоящем положению планет Солнечной системы может быть

практически однозначно предсказано их положение в любой наперед

заданный момент времени, в том числе очень точно могут быть предсказаны

солнечные и лунные затмения. Это пример детерминированных законов.

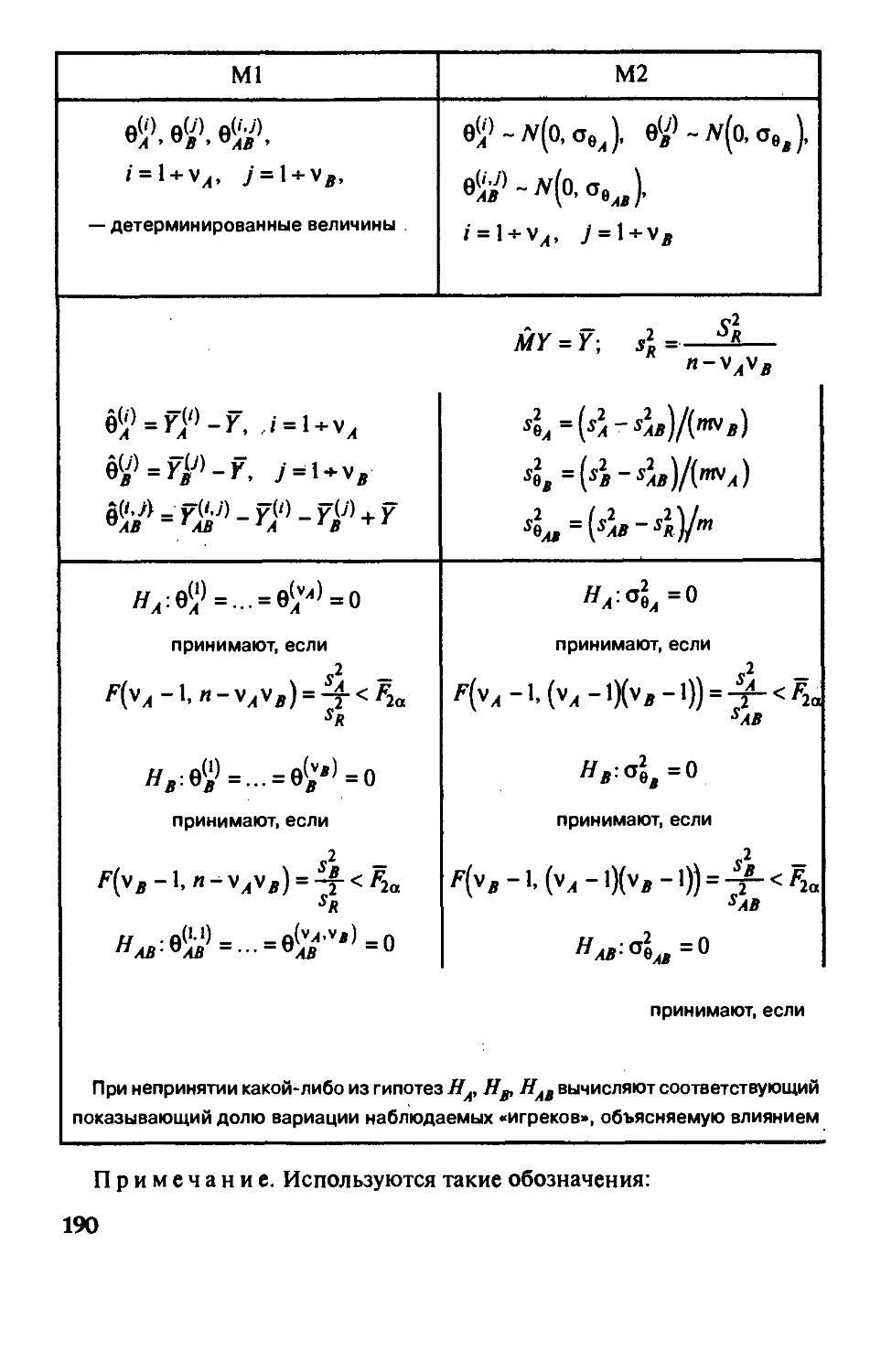

Вместе с тем не все явления макромира поддаются точному

предсказанию, несмотря на то что наши знания о нем непрерывно углубляются

и уточняются. Так, долговременные изменения климата,

кратковременные изменения погоды не являются объектами для успешного

прогнозирования. Еще менее детерминированы многие законы и

закономерности микромира. Например, с точки зрения теоретической физики

нельзя говорить о точном положении электрона в определенный момент

времени, но можно говорить о его распределенном положении в

пространстве («электронное облако»). Такого рода законы называются

статистическими. Согласно этим законам, будущее состояние системы

определяется не однозначно, а лишь с некоторой вероятностью,

являющейся объективной мерой возможности реализации заложенных в

прошлом тенденций изменения.

Теория вероятностей изучает свойства массовых случайных событий,

способных многократно повторяться при воспроизведении

определенного комплекса условий. Основное свойство любого случайного

события независимо от его природы — вероятность его осуществления.

Теория вероятностей — математическая наука. Из первоначально

заданной системы аксиом вытекают другие ее положения и теоремы.

Впервые законченную систему аксиом сформулировал в 1936 г советский

математик академик А.Н. Колмогоров в своей книге «Основные понятия

теории вероятностей».

Теория вероятностей вначале развивалась как прикладная

дисциплина. В связи с этим ее понятия и выводы имели окраску тех областей

знаний, в которых они были получены. Лишь постепенно

выкристаллизовалось то общее, что присуще вероятностным схемам независимо от

области их приложения: массовые случайные события, действия над ними

8

и их вероятности, случайные величины и их числовые характеристики.

Большой вклад в развитие теории вероятностей внесли русские ученые.

Практические приложения способствовали зарождению теории

вероятностей, они же питают ее развитие как науки, приводя к появлению все

новых ее ветвей и разделов.

На теорию вероятностей опирается математическая статистика,

задача которой состоит в том, чтобы по ограниченным данным (выборке)

восстановить с определенной степенью достоверности характеристики,

присущие генеральной совокупности, т.е. всему мыслимому набору

данных, описывающему изучаемое явление. За несколько последних

десятилетий от теории вероятностей «отпочковались» такие отрасли науки,

как теория случайных процессов, теория массового обслуживания,

теория информации, эконометрическое моделирование и др. Этот процесс

продолжается и теперь.

Одной из важнейших сфер приложения теории вероятностей

является экономика. В настоящее время трудно себе представить

исследование и прогнозирование экономических явлений без использования эко-

нометрического моделирования, регрессионного анализа, трендовых и

сглаживающей моделей и других методов, опирающихся на теорию

вероятностей.

Статистические закономерности присущи и централизованно

управляемой, и тем более децентрализованной экономике. Наличие таких

твердо устоявшихся в экономике понятий, как страховой запас,

резервные мощности, государственные резервы, финансовые риски и тп.,

свидетельствует об этом.

Необходимо также заметить, что без элементов случайности вообще

невозможно развитие. Без случайности были бы невозможны

возникновение жизни и совершенствование биологических видов, немыслимы

история человечества, творческая деятельность людей, развитие

социально-экономических систем. Таким образом, проявление случайности

в экономике следует рассматривать как отклонение от сложившегося

русла событий либо в положительную сторону (появление новых

научных открытий, технологий, способов ведения и организации

производства и т.п.), либо в отрицательную (стихийные бедствия, поломки

оборудования, болезни работников, конфликты людей и т.п.), что

впоследствии приводит к существенному изменению самого течения событий.

С развитием общества экономическая система все более

усложняется. Следовательно, по законам развития динамических систем должен

усиливаться статистический характер законов, описывающих

социально-экономические явления. Все это предопределяет необходимость

овладения методами теории вероятностей и математической статистики

как инструментом статистического анализа и прогнозирования

экономических явлений и процессов.

Часть 1

ТЕОРИЯ ВЕРОЯТНОСТЕЙ

Глава 1

ВЕРОЯТНОСТНЫЕ ПРОСТРАНСТВА

в настоящей главе в сжатом виде представлена эволюция теории

вероятностей от классической схемы с конечным числом равновозможных

исходов до аксиоматического построения. Вводятся важнейшие

понятия теории вероятностей: пространство элементарных событий,

случайные события и действия над ними, поле событий, вероятность,

вероятностное пространство.

§1.1. Классическое определение вероятности

Достоверным называют событие, которое обязательно произойдет

при осуществлении определенного комплекса условий. Так, например,

вода при нормальных атмосферных условиях и 0° С замерзает.

Соответственно, невозможным является событие, которое при заданном

комплексе условий никогда не произойдет. Случайным естественно назвать

такое событие, которое при заданном комплексе условий может как

произойти, так и не произойти. Мера возможности осуществления такого

события и есть его вероятность. Достоверное и невозможное события

могут рассматриваться как крайние частные случаи случайных событий.

Далее случайные события будем обозначать большими латинскими бук-

вамиу4, В, С,.... Достоверное событие обозначим буквой Q, невозможное —

символом 0. Введем теперь некоторые отношения между событиями.

Два события Ак В несовместны, если наступление одного из них

исключает наступление другого. Сумма событий А, В — это такое третье

событие С — А + В, которое происходит тогда, когда наступает либо со-

10

бытие А, либо событие В, либо они оба одновременно. Произведение

событий А, В — это такое событие С = АВ, которое наступает тогда, когда

происходят и событие А, и событие В. Событие А противоположно

событию А, если оно несовместно с событием А и вместе с ним образует

достоверное событие А+А = П.

Покажем, как могут быть построены математические модели

явлений с конечным числом исходов. Одной из таких моделей является

модель, известная под названием «классическая вероятностная схема».

В этой схеме определение вероятности основывается на равновозмож-

ности любого из конечного числа исходов, что характерно для первых

попыток исчисления шансов в азартных ифах.

Так, в случае с ифальной костью при однократном бросании равно-

возможно выпадение любой из шести граней, на которые нанесены

цифры 1, 2, 3, 4, 5, 6. Обозначим эти равновозможные исходы, или

элементарные события, через со,, cOj. ^з' ^4' ^5' ^б- Естественно, что шанс

осуществиться не одному исходу, а одному из двух, например или со,, или

(Oj, в 2 раза больше. Рассуждая таким образом, можно определить

шансы осуществления любого события, состоящего из нескольких

элементарных, так называемого составного события.

В общем случае, когда имеется п равновозможных элементарных

событий со,,..., (Од, вероятность любого составного события А, состоящего

из т элементарных событий {0/|, ..., со/^, определяется как отношение

числа элементарных событий, благоприятствующих событию А, к

общему числу элементарных событий, т.е.

р[А) = т/п. (I.I.I)

Например, в случае с ифальной костью вероятность события А,

состоящего в выпадении четного числа очков (т.е. А = {cOj, (о^, cOg}), равна

Р(А)=^/^—^/2, так как в событие А входят три элементарных события,

а общее число элементарных событий равно 6.

Из классического определения вероятности, в частности, вытекает,

что вероятность полного события Q, включающего все п элементарных

событий, равна единице:

/'(Q) = «/« = l.

Но ведь тогда полное событие Q, состоящее в появлении любого из

всего набора элементарных событий Q ={(0|, ..., (о„}, и является

достоверным событием, так как оно обязательно происходит. Поэтому

вероятность достоверного события равна единице.

Если события рассматривать как подмножества множества

элементарных событий, то отношения между событиями, введенные выше.

Можно интерпретировать как соотношения между множествами.

Несовместные события — это такие события, которые не содержат общих

11

элементов. Сумма (А+ В)» произведение событий АВ— это

соответственно их объединение AUB и пересечение Af)B, противоположное

событие А — дополнение А. Запись Ас: В означает, что в В содержатся все

элементарные события из А » могут содержаться элементарные

события, не входящие в А. Если А с В и В с: А, то А = В.

В случае классического определения вероятности справедлива

следующая теорема сложения вероятностей:

Теорема 1.1. Если два составных события А = {(0/|, ..., й>/^} и

В = {(й:, ..., шд} являются несовместными, то вероятность

объединенного события С = AUB равна сумме вероятностей этих двух событий.

□ Действительно, вероятности событий Aia В равны соответственно т/п и к/п,

а событие С = A\JB = {со/,..., со/^, ш^^,..., соу^} содержит т +

А:элементарных событий, так как по условию теоремы среди элементарных событий

{{0/|,..., со/^} нет ни одного, которое бы входило в набор {(Oj^,..., ау^},

поэтому, согласно классическому определению, его вероятность

т+к_т к

п п п

Из теоремы сложения вытекает, что

'W—^T^-'l^l-^in

р{а) = р{А)+р(А) = \,

поэтому

Р(а) = \-Р[а). (I.I.2)

Отсюда, в частности, следует, что вероятность невозможного

события, являющегося противоположным по отношению к достоверному

событию, равна нулю:

/'(0) = !-/'(«) = 0.

Урновая схема

Классическая схема, несмотря на всю свою офаниченность,

пригодна для решения ряда сугубо практических задач.

Рассмотрим, например, некоторую совокупность элементов

объема N. Это могут быть изделия, каждое из которых является годным или

бракованным; или семена, каждое из которых может быть всхожим или

нет; или избиратели, которые могут проголосовать за или против

кандидата, и тд. Подобного рода ситуации описываются урновой схемой:

в урне имеется Л'шаров, из них Л/белых w(N - М) черных.

12

Представим себе, что имеются только разрушающие средства

контроля каждого изделия на годность. Например, электролампа считается

годной, если до перегорания нити накаливания пройдет не менее чем

определенное число часов, а это можно определить только

непосредственным испытанием. В таком случае можно обследовать только часть

изделий, а не всю партию.

Итак, из урны, содержащей Л'шаров, в которой находится

неизвестное число Л/белых шаров, извлекается выборка объема п.

Требуется определить вероятность того, что в выборке будет

обнаружено т белых шаров. В частности, определить вероятность того, что т/п

близко к M/N, т.е. достоверно ли представление о генеральной

совокупности, полученное по выборке. Последняя из этих двух

сформулированных задач, как будет показано далее, является задачей математической

статистики.

Первая же задача — на применение классического определения

вероятности. В самом деле, в описанной ситуации каждая выборка не

имеет предпочтения по отношению к любой другой, т.е. все они равновоз-

можны. Подсчитаем число всех возможных выборок объема п из

Л'элементов. Как известно из комбинаторики, число способов, с помощью

которых можно выбрать п элементов из общего их числа Л', равно числу

Л"

сочетаний из Л'по л, т.е. С^ =—.—^—г-, где N1 = \-2-N. Таким образом,

«!(Л'-«]!

общее число исходов равно С^. Выясним, сколько исходов из общего

числа элементарных исходов благоприятствуют событию А, т.е. наличию

в выборке объема п белых шаров в количестве т. Число способов,

которыми можно из Л/белых шаров извлечь т штук, равно С^, а число

способов выбрать v\3(N— Af) черных шаров (л — т) штук равно С^Тд/-

Поэтому число исходов, благоприятных событию А, равно С^ C^Z^m ,

следовательно, вероятность события А, равная отношению числа

благоприятных исходов к их общему числу, такова:

О Пример 1.1. Пусть имеется партия, состоящая из 500 изделий, среди которых

два бракованных. Какова вероятность в выборке из 5 изделий не обнаружить ни

одного бракованного?

Воспользуемся формулой (1.1.3):

С^ С*

^498,50о(5. 5) = —3 = 0,98. ф

^-500

13

Какой вывод можно сделать о генеральной совокупности, не

обнаружив в выборке ни одного бракованного изделия? Кажется естественным

перенести этот вывод на всю генеральную совокупность. Таким образом,

по выборке, составляющей 1% от генеральной совокупности, мы

получили с вероятностью 0,98 абсолютно неправильный ответ: в

генеральной совокупности нет бракованных изделий. Этот вывод из очень

простой задачи должен не обескуражить, а, напротив, помочь правильно

построить статистические выводы по выборочным данным. В

рассматриваемом случае, очевидно, не следует пытаться оценивать долю

бракованных изделий {N — M)/N по их доле в выборке (л - т)/п, а, по-видимому,

целесообразно указывать интервал, который с определенной

надежностью должен накрыть неизвестную долю бракованных изделий {N— M)/N.

Этот интервал естественно задать в виде ±о, где ширина интервала

п

5(«, q) является функцией от объема выборки п и уровня надежности q.

Причем естественно ожидать (в чем мы и убедимся в дальнейшем),

что ширина интервала при прочих равных условиях уменьшается с

ростом объема выборки и увеличивается при возрастании уровня

надежности.

Как отмечалось выше, говорить о вероятности Р{А) как о мере

возможности осуществления случайного события А имеет смысл, только

если выполняется определенный комплекс условий. При изменении

условий изменится и вероятность. Так, если к комплексу условий, при

котором изучалась вероятность Р{А), добавить новое условие, состоящее в

появлении события В, то получим другое значение вероятности Р{А/В) —

условную вероятность события А при условии, что произошло событие В.

Вероятность Р{А) в отличие от условной будем называть безусловной.

Выведем теперь формулу условной вероятности. Пусть событиям А и

В благоприятствуют т v\ к элементарных исходов из п; тогда, согласно

формуле (1.1.1), их безусловные вероятности равны т/пи Л/л

соответственно. Пусть событию А при условии, что событие В произошло,

благоприятствуют г элементарных исходов, тогда, согласно формуле (1.1.1),

условная вероятность события А

Р(А/в) = г/к.

Разделив и числитель и знаменатель на п, получим формулу условной

вероятности:

П^/^)-^—^- (I.I.4)

поскольку событию у4П5соответствуют/-исходов и, следовательно, г/п —

его безусловная вероятность. Событие А называется независимым от В,

14

если его условная вероятность равна безусловной, т.е. Р(А/В) = Р{А), при

этом из формулы (1.1.4) получаем

р[АПВ) = р(а)р{в), (I.I.5)

те. свойство независимости взаимно и для независимых событий

вероятность их одновременного осуществления равна произведению их

вероятностей. Формула (1.1.4), записанная в виде

р(аПВ) = р(а)р(в/а), (I.I.6)

называется формулой умножения для зависимых событий, а

формула (1.1.5) — теоремой умножения для независимых событий.

Например, в опыте с игральной костью пусть событие А состоит в

выпадении числа очков, делящегося на три, т.е. А = {cOj. й>^}, а

событие В— в выпадении четного числа очков, т.е. В = {cOj, со^' ^бУ> тогда

АГ\В = (й^и по формуле условной вероятности (1.1.4) получаем:

но Р(А) = Ve ~ '/з> поэтому Р{А/В) = Р{А), т.е. события А v\ В

независимы.

§ 1.2. Конечная схема

с неравновозможными исходами

Ограниченность классического определения вероятности, в

частности, заложена в равновозможности исходов. Действительно, даже

небольшое усложнение практической ситуации немедленно войдет в

противоречие с равновозможностью, которая может рассматриваться

скорее как частный случай более общей ситуации.

Рассмотрим, например, стрельбу по круговой мишени.

Элементарными исходами здесь являются попадания в то или иное кольцо

круговой мишени. Попадание в малый внутренний круг оценивается в 10

очков, в окружающее его кольцо — 9 очков, в следующее — 8 и т.д.,

во внешнее кольцо — одно очко, непопадание в круговую мишень — нуль

очков. Итак, имеется одиннадцать элементарных событий (О,о, со,' •••' %•

Для каждого стрелка определенного класса имеются свои определенные

устойчивые шансы (вероятности) выбить за один выстрел то или иное

число очков/?,(,,..., Pq. Эти события, вообще говоря, неравновозможны.

Например, для мастеров спорта, по-видимому, исключено событие сОц,

Поэтому/?() = О, т.е. сразу исключается равновозможность.

15

Конечная схема с неравновозможными исходами определяется так.

Имеется конечный набор элементарных событий Q= {(О,,..., (0„}, и для

каждого элементарного события со^ задана его вероятность/?^, О < /?. < 1, причем

п

Y,Pi = 1- Вероятность любого составного события А = {co/i,..., со/^,} опре-

1=1

деляется как сумма вероятностей входящих в него элементарных

событий:

т

P(a)=1p, = 1p„. (1.2.1)

Эта схема является обобщением классической схемы. В самом деле,

если вернуться к случаю равновозможности и приписать каждому

элементарному событию вероятность '/„. то формула (1.2.1) приводит к

классическому определению вероятности.

В случае конечной схемы также верна теорема сложения.

Для двух несовместных событий АиВ, являющихся подмножествами Q,

p(aub)=p(a)+p[b).

□ В самом деле, пусть А = {{0/|,..., со/^}, В = {(Oj^,..., co^}. Согласно

формуле (1.2.1),

р(а)=1р,, P(B)=ipu.

1 = 1 К = |

Поскольку события А, В несовместны, они не имеют общих элементарных

событий и, следовательно, С = A[JB = {со/,, ..., со/^, (Oj^,..., соу^}.

На основании формулы (1.2.1) имеем:

p(c)=ip,^ipj^=p(A)^p(B). ■

Точно так же, как конечная схема с неравновозможными исходами

является обобщением классической конечной схемы с равновозможны-

ми исходами, дискретная схема с бесконечным числом неравновозмож-

ных событий, в свою очередь, является обобщением конечной схемы с

неравновозможными исходами.

В дискретной схеме множество Q = {со,,..., со^,...}, вообще говоря,

содержит счетное число элементарных событий. Для каждого

элементарного события задана его вероятность/?^ = Дсо^), О </?,< 1, причем Ха = 1-

/=1

Вероятность любого конечного либо счетного подмножества/4 с Q

множества элементарных событий Q равна сумме вероятностей

составляющих его элементарных событий, т.е. если A = \J(u, , то

16

Ф)=1Л = 1/'/,. (1.2.2)

т

если же /4 = U^/,> то имеет место равенство (1.2.1).

В конечной схеме, как и в классической, можно вывести формулу

условной вероятности.

Рассмотрим события А = {(0/|,..., щ,..., со/^}, B={(aj^,..., соу,,..., co^J,

такие, что{0/, = а)^|,..., {0/,=й)^р Km, к. Иными словами, /4 ni5= {щ^,..., щ}.

Тогда

/'И=1а,, p(B)=ipj^>o, p(Af]B)=ip,

Ц = 1 К = | Ц = |

Пусть событие В произошло, поэтому имеет место новая конечная

схема с к исходами, к < п, следовательно, сумма вероятностей полного

набора этих новых исходов должна быть равна единице, а она, согласно

первоначальной схеме, равна

к

1

к = 1

1р, = р(в).

Чтобы обеспечить равенство суммы вероятностей элементарных

событий единице, введем новые вероятности исходов:

-_^

в рамках новой схемы (т.е. при условии, что произошло событие В)

определяем вероятность события А:

Р{Л1В\-УЪ -1^-МШ

Таким образом, мы снова пришли к той же формуле условной

вероятности, что и в классической схеме [см. формулу (1.1.4)].

Независимость событий определяется аналогично классической схеме.

В качестве применения конечной схемы в следующей главе будет

исследована схема последовательных испытаний.

Рассмотрим простейшие 'Примеры схемы последовательных

испытаний как иллюстрацию конечной схемы с неравновозможными исходами.

О Пример 1.2. Система контроля изделий состоит из двух независимых

проверок, выполняемых одновременно. Изделие считается годным, если оно прошло

обе проверки. В результате каждой проверки бракованное изделие признается

годным с вероятностями а,, а^ соответственно. Найти вероятность того, что

бракованное изделие успешно пройдет обе проверки.

17

Если на вход системы контроля поступило бракованное изделие, то возможны

следующие четыре элементарных исхода: со, = {О, 0), coj = {О, 1), coj = {1, 0),

0)4 = {1, 1), где О означает, что изделие признано бракованным, 1 - годным.

Испытания независимы, поэтому получаем следующие значения вероятностей

элементарных исходов со = {/,, /j)-'

/,, = /,((0,) = />{/, = О, /, = 0} = (1 - а, )(1 - а,),

/^3=/'К) = «■('-«2)'

Сумма вероятностей элементарных событий должна быть равна единице.

Действительно,

4

Р{П)= Хл =(l-a,)(l-ct2) + (l-a,)a2+a,(l-a2) + a,a2 = 1.

Согласно условиям задачи и сформированной схеме, вероятность

пропустить бракованное изделие есть элементарное событие со^, состоящее в том, что

после первой проверки бракованное изделие будет признано годным и после

второй также, поэтому искомая вероятность р^ = ajUj. •

О Пример 1.3. В условиях примера 1.2 вероятности того, что в результате

первой и второй проверок будет отбраковано годное изделие, равны

соответственно р, и Pj. Найти вероятность отбраковки годного изделия.

Если на вход системы контроля поступило годное изделие, то возможны те

же самые четыре элементарных исхода, однако их вероятности будут другими.

Снова воспользуемся независимостью испытаний, тогда получим следующие

вероятности элементарных исходов:

^, =/?((0, )=/>{/,= О,/2=0} = р,Р2,

^2=/'К) = Р.(1-Р2).

^3=/'К) = (1-Р>)Р2.

^4=/'К) = (1-Р>)(1-Р2)-

Событие, состоящее в том, что отбраковано гбдное изделие, включает в себя

элементарные события ш,, Wj, Ш3, поэтому искомая вероятность равна

Л +Р2 +Рз =PlP2 +Pl(l -Р2) + (1-Р,)Р2 =Pl +Р2 -Р.Р2- •

18

§ 1.3. Исчисление событий

Одним из основных понятий теории вероятностей являются

пространство элементарных событий Q и события как некоторые

подмножества этого пространства. В общем случае пространство D. может быть

любой природы, как конечным, так и бесконечным, как дискретным,

так и непрерывным.

Рассмотрим, например, стрельбу по мишени. Если нас интересует

только сам факт попадания в мишень, то элементарными исходами

служат (О = 1 (попадание в мишень) и со = О (непопадание в мишень). Если

важно попадание в отдельные области мишени (области различаются с

точки зрения уязвимости реальной цели), то элементарными

событиями могут быть (0,0 = 10, (О, = 9, ..., со, = 1 (соответствуют числу очков,

приписанных попаданию в определенную область) и cOq = О

(непопадание в мишень). Наконец, если существенно важно, в какую именно

точку щита, на котором изображена мишень, произошло попадание, то

произвольный элементарный исход со = {х, у) представляет собой

координаты точки попадания, а пространство элементарных событий Q — это

множество точек щита.

Итак, пусть имеется пространство элементарных событий D. любой

природы. Будем рассматривать в качестве событий подмножества А, В,

С,... этого пространства. В таком случае действия над событиями

становятся действиями над подмножествами.

Событие А происходит тогда и только тогда, когда происходит одно

из элементарных событий со, из которых состоит А. Напомним

некоторые отношения между событиями, введенные ранее. События А и В

несовместны, если наступление одного из них исключает наступление

другого. Но ведь это означает, что Ан Вне имеют ни одного общего

элементарного события, т.е. не пересекаются.

Аналогично, событие А + В эквивалентно объединению A\JB,

т.е. множеству элементарных событий, которые входят или в А, или в В,

а событие АВ— пересечению АПВ, т.е. множеству элементарных

событий, которые являются общими для А и В. Операции объединения и

пересечения множеств симметричны, т.е.

A\JB = B\JA, Af]B = Bf]A.

Событие, которое включает все элементарные события, те. совпадает с

пространством элементарных событий Q, называется достоверным. Отсюда

Можно сделать вывод, что для любого события А ПЛ = А. Пустым

(невозможным) называется событие 0, которое не содержит ни одного элемента.

Отсюда два события Ан В несовместны, если АГ\В=0. Очевидно, A\J0 = A.

Напомним, что теоретико-множественной разностью двух событий А

и В называется такое событие А\В, которое содержит те элементарные

19

события, принадлежащие А, которые не входят в В. Отсюда событие А,

противоположное событию А, есть Л\А. В самом деле, Af]{D.\A) = 0 и

A\J(il\A) = Q, т. е., действительно, А =П\А. В частности, Q = 0, 0 = Q.

Иногда используется симметрическая разность событий С = А^В,

представляющая собой такое событие, в которое входят те

элементарные события, которые входят в А или В, но не входят в их пересечение

Af]B. Таким образом, эта операция может быть представлена с помощью

уже введенных операций следующим образом:

C = A^B = {A\B)\J{B\A).

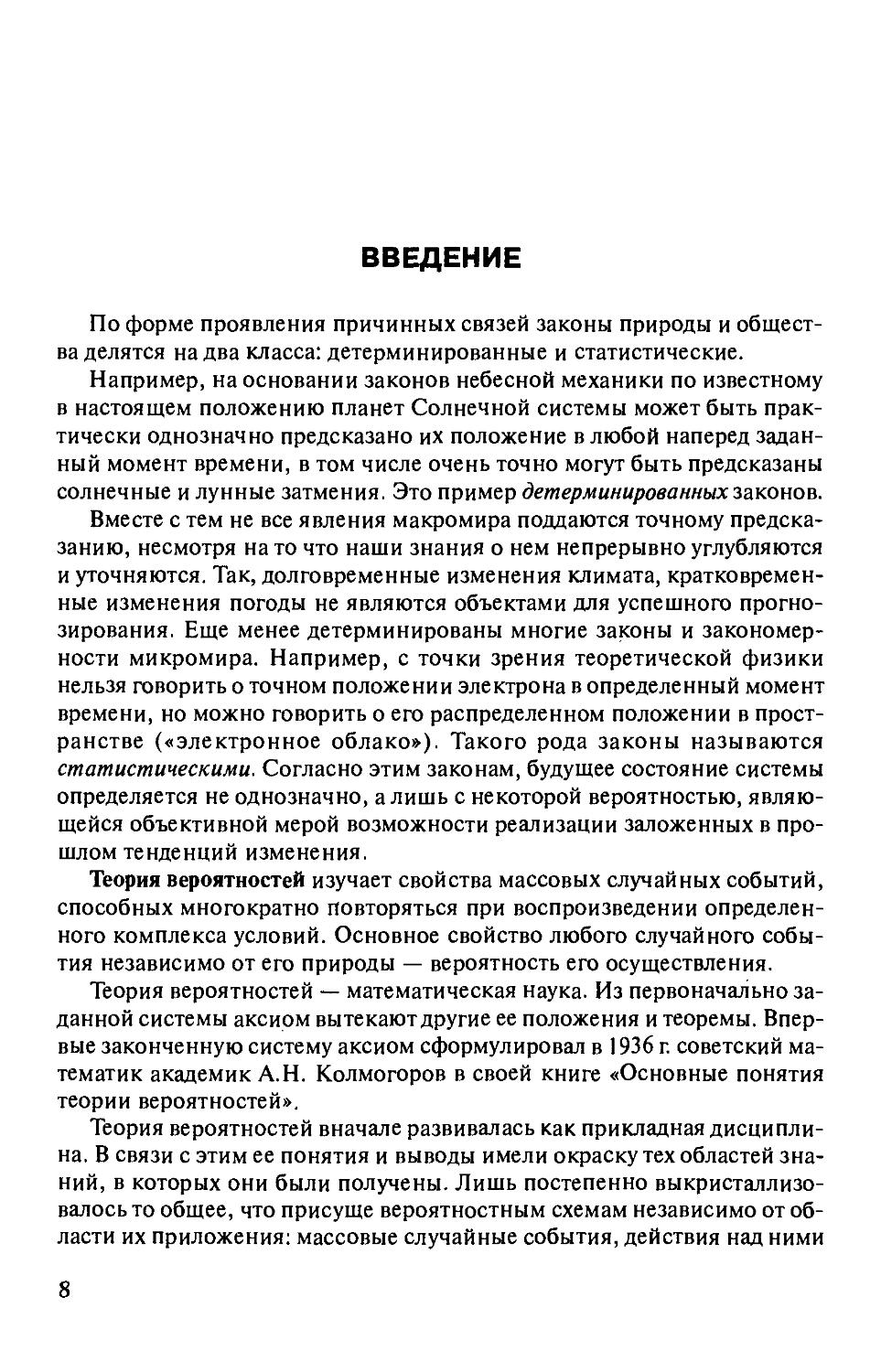

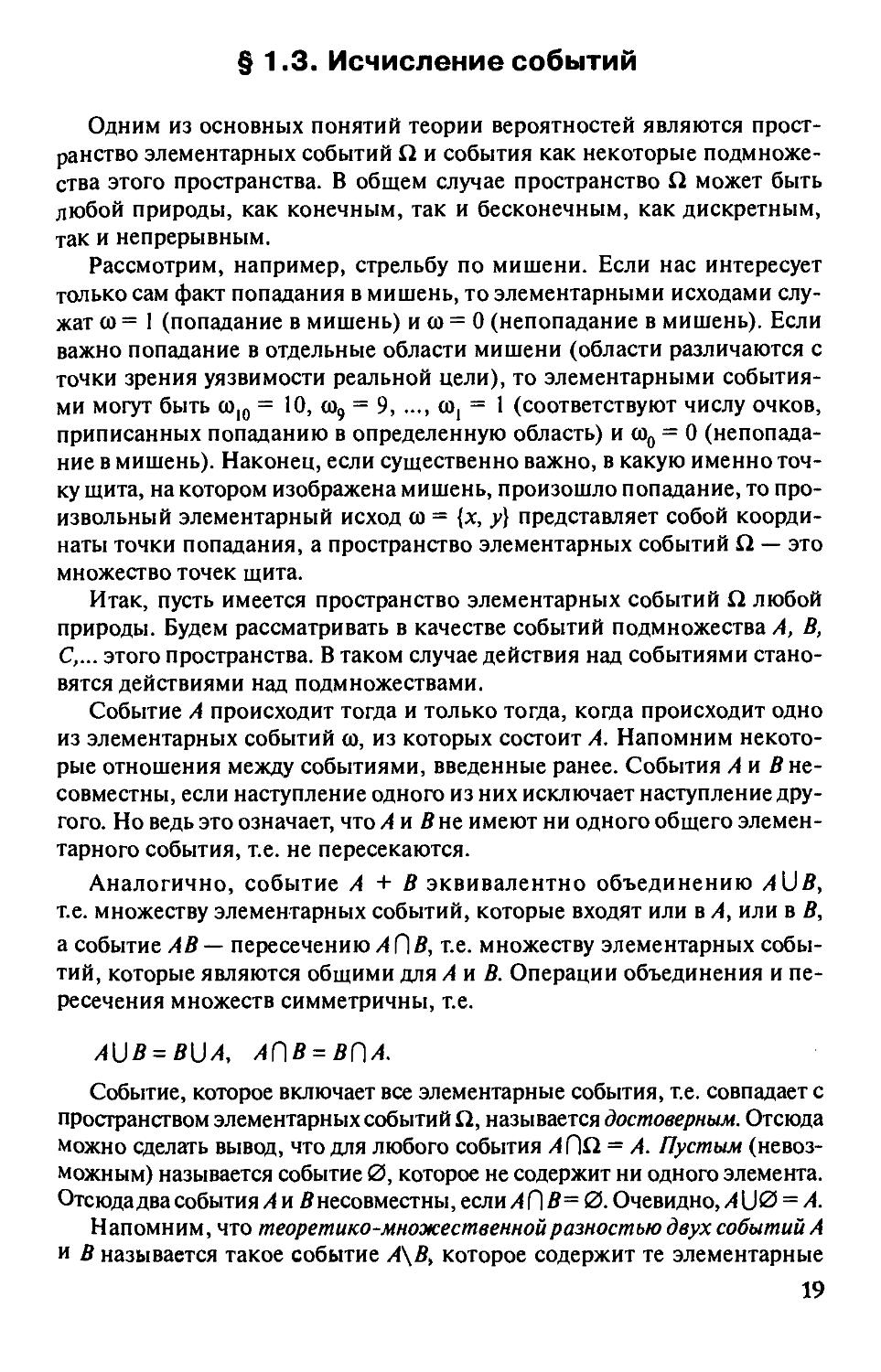

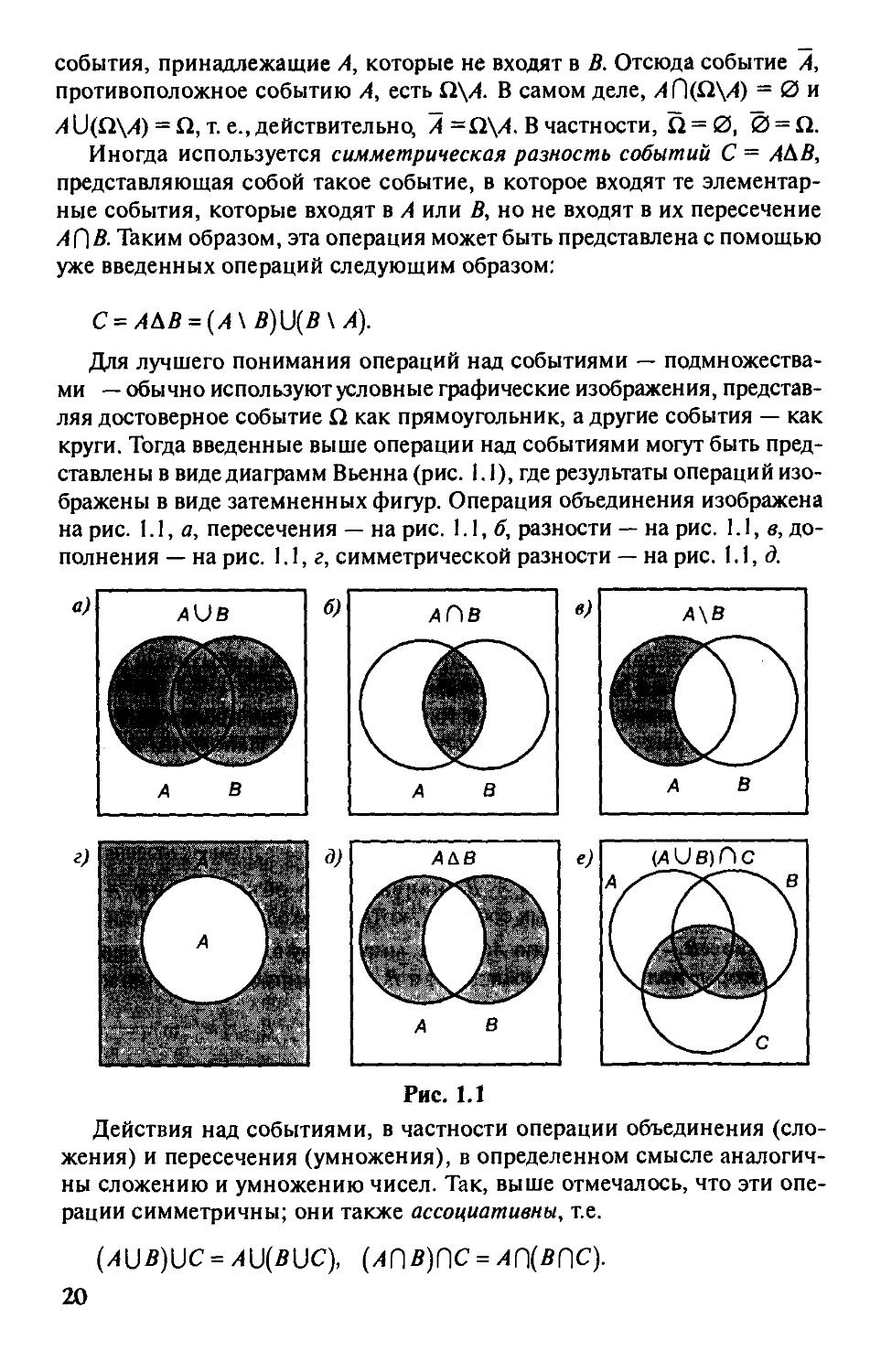

Для лучшего понимания операций над событиями —

подмножествами — обычно используют условные графические изображения,

представляя достоверное событие Q как прямоугольник, а другие события — как

круги. Тогда введенные выше операции над событиями могут быть

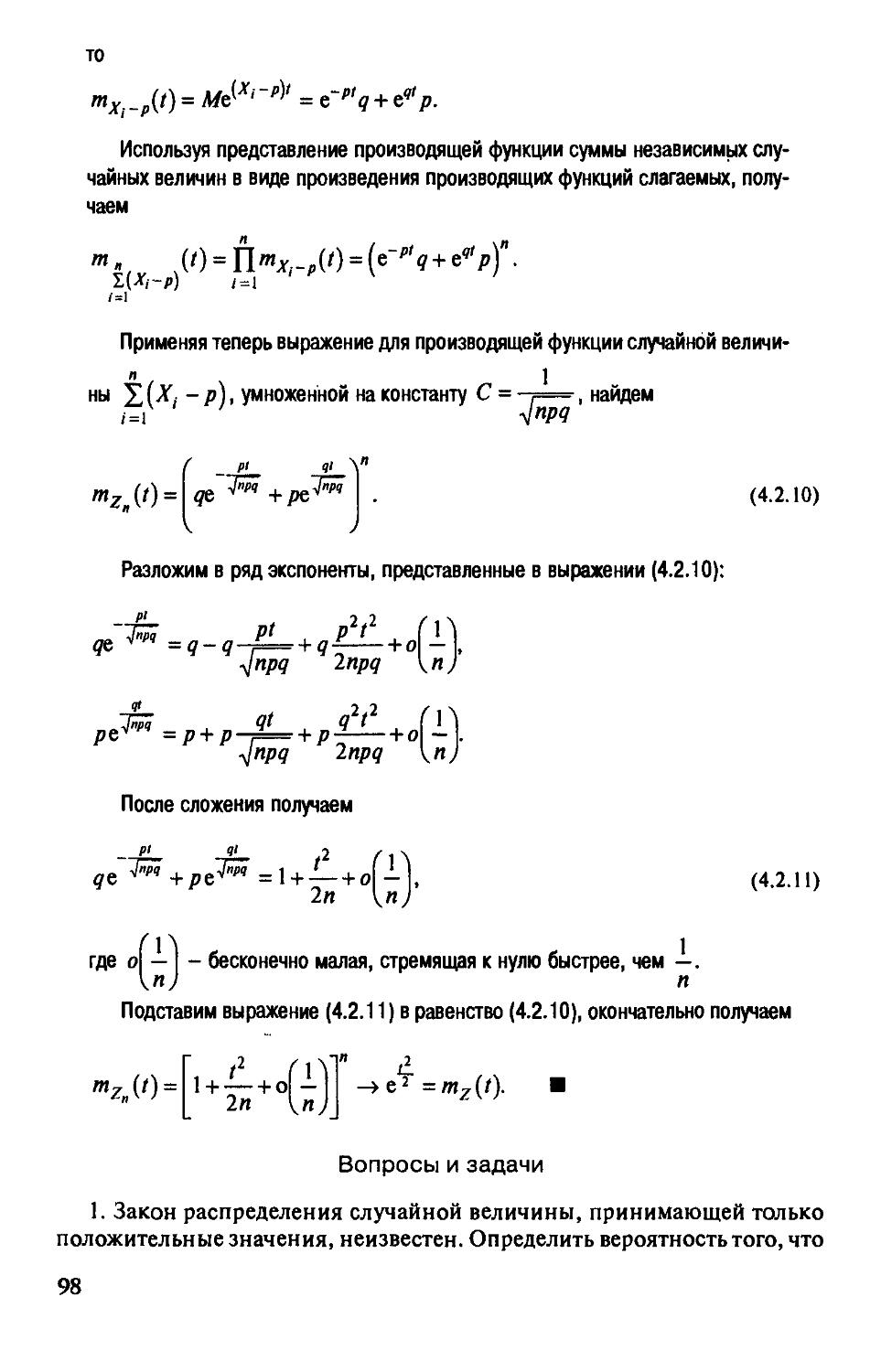

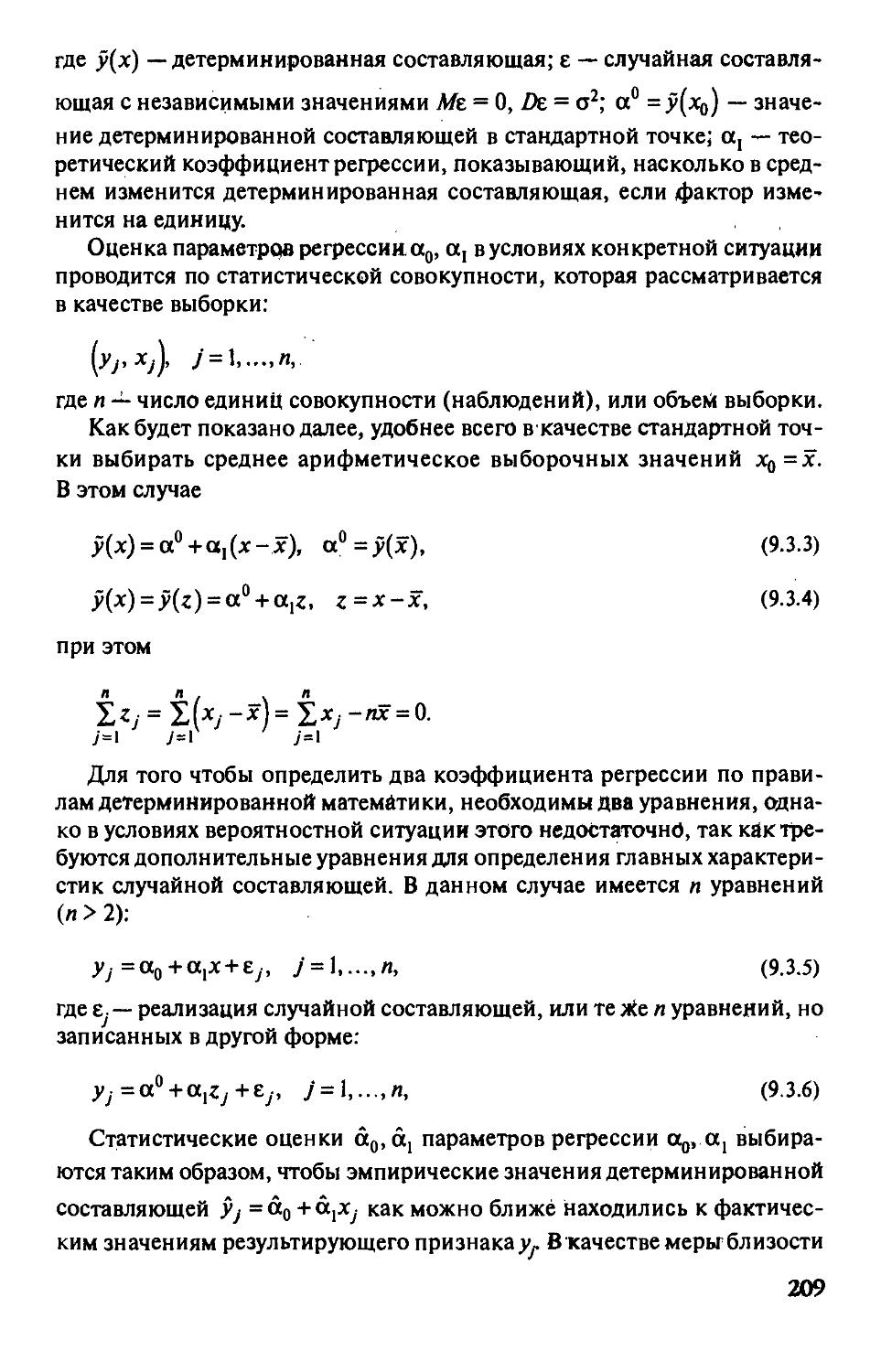

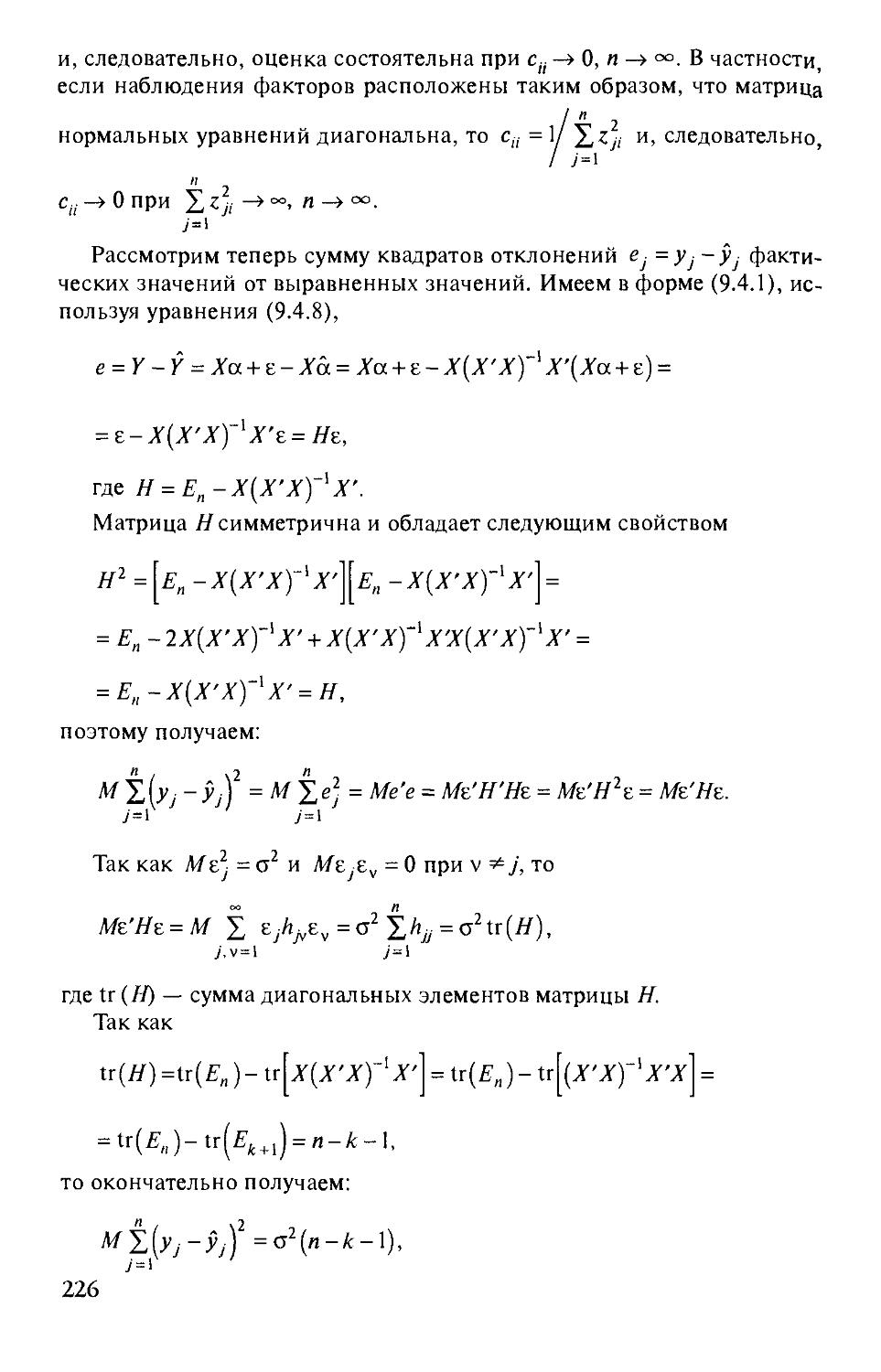

представлены в виде диафамм Вьенна (рис. I. I), где результаты операций

изображены в виде затемненных фигур. Операция объединения изображена

на рис. \Л, а, пересечения — на рис. 1.1,^, разности — на рис. 1.1, в,

дополнения — на рис. 1.1, г, симметрической разности — на рис. 1.1, d

д)

А&В

А^ци^^

fp.'^'f ^

\ "if \

А

Т'Гх

^Фщ

^^K.«fw

в

Рис. 1.1

Действия над событиями, в частности операции объединения

(сложения) и пересечения (умножения), в определенном смысле

аналогичны сложению и умножению чисел. Так, выше отмечалось, что эти

операции симметричны; они также ассоциативны, т.е.

{AUB)\JC = A\J{B\JC), {АПВ)ПС = АП{ВПС).

20

Кроме того, эти операции, так же как и операции над числами,

обладают свойством дистрибутивности:

{A\JB)nC = {AnC)\J{BnC). (1.3.1)

Q Множество Z)=И и^ П С изображено в виде диаграммы Вьенна на рис. 1.1, е,

Как видно из этой диаграммы, пересечение множества С и объединения /4 U Я

состоит, вообще говоря, из объединения трех непересекающихся частей:

D = [{A\ В)ПС]и[{В \ А)ПС][\{АПВ)Г\С].

Так клкА = А \JA при любом А, то

D = [{A\ В)ПС]и[{В \ А)ПС]и[{АПВ)ПС]Ц{АПВ)ПС].

Используя теперь свойство симметричности операций объединения,

объединим первый и третий операнды, второй и четвертый:

[{А \ В)Г\С][\{АПВ)ПС] = АПС; [{В \ А)Г\С][\{АГ\В)Г\С] = ВПС,

откуда окончательно получаем D = [АГ\С)и{ВГ\С), т.е. свойство

дистрибутивности действительно выполняется. ■

Другое сходство с действиями над числами заключается в том, что для

операции пересечения роль, аналогичную роли единицы и нуля при

умножении чисел, выполняют соответственно множества Q и 0, так как

Clf]A = А, АГ\0. = Ак 0Г\А = АГ\0 = 0. Вместе с тем

теоретико-множественные равенства /4Ш = А, Af]A = А и им подобные показывают, что

полной аналогии нет.

Действия над событиями важны не сами по себе, а как средство

определения вероятностей одних событий через вероятности других

событий. Так, например, если верна теорема сложения вероятностей, то

вероятность события С, являющегося объединением несовместных событий А

и В, равна сумме вероятностей последних событий PiQ = Р{А)+ Р{В), что

позволяет найти вероятность одного из трех событий через известные

вероятности двух других. Точно так же, если для событий А, Ви C=Af]B

справедлива теорема умножения, можно выразить вероятность одного

события через вероятности двух других:

Р{С) = Р{А)Р{В).

В случае конечной или счетной теоретико-вероятностной схемы,

рассмотренной в предыдущем параграфе, в качестве события

рассматривалось любое подмножество конечного или счетного пространства

элементарных событий Q. и вероятность события определялась как сумма

вероятностей входящих в него элементарных событий. Если же пространст-

21

во Q непрерывно, то имеет место континуум элементарных исходов.

Попытка считать событием любое подмножество непрерывного

пространства Q. сопряжена с большими трудностями.

Поэтому в общем случае приходится иметь дело не со всеми

подмножествами пространства Q., а лишь с определенным классом, замкнутым

относительно операций объединения, пересечения, дополнения.

Класс подмножеств пространства Q., замкнутый относительно

операций объединения, дополнения и пересечения, а также содержащий

множества 0, С1, называется полем. Будем обозначать поле буквой S.

Минимальное поле Sq состоит из полного и пустого множеств S^ = {0,0]. В

самом деле, 0 и Q входят в этот класс, а результатами операций

объединения, дополнения и пересечения над этими множествами снова служат

данные множества: 0\JQ. = CI, 0ПЙ = 0, 0 = Q, Q = 0. Другим, более

содержательным примером поля событий служит класс из четырех

событий S= {0, А, А, О]. Действительно,

0\jA = A, 0\jA = A, 0un=n, A\jA=a, A\jci=a A\jci=a

0ПА = 0, 0Г\А=0, 0Г\С1 = 0, АПА=0, АПП = А, АПП = А,

0 = П, А = А, П = 0.

§ 1.4. Аксиоматическое построение

теории вероятностей

При аксиоматическом построении теории вероятностей исходным

«материалом» служит пространство элементарных событий Q. и выделенный в

нем класс подмножеств, образующий поле событий S. Строение

пространства Q. и класса 5определяется конкретной областью приложения.

Определение 1.1. Вероятностью называется числовая функция,

определенная на поле событий 5 и обладающая следующими свойствами:

Аксиома I. Вероятность любого события Ае S

0<Р(А)< 1.

Аксиома 2. Вероятность достоверного события равна единице:

Р(С1)=\.

Аксиома 3. Вероятность объединения двух несовместных событий

равна сумме вероятностей этих событий:

P{A\JB) = P{A) + P{B), Af)B = 0.

22

Проверим, например, что конечная схема удовлетворяет условиям

этих аксиом. Напомним, что конечная схема задается конечным

множеством элементарных событий Q = {со,,..., (аJ и вероятностями каждо-

ГО из них о < />,. < 1, причем Хл =' • Вероятность любого события А,

являющегося подмножеством С1, те. А = {щ^, ..., Ш/^}, определяется по

формуле:

т

Pi^)=lPi = lP>r (1.4.1)

Класс S всех подмножеств Q. образует поле. В самом деле, 0 и Q

являются подмножествами, поэтому принадлежат S; очевидно также, что

для любых событий А е S, В е 5 их объединение и пересечение также

являются подмножествами Q; А, В — также подмножества.

Теперь проверим, что конечная схема удовлетворяет требованию

аксиомы 1. Для этого выберем произвольное событие А, которое является

подмножеством Q, так какА = {(0/|,..., ш/^}, то, согласно конечной схеме,

т

поэтому

0^Р(А)<1,

т.е. условие аксиомы 1 выполняется.

Условие аксиомы 2 выполняется, поскольку Q. = {со,, ..., ш^} и на

основании формулы (1.4.1)

<=1

Условие аксиомы 3 также выполняется, так как оно представляет

собой содержание теоремы сложения для конечной схемы. Эта теорема

была доказана в § 1.2.

Итак, конечная схема является примером объекта, для которого

выполняется система аксиом теории вероятностей.

Простейшим частным случаем конечной схемы служит

вероятностное описание испытания, которое может закончиться успехом или

неудачей. В этом случае Q. = {Шц, со,} состоит из двух элементарных

событий: (0(, = 0— неуспех в испытании, со, = 1 — успех в испытании,

Дш,) = р, Р{ы^ = 1 -Pz4- Поле в данной ситуации состоит из четырех

событий: 0, А ={(0,}, А = {(Од}, Q. = {(Од, со,}.

В качестве примера вероятностей схемы с непрерывным

пространством элементарных событий рассмотрим схему с геометрическими

вероятностями. Пусть пространством элементарных событий служит множё-

23

ство точек некоторой области G, имеющей площадь на плоскости. В

качестве событий будем рассматривать имеющие площадь подмножества

Л, В, С,... этой области. Самостоятельно докажите, что класс таких

подмножеств образует поле. При этом вероятность любого события Л

(подмножества, имеющего площадь mes (Л)), можно задать следующим

образом:

mesi^

^ ' mes (С/)

Докажите (по аналогии с конечной схемой), что описанная схема

удовлетворяет аксиомам теории вероятностей. Аналогично можно

построить геометрические вероятности в любом конечномерном

пространстве.

Из аксиом теории вероятностей вытекает ряд следствий, которые

могут быть доказаны так же, как это было сделано для классической

схемы. Предлагаем самостоятельно доказать утверждения, содержащиеся в

задачах к настоящей главе.

Во многих случаях требуется расщиренный вариант аксиомы 3.

А именно, аксиома 3 постулирует сложение вероятностей для

конечного числа несовместных событий, в то время как в расщиренном

варианте речь идет о счетном числе несовместных событий.

Аксиома 3'. Если

A^eS, 1 = 12,..., Aif]Aj=0, i^j.

то

ил

'■ = ' у

1рМ

(=1

Аксиомы теории вероятностей лищь постулируют существование

вероятностей для всех событий, образующих поле S, и задают

определенные правила действия с вероятностями.

Экспериментальное же определение вероятности любого события

А 6 Сможет быть осуществлено в результате испытаний, выполняемых

при определенном одном и том же комплексе условий. Как будет

показано ниже, выборочная частость т/п появления события А при больщом

числе испытаний п является достаточно хорощей оценкой

теоретической вероятности р = Р{А), что означает сходимость в некотором смысле

т

— =»/)при л-» оо.

п

Например, если событие А представляет собой выпадение «герба» при

однократном бросании симметричной монеты, то, согласно

классическому определению вероятности, Р{А) = '/2> поэтому есть основание счи-

24

тать, что при многих испытаниях частость выпадения «герба» близка к

I/,. Действительно, в XVII в. Бюффон провел такие эксперименты. В

результате оказалось: при 4040 бросаниях монеты частота выпадения

«герба» составила 2048, что дает частость, равную 0,507. Английский

статистик К. Пирсон провел 24 000 таких опытов, частость оказалась равной

0,5005.

Итак, определенная теоретико-вероятностная схема задается тремя

компонентами {Q, S, Р}, те. конкретным пространством элементарных

событий, конкретным набором подмножеств Q, образующих поле S,

а также конкретным заданием вероятностей Р на множествах поля.

Набор этих трех компонент далее везде будем называть вероятностным

пространством. Вероятность Рна {С1, S\ называется распределением

вероятностей на Q.

Вопросы и задачи

1. Опираясь на аксиомы теории вероятностей, докажите следующие

утверждения: а) Р{А)= \ - Р{Ау, б) 1\0) = 0; в) Р{А) > Р{В) при A:dB;

г)Р(А)<\.

2. Покажите, что из аксиомы 3 вытекает следующее следствие:

и 4 =1 ^(4) при 4 П /1, = 0 для I * j.

( = 1

3. Докажите, что для любых событий А, В имеет место следующая

формула сложения:

P{A\JB) = Р{А) + Р{В)- P{AV[B).

4. /4,, А^,..., А^ — случайные события. Доказать для л = 3, 4 формулу:

( = 1 ) ( = 1 \Si<jSn lii<j<kSn

5. Партия изделий состоит из т изделий 1-го сорта и п изделий 2-го

сорта. Проверка первых к изделий, выбранных из партии наудачу,

показала, что все они 2-го сорта (к < п). Чему равна вероятность того, что

среди следующих двух наудачу выбранных из оставщихся изделий по

меньщей мере одно окажется 2-го сорта?

6. Двое договорились о встрече в течение определенного часа. При-

шедщий первым ждет 20 мин и уходит. Какова вероятность встречи?

25

Указан и е. Рассмотреть вероятность как отношение площадей

множества точек (исходов), благоприятствующих встрече, и множества

возможных исходов. _

7. Докажите, что из независимости А, Д вытекает независимость/4, В;

А, В', В, А.

Глава 2

УСЛОВНЫЕ ВЕРОЯТНОСТИ.

ПОСЛЕДОВАТЕЛЬНОСТИ ИСПЫТАНИЙ

Все теоремы и формулы теории вероятностей и математической

статистики выводятся из аксиом теории вероятностей. В этой главе дается

определение условной вероятности, доказываются наиболее часто

используемые теоремы и формулы, основанные на условных

вероятностях. Вводится понятие независимости событий, которое затем

используется в схеме последовательных испытаний.

§ 2.1. Условные вероятности

в § 1.1 формула условной вероятности была выведена для

классической схемы. В общем случае эта формула служит определением условной

вероятности события А при условии, что произошло событие В, Р{В) > 0.

Определение 2.1. Условная вероятность события А при условии В

^ ' ' Р{В)

Определение 2.2. Событие А не зависит от события В, если

Р[А1В) = Р{А).

Независимость событий взаимна, т.е. если событие А не зависит от В,

то и событие В не зависит т А.Ъ самом деле, используя определения 2.1

и 2.2, при Р{А) > О имеем:

Из определения 2.1 вытекает следующая формула умножения

вероятностей:

Р{А(\В)^Р{А)Р{В1А). (2.1.1)

27

Для независимых событий вероятность произведения событий равна

произведению их вероятностей:

Р{А[)В) = Р{А)Р{В). (2.1.2)

Определение 2.3. События/4,,/42, ...,/4^ образуют полную группу

событий, если они попарно несовместны и вместе образуют

достоверное событие, т.е.

Aif)Aj=0, 1Ф], иД="-

Имеет место следующая теорема о формуле полной вероятности.

Теорема 2.1. Если события A^,..., А^, /Х'4,)>0 образуют полную группу

событий, то вероятность события Д может быть представлена как сумма

произведений безусловных вероятностей событий полной группы на

условные вероятности события В:

P{B)=tp{A^)P{B/A^). (2.1.3)

Q События полной группы /4,,..., А^ попарно несовместны, поэтому попарно

несовместны и их произведения (пересечения) с событием В, т.е. события ВГ\ А.,

BHAj при i^^j несовместны. Так как событие В можно представить в виде

B=\j{Bf)A^),

1 = 1

то, применив к этому разложению события В аксиому сложения вероятностей,

имеем:

Р{В)=±Р{ВПА,).

Используя формулу умножения вероятностей (2.1.1) для каждого

слагаемого, окончательно получаем:

P{B)=tp{A,)p{B/A^). ■

Требование, состоящее в том, что события /4^. образуют полную

группу событий, может быть заменено более слабым: события попарно не

я

пересекаются, В с: U4 • Кроме того, на основе аксиомы счетной адди-

тивности теорему полной вероятности можно распространить и на счет-

28

ное множество попарно непересекающихся событий А^, Р(А^) > О,

( = 1

Р{В)=1^Р{А^)Р{В/А^). (2.1.4)

( = 1

Из формулы полной вероятности (2.1.3) легко получить формулу Бай-

еса: для события В с Р{В) > О и для системы попарно несовместных

событий/1,, Д'^,) > О, B<z\jAi,

( = 1

. . р(аЛр(в/аЛ

P{AJB)= ^\ ki \ I ki (2.1.5)

ЪР{А)Р[В1Л,)

( = 1

в самом деле, применив формулы условной вероятности и

умножения вероятностей, имеем:

теперь, заменив вероятность события В по формуле полной

вероятности, получаем формулу (2.1.5),

Вероятности Р{А) событий А. называют априорными вероятностями,

т.е. вероятностями событий до выполнения опыта, а условные

вероятности этих событий Р{А./В) — апостериорными, т.е. уточненными в

результате опыта, исходом которого послужило появление события В.

О Пример 2.1. На предприятии изготовляются изделия определенного вида на

трех поточных линиях. На первой линии производится 20% изделий от всего

объема их производства, на второй - 30%, на третьей - 50%. Каждая из линий

характеризуется соответственно следующими процентами годности изделий: 95,

98 и 97%, Требуется определить вероятность того, что наугад взятое изделие,

выпущенное предприятием, окажется бракованным, а также вероятности того,

что это бракованное изделие сделано на первой, второй и третьей линиях.

Решение, Обозначим через A^, А^, А^ события, состоящие в том, что

наугад взятое изделие произведено соответственно на первой, второй и третьей

линиях. Согласно условиям задачи P(A^) = 0,2; PiA^) = 0,3; Р(,А^) = 0,5

и эти события образуют полную группу событий, поскольку они попарно

несовместны, т.е. PiA^) + Р(А^) + Р(А^) = 1.

Обозначим через В событие, соаоящее в том, что наугад взятое изделие

оказалось бракованным. Согласно условиям задачи Р {В/А^) = 0,05; Р (В/А^) = 0,02;

Р(В/А^) = 0,03,

29

Используя формулу полной вероятноаи, получаем P{B)^P{B/A^)P{A^) +

+ Р{В/А^)Р{А^) + Р(В/А^)Р{А^) = 0,05 0,2 + 0,020,3 + 0,03-0,5 =

= 0,031, т.е. вероятность того, что наугад взятое изделие окажвгся

бракованным, равна 3,1%.

Априорные вероятности того, что наугад взятое изделив изготовлено на

первой, вгорой или третьей линии, равны соответственно 0,2; 0^3 и 0,5.

Допустим, что в результате опыта наугад взятое изделие оказалось

бракованным; определим теперь апостериорные вероятности того, что это изделие

изготовлено на первой, второй и третьей линиях. По формуле Байеса имеем:

^ '' ' 0,031 31 ^ ^' ' 0,031 31

ы J ,п\ 0,03.0,5 15

' " ' 0,031 31

Таким образом, вероятности того, что наугад взятое и оказавшееся

бракованным изделие изготовлено на первой, второй или третьей линии, равны

соответственно 0,322; 0,194; 0,484. •

Формула умножения вероятностей (2.1.1) может быть

распространена на случай произвольного конечного числа событий:

/'(/1,П/12П...П/1„) = /'(/1,И^2/Л)-'РК/ЛП/<2П...П/1„_,). (2.1.6)

Определение 2.4. События /4,, А^,..., А^ независимы в

совокупности, если для любого их подмножества

ф,, ПЛ, П...П4,) = /'КЖ.)-''К). к<п.

Если это условие выполнено только для А; = 2, то события попарно

независимы.

Из независимости событий в совокупности вытекает попарная

независимость, а из попарной независимости не следует независимость в

совокупности.

§ 2.2. Последовательности испытаний

Пусть прпвплится конечное число л последрвательных независимых

испытаний, в каждом из копгррых может п1Юизойтирг1ределенное

событие: либо успех, либо противоположное событие —, чеудача. Такая

последовательность испытаний называется, сх€^мой,£ернулли, если

вероятности положительного исхода в каждом испытании о/^инаковы.

30

в качестве таких испытаний можно рассматривать, например,

производство изделий на определенном оборудовании при постоянстве

технологических и организационных условий, в этом случае изготовление

годного изделия — успех, бракованного — неудача. Эта ситуация

соответствует схеме Бернулли, если считать, что процесс изготовления

одного изделия не зависит от того, были годными или бракованными

предыдущие изделия. Другим примером является стрельба по мишени.

Здесь попадание — успех, промах — неудача. Если же речь идет о

выборочном контроле качества конечной партии изделий объема N по

выборке объема п, то даже при независимости и случайности отбора

единиц совокупности отдельный акт отбора зависит от того, сколько на

предшествующих этапах было извлечено годных изделий и бракованных

изделий. Ниже будет показано, что при N-¥ оо эта гипергеометрическая

(урновая) схема, рассмотренная в § 1.1, переходит в схему Бернулли.

В схеме Бернулли одному испытанию соответствует множество

элементарных исходов, состоящее из двух элементарных событий: {Шц, со,},

(Од = О (неудача) и со, = Г (успех), при этом А = {со,}, А = {щ}. Множество

элементарных исходов для п испытаний состоит уже из 2" элементарных

событий (О = {/,, ..., /д}, каждое из которых соответствует конкретному

исходу испытаний, при этом набор /,,..., /^ представляет собой

конкретную последовательность нулей и единиц, соответствующую результатам

испытаний на каждом шаге.

Если заданы вероятности успеха и неудачи в отдельном испытании

Дш,) = р; Pioif)) = 1 - /> = ^, то можно определитъ вероятность любого

элементарного исхода в п испытаниях. Действительно, рассмотрим

любой элементарный исход (/,,..., /„), при этом (<,, ij,..., /„) — конкретная

последовательность нулей и единиц, соответствующая

последовательности неудач или успехов в каждом из п индивидуальных испытаний,

например (0 = (1, О,..., 1).

Тогда, поскольку результаты отдельных испытаний независимы друг

от друга, получаем:

P{(x>) = P{(x>^)p{(x>o)■■■P{^x>^)= ... =pq-p.

Таким образом, если общий элементарный исход включает т успехов

» п - т неудач, то его вероятность

Р{о)) = р'"д"-'", ' (2.2.1)

и, следовательно, по аксиоме сложения вероятностей может быть

определена вероятность любого события, состоящего из нескольких

элементарных событий.

В частности, если нас интересует вероятность Р^т) того, что в п

испытаниях произошло т успехов, то ее определяем как сумму

вероятностей элементарных событий, характеризующихся т успехами. Вероят-

31

ность такого элементарного исхода, согласно формуле (2.2.1), равна

р1"дп-т Следовательно, для нахождения вероятности Р„(.т) надо

определить число элементарных событий, характеризующихся т успехами,

т.е. установить, сколькими способами могут быть на п мест расставлены

т единиц (остальные п - т мест занимаются нулями). Но ведь это

аналогично тому, что из п элементов надо выбрать (пометить) т элементов.

Число таких выборок, как известно, равно числу сочетаний из п по т,

т.е. С". Окончательно получаем

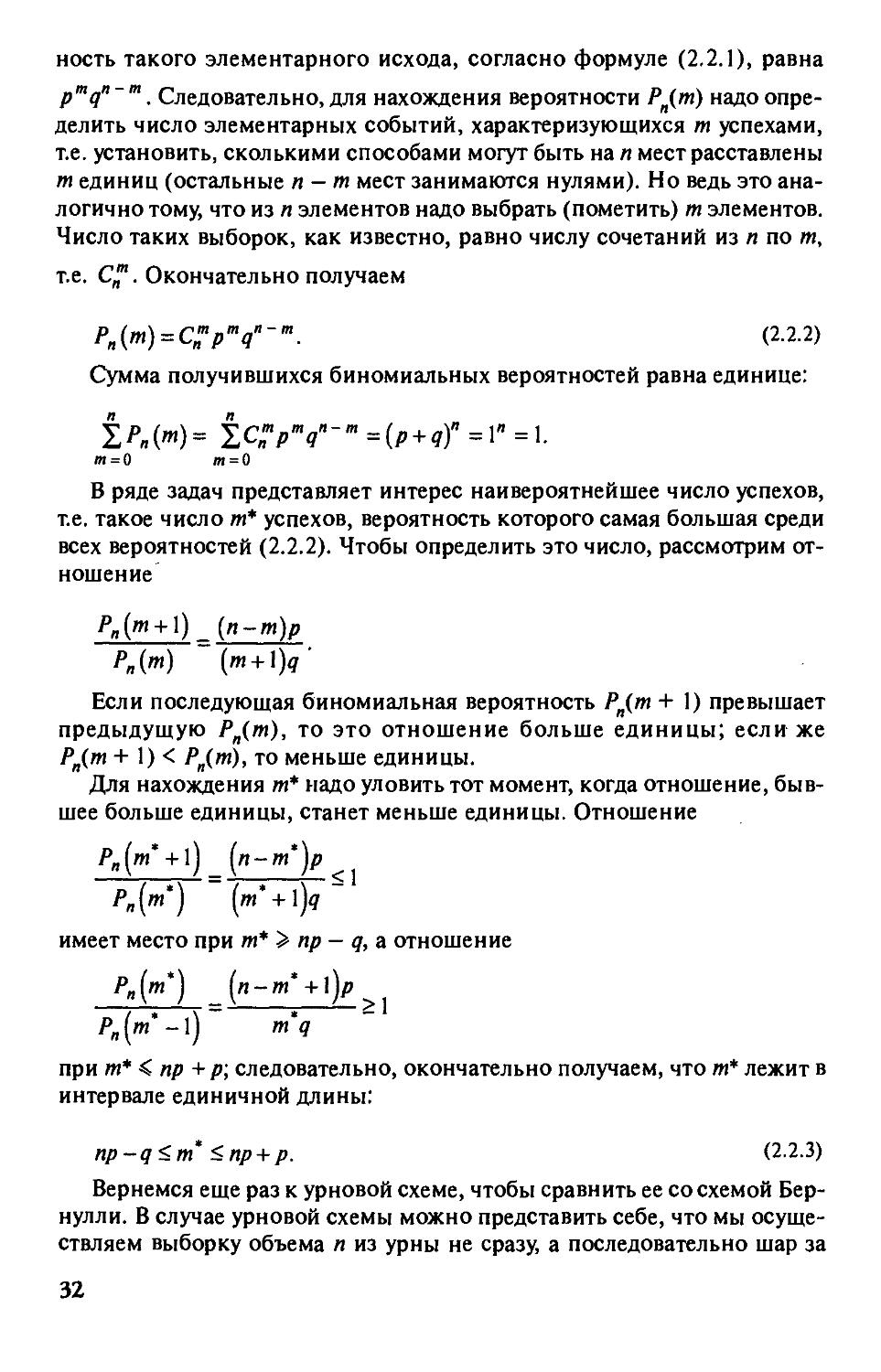

P„{m) = C:'p'"q"-'". (2.2.2)

Сумма получившихся биномиальных вероятностей равна единице:

!/>„(/«)= tc:p'"q"-'"=ip + q)"=\"=l

т = 0 т = 0

В ряде задач представляет интерес наивероятнейшее число успехов,

те. такое число т* успехов, вероятность которого самая большая среди

всех вероятностей (2.2.2). Чтобы определить это число, рассмотрим

отношение

Р„{т + \)^{п-т)р

Р„{т) ('« + 1^'

Если последующая биномиальная вероятность PJ,m + 1) превышает

предыдущую P„{fn), то это отношение больше единицы; если же

Р^{т + 1) < Р„(т), то меньше единицы.

Для нахождения т* надо уловить тот момент, когда отношение,

бывшее больше единицы, станет меньше единицы. Отношение

Р„(т* + \) ^(п-т')р ^^

/>„(/«*) (т* + \)д~

имеет место при т* > пр - q, а отношение

Р„(т*) ^(n-m' + l)p ^^

Р„[т*-\) m'q

при т* <: пр + р; следовательно, окончательно получаем, что т* лежит в

интервале единичной длины:

np-q<m' <пр + р. (2.2.3)

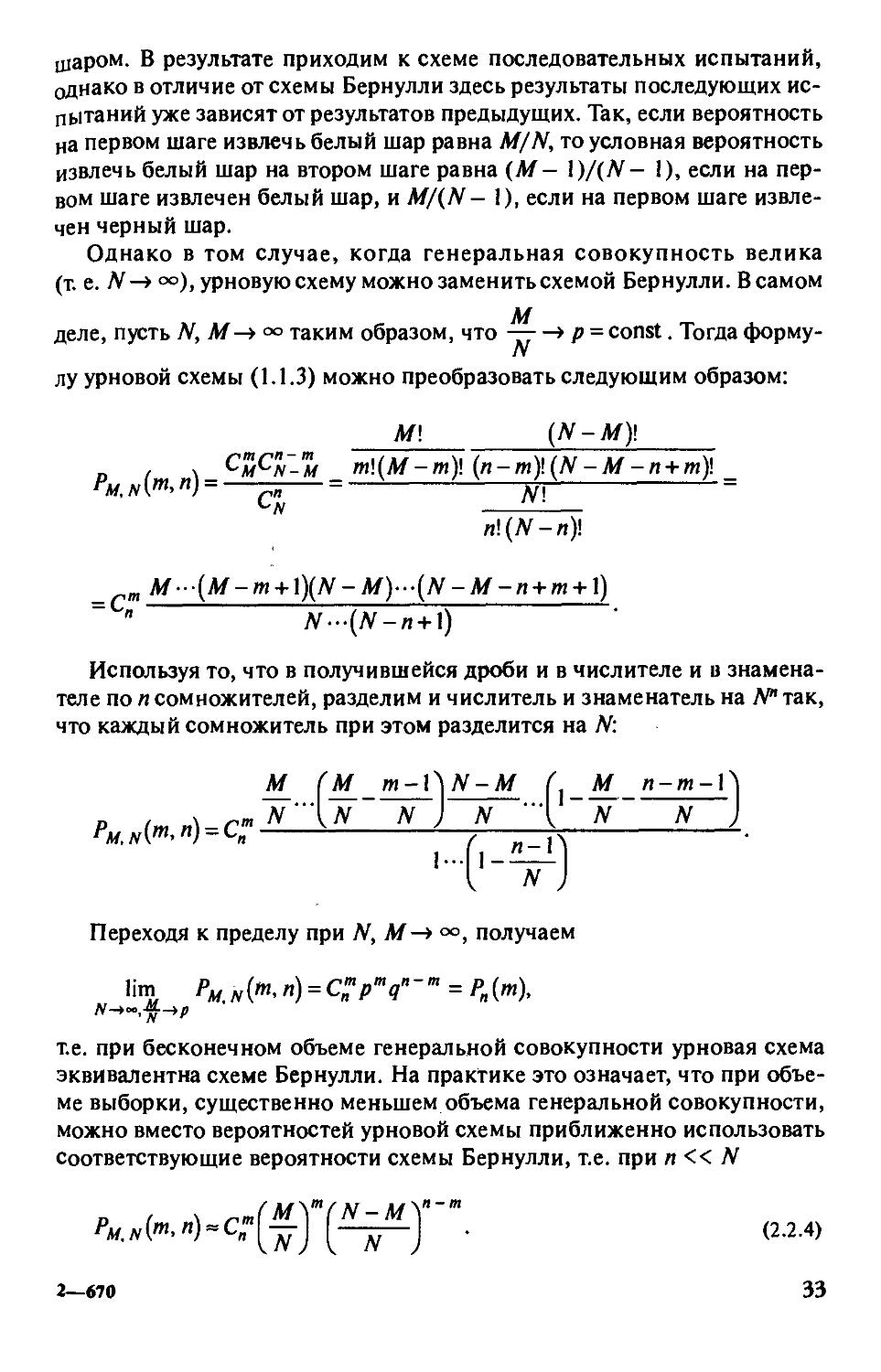

Вернемся еще раз к урновой схеме, чтобы сравнить ее со схемой Бер-

нулли. В случае урновой схемы можно представить себе, что мы

осуществляем выборку объема п из урны не сразу, а последовательно шар за

32

шаром. В результате приходим к схеме последовательных испытаний,

однако в отличие от схемы Бернулли здесь результаты последующих

испытаний уже зависят от результатов предыдущих. Так, если вероятность

на первом шаге извлечь белый шар равна M/N, то условная вероятность

извлечь белый шар на втором шаге равна (А/- 1)/(УУ- 1), если на

первом шаге извлечен белый шар, и M/(N- 1), если на первом шаге

извлечен черный шар.

Однако в том случае, когда генеральная совокупность велика

(т е. УУ-»оо),урновую схему можно заменить схемой Бернулли. В самом

А/

деле, пусть N, М-¥оо таким образом, что -гг-* Р = const. Тогда форму-

N

лу урновой схемы (1.1.3) можно преобразовать следующим образом:

М\ {N-M)\

D ( \_^m^"n'-'m т\{М-т)\ {n-m)\{N-М-п + т)\ _

О/, yvl'"'") ps ^1

С

n\{N-n)\

M-{M-m + \){N-M)--{N-M-n + m + \)

N-{N-n + \)

Используя то, что в получившейся дроби и в числителе и в

знаменателе по п сомножителей, разделим и числитель и знаменатель на Л*" так,

что каждый сомножитель при этом разделится на Л'^:

Переходя к пределу при N, М-*°°, получаем

Jim PM.Nifrt,n) = C;;'p'"q"-'" = Р„{т),

те. при бесконечном объеме генеральной совокупности урновая схема

эквивалентна схеме Бернулли. На практике это означает, что при

объеме выборки, существенно меньшем объема генеральной совокупности,

можно вместо вероятностей урновой схемы приближенно использовать

Соответствующие вероятности схемы Бернулли, т.е. при п « N

Рм.Агг'<")-C:\jj-j [—j;^j ■ (2.2.4)

2—670 33

Схема Пуассона (закон редких событий)

Рассмотрим, как ведут себя биномиальные вероятности при л -»<»

р-*0, пр-¥Х. Поделим числитель и знаменатель на п", тогда

j(l-V„)...(l,(„,|)/„) (!_„,,„). у,^

/и! ^ ' О-Р)" '«'

Предельные вероятности называются пуассоновскими:

•хШ

Р(т) = — е"'^, /и =0,1,... (2.2.5)

т\

Полиномиальная схема

От схемы независимых последовательных испытаний с двумя

исходами (схема Бернулли, или биномиальная схёШГможноТтёрейти к

полиномиальной схеме, т.е. к схеме последовательных независимых

испытаний, в каждом из которых возможны к исходов, к>2,с вероятностями

к

/)|, Р2,..., P/i,0<Pj<\, ^Pj =\.В этом случае пространство элементар-

ных событий содержит к" таких событий, а вероят«ость того, что из п

испытаний /и, закончатся первым исходом, /Wj — вторым исходом, ...,

Ш/^— к-м исходом, равна

Схема с зависимыми испытаниями

На практике, как было показано на примере урновой схемы, далеко

не всегда имеют место схемы с последовательными независимыми

испытаниями. Рассмотрим схему с зависимыми испытаниями, в каждом

из которых возможны к исходов. Элементарное событие, как и в случае

полиномиальной схемы с независимыми испытаниями, тогда таково:

ft> - {'|. '2' •••' 'дЬ ""Д^ каждый индекс может принимать к значений,

i,= ],2,...,k.

34

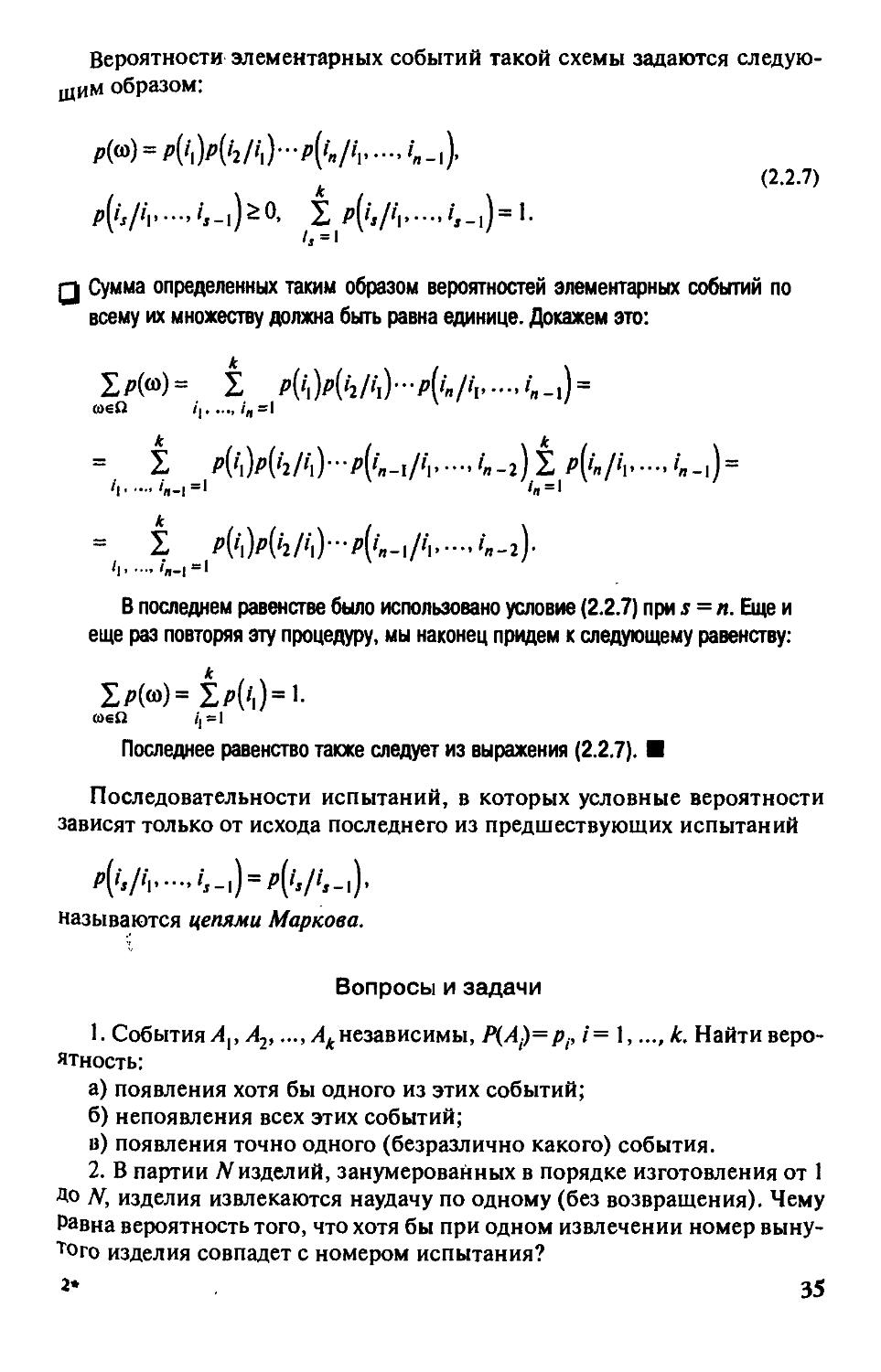

Вероятности алементарных событий такой схемы задаются

следующим образом:

(2.2.7)

к

I

p{is/iv-''s-i)^^' I P(is/h'-<is-i)=^

Q Сумма определенных таким образом вероятностей элементарных событий по

всему их множеству должна быть равна единице. Докажем это:

1рН= 1 p{h)p{h/'\]-p('n/ii ';-i) =

к к

= 1 P{h)p{'2/'\]-p{'n-l/'l'-''n-2)lp{'n/h '«-l) =

'I 'я-|=' '« = '

= I P[h)p[hlh)-p[in-\lh'-'ir,-2)-

h '«-!='

в последнем равенстве было использовано условие (2.2.7) при ; = л. Еще и

еще раз повторяя эту процедуру, мы наконец придем к следующему равенству:

Последнее равенство также следует из выражения (2.2.7). ■

Последовательности испытаний, в которых условные вероятности

зависят только от исхода последнего из предшествующих испытаний

p[^.|^v■■■^^s-] = p[^.|^s-!)'

называются цепями Маркова.

Вопросы и задачи

1. События/Ip/ljj ...,/1^независимы, Р{А)=Рр /= 1, ...,к. Найти

вероятность:

а) появления хотя бы одного из этих событий;

б) непоявления всех этих событий;

в) появления точно одного (безразлично какого) события.

2. В партии yv изделий, занумерованных в порядке изготовления от 1

ДО Л', изделия извлекаются наудачу по одному (без возвращения). Чему

Равна вероятность того, что хотя бы при одном извлечении номер выну-

''^ого изделия совпадет с номером испытания?

2» 35

3. Рабочий обслуживает 12 однотипных станков. Вероятность того,

что станок потребует к себе внимания рабочего в течение промежутка

времени Г, равна '/з- Чему равна вероятность того, что:

а) 4 станка за время Г потребуют к себе внимания рабочего;

б) число потребовавших внимания станков находится в интервале

между 3-м и 6-м (включая фаницы).

4. В семье 10 детей. Считая вероятности рождений мальчика и

девочки равными '/j, найти вероятность того, что в семье:

а) 5 мальчиков и 5 девочек;

б) число мальчиков от 3 до 8.

5. В вузе обучаются 730 студентов. Вероятность того, что день

рождения наугад взятого студента приходится на определенный день года,

равна '/зб5 ^^ каждого из 365 дней. Найти:

а) наиболее вероятное число студентов, родившихся 1 января;

б) вероятность того, что найдутся три студента, имеющих один и тот

же день рождения.

Глава 3

СЛУЧАЙНЫЕ ВЕЛИЧИНЫ

И ИХ ЧИСЛОВЫЕ ХАРАКТЕРИСТИКИ

Наряду со случайным событием и вероятностью понятие случайной

величины является важнейшим в теории вероятностей. Случайная

величина — это числовая функция, определенная на пространстве

элементарных событий. В настоящей главе представлены случайные

величины, наиболее часто встречающиеся в сфере экономики и управления,

а также определены и изучены их важнейшие характеристики: функции

распределения вероятностей и плотности вероятности, ряды

распределения, показатели центра фуппирования их значений, степени

вариации значений вокруг центра и другие числовые характеристики.

§ 3.1. Определение случайной величины

и ее функция распределения

Случайные величины встречаются нам повсюду в окружающей нас

действительности: курс доллара или температура воздуха в наугад

взятый день, цены товаров, время ожидания транспорта при поездке на

работу, прибыль или убытки фирмы, предприятия, организации, в

которой работаем, и т.п. Даже число дней в наугад взятом году является

случайной величиной: с вероятностью V4 это число равно 365, а с

вероятностью 'Д — 366.

Из последнего примера видно, что значение случайной величины

зависит от результата эксперимента: является ли наугад взятый год

високосным или обычным. Под результатом эксперимента здесь

понимается наступление конкретного элементарного события (исхода) (о^ из

всего множества (пространства) элементарных исходов €1. В нашем

примере это пространство может быть таким:

Q = {(D,,(02,(03,(04},

где (0|, (Oj, (О3 — первый, второй и третий обычные (невисокосные) годы;

(0^ — високосный год.

37

Тем самым число дней в году (случайная величина А') является

функцией от элементарных исходов:

ДГ((о,) = 365, ДГ((02) = 365, ДГ((Оз) = 365, X{(a^) = 366.

Иными словами, случайная величина как функция от (о

осуществляет отображение пространства элементарных событий Q, в некоторое

подмножество на числовой прямой. При этом каждому (о отвечает одно и

только одно число (в нашем случае X((i)^) = Х{и)2) = Х{и)^) = 365,

Д®4) ~ ^66)- Напротив, прообразов конкретного значения случайной

величины может быть много. Например, множество тех элементарных

событий, для которых Дса) = 365, состоит из трех элементарных событий:

{(о: Х{(а) = 365} = |(0,, (02, (Ojj.

Случайная величина, принимающая конечное или счетное число

значений на числовой прямой, называется дискретной. В нашем случае мы

имеем дело с дискретной случайной величиной, поскольку она

принимает два значения: 365, 366. Если же случайная величина принимает

непрерывное множество значений (например, значения на всей прямой,

на полупрямой, на отрезке), то такая величина называется непрерывной.

Для того чтобы работать со случайными величинами, надо знать в той

или иной форме вероятности тех или иных значений случайной

величины. Так, для дискретной случайной величины надо знать вероятности

отдельных ее значений. В нашем примере надо знать вероятности

событий

A^ = {(О: X{ai) = 365} = {(о,,щ,(а^}, /Ij = {®' ^i"^) = ^Щ = {®4}>

поскольку любой год из четырех равновозможен, то по классическому

определению вероятности

Для непрерывных случайных величин надо уметь подсчитывать

вероятность попадания на полупрямую, на полуинтервал и т.п., т.е.

вероятности событий

{(о: А"((d) < х}, {(о: х < Х{(л) < Xj}.

Поскольку при x^ < х^

{(о:X< А'((о)<Xj} = {(О: ^"((0)<х-^\{(О: А'((о)<xj.

то на самом деле достаточно уметь подсчитывать вероятности

попадания на полупрямую. Следовательно, надо, чтобы для любого х

множество {(О: Х((й) < х\ имело вероятность, т.е. принадлежало полю событий Sr.

38

{(о:А'((о)<х}е5.

Эти наводящие соображения делают понятным следующее строгое

(формальное) определение случайной величины.

Случайной величиной называется числовая функция Дса), заданная на

пространстве элементарных событий С1 и измеримая относительно поля

событий S. Под измеримостью в данном случае понимается следующее:

для любого —°о < х<оо

{(о: Х{(а) <x]eS.

(Далее случайные величины будут обозначаться прописными лат^1нски-

ми буквами (например, X, Y, Z) или строчными греческими буквами.)

Таким образом, чтобы знать все о случайной величине, надо для

любого —°° <х< °о знать вероятность

P{(i): А'((о) < х],

т.е. совокупность всех таких вероятностей концентрирует все знания о

распределении вероятностей по значениям случайной величины.

Поэтому функция распределения вероятностей, значение которой при

конкретном X и есть одна из таких вероятностей,

Гх{х) = Р{(о:Х{(а)<х}

содержит в себе все сведения о случайной величине.

Если речь идет об одной случайной величине, как в данном

контексте, то в обозначении функции распределения опускается индекс

случайной величины, т.е. употребляется просто f{x) (без индекса).

Как числовая функция от числового аргумента х, заданного на всей

прямой, функция распределения обладает следующими свойствами:

l)0<f(x)<l;

2) является неубывающей функцией, т.е. для Xj > x^

F{x,)>F{x,);

3) непрерывна слева, т.е.

F{x) = F{x-0)=]m F{x„);

х„<х

4) /-(-00) = о, /•(+оо)=1.

Первое свойство очевидно, поскольку значение функции

распределения — это вероятность.

39

01 Для доказательава второго свойства введем следующие обозначения:

>4, = {(о:А'((о)<х,|,

Ai=[<u:X{<u)<X2], \ (3.1.1)

В = {(о: X, ^ А'((о) < Х21,

тогда

Поскольку X, < д^, то >4,Су42, кроме того, А^ = >4, U Д причем, как видно из

обозначений, события A^viB несовместны, поэтому согласно аксиоме сложения

Р{А^) = Р[Л^)+Р{В). (3.1.2)

Следует заметить, что множества >4,, >42 и ^действительно являются

событиями, т.е. Л^^S, A.^<eS, BeS. В самом деле, принадлежность >4р >42 полю

событий 5 непосредотвенно вытекает из определения случайной величины.

Множество ^ является теоретико-множественной разностью событий >4, и А^,

которую можно заменить операциями пересечения и дополнения

B = A2\A^ = Air^A^,

а поскольку поле замкнуто относительно операций пересечения и дополнения,

то Be S. Далее будем использовать полученный здесь результат: поле замкнуто

относительно операции теоретико-множественной разности, а следовательно, и

симметрической разности.

Используя формулу (3.1.2), последнее соотношение перепииюм в

следующем виде:

F{x2) = f{x,) + PiB),

или

F{x2)-F{xi) = P{B). (3.1.3)

Поскольку вероятность любого события неотрицательна, тоР{В)>0\л,

следовательно, /I^Xj) > Дх,). Таким образом, второе свойство доказано. ■

Используя обозначения (3.1.1), запишем формулу (3.1.3) в следующем

виде:

/'{x,<A'<X2| = /'(x2)-f(x,), (3.1.4)

иными словами, вероятность попадания на полуинтервал х, < Х< Х2 равна

разности значений функции распределения на концах полуинтервала.

40

Q При доказательстве третьего свойства будем пользоваться расширенной

аксиомой сложения, а также следующими обозначениями:

В„={<и:х„йХ<х], (3.1.5)

JC| <JC2 < ... <JC„ < ... <JC, lim jc„ =JC,

т.е. jc„ - монотонная последовательность, сходящаяся к х.

Поскольку последовательность х^ монотонна, то В^ э Bj для / < / Кроме

того, так как 5„П5„+, =Л„^,,то

^«=Кпд„„)и(/?„п/?„„)=(д„пд„„)иКп^„,2)и(д„„пд„.2)=

=...= йКпд*„)ип5*.

*=я ^ ' *=я

т. е. может быть представлено в виде бесконечного объединения непересекаю-

щихся «колец» ^^^ n^^+i * несовместного с ними ядра fj^^^, поэтому на

основании расширенной аксиомы сложения

P{Bn)=iP[Bk^B,,,)^l{[\B\ (3.1.6)

Но из формулы (3.1.5) видно, что

оо

n^t ={co:jcSA'<jc} = 0,

Т. е. ядро - невозможное событие, поэтому

Следовательно, формула (3.1.6) примет вид:

p{b„)^Ip[b,V\b,^,\

к=п

но ряд

как видим, сходится, поэтому его остаток сходится к нулю:

1/КП/?,„)=/'(/?„)-.0. (3.1.7)

41

кжп

Используя обозначения (3.1.5), запишем формулу (3.1.7) в следующем виде:

Р{Вп) = {«: ^« ^ ^И < ^} = Пх) - F{x„) -^ 0.

Отсюда

limF{x„) = F{x-0) = Fix),

х„-*х

х„<х

что И требовалось доказать. ■

Четвертое свойство вытекает непосредственно из того, что

{со: ^(со) < -оо} = 0,

{со: А'(со) < -н»} = П,

поскольку Д0) = О, а Р{С1) = 1.

§ 3.2. Дискретные случайные величины

и их важнейшие числовые характеристики

Как было сказано выше, дискретная слунайдая величина принимает

конечное или счетное число значений. Поскольку переход от конечного

числа значении к счетному не представляет больших технических

трудностей, то основные характеристики дискретной случайной величины

будем рассматривать при конечном числе значений.

Итакгпусть случайная величина принимает конечное число к

значений jc, < JCj < ... < JC^. Тем самым все пространство элементарных событий

Q, отобразится случайной величиной Л(со) в А: этих значений,

прообразами которых служат события

Aj=[(u:X{(u) = Xi}, i=\,...,k,

образующие полную группу, поскольку эти события несовместны и

вместе составляют П.

Следует заметить, что множества /J^ действительно являются

событиями (т.е. А.& S), поскольку в нашем случае для х,. < jc < JC,+ ,

Aj = {to: ^(to) = x,} = {со: x, < ^(co) < x} e 5',

тем самым заданы их вероятности

Pi=P{Ai), 0</>, <1, / = 1,...,А:,

к

причем Х/'/ = 1> так как события А/ образуют полную фуппу

/• = 1

42

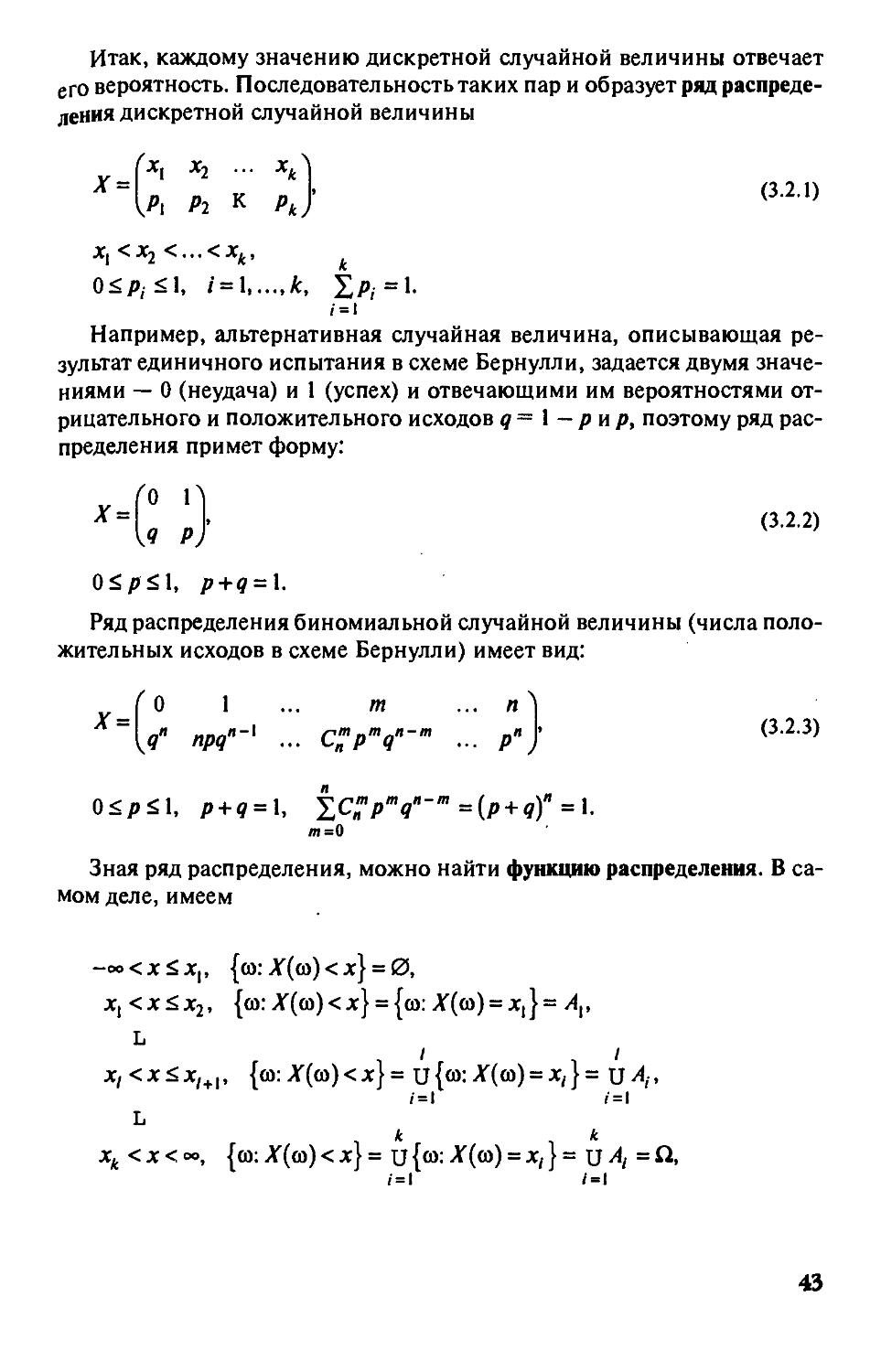

Итак, каждому значению дискретной случайной величины отвечает

его вероятность. Последовательность таких пар и образует ряд

распределения дискретной случайной величины

(Xi Х2 ... ХЛ

"'[р. Р2 к Р,} <""

о<л<1. ' = 1 k, !/»,='•

/=|

Например, альтернативная случайная величина, описывающая

результат единичного испытания в схеме Бернулли, задается двумя

значениями — О (неудача) и 1 (успех) и отвечающими им вероятностями

отрицательного и положительного исходов д= I — рнр, поэтому ряд

распределения примет форму:

x-J" '1

U р)

(3.2.2)

Ойрй\, р + д = \.

Ряд распределения биномиальной случайной величины (числа

положительных исходов в схеме Бернулли) имеет вид:

О \ ... т ... пЛ

[д" прд"-' ... СЦ'р^д"-'" ... р"J ^^"^-^^

0<рй1, р + д = \, iC/»'"9"-'"=(/» + 9)"=l.

Зная ряд распределения, можно найти функцию распределения. В

самом деле, имеем

-оокхйх^, {со:Л'(со)<jc} = 0,

JC, <JC<JC2, {co:A'(co)<Jc} = {co:A'(co) = jc,}= A^,

L

/ /

JC, <JC<JC,+,, {со: A'(co) < Jc} = и {ю: A'(co) = x,} = \j Aj,

/•=1 /=1

L

* к

x^ <jc<«>, {со:A'(co)<Jc} = и{ю:A'(co) = jc,} = иЛ =^'

/•=1 /=i

43

поэтому функция распределения примет вид:

О, -oo<JC<JC,,

p^, Xf<x<X2,

F{x):

ip,., х,<хйх,^,, <^-2-^)

/• = 1

1, JC^ < JC < oo.

Таким образом, функция распределения F{x) является ступенчатой

(кусочно-постоянной) со скачками в точках, координаты которых

равны значениям случайной величины, а значение функций равно сумме

вероятностей значений, не превосходящих данное. Напротив, зная

ступенчатую функцию распределения дискретной случайной величины,

можно найти ее ряд распределения. В самом деле, пусть

F{x) = q,, x,<x<x,^^, 1 = 0,...,к Ц = -«., jt^^i =+ooj,

тогда

Р{(л: Х{(£,) = X,} = Р{тх, < X{ia) <х,^] = f(x,^^- F{x,) = 9,^, -q,.

Таким образом, и функция распределения, и ряд распределения

являются эквивалентными обобщающими характеристиками дискретной

случайной величины. При определении важнейших числовых

характеристик дискретной случайной величины (математического ожидания и

дисперсии) будем использовать ряд распределения.

Математическое ожидание

Математическое ожидание, или генеральное среднее, является

наиболее употребител.ьной числовой характеристикой центра

группирования значений дискретной случайной величины. Обозначается

прописной латинской буквой Л/, поставленной перед обозначением случайной

величины MX — математическое ожидание случайной величины X.

Математическое ожидание — средневзвешенное значение случайной

величины с весами-вероятностями

к

МХ='^х,Р(. (3.2.5)

/•=1

Например, если заработная плата (в некоторых денежных единицах)

имеет следующий ряд распределения:

Г 80 100 120 "1

"1,0.25 0,5 0.25/

44

то средняя заработная плата (математическое ожидание)

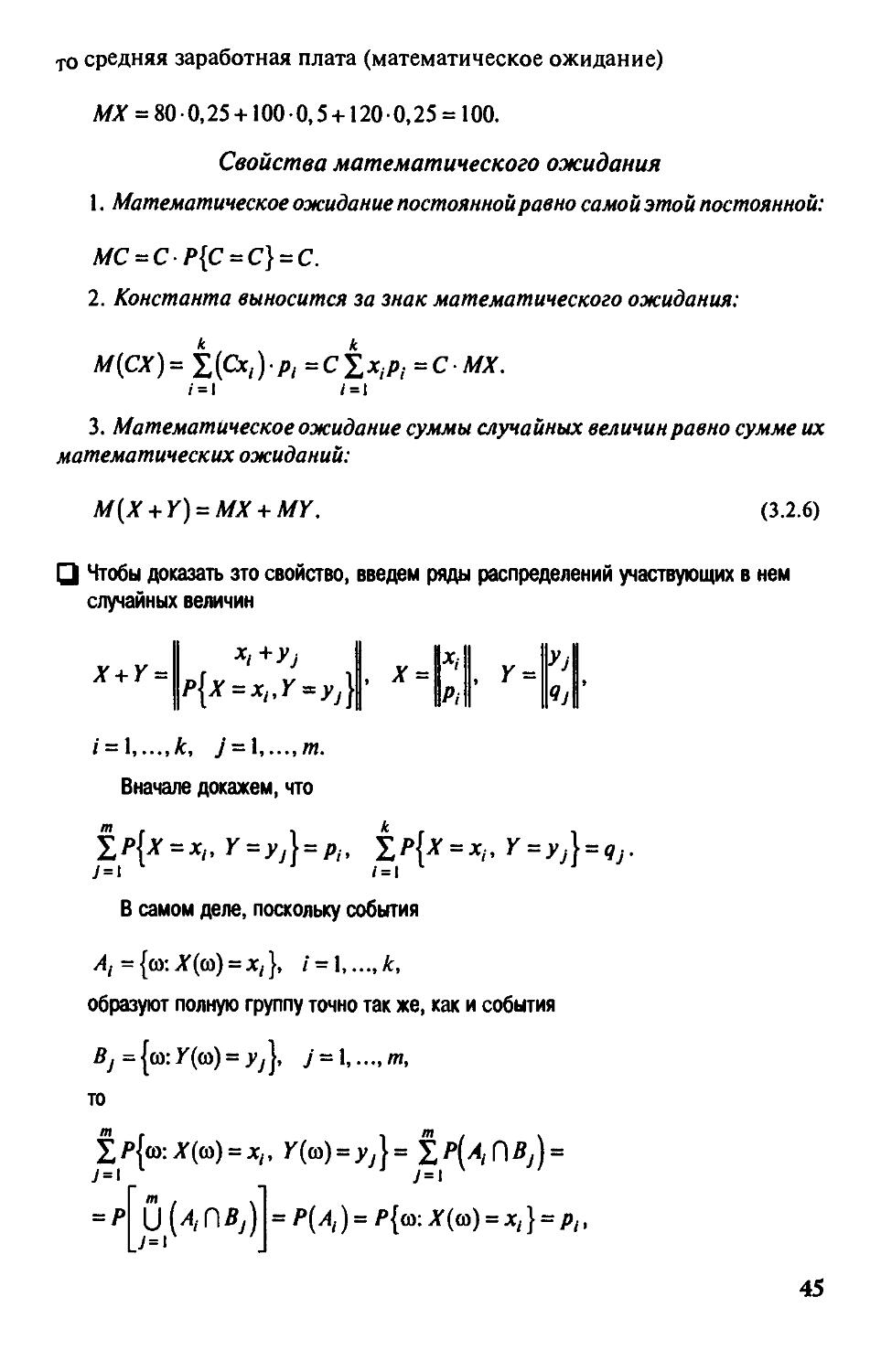

Л/;1Г = 800,25 + 1000,5 + 1200,25 = 100.

Свойства математического ожидания

1. Математическое ожидание постоянной равно самой этой постоянной:

МС = СР{С = С} = С.

2. Константа выносится за знак математического ожидания:

М{СХ) = 1(Сх, )■/»,= С S JC,/»,. =СМХ.

/• = 1 /=1

3. Математическое ожидание суммы случайных величин равно сумме их

математических ожиданий:

M{X + Y) = MX + MY.

(3.2.6)

Ul Чтобы доказать зто свойаво, введем ряды распределений участвующих в нем

случайных величин

1р{х = х,,Г^уМ' "^ ||/,,|

;ir + K = ILr„ \^ J 1 . х = 1 ' , Y

УЛ

tp{x = x,, Y = yj} = p^, l,P{x = x^, Y = yj} = gj.

/ = 1 к, У = 1 т.

Вначале дсжажем, что

к

I

7=1 * ' /=1

В самом деле, поскольку события

A,=[oi:X{(u) = Xi}, 1 = 1..„к,

образуют полную группу точно так же, как и события

Bj^^(o:Y{()i) = yj], у = 1 /и,

то

1я{со:^(со) = дг„ Y{(o) = yj}= 1/'(/(,П/?у) =

7 = 1

= Р

7 = 1

= P{Ai)=P{m:X{m) = Xi} = Pi,

45

аналогично

к

1

/• = 1

^р{(й:Х{(й) = Х1, Y((o) = yj} = qj.

Используем теперь полученные выражения для сумм вероятностей при

доказательстве третьего свойства, имеем:

M{X + Y)=it (xi + уМх = Xi,Y = y.) =

= ix,tp(x = x,,r = yj)+tyiip(x = x,,Y = yj) =

i=\ 7=1 ;=l /=l

= lx,p, + tyjQj = MX + MY,

1=1 ]=\

т.е. свойство доказано. ■

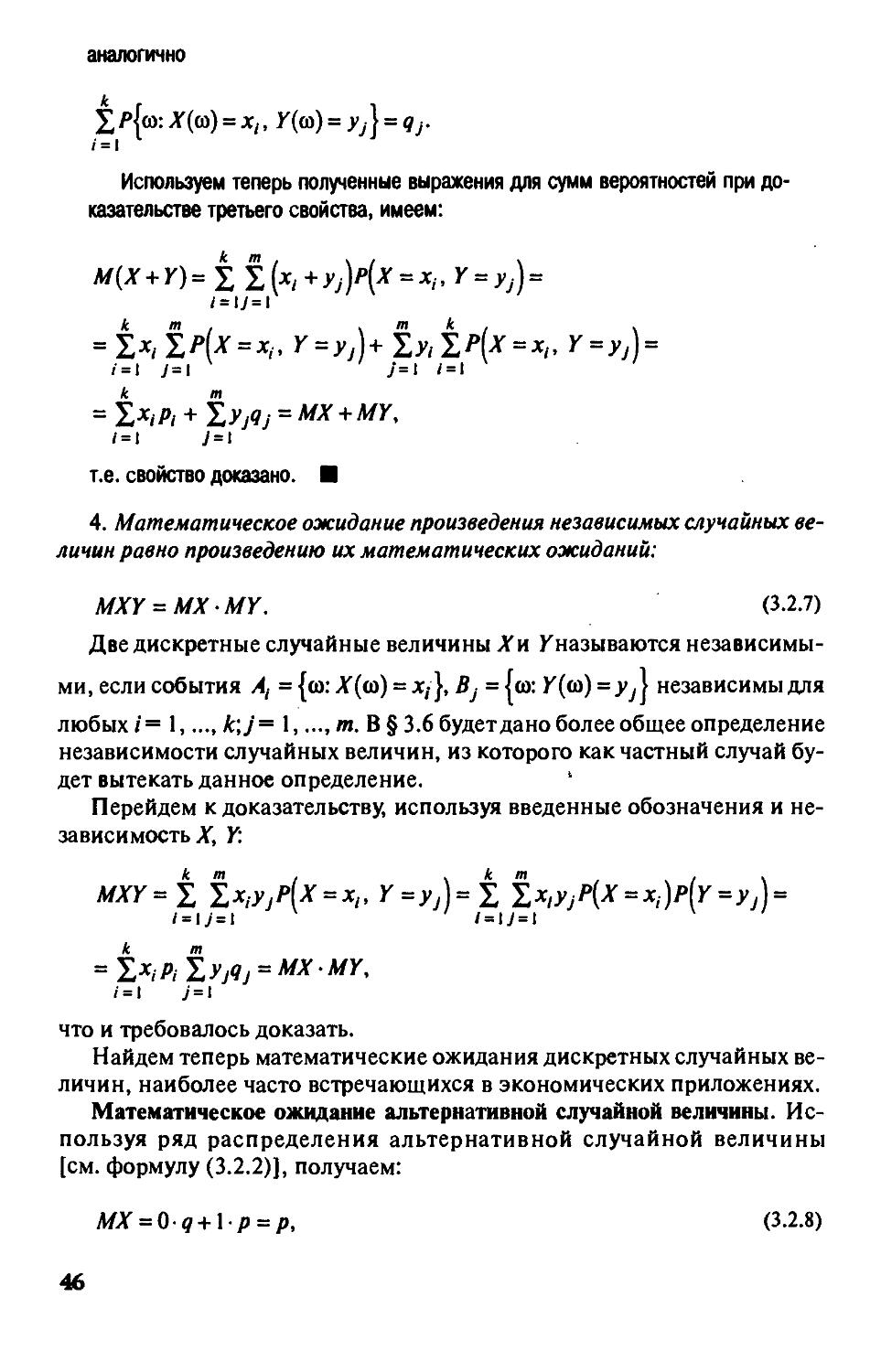

4. Математическое ожидание произведения независимых случайных

величин равно произведению их математических ожиданий:

MXY = MXMY. (3.2.7)

Две дискретные случайные величины Хн Кназываются

независимыми, если события А, = {to: A'(to) = xj}, Bj = {to: K(to) = yj\ независимы для

любых /= 1,.... k\J= 1,.... да. В § 3.6 будет дано более общее определение

независимости случайных величин, из которого как частный случай

будет вытекать данное определение.

Перейдем к доказательству, используя введенные обозначения и

независимость JT, Y:

MXY=i tx,yjP(x = x„ Y=yj)=itx,yjP[X = x,)p(Y=yj) =

i = \j=\ i=>\j=\

= txiPityjqj = MXMY,

/•=1 ;=i

что и требовалось доказать.

Найдем теперь математические ожидания дискретных случайных