Text

4 I

ОПТ) НАДЕЖНОСТЬ И КАЧЕСТВО

Межиздательская серия

И.А.Биргер

Техническая

диагностика

Москва «Машиностроение »1978

УДК 62.19

6П5.1

Б64

Рецензент д-р техн. ни у к проф. В. С. Стреляев

Биргер И. А.

Б64 Техническая диагностика. — М.: «Машиностроение»,

1978.—240^с, ил. — (Надежность и качество).

В пер. 1 р. 20 к*

Книга посвящена теоретическим основам технической диагностики.

В ней изложены статистические методы распознавания и разделения в про-

пространстве признаков, метрические и логические методы диагностики. Значи-

Значительное внимание уделено теории информации и ее приложению к задачам

диагностики.

Книга предназначена для инженеров, занимающихся проблемами надеж-

надежности и технической диагностики, а также может оказаться полезной сту-

студентам старших курсов и аспирантам, изучающим эти проблемы. Табл. 13,

ил. 78, список лит 66 назв.

31301-020

Б 038@1)-78 2°-78 6П51

© Издательство «Машиностроение», 1978 г.

ПРЕДИСЛОВИЕ

Техническая диагностика — молодая наука, возник-

возникшая в последние два десятилетия в связи с потребно-

потребностями современной техники. Все возрастающее значение

сложных и дорогостоящих технических систем, осо-

особенно в машиностроении и радиоэлектронике, требова-

требования безопасности, безотказности и долговечности де-

делают весьма важной оценку состояния системы, ее

надежности. Техническая диагностика — наука о рас-

распознавании состояния технической системы, включаю-

включающая широкий круг проблем, связанных с получением

и оценкой диагностической информации.

Книга посвящена главным образом теоретическим,

основам технической диагностики. Изучение общих

методов распознавания и математической теории диаг-

диагностики дает возможность более обоснованного выбора

конкретных способов диагностики и соответствующих

им правил решения. При изложении теории диагностики

особых требований к математической подготовке инже-

инженеров не предъявляется, хотя некоторые моменты могут

показаться трудными при первоначальном ознакомле-

ознакомлении. Математизация инженерных знаний является неиз-

неизбежным процессом, связанным с развитием техники,

однако следует всегда помнить, что цель расчета не

число, а понимание.

Изложение математических вопросов теории диаг-

диагностики дано на инженерном уровне строгости, что

позволяет во многих случаях сделать изложение более

простым и ясным. Инженерные вопросы технической

з

диагностики кратко рассмотрены в первой и последней

главах. Более подробный разбор вопросов техниче-

технического обеспечения требует отдельного рассмотрения.

Книга ориентирована на проблемы диагностики

механических систем (двигателей, машин и т. д.),

поэтому теоретические проблемы, связанные с автома-

автоматизированным контролем и поиском неисправностей,

структурой диагностического процесса и диагностиче-

диагностических тестов, весьма важных для радиоэлектронных

устройств, в книге опущены. Указанный пробел воспол-

восполняется весьма обширной литературой по технической

диагностике, в которой разбираются вопросы контроле-

способности.

Глава 1

ОСНОВЫ

ТЕХНИЧЕСКОЙ

ДИАГНОСТИКИ

Вводные замечания. Эта глава является вводной. В ней кратко

излагаются основные направления и задачи технической диаг-

диагностики.

В отличие от обычного изложения, задачи технической диаг-

диагностики рассматриваются в широком плане и связываются с об-

общей проблемой распознавания.

§ 1. ОСНОВНЫЕ НАПРАВЛЕНИЯ ТЕХНИЧЕСКОЙ

ДИАГНОСТИКИ

Определения. Термин «диагностика» происходит от греческого

слова «диагнозис», что означает распознавание, определение.

В процессе диагностики устанавливается диагноз, т. е. опре-

определяется состояние больного (медицинская диагностика; или

состояние технической системы (техническая диагностика).

Технической диагностикой называется наука о распознавании

состояния технической системы.

Цели технической диагностики. Рассмотрим кратко основное

содержание технической диагностики. Техническая диагностика

изучает методы получения и оценки диагностической информации,

диагностические модели и алгоритмы принятия решений. Целью

технической диагностики является повышение надежности и де-

сурса технических, систем.

Как известно, наиболее важным показателем надежности яв-

является отсутствие отказов во время функционирования (работы)

технической системы. Отказ авиационного двигателя в полетных

условиях, судовых механизмов во время плавания корабля,

энергетических установок в работе под нагрузкой может привести

к тяжелым последствиям.

Техническая диагностика благодаря раннему обнаружению

дефектов и неисправностей позволяет устранить подобные отказы

в процессе технического обслуживания, что повышает надежность

и эффективность эксплуатации, а также дает возможность эксплуа-

эксплуатации технических систем ответственного назначения по состоянию.

В практике ресурс таких систем определяется по наиболее

«слабым» экземплярам изделий. При эксплуатации по состоянию

каждый экземпляр эксплуатируется до предельного состояния

в соответствии с рекомендациями системы технической диагно-

диагностики. Эксплуатация по техническому состоянию может принести

выгоду, эквивалентную стоимости 30% общего парка машин.

Основные задачи технической диагностики. Техническая

диагностика решает обширный круг задач, многие из которых

являются смежными с задачами других научных дисциплин. Ос-

Основной задачей технической диагностики является распознавание

состояния технической системы в условиях ограниченной инфор-

информации.

Техническую диагностику иногда называют безразборной

диагностикой, т. е. диагностикой, осуществляемой без разборки

изделия. Анализ состояния проводится в условиях эксплуатации,

при которых получение информации крайне затруднено. Часто

не представляется возможным по имеющейся информации сделать

однозначное заключение и приходится использовать статистиче-

статистические методы.

Теоретическим фундаментом для решения основной задачи тех-

технической диагностики следует считать общую теорию распозна-

распознавания образцов. Эта теория, составляющая важный раздел тех-

технической кибернетики, занимается распознаванием образов любой

природы (геометрических, звуковых и т. п.), машинным распозна»

ванием речи, печатного и рукописного текстов и т. д. Техническая

диагностика изучает алгоритмы расаознавания применительно

к задачам диагностики, которые обычно могут рассматриваться

как задачи классификации.

Алгоритмы распознавания в технической диагностике частично

основываются на диагностических моделях, устанавливающих

связь между состояниями технической системы и их отображе-

отображениями в пространстве диагностических сигналов. Важной частью

проблемы распознавания являются правила принятия решений

(решающие правила).

Решение диагностической задачи (отнесение изделия к исправ-

исправным или неисправным) всегда связано с риском ложной тревоги

или пропуска цели. Для принятия обоснованного решения целе-

целесообразно привлекать методы теории статистических решений,

разработанные впервые в радиолокации.

Решение задач технической диагностики всегда связано с про-

гнозированием надежности на ближайший период эксплуатации

(до следующего технического осмотра). Здесь решения должны

основываться на моделях отказов, изучаемых в теории надеж-

надежности.

Вторым важным направлением технической диагностики

является теория контролеспособности. Контролеспособностью на-

называется свойство изделия обеспечивать достоверную оценку его

6

технического состояния и раннее обнаружение неисправностей й

отказов. Контролеспособность создается конструкцией изделия и

принятой системой технической диагностики.

Крупной задачей теории контролеспособности является изу-

изучение средств и методов получения диагностической информации.

В сложных технических системах используется автоматизирован-

автоматизированный контроль 'состояния, которым предусматривается обработка

диагностической информации и формирование управляющих сиг-

сигналов. Методы проектирования автоматизированных систем конт-

контроля составляют одно из направлений теории контролеспособ-

контролеспособности. Наконец, очень важные задачи теории контролеспособ-

контролеспособности связаны с разработкой алгоритмов поиска неисправностей,

разработкой диагностических тестов, минимизацией процесса

установления диагноза.

В связи с тем, что техническая диагностика развивалась пер-

первоначально только для радиоэлектронных систем, многие авторы

отождествляют теорию технической диагностики с теорией кон-

контролеспособности (поиском и контролем неисправностей), что,

конечно, ограничивает область приложения технической диаг-

диагностики.

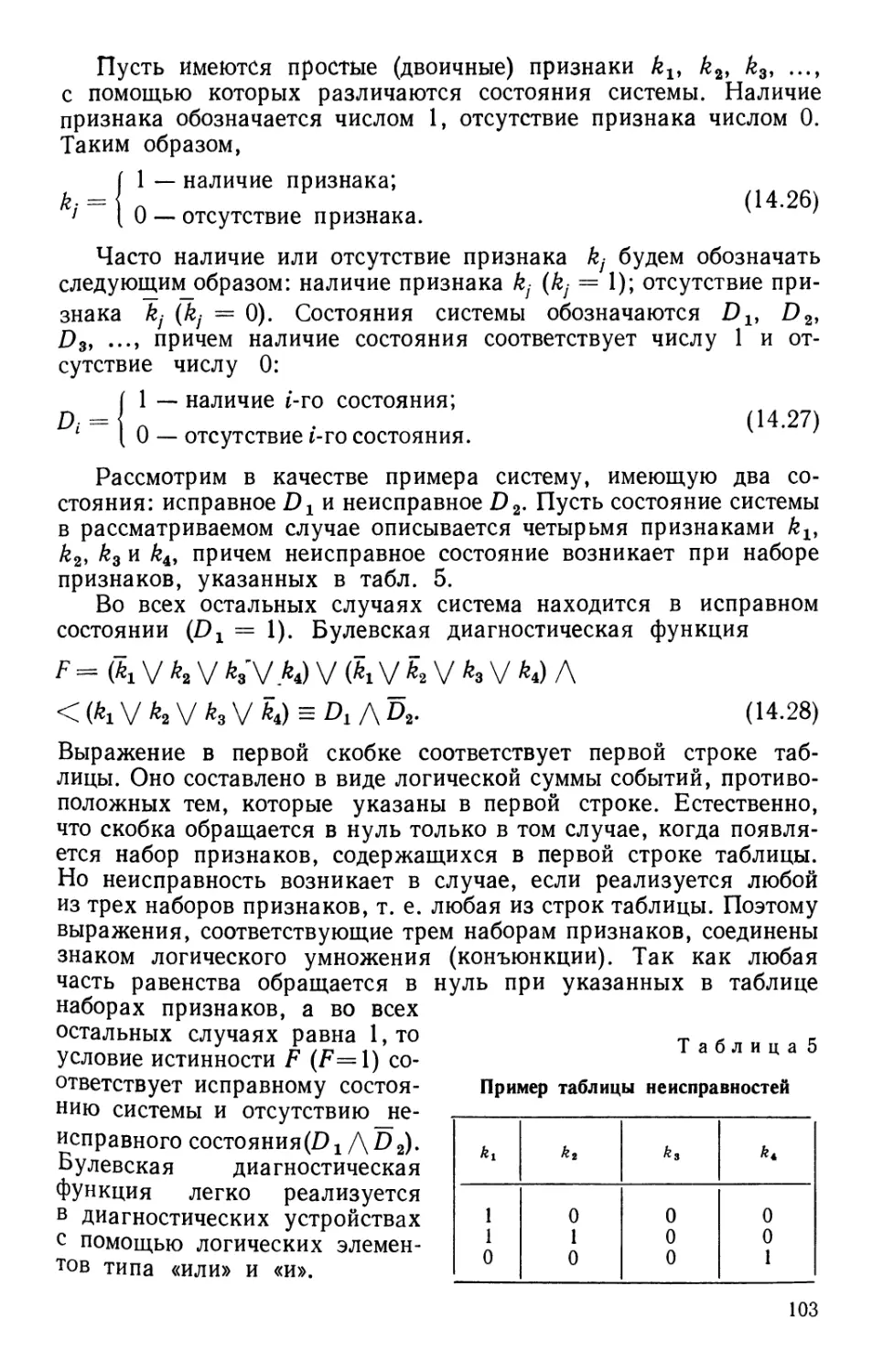

Структура технической диагностики. На рис. 1 показана струк-

структура технической диагностики. Она характеризуется двумя взаимо-

взаимопроникающими и взаимосвязанными направлениями: теорией

распознавания и теорией контролеспособности. Теория распозна-

распознавания содержит разделы, связанные с построением алгоритмов

распознавания, решающих правил и диагностических моделей.

Теория контролеспособности включает разработку средств и

методов получения диагностической информации, автоматизи-

автоматизированный контроль и поиск неисправностей. Техническую диаг-

диагностику следует рассматривать как раздел общей теории надеж-

надежности.

Техническая диагностика

Теория распознавания

Теория контролеспо-

контролеспособности

Алгоритмы

распозна-

распознавания

Правила

решения

Диагности-

Диагностические

модели

Диагности-

Диагностическая

информация

Контроль

состояния

Поиск

неисправ-

неисправностей

Рис. 1. Структура технической диагностики

§ 2. ПОСТАНОВКА ЗАДАЧ ТЕХНИЧЕСКОЙ ДИАГНОСТИКИ

Вводные замечания. Пусть требуется определить состояние

шлицевого соединения валов редуктора в эксплуатационных усло-

условиях. При большом износе шлицев появляются перекосы и устало-

усталостные разрушения. Непосредственный осмотр шлицев невозможен,

так как требует разборки редуктора, т. е. прекращения эксплуата-

эксплуатации. Неисправность шлицевого соединения может повлиять на

спектр колебаний корпуса редуктора, акустические колебания,

содержание железа в масле и другие параметры.

Задача технической диагностики состоит в определении сте-

степени износа шлицев (глубины разрушенного поверхностного слоя)

по данным измерений ряда косвенных параметров. Как указы-

указывалось, одной из важных особенностей технической диагностики

является распознавание в условиях ограниченной информации,

когда требуется руководствоваться определенными приемами

и правилами для принятия обоснованного решения.

Состояние системы описывается совокупностью (множеством)

определяющих ее параметров (признаков). Разумеется, что мно-

множество определяющих параметров (признаков) может быть раз-

различным, в первую очередь, в связи с самой задачей распознава-

распознавания. Например, для распознавания состояния шлицевого соеди-

соединения двигателя достаточна некоторая группа параметров, но она

должна быть дополнена, если проводится диагностика и других

деталей.

Распознавание состояния системы — отнесение состояния си-

системы к одному из возможных классов (диагнозов). Число диагно-

диагнозов (классов, типичных состояний, эталонов) зависит от особенно-

особенностей задачи и целей исследования.

Часто требуется провести выбор одного из двух диагнозов

(дифференциальная диагностика или дихотомия); например,

«исправное состояние» и «неисправное состояние». В других слу-

случаях необходимо более подробно охарактеризовать неисправное

состояние, например повышенный износ шлицев, возрастание вибра-

вибраций лопаток и т. п. В большинстве задач технической диагностики

диагнозы (классы) устанавливаются заранее, и в этих условиях

задачу распознавания часто называют задачей классифи-

классификации.

Так как техническая диагностика связана с обработкой боль-

большого объема информации, то принятие решений (распознавание)

часто осуществляется с помощью электронных вычислительных

машин (ЭВМ).

Совокупность последовательных действий в процессе распоз-

распознавания называется алгоритмом распознавания. Существенной

частью процесса распознавания является выбор параметров,

описывающих состояние системы. Они должны быть достаточно

информативны (см. гл. 8), чтобы при выбранном числе диагнозов

процесс разделения (распознавания) мог быть осуществлен.

Математическая постановка задачи. В задачах диагностики

состояние системы часто описывается с помощью комплекса приз-

признаков

К^(К *»¦•¦. */...-, *v). B-1)

где k4 — признак* имеющий т, разрядов.

Пусть, например, признак kj представляет собой трехразряд-

трехразрядный признак (trij = 3), характеризующий величину температуры

газа за турбиной: пониженная, нормальная, повышенная. Каждый

разряд (интервал,) признака k} обозначается /^s, например по-

повышенная температура за турбиной kj3. Фактически наблюдаемое

состояние соответствует определенной реализации признака, что

отмечается верхним индексом *. Например, при повышенной

температуре реализация признака k* = kf.6.

В общем случае каждый экземпляр системы соответствует

некоторой реализации комплекса признаков:

/г-(*,*, *2\..., *;,_..., К). B.2)

Во многих алгоритмах распознавания удобно характеризовать

систему параметрами х-г образующими v-мерный вектор или

точку в v-мерном пространстве:

*-=(*!, Х2>..., X/f..., Xv). B.3)

В большинстве случаев параметры х-г имеют непрерывное

распределение. Например, пусть Xj — параметр, выражающий

температуру за турбиной. Предположим, что соответствие между

параметром Xj (°С) и трехразрядным признаком kj таково:

<450

50—55

>500 /

В данном случае с помощью признака kj получается дискрет-

дискретное описание, тогда как параметр х}- дает непрерывное описание.

Отметим, что при непрерывном описании обычно требуется зна-

значительно больший объем предварительной информации, но опи-

описание получается более точным. Если, однако, известны стати-

статистические законы распределения параметра, то необходимый объем

предварительной информации сокращается.

Из предыдущего ясно, что принципиальных отличий при опи-

описании системы с помощью признаков или параметров нет, и в даль-

дальнейшем будут использованы оба вида описания.

Как указывалось, в задачах технической, диагностики. воз-

возможные состояния системы— диагнозы Dt — считаются -извест-

-известными.

Существуют два основных подхода к задаче распознавания:

вероятностный и детерминистский. Постановка задачи при ве-

вероятностных методах распознавания такова. Имеется система,

которая находится в одном из п случайных состояний Д. Из-

9

< п

450—550 kj2

вестна совокупность признаков (параметров), каждый из которых

с определенной вероятностью характеризует состояние системы.

Требуется построить решающее правило, с помощью которого

предъявленная (диагностируемая) совокупность признаков была бы

отнесена к одному из возможных состояний (диагнозов). Жела-

Желательно также оценить достоверность принятого решения и сте-

степень риска ошибочного решения.

При детерминистских методах распознавания удобно форму-

формулировать задачу на геометрическом языке. Если система харак-

характеризуется v-мерным вектором X, то любое состояние системы

представляет собой точку в v-мерном пространстве параметров

(признаков). Предполагается, что диагноз Д соответствует не-

некоторой области рассматриваемого пространства признаков. Тре-

Требуется найти решающее правило, в соответствии с которым предъ-

предъявленный вектор X* (диагностируемый объект) будет отнесен

к определенной области диагноза. Таким образом задача сводится

к разделению пространства признаков на области диагнозов.

При детерминистском подходе области диагнозов обычно счи-

считаются «непересекающимися», т. е. вероятность одного диагноза

(в область которого попадает точка) равна единице, вероятность

других равна нулю. Подобным образом предполагается, что и

каждый признак либо встречается при данном диагнозе, либо

отсутствует.

Вероятностный и детерминистский подходы не имеют прин-

принципиальных различий. Более общими являются вероятностные

методы, но они часто требуют и значительно большего объема

предварительной информации. Детерминистские подходы более

кратко описывают существенные стороны процесса распозна-

распознавания, меньше зависят от избыточной, малоценной информации,

больше соответствуют логике мышления человека.

В последующих главах излагаются основные алгоритмы рас-

распознавания в задачах технической диагностики.

1:)

Глава 2

СТАТИСТИЧЕСКИЕ

МЕТОДЫ

РАСПОЗНАВАНИЯ

Вводные замечания. Основное преимущество статистических

методов распознавания состоит в возможности одновременного

учета признаков различной физической природы, так как они

характеризуются безразмерными величинами — вероятностями их

появления при различных состояниях системы. В этой главе

содержится подробное изложение метода Байеса и метода после-

последовательного анализа. Теория статистических решений, состав-

составляющая особый раздел статистических методов, рассматривается

в следующей главе.

§ 3. МЕТОД БАЙЕСА

Среди методов технической диагностики метод, основанный

на обобщенной формуле Байеса, занимает особое место благо-

благодаря простоте и эффективности.

Разумеется, метод Байеса имеет недостатки: большой объем

предварительной информации, «угнетение» редко встречающихся

диагнозов и др. Однако в случаях, когда объем статистических

данных позволяет применить метод Байеса, его целесообразно

использовать как один из наиболее надежных и эффективных

методов.

Основы метода. Метод основан на простой формуле Байеса,

[19, 22]. Если имеется диагноз Dt и простой признак Лу, встре-

встречающийся при этом диагнозе, то вероятность совместного появ-

появления событий (наличие у объекта состояния Д и признака kj)

j) = Р (D,) P (kj/Dt) = Р (к,) Р (ВД7). C.1)

Из этого равенства вытекает формула Байеса (см. гл. 11)

РфМЛ-Рр,)-?^-. C.2)

Очень важно определить точный смысл всех входящих в эту

формулу величин.

11

Р (Д)— вероятность диагноза Д, определяемая по стати-

статистическим данным (априорная вероятность диагноза). Так, если

предварительно обследовано N объектов и у W,- объектов имелось

состояние Д, то

P(Di) = Nl/N. C.3)

Р (kj/Di) — вероятность появления признака kl у объектов с со-

состоянием Д. Если среди Nt объектов, имеющих диагноз Д,

у Ntj проявился признак Лу, то

P(k,/Dt)=JljL. C.4)

Р (kj) — вероятность появления признака k} во всех объектах

независимо от состояния (диагноза) объекта. Пусть из общего

числа N объектов признак kj был обнаружен у N- объектов, тогда

P(ki) = NjIN. C.5)

Для установления диагноза специальное вычисление Р (kj)

не требуется. Как будет ясно из дальнейшего, значения Р (Д)

и Р (kj/Di), известные для всех возможных состояний, опреде-

определяют величину Р (kj).

В равенстве C.2) Р (Djkj) — вероятность диагноза Д после

того, как стало известно наличие у рассматриваемого объекта

признака kj (апостериорная вероятность диагноза).

Обобщенная формула Байеса. Эта формула относится к слу-

случаю, когда обследование проводится по комплексу признаков АГ,

включающему признаки Л1э А2, ..., kv. Каждый из признаков к}

имеет mt разрядов (kjly ?/2, ..., kis, ..., kjm). В результате обсле-

обследования становится известной реализация признака

k* = kjs C.6)

и всего комплекса признаков /С*. Индекс *, как и раньше, озна-

означает конкретное значение (реализацию) признака. Формула

Байеса для комплекса признаков имеет вид

Р (DJK*) = Р (Д) Р (K*/Dt)/P (К*) (i = 1, 2, .. ., л), C.7)

где Р (Di/K*) — вероятность диагноза Д после того, как стали

известны результаты обследования по комплексу признаков /С,

Р (Д) — предварительная вероятность диагноза Д (по пред-

предшествующей статистике).

Формула C.7) относится к любому из п возможных состояний

(диагнозов) системы. Предполагается, что система находится

только в одном из указанных состояний и потому

?я(О,)=1. C.8)

s=l

12

В практических задачах нередко допускается возможность суще-

существования нескольких состояний Аъ ..., Лг, причем некоторые

из них могут встретиться в комбинации друг с другом. Тогда

в качестве различных диагнозов DL следует рассматривать от-

отдельные состояния Di = Ах,..., Dr = Аг и их комбинации

Dr+i = 41 Л А%* ... и т. п.

Перейдем к определению Р (K*lDi). Если комплекс признаков

состоит из v признаков, то

Р (K*lDi) = Р (kWt) P (kllkiDt) ...Р (**/*?... A?*_i D,), C.9)

где к* = kjs — разряд признака, выявившийся в результате

обследования. Для диагностически независимых признаков

. • .P(K/Di). C.10)

В большинстве практических задач, особенно при большом числе

признаков, можно принимать условие независимости признаков

даже при наличии существенных корреляционных связей между

ними.

Вероятность появления комплекса признаков /С*

t(s)(s) C.11)

s=l

Обобщенная формула Байеса может быть записана так:

C.12)

? Р (Ds) P (K*/Ds)

s=l

где Р (K*lDi) определяется равенством C.9) или C.10). Из

соотношения C.12) вытекает

^Р(Д.//Г)=1, C.13)

что, разумеется, и должно быть, так как один из диагнозов обя-

обязательно реализуется, а реализация одновременно двух диагно-

диагнозов невозможна.

Следует обратить внимание на то, что знаменатель формулы

Байеса для всех диагнозов одинаков. Это позволяет сначала опре-

определить вероятности совместного появления 1-го диагноза и дан-

данной реализации комплекса признаков

Р (DtK*) - Р (Д) Р (К*/Од C.14)

и затем апостериорную вероятность диагноза

^ ? P(D8K*). C.15)

13

Отметим, что иногда целесообразно использовать предвари-

предварительное логарифмирование формулы C.12), так как выраже-

выражение C.10) содержит произведения малых величин.

Если реализация некоторого комплекса признаков К* яв-

является детерминирующей для диагноза Dp, то этот комплекс не

встречается при других диагнозах:

0 при s Ф р;

Ф 0 при s = p.

Тогда, в силу равенства C.12)

0 при s ф р;

P(DJK*) =

1 при s = р.

C.16)

Таким образом, детерминистская логика установления диагноза

является частным случаем вероятностной логики. Формула Байеса

может использоваться и в том случае, когда часть признаков

имеет дискретное распределение, а другая часть — непрерывное.

Для непрерывного распределения используются плотности рас-

распределения. Однако в расчетном плане указанное различие приз-

признаков несущественно, если задание непрерывной кривой осуще-

осуществляется с помощью совокупности дискретных значений.

Диагностическая матрица. Для определения вероятности диаг-

диагнозов по методу Байеса необходимо составить диагностическую

матрицу (табл. 1), которая формируется на основе предвари-

предварительного статистического материала. В этой таблице содержатся

вероятности разрядов признаков при различных диагнозах. Если

ч

Таблица 1

Диагноз

Диагностическая матрица

в методе Байеса

Признак к:

Q

гН

0,8

0,1

*Г

а.

0,2

0,7

Q

ft.

0

0,2

Q

-fti

о.

0,1

0

Q

S3

•ее

0,1

0

ft,

0,6

0,3

*?

ft,

0,2

0,7

Q

ео

Он

0,2

0,1

3

сГ

«4

ео

•fti

ft.

0,8

0,9

р тл

0,3

0,1

14

признаки двухразрядные (простые признаки «да—нет»), то в таб-

таблице достаточно указать вероятность появления признака

р (kj/Dd- Вероятность отсутствия признака Р (&;/Д) = 1 —

(ty)

Однако более удобно использовать единообразную форму,

полагая, например, для двухразрядного признака Р (kf/Di) =

- Р (кц/Di); Р (kj/Dd = P (kjjDi).

т{

Отметим, что ^j P(kjs/Dt) = 1, где my- — число разрядов при-

s=l

знака kj. Сумма вероятностей всех возможных реализаций при-

признака равна единице.

В диагностическую матрицу включены априорные вероят-

вероятности диагнозов. Процесс обучения в методе. Байеса состоит

в формировании диагностической матрицы. Важно предусмотреть

возможность уточнения таблицы в процессе диагностики. Для

этого в памяти ЭВМ следует хранить не только значения Р (&ys/Dt),

но и следующие величины: N — общее число объектов, исполь-

использованных для составления диагностической матрицы; Nt — число

объектов с диагнозом Д; Ntj — число объектов с диагнозом Dt,

обследованных по признаку кг Если поступает новый объект

с диагнозом ?)д, то проводится корректировка прежних априор-

априорных вероятностей диагнозов следующим образом:

л/ . 1 C.17)

N,L + 1 л/ 1

N+\ { ^ N + 1 "Г W + 1 ' l r '

Далее вводятся поправки к вероятностям признаков. Пусть

у нового объекта с диагнозом D^ выявлен разряд г признака kj.

Тогда для дальнейшей диагностики принимаются новые значения

вероятности интервалов признака L при диагнозе D^'.

C.18)

Условные вероятности признаков при других диагнозах коррек-

корректировки не требуют.

Пример. Поясним метод Байеса. Пусть при наблюдении за газотурбинным

Двигателем проверяются два признака: kx — повышение температуры газа за.

турбиной более.чем на 50°С и k2 — увеличение времени выхода на^максимальную

частоту вращения более чем на 5 с. Предположим, что для данного типа двига-

двигателей появление этих признаков связано либо с неисправностью топливного регу-

регулятора (состояние Dx)y либо с увеличением радиального зазора в турбине (со-

\5

При нормальном состоянии двигателя (состояние D3) признак kx не наблю-

наблюдается, а признак k2 наблюдается в 5% случаев. На основании статистических

данных известно, что 80% двигателей вырабатывают ресурс в нормальном состоя-

состоянии, 5% двигателей имеют состояние D1 и 15% — состояние D2. Известно также,

что признак kx встречается при состоянии Dx в 20%, а при состоянии D2 в 40% слу-

случаев; признак к2 при состоянии Dx встречается в 30%, а при состоянии D2 —

в 50% случаев. Сведем эти данные в диагностическую таблицу (табл. 2).

Найдем сначала вероятности состояний двигателя, когда обнаружены оба

признака kx и k2. Для этого, считая признаки независимыми, применим фор-

формулу C.12).

Вероятность состояния

P(D1lk1kt) =

0,05-0,2.0,3

0,05-0,2-0,3 + 0,15-0,4-0,5 + 0,8-0-0,05

= 0,09.

Аналогично получим Р (DJkxk^ = 0,91; Р (О3/Л1ЛЯ) = 0.

Определим вероятность состояний двигателя, если обследование показало,

что повышение температуры не наблюдается (признак kx отсутствует), но увели-

увеличивается время выхода на максимальную частоту вращения (признак k2 наблю-

наблюдается). Отсутствие признака kr есть признак наличия kx (противоположное со-

событие), причем Р (kJDi) = 1 — Р (kJDt).

Для расчета применяют также формулу C.12), но значение Р (kJDj) в диагно-

диагностической таблице заменяют на Р (kJDi). В этом случае Р {DJkxk2) =

= 0,05-0,8-0,3

0,05-0,8-0,3 + 0,15-0,6-0,5 + 0,8-1.0,05

и аналогично Р (D2/kxk2) = 0,46; Р (DJkxk2) = 0,41. Вычислим вероятности

состояний в том случае, когда оба признака отсутствуют. Аналогично преды-

предыдущему получим

0,05-0,8-0,7 + 0,15-0,6-0,5 + 0,8-1 -0,15

= °'°3;

Р (D2/k±k2) = 0,05; Р (D3/M) = 0,92.

Отметим, что вероятности состояний D1wD2 отличны от нуля, так как рассматри-

рассматриваемые признаки не являются для них детерминирующими. Из проведенных

расчетов можно установить, что при наличии признаков k± и k2 в двигателе с ве-

вероятностью 0,91 имеется состояние Dlt т. е. увеличение радиального зазора. При

отсутствии обоих признаков наиболее вероятно нормальное состояние (вероят-

(вероятность 0,92). При отсутствии признака kx и наличии признака k2 вероятности со-

состояний D2nD3 примерно одинаковы @,46 и 0,41) и для уточнения состояния дви-

двигателя требуется проведение дополнительных обследований

Таблица 2

Вероятности- признаков и априорные вероятности

состояний

Dt

P (hlDi)

0,2

0,4

0,0

p (k2/Di)

0,3

0,5

0,05

p (Di)

0,05

0,15

0,80

16

Решающее правило — правило, в соответствии с которым при-

принимается решение о диагнозе. В^методе^айес.а объект с комплек-

комплексом признаков /С* относится к диагнозу' с наибольшей (апосте-

(апостериорной) вероятностью

K*eDl9 если P(Di/K*)>P(Dj/fC) (/-1, 2,..., /i; i + /). C.19)

Символ ? , применяемый в функциональном анализе, означает

принадлежность множеству. Условие C.19) указывает, что объект,

обладающий данной реализацией комплекса признаков Л** или,

короче, реализация /С* принадлежит диагнозу (состоянию) Д.

Правило C.19) обычно^ уточняется введением порогового значе-

значения для вероятности диагноза:

P(Dl/K*)>Pl9 C.20)

где Pi — заранее выбранный уровень распознавания для диаг-

диагноза Д. При этом вероятность ближайшего конкурирующего

диагноза не выше 1 — Pt. Обычно принимается Pt > 0,9. При

условии

P{DJK*)<Pi C.21)

решение о диагнозе в&^Я№ШМ2?Х?& (отказ от распознавания)

и требуется поступление дополнительной информации.

Процесс принятия решения в методе Байеса при расчете на

ЭВМ происходит достаточно быстро. Например, постановка диаг-

диагноза для 24 состояний при 80 многоразрядных признаках занимает

на ЭВМ с быстродействием 10—20 тысяч операций в секунду всего

несколько минут.

Как указывалось, методу Байеса присущи некоторые недо-

недостатки, например погрешности при распознавании редких диаг-

диагнозов. При практических расчетах целесообразно провести диаг-

диагностику и для случая равновероятностных диагнозов, положив

Р(Д)-1/я. C.22)

Тогда наибольшим значением апостериорной вероятности будет

обладать диагноз Д, для которого Р {K*IDL) максимальна:

/С 6 А, если Р (K*/Dt) > Р (КЩ) (/ = 1, 2,.. ., /i; i =f /).

C.23)

Иными словами, устанавливается диагноз Д, если данная сово-

совокупность признаков чаще встречается при диагнозе Д, чем при

Других диагнозах. Такое решающее правило соответствует ме-

методу максимального правдоподобия. Из предыдущего вытекает,

что этот метод является частным случаем метода Байеса при оди-

одинаковых априорных вероятностях диагнозов. В методе макси-

максимального правдоподобия «частые» и «редкие» диагнозы равно-

равноправны.

17

Для надежности распознавания условие C.23) должно быть

дополнено пороговым значением

Я(/С*/Д)>Л, C.24)

где Pt — заранее выбранный уровень распознавания для диаг-

диагноза Д.

§ 4. МЕТОД ПОСЛЕДОВАТЕЛЬНОГО АНАЛИЗА

Метод последовательного анализа, предложенный Вальдом,

применяется для дифференциальной диагностики (распознавания

двух состояний). В отличие от метода Байеса, число обследова-

обследований заранее не устанавливается, их проводится столько, сколько

необходимо для принятия решения с определенной степенью

риска.

Основы метода. При использовании метода Байеса для распоз-

распознавания состояний Dx и D2 следует составить отношение (для

независимых признаков)

Р (Р2//С*) ^ Р (Р2) Р (*\/Р2) -

р

Если

ИЛИ

Р №

Р(Рг) и ov

то принимается решение /f* ? D2-

В методе последовательного анализа рассматриваемые отно-

отношения вероятностей признаков (отношения правдоподобия) со-

составляются не сразу, а в последовательном порядке; поэтому,

как правило, требуется меньшее число обследований. Поясним

сущность метода на следующем примере.

Пример. Пусть при диагнозе Da простой признак kx встречается с вероят-

вероятностью Р (kJDi) и отсутствует с вероятностью Р (kJD^), для диагноза Р2 соот-

соответственно Р (k1/D2) и Р (kJDz). Если у объекта К* наблюдается признак kx

и при диагнозе Р2 он встречается значительно чаще, чем при Dlt то можно сде-

сделать вывод в пользу диагноза Р2:

D-4)

где А — верхняя граница принятия решения.

1$

В противоположном случае, когда признак kx значительно чаще встречается

при диагнозе Dx, принимается решение в пользу диагноза Dx:

при Р(№) < к € Dlt D-5)

где В — нижняя граница принятия решения. Если отношение вероятностей,

которое часто называется отношением правдоподобия,

то для решения требуется поступление дополнительной информации. Тогда

проводится обследование по признаку k2 и пусть, например, у диагностируемого

объекта этот признак отсутствует.

Составляется произведение двух отношений правдоподобия и

принимается решение об отнесении объекта к диагнозу D2. Подобным образом

учитывается нижняя граница принятия решения. Если признаки зависимые,

то используется отношение Р \k2lkxD2)lP {h^k-fi^, в котором учитывается

вероятность отсутствия признака k2, при условии, что признак kx имеется.

Дополнительные обследования проводятся до тех пор, пока при выбранных

границах А и В можно принять определенное решение.

Часто оказывается удобным рассматривать не отношение правдоподобия,

а натуральный логарифм этого отношения. Тогда условие D.7) будет таким:

In (Р (kx/D2)/P (VAl)) + I" (P (k2/D2)/P fo/^i)) >

Подобная форма применяется при нормальном распределении количественных

признаков.

Общая процедура метода. Будем для краткости считать, что

признаки являются независимыми. Пусть проведено v — 1 обсле-

обследований, которые еще не дали возможности принятия решения,

в

а < Р (КЮХ) Р

но после v-ro обследования

'р(Л>1)> ( }

Тогда принимается решение об отнесении объекта к диагнозу D2'.

Л** (Е D2. Если после v-ro обследования

то объект относится к диагнозу Dv Для сокращения объема об-

обследований следует вначале проводить обследование по наибо-

наиболее информативным признакам (см. гл. 7, 8).

19

300

200

100

400

-200

Неисправное

i i ь-***

°1*

1 <

i

-—55?

г з v 5 ff^

1 J^TI

i

Продолжение

испытаний

-^J | Исправное

? /

f /7

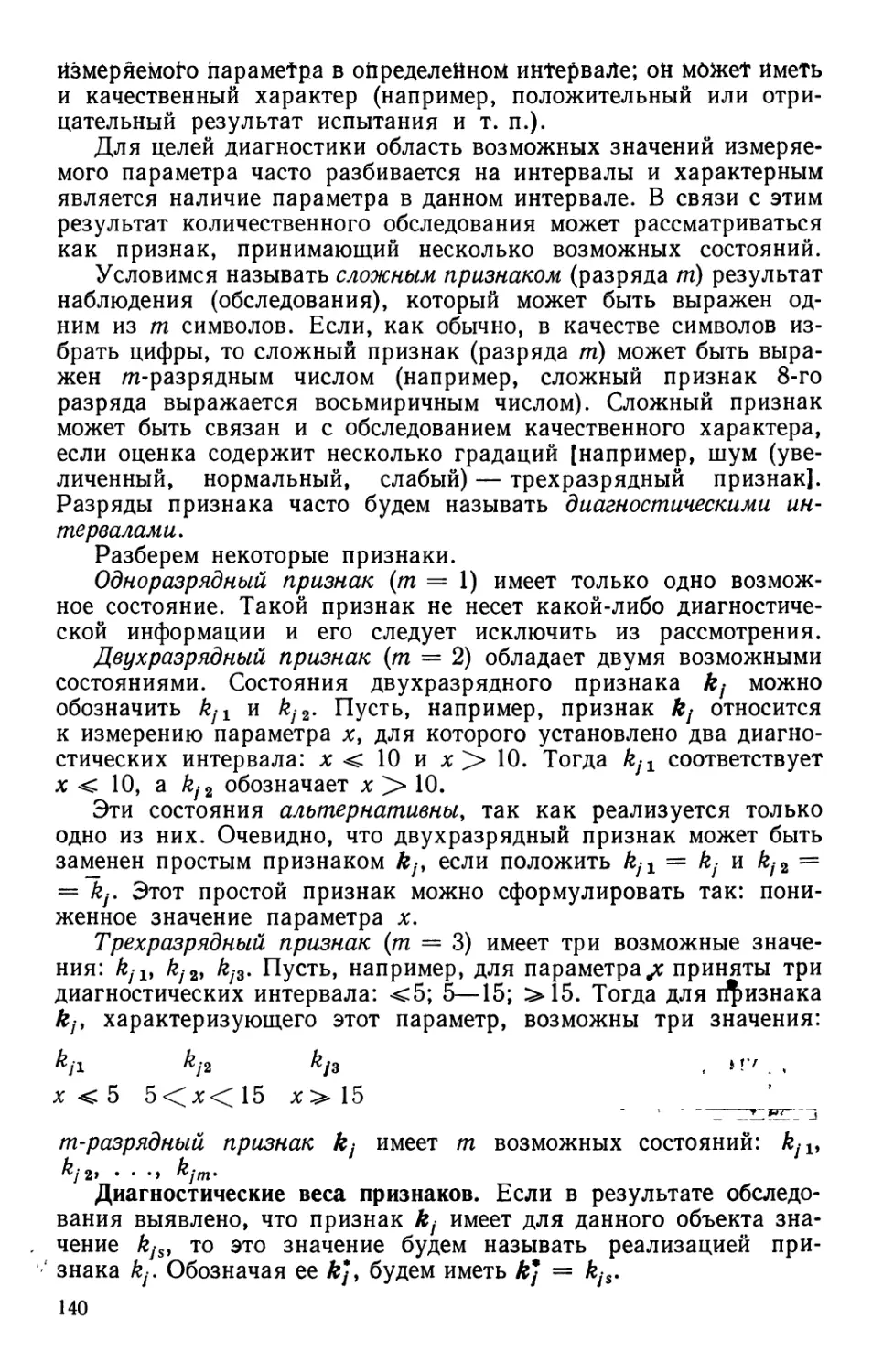

Рис. 2. Применение последовательного

анализа для оценки состояния двигателя

по результатам тензометрирования

Отметим, что метод пригоден

и для непрерывно распределен-

распределенных диагностических параметров,

хъ х2, но вместо вероятностей

признаков в отношения D.8),

D.9) и D.10) входят плотности

вероятностей параметров.

Связь границ принятия решения с вероятностями ошибок пер-

первого и второго рода При распознавании могут быть ошибки двоя-

двоякого рода. Ошибка относящаяся к диагнозу D± (принимается

решение о наличии диагноза D2, когда в действительности объект

принадлежит диагнозу Dx), называется ошибкой первого рода.

Ошибка, относящаяся к диагнозу D2 (принимается решение

в пользу диагноза Dlf когда справедлив диагноз D2), называется

ошибкой второго рода.

Считая состояние Dx исправным, а состояние D2 дефектным,

легко понять, что ошибка первого рода является «ложной тре-

тревогой», а ошибка второго рода «пропуском дефекта».

Обозначим вероятность ошибки первого рода а, второго рода р.

Допустим, что имеются условия D.8) и D.9) и принимается ре-

решение в пользу диагноза D2. Вероятность того, что это решение

будет справедливым, равна 1 — р. Вероятность принадлежности

объекта с данной реализацией признаков к диагнозу Dx состав-

составляет а. С другой стороны, в силу соотношения D.9), вероятность

диагноза ?>2, по крайней мере, в А раз больше, чем диа-

диагноза Dly т. е.

1-Р

А.

D.11)

Подобным образом можно получить и следующую оценку:

— а

D.12)

В практических расчетах часто принимают а = В = 0,05 или

а р 0Ю

Пример. В исправном газотурбинном двигателе среднее значение перемен-

переменного напряжения составляет xlt в дефектном двигателе это значение существенно

выше х2, но дисперсии практически мало отличаются of = g§ = а. Дна гностика

осуществляется с помощью измерения переменных напряжений в лопатках.

Закон распределения напряжений по отдельным лопаткам принимается нор-

нормальным.

20

Сначала проводится измерение в первой лопатке и составляется отношение

= : =г-г«- =- е~

е 2сг2

После проведения я-го обследования (т. е. измерения напряжений в лопатках 1,

2, ..., п) логарифм отношения

п

*iJ-

Х2 + Х!

Если для решения об исправном или неисправном состоянии двигателя нет до-

достаточных оснований, то отношение D.13) лежит в пределах

,„ в

Из последнего условия вытекает

п

Ь1-\-ап< ^ л-(/} < b2 -|- an, D.14)

где

GSU-ln-r-?—; 62=- . q2_ In -i-=^A; a =

^2 — ^1

Условие D.14) при различном числе испытаний п соответствует области между

двумя параллельными линиями (рис. 2). Если V хц) находится внутри линий, ис-

испытания продолжаются, если она выходит из «коридора», то принимается решение

о диагнозе.

о

Отметим, что Ьг < 0, так как —г— < 1. Ширина «коридора» тем больше,

1 — a

чем меньше величины а и р, чем меньше разность средних значений и чем выше

Дисперсия. Все эти обстоятельства с очевидностью соответствуют интуитивным

представлениям о процессе распознавания. Из рис. 2 видно, что после испытания

восьмой лопатки было принято решение о неисправном состоянии двигателя.

Отметим, что такая же процедура может использоваться для анализа напряжений

в различные моменты времени.

Глава 3

МЕТОДЫ

СТАТИСТИЧЕСКИХ

РЕШЕНИЙ

Вводные замечания. Рассматриваемые в этой главе методы

также относятся к статистическим. Однако они отличаются от

изложенных в гл. 2 правилами принятия решения. В методах

статистических решений решающее правило выбирается исходя

из некоторых условий оптимальности, например из условия мини-

минимума риска. Возникшие в математической статистике как методы

проверки статистических гипотез (работы Неймана и Пирсона),

рассматриваемые методы нашли широкое применение в радио-

радиолокации (обнаружение сигналов на фоне помех), радиотехнике,

общей теории связи и других областях. Методы статистических

решений успешно используются в задачах технической диагно-

диагностики [10, 24]. Ниже излагаются основы теории статистических

решений, более подробное изложение можно найти в работах

[15, 60, 62].

Рассмотрим сначала процесс распознавания при наличии

одного диагностического параметра.

§ 5. СТАТИСТИЧЕСКИЕ РЕШЕНИЯ

ДЛЯ ОДНОГО ДИАГНОСТИЧЕСКОГО ПАРАМЕТРА

Правило решения. Пусть производится диагностика состояния

газотурбинного двигателя по содержанию железа в масле (пара-

(параметр х). Задача состоит в выборе значения х0 параметра х таким

образом, что при ^х > хь следует принимать решение о снятии

двигателя с эксплуатации, а при х < ^ допускать дальнейшую

работу.

Так как состояние системы характеризуется одним пара-

параметром, то система имеет одномерное пространство признаков.

Разделение производится на два класса (дифференциальная диаг-

диагностика или дихотомия). Условимся считать: D1 — исправное

состояние и D2 — наличие дефекта. Тогда указанное правило

решения состоит в следующем:

при x<jc0 x(zD{, при х>х0 x?D2. E.1)

22

рис 3. Статистические рас-

распределения плотности веро- ^

ятности диагностического па- ffx/n) f X ^^ f(x/D)

раметра х для исправного -мЛ/-?/// / \ у^ ^v У * ' *'

р1 и дефектного D2 со-

состояний ^

Содержание железа в масле неоднозначно характеризует

состояние подшипника (в масло попадают железные частицы от

других трущихся деталей: шестерен, шлиц и т. д.). В зависимо-

зависимости от ряда факторов распределение х для дефектных и исправ-

исправных подшипников показано на рис. 3. Существенно, что области

исправного Dx и дефектного D2 состояний пересекаются и потому

принципиально невозможно выбрать значение х0, при котором

правило E.1) не давало бы ошибочных решений. Задача состоит

в том, чтобы выбор х0 был в некотором смысле оптимальным,

например давал наименьшее число ошибочных решений.

Рассмотрим сначала возможные ошибки при принятии решения.

Ложная тревога и пропуск цели (дефекта). Эти встречавшиеся

ранее термины явно связаны с радиолокационной техникой, но

они легко интерпретируются в задачах диагностики.

Ложной тревогой называется случай, когда принимается ре-

решение о наличии дефекта, но в действительности система нахо-

находится в исправном состоянии (вместо D± принимается D2).

Пропуск цели {дефекта) — принятие решения об исправном

состоянии, тогда как система содержит дефект (вместо D2 при-

принимается Dx).

В теории контроля эти ошибки называются риском постав-

поставщика и риском заказчика. Очевидно, что эти даоякого рода ощибки

могут иметь разлцчные последствия или различнее цеды.

Обозначим Hfj (i, j = 1,2) возможные решения по правилу E.1)

(первый нижний индекс соответствует индексу принятого диаг-

диагноза, второй — индексу действительного состояния). Тогда Н12 —

пропуск дефекта и Н21 — ложная тревога (Dt — исправное со-

состояние, D2 — дефектное состояние); Н1г и Я22 — правильные

решения.

Рассмотрим вероятность ложной тревоги Р (Я21) при исполь-

использовании правила E.1) (случай, когда при х > х0 объект является

исправным, но по правилу E.1) рассматривается как дефектный).

Площадь под кривой плотности вероятности исправного состояния,

соответствующая х > х0, выражает условную вероятность си-

ситуации^ х > х0 для исправных изделий

оо

p(*>*o/?>i)= \f(x/Dl)dx. E.2)

23

Вероятность ложной тревоги равна вероятности произведения

двух событий: наличие исправного состояния и значения х > х0.

Тогда

оо

Р (Я21) - Р (Dx) P(x> xJDx) - /\ J / (x/DJ dx, E.3)

Хо

где Рг = Р (DJ —априорная вероятность диагноза Dx (счи-

(считается известной на основании предварительных статистических

данных). Подобным образом находится вероятность пропуска

дефекта

Р (Н12) - Р (D8) Р (х < xJD2) = Р2 J / (x/D2) dx. E.4)

— оо

Средний риск. Вероятность принятия ошибочного решения сла-

слагается из вероятностей ложной тревоги и пропуска дефекта. Если

приписать «цены» этим ошибкам, то получим выражение для сред-

среднего риска

00 Хо

R = С21Р1 J / (x/DJ dx -f CnP2 J / (x/D2) dx. E.5)

Разумеется, цена ошибки имеет условное значение, но она

должна учесть предполагаемые последствия ложной тревоги и

пропуска дефекта. В задачах надежности стоимость пропуска

дефекта обычно существенно больше стоимости ложной тревоги

(C*i2 3> С21). Иногда вводится цена правильных решений Н1Х

и Я22, которая для сравнения со стоимостью потерь (ошибок)

принимается отрицательной. В общем случае средний риск (ожи-

(ожидаемая величина потери) выражается равенством

о

R = СпРг J f (jc/Di) dx + C2lP1 \ f (x/DJ dx +

— oo Xo

X0 oo

+ Cl2P2 J / (x/D2) dx ± C22P2 J / (x/D2) dx. E.6)

Величина х, предъявляемая для распознавания, является

случайной и потому равенства E.5) и E.6) представляют собой

среднее значение (математическое ожидание) риска.

Метод минимального риска. Найдем граничное значение х()

в правиле E.1) из условия минимума среднего риска. Дифферец-

24

рис. 4. Точки экстремума

среднего риска ошибоч-

ошибочных решений

цируя E.6) по х0 и приравнивая производную нулю, получим

сначала условие экстремума

-C22P2f(x0/D2)^0

или

fiXp/Di) _ (C12-C22)P2

f{xjD2)

E.7)

E.8)

Это условие часто определяет два значения л:0, из которых одно

соответствует минимуму, второе — максимуму риска (рис. 4).

Соотношение E.8) является необходимым, но недостаточным

условием минимума. Для существования минимума R в точке

х = х0 вторая производная должна быть положительной —т-=- >

ах0

> 0, что приводит к следующему условию относительно произ-

производных плотностей распределений:

!'

(С12-С22)Р2

Г(Х0/02)

E.9)

Если распределения f{xlDx) и f(xlD2) являются, как обычно,

одномодальными (т. е. содержат не более одной точки максимума),

то при

*1<*0<*2 E10)

условие E.9) выполняется. Действительно, в правой части ра-

равенства стоит положительная величина, а при х > xL производ-

производная /' (x/DJ < 0, тогда как при х < х2 значение /' (x/D2) > 0.

Для «двугорбых» распределений (рис. 5) условие E.9) должно

проверяться в каждой точке экстремума.

Рис. 5. Точки экстремума

для двугорбых распределе-

распределений

25

В дальнейшем под х0 будем понимать граничное значение

диагностического параметра, обеспечивающее по правилу E.1)

минимум среднего риска. Будем также считать распределения

f(xlD^j и f(x/D2) одномодальными («одногорбыми») (см. рис. 3).

Из условия E.8) следует, что решение об отнесении объекта х

к состоянию Dx или D2 можно связать с величиной отношения

правдоподобия. Напомним, что отношение плотностей вероятно-

вероятностей распределения х при двух состояниях называется отноше-

отношением правдоподобия.

В соответствии с правилом E.1) по методу минимального риска

принимается следующее решение о состоянии объекта, имеющего

данное значение параметра х:

ran ее ни f{x/Dl)

X^Uly если

f(x/D2) ^ (C21-

//^ С \ P

f{x,D2) ^ (C2l-Cn)Pl

Эти условия вытекают из соотношений E.1) и E.8).

Условие E.11) соответствует х < х0, условие E.12) х > х0.

Величина к = -77^—п , п2 представляет собой пороговое зна-

(С21 — Lu) Гг

чение для отношения правдоподобия. Напомним, что диагноз Dx

соответствует исправному состоянию, D2 — дефектному состоя-

состоянию объекта; С21 — цена ложной тревоги, С12 — цена пропуска

цели (первые индекс — принятое состояние, второй — действи-

действительное); Сц < О, С22 <0 — цены правильных решений (ус-

(условные выигрыши). В большинстве практических задач условные

выигрыши (доощрения) для правильных решен-цд не вводятся и

тогда

X = C12PjCnP1. E.13)

Существенно, что правило решения E.1) выражается теперь с по-

помощью отношения правдоподобия и для принятия решения даже

не требуется определение критического значения параметра х0.

Это справедливо при некоторых ограничениях, например, для

достаточно плавных («одногорбых») распределений.

Часто оказывается удобным рассматривать не отношение

правдоподобия, а логарифм этого отношения. Это не изменяет

результата, так как логарифмическая функция возрастает моно-

монотонно вместе со своим аргументом. Расчет для нормального и

некоторых других распределений при использовании логарифма

отношения правдоподобия оказывается несколько проще. Условие

минимума риска можно получить из других соображений, которые

окажутся важными в дальнейшем.

26

Запишем выражение для R в такой форме:

00 ОО

Я = СпРг | / (x/DJ dx + (С21 - Сп) Л J / (*/Dx) dx +

— со *,

ОО ОО

+ СпРг \ f (x/D2) dx + (С22 - С12) Р2 | / (x/D2) djf. E.14)

— оо Х0

ОО

Или, учитывая очевидные равенства J / (xlD^ dx = 1,

—со

во

J / (x/D2) dx = 1, получим

00

Я = СиЛ + С12Р2 + J [(С21 - Сп) PJ (x/DJ -

~(C1%-Cn)Pl(xlDj\dx. E.15)

Так как первые два слагаемые постоянные, то зависимость R

от х0 определяется величиной интеграла. При малых х0 (см.

рис. 3) подынтегральное выражение положительно (распределе-

(распределение/ (x/Dx) лежит левее/ (x/D2)), при больших х оно отрицательно.

Для того чтобы выбрать хо> соответствующее минимальному

значению /?, следует начать интегрирование с сечения х = xOi

в котором подынтегральное выражение отрицательно при х > х0.

Изменение знака подынтегрального выражения происходит

в сечении xOi причем (С21 — С±1) Рг {xJD^j — (С12 —

-C22)P2f(x0/D2) = 0, или

(С12-С22)Р2 .- lfi.

_ (С12-С22

Правило решения остается прежним [уравнение E.1)] и остаются

в силе условия E.8).

Пример. Рассмотрим случай, когда параметр х имеет нормальное распре-

распределение при исправном Dx и неисправном D2 состояниях. Рассеяние параметра

(величина среднеквадратичного отклонения) принимается одинаковым.

В рассматриваемом случае плотности распределений

/(/Dl)= e ;

а V 2я

(х-х2)*

f(x/D2) = * е 2а2 .

oV2n

Внося эти соотношения в равенство E.8), получаем после логарифмирования

1 1, _ 1П JlEliZl^sIf!.

~ ~№ [2JC« (JC* - *i> + *i ~ X21 - In (С21-Си)Р, ¦

27

Из этого уравнения

1__ а2/р2 q С \

хо — ~к~ (х\ + *г) - =- ( l'1 ~5 г 1П ~р -р ) •

z х2 — ati V ^1 C2i — си /

При х < Хо х ? Ог; при л: > хо л: ? D2.

Метод минимального числа ошибочных решений. Вероятность

ошибочного решения для решающего правила E.1)

х. E.17)

Из условия экстремума этой вероятности получаем

-—^ = — /у (xc/°i) -f ^2/ (V°2) — 0. E.18)

Условие минимума дает

^ш - — Рх/' (jto/DJ + PJ' (xo/D2) > 0 E.19)

или

/' (xjD^lF {xo/D2) < P2/Pv E.20)

Как указывалось, для одномодальных распределений при

условии E.10) неравенство E.20) выполняется и минимум вероят-

вероятности ошибочного решения получается из соотношения E.18):

/ (х /D )/f (х ID ) = Р /Р E21)

где, как и раньше, Рх = Р (Dx), Р2 = Р (D2) — априорные

вероятности диагнозов.

Решение х ? Dx принимается при

f(x/D1)/f(x/D2)>P2/Pl E.22)

и х ? D2 при

f(x/D1)/f(x/D2)<P2/Pv E.23)

Очевидно, что соотношения E.21)—E.23) являются частным

случаем условия минимального риска, если стоимости решений

одинаковы. Условие выбора граничного значения E.21) часто

называется условием Зигерта— Котельщгкова (условием идеаль-

идеального наблюдателя). К этому условию приводит также метод Байеса

(см. гл. 2). Действительно, вероятности диагнозов D± и D2 для

данного значения х (апостериорные вероятности) Р {DJx) =

= P(D1)f (x/DJ/f (*); Р (DJx) = Р (D2)f {xlD2)lf (x). Решение

x ? Di принимается при Р {DJx) >P(D2/x) или

f(x/D1)/f(x/D2)>P2/Ply E.24)

что совпадает с равенством E.22).

28

В задачах надежности рассматриваемый метод часто дает

«неосторожные решения», так как последствия ошибочных реше-

решений существенно различаются между собой. Обычно цена про-

пропуска дефекта существенно выше цены ложной тревоги. Если

указанные стоимости приблизительно одинаковы (для дефектов

с ограниченными последствиями, для некоторых задач контроля

и др.), то применение метода вполне оправдано.

Метод минимакса предназначен для ситуации, когда отсут-

отсутствуют предварительные статистические сведения о вероятности

ддаиюзав Dx и D2. Рассматривается «наихудший случай», т. е.

"наименее благоприятные значения Рг и Р2, приводящие к наи-

наибольшему значению (максимуму) риска.

Будем считать, что величина риска зависит теперь от х0 и Рг

(вероятность второго диагноза Р2 — 1 —Рг). Из соотношения

E.6) вытекает

R (х0, PJ = СпРг \ / (x/DJ dx + С21Р, J / (x/Dt) их +

—00 Хо

Х0 во

+ Си A - PJ \ 1 (x/D.) dx + С22 A - Л) | / (JC/D.) dx. E.25)

—оо Хо

Для нахождения экстремума приравняем нулю частные произ-

производные по х0 и Рг. Условие

1

1

=°

дает

f(xo/D2)

Из соотношения

E-26)

E.27)

E.28)

получаем

dx + Cn J fix/DJdx^

— oo

oo

= C12 J / (x/D2) dx + C22 J f (x/D2) dx.

E.29)

Теперь требуется определить значения х0 и Pl9 удовлетво-

удовлетворяющие уравнениям E.27) и E.29). Если хо и Р* являются кор-

корнями указанных уравнений, то точка R (лго, Р\) является экс-

экстремальной.

29

Можно показать для одномодальных распределений, что вели-

величина риска становится минимаксной (т. е. минимальной среди

максимальных значений, вызванных «неблагоприятной» величи-

величиной Pi). Отметим, что при Р1 = 0 и Рх = 1 риск принятия оши-

ошибочного решения отсутствует, так как ситуация не имеет неопре-

неопределенности. При Рх = 0 (все изделия неисправны) из условия E.8)

вытекает х0 —* — оо и все объекты действительно признаются

неисправными; при Рг = 1 и Р2 = 0 х0 —>оо ив соответствии

с имеющейся ситуацией все объекты классифицируются как

исправные.

Для промежуточных значений 0 < Рг < 1 риск возрастает

и при Pi = РГ становится максимальным. Рассматриваемым

методом выбирают величину х0 таким образом, чтобы при наименее

благоприятных значениях Р± потери, связанные с ошибочными

решениями, были бы минимальными.

Рассмотрим процедуру решения уравнений E.27) и E.29).

Сначала из уравнения E.29) найдем значение Хо, что можно сде-

сделать следующим образом. Представим уравнение E.29) в виде

Ф(*о)=*О, E.30)

где

во Хо

Ф (хо) = (Си - Сц) J / (x/DJ dx - (Clt - С22) J / (x/D2) dx+Cu-Cn.

Хо — во

E.31)

Последнее равенство можно записать с помощью функций рас-

распределения

Ф (*о) = (Си - Сц) [1 - F (хо/DJ] - (Са - С22) F (VAJ + Cu - С22;

Х0 Хо

/?(V^>i)= J fix/DJdx; F(xo/D2)= J f(x/D2)dx. E.32)

— oo —oo

Уравнение E.30) решаем по методу Ньютона, связывающему

исходные Хо(П_1) и последующие Хо{п) приближения:

v v Ф (Х0 (tt-1)) /С ОО\

^0 (л) = ^0 (л-1) Щ • @.66)

Значение производной

^ - (Си - С22)/(хо (*-i)/D2). E.34)

В качестве первого приближения можно принять *0<1) = (х{

+ г), где xl9 х2 — средние значения х для распределения

/ (xlDx) и / (x/D2). При достаточной близости хо{п) и хО(П~\) при-

принимаем Хо = д^о(л). Далее из равенства E.27) находим наименее

30

рис. 6. Определение гра-

граничного значения диагно-

диагностического параметра по

методу минимакса

L

благоприятное значение вероятностей исправного Р* и неисправ-

неисправного Р| состояний

/>?=•

С12

(C2l - Cn)f

(xS/D2)

PI == 1 - Pf. E.35)

Величину риска определяем по равенству E.25) при значе-

значениях Xq = Xq, Р\ = Р\. Отметим некоторые случаи, в которых

решение становится достаточно наглядным. Положим, что ус-

условные выигрыши отсутствуют Сц = С22 — 0» а цены ошибок

одинаковы С12 = С21. Тогда из уравнения E.29) вытекает

\f(x/Di)dx= \f(x/Dt)dx

F (xJD^) и F (xo/D2) — соответствующие функции распределе-

распределения. Последнее соотношение показывает равенство условных

вероятностей ошибочных решений.

На рис. 6 для этого случая площади Рлт и Рп<д равны. В об-

общем случае

x или

+F(xo/D2) = 1, где

/

\dx

f (x/D2) dx

C12 _ цена пропуска дефекта

C2i цена ложной тревоги

E.36)

Зависимость E.36) выражает равенство условных рисков ошибоч-

ошибочных решений. С помощью функций распределения она записы-

записывается в виде

= ¦§*-• E.37)

Метод Неймана—Пирсона. Как уже указывалось, оценки стои-

стоимости ошибок часто неизвестны и их достоверное определение

связано с большими трудностями. Вместе с тем ясно, что во всех

случаях желательно при определенном (допустимом) уровне одной

из ошибок минимизировать значение другой. Здесь центр проб-

проблемы переносится на обоснованный выбор допустимого уровня

31

ошибок. с._помощью предыдущегоv опыта или интуитивных сооб-

соображений.

По методу Неймана—Пирсона минимизируется вероятность

пропуска цели при заданном допустимом уровне вероятности

ложной тревоги. Таким образом, вероятность ложной тревоги

f(x/D1)dx<A, E.38)

где А — заданный допустимый уровень вероятности ложной

тревоги; Рг — вероятность исправного состояния.

Отметим, что обычно условие E.38) относят к условной ве-

вероятности ложной тревоги (множитель Рг отсутствует). В задачах

технической диагностики значения Рг и Р2 в большинстве слу-

случаев известны по статистическим данным.

Из рис. 3 видно, что увеличение ошибки ложной тревоги (се-

(сечение х0 перемещается влево) величина ошибки пропуска дефекта

уменьшается. Ее наименьшее значение будет соответствовать

знаку равенства в условии E.38):

оо

^i J [(х/Ог)с1х = А. E.39)

Теперь условие E.38) однозначно определяет величину xQ и

значение риска [уравнение E.6)].

Остановимся на выборе значения А — допустимого уровня

ложной тревоги (риска поставщика).

Пример. При эксплуатации было установлено, что у 2—3% двигателей встре-

встречаются поломки в результате повышенных динамических нагрузок при увеличен-

увеличенном флан&е шестерни редуктора. В дефектных редукторах наблюдается повышен-

повышенная виброперегрузка при частоте, соответствующей частоте зацепления. Было

проведено измерение вибраций всего парка двигателей и назначена норма, при

повышении которой двигатель направляется на разборку и дефектацию. При

выборе нормы исходили из двух соображений: число снимаемых с эксплуатации

двигателей должно существенно превышать ожидаемое число дефектных двига-

двигателей; принимаемое значение ложной тревоги не должно нарушать нормальную

эксплуатацию или приводить к чрезмерным экономическим потерям. Этим

условиям удовлетворяла норма, приводящая к снятию с эксплуатации при-

примерно 10% двигателей.

В практических задачах можно принимать

А = kP2, E.40)

где k — коэффициент избыточности, зависящий от разрешающей

способности диагностических средств, опасности дефекта, эко-

экономических затрат и других обстоятельств.

При дефектах с ограниченными последствиями можно прини-

принимать k = 1~3. При опасных дефектах k = З-т-10. Для редко

встречающихся (Р2 < 0,01), но крайне опасных дефектов коэф-

коэффициент избыточности может достигать и больших значений.

32

В задачах технической диагностики можно использовать и

другой подход: определить, градичное значение х0, исход»- из

забранной вероятности пропуска дефекта. В этом случае

dx^B, E.41)

где В — заданное значение вероятности пропуска дефекта.

Трудно указать общие правила для назначения величины 5,

она должна выбираться с учетом указанных ранее соображений.

Если дефект крайне нежелателен даже на единичном изделии,

можно принимать

где N — общее число изделий, находящихся в эксплуатации;

k — коэффициент избыточности A < k < 10). Во всех случаях,

для реализации принципа невозможности маловероятных собы-

событий, величина В должна быть малой (В < 0,01). В методе Ней-

Неймана—Пирсона граничное значение х0 находится из уравнения

E.39) или E.41).

При практическом решении подобных уравнений целесооб-

целесообразно использовать метод Ньютона [соотношение E.33)], пола-

полагая, например,

Ф (*о) = Pi\ f (xo/Dr) dx - Л; Ф' (хо) = - PJ (Xo/DJ. E.43)

Метод наибольшего правдоподобия можно рассматривать как

частный случай метода минимального риска. Правило решения

принимается следующим:

x?Dl9 если j|g>l; E.44)

где х — значение параметра для диагностируемого объекта.

Граничное значение находится из условия

f(*o/Di)-/(V#2). E.45)

Сопоставляя условия E.8) и E.45), легко установить, что они

совпадают, если положить

i?i2 — С22) Р2 1

И. Л. Биргср 33

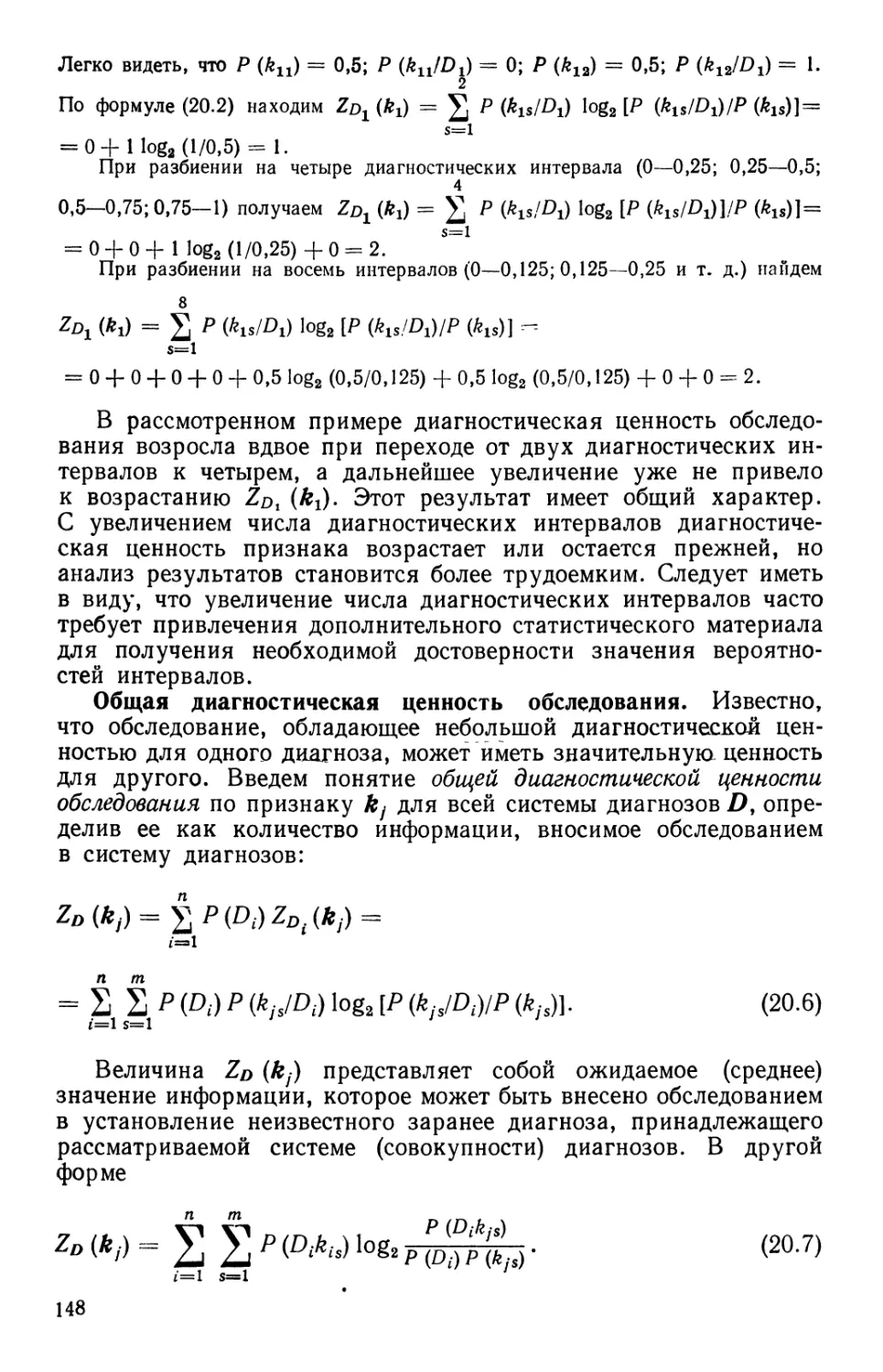

Рис. 7. Плотности рас-

распределения содержания

железа в граммах на 1 т

масла для исправных Dx

и неисправных D2 дви-

двигателей (номера линий

соответствуют табл. 3)

20 X

В большинстве практических случаев используется усло-

условие E.13), и тогда для метода наибольшего правдоподобия следует

считать

¦ =1.

E.47)

Для задач надежности вероятность неисправного состояния

обычно представляет собой малую величину, но цена пропуска

дефекта значительно больше цены ложной тревоги (С12 > С21).

Тогда условие E.47) дает решение, не требующее знания точных

значений стоимости ошибок и качественно отражающее указан-

указанные обстоятельства (Р2 С ^i» C12 > С21).

Пример. Диагностика состояния трансмиссии газотурбинного двигателя

осуществляется по содержанию железа в масле. Для исправного состояния сред-

среднее значение составляет хг = 5 E г железа на 1 т масла) и среднеквадратичное

отклонение ох = 2. При наличии дефекта подшипников и других деталей (не-

(неисправное состояние) эти значения равны х2 = 12, а2 = 3. Распределения пред-

предполагаются нормальными.

Требуется определить предельное содержание железа в масле, выше кото-

которого двигатель подлежит снятию с эксплуатации и разборке (во избежание опас-

опасных последствий). По статистическим данным, неисправное состояние трансмис-

трансмиссий наблюдается у 10% двигателей. Проведем решение различными методами.

Метод минимального риска. Примем, что отношение стоимостей пропуска

Q

цели и ложной тревоги -^- = 20, и откажемся от «вознаграждения» правильных

решений (С1Х = С22 = 0). Из условия E.8) получаем { ^^}\ = 20-^тг = 2>22-

Плотности распределения f

1

= т=г е

2-2*

1

= —т=г е

jc—12)»

2-3*

3]/я

лучаем после логарифмирования

. Внося эти значения в предыдущее равенство, по-

8

(*о -12J

18

= In

2-2,22

Это уравнение имеет положительный корень *о = 7,456. На рис. 7 даны плотности

распределения f(xJDx) и f(x/D2) и граничное значение хо.

34

По методу минимального числа ошибочных решений уравнение для определе-

определения хо будет таким:

(*о-5J (*0-12J /_2__М

-~"~ 8 h 18 \ 3 9 )

Положительный корень этого уравнения хо — 9,79.

Метод минимакса. Граничное значение хо вычисляется из уравнения E.32):

С21 [1 —Fixo/Di)] — C12F (xo/D2) - 0.

Для нормального распределения функции распределения выражаются с по-

помощью функций Лапласа

_1_

2

- JL j <ъ I хо — :

2

где Ф (х) =

Расчет проводится по формуле E.33). Первое приближение

хо A) = ft + *«>/2 = E + 12)/2 = 8,5.

Второе приближение

*0 B) = *0 A) - Ф (*0 A))/Ф' N A))'

Ф (*о A)) = С21 [ 1 - F (х0 A)/Ох)] - C12F (x0

Ф# (*о A)) = ~ С21/ (х0 {l)/Dx) - Cl2f (x0

Значения С21 = 1, С12 = 20. Расчеты дают а:0 B^ = 6,79. При расчете использо-

использовались таблицы для нормального распределения. Последующие приближения

дали: #0C) = 5,91; х0 D) = 5,72; лг0 E) = 5,71. При С21=1, С12 = 1 получено

дг0A^ = 8,5; дг0 ^2) = 7,79; л:0 ^3) = 7,80. Значения наиболее неблагоприятных ве-

вероятностей состояний при х*0 = 5,71 Р\ = 0,61; PJ = 0,39; при a:J = 7,80 Р\ =

= 0,93; р; = 0,07.

По методу Неймана—Пирсона принимаем Л = kP2- Считая последствия де-

дефекта ограниченными (для контроля состояния трансмиссии используются также

показания вибродатчиков), принимаем k = 1, что дает А = 0,1. Полагая первое

приближение х0 A) = (хг +^2)/^ = 8,5, находим второе приближение по фор-

формулам E.33) и E.43)

х _

0B)-

Расчеты дают следующие значения приближений: xQ ^2) = 6,85; х0 ^ = 7,36;

^0 D) == 7,43; х0 ^ = 7,43. По методу наибольшего правдоподобия граничное

значение находим из условия E.45), что дает *о = 8,14.

Результаты расчета показаны на рис. 8 и сведены в табл. 3. Для каждого из

граничных значений вычислены вероятности ложной тревоги и пропуска дефекта

по формулам E.3) и E.4) при Рг = 0,90 и Р2 = 0,10 и величина риска по соотно-

Шению E.5) при указанных значениях вероятностей состояний и при —^- = 20.

C2i

2* 35

Таблица 3

Результаты расчета по методам статистических решений

№

п/п

1

2

3

4

5

6

Метод

Метод минимального риска

Метод минимального числа

ошибок

Метод мини-

макса

Cl2 — °о

г

С 21

^12 1

Метод Неймана—Пирсона

Метод наибольшего прав-

правдоподобия

Гранич-

Граничное зна-

значение

7,46

9,79

5,71

7,80

7,44

8,14

Вероят-

Вероятность

ложной

тревоги

0,0984

0,0074

0,3235

0,0727

0,1000

0,0524

Вероят-

Вероятность

пропуска

дефекта

0,0065

0,0229

0,0018

0,0081

0,0064

0,0098

Средний

риск

0,229

0,467

0,360

0,234

0,230

0,249

Из сопоставления видно, что метод минимального числа ошибок дает неприемле-

неприемлемое решение, так как цены ошибок существенно различны. Граничное значение

по этому методу приводит к значительной вероятности пропуска дефекта. Метод

минимакса в основном варианте ( *2 = 20 ) требует очень большого съема дви-

\ ^21 /

гателей с эксплуатации (примерно 32%), так как исходит из наименее благоприят-

благоприятного случая (вероятность неисправного состояния Р2 = 0,39). Применение ме-

метода может быть оправданным, если отсутствуют даже косвенные оценки вероят-

вероятности неисправного состояния. В рассматриваемом примере удовлетворительные

результаты получаются по методу минимального риска.

§ 6. СТАТИСТИЧЕСКИЕ РЕШЕНИЯ ПРИ НАЛИЧИИ

ЗОНЫ НЕОПРЕДЕЛЕННОСТИ И ДРУГИЕ ОБОБЩЕНИЯ

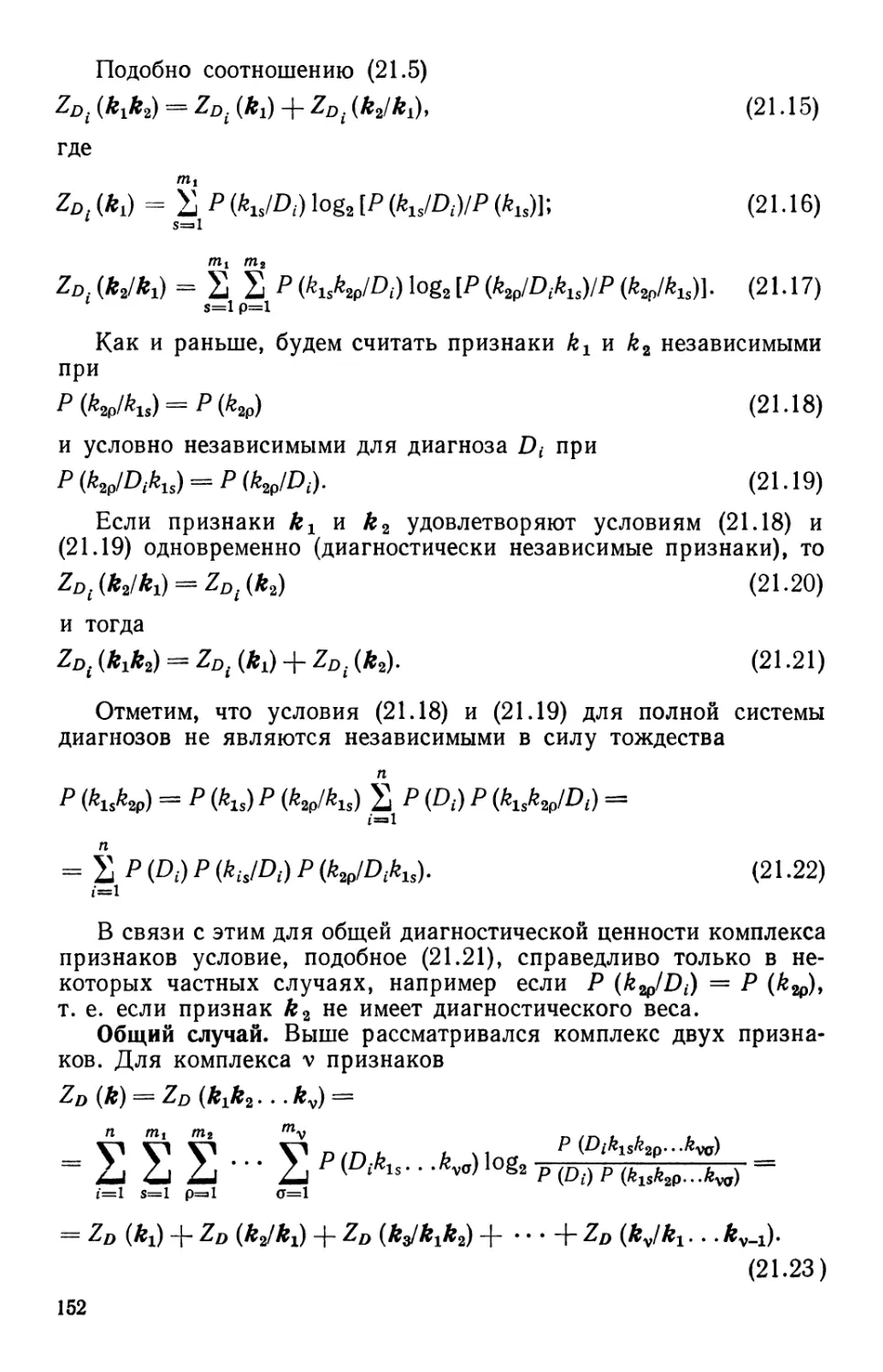

Правило решения при наличии зоны неопределенности. В неко-

некоторых случаях, когда требуется высокая надежность распозна-

распознавания (большая стоимость ошибок пропуска цели и ложной тре-

тревоги), целесообразно ввести зону неопределенности (зону отказа

от распознавания). Правило решения будет следующим (рис. 8):

x<x& F.1)

при

при х > xb

при

отказ от распознавания.

Разумеется, отказ от распознавания является нежелательным

событием. Он свидетельствует, что имеющейся информации недо-

недостаточно для принятия решения и нужны дополнительные све-

сведения.

36

рис. 8. Статистические

решения при наличии

зоны неопределенности

Определение среднего риска. Величина среднего риска при

наличии зоны отказа от распознавания может быть выражена

следующим равенством (см. § 5):

R - СпРх J / (х/пг) dx + СпРг J / (x/Dx) dx -f

~°° хь

+ Ci2P2 J / (x/D2) dx + C22P2 J / (x/D2) dx +

xb

xb

+ Co J [PJ (x/DJ + PJ (x/D2)} dx, F.2)

xa

где Co — цена отказа от распознавания.

Отметим, что Со > 0, иначе задача теряет смысл («вознаграж-

(«вознаграждение» за отказ от распознавания). Точно так же Сп < О, С22 <: О,

так как правильные решения не должны «штрафоваться».

Метод минимального риска при наличии зоны неопределенно-

неопределенности. Определим границы области принятия решения, исходя из

минимума среднего риска. Дифференцируя выражения F.2)

по ха и хъ и приравнивая производные нулю, найдем

дха ~uuri

dR

С12Р2/ (xa/D2) -

J (xb/D2)

Из этих уравнений получаем

_ (С12-С0)Р2 .

(Ct-dOP! '

__ (C0-C22)P2

F.3)

F.4)

F.5)

F.6)

37

Равенства F.5) и F.6), выражающие необходимые условия экстре-

экстремума, могут существовать, если их правые части положительны,

Для этого необходимо, чтобы

^12 > О)» С21 > Со, F.7)

т. е. стоимость ошибок должна быть больше стоимости отказа от

распознавания. Если не поощрять правильные решения (С1Х = О,

^22 = 0) и не платить за отказ от распознавания (Со = 0), то

область неопределенности будет занимать всю область изменения

параметра.

Для существования минимума функции двух переменных

R (Ха> xb) ДОЛЖНО быТЬ

от? / а»/? у

) >0 F-8)

Вследствие равенства нулю смешанной производной, условия

минимума таковы:

^ (С12-С0)Р2 . ,fi Q

Г (xa/D2) ^ (С0-С11)Р1

^ (Ср - С22) Р2

Можно показать для «одногорбых» распределений, что при ус-

условии

х1<ха<хь<х2 F.11)

условия F.9) и F.10) выполняются и соотношения F.5) и F.6)

дают значения ха и хь, соответствующие минимуму риска.

Метод Неймана—Пирсона при наличии зоны неопределимости.

Естественное обобщение метода состоит в том, что ха и хь опре-

определяются из условий:

ОО

Pi J /

F.12)

где Л и Б — вероятности ложной тревоги и пропуска дефекта.

Наличие зоны неопределенности дает возможность обеспе-

обеспечить заданные уровни ошибок за счет отказа от распознавания

в «сомнительных» случаях. Правило принятия решения F.1)

может быть выражено через отношения правдоподобия:

ПРИ f(x/D2) < (CQ

f(x/D2) > (С21-С0)Рг

ттпы (^12 — Ср) Р2 ^ f (Х/Рт) ^ (Со — С22) Р2 ПТ-.П9 пт ПЯРППЧНЯПЯНИЯ

ПрИ (C0-Cu)Px < /(*/OJ < (СИ-С,)Л °ТКа3 °Т Распознавания-

38

рассмотрим случай, когда параметр х распределен по нор-

нормальному закону при диагнозах Dx (исправное состояние) иО2

(неисправное состояние), причем среднеквадратичное отклонение

з обоих случаях одинаково.

Плотности распределений

i = —-?=- е

2G2

202

В силу соотношений F.5) и F.6) будем иметь

1П

(у /П \ 9rr2 l^^a V^2 Л1/ Г л I — ^2J — *" p Г ul ^ Г

\Xa/L/2) zu *\ ^o — W

о — ^2

ln / to/D) ~ ~~ 255-l2x"(X2 ~ Xl) + Xl ~ X2j = ln РГ

Из последних равенств находим

х2 —

^ = -o-l

ч а2 Г, Р2 i I Q — ^ 1

При С1Х = С22 ==0 и Со —> 0 получаем ха —> —сх), хь —> сх>,

т. е. зона неопределенности занимает всю область изменения

параметра.

Статистические решения для нескольких состояний. Выше были

рассмотрены случаи, когда статистические решения принимались

Для различения двух состояний (дихотомия). Принципиально

такая процедура позволяет провести разделение на п состояний,

каждый раз объединяя результаты для состояния D{ и Dt. Здесь

под Dt понимаются любые состояния, соответствующие условию

«не D,». Однако в некоторых случаях представляет интерес рас-

рассмотреть вопрос и в прямой постановке — статистические реше-

решения для классификации п состояний. Рассмотрим, как и раньше,

системы с одним диагностическим параметром х. Вначале оста-

остановимся на случае, когда проводится разделение на три состоя-

состояния (рис. 9). Правило решения состоит в следующем:

пРи —оо<х<л:1 x?D{, при хх<л:<х2 x?D2;

ПРИ *2<л:<оо x?D3. F.14)

39

О х1 х2 х

Рис. 9. Метод статистических решений для трех состояний

Средний риск

? ? ?

г\ — ^ll/l I / \X/*-S\) dX —р ^12^2 I / \X/J^2/ ^Х ~\~ ^13* 3 I

ОО 00 00

х. хг х

+ CnPi\ f(x/D1)dx + C2iP,\ f(x/D2)dx + C23P3\ f(x/DB)dx +

xt xt xt

oo oo oo

+ C3lPLl fix/DJdx + CnPil f(x/D2)dx + C33P3\ f(x/D3)dx. F.15)

x2 x2 x2

Величины Сij (IJ = 1, 2, 3) представляют собой элементы «пла-

«платежной матрицы». Индекс i соответствует принимаемой гипотезе

о состоянии объекта, индекс / — действительному состоянию.

Например, С12 выражает стоимость штрафа в случае, когда

по принятому правилу считается состояние Ъь тогда в действи-

действительности объект (изделие, машина) находится в состоянии D2-

Величины Сп < 0, так как они представляют собой поощрения

за правильные решения. Три первых слагаемых равенства F.15)

относятся к области первого состояния и т. д.

Рассмотрим метод минимального риска. В этом методе гранич-

граничные значения хг и х2 определяются из условия минимума R.

Необходимые условия минимума (экстремума)

OR

6R

= 0

приводят к следующим равенствам:

(Си - С2х) PJ (хЖ) + (Си - С22) PJ (Xi/D%)

F.16)

F.17)

(С21 - С31) PJ (

(С22 - С32) PJ (x2/D2)

= 0. F.18)

Из уравнения F.17) находим значение хи из уравнения F.18)—

х2. Для отыскания корней может быть использован метод

Ньютона.

40

Для того чтобы значения хг и лг2, удовлетворяющие урав-

уравнениям F.17) и F.18), соответствовали минимуму, необходимо

й достаточно выполнение следующих условий:

? |? F.19)

что дает

(Сп - С21) PJ' (xJD,) + (С12 - С22) Л/ (Ai/Da) +

+ (С13 - С23) /У' (^/D8) > 0; F.20)

(С81 - С81) Рх/' (x2/Dx) + (С22 - С32) /у' (x2/D2) +

+ (С23 - С33) PJ' (x2/D3) > 0. F.21)

Если распределения f(xlD^, f(x/D2) и f (x/D3) являются одно-

модальными («одногорбыми»), то последние условия выполняются

при

3, F.22)

где^1, х21 х3 — средние значения соответствующих распределений.

Статистические решения для многомерных распределений.

Выше рассматривались случаи, когда состояние системы (изделия)

характеризовалось одним параметром х и соответствующим (од-

(одномерным) распределением. Рассмотрим теперь системы, состоя-

состояния которых описываются несколькими диагностическими пара-

параметрами. Будем считать, что система может иметь только два

состояния — исправное D1 и неисправное D2. Состояние системы

характеризуется диагностическими параметрами х1у х2, ..., хп или

вектором х:

х=\хъ х2,...,хп]. F.23)

Статистическое распределение диагностических параметров для

состояния Dx

f(x/D1) = f(xl9 x2,...,xn/D1). F.24)

Если параметры хъ x2i ..., хп статистически независимы, то

(см. гл. 11)

/ (xlDx) = f (xJDJ f {x2lDx) ...f (xJDx). F.25)

Плотность распределения диагностических параметров для вто-

второго состояния

f(x/D2) = f(Xv x2,...,xJD2). F.26)

На рис. 10 показаны статистические распределения для двух

Диагностических параметров. Правило решения принимается

следующим:

если x?Sv то x^DL\

2, то x?D%. F.27)

41

f(X/»,) /f\

ж

/У

/ /

щ

/

/

L

Ш)

^

h

Si

^

Рис. 10. Статистические распределения для двух диагностиче-

диагностических параметров

Правило означает, что если точка, соответствующая вектору jc,

находится в области Sl9 то объект относится к состоянию Dly

и аналогично для области S2. Перейдем к определению среднего

риска. Обобщая соотношение F.7), получим

R = СпРг \ f (x/DJ dx + C2lP1 J / (x/DJ dx +

Si S2

+ Ci2P2 J / (x/D2) dx + C22P2 J / (x/D2) dx. F.28)

В равенстве F.28) интегралы распространяются на многомер-

многомерные области, причем под dx понимается элемент площади

dx = dxx dx2... dxn. F.29)

Учитывая, что плотности распределения для всей области удов-

удовлетворяют равенствам

dx-=l, F.30)

где 5 = Sx -f S2 — область изменения параметров хи ..., хп9

представим равенство F.28) в форме E.15):

R = СпР1 -\- С12Р2 ~\- J [(С21 — Сп) PJ

-(C12-C22)P2f(x/D2)]dx.

F.31)

Рассмотрим теперь метод минимального риска. Если гранич-

граничная линия L близка к центру первого распределения, то / (x/DJ >

^>f(x/D2) и подынтегральное выражение положительно.

42

Выберем положение границы L так чтобы вдоль границы подын-

подынтегральное выражение обратилось в нуль:

(Сп - Сп) PJ (xlDx) - (С12 - С22) P2fixlD2) - 0. F.32)

Последнее уравнение представляет собой уравнение границы

областей Sx и S2. Теперь область S2 выбрана таким образом,

что интеграл в равенстве F.31) будет иметь наибольшее по ве-

величине отрицательное значение. Это утверждение справедливо