Author: Растригин Л.А.

Tags: регулирование и управление машинами, процессами случайный поиск специфика этапы истории предрассудки

Year: 1978

Text

АКАДЕМИЯ НАУК СССР

НАУЧНЫЙ СОВЕТ ПО КОМПЛЕКСНОЙ ПРОБЛЕМЕ

«КИБЕРНЕТИКА*

MJ UII II

II

Выпуск 33

ПРОБЛЕМЫ СЛУЧАЙНОГО ПОИСКА

(Под редакцией Л. А. Растригина)

МрСКВА 1978

Сборник подготовлен Научным советом

по комплексной проблеме «Кибернетика» АН СССР.

117333, Москва, В-333, ул. Вавилова, 40, телефон 135-40-71

РЕДАКЦИОННАЯ КОЛЛЕГИЯ:

Д. т. н. С. И. Самойленко (председатель),

д. т. н. Е. В. Маркова (зам. председателя),

к. ф. н. С. С. Масчан (зам. председателя),

В. Г. Левадный (ответственный секретарь), д. т. н. В. М. Ахутин,

к. г.-м. н. Г. Г. Воробьев, д. т. н. Ю. Г. Дадаев,

д. ф.-м. н. Ю. И. Журавлев, чл.-корр. АН СССР Д. Е. Охоцимокийг

д. т. н. Д. А. Поспелов, д. т. н. И. В. Прангишвили,

чл.-корр. АН СССР А. Г. Спиркин, д. т. н. И. С. Уколов,

Э. В. Ханина, чл.-корр. АН СССР Я. 3. Цыпкин

В подготовке сборника принимали участие Л. А. Растригин,

П. Л. Мороз, А. И. Жданок, Г. С. Тapaceнко

(g) Научный совет по комплексна проблеме «Кибернетика»

АН СССР, 1978

УДК 62-506

СЛУЧАЙНЫЙ ПОИСК—СПЕЦИФИКА,

ЭТАПЫ ИСТОРИИ И ПРЕДРАССУДКИ

Л. А, Растригин

(Рига)

Случайный -поиск как МёТОД рекуррентной оптимизации

сложных систем возник сравнительно недавно — в начале

шестидесятых годов [1]. За немногим более чем полтора

десятилетия своей истории случайный поиск стал мощным

вычислительным средством, позволяющим решать сложнейшие задачи,

выдвигаемые наукой и народным хозяйством. Сейчас пожалуй уже

ни у кого нет сомнений б правомочности стохастических

процедур поиска и существовании задач, где такой подход более

целесообразен с различных точек зрения, чем детерминиррванные

алгоритмы поиска. Это оказалось возможным прежде всего в

связи с успешным решением ряда важных прикладных задач

(в основном из области оптимального проектирования сложных

систем современной техники), которые не удавалось решить,

другими методами, теоретическими результатами, с помощыо

которых показана большая эффективность случайного поиска

по сравнению с известными детерминированными процедурами,

и очевидными перспективами, которые открываются с

использованием элемента случайности в процессе -поиска (особенно по

преодолению приславутого «проклятия -размерности»).

ОСОБЕННОСТИ СЛУЧАЙНОГО ПОИСКА

Остановимся коротко на основных особенностях случайного

поиска, отличающих его от известных детерминированных

процедур оптимизации.

Случайный поиск как метод оптимизации получил

наибольшее применение при решении задач математического

программирования

Q(X)-+mm, (1)

1*

3

.[Si

где Х = (хи .. .,л:л) — вектор оптимизируемых параметров;

Q (X) — скалярная функция, значения которой могут

определяться случайной ошибкой; 5 —заданное множество допустимых

значений оптимизируемых параметров, которое определяется

системой равенств и неравенств:

g.(X) = 0, / = 1,...,т<л;

(*)>0, У = 1 Л. W

Задача математического программирования заключается

в отыскании решения X*, обладающего свойствами

Q(X*)=minQ(X) (3)

Известные методы решения приведенной задачи

существенным образом связаны с видом и свойствами функций Q(X)y

gi(X) и hj(X). Среди этих методов значительное место

занимают поисковые методы, суть которых сводится к

построению последовательности состояний

Х0-»Хг-+Х2-+ ... ^XN^ ..., (4)

где каждое последующее состояние должно быть в

определенном смысле лучше предыдушего. Алгоритм поиска определяет

способ перехода от одного состояния к другому:

XN = F[Xi9 Q(Xi)9 f = W-l,..., N-q]. (5)

Здесь q — глубина памяти алгоритма (иначе говоря, алгоритм

поиска является q-m^TOBUu). Функция (а в общем случае

оператор) F целиком определяет алгоритм поиска. Под F

подразумевается правило, инструкция, предписание, в соответствии с

которым следует действовать при данной предистории поиска

глубиной q.

Если оператор F детерминированный, то поиск называют

регулярным (детерминированным). Если же оператор случайный,

то поиск называют случайным (стохастическим).

Обозначим FQ — регулярный, a Fx— случайный операторы

поиска, где \ — символ случайного оператора. Для простоты

будем рассматривать операторы, которые могут быть

представлены в виде функций. Это не снизит значительно общности

рассмотрения. Алгоритм случайного поиска при этом записывается

в виде

X„=Ft[X„-u Q(**-i), W„-x] =

=/[х„_ь Q(**-i), w^-i.q, (6)

где / — функция, и^лг-i — вектор предистории поиска (в

простейшем случае q — шагового поиска):

4

То обстоятельство, что при £=0, т. е. в отсутствие элемента

случайности поиск приобретает детерминированный характер,

позволяет сделать первое и очевидное утверждение, что любой

регулярный метод поиска является частным случаем (при £ = 0)

некоторого множества случайных алгоритмов случайного

поиска.

Приведем пример. Градиентный метод поиска

A^ = *Ar-i-agradQ(*Ar-i), (7)

где оценка градиента имеет вид

gr ad Q {Х„-г) = у {Q (ЛГлг-i + gex) -

-Q(**-i), .. .,Q(*W-i + *^-Q(**-i)} (8)

(er i-й орт), является частным случаем, по крайней мере,

двух алгоритмов случайного поиска.

Первый алгоритм

XN = XN_X - a grad Q (AV-i) + «• (9)

где I —единичный случайный /г-мерный вектор. Это известный

градиентный алгоритм случайного поиска [3,4]. Второй

алгоритм имеет вид (7), но оценки градиента вычисляются

по формуле

grad Q (*„_0 =

_ V [Q (Х„-г + get + /!<)-<? (^)](gg< + /fr)

^ l**i + /!ilf * ( )

Здесь ^ — /-я реализация единичного случайного вектора. При

/ = 0 оба алгоритма вырождаются в градиентный алгоритм

поиска (7).

Таким образом, случайный поиск является естественным

расширением, продолжением и обобщением известных регулярных

методов поиска.

Другой особенностью случайного поиска, которая открывает

широкие возможности для его эффективного применения,

является использование оператора случайного шага g в качестве

стохастической модели сложных регулярных операторов

отыскания направлений поиска в пространстве оптимизируемых

параметров {X}.

Например, один из алгоритмов случайного поиска с

линейной тактикой (случайного спуска):

fog при ДО„>0; п

&XN+i = ^Xn при ±Qn < о У11)

является стохастической моделью алгоритма наискорейшего

спуска

5

„ iagtauQ(XN) при AQ//>0; .

Л*"+1 = (ДХ„ при AQ„<0, (12>

в которой вектор £ моделирует оценку градиента grad Q.

Любопытно, что подобную «оценку» нельзя даже назвать грубой,

так как ее стохастические свойства не напоминают свойств

оцениваемого градиента. Однако, несмотря на это, алгоритм (11)

не только работоспособен, но в ряде случаев и более

эффективен, чем алгоритм (12). Это показано в работе [5].

Здесь оператор случайного шага £ заменяет громоздкий

оператор оценки градиента, например, по формуле (8). Если

плотность распределения случайного вектора | выродится в дельта-

функцию вида

/>(!) = § (T-gradQ), (13)

то алгоритм случайного спуска (11) сведется к частному

случаю— алгоритму наискорейшего спуска (12).

Следующей особенностью случайного поиска, выгодно

отличающей его от регулярных методов, является его глобальность,

проявляющаяся прежде всего в локальных алгоритмах

случайного поиска, не предназначенных для отыскания глобального

экстремума. Так, алгоритм случайного спуска (11) может «айти

глобальный экстремум, а регулярный алгоритм наискорейшего

спуска в принципе не допускает такой возможности, поскольку

он построен для отыскания локального экстремума.

Таким образом, глобальность алгоритмов случайного поиска

является как бы «премией» за использование случайности и

что-то вроде «бесплатного приложения» к алгоритму. Это

обстоятельство особенно важно при оптимизации объектов с

неизвестной структурой, когда нет полной уверенности в одноэкст-

ремальности задачи и возможно (хотя и не ожидается) наличие

нескольких экстремумов. Использование в таком случае методов

глобального поиска было бы «неразумной» расточительностью.

Методы локального случайного поиска здесь наиболее прием-

лимы, так как они эффективно решают локальную задачу и

могут в принципе решить глобальную, если таковая будет иметь

место. Это обеспечивает случайному поиску своеобразную

психологическую надежность, которую очень ценят программисты.

Алгоритмическая простота случайного поиска делает его

привлекательным в первую очередь для потребителей. Опыт

показывает, что известные алгоритмы случайного поиска

являются лишь «канвой», на которой пользователь в каждом

конкретном случае «вышивает узоры» новых алгоритмов,

отражающих не только его вкусы и наклонности, что нельзя не

учитывать, но и специфику оптимизируемого объекта. Последнее

создает реальную основу для реализации известного

принципа— алгоритм должен конструироваться «под объект».

6

Наконец алгоритмическая простота случайного поиска

обуславливает простоту его аппаратурной реализации. Это не

только дает возможность строить простые, компактные и надежные

оптимизаторы с неограниченным числом оптимизируемых

параметров [6], но и позволяет довольно просто организовать их

оптимальный синтез на ЦВМ [7].

Теперь рассмотрим этапы истории случайного поиска.

Начнем с предыстории.

ПРЕДЫСТОРИЯ СЛУЧАЙНОГО ПОИСКА

Случайный поиск в процессах оптимизации имеет

предысторию, которой являются методы планирования экспериментов,

Монте-Карло, смешанные стратегии, «шумовая» идентификация,

гомеостат и усилитель умственных способностей. Рассмотрим их

коротко, тем более, что случайный поиск в своем развитии

опирается на эти вехи, о чем будет сказано ниже.

РАНДОМИЗАЦИЯ в процессах планирования

экспериментов вводится при необходимости осреднить результат по

ситуациям при наличии систематического дрейфа или

коррелированных помех. При этом случайный выбор порядка экспериментов

гарантирует несмещенность получаемых оценок параметров

модели объекта.

Здесь случайность играет роль смешивающего фактора,

позволяющего отфильтровать неизвестный систематический фактор.

МЕТОД МОНТЕ-КАРЛО сводится к оценке интеграла

I = \f{X)dX (14)

с помощью случайных точек (испытаний) Хи ..., Хм имеющих

распределение плотности вероятностей р (X), обладающей

свойствами:

р(Х)>0 для X£Q и \p(X)dX = 0

€1

Монте —Карловская оценка интеграла (14) имеет вид:

причем она обладает следующими ценными свойствами

состоятельности и несмещенности:

Y\mIN = I\ MIN = Iy

где М — оператор математического ожидания.

Преимущество этой оценки интеграла (14) по сравнению с

вычисленной по регулярной сетке проявляется с ростом

размерности области QczR71. Так при /г^З точность Монте-Карлов-

7

ской оценки в среднем превышает регулярную [8]. Любопытно,

что аналогичная оценка (п^З) определяет зону преимуществ,

случайного поиска по сравнению с градиентным по критерию

быстродействия [2].

В методе Монте-Карло случайность играет роль механизма,,

гарантирующего сколь угодно плотное размещение точек в

заданной области. Спецификой этой оценки, отличающей ее от

регулярной, является возможность ее реализации при любом ЛГ

(в том числе и при N=1, что широко используется в та.к

называемых рандомизированных алгоритмах оптимизации, о

которых будет сказано ниже).

СМЕШАННАЯ СТРАТЕГИЯ в матричных играх с

платежной матрицей в (#, у), когда решается задача максимизации

среднего выигрыша, заключается в вероятностном взвешивании

своих чистых стратегий Si,..., Sm:

т / т \

где pi — вероятность выбора /-й стратегии St. При отсутствии

седловой точки у матрицы в (л:, у), т. е. при

max min b (л:, у) Ф min max b (jc, у)

x у ух

смешанная стратегия является оптимальной. Это показано фон-

Нейманом еще в 1928 г. [9]. В данном случае смешение

стратегий связано не столько максимизацией выигрыша, сколько с

минимизацией проигрыша. Случай здесь не дает возможности

противнику много выиграть, и играет роль «дымовой завесы».

При отсутствии активности противника решение всегда

лежит в области чистых стратегий (смешение возможно, если

число таких оптимальных стратегий больше единицы. Однако оно

не необходимо).

ШУМОВАЯ ИДЕНТИФИКАЦИЯ динамических объектов

опирается на известное соотношение свертки между

автокорреляционной функцией входа Kxx(t) и взаимно-корреляционной

функцией входа и выхода Kxy(t) линейной динамической

системы

оо

Kxy(t) = \g(%)Kxx(t-t)<K

О

с весовой функцией g(t). Для идентификации этой функции

достаточно на вход объекта подать белый шум,

автокорреляционная функция которого является дельта-функция. В этом

случае, как легко заметить, взаимокорреляционная функция с

точностью до постоянного коэффициента будет совпадать с весовой

функцией объекта g(t). Здесь случайность позволяет как бы

«прощупать» динамику объекта на всех частотах. Она модели-

8

рует нереальное «всечастотное» возмущение стохастическим

образом.

ГОМЕОСТАТ предложенный Эшби [11] в 1946 г.

представляет собой линейную динамическую систему, которая в случае

неустойчивости изменяет свои параметры случайным образом

до тех пор пока не «айдет их устойчивую комбинацию, после

чего параметры не меняются. Управление гомеостата

Чг-"

где Y—-вектор переменных, изменяющихся в пределах: ||Г||<а*

А—матрица параметров, которая изменяется во времени

следующим образом:

при \\У\\-=а

при \\У\\^а9 к '

Мл "'

где S—случайная матрица, ||-||—знак нормы, которая .может

выбираться различным образом. Как легко заметить, (16)

является по сути дела алгоритмом случайного поиска с линейной

тактикой, который для случая оптимизации записывается в

виде (11).

В гомеостате случайность играет роль «всех

возможностей», что гарантирует ему отыскание устойчивой комбинации

параметров. Существенно, чтобы вероятность этого события не

была бы слишком малой. В противном случае алгоритм (3)

естественно неэффективен, как и всякий другой алгоритм

случайного поиска. Это обстоятельство четко определяет требование

к любому стохастическому алгоритму: вероятность удачного

шага не должна быть малой.

Алгоритм УСИЛИТЕЛЯ УМСТВЕННЫХ СПОСОБНОСТЕЙ

Эшби [12] по сути дела повторяет идею гомеостата и так же

эксплуатирует идею случайности как источника всех

возможностей.

И, наконец, важнейшим этапом предистории было

предложение А. А. Красовского использовать случайные модулирующие

сигналы для экстремального регулирования с применением

синхронного детектора.

Таким образом предистория случайного поиска связана с

использованием категории случайности для достижения

позитивных целей, исключая решение задачи оптимизации. С

предложения решать задачи оптимизации применяя элемент

случайности [1] и начинается история случайного поиска.

Эту историю условно можно подразделить на следующие

этапы

1. Эвристический этап

2. Этап рандомизации

3. Этап адаптации

9

ЭВРИСТИЧЕСКИЙ ЭТАП (1960—1970)

Этот этап характеризуется бурным процессом создания

огромного числа различных алгоритмов случайного поиска.

Интенсивность развития этого этапа напоминает прарыв огромной

силы. Трудно сказать, чем был вызван этот прорыв. Скорее

всего он был связан с неожиданным раскрытием больших

возможностей случайного поиска (СП), где обнаружились

факторы различного рода. А именно:

1. факторы простоты;

2. алгоритмические факторы;

3. бионические факторы;

4. психологические факторы.

Рассмотрим коротко основные из них.

ФАКТОРЫ ПРОСТОТЫ определяют несомненное

преимущество случайных процедур поиска по сравнению с

детерминированными:

1) Простота выбора случайного направления в алгоритмах.

2) Простота учета ограничений (нарушение ограничений

классифицируется как неудачный шаг со всеми необходимыми

последствиями — обратный шаг, адаптация длины шага,

адаптация распределения случайного шага и т. д.).

3) Простата учета предистории СП, которая отражается в

вероятностных свойствах случайного шага (самообучение)

[13].

4) Простота эвристического синтеза алгоритмов СП.

(Например при затруднениях следует вводить случайный шаг).

5) Простота программирования СП. (Опыт показывает, что

программы СП всегда оказываются значительно проще и

короче программ регулярных методов поиска).

АЛГОРИТМИЧЕСКИЕ ФАКТОРЫ определяют

качественную специфику алгоритмов случайного поиска:

1. Нечувствительность СП ко всякого рода ловушкам

(например, седловым точкам оптимизируемой функции).

2. Увеличение частоты циклов поиска по сравнению с

регулярными методами (так на п пробных шагов одного цикла

градиентного поиска приходится в среднем два случайных шага,

образующих цикл случайного поиска.).

3. Повышенное быстродействие случайного поиска (так если

регулярные алгоритмы обеспечивают продвижение к цели со

•скоростью обратнопропорциональной ra-раэмерности объекта,

то случайный поиск имеет скорость (1/Уга). Причем

преимущество случайного поиска с ростом размерности

оптимизируемой системы проявляются все в большей степени.

4. Сочетаемость случайного поиска с детерминированными

процедурами. (Так 1на базе случайного поиска могут быть

объединены любые регулярные алгоритмы, например, путем их

вероятностного взвешивания [14]).

30

'5. Иерархическая структура алгоритма случайного поиска,

которая позволяет довольно просто создавать на их базе

пакеты программ оптимизации [15].

БИОНИЧЕСКИЕ ФАКТОРЫ связывают алгоритмы

случайного поиска с биологическими системами управления на

различных уровнях, что позволяет широко пользоваться

аналогиями при синтезе алгоритмов случайного поиска [16]. Укажем на

уровни биологической организации, которые уже дали

возможность синтезировать эффективные алгоритмы случайного поиска:

1. Нейронный уровень, моделирование которого позволило

создать матричный случайный поиск [17], являющийся

стохастическим аналогом известного метода вращающихся

координат Розенброка.

2. Поведенческий уровень, моделирующий поведение животных

в неизвестной среде, дал возможность синтезировать

эффективные методы структурной адаптации случайного поиска

[18].

3. Популяционный уровень, моделирующий процессы эволюции,

эффективно использован для создания большего числа

алгоритмов случайного поиска, среди которых упомянем [19, 20].

4. Психологический уровень связан с моделированием

различных тактик поведения, что породило целый спектр

алгоритмов случайного поиска. Принцип «удовольствия»,

заставляющий повторять успешные действия отражен в алгоритмах

случайного поиска с линейной тактикой [21]. Он моделирует

работу подсознания. Случайный поиск с нелинейной

тактикой, позволяющий исправлять ошибки, моделирует принцип

«неудовольствия» и по сути дела является модификацией

метода проб и ошибок.

Все указанные факторы способствовали интенсивному

эвристическому синтезу алгоритмов случайного поиска и их

применению для решения сложных оптимизационных задач, которые

не удавалось решить другими методами. Эти обстоятельства

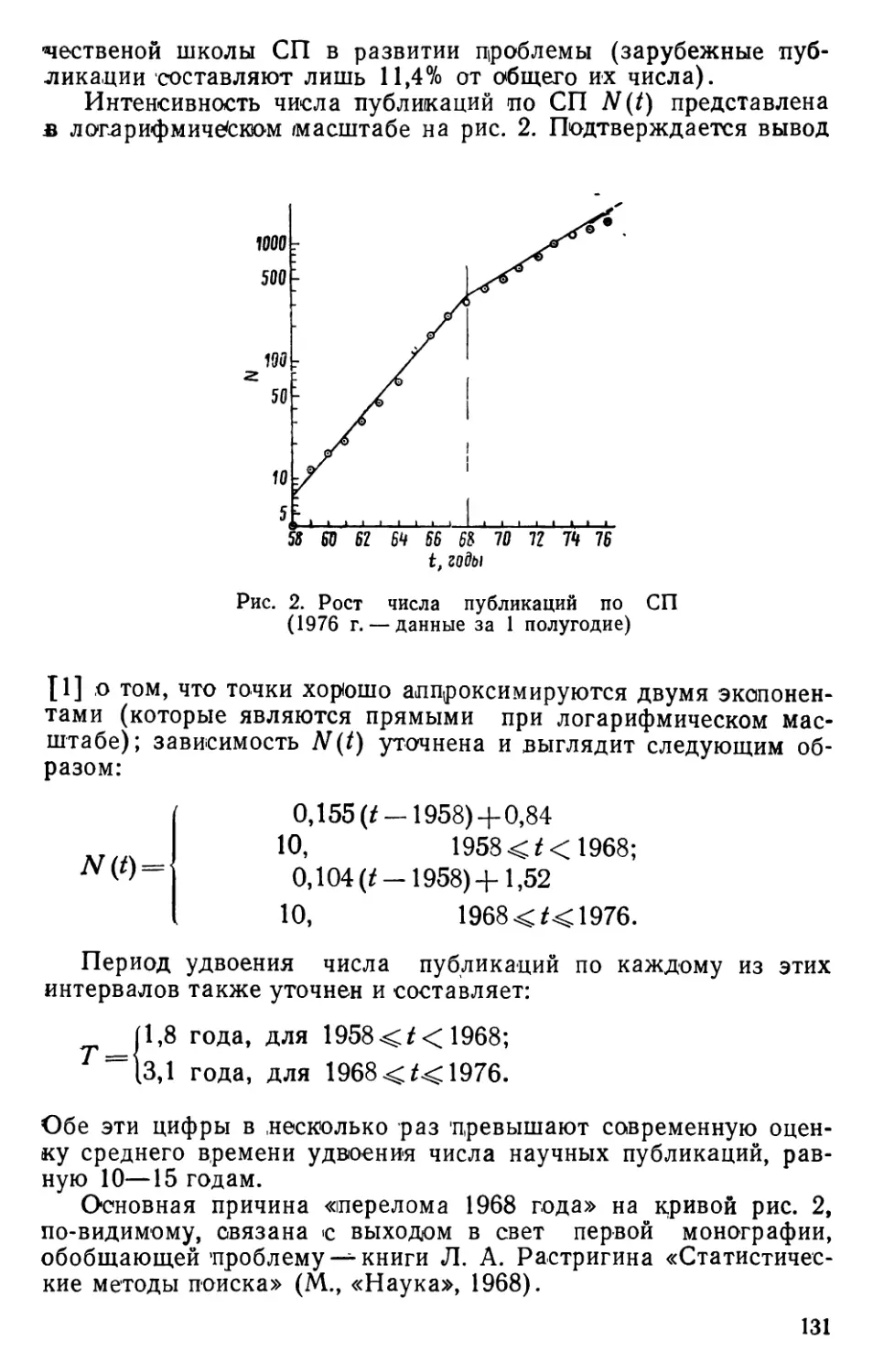

отразились в большем числе публикаций. Показано, что

интенсивность появления работ по случайному поиску в этот период

была максимальной (период удвоения числа публикаций была

равна 1,8 года по сравнению с 10—15 годами по науке в целом

[22]).

Теоретическое осмысливание результатов эвристического

этапа привело к обобщению, связанному с идеей рандомизации,

ла базе которой удалось обобщить эвристические алгоритмы.

ЭТАП РАНДОМИЗАЦИИ (1970—1975)

Идея рандомизации опирается на локальное представление

•минимизируемой функции Q(x) в локально-осредненном виде

123]:

11

где p(.) —весовая функция, заданная аналитически.

Конструкция этого осреднения позволяет определять градиент функции

Q(X) путем прямого дифференцирования:

4Q'(X) = lQ{X)vp(X-Y)dT9

где V —знак градиента. Оценку этого интеграла удобнее всего

делать методом Монте-Карло, т. е. воспользоваться (15):

VQ (x) = lfZ J(Y7) »

где Yt — независимые случайные вектора, генерированные в

соответствии с плотностью распределения p(Y).

Любопытно, что эту оценку можно сделать по одному

эксперименту, т. е. при N = \. Полученную оценку теперь

можно использовать, например, для оптимизации градиентным

методом [24]:

XM = Xk-wQ'{Xk)

как легко заметить, получаем алгоритм случайного поиска, где

случайность вошла при оценке градиента по Монте-Карло. Это

и есть рандомизация, которую в даином случае точнее назвать

«Монтекарлизацией».

В общем случае, взвешивание имеет статистический характер

Q'(X)=SQ(Y)p(Y/X)dY9

где p(Y/X) —условная плотность распределения У в районе X.

Оно получило наименование рандомизированного сглаживания

[25]. Различные виды условного распределения p(Y/X) приводят

к различным алгоритмам поиска. Так нормальное распределение

дает случайный поиск с парными пробами, а равномерное —

метод Кифера-Вольфовица. Как видно, идея рандомизированного

сглаживания явилась эффективным средством объединения

различных алгоритмов поиска. Особенно привлекательна она для

решения дискретных задач, когда множество {X} конечно. В этом

случае удается организовать поиск на базе указанного

рандомизированного сглаживания. В общем случае он оказывается

случайным.

Этап рандомизации очень много дал в понимании места

процессов случайного поиска среди других процессов принятия

решений. Случайный поиск оказался прямым следствием

смешанных стратегий, в то время как регулярные методы порождается

чистыми стратегиями.

12

ЭТАП АДАПТАЦИИ (1975—...)

Этот новый этап развития случайного поиска

характеризуется пониманием, что нельзя априори выбирать адекватный

объекту алгоритм поиска. Более того, для достаточно сложных

объектов такого всюду оптимального алгоритма и не существует.

Алгоритм поиска должен адаптироваться к каждой конкретной

ситуации, сложившейся в объекте в процессе поиска. При этом

процесс адаптации затрагивает как структуру S алгоритма

поиска А, так и его параметры Cs: A = <S, Cs>.

Рассмотрим оба вида адаптации.

1. Параметрическая адаптация (S = const, Cs=var в

алгоритмах случайного поиска обычно затрагивает длину рабочего

шага, объем накопления и распределения случайного шага. При

этом адаптация позволяет увеличить скорость сходимости

процесса случайного поиска, сделать его более надежным и т. д.

2. Структурная адаптация (S-var), S б fi, где й —

множество допустимых структур), связана как с изменением структуры,

так и ее параметров. Здесь возможны два случая [26]:

а) Множество возможных структур конечно: Q= {Si, ..., Sh}.

Эта задача эквивалентна работе с k алгоритмами поиска,

причем адаптация сводится к организации перехода с одного

алгоритма .на другой. Это по сути дела задача о £-руком бандите,

эффективного решения который для случая поиска еще не

найдено, хотя и имеются интересные попытки [27].

б) Множество Q — бесконечно. В этом случае задачу можно

параметризировать.

Очень эффективно в задачах структурной адаптации

применение идей эволюционного моделирования [28] и биологической

эволюции. Последняя уже была использована при адаптации

коллектива оптимизирующих автоматов [19, 29].

Этап адаптации еще не кончился и трудно сказать когда это

произойдет. Ясно одно, что успешность использования

алгоритмов случайного поиска при оптимизации сложных объектов

целиком зависит от его адаптивных свойств.

Работа по созданию эффективных алгоритмов структурной

адаптации только еще началась. Трудность этой задачи никак

нельзя преуменьшать. Для ее решения понадобится привлечь

не только классические методы типа теории статистических

решений, но и новые методы типа искусственного интеллекта.

ПРЕДРАССУДКИ

Широкому распространению случайного поиска часто

препятствуют всякого рода предрассудки, связанные с его

вероятностным характером. Рассмотрим некоторые из них.

1. ПСИХОЛОГИЧЕСКИЙ ПРЕДРАССУДОК связаи с

интуитивным представлением об оптимальности неслучайного

поведения. Он опирается на стремление минимизировать неопре-

13

деленность в процессах принятия решений. Очевидно, что в

достаточно сложных ситуациях снять полностью неопределенность

не удается и решение фактически рандомизируется

неизвестными факторами, влияние которых значительно. Именно поэтому

человек столь неохотно идет на преднамеренную

рандомизацию— ведь она вводит неопределенность, которая и создает

психологический дискомфорт при использовании

рандомизированных правил принятия решения даже при отсутствии

активного противника.

2. ВЕРОЯТНОСТНЫЙ ПРЕДРАССУДОК опирается на

довольно поверхностное соображение о том, что используя

стохастические алгоритмы поиска случайно можно и не решить

поставленную задачу. Действительно, если число шагов поиска

мало и строго ограничено, всегда существует конечная

вероятность того, что задача не будет решена. Но эта вероятность

достаточно мала (порядка 2~N, где N— число шагов поиска) и

легко учитывается при необходимости получения надежных

решений.

3. МАТЕМАТИЧЕСКИЙ ПРЕДРАССУДОК связан с

известным положением теории статистических решений о том, что

минимум функционала потерь достигается на чистых

стратегиях поведения, откуда делается вывод о том, что

детерминированное поведение всегда оптимально, коль скоро задан

критерий потерь. Имеются эффективные попытки построить

детерминированные алгоритмы поиска экстремума, опираясь на

это положение [30]. Естественно, что этот путь приводит к

регулярным алгоритмам.

Однако для того, чтобы воспользоваться этим положением

в задачах оптимизации необходимо иметь полное описание (в

том числе и вероятностное) поведения объекта в зоне, где

принимается решение. Но задачи оптимизации и отличаются тем,

что для их решения нет надобности в полном или

приближенном описании объекта — в процессе поиска может не

создаваться никаких моделей. Это обстоятельство и позволяет считать,

что многошаговый стохастический процесс поиска с точки

зрения простоты его реализации и быстродействия является в

сложных ситуациях более удобной конструкцией, чем любой из

регулярных методов.

ОРГВОПРОСЫ ПРОБЛЕМЫ СЛУЧАЙНОГО ПОИСКА

В конце 1970 г. при Совете по комплексной проблеме

«Кибернетика» была образована комиссия по проблеме случайного

поиска. В эту комиссию вошли представители от различных

научно-исследовательских и учебных организаций страны, где

систематически ведутся исследования по теории и приложениям

случайного поиска. Комиссия организует проведения

симпозиумов и рабочих совещаний, готовит ежегодник «Проблемы слу-

14

чайного поиска» (изд-во «Зинатне» в Риге уже выпустило

5 типографских сборников по 15 авт. листов каждый), издаег

библиографию по проблеме и проблемные записки [31—34].

Ежегодно комиссией проводятся узкие рабочие совещания,

посвященные различным аспектам случайного поиска. Всего

проведено одиннадцать таких совещаний по следующим темам:

ноябрь 1971 (Рига)—«Проблемная записка»

май 1972 (Харьков)—«Проблемная записка»

октябрь 1972 (Цакхадзор, Армения) — «Тестовые функции»

апрель 1973 (Рига) —«Проблемная записка»

октябрь 1973 (Ташкент)—«Случайный поиск в задачах

оптимального проектирования» [35]

март 1974 (Йошкар-Ола) — «Проблема подготовки

кадров» [36]

сентябрь 1974 (Харьков)—«Биологические аспекты

случайного поиска» [37]

октябрь 1975 (Таллин) — «Адаптация в процессах

случайного поиска»

июнь 1976 (Днепропетровск)—«Учет ограничений в

процессах случайного поиска».

декабрь 1976 (Агверан, Армения)—«Тестовые задачи и

методика тестирования алгоритмов СП».

апрель 1977 (Самарканд)—«Распознавание в процессах

поиска».

ЛИТЕРАТУРА

1. Растригин Л. А. Экстремальное регулирование методом случайного

поиска. — «Автоматика и телемеханика», I960, № 9.

2. Растригин Л. А. Сходимость метода случайного поиска при

экстремальном регулировании многсшараметрических систем. — «Автоматика и

телемеханика», ,1963, №11.

3. Юдин Д. Б. Методы качественного анализа сложных систем. П.—

«Изв. АН СССР», «Техническая кибернетика», 1966, № 1.

4. Хасьминский Р. 3. Применение случайного поиска в задачах

оптимизации и опознания. — «Проблемы передачи информации», 1965,

№ 3

5. Николаев Е. Г. Случайный и градиентный выбор направлений спуска в

алгоритмах оптимизации.— В кн.: «Проблемы случайного поиска». М., 1973,

6. Растригин Л. А., Сытенко Л. В. Многоканальные статистические

оптимизаторы. М., «Энергия», 1973.

7. Н икиф op oiB а Н. Е. О выборе оптимальных значений параметров

оптимизаторов. — В кн.: «Проблемы случайного поиска», вып. 3, Рига,

«Зинатне», 1974, стр. 265-^27i2.

8. С о б о ль И. М. Численные методы Монте-Карло. М., «Наука», 1973.

9. Нейман Д ж. Фон, Морге нштерн О. Теория игр и

экономическое поведение. Пер. с англ. М., «Наука», 1970.

10. Растригин Л. А. Статистические методы поиска. М., «Наука», 1968.

11. Эшби У. Росс. Конструкция мозга. М., ИЛ, 1962.

12. Эшби У. Росс. Схема усилителя мыслительных способностей. — В кн.:

«Автоматы». М., ИЛ, 1955.

13. Растригин Л. А. Случайный поиск в задачах оптимизации

многопараметрических систем. Рига, «Зинатне», 1965.

15-

14. Golinski I. Adaptacyny system optymalizacji nieliniowej. Pzace Ins.

Maszyn Matematycznych. 1975, 3.

15. Тарасеико Г. С. Пакет программ безусловной оптимизации. — В кн.:

«Проблемы случайного поиска», вып. 6. Рига, «Зинатне», .1977.

16. «Бионические аспекты случайного поиска» (ло материалам совещания).

«Информационные материалы: кибернетика», АН СССР, -вып. 1 (83), М.,

1975, стр. в—11.

17. Гринченко С. Н., Растригин Л. А. Алгоритмы матричного

случайного поиска. — В кн.: «Проблемы случайного поиска», вып. 5. Рига,

«Зинатне», 1976.

18. Короп В. Ф. Метод случайного спуска. — В кн.: «Проблемы

случайного поиска», вып. б. Рига, «Зинатне», 1976.

19. Нейм арк Ю. И. Автоматная оптимизация. — «Радиофизика», 1972, № 7.

20. Половинкин А. И. Алгоритмы поиска глобального экстремума при

проектировании инженерных конструкций. — «Автоматика и

вычислительная техника», 1970, № 2.

21. Растригин Л. А. Случайный поиск с линейной тактикой. Рига,

«Зинатне», 1971.

22. Гринченко С. Н. Еще раз о динамике публикаций ло случайному

поиску. (Ом. наст. об.).

23. Юдин Д. Б. Методы количественного анализа сложных систем. — П.

«Изв. АН CCGP», «Техническая кибернетика», 1966, № 1.

24. А н т о н о в Е. Г., К а т о в н и к В. Я. Фильтрация и сглаживание в

задачах поиска экстремума функций 'многих переменных. — «Автоматика и

вычислительная техника», 1970, № 6, стр. 53—60.

25. Цыпкин Я. 3. Сглаженные рандомизированные функционалы и.

алгоритмы в теории адаптации и обучения. — «Автоматика и телемеханика»,

1971, Хя 8.

26. Растригин Л. А. Структурная адаптация алгоритмов случайного

поиска.— В кн.: «Проблемы случайного поиска», вып. 5, Рига, «Зинатне»,

1976.

27. Я'блонский А. И. Рандомизированные стратегии в адаптивных

процессах двуальтернативного выбора. — «Автоматика и вычислительная

техника», 1977, № -I.

2-8. Фогель Л., Оуэне А., У о л ш М. Искусственный интелект и

эволюционное моделирование. Пер. с англ. М., «Мир», 1969.

29. My х ни В. И., Н е им а рк Ю. И., Р о н и н Е. И. Автоматная

оптимизация с эволюционной адаптацией. — В <ш.: «Проблемы случайного поиска»,

вып. 2. Рига, «Зинатне», 1973, стр. 83—98.

30. М о цк у с И. Б. Об оптимальных методах поиска экстремума. — В сб.:

«Вопросы кибернетики. Проблемы случайного поиска». М., 1973.

31. «Теория и применение случайного поиска». Библиография. Рига, 1972.

Ш. «Случайный поиск. (Теория и применение)». Библиография. Рига, 1973.

33. «Проблемы случайного поиска». (Проблемная записка). Проект. Рига,

«Зинатне», 1972.

34. Растригин Л. А. Методы случайного поиска. Предварительная

публикация. М. 1977.

35. Растригин Л. А., К а ми лов М. М. Проблемы случайного поиска.

«Информационные материалы: Кибернетика», АН СССР, вып. 3(76). М.,

1974, стр. 3—8.

36. Растригин Л. А., Т р а х тенб е рг <В. С. Рабочее совещание по

случайному поиску ,(лодготовка кадров). — «Информационные материалы:

Кибернетика», АН СССР, вып. 6i(78). M., 1974, стр. 13—14.

37. Растригин Л. А., Короп В. Ф. Биологические аспекты случайного

поиска. (По материалам совещания). — «Информационные материалы:

Кибернетика», АН GGCP, вып. 1 (83). М., 1976, стр. 8—41.

38. Растригин Л. А., Григоренко В. П. Адаптация случайного

поиска. (Материалы научных совещаний). «Информационные материалы:

Кибернетика», АН СССР, Вып. 4(92), М., 1976, стр. 27—30

16

УДК 62-506

ИНФОРМАЦИОННО-СТАТИСТИЧЕСКИЕ

АЛГОРИТМЫ ДЛЯ РЕШЕНИЯ

МНОГОЭКСТРЕМАЛЬНЫХ ЗАДАЧ

Р. Г. Стронгин

(Горький)

В последние годы расширился круг исследований,

посвященных созданию в том или ином смысле оптимальных

алгоритмов для отыскания экстремума функций (см., например, [1—7]).

При таких подходах, берущих начало от работы [8], вместо

внесения извне достаточно определенной схемы алгоритма с

последующим ее изучением, ставится задача выведения

численного метода из некоторой математической постановки,

включающей формальные предположения о классе функций,

содержащем оптимизируемую функцию, и некоторый критерий

эффективности вычислительного процесса, связывающий результаты

вычислений с оценками точности отыскания экстремума (два

обзора, посвященные таким подходам, опубликованы в

[9,10]).

Создание новых методов путем выведения оптимальных

алгоритмов предполагает наличие достаточно удобного

математического аппарата исследования, позволяющего эффективно

строить оценки экстремума по значениям оптимизируемой

функции, вычисленным в некоторых точках области

определения. Эти вопросы успешно решаются для выпуклых и

унимодальных одномерных функций [2, 8]. Однако для

многоэкстремальных функций, удовлетворяющих условию Липшица,

построение таких оценок в общем случае связано с

решением трудных задач теории покрытий [1, 4]. При

вероятностных предположениях об оптимизируемой

многоэкстремальной функции (см., например, [9, 10]) оценки экстремума

определяются через трудновычислимые интегралы по

соответствующим вероятностным мерам. Поэтому для получения

достаточно простых алгоритмов оптимизации прибегают к

приближенному построению покрытий [11], к приближенному

интегрированию [12], к замене оценок экстремума другими более или

менее естественными критериями, допускающими более простое

вычисление (например, [3, 5]). В некоторых случаях [13]

удается построить оптимальный алгоритм, не прибегая к упомянутым

выше упрощениям, однако в описание такого алгоритма входит

параметр (например, константа Липшица), который должен

быть задан априорно. Трудности априорного задания константы

можно гюеадоЯ&гь Приоетнув к уточнению принятой априорной

оценки в ходе решения задачи, но это приводит к тому, что тео-

17

ретическая многошаговая оптимальность алгоритма не

реализуется.

Поэтому выведение оптимального при тех или иных

предположениях метода следует рассматривать лишь как первый шаг,

который целесообразно дополнить изучением построенного

алгоритма оптимизации с традиционных позиций (вопросы

сходимости, скорости сходимости, устойчивости и т. п.). Ниже

описываются некоторые результаты такого «двухшагового»

рассмотрения для алгоритмов многоэкстремальной оптимизации,

построенных в рамках информационно-статистического подхода

(это описание является продолжением обзора [10]).

ВЕРОЯТНОСТНОЕ ОПИСАНИЕ И ОЦЕНКИ ЭКСТРЕМУМА

Для выведения оценок экстремума из вероятностных

представлений о множестве функций, содержащем оптимизируемую

функцию, в [14] предлагается следующая формальная схема.

Рассматривается задача отыскания абсолютного минимума

действительной функции ср на конечной сетке в некоторой

области евклидова пространства. Если занумеровать узлы сетки по

i от 0 до п (т. е. i g/= {0, 1,...,га}), то множество всех

функций отождествимо с п+1—мерным пространством Rn+i,

поскольку любая функция ср определяется /г+1-м значением

ф(0),..., ф(/г). Принимается, что априорные свойства

оптимизируемой функции заданы с помощью непрерывной

положительной плотности /(ф) на пространстве Rn¥i.

Допускается возможность вычисления значений функции в

узлах сетки / (эта операция названа испытанием), причем, в.

формальное рассмотрение входит лишь результат z

(вещественное число) испытания в точке i£lf который описывается как

реализация случайной величины с условной функцией

распределения вероятностей ^(г/ф). При этом рассматривается два

важных случая. В первом случае, эта функция может быть

задана условной положительной плотностью г|>г(2/ф)

распределения вероятностей, что можно интерпретировать как испытания

при наличии случайных помех, ибо повторные реализации

испытания с одним и тем же индексом i с вероятностью 1 будут

различны. Во втором случае,

иг / , ч J0' *<*<')•

т. е. исход г с вероятностью 1 совпадает со значением

функции в точке испытания (испытания без помех).

Вводится понятие дополнительной информации uk о

минимизируемой функции как множество пар

">Л = {(*„ z,):0<s<£},

18

соответствующих индексам iSJ для которых известны

результаты испытаний zs, и определяются априорные т](а) и

апостериорные т; (а/шЛ) вероятности того, что абсолютный минимум

достигается в узле а, т. е. функция <рбФа, где

Фа = {?6/?rt+1 :(v/e/\«) ? (0 > ?'(«)}•

Эти вероятности можно использовать для описания процесса

отыскания экстремума по мере накопления дополнительной

информации (!>А, однако они являются трудновычислимыми,

поскольку определяются через интегралы от плотностей по

областям достаточно сложного вида, например

Фа

и непосредственное использование этих вероятностей приведет

к громоздким методам, включающим операцию численного

интегрирования в пространствах существенно высокой

размерности (порядка числа п узлов сетки /).

Для преодоления вычислительных трудностей предлагается

аппроксимировать вероятности т)(а/©л) более просто

вычислимыми оценками £(а/соО, Для построения которых формально

задается разложение плотности f (cp)

/<?)=2/(*/«ж«). о)

ag/

При этом оценки £(а/о>л) определяются путем интегрирования

по всему пространству, что (в силу простоты области

интегрирования), например, для конкретных типов плотностей /(ср) из

работ [15, 16], позволяет получить аналитические выражения

для Ц*/<»к).

Доказано, что, если плотности /(у/а) зависят от

вещественного параметра с>0 таким образом, что

11m J /c(<p/a)d<p = lf ae/, (2)

то (с вероятностью 1)

11т|5(а/(ол) —ч(а/<ол)| = 0, аб/,

причем, аналогичное утверждение справедливо и для априорных

распределений |(а) и т](а) (т. е. £(а) в (1) можно

интерпретировать как априориое распределение для расположения

экстремума). По существу, условие (2) выделяет некоторый класс

вероятностных описаний, для которых построение

вероятностных оценок абсолютного экстремума удается упростить

(заметим, что для конкретных типов плотностей /(<р) из [15, 16],

представленных разложением (1), условие (2) выполняется).

2*

19

АПРИОРНАЯ ИНФОРМАЦИЯ И СВОЙСТВА АЛГОРИТМОВ

В работах [15—17] построены аналитические выражения

вероятностных оценок £(а/(о&) экстремума для трех классов

одномерных многоэкстремальных задач (минимизация при

вычислениях значений функции без помех; минимизация при

вычислениях с помехами; минимизация без помех при заданном

значении функции в точке абсолютного минимума) и

предложены пошагово-оптимальные алгоритмы, основанные на

использовании этих оценок (см. также [18]). Полученные результаты,

если их рассматривать в плане зависимости алгоритма от

априорных предположений, позволяют делать некоторые

интересные выводы.

Функционирование алгоритмов при минимизации

действительной функции ф(х) в отрезке [а, Ь] вещественной оси можно

описать как последовательное применение отображений

xk=--Gk(x\ ...,**-i; z°, ...,^"1), Л = 1,2

сопоставляющих функции у(х) последовательность точек {xk},

в которых вычисляются значения этой функции (результаты

вычислений обозначены через zk). В [19] показано, что

предельные точки последовательности {xh} для алгоритма из [15]

необходимо локально-оптимальны (если ц>(х) есть Липшицевая

функция). То есть последовательность {xh} не является всюду

плотной в области определения [а, 6], если функция отлична от

константы. Аналогичным свойством обладает

последовательность {xh} для алгоритма из [17], если функция ср(х)

мажорируется некоторым конусом с основанием в точке корня [20].

При минимизации с помехами для алгоритма из [18]

справедливо, что относительное число испытаний, попадающих в

фиксированную точку области определения, достигает максимума

в точке абсолютного минимума и экспоненциально спадает по

мере возрастания значений функции [21].

Для сравнения отметим, что алгоритмы [5, 12] порождают

(случай испытаний без помех) всюду плотные

последовательности в области определения, причем, одно из важных

различий априорных предположений, из которых выведены методы

[15—18], с одной стороны, и методы [5, 12], с другой стороны,

:qctoht в том, что, в первом случае, математические ожидания

первых разностей функции считаются отличными от нуля

(функция «не похожа» на константу), а, во втором случае, они

предполагаются нулевыми (функция — реализация винеровского

процесса). .

Однако, предположение, что математическое ожидание

первых разностей функции отлично от нуля, приводит к тому, что

абсолютное значение этого математического ожидания

становится параметром метода, подлежащим оценке в ходе решения

20

задачи [15, 19], в отличие от алгоритмов [5, 12], которые

также содержат параметры, но оценки этих параметров

несущественны для асимптотической сходимости к минимальному

значению функции. В этом отношении алгоритмы [15, 19] ближе

к методам [1, 3, 11], в которых необходима оценка константы

Липшица.

Исходные предположения, из которых выводится алгоритм

[17], отличаются от модели, использованной при построении

метода [15], по существу, лишь условием, что значение

функции в искомой точке абсолютного минимума задано. Это

дополнительное условие не только приводит к другому

алгоритму, но этот новый алгоритм уже не содержит параметров

исходной модели, подлежащих оценке.

В работах [22, 23] изучается вопрос об условиях, при

которых скорость сходимости алгоритма [15, 19] к глобальному

экстремуму, начиная с некоторого шага становится близкой к

геометрической, т. е. алгоритм автоматически переходит к

уточнению точки минимума со скоростью, характерной для

локальных методов, хотя правила выполнения итераций в

процессе решения задачи остаются неизменными (и для них

справедливо утверждение о сходимости к абсолютному экстремуму).

Установлено, что такая сходимость возможна, если функция в

некоторой окрестности точки х* экстремума имеет вид <р(х)~

~ К\х—х*\у где К—константа Липшица функции. В случае,

когда функция является гладкой в окрестности абсолютного

минимума, почти геометрическая сходимость не достижима.

В [24] эти результаты используются для ускорения сходимости

в других классах задач путем преобразования функции,

обеспечивающего выполнение условий почти геометрической

сходимости.

Показательно, что условие почти геометрической сходимости

имеет вид, подобный предположению о поведении

математического ожидания функции в окрестности минимума,

содержащемуся в модели [15], на которой основан обсуждаемый

алгоритм, т. е. быстрая сходимость возможна тогда, когда

априорные предположения выполняются достаточно полно.

Таким образом, существенные свойства алгоритмов,

построенных как оптимальные методы, определяются характером

некоторых основных предположений, входящих в априорное

описание класса функций, содержащего оптимизируемую

функцию. Это обстоятельство иллюстрирует возможности такого

подхода для построения эффективных алгоритмов.

Вопросы программной реализации рассмотренных выше

методов и сравнение их с другими алгоритмами обсуждаются

в [25].

21

ЛИТЕРАТУРА

1. Сухарев А. Г. Оптимальный поиск экстремума. М., МГУ, 1975.

2. Ч е рн о уськ о Ф. Л. Об оптимальном поиске минимума выпуклых

функций* — «Журнал вычисл. матем. и матем. физ.», 1970, т. 10, № 6,

стр, 1355—1366.

3. Данилин Ю. М. Оценка эффективности одного алгоритма отыскания

абсолютного минимума. — «Журнал вычисл. матем. и матем. физ.», 1971,

т. 11, Ко 4, стр. 1026^—И0Э1.

4. Иванов В. iB, Об оптимальных алгоритмах минимизации функций

некоторый, классов.— «Кибернетика», 19712^ IN? 4, стр, 3(1—94.

5. К u s h n е г. Н. A new Method of Locating the Maximum point of an

Arbitrary Multipeak Curve in the Presence of Noise. — Trans. ASME, Ser. D,

J. Basic Eng., 1964, v. 86, № 1, pp. 97—106.

6. Неймарк Ю. <И., Стронгин Р. Г. Информационный подход к

задаче поиска экстремума функции. — «Изв. АН СССР», «Техническая

кибернетика»», 1$66, № 1, стр. 17—26.

7. М оцк у с И. -Б. О байесовых методах поиска экстремума. —

«Автоматика и вычислительная техника», 19712, № 3, стр. 53—62.

8. К i e f е г J. Sequential Minimax Search for a Maximum. — «Proc. Amer.

Math. Soc.», 1953, v. 4, № 3, pp. 50i2->506.

9. Mo цк,у с И. Б. Об оптимальных методах поиска экстремума. —

«Вопросы кибернетики. Проблемы случайного поиска». Мм 1973/

10. Стронгин Р. Г. 'Информационно-статистический подход к построению

алгоритмов поиска глобального экстремума. — «Вопросы кибернетики.

Проблемы случайного поиска». М., .1973.

11. Евтушенко Ю. Г. Численный метод поиска глобального экстремума

функций (перебор на неравномерной сетке). — «Журнал .вычисл. матем. и

матем. физ.», 1971, т. 11, № 6, стр. '1390—1403.

12. Жилинскас А. Г. Одношаговый байесовский метод поиска экстремума

функций одной переменной. — «Кибернетика», 1975, № 1, стр. 139—144.

13. Сухарев А. Г. Наилучшие стратегии последовательного поиска

экстремума.— «Журнал вычисл. матем. и матем. физ.», 1972, т. 12, № 1,

стр. 35—50.

14. Стронгин Р. Г. О вероятностной оценке экстремума в

многоэкстремальных задачах. — В кн.: «Проблемы случайного поиска», вып. 5.

Рига, «Зинатне», 1976.

15.. С тр он г и н Р. Т\ Вы'бор испытаний и условие остановки в одномерном

глобальном поиске. — «Изв. высш. учебн. завед.», «Радиофизика», 1971,

т. /14, № 3, стр. 432—440.

16. Стронгин Р. Г. Информанионный метод многоэкстремальной

минимизации при измерениях с помехами. — «Изв. .АН СССР», «Техническая

кибернетика», 1969, № 6, стр. 118—126.

17. Стронгин Р. Г. Вероятностный подход к задаче определения корня

функции. — «Журнал вычисл. матем. и матем. физ.», 1972, т. 12, № 1,

стр. 3—13.

18. Стр он гин Р. Г. Алгоритмы для поиска абсолютного минимума. — В кн.:

«Задачи статистической оптимизации». Рига, «Зинатне», 1971.

19. Стронгин Р. Г. О сходимости одного алгоритма поиска глобального

экстремума. — «Изв. АН СССР», «Техническая кибернетика», 1973, №4,

стр. 10—16.

20. Стронгин Р. Г. Информационно-статистический метод решения-систем

нелинейных уравнений. — В кн.: «(Проблемы случайного поиска», вып. 4.

Рига, сЗинатне», '1975.

21. Стронгин Р. Г. Оценка сходимости помехоустойчивого алгоритма

глобального поиска. — В кн.: «Проблемы случайного поиска», вып. 6. Рига,

«Зинатне», «1977 (в печати).

22. Стронгин Р. Г. Монотонные алгоритмы многоэкстремальной олтими*

22

зации. 11-й Всесоюзный семи.нар «Численные иметоды нелинейного праграм-

мирова/ния». Харьков, 1976.

23. Стронгин Р. Г. О монотонной сходимости алгоритма глобального

поиска. — В кн. «Динамика систем», вып. 4. «Горький, Изд. ГГУ,

1976.

24. С Tip о нгин Р. Г. Простой алгоритм поиска глобального экстремума

функций .нескольких переменных и его использование в задаче

аппроксимации функций.—«сИзв. высш. учебн. завад.», «Радиофизика», 1972, т. 15,

№ 7, стр. 1077—«1084.

25. Г р и ш а г и н В. А., Стронгин Р. Г. Алгоритмы и программы

глобального поиска. — В кн.: «Автоматизированное оптимальное проектирование

инженерных объектов и технологических (Процессов». Горький, Изд. ГГУ,

J 974.

УДК 62-506

ОПТИМИЗИРУЮЩИЕ СЛУЧАЙНЫЕ ПРОЦЕССА

С НЕПРЕРЫВНЫМ ВРЕМЕНАМ

КАК ИДЕАЛЬНЫЙ МОДЕЛИ АЛГОРИТМОВ

СТОХАСТИЧЕСКОЙ ОПТИМИЗАЦИИ

Л. Л. Мороз, А. П. Коростелев

(Москва)

1. Введение. Под алгоритмами стохастической оптимизации

в настоящей работе мы понимаем практически реализуемые

дискретные алгоритмы, осуществляющие поиск экстремума той

или иной функции цели, и работающие в обстановке случайных

помех. Ниже, в примерах, мы рассматриваем рекуррентные

стохастические алгоритмы, представляющие собой цепи Маркова.

Однако, общие рассуждения, относящиеся к полезности

изучения процессов с непрерывным временем, могут быть отнесены

к более широкому классу дискретных процедур, например — к

дискретным процедурам «с памятью» (или с «накоплением»).

Огромное количество практически реализуемых алгоритмов

приводит к необходимости внесения некоторого

упорядочивания. Постановка такой задачи и частичное ее разрешение

содержатся для не стохастических алгоритмов в монографии

Э. Полака [1]'. Следуя этой работе, мы так же вводим понятие

принципиального алгоритма (ПА), однако вкладываем в это

понятие иное содержание.

ПА мы будем называть случайный процесс с непрерывным

временем, траектории которого осуществляют оптимизацию

заданной функций цели, и который в некотором смысле является

идеальной моделью для изучения определенных свойств

алгоритмов стохастической оптимизации. Сам ПА может быть

практически принципиально не реализуемым (например, — это

диффузионный процесс, траектории которого имеют бесконечную

скорость).

23

Приведенное определение ПА не претендует на формальную

полноту. Ниже мы попытаемся раскрыть его содержание на

ряде примеров.

Смысл введения ПА состоит в следующем: очень часто один

и тот же ПА допускает различную практическую реализацию в

виде алгоритмов стохастической оптимизации. Тем самым ПА

вводит упорядочивание в практически реализуемые алгоритмы:

алгоритмы, приближающие один и тот же ПА, попадают в один

класс.

Здесь сразу же необходимо отметить наличие

определенного субъективного момента в выборе ПА, однако польза

подобного подхода кажется несомненной.

Отметим, что под оптимизирующими процессами с

непрерывным временем мы понимаем не процессы оптимизации,

допускающие непрерывную во времени реализацию, например, в

аналоговых устройствах. Подобные процессы сами требуют

значительных сил на изучение их поведения [2, 3].

Мы вводим ПА, как некоторые более простые для

изучения, а часто — просто хорошо изученные, случайные процессы,

такие, например, как решения стохастических

дифференциальных уравнений [4, 5, 6].

Из известных авторам работ, в которых в той или иной

форме предлагается рассматривать идеальные модели отметим

здесь работу Л. Льюнга [7], где указано на необходимость

изучения обыкновенных дифференциальных уравнений,

описывающих поведение «незашумленных» траекторий, и работу Дере-

вицкого и Фрадкова [8], где содержится та же идея, а, кроме

того, изучаются и «зашумленные» траектории, представляющие

собой решение стохастического уравнения Ито.

Авторы также развивали этот подход на ряде конкретных

примеров [9, 10, И].

2. Ограничиваясь рекуррентными алгоритмами

стохастической оптимизации, можно определить ПА как марковские

процессы с непрерывным временем. В числе основных преимуществ

исследования ПА можно указать следующие:

— существует достаточно развитая теория подобных

процессов;

— существует мощный математический аппарат для

изучения этих процессов (стохастические дифференциальные

уравнения, краевые задачи, интегральные уравнения и т. д.);

— развитие существующего математического аппарата

позволяет, как правило, разрешить те специфические

теоретические вопросы, которые возникают при рассмотрении

марковских процессов в качестве процессов оптимизации;

— возможность получения качественных результатов,

поскольку поведение оптимизирующих процессов с непрерывным

временем лучше поддается эвристическому исследованию,

нежели поведение более сложных дискретных алгоритмов;

24

— возможность получения количественных оценок для ПАГ

(например, — дисперсий, времен достижения окрестности

экстремума и т. д.), которые затем могут быть использованы при

практических вычислениях.

3. В настоящем разделе мы проиллюстрируем предыдущие

рассуждения на ряде конкретных примеров.

Пример 1. Условия сходимости.

Рассмотрим дискретный и непрерывный алгоритмы

стохастической аппроксимации (Кифера—Вольфовица) [6]

х^-хл=±[У£*^^ (1)

dX {t)=^- Г/(*(0 + г(0)-/(Х(0--с(0) +

+o(t,X(t))wt]dt, (2>

где ап, сп\ a(t), c(t)— соответственно последовательности и

функции рабочих и пробных шагов; /(л:) —функция цели; Ел —

дискретный «шум» (последовательность независимых случайных

величин) Mln=0; Dtn=\\ wt—«белый шум»; сл(л:), o(t,x) —

интенсивности «шумов».

При некоторых условиях на функции f(x) и a(t, х) для

сходимости с вероятностью 1 процедур (1) и (2) AOCTaT04HOv

выполнения соответственно следующих условий [6J:

2ая=оо; ^j-f< + °o; 2аЛ< + °°;

л=1 *ШЩ сп п=\

(3)

\a{t)dt= + oo; \^Ldt< + oo; $ a(t).C(t)dt< + оо. (4>

о о к ' о

Исторически подобные достаточные условия сходимости

первыми были изучены для дискретных процедур [12]. Однако,

если бы были известны условия (4), то они по аналогии

наводили бы на мысль о справедливости условий (3). Подобные

рассуждения оказались полезными при решении следующей

задачи: найти условия необходимые и достаточные для

сходимости процедур (1) и (2). При определенных предположениях

на функции в правых частях (1) и (2) эти условия выглядят так:

оо оо

2#rt=00> для любого Х>0 2 ал-ехр{ —Хс^/ал}< оо; (5)

ОО

§ a(t)dt = оо, для любого Х>0

о

? (6)

\ a(t).exp {-\-c2(t)/a(t)} < оо.

о

25

Справедливость условий (6) срйвййтёлЬно лёгкб Мря^т быть

получка Ш осн№аний результатов раббт [13— 14]\ Услоййе

<5) быйю выМсано1 по аналогии. Оно оказалось спрайёД^йй^Гм,

но доказательство его существенно сложнее.

Пример 2. AcrfMhTOtHqecrtoe поведение процедуры Роббин-

са —Монро:

*яц - ~*п = \ {R (хп) + о (хп) • 6Я); (7)

dX(t)=±(R(X(t)) + c(X(t))wt)dt, (8)

где R(x) = B-(x — xQ) + 0(\x — xQ\); В — пбСтояннагя матрица.

При некоторых условиях случайные векторы уп = \Пь хп и

y(t) = Yt X(t) имеет асимптотически нормальные

распределения: Этот факт в непрерывном случае доказать Шюго npoiiie,

чем й дискретном (см. главу 6 книги [6]).

В непрерывном случае можно изучить асимптотическое

поведение процедур при другой зависимости рабочего Шага ot

времени (см. [15]). Так для процедуры

dX{t) = ±{-s\gnX{t) + wt\di

случайная величина Y(t) = ty -X (t) имеет асимптотически

«двухстороннее» показательное распределение. Оказывается, что для

соответствующей дискретной процедуры

*п+1 - *п = -г: I - Sign Xn + У

случайная величина уп = п>у-хп имеет также невырожденное

предельное распределение, но уже зависящее от характера

«шума» %п.

Пример 3. Процедуры оптимизации в условиях ограничений.

Отражение по направлению внутренней нормали. Пусть D —

область с кусочно гладкой границей. Рассмотрим два процесса

оптимизации с непрерывным временем:

dXt = -([S7f{Xt) + Wt]dt; (9)

dXt = [a(t)4ftft) + ^o{t, Xt)wt]dt (10)

с отражением по направлению внутренней нормали к границе Г

области D. Здесь т>0 малый параметр; wt — винеровский

процесс; f(x) o(t,x); a(t), c(t) — те же функции, что и в (2).

Можно доказать, что при малых т с вероятностью близкой

к 1 траектории (9) следуют вдоль траектории системы

dYt=4f<Xt)dt, (И)

.26

тде

~f(, b(v/W' xeD;

' * '~~ (проекции 4f{x) на границу Г при х$Т,

и процесс (9) имеет инвариантную меру ц (х) (стационарное при

i->oo распределение), определяемую формулой

1х (х) = const -exp {^~^}, (12)

которая при уг+Q является б-образной мерой, сосредоточенной

в точке глобального максимума (если он единственный)

функции f(x).

Для процесса (10) можно доказать сходимость его к точке

максимума функции f(x) в D либо к точке условного

максимума /(х).на границе Г при выполнении условий типа (6).

При построении дискретной процедуры оптимизации в

условиях ограничений в зависимости от целей, стоящих перед

исследователем, можно использовать в качестве идеальных моделей

как (9), так и (10). В первом случае дискретная процедура —

процедура с малым> неубывающим во времени рабочим шагом у:

*1ил —*n = T-lV/Si) + T«[, (13)

аппроксимирующая на границе Г отражение по направлению

внутренней нормали. Аппроксимацию отражения можно

производить различными способами, например, как в [11]. От

процедуры (13) естественно ожидать приближения на конечных

временах системы (11) и- наличия стационарного распределения,

которое, вообще говоря, отлично от (12) при разных «шумах»

в (13), но должно «сосредотачиваться» в точках максимума /(*).

Непрерывная модель (10) приводит при том или ином

приближении нормального отражения к процедуре стохастической

аппроксимации типа (1), но действующей в условиях

ограничений. По аналогии условия сходимости должны иметь вид (5).

Пример 4. Процедуры оптимизации в условиях ограничений.

Отражение по направлению поля, вырождающегося в

касательное. Пусть на границе гладкой области D определено поле 1(х)9

вырождающееся в касательное и терпящее разрыв в отдельных

точках. Особую точку О касания назовем притягивающей, если,

в некоторой окрестности О поле 1(х) направлено к этой точке.

Пусть f(x) —дифференцируемая функция цели. Пусть поле 1(х)

сконструировано так, что его притягивающие точки совпадают

с точками условного максимума f(x) на границе Г. Рассмотрим

два процесса оптимизации с непрерывным временем:

dXt = b(JCt)dt+c(Xt)dwt, (14)

где о(х)от (л:) — невырожденная матрица диффузии; Ь (^ —

произвольное поле в области D\

2?

dXt = a(t)v/(Xt)dt+^o(t, Xt)dwt (15)

с отражением по направлению поля 1(х) на границе Г [16].

Процесс (14)—однородный по времени, а в (15) входят

функции a(t) и c(t), стремящиеся к нулю при t-+oo.

Процесс (14) сходится с вероятностью 1 к одной из

притягивающих точек на границе за конечное в среднем время [16].

Процесс (15) сходится либо к одной из притягивающих точек

на границе, либо к точке максимума f(x) в области D. Эти

факты объясняются следующим образом: вырождающееся в

касательное поле обладает свойством «подталкивать»

поисковую траекторию к особой точке.

Для нахождения максимума f(x), который apriori находится

на границе можно использовать дискретный аналог процедуры

(14), аппроксимируя отражение по направлению поля 1(х). От

дискретной процедуры естественно ожидать сходимость (в

определенном смысле) за конечное в среднем число шагов.

Дискретный аналог процедуры (15) предназначен для нахождения

максимума f(x) вне зависимости от его положения.

Пример 5. Асимптотика стохастических процедур

оптимизации в условиях ограничений.

Рассмотрим дискретную процедуру

*rt+i —~Хп = <*п [ V/ (хп) + у, (16>

если xn£D — заданная область с гладкой границей Г. Если же

лся+1(ЕО, то осуществляем «зеркальное» отражение относительна

границы Г. Идеальной моделью процедуры (16) будет процесс

с нормальным отражением от границы Г, удовлетворяющий

уравнению

dXt = a(t).[S7f(Xt)dt + dwt]. (17>

Если О —точка условного максимума f(x) на границе Г, то

скорость сходимости (17) в касательном направлении a~lt2(t),

а в направлении нормали — аг1 (t), если только || V/(0) |j =^0-

Та же скорость сходимости имеет место и для процедуры (16),.

(см. пример 3).

4. В связи с изложенным выше авторам кажется

целесообразным следующий подход к конструированию алгоритмов

стохастической оптимизации:

4.1. Строится (если это возможно!) идеальная модель (ПА)

в виде оптимизирующего случайного процесса с непрерывным-,

временем, обладающего определенными требуемыми

свойствами.

4.2. Идеальная модель исследуется методами теории

случайных процессов.

4.3. Практически реализуемые алгоритмы стохастической оп-

28

тимизации конструируются как дискретные алгоритмы,

сохраняющие в определенном смысле требуемые свойства ПА.

4.4. Исследуются особенности поведения сконструированных

дискретных алгоритмов по сравнению с поведением ПА.

Следует указать, что построение ПА возможно,

по-видимому, далеко не всегда. Например, в предложенную схему не

вписываются задачи дискретного программирования.

5. Вопросы синтеза дискретных алгоритмов.

При использовании предлагаемого подхода синтез

алгоритмов, обладающих желаемыми свойствами, можно разбить на

2 этапа: структурный и параметрический. Структурный

синтез осуществляется на уровне выбора ПА. В

зависимости от исходной информации определяется класс

оптимизирующих случайных процессов с непрерывным временем,

которые могут выступать в качестве ПА в конкретной задаче.

Параметрический синтез состоит в выборе параметров

дискретного алгоритма с тем, чтобы приближались желаемые свойства

ПА (поведение внутри области' допустимого изменения

параметров или на границе, асимптотическое поведение или

поведение на конечном отрезке времени и т. д.).

Пример 6. Ставится задача найти глобальный максимум f(x)

в области D в обстановке случайных помех. Априорная

информация: существуют два близких по величине локальных

максимума: один — в подобласти D\^D, другой — на участке Г

границы dD\ причем наибольший из них является глобальным

максимумом. Задано ограничение на число возможных

«замеров» функции f(x).

Структурный синтез. Выбираем дискретный аналог

алгоритма (15), который предназначен для поиска максимума как

внутри области, так и на границе.

Параметрический синтез. Алгоритм работает дважды: с

начальной точкой из Z?! и Г. Закон убывания рабочих и пробных

шагов и число шагов осуществляем так, чтобы каждый из

максимумов был определен с одной и той же точностью,

диктуемой ограничениями на число проводимых «замеров» функции

f(x). При этом пользуемся результатами об асимптотическом

поведении алгоритма в окрестности каждого из максимумов.

ЛИТЕРАТУРА

1. Пола-к Э. Численные методы оптимизации. Единый -подход. М., «Мир»,

1974.

2. D г i m 1 М., Nedoma I. Stochastic Approximation for Continuous

Random Processes. — «Trans. II Prague Conf. on Inform. Theory, Stat. Decision

Funct. and Random Proc», Prague, 1960, pp. 145—158.

3. S a k г i s о n D. I. A Continuous Kiefer-Wolfowitz Procedure for Random

Processes. — «Ann. Math. Stat.», 1964, 35, pp. 590—599.

4. Кушнер Г. Дж. Стохастическая устойчивость и управление. М., «Мир»,

1969.

29

5. Хасьминский Р. 3. Устойчивость дифференциальных уравнений при«

случайных возмущениях их параметров. М., «Наука», 1969.

6. Невельсон М. Б., Хась минский Р. 3. Стохастическая

аппроксимация и «рекуррентное оценивание. М., «Наука», 1972.

7. L j u n g L. Convergence of Recursive Stochastic Algorithms, Report 7403. —

«Division of Automatic Control», Lund Inst, of Technology, 11974.

8. Деревицкий Д. П., Фрадков А. Л. Две модели для анализа

динамики алгоритмов адаптации. — «Автоматика и телемеханика», 1974, № 1,.

стр. 67—75.

9. М о р о з П. А. О связи диффузионных процессов с отражением с

процедурами стохастической оптимизации. — В об.: «Автоматизированные

системы управления в нефтяной и газовой промышленности». М., «Недра»,»

1976, 11в—»1<23.

10. Мороз П. А., Ко росте лев А. П. О нахождении условного

экстремума методом случайного -поиска. — «Автоматика и вычислительная тех- -

ника», 1971, № 2, стр. 36—40.

11. Мороз П. А., Кор ос теле в А. Л. О /принципе конструирования

процедур стохастической оптимизации в условиях ограничений. — «Автомата- -

ка и .вычислительная техника», Ш76, № 3.

12. В 1 u m I. R. Approximation method which converge with probability one,

Ann. Math. Stat. 25, 2 1(1954), 382-^386.

13. Вент цель А. Д., Фрейд л ин М. И. О малых случайных

возмущениях динамических систем. — «Успехи математических наук», 1970, т. 25,.

вып. 1, стр. 3—55.

14. Вентцель А. Д. Грубые предельные теоремы о больших уклонениях

для марковских случайных процессов I. — «Теория вероятности и ее

применение», 1976, т. 21, вып. 2, стр. 235—26(2.

15. Хась-минский Р. 3. О поведении процессов стохастической

аппроксимации для больших значений времени. — «Проблемы передачи

информации», 1973, т. 8, вып. 1.

16. Малютов М. Б. О краевой задаче Пуанкаре. — «Трзнш Московского-

матем. общества, 1969, т. 20, стр. 173—204.

УДК 62-506

О МЕТОДАХ ПОИСКА ЭКСТРЕМУМА

С НАИМЕНЬШЕЙ СРЕДНЕЙ ПОГРЕШНОСТЬЮ

Я. Б. Моцкус

(Вильнюс)

1. ВВЕДЕНИЕ

Многие известные методы поиска точки минимума

унимодальных функций многих переменных основаны на идее

квадратичной аппроксимации.

Многоэкстремальные задачи нередко оказываются столь

сложными, что на минимизируемую функцию целесообразно

смотреть как на реализацию некоторой случайной функции.

В таком случае оптимальным методом можно назвать такой

метод поиска, который минимизирует среднее отклонение от

искомой точки.

30

2. ФОРМУЛИРОВКА ЗАДАЧИ

Пусть минимизируемая функция f(x, со) является

реализацией некоторой случайной функции ср(х), где хвАаЯт9 со 6Й-

Здесь со — элементарное событие — неизвестный нам индекс

реализации.

Предположим, что статистические характеристики

случайной функции ф(#) заданы системой конечномерных функций

распределения

FXlt...,xn(yu ...,Уп) = Р{^/(хь <»)<yh i = l л},

л=1,2,..., (1).

где Р — априорная вероятность события

(»:/(Л|,»)<й, * = 1,...,я}. (1а)*

Наблюдением назовем вычисление значения функции в

точке xt. Результаты п наблюдений представим в виде вектора

««^(TW Т(4 хи...,хп) (2)

Решающим правилом назовем измеримую вектор-функцию

d = (du .. .,dn), компоненты которой определяют зависимость

Л+ 1-ого наблюдения от вектора zn, т. е.

хп+г = dn (zn) = *я+1 (d, со). (3)

Оптимальным или байесовым методом поиска назовем такое

решающее правило rf°, которое минимизирует среднее

отклонение от минимума, т. е. соответствует услорию

minAf[{(p(^+1)-cp0}, (4).

а

где <? (XN+i)=f($N+i (d, <*>), со) — значение функции / в точке

окончательного рещения Xn+u а 9о = 1п1/(х*®У- При доста-

х£А

точно общих предположениях [1], [2[, [3] рещение задачи (4)

существует и может быть получено из системы рекуррентных

уравнений

uN(zN)=min M{<?(x)/zN}y

х£А

ип_.х(гп_х)=т\пМ{ип(?п_.и cp(4 *)IZn-x) n=N,...,2 (5)

х£А

и0=т\пМиг(<?(х)ух),

х£А

где М {vXxDIzn} — условное математическое ожидание

случайной величины <?(х) относительно случайного вектора гдг.

Уравнения (5) остаются без изменений, и в случае «зашум-

ленных измерений» когда при фиксированном х&А наблюдаем

сумму

♦ C*i)—?(*i)+4i.

31

где Y]i — «шум» — независимые случайные величины с нулевым

математическим ожиданием и конечной дисперсией. При этих

условиях случайный вектор zn имеет вид

гп = (У(хг), ...,<К*Я), хи .-,хп), я = 1, ...,ЛГ

3. ИЛЛЮСТРАТИВНЫЙ ПРИМЕР

? (*)=/(*, <о) = (Х — со)2,

Априорная плотность вероятности —

/7((о) = ^-, если coge.

Из уравнений (5) следует, что оптимальная точка первого

наблюдения —

хг= ±1,

а точка оптимального решения —

( 1—Кт(1), еслил:1 = 1,

•*2~~(-1+}Лр(-1), если jc1= —1.

4. УСЛОВИЯ СХОДИМОСТИ

Согласно условию (4), байесовый метод поиска зависит от

того, каким будет задано априорное распределение

вероятностей Р. Поэтому для обоснования байесовых методов поиска

экстремума необходимо выяснить вопрос, каким требованиям

должно удовлетворять априорное распределение Р, чтобы

решающее правило d°, определяемое уравнениями (5), при

большом N обеспечило сходимость к минимуму любой непрерывной

функции. Ответ дает теорема I.

Перед тем как сформулировать эту теорему, введем

следующие обозначения:

гп = гя(х,<»,(1)=*т1п\\х — Х1\\ = \\х — хцХ)\\9

ККп

-А(сп) = {лг:11тгя = 5,5>0Э хвА],

П-*-оо

В(и) = {х:1\тгп = 0, х£А},

П-*-оо

Fx (У1гп) — функция условного распределения случайной

величины <р(«*) относительного случайного вектора zn.

f /,,\_- I0» если У<У*>

г»\У) — \\9 если у>ул,

32

Теорема 1. Пусть: 1) Л —компакт; 2) /(л:, со) —непрерывные

функции х; 3) условные математические ожидания в

уравнениях (5) непрерывны 4) существуют априорные плотности

вероятностей РХ19...,хп(Уи ••-, Уп)>0\ 5) VxgZJ (со), 8>0 Я/г5, что

\Fx(y\*n)-F*(y)\<b n>n6

и

Fxi(y/zn)—F(ii(y)=Oy / = 1,..., п;

6) Vjc'gA (со), у£% 38 = 8 {х'у) > 0 независимо от /г, что

Fx(y/zn)>b; 7) функция и (со) = sup |Un(zn)\ равномерно

интегрируема по Fx (ylzn)\ 8) М | ср01< оо, тогда

Нт|/(л:лг+1(^, со), со) —тт/(л:, со)|=0, VcogS,

TV—оо jr£4

где d°— решающее правило, соответствующее системе (5),

когда условные математические ожидания для всех zn

вычисляются с помощью формулы условных плотностей.

Теорема I означает, что при соблюдении условий 1)—8)

последовательность решающих правил, соответствующих

уравнению (5), гарантирует сходимость к минимуму для любой

непрерывной функции при N-+oo. При конечном N байесовый

метод d° обеспечивает наименьшее среднее отклонение от

минимума.

Большинство условий теоремы I легко проверяется,

несколько сложнее проверка условия 6); для марковских процессов

условие 6) выполняется.

5. ОДНОШАГОВЫЕ МЕТОДЫ

Решить нелинейные уравнения многомерного динамического

программирования (5) трудно. Поэтому в практических

вычислениях в основном применяются различные приближенные

подходы. Одним из них является одношаговый метод, когда на

каждом шаге предполагается, что следующее наблюдение будет

последним, т. е.

Яя_1 (*„-.!) = т1пЛ1 {«! («я-ь •*> ?(*)/a«_i} л=1» — • N,

х£А

где

u*n(zn) = mlnM [<f(x)lzn). (6)

х£А

Оказывается, что в условиях теоремы I решающее правило,

соответствующее условиям (6), также обеспечивает сходимость

к минимуму любой непрерывной функции.

3—6065

33

6. СЛУЧАЙ ОГРАНИЧЕННОЙ ПАМЯТИ

Другим способом приближенного решения уравнений (5)

является ограничение «памяти». Предполагается, что можно

«запомнить» результаты не более No наблюдений [1]. Случай,,

когда Л/о=1, рассмотрен в [53. В этом случае-байесовбе

решающее правило оказывается близким к одному из наиболее

известных вариантов случайного поиска [6]: следующее

наблюдение должно быть расположено на сфере, центром которой

является точка наиболее успешного наблюдения. Отличие бай-

есового метода в случае рассмотренном в [5], от методов

случайного поиска [6] заключается в том, что радиус сферы

нефиксируется заранее, а вычисляется по результатам

наблюдений согласно рекурентным уравнениям. В случае ограниченной

памяти сходимость к минимуму не гарантируется.

7. ВЫБОР АПРИОРНОЙ ФУНКЦИИ РАСПРЕДЕЛЕНИЯ

Априорное вероятностное пространство (Р, a, Q), где Р —

вероятностная мера на сг-алгебре, сг порожденной

цилиндрическими множествами (2), Q — множество подлежащих

рассмотрению функций заданных на Лс=/?п, по существу является

некоторой статистической моделью рассматриваемой

оптимизационной задачи. Эта модель определяет не только набор

возможных функций, но и вероятность их появления. Следовательно

удачный выбор функции априорного распределения (1)

является тем единственным рычагом, при помощи которого байесовые

методы поиска можно приспосабливать к требованиям того или

иного класса оптимизационных задач.

В соответствии с условием 2 теоремы 1 ограничимся

рассмотрением непрерывных функций. Для простоты будем считать,

что они заданы на /^-мерном кубе [ — 1, 1]. Одним из наиболее

слабых, но сохраняющих непрерывность реализаций требований

к функциям априорного распределения является независимость,

приращений Де1,..., е (х1,..., хт), определяемых рекуррентными,

формулами

Де.еДл:1,..., Хт) = Ьв%, (х\ *2 + s2,..., Хт) — ДеЛ*1,..., Хт)>

V.-.e^*1,..., ^) = Д81,...,ет_1(х1,..., *» + ej|l)-

-Де.......^*1,..., #"), (7)

где аг'6 I — 1, 1], £*>0, / = 1,..., т.

Легко видеть, что приращения, заданные формулами (7)„

являются разностными аналогами m-тых производных.

34

Известно [10], что из непрерывности реализаций и

независимости приращений следует, что конечномерные функции

распределения обязаны быть гауссовыми. Другим естественным

условием является требование стационарности, т. е.

однородности (независимость от сдвигов).

Нетрудно убедиться, что все указанные требования

(непрерывность, независимость приращений * и стационарность

соблюдаются для гауссового поля, с математическим ожидани-

ем [I и ковариационной функцией

/r,A_(,n(i--!^r*1).

/ = 1

(8)

где *}, л^6[—1, 1].

Для лучшего понимания этого случайного поля

ковариационную функцию (8) представим в виде

где xt, /=1,..., 2т есть координаты вершин куба [—1, 1],

т

KxfyM-flLiVti (Ю)

fining — xlr xlk — *{), если xl} > x\ xlk>x\

^г_"|тах(л^ —x\, xlk — xj), если xl. <x\ x\ <x[- I11'

Следовательно в случае jx = 0 на случайное поле,

определяемое условием (8), можно смотреть как на сумму независимых

винеровских полей с началами координат в вершинах куба

[—1, 1]. В одномерном случае эта сумма двух независимых

винеровских процессов; начало первого из них в точке —1, а

начало второго — в точке +1, причем второй процесс протекает в

обратном направлении.

Так можно определять функции априорного распределения

с точностью до нескольких параметров, в данном случае это

всего лишь два параметра \i и а2.

Для статистической оценки этих параметров можно провести

некоторое число М дополнительных наблюдений. Координаты

этих наблюдений удобно выбрать по закону равной вероятности

на А. Оценки для \х и а2 найдем методом максимального

правдоподобия. В нашем случае функция правдоподобия

Z,(|x,c2) = lng(2>, с2), (12)