Author: Румянцев К.Е. Котенко В.В.

Tags: электротехника кибернетика информационная безопасность телекоммуникации

ISBN: 978-5-9275-0670-5

Year: 2009

Text

МИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ

РОССИЙСКОЙ ФЕДЕРАЦИИ

ФЕДЕРАЛЬНОЕ АГЕНТСТВО ПО ОБРАЗОВАНИЮ

Технологический институт

Федерального государственного образовательного

учреждения высшего профессионального образования

«Южный федеральный университет»

В.В. КОТЕНКО

К.Е. РУМЯНЦЕВ

ТЕОРИЯ ИНФОРМАЦИИ

И

ЗАЩИТА ТЕЛЕКОММУНИКАЦИЙ

Ростов-на-Дону

Издательство Южного федерального университета

2009

УДК 621.391

ББК 32.811

К 73

Рецензенты:

профессор Военно-воздушной инженерной академии им. Н.Е. Жуковского,

доктор технических наук, профессор Величкин А. И,, г. Москва;

начальник кафедры Ростовского военного института ракетных войск, доктор

технических наук, профессор Габризльян Д, Д., г. Ростов-на-Дону;

председатель правления ЗАО "Институт информационных технологий", заведующий

кафедрой "Безопасность информационных технологий" Харьковского национального

университета радиоэлектроники, доктор технических наук, профессор Горбенко И, Д.,

г. Харьков.

Монография подготовлена и издана в рамках

национального проекта «Образование»

по «Программе развития федерального государственного образовательного учреждения

«Южный федеральный университет» на 2007-2010 гг.»

Котенко В.В., Румянцев К.Е.

К 73 Теория информации и защита телекоммуникаций: монография / В. В. Котенко,

К. Е. Румянцев. - Ростов н/Д: Изд-во ЮФУ, 2009. — 369 с.: ил. 49.

ISBN 978-5-9275-0670-5

Содержание монографии составляют результаты исследований в направлении

развития фундаментальных основ теории информации с позиций обеспечения

информационной безопасности. Основу изложения материала составляет

конкретизация модифицированной концепции теории информации, которая развивается

на стратегии кодирования источников и кодирования для каналов, принципы

информационного анализа источников и каналов, методы эффективного и

помехоустойчивого кодирования, теоретические основы защиты информации при

кодировании источников, принципы информационного анализа методов защиты

информации источников, информационный подход к оценке качества связи и защиты

информации. Приводятся оригинальные подходы к решению

III

ярокого круга задач

обработки передачи и защиты информации, теоретически подкрепленные теоремами,

следствиями и их доказательствами. Рассмотрение ведется с согласованных единых

позиций, в едином стиле, что не вызовет разночтения в понимании отдельных сложных

вопросов. Особое внимание уделено тенденциям развития комплексных подходов к

обработке, передаче и защите информации, что особенно актуально в условиях

интенсивного развития информационно-телекоммуникационных технологий.

Книга предназначена для научных работников и инженеров, занимающихся

разработкой и исследованием защищенных телекоммуникационных систем. Может

быть полезна студентам, магистрантам и аспирантам при освоении вопросов

информационной защиты телекоммуникаций.

ISBN 978-5-9275-0670-5

УДК 621.391

ББК 32.811

© ТТИ ЮФУ, 2009

© В.В. Котенко, К.Е. Румянцев, 2009

© Южный федеральный

университет, 2009

ПРЕДИСЛОВИЕ

В монографии нашли отражение результаты научных исследований, прово-

димых авторами в рамках инновационных научно-образовательных проектов

Южного Федерального университета, в ходе выполнения заданных научно-

исследовательских работ и научных исследований при поддержке гранта Т02-ОЗ.

1-816 Министерства науки и образования РФ. Среди них особо следует отметить

принципы теоретического построения теории информации, конкретизацию ее

фундаментального базиса в виде аксиом, концепцию теории информации с пози-

ций защиты телекоммуникаций и стратегии кодирования дискретных и непре-

рывных источников, открывающие возможности новых подходов к анализу их

свойств. В частности, это представление шифрования и скремблирования как

разновидности кодирования источника при изменении кодового словаря по за-

кону ключа. На основании данного представления были выведены и доказаны

основные теоремы шифрования и скремблирования, а также их следствия. Эти

теоремы приводятся впервые. На их основе получены аналитические выражения,

конкретизирующие понятия эффективности и стойкости шифрования с позиций

концепции теории информации, что позволило определить области обеспече-

ния условий практической, теоретической и абсолютной недешифруемости. К

фундаментальным результатам, приведенным в монографии, следует отнести

введение понятия “относительная избыточность” и доказательство с этих пози-

ций теоремы кодирования для непрерывных источников, а также теорем коди-

рования для канала при передаче информации непрерывных источников. Все

это открыло возможность фундаментального изложения информационного под-

хода к комплексной оценке эффективности систем связи и защиты информации.

Все главы монографии представляют интерес в качестве материалов по

теории информации с позиций информационной защиты телекоммуникаций. В

них приводятся оригинальные подходы к решению широкого круга задач обра-

ботки передачи и защиты информации, теоретически подкрепленные теорема-

ми, следствиями и их доказательствами. Рассмотрение ведется с согласованных

3

единых позиций, в едином стиле и не вызовет разночтения в понимании от-

дельных сложных вопросов.

Уровень изложения материала монографии полностью доступен понима-

нию, как специалистами, так и студентами старших курсов технических вузов.

Монография, несомненно, будет интересна и полезна научным работникам в

области информационной безопасности не только в качестве описания новых

подходов и принципов обработки, передачи и защиты информации, но и как

основа для потенциальных исследований в сфере разработки перспективных

способов обеспечения информационной безопасности телекоммуникационных

систем и объектов информатизации.

Отличительной особенностью монографии по сравнению с существую-

щей литературой по теории информации является фундаментальное рассмотре-

ние основных аспектов информационного анализа телекоммуникационных сис-

тем с позиций информационной безопасности. Это особенно важно в современ-

ных условиях, когда исследования в данном направлении приобретают приори-

тетное значение. При этом впервые защита информации описывается как одна

из основных задач кодирования информации, что позволяет решать различные

проблемы обработки, передачи и защиты информации с единых позиций. Мо-

нография опирается на труды отечественных и зарубежных ученых, внесших

значительный и общепризнанный вклад в развитие теории информации, что

обеспечивает ее преемственность с другими, изданными ранее трудами по тео-

рии информации, и доступность понимания базовых вопросов ее содержания.

Главы 1, 3, 5, 7, 8 и 11 написаны В.В. Котенко, главы 2, 4, 6, 9 и 10 —

К.Е. Румянцевым.

Авторы благодарят А.И. Величкина, И.Д. Горбенко, Д.Д. Габриэльяна и

П.Г. Горева за ценные замечания и советы, оказавшие значительную помощь в

написании монографии и подготовке ее к изданию.

4

ВВЕДЕНИЕ

Понятие «информация» является базовым объектом изучения и исследо-

вания в области информационной безопасности. Это объясняется тем, что без

четкого и глубокого представления объекта защиты невозможно эффективно

обеспечить его безопасность. Таким образом, классическая теория информации

потенциально способна обеспечить фундаментальную основу решения задач

информационной защиты телекоммуникационных систем. Однако ее примене-

ние для оптимального решения этих задач сталкивается с проблемой необходи-

мости комплексного подхода к теоретическому анализу не только процессов об-

работки и передачи информации, но и процессов защиты информации. Пробле-

ма состоит в том, теория информации в качестве фундаментальной основы ре-

шения задач информационной защиты телекоммуникаций должна учитывать

специфику обеспечения информационной безопасности. Решение этой пробле-

мы в настоящее время приобретает исключительно важное значение ввиду ин-

тенсивного развития информационно-телекоммуникационных технологий и, как

следствие, необходимости поиска новых подходов к их защите. К сожалению,

до настоящего времени решение данной проблемы не находило конструктивно-

го отражения в научной и учебной литературе в области теории информации.

Это во многом объясняет сложившуюся достаточно парадоксальную ситуацию,

когда теория информации, обладая потенциально эффективным математиче-

ским аппаратом, как правило, не используется при решении практических задач

информационной безопасности.

Основная причина отмеченной ситуации во многом состоит в том, что

попытки эффективного применения классической теория информации для ре-

шения задач защиты телекоммуникаций сталкиваются в настоящее время с ря-

дом проблем, игнорирование которых часто приводит к искаженным результа-

там. Во-первых, необходимо отметить, что традиционная теория информации,

основанная К.Шенноном, изначально предназначалась только для решения за-

дач телекоммуникации в части обработки и передачи информации. Однако её

5

многообещающее название может создать иллюзию о полной универсальности

аппарата теории информации и возможности его неограниченного применения

в различных областях. От этого заблуждения предостерегал ещё К.Шеннон, ви-

дя в нем не только опасность легковесных и ошибочных решений, но и угрозу

компрометации самой теории информации. Во-вторых, нельзя упускать из ви-

да, что развитие теории информации уже достаточно длительное время носит

двойственный характер. С одной стороны, это решение абстрактных математи-

ческих задач с формальной постановкой, весьма далекой от реальной практики.

С другой стороны, это решение прикладных задач с явно формальным матема-

тическим обоснованием. Таким образом, теория информации развивается па-

раллельно по двум слабо взаимосвязанным направлениям, что порождает риск

появления взаимоисключающих решений и выводов. Данная ситуация ещё бо-

лее усложняется обоюдной иронией в оценке имеющихся достижений со сто-

роны представителей каждого из направлений. Попытки ряда ведущих ученых,

и в первую очередь Р. Галлагера [1], найти выход из этой ситуации («переки-

нуть мостик между математиками и инженерами»), к сожалению, пока карди-

нальных результатов так и не принесли. В-третьих, до сих пор не дано сколько-

нибудь убедительного философского обоснования самого понятия «информа-

ция». Отсутствию единой философской системы взглядов на основополагаю-

щее понятие теории информации сопутствует неопределенность концепции са-

мой теории и, как следствие, неопределенность ее аксиоматического базиса.

Это порождает не только многоальтернативность взглядов на дальнейшее раз-

витие классической теории информации, но и способствует появлению значи-

тельного числа так называемых «новых теорий информации» и тому подобных

теорий, что в целом существенно затрудняет дальнейший научный поиск и дес-

табилизирует теоретические основы данной научной области, заложенные

К.Шенноном [3]. В-четвертых, пока только теория информации обладает апро-

бированным специальным математическим аппаратом, позволяющим описать

информационные процессы. Вызванная этим фактом вполне понятная потреб-

ность применения данного аппарата в других областях, в свою очередь, вызы-

6

вает негативную и научно некорректную тенденцию представления теории ин-

формации как части других наук (например, кибернетики, информатики, мате-

матики). Опасность этого предвидели и от этого предостерегали К. Шеннон,

А. Колмогоров, Р. Галлагер [1,3,4] и другие выдающиеся ученные. К сожале-

нию, эта тенденция проявляется и в настоящее время.

Основу классической теории информации как фундаментальной науки

составляет идея определяющего значения понятий кодирования и декодирова-

ния с точки зрения их функциональной роли в процессе обмена информацией, а

также их поэтапного представления с позиций источника и канала передачи

информации. Эта гениальная идея К.Шеннона определила разделение понятия

«кодирование» в задачах телекоммуникации на понятия «кодирование источ-

ника» и «кодирование для канала». Обоснованность такого разделения под-

тверждается наличием в то время двух явно выраженных составляющих про-

цесса телекоммуникации, представляющих собой обработку информации и её

передачу. С этих позиций основной целью кодирования источника является

уменьшение объёма (сжатие) информации для её эффективной обработки. Дан-

ная цель достигается путём применения кодов, осуществляющих уменьшение

избыточности информации. Такие коды принято называть эффективными.

Основной целью кодирования для канала является увеличение объёма переда-

ваемой информации для компенсации искажающего влияния помех при пере-

даче. Эта цель достигается путём применения кодов, осуществляющих искусст-

венное увеличение избыточности информации в пределах требуемой помехо-

устойчивости её передачи.

Без преувеличения можно отметить, что именно эта фундаментальная

идея К.Шеннона обеспечивает тот довольно устойчивый иммунитет, которым

обладает теория информации по отношению к деструктивному влиянию отме-

ченных выше и сопутствующих им проблем. Однако она не учитывает в полной

мере возрастающую роль третьей составляющей процесса телекоммуникации,

состоящей в защите информации. Следствием этого и ряда субъективных фак-

торов явились вполне понятные попытки решения задач данного класса вне

7

классической теории информации, что привело к формированию серьезного

научного направления, нацеленного исключительно на решение задач защиты

информации и включающего различного рода теории защиты информации. Не

умаляя значительности научных достижений в этом направлении, необходимо

отметить, что оно потенциально не способно обеспечить оптимальное решение

задач защиты телекоммуникаций. Для этого, как показывает научный опыт,

процесс коммуникации должен рассматриваться в целом, т.е. в виде комплекса

составляющих, включающего обработку, защиту и передачу информации.

Возможность выхода из отмеченных проблемных ситуаций открывает

рассмотренный в монографии подход, состоящий в модификации математиче-

ского аппарата классической теории информации с учетом третьей составляю-

щей процесса телекоммуникации - защиты информации. При этом модифика-

ция осуществляется в рамках классической теории информации без наруше-

ния ее структуры, т.е. исключает какую-либо ревизию фундаментальной идеи

К.Шеннона. Это достигается путем определения общих целей процессов обра-

ботки и защиты информации в рамках кодирования источника, состоящих в

сжатии информации, а также общих целей процессов передачи и имитозащиты,

состоящих в введении искусственной избыточности.

Основу рассматриваемого подхода составляет конкретизация фундамен-

тального базиса теории информации в виде аксиом и формирование модифици-

рованной концепции теории информации, учитывающей процесс защиты теле-

коммуникаций (глава 1). Предложенная концепция в последующем развивается

на стратегии кодирования источников (главы 2, 3, 5) и кодирования для каналов

(главы 7, 8, 10), принципы информационного анализа источников (главы 2, 5) и

каналов, методы эффективного (глава 4, 6) и помехоустойчивого кодирования

(глава 9), теоретические основы защиты информации при кодировании источ-

ников (главы 3, 5), принципы информационного анализа методов защиты ин-

формации источников, информационный подход к оценке качества связи и за-

щиты информации (глава 11). В главах монографии приводятся оригинальные

решения широкого круга проблем обработки, передачи и защиты информации,

8

теоретически подкрепленные теоремами, следствиями и их доказательствами,

что расширяя познавательный потенциал классической теории информации, от-

крывает новые перспективы для исследований в области защиты телекоммуни-

каций.

Глава 1

ОСНОВЫ ТЕОРИИ ИНФОРМАЦИИ

1.1. Состояние и проблемы современной теории информации

Успешное освоение любой научной теории в значительной мере зависит от

того, насколько четко понимаются ее проблемы и принципы теоретического

построения. Это представляет собой своеобразный фундамент для дальнейшего

формирования научного знания. Насколько прочен и конкретен будет этот

фундамент, настолько прочны будут и полученные в последующем теоретиче-

ские знания.

Исторический опыт развития человеческого знания показывает, что основу

любой теории обязательно составляет система научных и философских взгля-

дов (концепция) на предмет данной теории. От того, насколько конкретна, по-

нятна и научно обоснована эта концепция, во многом зависит как научно-

практическая значимость самой теории, так и перспективы ее дальнейшего раз-

вития. Взгляд на современное состояние теории информации с этих позиций

выявляет ряд проблем, которые обязательно следует учитывать при ее изуче-

нии. Прежде всего, это проблема существующей неопределённости базового

понятия теории — понятия “информация”. На первый взгляд конкретное и ло-

гически понятное представление информации как совокупности сведений об

окружающей действительности оказывается, ни в коей мере не раскрывает при-

роду самого понятия. Свидетельством этого служит довольно широкий спектр

взглядов на природу информации в современной научной литературе. О диапа-

зоне этого спектра можно судить по двум полярным точкам зрения: с одной

стороны — это утверждение о материальном характере понятия информации; с

другой — о его чисто нематериальной природе. По-видимому, попыткой сгла-

дить эти противоречия можно объяснить появившуюся в последнее время гипо-

тезу о том, что информация наряду с материей и энергией является первичным

понятием нашего мира. К сожалению, это еще больше усиливает существую-

щую неопределенность, учитывая проблематичность самого понятия “энергия”

10

в рамках общей теории относительности. Наверное, понимание этой неопреде-

ленности заставляет сторонников такой гипотезы делать довольно неординар-

ный вывод о том, что информация, являясь первичным параметром нашего ми-

ра, не может быть в строгом смысле определена. Нетрудно предугадать послед-

ствия такого вывода, если принять во внимание, что уже сейчас неопределён-

ность базового понятия приводит к значительной неоднозначности системы

взглядов (концепции) на саму теорию информации. Многообразие концепции

теории влечет за собой ряд негативных последствий. Прежде всего, это произ-

вольная трактовка места и роли теории информации в общей системе научных

знаний. Не может не настораживать то, с какой необоснованной легкостью эту

теорию рассматривают как часть других наук, относя ее то к математике, то к

кибернетике, а то и к информатике. Тем более, если учесть, что работа К. Шен-

нона [4], с которой, как принято считать, берет начало теория информации, на-

зывалась “Математическая теория связи” (1948). Это подчеркивает замысел К.

Шеннона создать самостоятельную науку о передаче информации в системах

связи. Отсюда представление ее в виде части кибернетики, информатики, мате-

матики или другой науки выглядит, по меньшей мере, некорректно. Причины

такого весьма вольного обращения с замыслом автора весьма очевидны. Опыт

развития научных знаний показывает, что любая теория должна опираться на

вполне определенную философскую базу. Без нее она подобна дому, построен-

ному без фундамента. В данном случае возможны два выхода: или создать и

подвести фундамент, или поставить этот дом в качестве пристройки на уже ис-

пытанный фундамент другого строения. Если перенести этот пример в плос-

кость научных теорий, то второй путь оказывается значительно проще. Вполне

понятно, что именно по нему и пошли авторы изданий, определяющих теорию

информации, как часть других наук. Цена этому — потеря самобытности и дез-

ориентация относительно общих задач, поставленных еще К. Шенноном. Это

нетрудно заметить по изданиям, в которых теория информации рассматривает-

ся как часть математики. Их содержание, как правило, изобилует решениями

абстрактных математических задач, труднопснимаемых и весьма далеких от

11

практических приложений, связанных с передачей информации. Именно с этой

негативной тенденцией в теории информации боролись в свое время К. Шен-

нон, А.Н. Колмогоров, Р. Галлагер [1,3,6] и другие ученые.

Неопределенность концепции теории информации приводит к еще одной

проблеме — догматизации процесса развития теории. Неуверенность в пра-

вильности выбора целей развития приводит к вполне понятной реакции возве-

дения в догмы уже имеющихся и апробированных достижений с целью их за-

щиты от возможного негативного влияния неизбежных проблем развития.

Следствием этого, как правило, является стремление обойти вниманием оче-

видные проблемы, если они угрожают догме. Так, до сих пор остается без вни-

мания проблема идентичности понятий энтропии и среднего количества ин-

формации для источника. В аналогичной ситуации находится проблема приме-

нимости аппарата теории для оценки смысла передаваемой информации. Со-

мнительные перспективы модернизации этого аппарата в условиях неопреде-

ленности философской базы закономерно вызывают неприятие попыток реше-

ния данной проблемы в рамках традиционной теории информации. Это приво-

дит к появлению “новых” и тому подобных альтернативных ’’теорий информа-

ции”, претендующих на решение данной проблемы. Образно говоря, возникает

довольно парадоксальная ситуация, когда в результате догматизации аппарата

развитие теории выходит за ее рамки.

Неопределенность основного понятия теории влечет за собой проблему не-

однозначности целого ряда базовых понятий и определений процессов обра-

ботки и передачи информации. В первую очередь это относится к таким поня-

тиям, как «сообщение» и «кодирование». Так, сообщение нередко определяется

как «известие», чаще как «совокупность данных» или как «последовательность

символов», а иногда и как «сигнал на предыдущей стадии обработки». Анало-

гичен диапазон представления кодирования, который простирается от довольно

абстрактного определения в виде «отображения информации в удобное множе-

ство кодовых символов» до «преобразования сообщений в последовательность

электрических сигналов, имеющих кодовые признаки». Эту неоднозначность

12

усиливает отсутствие более-менее убедительного обоснования взаимосвязи по-

нятий «кодирование» и «шифрование». Существующая неопределенность в по-

нимании этой взаимосвязи приводит к неоправданному исключению задач за-

щиты информации из общего комплекса задач кодирования источника и коди-

рования для канала, что негативно сказывается на целостности представления

как процессов передачи информации, так и процессов ее защиты.

Важно отметить, что подавляющее большинство неоднозначных определе-

ний, встречающихся в современной теории информации, в принципе, являются

верными. Проблема состоит в том, что они отражают только “грани” опреде-

ляемых понятий, не давая полного представления о них.

В целом совокупность отмеченных и сопутствующих им проблем оказыва-

ет негативное влияние на состояние традиционной теории информации. Прежде

всего это проявляется в неопределенности целей, задач и направлений ее раз-

вития. Так, представление теории в виде части определенной научной области

приводит к вполне понятной трансформации ее целей в соответствии с целями

этой области. Отмеченное выше многообразие попыток такого представления

вполне закономерно вызывает многообразие этих трансформаций. Порождае-

мая, таким образом, неопределенность еще более усиливается неоднозначно-

стью основных базовых понятий самой теории, что в конечном итоге значи-

тельно усложняет процесс ее освоения и последующего применения.

1.2. Принципы теоретического построения. Система аксиом и

исходных определений

Основу принципов построения теории информации составляет де-

дуктивный метод. Когда Евклид в своей книге «Начала» [7] впервые объединил

все известные к тому времени (IV в. до н.э.) геометрические законы в единую

дидактическую систему, он вряд ли ставил перед собой задачу определения но-

вого подхода к построению научных теорий. Великий ученый просто создал и

применил удобный «инструмент» достижения конкретной поставленной цели.

Однако по мере развития науки в течение более чем двух тысячелетий стало

13

ясно, что именно дедуктивное построение теорий является наиболее оптималь-

ным и совершенным. Сегодня ученые практически во всех научных областях

стараются изложить, если это возможно, результаты своих исследований в де-

дуктивной форме, что является одной из важнейших черт современной науки.

Содержание дедуктивного метода построения научных теорий в общем ви-

де может быть сформировано следующим образом. Научная теория в данном

случае представляется как некая дедуктивная система, которая основывается на

определенном множестве некоторых недоказуемых исходных предложений и

неопределяемых исходных понятий. Из множества исходных предложений, ко-

торые включают аксиомы (постулаты) и исходные определения, шаг за ша-

гом доказываются или выводятся производные предложения, называемые тео-

ремами. Сами аксиомы не могут быть доказаны и представляют собой предло-

жения, которые принимаются без доказательств в качестве первоначальных по-

сылок. Принятие таких посылок совершенно необходимо, так как доказательст-

во всякой теоремы выводится из чего-то установленного ранее, и какие-то пер-

воначальные посылки должны быть приняты в качестве исходных. По этой же

причине не могут быть определены все встречающиеся в данной системе поня-

тия: некоторые из них не определяются, а считаются исходными, и на их основе

определяются все остальные.

Образно говоря, построение научной теории дедуктивным методом можно

сравнить со строительством некоего здания, фундамент которого закладывается

путем задания аксиом (постулатов), исходных определений и понятий, а этажи

возводятся путем последовательного вывода доказательств теорем на основе

этого фундамента. По-видимому, именно это во многом повлияло на точку зре-

ния Евклида, который считал, что все постулаты и исходные определения

должны являться абсолютно достоверными. Из данного положения вытекала и

абсолютная истинность всей системы, так как все её предложения являются не-

обходимыми следствиями из постулатов и определений.

Это ошибочное мнение считалось непререкаемым вплоть до начала 19 ве-

ка, пока новый качественный уровень развития науки и техники не поставил её

14

под сомнение. Оказалось, что аксиомы и определения можно и должно рас-

сматривать как условно выбранные предложения. Благодаря этому перед уче-

ными открылась свобода в выборе желаемых аксиом (постулатов) и определе-

ний, способствующих, по их мнению, достижению поставленной цели. Опреде-

лим с позиций дедуктивного метода систему аксиом и исходных определений,

составляющих основу теории информации. Для этого сформулируем исходное

представление понятия «информация».

Аксиома 1. Понятие «информация» формируется только в процессе ком-

муникации.

Согласно аксиоме понятие «информация» свойственно только процессу комму-

никации между объектом информации и человеком, которые в данном случае

могут рассматриваться как элементы некоторой схемы коммуникации

(рис. 1.1).

Источник

информации

коммуникации

*

Полу 'чатель

информации

Рис .1.1. Схема коммуникации

Объект информации здесь выступает в роли источника информации, а че-

ловек — в роли ее получателя. При этом в качестве канала коммуникации мо-

жет выступать или окружающая среда, что соответствует непосредственной

коммуникации, или технические средства, что определяет техническую комму-

никацию (телекоммуникацию).

Аксиома 2. Получение информации является важнейшей потребностью

жизнедеятельности человека.

Получение информации человеком осуществляется через его органы

чувств. С этой точки зрения информация может быть классифицирована как:

- информация, поступающая через органы слуха;

- информация, поступающая через органы зрения;

- информация, поступающая через органы осязания;

15

- информация, поступающая через органы обоняния.

Информация воспринимается органами чувств человека как путем прямого

взаимодействия с окружающей средой, так и в процессе обмена информацией

через технические средства. При этом в качестве объекта информации может

выступать человек, техническое средство или сама окружающая среда во всем

ее многообразии проявлений. Все это во многом объясняет двоякий смысл су-

ществующих в настоящее время определений понятия «коммуникация». С од-

ной стороны, под коммуникацией принято понимать акт общения, сообщение

информации одним лицом другому или ряду лиц; с другой стороны — форму

связи с применением технических средств (как, например, телефон, телеграф,

радио, телевидение). Это дает основание классифицировать информацию на

информацию непосредственной коммуникации и информацию технической

коммуникации.

Информация непосредственной коммуникации (ИНК) — это информа-

ция, воспринимаемая органами чувств человека (Ч) при непосредственном об-

щении с другими людьми, техническими средствами (ТС) или при прямом

взаимодействии с окружающей средой. Информация технической коммуни-

кации (ИТК), или информация телекоммуникации — это информация, вос-

принимаемая органами чувств человека при общении через технические сред-

ства коммуникации (ТСК).

б

а

Рис. 1.2. Схемы непосредственной (а) и технической (б) коммуникаций

16

Сравнение схем коммуникации, построенных на основании введенной

классификации (рис. 1.2), показывает, что основное отличие схемы ИТК состо-

ит в применении технического канала коммуникации или канала телекоммуни-

кации, построенного на базе ТСК.

Научно-технический прогресс двадцатого века породил тенденцию неук-

лонного роста ИТК в общем объеме информации. Это привело к тому, что уже

на рубеже 40-х и 50-х годов информация технической коммуникации начала

приобретать доминирующее значение среди других видов информации. Имен-

но на данный период, как уже отмечалось, приходится начало развития тради-

ционной теории информации. Соотношение этих двух исторических фактов по-

зволяет прийти к следующим выводам:

во-первых, создание теории информации вызвано объективной закономер-

ностью, возникшей в ходе научно-технического прогресса;

во-вторых, теория изначально предназначалась для фундаментального тео-

ретического обеспечения возрастания роли ИТК, закономерного в условиях на-

учно-технического прогресса.

Полученный вывод подчеркивает самостоятельную роль теории информа-

ции в общей системе научных знаний. Кроме того, что особенно важно, он по-

зволяет обозначить область целесообразного применения теории, выход за гра-

ницы которой может привести к ошибочным результатам. Это означает, что

традиционная теория информации предназначена исключительно для решения

задач обработки и передачи информации телекоммуникации (технической

коммуникации), и применение ее по иному назначению требует определенной

осторожности.

Основываясь на введенной классификации, можно конкретизировать осо-

бенности, свойственные обмену информацией в процессе коммуникации.

Аксиома 3. Информация при коммуникации обязательно имеет определен-

ную форму.

Аксиома 4. В процессе телекоммуникации форма информации всегда под-

вергается изменению.

17

Изменение формы информации в процессе телекоммуникации определяет-

ся понятием «кодирование».

Для определения природы и содержания понятия «форма информации» об-

ратимся к установленной ранее аксиоме 2 и проведем аналогию с другой важ-

нейшей потребностью жизнедеятельности человека, связанной с потреблением

воды. В данном случае, если мы говорим о передаче воды одним лицом друго-

му, то всегда имеем в виду определенную форму', стакан воды, кружка и тому

подобное. В случае, когда для производства и доставки воды используются

специальные технические системы (заводы, транспорт), она поступает потреби-

телям в виде единой формы (например, в форме бутылки), после чего каждый

из них изменяет эту форму на форму, удобную для потребления (например,

стакан или бокал). Проекция этих рассуждений на процесс получения инфор-

мации путем телекоммуникации во многом объясняет введенное понятие

«форма информации», однако не позволяет в полной мере раскрыть его харак-

тер. Причиной этого является парадокс, свойственный обмену информацией. В

свое время его гениально отразил великий писатель и драматург Б. Шоу в од-

ном из своих высказываний. Дословно оно звучало так: если у вас есть яблоко и

у меня есть яблоко, то при обмене у нас окажется по яблоку; если у меня есть

идея и у вас есть идея, то при обмене у нас окажется по две идеи. Развивая

мысль писателя, сформулируем этот парадокс в виде аксиомы.

Аксиома 5. Парадокс Шоу, Информация при коммуникации имеет двой-

ственный характер, у которого логическая и материальная составляющие

проявляются одновременно.

Значение парадокса Шоу заключается в том, что он устанавливает 2 уровня

представления информации: логический и материальный. На каждом уровне

представления, согласно аксиоме 4, информация может принимать различные

формы: на логическом уровне — различные логические формы; на материаль-

ном уровне — различные материальные формы. При этом, исходя из двойст-

венного характера информации, установленного аксиомой 5, каждой логиче-

ской форме соответствует строго определенная материальная форма.

18

Основной логической формой информации является сообщение, основной

материальной формой — сигнал.

Это подтверждается общепринятым определением [44] для сигнала:

Сигнал представляет собой материальное воплощение (материальную

форму) сообщения.

Отсюда следует целесообразность двух уровней представления процессов

телекоммуникации: логического и материального. На логическом уровне обоб-

щенная схема телекоммуникации отображается в виде, приведенном на

рис. 1.3. В качестве основной логической формы информации, формируемой

источником информации (ИИ), здесь выступают сообщения, которые подвер-

гаются кодированию (К).

Рис. 1.3. Обобщенная схема телекоммуникации

В ходе кодирования происходит преобразование логической формы ин-

формации источника (сообщения) к виду логической формы, установленной в

канале передачи информации или канале связи (КС). Каналом связи называет-

ся совокупность технических средств, служащая для передачи сообщений (сиг-

налов) от одного отправителя к одному получателю [43]. Логическую форму,

полученную в результате кодирования, принято обозначать как кодовую ком-

бинацию или кодовую последовательность. В канале связи возможно искаже-

ние информации, поэтому основной целью декодирования (ДК) является мак-

симально точное восстановление исходной формы информации (сообщения),

для того чтобы ее воспринял получатель информации (ПИ).

Нетрудно заметить, что кодирование (декодирование) составляет основу

телекоммуникации.

Это во многом объясняет то главенствующее значение, которое придается

кодированию в теории информации. Задачи кодирования определяются требо-

ваниями к телекоммуникации, основными из которых выступают: оператив-

19

ность, помехозащищенность, конфиденциальность (секретность). Отсюда ос-

новными задачами кодирования являются:

1. Задача сокращения объема информации с целью обеспечения оператив-

ности коммуникации, которая определяется как задача сжатия информации;

2. Задача увеличения объема информации с целью достижения требуемой

помехозащищенности, которая определяется как задача избыточного или поме-

хоустойчивого кодирования;

3. Задача ограничения несанкционированного доступа к информации для

обеспечения требуемой конфиденциальности, которая определяется как задача

защиты информации.

Отметим явный антагонизм первой и второй задач. Можно предположить,

что именно он в свое время являлся основным препятствием к созданию теории

информации. К. Шеннон смог первым понять эту проблему и предложить гени-

альную по простоте идею ее решения, которая заключалась в разделении поня-

тия «кодирование» на «кодирование источника» и «кодирование для канала».

Её реализация привела к вполне естественной трансформации схемы коммуни-

кации рис. 1.3 к виду, представленному на рис. 1.4. Данная схема предусматри-

вает 2 независимых этапа кодирования: кодирование источника (КИ); кодиро-

вание для канала (КК).

Рис. 1.4. Схема телекоммуникации. Логический уровень представления

На первом этапе производится преобразование логической формы ИТК ви-

да сообщения к виду кодовой комбинации (кодовой последовательности) ис-

точника, которая на втором этапе преобразуется к виду кодовой комбинации

(кодовой последовательности) канала. Таким образом, реализация идеи К.

Шеннона приводит к увеличению числа видов логических форм ИТК до трех.

Введение дополнительного вида логической формы ИТК позволяет разделить

20

антагонистические задачи кодирования и сделать их независимыми. При этом

сжатие и шифрование становятся основными задачами кодирования источника,

а помехоустойчивое кодирование — основной задачей кодирования для канала.

Переход на материальный уровень представления телекоммуникации мож-

но рассматривать как результат трансформации схемы рис. 1.5 при замене со-

общений их материальной формой в виде сигнала, с учетом физических про-

цессов преобразования этой формы в ходе телекоммуникации. Общий вид ре-

зультата такой трансформации представлен на рис. 1.5. В приведенной схеме

источник информации формирует сигналы, соответствующие определенному

виду информации телекоммуникации.

Рис. 1.5. Схема телекоммуникации. Материальный уровень представления

Считается, что основными видами ИТК являются:

аудиоинформация, представляющая собой ИТК, воспринимаемую органа-

ми слуха получателя информации;

видеоинформация — ИТК, воспринимаемая органами зрения ПИ.

Сигналы источника, соответствующие аудиоинформации, в общем случае

представляют собой упругие колебания среды (акустические колебания). Такие

сигналы принято называть акустическими сигналами. Сигналы источника, со-

ответствующие видеоинформации, представляют собой световой поток, несу-

щий информацию об изображении.

Устройства прямого преобразования сигналов источника (УППСи) форми-

руют низкочастотные (НЧ) электрические сигналы, которые в зависимости от

вида ИТК определяются как аудиосигналы или видеосигналы. При формирова-

21

нии этих сигналов в УППСи, как правило, используются следующие цепи пре-

образований:

акустический сигнал — электроакустическое преобразование — цифровое

преобразование — аудиосигналу

световой поток — формирование поля электрических потенциалов — раз-

вертка — цифровое преобразование — видеосигнал.

В ряде случаев такое преобразование, как цифровое, может отсутствовать.

Исходя из этого, аудио- и видеосигналы принято разделять на аналоговые (не-

прерывные) и цифровые (ГОСТ 22670-77). Цифровые сигналы на выходе

УППСи часто называют данными.

Взаимосвязь логической и соответствующей ей материальной форм НТК

проявляется в виде изменения параметров сигнала в соответствии с сообщени-

ем. Параметр сигнала, отражающий сообщение, называется представляющим,

а другие параметры, не связанные с сообщением, считаются сопутствующи-

ми. Аналоговым (непрерывным) называется сигнал, у которого каждый из

представляющих параметров является непрерывнозначным. Цифровым назы-

вается сигнал с дискретно-значимыми представляющими параметрами [44].

В устройствах обработки и защиты (УОЗ) осуществляются преобразова-

ния, обеспечивающие защиту сигналов от несанкционированного доступа. В

частности, к этим преобразованиям могут относиться скремблирование и крип-

тографическая обработка (шифрование) параметров сигналов.

Устройства прямого преобразования сигналов для канала (УППСк) изме-

няют форму сигнала в соответствии с требованиями канала связи. При этом они

реализуют целый ряд преобразований, обеспечивающих помехоустойчивость и

защиту сигналов от несанкционированного доступа. По своей природе сигналы

на выходе УППСк представляют собой высокочастотные (ВЧ) электромагнит-

ные (электрические) колебания, соответствующие виду каналов связи (напри-

мер, радиосигналы или телевизионные сигналы).

В устройствах обратного преобразования (УОПСк и УОПСи) осуществля-

ется комплекс преобразований, целью которых в конечном итоге является пре-

22

доставление получателю информации сигнала, максимально точно соответст-

вующего сигналу источника.

Приведенное представление телекоммуникации на материальном уровне

является достаточно общим и обычно требует дополнительной детализации.

Однако даже в этом виде оно показывает:

1. При телекоммуникации происходит изменение материальной формы

ИТК, аналогичное изменению ее логической формы, например:

- для аудиоинформации это цепь: акустический сигнал — аудиосигнал —

радиосигнал;

- для видеоинформации это цепь: световой поток — видеосигнал — теле-

визионный сигнал.

2. Представление телекоммуникации на логическом уровне является осно-

вой ее представления на материальном уровне.

3. Представление на материальном уровне играет исключительно важную

роль для объяснения физической природы понятий и преобразований логиче-

ского уровня.

Детальному изучению и исследованию процессов телекоммуникации на

материальном уровне посвящен целый ряд научно апробированных и практиче-

ски значимых теорий, таких, как теория электросвязи, теория радиосвязи, ста-

тистическая теория радиосвязи и другие. Теория информации, как видно из

вышеизложенного, предназначена в первую очередь для решения задач теле-

коммуникации на логическом уровне в части оптимизации процессов обмена

информационными потоками. Она позволяет получать общие решения для раз-

личных материальных форм информации. Отсюда следует основополагающее

значение теории информации для теорий, предназначенных для решения задач

телекоммуникации на материальном уровне.

Базовым понятием теоретического описания форм информации на логиче-

ском уровне представления является понятие «ансамбль». Ансамбль — это не-

23

которое множество случайных значений определенной логической формы ин-

формации.

В терминах традиционной теории информации ансамбль задается выбо-

рочным пространством и вероятностной мерой. В общем случае выборочное

пространство представляет собой множество значений логической формы,

соответствующей ансамблю, а вероятностная мера — множество соответст-

вующих этим значениям вероятностей. Если выборочное пространство ансамб-

ля дискретно, то ансамбль принято считать дискретным, если оно непрерывно,

то ансамбль принято считать непрерывным и представлять в виде случайного

процесса. Таким образом, дискретный ансамбль определяется выборочным

пространством, представляющим собой множество дискретных значений логи-

ческой формы определенного вида (сообщений или кодовых комбинаций), и

вероятностной мерой на множестве этих значений, представляющей совокуп-

ность их вероятностей. Выборочное пространство такого ансамбля называется

дискретным и обладает следующими свойствами:

- любое конечное или счетное объединение или пересечение множеств

значений логической формы является другим значением логической формы;

- дополнение любого значения логической формы является другим значе-

нием логической формы.

На первый взгляд, второе свойство противоречит смысловому характеру

ИТК. Однако это противоречие может быть довольно просто устранено путем

присвоения значению логической формы, не имеющему смысла в рамках ис-

пользуемого языка, нулевой вероятности.

Вероятностная мера дискретного ансамбля обладает следующими свойст-

вами:

- каждое значение логической формы имеет неотрицательную вероят-

ность;

- всё выборочное пространство имеет вероятность, равную единице;

24

- вероятность любого конечного или счетного объединения непересекаю-

щихся значений логической формы равна сумме вероятностей отдельных

значений логической формы.

Основу определения дискретного ансамбля составляет задание алфавита.

Алфавит — это конечное множество букв (символов), из которых формируют-

ся значения логической формы, с заданными вероятностями этих букв (симво-

лов).

Непрерывный ансамбль в общем случае определяется выборочным про-

странством, представляющим собой непрерывный случайный процесс, и веро-

ятностной мерой, объединяющей плотности вероятностей реализаций этого

процесса.

Ансамбль, применяемый для представления источника информации, обыч-

но называют ансамблем сообщений, а значения его выборочного пространства

— сообщениями. При этом изначально считается, что различные сообщения

содержат различный объем информации.

Аксиома 6, Менее вероятное сообщение содержит больший объем ин-

формации.

Аксиома 7. Информация, содержащаяся в некоторой совокупности неза-

висимых сообщений, соответствует сумме информаций этих сообщений.

Приведенную систему аксиом и исходных определений можно рассматри-

вать как основу для дальнейшего освоения теории информации. Однако ее ус-

пешное применение требует конкретизации стратегии дальнейшего теоретиче-

ского построения. Это достигается путем конкретизации системы научных

взглядов на теорию информации или концепции теории информации.

1.3. Концепция теории информации

Обобщение проведенных рассуждений позволяет определить основные со-

ставляющие концепции теории информации:

25

1. Информация, как понятие, свойственна только процессу коммуника-

ции.

2. Получение информации об окружающей действительности является

важнейшей потребностью жизнедеятельности человека.

3. Информация воспринимается человеком через органы чувств как путем

прямого взаимодействия с окружающей средой, так и в процессе обмена ин-

формацией.

4. Информация, получаемая человеком путем коммуникации, подразделя-

ется на информацию непосредственной коммуникации и информацию теле-

коммуникации.

5. Под информацией телекоммуникации понимается информация, полу-

чаемая человеком посредством технических средств коммуникации.

6. Появление теории информации вызвано объективной закономерно-

стью, состоящей в возрастании роли ИТК в условиях научно-технического про-

гресса.

7. Теория информации занимает самостоятельное место в общей системе

научных знаний и предназначена для решения задач передачи и обработки ин-

формации телекоммуникации. Применение теории не по назначению требует

определенной осторожности, так как может привести к ошибочным результа-

там.

8. Информация коммуникации имеет двойственный характер, у которого

логическая и материальная составляющие проявляются одновременно. Отсюда

следует существование логических и соответствующих им материальных форм

представления данной информации. Исходной логической формой является со-

общение, материальной — сигнал на выходе источника.

9. Основными видами ИТК являются аудиоинформация и видеоинформа-

ция. Исходной логической формой аудиоинформации является аудиосообще-

ние; видеоинформации — видеосообщение. Основной исходной материальной

формой аудиоинформации является акустический сигнал; видеоинформации —

световой поток.

26

10. Существуют и целесообразны два уровня представления телекомму-

никации: логический и материальный. Теория информации предназначена для

решения задач коммуникации преимущественно на логическом уровне.

11. Процесс коммуникации как на логическом, так и на материальном

уровне представления характеризуется изменением формы ИТК.

Преобразование формы ИТК называется кодированием.

12. Кодирование составляет основу телекоммуникации. На логическом

уровне представления кодирование разделяется на кодирование источника и

кодирование для канала.

13. Основными задачами кодирования источника являются: сжатие и за-

щита информации. Кодирование источника будет оптимальным только при

комплексном решении отмеченных задач.

14. Основной задачей кодирования для канала является помехоустойчи-

вое кодирование.

15. Исходным понятием теории информации является понятие «сообще-

ние». Сообщения и формирующие их источники информации разделяются на

непрерывные и дискретные. Материальной формой сообщения является сигнал.

16. Взаимосвязь логической и соответствующей ей материальной форм

ИТК проявляется в виде изменения параметров сигнала в соответствии с сооб-

щением.

Представленная система взглядов (концепция) на теорию информации

открывает возможность решения целого ряда проблем, свойственных совре-

менному состоянию теории. Во-первых, она снимает неопределенность относи-

тельно места и роли теории информации в общей системе научных знаний. Во-

вторых, данная концепция позволяет конкретизировать предмет теории и опре-

делить область её применения, выход за границы которой может привести к

ошибочным результатам, дискредитирующим саму теорию. В-третьих, введе-

ние ею двух уровней представления процесса телекоммуникации открывает

перспективу устранения неоднозначности определения основных понятий тео-

рии информации и их взаимоотношения. В-четвёртых, с позиций данной кон-

27

цепции становятся понятными и приобретают реальные черты стратегия коди-

рования источника и стратегия кодирования для канала. В-пятых, что особенно

важно для специалистов по информационной безопасности телекоммуникаци-

онных систем, она впервые устанавливает целесообразность комплексного ре-

шения задач сжатия и защиты информации при кодировании источника.

Необходимо подчеркнуть, что данная система взглядов ни в коей мере не

выходит за рамки классической теории информации и, что особенно важно, она

является открытой для дальнейшего развития. Так, установление логического

уровня представления телекоммуникации оставляет место для результатов

дальнейших исследований в направлении оценки смысла передаваемой инфор-

мации. Наряду с этим, открытие целесообразности комплексного решения за-

дач сжатия и защиты информации при кодировании источника открывает ши-

рокое поле деятельности в направлении поиска новых подходов к сжатию ин-

формации на основе её защиты. Кстати, возможность таких подходов гениально

предсказал К.Шеннон в своей работе «Теория связи в секретных системах» [5].

Для описания реальных процессов с позиций любой концепции этим про-

цессам обязательно необходимо придать определенный математический образ,

позволяющий осуществлять количественную оценку.

1.4. Количественная оценка информации

1.4.1. Количество информации

Важнейшим вопросом конкретизации концепций теории информации все-

гда являлось установление меры количества информации. Первый продуктив-

ный шаг в этом направлении был сделан в 1928 году американским ученым Р.

Хартли, который, используя математический аппарат теории вероятностей,

впервые обозначил общий подход к определению меры количества информа-

ции. Раскроем содержание этого подхода.

Теорема 1.1. Пусть и является некоторым сообщением. Тогда, если извест-

на вероятность р(и) этого сообщения, то количество информации в сообщении

определяется в виде

28

J[u] = log —= -log p(u).

r p(u) r

(1.1)

Доказательство. Для доказательства теоремы проведем ряд мысленных

экспериментов.

Справка. Идея мысленного эксперимента как мощного орудия познания

впервые была предложена великим ученым Галилео Галилеем (1564 — 1642).

Она состоит в мысленном проведении такого эксперимента, который нельзя по-

ставить на практике, однако, предугадав его исход на основании глубокого по-

нимания законов окружающего мира, можно еще глубже познать законы при-

роды.

Первый эксперимент. Мысленно исследуем 2 сообщения щ и и2 о некото-

рых событиях:

- сообщение щ: «В Ростовской области в этом году собран рекордный

урожай»;

- сообщение и2: «Под Москвой приземлился космический аппарат с ино-

планетянами на борту».

Определим, какое из этих сообщений несет для нас больше информации.

Рассуждая логически, можно прийти к выводу, что это сообщение и2. Сообще-

ние ui конечно несет для нас информацию, но оно более предсказуемо (более

вероятно). Стояла хорошая погода, и большого урожая зерновых следовало

ожидать. Таким образом, сообщение щ только проинформировало нас о том,

что наши ожидания подтвердились. В отличие от него, сообщение и2 несет для

нас гораздо больше информации, так как является абсолютно неожиданным

(менее вероятным). Анализируя результаты этого эксперимента и принимая во

внимание аксиому 6, можно прийти к выводу, что количество информации в

сообщении и является функцией от величины, обратно пропорциональной ве-

роятности этого сообщения, т. е.

J(u) = f

VP(u)

29

Второй эксперимент. Мысленно предположим, что информацию сообще-

ний ui и U-2 мы получили одновременно в одном сообщении. Как в данном слу-

чае будет определяться количество информации? Ответ очевиден. Так как эти

события независимы, то совместная информация согласно аксиоме 7 будет оп-

ределяться как простая сумма информации одного и информации другого со-

общения:

Анализируя результаты эксперимента, ответим на вопрос: какая математи-

ческая функция обеспечивает выполнение равенства (1.2)? Ответ будет одно-

значным — логарифмы. Таким образом, можно прийти к выводу, что количест-

во информации в сообщении и определяется выражением вида

J[u] = logr—-— = - logr р (u). Что и требовалось доказать.

р(К)

Нетрудно заметить, что в определении количества информации (1.1) все

еще сохраняется неопределенность, так как остается без ответа вопрос: в каких

единицах может быть измерена информация? Анализ выражения (1.1) позволя-

ет сделать вывод, что ответ на этот вопрос даст конкретизация основания лога-

рифма. Принято считать, что, если г = 2, то информация измеряется в битах

(бит); г = е = 2,718 — в натах (нат); г = 10 — в дитах (дит). Обычно в форму-

ле (1.1) проводят двоичное логарифмирование, и информация измеряется в би-

тах.

В реальных ситуациях источник часто формирует сообщения и из букв ал-

фавита источника: А = ^а1...авд ) с вероятностями />(#1).../?Тогда в про-

стейшем случае, когда буквы алфавита равновероятны и взаимонезависимы

(^(ч) = а сообщения имеют постоянную длину L (постоянное число

букв), количество информации в каждом сообщении и определяется как

30

где J[a, ] = log.

j[u] = ZJ[aJ = Zlogr

= Z,logr(w1),

количество информации в букве.

Именно эту формулу получил в 1928 году Р. Хартли. Правомочен вопрос:

почему начало развития теории информации принято считать с 1948 года, хотя

единица ее измерения была определена еще в 1928 году?

Как уже отмечалось, Р. Хартли предложил только подход к количествен-

ной оценке информации. Однако он не смог вскрыть содержания процесса об-

мена информацией и прежде всего, связать этот процесс с коммуникацией (ак-

сиома 1), что не позволило ему пойти дальше в своих научных исследованиях.

Полученная им формула позволяла решать только абстрактные задачи и была

неприемлема для реальных задач обмена информацией.

Кроме того, в реальных дискретных источниках информации буквы алфа-

вита не равновероятны, а отсюда количество информации в формируемых со-

общениях неодинаково. Оно постоянно изменяется по мере формирования со-

общения источником, причем процесс этого изменения носит случайный харак-

тер. Отсюда следует, что количество информации не может использоваться в

качестве характеристики процесса обмена информацией. Однако, несмотря на

это, оно остается основным понятием теории информации. Приведенные рас-

суждения позволяют сформулировать основные свойства количества информа-

ции:

- в менее вероятных сообщениях заключено большее количество инфор-

мации;

- количество информации в нескольких независимых сообщениях равно

сумме количеств информации, заключенных в отдельных сообщениях (свойство

аддитивности);

- количество информации в сообщениях реальных источников носит слу-

чайный характер.

31

1.4.2. Среднее количество информации и энтропия

Итак, начиная с 1928 года, сложилась довольно парадоксальная ситуация,

когда подход к определению количества информации и единиц ее измерения

был обозначен, а что и как измерять, применительно к каким реальным практи-

ческим задачам, — оставалось неясным. Нельзя сказать, что не было попыток

решить эту проблему после открытия Р. Хартли, однако, как свидетельствует

история, они неизменно заканчивались безрезультатно. Потребовался теорети-

ческий и практический гений К. Шеннона, его глубокое понимание реальных

задач обмена информацией, чтобы дать мощный импульс формированию и раз-

витию теории информации как науки. Ключом к успеху явилось то, что К.

Шеннон решал отмеченную проблему применительно к реальным задачам об-

мена информации — задачам телекоммуникации (связи). Прежде всего, это по-

зволило конкретизировать ряд понятий, например понятие собственной инфор-

мации.

Собственной информацией принято считать информацию сообщения, за-

ключенную в нем самом. В системах телекоммуникации источник информации

может выдавать различные сообщения щ, каждое из которых характеризуется

своей собственной информацией

J[u,.] = -logr(p(uj)). (Ь4)

Характерным примером являются буквенные сообщения, передаваемые в

системах телекоммуникации. В данном случае количество собственной инфор-

мации сообщения, согласно (1.3), будет определяться вероятностями букв, из

которых оно состоит. Известно, что каждая буква в любом языке обладает соб-

ственной, отличной от других букв, вероятностью. Таким образом, каждое со-

общение будет обладать собственным (отличным от других сообщений) коли-

чеством информации. Отсюда следует, что при телекоммуникации количество

собственной информации изменяется во времени. А так как формирование букв

любого языка носит случайный характер, это изменение также будет случай-

ным.

32

Возникает проблема: количество собственной информации не может быть

использовано в качестве информационной характеристики телекоммуникации,

ввиду своего случайного характера. К. Шеннон предложил достаточно простой

с позиции современных представлений (но в свое время гениальный) путь ре-

шения данной проблемы: использовать в качестве такой информационной ха-

рактеристики не само количество собственной информации, а его математиче-

ское ожидание. Эта характеристика получила название среднего количества

собственной информации или просто среднего количества информации. Для

случая, когда источник информации задается дискретным ансамблем U, выбо-

рочное пространство которого составляют независимые сообщения щ, эта ха-

рактеристика определяется как

I[U] = М{J[и,. ]} = р (и,)logr р (и,).

Щ

(1-5)

Выражение (1.5) является фундаментальным для теории информации и оп-

ределяет среднее количество собственной информации, приходящейся на со-

общение источника информации.

К заслуге К. Шеннона следует отнести то, что он не ограничился приве-

денным определением. Сумев понять философскую глубину полученных ре-

зультатов, он пошел дальше. Как уже отмечалось, первоначально количество

информации в сообщении рассматривалось как мера непредсказуемости (неоп-

ределенности) этого сообщения. Чем более непредсказуемо сообщение, тем

большую информацию оно несет. С этих позиций выражение (1.5) характеризу-

ет среднюю неопределенность очередного состояния источника, т. е. неопреде-

ленность того, какое сообщение он будет в следующий момент генерировать.

Если в качестве сообщения щ рассматривается буква а. ? то это будет средняя

неопределенность очередного состояния источника на букву.

В физике меру неопределенности состояния системы называют энтропией.

Таким образом, вполне логично, что именно это название получило понятие,

характеризующее среднюю неопределенность в информационных системах.

33

Справка. Впервые понятие «энтропия» ввел немецкий физик Р. Клаузиус в

1865 году при формулировке второго закона термодинамики.

В общем случае энтропию можно рассматривать как меру неопределенно-

сти на различных этапах преобразования информации при телекоммуникации.

Как уже отмечалось, базовым понятием теоретического описания этих этапов

является понятие “ансамбль”, исходя из этого, можно сформулировать общее

определение энтропии с позиций теории информации. Энтропией называется

средняя неопределенность, характеризующая выборочное пространство ан-

самбля, задающего логическую форму информации телекоммуникации.

Если такой логической формой являются сообщения, формируемые дис-

кретным источником, общее определение принимает вид: энтропией дискрет-

ного источника называется средняя неопределенность сообщений, состав-

ляющих выборочное пространство ансамбля U источника. Если сообщения uz

взаимонезависимы, данная энтропия определяется выражением

H[U] = -^p(uI)1°gr(p(uI))- (1.6)

«i

В случае, когда в качестве элементов дискретного ансамбля источника вы-

ступают буквы а- алфавита ), энтропия (1.6) называется энтропи-

ей дискретного источника на букву и определяется выражением

H[U] = -XX«;)log^(a,)- (1-7)

j=l

Нетрудно заметить идентичность выражений (1.5) и (1.6), определяющих

среднее количество собственной информации и энтропию источника.

Правомочен вопрос: почему для источника информации характерно совпа-

дение этих двух по логике обратно противоположных понятий? К сожалению,

ответ на этот вопрос долгое время отсутствовал. Во многом это объясняется

тем, что проблема философского осмысления этого вопроса длительное время

находилась вне зоны научного внимания. Хотя, по-видимому, именно эта про-

блема во многом явилась причиной того, что после открытия Р.Хартли прошло

34

почти двадцать лет прежде, чем теория информации начала формироваться как

наука. Только подход к анализу информации с позиции телекоммуникации,

предложенный в 1948 году К. Шенноном, и, прежде всего, введение понятия

совместных ансамблей, поставили все на свои места. Для совместных ансамб-

лей, как будет показано далее, понятия средней взаимной информации и энтро-

пии становятся уже обратно пропорциональными. Однако найденный путь ре-

шения проблемы пока не объяснял саму проблему. Это объяснение дает приня-

тая концепция теории информации. Так как согласно аксиоме 1 понятие ин-

формации возникает только в процессе коммуникации, то перед ее установле-

нием потенциальный объект информации может восприниматься ее потенци-

альным получателем двояко: как нечто неизвестное и неопределенное, характе-

ризуемое энтропией, и как потенциальный источник информации, которая мо-

жет быть получена при установлении коммуникации и характеризуется сред-

ним количеством информации. При этом получение полной информации об

объекте будет приводить к полному снятию неопределенности о нем у получа-

теля. Отсюда объективно следует идентичность выражений для энтропии и

среднего количества информации ансамбля сообщений.

Приведенное К. Шенноном определение энтропии дискретных источников

является универсальным и применимо для всех видов логических форм, кото-

рые может принимать сообщение при телекоммуникации, если эти формы за-

даются дискретными ансамблями. Это дает основание называть данную энтро-

пию в общем случае энтропией дискретных ансамблей.

Определим основные свойства энтропии дискретных ансамблей [1].

Свойство 1. Энтропия не может быть отрицательной.

Доказательство. Это свойство вытекает из формулы (1.6), если учесть, что

вероятность p(uz) < 1.

Свойство 2. Энтропия детерминированных (неслучайных) сообщений

равна нулю.

35

Доказательство, Предположим, что среди множества сообщений одно

возникает с вероятностью единица, а вероятность появления других сообще-

ний, соответственно, равна нулю. Учитывая, что логарифм единицы равен ну-

лю, из формулы (1.6) легко определить, что в этом случае энтропия равна нулю,

т. e. неопределенность отсутствует.

Свойство 3, Энтропия увеличивается при уменьшении диапазона воз-

можных значений вероятностей элементов ансамбля.

Доказательство, Покажем, что любое преобразование вероятностей двух

элементов ансамбля, которое делает эти вероятности более близкими друг к

другу, увеличивает энтропию ансамбля.

Пусть X и Y являются ансамблями с вероятностными мерами:

Определим разность энтропий ансамблей X и Y:

Применив известное неравенство log z < (z -1) log e, получим:

H[X]-H[Y]<(loge)

р(аД-Е

= —е log 1-< 0.

Р^Д + Е

Откуда следует H[Y] > Н[Х], что и требовалось доказать.

Свойство 4. Энтропия максимальна тогда, когда все сообщения, состав-

ляющие выборочное пространство дискретного ансамбля, равновероятны.

36

Доказательство. Учитывая, что энтропия ансамбля, у которого все его т

элементов равновероятны, определяется как

Н_[Х] = -т—log— = logm,

т т

доказательство свойства сводится к доказательству неравенства Н[Х] < log/и.

Определим разность

Н[Х] - log т = 2 р(х) log—— - X Ах) log т = £ р(х) log

к Р\х) к х

Применив неравенство log z < (z -1) log e, получим:

т р(х)

Н[Х] - log т < log р(х)

тр(х) тр(х)

~ ГП X

wV

Откуда следует, чтоН[Х] < log т, что и требовалось доказать.

При применении общего определения энтропии к непрерывным ансамб-

лям возникает серьезная проблема, связанная в первую очередь с тем, что вы-

борочное пространство этих ансамблей представляется непрерывным случай-

ным процессом (случайной величиной). Покажем эту проблему.

Обозначим непрерывнозначную случайную величину, определяющую вы-

борочное пространство непрерывного ансамбля S, буквой s. Предположим, что

нам известна плотность вероятностей Р(^), определяющая вероятностную меру

ансамбля. Попытаемся решить задачу определения энтропии путем предельно-

го перехода от дискретного представления (1.7) к непрерывному, увеличивая

значение т/. Для этого разобьем область значений случайной величины 5 на mi

частей, равных zV . Значение mi установим достаточно большим, а zV достаточ-

но малым, чтобы считать

Si +As

Pi = J P{s)ds P{Si)ds .

S/

Подставив в (1.7) и перейдя к пределу при As—>0, получим:

37

00

H[S] = - Jp(s)logr P(s)ds -lim logr As = h[S] + a.

(1-8)

Из (1.8) видно, что энтропия непрерывного ансамбля содержит две состав-

ляющие, из которых вторая (а) порождает проблему стремления энтропии к

бесконечности при переходе к непрерывному выборочному пространству

(Ду —> 0). Физически этот результат вполне объясним. Ведь с позиции дискрет-

ных ансамблей энтропия — это средняя неопределенность элементов выбороч-

ного пространства. Таким образом, можно считать, что непрерывное выбороч-

ное пространство обладает бесконечно большим числом состояний. Отсюда,

его неопределенность будет бесконечно большой.

К. Шеннон предложил довольно оригинальное и простое решение этой

проблемы [4], состоящее в следующем: при определении энтропии непрерыв-

ных ансамблей (1.8) ограничиться только ее первой составляющей h[S] и не

учитывать вторую а. Он называл эту составляющую дифференциальной эн-

тропией и определил как

00

h[S] = - JP(s)logrP(s)6Zs. (1.9)

Применение дифференциальной энтропии открывает возможность относи-

тельной количественной оценки средней неопределенности выборочных про-

странств для непрерывных ансамблей, однако не снимает проблему в целом.

Это отмечал и К. Шеннон. Решение этой проблемы, по-видимому, потребует

новых подходов, одну из основ которых обязательно будет составлять понятие

«средняя взаимная информация».

1.5. Средняя взаимная информация для дискретных ансамблей

1.5.1. Взаимная информация и условная собственная информация

Собственная информация, содержащаяся в сообщении, является, очевидно,

функцией только ансамбля источника. Она может быть интерпретирована либо

как априорная неопределенность сообщения, либо как информация, требуемая

38

для разрешения этой неопределенности. Кажущаяся простота определения соб-

ственной информации (1.4), для чего требуется лишь один отдельный ансамбль,

в свое время ввела в заблуждение многих ученых. В результате этого, неодно-

кратные попытки, предпринятые в литературе для эвристической интерпрета-

ции собственной информации с помощью индивидуального ансамбля, привели

к большой путанице. В частности, исходя из отдельного ансамбля, трудно по-

нять, почему информация и неопределенность не должны быть связаны обрат-

ной зависимостью, а должны быть двумя различными взглядами на одно и то

же явление. Оказалось, что интуитивное понимание собственной информации

практически невозможно в терминах отдельного ансамбля.

Это наглядно проявляется в свете задач телекоммуникации. Пусть собст-

венная информация сообщений, формируемых источником, определяется ан-

самблем U источника с алфавитом А={а1...а£}. Собственная информация сооб-

щений, поступающих получателю, — ансамблем V получателя информации с

алфавитом B={Z>1...Zj^}. Пусть в качестве сообщений рассматриваются буквы,

т. е. Ui=<7fc и Vi=bj . Известно, что при телекоммуникации происходит трансфор-

мация а% в bj. Возникает вопрос: как описать процесс этой трансформации?

Вполне понятно, что в рамках отдельных ансамблей решить эту проблему не-

возможно. Ответ очевиден — необходимо использование понятия совместного

ансамбля UV. Однако, несмотря на эту очевидность, все же остается непонят-

ным: как это возможно осуществить.

По-видимому, для этого необходимо описать процесс телекоммуникации,

используя технологию, вводимую теорией информации. Учитывая, что количе-

ственная мера информации является функцией вероятности, это описание, не-

сомненно, должно основываться на известных вероятностных подходах к ре-

шению задач телекоммуникаций. Анализ этих подходов показывает, что основ-

ной вероятностной характеристикой, описывающей процесс передачи сообще-

ний при телекоммуникации, является так называемая апостериорная вероят-

ность. Апостериорная вероятность pia^/bj) — это вероятность того, что при-

39

нятое сообщение bj явилось следствием передачи сообщения а^. На вероятност-

ном языке (рис. 1.6), процесс передачи сообщения а% понимается как изменение

его вероятности от априорной p(ctk) до апостериорной при появлении на

приеме bj.

передача

РОЦЕСС ПЕРЕДАЧИ

да)ода/Д;

ЕРОЯТЮСТНЫЙ ЯЗЫК

Рис 1.6. Представление телекоммуникации с позиции теории вероятностей

Таким образом, апостериорную вероятность можно трактовать как неопре-

деленность, остающуюся о сообщении а% после приема bj. Переходя на инфор-

мационный язык (рис 1.7), можно считать, что эта неопределенность характери-

зует часть информации передаваемого сообщения ak, которая остается неиз-

вестной после приема сообщения bj. Ее называют условной собственной ин-

формацией и определяют как

J ak/b = log—-—— =-log/?(at/Z> ).

р(ак/Ьк)

(1.10)

Рис 1.7. Представление телекоммуникации с позиции теории информации

Таким образом, условная собственная информация — это информация,

которой не хватает получателю для однозначного определения переданного со-

общения а% по принятому bj. Исходя из этого, количество информации о со-

общении ak, содержащееся в сообщении bj, можно определить как

40

Выражение (1.11) описывает процесс передачи на информационном языке.

Данное описание позволяет придать физический смысл понятию условной соб-

ственной информации как количественной мере потерь информации при теле-

коммуникации (искажения в канале связи). Подстановка (1.4) и (1.10) в (1.11)

позволяет окончательно определить выражение, определяющее фундаменталь-

ное понятие теории информации — понятие взаимной информации.

Взаимная информация — это информация о сообщении содержащаяся

в сообщении Ь/.

v I a,/b )

] = log^ * (1.12)

Вопрос: почему данное понятие формулируется именно как взаимная ин-

формация? Такое название данное понятие получило из-за его симметрии отно-

сительно ак и Ьь следующей из (1.12):

р\ак/ЬЛ P\akbil P\bJak)

;м=log \ /=и =log f

P\ak) PWPybj) Р\ъ^

Определение взаимной информации, как и других понятий, используемых

для описания процесса передачи на информационном языке, невозможно без

использования совместного ансамбля UV.

Совместным ансамблем UV принято называть ансамбль, определяемый:

- совместным выборочным пространством, объединяющим выборочные

пространства отдельных ансамблей (U и V), составляющих совместный ан-

самбль;

- вероятностной мерой, характеризуемой распределением вероятностей

p(dkfy) над совместным выборочным пространством.

1.5.2. Средняя взаимная информация и условная энтропия

Как можно заметить из (1.12), взаимная информация является случайной

величиной, т. е. случайной числовой функцией элементов выборочного про-

странства совместного ансамбля UV. Это довольно необычная случайная вели-

41

чина, так как ее значение зависит от вероятностной меры, однако с ней можно

обращаться так же, как с любой другой случайной величиной. В частности, вза-

имная информация имеет математическое ожидание, дисперсию и моменты

всех порядков.

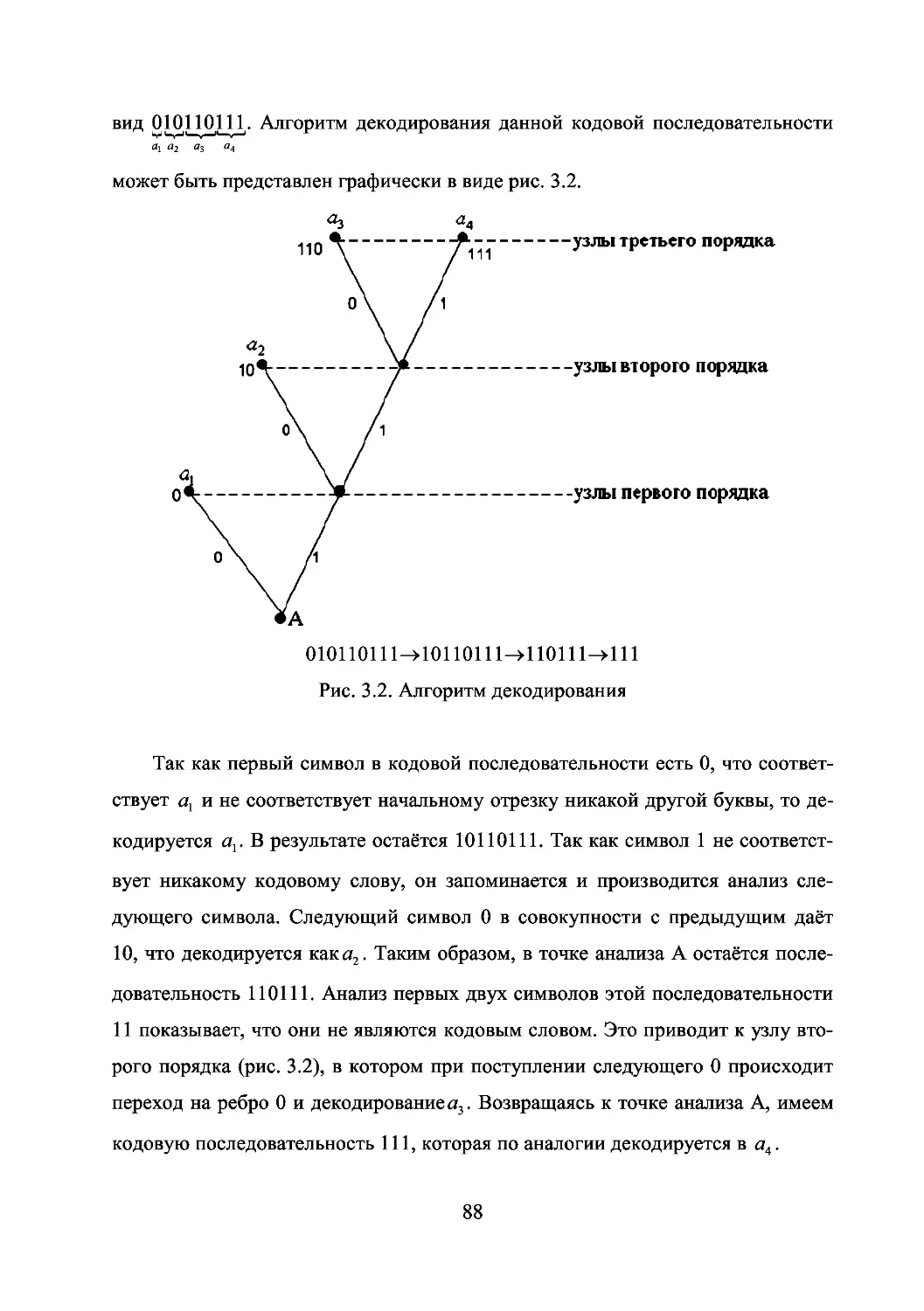

Средней взаимной информацией называется математическое ожидание

взаимной информации:

L N L N р(а Л) )

t[U;V]==ZZXaA)log V А • <113)

4=1 7=1 4=1 У=1 Р\ак)

Необходимо отметить, что средняя взаимная информация является функ-

цией только ансамбля UV, в то время как взаимная информация, которая явля-

ется случайной величиной, — функцией частных исходов а% и bj.

Условная собственная информация также является функцией на совмест-

ном ансамбле UV и имеет математическое ожидание, которое называется ус-

ловной энтропией и обозначается как

H[U/V] = £ ) J[at /*,] = - £ J p(akbj,)logp(at /*,). (1.14)

4=1 j=l 4=1 j=l

С учетом (1.14) выражение (1.13) для средней взаимной информации при-

нимает следующий вид:

I[U;V]=H[U] - H[U/V]. (1.15)

Это равенство показывает, что среднее количество взаимной информации

I[U;V] можно интерпретировать как среднюю неопределенность исхода ан-

самбля U, которая снимается после наблюдения исхода ансамбля V. В данном

случае H[U/V] представляет собой оставшуюся среднюю неопределенность U

после наблюдения V. С другой стороны, учитывая двоякий смысл, который

приобретает энтропия в процессе коммуникации, выражение для средней вза-

имной информации может представляться в виде

I[U; V] = I[U] - I[U/V].

Это позволяет интерпретировать ее, как среднюю информацию об элемен-

тах ансамбля U в элементах ансамбля V. В данном случае средняя условная

42

информация I[U/V] интерпретируется как среднее количество информации,

которого недостает в элементах ансамбля V для полного представления эле-

ментов ансамбля U:

X Z р (аА) 1о§ р !ь,) •

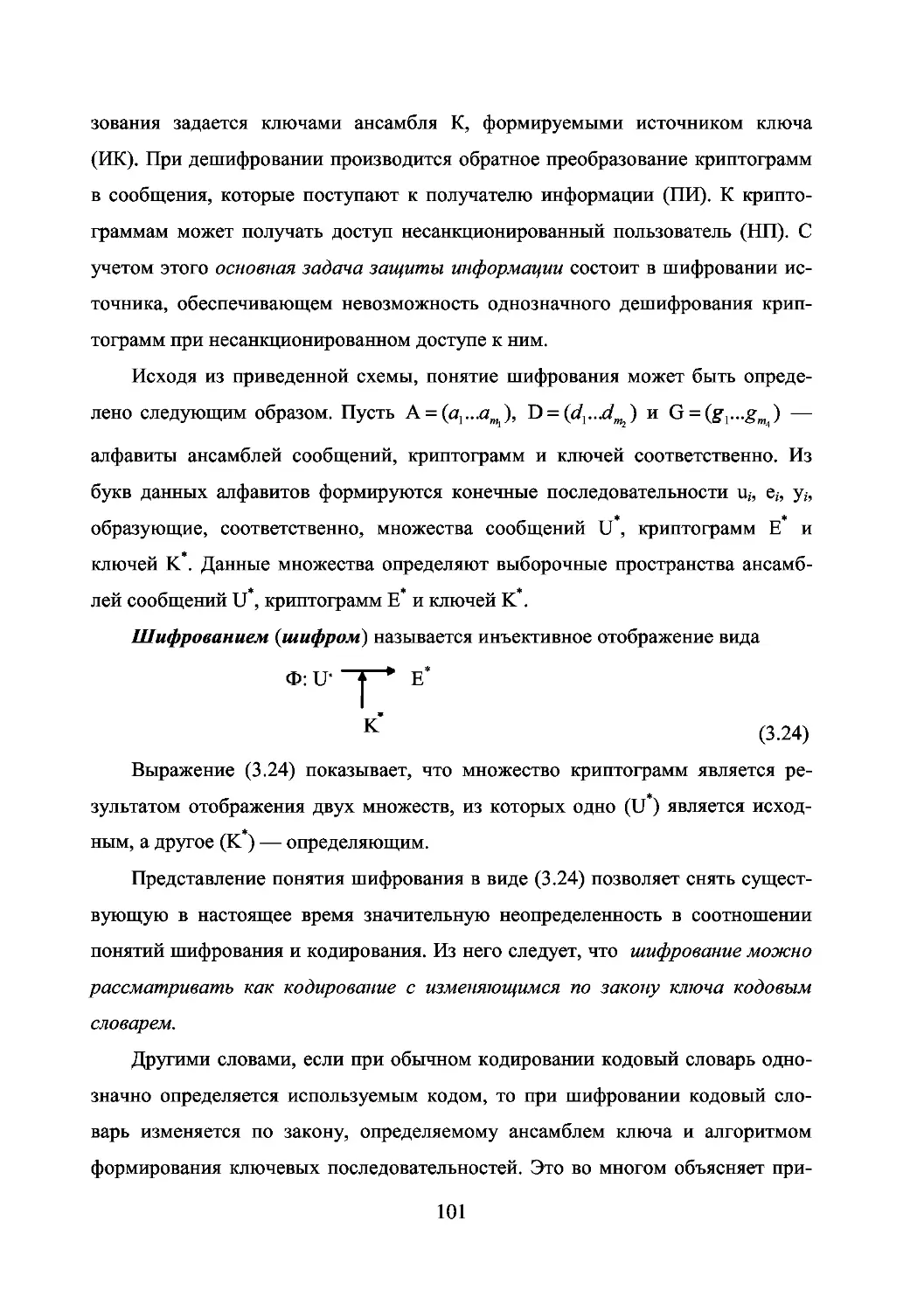

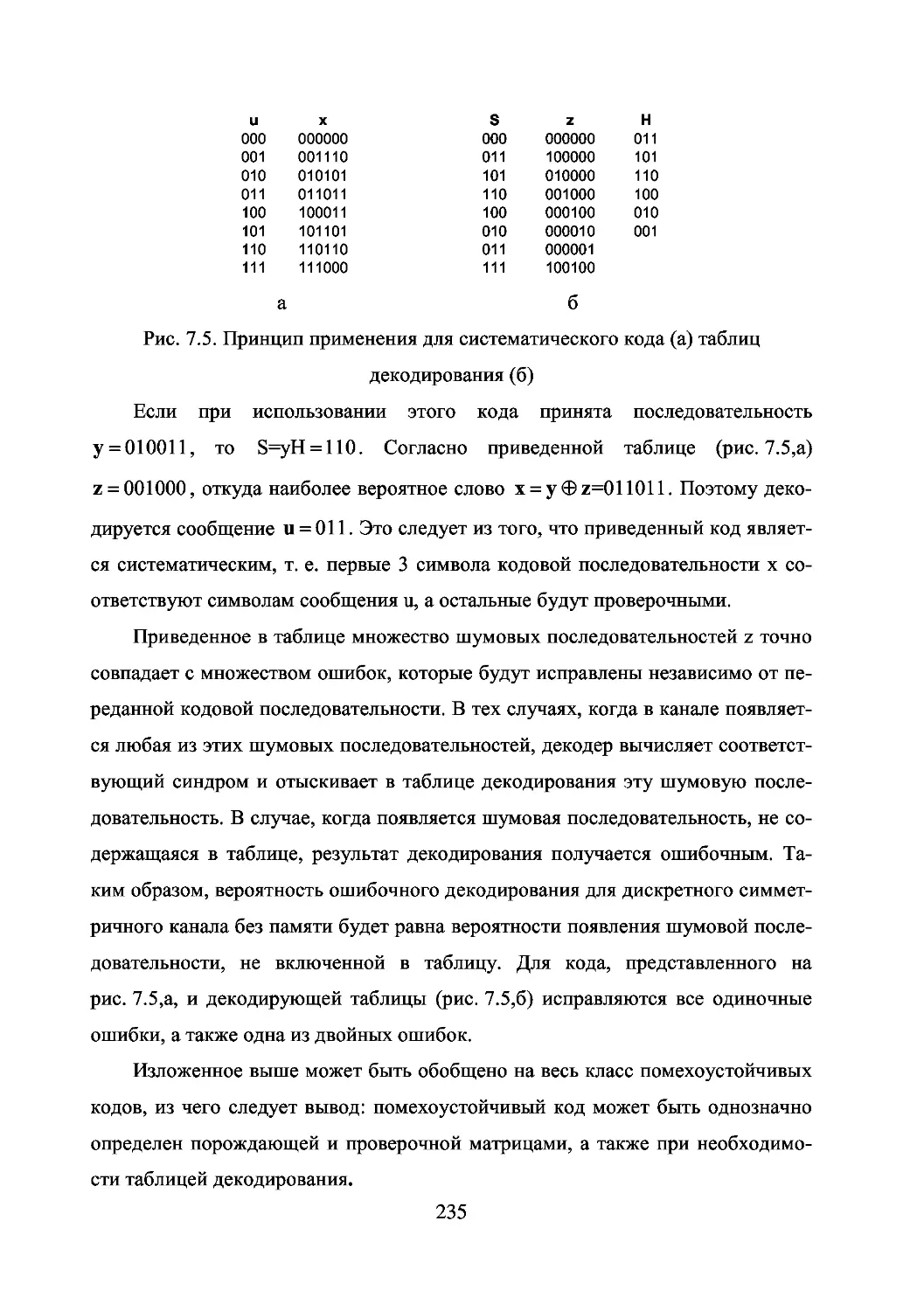

I[u/V] = yy