Author: Березюк Н.Т. Андрущенко А.Г. Мощнцкий С.С.

Tags: компьютерные технологии информатика справочник

Year: 1978

Text

кодирование

информации

ДВОИЧНЫЕ коды

КОДИРОВАНИЕ

ИНФОРМАЦИИ

двоичные коды

СПРАВОЧНИК

Под ред. проф. Н. Т. Березюка

Харьков

Издательство при Харьковском

государственном университете

издательского объединения аВища школа»

1978

6Ф0.1

К57

УДК 681.32

Кодирование информации (двоичные коды). Березюк Н. Т.,

Андрущенко А. Г., Мощнцкий С. С. и др. Харьков. из-

дательское объединение «Вища школа», 1978. 252 с.

В справочнике рассматриваются вопросы кодирования двоичной

информации. Приводятся основные понятия из теории информации и

вычислительной техники. Подробно описываются различные двоич-

ные коды, применяемые в дискретных устройствах переработки ин-

формации, принципыд1Х построения, даны их классификация и срав-

нительные характеристики. Содержатся практические рекомендации

по выбору соответствующих кодов.

. Справочник представляет интерес для инженерно-технических ра-

ботников, нанимающихся разработкой и созданием устройств переда-1

чн информации, вопросами применения вычислительной и инфорыа-j

ционной техники в АСУ.

Табл, 47. Ил. 20. Список лит.1 157 назв.

Рецензент д-р тртн- нюд^пррф Ф 4 Ктгр-оп

|К11ИГА НТБ1

Редакция научно-техническои литературы

Заа. редакцией Л. А. Гаврилова

30502—491 „о

КМ226(04)—78 , 95“78

(^Издательское объединение «Вища школа», 1978,

ПРЕДИСЛОВИЕ

Одна из важнейших научно-технических

проблем на современном этапе — создание автоматизи-

рованных систем управления и контроля для выпол-

’ нения различных задач. В процессе автоматизированно-

го управления и контроля происходит интенсивный обмен

информацией между отдельными частями систем, причем

объем информации, а также скорости обработки и пере-

дачи ее постоянно растут. Все более высокие требования

предъявляются к достоверности передаваемых сообще-

ний, что приводит к необходимости применять специ-

альные меры, снижающие частость появления ошибок до

некоторого допустимого уровня.

Одной из наиболее действенных мер является исполь-

зование помехоустойчивого кодирования. Поэтому во-

просам кодирования уделяется значительное внимание

со стороны советских и зарубежных исследователей и *

инженеров. Появилась необходимость определенной си-

стематизации работ и технических разработок, что, на

наш взгляд, значительно облегчит выбор кодов, схем их

реализации и декодирования при проектировании эле-

ментов цифровой вычислительной техники, дискретных

устройств автоматизированных систем управления. Это

приобретает особое значение в свете решений XXV съез-

да КПСС, где сказано о необходимости «... развивать

производство универсальных и управляющих комплексов,

а

периферийного оборудования, приборов, устройств

регистрации и передачи информации для автоматизиро-.

ванных систем управления технологическими процесса-

ми и оптимального управления в отраслях народного,

хозяйства».

В предлагаемом справочнике приводятся принципы

построения различных кодов. В первой главе даны ос-

новные понятия, касающиеся теории информации и

дискретных систем обработки информации и управления.

Вторая, третья и четвертая главы посвящены анализу

различных кодов, их классификации и сравнительным

оценкам. Рассматриваются преимущественно двоичные

коды, наиболее часто встречающиеся в практике при

проектировании и эксплуатации дискретных устройств.

Пятая глава содержит практические рекомендации по

сравнительному анализу и выбору соответствующих ко-

дов при проектировании дискретных устройств обработ-

ки и передачи информации.

Формулы имеют порядковую нумерацию внутри каж-

дой главы, а рисунки и таблицы — сквозную нумерацию.

Ссылки на литературу даются в квадратных скобках.

Цифры в скобках указывают номер источника из списка

литературы, помещенного в конце книги.

Данный справочник в предлагаемом читателю объеме

не претендует, разумеется, на исчерпывающее освеще-

ние всех вопросов, связанных с кодированием и декоди-

рованием информации.

Авторы выражают благодарность д-ру техн, наук

проф. Ф. А. Каткову, д-ру техн, наук проф. Н. С. Дани-

лину и д-ру техн, наук проф. В. В. Свиридову за ценные

замечания, которые способствовали улучшению содер-

жания книги.

Отзывы и пожелания просим направлять по адресу:

310003, г. Харьков, 3, ул. Университетская, 16, Издатель-

ство при Харьковском государственном университете

издательского объединения «Вища школа».

4

Глава

1

ОБЩИЕ СВЕДЕНИЯ

/

1.1. Двоичная система счисления

Как известно, любое n-разрядное число N

с основанием т может быть представлено в виде суммы:

N = , (1.1)

4=0

где ai — значение разрядного коэффициента i-го разря-

да. Например, число 326 в привычной десятичной форме

можно записать как _ , ,

Таблица 1

3 • 102 + 2 • 10' + 6 - 10° = 326. В двоичной системе счисле- ния основание т = 2, а в каче- Десятич- ное число Двоичное число

1 1

стве значений разрядных коэффи-

циентов используются цифры 0 и 1. 2 10

Число 100110 записывается 3 Й 11 101 111

согласно (1.1) как 7

1.25 + 0 • 24 + 0 • 23 + 1 • 22 -f- 9 13 1001 1101

+ 1 . 2' + 0 • 2°. 15 1111

В табл. 1 приведены примеры записи произвольного

ряда десятичных чисел в двоичной системе счисления.

По сравнению с другими системами счисления в дво-

ичной системе наиболее просто реализуются процессы

выполнения арифметических операций над числами.

В табл. 2 показаны правила выполнения операций сло-

жения, вычитания, умножения и Деления одноразрядных

двоичных чисел.

Довольно часто в двоичной системе применяют так

называемое сложение по модулю два. Знак сложения

в этом случае обозначается ф .

Таблица 2

Сложение Умножение 1 Выч втайне Деление

0+0 = 0 0X0 = 0 0 — 0=0 0| 1 =0

0+1 = 1 1+0=1 1+ 1= 10 0X1=0 1 X 0 = 0 1x1 = 1- 1—0= 1 1 — 1 = 0 0-1=1* 111 = 1

* Занимается 1 из старшего разряда.

Правила сложения по модулю два записываются в

следующем виде:

0ф0=0

0ф1 = 1

1ф0=1 (1.2)

1 ф 1 = 0.

Например, при' сложении по модулю два двоичных

чисел 1101101 и 1001111 получаем

1101101

Ф 1001111

оюоою.

Операция вычитания по модулю два происходит по сле-

дующим правилам:

о-о = о

0—1=1

1—0=1 (1.3)

1 — 1=0.

Сравнивая (1.2) и (1.3), можно убедиться в том, что

обе операции дают один и тот же результат. Поэтому

обычно применяют только операцию сложения по моду»

лю два.

6

В дальнейшем при изложении материала сложение

двоичных чисел .производим только по модулю два. Это

относится также к случаю умножения и деления их, так

как все промежуточные операции выполняются путем

сложения по модулю два. Пример таких арифметических

действий приведен в табл. 3.

Таблица 3

Сложение Умножение Деление

10110 + 1010 11100 10111 X 1010 10111 10111 10010110 100011 ш 111 П01- 110 111 111

1.2. Сведения из теории матриц .

Пусть имеются два равенства, в которых

коэффициенты а^-числа [3,111] fi = «цЫ1 + а12«2; vz =

= «21W1 + «22^2-

Рассматриваемое преобразование характеризуется таб-

лицей коэффициентов которая называется мат-

рицей. Например, для t>i = 1 • U\ 4- Оыг, о2 = Ouj + 1иг

Г1 0]

матрица а равна q । .

Даны два преобразования аир, характеризующиеся

соответственно матрицами

Матрица, определяющая преобразование ар, иначе

говоря, матрица произведения у, имеет вид

Till Т121 _. “llPll + я12р21 «11Р12 + «12P22I

[pi 722J .а21Ри + аггРг] «21Р12 + 0.22^22] •

Легко заметить правило образования элементов ма-

трицы произведения ар на приведенном примере произ-

ведения двух матриц, имеющих по две строки и два

столбца.

Каждый элемент строки матрицы а умножают на

соответствующий элемент столбца матрицы р, и полу-

ченные произведения складывают. Например, элемент

у 12 матрицы произведения, находящийся на пересечении

первой строки и второго столбца, является суммой про-

изведения первого элемента первой строки матрицы а

на первый элемент второго столбца р и второго элемента

той же строки а на второй элемент того же столбца р:

т.—

Понятие произведения двух матриц приложимо не

только к квадратным, ио и к прямоугольным матрицам.

Однако важно отметить, что произведение матриц имеет

смысл только в том случае, если число столбцов одной

матрицы равно числу строк другой.

Если в качестве элементов перемножаемых матриц

служат только символы 0 и 1, то операции умножения

двух прямоугольных матриц производятся по следую-

щим правилам.

1. Матрица произведения должна содержать число

строк и столбцов, равных максимальным числам строк

и столбцов перемножаемых матриц. Например, произве-

дение матриц

15

строк

ац<Х12 . • • . Я]б

(Z21 а22 • • • • ®25

₽11Р12 . . . ₽17

Р21Р22 . . • ₽27

5 строк

X

СЦ51&1Е2 * " •

PBjPsj • • • Р07

5 столбцов

7 столбцов

8

дает матрицу

7ПТ12 . • • Т17

Т21Т22 . . . Т27

• • • • • •

T15J152 • .Т157 1

15 строк.

7 столбцов

2. Каждый столбец матрицы произведения получается

путем сложения по модулю два тех столбцов матрицы,

имеющей наибольшее количество строк, номера которых

совпадают с номерами строк, где расположены единицы

соответствующего столбца матрицы, имеющей наиболь-

шее количество столбцов.

Пример. Умножить матрицу Mt на матрицу М2, где

Mt =

001

010 011 0001111 I

100 М2 = 0110011 1

101 по 111 1010101 1

Первый столбец матрицы произведения равен третьему столбцу

матрицы Mt, так как первый столбец матрицы М2, содержащий

наибольшее число столбцов, равное 7, имеет единицу в третьей

строке. Аналогично второй столбец матрицы произведения будет

равен второму столбцу матрицы Mt в связи с тем, что второй стол-

бец матрицы М2 имеет единицу только во второй строке.

Третий столбец матрицы произведения равен сумме по модулю

два второго и третьего столбца матрицы Mt, так как третий стол-

бец матрицы Ма содержит единицы во второй и третьей строках:

1

О

О 1

1 о

1 1

о

1

1

1 1

О 1

1 О

Аналогично находим остальные четыре столбца матрицы произ-

ведения М. Таким образом получим матрицу М произведения двух

матриц — Mi и Л18:

001 010 Oil 100011111 1010101 0110011 1100110

М = Mi X Ms = 100 X 0110011 = 0001111

101 1010101| 1011010

по 01И100

111 1101001

Рассмотрим прямоугольную матрицу. Общий элемент -

ее atk находится на пересечении строки i и столбца k:

anai2 . . . a-ik • • • ain

алай • . • a-ik • • • ain

®nlan2 • • • • • <Х«л

Элементы а1Ь агг, .... atk.....апп, расположен-

ные по нисходящей диагонали слева направо, образуют

главную диагональ матрицы.

Диагональной называется матрица, все элементы ко-

торой равны нулю, кроме тех, что расположены на

главной диагонали. Например, матрица 0^0 диагональна.

Единичная матрица — это диагональная матрица, все

элементы которой равны 1. Например, матрица в три

100

ою

001

Транспонированной матрицей называют матрицу,

которую можно получить из матрицы а, заменив строки

столбцами. Обозначим ее через а”. Тогда а}* = ац. На-

101

единичная.

столбца и три строки

пример, матрица ат = ПО

010

10

явЛяется транспонированной по отношению к матрице

I ио

* а =011 .

1100

Приведенные сведения ‘о матрицах в дальнейшем

используются при построении кодов.

1.3. Некоторые сведения из теории

вероятности

На практике очень часто приходится

сталкиваться с опытами (испытаниями, наблюдениями,

событиями), дающими различные результаты в зависи-

мости от условий (обстоятельств), которых мы не знаем

или не можем учесть.

Применение математики к изучению таких явлений

опирается на следующую закономерность. Во многих

случаях при многократном повторении одного и того же

опыта в одних и тех же условиях частота появления рас-

сматриваемого результата (т. е. отношение числа опы-

тов, в которых этот результат наблюдался, к общему

числ$ производимых опытов) остается все время пример-

но одинаковой, близкой к некоторому постоянному чис-

лу. Это постоянное число называют вероятностью рас-

сматриваемого события и обозначают буквой Р. Фор-

мула для непосредственного подсчета вероятности имеет

вид [98, 148] Р = , (1.4)

где N— общее число равновозможных и несовместимых

случаев (исходов) ; п — число благоприятствующих слу-

чаев; Р — вероятность совершения благоприятного слу-

чая. Обычно вероятность достоверного события прини-

мается равной единице, а невозможного события — нулю.

Тогда для любого события 0 < Р < 1.

Независимые события — это такие события, иа осу-

ществление одного из которых не влияет осуществление

других. Так, независимы события, состоящие в извлече-

нии черного шара из двух различных урн, содержащих

белые и черные шары. Однако два последовательных

извлечения черного шара из одндй урны (без возвраще-

ния вынутого шара в урну) не представляют собой неза-

висимые события, поскольку результат первого извлече-

ния влияет на число оставшихся в урне черных шаров и,

следовательно, отражается на условиях второго опыта.

Пусть событие А реализуется при П] из Ni равнове-

роятных исходов первого опыта, а независимое от него

событие В — при «2 из N? равновероятных исходов

второго опыта. В этом случае вероятность события А

П. „ П2

равна а вероятность В равна —.

сложный опыт, состоящий в том, что производятся оба

наши опыта. Очевидно, что данный сложный опыт может

иметь NiN? различных равновероятных исходов, посколь-

ку каждому из М исходов первого опыта могут отве-

чать Л^2 различных исходов второго опыта. Из этих NiN2

равновероятных исходов сложному событию АВ будут

благоприятствовать П!«2 исходов, которые получаются,

если комбинировать nt исходов первого опыта, благо-

приятствующих событию Д, с «2 исходами второго

опыта, благоприятствующими событию В. Такимобразом,

а Л.Пл rt1 ^2

вероятность события АВ выразим как • —

и, значит, Р (АВ) = Р (Л) Р (В). (1.5)

Эту формулу можно обобщить следующим образом.

Пусть Ль Д2, ... , Ak— какие-то k взаимно независи-

мые события. В этом случае

РИь .............ДЛ)=Р(Д1)Р(Д2)... P(Ak). (1.6) *

12

Если события зависимы, то после наступления одного

из них, например А, вероятность другого будет отли-

чаться от его вероятности Р(В), вычисленной без учета

наступления события А. Вероятность события В при

условии, что уже произошло событие Л, называют услов-

ной вероятностью и обозначают Ра(В) или Р(А/В).

Поэтому формула для вероятности одновременного на-

ступления двух зависимых событий должна быть запи-

сана в виде [148]

Р (А, В) = Р (А) РА (В). (1.7)

Например, вероятность вынуть два белых шара из

урны, в которой находятся два белых и три черных шара,

равна произведению вероятности вынуть белый шар

первый раз (событие Д) на вероятность вынуть белый

шар второй раз (событие В) при условии, что первым

был белый шар (произошло событие Д), т. е. Р (Д, В) =

= 24 • = Vio- Из формулы (1.7) следует выражение

^(В) = ^^-. (1.8)

1.4. Элементы теории информации

В природе многие процессы связаны с

передачей, преобразованием и хранением, информации.

Обычно под информацией понимаются те новые сведе-

ния об окружающем мире, которые мы получаем в ре-

зультате взаимодействия с ним, приспосабливаясь к

нему и изменяя его в этом процессе приспособления.

Комитетом научно-технической терминологии Академии

Наук СССР рекомендуется следующее определение:

«Информация — это сведения, являющиеся объектом

хранения, передачи и преобразования».

Во многих случаях нужно уметь определять количе-

ство информации. В 1927 г. Р. Хартли (Англия) пред-

ложил и обосновал количественную меру информации,

которая явилась отправной точкой теории информации.

Эта мера информации записывается так [43, 124]:

I = logN, (1.9)

где I — количество информации; N — общее число сооб-

щений, которое может быть составлено из п элементов,

каждый из которых имеет т возможных состояний,

т. е. N =тп.

Формулу (1.9) можно представить в виде

I—n\ogm. (1.Ю)

Наиболее удобен выбор основания логарифма, рав-

ного двум. При этом за единицу количества информации

принято считать информацию сообщения, содержащего

один элемент (п=1), который может принимать два

равновероятных состояния (т=2). Действительно,

1=1 • log22=l бит (дв. ед).

В случае одинаковой вероятности всех сообщений N,

вероятность каждого сообщения

Р = Мл. (1.11)

Тогда количество информации можно выразить через

вероятности поступления сообщений:

/ = 10g2 N = log2 -р- = — log2 Р . (1.12)

Если сообщения неравновероятны и независимы друг

от друга, то пользуются понятием средней информа-

т

ции [46]: /ср =— n^Pilo&Pt, где Pi— вероятность

1-го сообщения.

Средняя информация на один элемент сообщения

называется энтропией:

Я* _ SP{log2Pt. (1.13)

Величина Н представляет собой меру беспорядочно-

сти состояния источника сообщений и характеризует

среднюю степень^ неопределенности состояния этого

источника. В случае, когда все т различных состояний

источника равновероятные, т. е. А = х1т , энтропия

максимальна:

т

~ log2 ± = - т ± log2 ± = log,m.

4=1

(1.14)

Если сообщения неравновероятны, среднее количест-

во информации, содержащееся в одном сообщении, будет

Пример. Пусть передается текст,

в котором использованы 32 буквы

алфавита (N = 32). Если все буквы

равновероятны н вероятность появле-

ния любой из букв не зависит от

предыдущего текста, количество ин-

формации, приходящееся на одну

букву,

^мако = lo62w = log232 = 5 бит.

Пример. Имеем источник сообще-

ний» с двумя состояниями (W = 2).

— вероятность одного состояния;

Р3— вероятность другого состояния.

Тогда, учитывая, что /\-|-Р8 = 1, по,

Рис. 1. Энтропия Н в слу-

чае возможных состояний с

вероятностями Pi и 1 -Pf.

я =— 2 pt ад = - [A log./*! + (1 - (ад)1 • о-15)

<=1

Задаваясь величиной Р± = 0-т-1, можно вычислить H — Из

рис. 1, где приведена эта зависимость, видно, что знтропия макси-

мальна, если Pi = Р2 = 0,5, т. е. когда оба события равновероятны.

Энтропия, а следовательно, и количество информации

равны нулю (Я=0), когда А=0 или Pi=l. Действи-

тельно, если достоверно известно одно из состояний

источника, то сообщение об этом не несет никакой ин-

формации. Количество информации, определяемое по

формуле (1.15), представляет собой среднее количество

информации, приходящееся на один элемент сообщения.

В общем случае, когда вероятности отдельных состо-

яний разные и взаимозависимые, количество информа-

ции определяется формулой, выражающей условную

энтропию [46, 114]:

т т

<!, i) iog2P/(0. (1.16)

i=l z=l

где P (i, I) — совместная вероятность t-го и /-го. состоя-

ний; P/(t) — вероятность t-ro состояния при условии,

что ему предшествовало j-e состояние.

1.5. Структурная схема передачи

информации

Специфика различных областей примене-

ния систем передачи информации требует различного

подхода к реализации таких систем. Система передачи

по телефонным каналам связи, например, совершенно

не похожа на систему космической связи или тропосфер-

ной ни по техническому исполнению, ни по параметрам.

Однако в принципах построения и назначении отдель-

ных устройств самых разных систем много общего'. В об-

щем случае схема системы передачи информации пока-

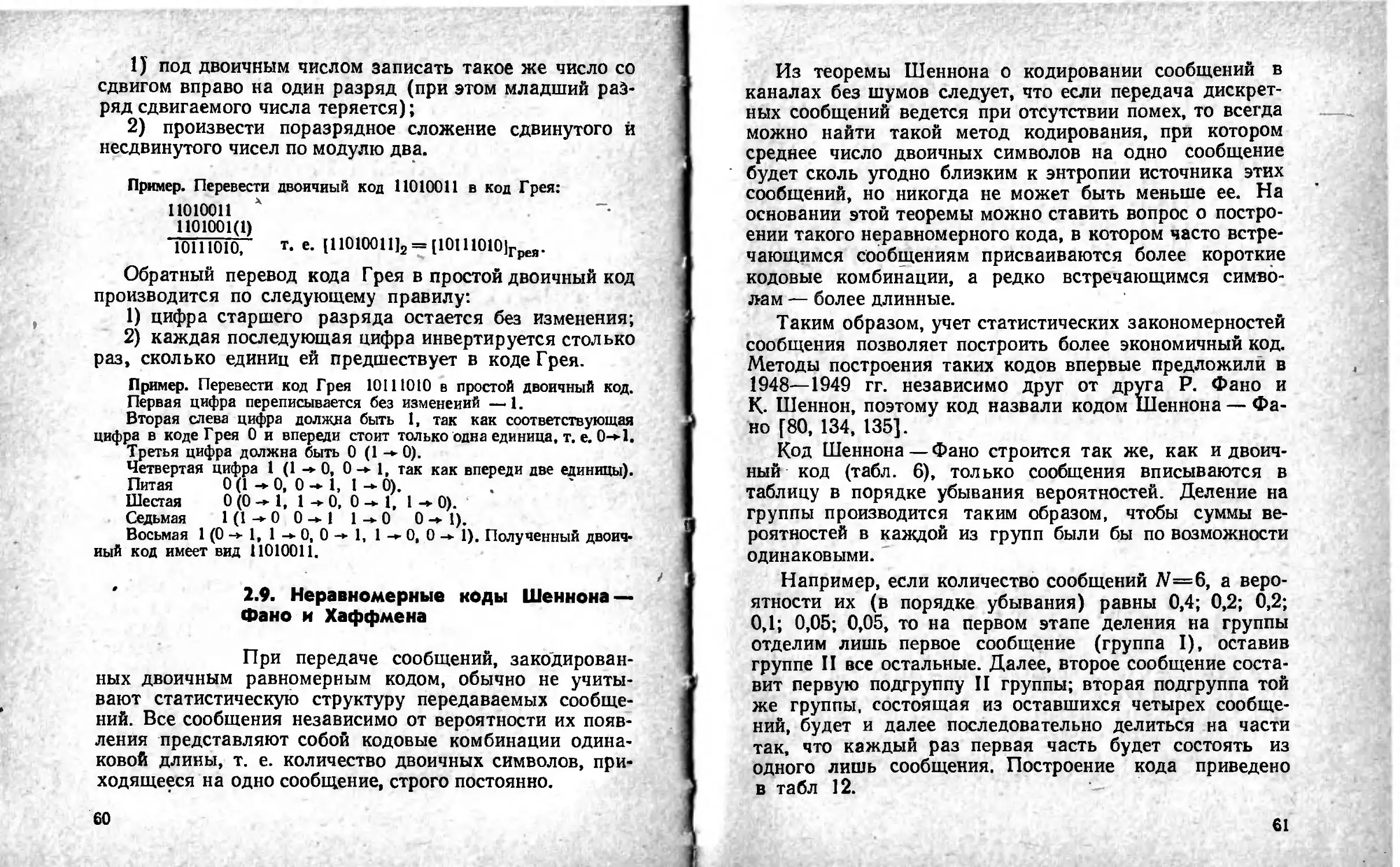

зана на рис. 2 [109, НО, 136, 146, 147].

Можно передавать самые различные по физической

природе сообщения: цифровые данные, полученные от

ЭВМ, речь, тексты телеграмм, команды управления,

результаты измерений различных физических величин.

Естественно, что все эти сообщения предварительно

должны быть преобразованы в электрические колебания,

сохраняющие все свойства исходных сообщений, а затем

унифицированы, т. е. представлены в форме, удобной

для последующей передачи. Под источником информации

на рис. 2 понимается устройство, в котором выполнены

все названные нами ранее операции.

Для более экономного использования линии связи,

а также для уменьшения 'влияния различных помех и

искажений пе^даваемая от источника информация мо-

жет быть в дальнейшем преобразована с помощью

Рис. 2. Структурная схема передачи

информации.

кодирующего устройства. Это преобразование, как пра-

вило, состоит из ряда операций, включающих учет ста-

тистики поступающей информации для устранения избы-

точности (статистическое кодирование), а также введе-

ние дополнительных элементов для уменьшения влияния

помех и искажений (помехоустойчивое кодирование).

В результате ряда преобразований на выходе коди-

рующего устройства образуется последовательность эле-

ментов, которая с помощью передатчика преобразуется

в форму, удобную для передачи по линии связи. Линия

связи — это среда, по которой происходит передача сиг-

налов от передатчика к приемнику. Учет влияния среды

необходим. В теории передачи информации часто встре-

чается понятие «канал связи» — это совокупность

средств, обеспечивающих передачу сигналов.

На вход приемника, кроме сигналов, прошедших сре-

ду, попадают также различные помехи. Приемник выде-

ляет из смеси сигнала и помех последовательность, кото-

рая должна соответствовать последовательности на

выходе кодирующего устройства. Однако из-за действия

помех, влияния среды, погрешностей различных преоб-

разований полное соответствие получить невозможно.

Поэтому такая последовательность вводится в декоди-

рующее устройство, которое выполняет операции по ее

преобразованию в последовательность, соответствующую

переданной. Полнота этого соответствия зависит от ряда

факторов: корректирующих возможностей кодированной

последовательности, уровня сигнала и помех, а также их

статистики, свойств декодирующего устройства. Сформи-

рованная в результате декодирования последователь-

ность поступает к получателю информации. Естественно,

что при проектировании систем передачи информации

всегда стремятся обеспечить такие условия работы, что-

бы отличие информации, получаемой от источника, от

информации, передаваемой получателю, было невелико

и не превышало некоторой допустимой величины. В дан-

ном случае основным показателем качества передачи

является достоверность передачи информации — степень

соответствия принятого сообщения переданному [5, 6].

Численно достоверность передачи информации харак-

теризуется коэффициентом ошибок:

N

Яош=-^. (1.17)

где NOm — количество неверно принятых сообщений; N —

общее количество переданных сообщений.

При увеличении N коэффициент ошибок стремится

к вероятности ошибочного приема или просто к вероят-

ности ошибки:

N

РОш = Ит-^. (1.18)

Л

1.6. Помехи и ошибки в каналах связи

При передаче по каналу связи информа-

ция подвергается воздействию различного рода помех:

широко известные флуктуационные, гармонические и

импульсные помехи.

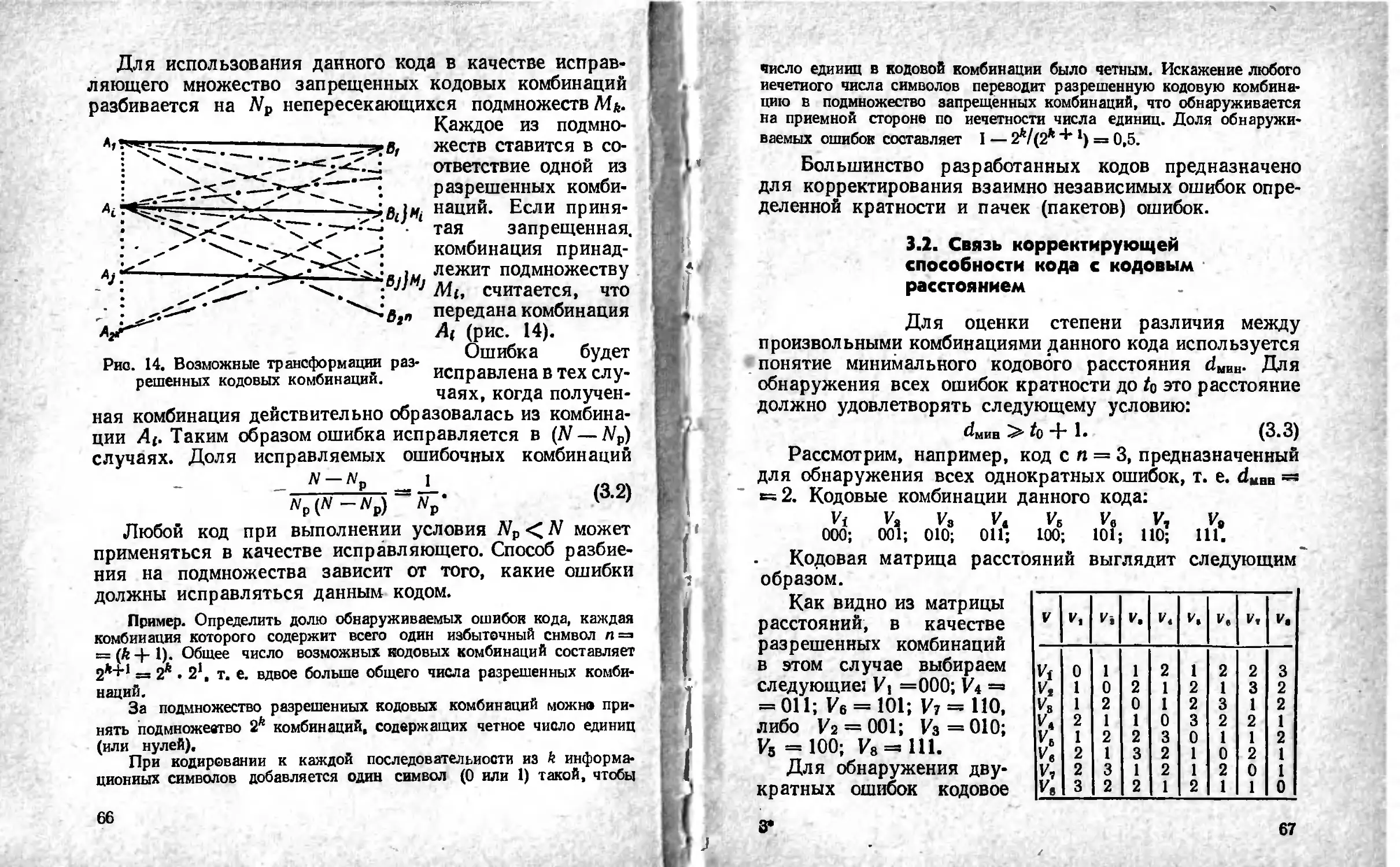

Рис. 3. Различные виды помех.

Флуктуационная помеха представляет собой напря-

жение, меняющееся во времени случайным образом

(рис. 3, а). Причина появления ее—тепловые шумы

линии, элементов аппаратуры и т. д. Гармоническая по-

меха (рис. 3,6) приближенно описывается синусоидаль-

ным колебанием: t/noM=Vsin(co/+<p)- Эти помехи возни-

кают, как правило, в самой аппаратуре из-за паразитного

проникновения в канал различных несущих колебаний.

Импульсной помехой называется помеха, пиковое

значение которой соизмеримо с амплитудой полезного

сигнала или превышает ее. Типичный вид одиночной

импульсной помехи показан на рис. 3, в. Импульсные

помехи обычно появляются пачками, по нескольку помех

в пачке (рис. 3, е). Характер процесса появления пачек

во времени и отдельных помех внутри одной пачки

существенно изменяется от канала к каналу и даже в

одном канале в различные периоды времени [16—18, 33,

48, 50, 115, 116, 120, 121].

По типу источников импульсные помехи можно раз-

делить на три основные группы: естественного проис-

хождения, промышленные, возникающие в аппаратуре.

К помехам естественного происхождения в первую

очередь следует отнести атмосферные помехи, основным

источником которых являются грозовые разряды, хаоти-

чески возникающие во многих участках земного шара.

Каждый такой разряд создает несколько мощных им-

пульсов электрического тока.

Источники промышленных помех многочисленны.

К ним относятся различные коллекторные электрические

машины, двигатели, аппараты, линии электропередачи,

электросварка.

Кроме классификации Помех по характеру воздейст-

вия на передаваемое сообщение, их классифицируют по

поведению во времени. Флуктуационные и гармониче-

ские помехи действуют непрерывно в течение длинных

отрезков времени. Их можно назвать постоянно дейст-

вующими. В отличие от них импульсные помехи дейст-

вуют на сигнал только в отдельные моменты. Помехи

такого типа называются сосредоточенными во времени.

В результате действия помех в канале связи инфор-

мация, передаваемая по этому каналу, искажается, при-

нятое сообщение будет отличаться от переданного, т. е.

сообщение принимается с ошибкой. Возникновение оши-

бок— случайный процесс, и предсказать появление их

заранее, до эксперимента, можно только статистически,

т. е. указывая вероятности того, что ошибка либо

произойдет, либо нет. При этом вероятность ошибки

может не зависеть от значения передаваемого элементар-

ного символа 0 или 1, т. е. среди неправильно принятых

сигналов одинаково часто встречаются как 1, так и 0.

20

Канал связи с такими ошибками называется симметрич-

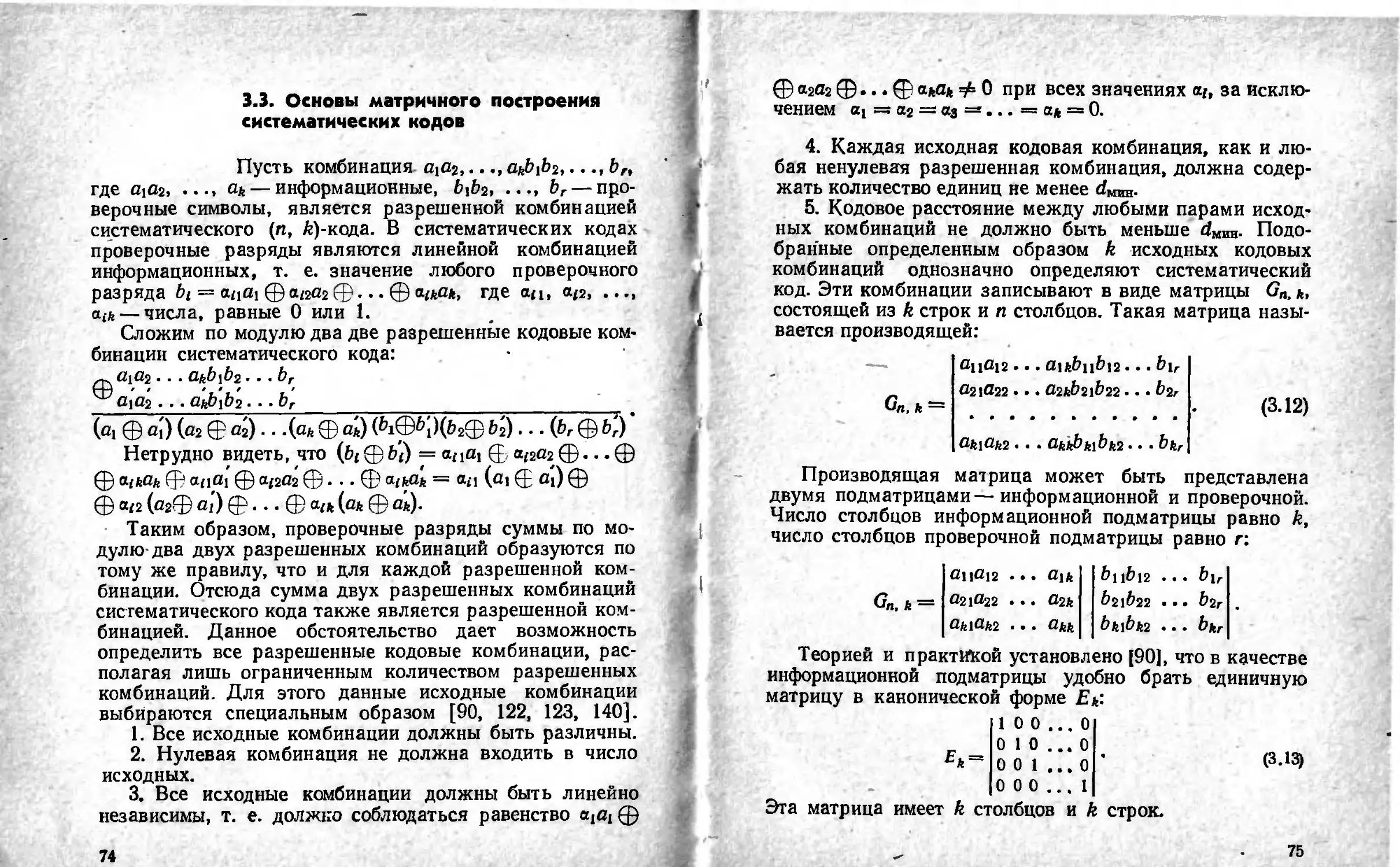

ным каналом. Условно такой канал показан на рис. 4.

Здесь входными являются символы 0 и 1. Возможными

выходными символами также будут 0 и 1. Вероятности

Pi, Р2 определяют вероятность неискаженной передачи

Рис. 4. Канал с искажениями символов 0 и 1.

Рис. 5. Канал со стиранием символов.

символов 0 и 1 соответственно, а вероятности (1 — Pi),

(1—Р2)—вероятность трансформации символов. При

Р1==Р2 канал является симметричным.

Другим примером канала связи с помехами может

служить так называе-

мый канал со стирани-

ем (рис. 5). На вход

такого канала поступа-

ют двоичные символы,

которые с вероятно-

стью Р передаются

правильно и с вероят- „ _ „

г Рис. 6. Канал со стиранием и тран-

НОСТЫО (1 Р) СТИра- сформацией символов.

ются (стертые симво-

лы условно обозначены через х). Таким образом, если

на вход канала поступают символы 0 и 1, то на выходе

получаются три различных символа: 0, 1, х. В этом

канале предполагается отсутствие трансформации сим-

21

ГЧ.Ч

волов. Такое предположение на практике не всегда

оправдывается. Поэтому используется модель стираю-

щего канала, в которой допустима трансформация сим-

волов (рис. 6). Если условия передачи ряда последова-

тельных символов не зависят один от другого, то такой

канал называется каналом без памяти. Если же условия

передачи символа зависят от предыдущих состояний

канала, канал называется каналом с памятью.

Экспериментальные исследования каналов связи [16,

60, 67, 69, 74], произведенные в СССР и за рубежом, по- ,

казали, что ошибки символов при передаче по каналу

связи, как правило, группируются в пачки (пакеты)

различной длительности.

Пачкой ошибок называется участок последовательно-

сти, начинающийся и кончающийся ошибочно приняты-

ми элементами. Внутри пачки могут быть и правильно

принятые элементы. Например, если в процессе передачи

последовательности 0110100111 последняя приобретает

вид 0010101001, то говорят, что она поражена пачкой

ошибок длиной в восемь разрядов. Здесь поражены вто-

рой, седьмой, восьмой и девятый разряды.

Сказанное ранее позволяет сделать вывод о том, что

в результате действия помех в каналах связи при пере-

даче сообщений возникают ошибки. В зависимости от

количества разрядов передаваемой последовательности,

принимаемых с ошибками, различают однократные, дву-

кратные и т. д. ошибки. Кроме этого имеют место пачки

ошибок. Знание характера распределения ошибок в ка-

нале связи позволяет правильно выбрать метод пере-

дачи сообщений по данному каналу.

Если ошибки, возникающие в передаваемом сооб-

щении, происходят независимо одна от другой, их рас-

пределение подчиняется биномиальному закону. В этом

случае предполагается, что вероятность поражения каж-

дого символа рэ передаваемой последовательности явля-

ется величиной постоянной. Тогда вероятность безоши-

22

бочного его приема—(1—рэ), а вероятность распре-

деления ошибок при передаче последовательности из п

символов Р = 5С^рэ(1—Рз)п~‘, (1-19)

г=о

где i — кратность ошибки в последовательности; С„ —

число сочетаний из п по i,

qI n(n—1) (и —2) , .(n—1) (120)

Каждый член суммы С1п р‘э (1—р9)"—г в формуле (1.19)

характеризует вероятность появления /-кратной ошибки

в передаваемой последовательности [31].

Для упрощения расчетов по формуле (1.19) в табл. 4

приведены значения функции (1 —рэу для часто встре-

чающихся значений р„ и i, в табл. 5 — значения Сп-

Т аб л и ц а 4

1 Рэ

IO-’ 10—3 Ю—4 Ю-5

1 0,99000000 0,99900000 0,99990000 0,99999000

2 0,98010000 0,99800100 0,99980001 0,99998000

3 0,97029900 0,99700300 0,99970003 0,99997000

4 0,96059601 0,99600600 0,99960006 0,99996000

5 0,95099005 0,99500999 0,99950010 0,99995000

6 0,94148015 0,99401498 0,99940015 0,99994000

7 0,93206535 0,99302097 J 0,99930021 0,99993000

8 0,92274470 0,99202795 0,99920028 0,99992000

9 0,91351725 0,99103592 0,99910036 0,99991000

10 0,90438208 0,99004488 0,99900045 0,99990001

11 0,89533825 0,98905484 0,99890055 0,99989001

12 0,88638488 0,98806578 0,99880066 0,99988001

13 0,87752102 0,98707772 0,99870078 0,99987001

14 0,86874581 0,98609064 0,99860091 0,99986001

15 0,86005836 0,98510455 0,99850105 0,99985001

16 0,85145777 0,98411944 0,99840120 0,99984001

17 0,84294319 0,98313532 0,99830136 0,99983001

23

Таблица 5

n

i 1 2 3 4 5 6 7 8 9 10 и 12 13 14 15 16 17

1 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17

2 — 1 3 6 10 15 21 28 36 45 55 66 78 91 105 120 136

3 — 1 4 10 20 35 56 84 120 165 220 286 364 455 560 680

4 — — — 1 5 15 35 70 126 210 330 495 715 1001 1365 1820 2380

5 — — — — 1 6 21 56 126 252 462 792 1287 2002 3003 4368 6188

6 — 1 7 28 84 210 462 924 1716 3003 5005 8008 12376

7 1 8 36 120 330 792 1716 3432 6435 . 11440 19448

8 — — - — — — — 1 9 45 165 495 1287 3003 6435 12870 24310

9 1 10 55 220 715 2002 5005 11440 24310

10 — 1 И 66 286 1001 3003 8008 19448

11 — — — — — — — — — — 1 12 78 364 1365 4368 12376

12 — — — — —- — — — — — — 1 13 91 455 1820 6188

13 — — — — — — — — — — — — 1 14 105 560 2380

14 — — — — — — — — — — — — — 1 15 '120 680

15 — — — — — — — — — — — — — 1 16 136

16 — — — — — — — — — — — — — — 1 17

17 — — — / — — — — — — — — — — — — 1

Продолжение табл. 5

i п

18 19 20 21 22 23 24

1 2 18 19 20 21 22 23 24

153 171 190 210 231 253 276

з 816 969 1140 1330 1540 1771 2024

4 3060 3876 4845 5985 7315 8885 10626

5 8568 11628 15504 20349 26334 33649 42504

6 18564 27132 38760 54264 74613 100947 134596

7 31824 50388 77520 116280 170544 245157 346104

8 43758 75582 125970 203490 319770 490314 735471

9 48620 92378 167960 293930 497420 817190 1307504

10 43758 92378 184756 352716 646646 1144066 1961256

11 31824 75582 167960 352716 705432 1352078 2496144

12 18564 50388 125970 293930 646646 1352078 2704156

13 8568 27132 77520 203490 497420 1144066 2496144

14 3060 11628 38760 116280 319770 817190 1961256

15 816 3876 15504 54264 170544 490314 1307504

16 153 969 4845 20349 74613 245157 735471

17 18 171 1140 5985 26334 100947 346104

18 1 19 190 1330 7315 33649 134596

19 1 20 210 1540 8885 42504

20 1 21 231 1771 10626

21 22 23 •— *—• ь—> »— 1 22 1 253 23 1 2024 276 24 1

24 1—— •—

Ш С'» Q Г'. — С

СО СО 00 LQ О СЧ

GN —' Г- CD CD —I

Продолжение табл.

4060

26

Следует отметить, что в реальных условиях ошибки,

появляющиеся в передаваемой информации, в большин-

стве случаев являются зависимыми (коррелированными)

и сгруппированы в пачки. Результаты эксперименталь-

ных исследований показали, что время группирования

ошибок в пачки составляет ничтожные доли всего вре-

мени передачи, но в течение этого времени сосредото-

чено наибольшее число ошибок. В интервалах же между

пачками возникают редкие независимые ошибки [66, 72,

102]. Поэтому оценка качества связи на основе биноми-

ального закона распределения ошибок является прибли-

женной. Законы распределения ошибок в каналах свя-

зи изучают преимущественно экспериментальным путем

и на основании этого создают математические модели

каналов связи.

1.7. Передача информации по каналу

без помех

Если через канал связи без помех пере-

дается последовательность дискретных сообщений дли-

тельностью Т, то предел отношения [46]

lim -sr = V [бит/cj, (1-21)

где 1 — количество информации, содержащейся в после-

довательности сообщений (скорость передачи информа-

ции по каналу связи). Предельное значение скорости

передачи информации называется пропускной способ-

ностью канала связи:

С = Уиако - Нп> [бит (дв. ед.)7с]. (1.22)

Как известно, количество информации в сообщениях

максимально при равной вероятности состояний. Тогда

(1.23)

Скорость передачи информации в общем случае за-

висит от статистических свойств сообщения и.параметров

27

канала связи. Пропускная способность — это характери-

стика канала связи, которая не зависит от скорости пере-

дачи информации. Количественно пропускная способ-

ность канала связи выражается максимальным количе-

ством двоичных единиц информации, которое данный

канал связи может передать за одну секунду.

Для наиболее эффективного использования канала

связи необходимо, чтобы скорость передачи информации

была как можно ближе к пропускной способности кана-

ла связи.

Если скорость поступления информации на вход

канала связи превышает пропускную способность кана-

ла, то по каналу будет передана не вся информация, т. е.

должно выполняться условие

У<С. (1.24)

Это основное условие согласования источника инфор-

мации и канала связи. Согласование осуществляется

путем соответствующего кодирования сообщений. Дока-

зано, что, если скорость информации, вырабатываемой

источником сообщений, достаточно близка к пропускной

способности канала [137, 138], т. е. VH=C — е, где е —

сколь угодно малая величина, всегда можно найти такой

способ кодирования, который обеспечит передачу сооб-

щений, вырабатываемых источником, причем скорость

передачи информации будет весьма близка к пропуск-

ной способности канала.

Обратное утверждение заключается в том, что невоз-

можно обеспечить длительную передачу всех сообще-

ний, если поток информации, вырабатываемый источни-

ком, превышает пропускную способность канала.

Если ко входу канала подключен источник сообщений

с энтропией на символ, равной пропускной способности

канала связи, считается, что источник согласован с ка-

налом. Если энтропия источника меньше пропускной

способности канала, что может быть в случае неравно-

вероятности состояний источника, то источник не согла-

28

сован с каналом связи, т. е. канал используется не пол-

ностью.

Согласование в статистическом смысле достигается

с помощью так называемого статистического кодирова-

ния. Для уяснения принципа статистического кодирова-

ния рассмотрим две последовательности сообщений,

представляющие, например, записанные через равные

промежутки времени сигналы о состоянии двухпозицион-

ного контролируемого объекта (включен или выключен):

110010111101000111010100010100

001000000011000000000000000000.

Символу 1 соответствует сигнал «объект включен»,

символу 0 — «объект выключен». Будем считать, что

символы появляются независимо один от другого.

Для первой последовательности символы 1 и 0 равно-

вероятны, для второй — вероятность первого символа

/^=0,1, второго символа— 1 — Pi=0,9.

Энтропия первой последовательности (1.13) Ht =

=—2 • 0,5 log2 0,5=1. Энтропия второй последователь-

ности Н2=—0,1 logzO, 1—0,9 log2 0,9 ~ 0,5. Следователь-

но, количество информации на символ во второй после-

довательности в два раза меньше, чем в первой.

При передаче последовательностей через бинарный

канал связи с C=log2m дв. ед./символ = 1 дв. ед./символ

первая последовательность будет согласована с каналом

в то время как при передаче второй последо-

вательности пропускная способность двоичного канала,

на символ в два раза больше энтропии источника, т. е.

канал недогружен и в статистическом смысле не согла-

сован с источником (С > Н2).

Статистическое кодирование позволяет повысить

энтропию передаваемых сообщений в пределе до вели-

чины, которая получается, если символы новой последо-

вательности равновероятны. При этом число символов в

последовательности будет сокращено. В результате

29

источник информации согласуется с каналом связи. Тех»

ника такого кодирования изложена в § 2.9.

1.8. Передача информации по каналу

с помехами

При передаче информации через канал

с помехами сообщения искажаются и на приемной сто-

роне нет полной уверенности в том, что принято именно

то сообщение, которое передавалось. Следовательно,

сообщение недостоверно, вероятность его после приема

не равна единице.

В этом случае количество получаемой информации

уменьшается на величину неопределенности, вносимой

помехами, т. е. определяется как разность энтропии

сообщения до и после приема: I = Н (J) — Ht (0, где

Н (i) — энтропия источника сообщений; Н/ (i) — энтро-

пия сообщений на приемной стороне. Уменьшение коли-

чества получаемой информации вследствие действия по-

мех рассмотрим на примере передачи сообщений о состоя-

нии двухпозиционного контролируемого объекта (включен,

выключен).

Пусть вероятности включенного и выключенного со-

стояния соответственно равны: Pi=P2=0,5. Вероятность

того, что при передаче состояния свыключено» прини-

мается информация о включенном состоянии, Р,(2) =

=0,01. Соответственно другие условные вероятности

следующие: Рг(2)=0,99; /,2(1)=0,01; Pi(l)'=0,99, где

величина Pi (/) — условная вероятность того, что при

передаче /-го сообщения будет принято сообщение I.

Вычисленная по формулам (1.13), (1.16) с учетом (1.8)

энтропия Hi = 1; Ht (j) = Ht (i) = 0,081.

Таким образом, за счет вносимых помех количество

информации уменьшается: Г =Ht — /7; (i) = 1 — 0,081 =

= 0,919 [бит]. Разделив I на время Т передачи одиноч-

30

ного сообщения, получим выражение для скорости пере-

дачи по каналу связи с помехами:

Г = hm _ = lira _£------!_1.

7,00 7 7,00 T

Пропускной способностью канала с шумами назы-

вается максимальная скорость передачи информации иа

символ или в единицу времени при условии, что канал

связи без помех согласован с источником информации:

С = Умако = НШ /цако/7.

Т-* «м

Если энтропия источника информации не превышает

пропускной способности канала Н < С, то существует

код, обеспечивающий передачу информации через канал

с помехами со сколь угодно малой частотой ошибок или

сколь угодно малой недостоверностью. В работе [1371

определена пропускная способность канала связи при

ограниченной средней мощности аналогового сигнала:

C = Fm log2 (1 + Гв/№ш),

где Fm— полоса частот канала; IF, — средняя мощность

сигнала; — средняя мощность помех (равномерный

спектр) с нормальным законом распределения амплитуд

в полосе частот канала связи.

Следовательно, можно передавать информацию по

каналу с помехами без ошибок, если скорость передачи

информации

V < С = Fm log2^1 +

Для скорости V > С при любой системе кодирования

частота ошибок конечная, причем она быстро растет

с увеличением V-

Из последнего выражения следует, что для канала

с весьма высоким уровнем шумов максималь-

ная скорость передачи близка к нулю. При

Умако= Fm loggU^/lV^. Максимальное количество информа-

ции, передаваемое за время Т, УМаквТ= FmTlo&WJWш=

c=FmTh (объем сигнала).

31

Глава неизбыточные коды

2

2. 1. Кодирование информации.

Основные понятия

В технике особую роль приобрели прео-

бразования дискретной информации, так как многочис-

ленные исследования показали, что в реальных услови-

ях непрерывный сигнал без потерь для качественных ха-

рактеристик функционирования системы может быть за-

менен дискретным сигналом. Дискретные представления

информации все более широко распространяются при

передаче и обработке информации. Формой представле-

ния информации является сообщение [85].

Процесс преобразования сообщений в комбинации из

дискретных сигналов называется кодированием; сово-

купность правил, в соответствии с которыми производят-

ся данные преобразования,— кодом.

Каждая комбинация записывается в виде последова-

тельности, составленной из некоторых условных симво-

лов — элементов кодовой комбинации. В качестве эле-

ментов кодовой комбинации могут использоваться буквы

(Л, В, С...) и цифры (0, 1,2...).

В технических информационных устройствах элемен-

тами могут служить одиночные импульсы постоянного

тока (видеоимпульсы), переменного тока (радиоимпуль-

сы), пауза между импульсами. Эти элементы различа-

ются по какому-либо одному или нескольким кодовым

(импульсным) признакам. В качестве кодовых призна-

ков применяются такие параметры, как величина, поляр-

ность, время, фаза, частота (рис. 7). Каждому сообще-

нию однозначно соответствует определенная кодовая

комбинация. Код позволяет записать все сообщения на

некотором общем для данного набора сообщений языке.

С этой точки зрения набор элементов данного кода рас-

32

сматривают как алфавит, а кодовые комбинации из этих

элементов — как кодовые слова. Каждое сообщение пе-

редается собственным кодовым словом.

Преобразование сообщений в кодовые комбинации

(кодовые слова) позволяет обеспечить [43, 103]:

а) передачу необходимого количества различных

сообщений по данному каналу связи с помощью комби-

нирования из п элементов, имеющих т кодовых при-

знаков; б) согласование параметров канала связи и пе-

редаваемых сообщений; в) повышение достоверности

передачи сообщений; г) более экономное использование

полосы канала связи; д) уменьшение стоимости пере-

дачи и хранения сообщений; е) скрытность передавае-

мых сообщений.

Выбор методов кодирования, обеспечивающих выпол-

нение указанных целей, является сложной задачей, ре-

шение которой зависит от ряда факторов: количества

передаваемых сообщений, числа кодовых признаков, тре-

буемого времени передачи, параметров канала связи,

возможности аппаратурной реализации. Однако в доста-

точно общем случае качество метода кодирования оце-

нивается объемом сигнала для достижения требуемой

помехоустойчивости при равной скорости передачи.

Правила составления кодовых комбинаций (коды) и

сами кодовые комбинации могут иметь различные харак-

теристики. К ним относятся: число кодовых (импульс-

ных) признаков, используемых для комбинирования,

количество разрядов кодовой комбинации, способ комби-

нирования (закон, согласно которому из единичных

элементов образуются кодовые комбинации), способы

формирования элементов кода (импульсные признаки),

способ передачи (разделение) элементарных сигналов.

Первые три свойства относятся к структурным характе-

ристикам самого кода, последние два — к характеристи-

кам сигналов кода. На рис. 7 приведены основные

характеристики кодов.

2 Г-2&6

33

Характеристика кода

nnhDHdO&Hn

pogogoN gogudaxi

одшэаьпиоу

впнрдодпнпдтк

goaouj

dnhDHnpNOK

эпно^оечиоиэп

aoHhniuaoh

nnhounpxjon

апнодоеяиоиап

дониои

tdiQHddnoHijnasH]

одшэаьпиоы

эонниошаоиэн

(aiQHdaKiOHgod)

одшзаьпиоя

аонниошооц

Рис. 7. Характеристики кедов.

атнопРпсоиогон^\

gownendu I/

XtWWfiUHn CJ OIQHhnOglT I

оиэпь \ 1----------------1

. ouanh

dlQHhnHnpj |

24

По числу импульсных признаков {символов) коды

подразделяются на единичные, двоичные, многопозици-

онные. В единичном коде используется только один сим-

вол, и кодовые комбинации отличаются друг от друга

лишь количеством сигналов. Кодовые комбинации дво-

ичных кодов состоят из двух символов (0 или 1). Много-

позиционные коды имеют количество символов более двух.

По количеству разрядов кодовые комбинации могут

иметь либо постоянное число разрядов, либо не постоян-

ное. Этот признак разделяет коды на равномерные и

неравномерные. В равномерных кодах каждая кодовая

комбинация содержит одинаковое число разрядов. Не-

равномерные коды — коды, в которых кодовые комбина-

ции могут содержать разное число разрядов.

По способу комбинирования различают коды, исполь-

зующие все возможные комбинации, и коды с частичным

использованием комбинаций.

Характер передачи кодовых комбинаций разделяет

коды на последовательный, параллельный и смешанный

способы передачи отдельных символов кода. При после-? -

довательной передаче^ е кодовые комбинации и ихедц,-

ничные элементы передаются последовательно во время.

ни по общей линии связи. При параллельной-передаче-

кодовых ~ комбинаций " Каждому _ разряду - выделяется

отдельная линия связи и все символы передаются -одно—

временно. Смешанный способ передачи объединяет

в себе последовательный и параллельный способы.

Кроме различия кодов по перечисленным характе-

ристикам, они могут иметь разное назначение и в

соответствии с этим подразделяются на телеграфные,

телемеханические, телевизионные, коммерческие, дипло-

матические, военные, коды цифровых машин.

Для передачи информации широко используются

двоичные и многопозиционные коды. Авторы ставили

перед собой задачу познакомить читателей с принципа-

ми построения двоичных кодов, получивших широкое

2*

35

применение в различных автоматизированных устройст-

вах обработки, хранения и передачи информации.

2.2. Классификация двоичных кодов

Известно большое количество кодов,

систематизация и классификация которых из-за их

многочисленных признаков являются довольно затруд-

нительными. Поэтому в основу классификации поло-

жим рассмотренные в предыдущем параграфе структур-

ные характеристики кодов. Коды можно разделить на

две самостоятельные группы. К первой относятся коды,

использующие все возможные комбинации — неизбы-

точные коды. В литературе их еще называют простыми

или первичными. Ко второй группе относятся коды, ис-

пользующие лишь определенную часть всех возможных

комбинаций. Такие коды согласно ГОСТ 17657—72 на-

зываются избыточными. Оставшаяся часть комбинаций

используется для обнаружения или исправления оши-

бок, возникающих при передаче сообщений. В этих

кодах количество разрядов кодовых комбинаций можно

условно разделить на определенное число разрядов,

предназначенных для информации (информационные

разряды), и число разрядов, предназначенных для кор-

рекции ошибок (проверочные разряды).

Обе группы кодов, в свою очередь, подразделяются

на равномерные и неравномерные. Равномерные коды —

это коды, все кодовые комбинации которых содержат

постоянное количество разрядов. Неравномерные коды

содержат кодовые комбинации с различным числом раз-

рядов. Ввиду того что неравномерные избыточные коды

не нашли применения на практике из-за сложности их

технической реализации, в дальнейшем их рассматривать

не будем.

38

Все избыточные коды разделяются на два класса:

непрерывные и блочные.

В непрерывных кодах процесс кодирования и деко-

дирования носит непрерывный характер. Этот класс ко-

дов появился сравнительно недавно и не получил пока

широкого развития. В блочных кодах каждому сообще-

нию соответствует кодовая комбинация (блок) из п сим-

волов; Блоки кодируются и декодируются отдельно друг

от друга.

Избыточные коды, в которых определенные разряды

кодовых комбинаций отводятся для информационных и

проверочных символов, называются разделимыми. Раз-

делимые блочные коды обозначаются обычно (п, ^-кода-

ми. где п — количество разрядов кодовой комбинации, k—

число разрядов, отводимых для информационных сим-

волов. Неразделимые коды не имеют четкого разделения

кодовой комбинации на информационные и проверочные

символы. К ним относятся коды с постоянным весом и

коды Плоткина [95, 129].

Разделимые блочные коды, в свою очередь, делятся

на несистематические и систематические. В несистемати-

ческих кодах проверочные символы представляют собой

суммы подблоков с I разрядами, на которые разделена

последовательность информационных символов. К этим

кодам относятся коды Бергера.

Самый большой класс разделимых блочных кодов

составляют систематические коды, у которых провероч-

ные символы определяются в результате проведения ли-

нейных операций над определенными информационными .

символами. Для двоичных кодов эти операции сводятся

к выбору каждого проверочного символа таким образом,

чтобы его сумма по модулю два с определенными инфор-

мационными символами была равной нулю.

К систематическим кодам относятся коды с проверкой

на четность, коды с повторением, корреляционный, ин-

версный, коды Хэмминга, Голея, Рида-Маллера, Макдо-

37

нальда, Варшамова, с малой плотностью проверок на

четность, итеративный код [8, 14, 24, 25, 34, 35, 49, 129,

130, 150].

Разновидностью систематических кодов являются

циклические коды. Кроме всех свойств систематического

кода, циклические коды имеют следующее свойство: если

некоторая кодовая комбинация принадлежит коду, то

получающаяся путем циклической перестановки симво-

лов новая комбинация также принадлежит данному ко-

ду. К наиболее известным циклическим кодам относятся

простейшие коды, коды Хэмминга, Боуза — Чоудхури —

Хоквингема, мажоритарные, коды Файра, Абрамсона,

Миласа — Абрамсона, Рида — Соломона, компаундные

коды. Классификация рассмотренных кодов приведена

на рис. 8.

В печати все чаще появляются отдельные сведения о

новых систематических кодах: дециклических, несистема-

тических кольцевых, циклических изверженных, абеле-

вых, вычетных и других. В работе [104] систематизиро-

ваны эти коды и указана литература, где приводятся

параметры этих кодов либо формулы для вычисления их

параметров. В Киевском политехническом институте

разработаны неприводимые сменнопосылочные коды,

обеспечивающие высокую верность передачи информа-

ции [46].

2.3. Основные характеристики кодов

Оценка кодов обычно производится по их

основным характеристикам, выражающим различные

количественные и качественные показатели. Данные ха-

рактеристики используются при выборе кодов, предна-

значенных для передачи, хранения и обработки инфор-

мации: длина кода; основание кода; мощность кода;

полное число кодовых комбинаций; число информацион-

ных символов; число проверочных символов; избыточ-

ность кода; скорость передачи; вес кодовой комбинации;

38

Рис. 8. Классификация двоичных кодов.

кодовое расстояние; весовая характеристика кода; веро-

ятность необнаруженной ошибки; оптимальность кода;

коэффициент ложных переходов.

Длина кода п — число разрядов (символов), состав-

ляющих кодовую комбинацию.

Основание кода tn — количество отличающихся друг

от друга значений импульсных признаков, используемых

в кодовых комбинациях. Для случая двоичных кодов

т = 2. В качестве значений импульсных признаков ис-

пользуются цифры 0 и 1.

Мощность кода Np — число кодовых комбинаций (рабо-

чих кодовых слов), используемых для передачи сообщений.

Полное число кодовых комбинаций N — число всех воз-

можных комбинаций, равное тп (для двоичных кодов М=2").

Число информационных символов k — количество сим-

волов (разрядов) кодовой комбинации, предназначенных

для передачи собственно сообщения. Очевидно,

ЛГР=2*. (2.1)

Число проверочных символов г — количество символов

(разрядов) кодовой комбинации, необходимых для кор-

рекции ошибок. Это число характеризует абсолютную

избыточность кода.

В теории кодирования под избыточностью кода R по-

нимают относительную избыточность, равную отношению

числа проверочных символов к длине кода:

М- (2-2)

В более общем случае эта формула может быть приве-

дена к виду

logman

8 = 1~> М

Скорость передачи кодовых комбинаций — отношение

числа информационных символов к длине кода:

^'«4- (2.4)

40

Поскольку п — k-\-r, то

/?'=!-/?. (2.5)

Пример. Определить избыточность и скорость передачи кода,

предназначенного для передачи 16 сообщений, если длина двоичного

кода п = 5. Полное число кодовых комбинаций:

W=2"=2»=32; R = 1 —= 1—4= °>2; ₽'=1—0,2=0,8.

Вес кодойой комбинации (кода) <« — количество еди-

ниц в кодовой комбинации. Например, кодовая комби-

нация 101100110 характеризуется длиной кода п = 9и.

весом о =5. Кодовое расстояние d между двумя кодовы-

ми комбинациями — число одноименных разрядов с раз-

личными символами. Практически кодовое расстояние

выражается как вес суммы по модулю два кодовых ком-

бинаций. Например, для определения кодового расстоя-

ния между комбинациями 10010111 и 00100110 необхо-

димо просуммировать их по модулю два:

, 10010111

+ 00100110

10110001.

Полученная в результате суммирования новая кодовая

комбинация характеризуется весом о = 4. Следовательно,

кодовое расстояние между исходными комбинациями d = 4.

Весовая характеристика кода W (о) — число кодовых

комбинаций веса о. Например, для кода, содержащего

кодовые комбинации 00000, 01110, 10101 и ПОП, весо-

вая характеристика W’(0) = 1, W(3) = 2, W’(4) = 1, т. е.

данный код состоит из одного кодового слова веса 0,

двух слов веса 3 и одного слова веса 4.

Вероятность необнаруженной ошибки Рв.о — это веро-

ятность такого события, при котором принятая кодовая

комбинация отличается от переданной, а свойства дан-

ного кода не позволяют определить факта наличия ошибки.

Оптимальность кода — свойство такого кода, который

обеспечивает наименьшую вероятность необнаружения

ошибки среди всех кодов той же длины п и избыточности г.

41

Коэффициент ложных переходов [76]

Л 1 vWP'(d)

Кл(<0 = NCd *

р , , п

(2.6)

где NPi(d) — число рабочих кодовых комбинаций, отсто-

ящих от /-кодовой комбинации на расстояние d; С„—

число сочетаний из п по d.

Данный коэффициент показывает, какая доля ошибок

кратности d не обнаруживается.

Пример. Определить коэффициенты ложных переходов для кода

с четырьмя рабочими комбинациями Np = 4t Vj = 001, Vt = 010, Vs =

= 011, V4=100.

Составим таблицу кодовых расстояний между каждыми комбина-

циями (векторами):

Из таблицы следует, что комбинация Vf

удалена на d = 1 от одного вектора и иа d = 2

от двух векторов, т.е. Npi (1) = 1, Npt (2) =

= 2, (3) = 0. Вектор V2 удален на d = 1 от

одного вектора и на d = 2 от двух векторов,

т. е. ЛС2(1) = 1, Л'р2 (2) = 2, Np2 (3) = 0.

Вектор Vs удален иа d = 1 от двух векторов и

иа d = 3 от одного вектора, т. е. (1) = 2,

Wp3 (2) = 0, Np3 (3) = 1. Вектор Vt удален иа

d = 2 от двух векторов и на d = 3 от одного вектора, т. е. Npi (1) =

= 0, Npi (2) = 2, Npi (3) = 1. Определим коэффициент ложных пере-

ходов:

..... 1 Wpi(l) + Afp2(l)-|-Wp3(l) + Wp4(l) 1 4 1

Кл0) - 4 Я ~ 4 ’ 3 ~ 3 :

’"3

л() = 4 С2 “ 4 • 3 = Т:

1 *pl(3)^p2(3) + Wp3(3)-i-tfp4(3) _i_ _2_ _L

ЛдИ = -*----------------------------------=4'1~2-

42

Доказано 193, 94], что для систематических кодов все

кодовые слова имеют одинаковое распределение кодовых

расстояний до других слов, поэтому распределение ко-

довых расстояний для любого слова можно определить,

используя весовую характеристику систематического кода.

Коэффициент ложных переходов в этом случае

lF(<o)

Кл(‘о) = -^-> (2.7)

где Г (<в)— весовая характеристика кода.

Пример. Пусть весовая характеристика кода с п = 5 следующая!

Р7(1) = 1; VT(3) = 2; VT(4) =*•; Tf(5) = 1. Определить коэффициент

ложных переходов.

Из формулы (2.7) следует, что Кл(1) = 0,2; Кя(2) = 0; Кл(3)=

= 0,2; Кл(4) = 0,2; /Сл(5) = 1. Таким образом, данный код обнару-

живает все двукратные ошибки и 80% однократных, трехкратных и

четырехкратных ошибок. Не обнаруживаются только пятикратные

ошибки.

2.4. Основы построения неизбыточных

кодов

Для неизбыточных кодов характерно пол-

ное использование комбинаций. К неизбыточным кодам от-

носят также коды с частичным использованием комбинаций,

у которых минимальное кодовое расстояние dMHH — 1. Такие

коды обнаруживают не все виды искажений, вызванных

даже однократной помехой. Количество различных ком-

бинаций, которое можно получить из «-разрядного чис-

ла, определяем по формуле

iV = CS + C’ + C^ + ... + C (2.8)

где С„, ... —число сочетаний из п элементов по

0,1, ..., п. После соответствующих преобразований по-

лучаем N = 2". Так как в этом случае используются

все возможные комбинации, то п является минимальным

количеством разрядов, с помощью которых можно пост-

43

роить максимальное количество кодовых комбинаций при

числе возможных значений символов 2 (0,1). Отсюда ко-

личество разрядов, необходимое для передачи W сообщений,

л = logg/V. (2.9)

Пример. Определить количество разрядов кодовой комбинации

для передачи восьми сообщений: п = log2 8=3, т. е. сообщение будет

состоять из трех символов, каждый из которых может принимать два

значения: 0 и 1.

Кодовые комбинации при использовании кода на все

сочетания строятся следующим образом. Составляется

таблица, в первой графе которой записываются номера

всех возможных сообще-

Таблица 6

До сооб- щения Ве- роят- ность полу- чения Деление на группы Кодовые комбина- ции

1 1/8 1 11 ООО

2 1/8 I J ’ll 001

3 1/8 1II1 010

4 1/8 J пп 011

5 1/8 1 11 100

6 1/8 II 1 II 101

7 1/8 111 1 1 10

8 1/8 И 1

или N, во второй — ве-

роятность их получения.

Далее все сообщения де-

лятся на две равные

группы. Для группы I

первому символу кодовых

комбинаций присваива-

ется, например, значение

0, для группы II — зна-

чение I. Далее каждая

из групп снова делится

на две группы. В качест-

ве значений второго сим-

вола кодовых комбина-

ций для сообщений груп-

пы I снова принимаем 0, для группы II — 1 и т. д.

Полученные комбинации отличаются одна от другой

не менее чем одним элементом.

Из табл. 6 видно, что запись комбинаций на все соче-

тания является записью чисел от 0 до 7 в двоичной

системе счисления. Такой код называют простым двоич-

ным кодом. Построение всех кодовых комбинаций этого

кода удобнее всего достигается посредством написания

44

необходимой последовательности двоичных чисел. В этих

кодах количество информации, "Приходящееся на один

символ, максимально. К неизбыточным кодам относятся

и так называемые отраженные двоичные коды, в кото-

рых соседние кодовые комбинации отличаются симво-

лом только в одном разряде. К таким кодам относится

широко известный код Грея.

Наряду с простым двоичным кодом часто использует-

ся двоично-десятичный код. Это обусловлено тем, что на

выбор кода влияют удобство восприятия результатов

вычислений или измерений, удобство преобразования

аналоговых величин в цифровой код и т. д. С точки зре-

ния простоты восприятия наибольшее преимущество име-

ет десятичная система счисления, но так как непосред-

ственно использовать ее в цифровых машинах нецелесо-

образно, применяется двоично-десятичная система, на

которой базируется двоично-десятичный код. В этой си-

стеме используется основание 10, но цифры в каждом

разряде записываются четырехразрядными двоичными

числами. Например, число 279 в двоично-десятичной

системе запишем следующим образом:

279- 0010 0111 1001

сотни десятки единицы.

Разновидностью двоично-десятичных кодов являются

самодополняющие двоично-десятичные коды, у которых

при инвертировании цифр во всех четырех разрядах

получается дополнение до 9 для кодируемой десятичной

цифры. К этим кодам принадлежат код с избытком 3-и

код Айкена.

Наиболее известными представителями неравномер-

ных двоичных кодов являются код Шеннона — Фано и

код Хаффмена [134].

На рис. 8 показана классификация неизбыточных

двоичных кодов.

45

2.5. Простые равномерные коды

В равномерных кодах все кодовые комби-

нации содержат одинаковое число элементов; Различие

между комбинациями заключается в сочетании их эле-

ментов. У нас в стране и за рубежом применяются раз-

личные коды, используемые в телеграфных системах, в

системах передачи данных, при обработке информации

на ЭВМ. В качестве примера рассмотрим международ-

ный телеграфный код № 2 (МТК-2), рекомендованный

МККТТ для использования в буквопечатающих теле-

графных аппаратах и уже распространенный повсемест-

но. Кодовую таблицу МТК-2 отражает табл. 7. В этом

коде 29 комбинаций из 32 используются для передачи

русской буквы либо цифры (знака препинания), либо

латинской буквы. Остальные три комбинации предназна-

чены для перевода регистров.

Из табл. 7 видно, что кодовые комбинации есть дво-

ичная запись соответствующих номеров строк. При по-

строении простых равномерных кодов кодовые комбина-

ции выбираются с учетом степени важности знаков в

сообщении. В коде МТК-2 при искажении комбинации

«русский регистр» вся следующая за ней последователь-

ность русских букв будет отпечатана на цифровом или

латинском регистре, т. е. неправильно. Поэтому для пе-

реключения регистров выбраны те кодовые комбинации,

которые меньше других подвержены действию помех.

С совершенствованием ЦВМ возникла необходимость

в использовании новых служебных, арифметических, ло-

гических и других символов, отсутствующих в междуна-

родном коде № 2, что привело к созданию различных

расширенных вариантов этого кода [117, 135].

В 1964 г. в нашей стране введен в действие

ГОСТ 10859—64, согласно которому для ввода и вывода

информации в ЦВМ стали использовать семиразрядный

код (рис. 9),

46

I

Таблица 7

Регистр Разряд комбинации

Ks

КОМбиИа-

1 ЦИН руоакий латинский цифр ж, виаки 1 2 3 4 Б

1 Т Т 5 0 0 0 о. 1

2 Возврат 0 0 0 1 0

каретки

) 3 О 0 9 0 0 0 1 1

4 Пробел 0 0 1 0 0

5 X Н Щ 0 0 1 0 1

i 6 н N 0 0 1 1 0

7 м М • 0 0 1 1 1

8 Перевод 0 1 0 0 0

строки

9 л L ) 0 1 0 0 1

10 р R 4 0 1 0 1 0

И г G III 0 1 0 1 1

12 и 1 8 0 1 1 0 0

13 п Р 0 0 1 1 0 1

14 ц С 1 0 1 1 1 0

15 ж V «— 0 1 1 1 1

16 Е Е 3 1 0 0 0 0

17 3 Z + 1 0 0 0 1

1 18 д D Кто там 1 0 0 1 0

19 Б В ? 1 0 0 1 1

20 С S ап. 1 0 1 0 0

21 ы У 6 1 0 1 0 1

22 ф F э 1 0 1 1 0-

23 ь X / 1 0 1 1 1

24 А А 1 1 0 0 0

25 В W 2 1 1 0 0 1

26 Й J Ю 1 1 0 1 0

27 Цифровой регистр 1 1 0 1 1

28 У и 7 1 1 1 0 0

29 Я Q 1 1 1 1 0 1

30 к К ( 1 1 1 1 0

31 Латинский регистр 1 1 1 1 1

32 Русский регистр 0 0 0 0 0

«

47

35 |

* * f I i LT," * ж -ж- ж ж 'а ж ж ж ж о

< п Г III • ж О'Ч ж <> 1 1 * 5 -о « с» Ж

Ц- **• Г) % «5г от <о a г N 1 V л

а к е х a 3 с a ОС 1 *ss!V

с с «э U ч Uj * <0 X ж «5 % X: о <5

I юп ж Ж W- м п - Uu Ж * 1 V л ••

Vm. сч го •о <© О) ♦ 1 •» • ж ж ]

Рис. 9,- Семиразрядный код (ГОСТ 10859-64).

«

Кодовая таблица в нем построена так, что в случае

необходимости простым исключением старших разрядов

можно получить подмножество комбинаций меньшей

разрядности. Например, с помощью трехразрядных дво-

ичных комбинаций можно представить цифры 0—7, с

помощью четырехразрядных комбинаций — все симво-

лы первой колонки таблицы (все десятичные цифры и

символы «плюс», «минус», «дробная черта», «запятая»,

«точка» и «пробел»). Введение пятого разряда позво-

ляет закодировать еще 16 математических и специаль-

ных символов. В частности, введение кодов «стрелки

вверх» и квадратных скобок позволяет соответственно

печатать в одну стрСТку степенные функции (a t х озна-

чает «а в степени х») и величины с индексами (a[t]

означает «а с индексом i»).

Шестиразрядный код дает возможность представить

все цифры и буквы русского алфавита, а полный семи-

разрядный код включает, кроме того, часть латинских

букв (которые по начертанию не совпадают с русскими),

символы отношений и логических функций, математиче-

ские, специальные функции и несколько резервных пози-

ций. Это позволило увеличить число резервных свобод-

ных позиций (до 24) для размещения дополнительных

символов, которые могут появляться в перспективе.

Примерно по такому же принципу построен новый се-

миразрядный международный первичный код (рис. 10).

Логически он может быть разделен на четыре зоны (ко-

лонки): 0—1, 2—3, 4—5, 6—7. В первой зоне расположе-

ны функциональные символы, за исключением символа

DEL («забой»), для которого сохранено последнее место

(комбинации 1111111). Основная часть функциональных

символов этой зоны делится на четыре группы:

первая — для управления передачей информации по

каналам связи (на рис. TCt — ТСю)', вторая — для уп-

равления печатью (FE0 — FE$); третья — для управле-

49

X ь> Л о k <o +J b % x =3> N ti

*». V» Ci «□ е •О Q Ъ b> •c Je -3 E c Cl

V» С1 «о с 1 Сз О: 45 К Еэ > Э X > Г4 (V (3) J -c 1

V- С> сз * 3 -С CQ СЭ £3 U4 4. QJ 3: •-Ч Fi к 'J £ % c>

сз *- ** «О С Э *•> <N fo <b <c 00 os •- — V II Л tv.

сь *• Сэ м с ь 1 * 5 * * *» oa X •^4 « + * 1 - X

С1 О V- U £ ! >эа гза ija "лг 2 1= <o g «О Ui 3 NVJ 1 *« 1 SUB JS3 I sd(*si) (JStlRS | (IS,) US ]

сз с> Ci i 1 hos^ji) £ 1 103 Ml). 1 W3(Sjl)\ 1 ЯЭ¥(я31)\ BEL Й Jt 1 37{{3d) t- 4? t £ IL £ О 43 «О

С *- ej «О <b «J r- 4> O) 3s СЧ 55 Vj

С ** сэ »* c> <£> ** Ci Ci *» Ci V» Ci *•»

С »» Ci c> v«. »» Ci Ci *• ** Cj Cl Vv.

г С Ci V- Ci c> Ci Ci *•. ** V- *4.

ха с Ci Ci C> Ci c> Ci Ci *' *». *«. *. »» *».

А?|« 1

Рис. 10. Новый семиразрядный международный кед.

50

ния оконечными устройствами \DCt — DC^\ четвер-

тая— для разделителей информации (/Si — /S4).

Все остальные зоны таблицы кода заняты печатаемы-

ми (графическими) символами. Колонки 2—3 выделены

для математических специальных символов, знаков пунк-

туации и цифр. В двух последних зонах размещены про-

писные и строчные латинские буквы в соответствии с тре-

бованиями лексико-графической упорядоченности (поло-

жение цифр, знаков пунктуации и пробела также

выбрано с учетом этих требований). Здесь расположены

также резервные позиции.

Символ («пробел») Space обычно не печатается, но

все же относится к числу графических и употребляется

для разделения слов и перемещения позиции печати на

один шаг вперед. Цифры кодируются простым двоичным

кодом. Построение четырехразрядных комбинаций для

них производится отбрасыванием трех старших элемен-

тов. Новый международный код построен для текстов,

использующих латинский алфавит.

Отсутствие в нем символов, соответствующих рус-

скому алфавиту, не позволило использовать его в на-

шей стране. Поэтому в 1967 г. был разработан новый

вариант первичного стандартного кода ГОСТ 13052—67

(рис. 11). В этом коде символом «0» обозначен латин-

ский международный регистр, символом «1» — русский

регистр. Зоны русского регистра те же, что и в между-

народном.

Во второй зоне все символы оставлены без измене-

ний, первый денежный знак обозначен символом, реко-

мендованным третьим проектом кода, второй денежный

знак в таблицу не включен, позиция 2/з используется для

символа «номер». Две последние зоны полностью (за

исключением позиций символов «забой» и «подчеркива-

ние») заняты- русскими прописными и строчными бук-

вами. То, что строчные буквы находятся до прописных,

отражает стремление использовать на первом этапе

61

Латинский регистр I Русский регистр

!б t Ос СХ ь * «1 X) T> Э <ъ 3 £

S «о 4 41 & < x X •X X S: X

55 с <к СХ E 3j * *Q Q г •0 3 «ъ 3 > «

е S е> •q Q) & X •5» X $ X Ci

£ I *

о> I О

OS Cr

Г- Q. о к 4 u ZS b X N 1 *Q fCi

/ е> о l> Ъ Q) 4. bv •mJ X о E c О

«а CL Ct «0 К Ь * X >- N > < 1

» It с «с Cj о 41 u. 4» 5: •m 3c X: % О

*) *•. r- •D o> - • * V II Л <ч

сч 1 ft я \ * 4- - 1 • \

V» ‘di (‘ай| 1 (СУ,) (to). 1 (СУз) J.P(*K))\ vnrfxty ЧЭ J? 5 <r> ex' < 1 (*И0) (РИз) | 1 (lw) 1 f'Htf)

о> \(CCi)M3 I in (ЗД| t i s «О m I 1J (>UJ)\ i K~ CQ I 8- eg •? 5 ? h- о s

—

е> а о Cl e> - о|** c> - c> H <s s Ci □

л «г вяппзипизЕИпанпа ииЕияипиииэиаипи иивиэзЕиаяиииаин

в

Рис. И, Стандартный код (ГОСТ 13052—67).

52

(когда строчные буквы не очень нужны) код с одними

только прописными буквами и достичь этого с минималь-

ными затратами на кодопреобразование.

В ЕС ЭВМ для ввода — вывода информации приме-

няют восьмиразрядный код КОИ-8 (рис. 12). Он разра-

ботан на основе семиразрядного кода (ГОСТ 13052—67),

но имеет несколько иной перечень функциональных сим-

волов и иное расположение колонок других символов.

2.6. Двоично-десятичные коды

В двоично-десятичных кодах каждая де-

сятичная цифра (сообщение) представляется группой

цифр, состоящей из четырех двухпозиционных символов.

Данная группа позволяет сформировать N = 24 = 16 ком-

бинаций. В десятичной системе используется только 10

цифр, т. е. шесть комбинаций являются избыточными.

В принципе могут быть включены любые шесть комби-

наций, что приводит к очень большому количеству ва-

риантов построения двоично-десятичных кодов. Общее

число вариантов 161/61^2,9 • 1010.

При рассмотрении десятичных цифр и двоичного пред-

ставления их видно, что использование первых четырех

степеней цифры 2 (2°=1; 2*=2; 22 = 4; 23 = 8) приво-

дит к одному из возможных кодов: 8-4-2-1. Каждый раз-

ряд этого кода имеет постоянный вес. Двоично-десятич-

ные коды строятся с учетом следующих условий [26, 31].

1. Вес наименьшей значащей цифры ?i равен 1.

2. Вес второй по минимальному значению цифры q2

составляет 1 или 2.

3. Вес, соответствующий двум оставшимся цифрам

кода, подбирается так, чтобы их сумма была больше

либо равна 6 (если <?г=2) или 7 (если <72=1)-

В соответствии с этими условиями можно сформули-

ровать 17 видов кодов, приведенных в табл. 8.

53

64

Кроме кода 8-4-2-1, все остальные 16 кодрв не имеют

однозначности в изображении десятичных чисел. Так, код

4-3-2-1 позволяет записать цифру 6 как 1010 или 0111.

Таблица 8

№ п/п Вео разрядов № п/п Вес разрядов Xs п,п •Вес разрядов

Q< Qi Qi Qi Qr Яя Qi 44 Qi Qt Qi

1 8—4—2— 1 7 6-3—2— 1 13 4—2—2— 1

2 7—4—2— 1 8 5-3-2— 1 14 6-3—1 — 1

3 6-4—2— 1 9 4-3-2— 1 15 5 —3—1 — 1

4 5—4—2— 1 10 3—3—2— 1 16 4—3—1— 1

5 4—4—2— 1 И 6—2—2— 1 17 5 —2 -1 — 1

6 7—3—2— 1 12 5—2—2— 1

Выбор вида двоично-десятичного кода диктуется ря-

дом конкретных условий его использования и соображе-

ниями удобства его реализации. Двоично-десятичные

коды широко применяются при построении дискретных

телеизмерительных систем в тех случаях, когда измеряе-

мый параметр должен воспроизводиться на цифровых

индикаторах. Двоично-десятичные коды обладают неко-

торой избыточностью: /? = 1 — log210/log316 = 0,2,

что можно использовать для обнаружения некоторых

ошибок, но при этом выявляются далеко не все даже

самые простые однократные ошибки.

2.7. Самодополняющиеся двоично-

десятичные коды

Широкое распространение в вычисли-

тельной технике нашли двоично-десятичные коды, обла- ч

дающие свойством самодополняемости. Необходимость

в таких кодах вызвана заменой операции вычитания в

ЭВМ операцией сложения, выполняемой в специальных

машинных кодах — обратном и дополнительном. В об-

Б5

ратном коде каждый разряд [а^ ]г представляется как

дополнение до 2 1, т. е. [а^]г=2 — I — qt. Дополнение

до 2—1 = 1 равно 0, если си =1, и 1, если. а< =0,

т. е. является инверсией цифры а< . Для десятичного

кода необходимо находить дополнение до 9. Удобство

самодополняемых двоично-десятичных кодов состоит в

том, что двоично-десятичный код цифры, являющейся

дополнением до 9, находится аналогично двоичному

коду простой инверсией двоичных изображений десятич-

ного числа в коде, для которого ищется дополнение. Сле-

довательно, если разряд десятичного числа a t представ-

ляем с'помощью группы из четырех двоичных символов

Qi, Qs, <?2, _<7ь_то дополнение до 9 определяется как

(аг]ю = <74<73<72<7 ь где qt — отрицание двоичной цифры q(.

Наиболее распространенными самодополняющими ко-

дами являются код ‘ 2—4—2—1 (код Айкена) и код

8—4—2—1 с избытком 3 (табл. 9).

Т а б л и ц а 9 Из таблицы видно, что при замене цифр всех четырех раз- рядов кода с 0 на 1 (или наобо- рот) получается дополнение до 9 для кодируемой десятичной цифры. 2.8. Отраженные коды В двоичном коде при переходе от изображения одного числа к изображению со- седнего старшего или соседнего

Деся- тичная цифра Код Айкена Код с избыт- ком 3