Author: Сибуя М. Ямамото Т.

Tags: компьютерные технологии программирование обработка данных вычислительная техника

Year: 1986

Text

М. Сибуя ,Т. Ямамото

АЛГОРИТМЫ

ОБРАБОТКИ

Алгоритмы обработки данных

*аишию»-11

М.Сибуя

Т. Ямамото

АЛГОРИТМЫ

ОБРАБОТКИ

ДАННЫХ

Перевод с японского

Э. К. НИКОЛАЕВОЙ

пои редакцией

канд. техн. наук В. В. ПАНФЕРОВА

МОСКВА «МИР» 1986

ББК 32.973

С 34

УДК 681.3

Сибуя М., Ямамото Т.

С 34 Алгоритмы обработки данных: Пер. с япон. — М.:

«Мир», 1986. — 218 с., ил.

В книге японских специалистов рассматриваются структуры хранения и

их отображения на память и способы динамического управления памятью.

Основное внимание уделяется вопросам использования древовидных структур

для задач поиска и сортировки. Обсуждается возможность аппаратной реали¬

зации отдельных методов сортировки.

Для научных работников и инженеров, занимающихся вычислительной

техникой.

"• ■ ебк з2'97’

Редакция литературы по информатике и робототехнике

© Иванами Сётен, 1983

© перевод на русский язык, «Мир»

1986

Предисловие редактора перевода

Книга, предлагаемая вниманию читателей, посвящена воп¬

росам структурной организации данных и методам, лежащим

в основе их обработки. Важность этой темы очевидна — ото¬

бражение на память, поиск и сортировка в той или иной

мере присутствуют во всех программах. Четкие представле¬

ния о них необходимы при решении любой задачи на ЭВМ.

В качестве концептуальной основы структурной организа¬

ции данных авторы используют понятие массива и описывают

различные способы отображения на память с позиции опера¬

ции доступа к элементам структуры. В книге рассматрива¬

ются такие фундаментальные приемы и методы нечисленного

программирования, как отображение структуры данных на

последовательную и связанную память, динамическое управ¬

ление памятью, структурная организация данных для задач

поиска и сортировки. Излагаются практически все хорошо

обоснованные методы обработки данных, для многих из них

приводятся оценки эффективности. Авторы стремятся пока¬

зать практическую направленность книги, подчеркивая, что

все рассматриваемые методы апробированы, многие широко

используются в рамках системного программного обеспече¬

ния, а некоторые уже реализованы аппаратно.

Уровень изложения материала таков, что он доступен не¬

подготовленному читателю. Книга будет полезна как инже¬

нерам, работающим над созданием практических систем, так

и студентам и аспирантам, специализирующимся в области

системного и прикладного программирования. Она может

служить хорошим введением в область нечисленных алго¬

ритмов.

Однако отметим, что материал изложен несколько кон¬

спективно. При его изучении будет полезно обратиться к не¬

которым разделам монографии Д. Кнута [1].

В заключение мне хочется поблагодарить Н. И. Ильин¬

ского и В. И. Скворцова за большую помощь, оказанную при

редактировании.

В. В. Панферов

Введение

Электронно-вычислительные машины (ЭВМ), как это сле¬

дует из названия, были разработаны в качестве машин для

вычислений. Однако в связи с расширением общественных

потребностей и соответствующим развитием техники усили¬

лась роль ЭВМ как устройства для нечисленной обработки

данных: передачи, хранения, поиска, преобразования, обра¬

ботки, связи (в том числе и связи между ЭВМ). Вместе

с этим быстро увеличивается количество данных, обрабаты¬

ваемых ЭВМ, и обычными становятся расчеты, в которых за¬

действованы объемы данных, измеряемые в таких единицах,

как гига (109) и тера (1012).

Данные, которыми оперирует машина, должны быть упо¬

рядочены и не должны представлять собой беспорядочный

набор, подобный исписанным листам бумаги, выброшенным

в корзину для мусора. Данные не только должны правильно

отражать сущность реального мира, но и форма их представ¬

ления должна быть пригодна для повседневной обработки,

например, как конторские документы для решения опреде¬

ленных задач. При упорядочении данных необходимо учиты¬

вать два аспекта: удобство использования данных человеком

и возможность их эффективной обработки машиной. Данные

вводятся в машину полуавтоматически и хранятся в ЭВМ

после соответствующей обработки. При необходимости мо¬

жет производиться их повторная обработка с выводом из

машины в виде таблицы. На всех этих этапах структура и

форма представления данных обычно различны. Так, при

вводе и выводе, например, форма представления данных

должна быть удобна для использования человеком (напри¬

мер, в графическом виде или в виде звуковой записи), а

формы данных, используемые внутри ЭВМ, — удобными для

машинной обработки

Запоминающие устройства для записи данных с течением

времени менялись. Особенно значительные изменения косну¬

лись объема памяти, в то время как логическая структура

менялась мало. Относительно быстродействующие дорогие и

обладающие небольшой емкостью запоминающие устрой¬

ства встроенные в ЭВМ, называют оперативной, внутрен¬

ней, или основной памятью. Медленнодействующие деше

вые запоминающие устройства используются в качеств*

внешней памяти, называемой также вспомогательной, или

файловой памятью, и связываются с ЭВМ через каналы. Маг-

Введение

7

нитные ленты, диски, барабаны и т. д. являются средой хра¬

нения внешних ЗУ и в большинстве случаев бывают съем¬

ными, а сами ЗУ являются при этом, в сущности, считываю-

ще-записывающими устройствами. Обращение к данным, хра¬

нящимся в оперативной памяти, может осуществляться по

мере необходимости и в требуемой последовательности. Ины¬

ми словами, возможен произвольный (случайный) доступ

к данным. В случае внешней памяти группа данных вначале

перемещается в оперативную память, только после этого про¬

изводится их обработка, т. е. для внешней памяти возможен

групповой доступ. Для данных на магнитных лентах прак¬

тически возможен только последовательный доступ — группо¬

вой доступ в направлении перемещения ленты.

Конкретная организация оперативной памяти для пользо¬

вателей ЭВМ «прозрачна», и нет большой необходимости

в понимании механизма их действия. Логически оперативная

память представляет собой множество байтов или-елов с при¬

своенными им номерами, или адресами, совокупность которых

называется адресным пространством. Даже при простой ло¬

гике доступ к внешней памяти и анализ его эффективности

оказываются сложными и зависят от характеристик машины.

При использовании виртуальной памяти, позволяющей не

вникать в различия между внешними ЗУ и ЗУ оперативной

памяти, работа пользователей ЭВМ еще более упрощается,

но еще более усложняется работа инженера, который должен

обеспечивать эффективность работы ЭВМ.

Целью настоящей книги являются рассмотрение структур

данных, используемых при обработке данных на ЭВМ, по¬

строение таких структур данных и обсуждение алгоритмов,

необходимых для их обработки.

Управление данными в своей основе относится к функциям

человека. По крайней мере правильность вводимых данных

и их полнота зависят исключительно от способностей и до¬

бросовестности человека, выполняющего эти действия. Как

же следует определять ценность однажды записанных дан¬

ных? Очевидно, что со временем ценность данных снижается.

Однако очень трудно установить единое правило, когда дан¬

ные следует удалять из информационной системы, а если их

нельзя удалять, то каким образом их переводить в архив

и т. п.

Пользователи данных обычно противятся любой попытке

удаления данных из системы, но лица, ответственные за ра¬

боту ЭВМ с финансовой стороны, безжалостно приостанав¬

ливают работы и удаляют экономически невыгодные данные.

Итак, любые данные имеют цену. Цена иных данных очень

велика, а раз так, что очевидно стремление получить эти

Данные как можно дешевле, поэтому появляются лица,

8

Введение

которые пытаются тайно копировать данные. Для надежного

полета космического корабля «Земля», например, требуется

огромное количество данных. Это потребует, очевидно, боль¬

ших затрат на сбор нужных данных любой ценой, извлече¬

ние из них необходимой информации, ее хранение, передачу

соответствующим лицам.

В этой книге не рассматривается управление данными с

точки зрения обеспечения их полноты и выбора данных для

удаления из памяти. Это, очевидно, задачи такой науки, как

статистика. Обеспечение секретности данных более тесно свя¬

зано с проблемами, обсуждаемыми в книге, но основной

темой является изучение систем, в функции которых входят

шифровка и дешифровка данных и оперирование этими дан¬

ными. Здесь рассматривается техника управления данными

не с точки зрения операций, осуществляемых человеком, а в

предположении, что данные уже введены в систему ЭВМ.

В первой главе даются общие определения основных эле¬

ментов данных и обсуждается возможность использования

структур, полученных их комбинациями. Очевидно, при этом

должны быть рассмотрены не только логические структуры —

структуры с точки зрения пользователя, но и физические

структуры, пригодные для практического использования

в ЭВМ.

Во второй главе рассматриваются древовидные структуры,

наиболее широко применяемые для представления и исполь¬

зования данных. Деревья очень хорошо подходят для описа¬

ния различных иерархических структур, просты для понима¬

ния и широко используются в различных приложениях. Кроме

того, такие структуры используют программы управления па¬

мятью операционных систем для поддержания файлов и т. д.

В этой же главе рассматриваются методы хеширования, по¬

зволяющие значительно сократить затраты времени на обра¬

ботку данных, для которых применяются совершенно другие

структуры.

В третьей главе рассматриваются наиболее простые алго¬

ритмы сортировки, обеспечивающие линейное упорядочение

данных в порядке возрастания значений ключей. Несмотря

на кажущуюся простоту сортировки, если вникать глубже и

детально проанализировать алгоритмы с точки зрения эффек¬

тивности, оказывается, что существуют проблемы, решение

Которых до сих пор не найдено.

В четвертой главе обсуждаются четыре независимые прак¬

тические проблемы. Разд. 1 посвящен методам доступа опе¬

рационных систем к виртуальной памяти, в которых исполь¬

зуются структуры В+-дерева. В разд. 2 рассматриваются

структуры данных для информационных систем типа поиска

источника (поиск по вторичному ключу). Эти структуры, упо¬

Введение

9

минавшиеся в гл. 1, рассматриваются здесь с различных сто¬

рон в конкретном применении. В разд. 3 обсуждаются осо¬

бенности представления данных, которых мы пока не каса¬

лись в предыдущих разделах книги: возможность уплотнения

данных за счет исключения избыточных элементов данных.

В разд. 4 рассматривается следующий шаг в подходе к уп¬

равлению данными — управление данными средствами аппа¬

ратного обеспечения; приведены варианты схем для сорти¬

ровки.

Поскольку отдельные аспекты, относящиеся к рассматри¬

ваемой области, обсуждаются и в специальных учебниках,

при написании данной книги авторы стремились по мере воз¬

можностей к доступному изложению материала для читате¬

лей, не являющихся специалистами в этих вопросах, учиты¬

вая важность практического применения излагаемого мате¬

риала. Недостаточность систематизации материала объясня¬

ется малочисленностью авторских сил, однако можно ожидать

расширения исследований в этой области и соответственно

притока новых исследователей.

Авторы выражают глубокую признательность членам ре¬

дакционной коллегии, рекомендовавших авторов для напи¬

сания этой книги, и редакционному отделу издательства

«Иванами Сётэн», оказывавшему самую разнообразную по¬

мощь авторам в их работе.

Май 1983 г. М. Сибуя

Т. Ямамото

Глава 1

Данные

Данные, хранящиеся в ЭВМ, представляют собой сово¬

купность нулей и единиц (битов). Биты объединяются в вось¬

мибитовые последовательности — байты, а также более длин¬

ные последовательности — слова, или длинные слова, вклю¬

чающие два и более слов. Основными последовательностями

считаются байты или слова. Каждому участку оперативной

памяти, который может вместить один байт или одно слово,

присваивается порядковый номер (адрес), и вся совокуп¬

ность адресов, предоставляемая пользователям ЭВМ, назы¬

вается адресным пространством. Какой смысл заключен в

данных, какими символами они выражены — буквенными

или цифровыми, что означает то или иное число — длину ли,

стоимость ли — все это определяется программой обработки.

В настоящее время пользователи ЭВМ подразделяют дан¬

ные, необходимые для решения практических задач, на не¬

сколько типов, связывая понятие типа не только с представ¬

лением данных в адресном пространстве, но и со способами

их обработки.

1.1. Основные типы данных

1.1.1. Элементы данных и структуры

Любое данное может быть отнесено к одному из двух

типов: основному (простому), форма представления которого

определяется структурой ЭВМ, или сложному, конструируе¬

мому пользователем для решения конкретных задач. Напри¬

мер, для нас многоугольники на плоскости — простые и

вполне понятные данные, над которыми можно выполнять

различную обработку: вычислять площадь, периметр, значе¬

ния диагоналей и углов; осуществлять перемещение, поворот

и масштабирование многоугольника на плоскости; определять

фигуры, получаемые в результате пересечения или объедине¬

ния таких многоугольников (в результате не обязательно дол¬

жен получиться многоугольник), и т. д. Каким же образом

в данном случае следует представлять многоугольники в па¬

мяти ЭВМ, чтобы иметь возможность такой обработки?

Можно воспользоваться различными способами представле¬

ния, но если абстрагироваться от них, то многоугольник сле¬

дует рассматривать как самостоятельный тип данных. Чело¬

век не может влиять на представление простых данных в ад-

Данные

11

респом пространстве. В отличие от простых представление

сложных типов данных задается человеком и образуется ком¬

бинацией простых.

Элементами данных являются символы, числа и тому по¬

добные данные, дальнейшее дробление которых не имеет

смысла. Они используются в качестве структурных элементов

сложных данных. К символам обычно относят буквы англий¬

ского алфавита, цифры, знаки, знаки азбуки «катакана»,

иероглифы, точечные знаки и т. д. Многие типы чисел хорошо

известны — натуральные, целые, десятичные числа с плаваю¬

щей точкой (вещественные числа) и т. д. Максимальное и

минимальное числа, представимые в машине, задают диапа¬

зон значений целых чисел, а также диапазон и точность

представления вещественных чисел. Целые числа из диапа¬

зона 0 и 1 часто рассматривают как значения логического

типа (переключатель, флажок). Знание физической единицы

измерения числовой величины, например длины, времени или

денежной единицы, устанавливает границы применимости

операций, что позволяет избежать многих ошибок при про¬

граммировании. Сказанное справедливо и для безразмерных

величин, если известно, какой смысл приписывает человек

обрабатываемым данным. Над целыми числами можно вы¬

полнять различные операции, отличающиеся точностью вы¬

числений, адресуемыми участками памяти и представлением.

Простая совокупность элементов данных одного типа об¬

разует массивы одномерные, двумерные и т. д. Массивы

вещественных чисел хорошо известны — это векторы, матрицы,

тензоры. Однако в обработке данных термин «массив» ис¬

пользуется в более широком смысле — просто как средство

оперирования группой данных. На практике массивами часто

называют совокупности данных двух и более типов, например

данные о продаже по месяцам, отделениям фирмы, отдель¬

ным изделиям. Отдельный элемент массива задается индек¬

сом, представляющим собой целое число или совокупность

целых чисел, указывающую местоположение элемента в мас¬

сиве. Слово языка можно представить, например, одномер¬

ным массивом букв соответствующей длины, а фразу — дву¬

мерным. Чтобы удовлетворить различным целям обработки,

слова и фразы следует рассматривать как тип данных более

высокого уровня, нежели массив символов. В японском языке

деление на слова затруднительно и требует использования

более сложного и менее очевидного способа представления

данных. Так, страницу печатного японского текста, например

эту страницу, можно представить двумерным массивом ло¬

гических величин. Для этого достаточно разбить страницу

прямоугольной сеткой на очень мелкие клетки (элементы

12

Глава 1

или ячейки изображения), такие, чтобы каждый элемент был

черным или белым. Для черно-белой фотографии потребуется

двумерный массив целых чисел, соответствующий плотностям

элементов изображения, а для цветной фотографии необхо¬

димы уже три целочисленных значения, по одному на каж¬

дый из трех основных цветов.

Разновидностями одномерных массивов являются струк¬

туры типа кольцо, стек, очередь и двусторонняя очередь.

Кольцо представляет собой одномерный массив с замкну¬

тыми концами, т. е. массив, в котором концы отсутствуют

(рис. 1.1, а). Типичным примером такой структуры является

таблица объектов, обработка которых производится путем

последовательного обхода, например входных сигналов, по¬

ступающих от терминалов, в системе с разделением времени.

И в случае когда регистрируются новые данные (п элемен¬

тов данных), которые вводятся в процесс равномерно во вре¬

мени, и в случае когда поддерживается процесс выполнения

плана, намеченного на каждый день из последующих три¬

дцати, начиная от данного дня, обычно используется кольцо.

Итак, кольцо — это такая структурная организация массива

данных, при которой целесообразнее перемещать границы

массива, оставляя неподвижными его элементы. Если органи¬

зовать кольцо неопределенной длины, то его можно исполь¬

зовать как очень гибкую структуру, в нужное место которой

можно вводить или исключать элементы данных.

Структура типа стек — это одномерный массив перемен¬

ной длины, обладающий той особенностью, что включение и

исключение элементов ограничено только одним концом мас¬

сива, называемого вершиной стека. Стек представляет собой

структуру (см. рис. 1.1,6), в которой первым обрабаты¬

вается тот элемент данных, который введен последним. Для

обработки древовидных структур, о которых речь пойдет

ниже, обычно используют рекурсивную обработку, основан¬

ную на вызове подпрограммы самой себя. При рекурсивном

вызове подпрограммы текущие значения переменных засыла¬

ются в стек и переменным присваиваются новые значения.

Обработка значений, хранящихся в стеке, может быть про¬

должена только после выхода из подпрограммы (т. е. после

завершения обработки новых значений) путем присваивания

переменным значений из стека.

Стек называли также магазинным списком, использовали

и другие названия, которые в конце концов были унифици¬

рованы. В отличие от очереди, которая будет рассмотрена

следующей, стек называли также списком, в котором первым

считается элемент, записанный последним (LIFO — last-in-

first-out list). Смысл этого названия очевиден и отражает

Данные

13

а

hi::::

ВключениеJ

Исключение

1 I 1

Н

/1

/

Исключение

-я

• I I I I

Н

| 1

IZ-CU

\

Включение

УС

1 I—

н

I I

/ /У'

Включение/

Исключение

—I I—

Н

I I

он

\

Включение

Исключение

fO^OO{Oy----COnZ~'^CO

Включение 1 Ч

Исключение Исключение

м::

н

I I—

Включение /

Исключение

Включение

Рис. 1.1. Совокупности элементов данных: а — кольцо; б — стек; в — оче¬

редь; г — двусторонняя очередь: д — двусторонняя очередь с ограничен¬

ным входом (включение данных разрешено только на одном конце); е —

двусторонняя очередь с ограниченным выходом (исключение данных раз¬

решено только на одном конце).

дисциплину обслуживания списка. В кафетериях США ис¬

пользуют посудные автоматы, называемые «Cafeteria well».

Одинаковые тарелки и чашки, точно вставленные в верти¬

кальную прорезь, поддерживаются пружиной, находящейся

на дне автомата. При заполнении прорези тарелками неза¬

висимо от их числа самая верхняя благодаря действию

14

Глава 1

пружины будет находиться на определенной высоте, удобной

для того, чтобы ее мог достать человек. Здесь как раз исполь¬

зуется принцип стека.

Структура типа очередь также представляет собой одно¬

мерный массив переменной длины и аналогична очереди лю¬

дей перед окошком кассы, торговым автоматом или телефо¬

ном-автоматом. Включение и исключение данных выполня¬

ются на разных концах массива (см. рис. 1.1,в). В отличие

от LIFO это список, в котором первым считывается элемент,

записанный первым (FIFO — first-in-first-out list). Очереди

широко используются в операционных системах, например

для организации одновременного использования устройстз

ввода-вывода многими пользователями или единственного

центрального процессора несколькими программами.

Структура, обладающая большей общностью, чем стек или

очередь, позволяющая осуществлять доступ, включение и ис¬

ключение на обоих концах массива, называется двусторонней

очередью (деком). Разновидностями двусторонней очереди

являются дек с ограниченным входом (включение допускается

только на одном конце) и дек с ограниченным выходом (ис¬

ключение допускается только на одном конце) (см. рис. 1.1, г,

а также рис. 1.10), которые с точки зрения общности зани¬

мают промежуточное положение между деком и стеком или

очередью.

Были рассмотрены три типа структур данных, которые на

логическом уровне являются просто разновидностями одно¬

мерных массивов с произвольным числом элементов. Позже

рассмотрим, как эти структуры могут быть представлены

в памяти.

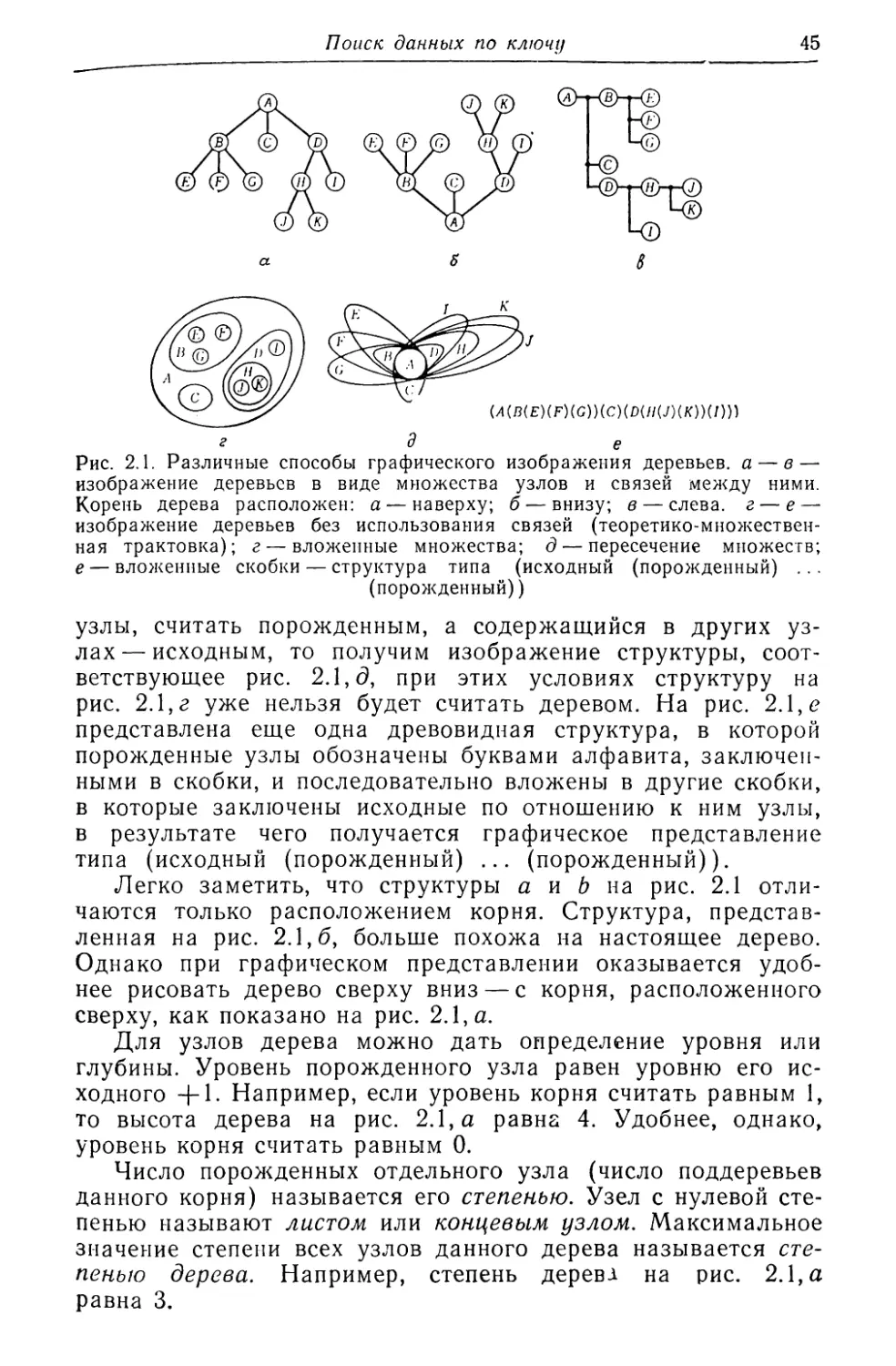

Очень важной структурой, для размещения элементов ко¬

торой требуется нелинейное адресное пространство, является

дерево. Существует большое число структур данных, которые

могут быть представлены деревьями. Это и классификацион¬

ные", и иерархические, и рекурсивные структуры. В библио¬

теках книги располагают согласно классификации. Управле¬

ние предприятием имеет иерархическую структуру. Автомо¬

биль представляет собой сложный механизм и состоит из

двигателя, корпуса, электрооборудования и других узлов, ко¬

торые в свою очередь также состоят из отдельных деталей

(рекурсивная структура). Основу структуры данных, называе¬

мой деревом, как и обычного дерева, составляют «разветвле¬

ния» (только благодаря им дерево имеет «ветви» разных

порядков). Деревья состоят из данных, каждое из которых

имеет структуру дерева. В гл. 2 деревья будут рассмотрены

более детально. Для выражения более общих связей между

Данные

15

узлами (разветвлениями) используют графы или сети. При

графическом представлении узлы обозначают точками, а свя¬

зи— линиями, соединяющими две точки. В виде графов, на¬

пример, могут быть представлены дорожные сети, сети связи

и электрические схемы.

Совокупность элементов данных разного типа называют

записью. В простейшем случае запись содержит постоянное

число элементов (/ь f2j ..., fk), называемых полями. Каждое

поле fi представляет собой элемент данных определенного

типа. Практическими примерами записей могут служить на¬

кладные и прочие документы в конторских операциях; одна

(Номер-служащего-фирмы (5-значное число), фамилия-и-имя (5 иероглифи¬

ческих знаков), запись фамилии и имени знаками азбуки (10 знаков ката-

каны), дата-рождения (5-значное число), код-подразделения (3-значное

число), код-профессии (3-значное число))

Рис. 1.2. Запись основного файла «Список служащих фирмы».

накладная представляет собой отдельную запись. Пример

записи показан на рис. 1.2. Значением поля записи может

быть последовательность символов произвольной длины. В та¬

ком случае одномерный массив с произвольным числом эле¬

ментов можно представить или одним полем, или совокуп¬

ностью полей. В первом случае получим записи с полями пе¬

ременной длины, а во втором — записи с переменным числом

полей.

Совокупность записей одинаковой структуры называется

файлом. В то же время файлом называют набор данных,

представленный во внешней памяти и предназначенный для

длительного хранения и многократного использования. Для

того чтобы иметь возможность извлекать из файла отдельные

записи, каждой записи присваивают уникальный номер или

имя, которое служит ее идентификатором и располагается

в отдельном поле. Этот идентификатор называют ключом

записи. При ручной обработке в качестве ключа обычно ис¬

пользуют имя, адрес, дату или их комбинацию в форме, наи¬

более привычной для человека. Для упрощения обработки

записи обычно хранятся отсортированными по ключу — дате

или порядковому номеру дня. Символьный ключ при машин¬

ной обработке представляется последовательностью двоичных

чисел, соответствующих кодам символов ключа. Поэтому

можно считать, что ключ задан натуральным числом. Есте¬

ственно, это будет число с очень большим числом разрядов,

много большим, чем это необходимо для идентификации.

Мы рассмотрели четыре типа структур, являющихся сово¬

купностями элементов данных: массив, одномерный массив

переменной длины, дерево, запись. Более сложный тип

16

Глава 1

данных 1Может включать эти структуры в качестве элементов.

Например, элементами записи может быть массив, стек, де¬

рево и т. д. Для описания явлений реального мира, производ¬

ственных функций и т. п. используются самые различные

числовые и нечисловые данные. Возникает необходимость в

определении связей между ними и в разработке операций по

их преобразованию. Наиболее строгой формой такого описания

является алгоритм. Однако сам алгоритм во многом зависит

от того, как представлены в памяти структуры обрабатывае¬

мых данных. В свою очередь структура данных, естественно,

должна отражать структуру рассматриваемых явлений или

производственных функций, и необходимо, чтобы логические

связи между данными соответствующим образом поддержи¬

вались и на физическом уровне.

Методы представления логических связей в адресном про¬

странстве рассматриваются в следующем разделе. В заключе¬

ние в качестве подготовки к анализу этих методов обсудим

простой, но важный тип элементов данных, называемый ука¬

зателем. Значением указателя является адрес первого слова

записи или элемента данных. При этом в качестве значения

указателя может использоваться как абсолютный, так и от-,

носительный адрес (смещение по отношению к некоторому

заданному адресу). Необязательно, чтобы значение указа¬

теля было известно пользователю. Достаточно, если пользо¬

ватель понимает, па что ссылается тот или иной указатель

в каждый конкретный момент. Указатели могут использо¬

ваться и независимо, однако чаще всего указатель помещают

в одном из полей записи и используют для обозначения связи

с другими записями.

1.1.2. Представление структур

Как же реально представить в памяти структуру данных

того или иного типа? Обычно для однородных массивов по¬

стоянной длины используют последовательное представление.

В этом случае логически смежные элементы массива разме¬

щаются в физически смежных ячейках памяти. Последо¬

вательное представление нетрудно распространить и на

массивы более высокой размерности, располагая в последова¬

тельных ячейках памяти элементы массива в лексикографи¬

ческом порядке индексов (м,/2, • 4). Например, если в

случае двумерного массива через обозначим номер строки,

а через /2 — номер столбца, то массив окажется расположен¬

ным в памяти по строкам. В общем случае 6-мерному мас¬

сиву со списком индексов (о, /2, •••, ik), каждый индекс ко¬

торого принадлежит диапазону /у ^ /у ^ ги соответствует од¬

Данные

17

номерный массив, индекс которого меняется от 1 до II (г, —

— lf + 1)и может быть вычислен по формуле

1 + t (ч - h) П (Г, - h + 1), где п (ri-ll+l) = l.

/ = 1 i = /+1 i — k-\-1

Для представления одномерного массива с элементами

данных переменной длины можно или сделать их длину по¬

стоянной (из расчета на максимальную длину), добавив

в конце каждого элемента особый символ — признак конца

данного, или в начало каждого элемента ввести поле для

хранения текущей длины данного. В последнем случае утра¬

чивается возможность произвольного доступа, и каждый раз

при необходимости извлечения одного элемента приходится

прослеживать всю последовательность по порядку, начиная

с первого. Поэтому лучше подготовить отдельно одномерный

массив указателей, содержащий адреса размещения каждого

элемента. Этот метод применим для любых многомерных

массивов с элементами переменной длины и сводится к под¬

готовке массива указателей соответствующей мерности.

В случае периодического изменения числа элементов (масси¬

вов переменной длины) необходимо использовать более гиб¬

кое представление, которое рассмотрено ниже.

Можно образовать кольцо, используя для этого одномер¬

ный массив постоянной длины, при обращении к элементам

которого как только будет достигнут один конец массива,

сразу же переходить к другому концу. На базе кольца очень

просто реализовать очередь или двустороннюю очередь. Если

поддерживается баланс по числу операций включения и ис¬

ключения элементов очереди, то ячейки памяти, занятые оче¬

редью, последовательно перемещаются в направлении вклю¬

чения новых элементов. Для представления стека можно вос¬

пользоваться одномерным массивом, ограничив доступ к эле¬

ментам единственным индексом, указывающим на вершину

стека в данный момент. Нулевое значение индекса означает,

что стек пуст.

Если для представления стеков и очередей использовать

массивы с малым числом элементов, то очень велика вероят¬

ность их переполнения. Увеличение длины массивов не только

ухудшает использование памяти, но и не гарантирует от пе¬

реполнения. Если использовать массивы такой длины, чтобы

исключить возможность их переполнения, то часть памяти,

действительно занятая данными, окажется совсем небольшой.

Еще большим недостатком является то, что обработка будет

прекращена, как только переполнится хотя бы один массив,

отведенный под стек, несмотря на наличие достаточного

18

Глава 1

\л 14-»(7ТЯЧс I Ч~*~••• ~Нr I Ч-Нz I * I

£

а

Часть

мольцв

Список

свободной

памяти

B-CB-Q3-- -СИ

5

Рис. 1.3. Представление кольца и очереди с использованием указателей

(представление в связанной памяти):

а — кольцо; б — исключение из кольца (включение в кольцо). При исклю¬

чении сплошная стрелка заменяется на пунктирную, а при включении —

объема свободной памяти в других массивах. Естественно,

возникают вопросы: нельзя ли всю незанятую память, отве¬

денную для представления массивов переменной длины, ис¬

пользовать как общую; как это скажется на эффективности

использования памяти?

Эту проблему можно решить путем придания памяти

определенной структуры, связав между собой отдельные бло¬

ки (узлы) памяти с помощью указателей. Рис. 1.3, а иллю¬

стрирует идею связанного представления на примере кольца.

Прямоугольниками на рисунке показаны узлы памяти. Каж¬

дый узел состоит из двух полей. Одно поле содержит эле¬

мент или более сложную структуру данных, а другое — ука¬

затель на следующий узел. Стрелки на рисунке соответствуют

значениям указателей. Если последовательность представ¬

лена в связанной памяти, то операции включения и исклю¬

чения элементов в последовательность выполняются так, как

показано на рис. 1.3,6. Обе операции используют список

свободной памяти — при включении память занимается, а при

исключении возвращается в этот список. В любом случае

пунктирная на сплошную; в — двусторонняя очередь.

Данные

19

происходит изменение трех указателей. При этом из схемы на

рис. 1.3,6 следует, что при заданном указателе на узел, содер¬

жащий данное S, операции включения и исключения возможны

только «справа от S» и невозможны «слева от S». Операция

«исключить S» также невозможна. Одним из способов, позво¬

ляющих преодолеть эти ограничения, является использование

в каждом узле двух указателей, что будет рассмотрено ниже.

В этом случае станет возможным производить включение и

исключение справа и слева от S. Возможен и другой техни¬

чески простой прием. При необходимости «исключить узел 5»

перепишем в него данные узла, находящегося справа от S

(данное Г), а затем исключим узел справа (фактически бу¬

дет исключен узел, следующий за S,— узел, первоначально

содержавший данное Т). Аналогично может быть выполнена

и операция «включить слева от 5». Для этого вначале вклю¬

чим новый узел справа от S и перепишем в него данное 5,

затем запишем новое данное в узел, который прежде зани¬

мало данное S, и, наконец, передвинем указатель доступа

к структуре на узел, который теперь содержит данное 5.

Представление в памяти двусторонних очередей должно

обеспечить возможность доступа с обоих концов очереди. Это

может быть достигнуто использованием в каждом узле двух

указателей, как показано на рис. 1.3, в. В этом случае опе¬

рации включения и исключения потребуют изменения пяти

указателей.

Одномерный массив с возможностью его свободного изме¬

нения называется списком. Считается, что списки обеспечи¬

вают эффективное использование памяти. Надо помнить, что

для хранения указателей требуется дополнительная память,

а для работы с указателями — дополнительные операции.

Основной смысл применения указателей заключается не

столько в повышении эффективности обработки, сколько в

возможности представления более сложных структур. Ис¬

пользование указателей позволяет связывать между собой

самые разнообразные данные, что является основой представ¬

ления различных самых сложных структур, механизмов, яв¬

лений. Среди них особое место занимают сравнительно про¬

стые, но очень важные древовидные структуры. Например,

если для представления узлов бинарного дерева (см. гл. 2)

использовать записи с двумя указателями, как показано

на рис. 1.4, то можно производить обход дерева начиная от

корня в направлении концевых узлов. Операции исключения

или включения листа (концевого узла) выполняются очень

просто — изменением всего трех указателей.

В математике одним из базовых понятий является множе¬

ство. В области обработки данных операции над множествами

часто также весьма желательны. Однако представление в па¬

20

Глава 1

мяти множества, не имеющего структуры, представляет зна¬

чительную проблему, и обычно стараются обходиться без

них. Пусть, например, в трехмерном пространстве задано ко¬

нечное множество, состоящее из п точек. Как представить это

множество в памяти, чтобы иметь возможность выполнять

соответствующие операции? Если число элементов множества

постоянно и все элементы заранее известны — перенумеруем

их числами от 1 до п. Сами элементы множества — коорди¬

наты точек (Xi,yi,Zi) (/ = 1,2, ..., п) — будем хранить в мат¬

рице из (яХЗ) элементов. Тогда для представления любого

Н-Ч~Г|Гр

GaiTtjze czжш

Рис. 1.4. Представление бинарного дерева с использованием указателей.

подмножества этого множества можно воспользоваться од¬

номерным массивом из п битов (ри р2, • рп)У присваивая

pi (/-му биту) значение 1, если точка с номером / принадле¬

жит подмножеству, и 0, если не принадлежит. Такой логиче¬

ский массив обычно называют битовой картой. Операции над

множествами в таком случае сводятся к логическим опера¬

циям над соответствующими логическими массивами.

Если элементы множества заранее не известны, представ¬

ление в виде битовой карты становится невозможным. Такая

ситуация возникает, например, когда элементы множества

задаются при вводе или формируются в процессе вычислений

и передаются во внешнюю память. В этом случае приходится

хранить описание каждого элемента (обычно в виде записи),

действительно присутствующего в этом множестве, но теперь

операции над множествами потребуют поэлементного их про¬

смотра. Например, для операции пересечения надо будет

сравнивать каждый элемент одного множества со всеми эле¬

ментами другого.

Совокупность записей, принадлежащих множеству, мож¬

но разместить как в последовательной, так и в связанной па¬

мяти. При размещении в памяти множество наделяется струк¬

турой (свойственной используемой памяти), которая опреде¬

ляет способ доступа и возможные пути доступа к элементам.

В основе операций извлечения, изменения, включения и ис¬

ключения лежит операция доступа. Вторая глава посвящена

рассмотрению этих операций, составляющих основу обра¬

ботки данных.

Данные

21

1.1.3. Внутренняя и внешняя память

Выше отмечалось, что критерием выбора того или иного

способа представления данных в памяти является эффектив¬

ность доступа к данным. Доступ к данным, хранящимся во

внутренней памяти (оперативное запоминающее устройство)

ЭВМ, и к данным, хранящимся в ее внешней памяти (внеш¬

ние запоминающие устройства), имеет существенные отличия.

Объем внутренней памяти в связи с техническим прогрессом

быстро увеличивается, по той же причине еще быстрее растет

объем внешней памяти и уменьшается ее стоимость. Расши¬

ряется применение виртуальной памяти, которая позволяет

пользователям не вникать в тонкости различия между внут¬

ренней и внешней памятью; в практику стали входить такие

термины, как «адресное пространство». С ростом объемов

обрабатываемых данных использование внешней памяти ста¬

новится необходимым. Это в свою очередь требует понима¬

ния специфики использования внешней памяти и знания со¬

временного уровня ее развития.

Внутренняя (оперативная) память характеризуется сле¬

дующими особенностями:

1) Значительно меньший объем по сравнению с внешней

памятью.

2) Затраты времени на доступ к любым данным, распо¬

ложенным в любом месте памяти, одинаково малы. Если па¬

мять однородна, то не имеет значения, близко или далеко

друг от друга расположены ячейка, к которой только что

осуществлялось обращение, и ячейка, к которой будет про¬

изведено следующее обращение. В некоторых случаях целе¬

сообразно использовать в качестве внутренней памяти еще

более быструю кэш-память с последовательным доступом.

3) Затраты времени на доступ к сколь угодно большому

массиву данных много меньше или сравнимы с затратами

времени на операции по их обработке.

К внешней (вспомогательной) памяти относится память

на магнитных барабанах, дисках, лентах и других видах ЗУ.

По своим характеристикам она в значительной степени от¬

личается от внутренней памяти и обладает следующими осо¬

бенностями:

1) Большой объем, в несколько раз превышающий объем

внутренней памяти. Таким образом, для доступа ко всему

содержимому внешней памяти требуется такое время, кото¬

рым нельзя пренебречь.

2) Для того чтобы прочитать какую-то запись из внешней

памяти, необходимо: найти блок во внешней памяти, содер¬

жащий нужную запись; передать найденный блок по каналу

ввода-вывода из внешней памяти в буфер ввода-вывода

22

Глава 1

(часть оперативной памяти, выделенная специально для об¬

мена с внешней памятью); извлечь из буфера нужную запись.

При записи выполняются аналогичные действия, но в обрат¬

ном порядке — данные, подлежащие записи, сначала пересы¬

лаются в буфер, а затем поблочно передаются по каналу

ввода-вывода и записываются во внешнюю память. Для

уменьшения затрат времени на чтение разрабатываются спе¬

циальные устройства, позволяющие извлекать из внешней

памяти только необходимые данные, но широкого распростра¬

нения такие устройства пока не получили из-за своей слож¬

ности.

3) Какой метод доступа к нужному блоку внешней памяти

окажется целесообразнее — непосредственный, не зависящий

от расположения других блоков, или последовательный, в по¬

рядке их физического размещения в памяти, — зависит как

от аппаратуры, так и от операционной системы. Обычно ме¬

тоды последовательного доступа оказываются проще и тре¬

буют меньших затрат времени.

Методы доступа и способы представления данных в па¬

мяти тесно связаны между собой. Вопросы, связанные с ними,

рассматриваются в последующих главах.

1.2. Обобщенные структуры данных

Существует большое разнообразие сложных типов дан¬

ных, но исследования, проведенные на большом практическом

материале, показали, что среди них можно выделить не¬

сколько наиболее общих. В этом разделе познакомимся с не¬

которыми из них. Для каждого типа были детально исследо¬

ваны характеристики, предложен язык или подобие языка

для их машинной обработки, разработана эффективная си¬

стема операций. Здесь рассматриваются результаты этих

исследований в самом общем виде, обсуждаются не столько

специальные языки или системы для работы с такими общими

структурами данных, сколько возможность использования их

важнейших свойств в рамках универсального языка. Общие

структуры называют также моделями данных, так как они

отражают представление пользователя о данных реального

мира.

1.2.1. Отношение

Даже очень большая совокупность записей, каждая из ко¬

торых содержит п полей, всегда может быть представлена

двумерной таблицей. В общем случае можно утверждать, что

в форме таблицы можно представить самые разнообразные

данные. Это могут быть таблицы курса акций, спортивных

Данные

23

результатов, теле- или радиопрограмм и т. п. В виде таблицы,

например, можно представить данные накладных, оформляе¬

мых при конторских операциях на предприятии или между

предприятиями, данные доклада и т. д. Таблица представляет

собой достаточно общий тип данных, наиболее доступный для

понимания. Таблица, имеющая форму, показанную на

рис. 1.5, а, называется отношением. Структурно каждая стро¬

ка таблицы представляет собой запись и называется корте¬

жем, или выборкой отношения. Столбцы таблицы называют

атрибутами отношения; каждый атрибут Л/ задает область

определения элементов данных ац (i= 1, ..., m). Совокуп¬

ность данных, представленная несколькими отношениями, на¬

зывается реляционной моделью. На рис. 1.5,6 и 1.5, в пока¬

заны примеры отношений. Пример на рис. 1.2 тоже можно

считать отношением. Отношение можно рассматривать как

множество элементов (лиц, организаций, изделий, торговых

сделок, конторских операций и т. д.), свойства которых выра-.

жены значениями кортежей. Однако можно считать также,

что таблица задает связь между атрибутами (столбцами таб¬

лицы). Например, карточка каталога содержит название од¬

ной книги, имеющейся в библиотеке, но одновременно с этим

связывает между собой данные, относящиеся к автору, изда¬

тельству, области науки. По совокупности карточек можно

получить ответы на такие вопросы, как: «Какое издательство

издает массовым тиражом книги по вычислительной технике?

В какой области знаний специализируется данный автор?»

и т. д. Именно поэтому и используют термин «отношение».

Отношение а < Ь между двумя действительными числами

а и Ь определим как подмножество М ={{хуу)\ (х, у)^

eRXR уХ<у} декартова произведения RXR={(x,y);

x^Ry у е R} множества R всех действительных чисел. Те¬

перь это отношение можно записать как (а,Ь)^М. Отноше¬

ние а = Ь можно определить аналогичным образом. Говорят,

что элементы множеств А и В находятся в функциональной

зависимости, если (a,b)^G и G={(xyy)\ (х,у)^А'ХВ,

y = f{x)} являются подмножеством А X В = {(х, у); х <= Л,

i/gB}. Для обозначения этого свойства обычно используется

запись вида /: А-+В или b = f(a). Если Л ={2,3}, В =

= {1, 2, 3 ,4, 5, 6}, то отношение делимости b на а (аеД

JgB) означает, что (а, Ь) принадлежит подмножеству

А\В, содержащему {(2,2), (2,4), (2,6), (3,3), (3,6)}. Это

подмножество можно представить в виде таблицы, показан¬

ной на рис. 1.5,г. Итак, любое подмножество Ау^В является

отношением. Если подмножество конечно, то его можно пред¬

ставить в виде таблицы. Отношение R на рис. 1.5, а также

представляет собой конечное подмножество, состоящее из

иг элементов декартова произведения множеств Ах X АгХ •••

ДОХОД-ОТ-ЛРОДАЖИ ИЗДАНИЙ

в

о

сз

к»

Qj

ll

? ll

1-5 *

't § I

g Q> §

S 13 ^

<§

QQ

CSJ ^ со Оъ со

C\j CNj CN] Го

J

|§

II

l§

j

s V5

1^

& *

it

i2

%

'I

!*

4I

iй

?3

1*1

r

4

ll

Ss

iS 4

I ^

II

1

a £

1^

£«

*v ^

l!

S<*

|g

1*

1 £

t|

Й_1_

,§

ll

I

в

В

’ tt

+

В

Он

О

VO

«£)

«=5

<v

4

О

5

<*3

s

Oh

H

В

о

Он

О

E-

O

В

<u

в

Ю

. s ^

. tJ -

<N К CO

a“ S ei

7Г ® °Q

£ *■ Ш

.r S ■*

<v я

- B 1

- о £?

0

с

1

-'О

E-1

>»

VO

9S

s

3

* 3*

a

о

к

E->

О

в

в

о

с

в

а

X

Я

в

Данные

25;

... X. Ап. Например, какой смысл заключен в отношении, по¬

казанном на рис. 1.5, д? Аналогично другим типам данных

это отношение также целиком относится к расчетным таб¬

лицам.

Поясним рис. 1.5, а. Отношение может периодически ме¬

нять свое содержание и число кортежей за счет включения,

исключения или обновления данных. Все конкретные значе¬

ния атрибута не только являются элементами данных одного

типа, но имеют одинаковую семантику (например, если част¬

ное лицо будет рассматривать «доход» фирмы как собствен¬

ный «доход», получится «злоупотребление доверием»). По¬

рядок атрибутов в отношении может быть произвольным.

Обычно порядок следования атрибутов устанавливают с уче¬

том семантики отношения. Предполагается, что все кортежи

отношения различны, а порядок их следования может быть

произвольным.

Прежде чем дать определение традиционных операций

над отношениями, отметим, что результатом выполнения лю¬

бой операции является отношение, а сами операции делятся

на унарные и бинарные.

1) Операции над множествами. Пусть R и 5 — произволь¬

ные отношения, определенные на множествах Аи А2, ..., Ап.

Поскольку отношения R, S являются подмножествами декар¬

това произведения, то к ним применимы все операции над

множествами, такие, как объединение, пересечение, вычита¬

ние и т. д.

2) Прямое произведение. Пусть R и S — произвольные от¬

ношения, определенные на множествах Аь А2, ..., Ап и

Ви В2> Bk соответственно. Тогда прямое произведение

этих отношений будет подмножеством декартова произведе¬

ния А! X .. • ХАпХВ !Х ... ХВк9

R ® 5 = {(г, s) | г €= R, sg S},

где '(г, s) — кортеж, состоящий из (п + k) элементов, пред¬

ставляющий собой конкатенацию кортежа г п-й степени и

кортежа 5 k-й степени.

3) Проекция. Пусть R — произвольное отношение, опре¬

деленное на множествах Ль Л2, ..., Ап, а В — подмножество

списка атрибутов отношения R, В = Ап X Л/2Х ••• X Ajky

{/1, ..., jk} с= {1, ..., п}. Обозначим через г [Aj] /-й элемент

г-го кортежа отношения R, тогда

R [В] = {г [в] = (г [А/Ч], г [Л/2], •.., г [Ajk]); г е= R}

называется проекцией R на В. Результирующее отношение-

получается из отношения R исключением атрибутов, отлич¬

26

Глава 1

ных от Л/i, ..., Ajk. При этом также исключаются повторяю¬

щиеся кортежи для выбранных атрибутов. Например:

R: А\

А2

Л3

R [А2 X Л3]: А2

Л3

а

2

X

2

X

b

1

У

1

У

а

2

У

2

У

Ь 2 х

4) Соединение. Обозначим через 0 произвольную опера¬

цию сравнения =, Ф, >, С, Пусть отношения R и

S имеют соответственно атрибуты А и В и эти атрибуты

сравнимы. Это означает, что А и В определены на одной

области, например содержат или натуральные числа, или

действительные числа, или буквы английского алфавита (в

последнем случае 0 ограничивается только операциями =

и Ф). В этом случае R[AQB]S ={(ry s); re/?, seS,

г [Л] 0s [Б]} называют 0-соединением отношений /?, S по ат¬

рибутам Л, В. Например:

R: Ах

to

Л3

S: В,

в2

а

1

и

2

и

а

2

V

3

X

b

4

V

4

W

с

2

W

с

3

и

R [Л3 = В2] S: А,

а2

А?,

Вх

В2

R[A2>Bx]S: Л,

а2

Лз

Вх

в2

а

1

и

2

и

Ъ

4

V

2

и

с

2

W

4

W

b

4

V

3

X

с

3

и

2

и

с

3

и

2

и

При соединении в результирующем отношении образуются

пары полностью совпадающих атрибутов. Один из них можно

исключить, выполнив проекцию на список атрибутов, в кото¬

ром один из атрибутов отсутствует. Соединение, обладающее

этим свойством, называют естественным соединением. Если

0 — произвольный двухместный предикат, то можно дать бо¬

лее общее определение соединения.

5) Деление. Пусть отношения /?, S имеют общее частич¬

ное прямое произведение В = С. Обозначим через Всу Сс

Данные

27

частичные прямые произведения, не входящие в В, С соот¬

ветствующих областей определения:

ве

s:

Отношение R можно рассматривать как отображение Вс

на Bt вообще говоря, не единственное. Пусть множество ото¬

браженных значений для подмножества х элементов Вс кор¬

тежа отношения R имеет вид

g(x\ R, B) = {r[B]\ r<=R, г[Вс] = х}.

Множество, включающее все значения хаВс проекции 5

на С, S[C] (подмножество 5[ВС]),

R[B + C]S = {r [Вс); г е= /?, S [С] с= g (г [Вс]\ R, В)}

называется результатом деления отношения R на отноше¬

ние S по атрибутам В, С. Например:

R: Вх

в2

въ

S: Сх

с2

а

1

X

X

1

а

1

У

X

2

Ь

2

X

У

1

/ПВзЧ-С,^: В, В2 (R[B2XB3])[B2 + C2]S: В3

х

У

1

Результат операции представляет собой отно¬

шение, состоящее из кортежей отношения /?[BiX52], ото¬

бражение которых полностью включено в S[Ci],

6) Ограничение. Если атрибуты Л, В отношения R сравни¬

мы в том смысле, какой имелся в виду при рассмотрении

соединения, и если обозначить операцию сравнения через 8,

то выражение

R [АВВ] = {r\ r<=R> г [А] Вг [В] }

называется В-ограничением отношения R. Рассмотренное выше

8-соединение может быть выражено через операции прямого

произведения и 0-ограничения

R [ABB] S = (R&S) [ABB]

28

Глава 1

Например:

R i А\ А2 Л3 R [А2 = А3]: А\ А2 Л3 R [А2 > A^\i А\ А2 Л3

р 3 5 <733 ^64

q 3 3 г 2 2

^64

г 2 2

В заключение определим специфическое отношение-кон*

станту, содержащее всего один кортеж и один атрибут {а)\

здесь а является константой с областью определения А. Ис¬

пользуя рассмотренные операции, можно сформулировать

различные запросы к реляционной модели данных. Рассмот¬

рим примеры построения запросов к реляционной модели,

содержащей три отношения:

ДЕТАЛЬ: (номер-детали, тип)

СКЛАД: (номер-склада, место-расположения)

ХРАНЕНИЕ: (номер-детали, номер-склада)

Получить номера складов, где хранится деталь под номе¬

ром 13:

(ХРАНЕНИЕ [номер-детали = номер-детали] {13}) [номер-

склада]

Здесь {13} представляет собой отношение-константу, кон¬

станта задает номер конкретной детали из всего допустимого

множества номеров.

Получить номера складов, на которых отсутствуют детали

типа а:

(ХРАНЕНИЕ [номер-детали ф номер-детали] (ДЕТАЛЬ

[тип = тип] {а})) [номер-склада]

Определить место расположения складов, где хранятся все

детали типа а:

(СКЛАД [номер-склада = номер-склада] (ХРАНЕНИЕ [но¬

мер-детали Ч- номер-детали] (ДЕТАЛЬ [тип = тип] {а})))

[место-расположения]

1.2.2. Структуры данных и отношения

1) Массив

Отношение ДОХОД-ОТ-ПРОДАЖИ (рис. 1.5,6) имеет

следующую структуру:

(название-магазина)Х (месяц)Х (шифр-изделия)X (выручка)

Это отношение можно представить трехмерным массивом

Данные

29

данных выручка, используя в качестве индексов конкретные

значения названий магазинов, месяцев и шифров изделий.

Сечения массива выручка по магазинам показаны на

рис. 1.6. Отметим, что отношение содержит только те данные,

НАЗВАНИЕ-МАГАЗИНА НАЗВАНИЕ-МАГАЗИНА

1-я половина 2-я половина

Рис. 1.6. Представление отношения ДОХОД-ОТ-ПРОДАЖИ

(рис. 1.5, б) трехмерным массивом Выручка.

которые соответствуют конкретной выручке. Таким образом,

чтобы зафиксировать «выручку от продажи нового изделия

за конкретный месяц в конкретном магазине» в отношение

ДОХОД-ОТ-ПРОДАЖИ достаточно добавить всего одну вы¬

борку. Для представления отношения трехмерным массивом

выручка необходимо заранее знать все месяцы, названия всех

магазинов и шифры всех изделий. Если различных магазинов

и товаров много, а предполагаемый период времени продол¬

жителен, то построить трехмерный массив, который охваты¬

вал бы все эти данные, может оказаться очень сложно. По¬

этому в общем случае трудно сказать, какое представление

лучше, — все зависит от конкретных условий.

2) Иерархическая структура

Часто возникает необходимость отдельные поля записи

одного типа рассматривать как набор записей другого типа.

На рис. 1.7, а двойной рамкой выделены поля, соответствую¬

щие наборам записей, а одинарной — элементам данных.

В общем случае каждый экземпляр записи верхнего уровня

может иметь произвольное число экземпляров подчиненных

записей. Совокупность записей имеет структуру дерева, и

подчиненная запись не может существовать без своего пред¬

шественника по иерархии. Все подчиненные записи в наборе

имеют одинаковую структуру. Элементы данных, выстраи-

30

Глава 1

Иод

сотрудника

Служащие

фирма/

х

Фами¬

лия

Профес¬

сия

биогра¬

фия

Дата рож¬

дения

НаименоВа -

ние плана

ИждиВенцы

Распределение

работ

План

Имя

—1

отношения

СЛУЖАЩИЕ

ФИРМЫ

БИОГРАФИЯ

Нод-

сотрудника

Фами¬

лия

Иод-

сотрудника

Профес¬

сия

Дата -

рожд.

ПЛАН

Иод -

сотрудника

Профес¬

сия

Наименование

- плана

Распредг

работ

Родственные -

ИЖДИВЕНЦЫ

Иод-

сотрудника

Имя

1

...

1

1

Рис. 1.7. Реляционная и иерархическая модели: а — иерархический файл;

б — представление с помощью отношений.

ваясь в последовательности, образуют структуры, которые

похожи больше на аллеи (дерево с параллельными ветвями),

чем на деревья. Структуры, в которых каждая подчи¬

ненная запись имеет только одну непосредственно пред¬

шествующую запись, называются иерархическими моделями

данных.

Можно представить иерархию в виде реляционной модели,

как показано на рис. 1.7,6; число отношений в этой модели

будет равно числу элементов дерева, заключенных в двойную

рамку. В этом случае элемент данных код-сотрудника будет

ключом отношений ПЕРСОНАЛ, БИОГРАФИЯ, ИЖДИВЕН¬

ЦЫ; для отношения ПЛАН ключом будет (код-сотрудника,

профессия). Считается, что иерархическая структура проста

для понимания и подходит для описания современных орга¬

Данные

31

низаций, классификации и т. п. Реляционная модель позво¬

ляет отображать иерархическую структуру и в этом смысле

является более общей моделью.

3) Спецификация

Спецификация указывает, из каких узлов и деталей со¬

стоит механизм (такой, например, как автомобиль), и содер¬

жит основные данные для сборочного цеха. Поскольку одни

и те же детали, такие, как винты, используются практически

в каждом узле, спецификация имеет форму, показанную на

рис. 1.8, а. Собственно «деталями» в спецификации такого

вида являются только элементы Е, G, Я, F. Можно заметить,

что спецификация в виде совокупности деревьев содержит

избыточность. После объединения этих деревьев с учетом

I—

В, 2

0,1

Ej F}J.

“1

Е,3

I

С,2

Су 1 1), 1

D

~1

с, г

“I

// 1

л

ЛЛ

ДЕТАЛИ

Исход¬

ный

Порож¬

денный

• Коли¬

чество

А

В

2

А

с

1

А

Е

3

В

С

А

/

В

л

1

В

Е

2

С

£

1

с

F

3

с

9

2

л

F

1

л

И

1

ПОРОЖДЕННЫЕ

ОБЪЕКТА А

В 2

О 1

Е 3

ПОРОЖДЕННЫЕ

ОБЪЕКТА С

Летам н™“}0

£ 1

F 3

G 2

ПОРОЖДЕННЫЕ

ОбЪЕНТА В

Детали ТеТтво

С 1

Д 1

Е 2

ПОРОЖДЕННЫЕ

ОБЪЕНТА D

Детали

F

Н

Рис. 1.8. Спецификация:

а — одно из представлений спецификации: «А состоит из двух В, одного С,

трех £», ..., «D состоит из одного F, одного Я»; б — представление спе¬

цификации в виде графа; в — представление в виде одного отношения;

г — представление в виде четырех отношений, соответствующих а.

32

Глава 1

вхождения в узел более мелких узлов и деталей получится

структура, отличная от иерархической (рис. 1.8,6). Струк¬

тура, в которой любой элемент может быть связан с любым

другим элементом, называется сетью. Сетевые модели опи¬

сывают наиболее общий случай связей между данными типа

«исходный-порожденный».

Спецификация может быть представлена одним отноше¬

нием, как показано на рис. 1.8, в. Однако в этом случае за¬

просы вида «Определить количество деталей каждого типа,

входящих в узел В» сведутся к выполнению последовательно¬

сти операций естественного соединения исходного отношения

с самим собой или результатом предыдущего соединения по

атрибутам «исходный-порожденный». И так до тех пор, пока

результирующее отношение не будет содержать в атрибуте

порожденный никаких других значений, кроме Е, G, Н, F.

Рассмотренная реляционная модель не является единствен¬

ной. Список деталей можно представить и в виде четырех

отношений (рис. 1.8,г), непосредственно соответствующих

исходным деревьям (рис. 1.8, а). Но в этом случае потребу¬

ется разрешить использовать имена отношений в качестве

элементов отношений.

4) Списочная структура

Совокупность данных, структурные свойства которой огра¬

ничены лишь относительным расположением элементов, на¬

зывается списком. Список — это массив неопределенной дли¬

ны с элементами разных типов. Списочная структура пред¬

ставляет собой список, элементами которого могут быть

списки и списочные структуры. Списочная^структура является

рекурсивной структурой данных, что следует из самого опре¬

деления. Например, следующие строки:

1) {constantу pi, е)

2) (constant, {pi, 3.14), {е, 2.72))

3) {{{а, +, Ь), X, с), {{d, X, е), +, !))

являются списочными структурами. Чтобы отличить сугубо

специальный смысл слова «список» и чтобы подчеркнуть это,

обычно пишут его с большой буквы: «Список». Первая строка

представляет собой список. Вторая — списочную структуру,

так как содержит в качестве элементов два списка, {pi, 3.14)

и (е, 2.72). Первая и вторая строки являются списочными

структурами; первая состоит из трех элементов данных, а

вторая — из элемента и двух списков. Третья строка пред¬

ставляет собой арифметическое выражение {a+b)c/{de-\-f).

По определению арифметическое выражение представляет

Данные

33

собой (операнд, знак операции, операнд); операнд может

быть константой, переменной или арифметическим выраже¬

нием. Представление арифметического выражения Списком

следует из рекурсивного характера самого определения.

К операциям над списочными структурами (Списками)

относятся: исключение части Списка, и в частности одного

элемента; конкатенация (объединение) двух Списков; вклю¬

чение элемента в Список. Кроме перечисленных операций

АРИФМЕТИЧЕСКОЕ-ВЫРАЖЕНИЕ

№ формулы

1-й операнд

2-й операнд

Операция

(1)

а

ь

+

(2)

(1)

с

X

(3)

(2)

(5)

-7-

(4)

d

е

X

(5)

(4)

f

—

Рис. 1.9. Представление арифметического выражения в виде отношения.

считаются определенными и обычные операции над элемен¬

тами данных. Типичным языком, применяемым для обработки

списочных структур в ЭВМ, является Лисп. Ему посвящены

многие учебники, к которым авторы рекомендуют обратиться

при необходимости.

Списочные структуры больше подходят для обработки не¬

большого числа сложно организованных данных, чем для

обработки большого числа данных одинаковой структуры.

Таким образом, роль списочной и реляционной моделей ока¬

зывается различной. Список — очень гибкая структура, по¬

этому если он неупорядочен и сложен, то и методы обработки

такой структуры также окажутся сложными. Более удобной

для обработки будет та структура, которая больше соответ¬

ствует структуре реального объекта. В вышеприведенном

примере третья структура представляет собой одну из таких

типичных моделей, вторая структура составлена из двух мо¬

делей: (constant, <pair>, <pair>, ...), где <pair> в свою оче¬

редь представляет собой модель (буква английского алфа¬

вита, число).

Если арифметическое выражение (3) представить отноше¬

нием, то получим таблицу, показанную на рис. 1.9. Это отно¬

шение содержит данные с разными областями определения

первого и второго операндов, однако его можно считать

представлением, удобным для обработки. Здесь одна формула

соответствует одному отношению и обработка отношения

2 Зак. 127

34

Г шва 1

потребует многократного выполнения одной и той же опера¬

ции, как и в рассмотренном ранее примере спецификации, что

отличает эту обработку от обработки рассмотренных ранее

примеров отношений.

5) Массив общего вида

Наиболее общая структура данных, охватывающая все

рассмотренные ранее структуры, такие, как массив, файл,

отношение, списочная структура и т. д., называется массивом

общего вида. Таким образом, массивом общего вида называ¬

ется массив, элементы которого не обязательно относятся

к одному типу данных. Массив общего вида допускает в ка¬

честве элементов использовать другой массив общего вида.

Какие операции могут потребоваться для работы с массивами

общего вида? Естественно, в их число должны входить опе¬

рации, которые описаны выше для рассмотренных структур

данных. Однако пока трудно дать более детальные рекомен¬

дации по практической реализации этих операций и по ме¬

тодам представления массива общего вида в памяти — эти

вопросы находятся пока в стадии исследования.

1.3. Динамическое распределение памяти

1.3.1. Простые методы

В языках * программирования данные разных типов, рас¬

смотренные в разд. 1, представляются чаще не в виде кон¬

стант, а в виде переменных. В данном случае понятие «пере¬

менная» наделяется дополнительными свойствами, отлич¬

ными от привычного «изменять значение». Первое касается

использования имен в тексте программы: устанавливается,

одному или разным данным соответствуют одинаковые имена

переменных в основной программе и в подпрограмме. Обыч¬

но, если нет специального указания (по умолчанию), области

действия имен устанавливаются в соответствии с определен¬

ными соглашениями — стандартом языка. Наряду с этим су¬

ществует возможность установить области действия имен пе¬

ременных уже или шире стандартных. Второе свойство дик¬

туется необходимостью определения времени распределения

памяти для переменных: до начала выполнения программы,

в момент обращения к подпрограмме или позднее, а также

метода распределения — статического или динамического.

В дополнение к этим свойствам иногда имеется возможность

указать, когда память, выделенная для размещения перемен¬

ных, становится ненужной и может быть распределена по¬

вторно.

Данные

35

Следует ли это свойство связывать с понятием типа пере¬

менной— вопрос особый; лучше, если пользователи не будут

углубляться в этот вопрос. На практике во многих случаях

в этом нет необходимости, так как память не очень загру¬

жена. Например, из-за того, что в языке Фортран рекурсив¬

ный вызов подпрограммы не допускается, отношение между

вызывающей и вызываемой программами имеет вид типа

«исходный-порожденный», и все необходимое распределение

памяти может быть выполнено при обращении к подпро¬

грамме. Поэтому для Фортрана достаточно стекового меха¬

низма управления памятью. Если при этом необходимо выде¬

лять память и для буферов ввода-вывода, то для управления

Область памяти Вызываемые

подпрограммы

Программа^ ^ронстанты^е^мшые^^ памяти ввода-вывода

Свободная Помят для

область буферов |

овода-вы вот

г/г/м

Основная

программа

Подпро¬

грамма А

Подпро -

грамма В

Рис. 1.10. Свободная область памяти организована в виде дека.

памятью можно использовать двустороннюю очередь (см.

рис. 1.10).

В некоторых случаях не удается так просто решить про¬

блему управления памятью.

1) Бывают случаи, когда в процессе обработки данные

промежуточных расчетов оказываются многочисленными и

громоздкими; хотя эти данные уже не нужны, они продол¬

жают занимать память, в то время как появляется необхо¬

димость в размещении новых данных. Обработка списков

относится именно к такому случаю.

2) Для задач обработки данных в реальном масштабе

времени невозможно предсказать изменение объемов обра¬

батываемых данных, что необходимо учитывать при реализа¬

ции таких задач на ЭВМ.

3) Операционная система с разделением времени должна

распределять память в соответствии с требованиями пользо¬

вателей.

4) Часть внешней памяти в соответствии с требованиями

пользователей должна распределяться между постоянными

и временными файлами.

Рассмотрим коротко методы, которые применяются в этих

случаях.

В разд. 2 встречался случай, когда область памяти (пул

памяти) (все равно—внешней или оперативной), предназна¬

ченная для использования, делилась на равные блоки, ко¬

торые по мере требований предоставлялись пользователям,

причем, когда они оказывались ненужными, пользователи

2*

36

Глава 1

возвращали их обратно для повторного использования. В этом

случае список свободных блоков можно организовать в виде

стека, а для освобождения использовать метод «сбора му¬

сора». В этом методе ставшие ненужными отдельные блоки

возвращаются в память одновременно — в момент, когда спи¬

сок свободного пространства пуст. Для выявления неисполь¬

зуемых блоков достаточно исключить из всей области исполь¬

зуемые блоки. Конкретные способы выявления последних

л-\Размеи |

-ь| Размер |

Занятый

Занятый

+ 1

+ 1

Рис. 1.11. Метод управления блоками с граничными признаками. Если сво¬

бодные блоки оказываются смежными в памяти, они объединяются.

зависят от структур обрабатываемых данных и особенно Ча¬

сто обсуждаются для списочных структур (поэтому здесь эти

способы не рассматриваются). Ниже разберем случай управ¬

ления памятью для блоков разных размеров, требуемых поль¬

зователями.

Пусть вся память, подлежащая распределению, представ¬

ляет собой один блок, содержащий конечное число ячеек с

непрерывно следующими адресами. Первоначальное распре¬

деление может быть выполнено очень просто — путем после¬

довательного уменьшения первоначального блока по каждому

запросу. Когда вся память блока будет распределена, оче¬

видно, несколько блоков станут ненужными и их память мо¬

жет быть использована повторно. Однако, если операцию по¬

вторного распределения использовать многократно, свободные

блоки будут становиться все меньше и меньше, поэтому перед

повторным распределением проводится уплотнение памяти—

перемещение всех занятых блоков в последовательные ячейки

для того, чтобы всю свободную память собрать вместе в один

блок. Если область памяти имеет достаточно большие раз¬

меры, необходимость в повторных уплотнениях возникает

редко.

Однако можно избежать больших затрат времени на пе¬

ремещение данных, если во все блоки, свободные и занятые,

включить небольшую служебную информацию специально

для управления памятью. Сущность этого метода заключа¬

ется в следующем (см. рис. 1.11). Свободные блоки объедини-

Данные

37

ются ь двухсвязанный список. В начале и в конце каждого

блока хранятся логические значения, показывающие, занят

или свободен данный блок, а для свободных блоков — и их

размеры. Благодаря этому, как только находящийся в про¬

цессе использования (занятый) блок становится ненужным,

проверяется, свободны или заняты блоки, смежные с ним по

памяти; если они свободны, их можно объединить. При рас¬

пределении список свободных блоков просматривается по¬

следовательно, пока не встретится блок размера не меньше

требуемого. Как только такой блок найден, достаточно вы¬

делить из него блок требуемого размера, а из оставшейся

части образовать новый блок. Если найденный свободный

блок лишь немного больше требуемого, то лучше занять его

полностью, чем оставлять небольшой блок в списке. В про¬

тивном случае образовавшиеся в разное время маленькие

свободные блоки имеют тенденцию скапливаться в начале

списка и увеличивают время поиска. Для того чтобы избе¬

жать этого, список свободных блоков лучше организовать

в виде кольца и каждый раз операцию поиска начинать

с того места кольца, где закончилась предыдущая.

Возможности различных методов динамического управле¬

ния памятью зависят от характера распределения размеров

требуемых блоков, частоты резервирования и освобождения

(по отношению к работе, затрачиваемой на обработку дан¬

ных), разброса времени существования каждого блока. По¬

этому анализ этих методов очень сложен. Если требуются

блоки достаточно больших размеров (сравнимых с размером

пула памяти), то, естественно, легко наступит «банкротство»

(переполнение) пула. Если времена существования блоков

примерно одинаковы, то список становится близким к оче¬

реди с дисциплиной обслуживания «первым включается —

первым исключается», и тогда больших проблем не возни¬

кает. Если же времена существования блоков имеют боль¬

шой разброс и сильно смещены в сторону малых времен, то

список становится близким к стеку с дисциплиной обслужива¬

ния «последним включается — первым исключается», и в этом

случае также особых трудностей нет. Когда, несмотря на из¬

быток свободной памяти, достаточно большие блоки отсут¬

ствуют, приходится использовать уплотнение. Однако даже

полное уплотнение не гарантирует от возможного краха, если

вероятность запросов на большие блоки велика.

Если оперативная память исчерпана, часть занятых бло¬

ков можно освободить, переписав их содержимое во внешнюю

память. Однако оказывается совсем не просто определить,

какие блоки следует освобождать, но здесь эти вопросы под¬

робно обсуждаться не будут. При использовании виртуальной

38

Глава 1

памяти это производится автоматически, но появляется

другая проблема — рассредоточение активных адресов па¬

мяти, ухудшающее эффективность.

1.3.2. Метод близнецов

1) Метод близнецов с бинарным разбиением

Итак, управление памятью без ограничения на размеры

резервируемых блоков требует довольно много времени.

Если же размеры резервируемых блоков ограничить 2к (k =

= 0,1,2, ...), то работа по управлению памятью чрезвы¬

чайно упростится. Если требуемый размер блока памяти не

является степенью 2, то выделяется больший блок минималь¬

ного размера 2*. Далее, если нет свободного блока размером

2й, то блок требуемого размера получают делением большего

блока на 2,4, ... части. Для простоты примем, что размер

пула памяти равен 2п. Идея распределения памяти в методе

близнецов показана на рис. 1.12. При разделении некоторого

блока на две части полученные блоки по отношению друг

к другу называются близнецами (или братьями). Близнецы

вновь могут делиться. Свободные блоки объединяются

в списки по размерам, а головные узлы этих списков собраны

в таблицу. При резервировании блока размером Ь находят

минимальное значение /г, удовлетворяющее требованию

b ^ 2к, и начинают поиск свободного блока с k-то списка;

если окажется, что список пуст, то ищут блок размером

2*+1, 2k+2, .... Как только свободный блок будет найден, он

удаляется из списка. Если окажется, что найденный блок

больше требуемого, его делят на две части. Одну из них (од¬

ного близнеца) включают в список соответствующего раз¬

мера, а другой передают пользователю или вновь делят.

При освобождении блока проверяется состояние его близ¬

неца, и если он свободен, то вначале он исключается из

списка, а затем близнецы объединяются в один блок. Для

полученного блока снова проверяется состояние его близнеца.

Смежные по памяти блоки одинакового размера не объеди¬

няются, если они не являются близнецами. Блок, ставший

свободным, включается в соответствующий список. На

рис. 1.12,6 показано, как в случае освобождения блока раз¬

мером 1 (отмечен стрелкой) дважды производится объеди¬

нение близнецов и в результате получается блок размером 4.

Показанные слева два свободных блока размером 2 являются

смежными, но не объединяются, поскольку не являются близ¬

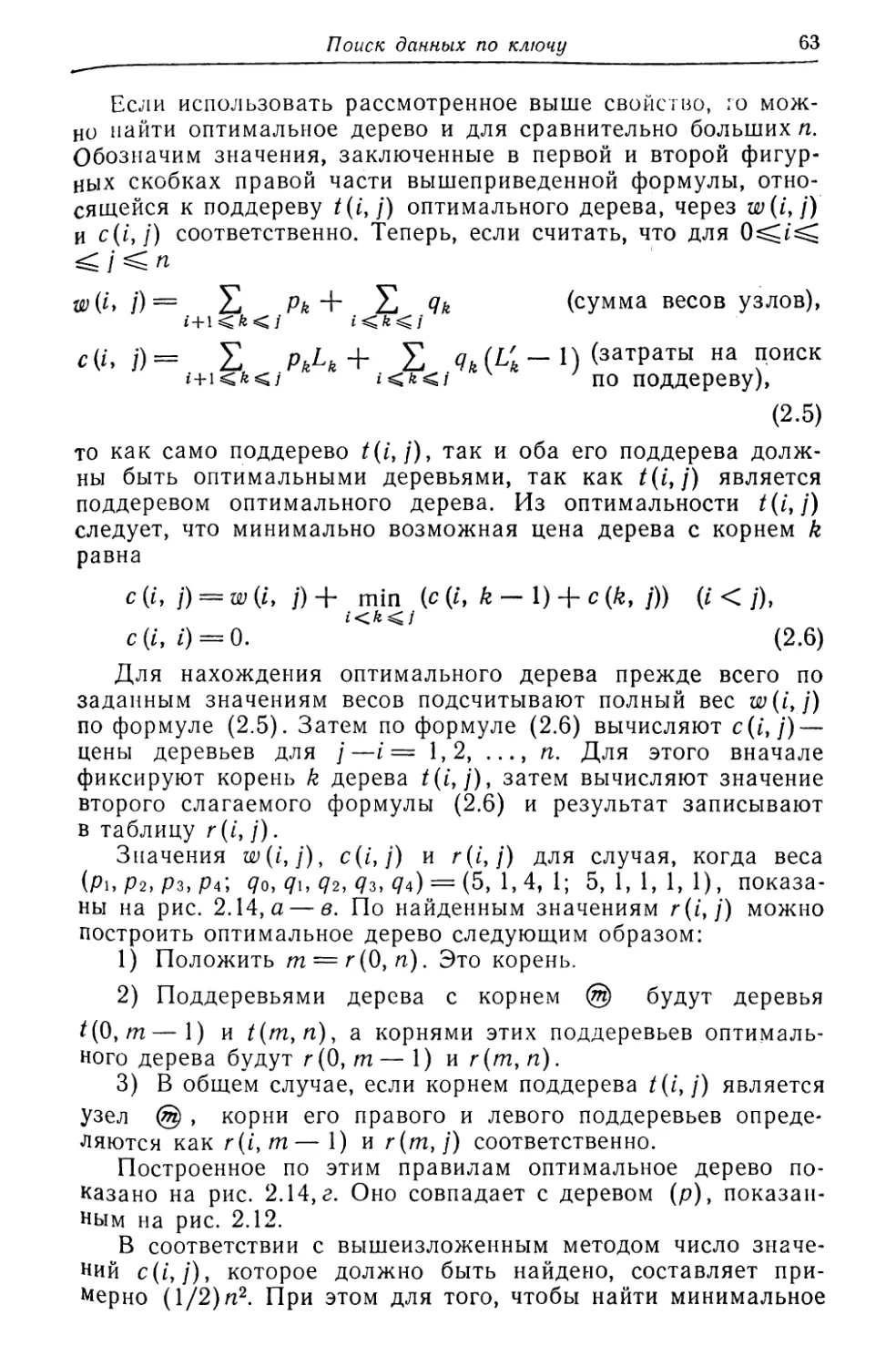

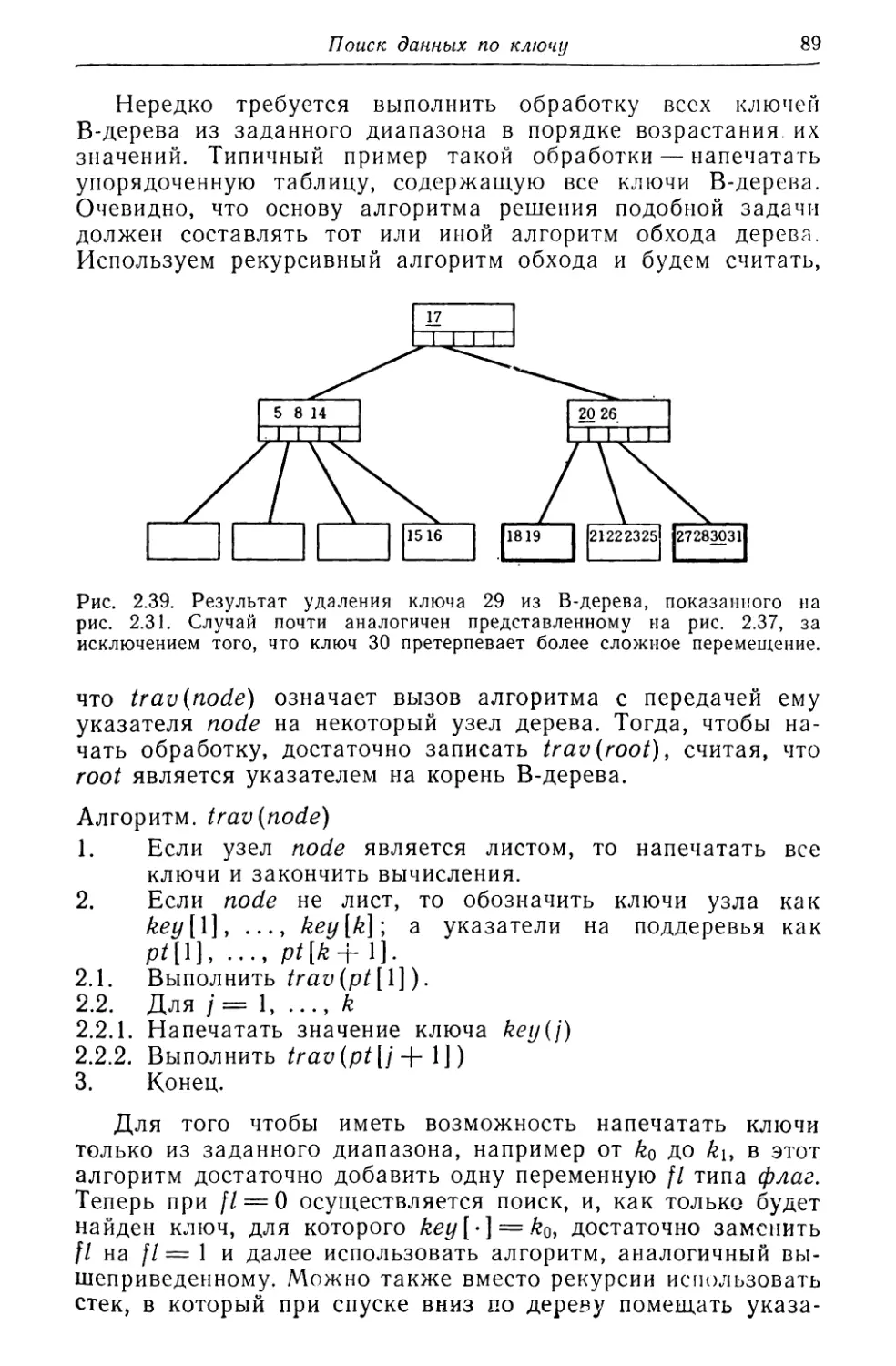

нецами.