Author: Седжвик Р.

Tags: компьютерные технологии языки программирования трансляторы программирование алгоритмы структуры данных язык программирования c

ISBN: 5-93772-083-0

Year: 2003

Text

РОБЕРТ СЕДЖВИК Принстонский Университет

третья редакция

ЧШй

Роберт Седжвик обладает настоящим талантом просто и

доступно объяснять сложнейшие вещи. Использование

реальных программ, занимающих менее одной страницы

которые к тому же легко понять - вот одно из

несомненных достоинств книги. Рисунки, программы и

таблицы оказывают существенную помощь в усвоении

материала и выгодно отличают эту книгу от других.

- Уильям А. Вард

Университет Южной Алабамы

A ADDISON-WESLEY

▼▼ Pearson Education

DiaSofit

Фундаментальные

алгоритмы

Роберт Седжвик

Фундаментальные алгоритмы на С

Части 1-5

Анализ / Структуры данных / Сортировка /

Поиск / Алгоритмы на графах

DiaSoft

Москва • Санкт-Петербург • Киев

2003

in С

PARTS 1-5

FUNDAMENTALS

DATA STRUCTURES

SORTING

SEARCHING

GRAPH ALGORITHMS

Robert Sedgewick

Pг i n с с t о п. U и i v с rs i i v

Л AD DI SON-WESLEY

Boston • San Francisco • New York • Toronto • Montreal

London • Munich • Paris • Madrid

Capetown • Sydney • Tokyo • Singapore • Mexico City

Фундаментальные

алгоритмы

ЧАСТИ 1-5

АНАЛИЗ

СТРУКТУРЫ ДАННЫХ

СОРТИРОВКА

ПОИСК

АЛГОРИТМЫ НА ГРАФАХ

Роберт Седжвик

т

ж DiaSoft

Москва • Санкт-Петербург • Киев

2003

ББК 32.973.2

УДК 681.3.06(075)

С 88

Седжвик Роберт

С 88 Фундаментальные алгоритмы на С. Анализ/Структуры данных/Сортировка/Поиск/

Алгоритмы на графах: Пер. с англ./Роберт Седжвик. - СПб: ООО «ДиаСофтЮП»,

2003.- 1136 с.

ISBN 5-93772-083-0

Эта книга посвящена глубокому исследованию всех основополагающих концепций и алгорит¬

мов, которые, несомненно, относятся к категории “вечных”. Тщательным образом проштудировав

их, вы получите знания, которые никогда не устареют и которыми вы будете пользоваться всегда.

Краткость, точность, выверенность, актуальность, изобилие примеров и учебных заданий - вот

лишь небольшой перечень очевидных достоинств книги. Иллюстрация алгоритмов на одном из

наиболее эффективных языков программирования С лишний раз подчеркивает их популярность и

“вечность”. Подробно рассматривается широчайший спектр фундаментальных алгоритмов и алго¬

ритмов на графах. Большое внимание уделяется рабочим характеристикам алгоритмов, а также их

математическому выводу.

Книгу можно использовать в качестве курса лекций (как студентами, так и преподавателями),

справочного пособия или просто “романа”, получая при этом ни с чем не сравнимое удовольствие.

»

ББК 32.973.2

Научное издание

Роберт Седжвик

ФУНДАМЕНТАЛЬНЫЕ АЛГОРИТМЫ НА С

Анализ/Структуры данных/Сортировка/Поиск/Алгоритмы на графах

Заведующий редакцией С.Н.Козлов

Научный редактор Ю.Н.Артемепко

Верстка Т.Н.Артеменко

Главный дизайнер О. А.Шадрин

H/K

ООО «ДиаСофтЮП», 196105, Санкт-Петербург, пр. Ю.Гагарина, д. 1,ком. 108.

Лицензия №000328 от 9 декабря 1999 г.

Сдано в набор 10.01.2003. Подписано в печать 28.02.2003. Формат 70x100/16.

Бумага типографская. Гарнитура Таймс. Печать офсетная. Печ.л. 71.

Тираж 2000 экз. Заказ № 98

Отпечатано с готовых диапозитивов в ФГУП ордена Трудового Красного Знамени «Техническая книга»

Министерства Российской Федерации по делам печати, телерадиовещания и средств массовых коммуникаций

198005, Санкт-Петербург, Измайловский пр., 29.

Authorized translation from the English language edition, entitled ALGORITHMS IN C, PARTS 1-5 (BUNDLE):

FUNDAMENTALS, DATA STRUCTURES, SORTING, SEARCHING, AND GRAPH ALGORITHMS, 3rd Edition by

SEDGEWICK, ROBERT, published by Pearson Education, Inc, publishing as Addison Wesley,

Copyright © 2002

All rights reserved. No part of this book may be reproduced or transmitted in any form or by any means, electronic or mechanical, including

photocopying, recording or by any information storage retrieval system, without permission from the Pearson Education, Inc.

Russian language edition published by DiaSoft LTD.,

Copyright © 2003

Лицензия предоставлена издательством Addison Wesley. (Pearson Education, Inc.)

Все права зарезервированы, включая право на полное или частичное воспроизведение в какой бы то ни было форме.

ISBN 5-93772-083-0 (рус.) © Перевод на русский язык. ООО «ДиаСофтЮП», 2003

ISBN 0-201-31452-5 (англ.) © Addison Wesley, 2002

ISBN 0-201-31663-3 (англ.) © Addison Wesley, 2002

© Оформление. ООО «ДиаСофтЮП», 2003

Гигиеническое заключение № 77.99.6.953.П.438.2.99 от 04.02.1999

Оглавление

Часть 1. Анализ 17

Глава 1. Введение 18

1.1 Алгоритмы 19

1.2 Пример задачи связности 21

1.3 Алгоритмы объединения-поиска 25

1.4 Перспективы 36

1.5 Обзор тем 38

Глава 2. Принципы анализа алгоритмов 40

2.1 Реализация и эмпирический анализ 41

2.2 Анализ алгоритмов 45

2.3 Рост функций 48

2.4 О-нотация 54

2.5 Простейшие рекурсии 59

2.6 Примеры анализа алгоритмов 63

2.7 Гарантии, предсказания и ограничения 68

Ссылки к части 1 72

Часть 2. Структуры данных 74

Глава 3. Элементарные структуры данных 75

3.1 Строительные блоки 76

3.2 Массивы 86

3.3 Связные списки 92

3.4 Обработка простых списков 98

3.5 Распределение памяти под списки 106

3.6 Строки 109

3.7 Составные структуры данных 114

Глава 4. Абстрактные типы данных 124

4.1 Абстрактные объекты и коллекции объектов 128

4.2 АТД стека магазинного типа 131

4.3 Примеры клиентских программ, использующих АТД стека 134

4.4 Реализации АТД стека 140

4.5 Создание нового АТД 144

4.6 Очереди FIFO и обобщенные очереди 147

4.7 Повторяющиеся и индексные элементы 155

4.8 АТД первого класса 160

4.9 Пример использования АТД в приложениях 170

4.10 Перспективы 175

6

Фундаментальные алгоритмы на С. Части 1—5

Глава 5. Рекурсия и деревья 177

5.1 Рекурсивные алгоритмы 178

5.2 Разделяй и властвуй 185

5.3 Динамическое программирование 199

5.4 Деревья 206

5.5 Математические свойства бинарных деревьев 215

5.6 Обход дерева 218

5.7 Рекурсивные алгоритмы бйнарных деревьев , 224

5.8 Обход графа 229

5.9 Перспективы 235

Ссылки к части 2 236

Часть 3. Сортировка 237

Глава 6. Элементарные методы сортировки 238

6.1 Правила игры 240

6.2 Сортировка выбором 246

6.3 Сортировка вставками 247

6.4 Пузырьковая сортировка 250

6.5 Характеристики производительности элементарных методов сортировки 252

6.6 Сортировка методом Шелла 258

6.7 Сортировка других типов данных 267

6.8 Сортировка по индексам и указателям 271

6.9 Сортировка связных списков 278

6.10 Метод распределяющего подсчета 282

Глава 7. Быстрая сортировка 285

7.1 Базовый алгоритм 286

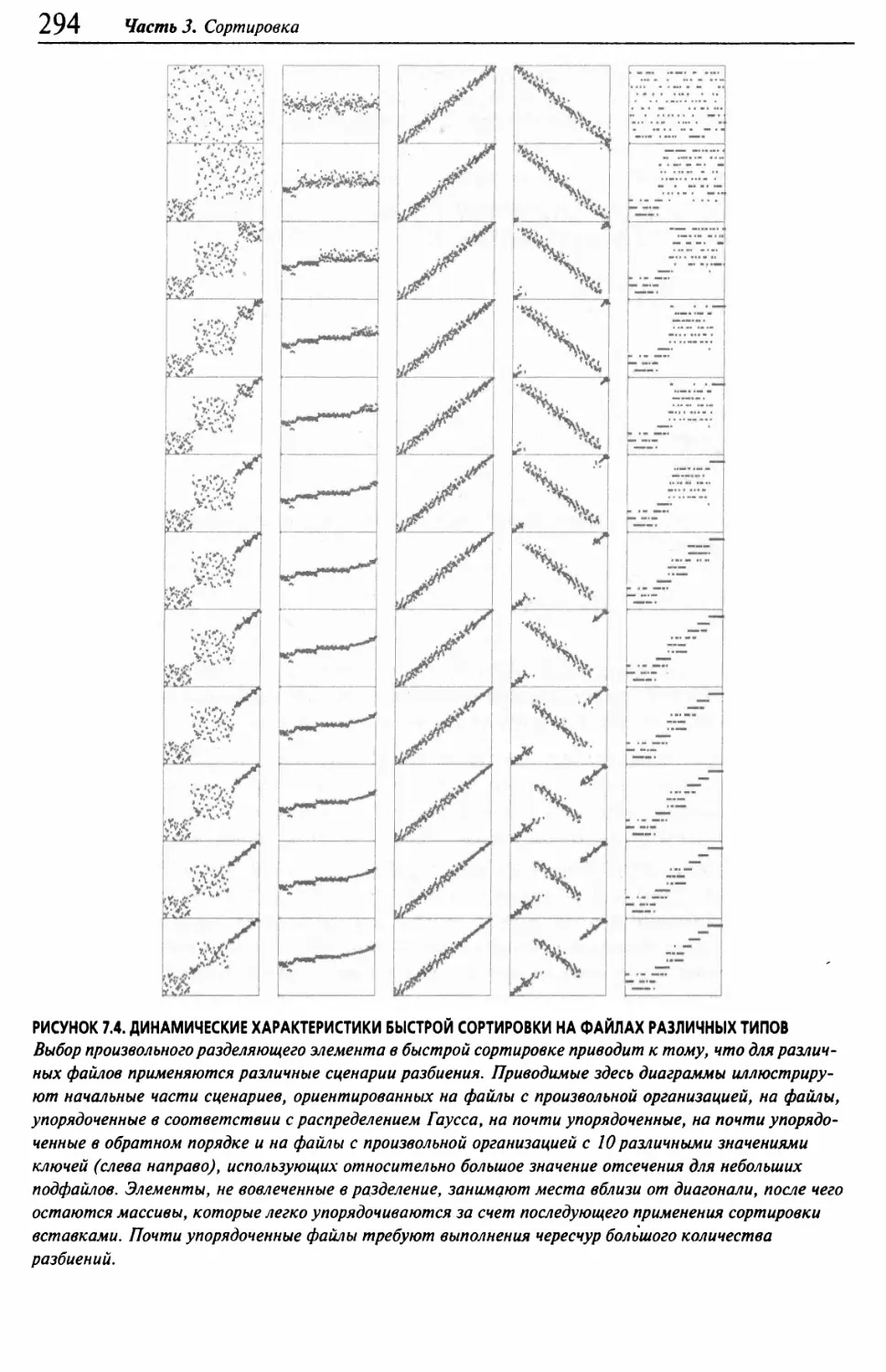

7.2 Характеристики производительности быстрой сортировки 291

7.3 Размер стека 295

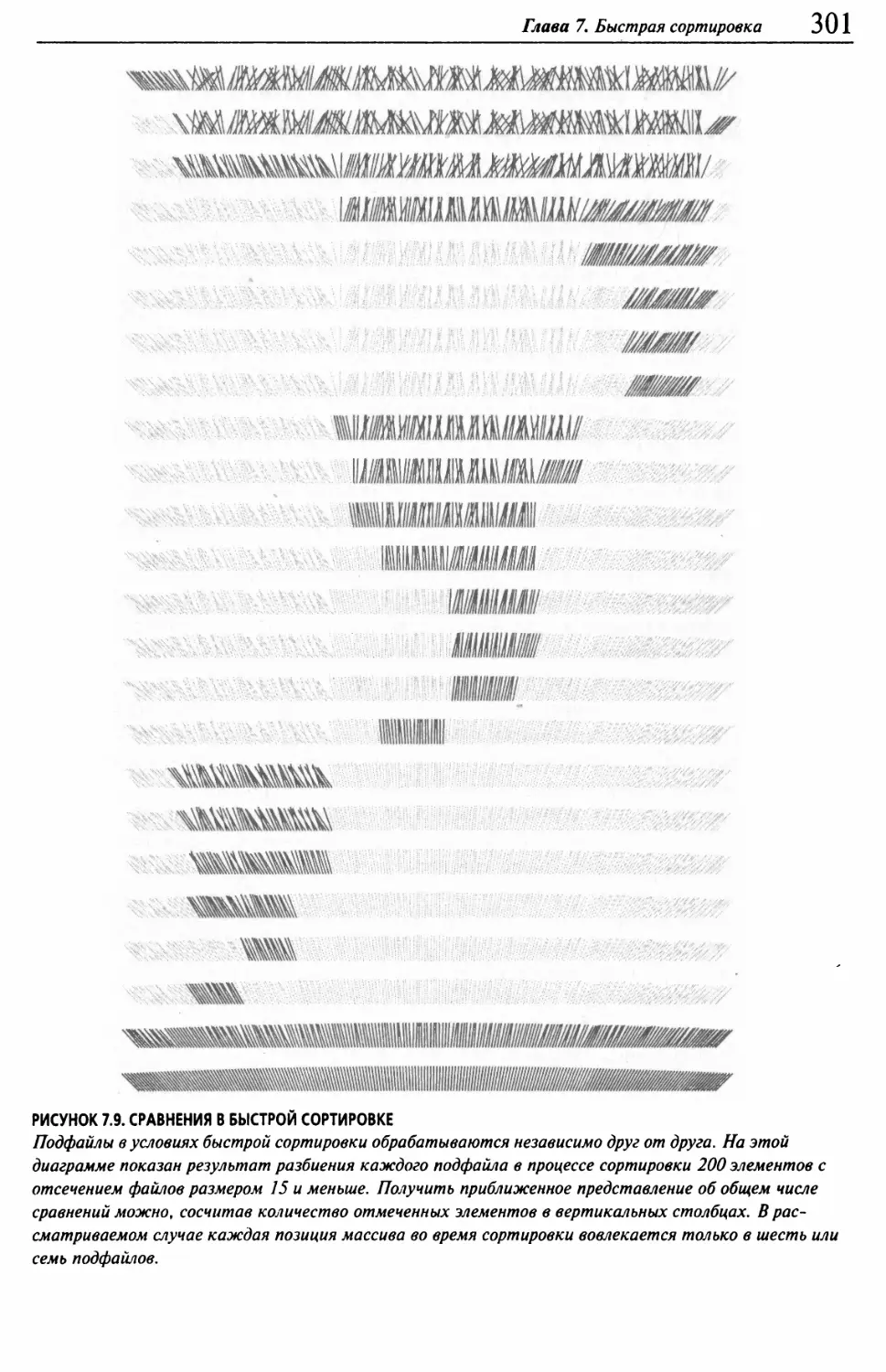

7.4 Подфайлы небольших размеров 299

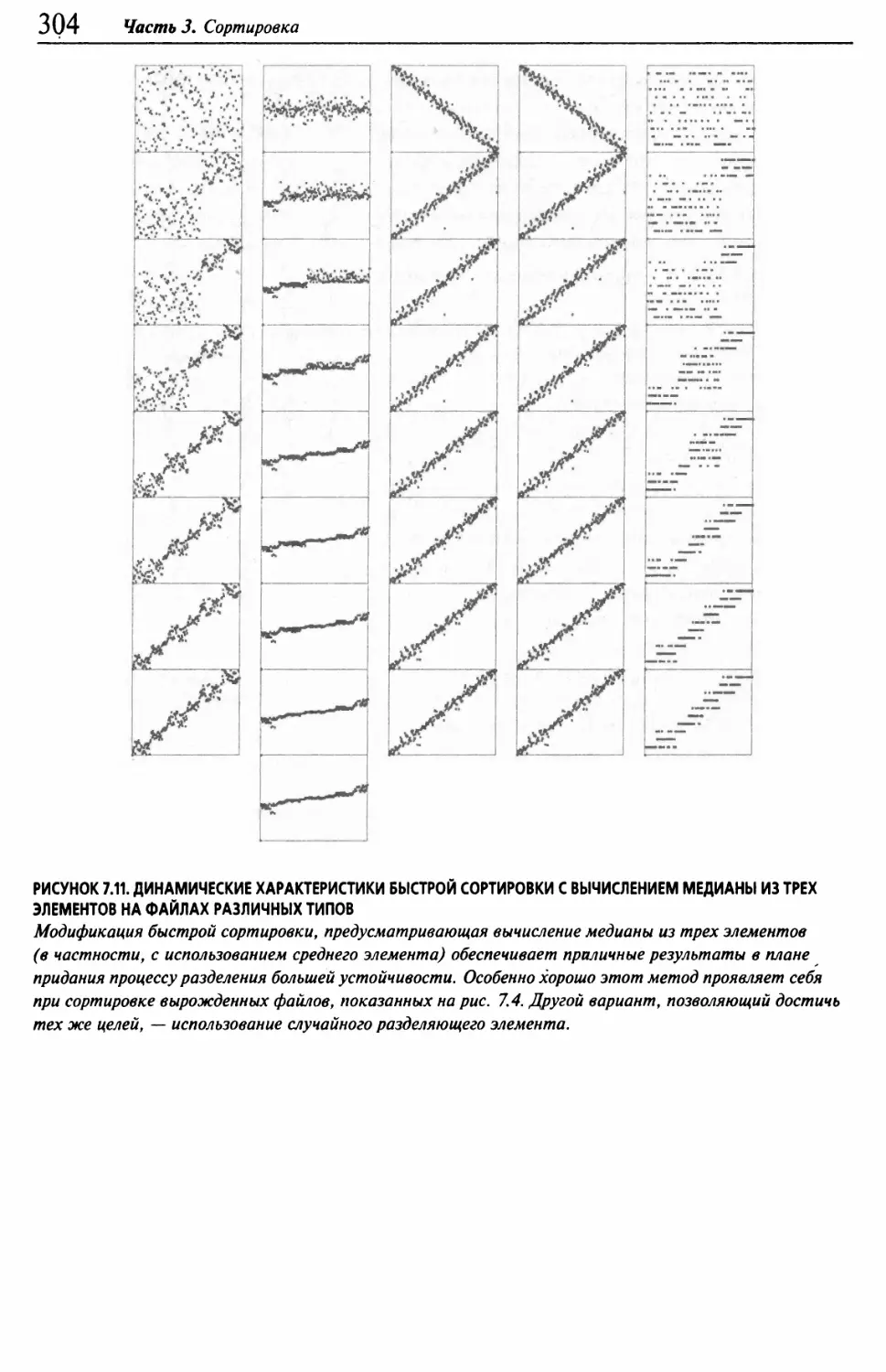

7.5 Метод разделения с вычислением медианы из трех элементов 302

7.6 Дублированные ключи 307

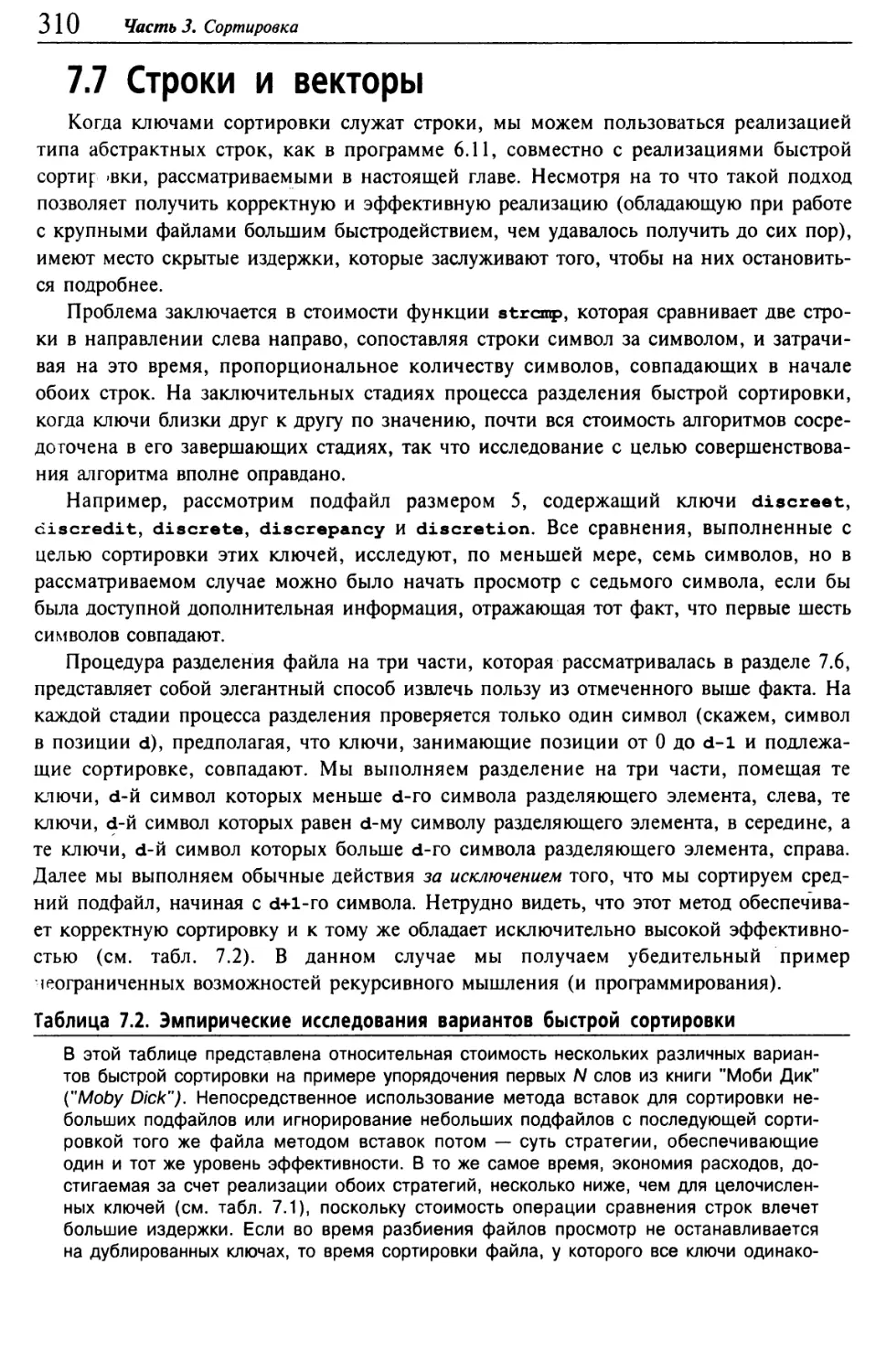

7.7 Строки и векторы 310

7.8 Выборка 312

Глава 8. Слияние и сортировка слиянием 316

8.1 Двухпутевое слияние 318

8.2 Абстрактное обменное слияние 320

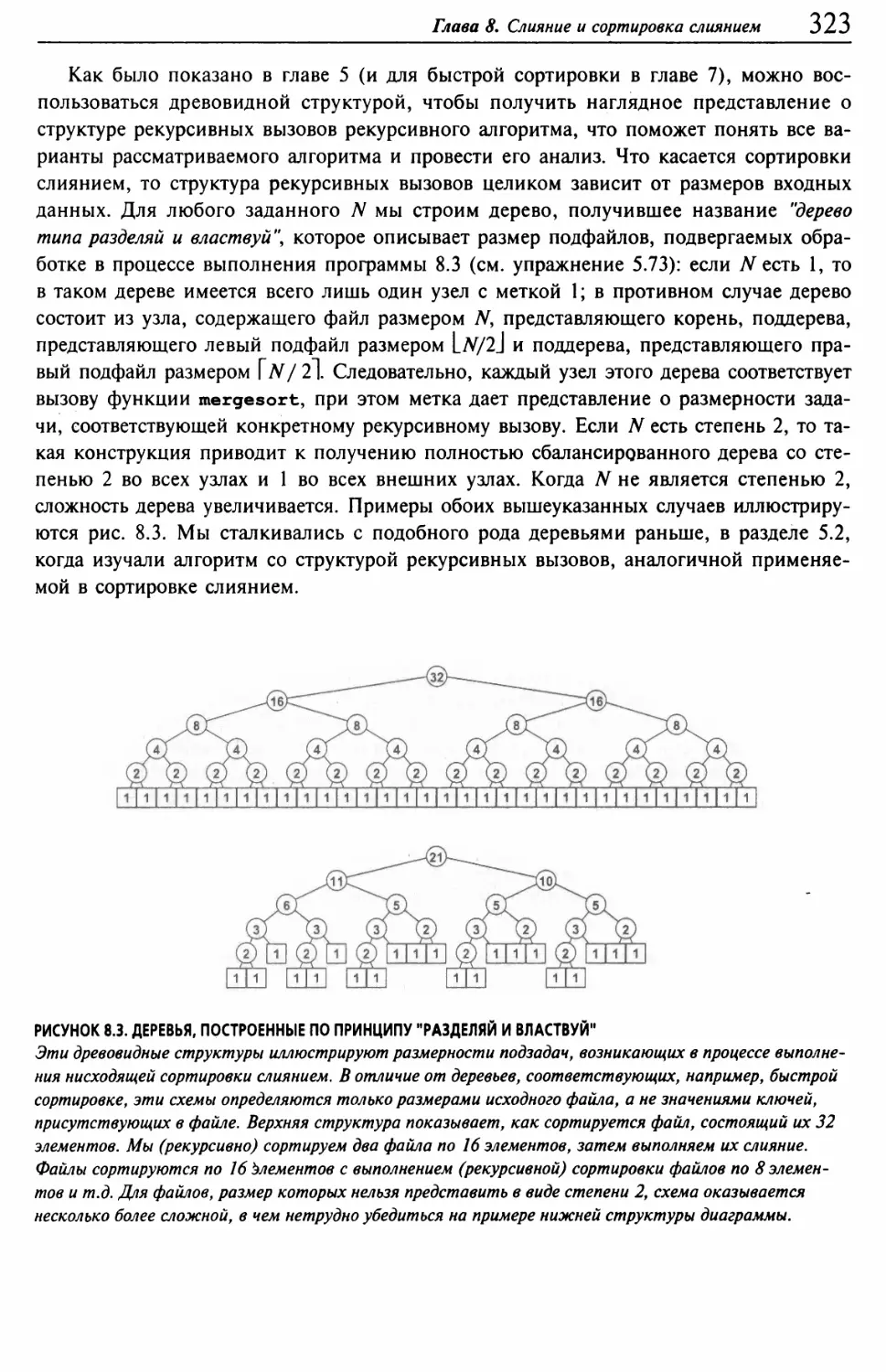

8.3 Нисходящая сортировка слиянием 322

8.4 Усовершенствования базового алгоритма 325

8.5 Восходящая сортировка слиянием 328

8.6 Производительность сортировки слиянием 331

8.7 Реализация сортировки слиянием, ориентированная на связные списки 335

8.8 Возврат к рекурсии 338

Оглавление

Глава 9. Очереди по приоритетам и пирамидальная сортировка 340

9.1 Элементарные реализации 344

9.2 Пирамидальная структура данных 347

9.3 Алгоритмы для сортирующих деревьев 349

9.4 Пирамидальная сортировка 356

9.5 Абстрактный тип данных очереди по приоритетам 363

9.6 Очередь по приоритетам для индексных элементов 368

9.7 Биномиальные очереди 372

Глава 10. Поразрядная сортировка 383

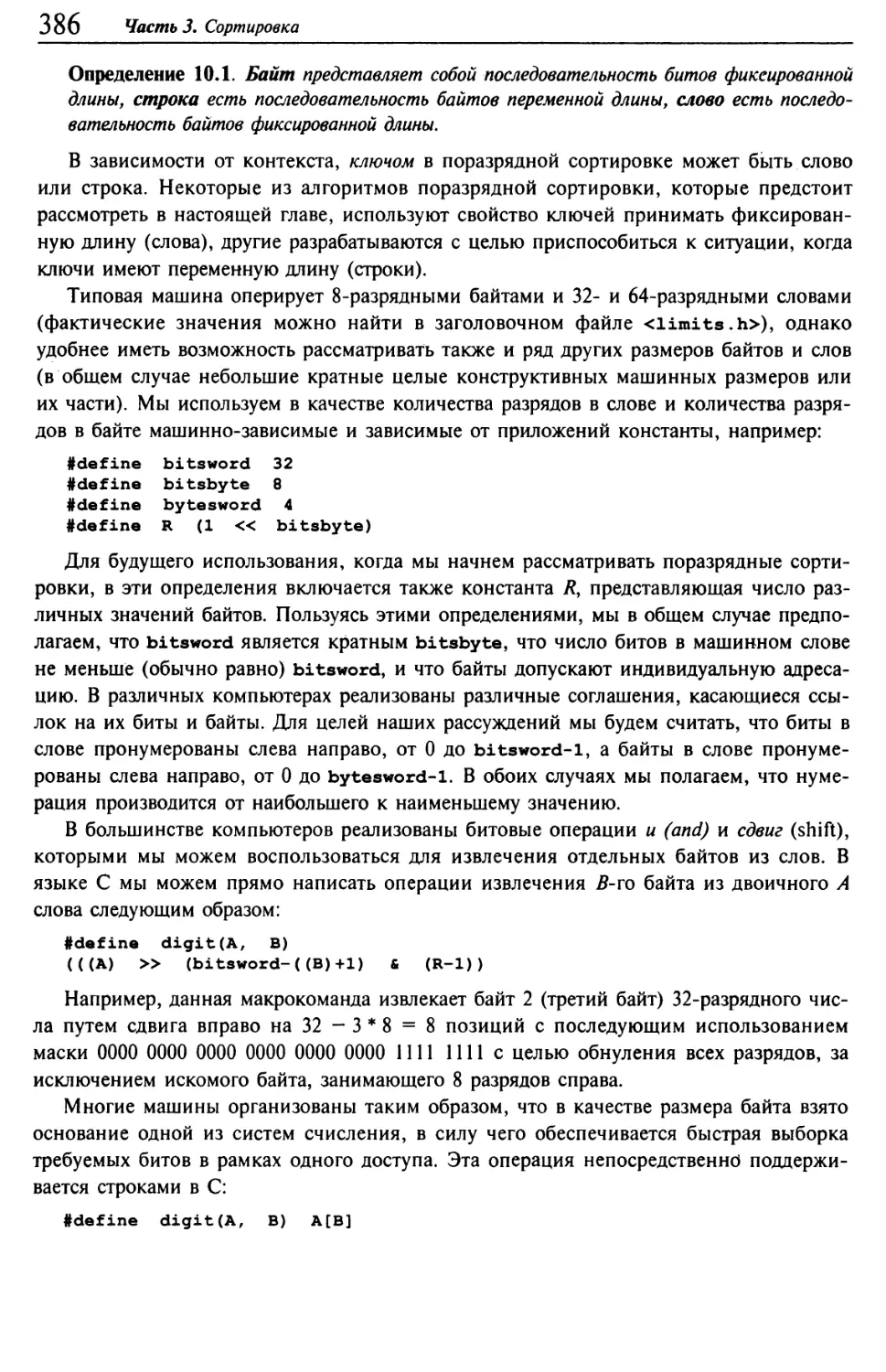

10.1 Биты, байты и слова 385

10.2 Бинарная быстрая сортировка 388

10.3 Поразрядная сортировка*MSD 394

10.4 Трехпутевая поразрядная быстрая сортировка 402

10.5 Поразрядная сортировка LSD 406

10.6 Рабочие характеристики поразрядных сортировок 410

10.7 Сортировки с сублинейным временем выполнения 414

Глава 11. Методы сортировки специального назначения 419

11.1 Четно-нечетная сортировка слиянием Бэтчера 421

11.2 Сети сортировки 426

11.3 Внешняя сортировка 434

11.4 Различные реализации сортировки слиянием 441

11.5 Параллельная процедура сортировки слиянием 448

Ссылки к части 3 453

Часть 4. Поиск 455

Глава 12. Таблицы символов и деревья бинарного поиска 456

12.1 Абстрактный тип данных таблицы символов 458

12.2 Поиске использованием индексации по ключам 463

12.3 Последовательный поиск 466

12.4 Бинарный поиск 472

12.5 Деревья бинарного поиска 477

12.6 Характеристики производительности деревьев бинарного поиска 483

12.7 Реализация индексов при помощи таблиц символов 486

12.8 Вставка в корень в деревьях бинарного поиска 490

12.9 Реализации других функций АТД с помощью BST-дерева 495

Глава 13. Сбалансированные деревья 504

13.1 Рандомизированные BST-деревья 508

13.2 Расширенные деревья бинарного поиска 514

13.3 Нисходящие 2-3-4-деревья 520

13.4 Красно-черные, или RB-деревья 525

13.5 Списки пропусков 535

13.6 Характеристики производительности 543

О Фундаментальные алгоритмы на С. Части 1—5

Глава 14. Хеширование 547

14.1 Хеш-функции 548

14.2 Раздельное связывание 558

14.3 Линейное зондирование 562

14.4 Двойное хеширование 567

14.5 Динамические хеш-таблицы 573

14.6 Перспективы 577

Глава 15. Поразрядный поиск 582

15.1 Деревья цифрового поиска 583

15.2 Trie-д еревья 588

15.3 Patricia-деревья 597

15.4 Многопутевые trie-деревья и TST-деревья *. 605

15.5 Алгоритмы индексирования текстовых строк 652

Глава 16. Внешний поиск 627

16.1 Правила игры 629

16.2 Индексно-последовательный доступ 631

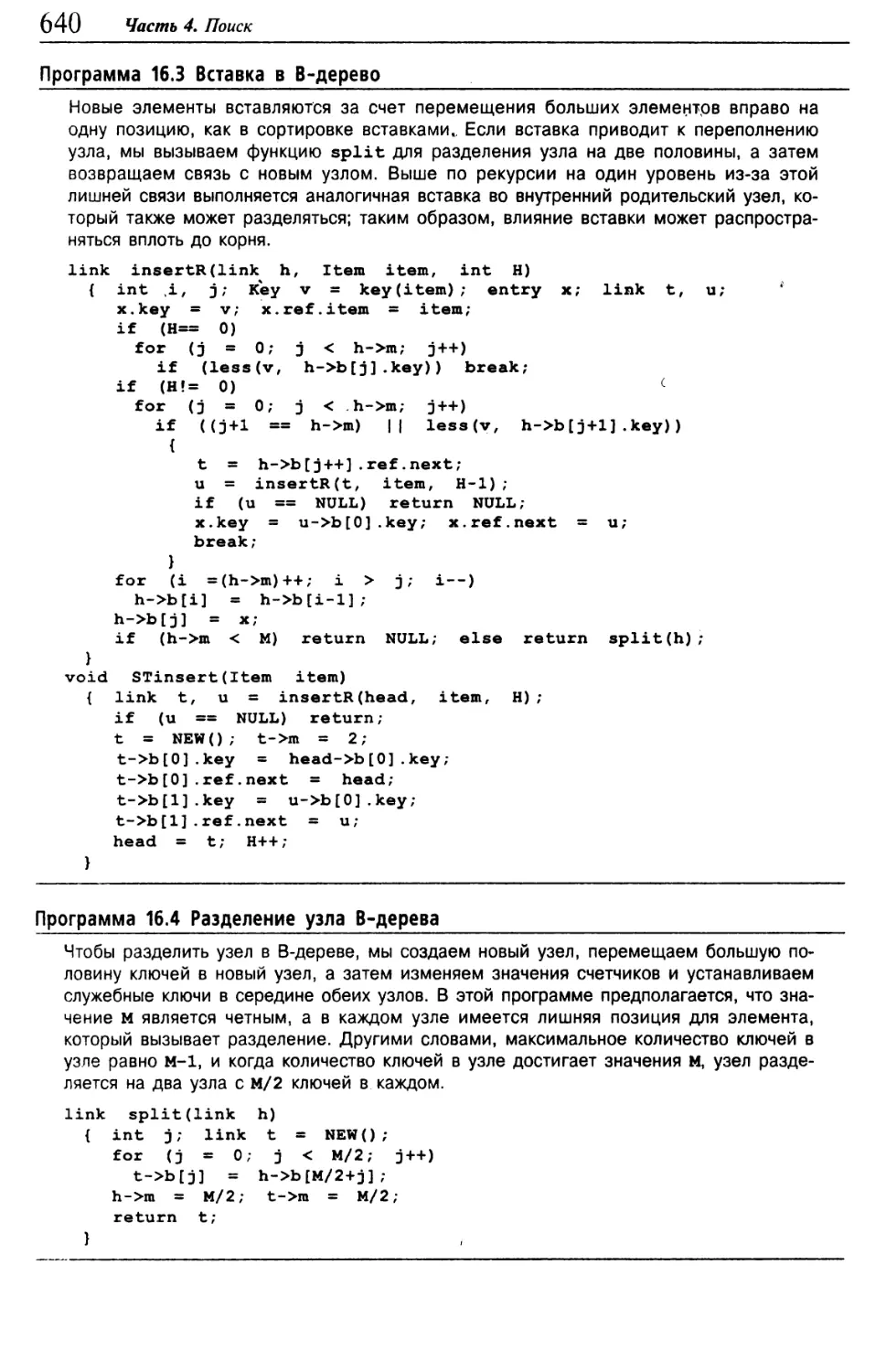

16.3 В-деревья 634

16.4 Расширяемое хеширование 646

16.5 Перспективы 657

Ссылки к части 4 660

Предметный указатель к частям 1-4 663

Часть 5. Алгоритмы на графах 673

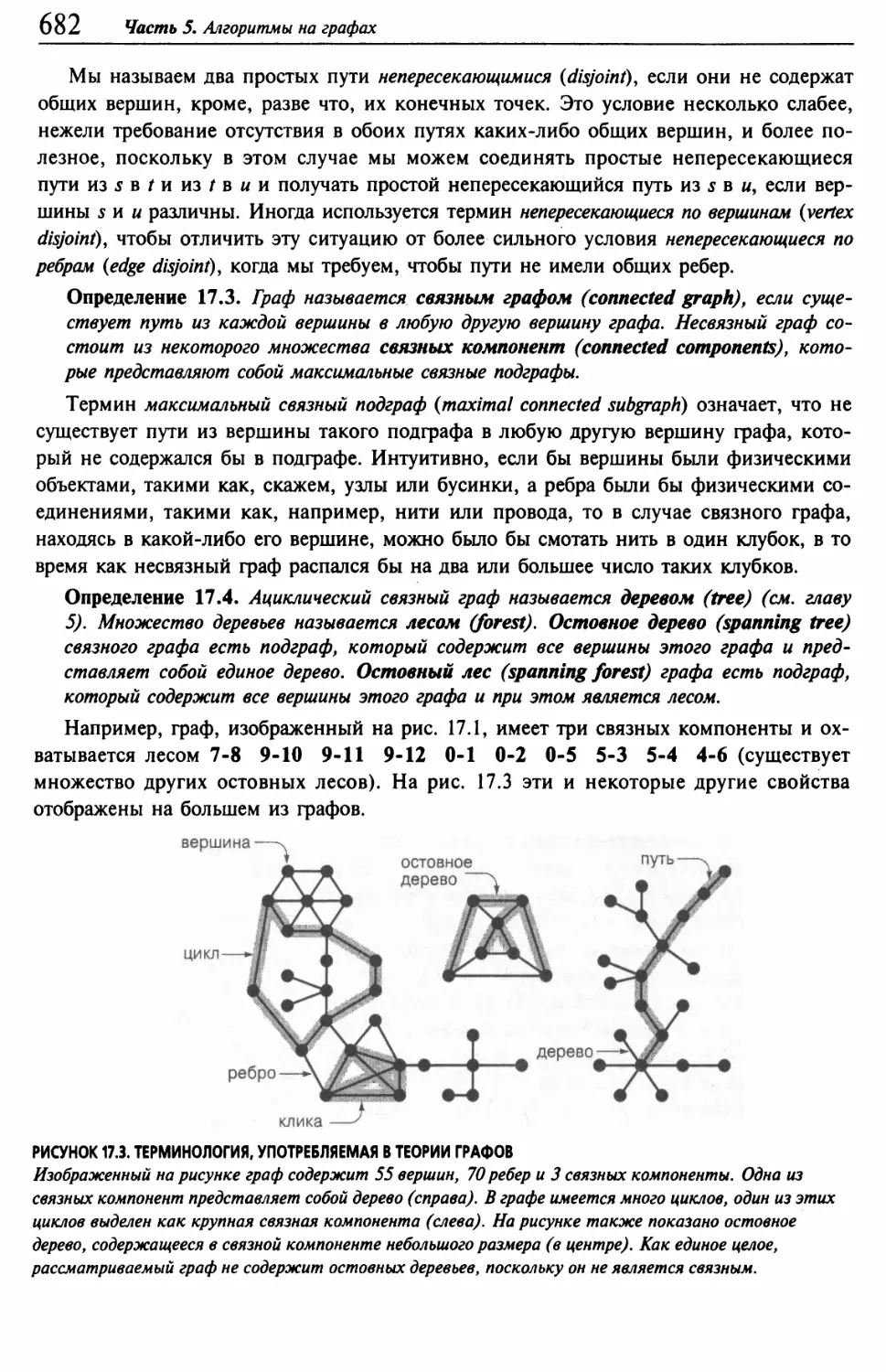

Глава 17. Свойства и типы графов 674

17.1 Глоссарий 678

17.2 АТД графа 687

17.3 Представление графа в виде матрицы смежности 691

17.4 Представление графа в виде списка смежных вершин 697

17.5 Вариации, расширения и затраты 700

17.6 Генераторы графов 709

17.7 Простые, эйлеровы и гамильтоновы пути 720

17.8 Задачи обработки графов 734

Глава 18. Поиск на графах 744

18.1 Исследование лабиринта 745

i 8.2 Поиск в глубину 750

18.3 АТД-функции поиска на графе 755

18.4 Свойства лесов DFS 760

18.5 Алгоритмы DFS 767

18.6 Отделимость и бисвязность 774

18.7 Поиск в ширину 782

18.8 Обобщенный поиск на графах 792

18.9 Анализ алгоритмов на графах 800

Оглавление

Глава 19. Орграфы и ориентированные ациклические графы 807

19.1 Глоссарий и правила игры 810

19.2 Анатомия поиска DFS в орграфах 819

19.3 Достижимость и транзитивное замыкание 828

19.4 Отношения эквивалентности и частичные порядки 840

19:5 Графы DAG 844

19.6 Топологическая сортировка 849

19.7 Достижимость в графе DAG 859

19.8 Сильные компоненты в орграфах 862

19.9 Еще раз о транзитивном замыкании 872

19.10 Перспективы 876

Глава 20. Минимальные остовные деревья 880

20.1 Представления 883

20.2 Принципы, положенные в основу алгоритмов построения дерева MST 889

20.3 Алгоритм Прима и поиск по приоритету 896

20.4 Алгоритм Крускала 907

20.5 Алгоритм Борувки 913

20.6 Сравнения и усовершенствования 916

20.7 Эвклидово дерево MST 922

Глава 21. Кратчайшие пути 925

21.1 Основные принципы 933

21.2 Алгоритм Дейкстры 938

21.3 Все кратчайшие пути 948

21.4 Кратчайшие пути в ациклических сетях 956

21.5 Эвклидовы сети 964

21.6 Сведение 969

21.7 Отрицательные веса 984

21.8 Перспективы 1001

Глава 22. Потоки в сетях 1003

22.1 Транспортные сети 1010

22.2 Алгоритм поиска максимального потока методом аугментального пути 1022

22.3 Алгоритмы определения максимальных потоков

методом выталкивания превосходящего потока 1047

22.4 Сведение к максимальному потоку 1061

22.5 Потоки минимальной стоимости 1079

22.6 Сетевой симплексный алгоритм 1089

22.7 Сведение к задаче о потоке минимальной стоимости 1108

22.8 Перспективы 1117

Ссылки, использованные в пятой части 1121

Предметный указатель к части 5 1123

Предисловие

Зта книга знакомит вас с наиболее важными из применяемых на сегодняшний день

компьютерных алгоритмов, а также обучает, фундаментальным технологиям, кото¬

рые непосредственно адресованы все возрастающему количеству разработчиков,

нуждающихся в подобных знаниях. Она может быть использована как учебник для сту¬

дентов второго, третьего или четвертого курсов факультетов, связанных с компьютер¬

ными науками, после того как студенты овладели основными навыками и ознакомле¬

ны с компьютерными системами. Книга также может быть полезной для тех, кто

занимается самообразованием, или служить в качестве справочника для тех, кого ин¬

тересует разработка компьютерных систем или прикладных программ, поскольку она

содержит программные реализации полезных алгоритмов и подробную информацию о

рабочих характеристиках этих алгоритмов. В более широкой перспективе эту книгу

можно рассматривать как подходящее введение в данную предметную область.

В новом издании текст был полностью переработан, в него было включено более

тысячи новых упражнений, более сотни новых рисунков и десятки новых программ.

Кроме того, все рисунки были снабжены подробными комментариями. Этот новый

материал охватывает как новые темы, так и более полно поясняет многие классичес¬

кие алгоритмы. Большое внимание, уделенное в книге абстрактным типам данных,

расширяет сферу применения приведенных программ и делает их более пригодными

для современных сред программирования. Читатели, знакомые с предыдущими изда¬

ниями книги, найдут в ней множество новой информации; каждый читатель найдет в

книге большой объем учебного материала, который позволит успешно изучить наибо¬

лее важные понятия.

Вследствие большого объема нового материала, мы разбили новое издание на два

тома (каждый примерно равен по объему предыдущему изданию), первый из них пе¬

ред вами. Этот том охватывает фундаментальные понятия, структуры данных, алгоритмы

сортировки и алгоритмы поиска; во втором томе рассматриваются более развитые алго¬

ритмы и более сложные приложения, построенные на базе абстракций и методов, разра¬

ботанных в первом томе. Почти весь материал по основным принципам и структурам

данных, изложенный в этом издании, в предыдущих изданиях книги не рассматривался.

Эта книга адресована не только программистам и студентам, изучающим программи¬

рование и компьютерные науки. Практически каждый, кто пользуется компьютером, же¬

лает работать на нем быстрее или решать более сложные задачи. Алгоритмы, приведенные

в этой книге, представляют квинтэссенцию знаний, накопленную более чем за 50 лет, без

которых нельзя обойтись в многочисленных приложениях для эффективного использова¬

ния компьютера. От задач моделирования систем из N тел в физике и до задач анали!б ге¬

нетического кода в молекулярной биологии, описанные здесь базовые методы стали важ¬

ными составляющими современных научных исследований; от систем баз данных до

механизма поиска в Internet они стали базовыми компонентами современных про¬

граммных систем. По мере того, как сфера применения компьютерных приложений

становится все шире, возрастает влияние многих из рассмотренных здесь базовых ме¬

тодов. Данная книга может быть использована как источник информации для студен¬

тов и профессионалов, заинтересованных в ознакомлении и эффективном использова¬

нии описанных фундаментальных алгоритмов как основных инструментальных средств

для любых компьютерных приложений, какие они намерены разрабатывать.

Предисловие 1 1

Графы и алгоритмы на графах активно проникают во все современные компью¬

терные приложения. В этой книге описаны широко известные методы решения задач

обработки графов, которые возникают на практике. Ее основная цель заключается в

том, чтобы сделать эти методы и основные принципы, составляющие их основу, дос¬

тупными для все большего числа людей, которые в них нуждаются. Предлагаемый ма¬

териал книги представлен таких образом, что сначала излагаются начальные сведения,

начиная с базовой информации и основных понятий, с постепенным переходом к

анализу классических методов, и завершается изучением современных технологий, ко¬

торые все еще находятся на стадии разработки. Тщательно подобранные примеры,

подробные рисунки и завершенные программные реализации сопровождаются под¬

робным описанием алгоритмов и приложений.

Книга исключительно полезна на ранних стадиях курса обучения компьютерным

наукам, сразу после того, как студенты получат основные навыки программирования

и ознакомятся с компьютерными системами, и в то же время перед тем, как присту¬

пят к изучению специальных курсов по современным областям компьютерных наук

или прикладных вычислительных систем. Эта книга будет полезна как материал для

самообразования или как справочное пособие для специалистов, занятых разработкой

компьютерных систем или компьютерных приложений, поскольку она содержит про¬

граммные реализации полезных алгоритмов и подробные данные о рабочих характе¬

ристиках этих алгоритмов. Широкая перспектива, открывающаяся перед ними, делает

эту книгу подходящим введением в указанную выше область знаний.

Автор полностью переделал текст книги для этого издания и добавил несколько

тысяч упражнений, сотни новых иллюстраций, десятки новых программ и снабдил все

рисунки и программы развернутыми комментариями. Этот новый материал содержит

как описание новых тем, так и более полный анализ многих классических алгоритмов.

На протяжении всей книги основное внимание уделяется абстрактным типам данных,

которые существенно расширяют область применения программ и делают их исполь¬

зование более эффективным. Те, кто знаком с предыдущими изданиями настоящей

книги, найдут в ней много новой информации; все читатели найдут в ней массу по¬

лезного педагогического материала, который обеспечивает четкое понимание основ¬

ных понятий.

Книга предназначена не только для программистов и студентов, изучающих компь¬

ютерные науки. Все, кто работает с компьютером, хотят работать быстрее и решать

все более крупные задачи. Алгоритмы, которые мы изучаем, представляют собой об¬

ласть знаний, быстро развивавшуюся в течение последних пятидесяти лет и ставшую

основой для эффективного использования компьютера на широком множестве прило¬

жений. Начиная с задач моделирования систем из N тел в физике и заканчивая задача¬

ми анализа генетического кода в молекулярной биологии, описанные здесь^базовые

методы стали основной частью современных научных исследований; от систем баз

данных до механизмов поиска в Intenet они стали важной частью современных про¬

граммных систем. По мере того, как сфера применения компьютерных приложений

становится все шире, возрастает значение многих из базовых алгоритмов, особенно

фундаментальных алгоритмов на графах, описание которых дано в этом томе. Назна¬

чение этой книги состоит в том, чтобы стать источником информации для студентов и

профессионалов, чтобы они понимали и при необходимости искусно использовали ал¬

горитмы на графах в любом компьютерном приложении, каким бы оно ни было.

12 Фундаментальные алгоритмы на С. Части 1—5

Круг рассматриваемых вопросов

Книга содержит 22 главы, сгруппированных в виде пяти основных частей: основ¬

ные понятия, структуры данных, сортировка, поиск и алгоритмы на графах. Приве¬

денные в ней описания призваны ознакомить читателей с основными свойствами мак¬

симально широкого круга фундаментальных алгоритмов. Описанные здесь алгоритмы

находят широкое применение на протяжении многих лет и являются существенно важ¬

ными как для профессиональных программистов, так и для студентов, изучающих

компьютерные науки. Все описанные в книге хитроумные методы, от биномиальных

очередей до trie-деревьев, относятся к базовым концепциям, лежащим в основе ком¬

пьютерных наук. Основной целью при написании этих книг было собрать воедино

фундаментальные методы из этих различных областей дискретной математики с целью

ознакомления с лучшими методами решения задач с помощью компьютера.

По достоинству вы сможете оценить собранный в книге материал, имея за плечами

курсы по изучению основных принципов разработки и анализа алгоритмов и опыт

программирования на языках высокого уровня, таких как C++, Java, или С. Эта кни¬

га предполагает наличие у читателя соответствующей подготовки. Данный том предпо¬

лагает знание массивов, связных списков, абстрактных типов данных (АТД), в нем ис¬

пользуются очереди по приоритету, таблицы символов, АТД объединения-поиска -

все эти понятия подробно рассматриваются в частях 1-4 (и во многих других коммен¬

тариях к алгоритмам и структурах данных).

Базовые свойства графов и алгоритмов на графах разработаны на базе основных

понятий, в то же время для их полного понимания очень часто необходимо глубоко

погружаться в пучину сложных математических выкладок. Несмотря на то что обсуж¬

дение современных математических понятий носит конспективный характер, на уров¬

не общих рассуждений и описаний, от читателя, тем не менее, требуется более высо¬

кая математическая подготовка, чем для работы с материалами, содержащимися в

частях 1-4. Несмотря на это, читатели, обладающие различными уровнями математи¬

ческой подготовки, извлекут для себя немалую пользу из этой книги. К такому подхо¬

ду вынуждает следующее обстоятельство: некоторые элементарные алгоритмы на гра¬

фах, которые могут быть понятны и использоваться каждым, лишь немногим

отличаются от развитых алгоритмов, которые понимает далеко не каждый. Основная

цель в подобных случаях — поместить важные алгоритмы в контекст других методов, а

не требовать изучения всего математического материала. Однако строгий подход, на

котором настаивают высококвалифицированные математики, часто приводит нас к со¬

зданию хороших программ, в связи с чем автор стремился сохранить баланс между

формальным подходом, на котором настаивают теоретики, и изложением материала,

рекомендуемом практиками, не жертвуя при этом строгостью.

Использование материала в рамках учебных курсов

Что касается стиля изложения материала, то в этом плане преподавателю предос¬

тавляется свобода в широких пределах, в зависимости от предпочтений преподавателя

и подготовки студентов. Описанные в книге алгоритмы широко использовались в те¬

чение многих лет, они представляют собой совокупность знаний, необходимых как

программисту-практику, так и студенту, изучающему теорию вычислительных систем.

В данной книге содержится объем основного материала, достаточный для того, чтобы

ее можно было использовать в качестве учебника по курсу алгоритмов и структур

Предисловие 13

данных, в то же время она содержит достаточно материала, чтобы быть использован¬

ной в качестве учебника по курсу алгоритмов на графах. Возможно, одни преподава¬

тели будут уделять основное внимание реализациям и практическим вопросам, а дру¬

гие - анализу и теоретическим исследованиям.

Данная книга ориентирована на изучение алгоритмов, которые, скорее всего, бу¬

дут использованы на практике. В ней содержится достаточно подробная информация

об инструментальных средствах, позволяющих читателям уверенно реализовывать, от¬

лаживать и запускать в работу алгоритмы решения различных задач или снабжать при¬

ложения необходимыми функциональными возможностями. В книгу включены полные

реализации рассматриваемых в ней методов, равно как и описание работы этих про¬

грамм на специально подобранном множестве примеров. Поскольку мы работаем с

реальными программными кодами, а не пользуемся псевдокодами, эти программы

можно быстро запустить в работу в рамках практических приложений.

Действительно, одним из практических применений этих алгоритмов было создание

сотен иллюстраций для данной книги. Благодаря этим иллюстрациям, суть многих ал¬

горитмов становится понятной на интуитивном уровне.

В книге подробно рассматриваются рабочие характеристики алгоритмов и ситуа¬

ции, в которых эти алгоритмы могут быть полезны. В контексте прослеживается связь

с анализом алгоритмов и теорией вычислительных систем. Чтобы показать, почему

предпочтение отдается тому или иному алгоритму, там, где это уместно, приводятся

результаты эмпирических и аналитических исследований. В представляющих интерес

случаях дается описание взаимосвязи между рассматриваемыми практическими алго¬

ритмами и чисто теоретическими результатами. Специальная информация по рабочим

характеристикам алгоритмов и их реализациям обобщается, выделяется и обсуждается

на протяжении всей книги.

Язык программирования

Во всех реализациях используется язык программирования С. Каждый конкретный

язык программирования имеет свои преимущества и недостатки; мы используем язык

С, так как он легко доступен и обладает свойствами, которые требуются для наших

приложений. Программные реализации можно легко перевести на любой другой со¬

временный язык программирования, так как в языке С имеется лишь небольшое чис¬

ло конструкций, характерных только для него. Мы используем стандартные идиомы

языка С там, когда в этом возникает необходимость, но назначение этой книги состо¬

ит не в том, чтобы служить справочным пособием по программированию на С.

В эту редакцию книги включено множество новых программ, многие из старых

программ были переделаны, главным образом, в силу того, чтобы их можно было ис¬

пользовать как реализации абстрактных типов данных. Обширные эмпирические ис¬

следования и сравнения программ проводятся на протяжении всего текста книги.

Цель данной книги заключается в том, чтобы представить алгоритмы в максималь¬

но простой и понятной форме. Везде, где это возможно, мы стремились сохранить

этот стиль, чтобы сходные по выполняемым действиям программы выглядели похожи¬

ми. Для многих алгоритмов в этой книге это подобие сохраняется независимо от язы¬

ка: быстрая сортировка (если выбирать какой-либо яркий пример) так и остается бы¬

строй сортировкой независимо от того, какой язык выбран для реализации ее

алгоритма: Algol-60, Basic, Fortran, Smalltalk, Ada, Pascal, C, PostScript, Java или ка¬

14 Фундаментальные алгоритмы на С. Части 1—5

кой-то другой из бесчисленного множества языков и сред программирования, в кото¬

рых она показала себя эффективным методом сортировки.

Мы стремимся к изящным, компактным, эффективным и переносимым реализаци¬

ям, однако мы придерживаемся той точки зрения, что главное - это эффективность,

поэтому мы стараемся не упустить из виду рабочие характеристики создаваемых нами

программ на всех стадиях разработки.

Благодарности

Многие читатели прислали мне исключительно полезные отзывы о предыдущих из¬

даниях этой книги. В частности, в течение ряда лет предварительные наброски книги

апробировались на сотнях студентов в Принстоне и Брауне. Особую благодарность хо¬

телось бы выразить Трине Эйвери (Tina Avery) и Тому Фримену (Tom Freeman) за

оказанную помощь в выпуске первого издания; Джанет Инсерпи (Janet Incerpi) за

проявленные ею творческий подход и изобретательность, чтобы заставить аппаратные

и программные средства нашей примитивной и давно устаревшей компьютеризиро¬

ванной издательской системы напечатать первое издание книги; Марку Брауну (Mark

Brown) за его участие в исследованиях по визуализации алгоритмов, которые во мно¬

гом способствовали появлению в книге многочисленных рисунков, а также Дэйву

Хенсону (Dave Hanson) и Эндрю Эппелю (Andrew Appel) за их постоянную готов¬

ность ответить на мои вопросы, связанные с языками программирования. Я хотел бы

также поблагодарить многочисленных читателей, приславших отзывы на различные из¬

дания этой книги, в том числе Гая Олмсу, Джона Бентли, Марка Брауна, Джея Гри-

шера, Аллана Хейдона, Кеннеди Лемке, Юди Манбер, Дану Ричардс, Джона Рейфа,

М. Розенфельда, Стивена Сейдмана, Майка Квина и Вильяма Варда.

При подготовке нового издания я имел удовольствие работать с Питером Гордоном

(Peter Gordon), Дебби Лафферти (Debbie Lafferty) из издательства Addison-Wesley, кото¬

рые терпеливо опекали этот проект с момента его зарождения. Большое удовольствие до¬

ставила мне совместная работа с другими штатными сотрудниками этого издательства. Ха¬

рактер проекта сделал подготовку издания данной книги несколько непривычной задачей

для многих из них, и я высоко ценю проявленную ими снисходительность.

В процессе написания этой книги я приобрел трех новых наставников и хочу осо¬

бо выразить им свою признательность. Во-первых, Стиву Саммиту (Steve Summit), ко¬

торый внимательно проверил на техническом уровне первые варианты рукописи и

предоставил буквально тысячи подробных комментариев, особенно в отношении про¬

грамм. Стив хорошо понимал мое стремление снабдить книгу изящными и эффектив¬

ные реализациями, и его комментарии помогли мне не только обеспечить определен¬

ное единообразие реализаций, но и существенно улучшить многие из них. Во-вторых,

хочу поблагодарить Лин Дюпре (Lyn Dupre) за тысячи подробных комментариев в от¬

ношении рукописи, которые помогли не только избежать и исправить грамматические

ошибки, но и (что значительно важнее) выработать последовательный и связный стиль

написания, что позволило собрать воедино устрашающую массу технического материа¬

ла. Я исключительно благодарен полученной возможности поучиться у Стива и Лин -

их вклад в разработку этой книги оказался решающим.

Многое из написанного здесь я узнал из лекций и трудов Дона Кнута (Don

Knuth) - моего наставника в Стэнфорде. Хотя непосредственно Дон и не участвовал

в написании этой книги, его влияние можно почувствовать на всем ее протяжении,

ибо именно он поставил изучение алгоритмов на научную основу, благодаря чему во¬

Предисловие 15

обще стало возможным появление подобного рода книг. Мой друг и коллега Филлип

Флажоле (Philippe Flajolet), благодаря которому анализ алгоритмов стал вполне сфор¬

мировавшейся областью исследований, оказал такое же влияние этот труд.

Я глубоко признателен за оказанную мне поддержку Принстонскому университету,

Брауновскому университету и Национальному институту исследований в области ин¬

форматики и автоматики (INRIA - Institute de Recherche en Informatique and

Automatique), где я проделал большую часть работы над книгой, а также Институту

исследований проблем безопасности и Исследовательскому центру компании Xerox в

Пало-Альто, где была проделана часть работы во время моих визитов туда. В основу

многих глав этой книги положены исследования, которые щедро финансировались

Национальным научным фондом и Отделом военно-морских исследований. И в заклю¬

чение, я благодарю Билла Боуэна (Bill Bowen), Аарона Лемоника (Aaron Lemonick) и

Нейла Руденштайна (Neil Rudenstine) за то, что они способствовали созданию в

Принстоне академической обстановки, в которой я получил возможность подготовить

эту книгу, несмотря на множество других возложенных на меня обязанностей.

Роберт Седжвик

Марли-де-Руа, Франция, февраль 1983 г.

Принстон, Нью-Джерси, январь 1990 г.

Джеймстаун, Род-Айленд, август 2001 г.

Адаму, Эндрю, Бретт, Робби и, в первую очередь, Линде посвящается.

Примечания к упражнениям

Классификация упражнений - это занятие, сопряженное с рядом трудностей, по¬

скольку читатели такой книги, как эта, обладают различным уровнем знаний и опыта.

Тем не менее, определенное указание не помешает, поэтому многие упражнения по¬

мечены одним из четырех маркеров, дабы проще было выбрать соответствующий под¬

ход.

Упражнения, которые проверяют, насколько хорошо вы усвоили материал, помечены

незаполненным треугольником:

> 17.3. Составьте список неизоморфных циклов графа, представленного на рис. 17.1.

Например, если в вашем списке содержится цикл 3-4-5-3, в нем не могут нахо¬

диться циклы 3-5-4-3, 4-5-3-4, 4-3-5-4, 5-3-4-5 или 5-4-3-5.

Чаще всего такие упражнения непосредственно связаны с примерами в тексте.

Они не должны вызывать особых трудностей, но их выполнение может прояснить

факт или понятия, которые, возможно, ускользнули из вашего внимания во время

чтения текста.

Упражнения, которые дополняют текст новой и требующей размышления информаци¬

ей, помечены незаполненной окружностью:

о 18.6. Реализуйте DFS, используя свою независимую от представления АТД-функ-

цию для обработки списков ребер из упражнения 17.60.

Такие упражнения заставляют сосредоточиться на важных понятиях, связанных с

материалом, наложенным в тексте, или искать ответа на вопрос, который может воз¬

никнуть во время прочтения. Возможно, читатели сочтут полезным прочесть эти уп¬

ражнения дбже при отсутствии времени для их выполнения.

16 Фундаментальные алгоритмы на С. Части 1-5

Упражнения, которые имеют цель поставить перед читателями задачу, помечены

черной точкой:

• 19.2. Назовите пример крупного графа DAG, описывающего какую-нибудь дея¬

тельность, выполняемую в интерактивном режиме, возможно, графа, определяемо¬

го зависимостями, связывающими определения функций в крупной системе про¬

граммного обеспечения, или связями каталогов в крупной файловой системе.

Для выполнения таких упражнений требуется потратить значительное время, в за¬

висимости от опыта читателя. В общем случае, лучше всего выполнять их в несколько

приемов.

Несколько упражнений, которые особенно трудны (по сравнению с большинством

других) помечены двумя черными точками:

•• 20.77. Разработайте алгоритм, который при заданном множестве N точек на плос¬

кости находит множество ребер, мощность которого пропорциональна N, и в ко¬

тором наверняка содержится дерево MST. Этот алгоритм должен содержать доста¬

точно легкие вычисления, чтобы можно было разработать компактную и

эффективную реализацию.

Эти упражнения аналогичны вопросам, которые могут ставиться в научной литера¬

туре, однако материал книги может так подготовить читателей, что им доставит удо¬

вольствие попытаться ответить на них (а, возможно, и преуспеть в этом).

Мы старались, чтобы все пометки были безотносительны к программной и матема¬

тической подготовке читателей. Те упражнения, которые требуют наличия опыта по

программированию или математическому анализу, очевидны. Мы настоятельно реко¬

мендуем читателям проверить свое понимание алгоритмов, реализовав их. Тем не ме¬

нее, упражнения, подобные приведенному ниже, просты для профессиональных про¬

граммистов или студентов, изучающих программирование, но могут потребовать

значительных усилий от тех, кто в последнее время по ряду причин программировани¬

ем не занимался:

• 17.73. Напишите программу, которая генерирует V случайных точек на плоскости,

после чего строит граф, состоящий из ребер, соединяющих все пары точек, уда¬

ленных друг от друга на расстояние, не превышающее d (см. рис. 17.13 и програм¬

му 3.20). Определите, какое значение d следует выбрать, чтобы ожидаемое число

ребер было равно Е. Проведите тестирование полученной программы в соответствии с

изложенным в упражнении 17.64 (для низких уровней насыщенности) и в соответствии

с изложенным в упражнении 17.65 (для высоких уровней насыщенности).

Мы настоятельно рекомендуем всем читателям стремиться учитывать приводимые

нами аналитические обоснования свойств всех алгоритмов. С другой стороны, упраж¬

нения, подобные нижеследующему, не составляют сложности для профессионального

математика или студента, изучающего дискретную математику, однако наверняка потребу¬

ют значительных усилий от тех, кто давно не занимался математическим анализом:

• 18.3. Сколько существует путей обхода лабиринта, показанного на рис. 18.2 и 18.3,

при проведении исследования Тремо?

Книга снабжена большим количеством упражнений, чтобы всех их можно было

прочесть и усвоить; тем не менее, я надеюсь, что среди них достаточно таких, кото¬

рые могут послужить мощным стимулом к углубленному пониманию интересующих их

вопросов, нежели простое чтение текста.

Анализ

1

2

Ввеление

Принципы анализа алгоритмов

Введение

Цель этой книги - изучение широкого множества важ¬

ных и полезных алгоритмов, то есть, методов реше¬

ния задач, которые подходят для компьютерной реализа¬

ции. Мы будем иметь дело с различными областями

применения, всегда уделяя основное внимание фундамен¬

тальным алгоритмам, которые важно знать и интересно

изучать. Мы затратим достаточное время на изучение каж¬

дого алгоритма, чтобы понять его основные характеристи¬

ки и разобраться во всех его тонкостях. Наша цель - до¬

статочно подробно изучить как можно больше самых

важных алгоритмов, используемых в компьютерах в насто¬

ящее время, чтобы уметь ими пользоваться и дать оценку

их сильным и слабым сторонам.

Стратегия, используемая для изучения программ, пред¬

ставленных в этой книге, заключается в их реализации и

тестировании, экспериментировании с различными их вер¬

сиями, в анализе их работы на небольших примерах и в

попытках их выполнения применительно к более сложным

практическим задачам, с какими мы можем столкнуться

на практике. Для описания алгоритмов будет использован

язык программирования С, что также позволит получить

полезные программные реализации. Программы написаны

в единообразном стиле, который допускает также их пе¬

ревод на другие современные языки программирования.

Значительное внимание также уделяется рабочим ха¬

рактеристикам алгоритмов, чтобы легче было разрабаты¬

вать более совершенствованные версий алгоритмов, срав¬

нивать различные алгоритмы выполнения одной и той же

задачи и предсказывать или гарантировать их производи¬

тельность при решении сложных задач. Чтобы понять, как

работает тот или иной алгоритм, возможно, потребуется

выполнить ряд экспериментов с ними или провести их ма-

Глава 1. Введение 19

тематический анализ, либо и то, и другое. Мы рассмотрим подробную информацию,

касающуюся многих наиболее важных алгоритмов, причем, когда это целесообразно,

аналитические выкладки приводятся непосредственно в тексте; в других случаях, необ¬

ходимые результаты берутся из научных публикаций.

Чтобы продемонстрировать общий подход к разработке алгоритмических решений,

в этой главе мы рассмотрим подробный пример, по условиям которого для решения

конкретной задачи используются несколько алгоритмов. Рассматриваемая задача — это

не просто модельная задача; это фундаментальная вычислительная задача, и решение,

которое мы стремимся получить, должно быть пригодным для использования в раз¬

личных приложениях. Мы начнем с простого решения, затем постараемся выяснить

его рабочие характеристики, что поможет нам найти способы усовершенствовать ал¬

горитм. Выполнив определенное число итераций этого процесса, получим эффектив¬

ный и полезный алгоритм решения задачи. Этот пример служит своего рода прототи¬

пом использования одной и той же общей методологии на протяжении всей книги.

Глава завершается кратким обсуждением содержания книги, включая описание ос¬

новных ее частей и их взаимосвязь между собой.

1.1 Алгоритмы

Для написания компьютерной программы мы обычно используем метод, который

уже был когда-то разработан для решения какой-либо задачи. Часто этот метод не за¬

висит от конкретного используемого компьютера - вполне вероятно, что он будет

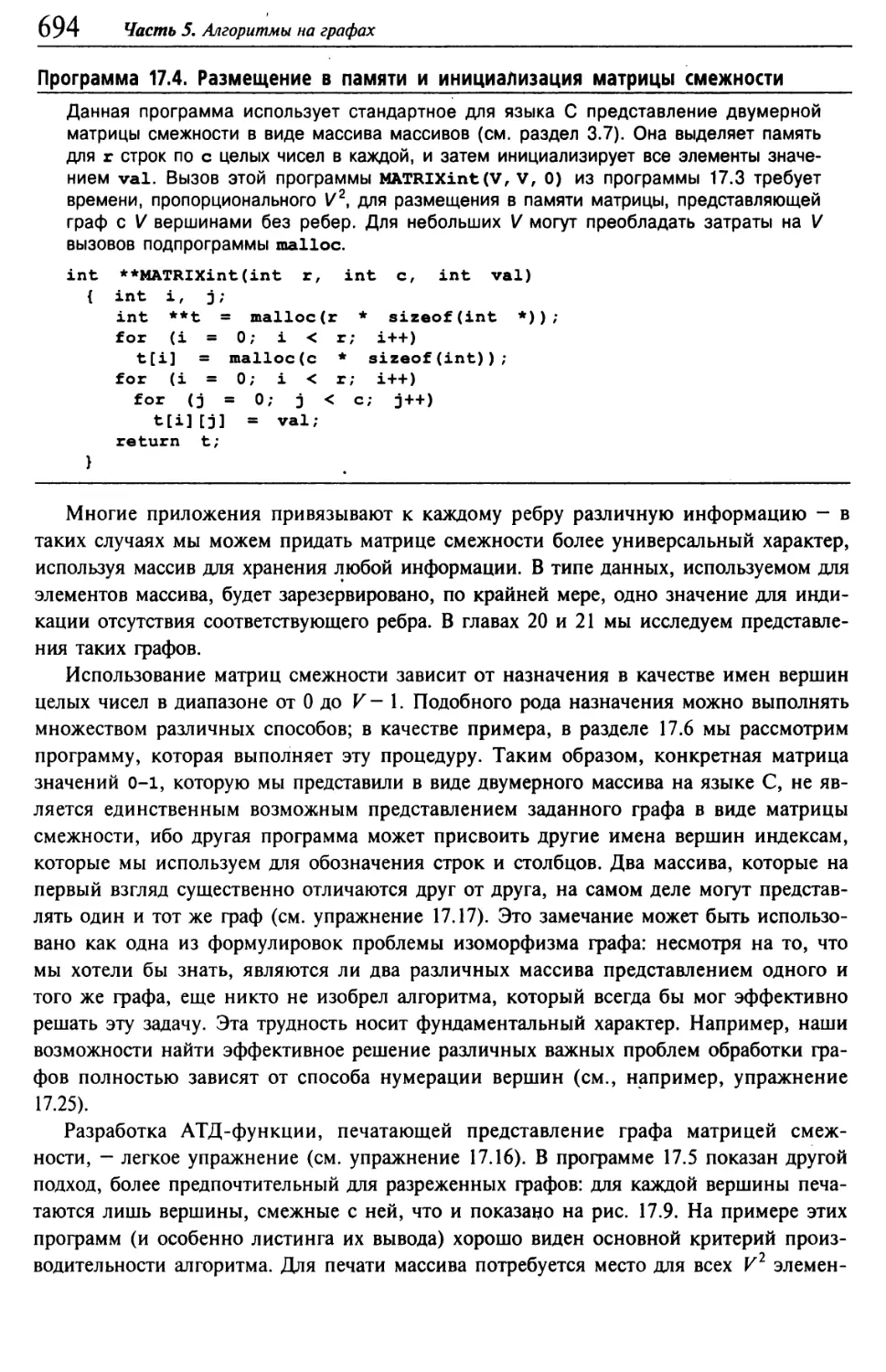

одинаково пригодным для многих компьютеров и многих компьютерных языков.

Именно метод, а не сама программа должен быть исследован с тем, чтобы выяснить, как

подойти к решению задачи. Термин алгоритм используется в компьютерных науках для

описания метода решения задачи, пригодного для реализации в виде компьютерной про¬

граммы. Алгоритмы составляют основу теории вычислительных машин и систем: они явля¬

ются основными объектами изучения во многих, если не большинства ее областей.

Большая часть представляющих интерес алгоритмов использует методы организа¬

ции данных, применяемых в вычислениях. Созданные таким образом объекты называ¬

ются структурами данных (data structures), и они также являются центральными объекта¬

ми изучения компьютерных наук. Следовательно, алгоритмы и структуры данных идут

рука об руку. В этой книге мы будем придерживаться точки зрения, согласно которой

структуры данных существуют как промежуточные или конечные результаты выполне¬

ния алгоритмов и, следовательно, обязаны мы их изучить, чтобы получить полное

представление об алгоритме. Простые алгоритмы могут порождать сложные структуры

данных и наоборот, сложные алгоритмы могут использовать простые структуры дан¬

ных. В этой книге будут изучены свойства многих структур данных; фактически книга

вполне могла бы называться "Алгоритмы и структуры данных в языке С".

Когда компьютер используется для решения той или иной задачи, мы, как прави¬

ло, сталкиваемся с рядом различных возможных подходов. При решении простых за¬

дач выбор того или иного подхода вряд ли имеет особое значение, если только выб¬

ранный подход приводит к правильному решению. Однако, при решении сложных

задач (или в приложениях, в которых приходится решать очень большое количество

простых задач) мы немедленно сталкиваемся с необходимостью разработки методов, в

20 Часть 1. Анализ

условиях которых время или память используются с максимально возможной эффек¬

тивностью.

Основная побудительная причина изучения алгоритмов состоит в том, что это зна¬

ние этой предметной области позволяет обеспечить огромную экономию ресурсов,

вплоть до получения решений задач, которые в противном случае были бы невозмож¬

ны. В приложениях, в которых обрабатываются миллионы объектов, часто оказывается

возможным ускорить работу программы в миллионы раз, используя хорошо разрабо¬

танный алгоритм. Подобный пример приводится в разделе 1.2 и многих других разде¬

лах книги. Для сравнения, дополнительные затраты денег или времени для приобрете¬

ния и установки нового компьютера потенциально позволяет ускорить работу программы

всего лишь в 10-100 раз. Тщательная разработка алгоритма - исключительно эффектив¬

ная часть процесса решения сложной задачи в любой области применения.

При разработке очень большой или очень сложной компьютерной программы зна¬

чительные усилия должны быть направлены на понимание и постановку задачи, под¬

лежащей решению, оценку ее сложности и разбиение ее на менее сложные подзадачи,

решения которых можно легко реализовать. Часто реализация многих из алгоритмов

решения задач, полученных в результате разбиения, тривиальна. Однако в большинстве

случаев существует несколько алгоритмов, выбор которых особенно важен, поскольку

на их выполнения затрачивается существенная часть системных ресурсов. Именно

этим типам алгоритмов уделяется основное внимание в данной книге. Мы изучим ряд

основополагающих алгоритмов, которые полезны при решении сложных задач во

многих областях применения.

Совместное использование одних и тех же программ в различных компьютерных

системах становится все более распространенным, поэтому, рассчитывая на использо¬

вание многих из рассмотренных в книге алгоритмов, мы в то же время должны созна¬

вать, что реализовывать нам удастся лишь немногие из них. Тем не менее, реализация

простых версий базовых алгоритмов позволяет лучше их понять и, следовательно, эф¬

фективнее использовать и точнее настраивать более развитые их версии. И что еще

важнее, повод для повторной реализации базовых алгоритмов возникает очень часто.

Основная причина состоит в том, что мы сталкиваемся, и очень часто, с совершенно

новыми вычислительными средами (аппаратными и программными) и с новыми свой¬

ствами, которые не могут наилучшим образом использовать старые реализации этих

алгоритмов. Другими словами, чтобы наши решения были более переносимыми и

дольше сохраняли актуальность, мы часто пользуемся базовыми алгоритмами, ориен¬

тированными на конкретное приложение, а не полагаемся на системные подпрограм¬

мы. Другая часто возникающая причина повторной реализации базовых алгоритмов

заключается в том, что механизмы совместного использования программ во многих

компьютерных системах не всегда обладают достаточной мощностью, чтобы позволить

нам адаптировать стандартные программы для эффективного решения специальных

задач (либо вообще могут не подходить для их выполнения), поэтому иногда гораздо

легче разработать новую реализацию.

Компьютерные программы часто чрезмерно оптимизированы. В некоторых случаях

достижения максимальной эффективности реализации конкретного алгоритма не стоит

затрачиваемых на это усилий, например, если алгоритм не предназначен для решения

очень сложной задачи или не используется многократно. В отдельных случаях вполне

Глава 1. Введение 2 1

достаточно аккуратной, сравнительно простой реализации: достаточно быть уверенным

в ее работоспособности и в том, что, скорее всего, в худшем случае она будет рабо¬

тать в 5—10 раз медленнее наиболее эффективной версии, что может означать увеличе¬

ние времени выполнения на несколько дополнительных секунд. И напротив, правиль¬

ный выбор алгоритма может ускорить работу в 100-1000 и более раз, что может

обеспечить экономию времени прогона алгоритма в минутах, часах и даже более того.

В этой книге основное внимание уделяется простейшим приемлемым реализациям

наилучших алгоритмов.

Выбор наилучшего алгоритма решения конкретной задачи может оказаться слож¬

ным процессом, подчас требующим сложного математического анализа. Направление

компьютерных наук, занимающееся изучением подобных вопросов, называется анали¬

зом алгоритмов (analysis of algorithm). Анализ многих изучаемых нами алгоритмов пока¬

зывает, что для них характерна прекрасная производительность; о хорошей работе

других известно просто из опыта их применения. Наша основная цель - изучение ал¬

горитмов, пригодных для решения важных задач, хотя большое внимание будет уделе¬

но также сравнительной производительности различных методов. Не следует использо¬

вать алгоритм, не имея представления о ресурсах, которые могут потребоваться для

его выполнения, поэтому мы стремимся заранее знать, какую производительность

можно ожидать от того или иного алгоритма.

1.2 Пример задачи связности

Предположим, что имеется последовательность пар це¬

лых чисел, в которой каждое целое число представляет

объект некоторого типа, а пара p-q интерпретируется как

"р связано с q". Мы полагаем, что отношение ’’связано с"

является транзитивным: если р связано с q, a q связано с

г, то р связано с г. Задача состоит в написании програм¬

мы, исключающей лишние пары из этого множества: ког¬

да программа вводит пару p-q, она должна выводить эту

пару только в том случае, если из просмотренные на те¬

кущий момент множества пар не следует, что р связано с

q. Если просмотренных ранее пар следует, что р связано

с q, то программа должна игнорировать пару p-q и пере¬

ходить к вводу следующей пары. Пример такого процесса

показан на рис. 1.1.

Задача состоит в разработке программы, которая мо¬

жет запомнить достаточный объем информации о просмот¬

ренных парах, чтобы решить, связана ли новая пара

объектов. Достаточно неформально задачу разработки та¬

кого метода мы называем задачей связности (connectivity

problem). Такая задача возникает в ряде важных приложе¬

ний. Мы коротко рассмотрим три примера, подтверждаю¬

щие фундаментальный характер этой задачи.

Например, целые числа могли бы представлять компь¬

ютеры в большой сети, а пары чисел могли бы представ-

3-4

4-9

8-0

2-3

5-6

2-9

5-9

7-3

4-8

5-6

0-2

6-1

3-4

4-9

8-0

2-3

5-6

5-9

7-3

4-8

6-1

2-3-4-9

5-6

0-8-4-3-2

РИСУНОК 1.1.

ПРИМЕР ЗАДАЧИ СВЯЗНОСТИ

При заданной последователь¬

ности пар целых чисел,

представляющих связь между

объектами (столбец слева),

в алгоритме решения задачи

связности передайте на

вывод те пары, которые

устанавливают новые связи

(столбец в центре). Напри¬

мер, пара 2-9 не должна

выводиться, поскольку связь

2-3-4-9 определяется ранее

указанными связями (доказа¬

тельство этого утверждения

показано справа).

22 Часть /. Анализ

лять соединения в сети. Тогда такой программой можно воспользоваться для опреде¬

ления того, нужно ли устанавливать новое прямое соединение между р и q, чтобы они

имели возможность обмениваться информацией, или же можно использовать суще¬

ствующие соединения, чтобы установить коммутируемый канал связи между ними. В

подобных приложениях может потребоваться обработка миллионов точек и миллиар¬

дов или большего числа соединений. Как мы увидим далее, решить подобную задачу

для такого приложения невозможно, не имея эффективного алгоритма.

Аналогично, целые числа могут представлять токоприемники электрической сети, а

пары этих чисел могут представлять связывающие их провода. В этом случае програм¬

му можно было бы использовать для определения способа соединения всех токопри¬

емников без каких-либо избыточных соединений, если это возможно. Не существует

никакой гарантии того, что ребер списка окажется достаточно для соединения всех

точек - действительно, вскоре мы увидим, что определение факта, так ли это, может

стать основным применением нашей программы.

Рисунок 1.2 служит более сложным примером использования этих двух видов при¬

ложений. Изучение этого рисунка дает представление о сложности задачи связности:

как можно быстро выяснить, являются ли любые две заданные точки в такой сети свя¬

занными?

РИСУНОК 1.2. БОЛЕЕ СЛОЖНЫЙ ПРИМЕР ЗАДАЧИ СВЯЗНОСТИ

Объекты задачи связности могут быть точками соединений, а пары чисел могут быть соединениями

между ними, как показано в этом идеализированном примере. Они могут представлять провода,

соединяющие здания в городе или компоненты компьютерной микросхемы. Это графическое пред¬

ставление позволяет человеку выявить узлы, не связанные друг с другом, однако алгоритм должен

работать только с переданными ему парами целых чисел. Связаны ли два узла, помеченные черными

кружками ?

Глава 1. Введение 23

Еще один пример встречается в некоторых средах программирования, где имена

каких-либо двух переменных можно объявлять эквивалентными. Задача заключается в

том, чтобы после считывания некоторой последовательности таких объявлений опреде¬

лить, являются ли два заданных имени эквивалентными. Это приложение — одно из

первых, давших начало разработке нескольких алгоритмов, которые мы будем рас¬

сматривать. Как будет показано далее, оно устанавливает непосредственную связь

между рассматриваемой задачей и простой абстракцией, которая позволяет нам ис¬

пользовать эти алгоритмы для широкого круга приложений.

Такие приложения; как задача об эквивалентности имен переменных, описанная в

предыдущем абзаце, требует, чтобы целое число с каждым отдельным именем пере¬

менной было сопоставлено некоторое целое число. Такое сопоставление подразумева¬

ется также в описанных выше приложениях, устанавливающих соединения в сети и в

электрической цепи. В главах 10-16 мы рассмотрим ряд алгоритмов, которые могут

эффективно построить такое сопоставление. Таким образом, в этой главе без ущерба

для общности изложения можно предположить, что имеется N объектов с целочислен¬

ными именами от 0 до N -1.

Нам требуется программа, которая выполняет конкретную, четко поставленную за¬

дачу. Существует множество других задач, связанных с этой задачей, которые нам,

возможно, придется решать. Одна из первых проблем, с которой приходится сталки¬

ваться при разработке того или иного алгоритма, связана с необходимостью убедиться

в том, что задана поставлена правильно. Как правило, чем больше требуется от алго¬

ритма, тем больше времени и объема памяти может потребоваться для решения задачи.

Это соотношение невозможно заранее точно выразить в числах, и часто постановку

задачи приходится менять, когда выясняется, что ее трудно решить, либо ее решение

требует слишком больших затрат, либо когда, при удачном стечении обстоятельств,

выясняется, что алгоритм может предоставить более полезную информацию, чем от

него требовалось в первоначальной постановке.

Например, приведенная выше постановка задачи связности требует только, чтобы

программа каким-либо образом могла узнать, является ли данная пара p-q связанной,

но не требует показать какой-либо один или все способы соединения этой пары. До¬

бавление в постановку конкретного требования усложняет задачу и приводит к друго¬

му семейству алгоритмов, которое мы кратко будет рассматривать в главе 5 и подроб¬

но - в части 7.

Описанная в предыдущем абзаце постановка задачи требуют больше информации,

чем первоначальная постановка; можно также потребовать от нее меньше информации.

Например, можно просто потребовать ответа на вопрос: "Достаточно ли М связей для

соединения всех N объектов?”. Эта задача служит иллюстрацией того факта, что для

разработки эффективных алгоритмов часто требуется обдумать вопросы, касающиеся

обрабатываемых объектов, на высоких уровнях абстракции. В данном случае из фун¬

даментальных положений теории графов следует, что все N объектов связаны тогда и

только тогда, когда количество пар, выданных алгоритмом решения задачи связности,

в точности равно N -1 (см. раздел 5.4). Иначе говоря, алгоритм решения задачи связ¬

ности никогда не выдаст более N -1 пар, поскольку как только он выдаст более

N - 1 пары, любая встретившаяся после этого пара уже будет связанной. Соответ¬

ственно, можно написать программу, отвечающую "да/нет" на только что поставлен¬

24 Часть 1. Анализ

ный вопрос, изменив программу, которая решает задачу связности таким образом,

чтобы она увеличивала значение специального счетчика, а не выдавала на выходе ра¬

нее несвязанную пару, и отвечала "да", когда значение счетчика достигнет значения

N- 1, и "нет”, если это не происходит. Этот вопрос - всего лишь один из множества

вопросов, на которые мы хотели бы получить ответ, исследуя свойства связности гра¬

фов. Входное множество пар чисел называется графом (graph), а выходное множество

пар — остовным деревом (spanning tree) этого графа, связывающим все объекты. Свой¬

ства графов, остовных деревьев и всевозможные связанные с ними алгоритмы будут

рассматриваться в части 7.

Имеет смысл попытаться выявить базовые операции, использованные в алгоритме

решения задачи связности и тем самым сделать любой алгоритм решения этой задачи

полезным для решения ряда аналогичных задач. В частности, при получении каждой

новой пары вначале необходимо определить, представляет ли она новое соединение,

затем следует увязать информацию о том, что это соединение было просмотрено, в

общую картину связности объектов таким образом, чтобы эта пара учитывалась при

проверке последующих соединений в будущем. Мы инкапсулируем эти две задачи в

виде абстрактных операций (abstract operation), полагая, что вводимые целочисленные

значения представляют элементы в абстрактных множествах, а затем разработаем такие

алгоритмы и структуры данных, которые могут:

■ находить множество, содержащее заданный элемент,

■ замещать множества, содержащие два данных элемента, их объединением.

Организация алгоритмов в виде последовательности абстрактных операций, по-ви¬

димому, не препятствует никаким вариантам решения задачи связности, а сами эти

операции могут оказаться полезными при решении других задач. Разработка все более

высоких уровней абстракции, обеспечивающими возрастающие возможности, - ос¬

новной процесс в компьютерных науках в целом и в разработке алгоритмов в частно¬

сти, и на протяжении этой книги мы будем обращаться к нему неоднократно. В этой

главе мы неформально воспользуемся абстрактным мышлением в качестве руководя¬

щих принципов при разработке программ решения задачи связности; как внедряются

абстракции в программы на языке С, будет показано в главе 4.

Задача связности легко решается посредством абстрактных операций find (поиск) и

union (объединение). После считывания новой пары p-q из ввода мы выполняем опера¬

цию find для каждого элемента пары. Если элементы пары находятся в одном наборе,

мы переходим к следующей паре; если нет, то выполняем операцию union и записыва¬

ем Ъту пару. Множества представляют связные компоненты (connected component): это

подмножества объектов, характеризующиеся тем, что любые два объекта в данной

компоненте связаны. Этот подход сводит разработку алгоритмического решения зада¬

чи связности к задачам определения структуры данных, представляющей эти множе¬

ства, и к разработке алгоритмов операций union и find, которые эффективно использу¬

ют эту структуру данных.

Существует много возможных способов представления и обработки абстрактных

множеств. В этой главе основное внимание уделяется поиску представления, которое

может эффективно поддерживать операции union и find, требуемые для решения задачи

связности.

Глава L Введение 25

Упражнения

1.1. Приведите выходные результаты, которые должен вычислить алгоритм реше¬

ния задачи связности при заданном вводе 0-2, 1-4, 2-5, 3-6, 0-4, 6-0 и 1-3.

1.2. Перечислите все возможные способы связывания двух различных объектов,

показанных в примере на рис. 1.1.

1.3. Опишите простой метод подсчета числа множеств, остающихся после выполне¬

ния операций union и find при решении задачи связности, как описано в тексте.

1.3 Алгоритмы объединения-поиска

Первый шаг в процессе разработки эффективного алгоритма решения заданной за¬

дачи - реализация упрощенного алгоритма ее решения. Если нужно решить несколько ва¬

риантов конкретной задачи, которые оказываются простыми, это может быть выпол¬

нено посредством упрощенной реализации. Если требуется более сложный алгоритм,

то упрощенная реализация предоставляет возможность проверить правильность работы

алгоритма для простых случаев и может служить отправной точкой для оценки харак¬

теристик производительности. Эффективность всегда остается предметом наших забот,

однако наш основной интерес при разработке первой программы решения задачи со¬

стоит в том, чтобы убедиться, что эта программа является правильным решением.

Первая мысль, которая при этом возникает - надо как-то сохранить все вводимые

пары, а затем создать функцию для их просмотра, чтобы попытаться выяснить, связа¬

на ли следующая пара объектов. Однако нам придется воспользоваться другим подхо¬

дом. Во-первых, количество пар может быть настолько велико, что в условиях прак¬

тического приложения все они не поместятся в памяти. Во-вторых, что гораздо

важнее, не существует никакого простого метода, который позволил бы определить,

связаны ли два объекта на множестве всех соединений, даже если бы нам удалось

всех их разместить в памяти! Базовый метод, использующий этот подход, рассматрива¬

ется в главе 5, методы, которые исследуются в этой главе, проще, поскольку они ре¬

шают менее сложную задачу, и эффективнее, поскольку не требуют сохранения всех

пар. Все они используют массив целых чисел, каждое из которых соответствует от¬

дельному объекту, для хранения информации, необходимой для реализации операций

union и find.

Массивы суть элементарные структуры данных, которые подробно изучаются в

разделе 3.2. Здесь же они используются в простейшей форме: мы объявляем, что соби¬

раемся использовать, скажем, 1000 целых чисел, записывая а [1000]; затем мы обра¬

щаемся к /-ому целому числу в массиве, записывая a[i] для 0 < / < 1000.

Программа 1.1 представляет собой реализацию простого алгоритма, называемого

алгоритмом быстрого поиска (quick find algorith), решающего задачу связности. В основе

этого алгоритма лежит использование массива целых чисел, обладающих тем свой¬

ством, что р и q связаны тогда и только тогда, когда р-тая и #-тая записи массива рав¬

ны. Мы инициализируем /-тую запись массива значением / при 0 < / < N. Чтобы реа¬

лизовать операцию union для р и q, мы просматриваем массив, изменяя все записи с

именем р на записи с именем q. Этот выбор произволен - можно было бы все записи

с именем q изменить на записи с именем р.

26 Часть 1. Анализ

Программа 1.1. Решение задачи связности методом быстрого поиска

Эта программа считывает последовательность пар неотрицательных целых чисел,

меньших N, из стандартного ввода (интерпретируя пару р q, как "связать объект р с

объектом q") и выводит пары, представляющие объекты, которые еще не связаны.

Она поддерживает массив id, содержащий запись для каждого объекта и обладаю¬

щий тем свойством, что элементы id[p] и id[q] равны тогда и только тогда, когда

объекты р и q связаны. Для простоты N определена во время компиляции как кон¬

станта. Иначе можно было бы считывать ее из ввода и распределять массив id дина¬

мически (см. раздел 3.2).

#include <stdio.h>

#define N 10000

main ()

{ int i, p, q, t, id[N] ;

for (i = 0; i < N; i++) id[i] = i;

while (scanf("%d %d\n", &p, &q) == 2)

{

if (id[p] == id[q]) continue;

for (t = id[p] , i = 0; i < N; i++)

if (id[i] == t) id[i] = id[q] ;

printf(" %d %d\n", p, q);

}

}

Изменения массива при выполнении операций union

в примере на рис. 1.1 показаны на рис. 1.3. Для реали¬

зации операции find достаточно проверить указанные

записи массива на предмет равенства - отсюда следует

название быстрый поиск (quick-find). С другой стороны,

операция union требует просмотра всего массива для

каждой вводимой пары.

Свойство 1.1 Алгоритм быстрого поиска выполняет не

менее MN инструкций для решения задачи связности

при наличии N объектов, для которых требуется вы¬

полнение М операций объединения.

Для каждой из М операций union цикл for выполня¬

ется N раз. Для каждой итерации требуется выпол¬

нение, по меньшей мере, одной инструкции (если ог¬

раничиваться только проверкой завершения цикла). ■

На современных компьютерах можно выполнять де¬

сятки или сотни миллионов инструкций в секунду, по¬

этому эти затраты не заметны, если значения М и N

малы, но в современных приложениях может потребо¬

ваться обработка миллиардов объектов и миллионов

вводимых пар. Поэтому мы неизбежно приходим к

заключению, что для подобных задач нельзя найти при¬

емлемого решения, если пользоваться алгоритмом быс¬

трого поиска (см. упражнение 1.10). Процесс точного

количественного обоснования этого заключения будет

рассматриваться в главе 2.

р q

0123456789

2 4 4

2 9 9

2 9 9

9

9

9

9

9

1 1

7 8

7 8

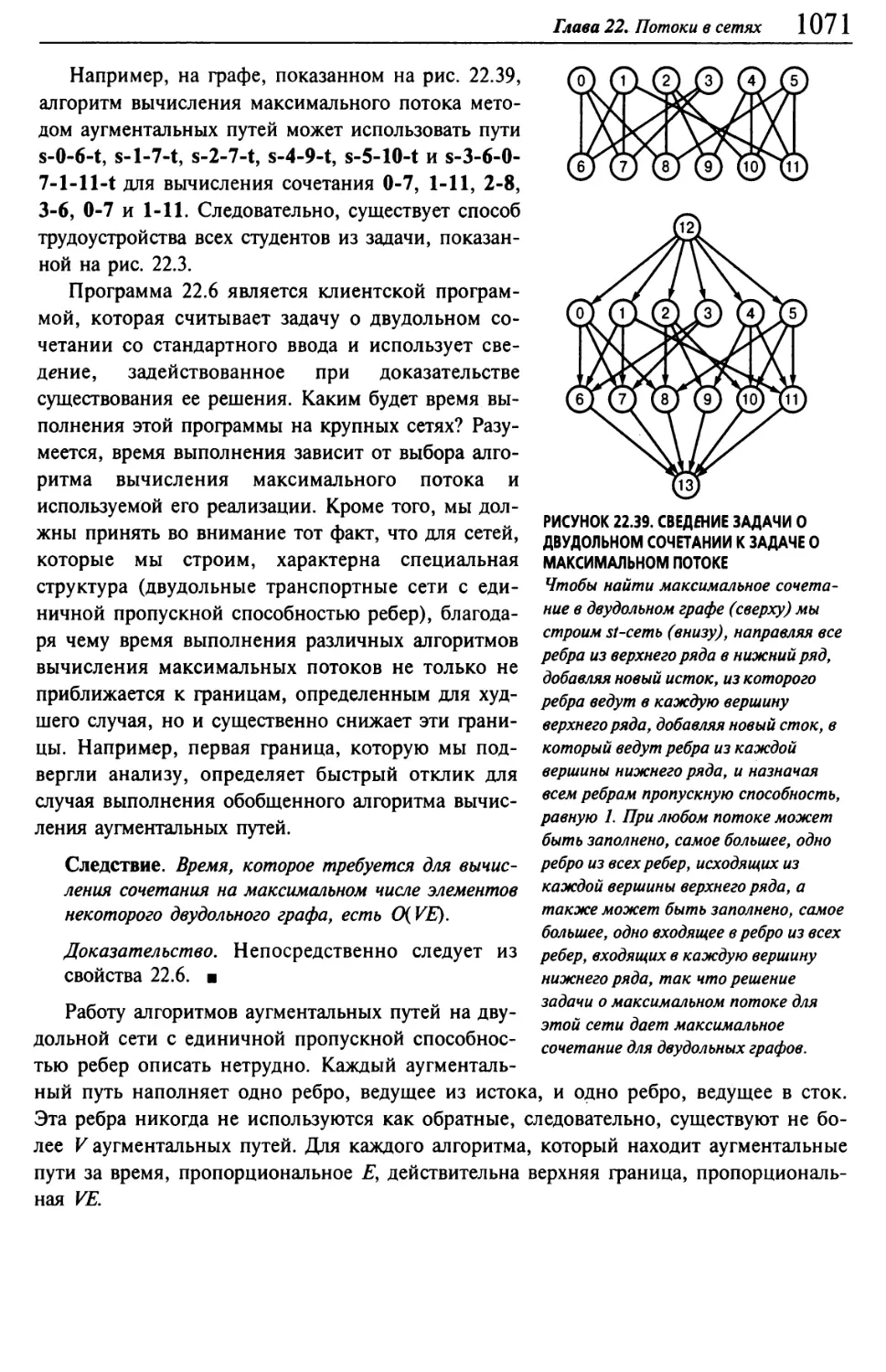

7 0

7 0

9 7

9 9

0 0 0 0 0

0 0 0 0 0

0 0 0 0 0

11111

РИСУНОК 1.3

ПРИМЕР БЫСТРОГО ПОИСКА

(МЕДЛЕННОГО ОБЪЕДИНЕНИЯ)

В этой таблице приводится

содержимое массива id после

того, как каждая пара,

представленная слева, обраба¬

тывается алгоритмом быстрого

поиска (программа 1.1).

Затененные элементы — это

те, которые изменяются для

выполнения операции union.

При обработке пары р q все

элементы, имеющие значение

id[p], получают значение

id[q].

Глава 7. Введение 27

®®@®®®®®®

® ® ©

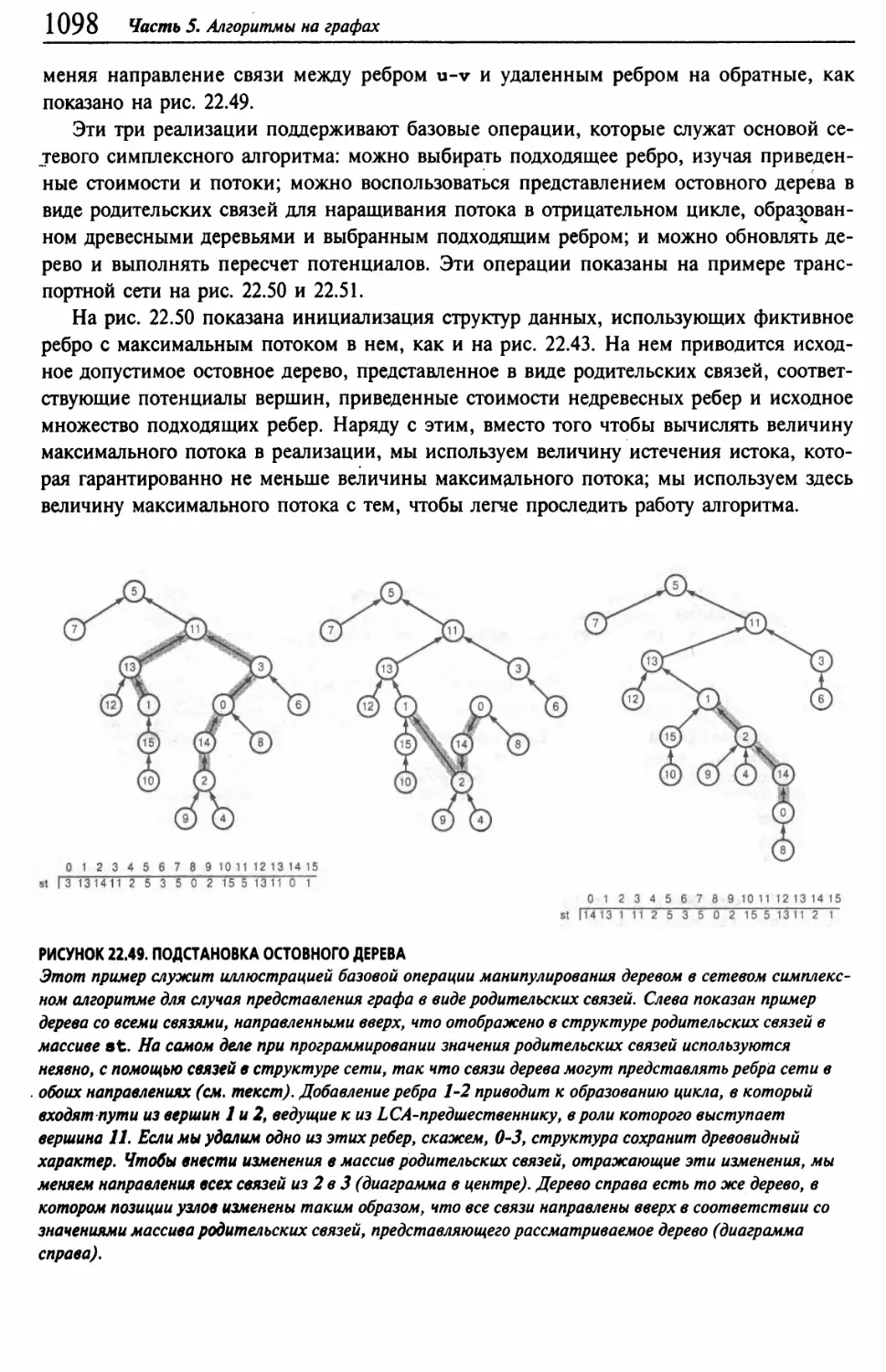

® ® ® ®

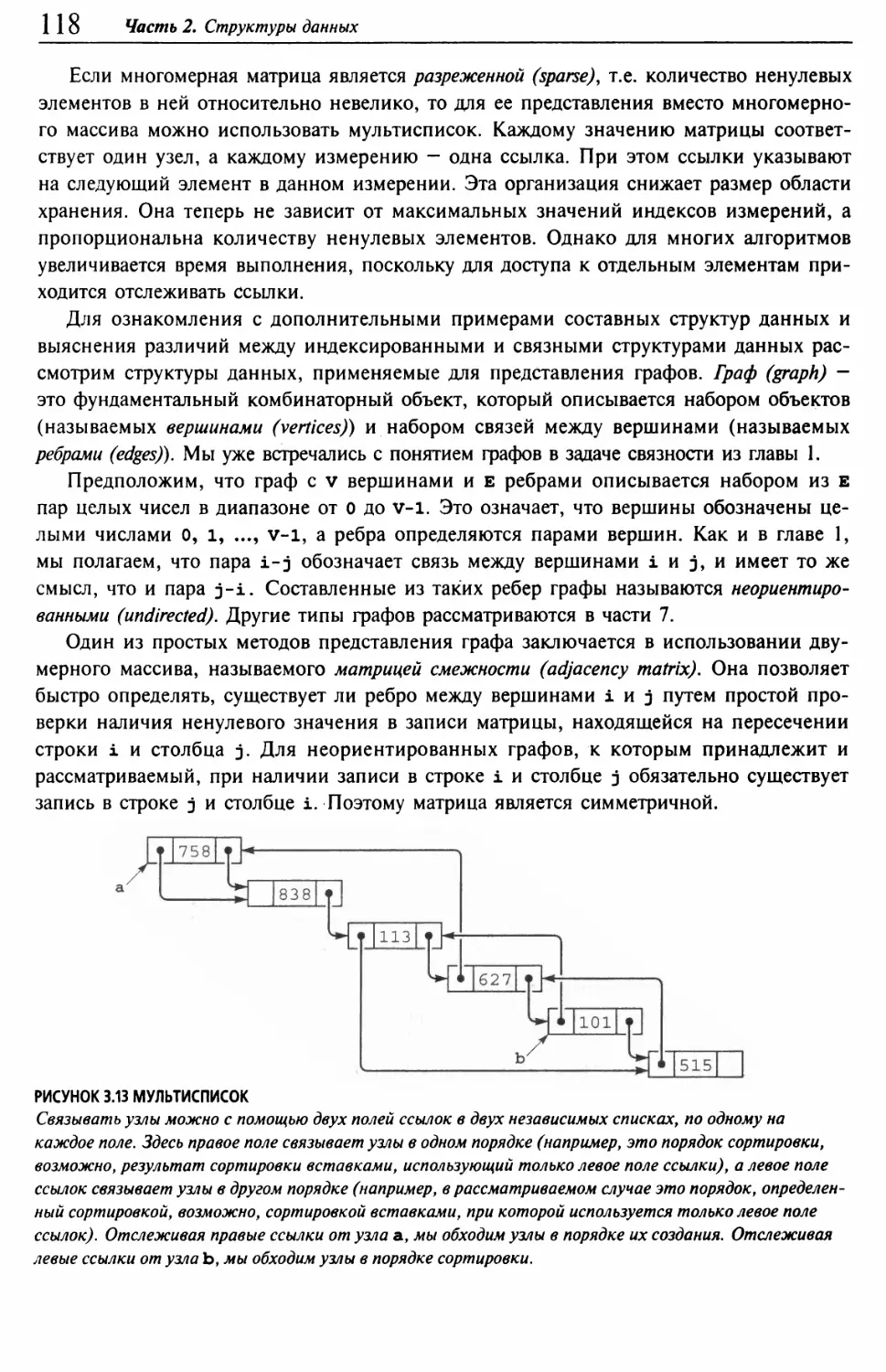

Графическое представление массива, показанного на

рис. 1.3, приведено на рис. 1.4. Можно считать, что не¬

которые объекты представляют множество, к которому

они принадлежат, а остальные указывают на представите¬

ля их множества. Причина обращения к такому графи¬

ческому представлению массива вскоре станет понятна.

Обратите внимание на тот факт, что связи между объек¬

тами в этом представлении не обязательно совпадают со

связями во вводимых парах — они представляют собой

информацию, запоминаемую алгоритмом, чтобы иметь

возможность определить, соединены ли пары, которые

будут вводиться в будущем.

Следующий алгоритм, который мы рассмотрим, пред¬

ставляет собой метод, дополнительный к предшествующе¬

му и названный алгоритмом быстрого объединения (quick-

union algorithm). В его основе лежит та же структура

данных - массив, индексированный по именам объектов,

но в нем используется иная интерпретация значений, что

приводит к более сложным абстрактным структурам. В

структуре, которая не содержит циклов, каждый объект

указывает на другой объект того же множества. Чтобы

определить, находятся ли два объекта в одном множе¬

стве, мы следуем указателям на каждый из них до тех

пор, пока не будет достигнут объект, который указывает

на самого себя. Объекты находятся одном и том же мно¬

жестве тогда и только тогда, когда этот процесс приво¬

дит из каждого из них к одному и тому же объекту. Если

они не содержатся в одном множестве, процесс завер¬

шится на разных объектах (которые указывают сами на

себя). Тогда для образования объединения достаточно

связать оба эти объекта друг с другом, чтобы выполнить

операцию union; отсюда и название быстрое объединение

(quick-union).

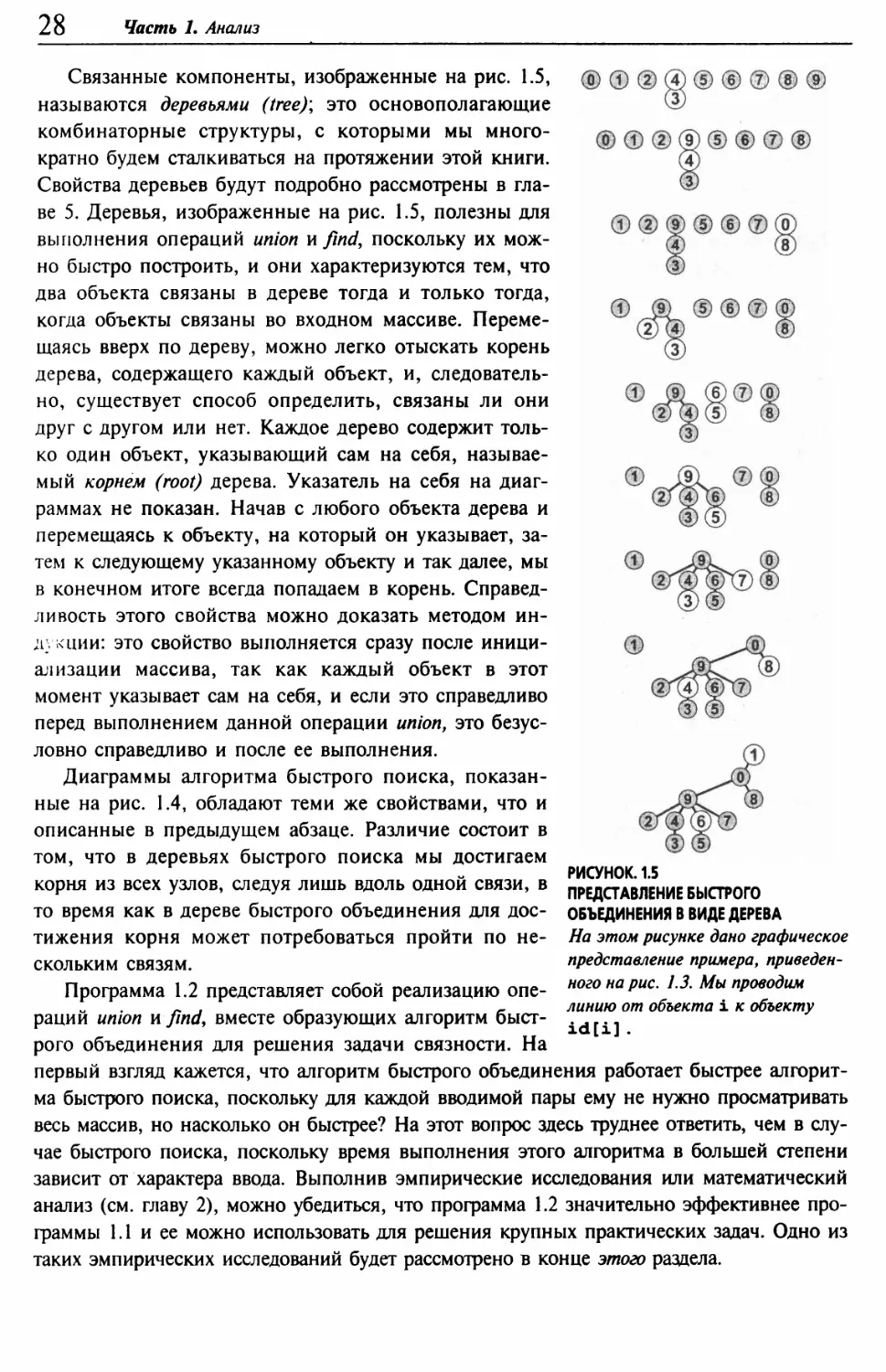

На рис. 1.5 показано графическое представление, ко¬

торое соответствует рис. 1.4 при выполнении алгоритма

быстрого объединения на массиве, изображенном на рис.

1.1, а на рис. 1.6 показаны соответствующие изменения в

массиве id. Графическое представление структуры дан¬

ных позволяет сравнительно легко понять, как работает

алгоритм - вводимые пары, о которых известно, что они

связаны во входных данных, остаются связанными и в

структуре данных. Как упоминалось ранее, важно иметь в виду с самого начала, что

связи в структуре данных не обязательно совпадают со связями в приложении, отобра¬

жаемыми вводимыми парами; скорее, алгоритм строит их таким образом, чтобы обес¬

печить эффективное выполнение операций union и find.

РИСУНОК 1.4

ПРЕДСТАВЛЕНИЕ БЫСТРОГО

ПОИСКА В ВИДЕ ДЕРЕВА.

На этом рисунке показано

графическое представление

примера, приведенного на рис.

1.3. Связи на этом рисунке не

обязательно представляют

связи во входном массиве.

Например, структура,

показанная на нижней

диаграмме, содержит связь

1-7, которая отсутствует во

вводе, но образуется в резуль¬

тате обработки строки

связей 7-3-4-9-5-6-1.

28 Часть 1. Анализ

Связанные компоненты, изображенные на рис. 1.5,

называются деревьями (tree); это основополагающие

комбинаторные структуры, с которыми мы много¬

кратно будем сталкиваться на протяжении этой книги.

Свойства деревьев будут подробно рассмотрены в гла¬

ве 5. Деревья, изображенные на рис. 1.5, полезны для

выполнения операций union и find, поскольку их мож¬

но быстро построить, и они характеризуются тем, что

два объекта связаны в дереве тогда и только тогда,

когда объекты связаны во входном массиве. Переме¬

щаясь вверх по дереву, можно легко отыскать корень

дерева, содержащего каждый объект, и, следователь¬

но, существует способ определить, связаны ли они

друг с другом или нет. Каждое дерево содержит толь¬

ко один объект, указывающий сам на себя, называе¬

мый корнем (root) дерева. Указатель на себя на диаг¬

раммах не показан. Начав с любого объекта дерева и

перемещаясь к объекту, на который он указывает, за¬

тем к следующему указанному объекту и так далее, мы

в конечном итоге всегда попадаем в корень. Справед¬

ливость этого свойства можно доказать методом ин¬

дукции: это свойство выполняется сразу после иници¬

ализации массива, так как каждый объект в этот

момент указывает сам на себя, и если это справедливо

перед выполнением данной операции union, это безус¬

ловно справедливо и после ее выполнения.

Диаграммы алгоритма быстрого поиска, показан¬

ные на рис. 1.4, обладают теми же свойствами, что и

описанные в предыдущем абзаце. Различие состоит в

том, что в деревьях быстрого поиска мы достигаем

корня из всех узлов, следуя лишь вдоль одной связи, в

то время как в дереве быстрого объединения для дос¬

тижения корня может потребоваться пройти по не¬

скольким связям.

Программа 1.2 представляет собой реализацию опе¬

раций union n findy вместе образующих алгоритм быст-

®Ф®@®®®®®

(D

® ® ® ® ® ® ® ®

0

®

РИСУНОК. 1.5

ПРЕДСТАВЛЕНИЕ БЫСТРОГО

ОБЪЕДИНЕНИЯ В ВИДЕ ДЕРЕВА

На этом рисунке дано графическое

представление примера, приведен¬

ного на рис. 1.3. Мы проводим

линию от объекта i к объекту

id[i].

рого объединения для решения задачи связности. На

первый взгляд кажется, что алгоритм быстрого объединения работает быстрее алгорит¬

ма быстрого поиска, поскольку для каждой вводимой пары ему не нужно просматривать

весь массив, но насколько он быстрее? На этот вопрос здесь труднее ответить, чем в слу¬

чае быстрого поиска, поскольку время выполнения этого алгоритма в большей степени

зависит от характера ввода. Выполнив эмпирические исследования или математический

анализ (см. главу 2), можно убедиться, что программа 1.2 значительно эффективнее про¬

граммы 1.1 и ее можно использовать для решения крупных практических задач. Одно из

таких эмпирических исследований будет рассмотрено в конце этого раздела.

Глава 1. Введение 29

А пока быстрое объединение будем считать усо¬

вершенствованием, поскольку оно устраняет основ¬

ной недостаток быстрого поиска (состоящий в том,

что для выполнения М операций union на N объектах

программе нужно выполнить, по меньшей мере, NM

инструкций).

Программа 1.2 Решение задачи связности методом

быстрого объединения

Если тело цикла while в программе 1.1 заменить

этим кодом, мы получим программу, которая соот¬

ветствует тем же спецификациям, что и программа

1.1, но выполняет меньше вычислений для операции

union за счет выполнения большего количества вы¬

числений для операции find. Циклы for и последую¬

щий оператор if в этом коде определяют необходи¬

мые и достаточные условия для того, чтобы массив

id для р и q был связанным. Оператор присваива¬

ния id[i] = j реализует операцию union.

for (i = р;

for (j = q;

if (i == j)

id[i] = j;

printf(" %d %d\n",

i != id[i];

j !« id[j];

continue;

= id[i])

= id[j])

q) ;

Это различие между быстрым объединением и

быстрым поиском действительно является усовер¬

шенствованием, но быстрое объединение все же об¬

ладает тем недостатком, что нельзя гарантировать,

что оно будет выполняться существенно быстрее бы¬

строго поиска в каждом случае, ибо может возник¬

нуть такое сочетание вводимых данных, что опера¬

ция find замедлится.

Свойство 1.2. Пусть даны М пар на множестве N

объектов и М > N; для решения задачи связности

алгоритму быстрого объединения может потребо¬

ваться выполнение более MN/2 инструкций.

р

q

0

1

2

3

4

5 6

7

8

9

3

4

0

1

2

щ.

4

5 6

7

8

9

4

9

0

1

2

4

9

5 6

7

8

9

8

0

0

1

2

4

9

5 6

7

0

9

2

3

0

1 !1(

4

9

5 6

7

0

9

5

6

0

1

9

4

9

И б

7

0

9

2

9

0

1

9

4

9

6 6

7

0

9

5

9

0

1

9

4

9

6 ш

7

0

9

7

3

0

1

9

4

9

6 9

ш

0

9

4

8

0

1

9

4

9

6 9

9

0

■

5

6

0

1

9

4

9

б 9

9

0

0

0

2

0

1

9

4

9

б 9

9

0

0

6

1

н

1

9

4

9

6 9

9

0

0

5

8

1

1

9

4

9

6 9

9

0

0

РИСУНОК 1.6.

ПРИМЕР БЫСТРОГО ОБЪЕДИНЕНИЯ

(НЕ ОЧЕНЬ БЫСТРОГО ПОИСКА)

В этой таблице отображается

содержимое массива id после

обработки каждой из показанных

слева пар чисел алгоритмом

быстрого поиска (программа 1.1).

Затененные элементы — это те,

значения которых изменяются для

последующего выполнения операции

объединения (по одному на каждую

операцию). При обработке пары

р q мы следуем по указателям из р,

чтобы выйти в элемент i, для

которого id [ i ] = i; затем мы

следуем по указателям из i, чтобы

попасть в элемент j, для которого

id[ j] = j; затем, если i и j

различны, устанавливаем id [ i ] =

id [ j ]. Для выполнения операции

find для пары 5-8 (последняя

строка) i принимает значения 5 6

9 0 1, a j ~ значения 8 0 1.

Предположим, что пары вводятся в следующем

порядке: 1-2, 2-3, 3-4 и так далее. После ввода

N - 1 таких пар мы имеем N объектов, принадле¬

жащих к одному множеству, и сформированное алгоритмом быстрого объединения

дерево представляет собой прямую линию, в котором объект N указывает на

объект N- \ , тот, в свою очередь, — на объект N -2, тот — на N - 3 и так далее.

Чтобы выполнить операцию find для объекта N, программа должна отследить N -1

указателей. Таким образом, среднее количество указателей, отслеживаемых для

первых N пар, равно

(О + 1 + ... + (N— I)) / N = (N- 1) / 2

30 Часть 1. Анализ

Теперь предположим, что все остальные пары связывают объект N с каким-либо

другим объектом. Чтобы выполнить операцию find для каждой из этих пар, требует¬

ся отследить, по меньшей мере, (N— 1) указателей. Общее число инструкций для

М операций find для такой последовательности вводимых пар определенно больше

MN/ 2. ■

К счастью, можно легко внести такие изменения в этот алгоритм, которые гаран¬

тируют, что худшие случаи, подобные этому, не возникнут. Вместо того чтобы произ¬

вольным образом соединять второе дерево с первым для выполнения операции union,

можно отслеживать количество узлов в каждом дереве и всегда соединять меньшее де¬

рево с большим. Это изменение требует несколько большего объема кодов и наличия

еще одного массива для хранения счетчиков узлов, как показано в программе 1.3, но

оно приводит к существенному повышению эффективности алгоритма. Мы будем на¬

зывать этот алгоритм алгоритмом взвешенного быстрого объединения (weighted quick-union

algorithm).

Программа 1.3 Взвешенная версия быстрого бъединения

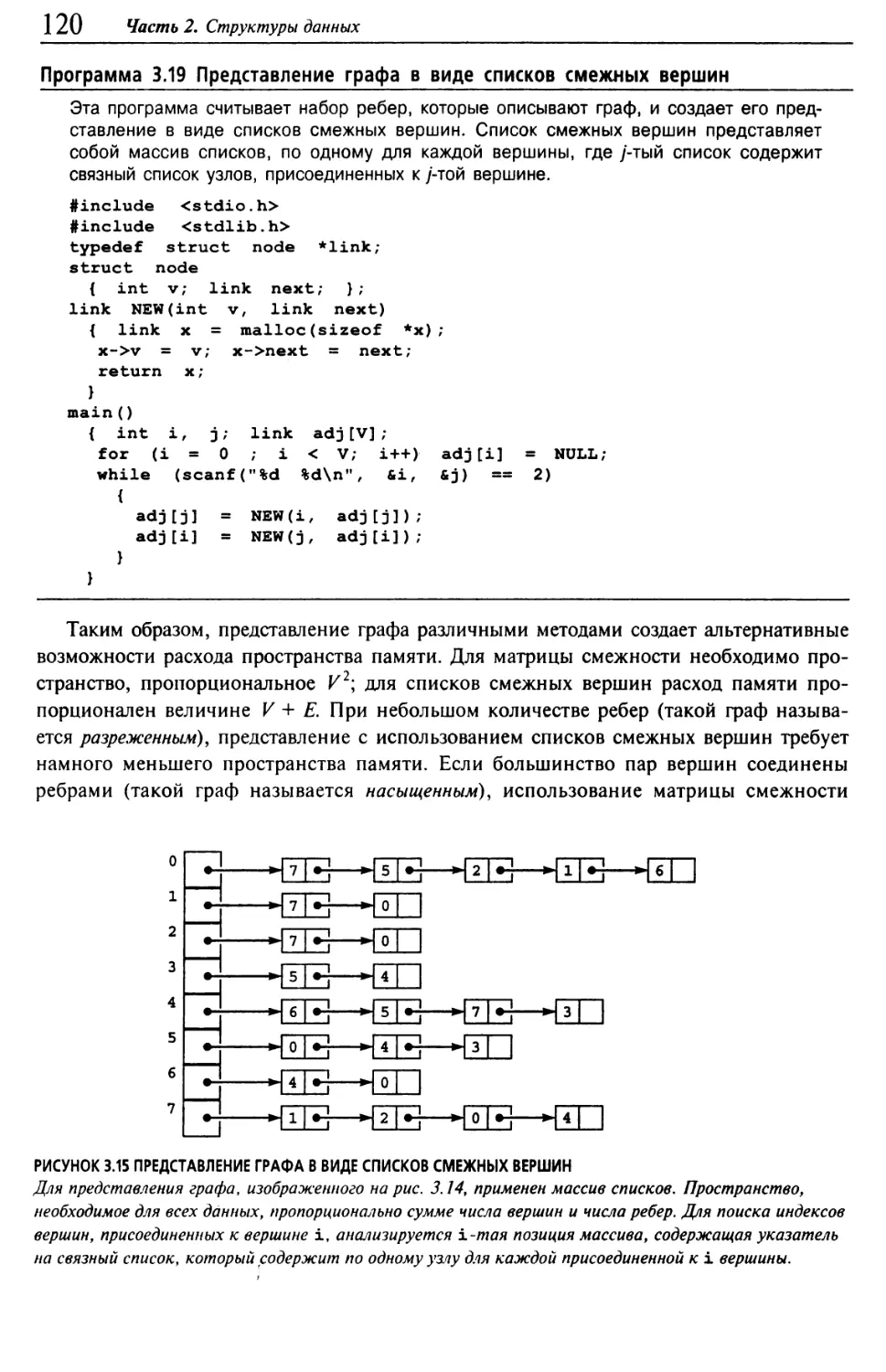

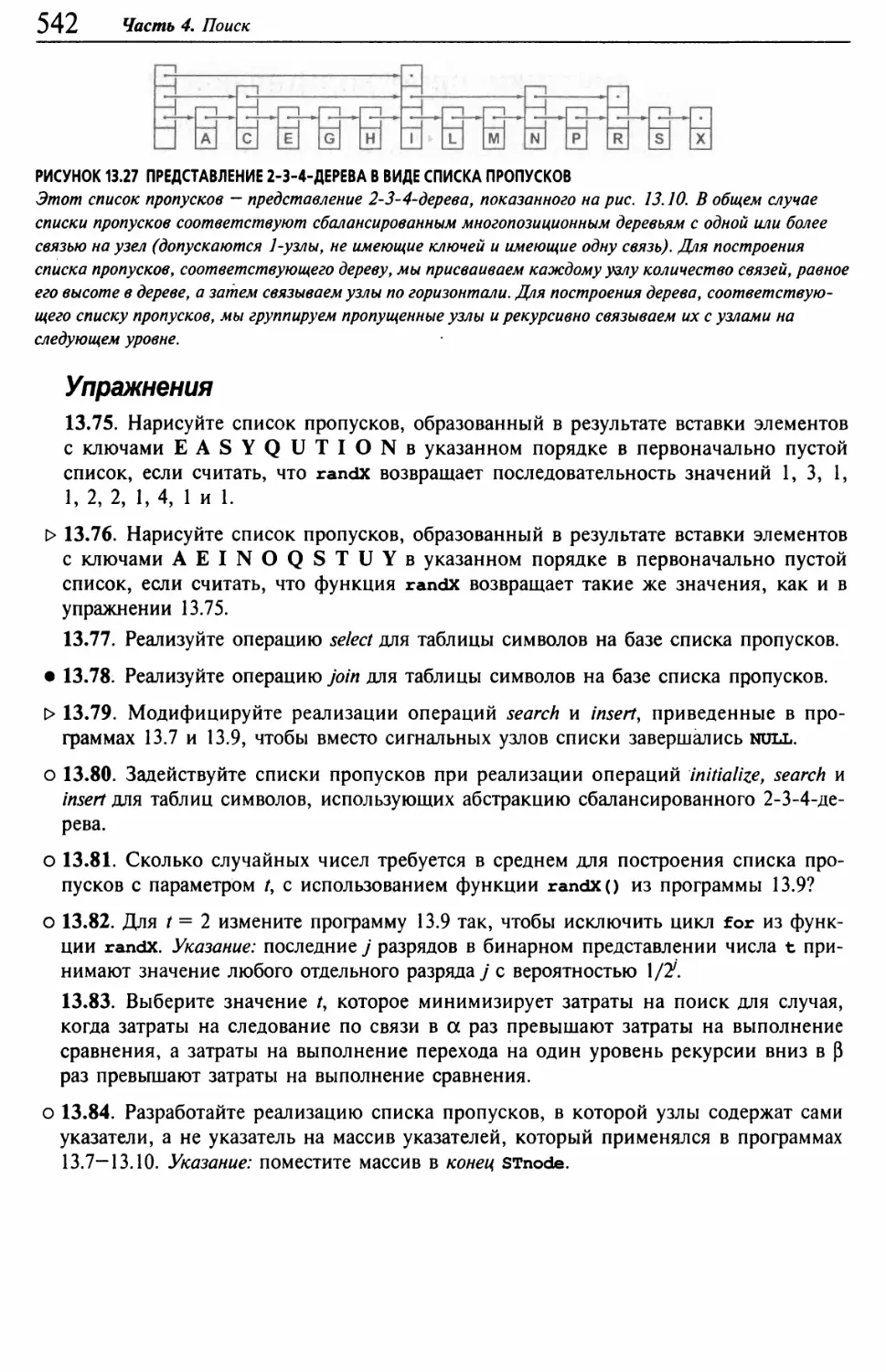

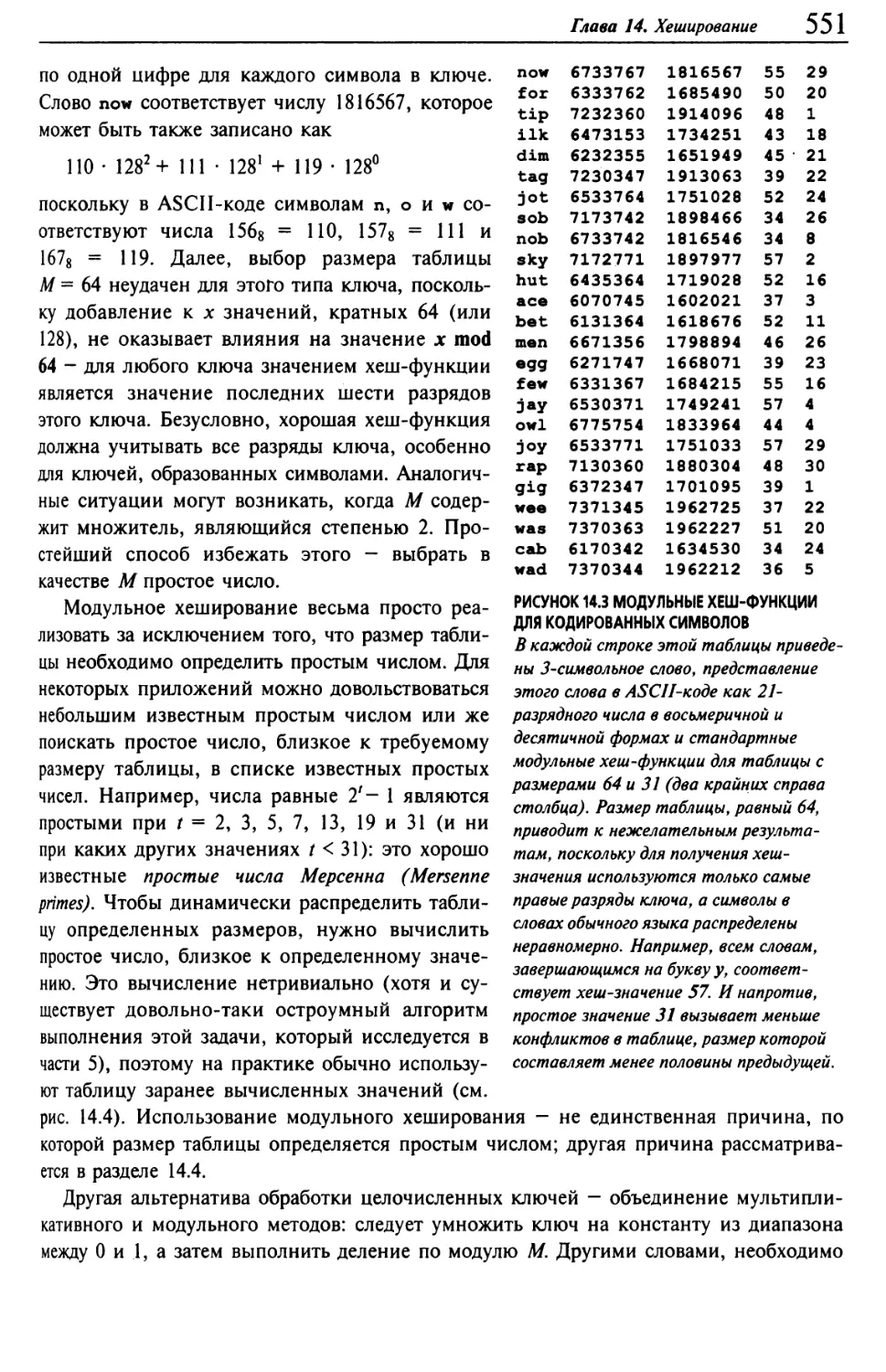

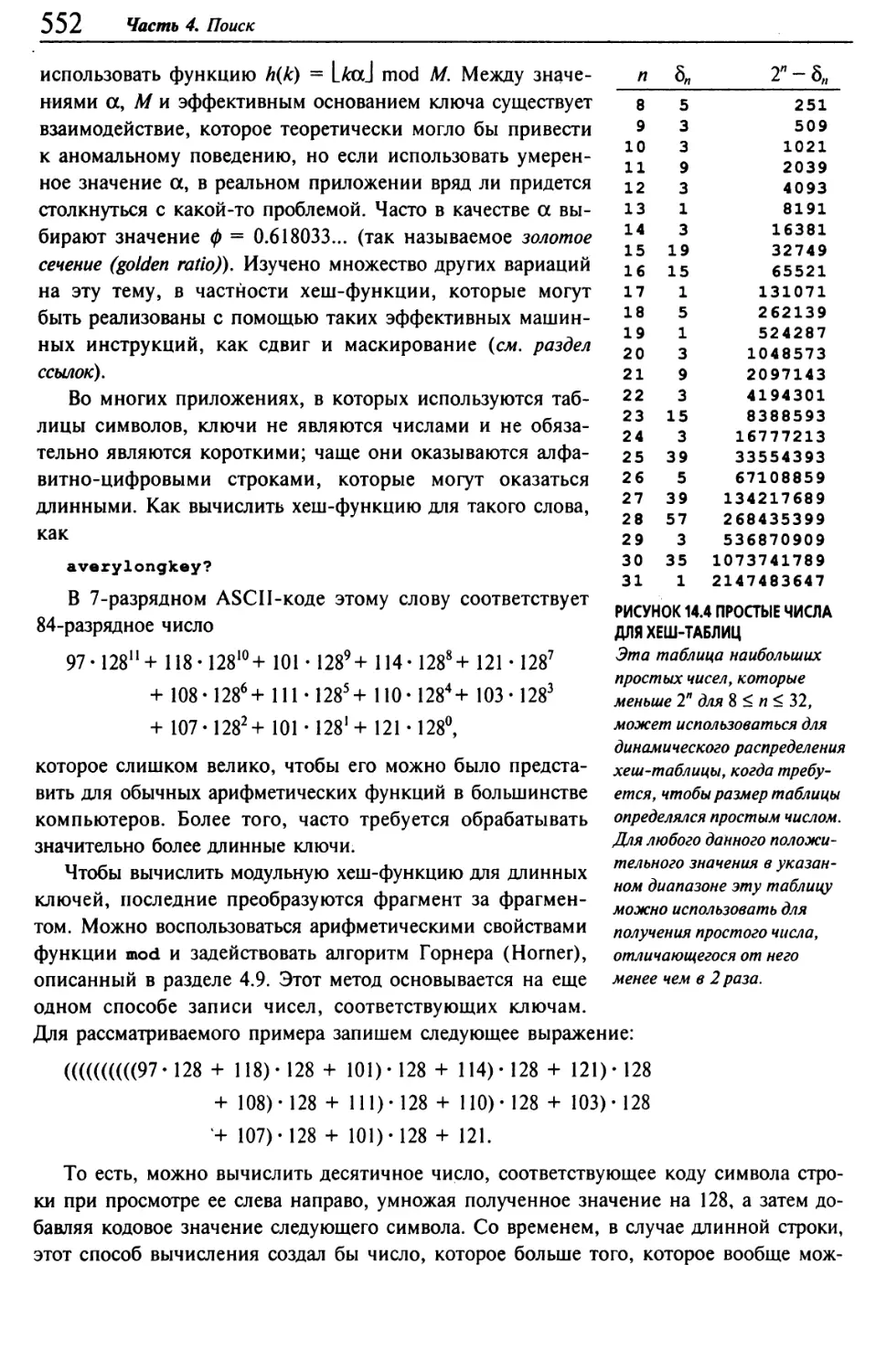

Эта программа является модификацией алгоритма быстрого объединения (см. про¬