Text

QUEUEING SYSTEMS

VOLUME 1: THEORY

Leonard Kleinrock

Professor

Computer Science Department

School of Engineering and Applied Science

University of California, Los Angeles

A Wiley-Interscience Publication

John Wiley & Sons

New York • London Sydney Toronto

Л. Клейнрок

. ТЕОРИЯ МАССОВОГО ОБСЛУЖИВАНИЯ

Перевод с английского

канд. техн, наук И. И. Грушко

Под редакцией

д-ра техн, наук В. И. Неймана

МОСКВА МАШИНОСТРОЕНИЕ • 1979

ББК 22.18

К48

УДК 519.872

Клейнрок Л.

К48 Теория массового обслуживания. Пер.

с англ./Пер. И. И. Грушко; ред. В. И. Нейман.—

М.: Машиностроение, 1979.— 432 с., ил.

В пер. 2 р. 30 к.

Книга посвящена вопросам проектирования систем массового обслуживания и повышению эффективности их работы. В ией рассмотрены теоретические вопросы анализа математических моделей систем ожидания. Материал изложен в порядке возрастающей сложности от элементарной теории до наиболее мощной теории, разрабатываемой в последнее время для систем обслуживания общего типа. Она содержит необходимый справочный материал по теории вероятностей и операционному исчислению.

Книга предназначена для научных работников, а также инженеров, занимающихся вопросами теории массового обслуживания и ее практическим применением.

ИБ 2280

Леонард Клейнрок

ТЕОРИЯ МАССОВОГО ОБСЛУЖИВАНИЯ

Редактор Т. В. Абызова

Художественный редактор С. С. Водчиц Технический редактор Т. И. Андреева Корректор И. М. Бореыша

Переплет художника Е. В. Бекетова

ББК 22.18

6Ф0.1

Сдано в набор 13.04.79. Подписано в печать 30.11.79. Формат 60Х 901/1в Бумага типографская № 1. Гарнитура литературная. Печать высокая.

Усл. печ. л. 27,0. Уч.-изд. л. 28,4.

Тираж 10 000 экз. Заказ 1358.

Цена 2 р. 30 к.

Издательство «Машиностроение», 107885, Москва, ГСП-6, 1-й Басманный пер., 3

Ленинградская типография № 6 Ленинградского производственного объединения «Техническая книга» Союзполиграфпрома при Государственном комитете СССР по делам издательств, полиграфии и книжной торговли.

193144, Ленинград, С-144, ул. Моисеенко, 10

© 1975, by John Wiley & Sons, Inc.

Published simultaneously in Canada. No part of this book may be reproduced by any means, nor transmitted, nor translated into a machine language without the written permission of the publisher.

© Перевод на русский язык, «Машиностроение», 1979 г.

Предисловие к русскому изданию

Предлагаемая книга американского профессора Л. Клейнрока посвящена одному из важных разделов прикладной математики — теории массового обслуживания. В отличие от других книг на рассматриваемую тему данная книга написана инженером для инженеров. Этим определяются ее важные достоинства как, впрочем, и некоторые недостатки.

Несомненным достоинством книги является ясное и исчерпывающее изложение важнейших результатов современной теории массового обслуживания, представляющих интерес для инженерных применений. Автор книги принимал активное участие в создании крупнейшей сети вычислительных центров (сети ARPA), и это позволило ему собрать уникальный материал. Указанный материал в основном составляет содержание второго тома книги (В русском переводе отдельная книга: Л. Клейнрок. Вычислительные системы с очередями. М., Мир, 1979 г.) Первый том, по замыслу автора, должен был содержать изложение теоретических основ, необходимых для чтения второго тома. Успешное осуществление этого замысла позволяет рассматривать первый том как самостоятельное пособие, которое может быть полезно не только специалистам по сетям ЭВМ, но и более широкому кругу читателей, применяющих методы теории массового обслуживания.

Современную теорию массового обслуживания используют во многих областях науки, техники и военного дела. Существенное место

5

среди технических применений теории массового обслуживания, наряду с техникой передачи, распределения и обработки информации, занимают вопросы организации производства в машиностроении, поэтому можно ожидать, что эта книга будет встречена с интересом также традиционными читателями издательства «Машиностроение».

Некоторым недостатком книги является проявляемое иногда автором невнимание к математической строгости, свойственное технической литературе. Редактор не стремился обнаружить все неточности такого рода и прокомментировать их; в конце концов, задача перевода состоит не в том, чтобы дополнять и поправлять автора, а в том, чтобы как можно точнее передать его мысли.

Книга написана живым языком, содержит много наглядных примеров. Достоинства книги позволяют с полным основанием рекомендовать ее советскому читателю.

Пользуюсь приятной возможностью принести благодарность профессору Л. Клейнроку, приславшему большой список опечаток, допущенных в оригинале, что позволило своевременно внести необходимые исправления в переводе.

Д-р техн, наук В. И. НЕЙМАН

Введение

Сколько времени на этой неделе Вы провели в очередях? По-видимому, нам не удается избежать частых задержек, и в этом отношении положение непрерывно ухудшается. В предлагаемой книге изучаются явления простоев, ожиданий и обслуживания, которые составляют предмет теории массового обслуживания.

/' Любую систему, в которой поток требований встречает ограниченные средства их удовлетворения, можно рассматривать как систему массового обслуживания (СМО)| В частности, если моменты поступления требований или продолжительность их обслуживания не регламенти-руются^ то при пользовании системой возникают конфликты, и образуется очередь.| Длина этой очереди зависит от двух характеристик потока требований: во-первых, она зависит от интенсивности поступления требований и, во-вторых, от статистических флуктуаций этой интенсивности. Конечно,/если интенсивность поступления требований превышает пропускную способность системы, то система не справляется с потоком этих требований, и начинает расти очередь неограниченной длины.; Однако, даже если интенсивность поступления требований меньше пропускной способности системы, очередь может образоваться из-за статистических флуктуаций и внезапного накопления требований (которое может случиться); влияние таких колебаний в большой степени увеличивается, если средняя нагрузка приближается к пропускной способности системы (но необязательно достигает ее). Простота таких СМО

7

обманчива, и при их исследованиях приходится прибегать к глубоким аналитическим выкладкам. К счастью, исследование СМО может быть выполнено на основе одного хорошо известного фундаментального закона науки. Это — закон сохранения потока, состоящий в том, что интенсивность роста числа требований в системе определяется разностью интенсивностей входящего и исходящего потоков/Этот факт позволяет сравнительно легко составить основную систему уравнений для СМО достаточно сложной структуры.

Целью настоящей книги является изложение теории массового обслуживания для аспирантов первого года обучения. Предполагается, что читатель знаком с начальным курсом теории вероятностей; однако в приложении II дан краткий обзор основных результатов теории вероятностей, необходимых в дальнейшем. Полезно также (но не необходимо) знакомство читателя с операторным методом, хотя и для этого случая в приложении I приведена достаточно полная сводка результатов. Читателю рекомендуется прочитать оба приложения, прежде чем переходить к основному тексту. Хотя язык книги — это язык математики, мы старались по возможности дать неформальное изложение материала, чтобы установить равновесие между обычно применяемыми в таких исследованиях абстракциями и необходимым для практического использования пониманием. Мы надеемся, что выбранный средний уровень изложения достаточен для того, чтобы не шокировать математиков и не поставить в тупик практиков. В ряде случаев мы отказались от строгих доказательств единственности, существования и сходимости, чтобы не затемнять основное изложение. В такие моменты читатель отсылается к другим книгам. Мы отказались от скучного подхода «теорема — доказательство» и предпочли провести читателя через естественную последовательность рас-суждений, чтобы вместе «открыть» результат.

Читателю может показаться, что принятое изложение материала либо слишком элементарно и ограничено, либо далеко от точного и изящного; такой читатель пренебрегает интересами практики. Мы полагаем, что книга, 8

подобная предлагаемой, в которой стираются внутренние препятствия, является полезной и необходимой. Эта книга написана в течение пятилетнего периода, во время которого она была использована для чтения годового (позже, двухчетвертного) курса лекций по теории массового обслуживания в Калифорнийском Университете в Лос-Анджелесе. Материал был разработан в Отделении вычислительной техники факультета инженерных и прикладных наук и прошел успешную проверку в наиболее критической и бескомпромиссной аудитории, а именно у аспирантов. Книга пригодна не только для отделения вычислительной техники, но и для других технических отделений, отделений исследования операций, математики и многих других, специализирующихся в области естественных наук, народного хозяйства, управления и планирования.

Для изложения содержания книги необходимо сначала привести описание очень удобных сокращенных обозначений, принятых в теории массового обслуживания. В их основе лежит трехбуквенное обозначение вида А/В/ш, где А и В описывают соответственно распределение промежутков времени между последовательными требованиями и распределение времени их обслуживания, ат — число обслуживающих приборов. А и В принимают значения из следующего набора символов, интерпретация которых дается распределениями, указанными в круглых скобках: М (показательное), Ег (распределение Эрланга порядка г), Н/? (гиперпоказательное порядка R), D (детерминированное), G (распределение общего вида). Иногда приходится указывать также емкость накопителя системы (которую обозначим через К) или число источников нагрузки (которое обозначим через М); в этом случае будет использоваться пятибуквенное обозначение: А/В/т/К/М. В случае отсутствия одного из Двух последних индексов предполагается, что его значение сколь угодно велико. Так, например, запись вида D/M/2/20 означает систему с двумя обслуживающими приборами, прстоянным (детерминированным) временем между двумя последовательно поступающими требованиями, показательным распределением

9

времени обслуживания и накопителем емкостью 20 требований.

Данная книга является первым томом двухтомной серии, в которой второй том 1 посвящен применениям этой теории к вычислительным системам. Первый том (состоящий из четырех частей) начинается гл. 1, представляющей собой введение в теорию массового обслуживания: в ней устанавливается место СМО в общей схеме потоков в сетях и обсуждаются методы расчета характеристик СМО. Читатель, знакомый с материалом приложений I и II (или прочитавший эти приложения), может перейти к изучению гл. 2, причем здесь необходима некоторая осторожность. Очень важным и простым является1 параграф 2.1. Однако параграфы 2.2—2.4 могут оказаться довольно трудными для читателя, впервые знакомящегося с теорией массового обслуживания; такому читателю целесообразнее пропустить эти разделы и перейти непосредственно к параграфу 2.5, в котором определяется фундаментальный процесс размножения и гибели и впервые применяются метод производящих функций и преобразование Лапласа. После изложения в первой части этих предварительных сведений переходим во второй части к элементарной теории массового обслуживания. Гл. 3 начинается с вывода общего решения для процесса размножения и гибели в установившемся режиме, и большая ее часть посвящена рассмотрению простых, но важных примеров. В гл. 4 эти результаты обобщаются, и рассматривается метод этапов, а затем дается введение в теории марковских сетей массового обслуживания.

Если вычисления, проводимые во второй части, удается свести к алгебраическим уравнениям и теории операторных преобразований, то в третьей части приходится опять вернуться к теоретико-вероятностным методам. Рассмотрение промежуточной теории массового обслуживания начинается в гл. 5 с важнейшего примера СМО типа M/G/1, затем исследуется двойственная ей система G/M/1 и ее естествен-ное обобщение — система G/M/m (гл. 6). В гл. 7

1 См. Клейнрок Л. Вычислительные системы с очере» дями. Пер. с англ. М-, Мир, 1979 г. — Прим. пер.

19

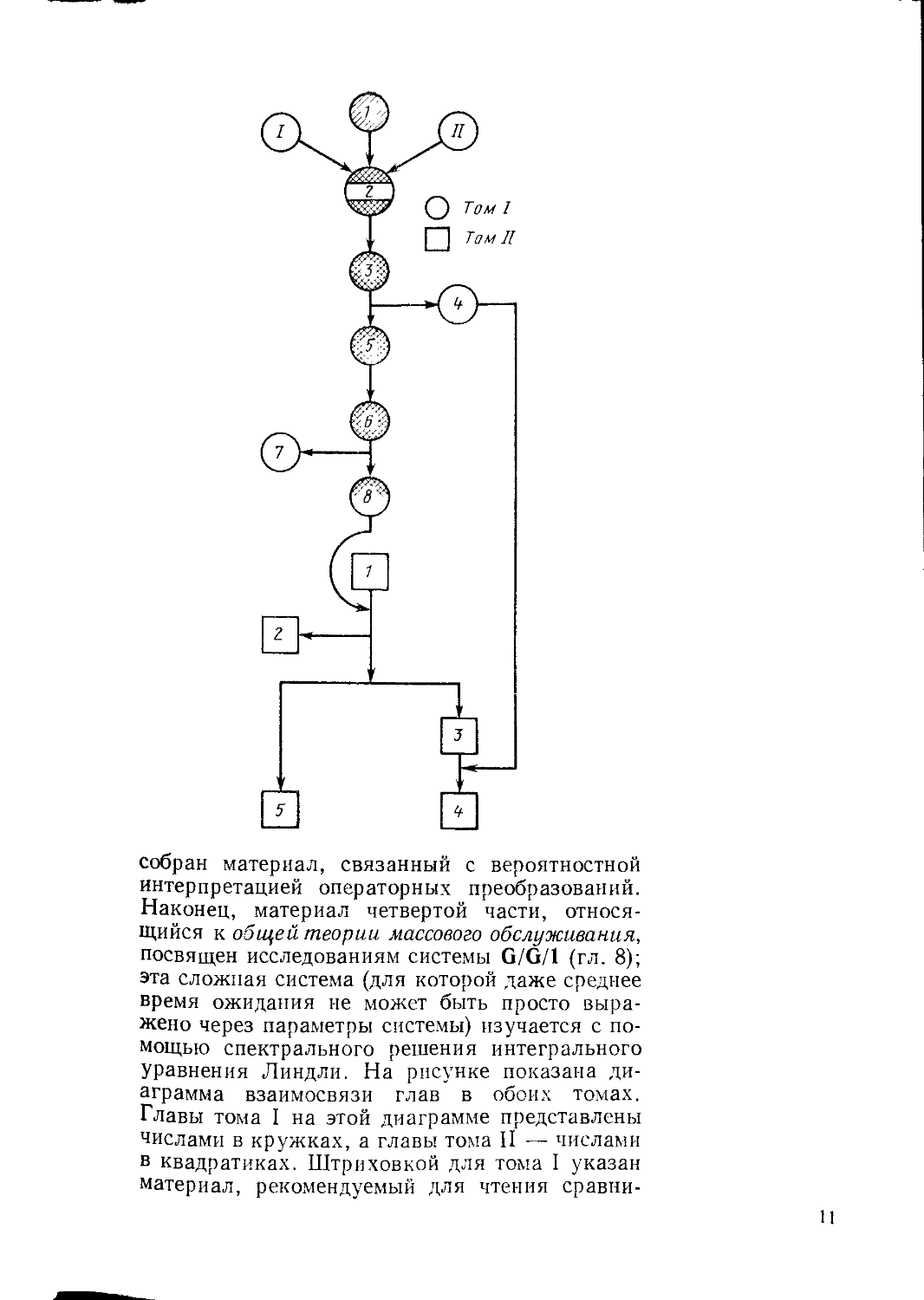

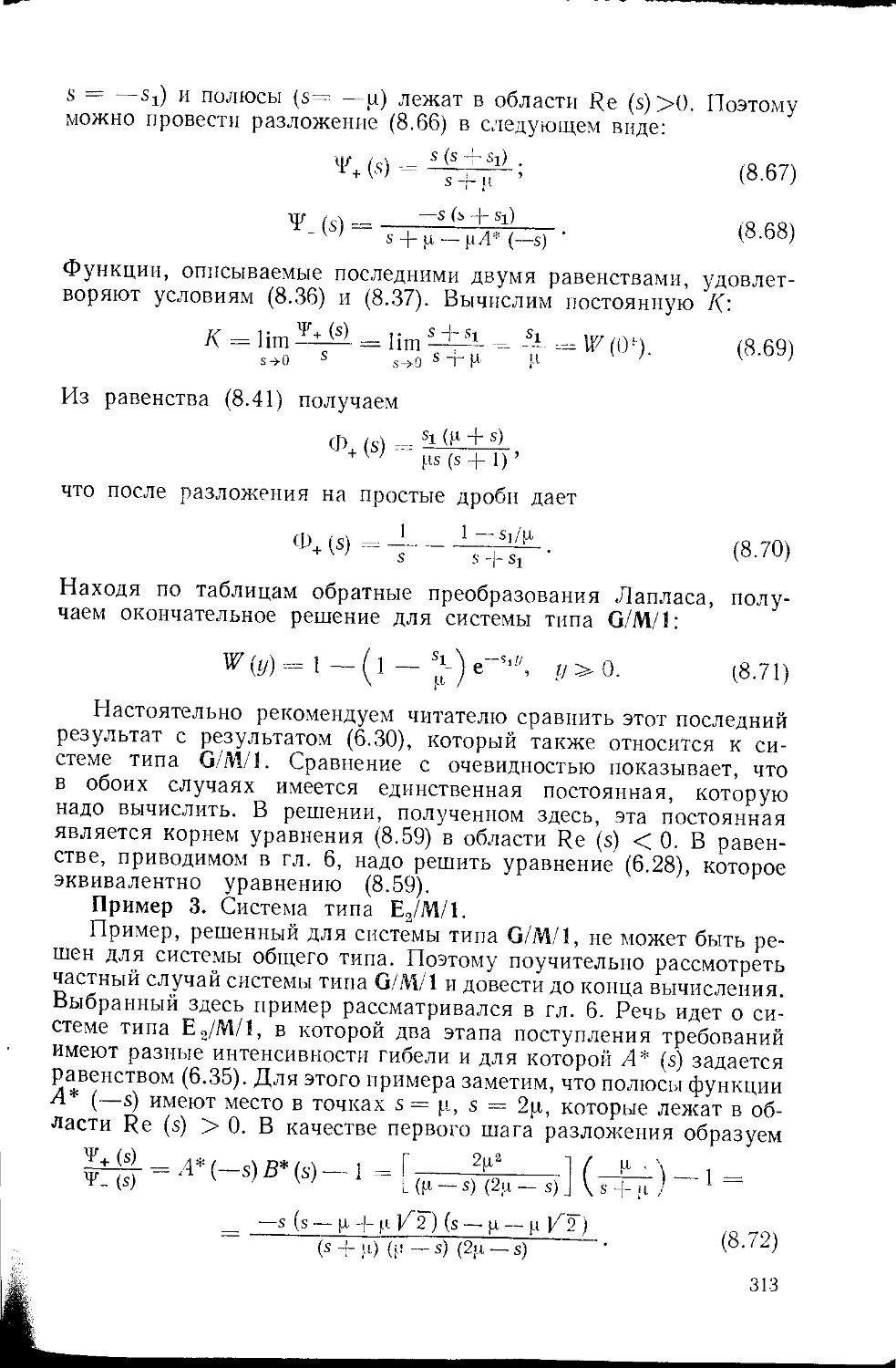

собран материал, связанный с вероятностной интерпретацией операторных преобразований. Наконец, материал четвертой части, относящийся к общей теории массового обслуживания, посвящен исследованиям системы G/G/1 (гл. 8); эта сложная система (для которой даже среднее время ожидания не может быть просто выражено через параметры системы) изучается с помощью спектрального решения интегрального уравнения Линдли. На рисунке показана диаграмма взаимосвязи глав в обоих томах. Главы тома I на этой диаграмме представлены числами в кружках, а главы тома II — числами в квадратиках. Штриховкой для тома I указан материал, рекомендуемый для чтения сравни

11

тельно ненапряженного начального курса по теории массового обслуживания, рассчитанного на один семестр. Штриховка в гл. 2 указывает, что параграфы 2.2—2.4 могут быть при первом чтении опущены; это же относится к параграфам 8.3 и 8.4. Более насыщенный односеместровый курс может включать весь материал первого тома. Том I завершается обзором важнейших результатов, полученных в книге, которые сгруппированы по классам рассматриваемых систем; этот список результатов может быть использован читателем как справочник. Каждый результат сопровождается указанием страницы, на которой он появляется впервые; это упрощает задачу поиска материала.

Каждая 1лава содержит свой список литературы, составленный в алфавитном порядке по авторам и по годам. Все важнейшие формулы отмечены символом ж, и все они включены в итоговый список важнейших формул. Каждая глава содержит также задачи, которые в ряде случаев расширяют материал главы; читателю рекомендуется решить их.

Том II содержит материал, рекомендуемый для второго курса теории массового обслуживания, рассчитан на применение к вычислительным системам. В нем гл. 1 представляет собой обзор основных результатов теории, изложенной в томе I. В гл. 2 изучаются границы, неравенства и приближения, описывающие важнейшие характеристики СМО, включая переходные и нестационарные характеристики; это достигается за счет отказа от попыток получения точных результатов, и при этом удается значительно глубже проникнуть в сущность решения реальных задач. В гл. 3 закладываются основы теории систем с разделением времени, базирующиеся на основных понятиях о СМО с приоритетами. В гл. 4 изучается класс систем, описываемых как СМО с абсолютными приоритетами, но которые больше известны как вычислительные системы с разделением времени. Рассматриваются модели как с одним средством обслуживания, так и со многими средствами, вытекающие непосредственно из результатов гл. 4 тома I. В этой главе также предпринимается попытка использовать диффузионное прибли-12

Жение, развитое в гл. 2. Наконец, в гл. 5 определяется и исследуется очень важный класс сетей связи электронных вычислительных машин, для изучения которых используются вся изложенная теория и еще некоторые дополнительные результаты \ Предлагаемая серия из двух томов начинается с изложения теории массового обслуживания, которая представляет большой интерес и сама по себе. Однако главной целью, подкрепленной личными интересами автора, является применение этой теории к реально существующим системам, в данном случае главным образом к вычислительным системам .

Выбор материала, помещенного в томе I (и особенно в томе II), отражает личные вкусы автора и его интересы в данной области. Например, я предпочел не включать длинные обсуждения методов моделирования или методов численного анализа СМО. Эти вопросы очень важны для исследования реальных СМО, однако они мало подходят в качестве материала для включения в текст учебника; вкратце их возможные применения обсуждаются, но на них не акцентируется внимание.

Может быть, имеет смысл посвятить несколько слов истории и развитию теории массового обслуживания. Нет ничего удивительного в том, что теория массового обслуживания возникла в телефонии в первые два десятилетия нашего столетия благодаря работам А. К. Эрланга, заложившего основы теории намного раньше того времени, когда стала популяризироваться и даже развиваться теория вероятностей. Этот замечательный человек установил многие принципиальные результаты, которые используют в настоящее время. Двадцатые годы нашего столетия были временем плодотворного применения его результатов; это продолжалось вплоть до середины 30-х годов, когда Феллер ввел понятие процесса размножения и гибели 1 2,

1 Фактически автор, вопреки этому обещанию, рассматривает сети связи ЭВМ в двух главах тома II — пятой и шестой. — Прим. ред.

2 В этот же период фундаментальные результаты теории массового обслуживания были опубликованы советскими математиками А. Н. Колмогоровым и А. Я. Хин-чиным. — Прим. ред.

13

н теория массового обслуживания привлекла внимание математиков как объект серьезного исследования. Во время второй мировой войны и в последующие годы эта теория играла важнейшую роль в развитии новой области — исследование операций, — которая казалась весьма многообещающей в первые послевоенные годы. Но из-за сложности реальных систем интерес к теории исследования операций стал уменьшаться, однако математики сразу оценили преимущества теории массового обслуживания. Передовые исследователи продвинулись достаточно далеко в этой сложной и глубокой области математики. Однако вскоре выяснилось, что реально интересующие практику модели не могут быть решены, и поток работ в этой области существенно уменьшился. И только с развитием вычислительной техники работы по теории массового обслуживания опять начали бурно развиваться применительно к широкому классу практических задач, но теперь уже со значительным успехом. В частности, это справедливо и для применений методов теории массового обслуживания к анализу характеристик вычислительных систем, чем и объясняется популярность этой теории среди современных инженеров и ученых. Многие актуальные проблемы формулируются в терминах теории массового обслуживания, и многие методы решения, развиваемые в рамках этой теории, оказываются вполне пригодными для их использования. Более того, применение вычислительных машин для решения уравнений теории массового обслуживания вызвало новый интерес к этой области. Можно надеяться, что предлагаемая книга поможет читателю выработать современное понимание возможностей применения методов теории.

Пользуюсь приятной возможностью завершить введение благодарностями тем лицам и институтам, которые сделали возможным появление этой книги. Прежде всего я хочу выразить благодарность всем тем, кто принимал участие в создании стимулирующей среды в Отделении вычислительной техники Калифорнийского Университета в Лос-Анджелесе, которая ободряла и поощряла мои усилия 14

в этом направлении. Благодарю Агентство перспективных научных исследований Министерства обороны США, которое предоставило мне возможность участвовать в некоторых наиболее перспективных проектах вычислительных систем и сетей, когда-либо разрабатывавшихся. Фонд Джона Симона Гугенхейма предоставил мне в 1971—1972 академическом году стипендию, что обеспечило возможность проведения дальнейшей исследовательской работы в этот период. Сотни аспирантов, прослушавших мой курс по теории массового обслуживания, внесли свой положительный и критический вклад, и я счастлив выразить свою признательность за оказанную мне помощь Арне Нильссону, Джони Вону, Саймону Лэму, Фуаду Тобаги, Фаруку Камуну, Роберту Райсу и Томасу 5 Сайксу. Мои академические и профессиональные коллеги оказывали мне всяческую поддержку в этом начинании. Я признателен всем машинисткам. Большую часть работы выполнила Шарлотта Лярош, и я всегда буду у нее в долгу. Диане Скосайпек и Синтии Эллман я приношу свою глубокую благодарность за быстрое, инициативное и доброжелательное выполнение трудной задачи чтения верстки и исправления опечаток. Кроме того, большой вклад внесли Барбара Уоррен, Джейн Дубинская, Джейн Фуччи и Глория Рой. Я во многом обязан моей семье (и особенно моей жене Стелле), которая оказала мне значительно большую поддержку, чем предусмотрено долгом и брачным контрактом. Наконец, я был бы воистину нерадивым, если бы не поблагодарил мой безотказный диктофон, который все время беседовал со мной.

Март 1974, ЛЕОНАРД КЛЕЙНРОК

ЧАСТЬ I

ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

За деревьями трудно увидеть лес (особенно если деревья разбросаны, а не стоят в каком-либо порядке). Аналогичные трудности часто возникают при встрече с набором математических результатов, которыми мы пытаемся овладеть; успех возможен только после того, как будет понята и оценена применимость этих результатов к реально существующим задачам, когда с уверенностью можно сказать, что стала ясной полезность рассматриваемых математических методов.

Две главы, содержащие предварительные сведения, совершенно противоположны по своему характеру. В гл. 1 показаны глобальная картина возникновения систем массового обслуживания и их значение. Здесь для наглядности приведены развлекательные примеры. В гл. 2, посвященной случайным процессам, делается решительный шаг в сторону математических определений (и при этом быстро теряется перспектива). Однако мы призываем читателя не сдаваться перед этой трудностью, так как, возможно, это будет наиболее сложным местом, с которым читатель встретится в данной книге. В частности, гл. 2 начинается с изложения одного полезного графического способа описания динамики потока требований в системах массового обслуживания. Затем вводится понятие вероятностных процессов, которые возникают при исследовании поступления требований, их характеристик и накопления в СМО самого общего вида. Затем читатель подводится с помощью очень простой аргумен-|0

тации к одному из важнейших результатов теории массового обслуживания — результату Литтла. После такого введения в теорию вероятностных процессов предпринимается попытка очень компактного сравнения многих хорошо известных (но не столь хорошо различаемых) процессов в общепринятой терминологии и обозначениях, что приводит в итоге к рис. 2.4, показывающему взаимосвязь между этими процессами; читателю сразу становится ясной центральная роль, которую играет пуассоновский процесс, так как он находится на пересечении всех рассматриваемых в этой главе вероятностных процессов. Затем вводится понятие марковских цепей с дискретным и непрерывным временем; эти параграфы, возможно, представят наибольшую трудность для начинающего, и при первом чтении вполне допустимо этот материал пропустить. В конце параграфа 2.4 мы встречаемся с важными процессами размножения и гибели, и здесь опять приходится вернуться к физическим системам. Фактически читатель мог бы начать изучение с параграфа 2.5, так как рассматриваемый здесь материал почти не связан с остальной частью текста. Только изредка возникает необходимость в более подробном материале из параграфов 2.3 и 2.4. Если читатель осилит материал гл. 2, он будет в состоянии овладеть всем материалом книги.

ГЛАВА 1

Системы массового обслуживания

Занятным предметом этой книги является один из самых безрадостных аспектов нашей жизни, а именно, ожидание в очередях. Резонно спросить: «Какая польза от изучения такого неприятного явления?» Ответ, конечно, состоит в том, что через понимание приходит сочувствие, а именно оно и необходимо, так как с развитием цивилизации люди все больше и больше времени проводят в очередях, и необходимо найти пути преодоления этих неприятностей. Представим себе на минуту, сколько Времени мы проводим ежедневно в очереди того или иного типа:

17

ожидание завтрака; ожидание у светофора; замедление на. улицах и автострадах; задержка при въезде на стоянку автомобиля; очередь у лифта; очередь за утренним кофе; занятость телефона и т. д. Этот список бесконечен так же, как часто бесконечными оказываются и сами очереди.

Упорядоченность очередей в разных странах мира различна. Например, англичане весьма склонны к формированию упорядоченных очередей, в то время как некоторые жители Средиземноморья находят это нелепым (приходилось ли Вам когда-нибудь наблюдать процесс швартования судов в порту Бриндизи?). В армии Соединенных Штатов распространен девиз: «Торопись и жди!» Такова природа явления, которое мы намерены исследовать.

1.1. СИСТЕМЫ ПОТОКОВ

Системы массового обслуживания (СМО) являются примером более широкого класса интересных динамических систем, которые назовем для удобства системами потоков. Система потоков — это система, в которой некоторые предметы текут, движутся или транспортируются по одному или нескольким каналам ограниченной пропускной способности с целью перемещения из одной точки в другую^ Рассмотрим, например, поток автомобильного транспорта по сети автодорог, перевозку грузов по железнодорожной системе, поток воды через плотину, передачу телефонных или телеграфных сообщений, прохождение покупателей через кассу универсама или поток программ в вычислительной системе с разделением времени. В этих примерах предметами являются соответственно автомобили, грузы, вода, телефонные или телеграфные сообщения, покупатели и программы; каналом или каналами являются соответственно сеть автомобильных дорог, железнодорожная сеть, плотина, телефонная или телеграфная сеть, касса универсама, вычислительная система. Ограниченная пропускная способность означает, что канал может удовлетворять требования (предъявляемые к нему предметами) только с конечной скоростью. Очевидно, что анализ таких систем требует специальных аналитических методов, развитых в различных дисциплинах, и, как мы увидим, одной из таких дисциплин является теория массового обслуживания.

(При анализе систем потоков их естественно разбить на два класса: регулярные и нерегулярные потоки. К первому классу относят системы, в которых потоки ведут себя предсказуемым образом. Это значит, что величина потока точно известна и является постоянной на всем интересующем нас интервале; время появления потока в канале и число требований, которые поступают в канал, известны и постоянны. В случае одного канала анализ таких систем тривиален J Например, рассмотрим фабрику по переработке ананасов, на которой пустые жестяные банки транспортируются по 18

Кадавра

Рис. 1.1. Задача о максимальном потоке

конвейерной ленте в пункт, где их заполняют ломтиками ананасов, а затем должны следовать дальше по этой же ленте для последующих операций. Предположим, что при этом жестяные банки поступают с постоянной скоростью по одной банке в секунду и что операция по заполнению одной банки ананасами занимает девять десятых секунды. Это число постоянно тля всех банок и операций по наполнению. Ясно, что такая система будет работать бесперебойно и равномерно, пока будут выполняться указанные выше условия. Можно сказать, что интенсивность R поступления требований в систему равна одной банке в секунду и что максимальная скорость обслуживания (или пропускная способность) С -= 1/0,9 =- 1,1111 .. операций наполнения в секунду. В рассмотренном примере выполняется условие R <Z С. Но известно, что произойдет, если это условие нарушится, т. е. будет R /> С: либо банки, либо ломтики ананасов начнут накапливаться и наводнят всю фабрику! Таким образом, если не допускаются хаотические скопления, то пропускная способность системы должна быть больше, чем интенсивность потока требований. Это справедливо для всех систем потоков. Приведенное простое замечание является почти исчерпывающим для детерминированных потоков с одним каналом. Такие системы не представляют серьезного теоретического интереса.

Более интересным представляется случай регулярного потока, распространяющегося по сети каналов. Для стабильного потока условие R </ С является очевидным требованием для каждого канала. Но здесь возникает серьезная комбинаторная задача. Например, рассмотрим железнодорожную сеть некоторой мифической страны Гатафла, показанную на рис. 1.1. Сценарий сводится к тому, что по этой железнодорожной сети должны перевозить фиги, выращенные в городе Абра, в пункт назначения — город Дадабра. Числа, приписанные на рис. 1.1 каждому каналу (каждой железнодорожной ветке), обозначают максимальное число бушелей фиг, которое может быть пропущено по этому каналу за один день. Теперь мы приходим к следующей задаче о потоке фиг: чему равно максимальное число бушелей фиг, которое может ежедневно направляться из Абры и Кадабру, и каким образом Должен следовать этот поток? Ответ на этот вопрос о максимальной

19

нагрузке потоков в различных сетях хорошо известен в теории потоков в сетях и называется теоремой о максимальном потоке через минимальное сечение. Чтобы сформулировать эту теорему, определим сначала сечение как множество каналов, удаление которых из сети приводит к разрыву всех возможных путей (потоков) от пункта отправления (Абра) в пункт назначения (Кадабра). Пропускную способность такого сечения определим как общий поток фиг, который может пройти через сечение от пункта отправления к пункту назначения. Примером одного такого разреза является набор ветвей из Абры в Зевс, Саксамада в Зевс и Сакса-мада в Ориак; пропускная способность этого разреза равна, очевидно, 23 бушелям фиг в день. Теорема о максимальном потоке через минимальное сечение утверждает, что максимальный поток, который может быть пропущен от начальной точки к конечной, равен минимальной пропускной способности по всем сечениям. В нашем примере можно видеть, что максимальный поток равен 21 бушелю фиг в день (читателю предлагается проверить это). В общем случае надо просмотреть все сечения, разделяющие заданную начальную и конечную точки. Такое вычисление может потребовать огромного времени. К счастью, существует мощный метод, позволяющий определить не только величину максимального потока, но и набор путей, на котором достигается этот максимальный поток. Этот метод известен под названием алгоритма маркировки (он предложен Фордом и Фалкерсоном [1 ]) и является эффективным в том смысле, что объем вычислений растет как небольшая степень от числа узлов; описание этого алгоритма приводится в гл. 5 тома II.

Кроме задачи о максимальном потоке, можно сформулировать многие другие интересные и имеющие смысл задачи о потоках в таких сетях. Например, назначая цену каждому каналу, можно поставить задачу о построении сети минимальной стоимости, обеспечивающей данный поток. Такие же задачи можно ставить и о сетях, в которых имеется не только одна начальная и конечная точка. Усложняя задачу еще больше, можно потребовать, чтобы данная сеть обеспечивала потоки различных типов, например бушелей фиг, ящиков с патронами и бочек с нефтью. Задача о комбинированных (или многопредметных) перевозках является чрезвычайно сложной, и, как правило, для ее решения приходится выполнять вычисления очень большого объема. Эти и многие другие замечательные задачи теории потоков в сетях можно найти в исчерпывающей книге Франка и Фриша [2]; мы встретимся с ними опять в гл. 5 тома II. Теория потоков в сетях использует методы теории графов, комбинаторной математики, теории функций, математического и эвристического программирования.

Вторым классом, который можно выделить в системах потоков, является класс случайных, или вероятностных, потоков. Под этим подразумевается, что время поступления требования на обслуживание (на занятие канала) не определено или непредска-20

зуемо, п что непредсказуемо также число требований, поступающих в систему. Случайность, непредсказуемость и нерегулярность природы таких потоков приводит к существенным трудностям при понимании н решении возникающих здесь задач. Более того, очевидно, что большинство реально возникающих потоков относится именно к этому классу. Простейшим также является случай одного канала (или однолинейной системы); однако если обсуждавшийся выше случай детерминированного или регулярного потока, поступающего в однолинейную систему, был тривиален, то возникающая теперь однолинейная задача имеет определенные трудности, и для ее решения приходится применять многие результаты современной теории массового обслуживания.

Например, рассмотрим вычислительный центр, в котором требования на вычисления обслуживаются группами. Требования на вычисления поступают в систему в непредсказуемые моменты времени, п в момент их поступления вычислительное устройство может быть загружено обслуживанием других требований. Если вычислительное устройство свободно, то, как правило, оно сразу начинает обслуживать вновь поступившее требование, которое пребывает в системе до тех пор, пока его обслуживание не будет полностью завершено. Если же в момент поступления нового требования система загружена, то это требование будет ожидать в очереди до тех пор, пока оно не будет выбрано для обслуживания среди остальных ожидающих требований. До тех пор, пока данное требование не будет выбрано для обслуживания, ни вычислительный центр, ни программист не знают точно, сколько усилий уйдет на обслуживание этого требования в системе; в этом смысле обслуживание требования, действительно, непредсказуемо.

Возникает несколько естественных вопросов, на которые хотелось бы получить разумные и полные ответы. Каково, например, ожидаемое время, которое придется провести требованию в очереди на обслуживание? Сколько требований будет обслужено перед данным? В какое время суток вычислительный центр будет загружен? Каков ожидаемый промежуток времени непрерывной загрузки центра? Эти вопросы требуют ответов в виде вероятностей определенных периодов времени или числа требований, или просто в виде средних значений этих величин. Дополнительные соображения, такие как поломка машины (нередко встречающееся условие), вносят дальнейшие усложнения вопроса; ясно, что в этом случае некоторое приоритетное событие задерживает завершение обслуживания требования. Другие интересные явления могут иметь место, когда требования обслуживаются не в порядке их поступления. Например, в вычислительных системах с разделением времени используются весьма сложные алгоритмы распределения и обслуживания, которые рассматриваются в гл. 4 тома II.

Методы исследования задач с однолинейной системой и случайным потоком являются составной частью теории массового 21

обслуживания, и большая часть материала данной книги посвящена этим методам. При этом предполагается знакомство читателя с основами теории вероятностей, а также с комплексными переменными и некоторыми обычными методами операционного исчисления; обзор этого материала приведен в приложениях I и II.

Как и в случае детерминированного потока, можно сосредоточить внимание на задачах, связанных с сетями каналов, по которым циркулируют случайные потоки. .Примером подобной сети может служить вычислительная сеть. Такая система состоит из ЭВМ, связанны:-; между собой линиями связи, причем пропускная способность каждой линии конечна. Вернемся к фантастической стране Гатафла и предположим, что рассмотренная выше железнодорожная сеть теперь представляет собой вычислительную сеть. Предположим, что клиенты, находящиеся в городе Абра, хотят воспользоваться вычислительным устройством, расположенным в городе Кадабра. Конкретные моменты времен:; возникновения этих требований непредсказуемы, так же как непредсказуемы продолжительности управляющих сигналов или команд, описывающих эти требования. Эти команды должны быть переданы в Кадабру по сети связи как сообщения. Передача сообщения по некоторому пути на сети связи осуществляется после ввода сообщения в сеть в пункте Абра и выбора соответствующего решающего правила (называемого процедурой выбора маршрута). Если часть выбранного пути оказалась занятой, а это возможно, то сообщение должно встать в очередь перед занятым каналом и ждать до тех пор, пока он освободится. Постоянные решения должны приниматься с учетом потока сообщений и процедуры выбора маршрута. Можно надеяться, что сообщение со временем достигнет Кадабры, необходимые вычисления будут выполнены, а результаты опять будут введены в сеть связи для передачи обратно в Абру.

Очевидно, что в описанном примере вычислительной сети возникает много сложных задач теории массового обслуживания, а также теории потоков в сетях и решений. Некоторые из этих вопросов уже были рассмотрены автором раньше [3]. Анализ этих систем откладывается до гл. 5 тома II

Можно надеяться, что введенное понятие1 системы потоков дает читателю представление о том, какое место в общей схеме занимает теория массового обслуживания. Центральными методами этой теории являются методы анализа вероятностных пото-

£ Принятая классификация относит СМО к классу систем потоков. Этот подход подчеркивает применение теории массового обслуживания. Другим подходом было бы отнесение теории массового обслуживания к прикладной теории вероятностных процессов; такой подход подчеркивал бы математический характер теории, а не ее применения! В данном двухтомнике принята первая точка зрения, а именно точка зрения, сйТГТанная с применением теории массового обслуживания как главной задачи, а не с развитием формальных математических результатов. 22

ков. Просмотр периодической литературы ясно показывает бурное развитие и жизнеспособность этой теории и, в частности, расширение важных областей ее применения.

1.2. ХАРАКТЕРИСТИКИ СИСТЕМ МАССОВОГО

ОБСЛУЖИВАНИЯ С ОЖИДАНИЕМ

Для полного описания системы массового обслуживания с ожиданием надо указать вероятностные процессы, описывающие входящий поток требований, структуру обслуживающего прибора и дисциплину обслуживания. В общем случае входящий поток требований описывается распределением вероятностей промежутков времени между соседними требованиями, которое обозначается1

A (f) ----- Р [время между последовательными требованиями * (1.1)

В большей части теории v:;|'<-n"nrn пбгтчкгпяпчя Ч'ШДПО-’ЧГЯОТСЩ что промежутки времени между последовательными требованиями являются независимыми, одинаково распределенными случайными величинами (и, следовательно, входящий поток требований образует стационарный процесс восстановления; см. гл. 2). Таким образом, как правило, существенным описанием потока является только функция распределения A (t). Второй статистической величиной, которую надо описать, является время, в течение которого требование пребывает в канале; эта величина обычно называется временем обслуживания, а ее распределение обозначается через В (х) , так что

В (х) =-= Р [время обслуживания < х]. (1.2)

Здесь под временем обслуживания понимается промежуток времени, в течение которого требование находится в обслуживающем приборе.

Для описания структуры обслуживающего прибора и дисциплины обслуживания необходимо ввести в рассмотрение еще некоторые величины. Одной из них является емкость памяти, в которой накапливаются ожидающие требования; обычно ее обозначают через /<, и часто число К предполагается бесконечным. Другой характеристикой является число доступных, обслуживающих приборов. Если это число больше единицы, то функции распределения времени обслуживания для каждого прибора могут быть различными, и этот факт будет отмечаться индексом у функции распределения В (х). Входящий поток требований также может состоять из нескольких классов’, в таком случае каждый из классов требований может быть описан своим распределением А (/) вероятностей промежутков времени между последовательными требо-

1 Запись Р [А ] означает, как обычно, «вероятность события Д».

23

ваниями и распределением В (х) времени обслуживания, что будет отмечаться индексом у этих распределений.

Важнейшей структурной характеристикой системы массового обслуживания является дисциплина обслуживания; она задает порядок выбора требований из очереди для обслуживания. Примерами стационарных дисциплин обслуживания являются обслуживание в порядке поступления (ОПП), обслуживание в обратном порядке (ООП) и случайный выбор требований для обслуживания Е Если поступающие требования различаются по группам и устанавливается некоторый приоритет обслуживания групп, то говорят о приоритетной дисциплине обслуживания.

Характеристики, определяющие доступность обслуживающего прибора, могут быть использованы и в других случаях (например, в задачах, в которых прибор выходит из строя). Кроме того, система массового обслуживания может учитывать такое поведение клиентов, как уход из очереди, переходы из одной очереди в другую, задержку перед входом в очередь, покупку места в очереди, мошенничество в очереди и многие другие интересные и не являющиеся неожиданными поступки, свойственные людям. Мы встретимся с такими явлениями по мере чтения текста (обслуживание в порядке поступления в соответствии с номером страницы).

Указав характеристики системы массового обслуживания, необходимо определить показатели эффективности работы системы, которые будут получены в результате анализа. Интерес в основном представляют время ожидания требованием обслуживания, число требований в системе, длина периода занятости (промежуток времени непрерывной работы обслуживающего устройства), длина свободного периода и текущая задолженность, выраженная в единицах времени. Все эти величины являются случайными, и для их анализа будем искать полное вероятностное описание (т. е. функцию распределения вероятностей). Однако обычно определить функцию распределения — это значит сделать больше, чем требуется, поэтому часто анализ ограничивается вычислением нескольких первых моментов (среднего значения, дисперсии и т. д.).

Дальнейшее изложение материала начинается с рассмотрения простейших соображений и развития непосредственных методов исследования, что позволяет обратить внимание на существенные

1 Соответствующие английские обозначения FCFS (first—соте—first—serve, т. е. первый поступивший первым обслуживается), LCFS (last—соте—first— serve, т. е. последний поступивший первым обслуживается) и RANDOM (случайно). Развитие вычислительной техники и широкое распространение языков программирования, использующих латинский алфавит и некоторые слова английского языка, приводит к тому, что во многих книгах и статьях, издаваемых на русском языке, воспроизводятся английские термины, используемые в языках программирования. Это сдерживает развитие русской научно-технический терминологии, п в работах, непосредственно не связанных с применением ЭВМ, невидимому, должно рассматриваться как явление нежелательное. — Прим. ред. 24

детали~'анализа. Затем будет решено несколько простых задач теории^массового обслуживания, простых по крайней мере по своей формулировке, однако достаточно трудных для решения. Чтобы решить их надлежащим образом, сначала остановимся на некоторых важных случайных процессах, описывающих процесс поступления требований и процесс их обслуживания в СМО.

СПИСОК ЛИТЕРАТУРЫ

1. Форд Л. и Фалкерсон Д. Потоки в сетях. Пер. с англ./Пер. И. А. Вайнштейн. М., Мир, 1966. 276 с.

2. Frank Н. and Frisch I. Т. Communication, Transmission and Transportation Networks, Addison — Wesley (Reading, Mass.), 1971.

3. Клейнрок Л. Коммуникационные сети. Стохастические потоки и задержки сообщений. Пер. с англ./Под ред. А. А. Первозванского. М., Наука, 1970. 255 с.

ГЛАВ А 2

Некоторые важные случайные процессы1

Предполагается, что читатель знаком с основными элементарными понятиями, терминологией и идеями теории вероятностей. Те частные аспекты этой теории, которые необходимы для данной книги, кратко изложены в приложении II с целью облегчить работу тех читателей, которые пожелают быстро восстановить в памяти необходимую информацию; читателю рекомендуется просмотреть этот материал, особенно параграф II.4 о преобразованиях, производящих функциях и характеристических функциях.

В приложение II вошли следующие важнейшие определения, понятия и результаты:

. Пространство элементарных событий, события и вероятность.

. Условная вероятность, статистическая независимость, закон полной вероятности, теорема Байеса.

. Действительная случайная величина, функция распределения вероятностей, плотность распределения и их простейшие свойства.

. События, связанные со случайными величинами, и их вероятности.

. Функции совместного распределения.

1 Читатель при первом чтении может пропустить параграфы 2.2—2.4.

25

. Функции случайных величин и их плотности распределений.

. Математическое ожидание.

. Преобразование Лапласа, производящие функции, характеристические функции, их свойства и взаимосвязь1.

. Неравенства и предельные теоремы.

. Определение вероятностного процесса.

2.1. ОБОЗНАЧЕНИЯ И СТРУКТУРА СИСТЕМ

МАССОВОГО ОБСЛУЖИВАНИЯ С ОЖИДАНИЕМ

Прежде чем вплотную заняться изучением теории массового обслуживания от элементарных определений к промежуточной и, наконец, к общей теории, важно понять основную структуру СМО. Попутно читатель увидит направление данного курса.

Задачей настоящего параграфа является определение некоторых символических и графических обозначений и основных вероятностных процессов, которые характерны для систем массового обслуживания. Здесь будут получены простые, но важные для таких систем результаты, связывающие некоторые моменты первого порядка случайных величин. Это даст возможность ввести в рассмотрение величины и процессы, изучению которых посвящены многие страницы книги.

Рассматриваемая система представляет собой систему самого общего вида G/G/m. Вспомним (см. введение), что в такой системе полностью известны распределение вероятностей А (/) промежутков времени между последовательными требованиями и распределение вероятностей В (х) времени обслуживания (все промежутки времени между последовательными требованиями и все продолжительности времени обслуживания предполагаются независимыми друг от друга). Система имеет m обслуживающих приборов, и дисциплина обслуживания произвольна (в частности, она не должна быть обязательно дисциплиной обслуживания в порядке поступления).

^Остановимся на потоке требований, которые поступают на вход системы, проходят через нее и в конце концов покидают эту систему; для этого пронумеруем требования и введем обозначение

Сц — п-е требование, поступающее в систему. (2.1)

Рассматриваемая система можетбытьпредставлена, какпоказано на рис. 2.1: прямоугольник означает собственно систему массового обслуживания, слева изображен поток входящих требований, а справа — выходящий поток. Можно сразу определить некото-

1 Приложение I является памяткой по теории преобразований. Этот материал также важен для полного понимания текста книги.

20

Рис. 2.1. СМО общего вида

рые представляющие интерес случайные процессы. Например, процесс

N (/) А число требований в системе в момент t*. (2.2)

Другим интересным вероятностным процессом является незавершенная работа U (/) в момент t, точное определение которой имеет следующий вид:

(7 (/) А незавершенная работа системы в момент t А

А остаточное время, необходимое для освобождения системы от всех требований, находящихся в пей в момент г. (2.3)

Если U (t) > 0, то говорят, что система занята; система называется свободной (незанятой), если U (/) — 0. Представляют интерес также длительность и локализация периодов занятости и простоя системы. Эти вероятностные процессы можно описать с помощью определенного ниже набора случайных величин или графически путем изображения указанных величин на временной диаграмме, которая будет определена ниже. Начнем с определений. Напомним, что п-е требование обозначено через Сп, и /определим момент хп поступления этого требования:

хп А время поступления требования Сп. (2.4)

Обозначим далее промежуток времени между требованиями C„_i и Сп через tn\

tn А промежуток времени между C„_i и Сп — т„ — xn_i- (2.5)

Так как предполагается, что все промежутки между последовательными требованиями подчиняются распределению А (/), то независимо от п имеем

Р < t\ - A (t). (2.6)

Аналогично введем время обслуживания требования С„ в виде х„ А время обслуживания С,г. (2.7)

Согласно сделанным предложениям, имеем

Р \хп < х] = В(х). (2.8)

Последовательности (tn} и {%„} можно рассматривать как последовательности входных переменных для исследуемой системы, Обра-

* Обозначение а, следует читать «равно по определению».

ботка требовании в системе приводит к образованию очереди, поэтому необходимо определить время ожидания (время, которое требование проводит в очереди) \ Определим его в виде

Щ,г А время ожидания (в очереди) для требования С;1. (2.9)

Полное время, проведенное требованием в системе, складывается из времени ожидания и времени обслуживания и определяется равенством:

sn А время пребывания в системе (очередь плюс обслуживание) для Сп ] - - - хп. (2.10)

Таким образом, для требования Сп определены время его поступления, «его» промежуток времени между последовательными требованиями, его время обслуживания, время ожидания и время пребывания в системе.^

Теперь перейдем к некоторым дальнейшим определениям. Рассмотрим опять промежуток времени tn между двумя последовательными требованиями. Нам понадобится предельная случайная величина, определяемая равенством

/Alim^; (2.11)

П->со

этот предельный переход будем обозначать также следующим образом: tn -> t. (Предполагается, что промежуток времени tn между двумя последовательными требованиями не зависит от номера п, хотя многие представляющие интерес случайные величины не удовлетворяют этому ограничению.) Функцию распределения вероятностей, как правило, будем обозначать через

Р [tn<. t] = An(t), (2.12)

а функцию распределения предельной случайной величины — (2.13)

Этот факт будем также обозначать следующим образом: Ап (/) -> A (t). Для промежутка времени tn между двумя соседними требованиями естественно предположить выполнение равенства Ап (i) — A (t), что приводит к (2.6). Аналогично, плотности распределения случайных величин tn и t будем обозначать через ап (/)

1 В литературе по теории массового обслуживания термины «время ожидания» и «время пребывания в очереди» являются конкурирующими. Иногда первый из этих терминов используют для обозначения полного времени, проведенного требованием в системе; одиако часто эти два определения меняют местами. Попытка устранить это недоразумение состоит в том, что оба термина: «время ожидания» и «время пребывания в очереди» в данной монографии используются для обозначения одной и той же величины, а именно времени, проведенного ожидающим требованием в очереди (но не на обслуживании); более подходящим названием для этой случайной величины было бы, возможно, «потерянное время». Полное время, проведенное требованием в системе, будем называть «временем пребывания в системе» (иногда это время называют также «временем в потоке»), 28

и а (0 соответственно, т. е. а„ (I) -*• a (t). Наконец, преобразования Лапласа (см. приложение II) плотностей распределений соответственно обозначим через Л,‘ (s) и Л* (s), так что в очевидных обозначениях An (s) -> Л* (s). Буквы Л (и а) использованы в этих обозначениях для того, чтобы напомнить читателю о том, что исследуемой случайной величиной является промежуток времени между двумя последовательными требованиями. Естественный интерес представляют моменты распределения этой случайной величины, для которых используется обозначение1

E[tn]/\tn. (2.14)

Согласно принятым обозначениям средний предельный промежуток времени задается2 величиной t в том смысле, что tn t. Величина t, равная среднему промежутку времени между двумя соседними требованиями, очень часто появляется в уравнениях, описывающих СМО, поэтому для нее удобно ввести следующее специальное обозначение:

/Д-^. (2.15)

Таким образом, X соответствует интенсивности поступления требований в систему.

Представляют интерес также моменты более высокого порядка для промежутка времени между соседними требованиями. Произвольный момент k-го порядка определяется равенством

Е [?] A ak, k = 0, 1, 2, ... (2.16)

Это равенство — стандартное определение k-ro момента ак промежутка времени t между сосещщми требованиями; заметим, что непосредственно из этого определения вытекает:

(2.17)

Таким образом, имеются три различных обозначения для среднего промежутка времени между соседними требованиями; в частности, общепринятым является символ а; в тексте книги используются по необходимости все три обозначения.

1 Символ Е [ ] означает математическое ожидание величины, заключенной в квадратные скобки. Другим используемым в книге обозначением для математического ожидания является черта, поставленная над случайной величиной.

2 На самом деле среднюю предельную величину надо было бы обозначить и тильдой, и чертой сверху, но во избежание громоздкости будем писать просто черту; такое обозначение будет использовано в дальнейшем для многих случайных величин.

29

Резюмируя все сказанное о промежутке времени между последовательными требованиями, получаем

tn Л промежуток времени между требованиями Сп и Сп_р,

tn -► t, Ап (t) -> A (f), ап (0 -> а (/), А„ (s) -> Л* (s);

~tn->7= 4- == fli = a, tn~>lk = ak. (2.18)

Л

Аналогичным образом введем следующие обозначения для переменных хп, wn, sn:

хп = время обслуживания требования' Сп,

Хп -> X, В,г (х) -> В (х), Ьп (х) -> b (х), Bn ($) В* (s);

хп~>х= =&1 = 6, х*-->/==(2-19)

к',г - время ожидания для требования С„;

wn -> w, IVп (у) -> W (у), Wn (у) -> w (у), W*n (s) -► IV* (s);

wn -> w = W, w'!t -> wk; (2.20)

sn = время пребывания требования C„ в системе;

sn -> s, Sr! (у) -+S (у), sn (у) -> s (//), S* (s) -> S* (s);

~sn->^==T, sI->Z (2.21)

Все эти обозначения очевидны, за исключением, возможно, специальных символов, участвующих в обозначениях момента первого порядка и иногда моментов более высокого порядка (имеется в виду использование символов X, а, р, b, W и Т). Сошлемся здесь на глоссарий в конце книги, содержащий полный набор обозначений, используемых в'данной книге.

Используя введенные обозначения, опишем теперь временную диаграмму системы массового обслуживания, позволяющую графически проследить динамику системы и выделить детали исследуемых вероятностных процессов. Такая диаграмма для обслуживания в порядке поступления показана на рис. 2.2, однако нетрудно увидеть, как этот рисунок можно преобразовать для произвольной дисциплины обслуживания. На диаграмме нижняя ось времени соответствует очереди, а верхняя — прибору обслуживания. Рассматриваемая диаграмма соответствует случаю одного обслуживающего прибора, хотя легко поддается обобщению. Входящие снизу стрелки (как для осп очереди, так и для оси обслуживания) указывают на поступление требования. Стрелки, выходящие сверху, обозначают уход требования из очереди.

Из рис. 2.2 видно, что требование Cn+i поступило в очередь на обслуживание раньше, чем требование Сп освободило обслуживающий прибор. Так как требование Cn+i может быть обслужено 30

только лишь после того, как требование Сп освободит прибор, то в системе происходят одновременно два события: завершается обслуживание требования С,г, и требование C„+i поступает в прибор обслуживания. Другой пример дает требование С„+2; приходя в систему, требование Сп+2 застает обслуживающий прибор свободным, и обслуживание этого требования начинается немедленно. На диаграмме видно также время ожидания и время пребывания требования Сп в системе (заметим, что wn+2 = 0). Для временного описания системы удобно ввести функции N (/) — число требований в системе и U (t) — незавершенная работа, а также периоды занятости и простоя обслуживающего прибора. Использование временных диаграмм окажется весьма полезным в изложении следующего материала.

В общем случае для системы массового обслуживания естественно ожидать, что с увеличением числа требований растет время ожидания. Одним из проявлений этого правила служит простое соотношение, связывающее среднее число требований в системе, интенсивность потока требовании и среднее время пребывания требования в системе. Наша ближайшая задача — установить это соотношение с целью углубления понимания характеристик таких систем. Возвращаясь к рис. 2.1, рассмотрим вход системы массового обслуживания и подсчитаем число входящих требований как функцию времени. Обозначим эту величине « (0:

а (/) Д число поступающих в промежутке времени (О, f) требований. (2.22)

Перейдем теперь к выходу системы и подсчитаем число требований, выходящих из нее; для этого введем обозначение

6 (/) Д число исходящих в промежутке времени (0, t) требований. (2.2.1)

31

Рис. 2.3. Поступления и уходы

На рис. 2.3 приведены примеры функциональных зависимостей этих двух вероятностных процессов от времени.

Ясно, что число N (/) требований в системе в момент времени t должно удовлетворять равенству

N (t) = a (t) — S (t).

С другой стороны, площадь между двумя рассматриваемыми кривыми, взятая от начальной точки до некоторой фиксированной точки I, представляет собой общее время, проведенное всеми требованиями в системе за время (0, /) (измеренное в единицах «требование — секунда»); обозначим эту накопленную величину у (t). Пусть означает интенсивность (требований в секунду) поступления требований в систему в промежутке времени (0, t), т. е.

Х(^)Д^1. (2.24)

Определим также величину Tt как время, проведенное одним требованием в системе, усредненное по всем требованиям, находящимся в системе в течение времени (0, t). Так как у (/) равно общему времени («требование — секунда») в системе по всем требованиям вплоть до момента t, то ясно, что Tt определяется отношением

Т =_

Наконец, определим величину Nt как среднее число требований в системе в промежутке времени (0, /); эта величина может быть получена как отношение накопленного числа у (t) к длине t промежутка времени наблюдения:

Из последних трех уравнений следует, что

N t = t-

32

Предположим теперь, что рассматриваемая система массового обслуживания такова, что при t —> оо существуют следующие пределы:

X = lim t -> оо

Т= limTV t -> СЮ

Заметим, что для интенсивности поступления требований в систему и среднего времени пребывания требования в системе соответственно используются приведенные выше определения к и Т. Если указанные два предела существуют, то существует также предел для Nt, который обозначим через N. Последний предел соответственно задает среднее число требований в системе:

N = (2.25)

Этот результат, называемый формулойЛиттла, и является именно тем соотношением, которое мы искали. Оно устанавливает, что среднее число требований в системе равно произведению интенсивности поступления требований в систему на среднее время пребывания требования в системе х. Приведенное доказательство не зависит ни от каких-нибудь частных ограничений, накладываемых на вид распределения А (/) входящего потока или на вид распределения В (х) времени обслуживания, ни от числа обслуживающих приборов, ни от конкретного характера дисциплины обслуживания в системе. Этот результат долгое время существовал в виде «фольклорной теоремы»; первым человеком, давшим его строгую формулировку и доказательство, был Дж. Д. К- Литтл [91; некоторые дальнейшие упрощения были даны в работах У. С. Джевелла [7], С. Эйлона [3] и С. Стидхема [13]. Важно подчеркнуть, что на выбор систем массового обслуживания не накладывается никаких точных ограничений. Так, прямоугольник на рис. 2.1 может означать как целую систему, состоящую из очереди и обслуживающего прибора, так и только очередь требований; в последнем случае выведенное соотношение принимает вид

= (2.26)

где Nq — определенное ранее среднее число требований в очереди, a W — среднее время ожидания в очереди.

1 Интуитивное доказательство формулы Литтла сводится к утверждению, что требование, входящее в систему, находит в ней то же самое среднее число требований ,У,_которое остается в системе, когда это требование покидает ее. Эта величина N попросту равна произведению интенсивности К поступления требований в систему на среднее время Т пребывания требования в системе.

2 Л. Клейнрок 33

Третья возможность сводится к тому, что система состоит только из обслуживающего прибора (или приборов); в этом случае равенство (2.25) приводится к виду

Л/, = й, (2.27)

где Ns — среднее число требований в обслуживающем приборе (или приборах), а х — среднее время, проведенное требованием в обслуживающем приборе. Отметим, что в этом случае всегда имеет место равенство

T = x-]-W. (2.28)

Системы массового обслуживания можно различать по частным классам требований, например по приоритетам обслуживания, или по каким-либо другим признакам этих классов; выведенное соотношение применимо к любому из них. Иными словами, как бы мы ни определили систему массового обслуживания, среднее число требований в системе равно произведению интенсивности потока входящих в систему требований на среднее время пребывания требования в системе.

Рассмотрим теперь один из основных параметров р, который называется коэффициентом использования. Этот параметр является фундаментальным в том смысле, что он равен отношению R/C, введенному в гл. 1, т. е. равен отношению интенсивности, с которой работа поступает в систему, к той максимальной интенсивности (пропускной способности), с которой система может выполнять эту работу. Работу, вносимую в систему каждым поступающим требованием, измеряют в секундах \ необходимых для его обслуживания. Таким образом, для однолинейных систем определение параметра р имеет следующий вид:

р Л (интенсивность поступления требований в систему) X

X (среднее время обслуживания) — Кх. (2.29)

Последнее равенство справедливо, так как максимальная интенсивность, с которой однолинейная система может выполнять обслуживание, равна 1 с/с, а каждое поступающее требование вносит работу в количестве х с; поскольку в среднем в систему поступает % требований в секунду, то в среднем каждую секунду все поступающие требования вносят работу, равную Хх с. В случае многолинейной системы (например, когда в системе имеется т обслуживающих приборов) определение коэффициента использования в зависимости от отношения RJC остается тем же самым, причем под пропускной способностью системы теперь понимают

1 Читателя не должно смущать, что работа измеряется в единицах времени, так как здесь предполагается, что эта работа выполняется с постоянной мощностью (сравни: повременная оплата труда). — Прим, ред 34

т с/с; В зависимости от параметров системы это определение можно переписать в виде

-(2.30)

Равенства (2.29) и (2.30) справедливы в случае, когда максимальная интенсивность обслуживания системы не зависит от ее состояния; в противном случае приходится вводить более точное определение. Интенсивность поступления работы в систему иногда называется интенсивностью нагрузки и выражается, как правило, в эрлангах-, в однолинейной системе интенсивность нагрузки равна коэффициенту использования, а в системе с т обслуживающими приборами она равна тр. Параметр р заключен в пределах 0 < < р < 1 и может быть интерпретирован как

р = Е [доля занятых приборов 1. (2-31)

(Для системы с бесконечным числом обслуживающих приборов бессмысленно вводить коэффициент использования р, и вместо него рассматривают число занятых приборов и его среднее.)

Ясно, что для стационарности системы G/G/1 должно выполняться условие R < С, так что 0 < р < 1. Однако случай р = 1 также иногда включают в диапазон стационарности системы (в частности для системы D/D/1). Под стационарностью здесь опять подразумевается тот факт, что существуют предельные распределения для всех представляющих интерес случайных величин и что все требования в конце концов будут обслужены. При этих предположениях можно провести следующие простые рассуждения. Пусть т — сколь-угодно длинный промежуток времени. В этом промежутке ожидаемое число поступающих требований (согласно закону больших чисел) с вероятностью 1 будет примерно равно Хт. Обозначим через р0 вероятность того, что в некоторый случайный момент времени обслуживающее устройство будет свободным. Тогда можно сказать, что в промежутке времени т обслуживающий прибор будет занят (т — тр0) секунд, так что с вероятностью 1 число обслуженных в этом интервале требований очень близко к (т — тр0)/х. Приравнивая число требований в промежутке т к числу обслуженных в этом промежутке требований, для достаточно больших т получаем

X

При т -> оо имеем Хх= 1 —р0. Используя определение (2.29), наконец, приходим к следующему важному выводу для систем

р=1— р0. (2.32)

Интерпретация этого равенства состоит в том, что о в точности Равно доли времени занятости обслуживающего рибора; это 2* 35

согласуется с равенством (2.27) в том, что лх= р равно среднему числу требований в обслуживающем приборе.

Таким образом, мы кратко ознакомились с системой массового обслуживания общего вида, для которой были рассмотрены некоторые основные вероятностные процессы и введены важнейшие определения и обозначения. Кроме того, был установлен результат Литтла, позволяющий по известному среднему значению времени пребывания требования в системе определять среднее число требований в системе (и наоборот). Теперь перейдем к более подробному изучению важнейших вероятностных процессов, встречающихся в системах массового обслуживания.

2.2.* ОПРЕДЕЛЕНИЕ И КЛАССИФИКАЦИЯ ВЕРОЯТНОСТНЫХ ПРОЦЕССОВ

В конце приложения II дано определение вероятностного процесса, которое по существу устанавливает, что это семейство случайных величин X (/), значения которых индексируются временным параметром I. Например, число зрителей в кинотеатре или атмосферное давление в зале этого кинотеатра как функции времени являются вероятностными процессами (по меньшей мере эти функции можно моделировать вероятностными процессами). Часто вероятностный процесс называют случайным процессом. Случайный процесс можно представить себе как процесс движения частиц в некотором пространстве. В основе классификации случайных процессов лежат три характеристики: пространство состояний, индексирующий параметр (время) и статистические зависимости между случайными значениями процесса X (/), соответствующими разным значениям индексирующего параметра /. Рассмотрим каждую из этих величин для того, чтобы наметить общую основу случайных процессов.

Начнем с пространства состояний. Пространством состояний называют множество возможных значений (состояний) процесса X (t). По аналогии с процессом движения частиц говорят, что процесс характеризуется дискретным множеством состояний, если множество возможных положений частиц в пространстве конечно или счетно; часто такой процесс называют цепью. Пространство состояний цепи обычно задают натуральным рядом чисел: (0, 1, 2, ...}. С другой стороны, если допустимое множество положений частиц в пространстве представляет собой конечный или бесконечный непрерывный интервал (или несколько таких интервалов), говорят, что процесс имеет непрерывное множество состояний.

* Читатель может пропустить параграфы 2.2—2.4 и непосредственно перейти к параграфу 2.5. К пропущенному материалу можно возвратиться, если возникнет в этом необходимость.

36

Рассмотрим теперь индексирующий параметр (время). Если допускаются изменения положения частиц в конечном или счетном числе моментов времени, то говорят о процессе с дискретным (временным) параметром; если же допускаются изменения положений частиц в любой точке конечного или бесконечного промежутка времени (или множества промежутков), то говорят о процессе с непрерывным параметром. В первом случае для обозначения процесса используют символ Хп, тогда как во втором — X (/). Величину Хп часто называют случайной, или вероятностной последовательностью, а величину X (/) — случайным, или вероятностным процессом.

Отличительной особенностью вероятностного процесса является зависимость случайных величин X (t) или Хп от других членов этого же семейства. Согласно определению, данному в приложении II, надо задать полную функцию совместного распределения вероятностей этих случайных величин (их совокупность можно рассматривать как векторную случайную величину, для обозначения которой применяют жирный шрифт) X — [X (/х), X (/.>), 1, а именно функцию

Fx (х; t) А Р [X (F) < хг, . . . X (tn х„)] (2.33)

для всех х = (хх, х2, хп), t = (tlt t.2, ..., tn) и n. Как указано в приложении, такая задача представляет существенную трудность; к счастью, однако , многие представляющие интерес случайные процессы допускают более простое описание. Как бы то ни было, функция Fx (х; t) представляет собой полное описание зависимостей между случайными величинами вероятностного процесса. Ниже описаны некоторые типы обычных вероятностных процессов, характеризуемых различными видами зависимостей между случайными значениями этих процессов. Такая классификация проводится для того, чтобы дать читателю общую картину рассматриваемой области науки и помочь выделить ту ее часть, которая необходима для изучения теории массового обслуживания, а также для выявления ее связи с вероятностными процессами.

Стационарные процессы. Согласно определению, приведенному в конце приложения II, вероятностный процесс Х'([) называется стационарным, если функция Fx (х, t) инвариантна относительно сдвигов во времени для всех значений ее аргументов; иными словами, для произвольно заданной постоянной величины г должно выполняться равенство

Fx (х; t + т) = Fx (х; t), (2.34)

где через t + т обозначен вектор (/х + т, /2 + т, ...,/„ + т).

Процесс X (t) принято называть стационарным в широком смысле, если как первый, так и второй моменты распределения не зависят от выбора точки на временной оси, т. е. если Е [X (/)] не зависит от I, а Е [X (/) X (/) + т) ] зависит только от т и не 37

зависит от t. Заметим, что всякий стационарный процесс является стационарным в широком смысле, но не наоборот. Как и следует ожидать, теория стационарных случайных процессов проще, чем теория нестационарных случайных процессов.

Независимые процессы. Самым тривиальным вероятностным процессом является случайная последовательность, в которой величины {Хп} образуют множество независимых случайных величин, т. е. совместная плотность распределения вероятностей, определенная для рассматриваемого вероятностного процесса в приложении II, разлагается в произведение

/х(х; t)A/v ,.Xn(xv...,xn;

tx)...fXn{x^ tn). (2.35)

Такую последовательность можно назвать случайным процессом лишь очень приблизительно, так как между ее случайными значениями нет связи или зависимости. Такой же независимый случайный процесс может быть определен и для непрерывных вероятностных процессов, и его обычно называют белым шумом (примером такого процесса является производная броуновского движения по времени).

Марковские процессы. В 1907 г. А. А. Марков опубликовал работу ПО], в которой определил и исследовал процессы, известные сейчас под названием марковских. Он рассмотрел простую и очень полезную форму зависимости между случайными величинами, образующими вероятностный процесс, к описанию которой и перейдем.

Марковский процесс с дискретным пространством состояний называется цепью Маркова. Наиболее простая и понятная — это цепь Маркова с дискретным временем. Множество случайных величин {Хп] образует цепь Маркова, если вероятность того, что следующее значение (состояние) равно Хп+1, зависит только от текущего значения (состояния) Хп и не зависит от предыдущих значений процесса. Таким образом, имеется случайная последовательность, в которой зависимость распространяется назад на одну единицу времени. Иными словами, воздействие всей предыстории процесса на его будущее полностью сосредоточено в текущем значении процесса.

Изменения состояний в цепи Маркова с дискретным временем могут происходить только в моменты, предопределяемые натуральным рядом чисел: 0, 1, 2, ..., п, ... . Однако для цепи Маркова с непрерывным временем изменение состояния может произойти в любой момент времени. Таким образом, появляется необходимость ввести в рассмотрение случайную величину, указывающую, как долго процесс остается в текущем (дискретном) состоянии перед тем, как перейдет в другое состояние. Но, поскольку, согласно марковскому свойству, вся предыстория процесса полностью заключена в определении текущего состояния, нельзя ЗЯ

требовать, чтобы описание этого текущего состояния содержало также информацию о том, как долго процесс находится в этом состоянии. Это накладывает существенные ограничения па распределение времени пребывания процесса в данном состоянии. Действительно, как увидим из равенства (2.85), время пребывания в этом состоянии должно быть распределено по показательному закону. Таким образом, показательное распределение является непрерывным распределением без последействия. Это замечание достаточно подробно обсуждается ниже в данной главе. Аналогично в случае цепи Маркова с дискретным временем время пребывания процесса в данном состоянии описывается геометрическим распределением, которое является единственным дискретным распределением без последействия. Требование отсутствия последействия накладывается на все цепи Маркова и является существенным ограничением общности тех процессов, которые будут рассмотрены.

Аналитически марковское свойство может быть записано в виде

? [X (/я+1) = Мг+11 X (t„) = Хп, X (/п1) =

= Х1] = Р [X (tn+1) = хп+11X (1п) = хп], (2.36)

где < t2 < ... < tn < tn+1, a Xt принадлежит некоторому дискретному пространству состояний.

Марковские процессы занимают центральное место в исследованиях систем массового обслуживания с ожиданием и будут неоднократно встречаться в этой книге. Именно поэтому значительная часть данного параграфа посвящена цепям Маркова с дискретным и непрерывным временем.

Процессы размножения и гибели. Один из важнейших частных случаев цепей Маркова известен под названием процесса размножения и гибели.' Этот процесс может быть либо с дискретным, либо с непрерывным временем, а определяющее его условие состоит в том, что допускаются переходы только в соседние состояния. Таким образом, если (без потери общности) в качестве дискретного пространства состояний выбран ряд натуральных чисел, то для процесса размножения и гибели переход из состояния Хп = i возможен только в одно из состояний Xn+1 — i — 1, i или i + 1 и ни в какое другое. Как мы увидим, процессы размножения и гибели играют важную роль в теории массового обслуживания. Однако продолжим общий обзор вероятностных процессов, чтобы увидеть место каждого из них.

Полумарковские процессы. Начнем с обсуждения полумарков-ских процессов с дискретным временем. Дискретная цепь Маркова характеризуется тем, что в каждом единичном промежутке времени процесс переходит из текущего состояния в некоторое другое (а может быть, в то же самое) состояние. Вероятности перехода совершенно произвольны; однако вытекающее из марковского свойства требование, чтобы переход происходил в каждый еди-

39

ничный промежуток времени, приводит к тому, что Время пребывания процесса в данном состоянии подчиняется геометрическому распределению [что будет видно из равенства (2.66)1. Как уже отмечалось, это накладывает существенные ограничения на рассматриваемые процессы. Если же снять это ограничение, т. е. допустить произвольные распределения для времени пребывания процесса в данном состоянии, то это непосредственно приведет к понятию полумарковского процесса с дискретным временем. При этом определяющим будет условие, что разрешаются произвольные распределения вероятностей времени между переходами из одного состояния в другое. Отметим, однако, что сточки зрения моментов изменения состояния процесс ведет себя как обычная цепь Маркова, и фактически можно сказать, что в эти моменты имеет место вложенная цепь Маркова.

Из изложенного непосредственно вытекает определение полумарковского процесса с непрерывным временем. Здесь допускаются переходы из одного состояния в другое в любой произвольный момент времени. Однако в противоположность марковскому процессу, для которого распределение времени пребывания в состоянии является показательным, в данном случае допускается произвольное распределение. Это приводит к процессам значительно более общего вида, которые успешно применяют при исследовании систем массового обслуживания. Относительно моментов времени изменения состояний здесь также появляются вложенные цепи Маркова. Ясно, что класс марковских процессов входит в класс полумарковских процессов.

Случайные блуждания. При исследовании случайных процессов часто встречается процесс, который получил название случайного блуждания. Случайное блуждание можно представить себе как передвижение частицы из одного состояния в другое в некотором (скажем, дискретном) пространстве состояний. Задача состоит в нахождении местоположения частицы в этом пространстве. Отличительная черта случайного блуждания состоит в том, что последующее положение, которое займет процесс, равно предыдущему положению плюс случайное перемещение, величину которого выбирают независимым образом из произвольного распределения; это распределение, однако, является одним и тем же в любом состоянии процесса Е Иначе говоря, последовательность случайных величин {£„) называется случайным блужданием (с начальной точкой в начале координат), если

S„ = Xt + X2+ . . +Х„, n= 1, 2.......... (2.37)

где So = 0, a Xt, Х2, ••• — последовательность независимых одинаково распределенных случайных величин. Индекс п служит только для нумерации переходов процесса из одного состояния в другое; ясно, что если п пробегает дискретное множество, то

1 За исключением, может быть, нескольких граничных состояний.

40

имеет место случайное блуждание с дискретным временем, а если п выбирается из континуума, имеет место случайное блуждание с непрерывным временем. В любом случае предполагается, что распределение промежутков времени между этими переходами произвольно, и, следовательно, случайные блуждания представляют собой частный случай полумарковского процесса Е В случае, когда совместное распределение вероятностей для Х„ дискретно, то говорят о случайном блуждании с дискретным множеством состояний; в этом случае вероятности р^ перехода из /-го состояния в /-е зависят только от разности индексов / — i, что обозначается через qt_j.

Примером случайного блуждания с непрерывным временем является броуновское движение; примером случайного блуждания с дискретным временем является общее число выпадения гербов в последовательности независимых подбрасываний монеты.

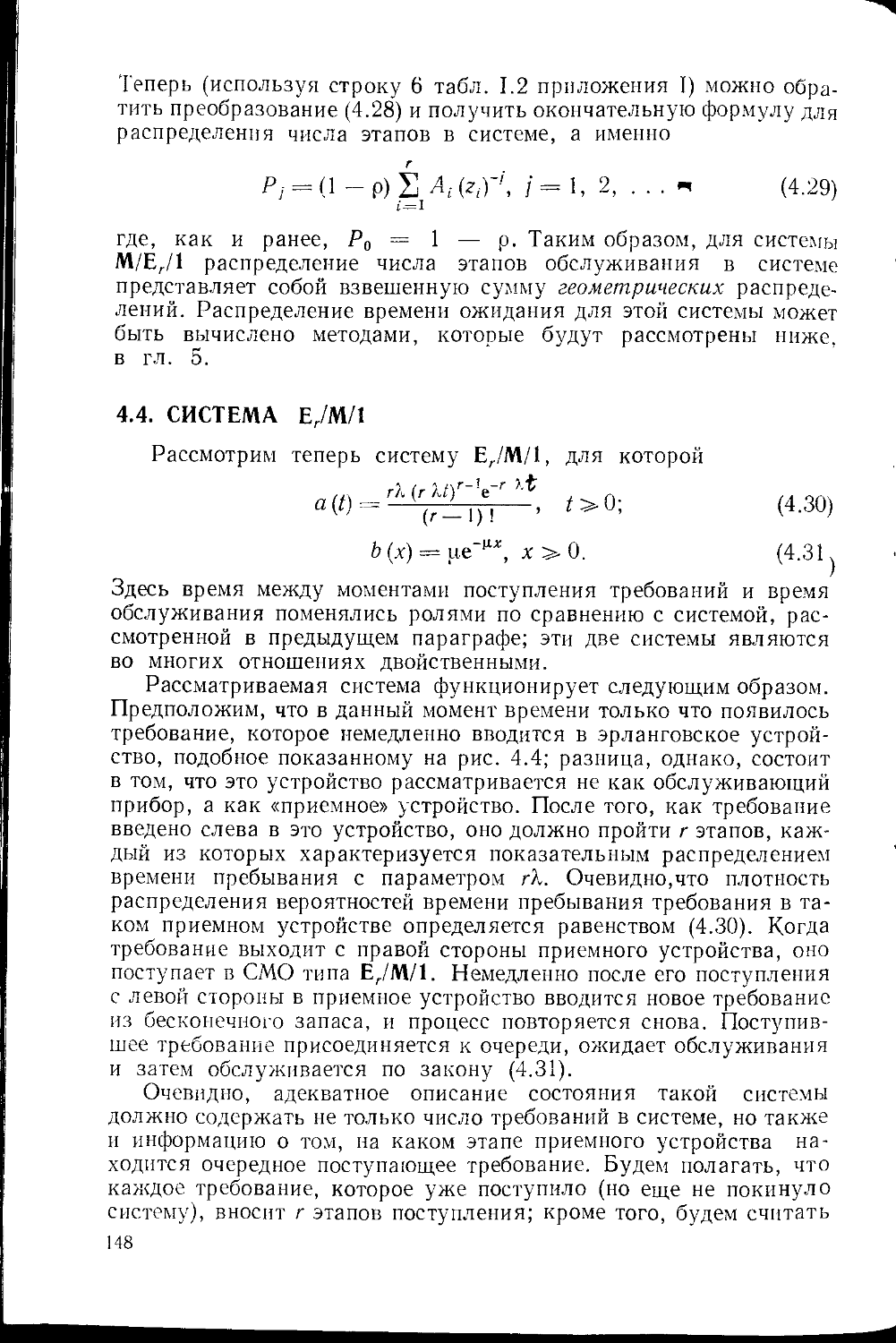

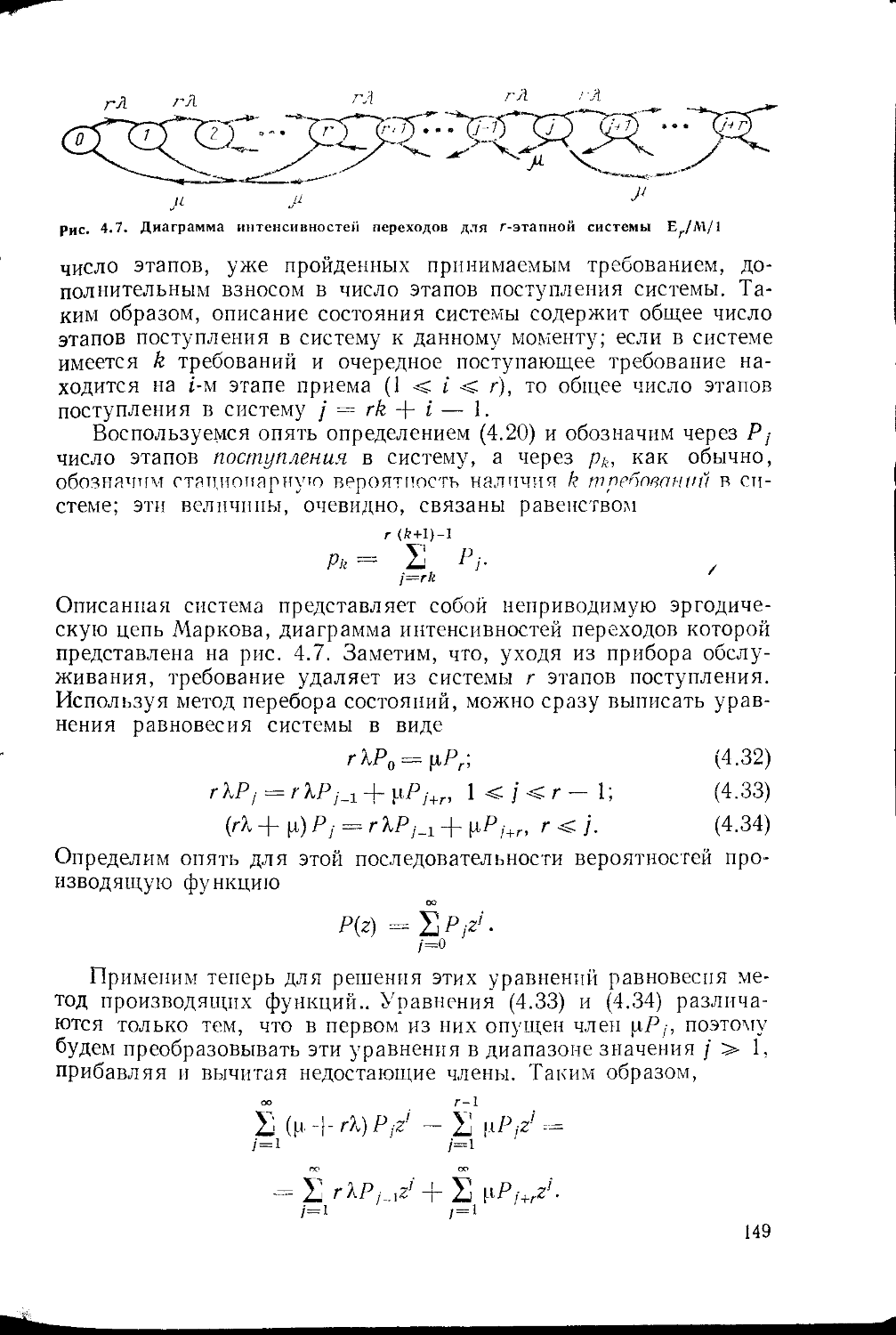

Случайное блуждание иногда называют процессом с независимыми приращениями.