Tags: компьютерные технологии программирование язык программирования c++

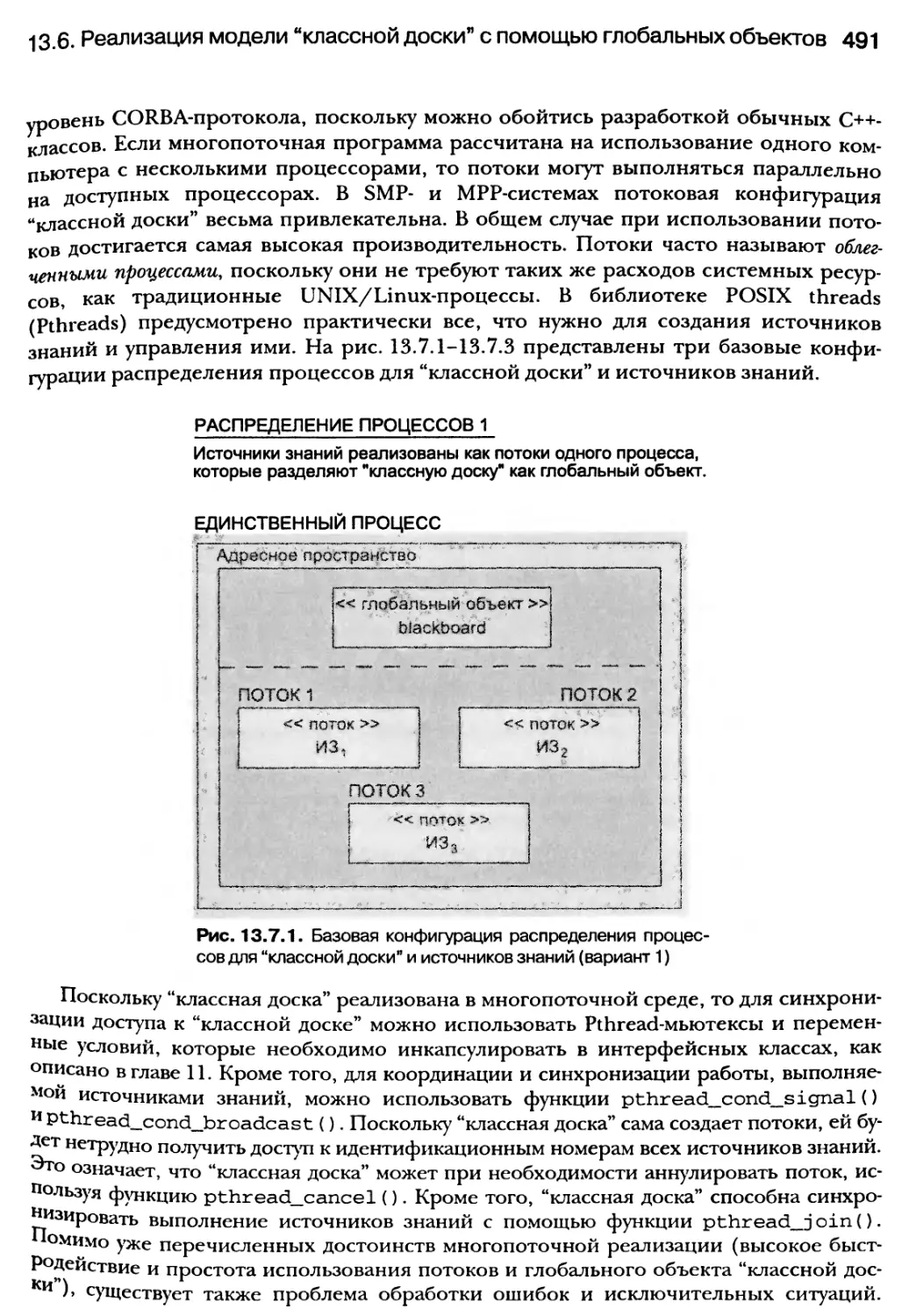

ISBN: 5-8459-0686-5

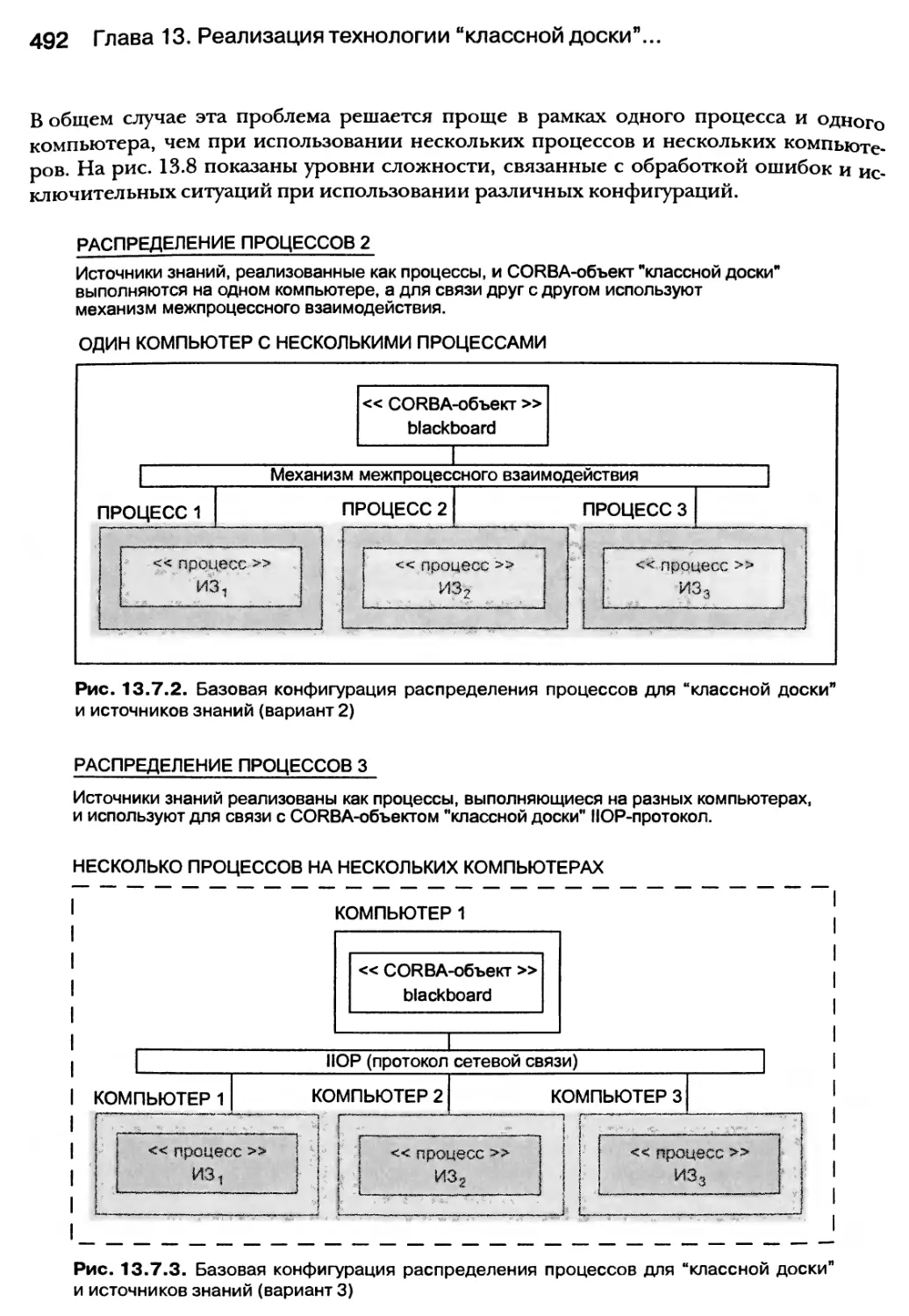

Year: 2004

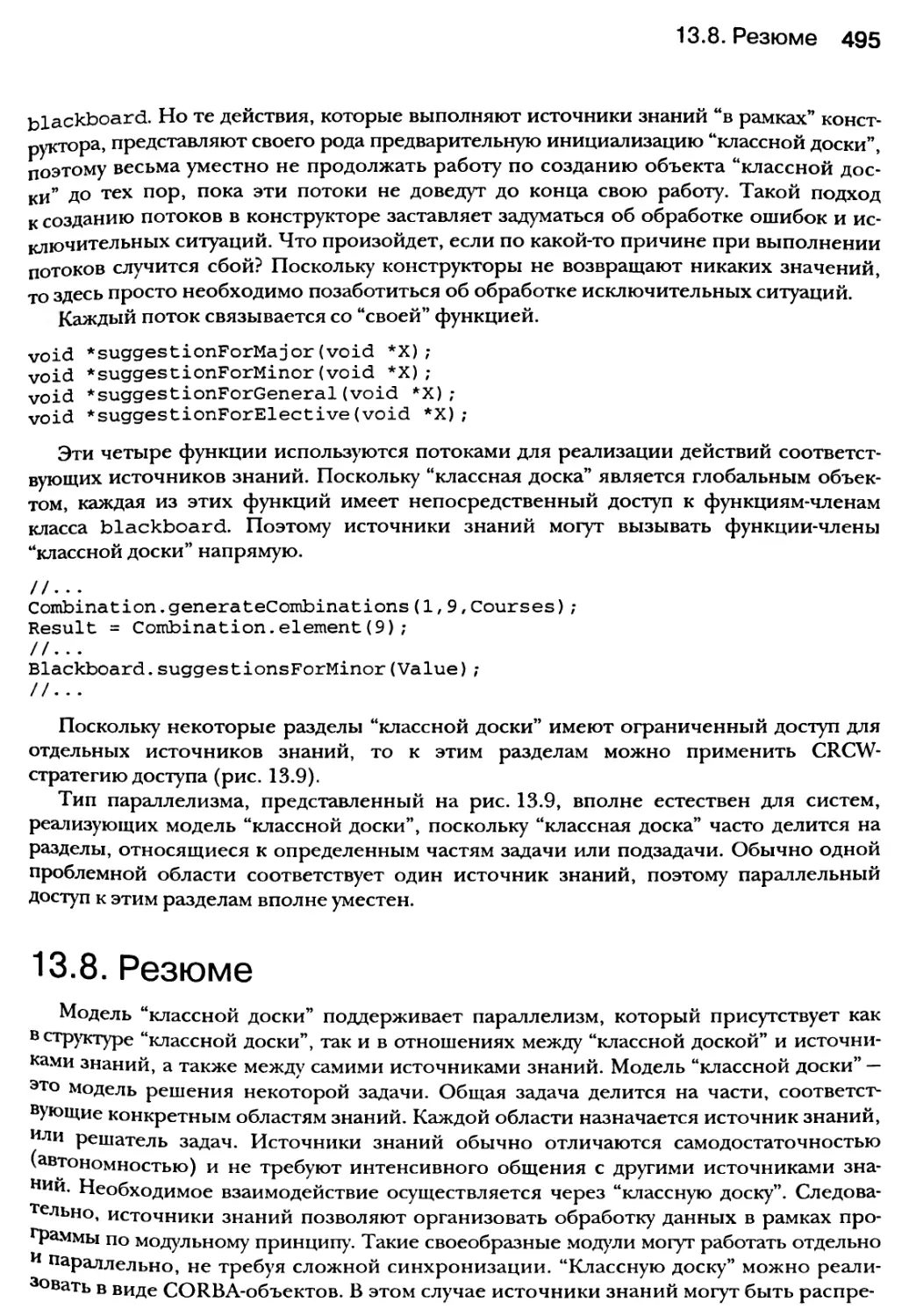

Text

Данный файл был взят с сайта:

-FVQHBook.IlGfe

Данный файл представлен исключительно в ознакомительных

целях. Уважаемый читатель! Если вы скопируете его, Вы должны

незамедлительно удалить его сразу после ознакомления с

содержанием. Копируя и сохраняя его Вы принимаете на себя всю

ответственность, согласно действующему международному

законодательству.

Все авторские права на данный файл сохраняются за

правообладателем. Любое коммерческое и иное использование

кроме предварительного ознакомления запрещено. Публикация

данного документа не преследует за собой никакой коммерческой

выгоды. Но такие документы способствуют быстрейшему

профессиональному и духовному росту читателей и являются

рекламой бумажных изданий таких документов.

Все авторские права сохраняются за правообладателем. Если

Вы являетесь автором данного документа и хотите дополнить его

или изменить, уточнить реквизиты автора или опубликовать

другие документы, пожалуйста, свяжитесь с нами по e-mail - мы

будем рады услышать ваши пожелания.

ProgBook.net - библиотека программиста.

В нашей библиотеке Вы найдете книги и статьи практически по

любому языку программирования.

параллельное

и распределенное

программирование

с использованием

Камерон

Хьюз

Трейси

Хьюз

Параллельное

и распределенное

программирование

с использованием

Parallel

and Distributed

Programming

Using

Cameron Hughes • Tracey Hughes

Л Addison-Wesley

Pearson Education

Boston • San Fransisco • New York • Toronto • Montreal

London * Munich • Paris • Madrid

Cape Town • Sydney • Tokyo • Singapore • Mexico City

Параллельное

и распределенное

программирование

с использованием

Камерон Хьюз • Трейси Хьюз

Москва • Санкт-Петербург • Киев

2004

ББК 32.973.26-018.2.75

Х98

УДК 681.3.07

Издательский дом “Вильямс”

Зав. редакцией С. Н. Тригуб

Перевод с английского и редакция Н. М. Ручко

По общим вопросам обращайтесь в Издательский дом “Вильямс” по адресу:

info@dialektika.com, http://www.dialektika.com

Хьюз, Камерон, Хьюз, Трейси.

Х98 Параллельное и распределенное программирование на C++. : Пер. с англ. — М. :

Издательский дом “Вильямс”, 2004. — 672 с.: ил. — Парал. тит. англ.

ISBN 5-8459-0686-5 (рус.)

В книге представлен архитектурный подход к распределенному и параллельному

программированию с использованием языка C++. Здесь описаны простые методы

программирования параллельных виртуальных машин и основы разработки кла-

стерных приложений. Эта книга не только научит писать программные компоненты,

предназначенные для совместной работы в сетевой среде, но и послужит надежным

“путеводителем” по стандартам для программистов, которые занимаются многоза-

дачными и многопоточными приложениями. Многолетний опыт работы привел ав-

торов книги к использованию агентно-ориентированной архитектуры, а для мини-

мизации затрат на обеспечение связей между объектами системы они предлагают

применить методологию “классной доски”.

Эта книга адресована программистам, проектировщикам и разработчикам про-

граммных продуктов, а также научным работникам, преподавателям и студентам, ко-

торых интересует введение в параллельное и распределенное программирование

с использованием языка C++.

ББК 32.973.26-018.2.75

Все названия программных продуктов являются зарегистрированными торговыми марками со-

ответствующих фирм.

Никакая часть настоящего издания ни в каких целях не может быть воспроизведена в какой бы то

ни было форме и какими бы то ни было средствами, будь то электронные или механические, включая

фотокопирование и запись на магнитный носитель, если на это нет письменного разрешения издатель-

ства Addison-Wesley Publishing Company, Inc.

Authorized translation from the English language edition published by Addison-Wesley Publishing

Company, Inc , Copyright © 2004

.All rights reserved. No part of this book may be reproduced or transmitted in any form or by any

means, electronic or mechanical, including photocopying, recording or by any information storage

retrieval system, without permission from the Publisher.

Russian language edition published by Williams Publishing House according to the Agreement with

R&I Enterprises International, Copyright © 2004

ISBN 5-8459-0686-5 (pyc.)

ISBN 0-13-101376-9 (англ.)

© Издательский дом “Вильямс”, 2004

© Pearson Education, Inc., 2004

ОГЛАВЛЕНИЕ

Введение 16

Глава 1. Преимущества параллельного программирования 23

Глава 2. Проблемы параллельного и распределенного

программирования 42

Глава 3. Разбиение С++-программ на множество задач 57

Глава 4. Разбиение С++-программ на множество потоков 111

Глава 5. Синхронизация параллельно выполняемых задач 183

Глава 6. Объединение возможностей параллельного

программирования и С++-средств на основе PVM 211

Глава 7. Обработка ошибок, исключительных ситуаций

и надежность программного обеспечения 245

Глава 8. Распределенное объектно-ориентированное

программирование в C++ 268

Глава 9. Реализация моделей SPMD и MPMD с помощью

шаблонов и MPI-программирования 312

Глава 10. Визуализация проектов параллельных

и распределенных систем 336

Глава 11. Проектирование компонентов для поддержки

параллелизма 377

Глава 12. Реализация агентно-ориентированных архитектур 427

Глава 13. Реализация технологии “классной доски”

с использованием pvm-средств, потоков

и компонентов C++ 463

Приложение А 497

Приложение Б 507

Список литературы 657

Предметный указатель 660

СОДЕРЖАНИЕ

Введение 16

Этапы большого пути 17

Подход 18

Почему именно C++ 18

Библиотеки для параллельного и распределенного программирования 19

Новый единый стандарт спецификаций UNIX 19

Для кого написана эта книга 19

Среды разработки 20

Дополнительный материал 20

Глава 1. Преимущества паралельного программирования 23

1.1. Что такое параллелизм 25

1.1.1. Два основных подхода к достижению параллельности 26

1-2. Преимущества параллельного программирования 28

1.2.1. Простейшая модель параллельного программирования (PRAM) 29

1.2.2. Простейшая классификация схем параллелизма 30

1-3. Преимущества распределенного программирования 31

1.3.1. Простейшие модели распределенного программирования 32

1.3.2. Мультиагентные распределенные системы 32

1-4. Минимальные требования 33

1.4.1. Декомпозиция 33

1.4.2. Связь 34

1.4.3. Синхронизация 34

1 -5. Базовые уровни программного параллелизма 34

1.5.1. Параллелизм на уровне инструкций 34

1.5.2. Параллелизм на уровне подпрограмм 35

8 Содержание

1.5.3. Параллелизм на уровне объектов 35

1.5.4. Параллелизм на уровне приложений 35

1.6. Отсутствие языковой поддержки параллелизма в C++ 36

1.6.1. Варианты реализации параллелизма с помощью C++ 36

1.6.2. Стандарт MPI 37

1.6.3. Pvm: стандарт для кластерного программирования 38

1.6.4. Стандарт CORBA 38

1.6.5. Реализации библиотек на основе стандартов 39

1.7. Среды для параллельного и распределенного программирования 40

1.8. Резюме 40

Глава 2. Проблемы параллельного и распределенного

программирования 42

2.1. Кардинальное изменение парадигмы 44

2.2. Проблемы координации 44

2.3. Отказы оборудования и поведение ПО 51

2.4. Негативные последствия излишнего параллелизма и распределения 52

2.5. Выбор архитектуры 53

2.6. Различные методы тестирования и отладки 54

2.7. Связь между параллельным и распределенным проектами 55

2.8. Резюме 56

Глава 3. Разбиение С++-программ на множество задач 57

3.1. Определение процесса 58

3.1.1. Два вида процессов 59

3.1.2. Блок управления процессами 59

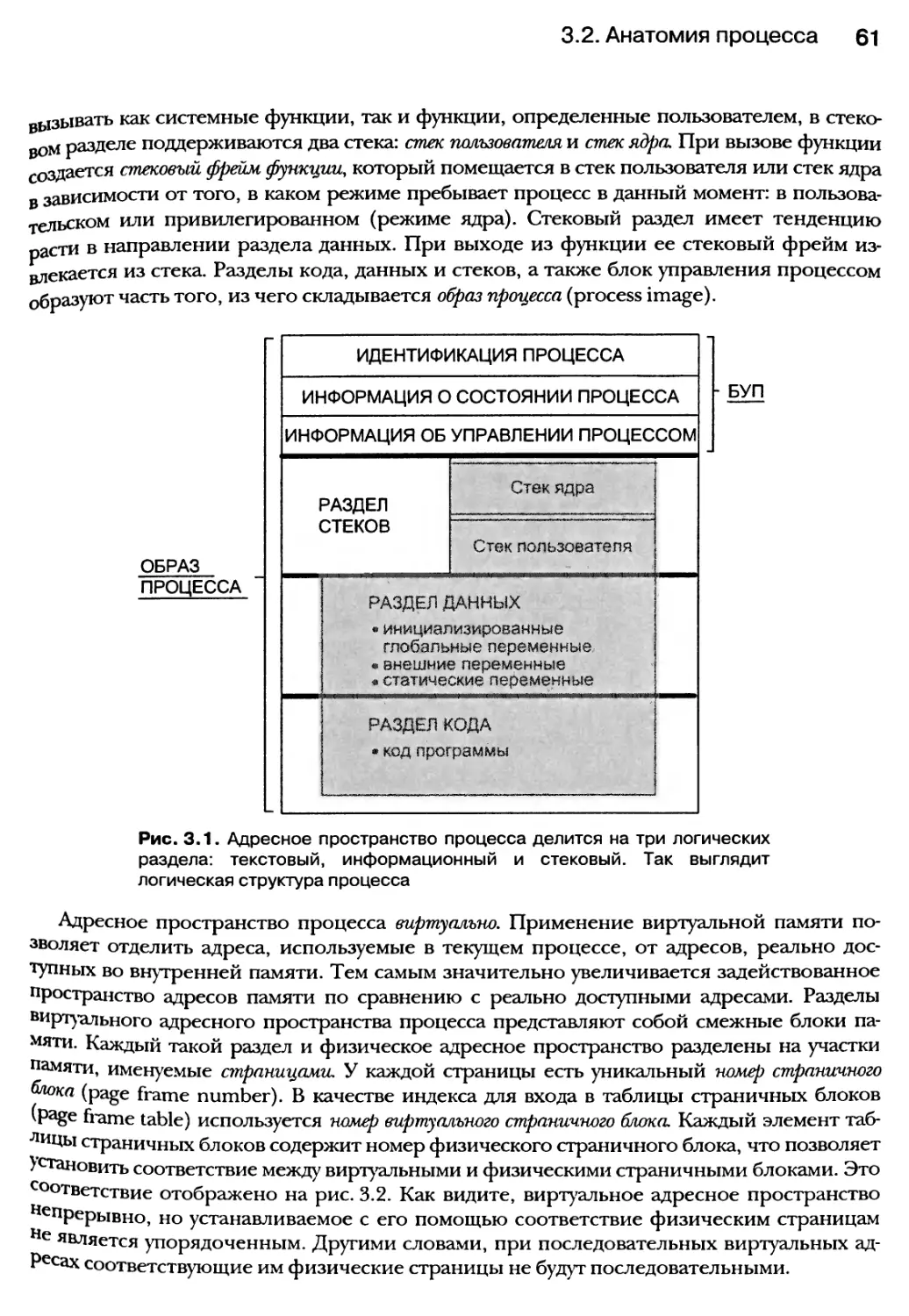

3.2. Анатомия процесса 60

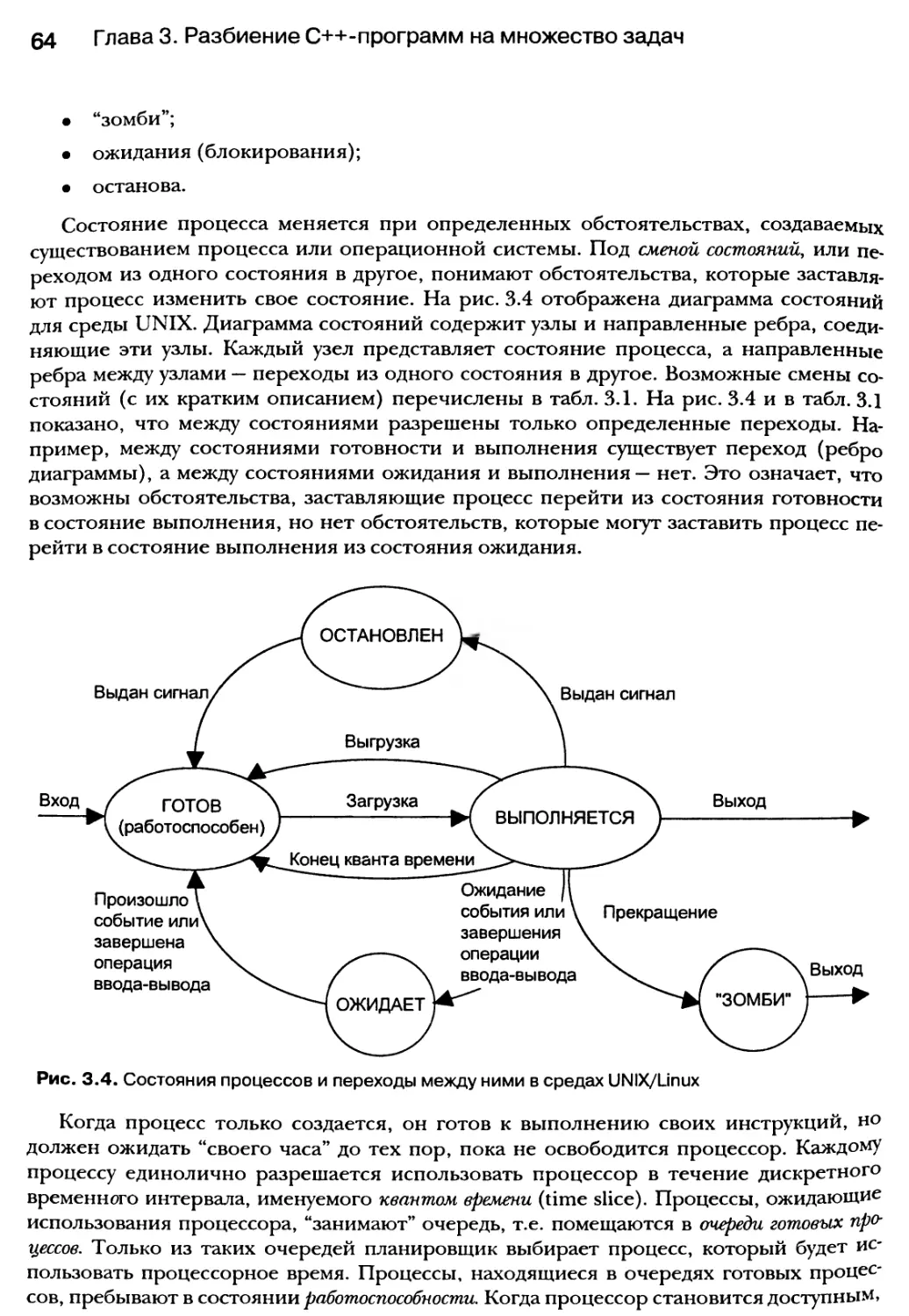

3.3. Состояния процессов 63

3.4. Планирование процессов 66

3.4.1. Стратегия планирования 67

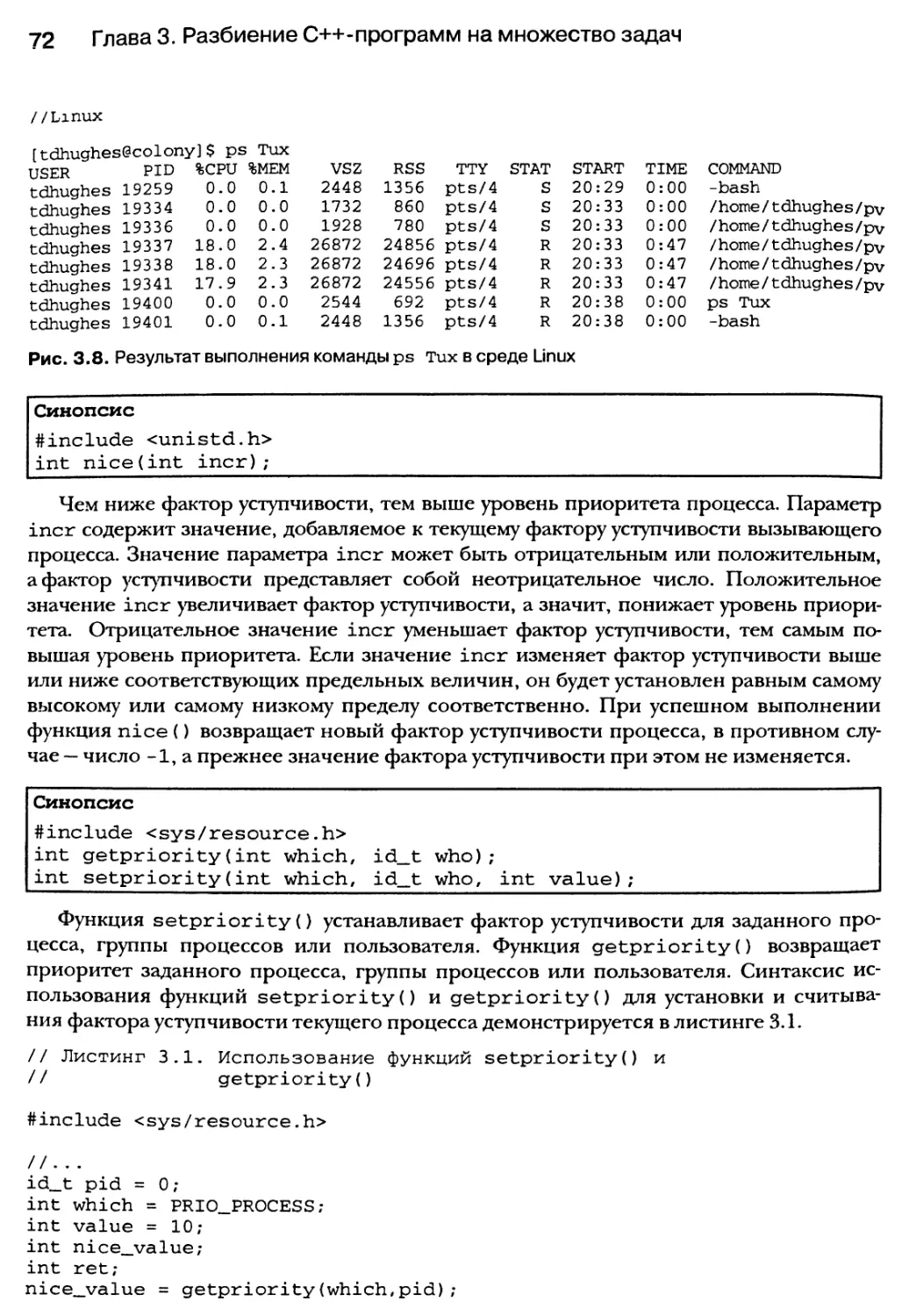

3.4.2. Использование утилиты PS 69

3.4.3. Установка и получение приоритета процесса 71

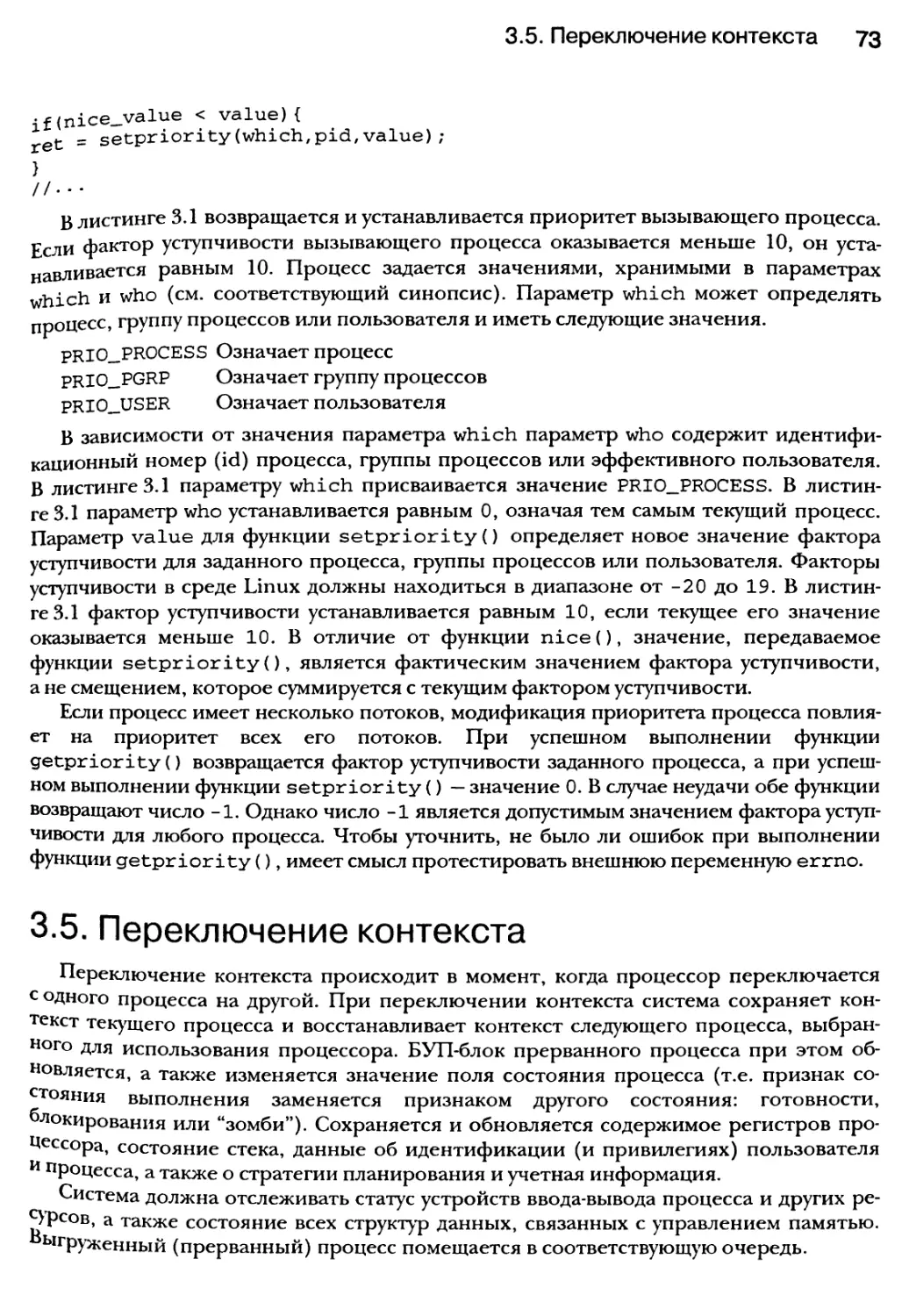

3.5. Переключение контекста 73

3.6. Создание процесса 74

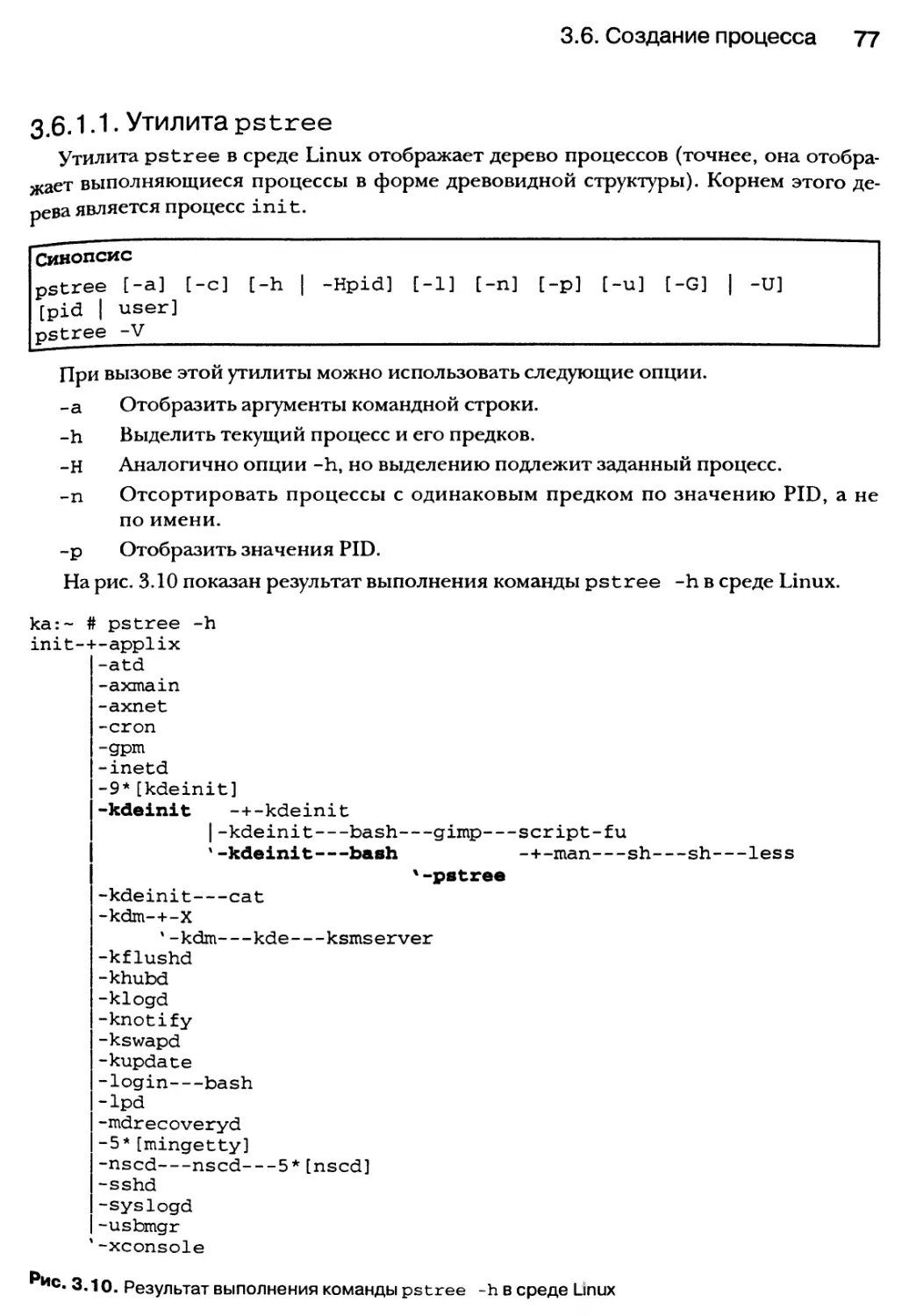

3.6.1. Отношения между родительскими и сыновними процессами 74

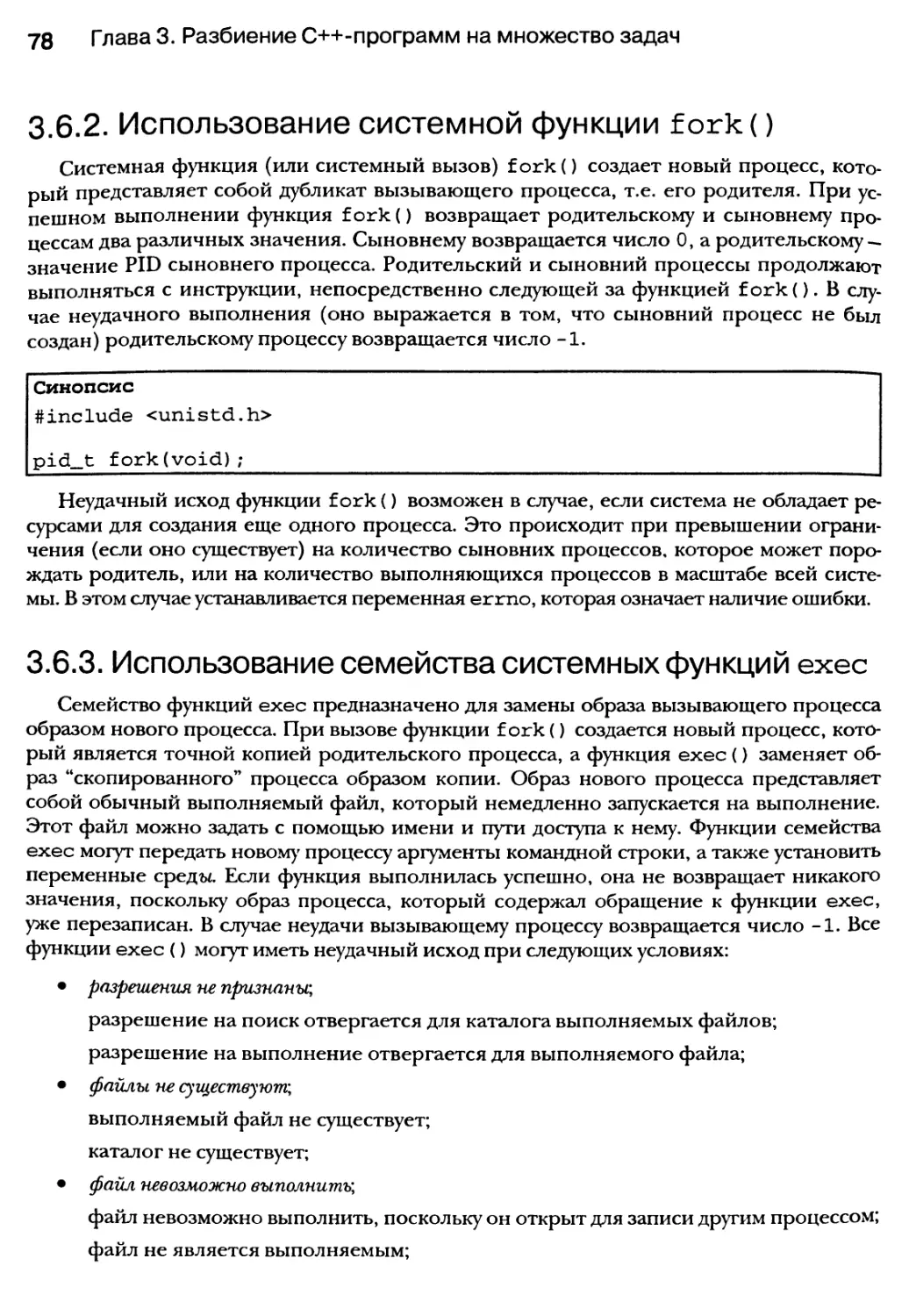

3.6.2. Использование системной функции fork() 78

3.6.3. Использование семейства системных функций ехес 78

3.6.4. Использование функции system() для порождения процессов 83

3.6.5. Использование posix-функций для порождения процессов 83

Содержание $

3.6.6. Идентификация родительских и сыновних процессов с помощью

функций управления процессами 8С

3.7. Завершение процесса 82

3.7.1. Функции exit(), kill() и abort() 9С

3.8. Ресурсы процессов 91

3.8.1. Типы ресурсов 93

3.8.2. Posix-функции для установки ограничений доступа к ресурсам 94

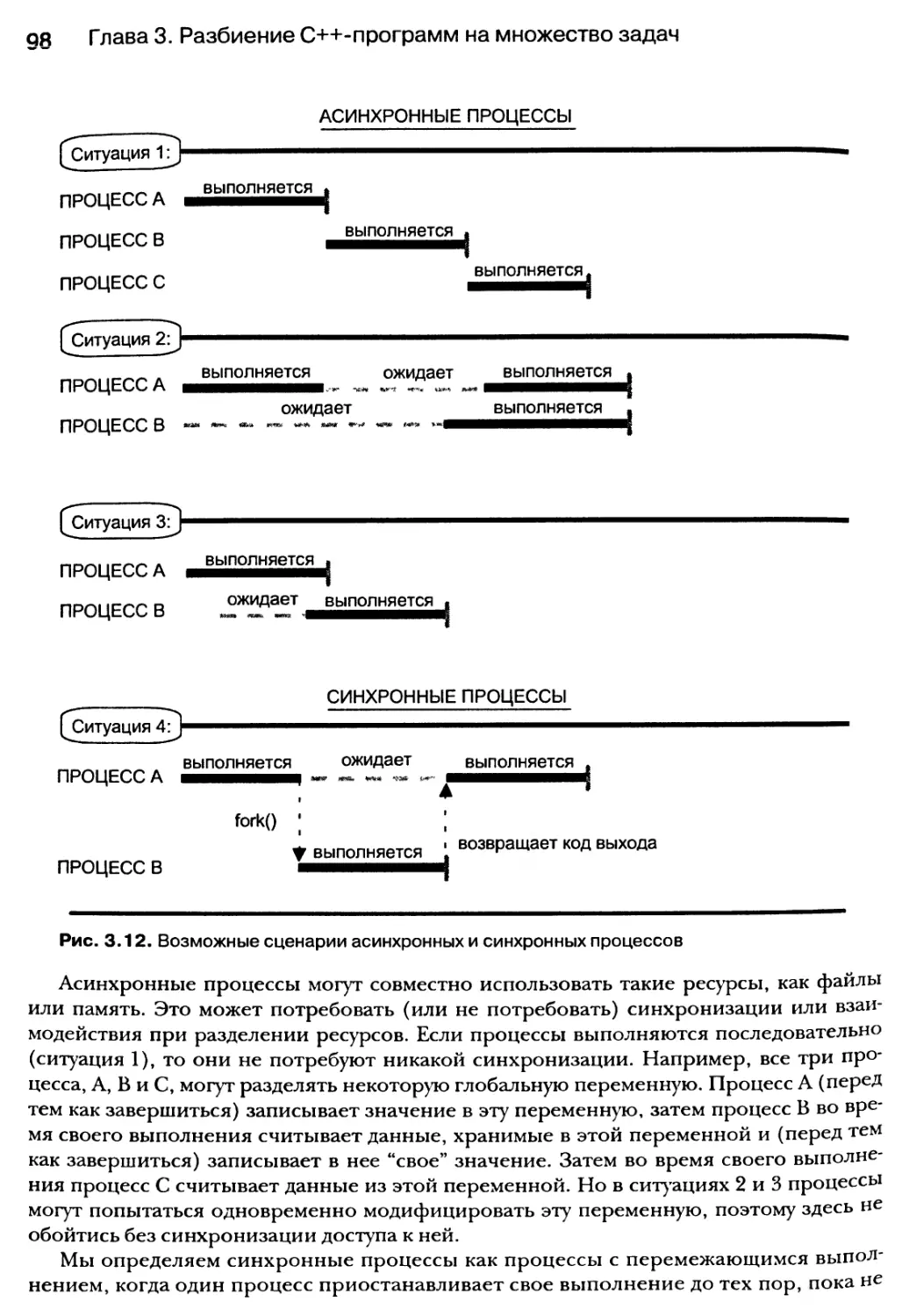

3.9. Асинхронные и синхронные процессы 97

3.9.1. Создание синхронных и асинхронных процессов с помощью

функций fork(), ехес(), system() и posix_spawn() 99

3.9.2. Функция wait() 99

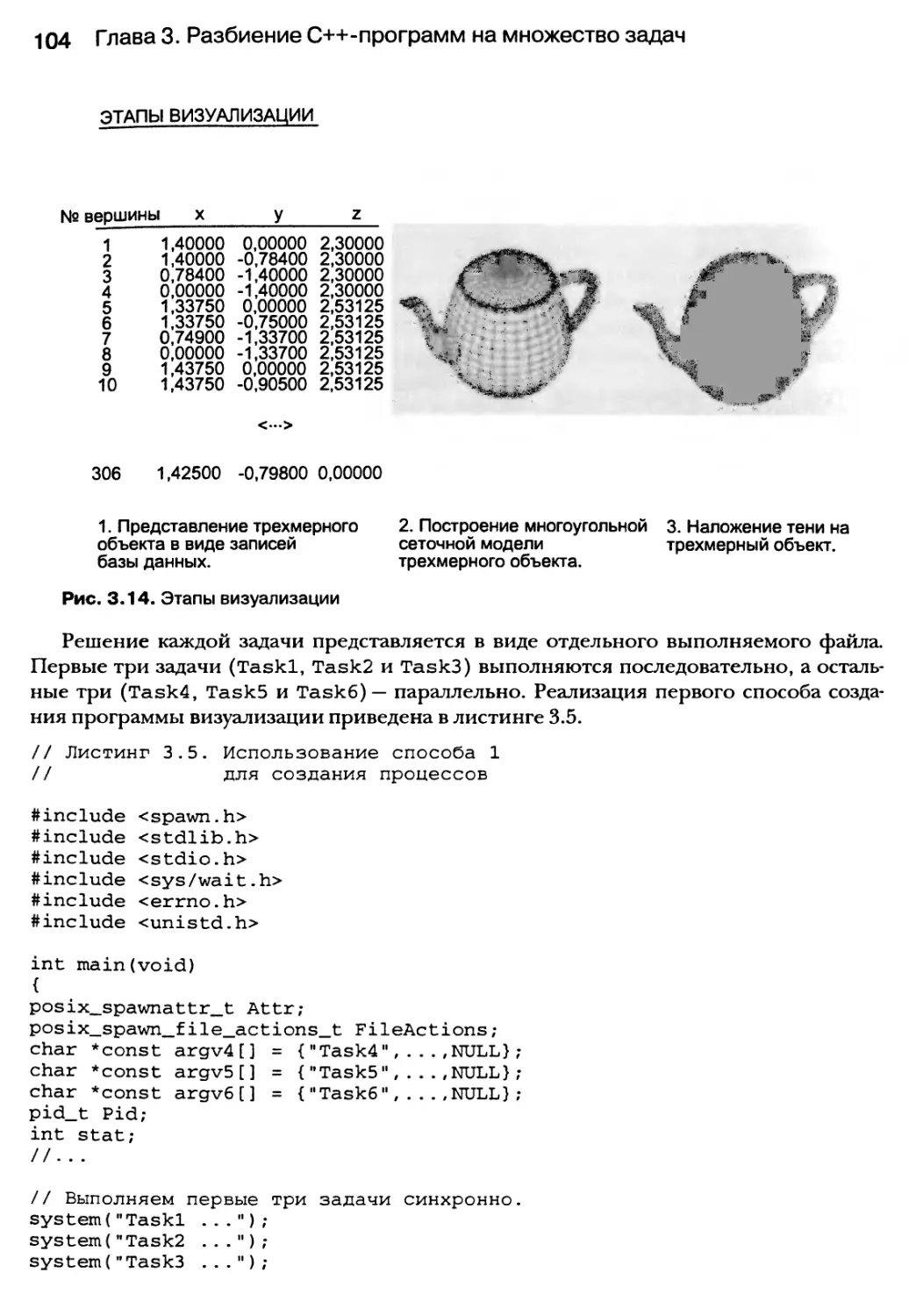

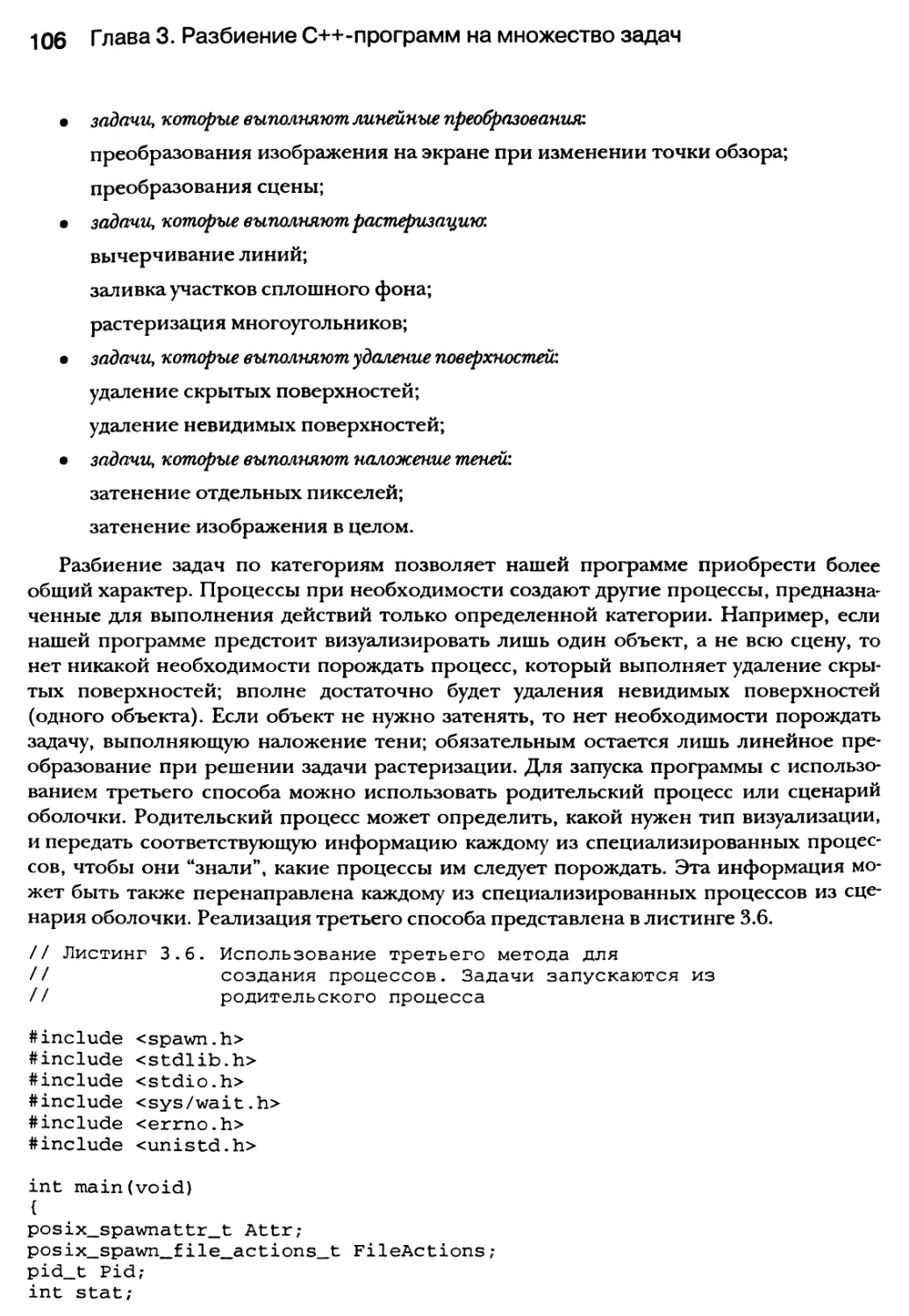

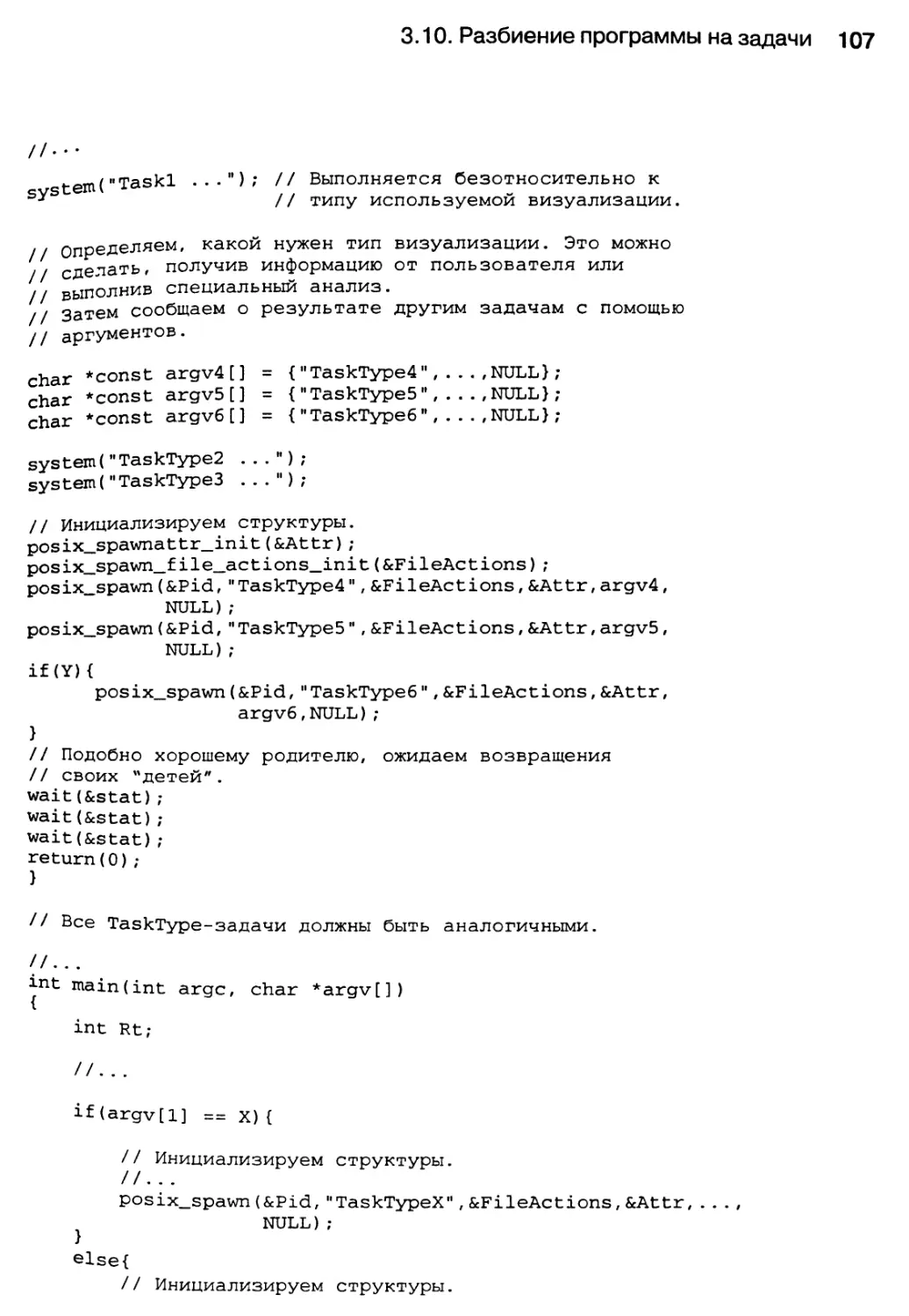

3.10. Разбиение программы на задачи 101

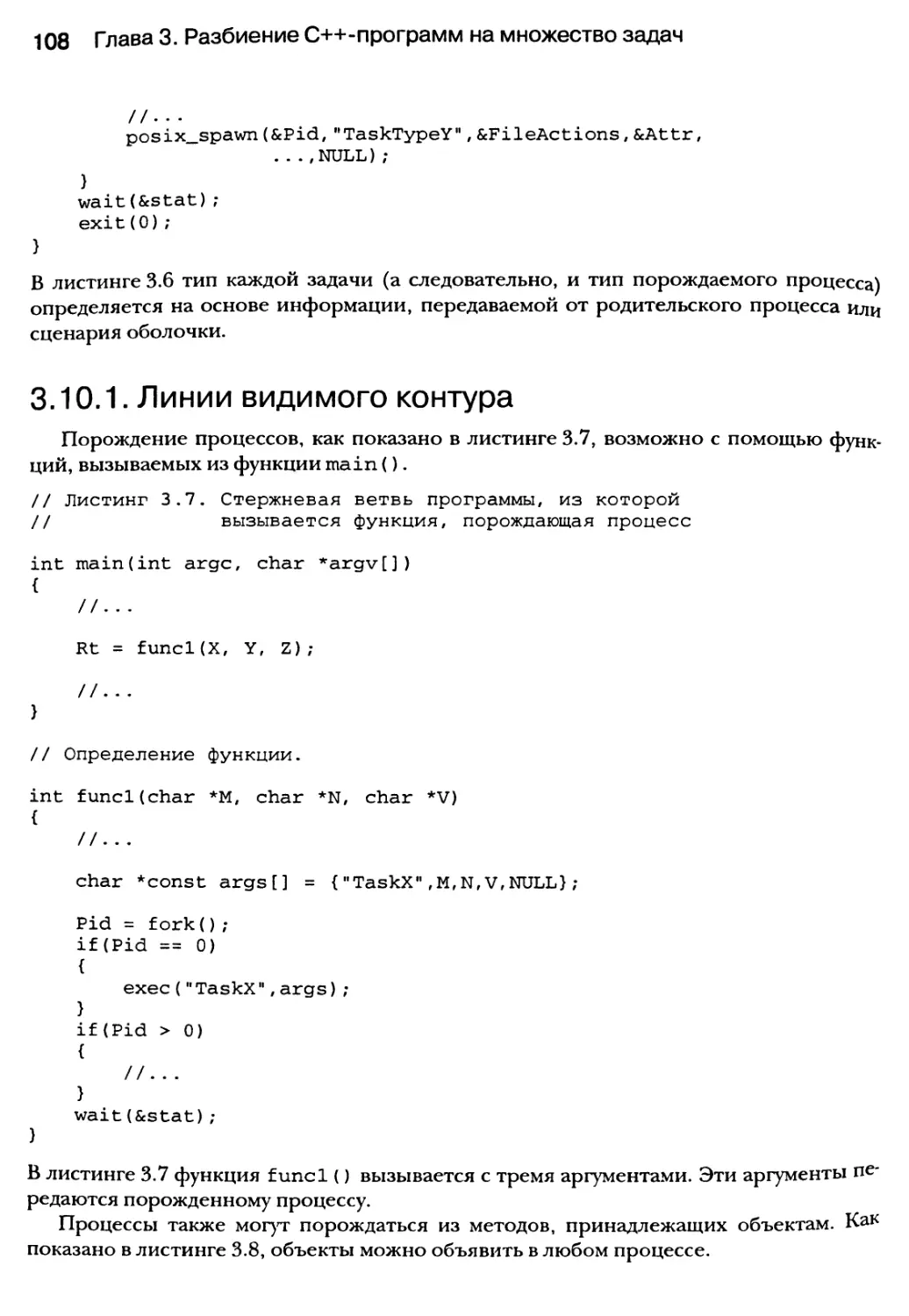

3.10.1. Линии видимого контура 108

3.11. Резюме 109

Глава 4. Разбиение С++-программ на множество

потоков 111

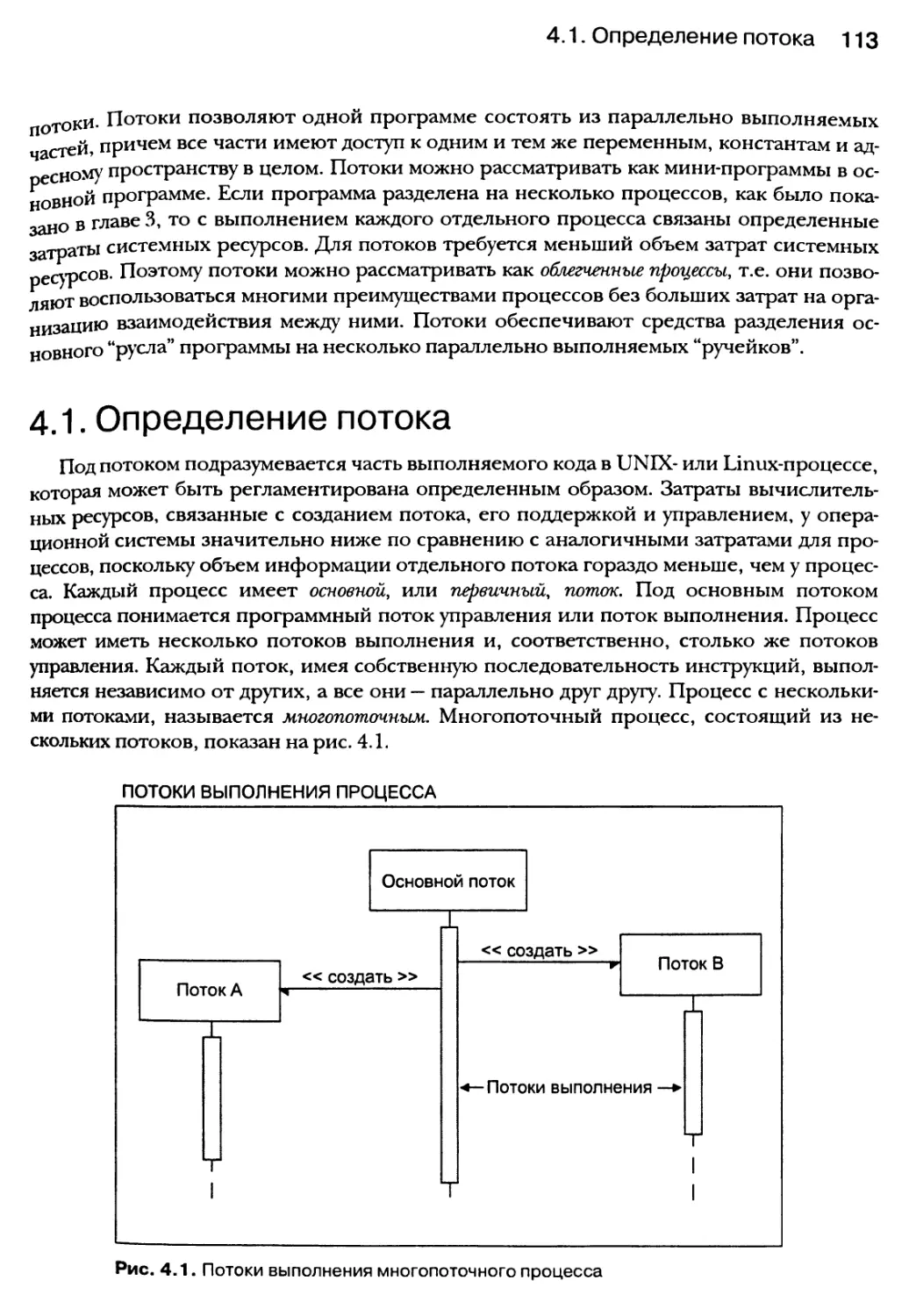

4.1. Определение потока 113

4.1.1. Контекстные требования потока 114

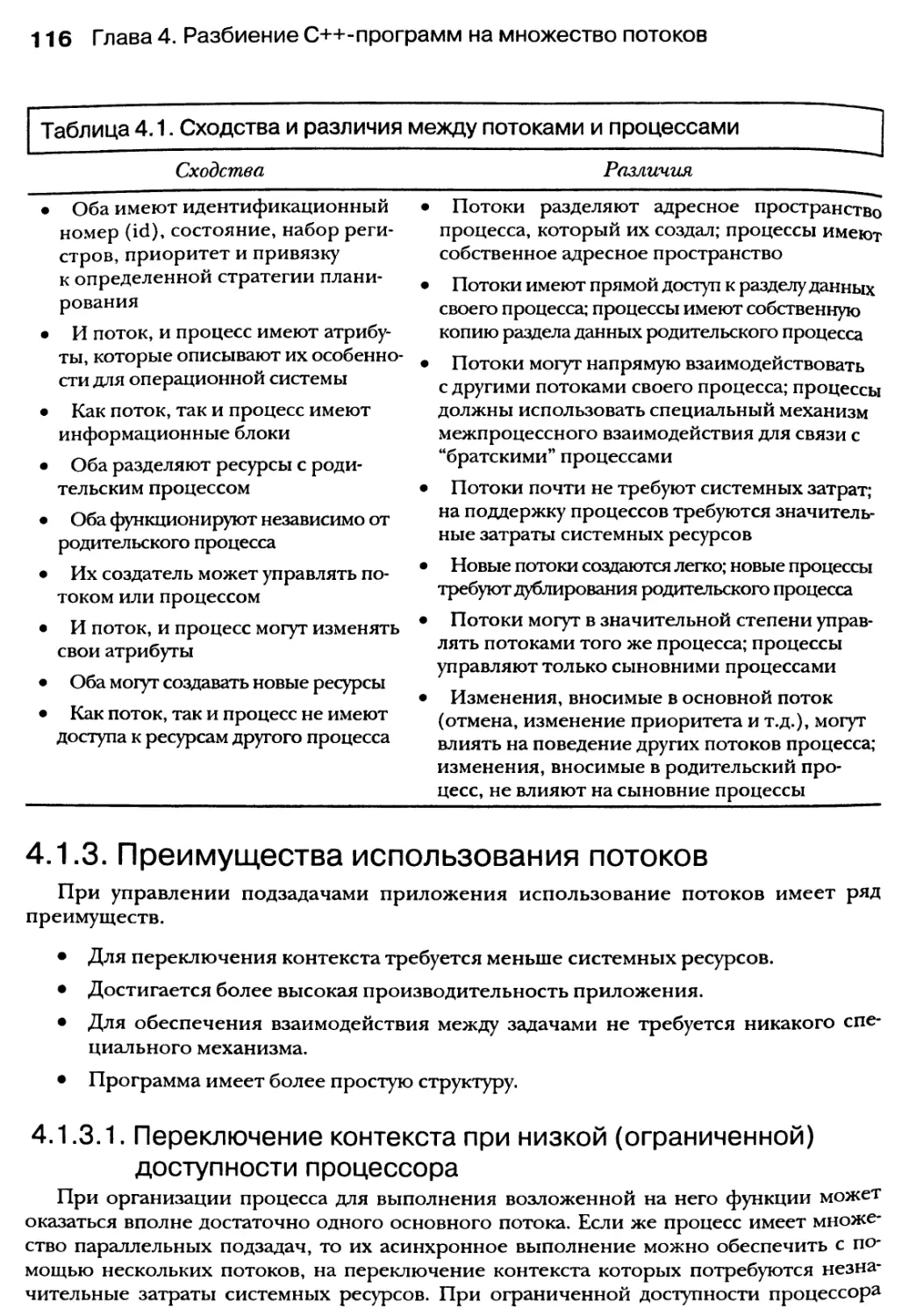

4.1.2. Сравнение потоков и процессов 115

4.1.3. Преимущества использования потоков 116

4.1.4. Недостатки использования потоков 117

4.2. Анатомия потока 119

4.2.1. Атрибуты потока 121

4.3. Планирование потоков 123

4.3.1. Состояния потоков 124

4.3.2. Планирование потоков и область конкуренции 125

4.3.3. Стратегия планирования и приоритет 125

4.4. Ресурсы потоков 128

4.5. Модели создания и функционирования потоков 129

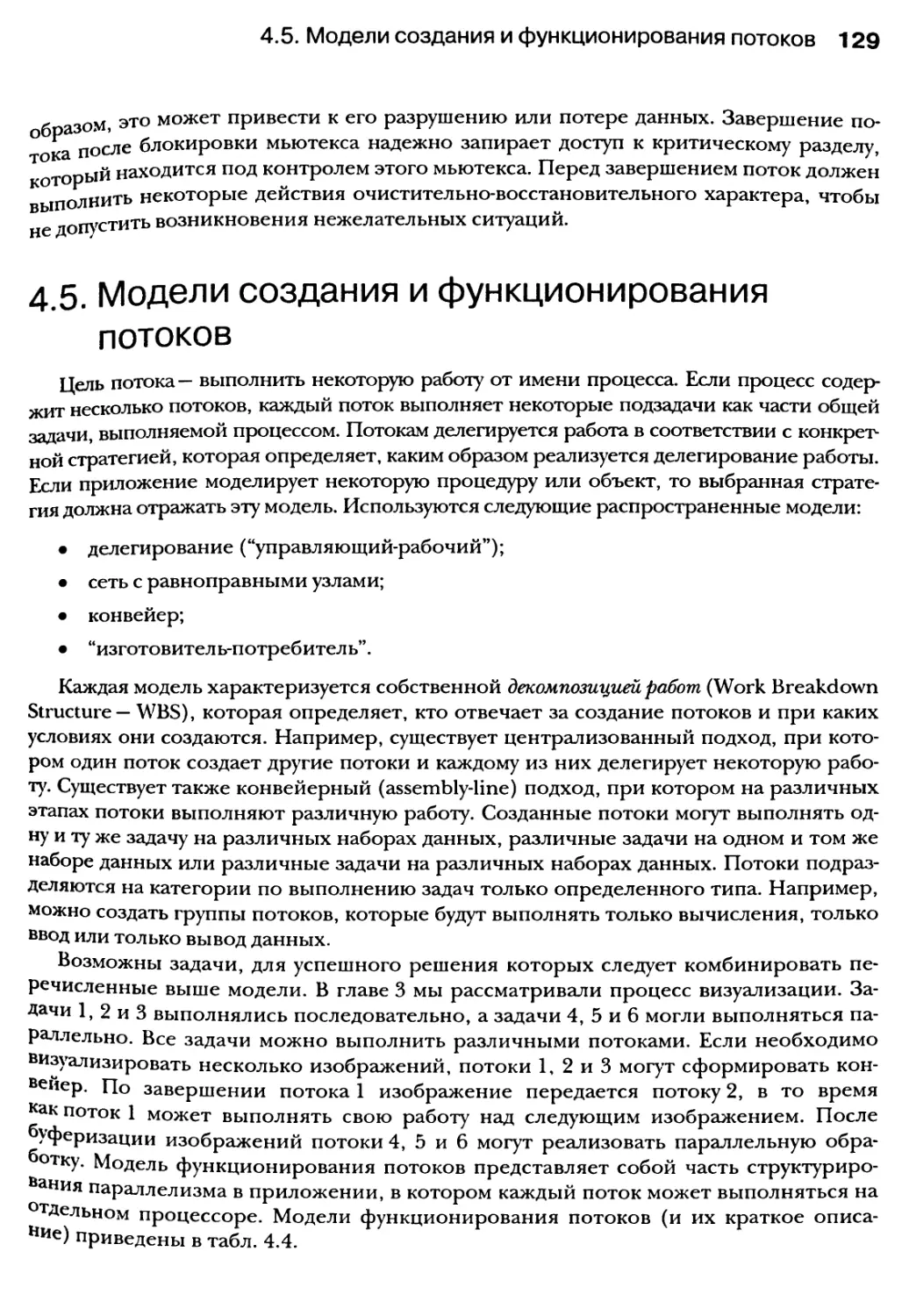

4.5.1. Модель делегирования 130

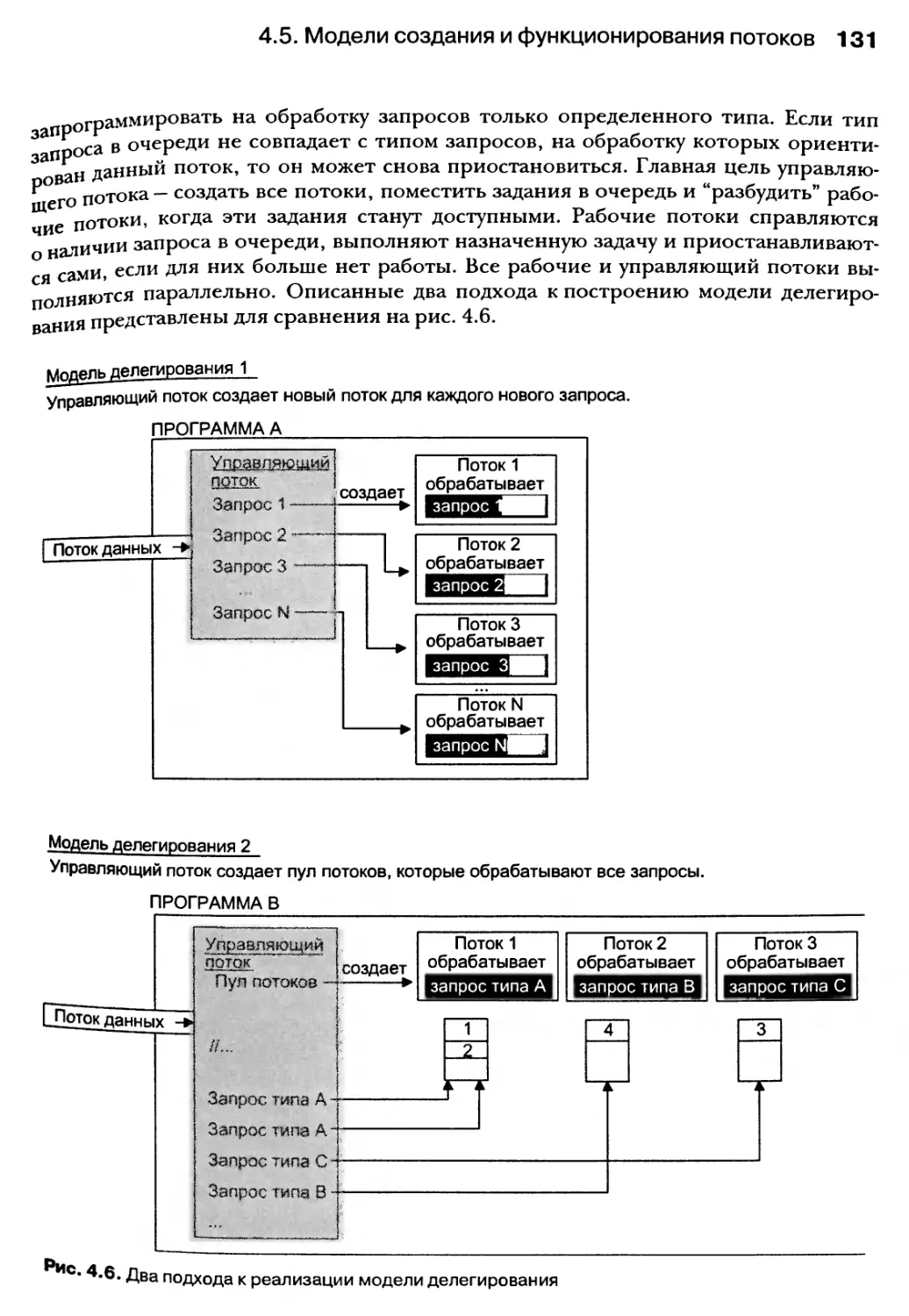

4.5.2. Модель с равноправными узлами 132

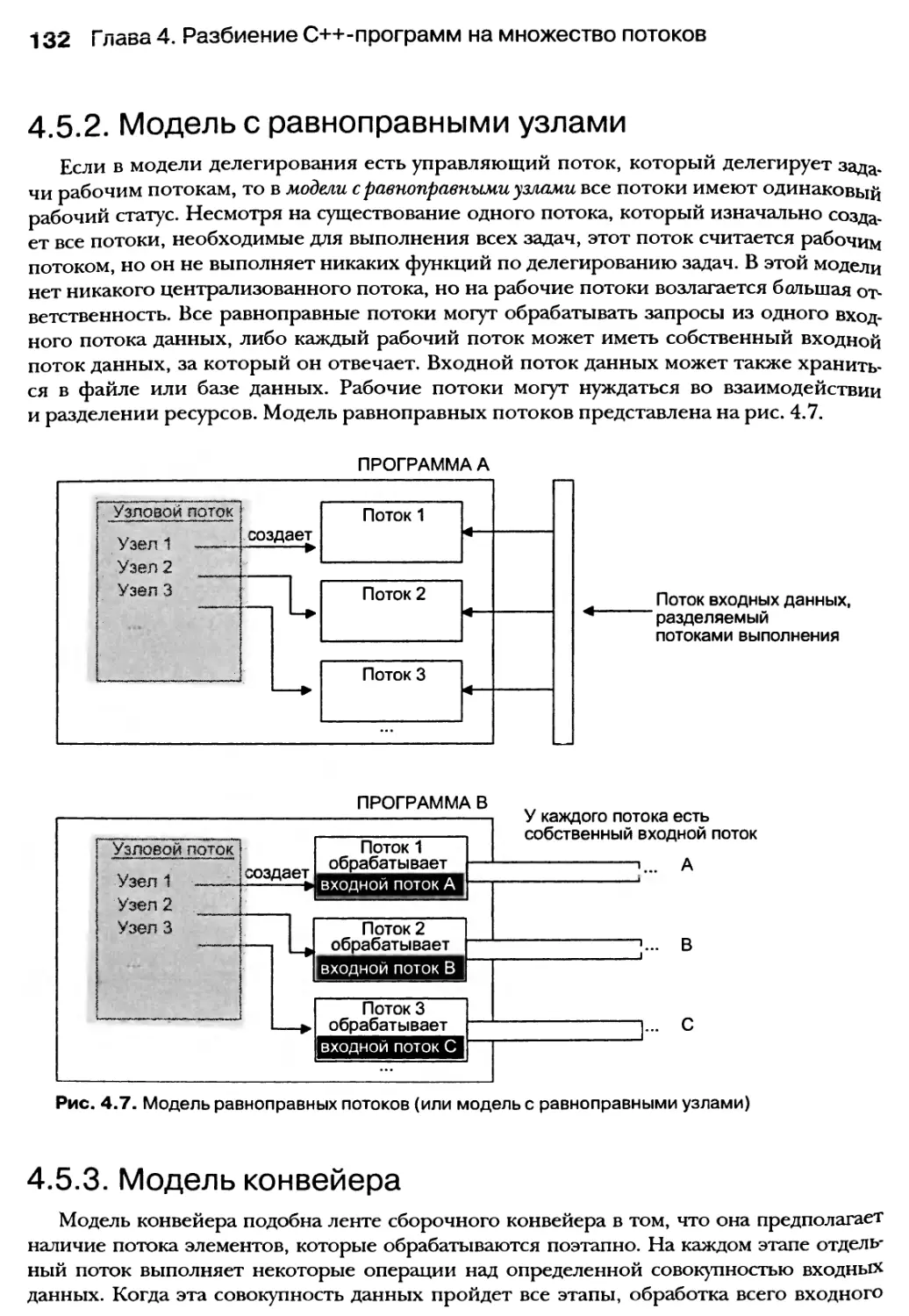

4.5.3. Модель конвейера 132

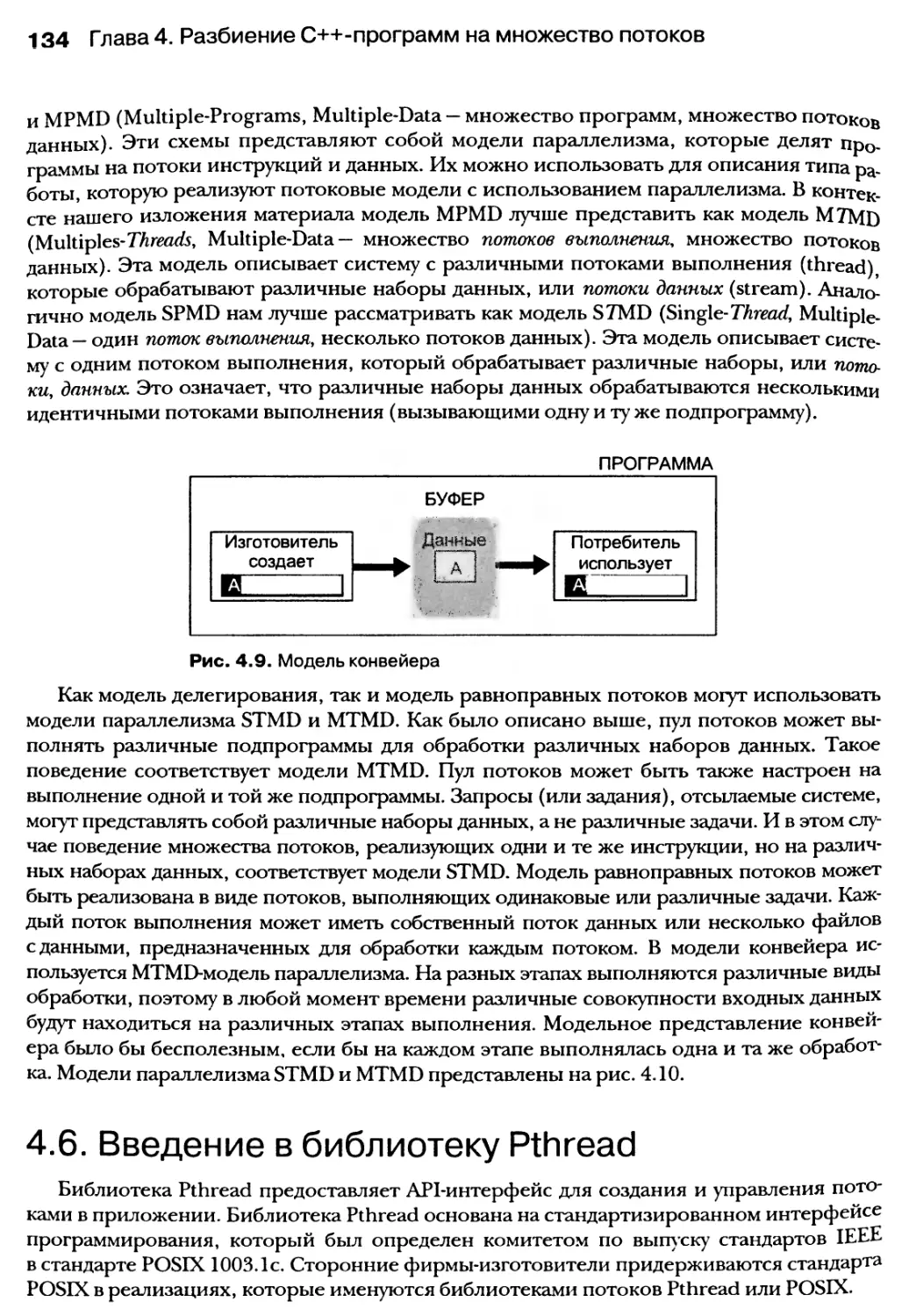

4.5.4. Модель “изготовитель-потребитель” 133

4.5.5. Модели SPMD и MPMD для потоков 133

4.6. Введение в библиотеку PTHREAD 134

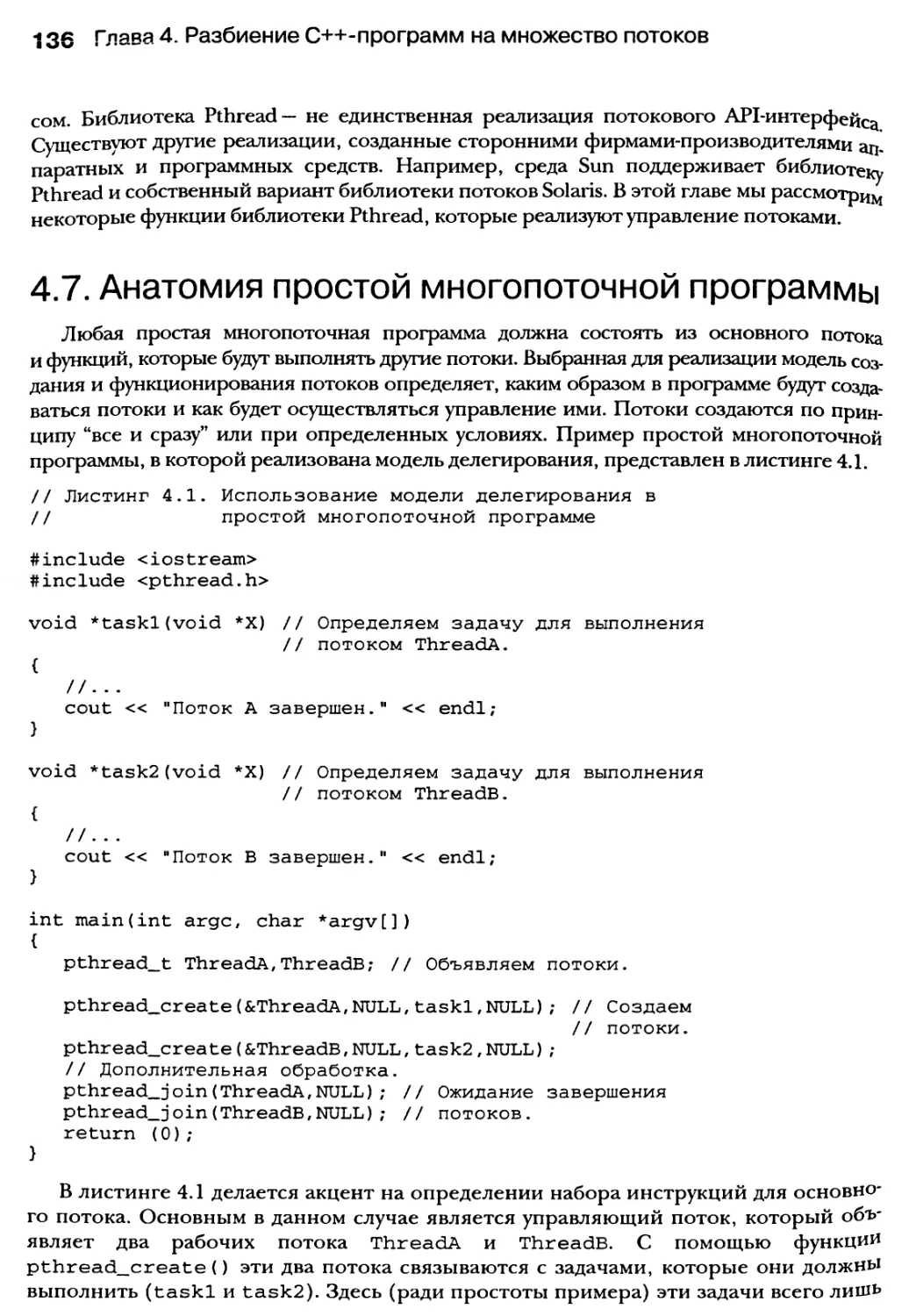

4.7. Анатомия простой многопоточной программы 136

4.7.1. Компиляция и компоновка многопоточных программ 137

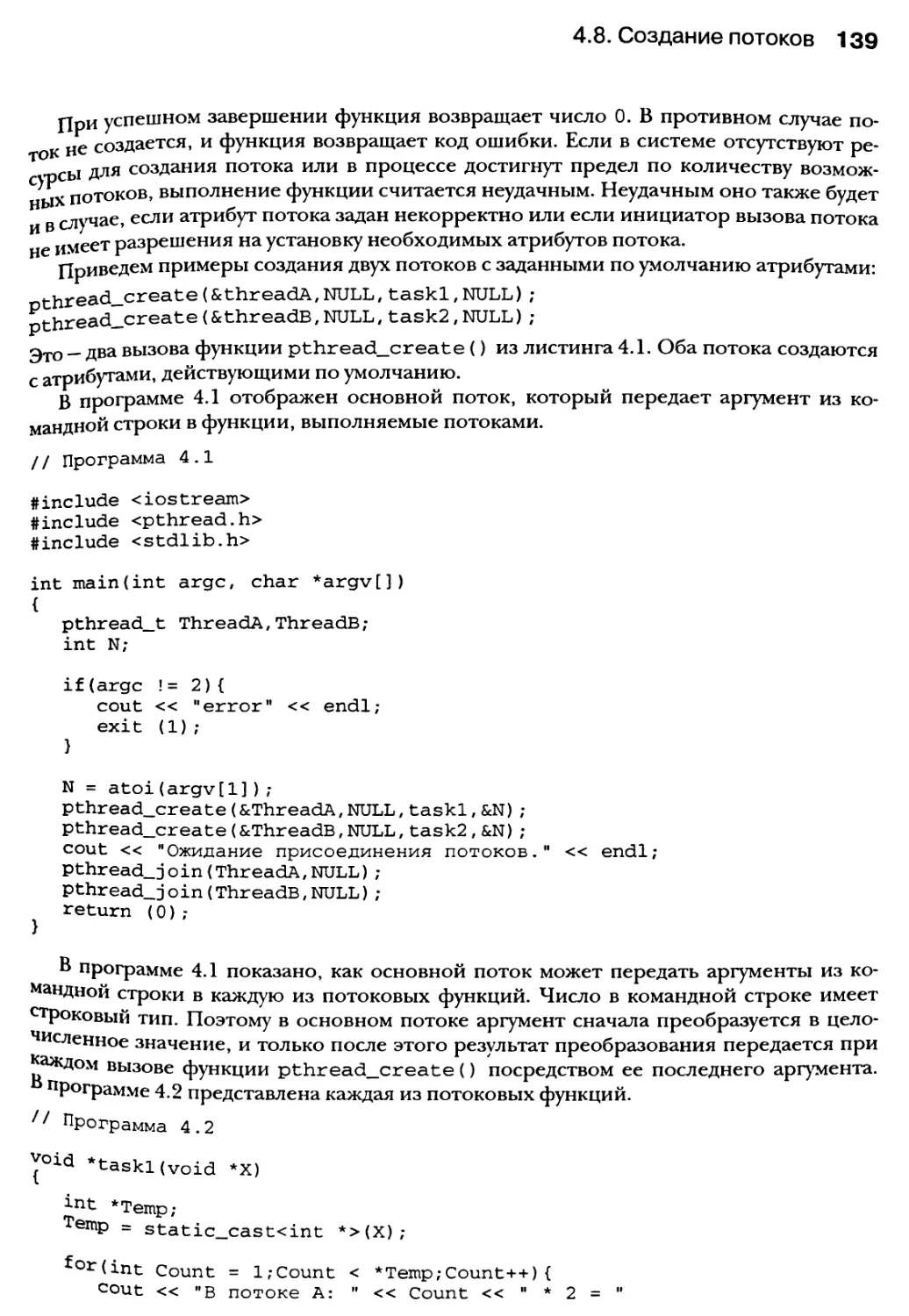

4.8. Создание потоков 138

4.8.1. Получение идентификатора потока 141

4.8.2. Присоединение потоков 141

10 Содержание

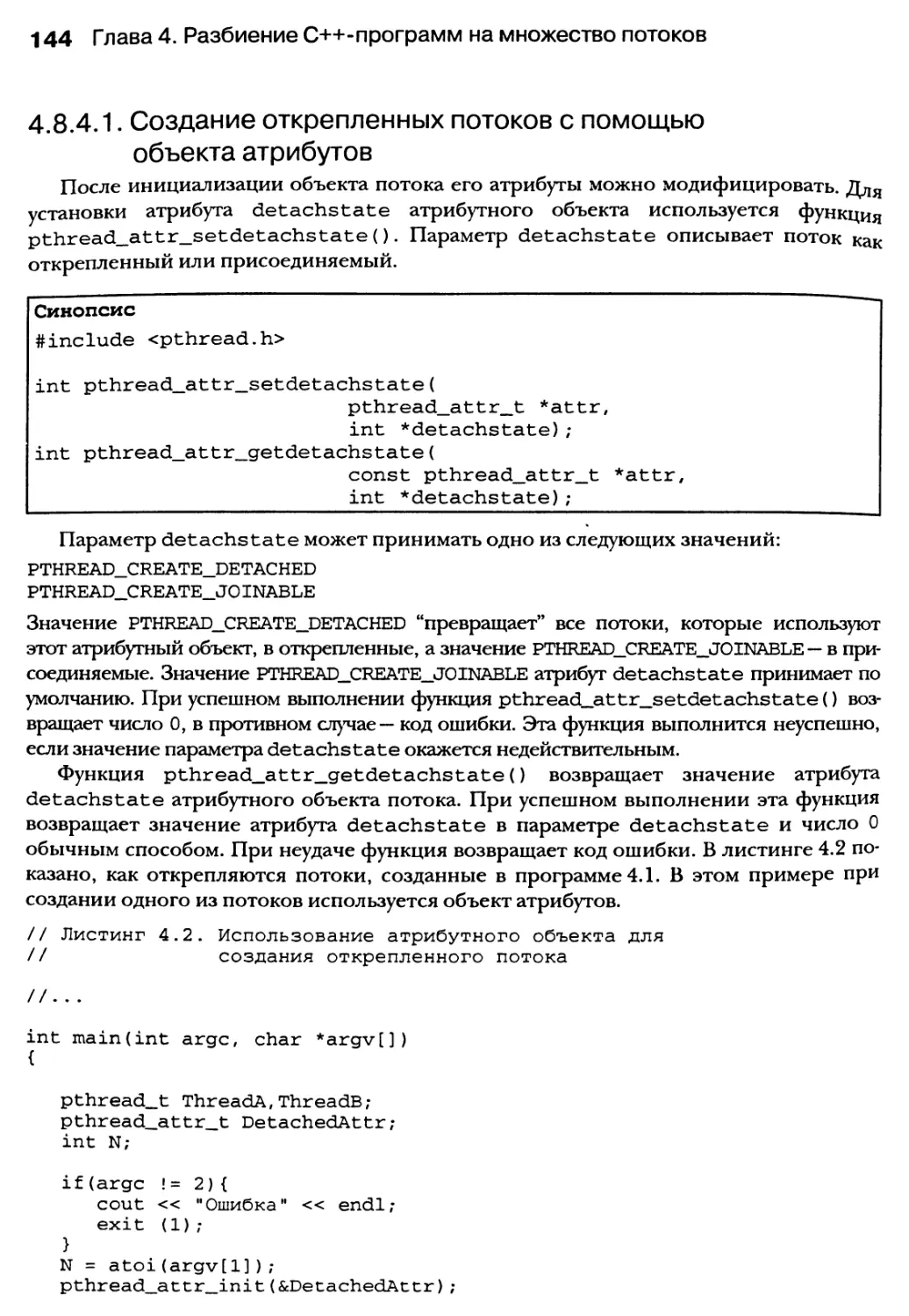

4.8.3. Создание открепленных потоков 142

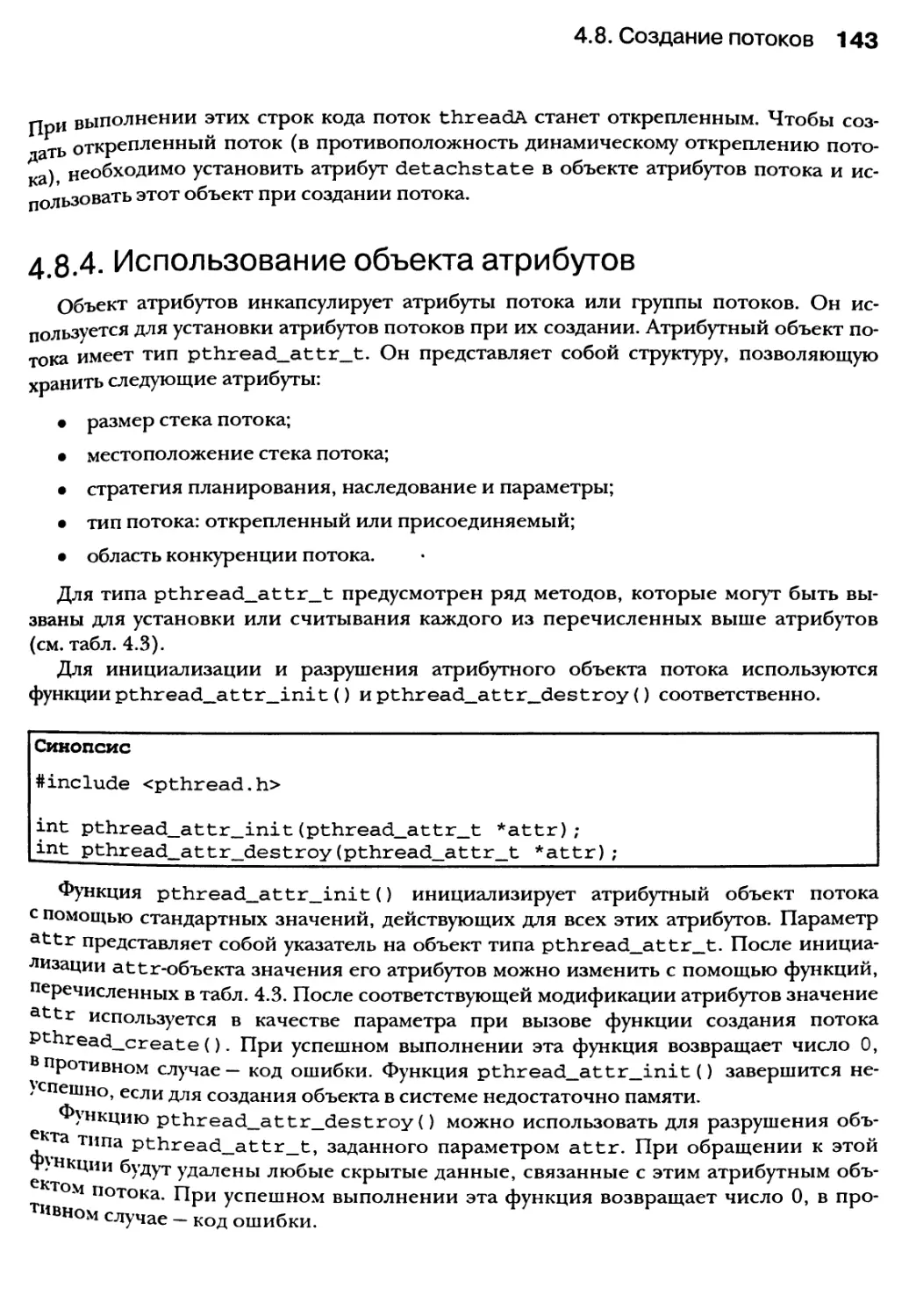

4.8.4. Использование объекта атрибутов 143

4.9. Управление потоками 145

4.9.1. Завершение потоков 145

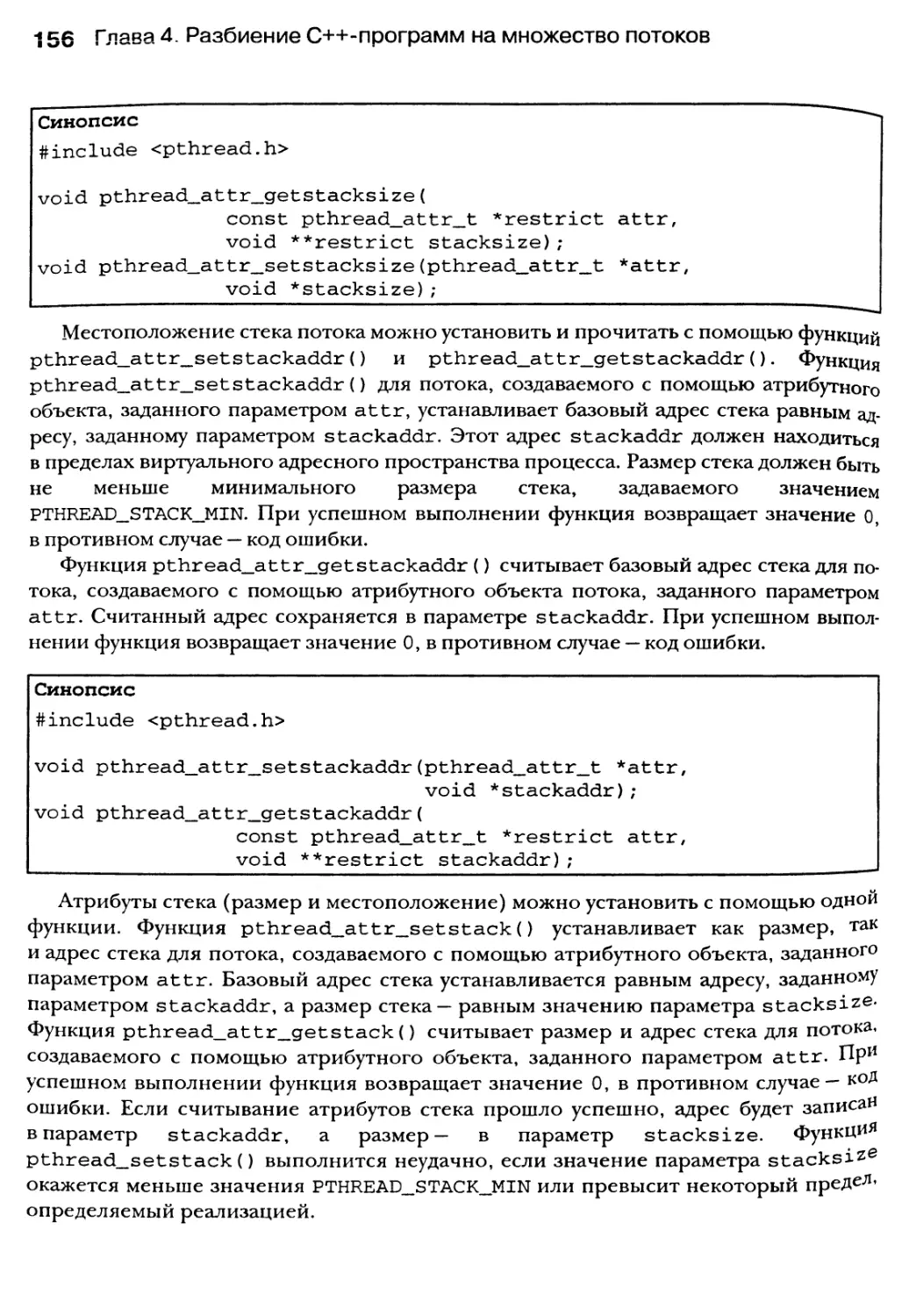

4.9.2. Управление стеком потока 154

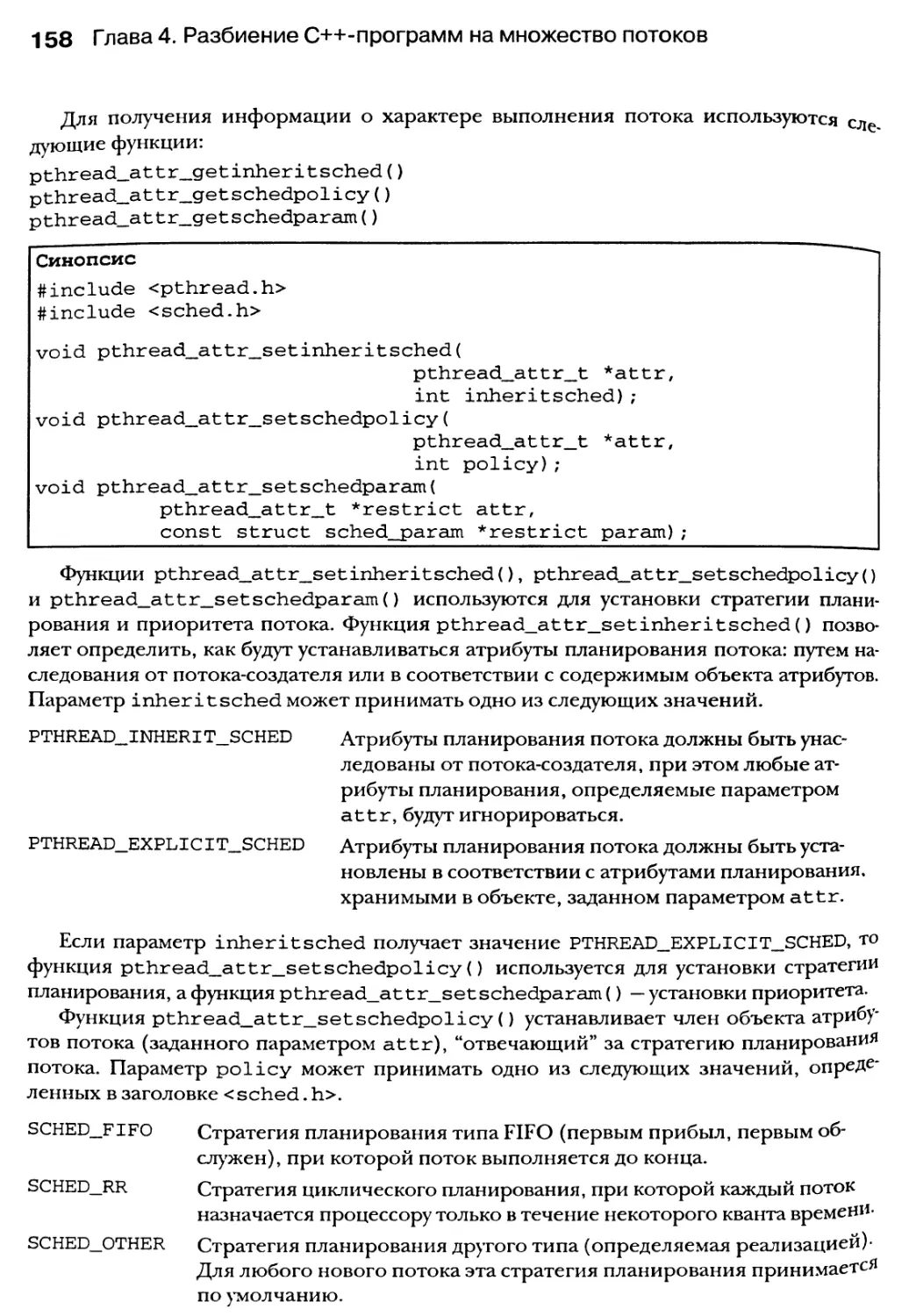

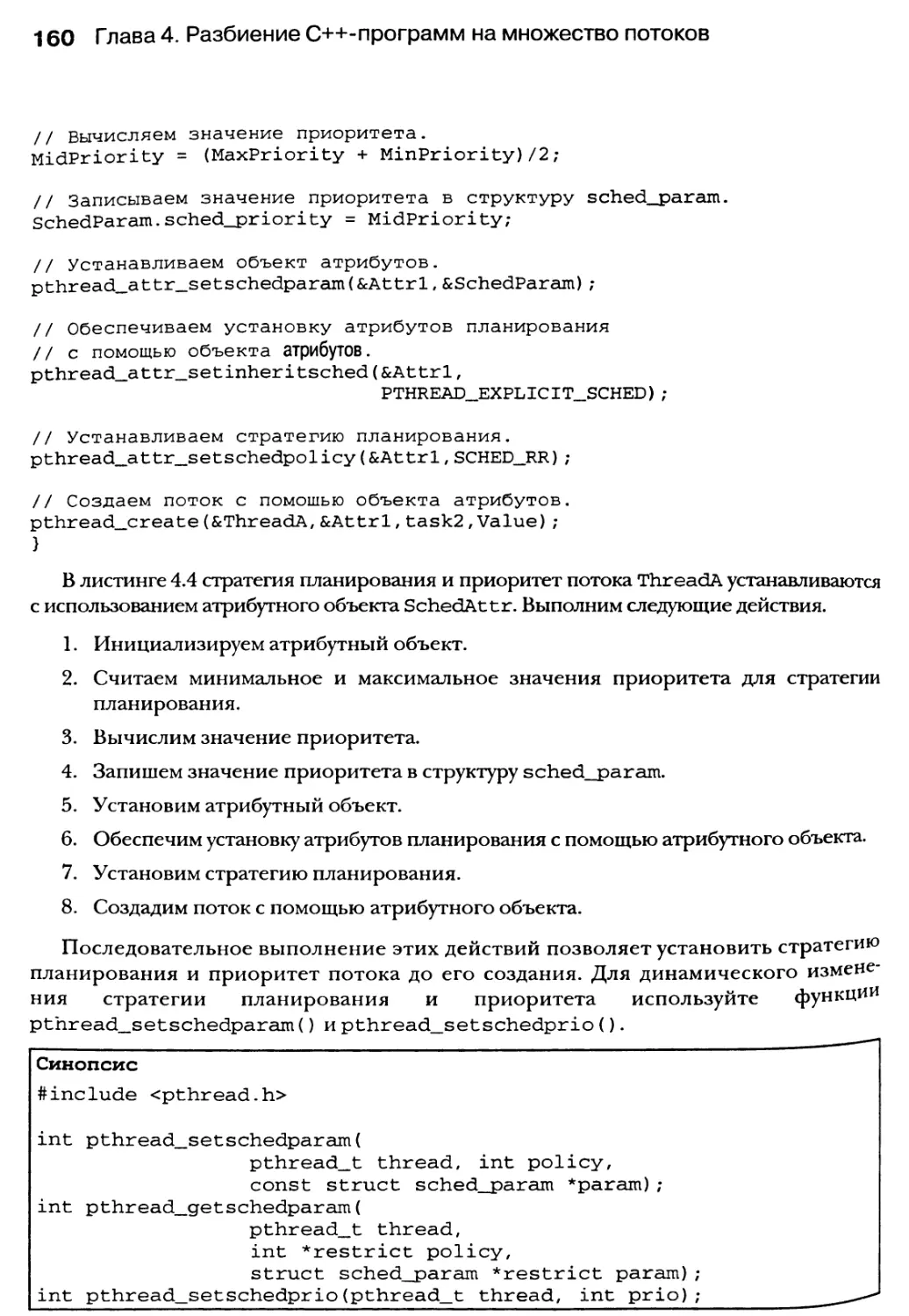

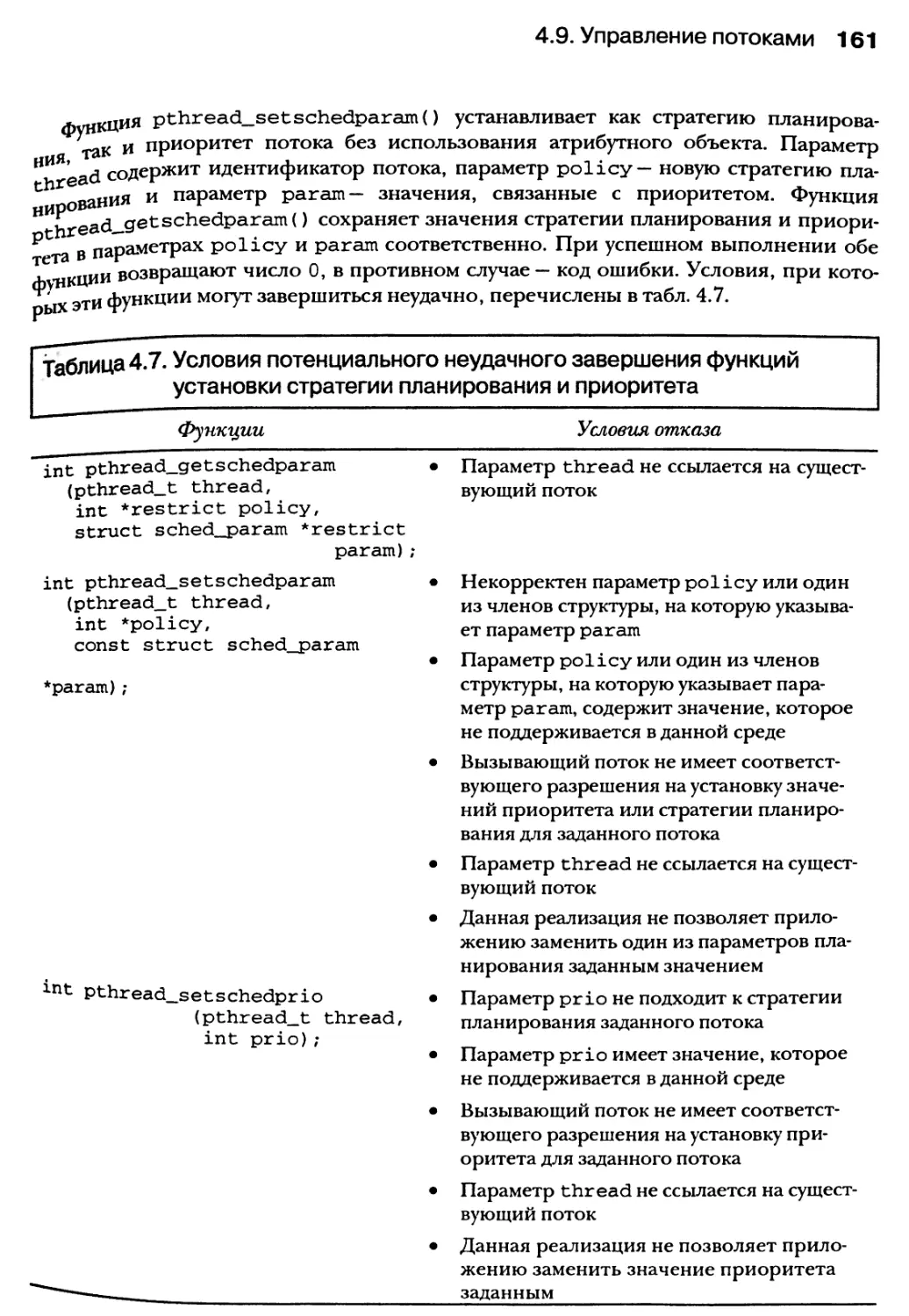

4.9.3. Установка атрибутов планирования и свойств потоков 157

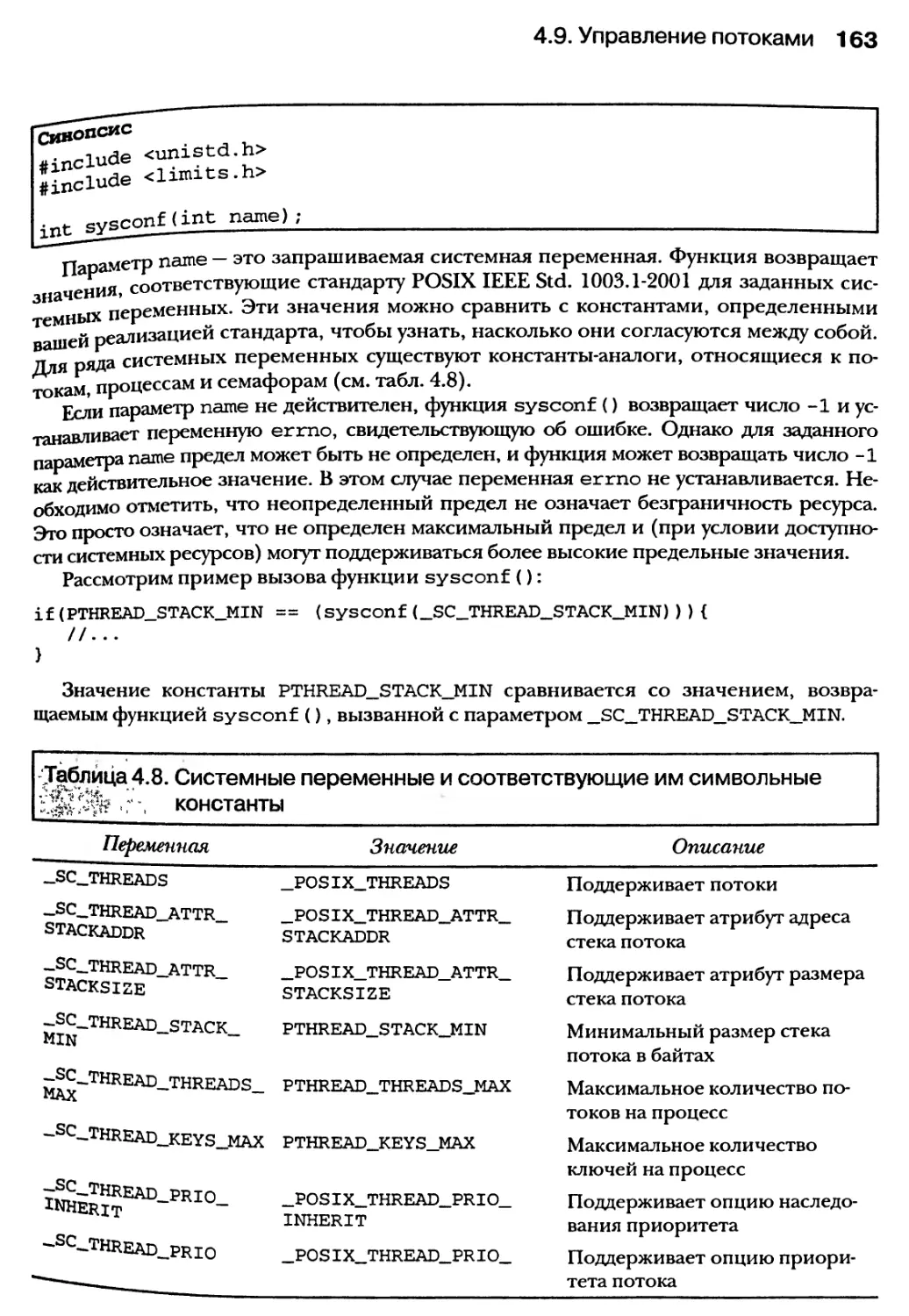

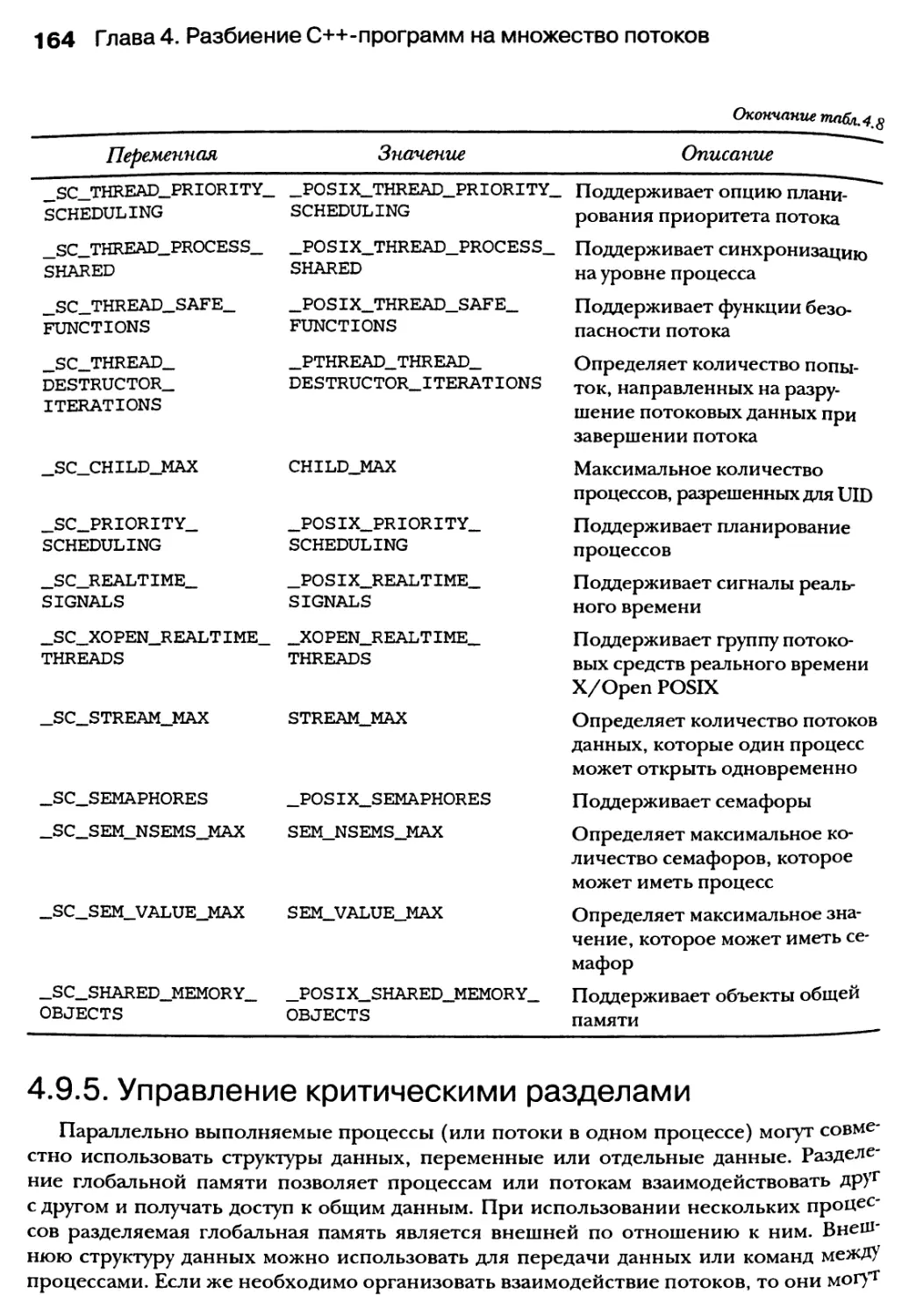

4.9.4. Использование функции sysconf() 162

4.9.5. Управление критическими разделами 164

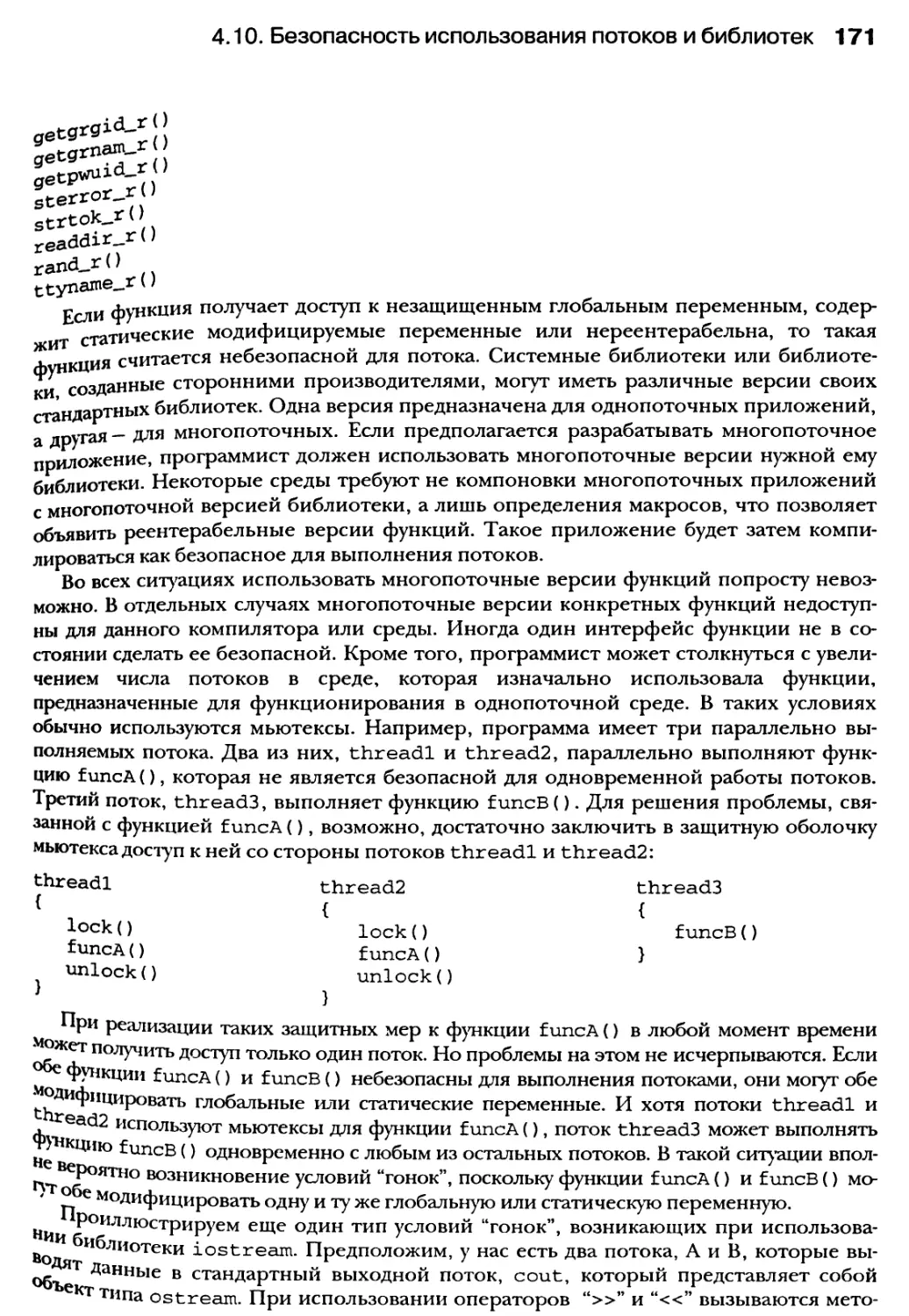

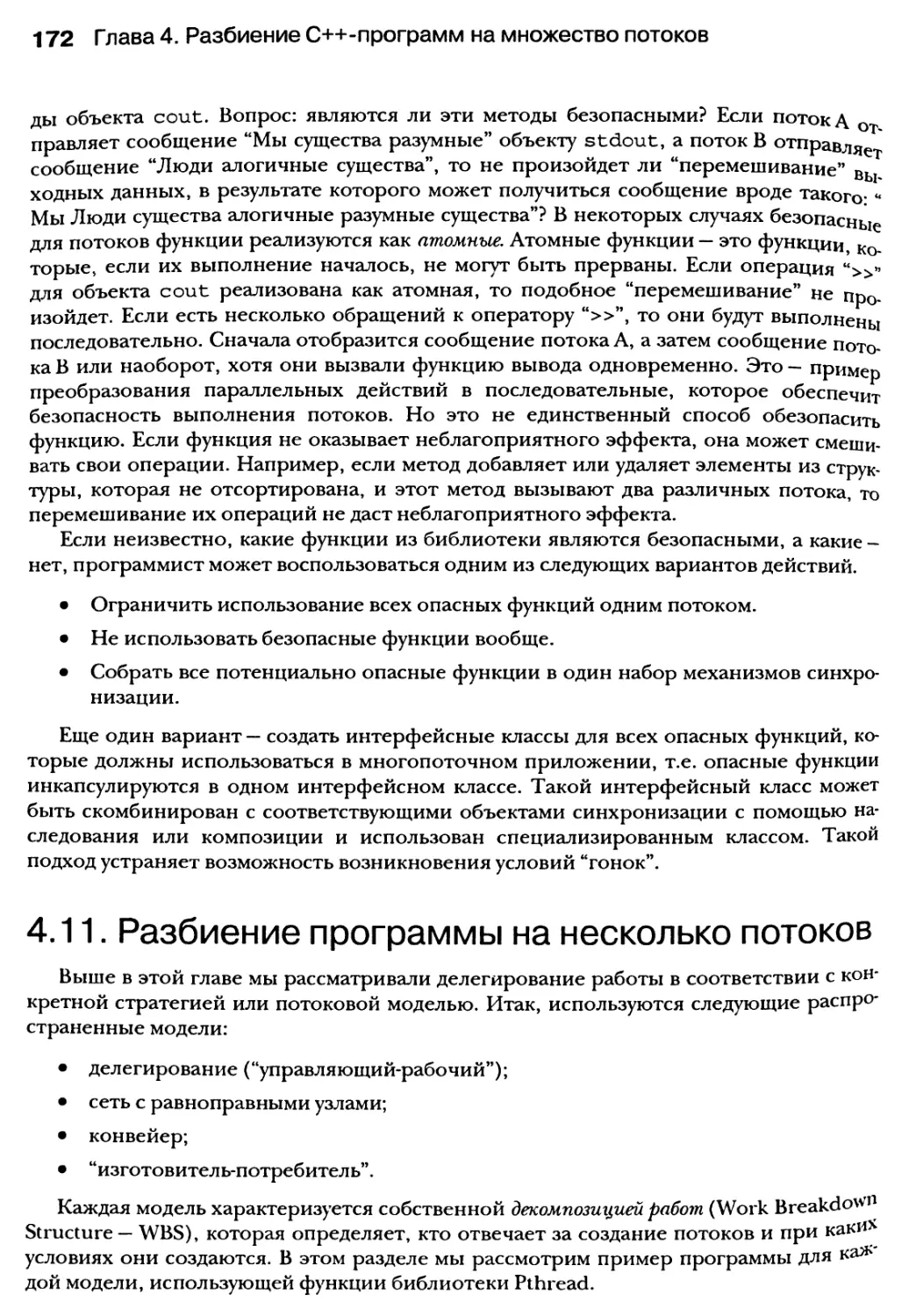

4.10. Безопасность использования потоков и библиотек 170

4.11. Разбиение программы на несколько потоков 172

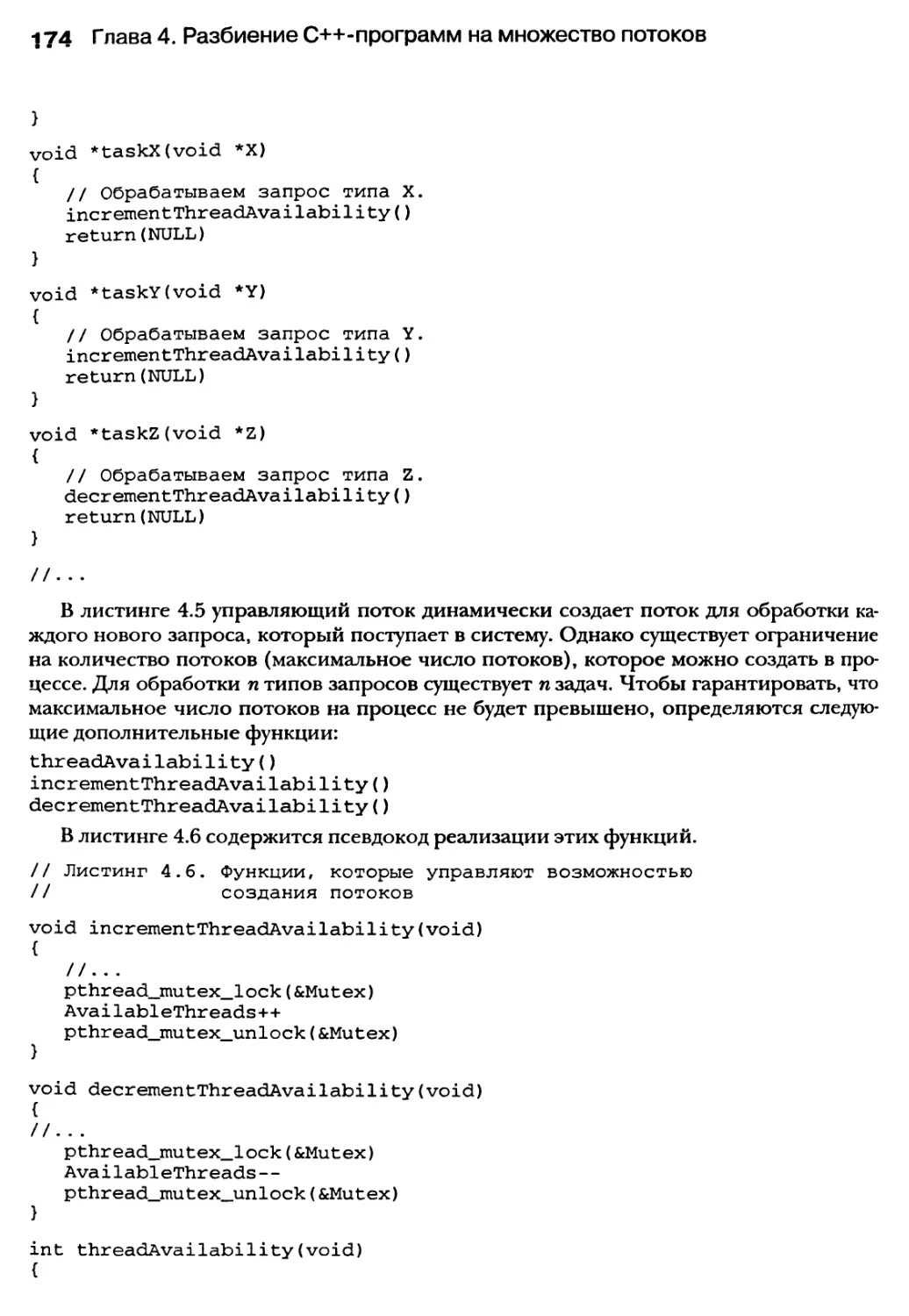

4.11.1. Использование модели делегирования 173

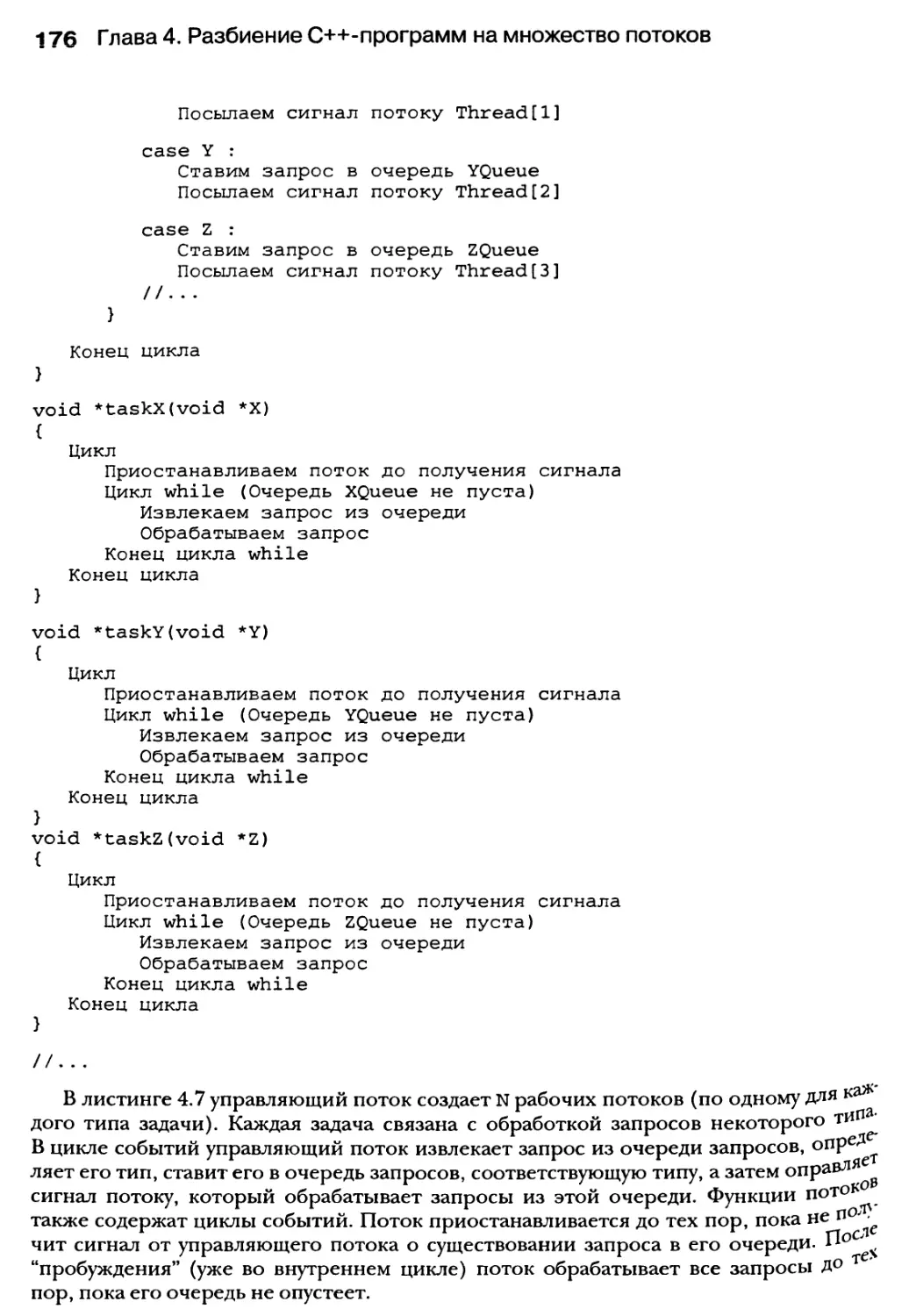

4.11.2. Использование модели сети с равноправными узлами 177

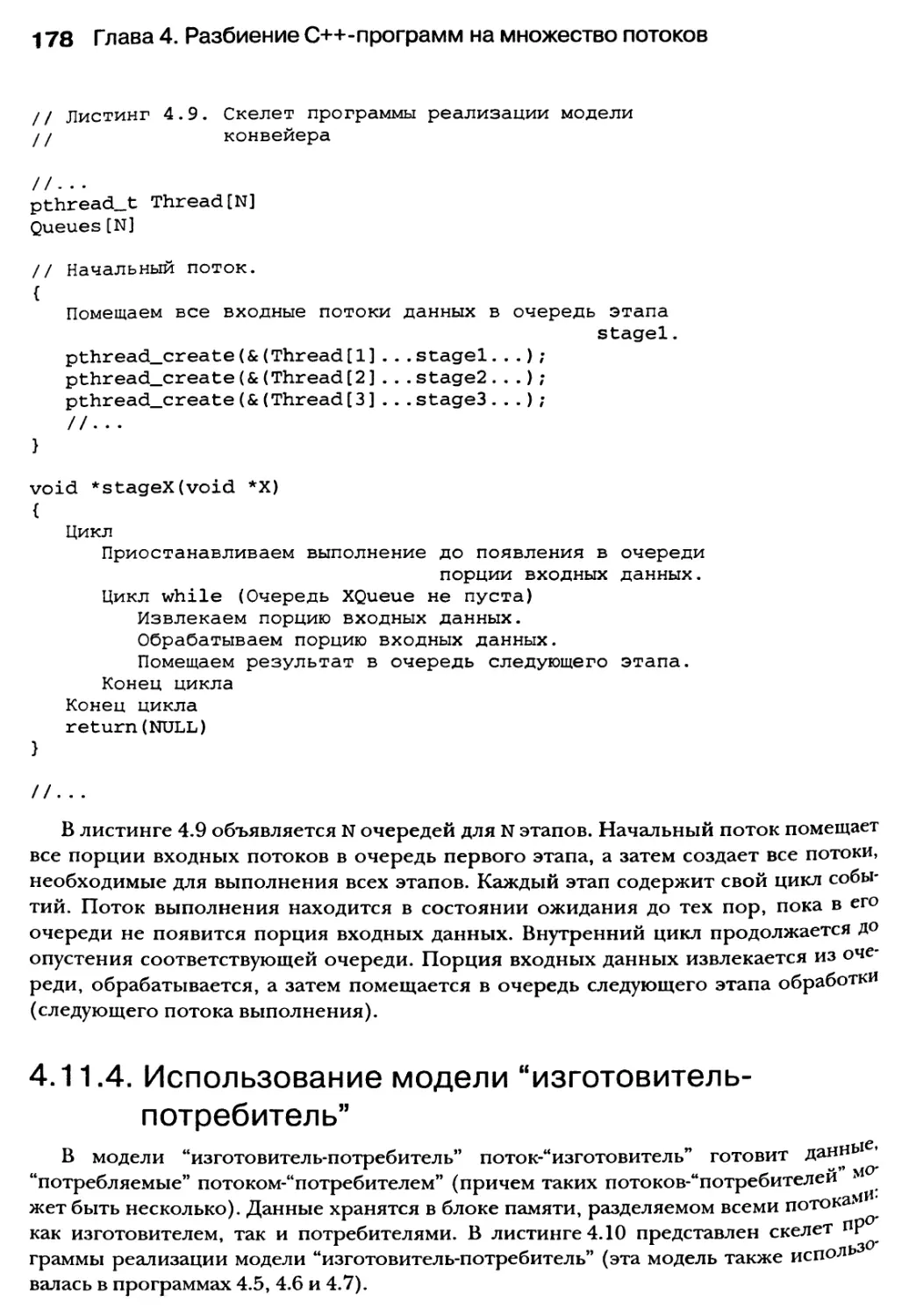

4.11.3. Использование модели конвейера 177

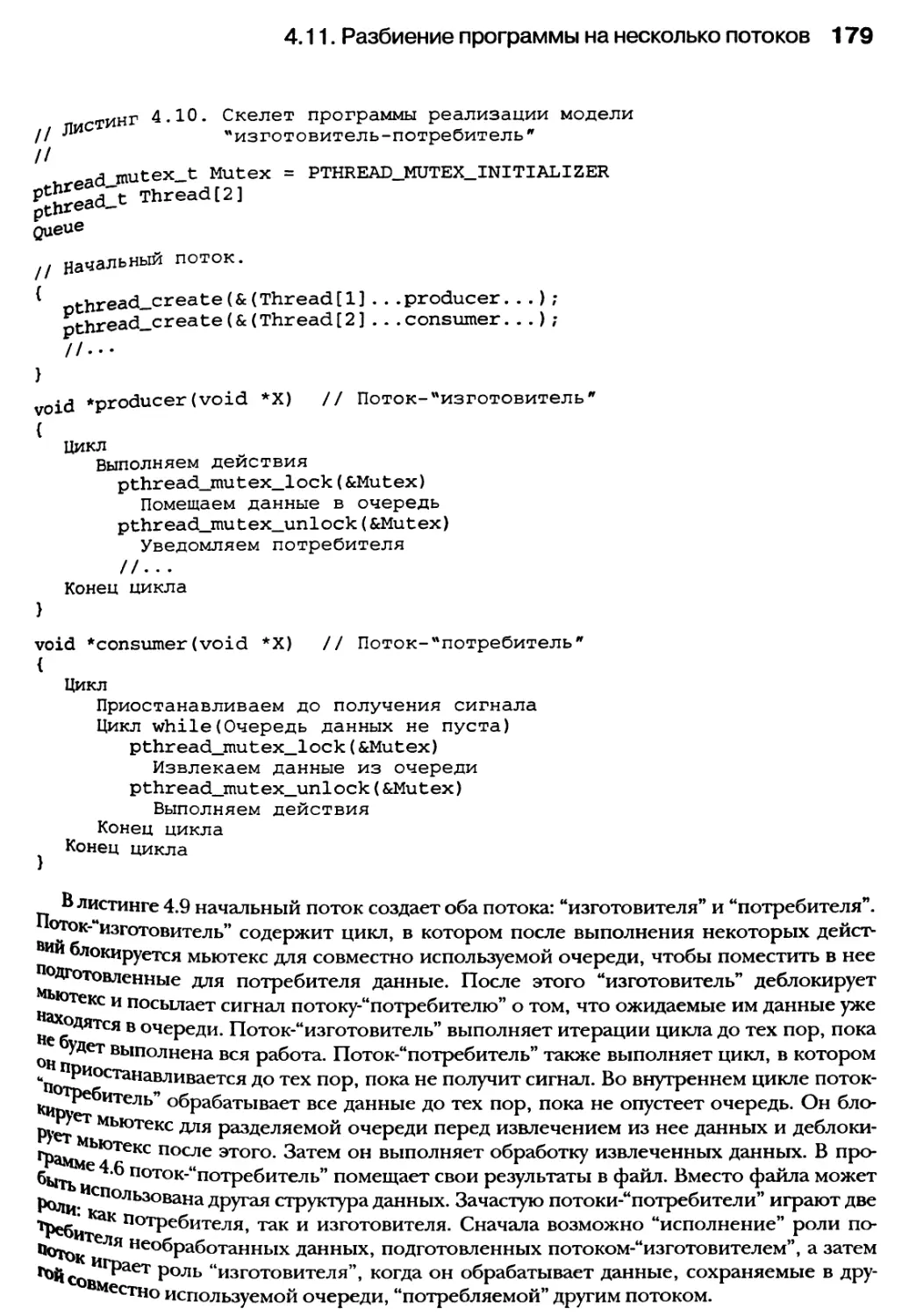

4.11.4. Использование модели “изготовитель-потребитель” 178

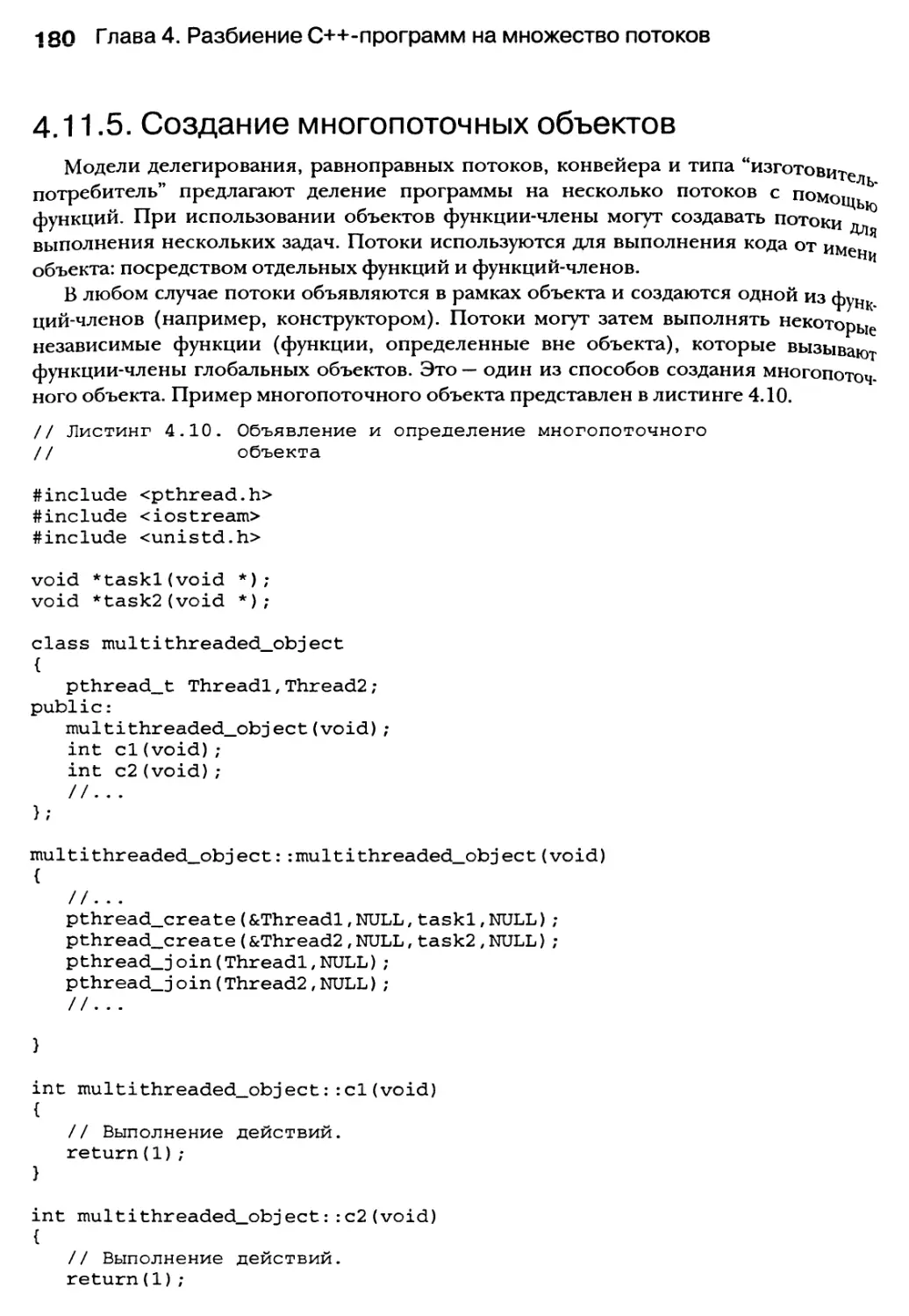

4.11.5. Создание многопоточных объектов 180

Резюме 181

Глава 5. Синхронизация параллельно выполняемых

задач 183

5.1. Координация порядка выполнения потоков 185

5.1.1. Взаимоотношения между синхронизируемыми задачами 185

5.1.2. Отношения типа старт-старт (СС) 186

5.1.3. Отношения типа финиш-старт (ФС) 187

5.1.4. Отношения типа старт-финиш (СФ) 188

5.1.5. Отношения типа финиш-финиш (ФФ) 188

5.2. Синхронизация доступа к данным 189

5.2.1. Модель PRAM 189

5.3. Что такое семафоры 193

5.3.1. Операции по управлению семафором 193

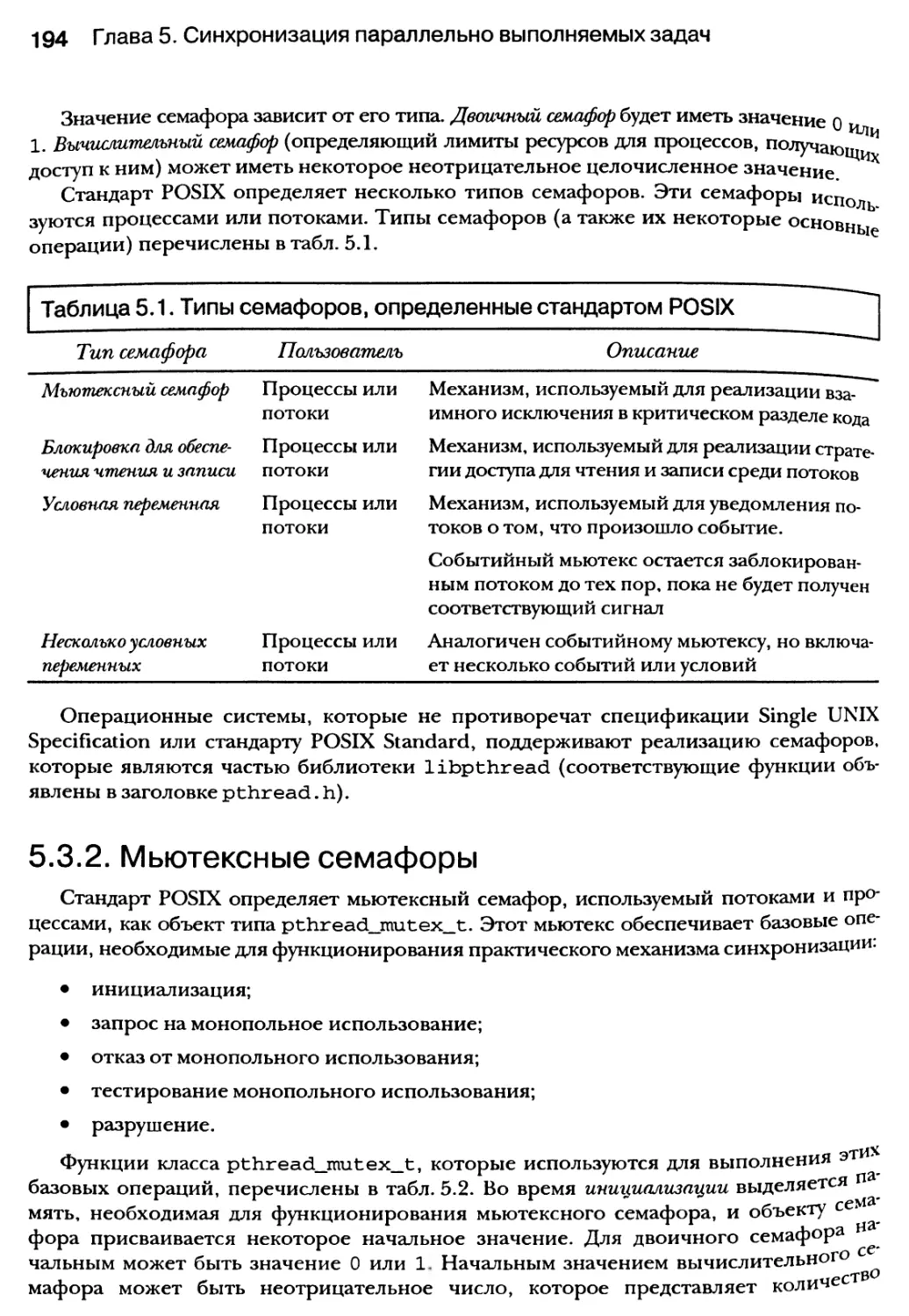

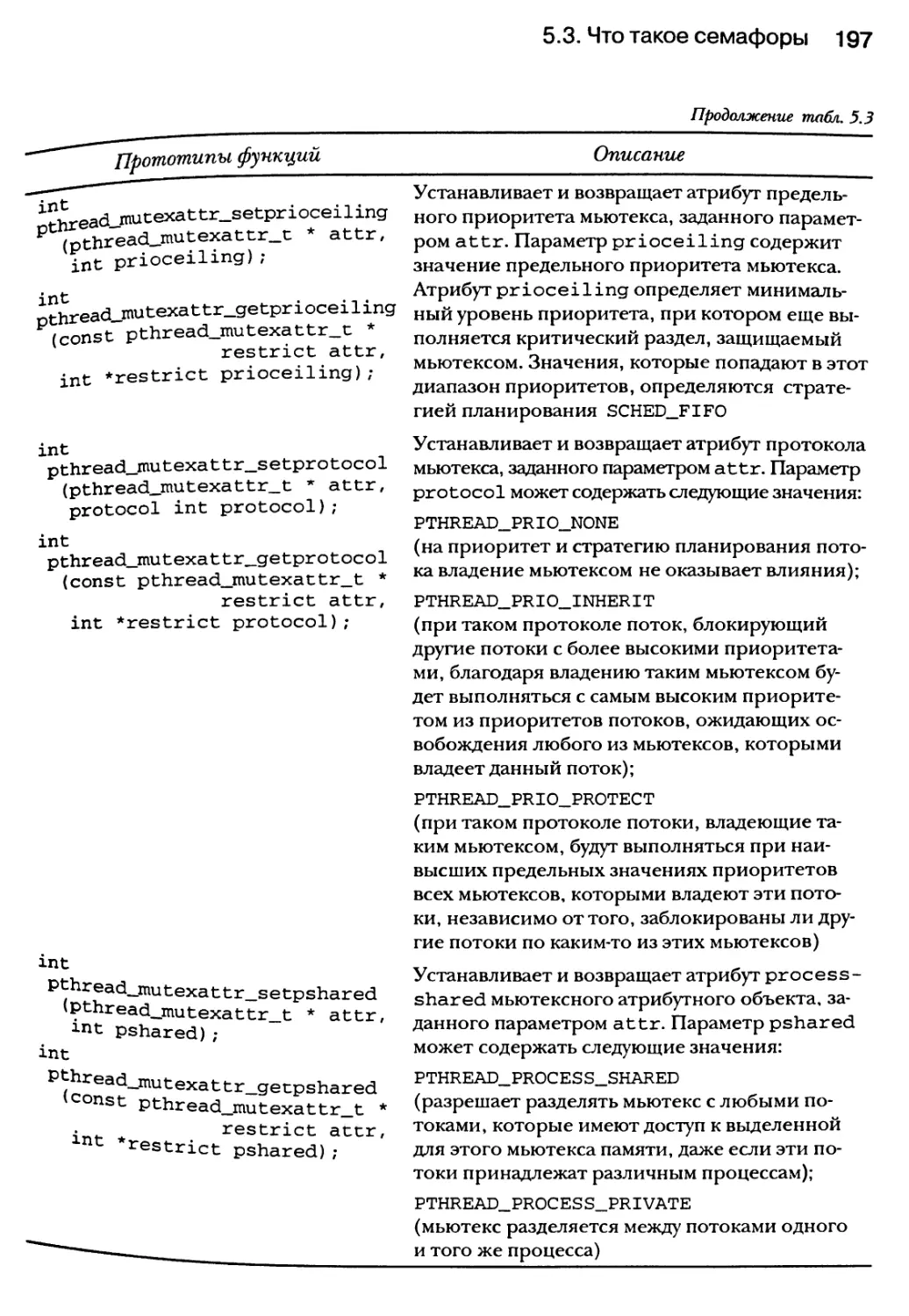

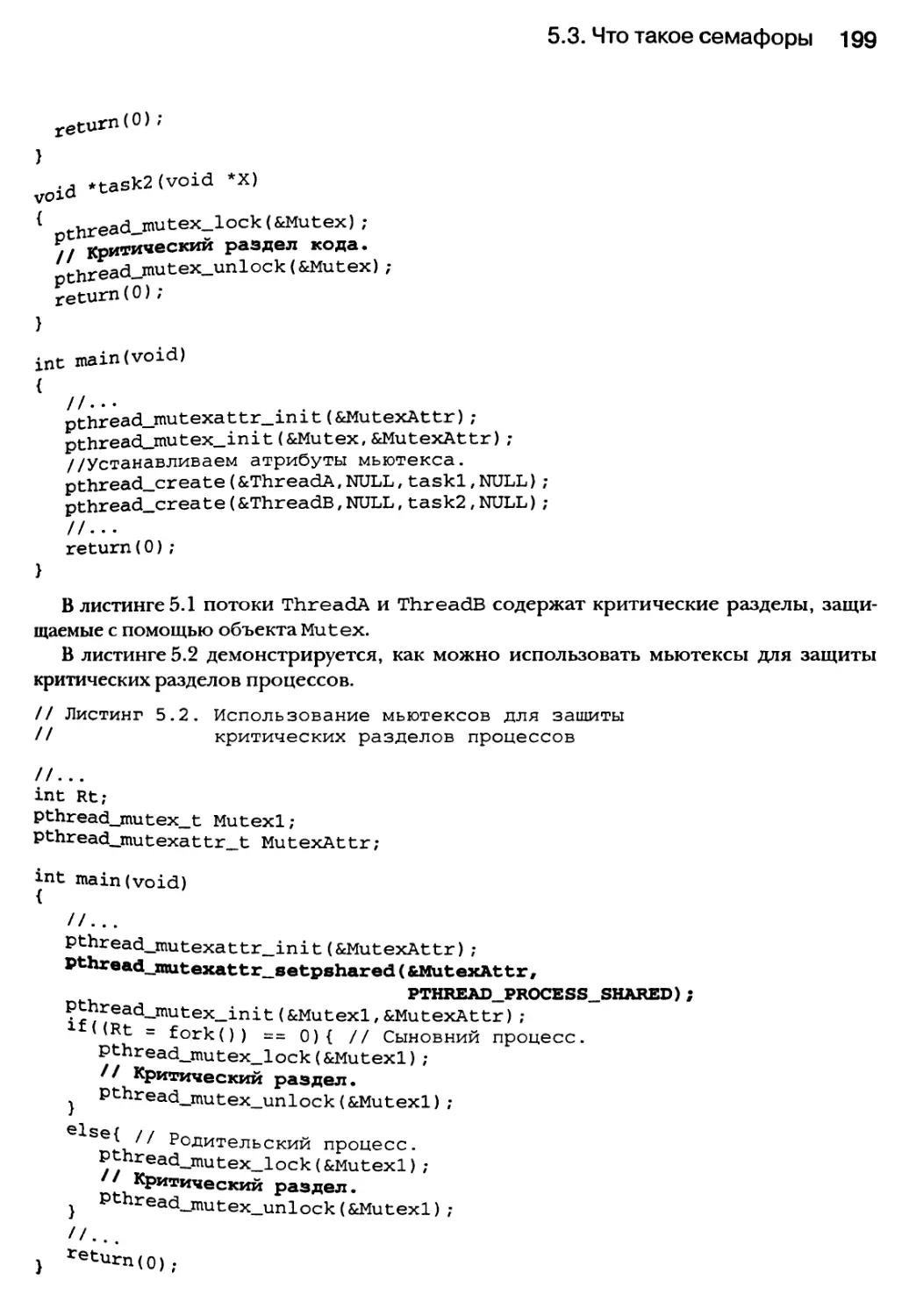

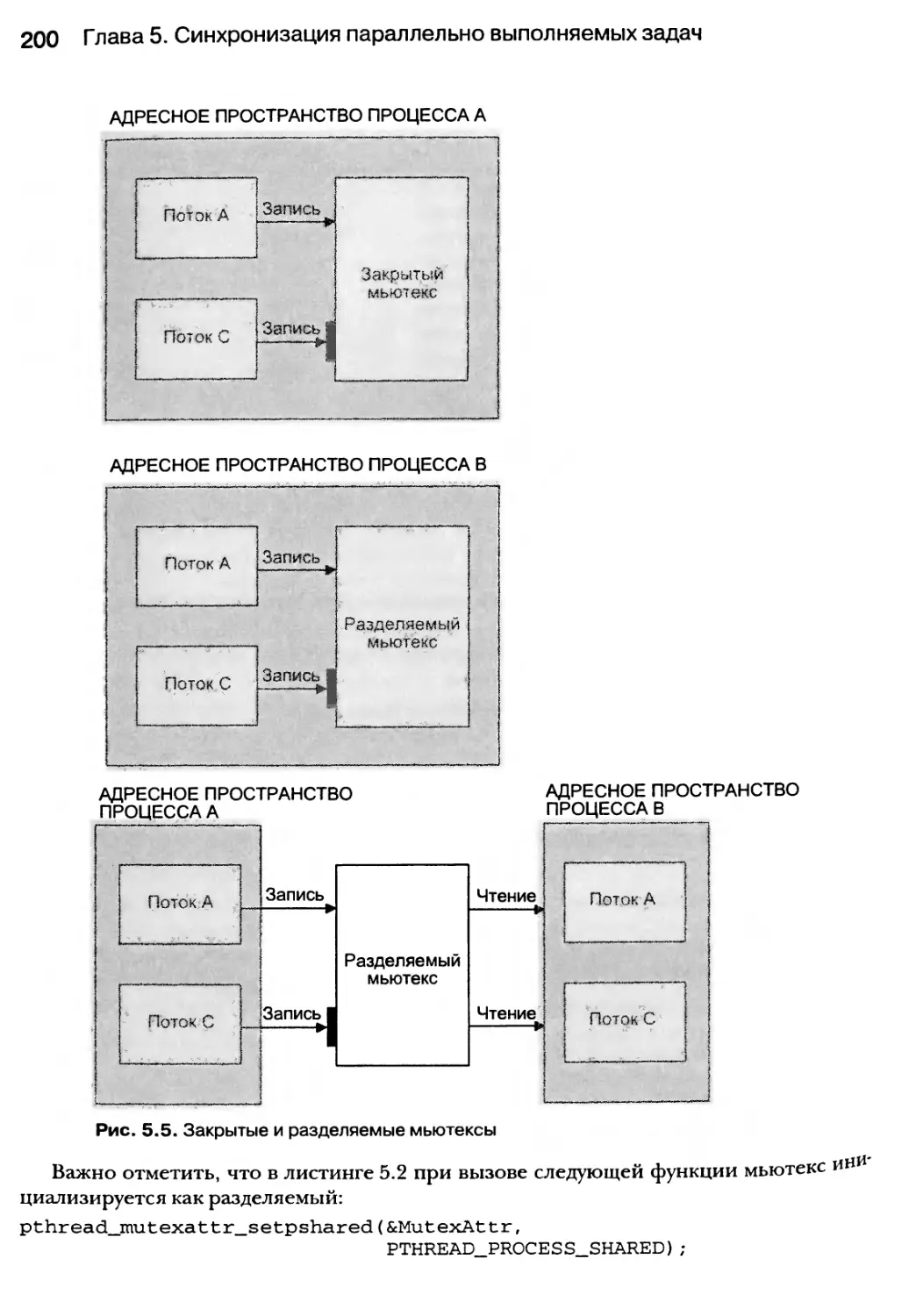

5.3.2. Мьютексные семафоры 194

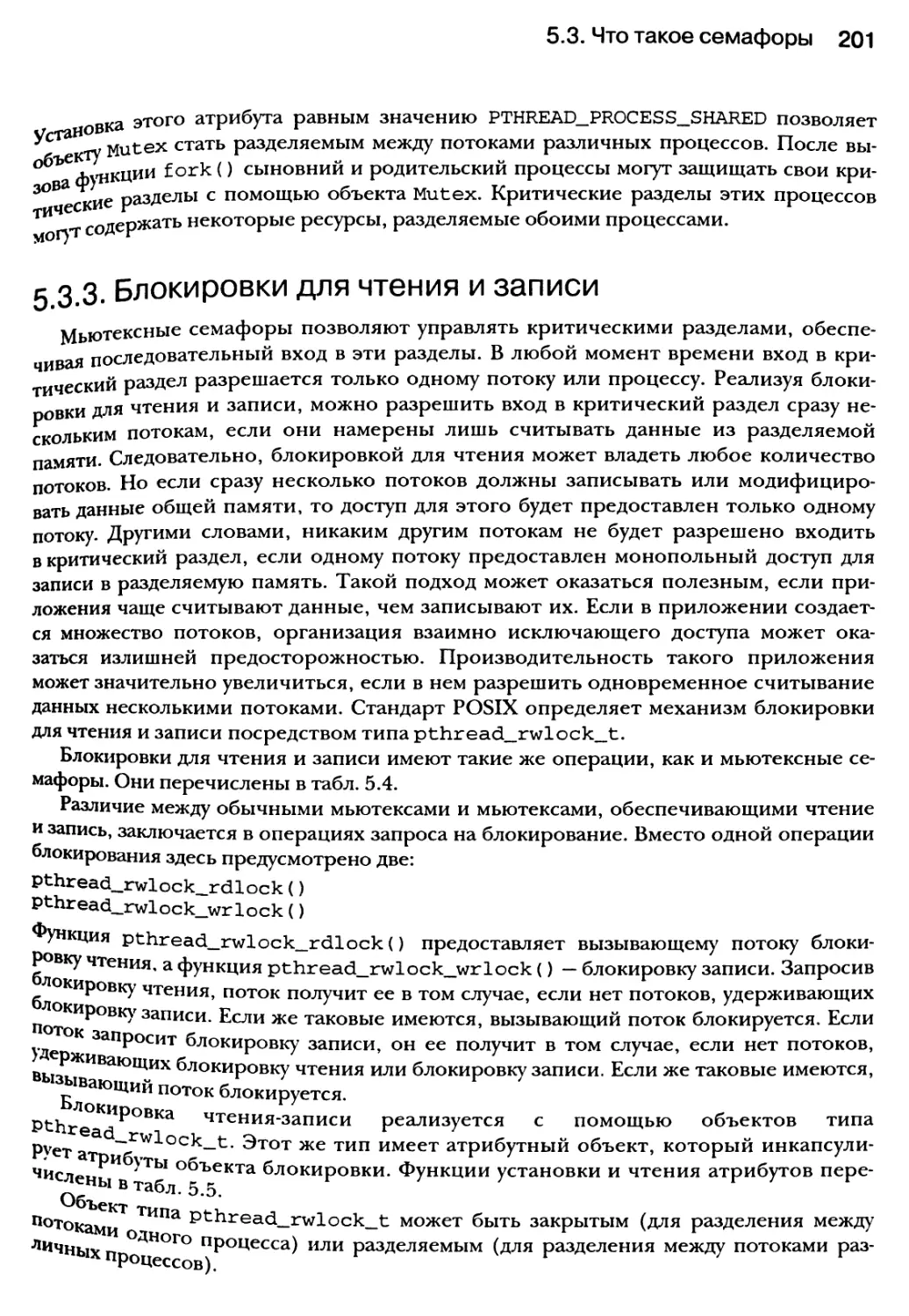

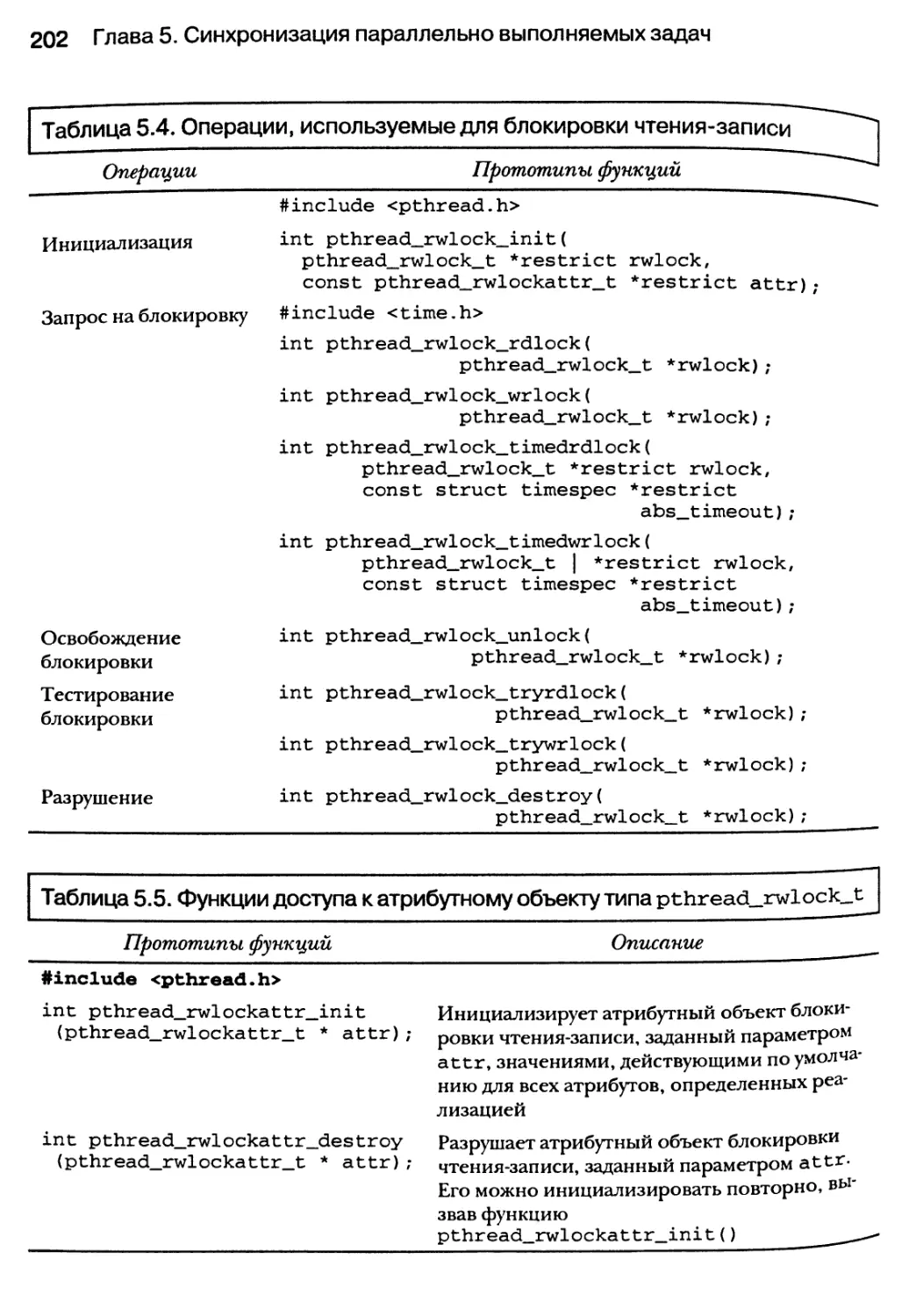

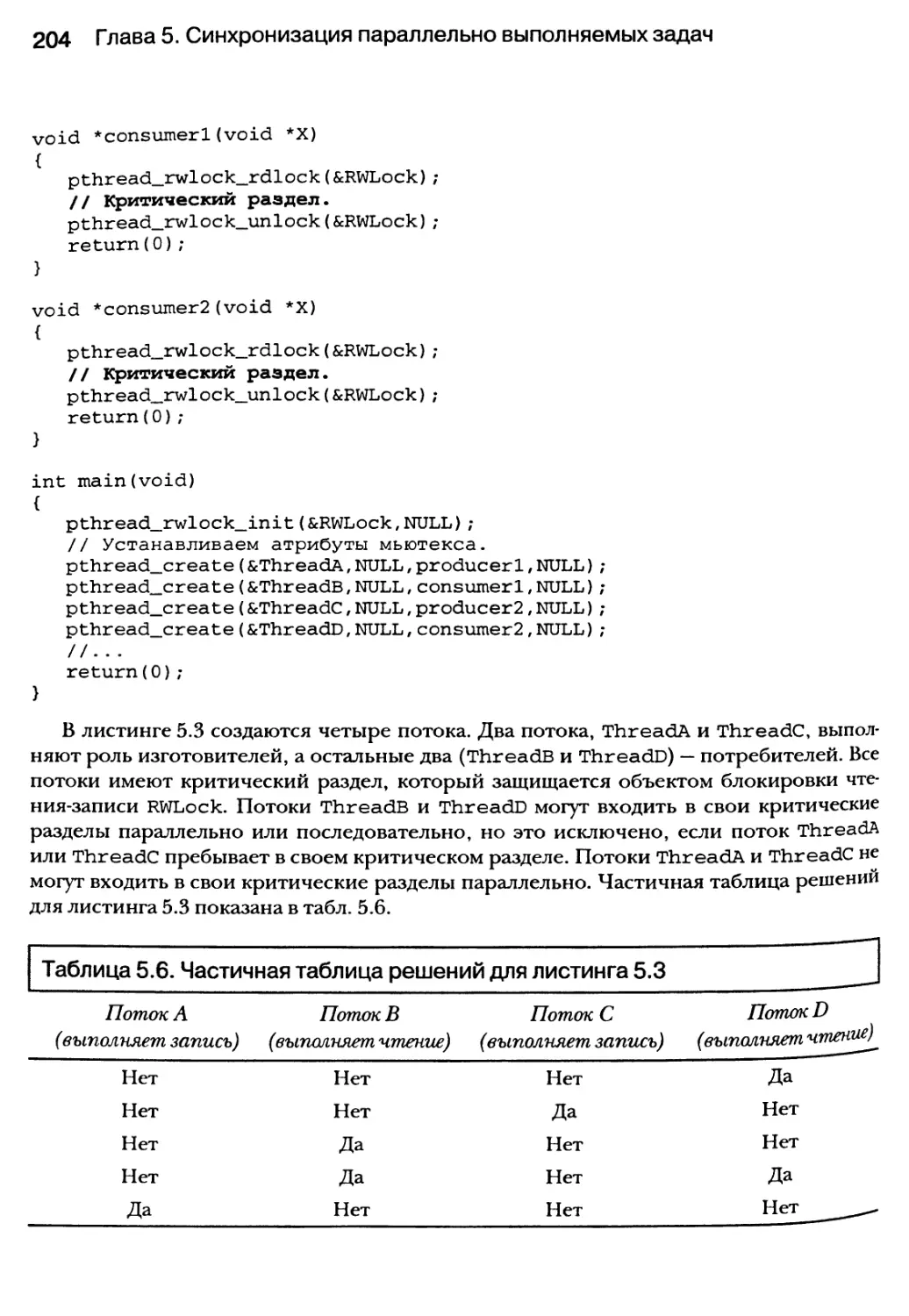

5.3.3. Блокировки для чтения и записи 201

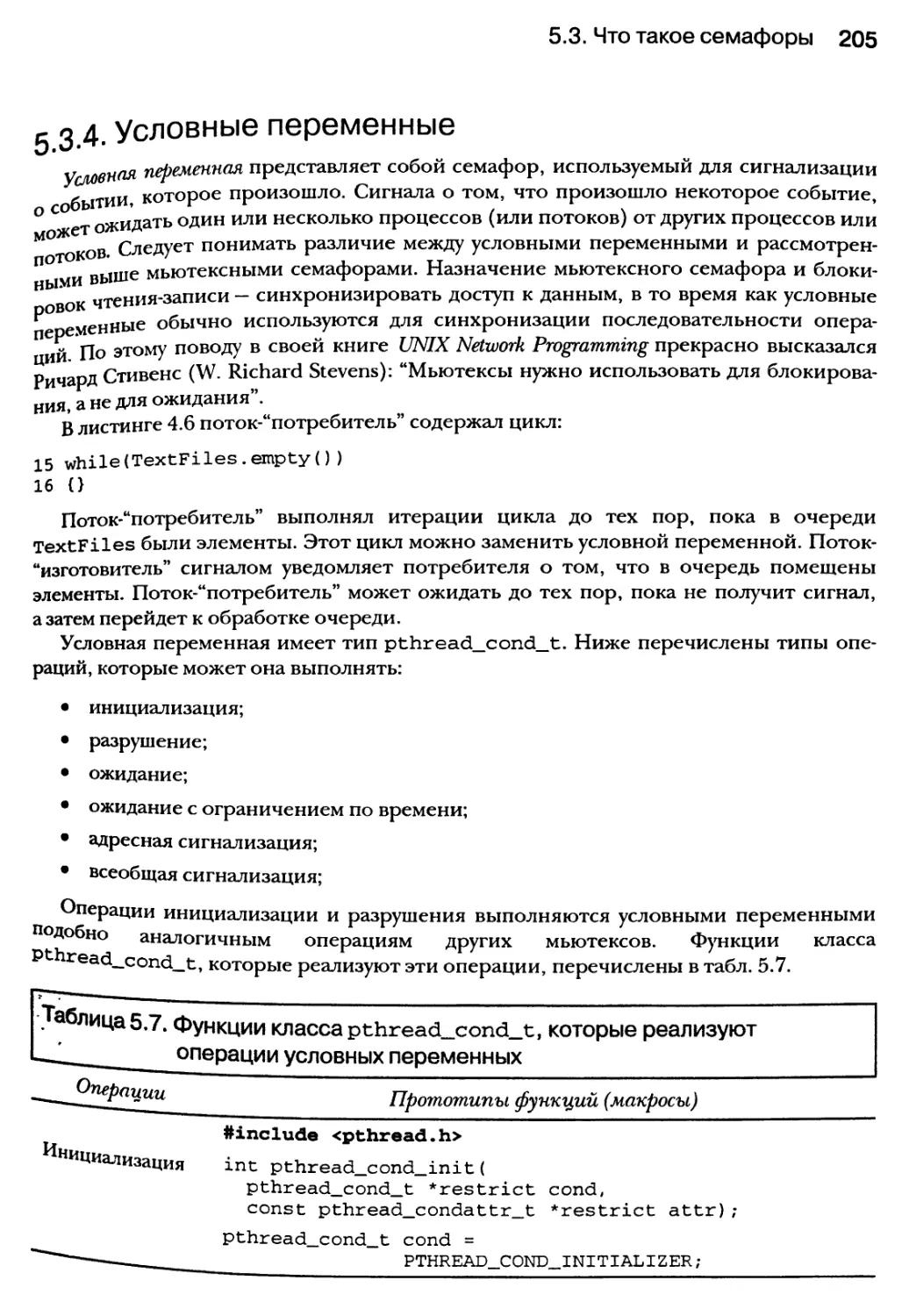

5.3.4. Условные переменные 205

5.4. Объектно-ориентированный подход к синхронизации 210

5.5. Резюме 210

Глава 6. Объединение возможностей параллельного

программирования и С++-средств на основе PVM 211

6.1. Классические модели параллелизма, поддерживаемые системой PVM 213

6.2. Библиотека PVM для языка C++ 214

6.2.1. Компиляция и компоновка С++/РУМ-программ 217

6.2.2. Выполнение PVM-программы в виде двоичного файла 218

Содержание 11

6.2.3. Требования к PVM-программам 220

6.2.4. Объединение динамической С++-библиотеки с библиотекой PVM 222

6.2.5. Методы использования PVM-задач 223

6.3. Базовые механизмы PVM 233

6.3.1. Функции управления процессами 234

6.3.2. Упаковка и отправка сообщений 236

6.4. Доступ к стандартному входному потоку (STDIN) и стандартному

выходному потоку (STDOUT) со стороны pvm-задач 242

6.4.1. Получение доступа к стандартному выходному потоку (COUT)

из сыновней задачи 243

6.5. Резюме 243

Глава 7. Обработка ошибок, исключительных ситуаций

и надежность программного обеспечения 245

7.1. Надежность программного обеспечения 247

7.2. Отказы в программных и аппаратных компонентах 249

7.3. Определение дефектов в зависимости от спецификаций ПО 251

7.4. Обработка ошибок или обработка исключительных ситуаций? 251

7.5. Надежность ПО: простой план 255

7.5.1. План А: модель возобновления, план Б: модель завершения 255

7.6. Использование объектов отображения для обработки ошибок 256

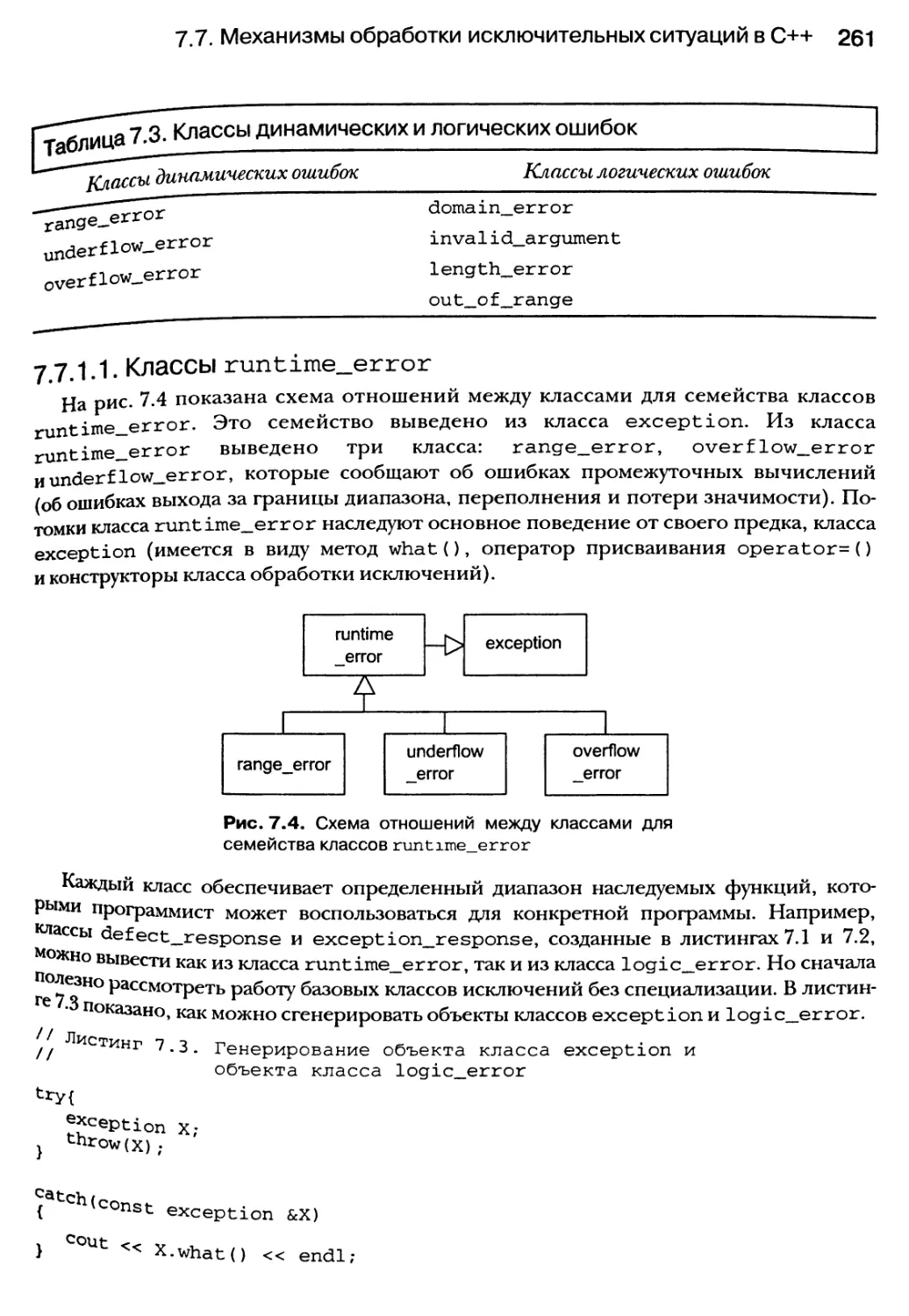

7.7. Механизмы обработки исключительных ситуаций в C++ 259

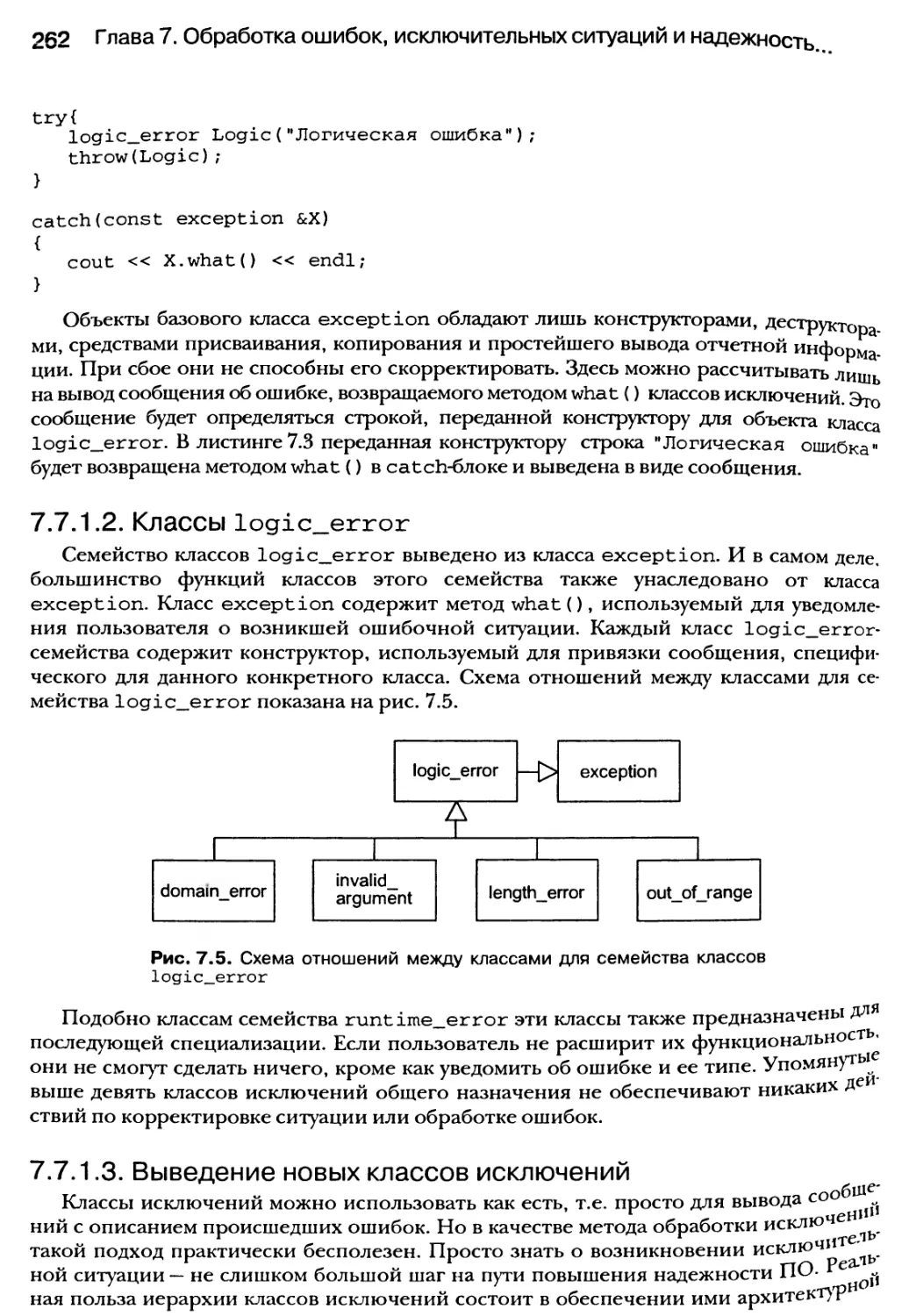

7.7.1. Классы исключений 260

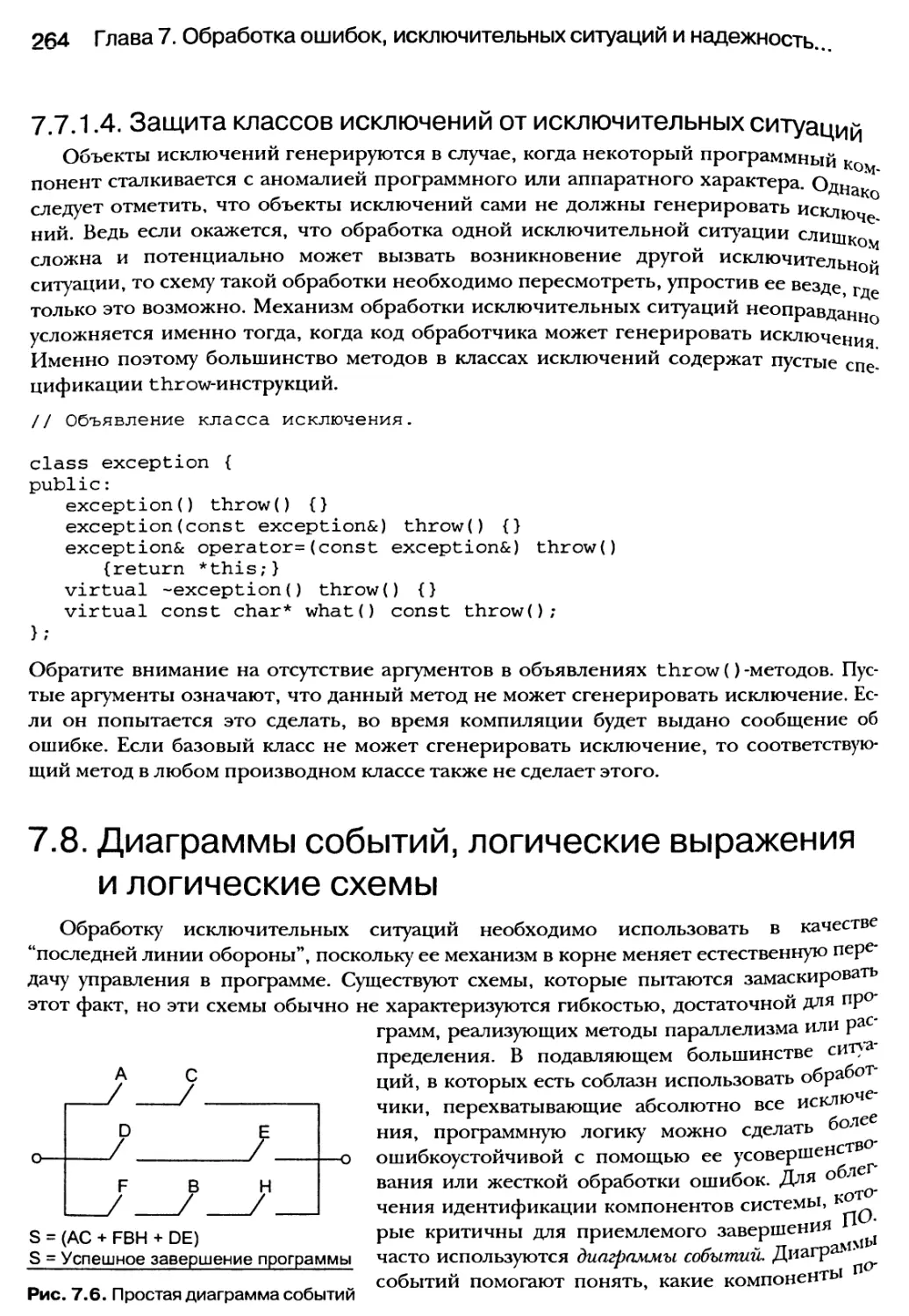

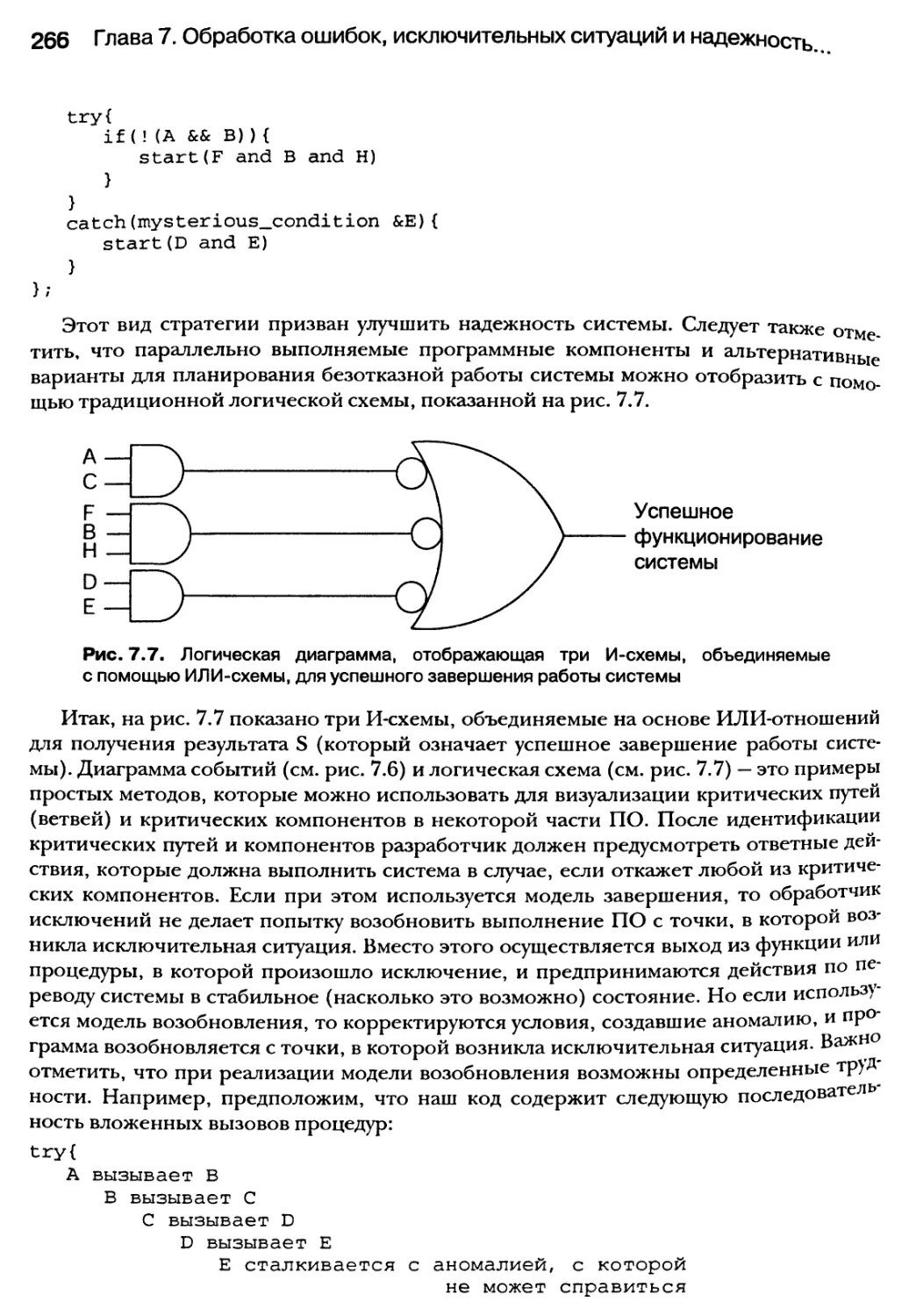

7.8. Диаграммы событий, логические выражения и логические схемы 264

7.9. Резюме 267

Глава 8. Распределенное объектно-ориентированное

программирование в C++ 268

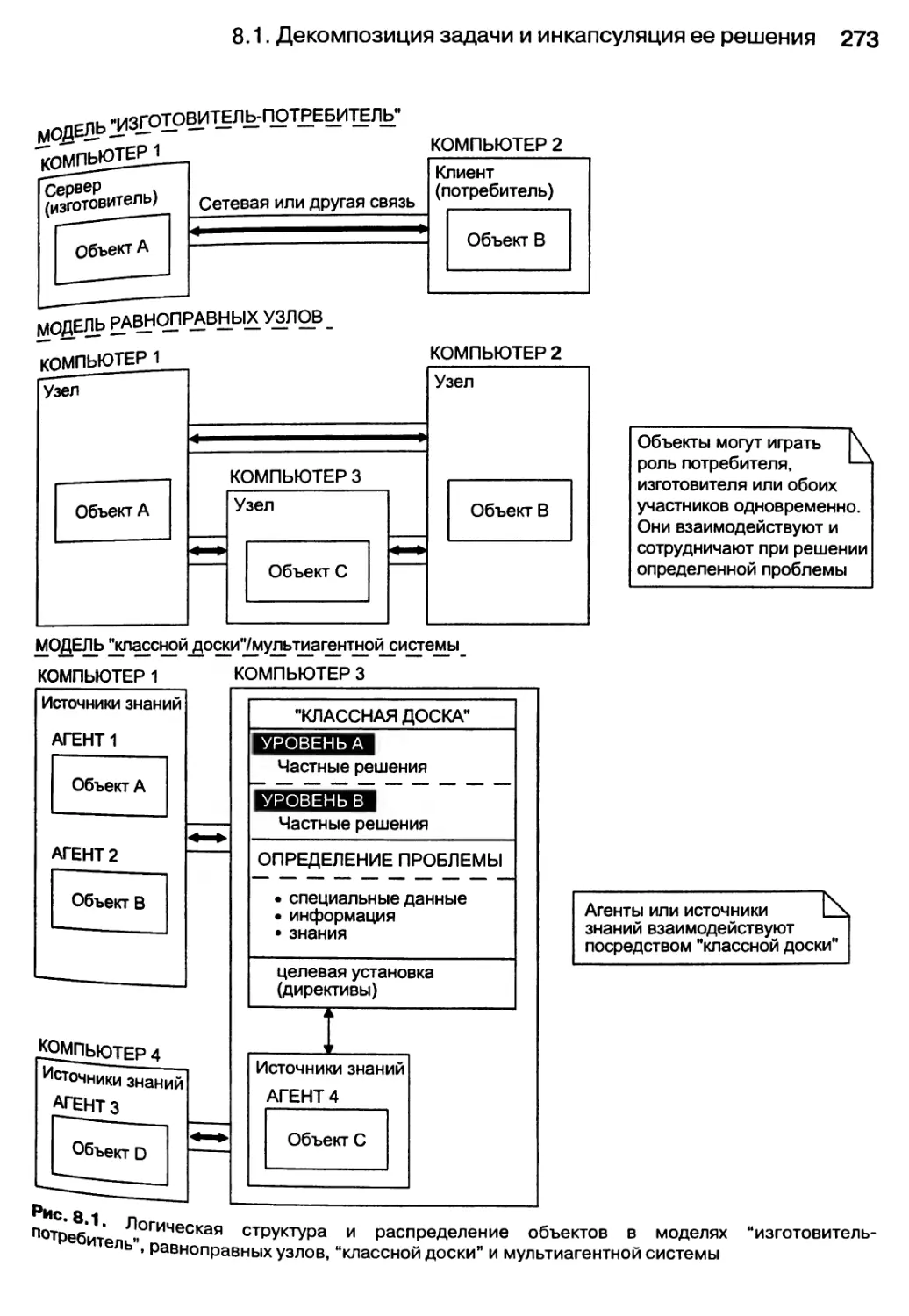

8.1. Декомпозиция задачи и инкапсуляция ее решения 271

8.1.1. Взаимодействие между распределенными объектами 272

8.1.2. Синхронизация взаимодействия локальных и удаленных объектов 274

8.1.3. Обработка ошибок и исключений в распределенной среде 275

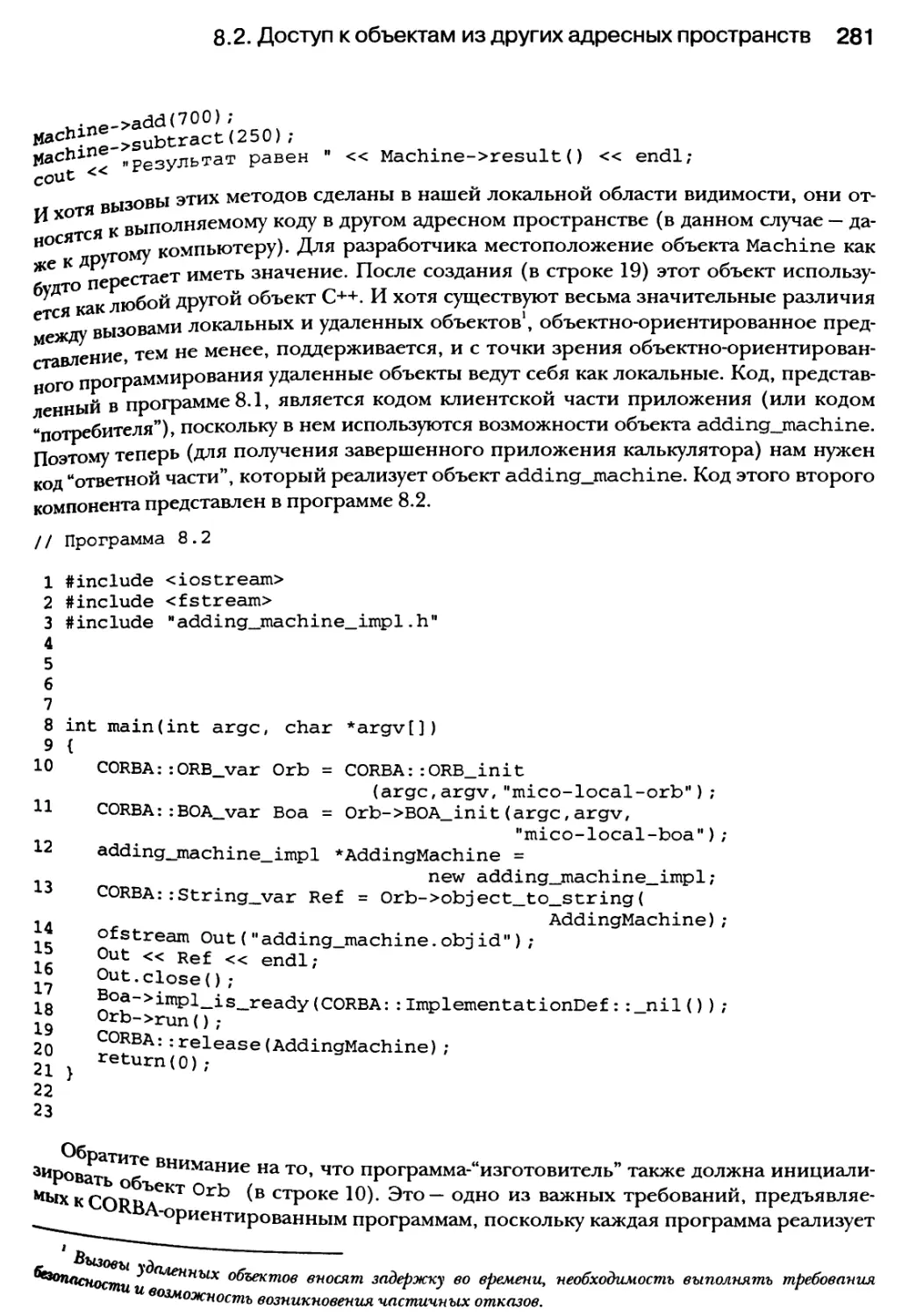

8.2. Доступ к объектам из других адресных пространств 275

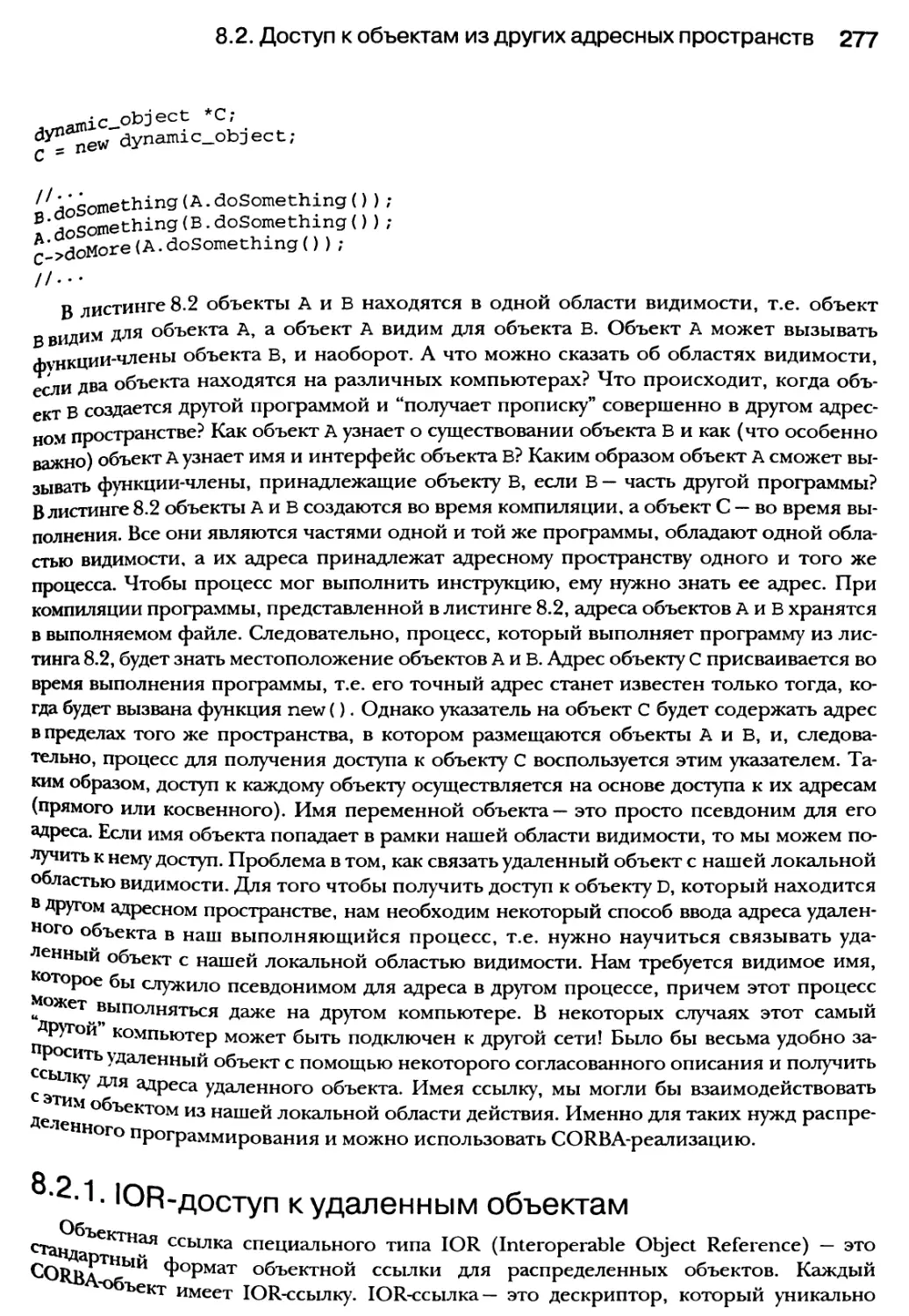

8.2.1. IOR-доступ к удаленным объектам 277

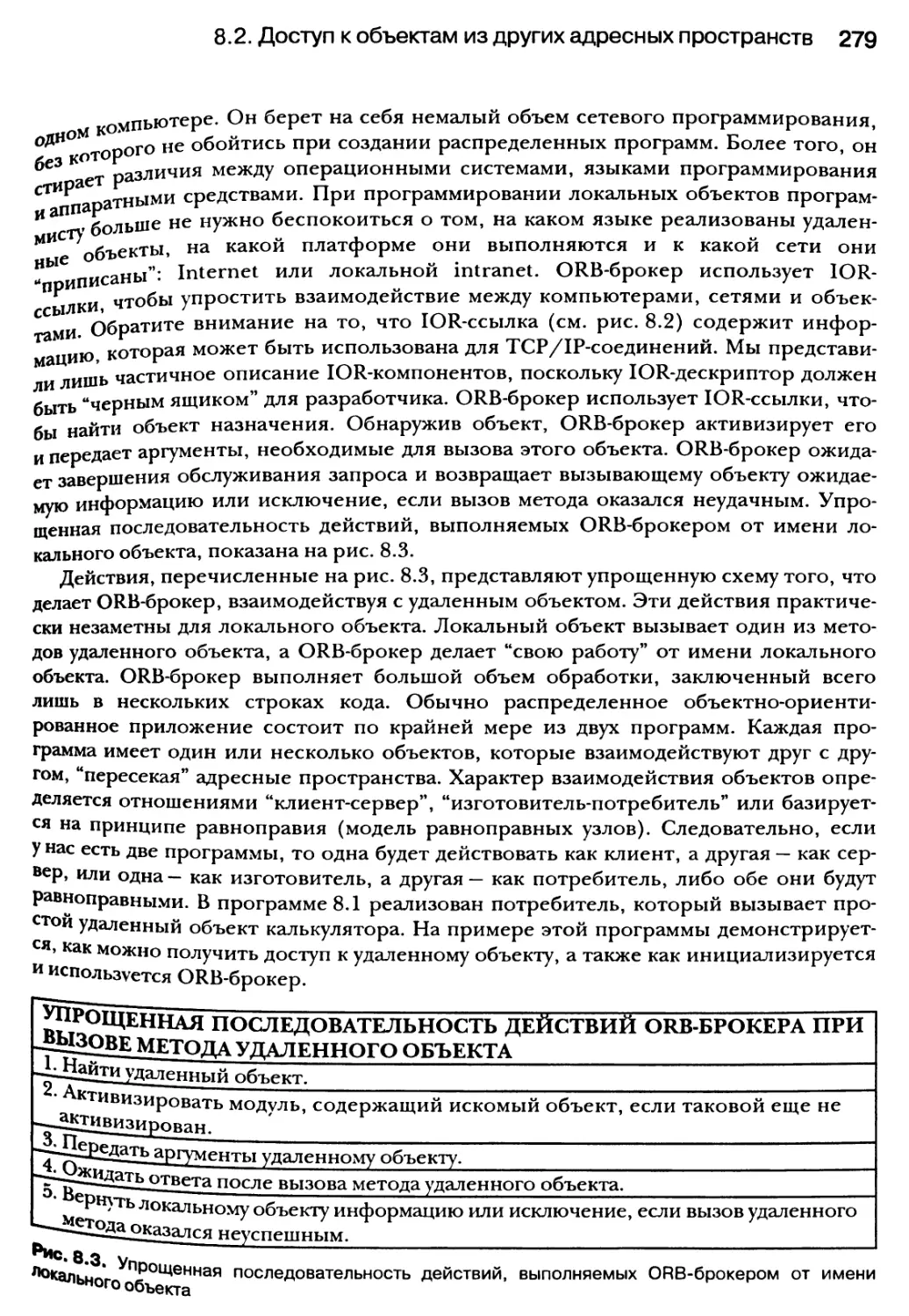

8.2.2. Брокеры объектных запросов (ORB) 278

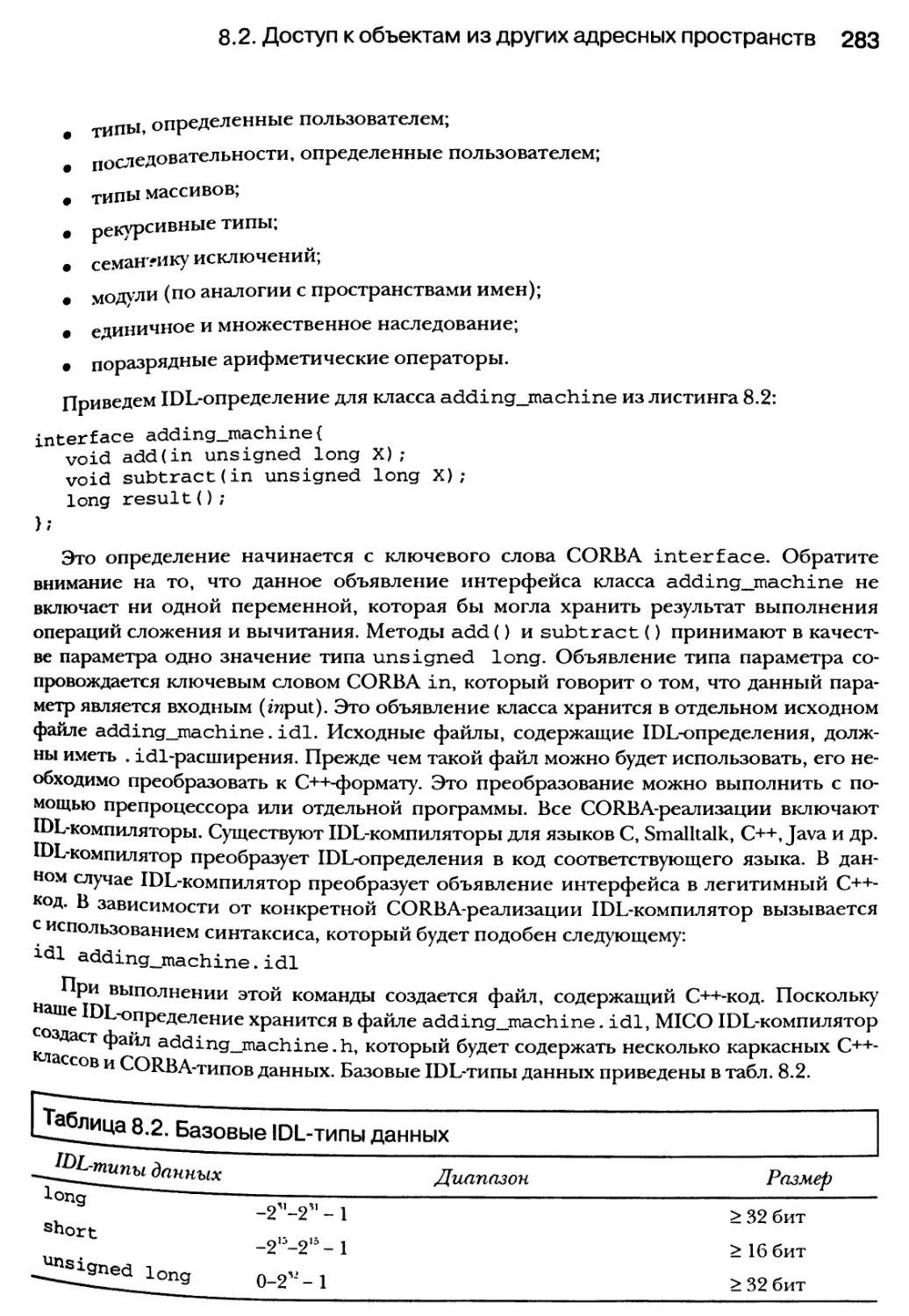

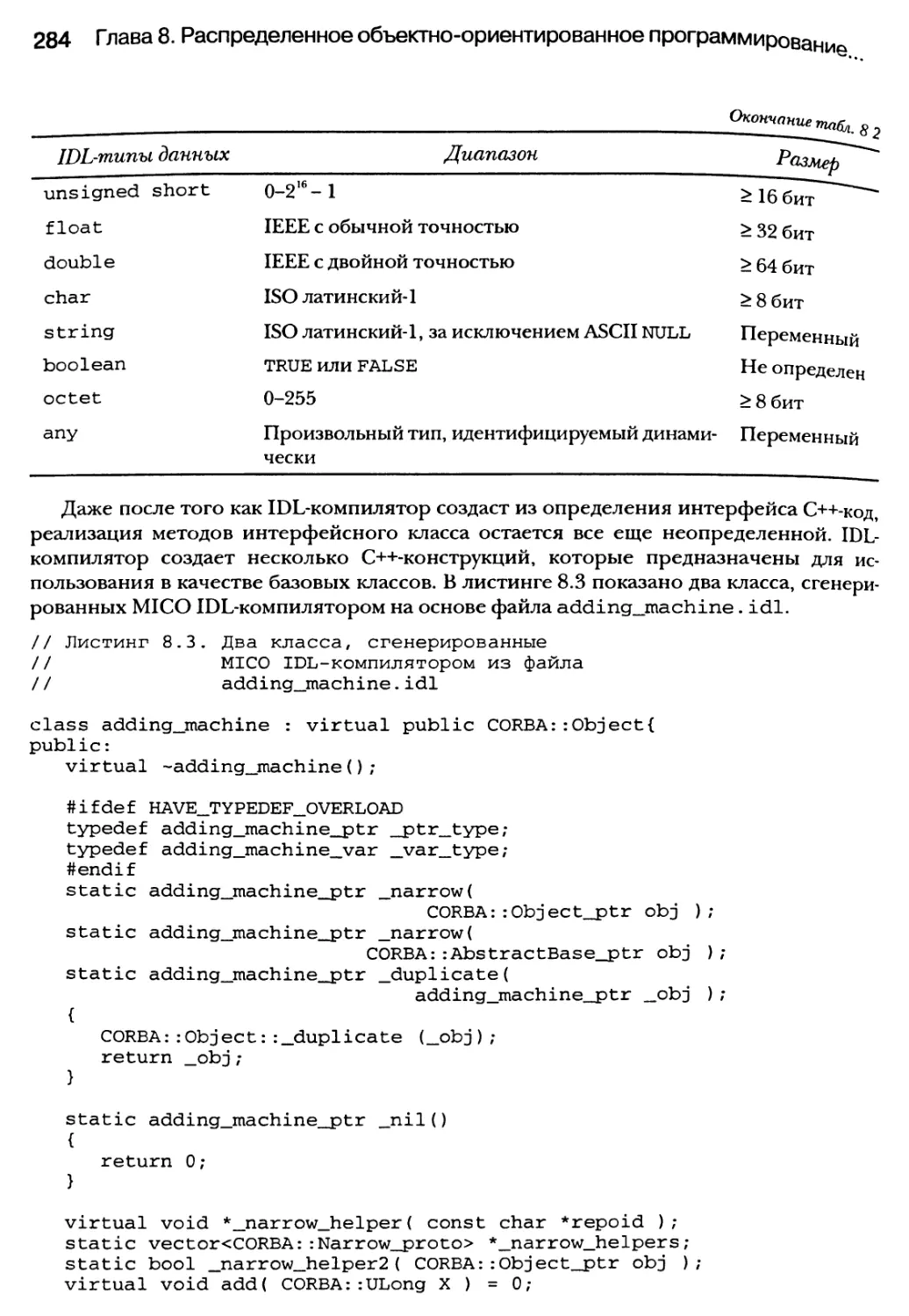

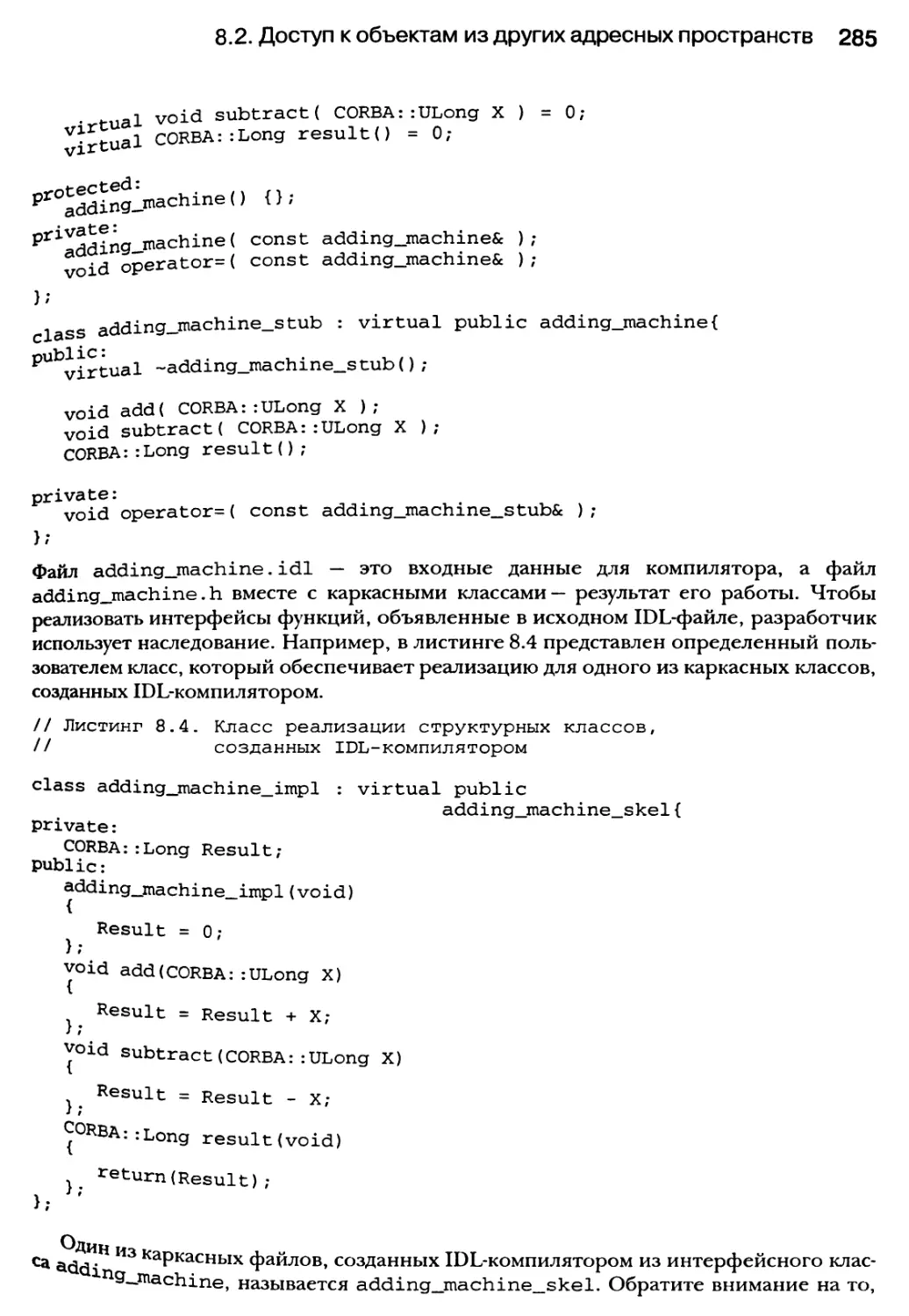

8.2.3. Язык описания интерфейсов (IDL): более “пристальный” взгляд

на CORBA-объекты 282

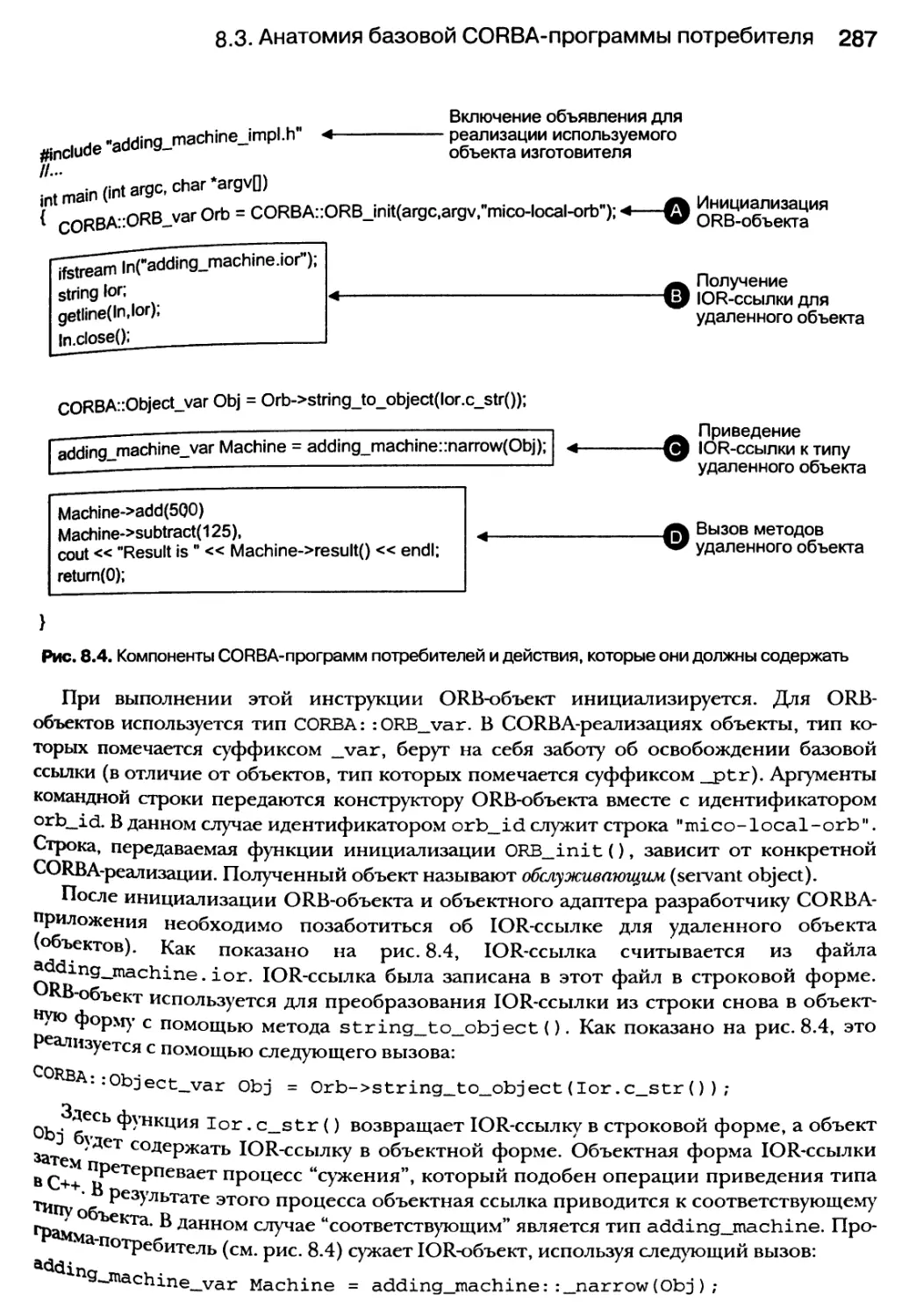

8.3. Анатомия базовой CORBA-программы потребителя 286

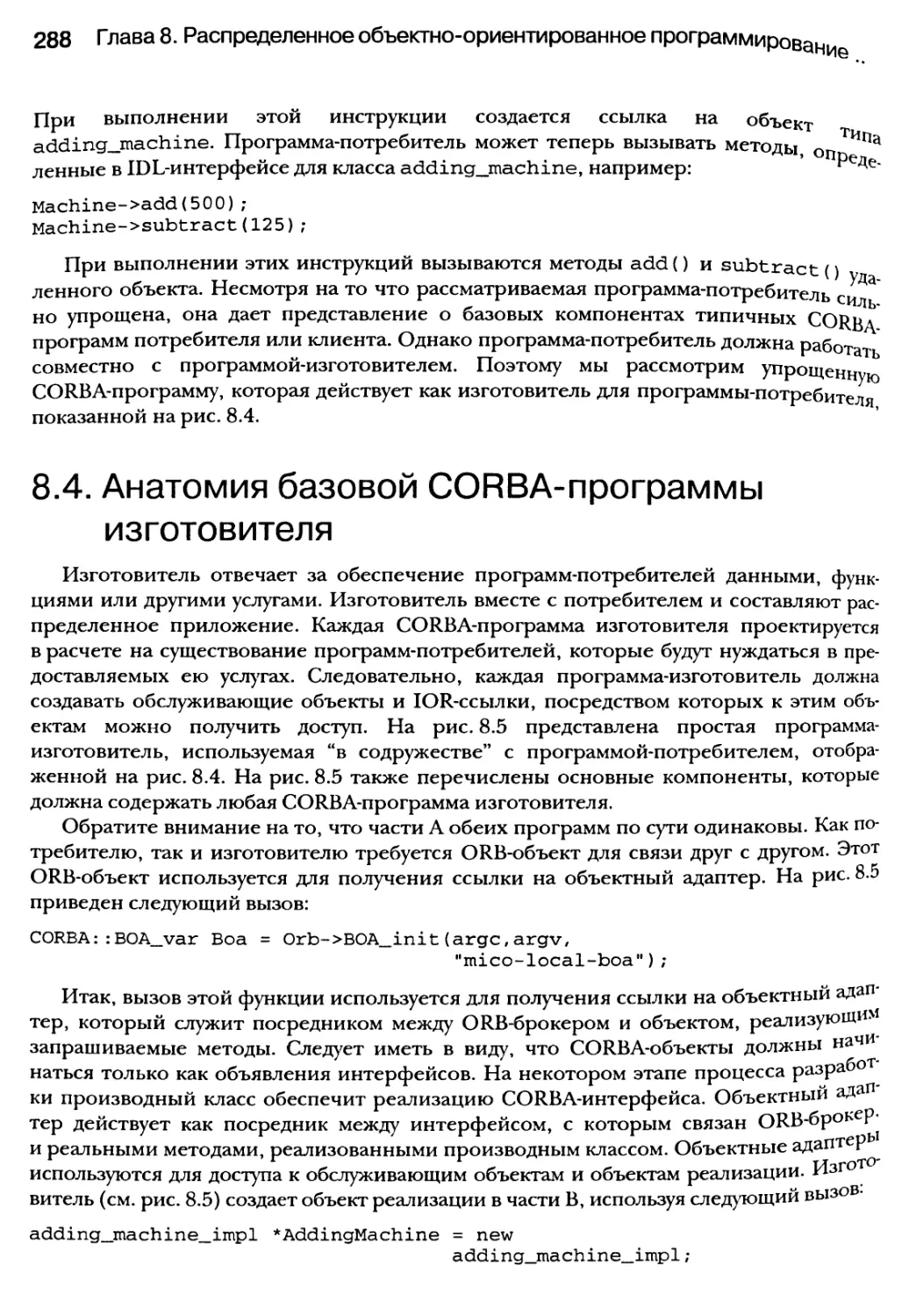

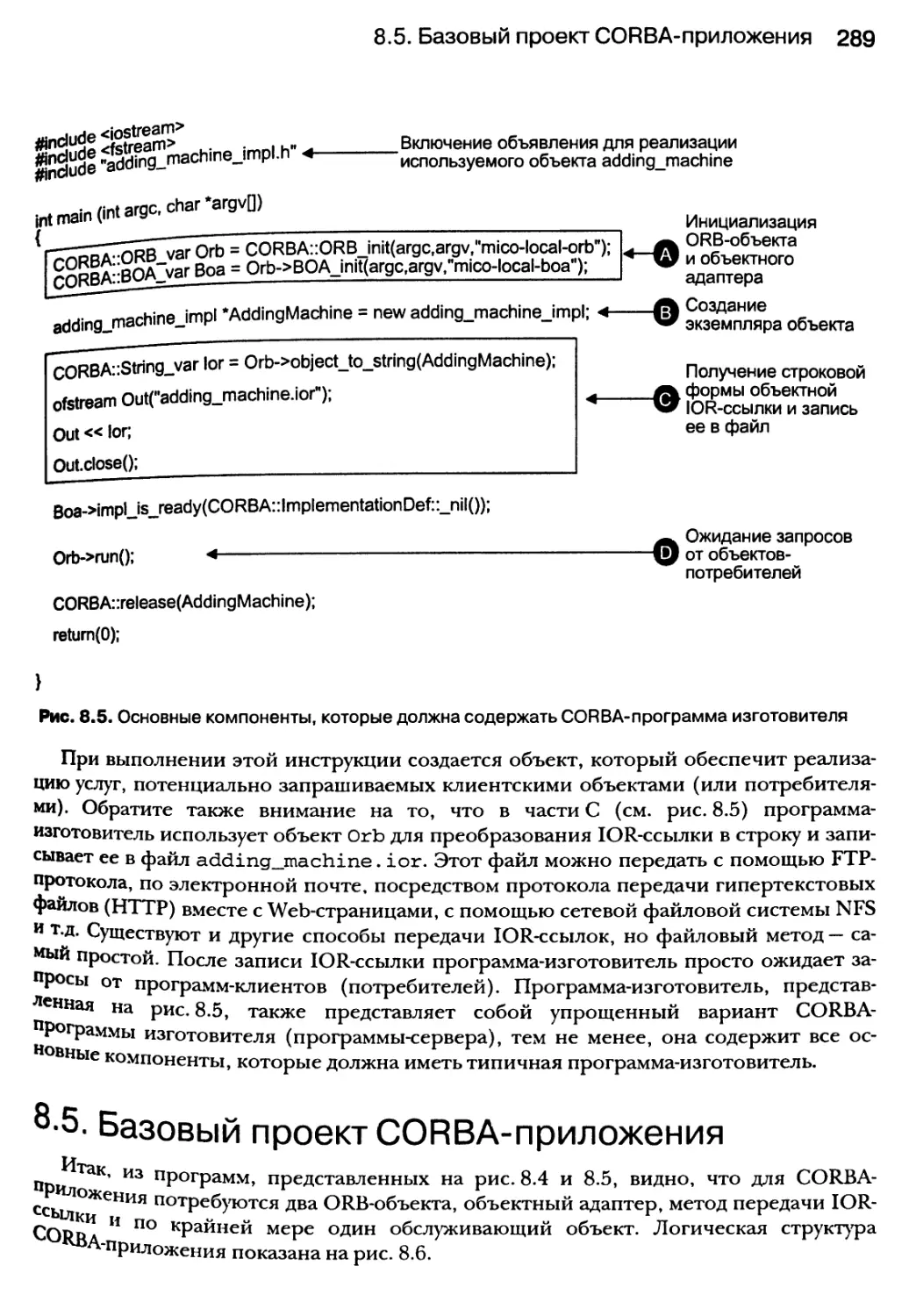

8.4. Анатомия базовой CORBA-программы изготовителя 288

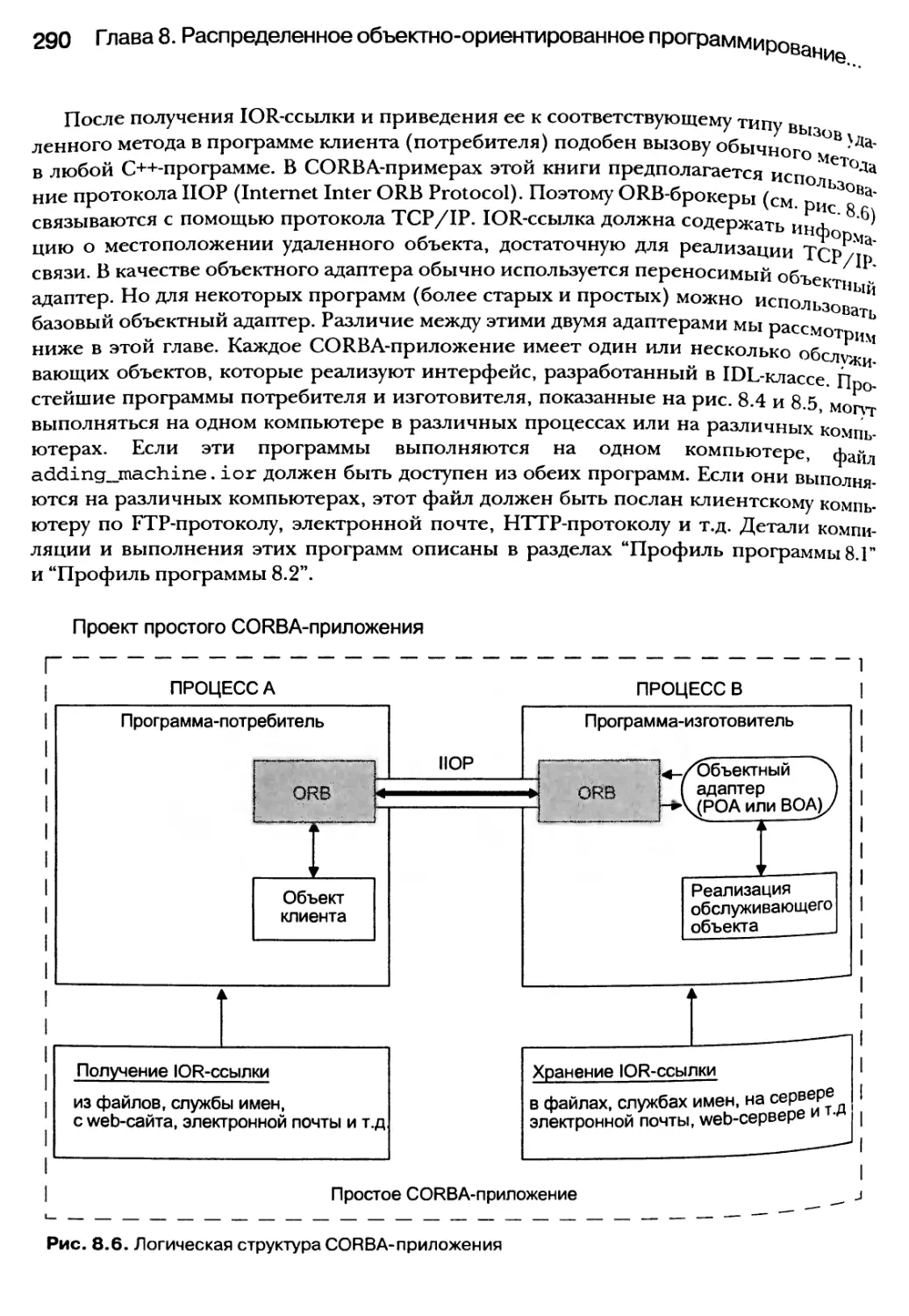

8.5. Базовый проект CORBA-приложения 289

12 Содержание

8.5.1. IDL-компилятор 292

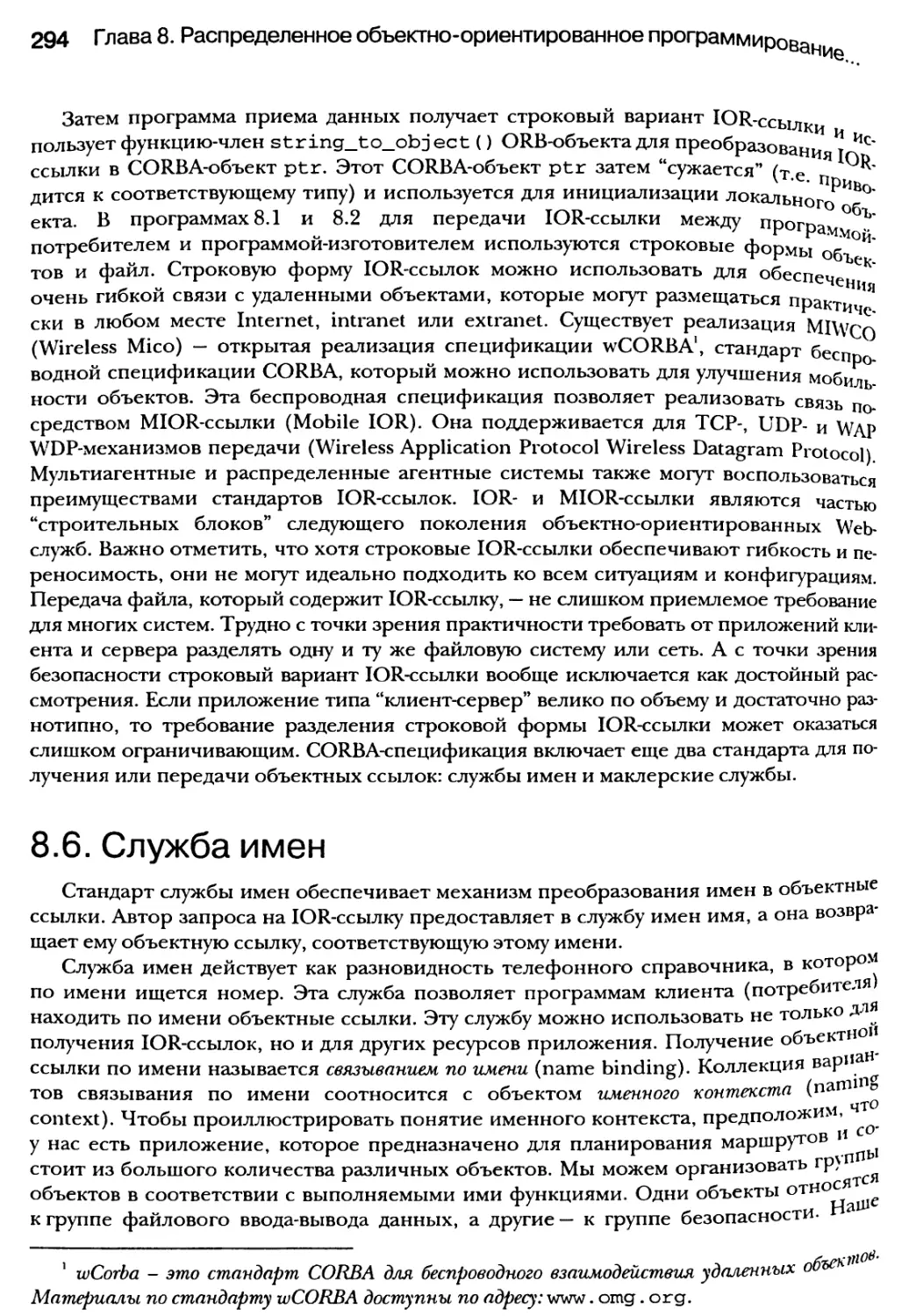

8.5.2. Получение IOR-ссылки для удаленных объектов 293

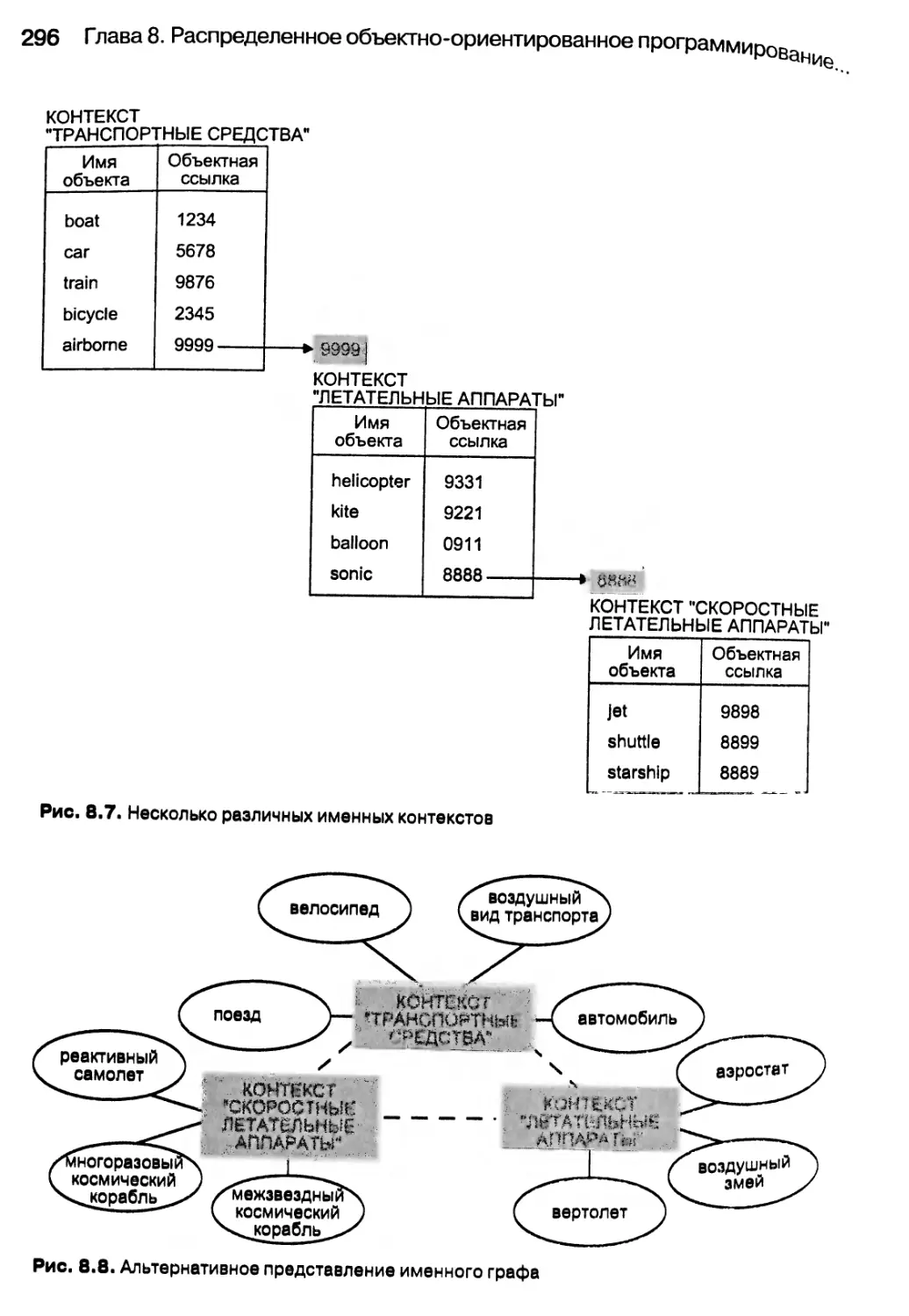

8.6. Служба имен 294

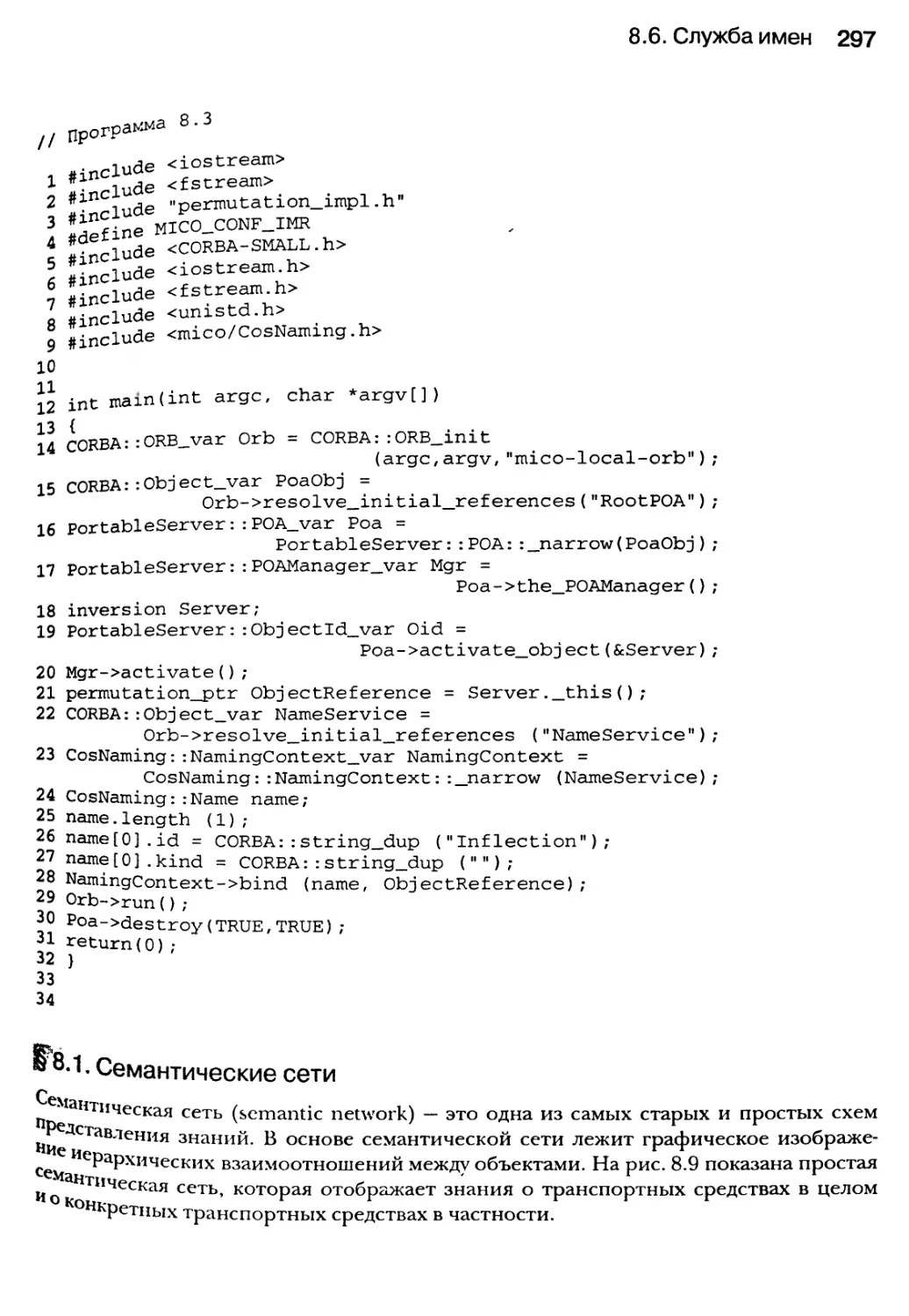

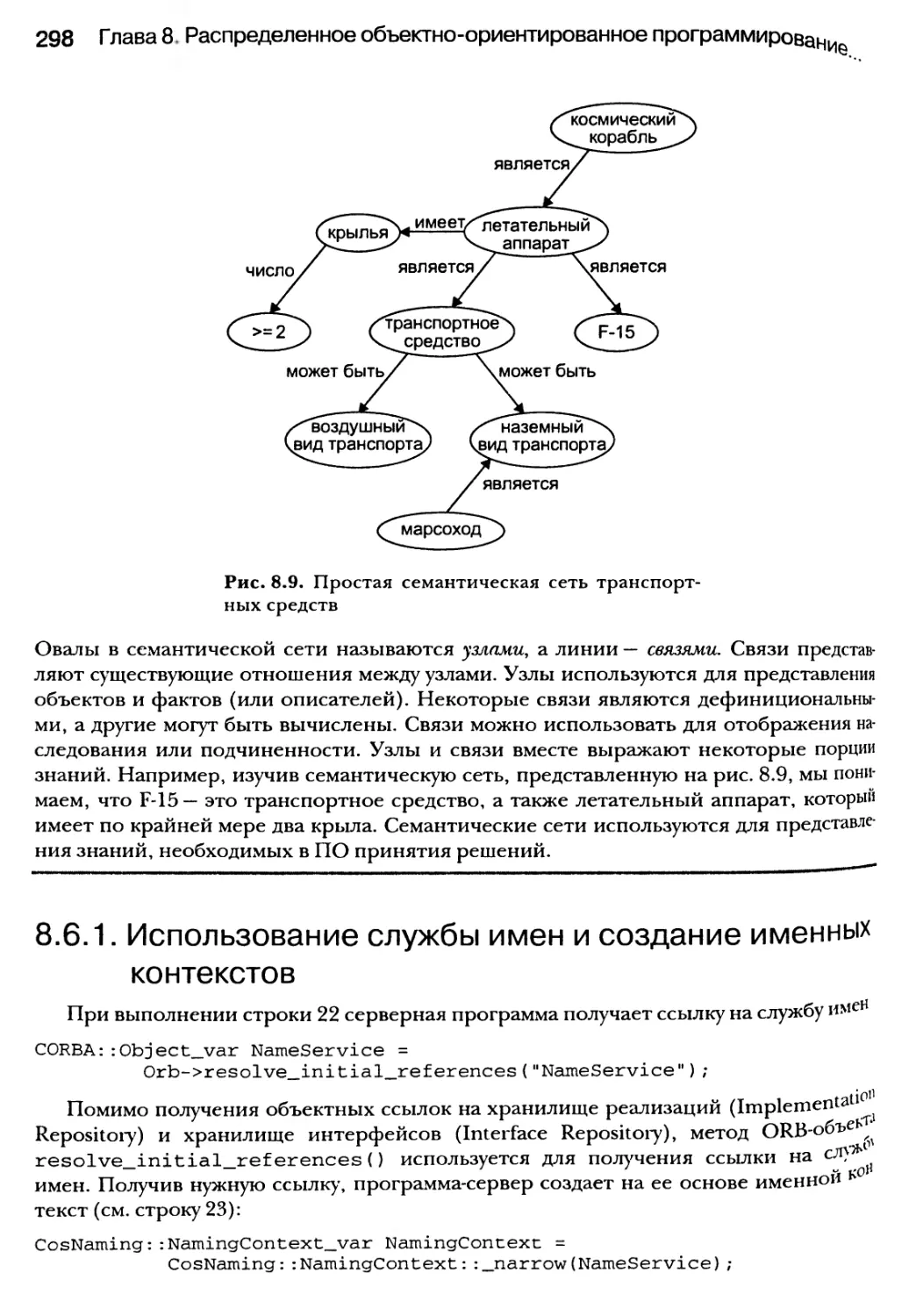

8.6.1. Использование службы имен и создание именных контекстов 298

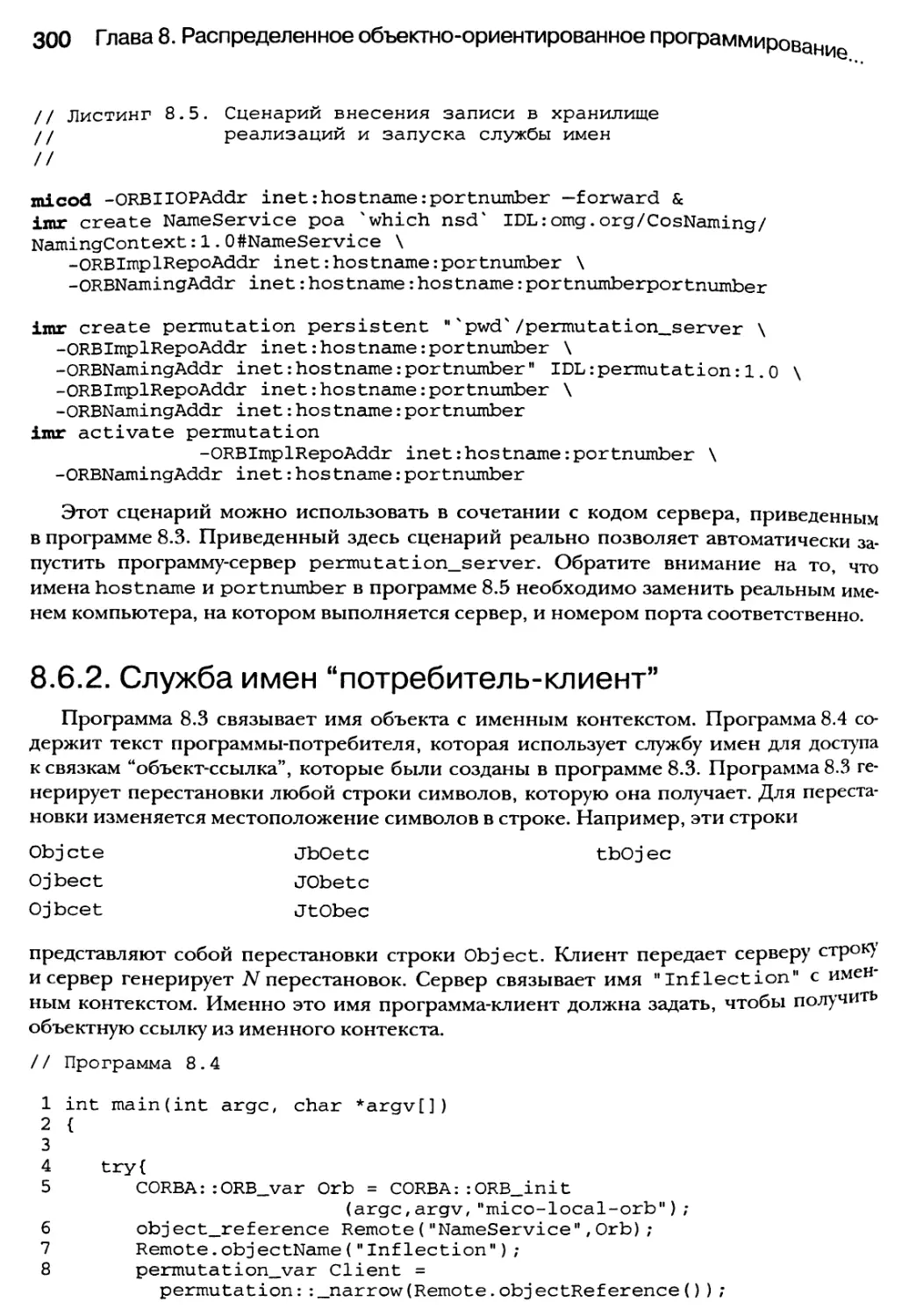

8.6.2. Служба имен “потребитель-клиент” 300

8.7. Подробнее об объектных адаптерах 303

8.8. Хранилища реализаций и интерфейсов 305

8.9. Простые распределенные Web-службы, использующие CORBA-спецификацию 306

8.10. Маклерская служба 307

8.11. Парадигма “клиент-сервер” 309

8.12. Резюме 311

Глава 9. Реализация моделей SPMD и MPMD с помощью

шаблонов и МР1-программирования 312

9.1. Декомпозиция работ для МР1-интерфейса 314

9.1.1. Дифференциация задач по рангу 315

9.1.2. Группирование задач по коммуникаторам 317

9.1.3. Анатомия MPI-задачи 319

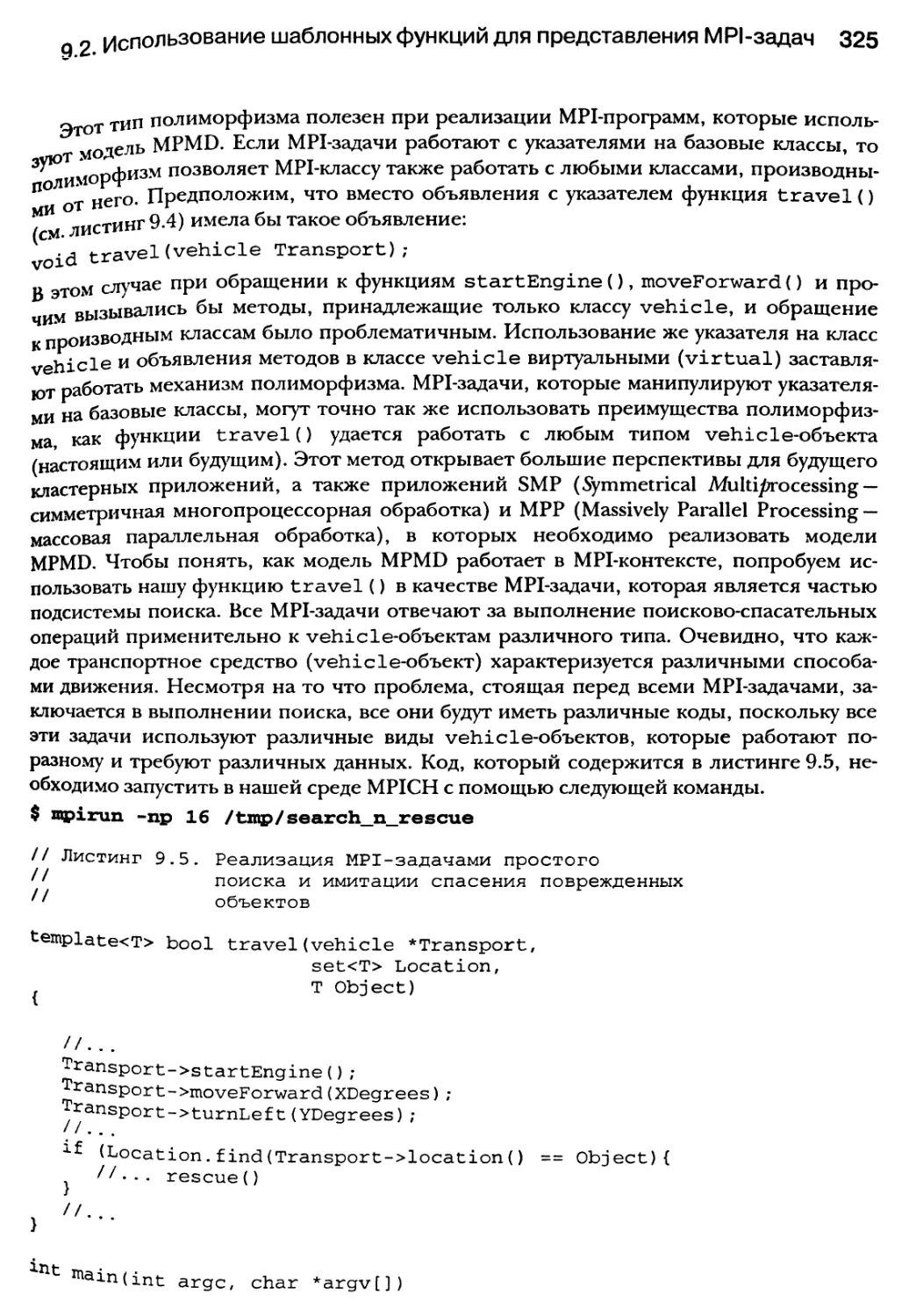

9.2. Использование шаблонных функций для представления МР1-задач 320

9.2.1. Реализация шаблонов и модель SPMD (типы данных) 321

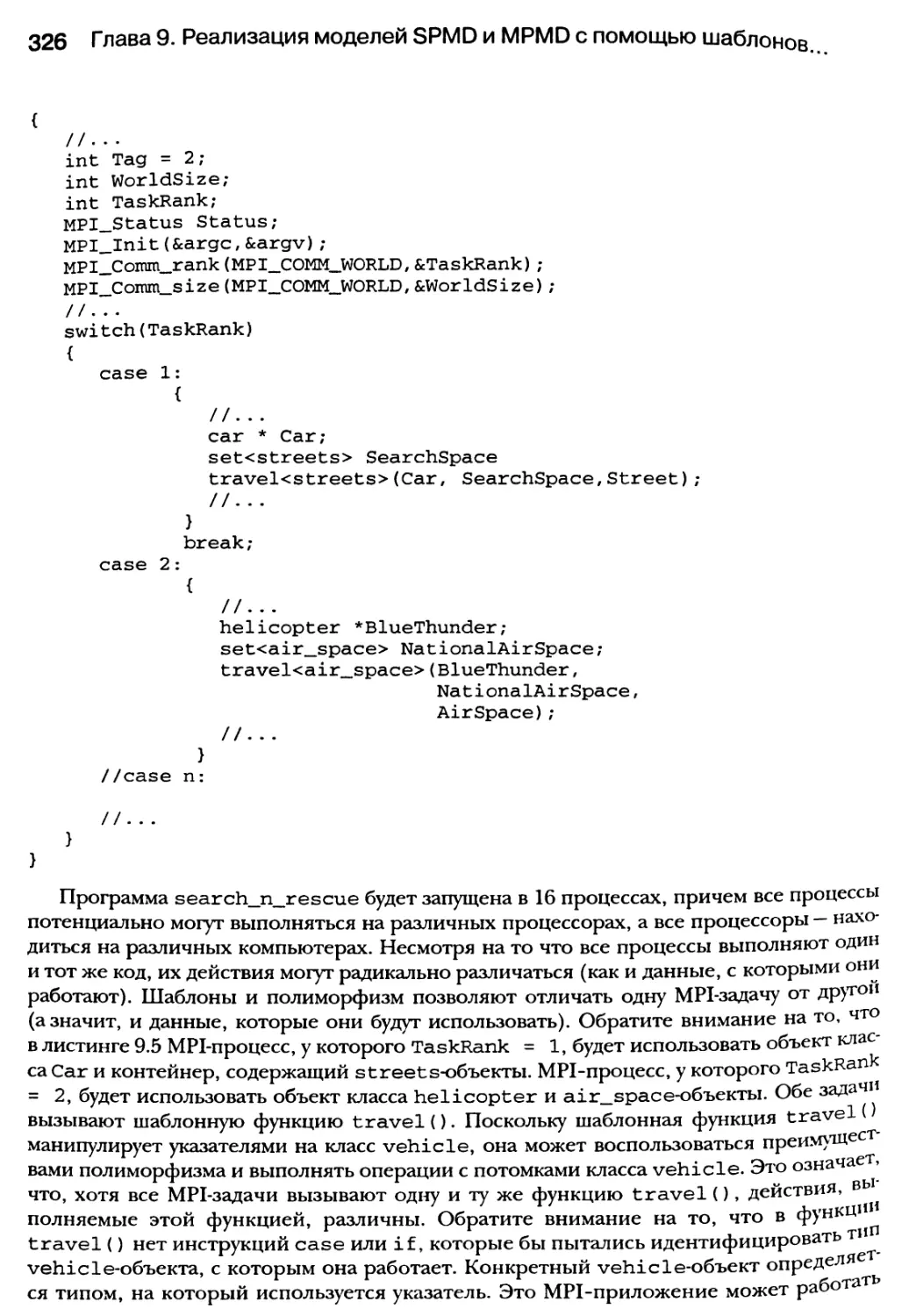

9.2.2. Использование полиморфизма для реализации MPMD-модели 322

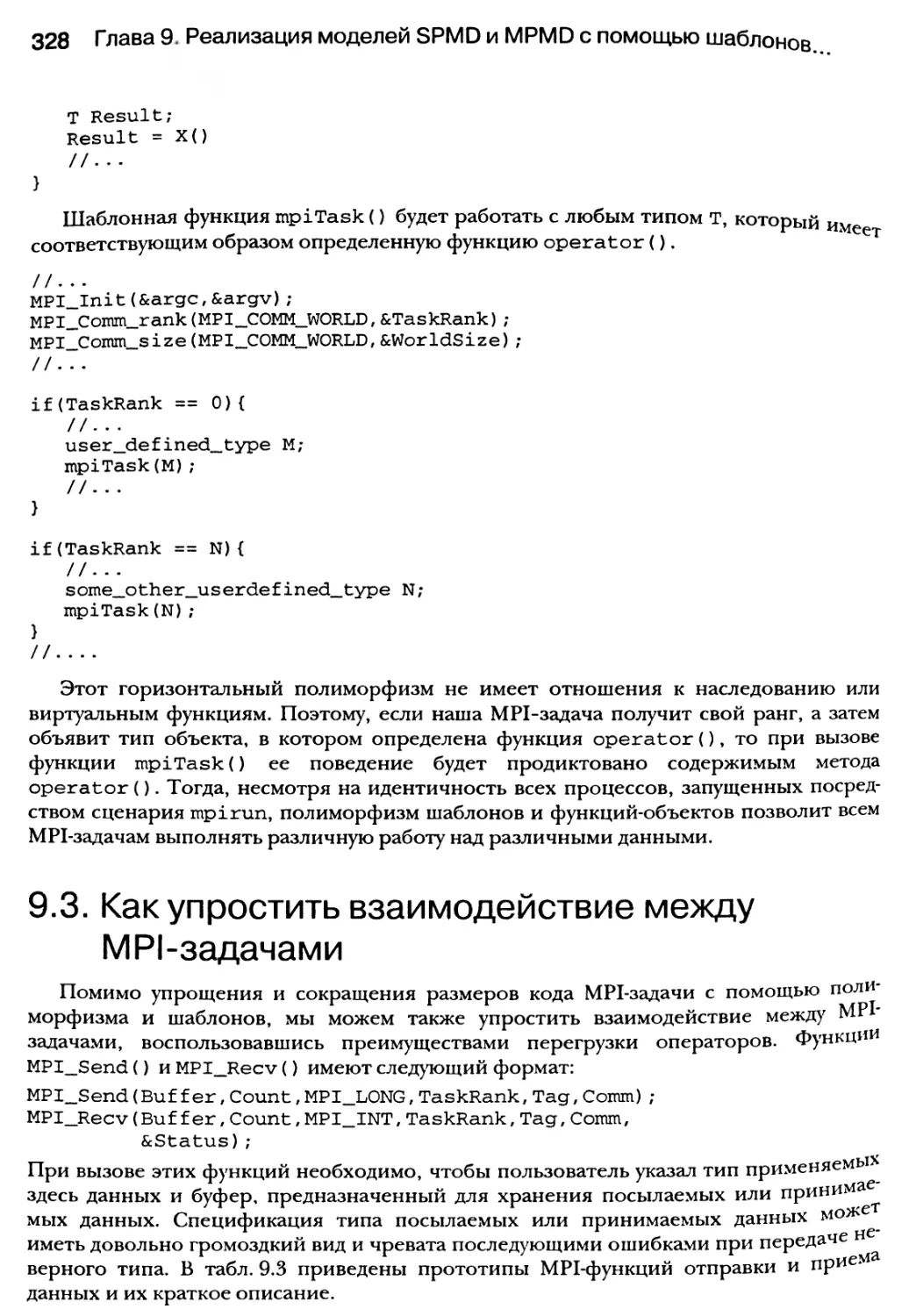

9.2.3. Введение MPMD-модели с помощью функций-объектов 327

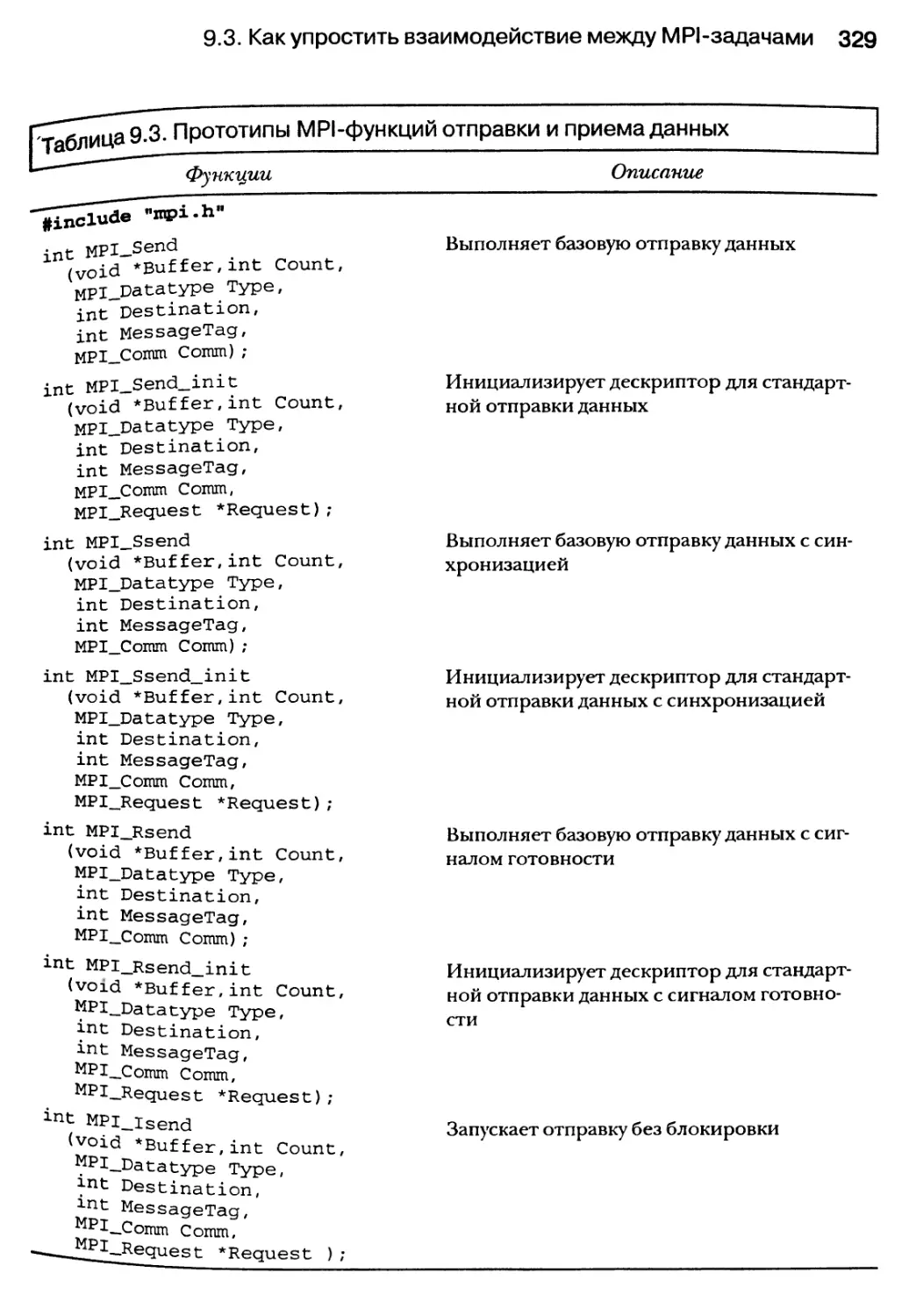

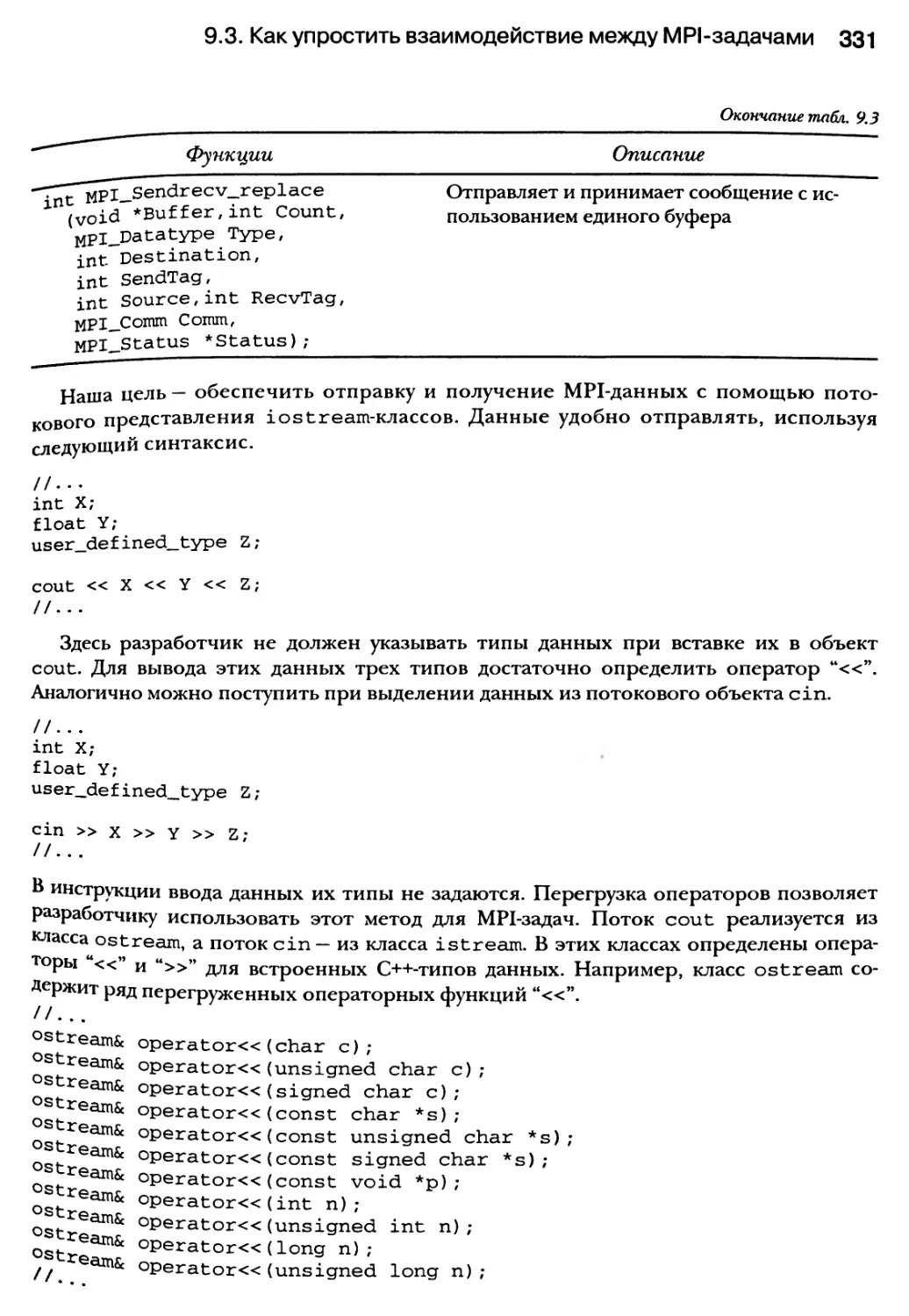

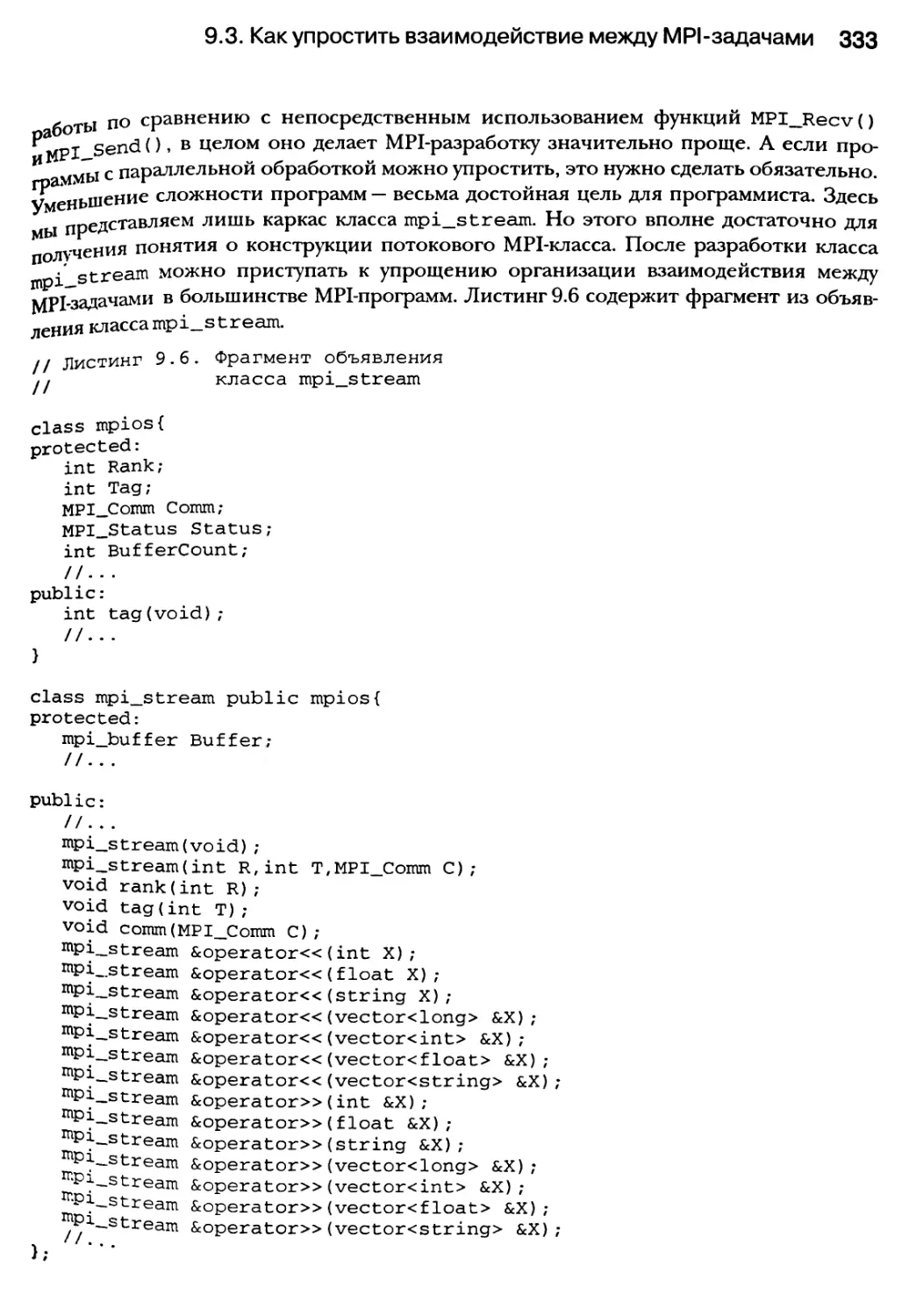

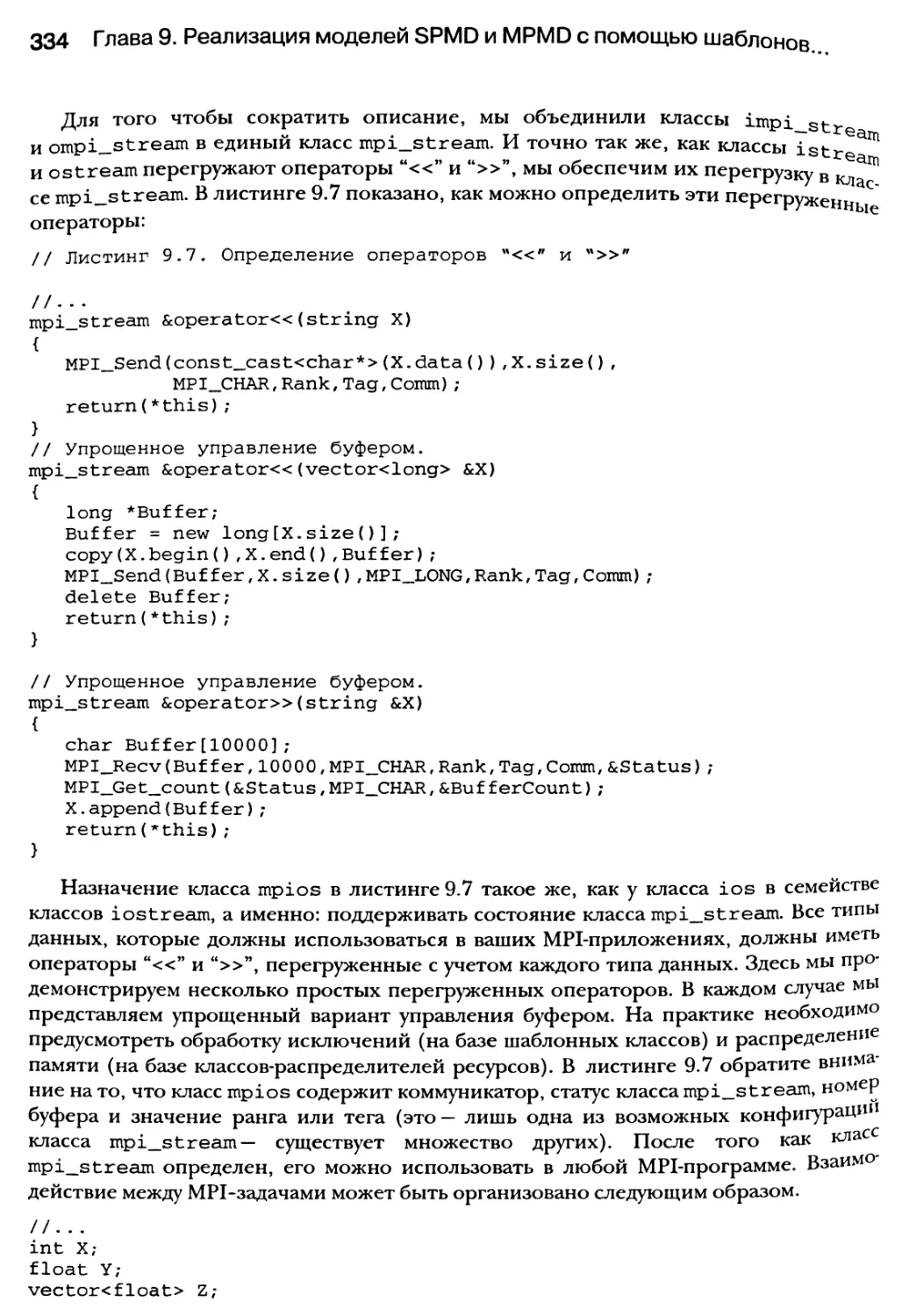

9.3. Как упростить взаимодействие между MPI-задачами 328

9.3.1. Перегрузка операторов “«” и “»” для организации взаимодействия

между MPI-задачами 332

9.4. Резюме 335

Глава 10. Визуализация проектов параллельных

и распределенных систем ззб

10.1. Визуализация структур 338

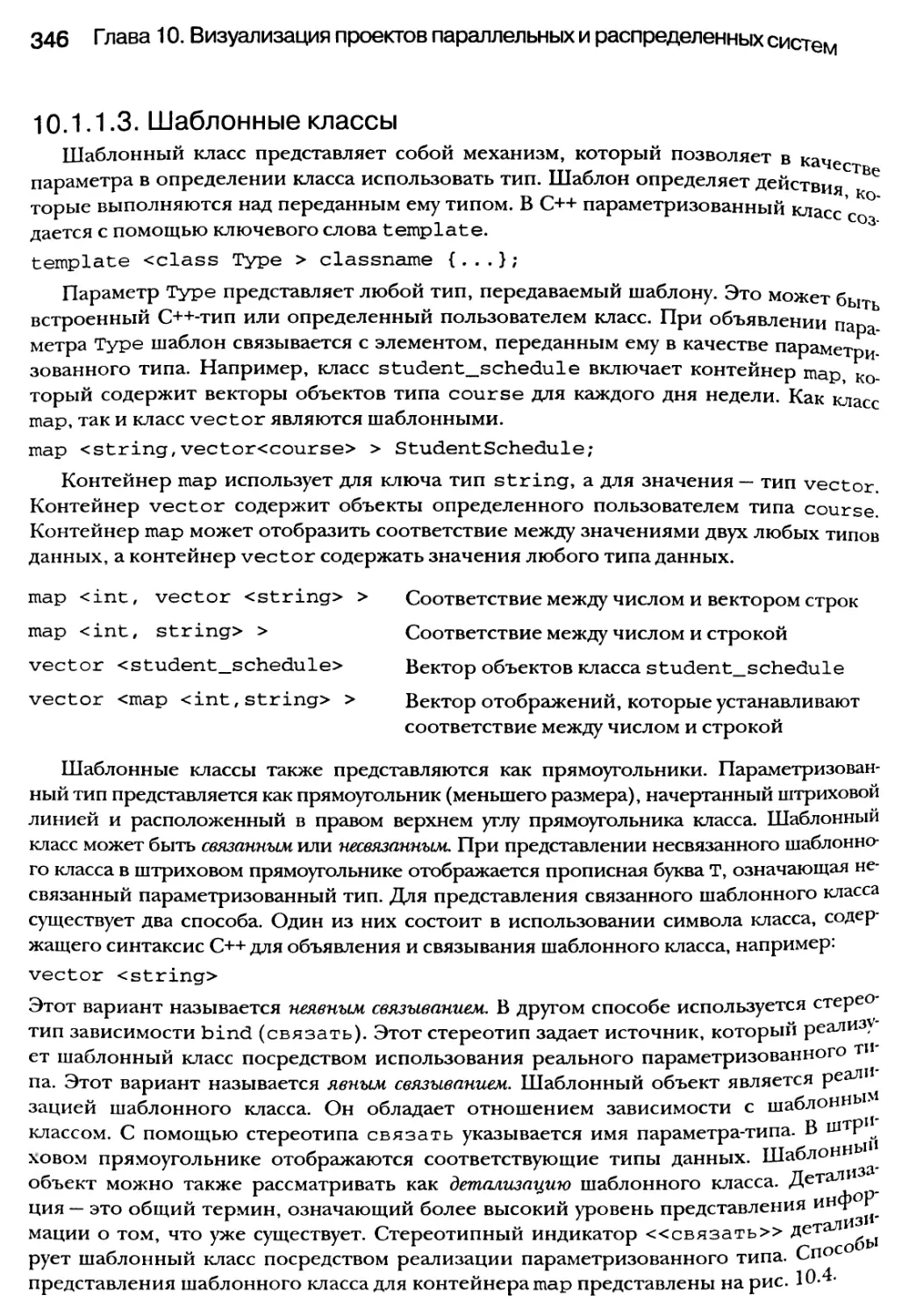

10.1.1. Классы и объекты 338

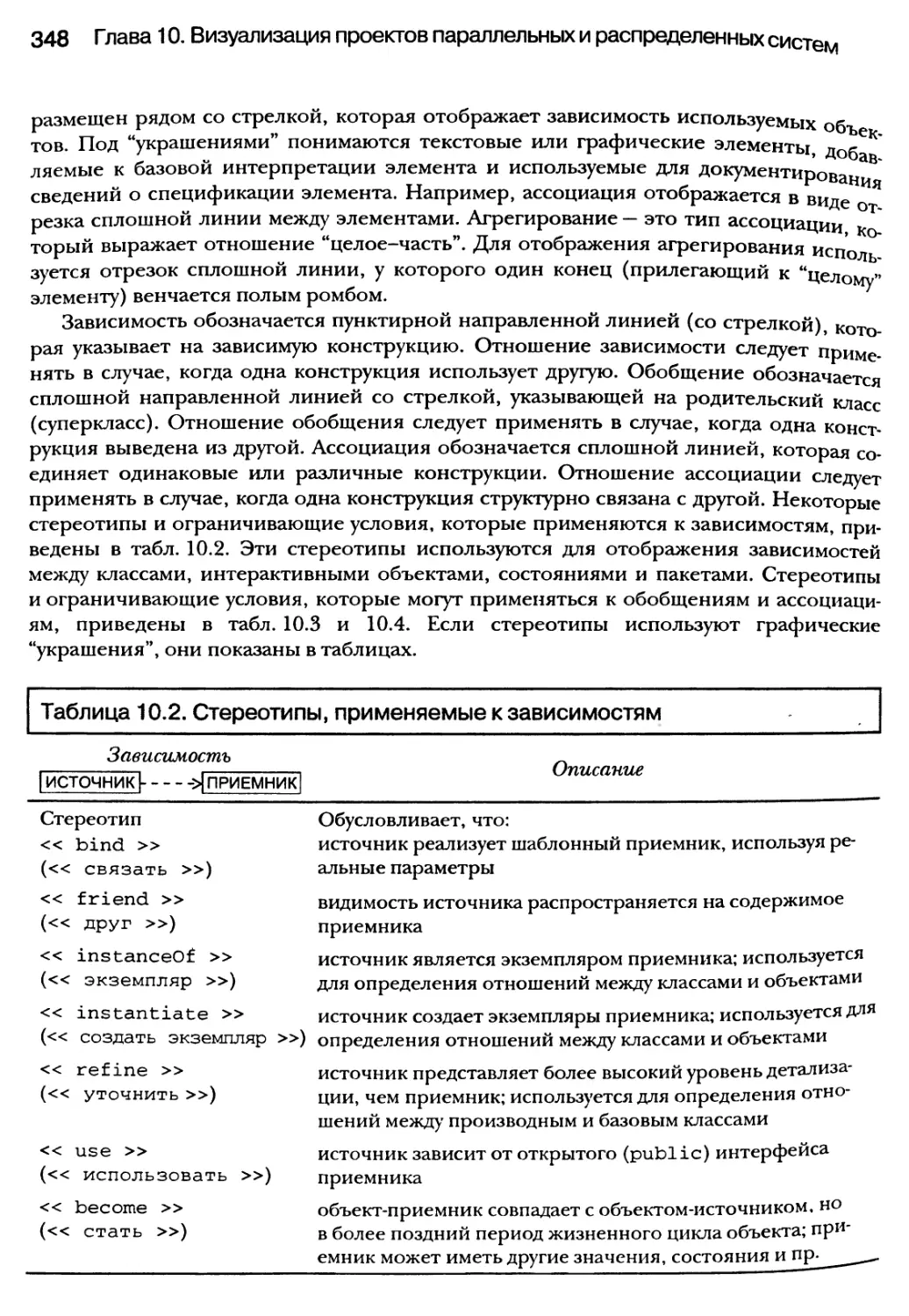

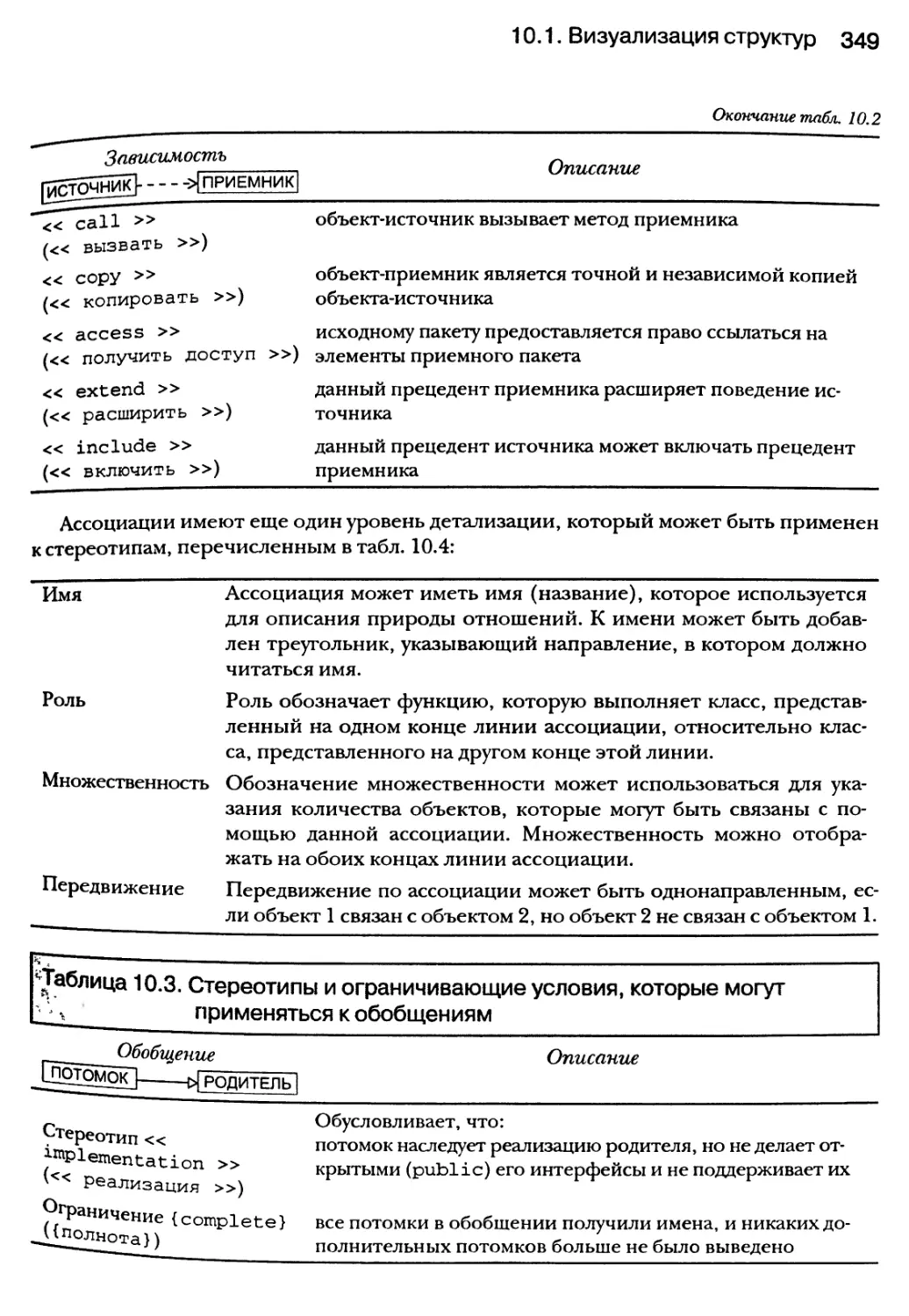

10.1.2. Отношения между классами и объектами 347

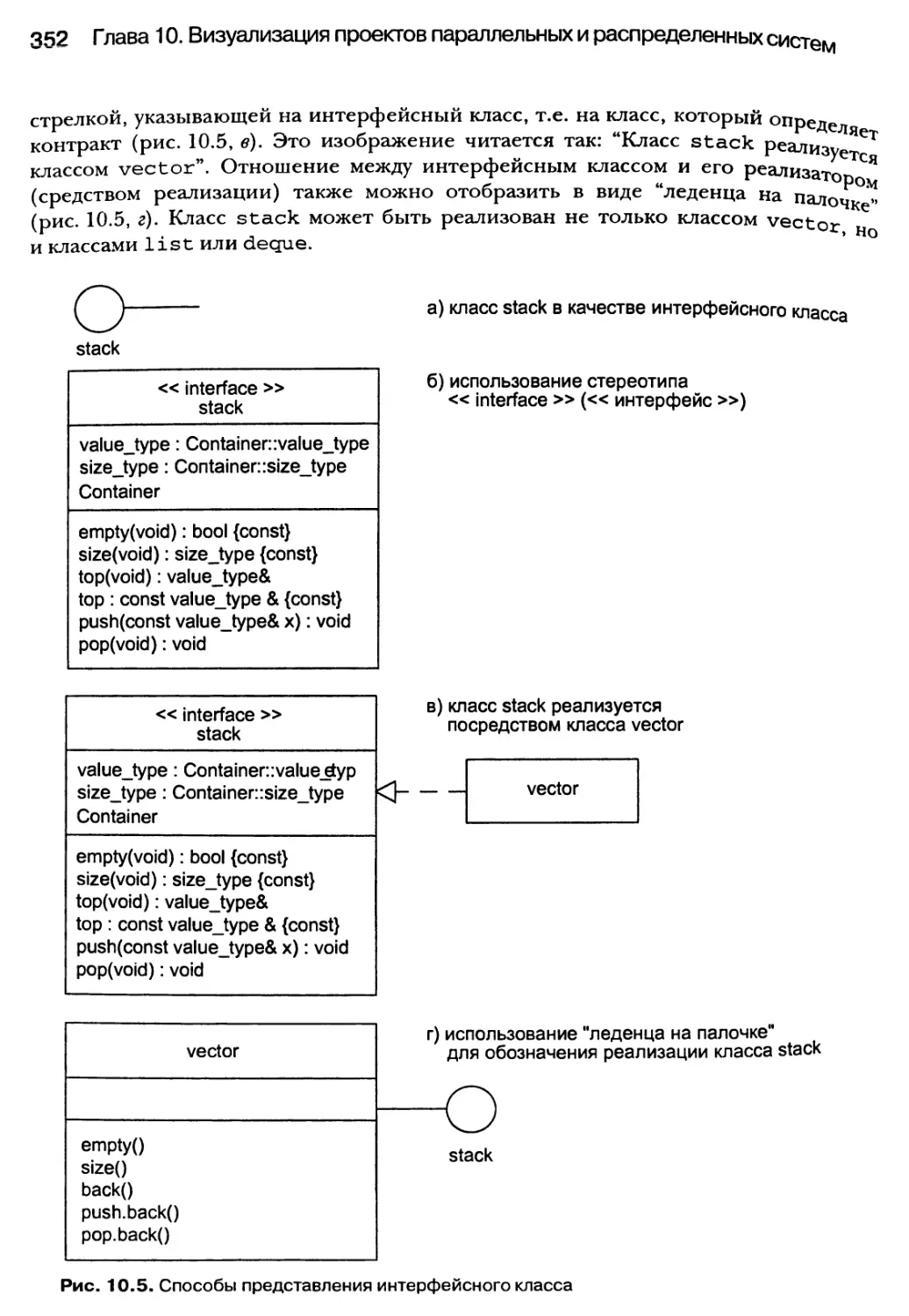

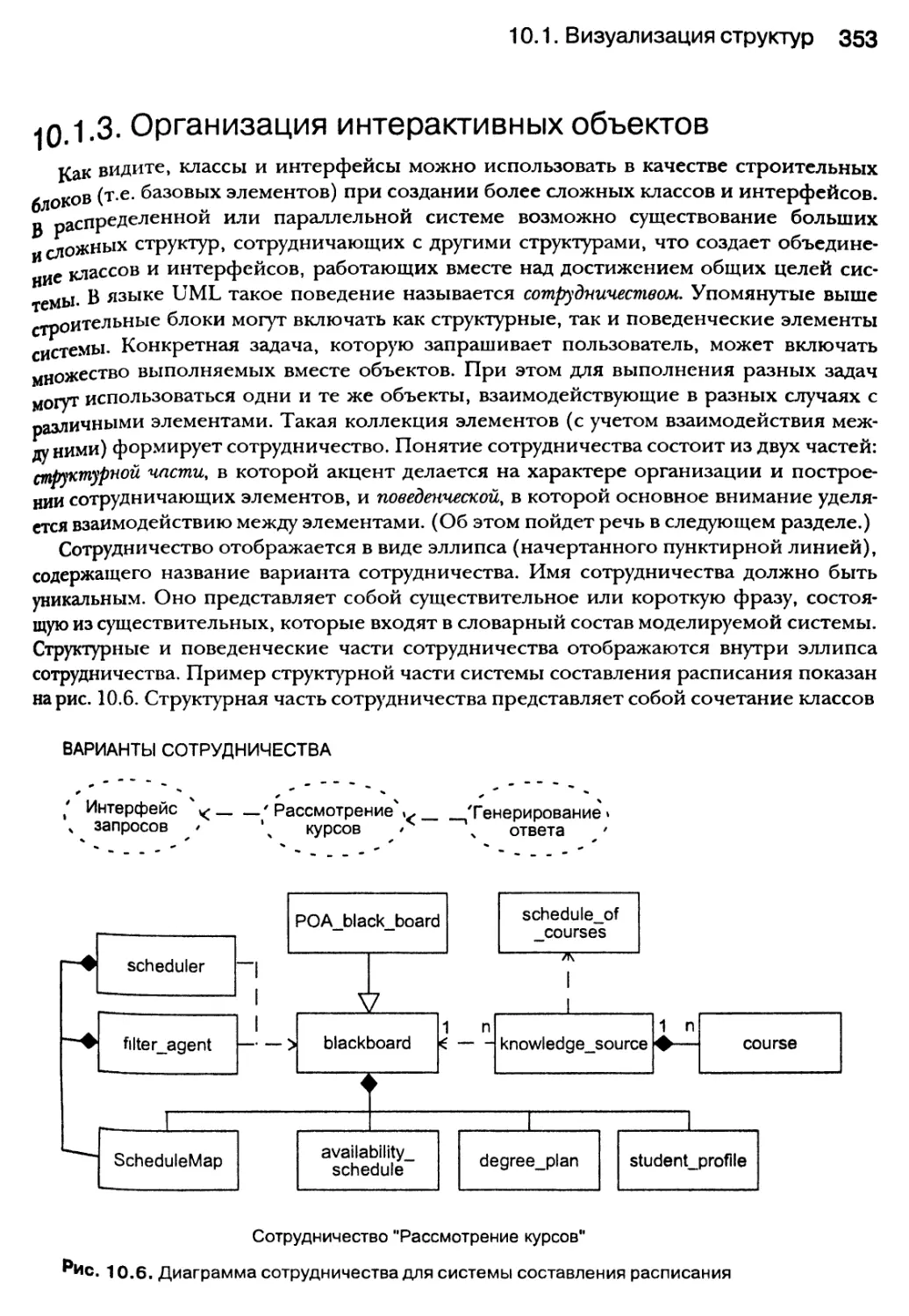

10.1.3. Организация интерактивных объектов 353

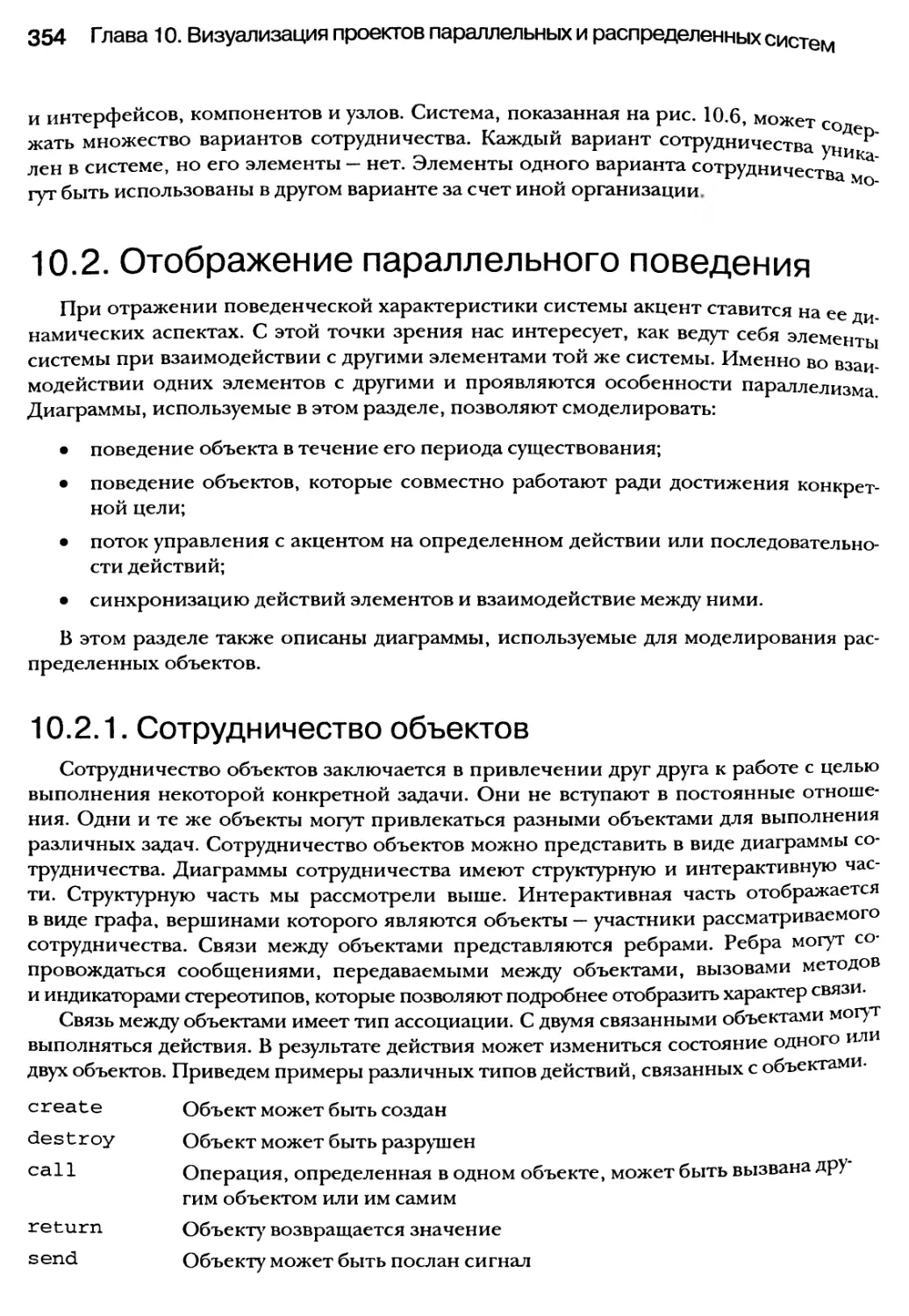

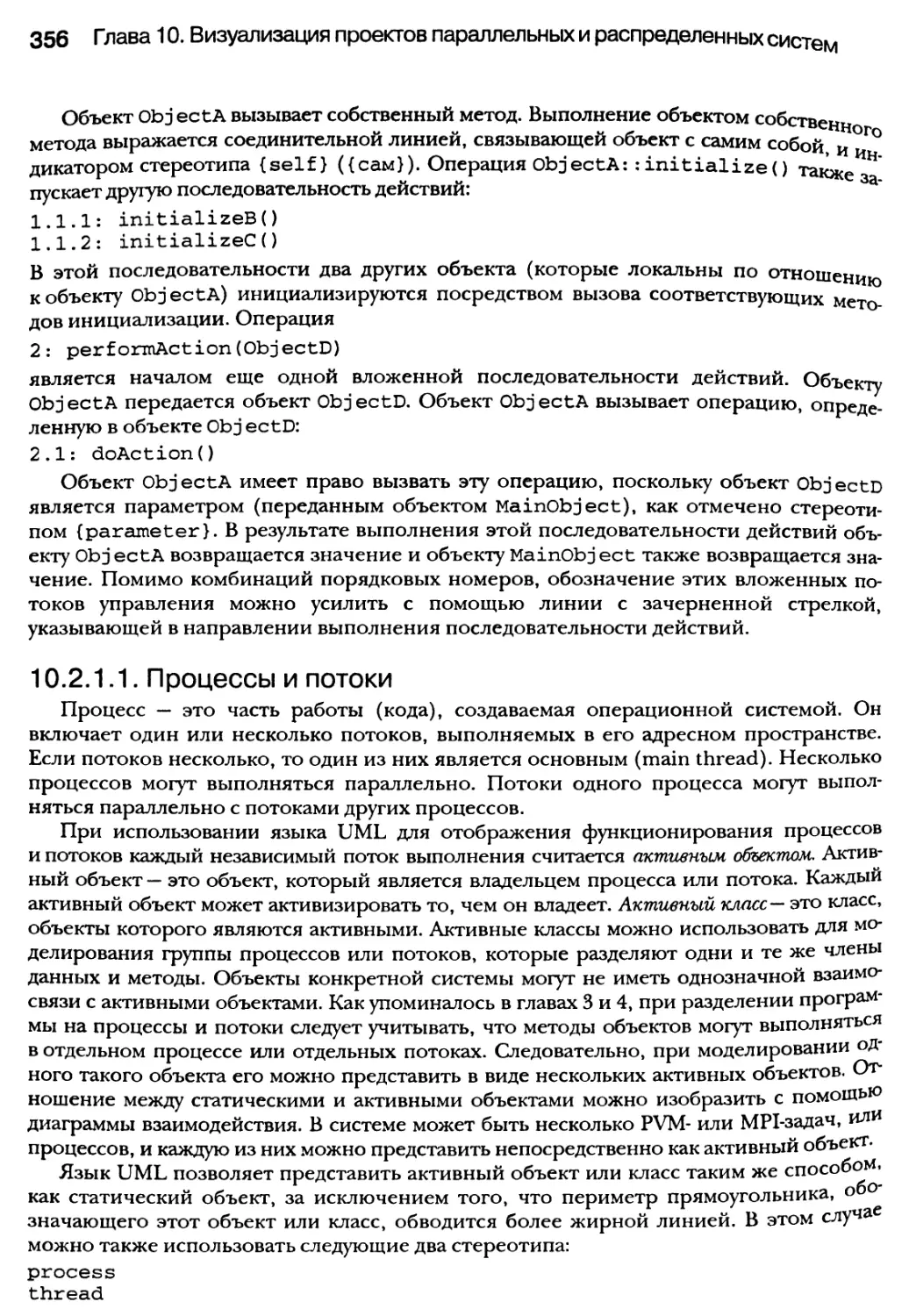

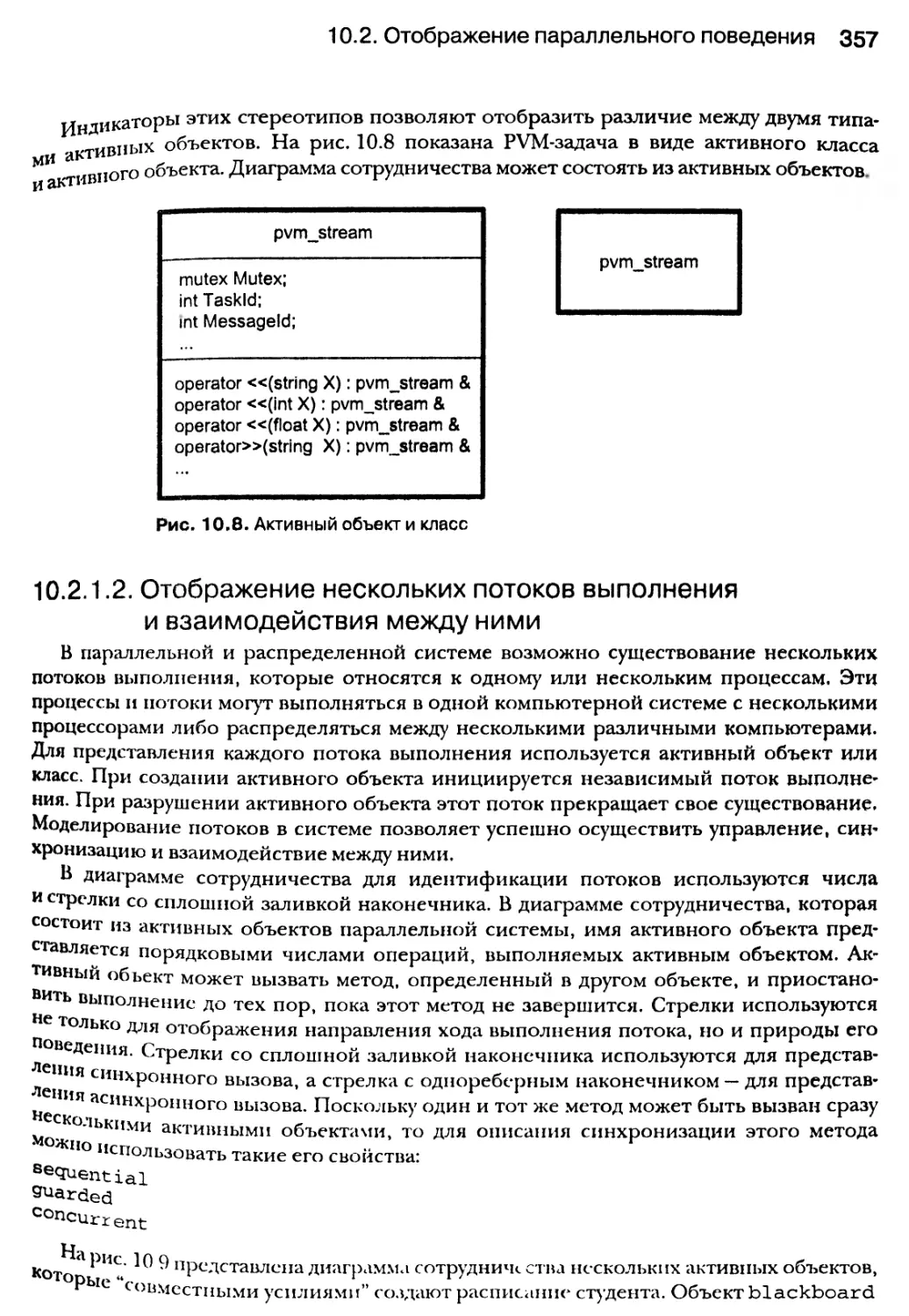

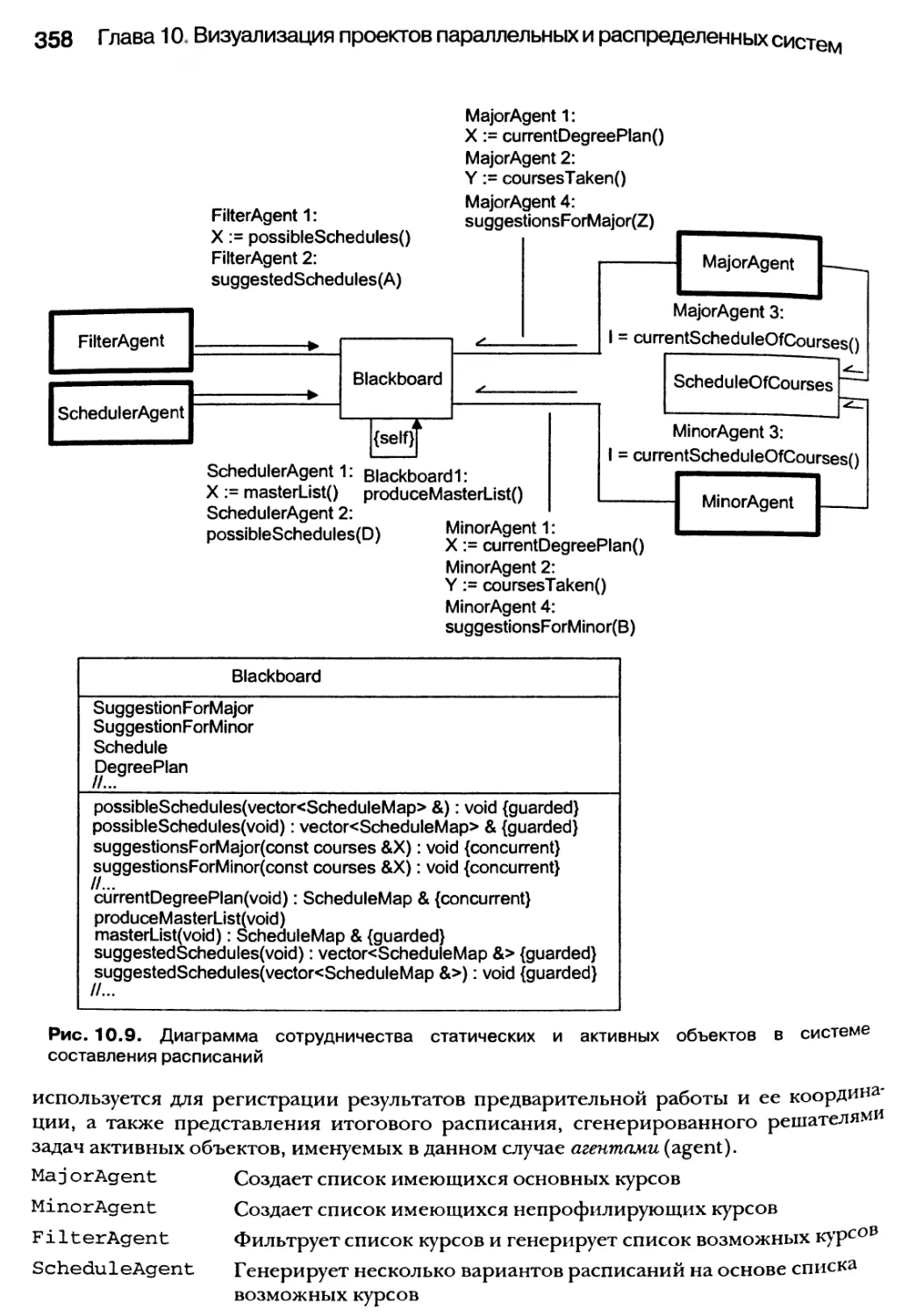

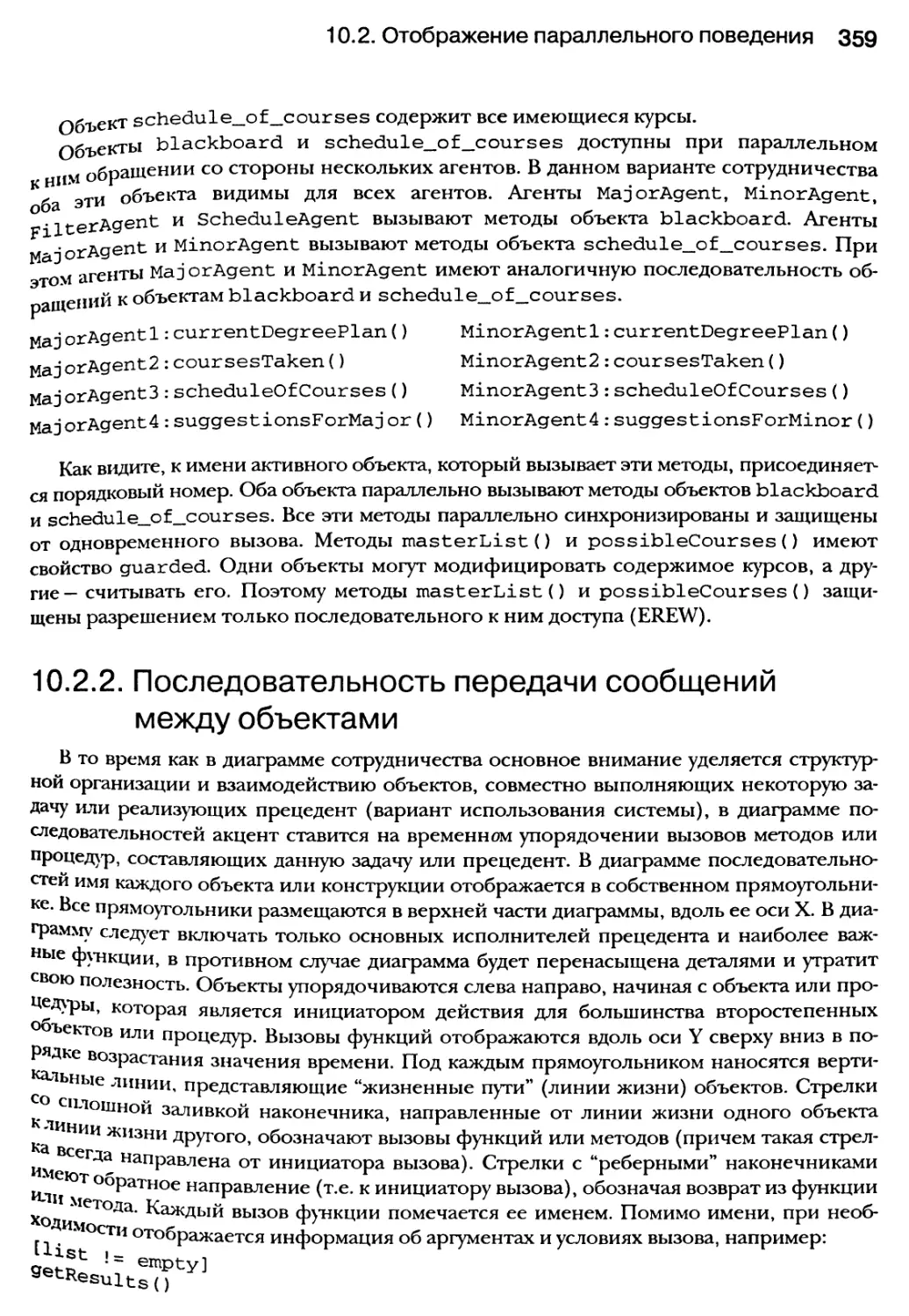

10.2. Отображение параллельного поведения 354

10.2.1. Сотрудничество объектов 354

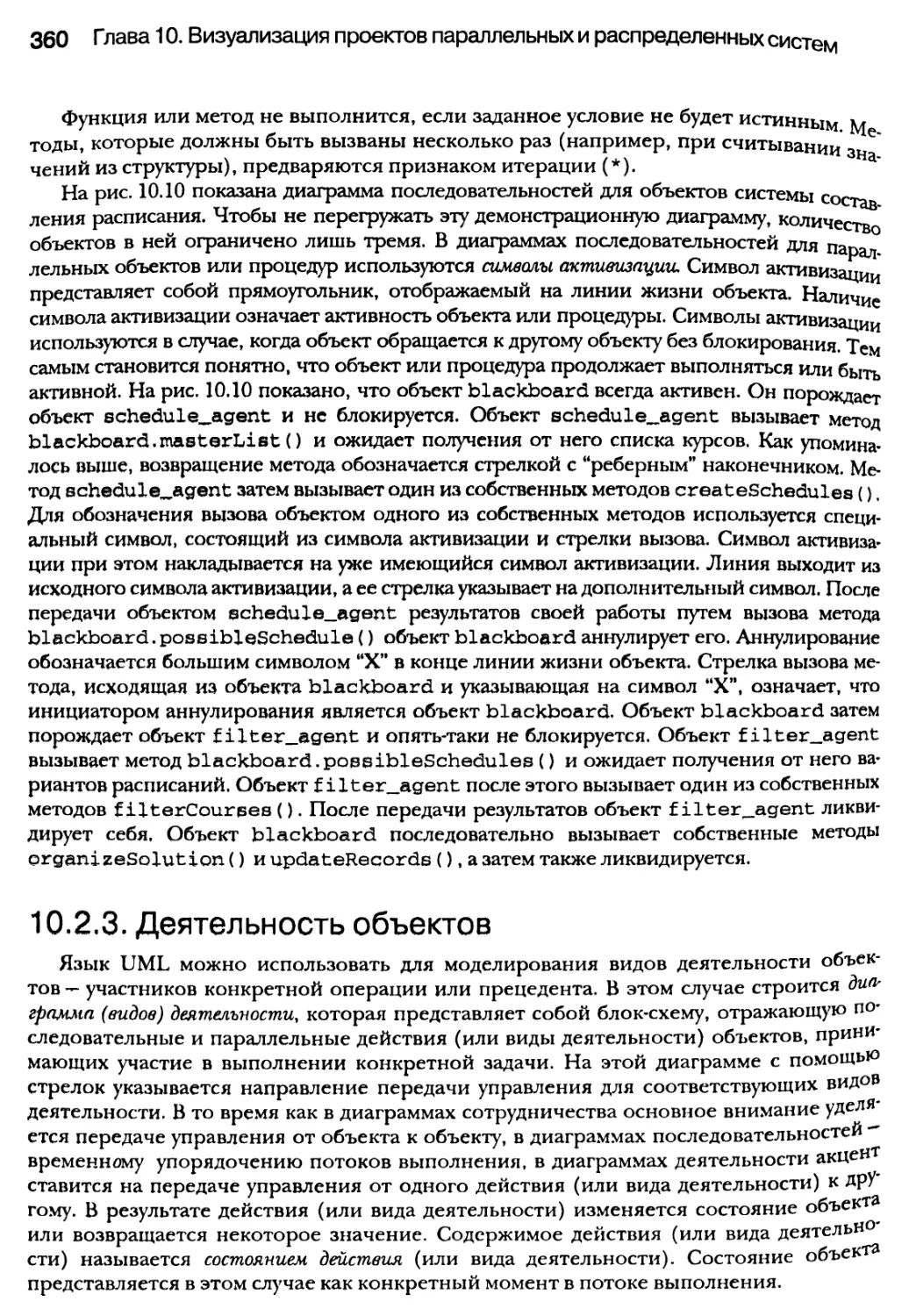

10.2.2. Последовательность передачи сообщений между объектами 359

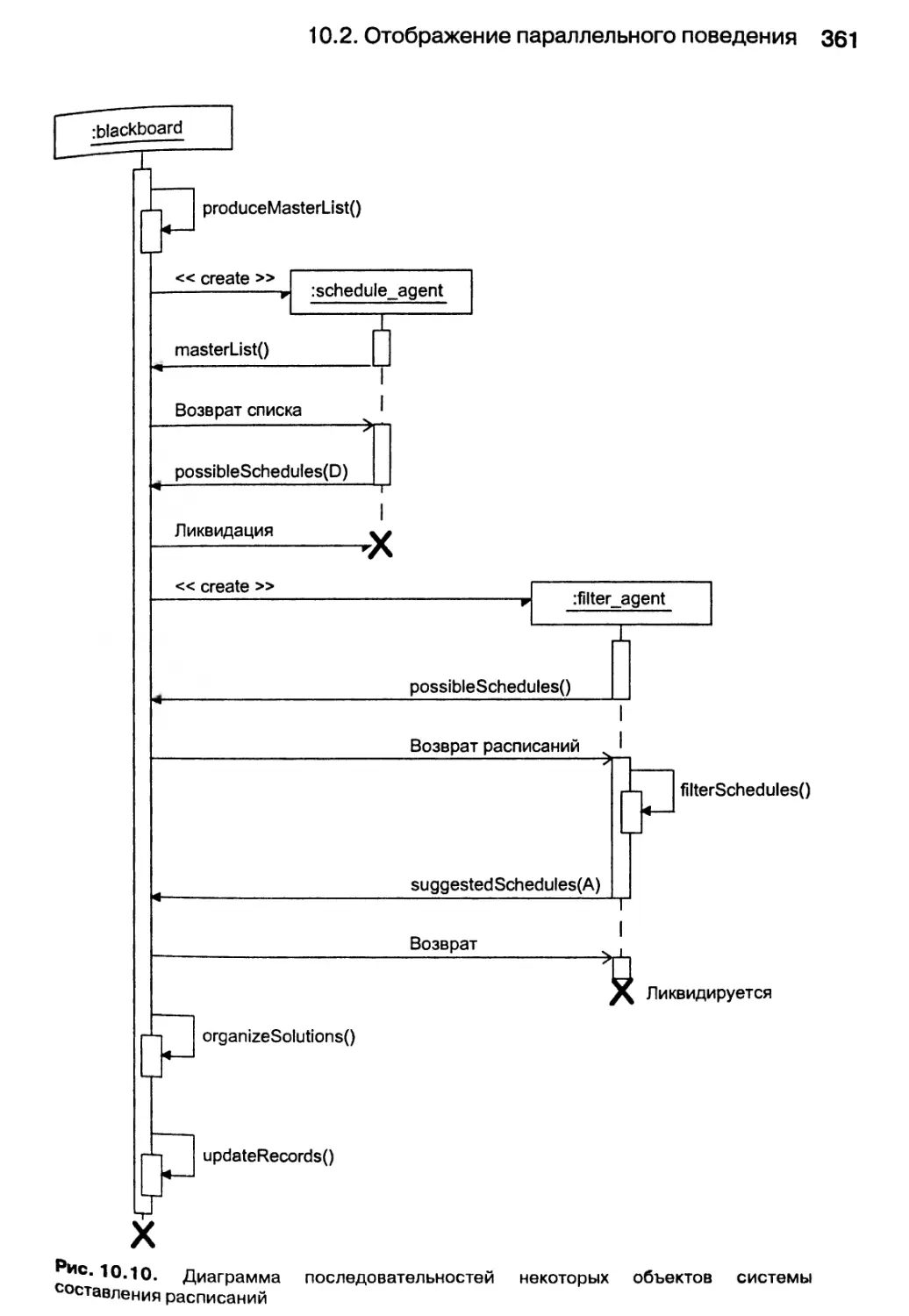

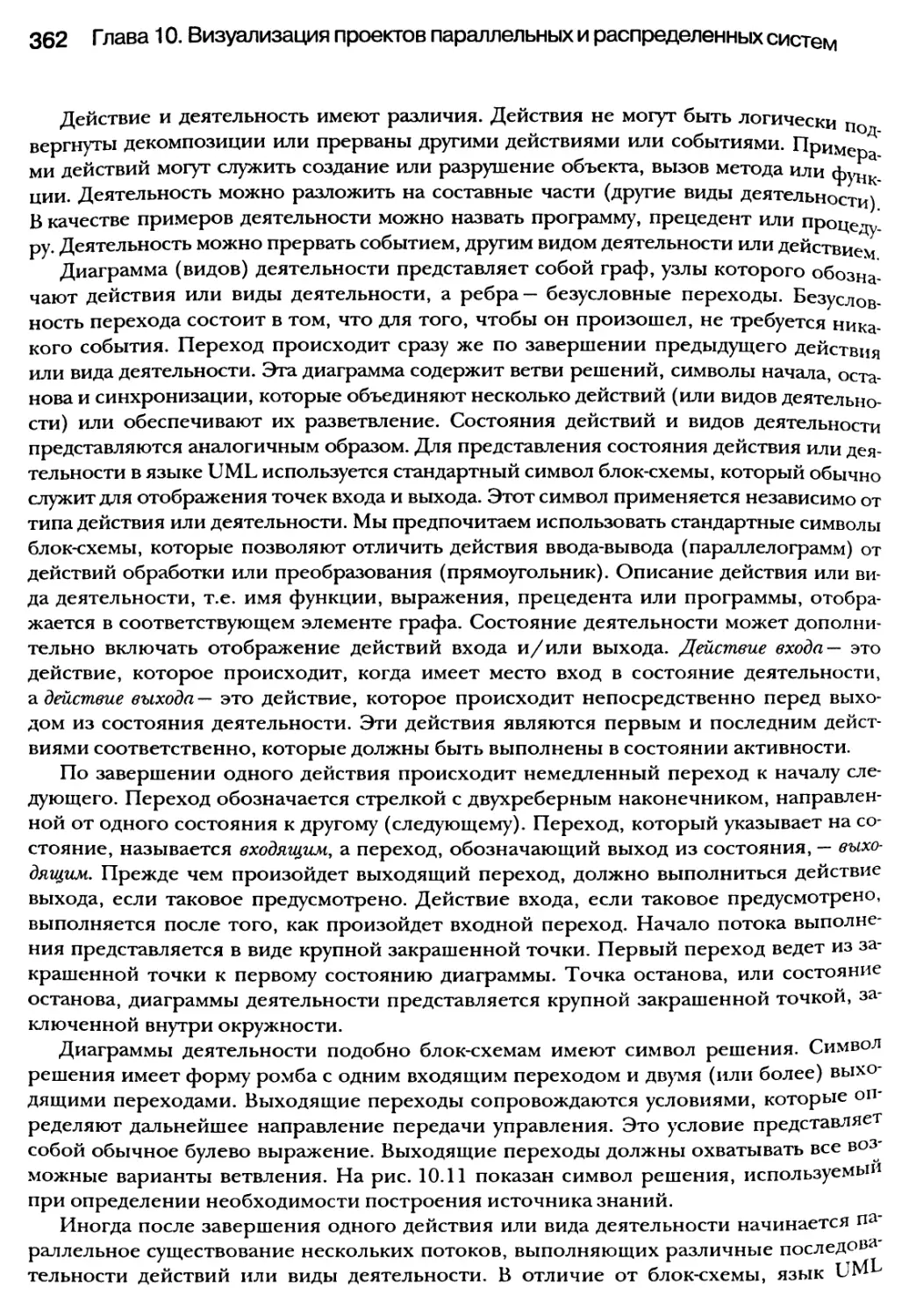

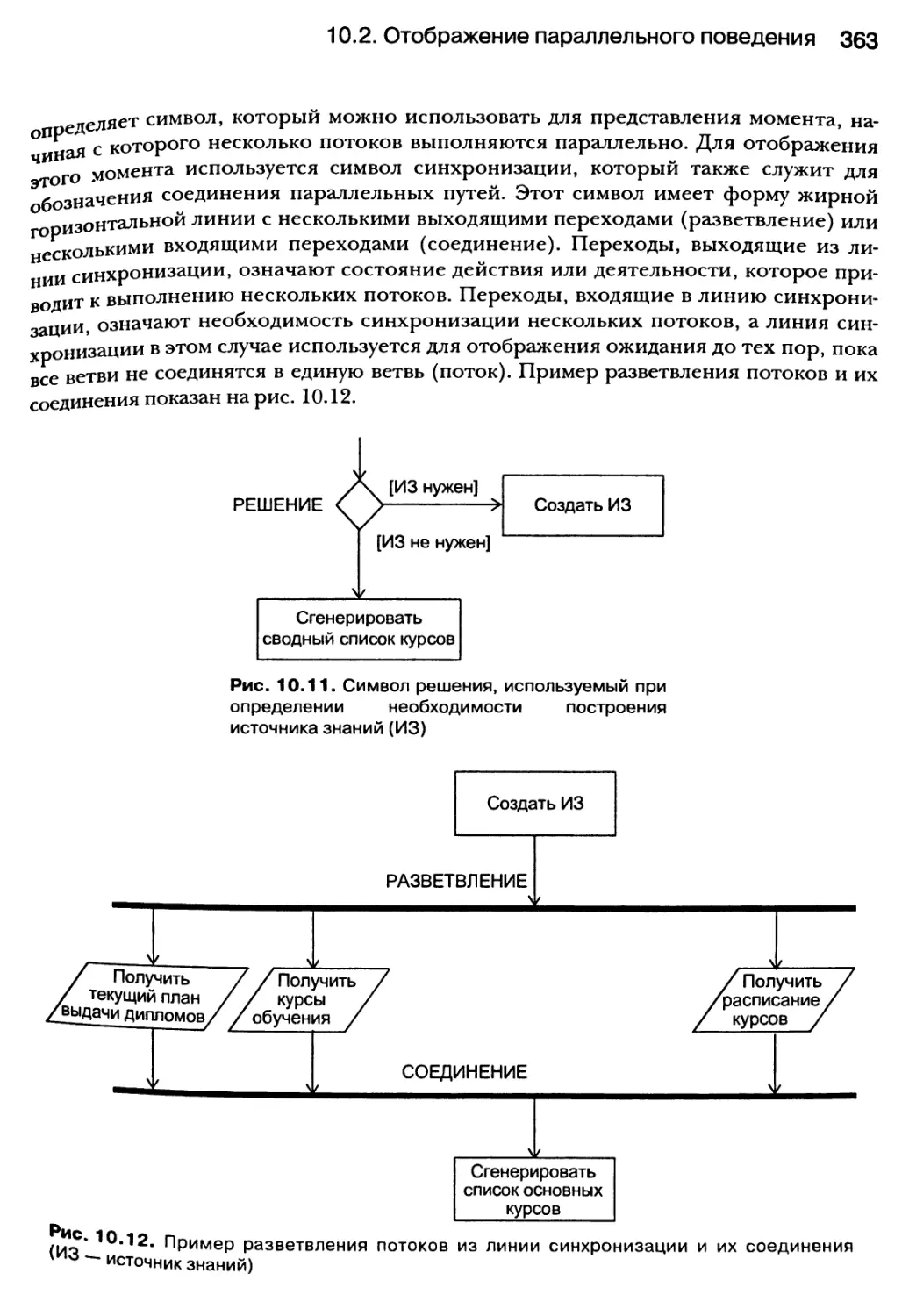

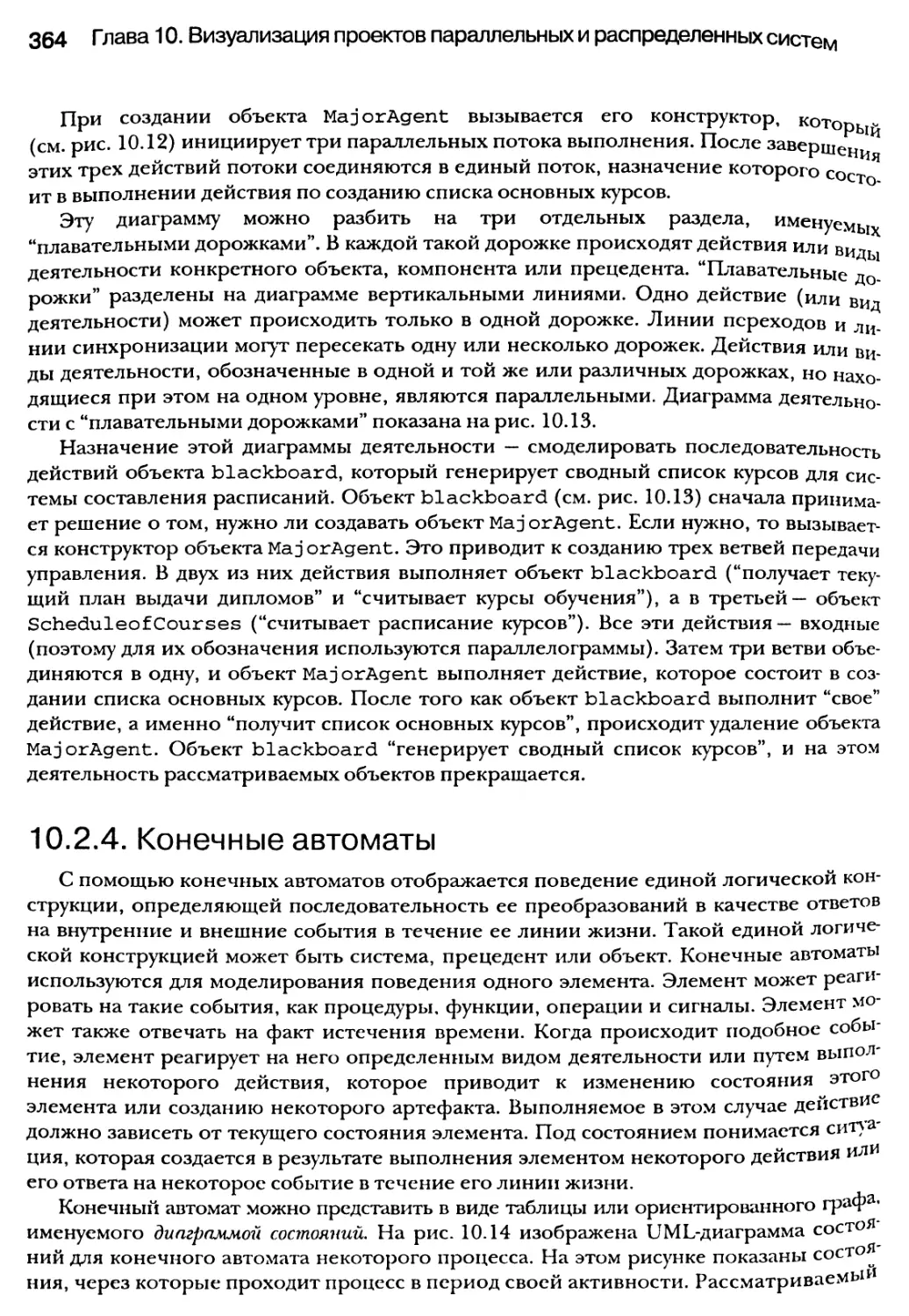

10.2.3. Деятельность объектов 360

10.2.4. Конечные автоматы 364

10.2.5. Распределенные объекты 371

Содержание 13

10.3. Визуализация всей системы 371

10.3.1. Визуализация развертывания систем 372

10.3.2. Архитектура системы 373

10.4. Резюме 374

Глава 11. Проектирование компонентов для поддержки

параллелизма 377

11.1. Как воспользоваться преимуществами интерфейсных классов 380

11.2. Подробнее об объектно-ориентированном взаимном исключении

и интерфейсных классах 385

11.2.1. “Полуширокие” интерфейсы 386

11.3. Поддержка потокового представления 393

11.3.1. Перегрузка операторов “«” и “»” для PVM-потоков данных 395

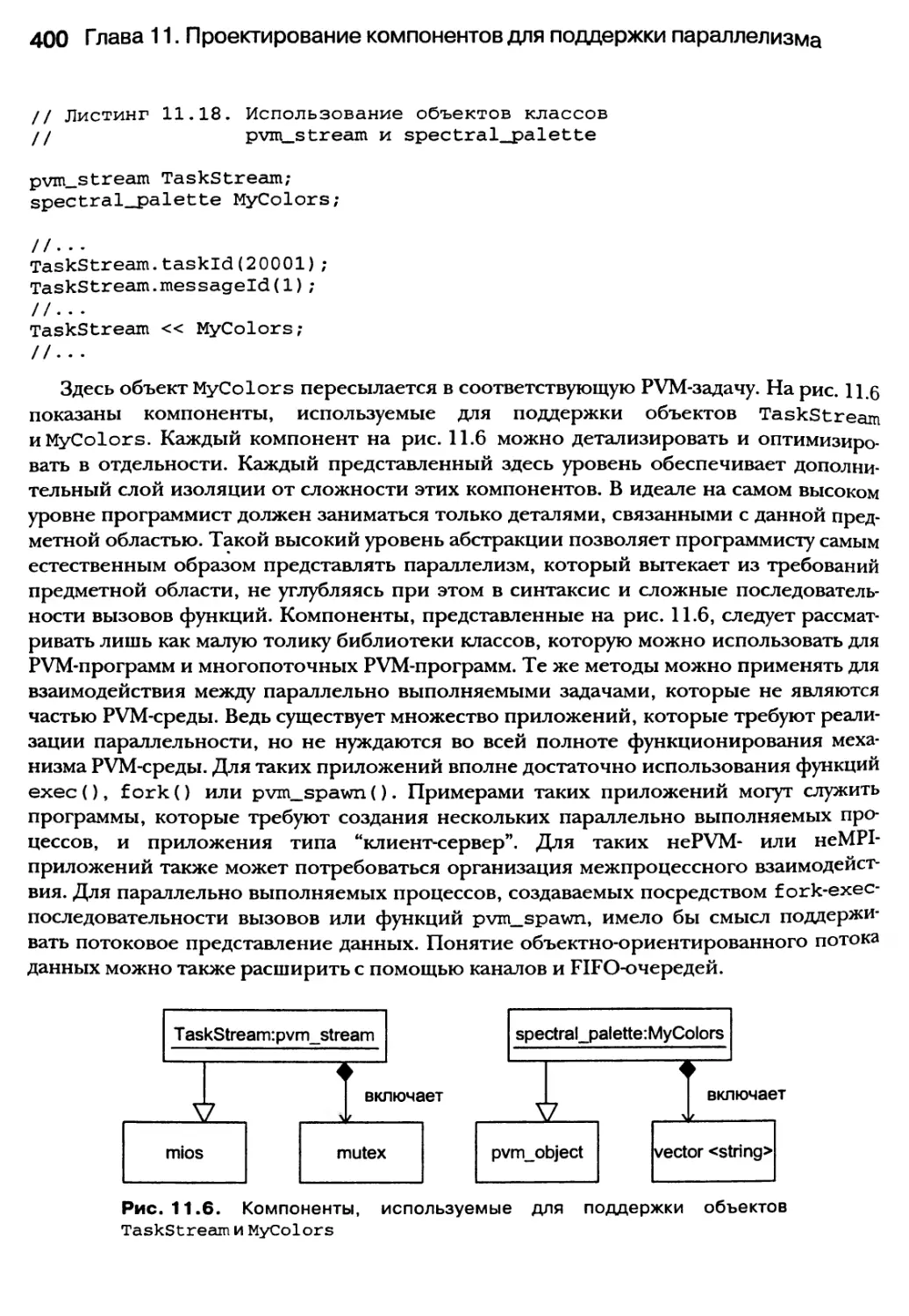

11.4. Пользовательские классы, создаваемые для обработки PVM-потоков данных 398

11.5. Объектно-ориентированные каналы и FIFO-очереди как базовые

элементы низкого уровня 401

11.5.1. Связь каналов с iostream-объектами с помощью дескрипторов файлов 405

11.5.2. Доступ к анонимным каналам с использованием итератора

OSTREAMJTERATOR 408

11.5.3. FIFO-очереди (именованные каналы), iostreams-классы и итераторы

типа ostream_iterator 415

11.6. Каркасные классы 421

11.7. Резюме 425

Глава 12. Реализация агентно-ориентированных

архитектур 427

12.1. Что такое агенты 429

12.1.1. Агенты: исходное определение 429

12.1.2. Типы агентов 430

12.1.3. В чем состоит разница между объектами и агентами 431

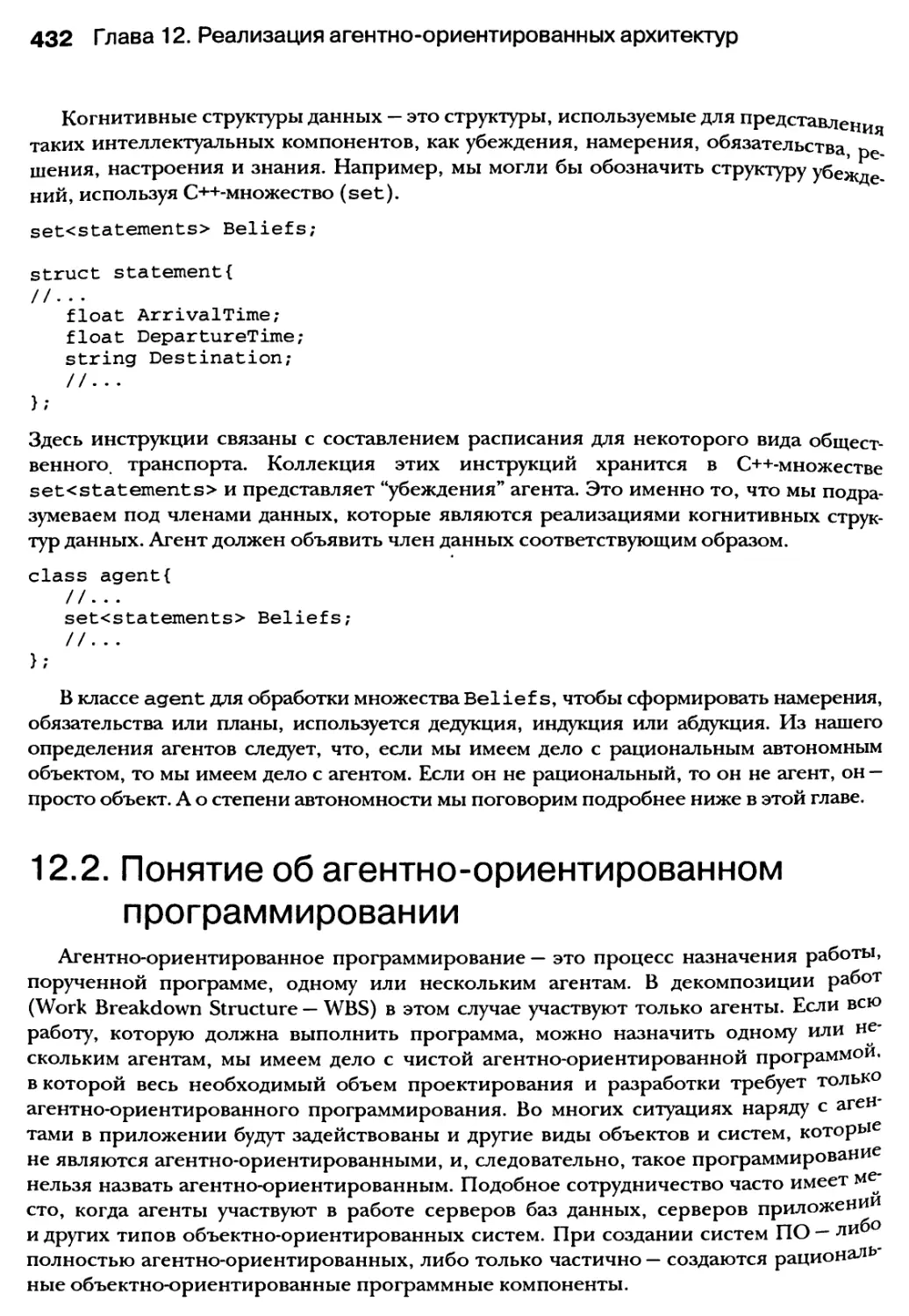

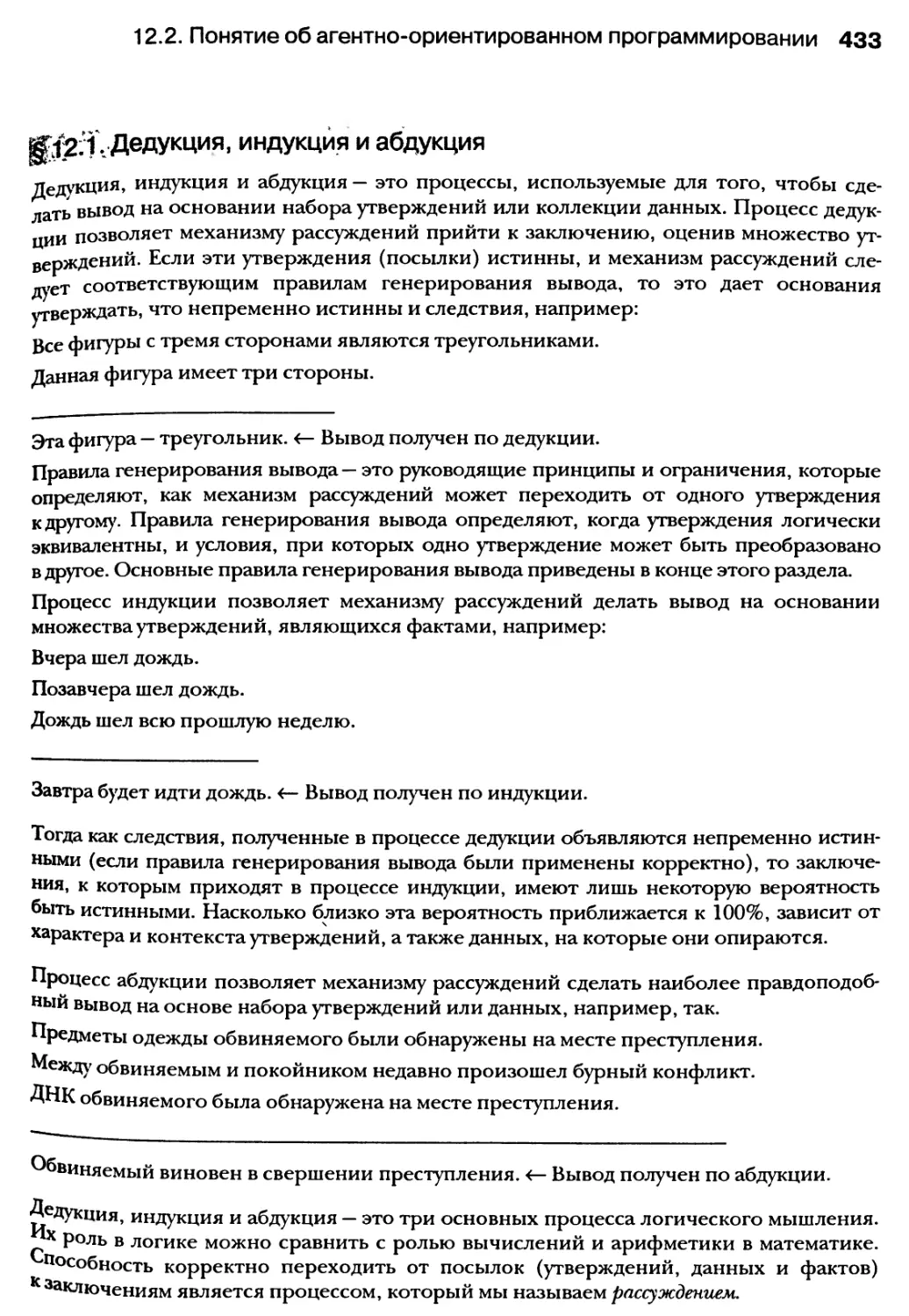

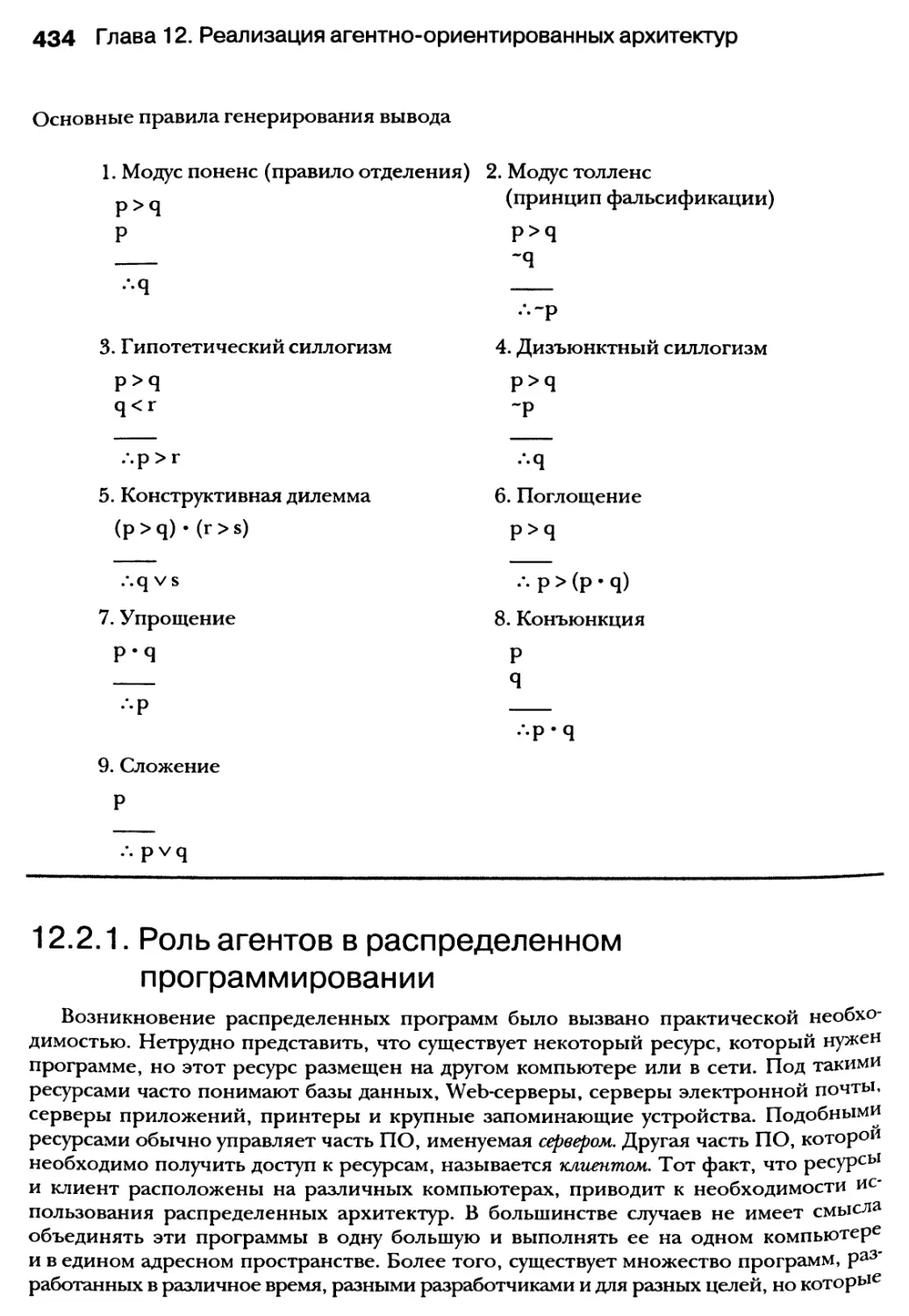

12.2. Понятие об агентно-ориентированном программировании 432

12.2.1. Роль агентов в распределенном программировании 434

12.2.2. Агенты и параллельное программирование 436

12.3. Базовые компоненты агентов 437

12.3.1. Когнитивные структуры данных 438

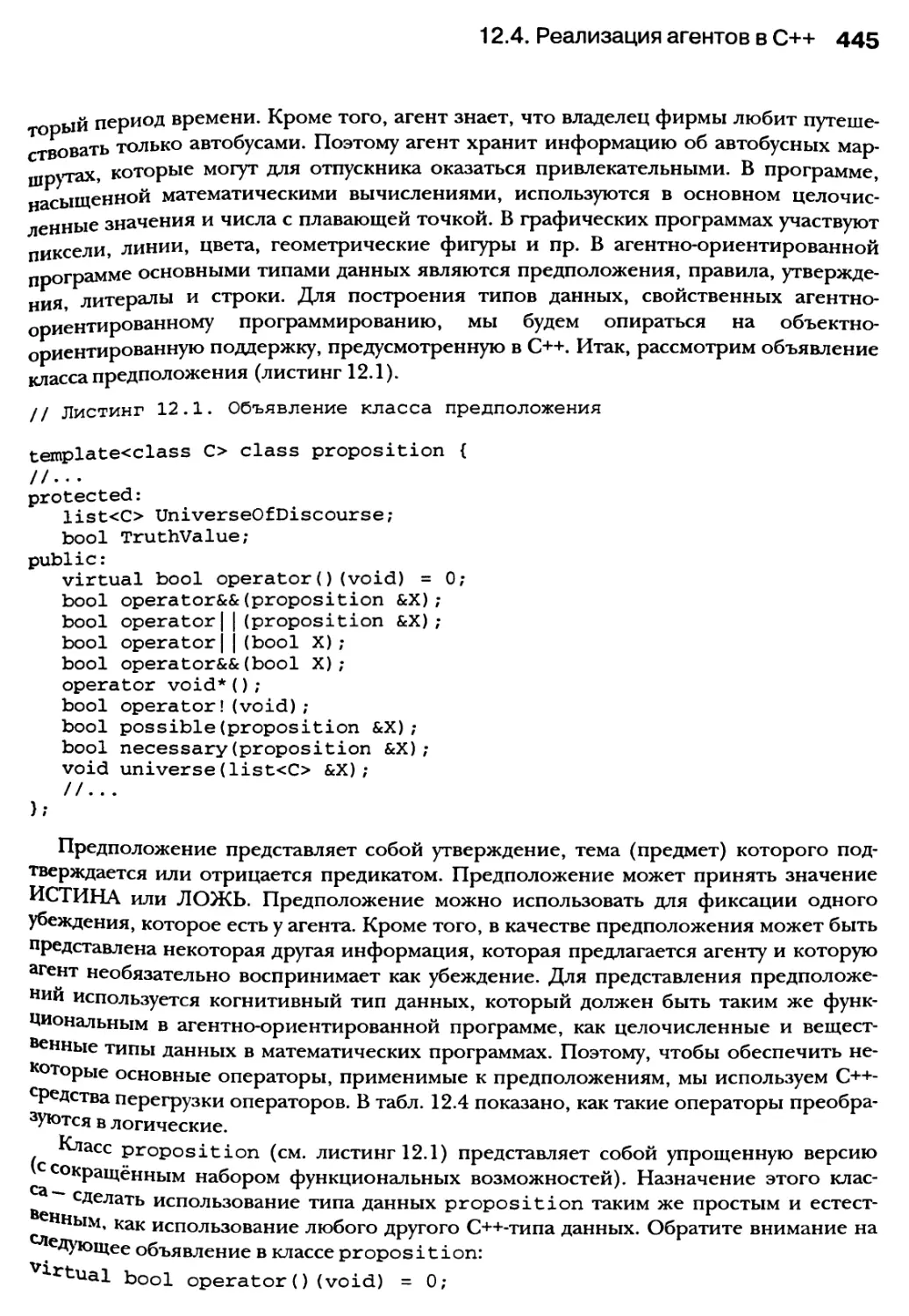

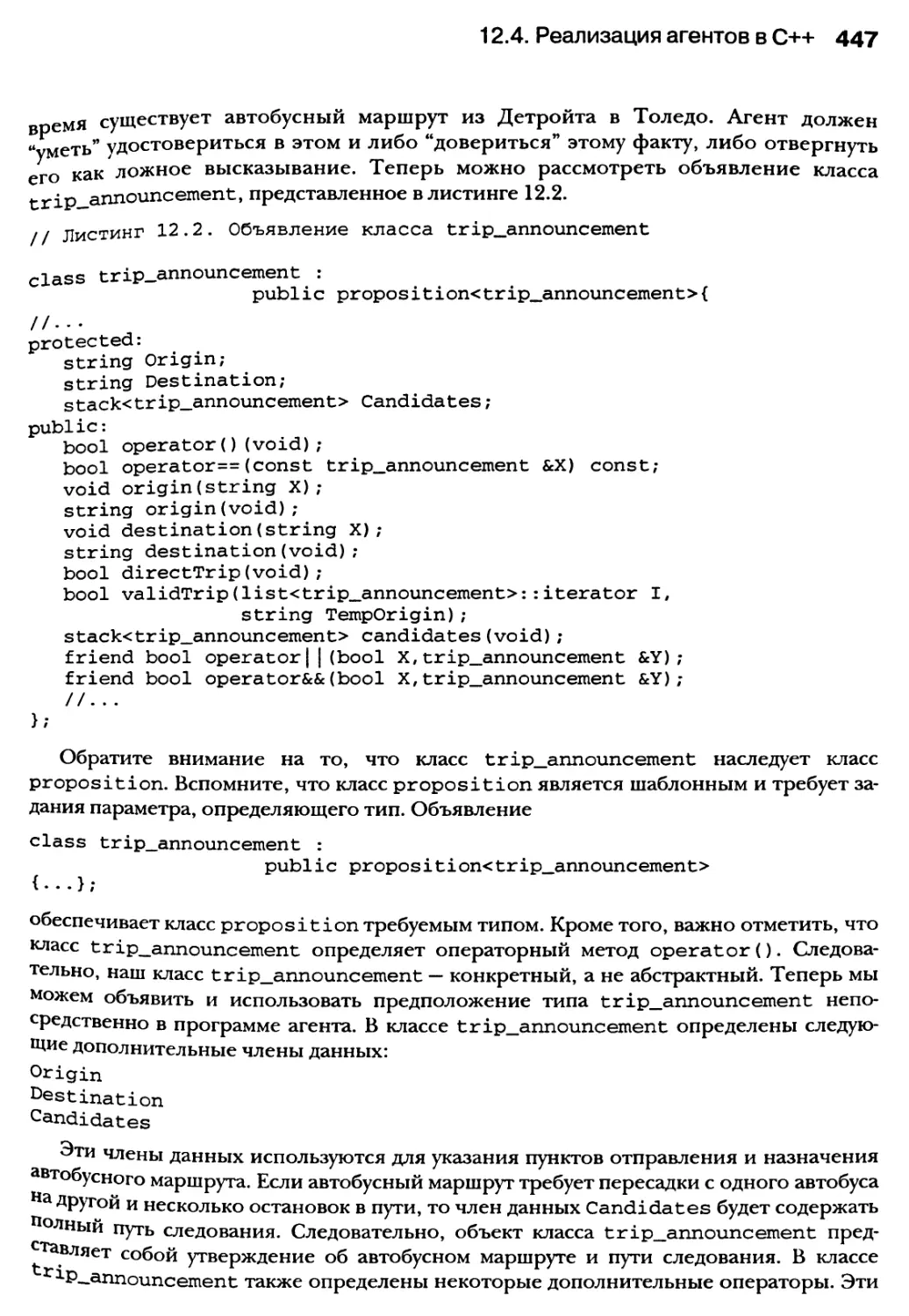

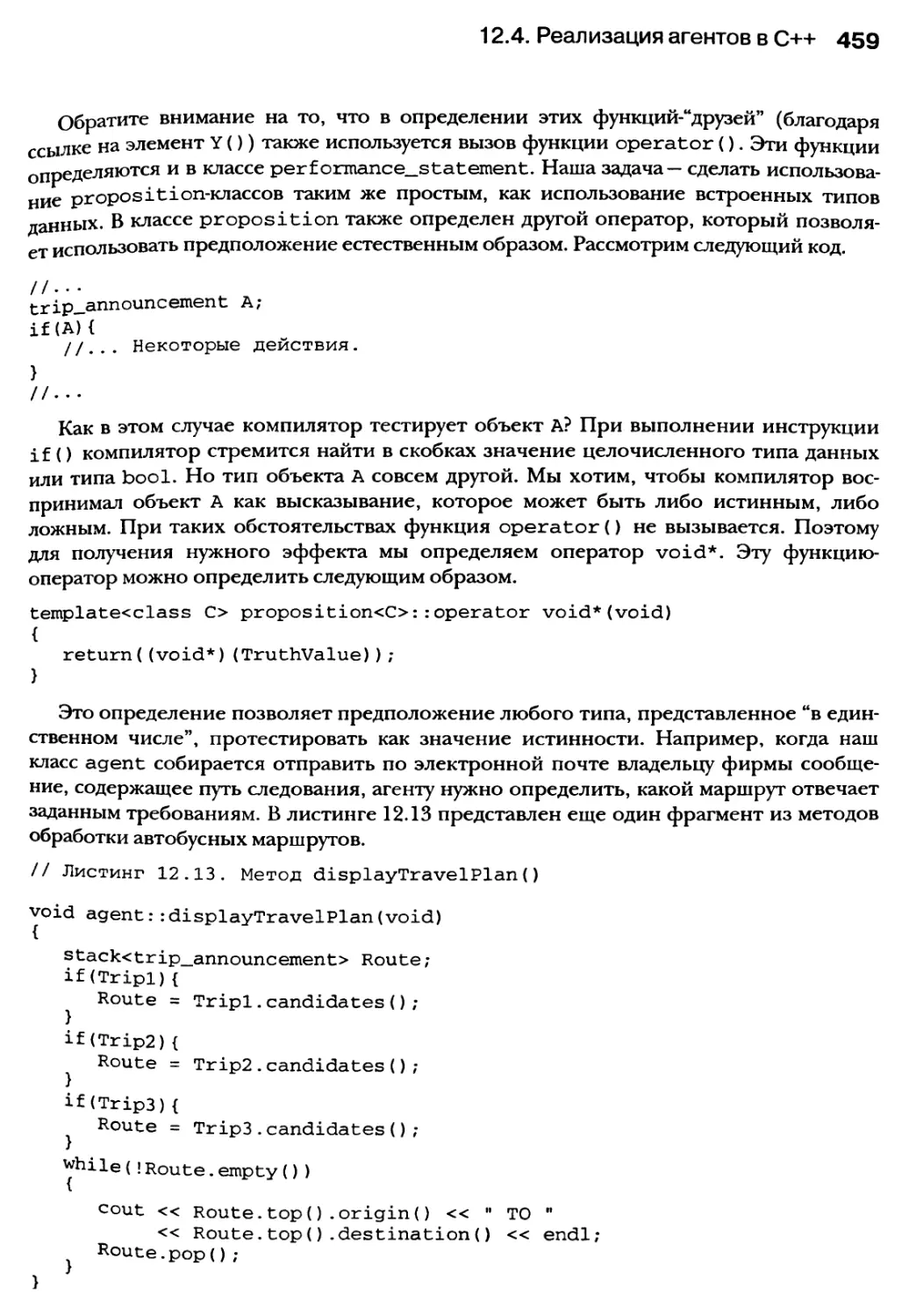

12.4. Реализация агентов в C++ 444

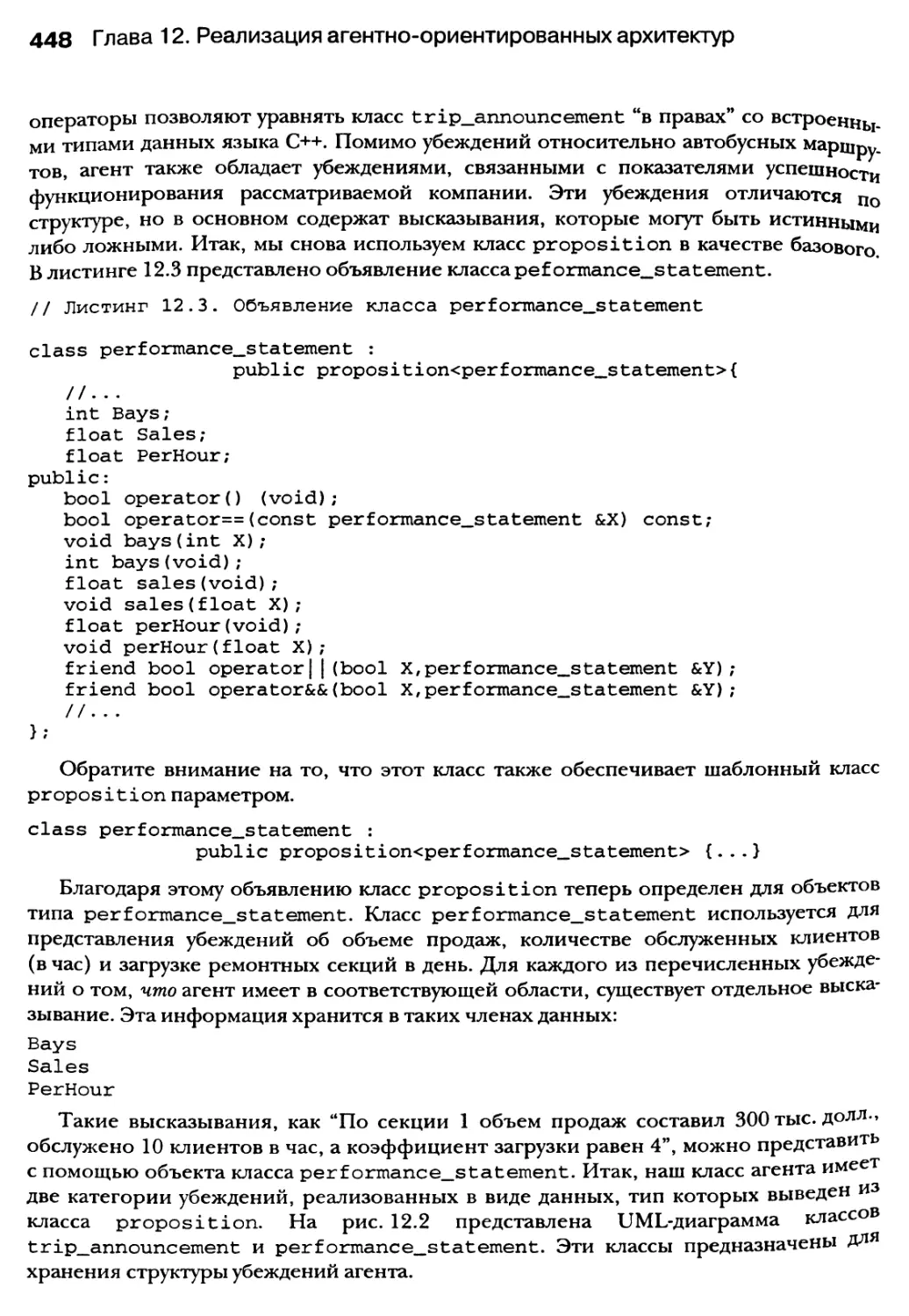

12.4.1. Типы данных предположений и структуры убеждений 444

12.4.2. Класс агента 449

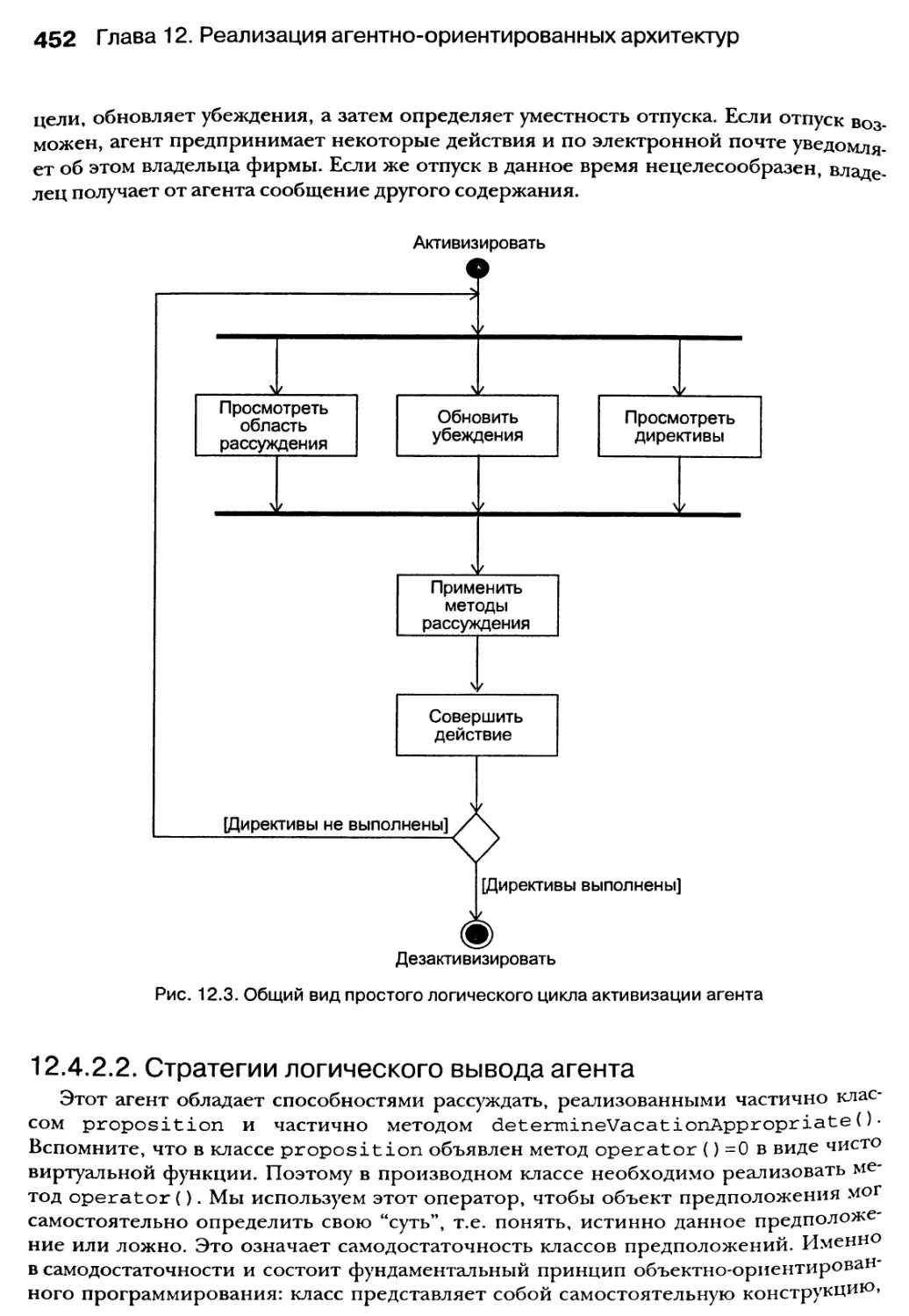

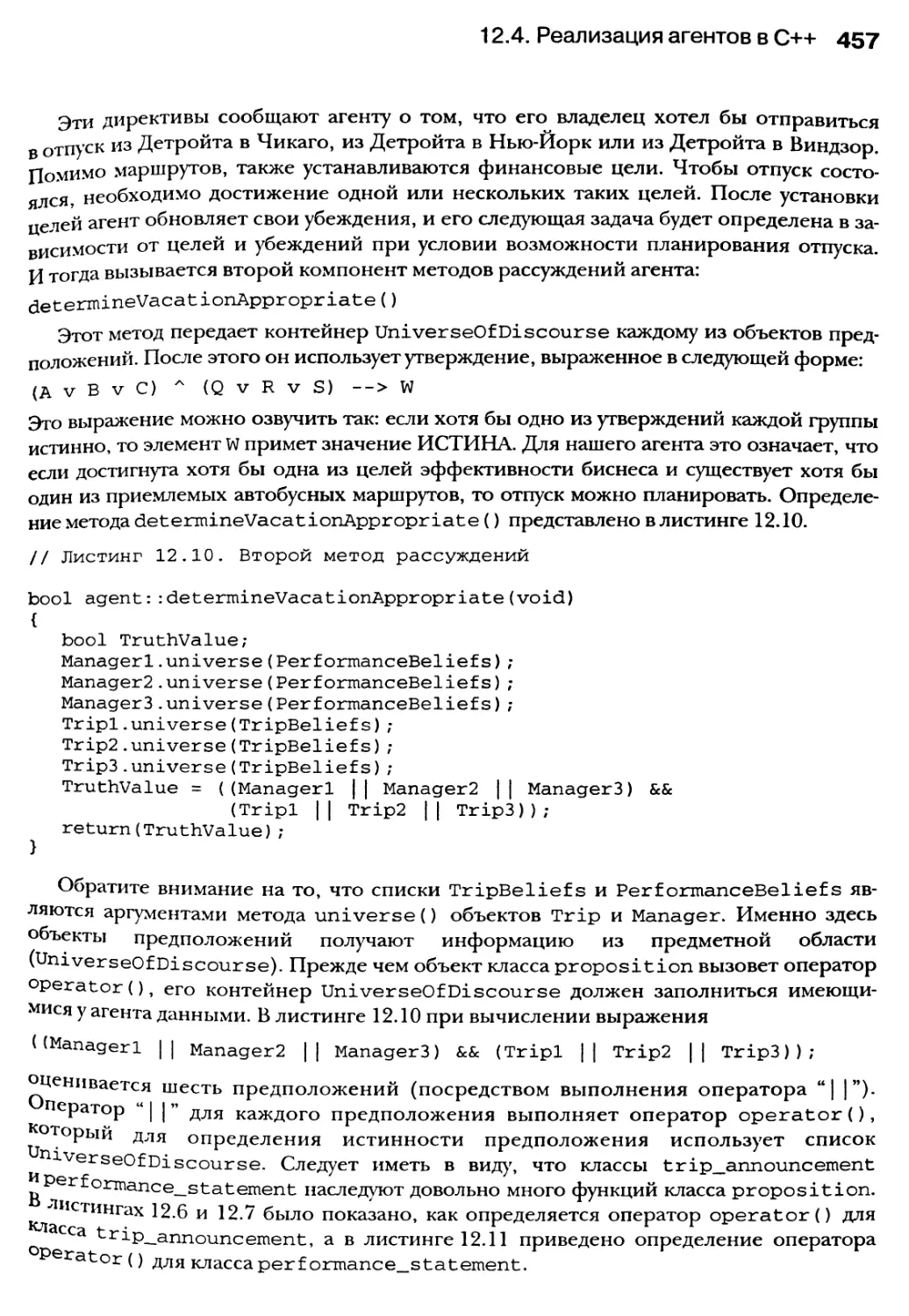

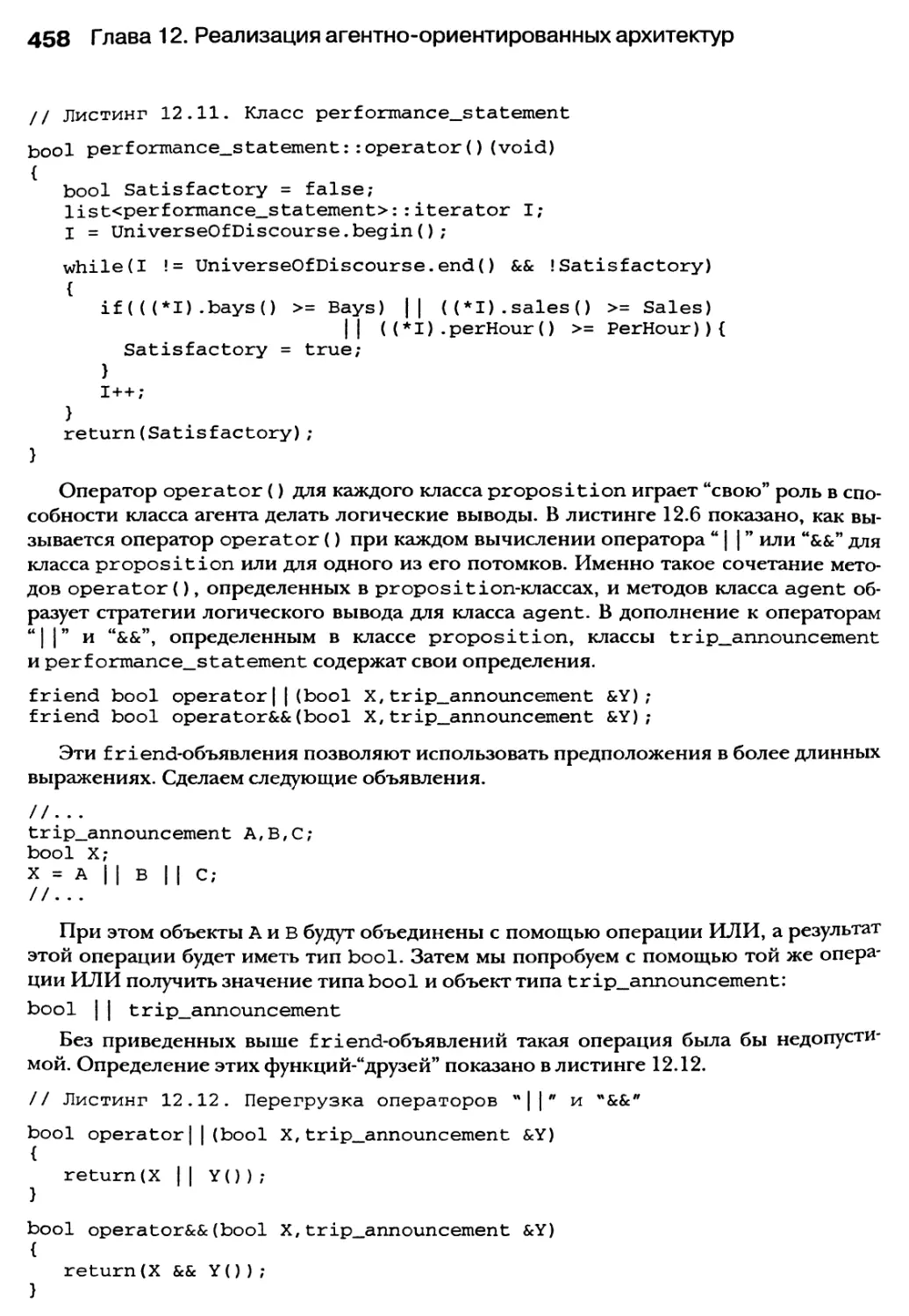

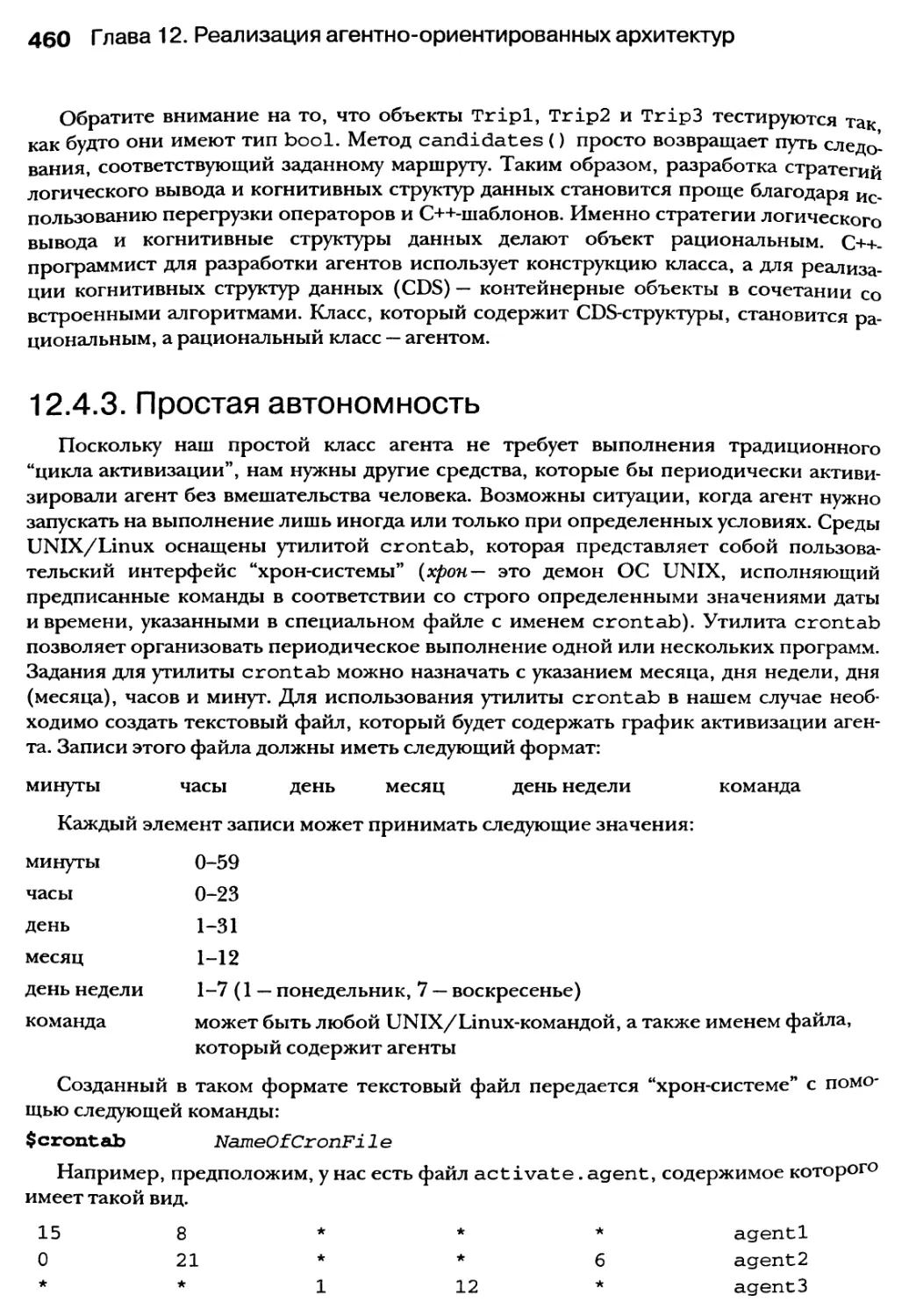

12.4.3. Простая автономность 460

12.5. Мультиагентные системы 461

12.6. Резюме 462

14 Содержание

Глава 13. Реализация технологии “классной доски”

с использованием PVM-средств, потоков

и компонентов C++ 463

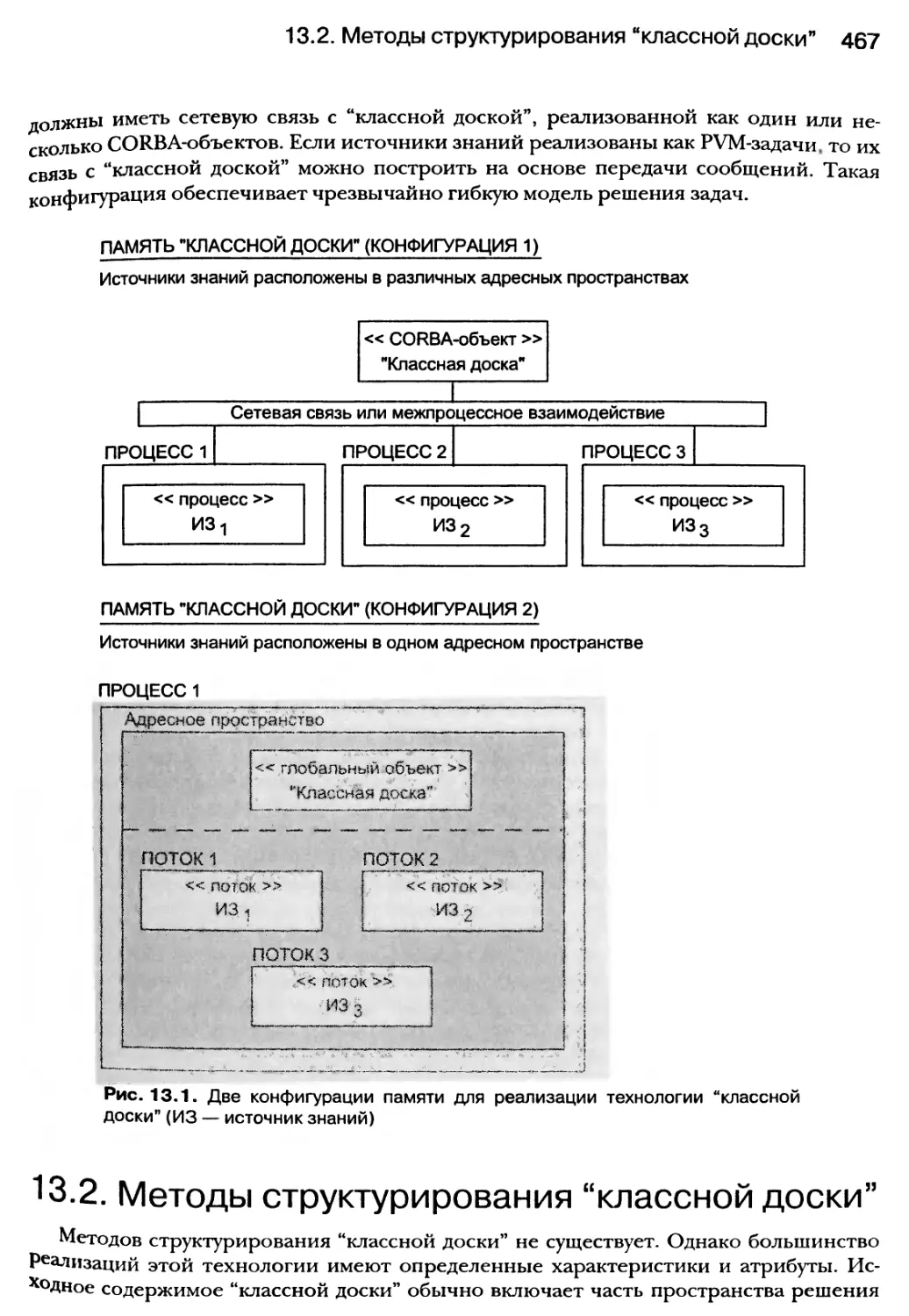

13.1. Модель “классной доски” 465

13.2. Методы структурирования “классной доски” 467

13.3. Анатомия источника знаний 470

13.4. Стратегии управления для “классной доски” 471

13.5. Реализация модели “классной доски” с помощью CORBA-объектов 475

13.5.1. Пример использования corba-объекта “классной доски” 475

13.5.2. Реализация интерфейсного класса blackboard 478

13.5.3. Порождение источников знаний в конструкторе “классной доски” 480

13.6. Реализация модели “классной доски” с помощью глобальных объектов 490

13.7. Активизация источников знаний с помощью потоков 494

13.8. Резюме 495

Приложение А 497

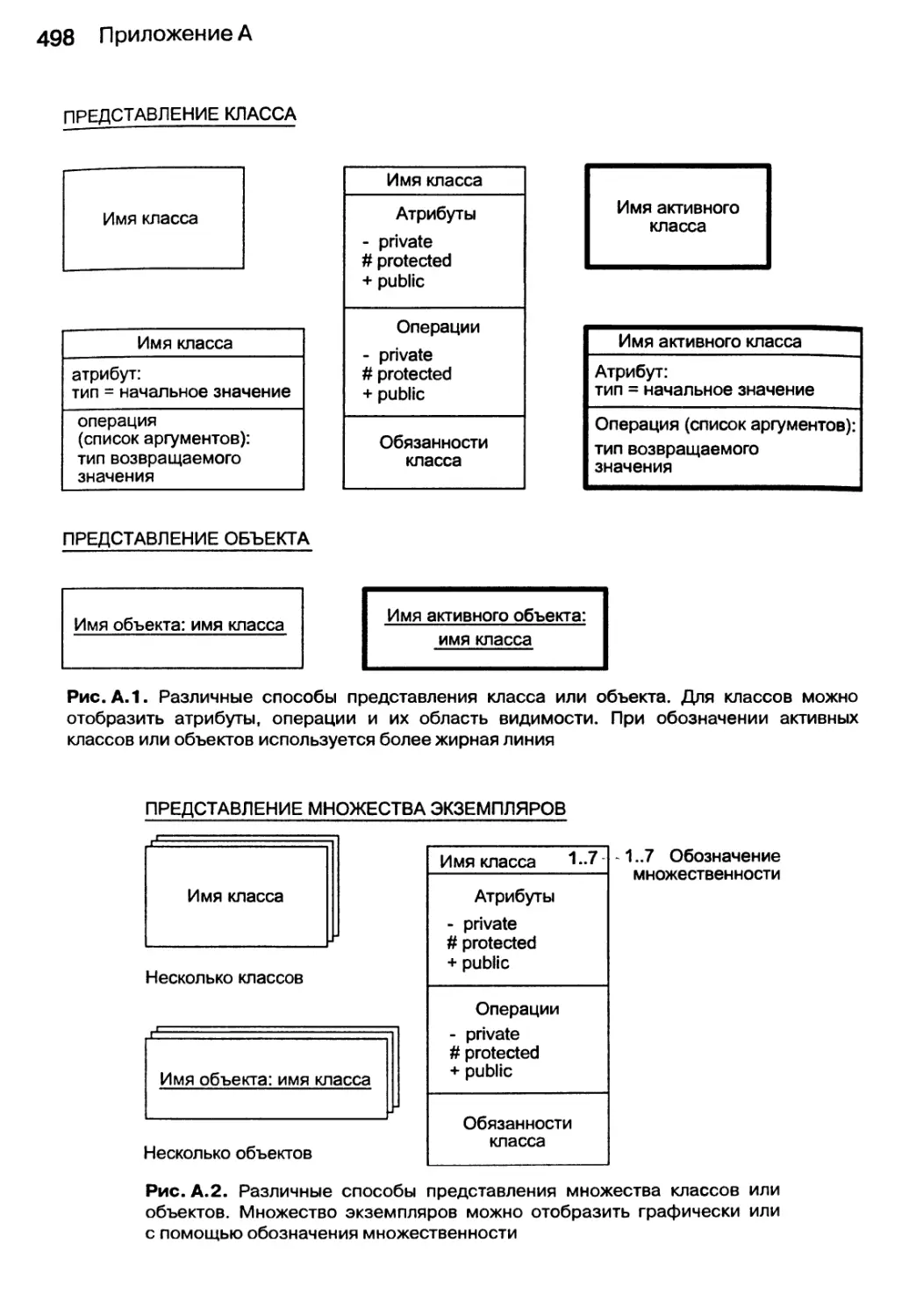

А. 1. Диаграммы классов и объектов 497

А.2. Диаграммы взаимодействия 499

А.2.1. Диаграммы сотрудничества 499

А.2.2. Диаграммы последовательностей 499

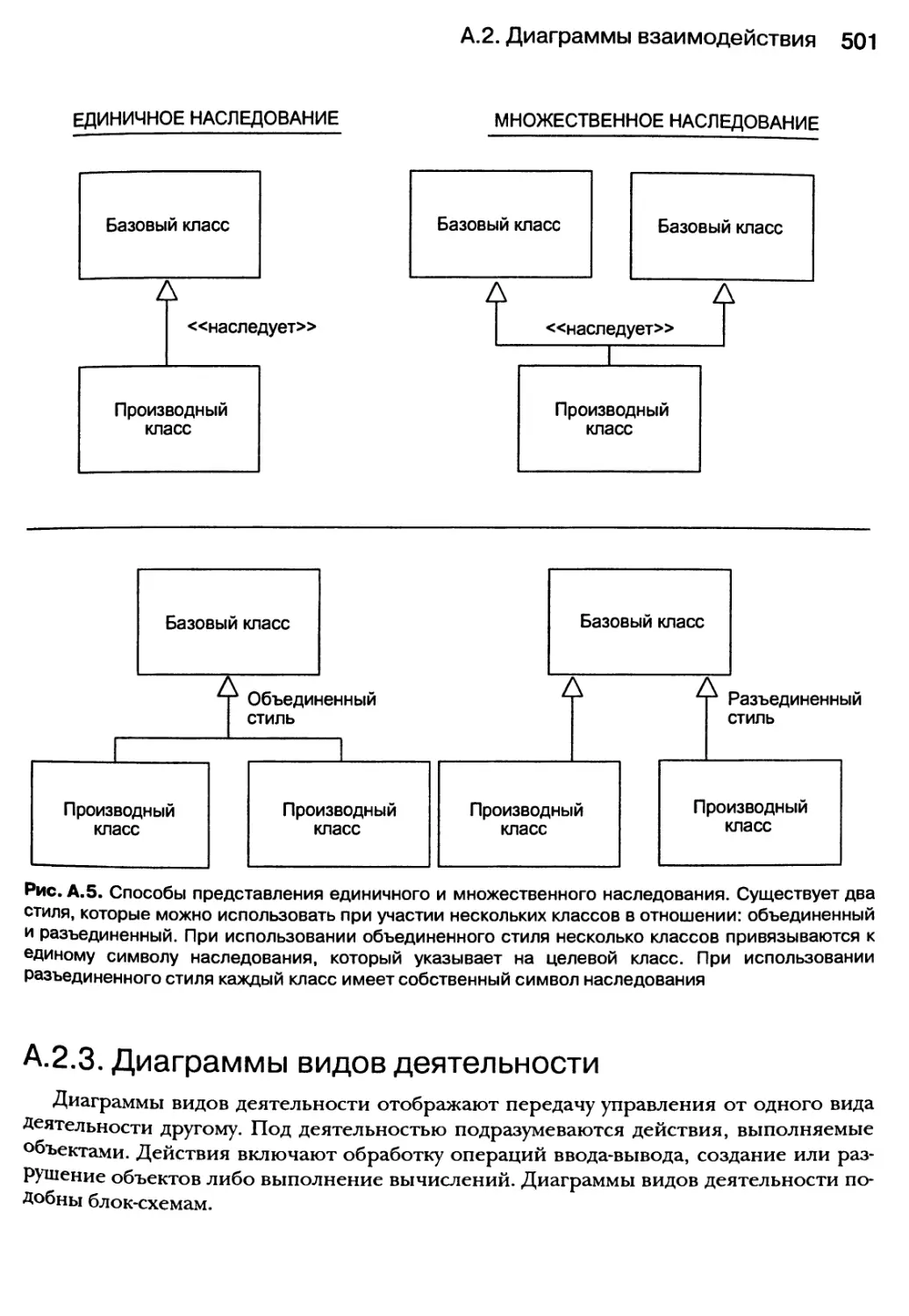

А.2.3. Диаграммы видов деятельности 501

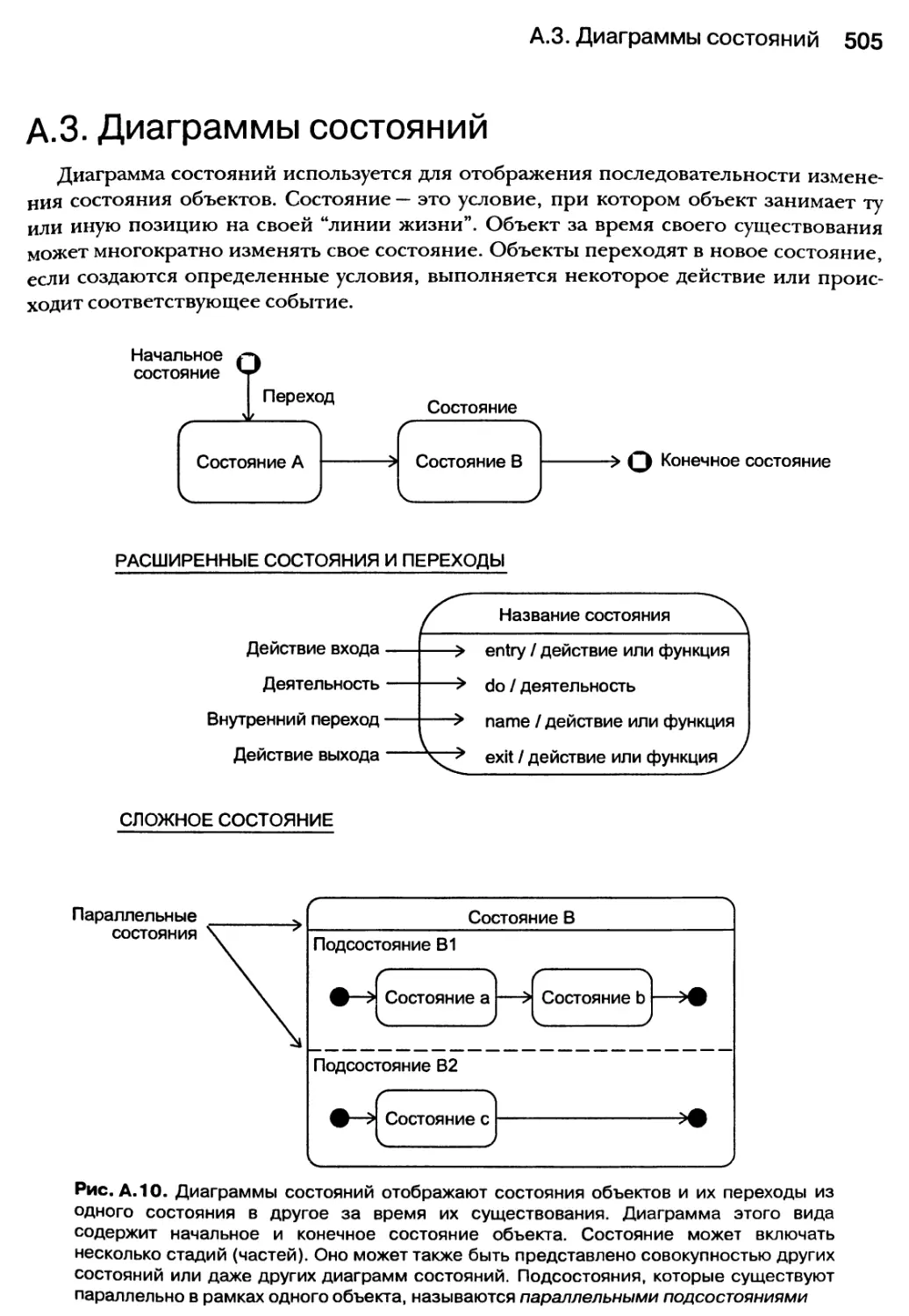

А.З. Диаграммы состояний 505

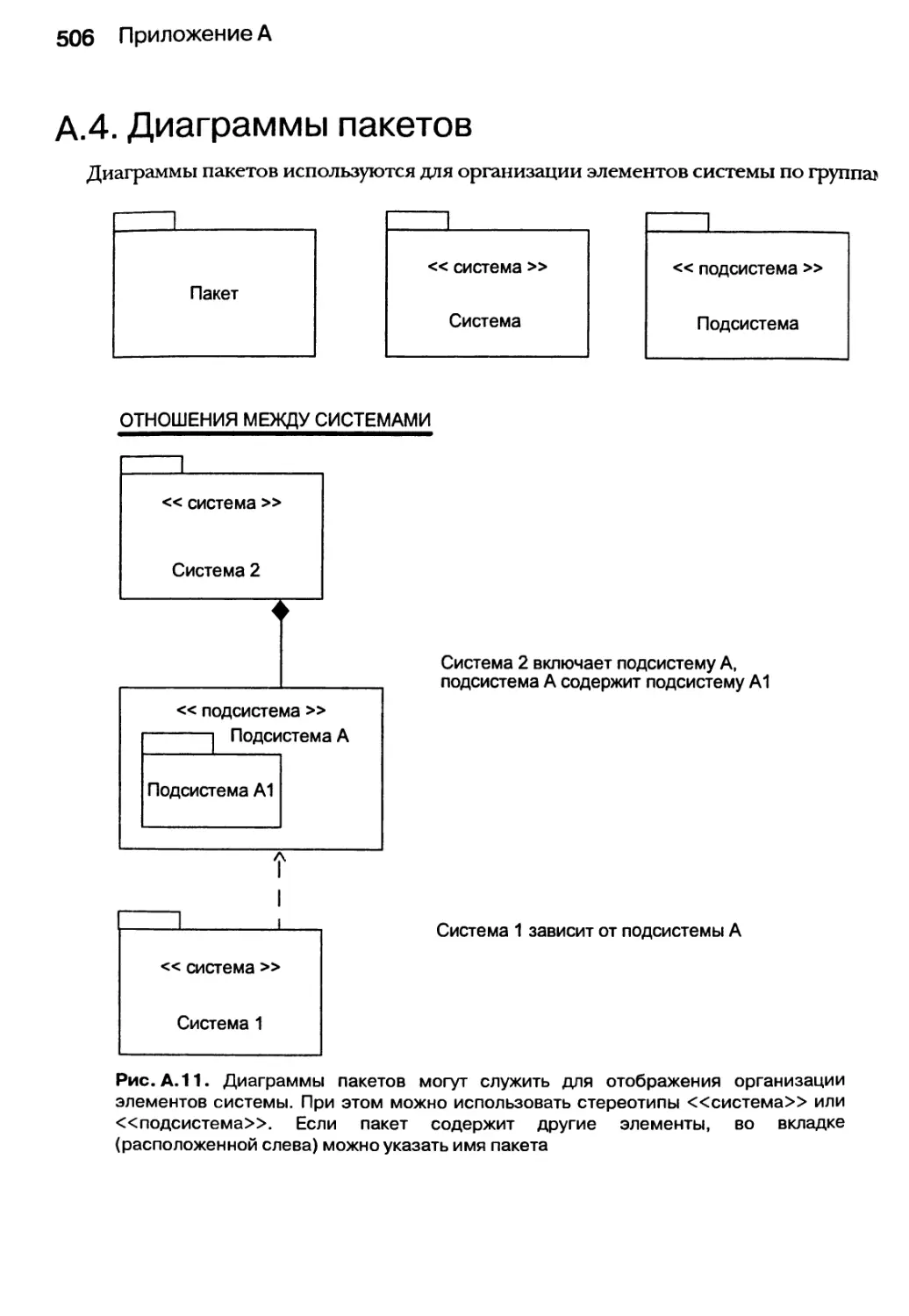

А.4. Диаграммы пакетов 506

Приложение Б 507

Список литературы 657

Предметный указатель 660

Эта книга посвящена всем программистам, “безвредным”хакерам,

инженерам-полуночникам и бесчисленным добровольцам, которые

без устали и сожаления отдают свой талант, мастерство, опыт и время,

чтобы сделать открытые программные продукты реальностью

и совершить революцию в Linux. Без их вклада кластерное, МРР-, SMP-

и распределенное программирование не было бы столь доступным для всех

желающих, каким оно стало в настоящее время.

ВВЕДЕНИЕ

В этой книге представлен архитектурный подход к распределенному и парал-

лельному программированию с использованием языка C++. Особое внимание

уделяется применению стандартной С++-библиотеки, алгоритмов и контей-

нерных классов в распределенных и параллельных средах. Кроме того, мы подроб-

но разъясняем методы расширения возможностей языка C++, направленные на ре-

шение задач программирования этой категории, с помощью библиотек классов

и функций. При этом нас больше всего интересует характер взаимодействия

средств C++ с новыми стандартами POSIX и Single UNIX применительно к органи-

зации многопоточной обработки. Здесь рассматриваются вопросы объединения

С++-программ с программами, написанными на других языках программирования,

для поиска “многоязычных” решений проблем распределенного и параллельного

программирования, а также некоторые методы организации программного обеспе-

чения, предназначенные для поддержки этого вида программирования.

В книге показано, как преодолеть основные трудности параллелизма, и описано,

что понимается под производным распараллеливанием. Мы сознательно уделяем

внимание не методам оптимизации, аппаратным характеристикам или производи-

тельности, а способам структуризации компьютерных программ и программных сис-

тем ради получения преимуществ от параллелизма. Более того, мы не пытаемся при-

менить методы параллельного программирования к сложным научным и математиче-

ским алгоритмам, а хотим познакомить читателя с мультипарадигматическим

подходом к решению некоторых проблем, которые присущи распределенному и па-

раллельному программированию. Чтобы эффективно решать эти задачи, необходимо

сочетать различные программные и инженерные подходы. Например, методы объ-

ектно-ориентированного программирования используются для решения проблем

“гонки” данных и синхронизации их обработки. При многозадачном и многопоточ-

ном управлении мы считаем наиболее перспективной агентно-ориентированную ар-

хитектуру. А для минимизации затрат на обеспечение связей между объектами мы

привлекаем методологию “классной доски” (стратегия решения сложных системных

задач с использованием разнородных источников знаний, взаимодействующих через

общее информационное поле). Помимо объектно-ориентированного, агентно-

Введение 17

ориентированного и AI-ориентированного (AI— сокр. от artificial intelligence— искусст-

венный интеллект) программирования, мы используем параметризованное

(настраиваемое) программирование для реализации обобщенных алгоритмов, кото-

рые применяются именно там, где нужен параллелизм. Опыт разработки программ-

ного обеспечения всевозможных форм и объемов позволил нам убедиться в том, что

для успешного проектирования программных средств и эффективной их реализации

без разносторонности (универсальности) применяемых средств уже не обойтись.

Предложения, идеи и решения, представленные в этой книге, отражают практиче-

ские результаты нашей работы.

Этапы большого пути

При написании параллельных или распределенных программ, как правило, необ-

ходимо “пройти” следующие три основных этапа.

1. Идентификация естественного параллелизма, который существует в контексте

предметной области.

2. Разбиение задачи, стоящей перед программным обеспечением, на несколько

подзадач, которые можно выполнять одновременно, чтобы достичь требуемого

уровня параллелизма.

3. Координация этих задач, позволяющая обеспечить корректную и эффективную

работу программных средств в соответствии с их назначением.

гонка данных

частичный отказ

взаимоблокировка

регистрация завершения работы

проблема многофазной синхронизации

локализация ошибок

Эти три этапа достигаются при условии параллельного решения следующих проблем:

обнаружение взаимоблокировки

бесконечное ожидание

отказ средств коммуникации

отсутствие глобального состояния

несоответствие протоколов

отсутствие средств централизованного

распределения ресурсов

В этой книге разъясняются все названные проблемы, причины их возникновения

и возможные пути решения.

Наконец, в некоторых механизмах, выбранных нами для обеспечения паралле-

лизма, в качестве протокола используется TCP/IP (Transmission Control

Protocol/Internet Protocol— протокол управления передачей/протокол Internet).

В частности, имеются в виду следующие механизмы: библиотека MPI (Message Passing

Interface — интерфейс для передачи сообщений), библиотека PVM (Parallel Virtual

Machine — параллельная виртуальная машина) и библиотека MICO (или CORBA —

Common Object Request Broker Architecture — технология построения распределен-

ных объектных приложений). Эти механизмы позволяют использовать наши подходы

в среде Internet/Intranet, а это значит, что программы, работающие параллельно, мо-

гут выполняться на различных сайтах Internet (или корпоративной сети intranet)

и общаться между собой посредством передачи сообщений. Многие эти идеи служат

18 Введение

в качестве основы для построения инфраструктуры Web-служб. В дополнение к MPI-

и PVM-процедурам, используемые нами CORBA-объекты, размещенные на различных

серверах, могут взаимодействовать друг с другом через Internet. Эти компоненты

можно использовать для обеспечения различных Intemet/Intranet-служб.

Подход

При решении проблем, которые встречаются при написании параллельных

или распределенных программ, мы придерживаемся компонентного подхода.

Наша главная цель — использовать в качестве строительных блоков параллелизма

каркасные классы. Каркасные классы поддерживаются объектно-ориентирован-

ными мьютексами, семафорами, конвейерами и сокетами. С помощью интер-

фейсных классов удается значительно снизить сложность синхронизации задач

и их взаимодействия. Для того чтобы упростить управление потоками и процес-

сами, мы используем агентно-ориентированные потоки и процессы. Наш основ-

ной подход к глобальному состоянию и связанные с ним проблемы включают

применение методологии “классной доски”. Для получения мультипарадигмати-

ческих решений мы сочетаем агентно-ориентированные и объектно-

ориентированные архитектуры. Такой мультипарадигматический подход обеспе-

чивают средства, которыми обладает язык C++ для объектно-ориентированного,

параметризованного и структурного программирования.

Почему именно C++

Существуют С++-компиляторы, которые работают практически на всех извест-

ных платформах и в операционных средах. Национальный Институт Стандарти-

зации США (American National Standards Institute — ANSI) и Международная ор-

ганизация по стандартизации (International Organization for Standardization — ISO)

определили стандарты для языка C++ и его библиотеки. Существуют устойчиво

работающие, так называемые открытые (open source) (т.е. лицензионные про-

граммы вместе с их исходными текстами, не связанные ограничениями на даль-

нейшую модификацию и распространение с сохранением информации о первич-

ном авторстве и внесенных изменениях), а также коммерческие реализации этого

языка. Язык C++ был быстро освоен научными работниками, проектировщиками

и профессиональными разработчиками всего мира. Его использовали для реше-

ния самых разных (по объему и форме) проблем: для написания как отдельных

драйверов устройств, так и крупномасштабных промышленных приложений.

Язык C++ поддерживает мультипарадигматический подход к разработке про-

граммных продуктов и библиотек, которые делают средства параллельного и рас-

пределенного программирования легко доступными.

Введение 19

Библиотеки для параллельного

и распределенного программирования

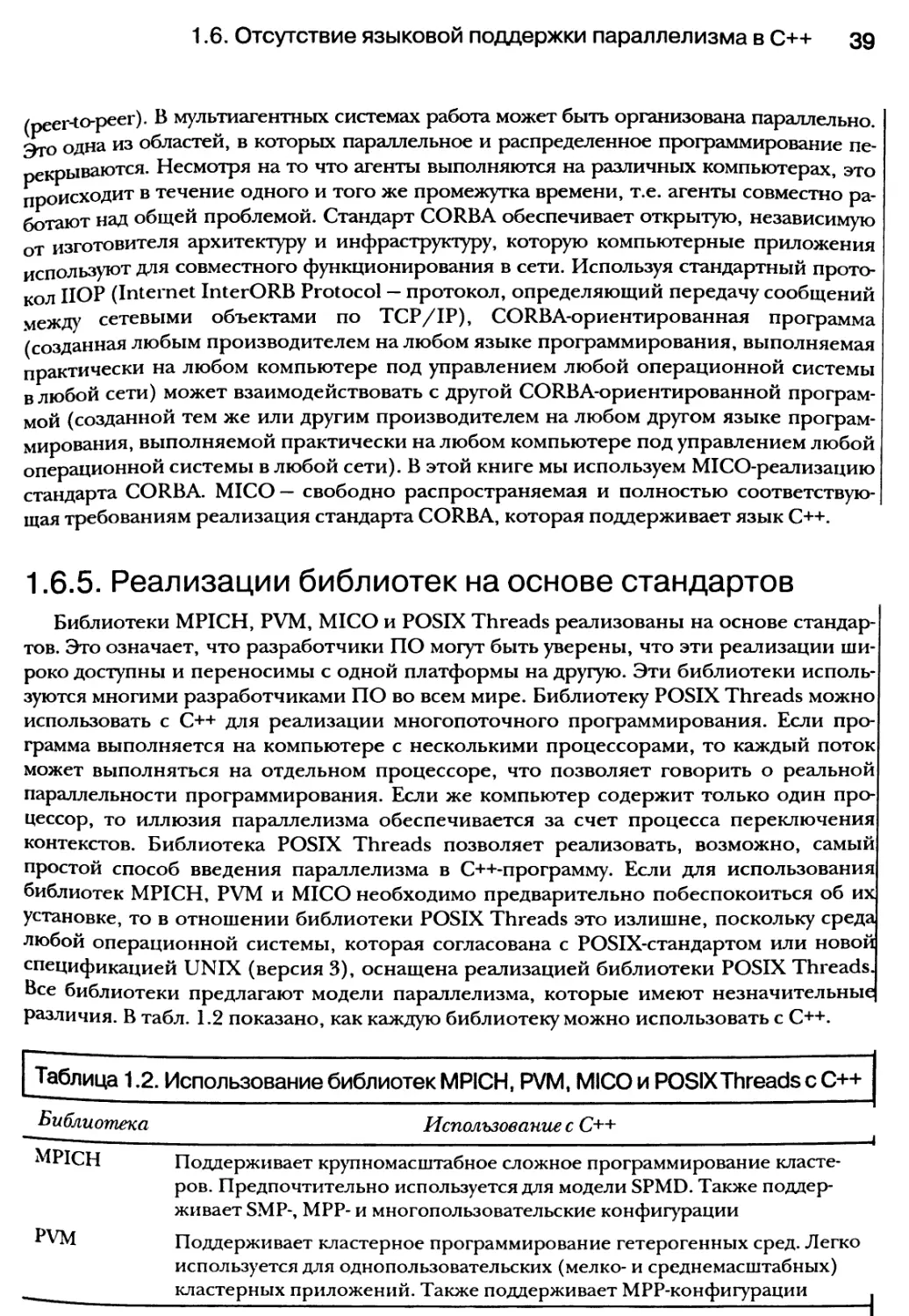

Для параллельного программирования на основе C++ используются такие библио-

теки, как MPICH (реализация библиотеки MPI), PVM и Pthreads (POSIX1 Threads). Для

распределенного программирования применяется библиотека MICO (С++-реализация

стандарта CORBA). Стандартная библиотека C++ (C++ Standard Library) в сочетании

с CORBA и библиотекой Pthreads обеспечивает поддержку концепций агентно-

ориентированного программирования и программирования на основе методологии

“классной доски”, которые рассматриваются в этой книге.

Новый единый стандарт спецификаций UNIX

Новый единый стандарт спецификаций UNIX (Single UNIX Specifications

Standard) версии 3 — совместный труд Института инженеров по электротехнике

и электронике (Institute of Electrical and Electronics Engineers — IEEE2) и организации

Open Group — был выпущен в декабре 2001 года. Новый единый стандарт специфика-

ций UNIX реализует стандарты POSIX и способствует повышению уровня переноси-

мости программных продуктов. Его основное назначение — дать разработчикам про-

граммного обеспечения единый набор API-функций (Application Programming

Interface — интерфейс прикладного программирования, т.е. набор функций, предос-

тавляемый для использования в прикладных программах), поддерживаемых каждой

UNIX-системой. Этот документ обеспечивает надежный “путеводитель” по стандар-

там для программистов, которые занимаются многозадачными и многопоточными

приложениями. В этой книге, рассматривая темы создания процессов, управления

процессами, использования библиотеки Pthreads, новых процедур posix_spawn (),

POSIX-семафоров и FIFO-очередей (/irst-m, yirst-out — “первым поступил, первым об-

служен”), мы опираемся исключительно на новый единый стандарт спецификаций

UNIX. В приложении Б представлены выдержки из этого стандарта, которые могут

быть использованы в качестве справочника для изложенного нами материала.

Для кого написана эта книга

Эта книга предназначена для проектировщиков и разработчиков программного

обеспечения, прикладных программистов и научных работников, преподавателей

и студентов, которых интересует введение в параллельное и распределенное про-

граммирование с использованием языка C++. Для освоения материала этой книги чи-

тателю необходимо иметь базовые знания языка C++ и стандартной С++-библиотеки

классов, поскольку учебный курс по программированию на C++ и по объектно-1

ориентированному программированию здесь не предусмотрен. Предполагается, что

читатель должен иметь общее представление о таких принципах объектно-|

1 POSIX— Portable Operating System Interface for computer environments— интерфейс переносимой one\

рационной системы (набор стандартов IEEE, описывающих интерфейсы ОС для UNIX).

2 IEEE— профессиональное объединение, выпускающие свои собственные стандарты; членами /£££|

являются ANSI и ISO.

20 Введение

ориентированного программирования, как инкапсуляция, наследование и полимор-

физм. В настоящей книге излагаются основы параллельного и распределенного про-

граммирования в контексте C++.

Среды разработки

Примеры и программы, представленные в этой книге, разработаны и протестиро-

ваны в Linux- и UNIX-средах, а именно — под управлением Solaris 8, Aix и Linux (SuSE,

Red Hat). MPI- и PVM-код разработан и протестирован на 32-узловом Linux-ориенти-

рованном кластере. Многие программы протестированы на серверах семейства Sun

Enterprise 450. Мы использовали Sun C++ Workshop (С++-компилятор компании Port-

land Group) и проект по свободному распространению программного обеспечения

GNU C++. Большинство примеров должны выполняться как в UNIX-, так и Linux-

средах. Если конкретный пример не предназначен для выполнения в обеих назван-

ных средах, этот факт отмечается в разделе “Профиль программы”, которым снабжа-

ются все законченные примеры программ этой книги.

Дополнительный материал

Диаграммы UML

Для построения многих диаграмм в этой книге применяется стандарт UML

(Unified Modeling Language — унифицированный язык моделирования). В частности,

для описания важных архитектур параллелизма и межклассовых взаимоотношений

используются диаграммы действий, развертывания (внедрения), классов и состояний.

И хотя знание языка UML не является необходимым условием, все же некоторый

уровень осведомленности в этом вопросе окажется весьма полезным. Описание

и разъяснение символов и самого языка UML приведено в приложении А.

Профили программы

Каждая законченная программа в этой книге сопровождается разделом “Профиль

программы”, который содержит описание таких особенностей реализации, как тре-

буемые заголовки, библиотеки, инструкции по компиляции и компоновке. Профиль

программы также включает подраздел “Примечания”, содержащий специальную ин-

формацию, которую необходимо принять во внимание при выполнении данной про-

граммы. Если код не сопровождается профилем программы, значит, он предназначен

только для демонстрации.

Параграфы

Мы посчитали лишним включать сугубо теоретические замечания в такую книгу-

введение, как эта. Но в некоторых случаях без теоретических или математических

выкладок было не обойтись, и тогда мы сопровождали такие выкладки подробными

разъяснениями, оформленными в виде параграфов (например, § 6.1).

Введение 21

Тестирование кода и его надежность

Несмотря на то что все примеры и приложения, приведенные в этой книге, были

протестированы для подтверждения их корректности, мы не даем никаких гарантий,

что эти программы полностью лишены изъянов или ошибок, совместимы с любым кон-

кретным стандартом, годятся для продажи или отвечают вашим конкретным требова-

ниям. На эти программы не следует полагаться при решении проблем, если существует

вероятность, что некорректный способ получения результатов может привести к мате-

риальном}7 ущербу. Авторы и издатели этой книги не признают какую бы то ни было от-

ветственность за прямой или косвенный ущерб, который может явиться результатом

использования примеров, программ или приложений, представленных в этой книге.

Ждем ваших отзывов!

Вы, читатель этой книги, и есть главный ее критик и комментатор. Мы ценим ваше

мнение и хотим знать, что было сделано нами правильно, что можно было сделать

лучше и что еще вы хотели бы увидеть изданным нами. Нам интересно услышать

и любые другие замечания, которые вам хотелось бы высказать в наш адрес.

Мы ждем ваших комментариев и надеемся на них. Вы можете прислать нам бумаж-

ное или электронное письмо, либо просто посетить наш Web-сервер и оставить свои

замечания там. Одним словом, любым удобным для вас способом дайте нам знать, нравит

ся или нет вам эта книга, а также выскажите свое мнение о том, как сделать наши книги

более интересными для вас.

Посылая письмо или сообщение, не забудьте указать название книги и ее авторов,

а также ваш обратный адрес. Мы внимательно ознакомимся с вашим мнением и обязательно

учтем его при отборе и подготовке к изданию последующих книг. Наши координаты:

E-mail: info@dialektika.com

WWW: http://www.dialektika.com

Информация для писем из:

России: 115419, Москва, а/я 783

Украины: 03150, Киев, а/я 152

Благодарности

Мы никогда бы не смогли “вытянуть” этот проект без помощи, поддержки, конст-

руктивной критики и материальных ресурсов многих наших друзей и коллег. В част-

ности, мы хотели бы поблагодарить Терри Льюиса (Terry Lewis) и Дага Джонсона

(Doug Johnson) из компании OSC (Ohio Super-Computing) за предоставление доступа

к 32-узловому Linux-ориентированному кластеру; Марка Уэлтона (Mark Welton) из

компании YSU за экспертный анализ и помощь при конфигурировании кластера для

поддержки наших PVM- и MPI-программ; Сэлу Сандерс (Sal Sanders) из компании YSU,

позволившую нам работать на Power-PC с установленными Mac OSX и Adobe

Illustrator; Брайана Нельсона (Brian Nelson) из YSU за разрешение протестировать

многие наши многопоточные и распределенные программы на многопроцессорных

вычислительных машинах Sun Е-250 и Е-450. Мы также признательны Мэри Энн

Джонсон (Mary Ann Johnson) и Джеффри Тримблу (Jeffrey Trimble) из YSU MAAG за

помощь в получении справочной информации; Клавдию М. Стэнзиоло (Claudio М.

Stanziola), Полетт Голдвебер (Paulette Goldweber) и Жаклин Хэнсон (Jacqueline

Hansson) из объединения IEEE Standards and Licensing and Contracts Office за получе-

ние разрешения на переиздание фрагментов нового стандарта Single-UNIX/POSIX;

Эндрю Джози (Andrew Josey) и Джину Пирсу (Gene Pierce) из организации Open

Group за аналогичное содействие. Большое спасибо Тревору Уоткинсу (Trevor

Watkins) из организации Z-Group за помощь в тестировании примеров программ; ис-

пользование его распределенной Linux-среды было особенно важным фактором

в процессе тестирования. Особую благодарность заслужили Стив Тарасвеки (Steve

Tarasweki) за согласие написать рецензию на эту книгу (несмотря на то, что она была

еще в черновом варианте); доктор Юджин Сантос (Eugene Santos) за то, что он указал

нужное направление при составлении категорий структур данных, которые можно

использовать в PYM (Parallel Virtual Machine — параллельная виртуальная машина);

доктор Майк Кресиманно (Mike Crescimanno) из организации Advanced Computing

Work Group (ACWG) при компании YSU за разрешение представить некоторые мате-

риалы из этой книги на одном из совещаний ACWG. Наконец, мы хотим выразить

признательность Полю Петрелия (Paul Petralia) и всему составу производственной

группы (особенно Гейлу Кокеру-Богусу (Gail Cocker-Bogusz)) из компании Prentice Hall

за их терпение, поддержку, энтузиазм и высокий профессионализм.

ПРЕИМУЩЕСТВА

ПАРАЛЛЕЛЬНОГО

ПРОГРАММИРОВАНИЯ

В этой главе...

1.1. Что такое параллелизм

1.2. Преимущества параллельного программирования

1.3. Преимущества распределенного программирования

1.4. Минимальные требования

1.5. Базовые уровни программного параллелизма

1.6. Отсутствие языковой поддержки параллелизма в C++

1.7. Среды для параллельного и распределенного

программирования

1.8. Резюме

“Я допускаю, что параллелизм лучше всего поддерживать с помощью

библиотеки, причем такую библиотеку можно реализовать без существенных

расширений самого языка программирования.”

— Бьерн Страуструп, создатель языка C++

Для того чтобы в настоящее время разрабатывать программное обеспечение, не-

обходимы практические знания параллельного и распределенного программиро-

вания. Теперь перед разработчиками приложений все чаще ставится задача, что-

бы отдельные программные составляющие надлежащим образом выполнялись в Internet

или Intranet. Если программа (или ее часть) развернута в одной или нескольких таких сре-

дах, то к ней предъявляются самые жесткие требования по части производительности.

Пользователь всегда надеется, что результаты работы программ будут мгновенными

и надежными. Во многих ситуациях заказчик хотел бы, чтобы программное обеспече-

ние удовлетворяло сразу многим требованиям. Зачастую пользователь не видит ничего

необычного в своих намерениях одновременно загружать программные продукты

и данные из Internet. Программное обеспечение, предназначенное для приема телетекста,

также должно быть способно на гладкое воспроизведение графических изображений и

звука после цифровой обработки (причем без прерывания). Программное обеспечение

Web-сервера нередко выдерживает сотни тысяч посещений в день, а часто посещаемые

почтовые серверы— порядка миллиона отправляемых и получаемых сообщений. При

этом важно не только количество обрабатываемых сообщений, но и их содержимое.

Например, передача данных, содержащих оцифрованные музыку, видео или графиче-

ские изображения, может “поглотить” всю пропускную способность сети и причинить

серьезные неприятности программному обеспечению сервера, которое не было спро-

ектировано должным образом. Обычно мы имеем дело с сетевой вычислительной

1.1. Что такое параллелизм 25

средой, состоящей из компьютеров с несколькими процессорами. Чем больше функций

возлагается на программное обеспечение, тем больше к нему предъявляется требова-

ний. Чтобы удовлетворить минимальные требования пользователя, современные про-

граммы должны быть еще более производительными и интеллектуальными. Программ-

ное обеспечение следует проектировать так, чтобы можно было воспользоваться

преимуществами компьютеров, оснащенных несколькими процессорами. А поскольку

сетевые компьютеры — это скорее правило, чем исключение, то целью проектирова-

ния программного обеспечения должно быть его корректное и эффективное выпол-

нение при условии, что некоторые его составляющие будут одновременно выпол-

няться на различных компьютерах. В некоторых случаях используемые компьютеры

могут иметь совершенно различные операционные системы с разными сетевыми

протоколами! Чтобы справиться с описанными реалиями, ассортимент разработок

программных продуктов должен включать методы реализации параллелизма посред-

ством параллельного и распределенного программирования.

1.1. Что такое параллелизм

Два события называют одновременными, если они происходят в течение одного и того

же временного интервала. Если несколько задач выполняются в течение одного и того

же временного интервала, то говорят, что они выполняются параллельно. Для нас термин

параллельно необязательно означает “точно в один момент”. Например, две задачи могут

выполняться параллельно в течение одной и той же секунды, но при этом каждая из них

выполняется в различные доли этой секунды. Так, первая задача может отработать

в первую десятую часть секунды и приостановиться, затем вторая может отработать

в следующую десятую часть секунды и приостановиться, после чего первая задача может

возобновить выполнение в течение третьей доли секунды, и т.д. Таким образом, эти за-

дачи могут выполняться по очереди, но поскольку продолжительность секунды с точки

зрения человека весьма коротка, то кажется, что они выполняются одновременно. По-

нятие одновременности (параллельности) можно распространить и на более длинные ин-

тервалы времени. Так, две программы, выполняющие некоторую задачу в течение одно-

го и того же часа, постепенно приближаясь к своей конечной цели в течение этого часа,

могут (или могут не) работать точно в одни и те же моменты времени. Мы говорим, что

данные две программы для этого часа выполняются параллельно, или одновременно.

Другими словами, задачи, которые существуют в одно и то же время и выполняются

в течение одного и того же интервала времени, являются параллельными. Параллельные

задачи могут выполняться в одно- или многопроцессорной среде. В однопроцессорной

среде параллельные задачи существуют в одно и то же время и выполняются в течение

одного и того же интервала времени за счет контекстного переключения. В многопро-

цессорной среде, если свободно достаточное количество процессоров, параллельные

задачи могут выполняться в одни и те же моменты времени в течение одного и того же

периода времени. Основной фактор, влияющий на степень приемлемости для паралле-

лизма того или иного интервала времени, определяется конкретным приложением.

Цель технологий параллелизма — обеспечить условия, позволяющие компьютер-

ным программам делать больший объем работы за тот же интервал времени. Поэтому

проектирование программ должно ориентироваться не на выполнение одной задачи

в некоторый промежуток времени, а на одновременное выполнение нескольких за-

дач, на которые предварительно должна быть разбита программа. Возможны ситуа-

ции, когда целью является не выполнение большего объема работы в течение того же

26 Глава 1. Преимущества параллельного программирования

интервала времени, а упрощение решения с точки зрения программирования. Иногда

имеет смысл думать о решении проблемы как о множестве параллельно выполняемых

задач. Например (если взять для сравнения вполне житейскую ситуацию), проблему

снижения веса лучше всего представить в виде двух параллельно выполняемых задач:

диета и физическая нагрузка. Иначе говоря, для решения этой проблемы предполагает^

ся применение строгой диеты и физических упражнений в один и тот же интервал вре-

мени (необязательно точно в одни и те же моменты времени). Обычно не слишком полезно

(или эффективно) выполнять одну подзадачу в один период времени, а другую — совер-

шенно в другой. Именно параллельность обоих процессов дает естественную форму ис-

комого решения проблемы. Иногда к параллельности прибегают, чтобы увеличить бы-

стродействие программы или приблизить момент ее завершения. В других случаях па-

раллельность используется для увеличения продуктивности программы (объема

выполняемой ею работы) за тот же период времени при вторичности скорости ее рабо-

ты. Например, для некоторых Web-сайтов важно как можно дольше удерживать пользо-

вателей. Поэтому здесь имеет значение не то, насколько быстро будет происходить под-

ключение (регистрация) и отключение пользователей, а сколько пользователей сможет

этот сайт обслуживать одновременно. Следовательно, цель проектирования программ-

ного обеспечения такого сайта — обрабатывать максимальное количество подключений

за как можно больший промежуток времени. Наконец, параллельность упрощает само

программное обеспечение. Зачастую сложную последовательность операций можно уп-

ростить, организовав ее в виде ряда небольших параллельно выполняемых операций.

Независимо от частной цели (ускорение работы программ, обработка увеличенной на-

грузки или упрощение реализации программы), наша главная цель — усовершенство-

вать программное обеспечение, воспользовавшись принципом параллельности.

1.1.1. Два основных подхода к достижению

параллельности

Параллельное и распределенное программирование— это два базовых подхода

к достижению параллельного выполнения составляющих программного обеспечения

(ПО). Они представляют собой две различные парадигмы программирования, которые

иногда пересекаются. Методы параллельного программирования позволяют распределить

работу программы между двумя (или больше) процессорами в рамках одного физиче-

ского или одного виртуального компьютера. Методы распределенного программирования

позволяют распределить работу программы между двумя (или больше) процессами,

причем процессы могут существовать на одном и том же компьютере или на разных.

Другими словами, части распределенной программы зачастую выполняются на разных

компьютерах, связываемых по сети, или по крайней мере в различных процессах. Про-

грамма, содержащая параллелизм, выполняется на одном и том же физическом или

виртуальном компьютере. Такую программу можно разбить на процессы (process) или

потоки (thread). Процессы мы рассмотрим в главе 3, а потоки — в главе 4. В изложении

материала этой книги мы будем придерживаться того, что распределенные программы

разбиваются только на процессы. Многопоточность ограничивается параллелизмом.

Формально параллельные программы иногда бывают распределенными, например, при

PVM-программировании (Parallel Virtual Machine — параллельная виртуальная машина).

Распределенное программирование иногда используется для реализации параллелизма,

как в случае с MPI-программированием (Message Passing Interface — интерфейс для

1.1. Что такое параллелизм 27

передачи сообщений). Однако не все распределенные программы включают паралле-

лизм. Части распределенной программы могут выполняться по различным запросам

и в различные периоды времени. Например, программу календаря можно разделить

на две составляющие. Одна часть должна обеспечивать пользователя информацией,

присущей календарю, и способом записи данных о важных для него встречах, а другая

часть должна предоставлять пользователю набор сигналов для разных типов встреч.

Пользователь составляет расписание встреч, используя одну часть ПО, в то время как

другая его часть выполняется независимо от первой. Набор сигналов и компонентов

расписания вместе образуют единое приложение, которое разделено на две части,

выполняемые по отдельности. При чистом параллелизме одновременно выполняе-

мые части являются компонентами одной и той же программы. Части распределен-

ных приложений обычно реализуются как отдельные программы. Типичная архитек-

тура построения параллельной и распределенной программ показана на рис. 1.2.

Рис.Д/1. Типичная архитектура построения параллельной и распределенной программ

28 Глава 1. Преимущества параллельного программирования

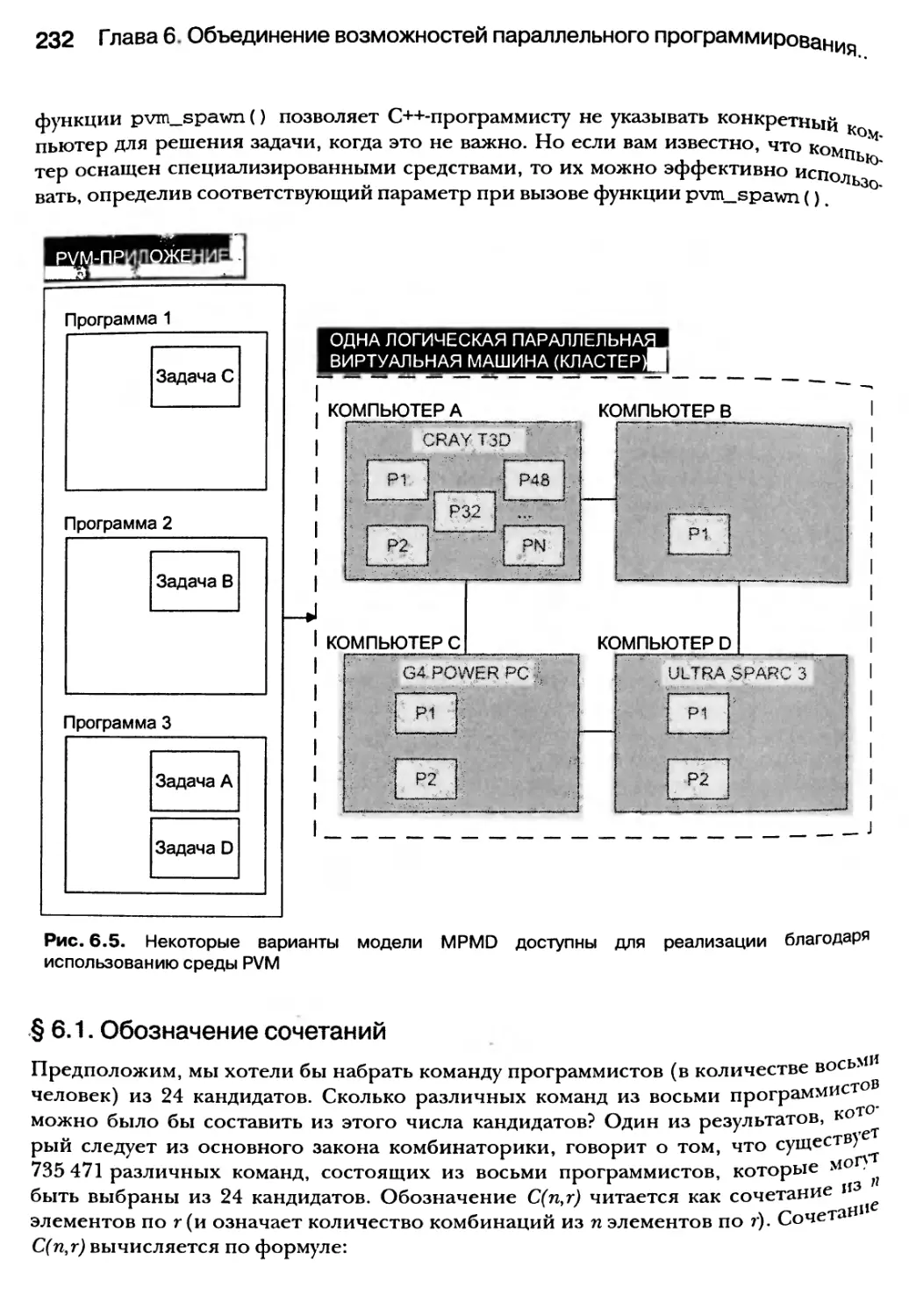

Параллельное приложение, показанное на рис. 1.2, состоит из одной программы,

разделенной на четыре задачи. Каждая задача выполняется на отдельном процессоре,

следовательно, все они могут выполняться одновременно. Эти задачи можно реализо-

вать в 1.2, состоит из трех отдельных программ, каждая из которых выполняется на от-

дельном компьютере. При этом программа 3 состоит из двух отдельных частей (задачи А и

задачи D), выполняющихся на одном компьютере. Несмотря на это, задачи А и D являются

распределенными, поскольку они реализованы как два отдельных процесса. Задачи парал-

лельной программы более тесно связаны, чем задачи распределенного приложения.

В общем случае процессоры, связанные с распределенными программами, находятся

на различных компьютерах, в то время как процессоры, связанные с программами,

реализующими параллелизм, находятся на одном и том же компьютере. Конечно же,

существуют гибридные приложения, которые являются и параллельными, и распреде-

ленными одновременно. Именно такие гибридные объединения становятся нормой.

1.2. Преимущества параллельного

программирования

Программы, надлежащее качество проектирования которых позволяет воспользо-

ваться преимуществами параллелизма, могут выполняться быстрее, чем их последо-

вательные эквиваленты, что повышает их рыночную стоимость. Иногда скорость мо-

жет спасти жизнь. В таких случаях быстрее означает лучше. Иногда решение некоторых

проблем представляется естественнее в виде коллекции одновременно выполняемых

задач. Это характерно для таких областей, как научное программирование, математи-

ческое и программирование искусственного интеллекта. Это означает, что в некото-

рых ситуациях технологии параллельного программирования снижают трудозатраты

разработчика ПО, позволяя ему напрямую реализовать структуры данных, алгоритмы

и эвристические методы, разрабатываемые учеными. При этом используется специа-

лизированное оборудование. Например, в мультимедийной программе с широкими

функциональными возможностями с целью получения более высокой производи-

тельности ее логика может быть распределена между такими специализированны-

ми процессорами, как микросхемы компьютерной графики, цифровые звуковые

процессоры и математические спецпроцессоры. К таким процессорам обычно

обеспечивается одновременный доступ. МРР-компьютеры (Massively Parallel

Processors — процессоры с массовым параллелизмом) имеют сотни, а иногда и тысячи

процессоров, что позволяет их использовать для решения проблем, которые про-

сто не реально решить последовательными методами. Однако при использовании

МРР-компьютеров (т.е. при объединении скорости и “грубой силы”) невозможное

становится возможным. К категории применимости МРР-компьютеров можно от-

нести моделирование экологической системы (или моделирование влияния раз-

личных факторов на окружающую среду), исследование космического пространства

и ряд тем из области биологических исследований, например проект моделирова-

ния генома человека. Применение более совершенных технологий параллельного

программирования открывает двери к архитектурам ПО, которые специально раз-

рабатываются для параллельных сред. Например, существуют специальные муль-

тиагентные архитектуры и архитектуры, использующие методологию “классной

доски”, разработанные специально для среды с параллельными процессорами.

1.2. Преимущества параллельного программирования 29

1.2.1. Простейшая модель параллельного

программирования (PRAM)

В качестве простейшей модели, отражающей базовые концепции параллельного

программирования, рассмотрим модель PRAM (Parallel Random Access Machine — па-

раллельная машина с произвольным доступом). PRAM — это упрощенная теоретиче-

ская модель с п процессорами, которые используют общую глобальную память. Про-

стая модель PRAM изображена на рис. 1.2.

Все процессоры имеют доступ для чтения и запи-

си к общей глобальной памяти. В PRAM-среде возмо-

жен одновременный доступ. Предположим, что все

процессоры могут параллельно выполнять различ-

ные арифметические и логические операции. Кроме

того, каждый из теоретических процессоров

(см. рис. 1.2) может обращаться к общей памяти в од-

ну непрерываемую единицу времени. PRAM-модель об-

ладает как параллельными, так и исключающими ал-

горитмами считывания данных. Параллельные алго-

Рис. 1.2. Простая модель PRAM

ритмы считывания данных позволяют одновременно

обращаться к одной и той же области памяти без ис-

кажения (порчи) данных. Исключающие алгоритмы считывания данных использу-

ются в случае, когда необходима гарантия того, что никакие два процесса никогда

не будут считывать данные из одной и той же области памяти одновременно. PRAM-

модель также обладает параллельными и исключающими алгоритмами записи дан-

ных. Параллельные алгоритмы позволяют нескольким процессам одновременно

записывать данные в одну и ту же область памяти, в то время как исключающие ал-

горитмы гарантируют, что никакие два процесса не будут записывать данные в одну

и ту же область памяти одновременно. Четыре основных алгоритма считывания

и записи данных перечислены в табл. 1.1.

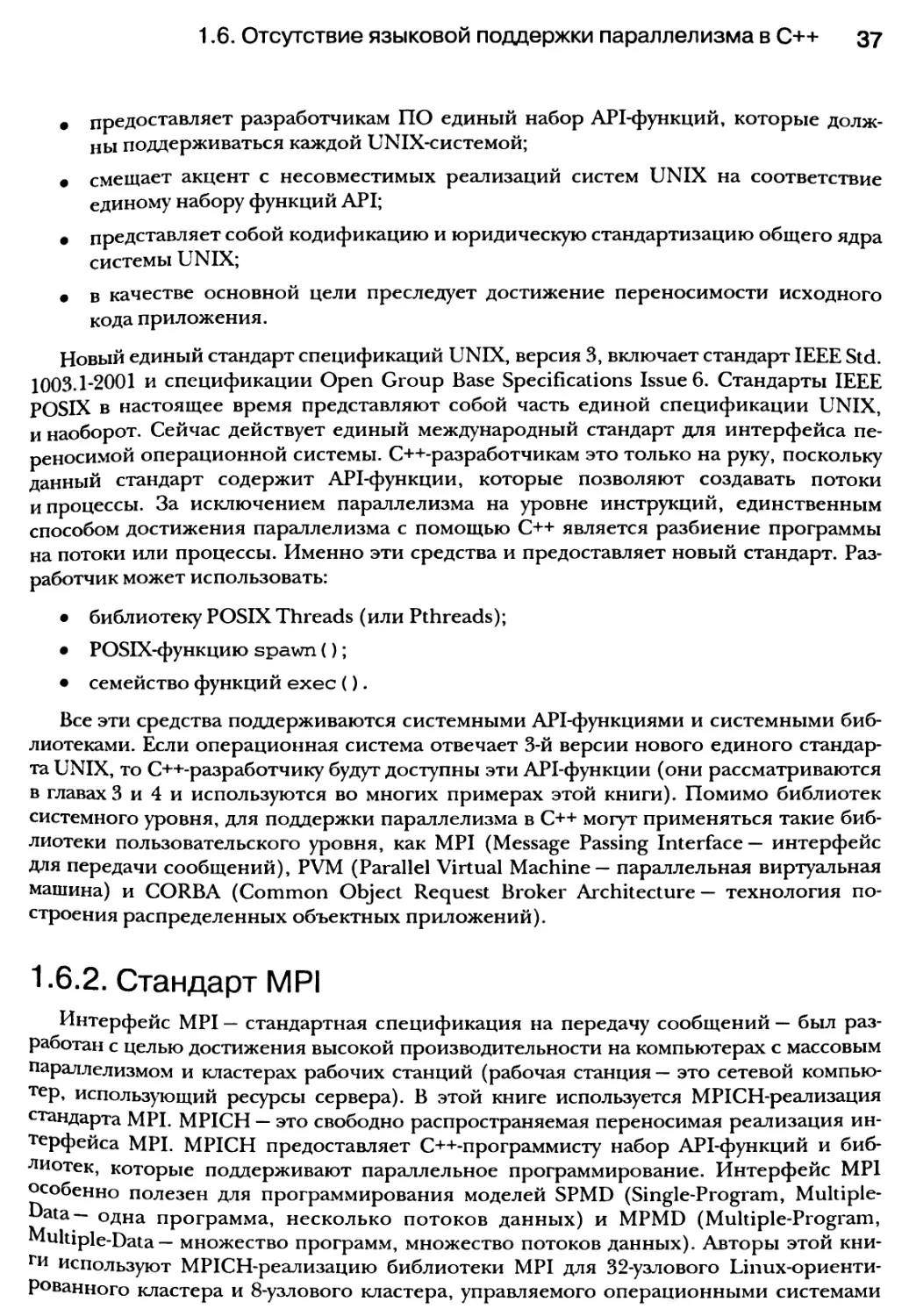

Таблица 1.1. Четыре базовых алгоритма считывания и записи данных

Типы алгоритмов

Описание

EREW CREW ERCW CRCW Исключающее считывание/исключающая запись Параллельное считывание/исключающая запись Исключающее считывание/параллельная запись Параллельное считывание/параллельная запись

В этой книге мы будем часто обращаться к этим типам алгоритмов для реализации

параллельных архитектур. Архитектура, построенная на основе технологии “классной

Доски , — это одна из важных архитектур, которую мы реализуем с помощью PRAM-

Модели (см. главу 13). Необходимо отметить, что хотя PRAM — это упрощенная теоре-

тическая модель, она успешно используется для разработки практических программ,

и эти программы могут соперничать по производительности с программами, которые

были разработаны с использованием более сложных моделей параллелизма.

30 Глава 1. Преимущества параллельного программирования

1.2.2. Простейшая классификация схем параллелизма

PRAM — это способ построения простой модели, которая позволяет предста-

вить, как компьютеры можно условно разбить на процессоры и память и как эти

процессоры получают доступ к памяти. Упрощенная классификации схем функцио-

нирования параллельных компьютеров была предложена М. Флинном (М. J. Flynn)1.

Согласно этой классификации различались две схемы: SIMD (Single-Instruction,

Multiple-Data — архитектура с одним потоком команд и многими потоками данных)

и MIMD (Multiple-Instruction, Multiple-Data — архитектура со множеством потоков

команд и множеством потоков данных). Несколько позже эти схемы были расши-

рены до SPMD (Single-Program, Multiple-Data — одна программа, несколько потоков

данных) и MPMD (Multiple-Programs, Multiple-Data — множество программ, множест-

во потоков данных) соответственно. Схема SPMD (SIMD) позволяет нескольким

процессорам выполнять одну и ту же инструкцию или программу при условии, что

каждый процессор получает доступ к различным данным. Схема MPMD (MIMD) по-

зволяет работать нескольким процессорам, причем все они выполняют различные

программы или инструкции и пользуются собственными данными. Таким образом,

в одной схеме все процессоры выполняют одну и ту же программу или инструкцию,

а в другой все процессоры выполняют различные программы или инструкции. Ко-

нечно же, возможны гибриды этих моделей, в которых процессоры могут быть раз-

делены на группы, из которых одни образуют SPMD-модель, а другие — MPMD-

модель. При использовании схемы SPMD все процессоры просто выполняют одни

и те же операции, но с различными данными. Например, мы можем разбить одну

задачу на группы и назначить для каждой группы отдельный процессор. В этом слу-

чае каждый процессор при решении задачи будет применять одинаковые правила,

обрабатывая при этом различные части этой задачи. Когда все процессоры спра-

вятся со своими участками работы, мы получим решение всей задачи. Если же при-

меняется схема MPMD, все процессоры выполняют различные виды работы, и, хо-

тя при этом все они вместе пытаются решить одну проблему, каждому из них выде-

ляется свой аспект этой проблемы. Например, разделим задачу по обеспечению

безопасности Web-сервера по схеме MPMD. В этом случае каждому процессору ста-

вится своя подзадача. Предположим, один процессор будет отслеживать работу

портов, другой — курировать процесс регистрации пользователей, а третий — ана-

лизировать содержимое пакетов и т.д. Таким образом, каждый процессор работает

с нужными ему данными. И хотя различные процессоры выполняют разные виды

работы, используя различные данные, все они вместе работают в одном направле-

нии — обеспечивают безопасность Web-сервера. Принципы параллельного про-

граммирования, рассматриваемые в этой книге, нетрудно описать, используя моде-

ли PRAM, SPMD (SIMD) и MPMD (MIMD). И в самом деле, эти схемы и модели ус-

пешно используются для реализации практических мелко- и среднемасштабных

приложений и вполне могут вас устраивать до тех пор, пока вы не подготовитесь

к параллельному программированию более высокой степени организации.

1 M.J. Flynn. Very high-speed computers. Из сборников объединения, IEEE, 54, 1901-1909 (декабрь 1966).

1.3. Преимущества распределенного программирования 31

1.3. Преимущества распределенного

программирования

Методы распределенного программирования позволяют воспользоваться пре-

имуществами ресурсов, размещенных в Internet, в корпоративных Intranet и локаль-

ных сетях. Распределенное программирование обычно включает сетевое программи-

рование в той или иной форме. Это означает, что программе, которая выполняется

на одном компьютере в одной сети, требуется некоторый аппаратный или программ-

ный ресурс, который принадлежит другому компьютеру в той же или удаленной сети.

Распределенное программирование подразумевает общение одной программы с дру-

гой через сетевое соединение, которое включает соответствующее оборудование

(от модемов до спутников). Отличительной чертой распределенных программ явля-

ется то, что они разбиваются на части. Эти части обычно реализуются как отдельные

программы, которые, как правило, выполняются на разных компьютерах и взаимо-

действуют друг с другом через сеть. Методы распределенного программирования

предоставляют доступ к ресурсам, которые географически могут находиться на боль-

шом расстоянии друг от друга. Например, распределенная программа, разделенная на

компонент Web-сервера и компонент Web-клиента, может выполняться на двух раз-

личных компьютерах. Компонент Web-сервера может располагаться, допустим, в Аф-

рике, а компонент Web-клиента — в Японии. Часть Web-клиента может использовать

программные и аппаратные ресурсы компонента Web-сервера, несмотря на то, что их

разделяет огромное расстояние, и почти наверняка они относятся к различным се-

тям, функционирующим под управлением различных операционных сред. Методы

распределенного программирования предусматривают совместный доступ к дорого-

стоящим программным и аппаратным ресурсам. Например, высококачественный го-

лографический принтер может обладать специальным программным обеспечением

сервера печати, которое предоставляет соответствующие услуги для ПО клиента. ПО

клиента печати размещается на одном компьютере, а ПО сервера печати — на другом.

Как правило, для обслуживания множества клиентов печати достаточно только одно-

го сервера печати. Распределенные вычисления можно использовать для создания

определенного уровня избыточности вычислительных средств на случай аварии. Если

разделить программу на несколько частей, каждая из которых будет выполняться на

отдельном компьютере, то некоторым из этих частей мы можем поручить одну и ту же

работу. Если по какой-то причине один компьютер откажет, его программу заменит

аналогичная программа, выполняющаяся на другом компьютере. Ни для кого не сек-

рет, что базы данных способны хранить миллионы, триллионы и даже квадриллионы

единиц информации. И, конечно же, нереально каждому пользователю иметь копию

подобной базы данных. А ведь пользователи и компьютер, содержащий базу данных,

зачастую находятся не просто в разных зданиях, а в разных городах или даже странах.

Но именно методы распределенного программирования дают возможность пользова-

телям (независимо от их местонахождения) обращаться к таким базам данных.

32 Глава 1. Преимущества параллельного программирования

1.3.1. Простейшие модели распределенного

программирования

Возможно, самой простой и распространенной моделью распределенной обра-

ботки данных является модель типа “клиент/сервер”. В этой модели программа раз-

бивается на две части: одна часть называется сервером, а другая — клиентом. Сервер

имеет прямой доступ к некоторым аппаратным и программным ресурсам, которые

желает использовать клиент. В большинстве случаев сервер и клиент располагаются

на разных компьютерах. Обычно между клиентом и сервером существует отношение

типа “множество-к-одному”, т.е., как правило, один сервер отвечает на запросы мно-

гих клиентов. Сервер часто обеспечивает опосредованный доступ к огромной базе

данных, дорогостоящему оборудованию или некоторой коллекции приложений. Кли-

ент может запросить интересующие его данные, сделать запрос на выполнение вы-

числительной процедуры или обработку другого типа. В качестве примера приложе-

ния типа “клиент/сервер” приведем механизм поиска (search engine). Механизмы

(или машины) поиска используются для поиска заданной информации в Internet или

корпоративной Intranet. Клиент служит для получения ключевого слова или фразы,

которая интересует пользователя. Часть ПО клиента затем передает сформирован-

ный запрос той части ПО сервера, которая обладает средствами поиска информации

по заданному пользователем ключевому слову или фразе. Сервер либо имеет прямой

доступ к информации, либо связан с другими серверами, которые имеют его. В иде-

альном случае сервер находит запрошенное пользователем ключевое слово или фразу

и возвращает найденную информацию клиенту. Несмотря на то что клиент и сервер

представляют собой отдельные программы, выполняющиеся на разных компьютерах,

вместе они составляют единое приложение. Разделение ПО на части клиента и сер-

вера и есть основной метод распределенного программирования. Модель типа

“клиент/сервер” также имеет другие формы, которые зависят от конкретной среды.

Например, термин “изготовитель-потребитель” (producer-consumer) можно считать

близким родственником термина “клиент/сервер”. Обычно клиент-серверными при-

ложениями называют большие программы, а термин “изготовитель-потребитель” от-

носят к программам меньшего объема. Если программы имеют уровень операционной

системы или ниже, к ним применяют термин “изготовитель-потребитель”, если вы-

ше — то термин “клиент/сервер” (конечно же, исключения есть из всякого правила).

1.3.2. Мультиагентные распределенные системы

Несмотря на то что модель типа “клиент/сервер” — самая распространенная мо-

дель распределенного программирования, все же она не единственная. Используются

также агенты — рациональные компоненты ПО, которые характеризуются самонаве-

дением и автономностью и могут постоянно находиться в состоянии выполнения.

Агенты могут как создавать запросы к другим программным компонентам, так и отве-

чать на запросы, полученные от других программных компонентов. Агенты сотруд-

ничают в пределах групп для коллективного выполнения определенных задач. В та-

кой модели не существует конкретного клиента или сервера. Это — модель сети с рав-

ноправными узлами (peer-to-peer), в которой все компоненты имеют одинаковые

права, и при этом у каждого компонента есть что предложить другому. Например,

агент, который назначает цены на восстановление старинных спортивных машин, мо-

жет работать вместе с другими агентами. Один агент может быть специалистом по мо-

1.4. Минимальные требования 33

торам, другой — по кузовам, а третий предпочитает работать как дизайнер по интерье-

рам. Эти агенты могут совместно оценить стоимость работ по восстановлению автомо-

биля. Агенты являются распределенными, поскольку все они размещаются на разных

серверах в Internet. Для связи агенты используют согласованный Internet-протокол. Для

одних типов распределенного программирования лучше подходит модель типа

“клиент/сервер”, а для других — модель равноправных агентов. В этой книге рассматри-

ваются обе модели. Большинство требований, предъявляемых к распределенному про-

граммированию, удовлетворяется моделями “клиент/сервер” и равноправных агентов.

1.4. Минимальные требования

Параллельное и распределенное программирование требует определенных за-

трат. Несмотря на описанные выше преимущества, написание параллельных и рас-

пределенных программ не обходится без проблем и необходимости наличия предпо-

сылок. О проблемах мы поговорим в главе 2, а предпосылки рассмотрим в следующих

разделах. Написанию программы или разработке отдельной части ПО должен пред-

шествовать процесс проектирования. Что касается параллельных и распределенных

программ, то процесс проектирования должен включать три составляющих: декомпо-

зиция, связь и синхронизация (ДСС).

1.4.1. Декомпозиция

Декомпозиция — это процесс разбиения задачи и ее решения на части. Иногда

части группируются в логические области (т.е. поиск, сортировка, вычисление, ввод

и вывод данных и т.д.). В других случаях части группируются по логическим ресурсам

(т.е. файл, связь, принтер, база данных и т.д.). Декомпозиция программного решения

часто сводится к декомпозиции работ (work breakdown structure — WBS). Декомпози-

ция работ определяет, что должны делать разные части ПО. Одна из основных про-

блем параллельного программирования — идентификация естественной декомпози-

ции работ для программного решения. Не существует простого и однозначного под-

хода к идентификации WBS. Разработка ПО — это процесс перевода принципов, идей,

шаблонов, правил, алгоритмов или формул в набор инструкций, которые выполняют-

ся, и данных, которые обрабатываются компьютером. Это, в основном, и составляет

процесс моделирования. Программные модели — это воспроизведение в виде ПО не-

которой реальной задачи, процесса или идеала. Цель модели— сымитировать или

скопировать поведение и характеристики некоторой реальной сущности в конкрет-

ной предметной области. Процесс моделирования вскрывает естественную декомпо-

зицию работ программного решения. Чем лучше модель понята и разработана, тем

более естественной будет декомпозиция работ. Наша цель — обнаружить параллелизм

и распределение с помощью моделирования. Если естественный параллелизм не на-

блюдается, не стоит его навязывать насильно. На вопрос, как разбить приложение на

параллельно выполняемые части, необходимо найти ответ в период проектирования,

и правильность этого ответа должна стать очевидной в модели решения. Если модель

задачи и решения не предполагает параллелизма и распределения, следует попытать-

ся найти последовательное решение. Если последовательное решение оказывается

неудачным, эта неудача может дать ключ к нужному параллельному’ решению.

34 Глава 1. Преимущества параллельного программирования

1.4.2. Связь

После декомпозиции программного решения на ряд параллельно выполняемых частей

обычно возникает вопрос о связи этих частей между собой. Как же реализовать связь, если

эти части разнесены по различным процессам или различным компьютерам? Должны ли

различные части ПО совместно использовать общую область памяти? Каким образом

одна часть ПО узнает о том, что другая справилась со своей задачей? Какая часть должна

первой приступить к работе? Откуда один компонент узнает об отказе другого компо-

нента? На эти и многие другие вопросы необходимо найти ответы при проектировании

параллельных и распределенных систем. Если отдельным частям ПО не нужно связы-

ваться между собой, значит, они в действительности не образуют единое приложение.

1.4.3. Синхронизация

Декомпозиция работ, как уже было отмечено выше, определяет, что должны делать

разные части ПО. Когда множество компонентов ПО работают в рамках одной зада-

чи, их функционирование необходимо координировать. Определенный компонент

должен “уметь” определить, когда достигается решение всей задачи. Необходимо также

скоординировать порядок выполнения компонентов. При этом возникает множество

вопросов. Все ли части ПО должны одновременно приступать к работе или только

некоторые, а остальные могут находиться пока в состоянии ожидания? Каким двум

(или больше) компонентам необходим доступ к одному и тому же ресурсу? Кто имеет

право получить его первым? Если некоторые части ПО завершат свою работу гораздо

раньше других, то нужно ли им “поручать” новую работу? Кто должен давать новую

работу в таких случаях? ДСС (декомпозиция, связь и синхронизация) — это тот мини-

мум вопросов, которые необходимо решить, приступая к параллельному или распре-

деленному программированию. Помимо сути проблем, составляющих ДСС, важно

также рассмотреть их привязку. Существует несколько уровней параллелизма в разра-

ботке приложений, и в каждом из них ДСС-составляющие применяются по-разному.

1.5. Базовые уровни программного параллелизма

В этой книге мы исследуем возможности параллелизма в пределах приложения

(в противоположность параллелизму на уровне операционной системы или аппарат-

ных средств). Несмотря на то что параллелизм на уровне операционной системы или

аппаратных средств поддерживает параллелизм приложения, нас все же интересует

само приложение. Итак, параллелизм можно обеспечить на уровне:

• инструкций;

• подпрограмм (функций или процедур);

• объектов;

• приложений.

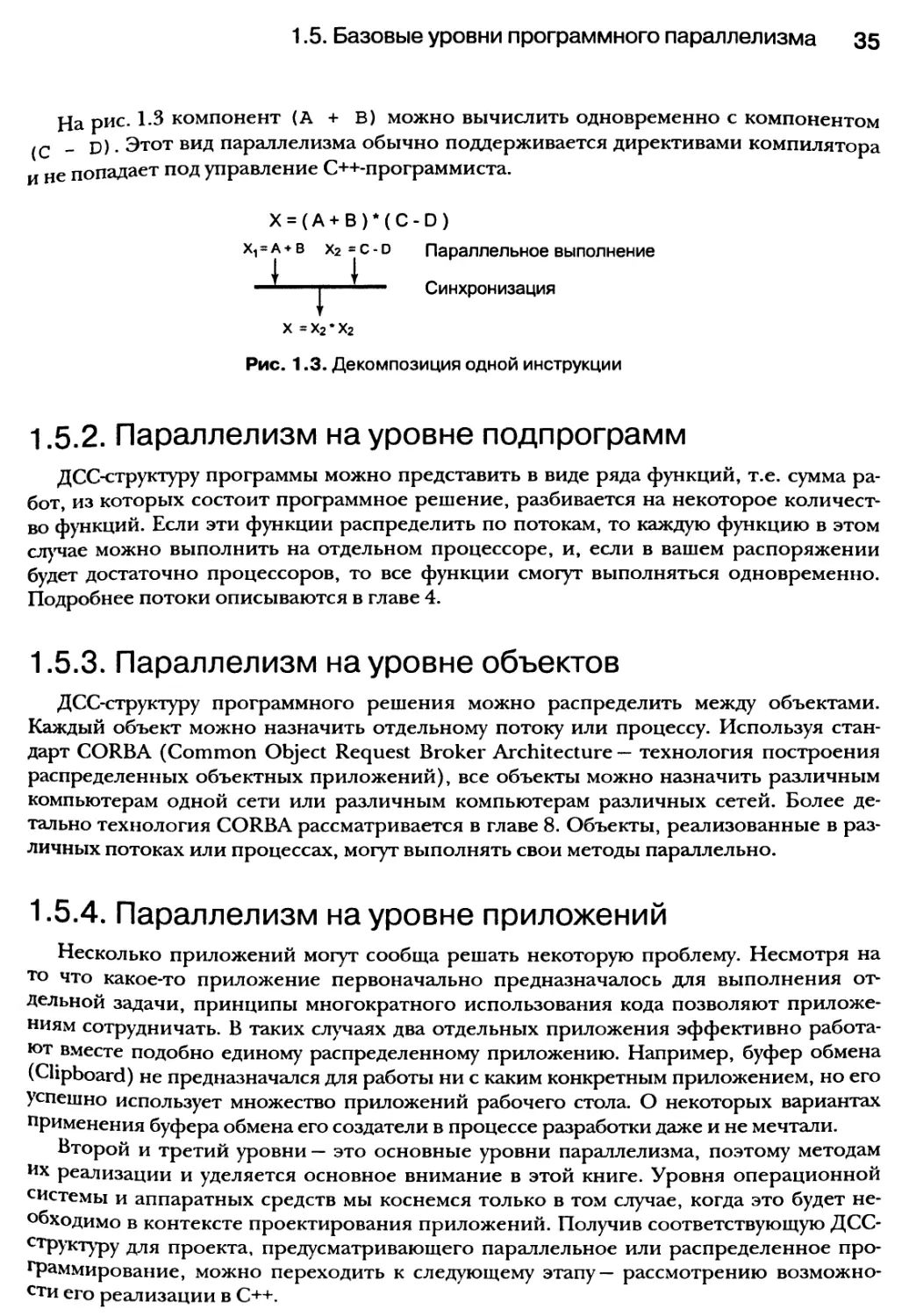

1.5.1. Параллелизм на уровне инструкций

Параллелизм на уровне инструкций возникает, если несколько частей одной инст-

рукции могут выполняться одновременно. На рис. 1.3 показан пример декомпозиции

одной инструкции с целью достижения параллелизма выполнения отдельных операций.

1.5. Базовые уровни программного параллелизма 35

На рис. 1.8 компонент (А + В) можно вычислить одновременно с компонентом

(Q _ о) • Этот вид параллелизма обычно поддерживается директивами компилятора

и не попадает под управление С++-программиста.

X = (А + В ) * ( С - D )

Х1 = а + в х2 s с -d Параллельное выполнение

1J..... Синхронизация

X = х2 • х2

Рис. 1.3. Декомпозиция одной инструкции

1.5.2. Параллелизм на уровне подпрограмм

ДСС-структуру программы можно представить в виде ряда функций, т.е. сумма ра-

бот, из которых состоит программное решение, разбивается на некоторое количест-

во функций. Если эти функции распределить по потокам, то каждую функцию в этом

случае можно выполнить на отдельном процессоре, и, если в вашем распоряжении

будет достаточно процессоров, то все функции смогут выполняться одновременно.

Подробнее потоки описываются в главе 4.

1.5.3. Параллелизм на уровне объектов

ДСС-структуру программного решения можно распределить между объектами.

Каждый объект можно назначить отдельному потоку или процессу. Используя стан-

дарт CORBA (Common Object Request Broker Architecture — технология построения

распределенных объектных приложений), все объекты можно назначить различным

компьютерам одной сети или различным компьютерам различных сетей. Более де-

тально технология CORBA рассматривается в главе 8. Объекты, реализованные в раз-

личных потоках или процессах, могут выполнять свои методы параллельно.

1.5.4. Параллелизм на уровне приложений

Несколько приложений могут сообща решать некоторую проблему. Несмотря на

то что какое-то приложение первоначально предназначалось для выполнения от-

дельной задачи, принципы многократного использования кода позволяют приложе-

ниям сотрудничать. В таких случаях два отдельных приложения эффективно работа-

ют вместе подобно единому распределенному приложению. Например, буфер обмена

(Clipboard) не предназначался для работы ни с каким конкретным приложением, но его

успешно использует множество приложений рабочего стола. О некоторых вариантах

применения буфера обмена его создатели в процессе разработки даже и не мечтали.

Второй и третий уровни — это основные уровни параллелизма, поэтому методам

их реализации и уделяется основное внимание в этой книге. Уровня операционной

системы и аппаратных средств мы коснемся только в том случае, когда это будет не-

обходимо в контексте проектирования приложений. Получив соответствующую ДСС-

структуру для проекта, предусматривающего параллельное или распределенное про-

граммирование, можно переходить к следующему этапу — рассмотрению возможно-

сти его реализации в C++.

36 Глава 1. Преимущества параллельного программирования

1.6. Отсутствие языковой поддержки

параллелизма в C++

Язык C++ не содержит никаких синтаксических примитивов для параллелизма.

С++-стандарт ISO также отмалчивается на тему многопоточности. В языке C++ не пре-

дусмотрено никаких средств, чтобы указать, что заданные инструкции должны вы-

полняться параллельно. Включение встроенных средств параллелизма в других язы-

ках представляется как их особое достоинство. Бьерн Страуструп, создатель языка

C++, имел свое мнение на этот счет:

Можно организовать поддержку параллелизма средствами библиотек, которые будут

приближаться к встроенным средствам параллелизма как по эффективности, так и по

удобству применения. Опираясь на такие библиотеки, можно поддерживать различные

модели, а не только одну, как при использования встроенных средств параллелизма.

Я полагаю, что большинство программистов согласятся со мной, что именно такое

направление (создание набора библиотек поддержки параллелизма) позволит ре-

шить проблемы переносимости, используя тонкий слой интерфейсных классов.

Более того, Страуструп говорит: “Я считаю, что параллелизм в C++ должен быть

представлен библиотеками, а не как языковое средство”. Авторы этой книги находят

позицию Страуструпа и его рекомендации по реализации параллелизма в качестве

библиотечного средства наиболее подходящими с практической точки зрения. В на-

стоящей книге рассмотрен только этот вариант, и такой выбор объясняется доступно-

стью высококачественных библиотек, которые успешно можно использовать для реше-

ния задач параллельного и распределенного программирования. Библиотеки, которые

мы используем для усиления языка C++ с этой целью, реализуют национальные и между-

народные стандарты и используются тысячами С++-программистов во всем мире.

1.6.1. Варианты реализации параллелизма

с помощью C++

Несмотря на существование специальных версий языка C++, предусматривающих

“встроенные” средства параллельной обработки данных, мы представляем методы

реализации параллелизма с использованием стандарта ISO (International Organization

for Standardization — Международная организация по стандартизации) для C++. Мы

находим библиотечный подход к параллелизму (при котором используются как сис-

темные, так и пользовательские библиотеки) наиболее гибким. Системные библио-

теки предоставляются средой операционной системы. Например, поточно-

ориентированная библиотека POSIX (Portable Operating System Interface — интер-

фейс переносимой операционной системы) содержит набор системных функций,

которые в сочетании с языковыми средствами C++ успешно используются для

поддержки параллелизма. Библиотека POSIX Threads является частью нового еди-

ного стандарта спецификаций UNIX (Single UNIX Specifications Standard) и включе-

на в набор стандартов IEEE, описывающих интерфейсы ОС для UNIX (IEEE Std.

1003.1-2001). Создание нового единого стандарта спецификаций UNIX финансиру-

ется организацией Open Group, а его разработка поручена организации Austin

Common Standards Revision Group. В соответствии с документами Open Group но-

вый единый стандарт спецификаций UNIX:

1.6. Отсутствие языковой поддержки параллелизма в C++ 37

• предоставляет разработчикам ПО единый набор API-функций, которые долж-

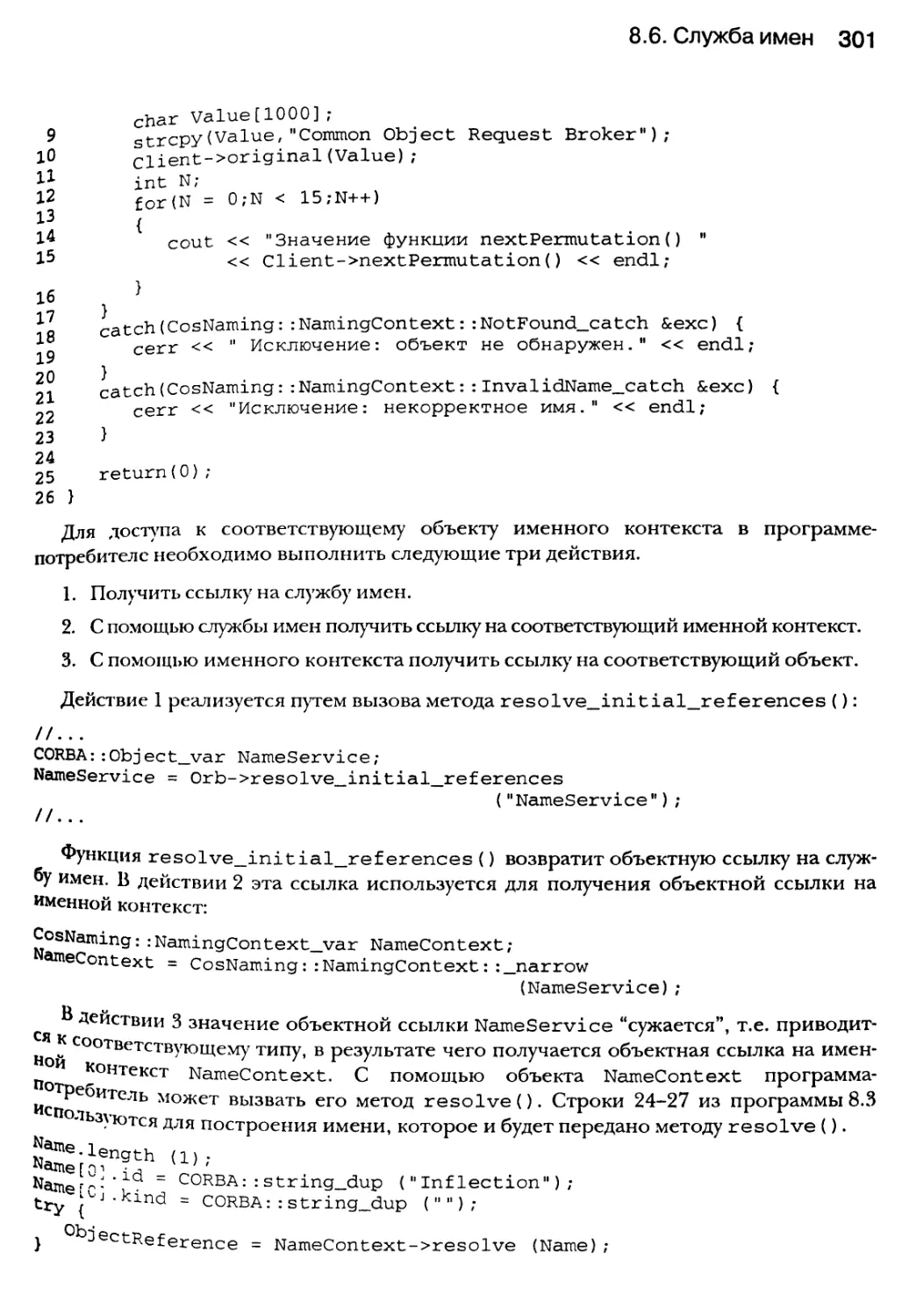

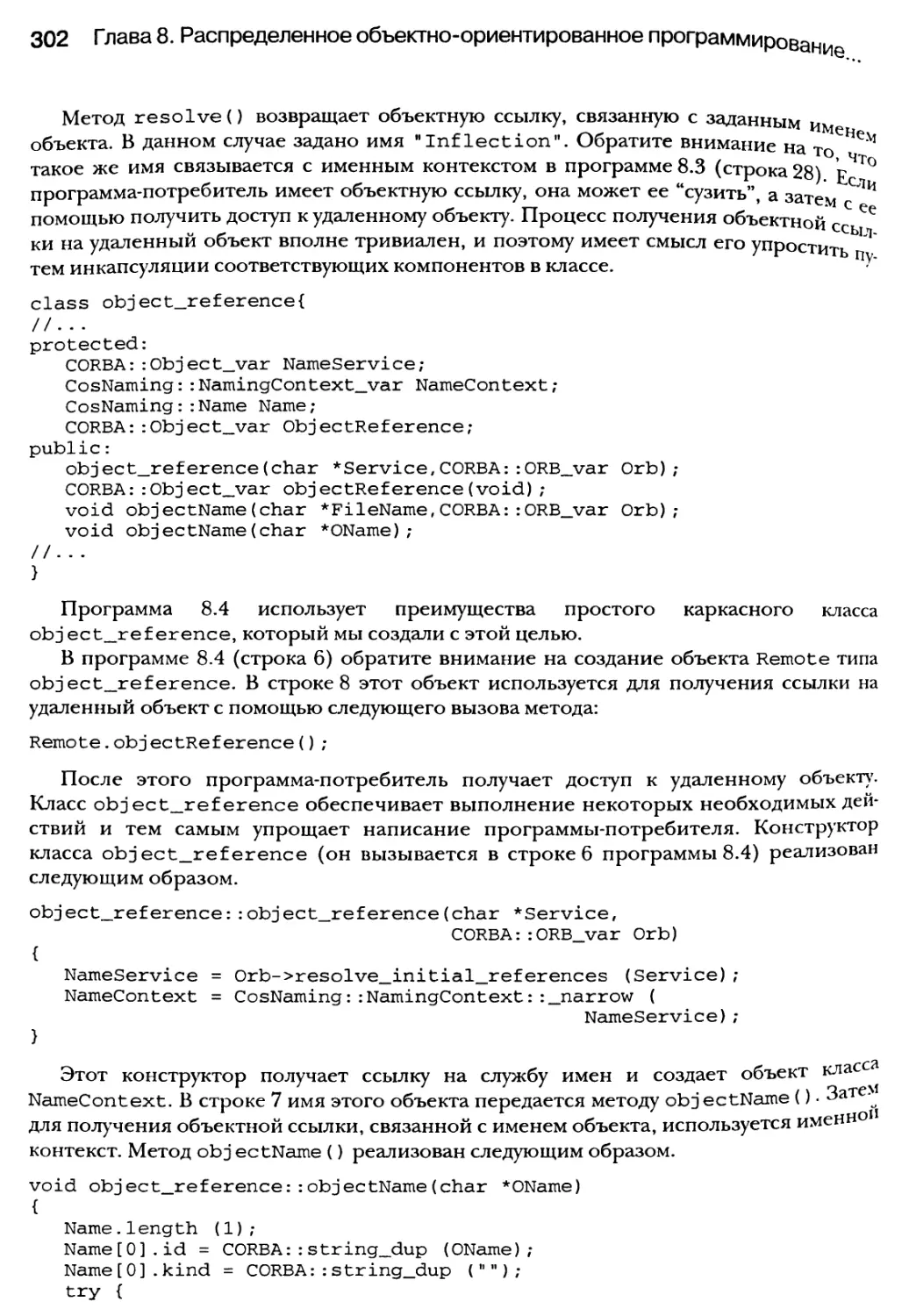

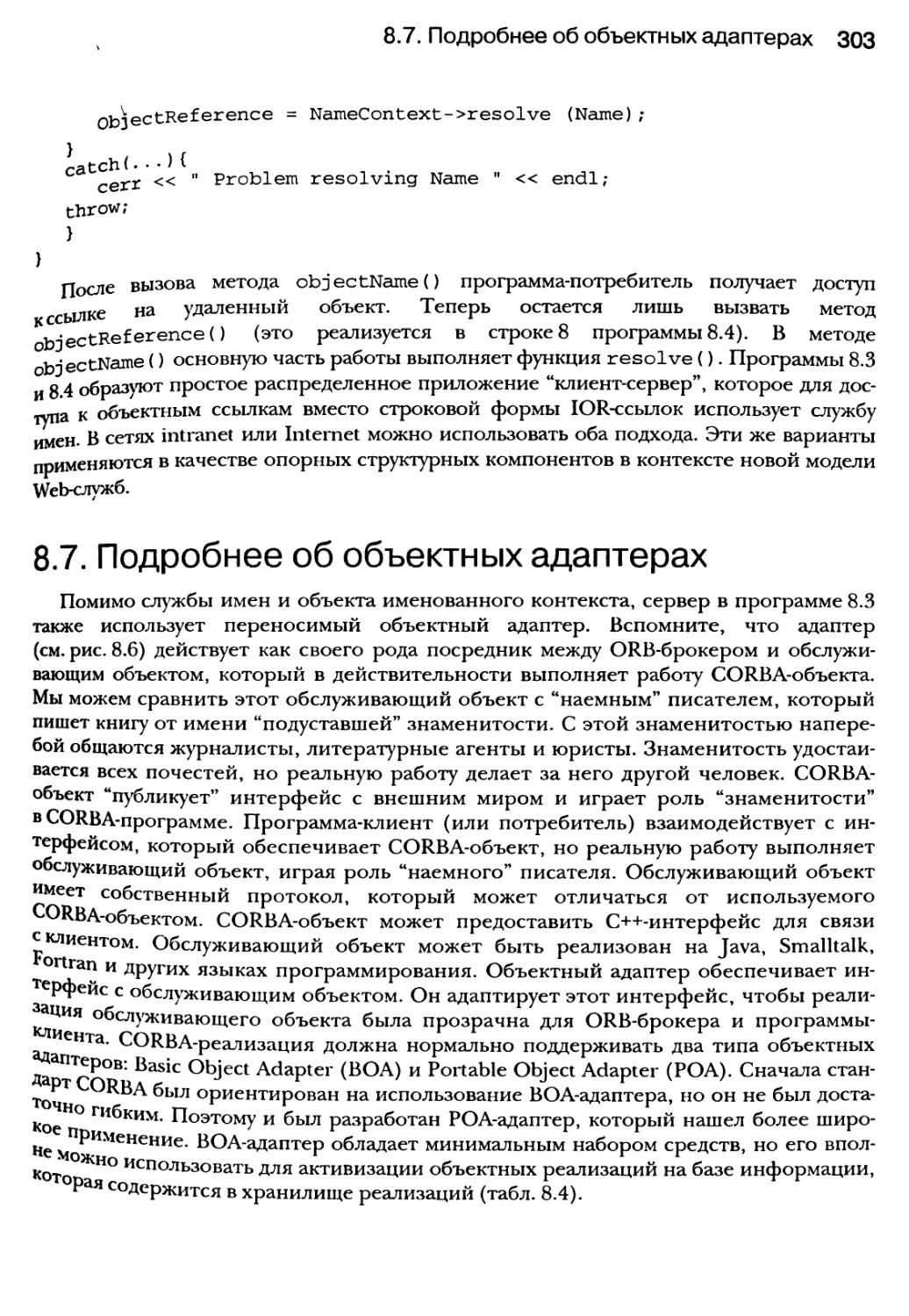

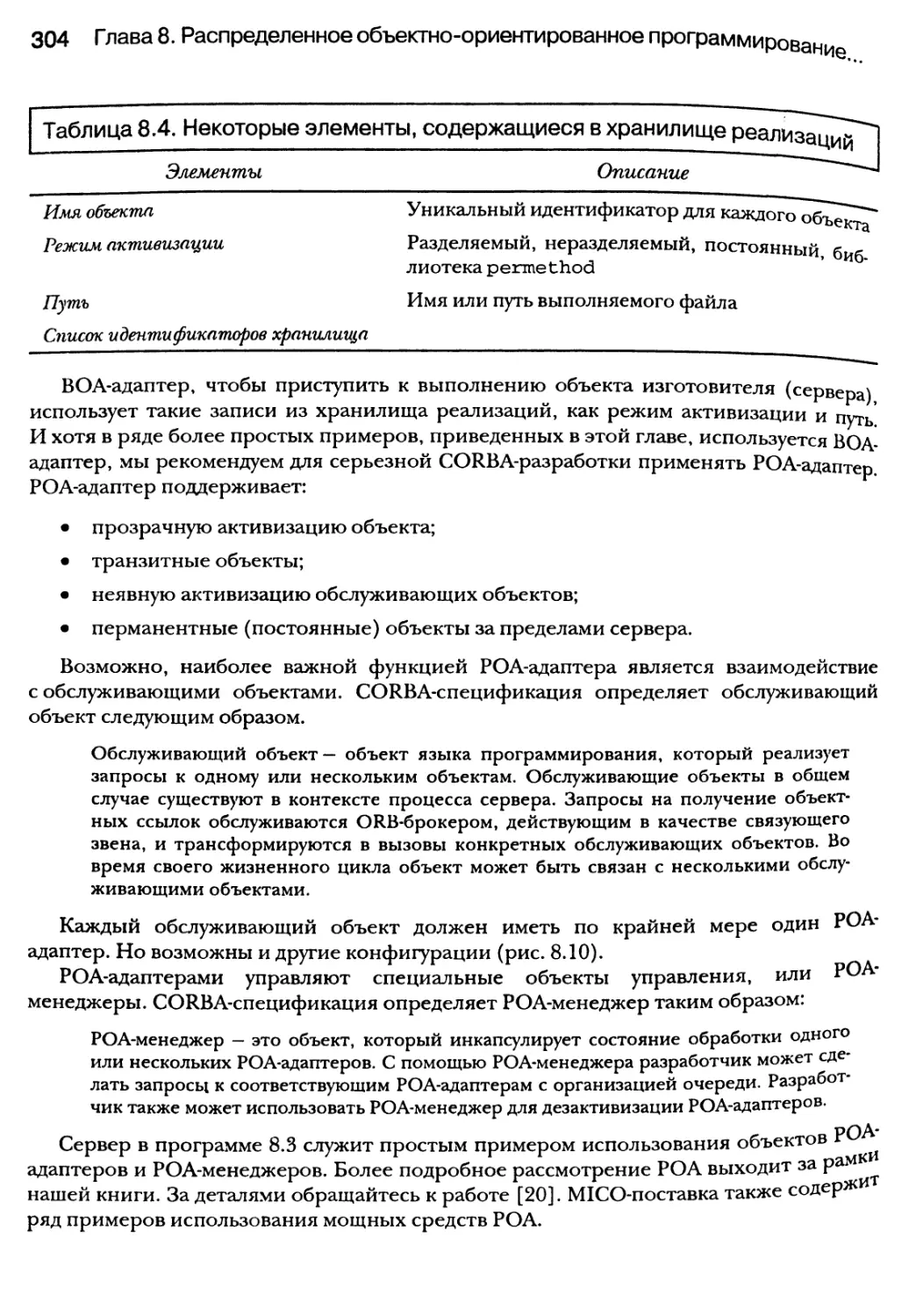

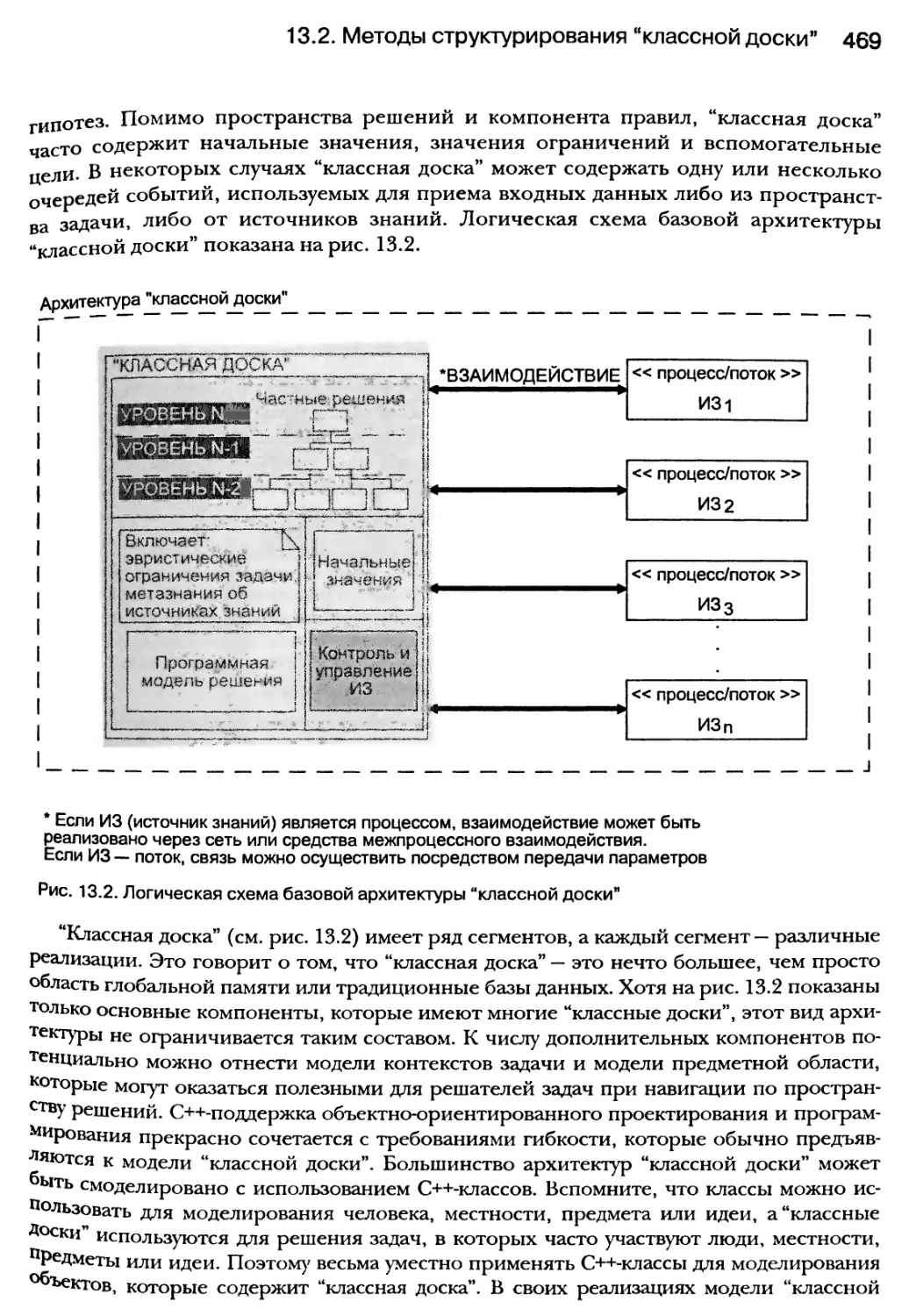

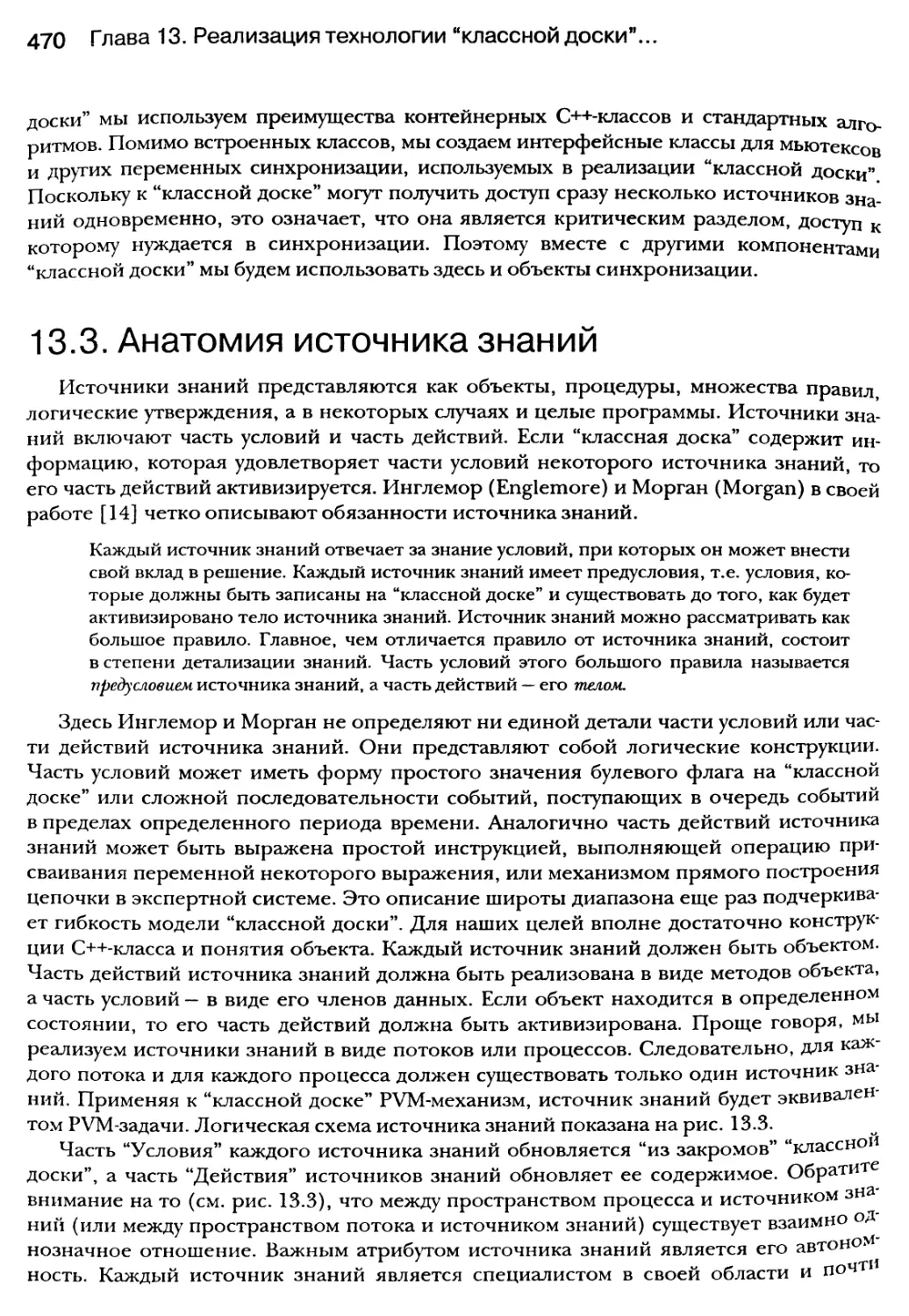

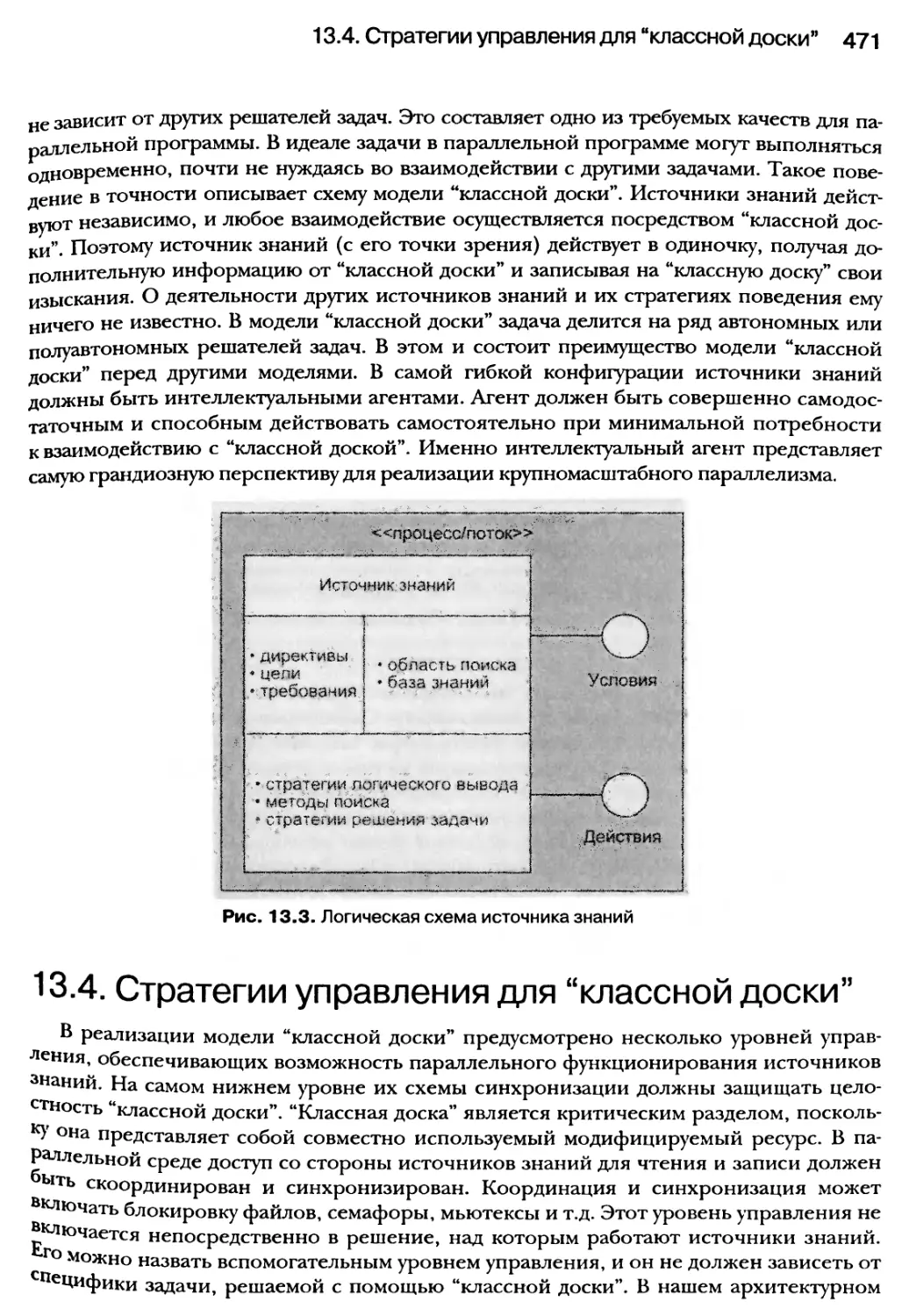

ны поддерживаться каждой UNIX-системой;