Text

Кибернетический

сборник

НОВАЯ СЕРИЯ

ВЫПУСК

4

Сборник переводов

Под редакцией

А. А. ЛЯПУНОВА и О. Б. ЛУПАНОВА

ИЗДАТЕЛЬСТВО «МИР»

Москва 1967

УДК 519.95

Научный совет по кибернетике

Академии наук СССР

Четвертый выпуск новой серии кибернетических сборников состоит из

двух разделов: математические вопросы и математическая лингвистика.

В первом из них помещены статьи по теории кодирования, линейному

программированию и теории алгоритмов с оценками. Несомненный интерес у

читателей вызовет впервые публикуемая в этом сборнике статья на весьма

актуальную тему о вычислительной сложности алгоритмов (Хартманиса и

Стириза).

В раздел «Математическая лингвистика» включена работа Н. Хомского и

Дж. Миллера, завершающая собой цикл статей, в которых обсуждаются

математические модели языка.

Сборник рассчитан на научных работников, инженеров, аспирантов и

студентов различных специальностей, занимающихся и интересующихся

кибернетикой в ее математическом аспекте^

Редакция литературы по вопросам математических наук

Инд. 2-2-3

Математические вопросы

Структура и свойства бинарных

циклических алфавитов^)

Дж. Мак-Вильяме

Коды, которые могут использоваться для контроля ошибок в реальных

системах передачи данных, ограничены природой передающей аппаратуры.

Эти ограничения не связаны с главными функциями кода, хотя, конечно, они

часто исключают большинство кодов, относительно которых в настоящее

время что-либо известно.

Например, код, который следует использовать для контроля ошибок и

ретрансляции на линиях между центрами, коммутирующими данные, должен

быть циклическим (или укороченным циклическим) кодом с 744

информационными позициями и 20 корректирующими позициями. Вычислительная

проблема в этом случае локализуется на тех циклических кодах, которые имеют

точно 20 корректирующих позиций и блоковую длину 764 или' больше, и.

состоит в выборе такого кода, который является наиболее подходящим для

контроля ошибок для конкретного канала.

В данной статье дается процедура решения таких задач. В ней

описывается, как определять циклические коды с фиксированной блоковой длиной

и фиксированным числом корректирующих позиций, если, конечно, такие

существуют, и даются некоторые методы нахождения числа кодовых слов

каждого веса в данном коде. При известной статистике канала это позволяет

оценить корректирующие свойства кода.

Предлагаемая процедура основана на анализе алгебраической структуры

циклических кодов, который проводится в разд. П. Разд. I содержит

поэтапное описание процедуры без математического обоснования. Можно надеяться,

что теория, приводимая в разд. П, окажется полезной в других приложениях.

ВВЕДЕНИЕ

В данной статье слово «алфавит» означает систематический

код —код, в котором каждое кодовое слово содержит

определенное фиксированное число k информационных позиций,

значения которых являются произвольными, и фиксированное

число п— k корректирующих позиций. Каждая цифра, стоящая в

корректирующей позиции, является суммой значений, которые

принимаются в определенном подмножестве информационных

позиций. Число п называется блоковой длиной алфавита.

Индивидуальные члены алфавита называются буквами.

пь к^^м ^^^^ ^ ^ ^"^s ♦^•' 'The Structure and properties of binary cyclic al-

pnaDets, Bell Syst. Techn. Journ., 44, № 2 (1965), 303—332.

Дж. МаК'Вильямо

Хорошо известно [1], что буквы алфавита с блоковой

длиной п образуют подпространство векторного пространства всех

возможных строк из п бинарных символов. Это большое

пространство обозначается через V^y где V — поле {О, 1}. Число k

информационных позиций является также размерностью

подпространства, занимаемого алфавитом [1]. Циклический алфа^

вит обладает тем дополнительным свойством, что если он

содержит букву а, то он содержит также все векторы из V^y

которые являются циклическими подстановками а.

В силу нескольких веских причин применение циклических

алфавитов для контроля ошибок пользуется широкой

популярностью. Во-первых, циклические алфавиты имеют простые

правила кодирования, допускающие относительно дешевую

реализацию. Во-вторых, «лучшие» известные алфавиты являются

циклическими ^). В-третьих, свойство цикличности приводит к

определенной алгебраической структуре алфавитов, которая

может быть использована для предсказания их корректирующих

свойств и для отыскания алфавитов с соответствующими свойг<

ствами.

Алфавит', который может быть использован в системе

передачи данных, должен удовлетворять определенным

требованиям. Сюда относятся определенные ограничения на величины

пики одно естественное требование, заключающееся в том, что

алфавит может быть использован для контроля ошибок. Эти

ограничения не могут быть полностью произвольными: для

данной пары чисел пик возможна, что или вообще не существует

циклических алфавитов, или не существует циклического алфа:

вита с желаемыми корректирующими свойствами.

Расстояние Хэмминга между двумя векторами равно числу

координат, в которых эти векторы различны. Расстояние между

Vi и V2 равно, таким образом, минимальному числу изменений,

которые надо произвести в Vi для того, чтобы перевести его

в V2. Обычная стратегия при выборе алфавита сводится к тому,

чтобы по возможности дальше (в терминах расстояния по Хэм-

мингу) располагать его точки. Если это выполнено, то

потребуется относительно большое число ошибок для того, чтобы

перевести одну букву алфавита в другую букву того же самого

алфавита.

Вес вектора в пространстве V^ равен его расстоянию от

начала координат и, следовательно, равен числу содержащихся

в нем единиц. Пусть а с весом s будет буквой алфавитаИ.

Если р —другая буква 91, то а+ р —также буква 91, not

скольку 9[ является векторным подпространством; a-f р нахо-

^) Очень вероятно, что причиной этого является то, что никакой другой

класс алфавитов так систематически не изучался,

Бинарные циклические алфавиты

дится на расстоянии s от р. Пусть A{s) обозначает число букв

с весом S в алфавите 21. Тогда A(s) равно числу букв в

алфавите 21. находящихся на расстоянии s от некоторой произволь^

ной буквы из 21.

Множество чисел Л(0), Л(1), ..., А{п) называется спектром

алфавита 21. Спектр алфавита в сочетании со статистикой

канала может быть использован для получения оценок корректи'

рующих возможностей алфавита [2].

Алфавит, используемый для обнаружения ошибок, не

сможет обнаружить тип ошибки, который сам является буквой ал*

фавита. Если Л(1')=0, то алфавит позволяет обнаруживать все

Сп типов i-кратных ошибок на блоковой длине п. Если А{1)Ф0,

то алфавит не позволяет обнаружить Л (i) типов ошибок из Сл

возможных. Обычно для получения хорошего качества

телефонных линий, как это следует из анализа имеющихся данных [2],

требуется, чтобы Л(1) и Л (2) равнялись нулю. Для больших

значений i было бы хорошо, если бы буквы веса i не были бы

такими же, как типы ошибок, которые обычно

классифицируются как «пакеты». Это предположение приводит к следую^

щему не точно формулируемому требованию: ненулевые пози^

ции в буквах малого веса должны располагаться по

возможности дальше друг от друга. Циклические алфавиты в

определенной степени удовлетворяют этому требованию, так как их

буквы наименьшего веса охватывают ненулевыми символами по

меньшей мере n—k+l подряд идущих позиций.

Так как для целей контроля ошибок может действительно

понадобиться выбрать некоторые специальные алфавиты и так

как пока не известно, каким именно требованиям должны

удовлетворять эти алфавиты, то желательно иметь возможность

получать некоторую детальную информацию об имеющихся

алфавитах. В данной работе описывается процедура, которая с

помощью ускоренных вычислений позволяет выделить

циклические алфавиты, имеющие заключенные в некоторых границах

значения п и й, а также найти спектры этих алфавитов.

Составлена большая библиотека вычислительных программ, полезных

в данной процедуре.

Статья написана по следующему плану:

Раздел I содержит поэтапное описание процедуры выбора

циклических алфавитов и определения их спектров.

Раздел II содержит математическое обоснование процедур,

приведенных в разд. I, и является по существу достаточно

полным описанием структуры циклических алфавитов.

Для того чтобы следовать рецептам, приведенным в разд. I,

не обязательно читать разд. II. Однако в некоторых труднцх

10 Дж. МаК'Вильямс

случаях — здесь подразумеваются случаи, в которых требуются

большие затраты машинного времени, — материал разд. II

может указать путь преодоления этих трудностей.

I. СВОЙСТВА ЦИКЛИЧЕСКИХ АЛФАВИТОВ

В этом разделе мы в общих чертах описываем процедуру

решения следующей проблемы.

Для заданной блоковой длины п и заданного числа т

корректирующих позиций бинарного циклического алфавита,

лежащих в границах

требуется найти алфавит (или алфавиты), имеющий

наибольшее минимальное кодовое расстояние.

В работе всюду предполагается, что п является нечетным

числом. Многие из результатов, излагаемых в данном разделе и

доказываемых в разд. II, являются неправильными для четных

значений п.

Пусть ^п означает кольцо полиномов по модулю х'^—1 над

бинарным полем. 5И^ состоит из всех полиномов степени не

больше п—\ с коэффициентами из бинарного поля. Сложение

полиномов осуществляется как обычно, а для умножения двух

полиномов надо перемножить их обычным способом и затем

осуществить редукцию степеней х по модулю п.

Циклические алфавиты с блоковой длиной п можно

рассматривать как множества Щ таких полиномов из 9?^, которые

делятся (по модулю л:^—1) на фиксированный полином а{х).

Полином а{х) может (и должен) быть взят среди множителей

хп—ij тогда число корректирующих позиций алфавита %

совпадает со степенью а{х). Полином а{х) называется

порождающим множителем 21. Будем записывать: % = Ш^^- а {х).

Пусть 0) принимает в качестве своих значений одно из чисел

О, 1, ..., п—1. Обозначим через 22 (п) подстановку co~>2(o(modn).

Подстановка 22(ai) разбивает множество чисел О, 1, ..., п—1

на непересекающиеся циклы, например в табл. 1 приведены

циклы 22(63).

Пусть fo{x), fi{x), ..., ft^i{x) будут неприводимыми

множителями х^—1. Так как п нечетно, то все эти множители

различны. Пусть £ — первообразный корень п-й степени из

единицы. Циклы 22(л) и полиномы fi{x) связаны между собой

следующим образом: нулями fi{x) в соответствующем^) расши-

*) Например, в поле Галуа порядка 2', состоящего из корней уравнения

У^*—Уу где ^ —длина цикла подстановки 22(/г)', содержащего 1.

Доказательство этого «хорошо известного» соответствия дается в разд. II.

Винарные циклические алфавиты

11

рении бинарного поля являются С'^», С'^з, ,,.,^'"й,где {ги Гз, ...

..., Ги) —цикл 22(п); каждый цикл представляет, таким

образом, нули одного из полиномов fi{x). Число неприводимых

множителей л:^—1 совпадает, конечно, с числом циклов подстановки

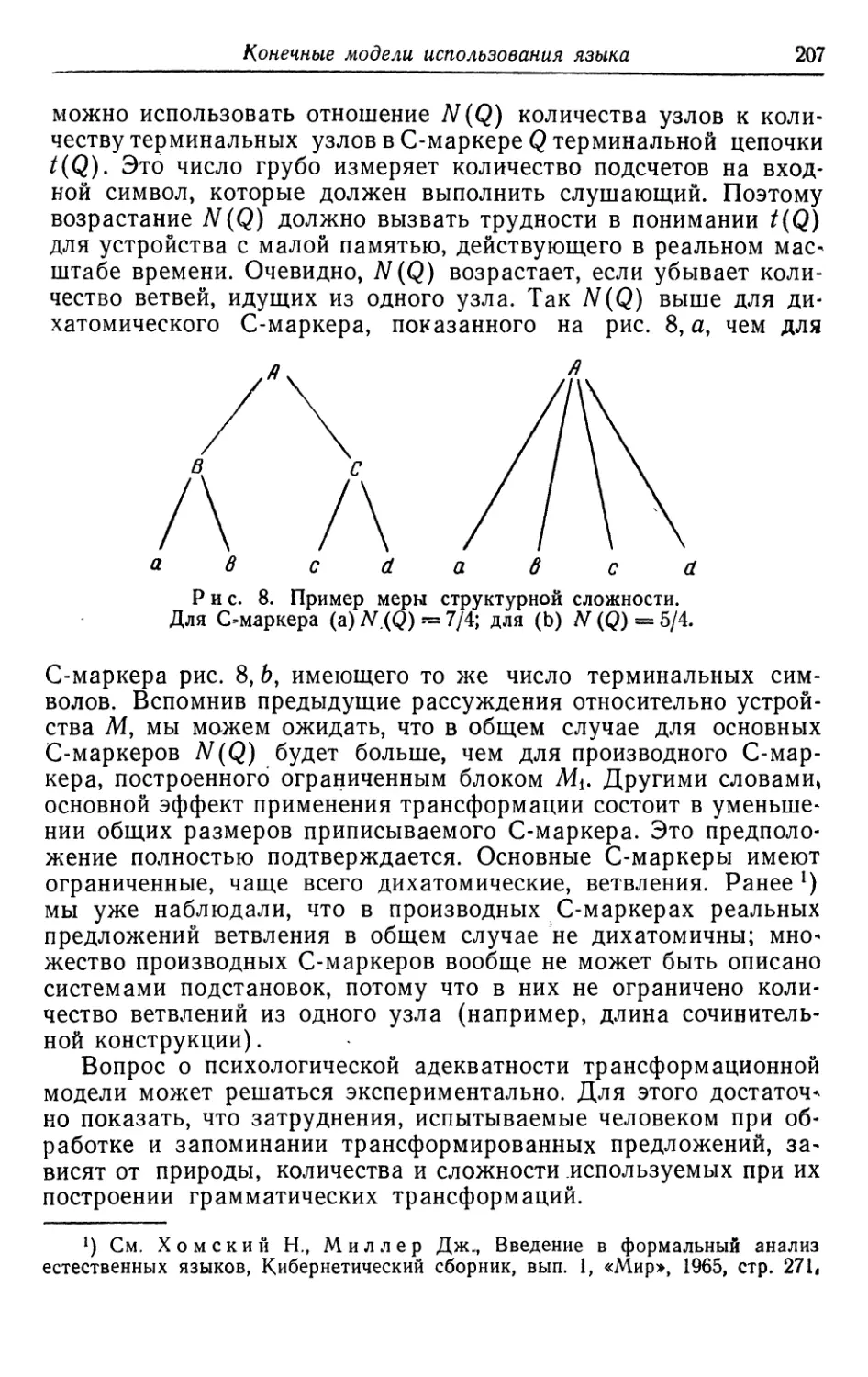

S2(n). Будем говорить, что полином fi{x) с корнями S'^i, ...,С^*

ассоциирован с циклом (ri, ..., г^).

Пусть S означает множество циклов подстановки 22(п).

Пусть fi^{x)j fi^{x)y ..., fi (jc)— множество неприводимых

множителей х'^—1, ассоциированных с циклами множества S. Пусть

a{x) = f^^{x).f^^{x)... ft^{x)

есть порождающий множитель алфавита 91. Будем говорить,

что циклический алфавит 2l = 9t„'a(.^) ассоциирован с

множеством S.

Пусть 1 <Г1<Г2< ... <п — список делителей п ^). Сопоставим

каждому циклу подстановки 22(^) показатель ei^njri,

определяемый тем свойством, что г^ является наибольшим делите-*

лем числа п, на который делится каждый член данного цикла.

Большая часть информации о циклических алфавитах с

блоковой длиной п может быть получена путем обозрения циклов

подстановки 22 (п).

Таблица 1

Циклы подстановки 2)2 (63)

1

3

5

7

9

11

13

15

21

23

27

31

0

2

6

10

14

18

22

19

30

42

29

45

47

Циклы

4

12

17

28

36

25

26

39

43

54

55

8

24

20

35

37

38

51

46

59

16

33

34

49

44

41

57

53

61

32

48

40

56

50

52

60

58

62

Показатель

63

21

63

9

7

63

63

21

3

63

7

63

1

О Введенное здесь обозначение г» для делителей п не следует путать

с предыдущим использованием этого обозначения для членов циклов. —

Прим, перев.

12 Дж. Мак-Вильяме

Предложение I. Пусть tjo, iii, ..., r\t^i будут циклима

подстановки ЕгСп), и пусть nii — длина цикла Ц{. Число ^)

циклических алфавитов с блоковой длиной п равно 2К Алфавит,

ассоциированный с множеством S циклов, имеет ш= ^ nii

корректирующих позиций.

Предложение П. Пусть е будет наименьшим обидим

кратным показателей циклов, входящих в S. Если еКп, то

алфавит, ассоциированный с S, имеет минимальное расстояние,

равное 2. Если е = п, то минимальное расстояние алфавита

равно по меньшей мере 3.

Предложение П1 (граница Бозе — Чоулхури). Если

циклы множества S содержат числа 1, 2, ..., d—1, то минимальное

расстояние алфавита, ассоциированного с S, не меньше d.

Необходимо отметить, что минимальное расстояние может

быть и часто бывает больше, чем нижняя граница,

определяемая предложениями П и П1. Можно, конечно, прийти к

заключению, что не существует удовлетворительных циклических

кодов с блоковой длиной п. Основной целью предложений I

и П является исключение из рассмотрений таких бесполезных

значений д. Предположим, однако, что данное значение п

таково, что существует алфавит с требуемым числом

корректирующих позиций и минимальным расстоянием, равным по

меньшей мере 3. Тогда полезно установить взаимно однозначное

соответствие между циклами подстановки 22 (/г) и неприводимыми

множителями х^—1.

Показатель полинома f{x) определяется как наименьшее

число е, для которого f{x) делит х^—1. Найдем неприводимые

множители многочленов х'^ — Р) и х^^—1 {ei = h/ai) для

каждого делителя а{ числа п. Некоторые из неприводимых

множителей многочлена х^—1 принадлежат показателю е^ они

появляются среди неприводимых множителей x^t — i ц могут быть

определены с помощью проверки.

Любой неприводимый множитель х^—1, принадлежащий

показателю /г, может быть выбран в качестве ассоциированного

с циклом, содержащим единицу, подстановки 22 (^). Пусть

fi{x) является таким полиномом, тогда t, — нуль fi(x). Если г

*) Это число включает три «тривиальных» алфавита: алфавит,

совпадающий со всем Шп1 алфавит, состоящий только из нуля, и алфавит,

содержащий только нуль и вектор веса л.

2) Это, действительно, сделано для всех нечетных значений л < 1023,

Бинарные циклические алфавиты 13

является собственным делителем п, то г — наименьший член

цикла с показателем е = п1г. Полином, ассоциированный с этим

циклом, также имеет показатель е. Пусть gu g2, . •., gs будут

неприводимыми множителями х'^—1, принадлежащими

показателю е. Выбирая fi{x) ассоциированным с циклом, содержащим

единицу, мы неявным образом делаем выбор, согласно

которому полином ^г(^) ассоциирован с циклом, содержащим г.

Этот выбор может быть сделан явным следующим образом.

Предложение IV. Многочлен gi(х^) делится нацело на

fi{x) тогда и только тогда, когда он ассоциирован с циклом,

codepMaWfUM г^).

Мы можем теперь приписать каждому делителю п числа п

неприводимый множитель fi{x) многочлена д:^—1,

принадлежащий показателю ei^njri. Для этого не надо тем не менее

просматривать каждый из циклов подстановки 22(п),

ассоциированных с неприводимыми множителями х'^—1. Основная

работа может быть проделана по-другому. Прежде чем описывать

эту процедуру, мы ее проиллюстрируем.

Предположим, что пит заключены в следующих границах:

52<^а1-<64 и т==9. Найдено, что

2i (53) имеет два цикла длин 1, б^;

Ег (55) имеет пять циклов длин 1,4, 10, 20, 20;

22 (57) имеет пять циклов длин 1, 2, 18, 18, 18;

Ез (59) имеет два цикла длин 1, 58;

Ег (61) имеет два цикла длин 1, 60;

22 (63) имеет тринадцать циклов длин 1, 2, 3, 6.

Согласно предложению I, единственно возможной блоковой

длиной является 63, поскольку длины циклов для других значе-^

НИИ п не могут в сумме дать девять. Делителями 63 являются

3,7,9,21. Циклы подстановки 22(63) и их показатели

приведены в табл. 1. Девять корректирующих позиций могут быть

получены, если взять один цикл длины 6 и один цикл длины 3

или цикл длины 6, цикл длины 2 и цикл длины 1. Согласно

предложению П, наименьшее общее кратное показателей

циклов должно быть, 63. Следовательно, цикл длины 6 должен

иметь показатель 63 или 9^). Граница Бозе — Чоудхури не дает

дополнительной информации: минимальное расстояние, равное

') Этот элегантный и экономящий время способ был предложен Р. Л.

Грэхемом (R. L. Graham).

^) Это обстоятельство было пропущено, поскольку автор не заметила это

во-время.

14

Дж. Мак-Вильямс

Трем, обеспечивается предложением II, и мы не можем

подобрать комбинацию циклов, содержащих числа 1, 2 и 3 и

имеющих только девять корректирующих позиций. Следовательно,

надо просчитать спектры 18 различных алфавитов. (Ниже

будет показано, что это не является необходимым.)

Предположим, что т=12. Тогда выбор первого и второго

циклов в соответствии с предложением III обеспечивает нам

минимальное расстояние, равное по меньшей мере пяти^).

Таблица 2

Неприводимые множители многочлена х^^ — 1

/l

/2

/з

/4

/б

/б

/7

Л

Л

/ю

/и

fn

/l3

Множитель

714

414

700

554

534

634

444

664

724

604

600

540

640

Показатель

63

63

3

63

21

63

^ 9

63

21

63

1

7

7

Ассоциированный цикл

1, 2, 4, 8, 16, 32

21, 42

3, 6, 12, 24, 33, 48

7, 14, 28, 35, 49, 56

-

9, 18, 36

Полиномы записаны в восьмеричной системе так, что при переводе цифр в двоичную

систему единицы означают позиции с ненулевыми коэффициентами. Члены полиномов

располагаются в возрастающем порядке их степеней, например

714=:111001100г=1 + л:4-л:2 + л:5+;гв.

Таблица 2 содержит список неприводимых множителей

многочлена л:^^—1 и их показатели. Свяжем первый полином (714)

с первым циклом. Тогда один из полиномов с показателем 21

будет ассоциирован со вторым циклом. В соответствии с

предложением IV правильным выбором является 534. Полноты ради

мы используем также предложение IV для установления

соответствия между полиномом 640 и циклом, начинающимся с 9.

VI Математически не доказано, что другой выбор не может привести к

большему минимальному расстоянию. Для полной уверенности необходимо

вычислить спектры всех алфавитов с 12 корректирующими позициями и

показателем 63,

Бинарные циклические алфавиты 15

Единственным полиномам с показателями 9 и 3 соответствуют,

естественно, циклы, начинающиеся с 7 и 21.

Для объяснения последующих шагов необходимо ввести

некоторые дальнейшие определения.

Пусть q будет числом, взаимно простым с п. Отображение

Oq : х^ ~> х^^ (показатель степени берется по модулю п) является

автоморфизмом в 31„. Действие Oq на циклический алфавит

переводит его в эквивалентный [1] циклический алфавит: 31а^=21^

причем 3[ и 31' имеют одинаковые спектры. Число

подстановок Gq, различно действующих на 31, относительно мало; если

qi и q2 лежат в одном и том же цикле подстановки 22(п), то

31а,. = 31а,,.

(В частности, если q лежит в цикле, содержащем 1, то

Sla, = 3l.)

Из каждого цикла S2(ai), содержащего числа, взаимно

простые с п, выберем по одному q. Для az = 63 мы выберем числа,

лежащие в основе табл. 1. Такой выбор обладает

вычислительными преимуществами, поскольку 52^25 (mod 63); 5^^62(mod 63);

5^=58 (mod 63), 5^=38 (mod 63).

Каждый циклический алфавит 3[ содержит единственный

полином с{х), идемпотент 21, который обладает следующим

полезным свойством: 31а, = 31' тогда и только тогда, когда

c{x)aq = c^{x). Для целей вычислений лучше знать

идемпотент % чем порождающий множитель 3[. Обозначим через

1+9г(А:) идемпотент алфавита ^nfi(x), где fi(x)

—неприводимый множитель многочлена х'^—1. Полиномы 9г(А:), i = 0, 1, ...

..., t—1, называются примитивными идемпотентами кольца Ш^

и обладают следующими полезными свойствами:

(i) вг(А:) могут быть легко вычислены; в частности, это

проделано для всех нечетных п<^1023. (Метод, с помощью которого

это было сделано, описывается в следующем разделе.)

(ii) Идемпотент алфавита с порождающим множителем

fiS^)fiM^'-fi,{^) равен

1 + е/Л^) + в/Лх)+ ... +Qtri^).

(iii) Автоморфизмы Oq приводят к перестановкам идемпо-

тентов Qi{x) между собой.

Алфавит с идемпотентом Qi{x) является минимальным

алфавитом в Шп (т. е. он не имеет ненулевых подалфавитов). Его

порождающий множитель равен (л:^—l)/fi{x). Алфавит споро

ждающим многочленом fiix) является максимальным

алфавитом в 3?я и имеет идемпотент 1+Ji(a:).

le Дж. МаК'Вильяме

По своей природе циклический алфавит % определяется ско-^

рее суммой примитивных идемпотентов JR^j, чем произведением

неприводимых множителей полинома х'^—1.

Предложение V. Если fi(х) и f^{х) — неприводимые

множители многочлена х^—1, принадлежащие одному и тому же

показателю, то Qi{x)ag=Q2{x) для некоторого автоморфизма Og

кольца ^п- Следовательно, минимальные алфавиты,

порожденные многочленами 6i(-v) и 02(л:), эквивалентны, и максимальные

алфавиты, порожденные многочленами 1 + 0i(a:) и 1 + д2{х)у

также эквивалентны. Наоборот, если два минимальных

(максимальных) алфавита имеют тот же самый спектр, то они

эквивалентны относительно одного из автоморфизмов Og.

Предложение VI. Алфавит с идемпотентом (1 + 9^1 +

4- • • • +9^) эквивалентен алфавиту с идемпотентом (1 + 9£^а^+

Предложение VII. Пусть 1 +вг(х) является

идемпотентом, ассоциированным с циклом подстановки 22(az),

содержащим 1. Пусть и и V — числа, взаимно простые спи такие, что

uv^\{modn). Тогда \+Qi{x)au является идемпотентом,

ассоциированным с циклом 22 (^), содержащим v.

Иллюстрацию опять проведем для случая я = 63. Табл. 3

содержит список примитивных идемпотентов $Нез- Этот список

параллелен списку табл. 2. В табл. 2 f-й множитель fi{x)

является порождающим множителем алфавита с идемпотентом

1+в{{х)у где вг(А^) является /-М примитивным идемпотентом

табл. 3. Соответствие между некоторыми Эг^л:) и циклами

Иг (63) перенесено из табл. 2.

Автоморфизм 05 приводит к следующей подстановке множен

ства примитивных идемпотентов кольца ^Iq^:

(9i, 9io, Ss» ^6, 02, %){%, 09)(0i2, ^id) {%){%) i^u)'

Другие автоморфизмы, как уже говорилось, приводят-4с сте-«

пеням этой подстановки.

Например, (Тв2=с^5* Д^^т

(вх, ве)(0,о, 02) (вз, 04) (05, 9,) (0,2, 9,з) (0з) (9^) (©п).

Рассмотрим алфавит с девятью корректирующими позиция^

ми, ассоциированный с циклами (1, 2, 4, 8, 16, 32) и (9, 18, 36).

По табл. 2 порождающим множителем этого алфавита

является./i (л:) fi3 (л:), а его идемпотентом — (1+01+^01з). Идемпо-

тенты, которые могут быть получены из этого идемпотента с по-

Бинарные циклические алфавиты

17

Таблица 3

ei

62

ез

64

Об

Об

67

68

69

бю

би

^12

^13

Примитивные идемпотенты кольца

321026251170

010305172162

333333333333

044160277124

012231301223

375343166036

044044044044

331327363052

323I120323I1

375263355116

777777777777

456271345627

723516472351

156307227 0

267315277

333333333

317353233

130122313

225150213

044044044

375016044

203231120

136243020

777777777

134562713 -

647235164

^69

Ассоциированные циклы

в соответствии

с табл. 2

1, 2, 4, 8, 16, 32

21, 42

-

3, 6, 12, 24, 33, 48

7, 14, 28, 35, 49, 56

0

9, 18, 36

В соответствии

со свойством VI

11, 22, 25, 37, 44, 50

5, 10, 17, 20, 34, 40

31, 47, 55, 56, 61, 62

1 22, 29, 43, 46. 53, 58

15, 30, 39. 51, 57, 60

13, 19, 26, 38, 41, 52

27, 45, 54

-

') Используя соотношение 94'a5=9i, легко проверить, что здесь произошла опечатка и

идемпотентом 6i является многочлен 321026251170 156307277, вес которого действительно

равен 32,—Прим, перев.

МОЩЬЮ автоморфизма сГб и его степеней, равны

1 + ^10 + ^12» 1 + ^8 + ^13» 1 + 9б + ^12»

1 + 92+913, l + 94+9i2.

Порождающие множители соответствующих алфавитов

(включая исходный алфавит) имеют вид

fi • fis, fio • fi2, fe • fi3, fe • fi2, /2 • fi3i /4 • fi2-

В соответствии с предложением VI все эти (шесть)

алфавиты эквивалентны. Аналогично алфавит, ассоциированный с

циклами (1, 2, 4, 8, 16, 32) и (27, 45, 54), имеет идемпотент

1+61 + 612, и ему эквивалентны алфавиты с идемпотентами

l + 9io+9i3, 1 + 98+9,2, 1+ 96 + 6,3, 1 + 62+6,2, 1 + 64+018

Третья возможность при девяти корректирующих позициях

связана с циклами (1, 2, 4, 16, 32), (21, 42), (0).

Ассоциированный идемпотент равен 1+61 + 63 + 611, и эквивалентные

алфавиты определяются идемпотентами

i + eio+вз+ви, 1+б8+бз+е,„ 1 + ве+бз+ен,

1 + е2+ез+вп, 1 + в4+ез+вп.

2 Зак. 47f

18 Дж, МаК'Вильямс

Следовательно, среди 18 алфавитов с девятью

корректирующими позициями и минимальным расстоянием не меньше 3 в

действительности имеются самое большее три различных

спектра.

Выше мы показали, что алфавит с 12 корректирующими по-»

зициями, ассоциированный с циклами (1, 2, 4, 8, 16, 32) и

(3, 6, 12, 24, 33, 48), имеет минимальное расстояние, по меньшей

мере равное 5. Идемпотент этого алфавита равен l+Bi + Bs.

Имеется по меньшей мере^) пять эквивалентных алфавитов,

которые определяются идемпотентами

i + eio+e9> 1 + 98+65» i + Oe+e^, i+ 92+85, 1+ 94+89.

Оказалось, что один из этих алфавитов исследовать легче,

чем выбранный исходный алфавит.

Взаимно однозначное соответствие между циклами подста^

новки 22(63) и примитивными идемпотентами кольца SR^a "о*^"

ностью описывается предложением VII и выписано в табл. 4.

Например, 5X38 = 190= 1 (mod 63) (38 = 55(mod 63));

следовательно,

9i • cTg == 9io

соответствует циклу (13, 19, 26, 38, 41, 52).

Теперь необходимо рассмотреть проблему непосредственного

вычисления спектра циклического алфавита.

Для малых алфавитов это может быть выполнено путем

непосредственного просчета без слишком больших затрат

вычислительного времени. На IBM-7090 алфавит с блоковой длиной

765 и 22^ буквами был проанализирован (побуквенно) за

0,32 час. Этот алфавит имеет 745 корректирующих позиций.

Типичной, однако, является задача вычисления спектра алфавита

с 2^^5 словами и 20 корректирующими позициями.

Непосредственный просчет такой задачи требует около миллиона

вычислительных часов. К счастью, имеется способ решения этой

дилеммы.

Пусть а{х) степени т будет множителем х'^—1, и пусть

b{x) = (x^ — \)Ja{x).

Алфавиты % = Шп'а{х) и S=:SR„ •6(а:) называются

дуальными или ортогональными 2). Пусть A{s) и B{s) означают

^) Вполне возможно, что алфавиты, не входящие в этот список, также

имеют такой же спектр и, возможно, эквивалентны первому алфавиту

относительно подстановки, не являющейся автоморфизмом кольца Шп-

2); Это определение дуального алфавита не является обычным

(общепринятым). Обычный дуальный к Ж алфавит эквивалентен S3 и, следовательно,

имеет тот же спектр. Более полно это различие будет объяснено в разд. II.

Таблица 4

Спектры малых алфавитов кольца Шв^

01 + 912 (29 букв)

В(0) =1

В (28) = 189

В (32) = 252

В (36) = 7

В (40) = 63

9i + 9i3 (29 букв)

В{0) =1

В (28) = 252

В (32) = 63

В (36) = 196

в1 + 9з + 911 (29 букв)

В{0) =1

jB (25) = 3

В (26) = 63

В (29) = 126

В (31) = 63

Б (32) = 63

В (34) = 126

В (37) = 63

В (42) = 3

В (63) = 1

9i + 95 (2»2 букв)

5(0) =1

Б (24) = 210

В (28) = 1512

В (32) = 1071

В (36) = 1176

В (40) = 126

2»

20 Дж. Мак-Вильяме

соответственно числа букв веса 5 в алфавитах 91 и 33,

Предположим, что 91 с m корректирующими позициями является

большим алфавитом, спектр которого мы хотим найти; 23

содержит 2^ букв, и его спектр может быть найден непосредственным

вычислением или более тонкими методами. Тогда A{s) может

быть найдено из В{$) следующим образом [3].

Предложение VHI. Величины A{s) и B{s) связаны

выражением

2"^ ^ A{s)z' =^ B{s){\+zf-' {\ —z)\

Опишем теперь методы, которые иногда бывают полезными

при вычислении спектров малых циклических алфавитов.

Пусть а будет буквой циклического алфавита 91, и пусть аТ

является буквой, полученной из а путем -.одной циклической

перестановки вправо. Например, для п = 7 мы должны иметь

а = (0110111), аГ = (1011011), аР = (1101101) и т. д.

Все буквы аР принадлежат 91. Множество (всех)

различных букв аГ^ при фиксированном а назовем циклом в 91;

а является представителем этого цикла; число л (а) различных

букв в цикле называется периодом а или длиной цикла, Зная

длину каждого цикла в 91 и вес одной буквы из каждого

цикла, можно сразу вычислить спектр 91,

Если % и Ъ—дуальные алфавиты и

\+с{х)—идемпотент 9[, то с{х) является идемпотентом 2J. Алфавит Эй^ с идем-

потентом 9г(А:) дуален максимальному алфавиту, порождаемому

неприводимым множителем fi{x). Алфавит 9№г называется

минимальным алфавитом. Алфавит с порождающим множителем

fi{^)'fji^) имеет идемпотент l+Qi{x)+Qj{x), а дуальный ему

алфавит является об1^динением Ш^ и Mj и имеет идемпотент

9г (х) + 0j(х). Процедура состоит в нахождении циклических

представителей для Mi и последующего получения из них

циклических представителей для Ш^ [} Mj, Это делается в

соответствии со следующим предложением.

Предложение IX. Кйждый цикл Tti (за исключением

цикла, содержащего-нулевую букву) имеет длину jc(9t); кроме

того, n{Qi) является показателем ei неприводимого

полинома fi (х).

Например, для д=63 SRj имеет один цикл длины 63. Этот

цикл содержит букву, соответствующую многочлену Qi{x), вес

которого равен 32. Спектр Mi определяется равенствами

Бинарные циклические алфавиты 21

S(0) = 1 и В(32)=63. Спектр максимального алфавита Stgj-fi (а:)

определяется соотношением

63

26 2 Л (5)z' = {\+ zf^+ 63 (1 + zf' (1 — г)32.

5 = 0

Аналогично ЗИ^з имеет один цикл длины 7, который

содержит букву веса 36, соответствующую многочлену 9i2(a:). Спектр

3^12 задается равенствами 5(0) = 1 и В (36) =7, и дуальный

алфавит ^63'fi2(^) имеет спектр A{s), определяемый

соотношением

63

2з2^(5)г" = (1+;г)бз+7(1+г)27(1—г)зб.

Заметим, что равенство

8Л (2) = С1з+ 7 [CIj — 27 . 36 + СУ = 2016

соответствует утверждению предложения II о том, что этот

частный алфавит может содержать буквы веса 2.

Алфавит 9Р?5 содержит три цикла длины 21. Можно

проверить вручную, что Qby Q5+Q5T и Q^ + QbT^ лежат в различных

циклах. Их веса соответственно равны 24, 36 и 36 и спектр Ш^

имеет вид В (0)=1, В (24) =21, В (36) =42.

Эта техника является полезной только тогда, когда 9№;

содержит относительно малое число различных циклов. В

противном случае процесс отыскания циклических представителей

становится чрезвычайно трудоемким ^).

Если циклические представители Ш^ и ЭКу известны, то

можно построить циклические представители алфавита 9№^ U 3№у

(с идемпотентом Qi + Qj) в соответствии со следующим

предложением.

Предложение X. Пусть mi, тг, ..., т^^ являются

циклическими представителями 3№^ периода ei, и пусть пи Пг, ..., п^

являются циклическими представителями 9№у периода е^. Пусть

Huh означают соответственно наименьшее оби^ее кратное и

наибольший обилий делитель ei и ej. Тогда циклическими

представителями Ш^ и 9Иу являются mi, тг, ..., т^, Пи п^^ ..., Лр,

а также nti + njT^ для всех пар (f, /) а v=0, 1, ..., h—1,

причем период nii+njT'^ равен Я.

Например, для д=63 в алфавите Зй^ U 9№i2 имеются один

циклический представитель 6i (периода 63), один циклический

') в работе [8] предложен легко машинизируемый способ отыскания

циклических представителей в 2R^ — Прим, перев^

22 Дж. МаК'Вильямс

представитель 0i2 (периода 7) и семь циклических представителей

9i + ei2p, v = 0, 1, ..., 6, периода 63. Алфавит 2«iU 2)^13

строится аналогичным образом. Спектр алфавита

надо строить путем добавления буквы веса 63,

соответствующей 011, к объединению ЗК^иЗйз (циклические представители:

01, 9з, 01+.03, 01+ 03?"). Спектры этих трех и дуальных им

алфавитов приведены в табл. 4 и 5. Дуальные алфавиты являются

теми тремя неэквивалентными алфавитами с блоковой

длиной 63 и девятью корректирующими позициями, которые надо

было отыскать.

В алфавите 9Wi U SRg имеются следующие циклические

представители: 01 (периода 63), 05, 05 + 05?", 05 + 057"^ (периода 21) и

01+ 05^ 01+(05 + 05Г)Л 01+(05 + 05Р)Л v = 0, 1, ..., 20

(периода 63). Спектры этого алфавита и ему дуального приведены

в табл. 4 и 5. Дуальный алфавит, как и было предсказано,

имеет минимальное расстояние, равное 5.

Дадим теперь итоговое описание процедуры:

1) Выписываем список циклов подстановки 22(az) для

каждого допустимого значения п и проверяем, для каких сумм длин

различных циклов можно получить нужное число

корректирующих позиций. Отбрасываем те значения п, для которых это

невозможно.

2) Вычисляем показатель каждого цикла 22(/t).

Пусть S является множеством циклов пригодных длин.

Находим наименьшее общее кратное показателей циклов из 5.

Отбрасываем те множества 5, для которых это число меньше чем п.

3) Устанавливаем теперь соответствие между циклами из

S и примитивными идемпотентами Шп. Это делается в два

этапа. Выписываем списки неприводимых множителей

многочленов х^—1 и /^ — 1, ei = nlri для всех собственных

делителей Гг числа п. Пусть /о(а:), fi{x), ..., f<_i(A:)—неприводимые

множители х^ — 1. Неприводимые множители х^^ —1 должны

быть среди fi{x). Начиная с наименьшего значения е^ припишем

каждому многочлену fi{x) его показатель путем сравнения

списков. Поставим некоторый многочлен fi{x) с показателем п

в соответствие циклу, начинающемуся с 1, и, используя

предложение IV, найдем полином с показателем е{, соответствующий

циклу, начинающемуся с Г{,

4) Выпишем параллельный список примитивных идемпотен-

тов кольца Шп и перенесем в него циклы в соответствии с

найденным порядком сопоставления. В каждом цикле подстановки

22(/г), содержащем числа, взаимно простые с az, отметим число (/

и найдем результат применения подстановки Oq к множеству

Таблица 5

Спектральные вероятности ^) больших алфавитов кольца fRes

l + 8i + 8i2 (9 корректирующих позиций)

а (0) == 1 = а (63)

а (1) == а (2) = а (3) = О

а (4)== 0,21153 ХЮ"^

а (5) = 0,20973 X 10"^

а (6) = 0,19243 ХЮ-^

а (7)== 0,19571 ХЮ"^

а (8) = 0,19526 X Ю"^

a{s) = a{n — s)

а (s) = 2~^ для других значений 5

^ l + 8i + 8i3 (9 корректирующих позиций)

а{0) =1 = а(63)

а{\) ==а(2) = 0

a(3) =а(4) = 0,15865 ХЮ''^

а (5) =а(6) =0,20077X10"^

а (7) =а(8) =0,19451X10"^

а {9) =а (10) = 0,19544 X Ю'^

а (11) = а (12) = 0,19528 X 10""^

a{s) =а{п — S)

a{s) =2"^ для других значений 5

1+81 + 83 + 811 (9 корректирующих позиций)

аф) =1

а{\) =а(2) = а(3) = 0

а (4) =0,19634X10"^

а (6) =0,19626X10 ^

а (8) = 0,19502 ХЮ'^

а (1) = О для всех нечетных значений /

а (2/) = 2"^ для других значений /

1 + 81 + 85 (12 корректирующих позиций)

а{0) =1 а(63) = 1

а{\) =а{2) =а(3) = а(4) = 0

а (5) =а(6) =0,26889X10 ^

а {7) =а(8) =0,24119X10""'

а (9) = а (10) = 0,24461X10"'

а{П) = а (12) = 0,24404 X Ю"'

а (13) = а (14) = 0,24416 X Ю"'

a{s) =а{п — s)

_.. a{s) =2"^^ для других значений 5

') Спектральные вероятности а (s) определяются как A{s)/C^; числа A{s) часто бьиаю!

слишком большими для вычислительных устройств.

24 Дж. МаК'Вильямс

примитивных идемпотентов. Используя предложение VII,

установим полное соответствие между циклами и примитивными

идемпотентами.

5) Пусть 5i, 52, ..., 5у будут циклами допустимого

множества S, fi{x), f2{x)y ..., /v(a:)—соответствующими

неприводимыми множителями многочлена х'^—1 h9i(a:), ЭгСл:),..., 9v(a:) —

соответствующими примитивными идемпотентами. Тогда

искомый алфавит порождается множителем f{x)=fi{x)'f2{x) ...

... fvW- Порождающий идемпотент ортогонального алфавита

равен

Q{x) = Q,{x) + Q,{x)+ ... +%{х).

По результатам действия автоморфизма Oq на идемпотент 9 (л:)

разделим допустимые алфавиты на автоморфные классы.

Алфавиты из одного и того же автоморфного класса имеют

одинаковые спектры.

6) Часто ортогональный алфавит Шп*в{х) намного меньше,

чем исходный алфавит Шп*!{х). В этом случае лучше

вычислять спектр Шп'д{х) и затем получать спектр 9t„'f{x) на

основе предложения VIII. Если 9(л:) является суммой двух или

трех примитивных идемпотентов, то его спектр может быть

построен способом, описанным в предложении X. Короче говоря,

алфавит может строиться с помощью векторов,

соответствующих полиномам 6(а:), xQ(x), ..., x'^Q(x) [m —степень f{x)], а

его спектр вычисляется.

II. ДОКАЗАТЕЛЬСТВА

В этом разделе мы даем доказательство предложений разд. I.

Пусть V — бинарное поле, а V'^ — множество всех возможных

строк из п бинарных символов; У^ есть п-мерное векторное

пространство над У, и пусть Шп будет, как и ранее, множеством

полиномов, взятых по модулю х'^ — 1 над V. Ш„ является

коммутативным кольцом.

Между V'^ и Шп можно установить следующее взаимно

однозначное соответствие

ao+aiA:+ ... +a„^iA:'^-i :^ ао, а^, ..., a^^j.

Это соответствие, очевидно, инвариантно относительно

сложений ив ШпИ в V^,

Подмножество 31 полиномов из Ш^ называется идеалом,

если

(i) gug2^^^gi+g2e'!l\

(ii) g^%=^rg^ 21 для любого r(:9tn.

Бинарные циклические алфавиты 25

Согласно свойству (i), идеал в Ш^п соответствует линейному

подпространству в У^. Согласно свойству (ii), при г==х это

подпространство инвариантно относительно циклического сдвига

координат и, следовательно, является циклическим алфавитом

в V". Наоборот, всякий циклический алфавит в V^^' является

идеалом в Шп. Как идеал, так и алфавит мы будем обозначать

одной и той же буквой 21.

Лемма 2.0. Идеал 91 кольца Шп состоит из всех кратных

{в Шп) некоторого полинома а{х), который делит л:^ —П).

Полином а{х) является единственным полиномом наименьшей

степени в %.

Доказательство этой леммы можно найти в

монографии Питерсона ([4], разд. 6.4).

Полином а{х) будет называться порождаюи{им

множителем 9t. Полином Ь(х) = {х^—1)1 а{х) будет называться

взаимным (обратным) множителем 91. Это предположение всюду

в дальнейшем выполняется: идеал, обозначаемый через 91, имеет

порождающий множитель, обозначаемый через а{х), и

взаимный множитель, обозначаемый через Ь{х). Степень а{х) будет

обозначаться через т, а степень Ь{х)—через k, так что,

конечно, m + k = n.

Лемма 2.1. Размерность % как векторного пространства

в У" равна k, а число корректирующих позиций алфавита 91

равно т.

Для доказательства см. теорему 6.11 работы [4].

Число различных алфавитов в Шп равно числу различных

делителей многочлена х'^—1, а размерность алфавита 91 равна

степени взаимного множителя. Однако, если п — нечетное число

(а это мы всюду предполагаем), можно определить допустимые

размерности при блоковой длине п, не решая существенно

более сложную задачу нахождения множителей х'^—1.

Пусть (О принимает в качестве своих значений одно из

чисел О, 1, ..., Az—1. Обозначим через 22(az) отображение

(о->2о) (modn). В силу нечетности п Ii^in) является

подстановкой чисел О, 1, ..., п— 1.

Подстановка I^zin) на числах О, 1, ..., п—1 распадается

на циклы (циклы Ег (63) приведены в табл. 1). Нахождение

этих циклов является достаточно простым делом.

') а(х) делит х^ — 1 в кольце V[x] всех полиномов над V. Говорить, что

что-то делит д:" — 1 в di^t бессмысленно.

26 Дж. МаК'Вильямс

Соотношение между этими циклами и множителями

многочлена х'^ — 1 над V является хорошо известной частью теории

Галуа. Здесь оно детально описывается только в силу трудности

отыскания четкой справки.

Лемма 2.2. Пусть S будет подмножеством чисел О, 1, ...

..., п—1. S инвариантно относительно 22{п) тогда и только

тогда, когда оно является объединением циклов подстановки 22 (п).

Доказательство. Если S является таким объединением,

то оно инвариантно относительно 22(п), поскольку каждый

частный цикл инвариантен.

Предположим, что S инвариантно относительно 22 (п) и г

принадлежит S. Тогда для любого значения v число 2^ • г также

принадлежит S. Множество S содержит вместе с г все циклы,

содержащие г. Таким образом, S является объединением циклов

подстановки 22(п).

Лемма 2.3. Пусть S инвариантно относительно 22 (^), ti

пусть Sx — множество всех сумм вида r^-\-rs^-\- ... +^^^,

^5,6*5» ГзгФ rs.. Тогда S^ инвариантно относительно 22(п).

Доказательство. Нам необходимо показать только, что

22(п) отображает Sx в себя; тогда отображение должно быть

взаимно однозначным. Пустьг^^+ ^53+ ••• +^5^€^т, Гз^фГз:,

применяя 22(п), мы получаем число 2rs^'\-2rs^-\- ... +2г^^,

которое опять принадлежит S^. Следовательно, лемма доказана.

Пусть (l, 2, 2^ ..., 2"^'~^) будет циклом 22(п),

содержащим 1. 2^"*^ 1 (mod/г) или п делится на 2"^'—1. Положим

N==2^'—1. Каждый корень степени п из единицы является

также корнем степени Л^ из единицы. Пусть У(2^0 будет полем

Галуа корней степени Л^ из единицы над исходным полем V.

Многочлен х^ — 1 распадается над V{2^') на линейные

множители вида X — ^^ где ^ — первообразный корень степени п из

единицы, (g не является первообразным корнем Л^-й степени из

единицы, за исключением случая N = n.)

Автоморфизмы V(2^') над V описываются отображением

а~>а2 и его степенями, rjxea^V (2'"')'» кроме того, а=а2 тогда

и только тогда, когда a^V [5].

Явная связь между циклами 22 (п) и' множителями х^^-1

состоит в следующем.

Бинарные циклические алфавиты 27

Лемма 2.4»). Пусть S = {ri, гг, ..., Гш} будет множеством

всех чисел, инвариантных относительно Ъг[п), причем Г1ФГу

Полином f (а^) = II (^ — S'^O является множителем полинома

i

х^ — 1 над V, и его коэффициенты лежат в У.

Пусть f {х) == (х — С'О {х — t!') ..,{х — 1'гп) будет

разложением над V(2'"') полинома f{x), который делит х^—1 над V.

Множество {ги г^, ..., r^i} инвариантно относительно 22(д).

Доказательство. Пусть S = {ri, Г2, ..., г^} будет

множеством различных чисел, инвариантных относительно Е2(д).

(x) = (jc —S^i)(jc —S^2)...(^ —СЧ делит х^-1 над1/(2'"0»

так как каждый линейный множитель делит х'^ — 1 и Г1Фг^,

Пусть а„_^ будет коэффициентом при х'^-'^ в полиноме f{x),

an-t является г-й симметрической функцией от ^^, ^^, ..., С'''^,

или

Согласно лемме 2.3,

2г.+2г^ + ... +2rs

{а.-гУ= S С'^"^^-^'''^ = а„

■f

Таким образом, коэффициенты полинома \{х) лежат в 1/, и

f (л:) делит л:^ — 1 над У.

Предположим, что \[х) делит л:^ —1 над У. Нулями f{x)

в 1/(2^*) являются S'^S S'^^ ..., ^Х где g —первообразный ко^

рень степени п из единицы, а ri, Г2, ..., Гт — числа по модулю п.

Так как в соответствии с леммой 2.3 все симметрические

функции от 1^\ ^^у ..., ^^ лежат в У, то f{x) инвариантен

относительно преобразования ^--►С^, и, следовательно, это

преобразование приводит к перестановке нулей f{x). Таким образом,

множество ги ^2, ..., ^т инвариантно относительно S2(ai).

Наименьшие множества, инвариантные относительно Ъг{п),

называются индивидуальными циклами E2(ai).

В соответствии с изложенным каждый такой цикл

определяется нулями неприводимого множителя многочлена х'^—1, и

каждый неприводимый множитель [(л:) соответствует циклу

S2(n).

*) Напомним, что мы работаем в V{x\ а не в Ып.

28 Дж. Мак-Вильямс

Доказательство предложения I

Число циклов подстановки 22(ai) равно /, и в соответствии

с вышесказанным t является также числом неприводимых

множителей а:^—1. Эти неприводимые множители все различны

((л:^— 1) в случае нечетного п не имеет кратных корней над V)

и могут быть скомбинированы умножением в 2' различных

множителей полинома л:^ — 1. Кроме того, таким способом

получаются все возможные множители л:^ — 1. Следовательно, всего

существует 2* циклических алфавитов с блоковой длиной п.

Пусть a{x)=fi{x) fz{x) .'., f^{x) будет порождающим

множителем циклического алфавита 91. Пусть т^ будет степенью

многочлена fi{x); Шг является длиной цикла подстановки ЕгС^),

соответствующего многочлену fi{x). Согласно лемме 2.1, число

V

корректирующих позиций алфавита 91 равно m=^mi.

Показатель полинома а(х) определяется как наименьшее

число е, такое, что а{х) делит х^— 1. Пусть

а{х) = {х-1Щх -t'2),,,{x-tH

где ^ — первообразный корень степени п из единицы и

{ги ^2, ..., Гш} является множеством циклов подстановки 22(^г).

Тогда показатель а{х) равен такому наименьшему значению е,

что

($''0^=1, или ert^l (mod/г), /=1,.2, ..., т.

е = п1а, где а — наибольший общий делитель чисел Ги г^, ./.

..., г^ и п.

Если а{х)—неприводимый множитель л:^ —1 [ги Гг, ..., Гт

образуют индивидуальный цикл подстановки S2(n)], величина а

является наибольшим делителем п, делящим каждый член

цикла {г1, Г2, ..., Тггх^' Величина е = п1а называется показателем

цикла, так же как и показателем полинома а{х).

Показатель объединения циклов или показатель

произведения полиномов равен наименьшему общему кратному их

индивидуальных показателей.

Доказательство предложения 11

Идеал 91 с порождающим множителем а{х) содержит

многочлен х^—1 (=д:^+1), где е — показатель а{х). Если ^ = п,

этот полином является нулевым в 91; если е<п, то он

соответствует букве веса 2 в алфавите 91.

Если 91 содержит букву веса 2, то идеал % содержит (при

соответствующей циклической подстановке) полином л:^ — I

{е<п), делящийся на а{х). Тогда показатель а{х) меньше чем п.

Бинарные циклические алфавиты 29

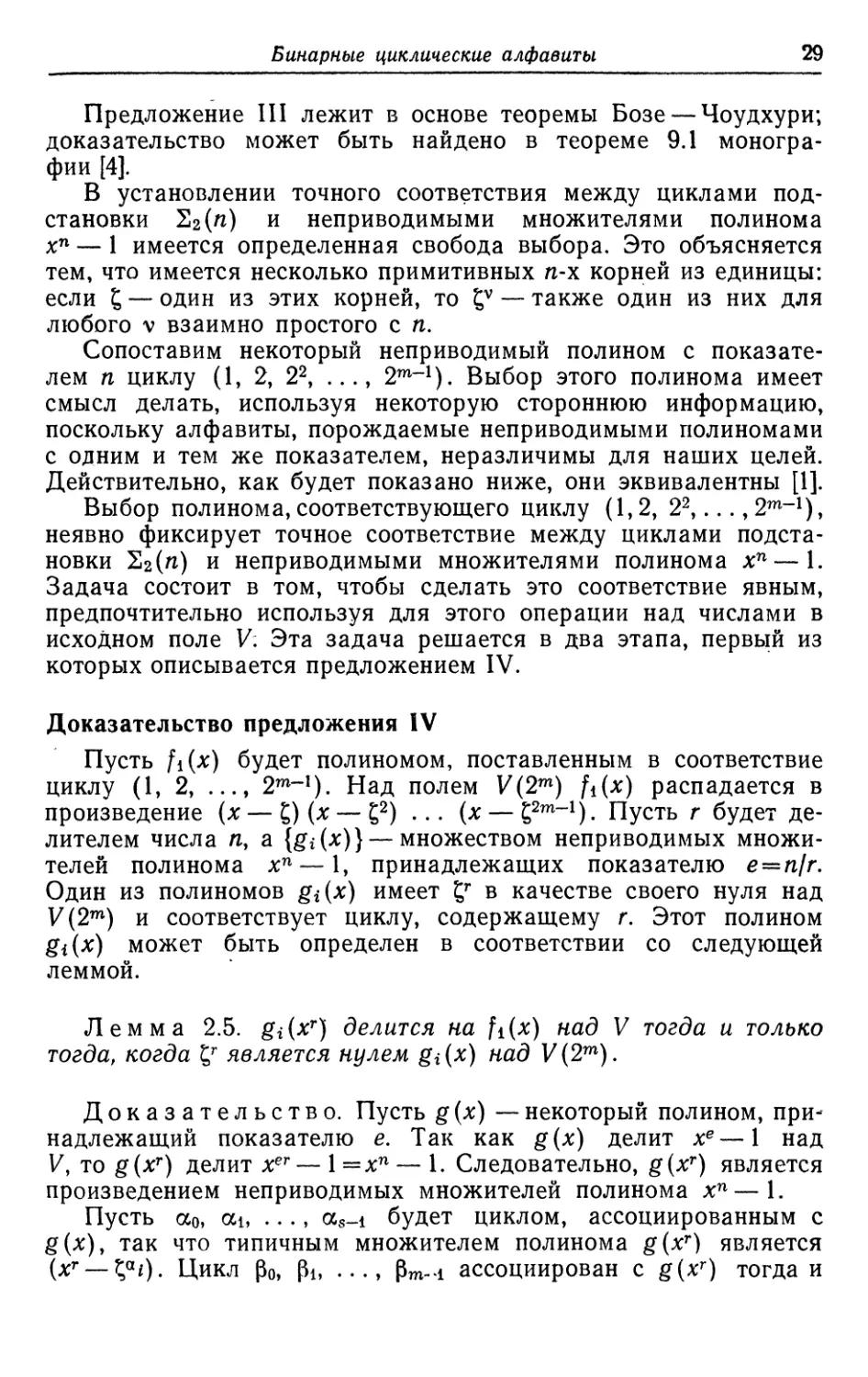

Предложение III лежит в основе теоремы Бозе — Чоудхури;

доказательство может быть найдено в теореме 9.1

монографии [4].

В установлении точного соответствия между циклами

подстановки 22(п) и неприводимыми множителями полинома

хп — 1 имеется определенная свобода выбора. Это объясняется

тем, что имеется несколько примитивных п-х корней из единицы:

если ^ — один из этих корней, то Z^ — также один из них для

любого V взаимно простого с п.

Сопоставим некоторый неприводимый полином с

показателем п циклу (1, 2, 22, ..., 2^-^). Выбор этого полинома имеет

смысл делать, используя некоторую стороннюю информацию,

поскольку алфавиты, порождаемые неприводимыми полиномами

с одним и тем же показателем, неразличимы для наших целей.

Действительно, как будет показано ниже, они эквивалентны [1].

Выбор полинома,соответствующего циклу (1,2, 2^...,2^-i),

неявно фиксирует точное соответствие между циклами

подстановки ЕгС^г) и неприводимыми множителями полинома л:^—1.

Задача состоит в том, чтобы сделать это соответствие явным,

предпочтительно используя для этого операции над числами в

исходном поле V: Эта задача решается в два этапа, первый из

которых описывается предложением IV.

Доказательство предложения IV

Пусть fi{x) будет полиномом, поставленным в соответствие

циклу (1, 2, ..., 2^-^). Над полем V(2^) fi(x) распадается в

произведение {х — t,) (х — g^) ... (л: — gsm-ij Пусть г будет

делителем числа п, а {gi(л:)} —множеством неприводимых

множителей полинома л:^ — 1, принадлежащих показателю е = п1г.

Один из полиномов gi{x) имеет ^^ в качестве своего нуля над

У (2^) и соответствует циклу, содержащему г. Этот полином

gi{x) может быть определен в соответствии со следующей

леммой.

Лемма 2.5. gi(x^) делится на fi{x) над V тогда и только

тогда, когда ^^ является нулем gi{x) над 1/(2^).

Доказательство. Пусть g{х) — некоторый полином,

принадлежащий показателю е. Так как g{x) делит х^—1 над

I/, то g{x^) делит а:^^— 1=х^ — 1. Следовательно, g{x^) является

произведением неприводимых множителей полинома х^—1.

Пусть ао, ai, ..., «s-i будет циклом, ассоциированным с

g{x), так что типичным множителем полинома g{x^) является

(л:^ —^«0. Цикл ро, Pi, ..., Pm-i ассоциирован с g(A;^) тогда и

30 Дж. Мак-Вильямс

только тогда, когда rPj = cLt[{^y = t,^^] при соответствующем

выборе /, /.

Предположим теперь, что gi{x'') делится над V на /i(a:).

Тогда цикл (1, 2, ..., 2^-^) ассоциирован с giix"") и ^^ = ^"^ для

некоторого L Следовательно, ^^ является нулем полинома g^(л:).

Предположим затем, что ^^ является нулем полинома gi{x).

Тогда с gi{x) ассоциирован цикл (г, 2г, ..., 2«-V). 0*!евидно,

что (1, 2, ..., 2^-1) является циклом, ассоциированным с

giix''), nfiix) лелит giix"-).

Необходимо отметить, что в доказательстве этой теоремы

дается способ нахождения множителей полинома g{x^),

который является полезным и для других приложений.

Автоморфизмы и идемпотенты кольца Ш^^

Пусть q — число, взаимно простое с д, и пусть Од —

отображение кольца Шп в себя, определяемое соотношением

h{x) -^h{x^), где показатель степени редуцируется по

модулю п. Ясно, что соответствие Oq сохраняет в Шп операции

сложения и умножения и является взаимно однозначным, так как^/

взаимно просто с п; из л:'^ =^^^ следует, что iq^q (modAi),

откуда в свою очередь следует, что i^ (modn), Oq является

автоморфизмом кольца 91^, и 51 огд опять является идеалом.

В пространстве 1/^ ог^ приводит к перестановке номеров

координат, описываемой соотношением (iy-^q(i>{niodn) [22(^1)

является частным случаем огг]. Таким образом, Gq переводит

алфавиты в 1/^ в эквивалентные алфавиты, и в частности циклические

алфавиты в эквивалентные циклические алфавиты.

Автоморфизмы Gq ЯВЛЯЮТСЯ полезным аппаратом

исследования, поскольку их действие на идеалы кольца Шп вычисляется

легко.

Лемма 2.6^). Каждый идеал ^кольца Шп содержит

единственный полином с{х) со следующими свойствами:

(i) c{x)=[c{x)f, с{х) является идемпотентом-,

(ii) % = Шп-с{х), с{х) порождаете;

(iii) с{х) является единицей в 51;

(iv) с{х) * Gq является идемпотентом 31а^.

Доказательство. Пусть а{х) и b{х) будут

соответственно порождающим и взаимным множителями 51. Так как

п — нечетное число, то они взаимно просты. Следовательно,

^)) Другими словами, Шп является коммутативным полупростым кольцом.

Оно является, конечнр, и групповой алгеброй циклической группы ^порядка п

над 1^; из нечетности п вытекает, что алгебра является полупростой [6].

Бинарные циклические алфавиты 31

существуют такие полиномы hi{x) и h2{x), что a(x)hi{x) +]

+ b{x)h2{x) = l и hi{x), h2{x) взаимно просты соответственно

с Ь{х) и а{х). Покажем, что полином с{х) =hi{x)a{x) является

идемпотентом идеала 91.

(О [c{x)Y + c{x)h2{x)b{x)=c{x). Второе слагаемое в левой

части этого равенства равно нулю, так как содержит множитель

х^ — 1. Следовательно, с{х) —идемпотент.

(ii) Порождающий множитель идеала Шп*с{х) является

наибольшим общим множителем полиномов с{х) и (л:^—1).

В соответствии с построением с{х) он равен а{х).

Следовательно, Ot„ • с(х)= %.

(iii) Если а{х)^%, то, согласно (ii), а{х) =а'(х) - с{х).

Тогда в соответствии с (i) а{х) * с{х) =а'{x)[c{x)f = a'{x) X

Хс{х)==а{х). Следовательно, с{х) является единицей идеала 91,

причем с{х) является единственной единицей, так как

коммутативное кольцо 91 не может содержать двух единиц.

(iv) c{x)aq является единственным идемпотентом идеала

Ш„ • с{х) Од == 9[а^, поскольку Oq — автоморфизм кольца 3?„.

Теперь с каждым идеалом 9[ мы свяжем полином с{х),

порождающий идемпотент 91.

С л е дств ие 2.7. 91а^ = 91 тогда и только тогда, когда

с{х)од = с{х).

Следствие 2.8. Stag =91 для каждого идеала % кольца

Ш„; эквивалентно, каждый циклический алфавит в V^

инвариантен относительно перестановки ЕгС^г).

Два вектора (ао, ai, ..., an-i) и (Ро, Рь •.., Pn-i)

называются ортогональными, если

2а^-Р/ = 0 (умножение и сложение в поле V).

/«о

Ортогональное дополнение (дуальный алфавит) 91-^ к 91 со^

стоит из тех векторов в V'^, которые ортогональны к каждому

вектору в 2t. Для наших целей удобнее говорить, что

циклические алфавиты 91 и 23 ортогональны, если 23 порождается по-*

линомом b {х) = {х'^ — 1) /а (л:). Это вытекает из следующей

леммы.

Лемма 2.9. 91-'^ эквивалентен идеалу, порожденному

полиномом Ь{х), и может быть получен из него отображением

Хт:>Х''К

Доказательство этой леммы можно найти в монографии Пи-*

Херсона ([4], 6.12),

32 Дж. МаК'Вильямс

Лемма 2.10. Еели с{х)—идемпотент идеала % то 1+с{хЩ

является идемпотентом идеала 2} = 9i^ • b{x). |

Доказательство. Согласно лемме 2.6, идемпотент идеа|

ла 95 равен |

h2{x) й (х) = 1 + Ai (х) а (л:) == 1 + с{ху \

Так как мы условились называть 21 и 93 ортогональными]

идеалами, то мы можем также называть с{х) и 1+с{х) opToroil

нальными идемпотентами. Это естественно, поскольку, согласн(?{

давно установившимся традициям, в теории алгебр два идем-;

потента называются ортогональными, если их произведение;

равно нулю [6]. [с{х){1+'с{х))^с{х)+с{х)=0.] Мы примем эта

соглашение. Необходимо отметить, что ортогональность идеален*

совсем не то же самое, что ортогональность идемпотентов,

Идемпотенты Ci{x) и С2{х) ортогональны, если Ci{x) -С2{х) =0,

Идеалы, порождаемые этими идемпотентами, не ортогональны,

за исключением случая, когда к тому же Ci{x) +С2{х) = 1.

Лемма 2.11. (i) Полином Ci{х) • Сг{х) является

идемпотентом идеала %{]%2' {^'^)' Полином Ci{x)+C2{x)+Ci{x) * С2{х)

является идемпотентом идеала 5liU %-

Доказательство.

(i) %i [] % порождается наименьшим общим кратным а(х)

полиномов ai(л:) и а2{х). Поэтому а{х) является наибольшим

общим множителем полиномов Ci{x) * С2{х) и х'^ — 1.

Следовательно, полином Ci{x)'C2{x) является идемпотентом идеала

9tn*a{x),

(ii) Положим d{x)=Ci{x)+C2{x)+Ci(x)C2{x). Тогда-

Ci{x)d{x)=Ci{x) и C2{x)d{x)=C2{x). Таким образом, d{x)

является идемпотентом, и идеал Э^п • ^(а:) содержит 5li и Щ.

Пусть 91 —некоторый идеал, содержащий % и 512, и Г1усть

с{х)—идемпотент 91. Так как с{х) является единицей в 91, то

Ci{x)c{x)=Ci{x), t=l, 2. То£да d{x) 'c{x)=d{x) и ^n-d{x)

содержится в каждом идеале 91. Следовательно, Ш^ • d{x) = %i[i %.

Идеал кольца называется минимальным, если он не

содержит никаких подидеалов, кроме (0). Минимальный идеал в Щ2

будет обозначаться через $W/, его порождающий множитель —

через mi{x), его взаимный множитель — через /г(-^) и его

порождающий идемпотент — через Qi{x), Идемпотент

минимального идеала называется примитивным идемпотентом.

Лемма 2.12.

(i) Tli является минимальным идеалом тогда и только тогда,

когда fi{x) является неприводимым множителем полинома

x'^—L

Бинарные циклические алфавиты 33

(И) Wftif\Ttj = Oy если 1Ф]'; размерность 9№;U3№y равна

сумме размерностей Щ а Зйу.

(iii) Любой идеал % является объединением минимальных

идеалов, входящих в % В частности, Шп является объединением

всех его минимальных идеалов.

Доказательство.

(i) Следует из леммы 2.1, так как размерность

минимального идеала по возможности минимальна.

(ii) Порождающий множитель идеала, ортогонального к

Щ(]^j, является наибольшим общим множителем полиномов

fi{x) и fj{x), который равен 1. Следовательно, ЯК^пЗйу

эквивалентно Шй" и равно 0. Вторая часть утверждения немедленно

вытекает из первой.

(iii) Пусть Ь(х) будет взаимным множителем идеала Щ, и

пусть b{x)=^fi{x) *f2{x) ,,,fy^(x), где (в силу нечетности п)

fi{x)—различные неприводимые множители многочлена х^—1.

Идеал 51 содержит полиномы (х^—l)lfi(x) и, следовательно,

содержит минимальные идеалы Ш^ i=l, 2, ..., v, а также их

объединение Ш^ЦЩИ ••• U9№^- Согласно (ii), размерность

этого объединения равна сумме степеней полиномов fi(x),

f2{x)y ..., fvix), котор|ая в соответствии с леммой 2.1 является

размерностью 21. Таким образом, 21 = 9№i и ЗИз и ••• уЗИ^-

Заметим, что эта теорема не верна для четных п,^

Пусть 9о, 9i, ..., Qt-i будет множеством примитивных идем-

потентов кольца SR^.

Следствие 2.13.

(i) е^-е, = 0, i¥=/.

(ii) Каждый идемпотент в 9tn может быть представлен в

форме

еде e>i принадлежат V. В частности,

Доказательство.

(i) Следует из лемм 2.12(ii) и 2.1 l(i).

(ii) Так как любой идеал в Шп является объединением

минимальных идеалов, то любой идемпотент может быть получен

из 6г повторным применением утверждения (ii) леммы 2.11.

34 Дж. МаК'Вильямс

Произведения членов исчезают согласно свойству (i) данного,

следствия. В частности,

9?„.l = SR„.(Se,).

Лемма 2.14 ^). Если \Xi и \Х2 принадлежат минимальному^

идеалу 2№ и iuii'iui2==0, то либо \i\ = 0, либо |i2 = 0.

Доказательство. Предположим, что iui2=?^0. Рассмотрим

множество Л элементов т из 2№, таких, что m«jji2=0. Если

^1, /ПгёЛ, то mi + m2€A; если тбЛ и im^St^, то mji^A.

Следовательно, Л является подидеалом в 5Ш и в силу

минимальности Ш либо равно нулю, либо совпадает со всем Ш. Пусть Q

будет идемпотентом в 9И. Тогда 0iui2 = iui2=7^O. Следовательно,

06 Л и АФЖ Таким образом, имеем Л=0 и, следовательно,

[11 = 0.

Ясно, что очень важно найти явные формы для примитивных

идемпотентов 9г(А:). Действительно, если эта задача трудна, то

все предыдущие теоретические результаты имеют малую прак*

тическую ценность. Однако эта задача легко разрешима и, в

частности, выполнена для всех нечетных значений п вплоть до

1023. Метод, который при этом использовался, принадлежит

Прэнджу [7] и описывается ниже.

Пусть г={г1, Г2, ...,- Гт} — ЦИКЛ подстановки S2(n), и пусть

х\г означает полином х^^-\-х^^-{- ... -\-х^гп. Полином Цг является

идемпотентом, так как возведение его в квадрат является

простой перестановкой степеней х.

Лемма 2.14. Полином

п-1

является идемпотентом тогда и только тогда, когда он может

быть записан как сумма полиномов г|г.

Доказательство. Ясно, что любая сумма полиномов Цг

является идемпотентом. «Необходимая» часть леммы следует

из леммы 2.2.

Лемма 2.15. Число примитивных идемпотентов кольца 91^

равно числу циклов подстановки SaC^)-

^) Можно также сделать ссылку на хорошо известную теорему [4, 5]

о том, что минимальный идеал Ш изоморфен полю Галуа V[y]/f{yl4

Бинарные циклические алфавиты 35

Доказательство. Пусть 5 будет числом примитивных

идемпотентов. Согласно. 2.12(iiii), число идеалов в йп равно 2^.

Следовательно, 5 является также числом циклов подстановки

Любой идемпотент может быть представлен как линейная

комбинация полиномов г\г (которые находятся легко) или как

линейная комбинация примитивных идемпотентов 0j. Идемпо-

тенты 9у обладают дополнительным свойством взаимной

ортогональности. Каждый т]г, в частности, является суммой

подмножества 0j. Задача состоит в расщеплении г\г на его компоненты.

Будем считать, что S и Т — непустые множества индексов

О, 1, ... S ^— 1, причем 8ФТ. Тогда

Произведение двух идемпотентов будет содержать меньше

примитивных идемпотентов, чем каждый множитель.

Пусть / будет числом примитивных идемпотентов. Тогда

/^1 t-i

1= 2вуг и если 1= Ц^у,

где Ij — ортогональные идемпотенты, то gj с точностью до

порядка нумерации те же, что и 0j. Мы используем этот факт для

установления следующего алгоритма.

Предположим, что имеются некоторым образом

расположенные от 1 до т<^ взаимно ортогональные идемпотенты,

1= 2Ь ^/ = ^/. li'lj=0, 1ф;\

Пусть g — идемпотент; положим

lj = ljl + lj{l+l) = ln + lj2^ У = 0, 1, ..., t-1.

gji и gj2 являются идемпотентами, причем эти новые

идемпотенты взаимно ортогональны. Если расщепление является

действительным (может случиться, что lj = l или gj=l+X и тогда

расщепление не произойдет), то результат приводит к

расположению более чем т взаимно ортогональных идемпотентов.

В начале алгоритма мы положим 1=t]i+(l+iii), а

остальные 'i]j зарезервируем в качестве подходящих кандидатов в g.

Вычисление закончится тогда, когда в разложение будут вхо-*

дить t компонент. Так как т]г являются также и базисом для

Шд, то эта процедура будет длиться до тех пор, пока не исчер*

паются все Цг-

36 Дж. Мак-Вильяме

Примитивный идемпотент Qi{x) является порождающим

идемпотентом минимального идеала Шi\ ортогональный

идемпотент \+Qi{x) является порождающим идемпотентом

максимального идеала ^г\ порождающий множитель fi{x) идеала Ф/

является неприводимым множителем многочлена х'^—1 и

наибольшим общим множителем полиномов \+^г{^) и л:"—1.

Таким образом, мы можем составить параллельные списки

примитивных идемпотентов и неприводимых множителей полинома

х'^ — 1, имеющие отношение к разд. I.

Вернемся теперь к автоморфизмам Oq кольца Шп.

Множество автоморфизмов Oq является абелевой группой

относительно операции умножения ог^, • Oq^ == Oq^q^,

определяемой обычным образом. Она изоморфна (мультипликативной)

группе чисел по модулю п, взаимно простых с п. Так как огг и

его степени не изменяют идемпотентов кольца SRn, то в

соответствии с нашими целями мы можем вынести эту подгруппу

за скобки. Практически мы выбираем одно q из каждого цикла

22 (п), содержащего числа, взаимно простые с п. Эти q (и

соответственно Oq) образуют значительно меньшую абелеву

группу, структура которой может быть найдена «вручную» так, как

это проиллюстрировано для п = 63. Имеет смысл найти

множество порождающих для этой группы. Тогда можно будет

просчитывать только результат воздействия порождающих на

множество примитивных идемпотентов кольца SR^, поскольку это дает

возможность легко просчитать результат воздействия любого

автоморфизма на любой идеал. Таким образом, предложение VI

доказано.

Доказательство предложения VII

Пусть fi{x) будет неприводимым множителем полинома

х'^—1, ассоциированным с циклом (1, 2, ..., 2^-^). Пусть v —

число, взаимно простое с п, и мы хотим определить полином

fr(A^), ассоциированный с циклом (t;, 2у, ..., 2^-^t;). Так как v

взаимно просто с п, то имеются два цикла с одинаковой длиной.

Полином fi{x) является наибольшим общим множителем

полиномов l-f-9i(A:) и {х'^—1). Таким образом, полином 1г1^01(лс)

делится на ПОЛИНОМ (л: — ?) (л: — ^2) ... [х — С )• Пусть w —та*

кое взаимно простое с п число, что uv^{{moAn). Тогда

[1 + 01 {х)] ог„ = 1 + 9i {^"') делится на

который в свою очередь делится на

{x-t:){x-e)...{x-i'"''').

Бинарные циклические алфавиты 37

Таким образом, fr{x) делится на [l+9i(A:)]oru над 1/(2^), и

так как коэффициенты обоих полиномов лежат в I/, то fr(x)

делится на [l+,9i(A:)]oru и над V. Следовательно, fr{x) является

наибольшим обш;им множителем полиномов [1+9i(A:)]oru и

(x^'—l).

Спектр циклических алфавитов

Пусть а{х) и Ь(х) будут соответственно порождающим и

взаимным множителями идеала 21 в 9t„. Пусть Ь{х)

принадлежит показателю е, где п = еа, а>1. Пусть 21'будет идеалом в

Ше^) со взаимным полиномом Ь{х).

Лемма 2Л6. Каждая буква из % состоит из а повторений

буквы из 21'.

Доказательство. Пусть а'{х) = (х^—l)lb{x) будет

порождающим полиномом 21'. Тогда

а-1

Пусть Г {х) а' (х) = 2 ^i^^ (умножение в SR^) будет буквой %'.

В соответствии с умножением в SR„ 21 содержит

Следовательно, каждая буква из 21' может быть продолжена до

буквы из 21, которая состоит из а повторений исходной буквы

из 21'. Очевидно, что различные буквы из 21' приводят к раз^

личным буквам из 21. Так как размерности 21 и 21' обе равны

степени Ь{х), то таким способом получается весь идеал %.

Следствие 2.17. Пусть спектр 21' равен A'{i), i = 0,

1, ..., е. Спектр 21 задается равенствами A{ai)=A^(i),

i = 0, 1, ..., ^.

Например, пусть п=15 и Ь{х)=^1+х+х^. Полином Ь(х)

принадлежит показателю 3

^'W = -T7^=l + -^*» а{х) = {\+х^-^х^+х'+х^^){1+х).

О Ше —КОЛЬЦО полиномов по модулю (х^—1).

38 Дж. Мак-Вильямс

Ниже приведена таблица идеалов 21 и 21':

0 12 0 12 3 4 5 6 7 8 9 10 11 12 13 14

0 0 0

1 1 0

0 1 1

1 0 1

0 0 0

I 1 0

0 1 1

1 0 1

0 0 0

1 1 0

0 1 1

1 0 1

0 0 0

1 1 0

0 1 1

1 0 1

0

1

0

1

0

1

I

0

0

0

1

1

0

1

0

1

0

1

1

0

0

0

1

1

Пусть Т обозначает циклическую перестановку (о->(о +

+ l(modn) чисел О, 1, ..., п—1. Т будет также обозначать

отображение h{x) ->xh{x) (степень по модулю п) кольца Ш^

в себя. Ясно, что Т'^ является тождественным отображением.

Если а 6 21, то полиномы (или векторы) аГ, аР, ..., аГ^-^

также принадлежат 21. Буквы из 21 разбиваются на некоторое

число непересекающихся циклов, и для построения 21

достаточно знать по одной букве из каждого цикла. В

действительности построение всей картины идеала 21 таким способом редко

оказывается полезным. Мы ограничимся нахождением

спектра 21.

Множество а, аГ, ..., аТ'^~^ не всегда содержит п

различных букв. Обозначим через я (а) число различных букв в этом

множестве; я (а) называется периодом а. Множество

а, аГ, ..., аГ^^«^-'

является полным циклом в 21, и длина этого цикла равна я (а).

Пусть г{х) 6 9tn, пусть а(х) —наибольший общий множитель

полиномов г{х) и (л:^—1), и пусть Ь{х) = {х'^—1)1а{х).

Лемма 2.18. Период г(х) равен показателю, которому

принадлежит b {х).

Доказательство. Предположим, что Ь{х) принадлежит

показателю е, и положим а^{х)=={х^—1)/6(а:), r{x)=^h{x)' а{х),

где h{x) взаимно прост с х'^ — Х. Тогда г{х){х^—1) =

= /г (л:) • а (х) • 6 (л:) • а' (л:) = /г (л:) • а' {х) (л:^ — 1) = 0. Следователь-

но, л:^ • г (л:) = г (л:), и период г [х) •< е.

Предположим, что период г{х) равен е\ Тогда е'^п и

г{х) {х^'— 1) =0. В V[x\ h{x) -aix) {х''—\) =i{x) {х^^ — 1) =

= i{x) -а{х) -b{x), где i(л:)—полином в УМ. Полиномы Ь(х)

и h{x) взаимно просты, так как Ь{х) является множителем

х'^ — 1. Таким образом, Ь(х) делит х^' — 1 и е'^е.

Доказательство предложения IX

Пусть я(6г) является периодом 9^, а я(т)—периодом

m 6 9in • вг. Тогда тх^ ^^ = т^^х^ ^'^ = т6^ = т. Следовательно,

Бинарные циклические алфавиты 39

K{m)<n{Qi), Также 0=т(х'^'^)+1) =mQi{x^(^)+l) ==

= т6гЭг(А:^^^+1). Согласно лемме 2.13, так как тЭг^О, мы

должны иметь 9^(а:=^(^)+1) =0. Таким образом, я(6г) <д(т), так

что я(Эг)=я;(т). Согласно 2.18, я{Эг) является показателем

неприводимого полинома fi{x).

Если п = 2^—1, то неприводимый полином /(л:), принадле^

жащий показателю п, имеет степень т и, если не считать

нулевого цикла, минимальный идеал периода п состоит только из

одного цикла. Максимальный идеал с порождающим

множителем f{x) является кодом Хэмминга (плотноупакованным

кодом с минимальным расстоянием, равным 3 [3]). Если п не

имеет такого вида, то минимальный идеал периода п содержит

более чем один цикл, и тогда необходимо находить несколько

циклических представителей. Никаких сокращенных способов

выполнения этой процедуры не предложено; частные случаи,

которые изучались, были решены непосредственным образом^).

Если циклические представители циклов Э^Э^ и ЩЭу найдены,

то циклические представители для 91(вг + Э;) могут быть

найдены с помощью следующих лемм.

Пусть//гбЭге^, ne^Qj.

Лемма 2Л9. тТ^-{-пТ^ = тТ^'+пТ^' тогда и только

тогда, когда тТ^ = тТ^ и nV = nV .

Доказательство. Вышеуказанное равенство может

быть переписано в виде

тТ'' — тТ''' = пГ — пГ'.

Левая половина принадлежит ШЭг, а правая — 9i9j.

Пересечение этих идеалов равно нулю.

Пусть п{т) и п{п) будут соответственно периодами тип,

и пусть Ник будут соответственно наименьшим общим

кратным и наибольшим общим делителем этих чисел.

Лемма 2.20 (доказательство предложения X), п{т)п{п)

элементов тТ^+^пТ^ распадаются на h циклов периода Н.

Векторы тТ^+п, |1=0, 1, ..., h — 1, лежат в различных циклах и

могут быть выбраны в качестве циклических представителей.

Доказательство. Пусть К будет периодом вектора

тТ^+пТ"^. Тогда

(mr^+ пГ) Т^ = тТ^'+пГ,

^) См. примечание на стр, 21. — Прим. перев^

40 Дж. Мак-Вильяме

И, согласно 2.19, {v+A.)=v(modn(n)) и (jx4-X)=|i(mod jt(m)).

Таким образом, Х делится как на я(т), так и на я(п), т. е.

'k=qH, где ^ — число, не меньшее единицы. Векторы тТ^+п и

тТ^ -f п лежат в одном и том же цикле тогда и только тогда,

когда

{тТ''+п)Т^ = тТ'''+п

или когда (|i + p)^|i'(modn(m)) и p^O(modn(n)). Ир, и я(т)

делятся на к. Следовательно, сравнение ([i—[i')^р(mod п(т))

означает, что [i—[i^ делится на /г. Таким образом, h векторов

тТ^+'Пу |1 = 0, 1, ..., /г—1, должны лежать в различных циклах.

Таким образом, имеемся по меньшей мере h различных

циклов, и период каждого из них не меньше Я. Так как всего

имеется только п{т) ' n{n)=hH различных элементов, то возможно

суш.ествование только h циклов периода Я.

Вернемся теперь к предложению V, которое раньше было

опущено. Перефразируем это предложение следующим образом:

Теорема 2.21. Пусть Ш^ и Эйз— минимальные идеалы в

Шп. Следующие три утверждения эквивалентны:

(i) Ш^ и Эйз имеют один и тот оюе спектра

(ii) a^i и Эйз имеют одну и ту же размерность и период.

(iii) Существует такой автоморфизм а^ кольца 91„, что

Доказательство. Покажем, что(1) =ф(ii) =ф(iii) =ф(i)*

Пусть А {s) — число букв веса 5 в 2)?^. Покажем, что

период Tti равен наибольшему общему множителю чисел A{s),

s>0.

Предположим сначала, что период Ш1 равен п. Пусть 2*^

будет общим числом букв в 9К^. Ортогональное дополнение Tti

не может содержать букв с весом 1, поскольку оно является

нетривиальным циклическим алфавитом. Согласно предложению

VHI, мы получаем

2Л(5)=2'/-1,

5=1

^sA{s)=2^r'n.

£-1

Согласно первому равенству, &i = &2, так что размерности

Шх и 9Й2 равны. Так как каждый цикл из ЗИ^, исключая цикл,

Бинарные циклические алфавиты, 41

СОСТОЯЩИЙ из нулевой буквы, имеет длину п, то п делит каждое

число A{s) для 5>0. Согласно второму равенству, любой об^

щий множитель чисел A{s) является степенью двойки. В силу

первого равенства такого множителя не существует.

Предположим теперь, что период 9К/ равен et и п/^^ = аг>1.

Согласно леммам 2.16 и 2.17, в %^ существует такой макси*

мальный идеал Эй/с периодом ei и спектром A^{s), что спектр

9ГО/ определяется равенствами A{aiS)=A^(s). Согласно первой

части доказательства, е{ является наибольшим общим

множителем чисел A^{s), 5>0. Следовательно, ei является наибольшим

общим множителем чисел A{aiS), aiS>0.

(ii) гф (iii). Предположим сначала, что рериод SO^i и 3^2

равен п. Пусть Шх соответствует циклу (1, 2, 2^, ..., 2^-*)

подстановки 22(п) и 2)?2 соответствует циклу (у, 2у, ..., 2'^-^v),

V должно быть взаимно просто с п, так как неприводимый

полином, ассоциированный с STOg, принадлежит показателю п. Выбе^

рем и, взаимно простое спи такое, что uv^l{modn). Так же

как в доказательстве предложения VH, можно показать, что

3№ia„==:aK2.

Предположим теперь, что 9К/ имеют показатель е, i=l, 2,

где .п1е = г>1. Пусть Tti и Зйз ассоциированы с циклами

(г, 2г, ..., 2'^'"V) и (5, 25, ..., 2"^'~^s). Длины этих циклов

равны, поскольку Tt^ и SKg имеют одинаковую размерность.

Аналогично доказательству леммы 2.5 получаем, что s==qr,

где q взаимно просуо с п. Обращаясь опять к доказательству

предложения Vn, получаем 3№ior^ = 9№2.

(iii)z^(i). Если Ш^ и 9№2 эквивалентны, то они, очевидно,

имеют один и тот же спектр.

Таким образом, мы показали, что минимальные и

максимальные циклические алфавиты кольца 91;^, имеющие один и

тот же спектр, эквивалентны. Неизвестно, справедливо ли это

утверждение для других циклических алфавитов. Однако

найдено много случаев, когда для циклических алфавитов с одним

и тем же спектром определенно не существует ни одного

автоморфизма Oq, переводящего их друг в друга.

Заключение

До настоящего времени большинство теоретических работ по

бинарным циклическим алфавитам концентрировалось на

алфавитах с блоковой длиной вида п = 2^—1. Такие числа при

увеличении п становятся достаточно редкими. С другой стороны,

алфавиты с большой блоковой длиной являются важными для

42 Дж. МаК'Вильямс

их действенного использования в телефонных линиях, причем в

этих применениях блоковая длина, хотя и должна быть

большой, по-видимому, ограничена некоторым узким диапазоном.

Поэтому представляется целесообразным разработка

экономичных процедур для отыскания алфавитов с указанными

свойствами, если, конечно, такие существуют. Объем приведенной

в данной статье информации о структуре полиномов кольца Ш^

не так велик, однако она имеет существенные практические

применения.

ЛИТЕРАТУРА

1. Slepian D., А Class of Binary Signaling Alphabets, В. 5. Г Л, 35

"<1956 Jan.), 203. (Русский перевод: Слеп ян Д., Класс бинарных

сигнальных алфавитов, сб. «Теория передачи информации», 1958, ИЛ.)

2. Elliott Е. О., Estimates of Error Rates for Codes on Burst Noise

Channels, B. S. T. /., 42 (1963 Sept.), 1977.

3. M a с W i 11 i a m s J., A Theofem on the Distribution of Weights in a

Systematic Code, B. S. T. J., 42 (1963 Jan.), 79.

4. Peterson W. W., Error Correcting Codes, John Wiley and Sons, Inc., New

York, 1961. (Русский перевод: Питерсон У., Коды, исправляю1цие

ошибки, «Мир», 1964.|

5. Van de Waerden В. L., Modern Algebra, Julius Springer, Berlin, 1937.

(Русский перевод: Ван дер Варден, Современная алгебра, ч. I,

ГИТТЛ, 1947.)

6. С U г t i S С. W., Reiner I., Representation Theory of Finite Groups and