Text

Nonlinear Programming

Theory and Algorithms

Mokhtar S. Bazaraa

С. М. Shetty

School of Industrial and Systems Engineering

Georgia Institute of Technology

Atlanta, Georgia

John Wiley and Sons

New York Chichester Brisbane Toronto

1979

.Базара, К.Шетти

Нелинейное

программирование

Теория

д алгоритмы

Перевод с английского

Т. Д. Березневой и В. А. Березнева

под редакцией Д. Б. Юдина

Издательство «Мир»-Москва 1982

ББК 22.143

17

УДК 51.38 + 519.9

Базара М., Шетти К.

Б 17 Нелинейное программирование. Теория и алгоритмы:

Пер. с англ. — М.: Мир, 1982.

583 с.

Относительно простой, но достаточно строгий курс нелинейного программи-

программирования. Монография, написанная известными американскими специалистами,

поможет подготовить инженеров к совместной с математиками работе по переводу

прикладных задач на формальный язык.

Для инженеров и математиков-прикладников, специализирующихся в области

нелинейного программирования и оптимизации.

20-82, чЛ 1502000000 ББК 22.143

041 @1)-82

Редакция литературы по математическим наукам

Copyright © 1979 by John Wiley & Sons, Inc.

All rights reserved. Authorized translation from

English language edition published by John Wiley

& Sons, Inc.

© Перевод на русский язык, «Мир», 1982

Предисловие редактора перевода

Оптимизационный подход к постановке и решению задач син-

синтеза сложных систем является важным резервом повышения ка-

качества управления, планирования и проектирования. Выбор це-

целей оптимизации и областей изменения управляющих параме-

параметров— задача конкретных общественных, экономических и

технических наук. Разработка аппарата оптимизации — предмет

математического программирования.

Общеизвестны рост и достижения линейного программирова-

программирования в повышении эффективности экономического моделирования

и оптимизации плановых решений. Более скромны успехи ли-

линейного программирования в технических приложениях, управ-

управлении и проектировании. Совершенствование технологических

процессов и качества управления объектами различной природы,

так же как и создание экономных и надежных конструкций, тре-

требует, как правило, учета нелинейных эффектов. В последние

годы все чаще возникает необходимость в использовании нели-

нелинейных моделей и для описания экономических процессов.

Многие нелинейные задачи оптимизации, встречающиеся в

экономике и технике, описываются в естественной постановке

выпуклыми или вогнутыми функционалами и выпуклыми обла-

областями допустимых значений управляющих параметров. Это

определяется как неформальными, так и формальными сообра-

соображениями. Так, зависимость показателей эффективности техниче-

технических систем от своих аргументов описывается обычно вогнутой

функцией. Чем выше технические характеристики системы, тем

труднее добиться приращения величины критерия ее эффектив-

эффективности. Производственные функции, характеризующие экономи-

экономические системы, определяют вогнутую функциональную зависи-

зависимость объема выпускаемой продукции от объемов используемых

ресурсов. При больших капиталовложениях выпуск продукции

на каждый рубль дополнительных вложений увеличивается

меньше, чем при малых капиталовложениях. Чем больше объем

производства, тем больше средств отвлекается на согласование

и организацию взаимодействия между элементами системы.

6 ПРЕДИСЛОВИЕ РЕДАКТОРА ПЕРЕВОДА

Формальное описание широкого круга ситуаций, в которых

функционалы и множества, определяющие нелинейную задачу

математического программирования, оказываются выпуклыми,

устанавливается содержательным истолкованием теоремы Ка-

стена, обобщающей известную теорему Ляпунова.

Особое внимание, уделяемое выпуклому программированию,

объясняется и тем, что для класса выпуклых задач общего вида

и для различных его подклассов можно создать методы, гаран-

гарантирующие решение любой задачи класса с заданной точностью

за время, растущее относительно медленно с увеличением раз-

размерности задач. Для нелинейных задач более широких классов

таких гарантий дать нельзя.

Предлагаемый вниманию читателя перевод представляет со-

собой относительно элементарный и в то же время достаточно

строгий и систематический курс нелинейной оптимизации. Этот

курс выгодно отличается от опубликованных в последнее время

монографий по различным аспектам теории и методов оптимиза-

оптимизации своей практической ориентацией — он адресуется инженеру,

ответственному за постановку практических задач. В своем пре-

предисловии авторы подробно характеризуют содержание книги,

поэтому отметим лишь некоторые методические особенности из-

изложения. Применение введенных в монографии понятий и мето-

методов иллюстрируется графическими и численными примерами.

Кроме того, в каждой главе содержится большое количество

упражнений различной степени трудности. Часть из них непо-

непосредственно связана с излагаемым материалом, другие расши-

расширяют круг вопросов, рассматриваемых в основном тексте.

Имеются достаточно трудные задачи, рассчитанные на подготов-

подготовленного читателя. В методическом отношении полезны приводи-

приводимые в конце каждой главы замечания, библиографические

справки, обобщения и прикладные и теоретические проблемы,

связанные с излагаемым в соответствующей главе материалом.

Все это способствует активному усвоению книги. Следует отме-

отметить, что работам советских специалистов по математическому

программированию в книге достаточного внимания не уделено.

Для удобства читателей мы сочли возможным привести допол-

дополнительный библиографический список, содержащий работы со-

советских математиков по затронутым в книге вопросам, а также

некоторые библиографические комментарии.

Книга М. Базара и К. М. Шетти заинтересует многочислен-

многочисленных специалистов-практиков в области исследования операций,

управления, планирования и проектирования, а также будет по-

полезна студентам соответствующих специальностей.

Д. Б. Юдин

Посвящается нашим

родителям

Предисловие

Математическое программирование имеет дело с задачей опти-

оптимизации значений некоторой целевой функции при ограничениях

типа равенств и неравенств. Задача, в которой все фигурирую-

фигурирующие при ее описании функции линейны, называется задачей

линейного программирования. В противном случае имеет место

задача нелинейного программирования. Разработка симплекс-

метода и появление быстродействующих вычислительных машин

сделали линейное программирование важным инструментом ре-

решения многих проблем, возникающих в самых различных обла-

областях. Однако большинство реальных задач не может быть

адекватно описано с помощью моделей линейного программи-

программирования из-за нелинейности целевой функции или некоторых

ограничений. В последние два десятилетия значительного про-

прогресса достигли исследования нелинейных задач. Настоящая

книга представляет собой достаточно полное изложение этих

достижений.

Книга разделена на три основные части: выпуклый анализ;

условия оптимальности и двойственности; вычислительные ме-

методы. Конечной целью при изучении оптимизационных задач

является построение эффективных вычислительных схем для ре-

решения практических задач. Выпуклый анализ, включающий в

себя теории выпуклых множеств и выпуклых функций, играет

важную роль при изучении области определения задач оптими-

оптимизации. Условия оптимальности и теория двойственности могут

использоваться как для получения критериев, отличающих оп-

оптимальное решение, так и для обоснования вычислительных

методов.

При подготовке монографии особое внимание уделялось пол-

полноте и замкнутости изложения, дающим возможность использо*

вать ее также в качестве учебного пособия либо справочника.

Чтобы облегчить усвоение вводимых понятий и методов, в каж^-

Дой главе приводятся детально разобранные примеры и иллк^

страции. Кроме того, каждая глава содержит упражнения.

Они включают в себя A) простые числовые задачи, предна2-

значенные для закрепления обсуждаемых вопросов; B) за-

задачи, дополняющие изложенный в главе основной материал;

8 ПРЕДИСЛОВИЕ

C) теоретические упражнения для более подготовленных чита-

читателей. Каждая глава завершается библиографическими сведе-

сведениями и комментариями, которые будут полезны читателю при

более глубоком изучении предмета. В конце книги приводится об-

обширная библиография по математическому программированию.

Первая глава содержит примеры задач из разных областей

инженерных дисциплин, которые могут быть формально сведены

к задачам математического программирования. В частности, об-

обсуждаются модели математического программирования, к кото-

которым сводятся задачи дискретного и непрерывного оптимального

управления. Изложение иллюстрируется примерами управления

производством и запасами. Рассматривается также пример, свя-

связанный со строительством шоссейных дорог. Приводятся при-

примеры проектирования конструкций в строительной механике и

машиностроении. Устойчивые состояния электрической цепи ин-

интерпретируются как оптимальные решения задачи квадратич-

квадратичного программирования. Исследуются нелинейные задачи, воз-

возникающие при управлении водными ресурсами. Наконец, обсуж-

обсуждаются нелинейные модели, возникающие в стохастическом

программировании.

Остальные главы книги разделены на три части. Первая

часть, содержащая гл. 2 и 3, посвящена анализу выпуклых

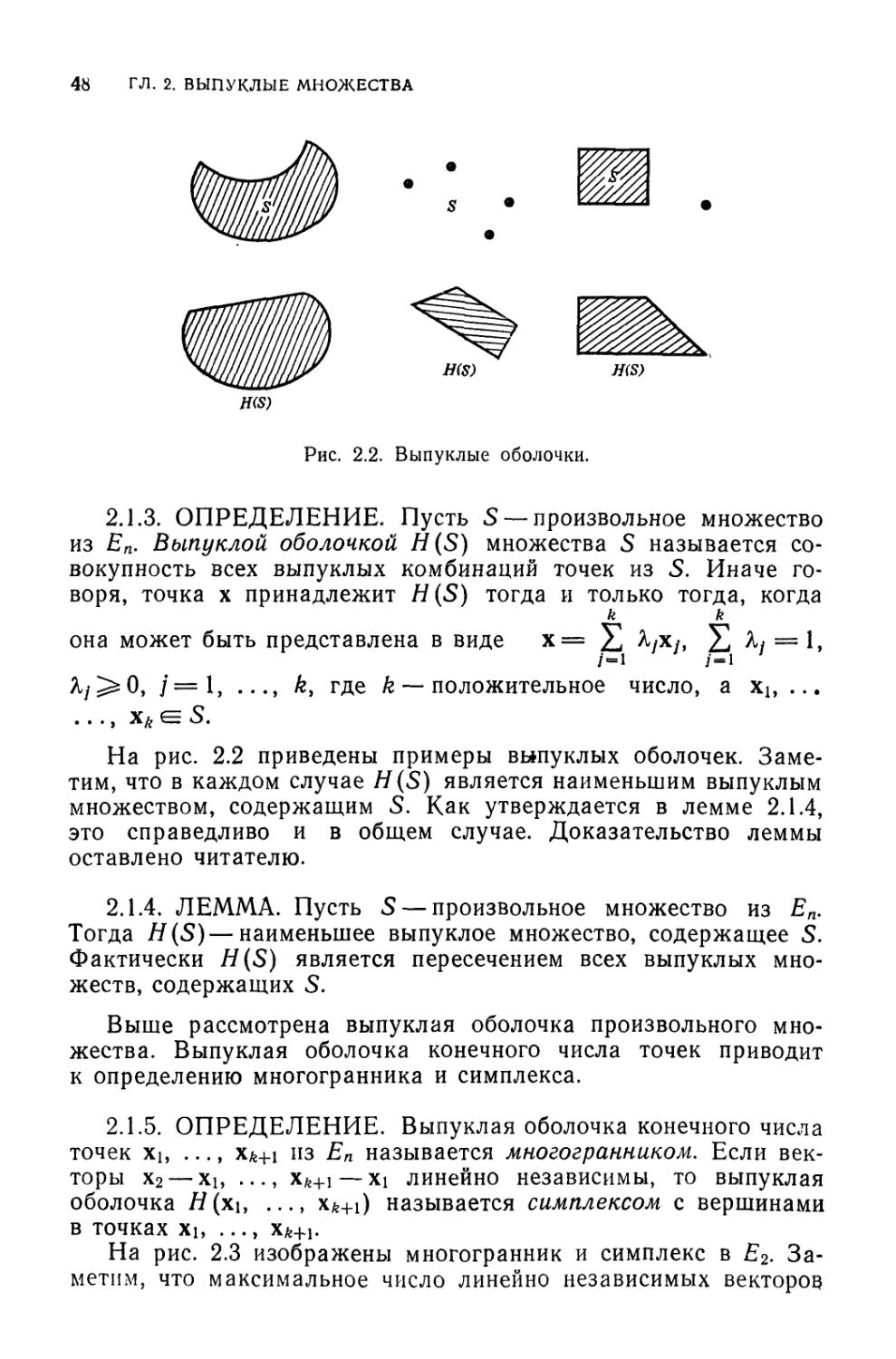

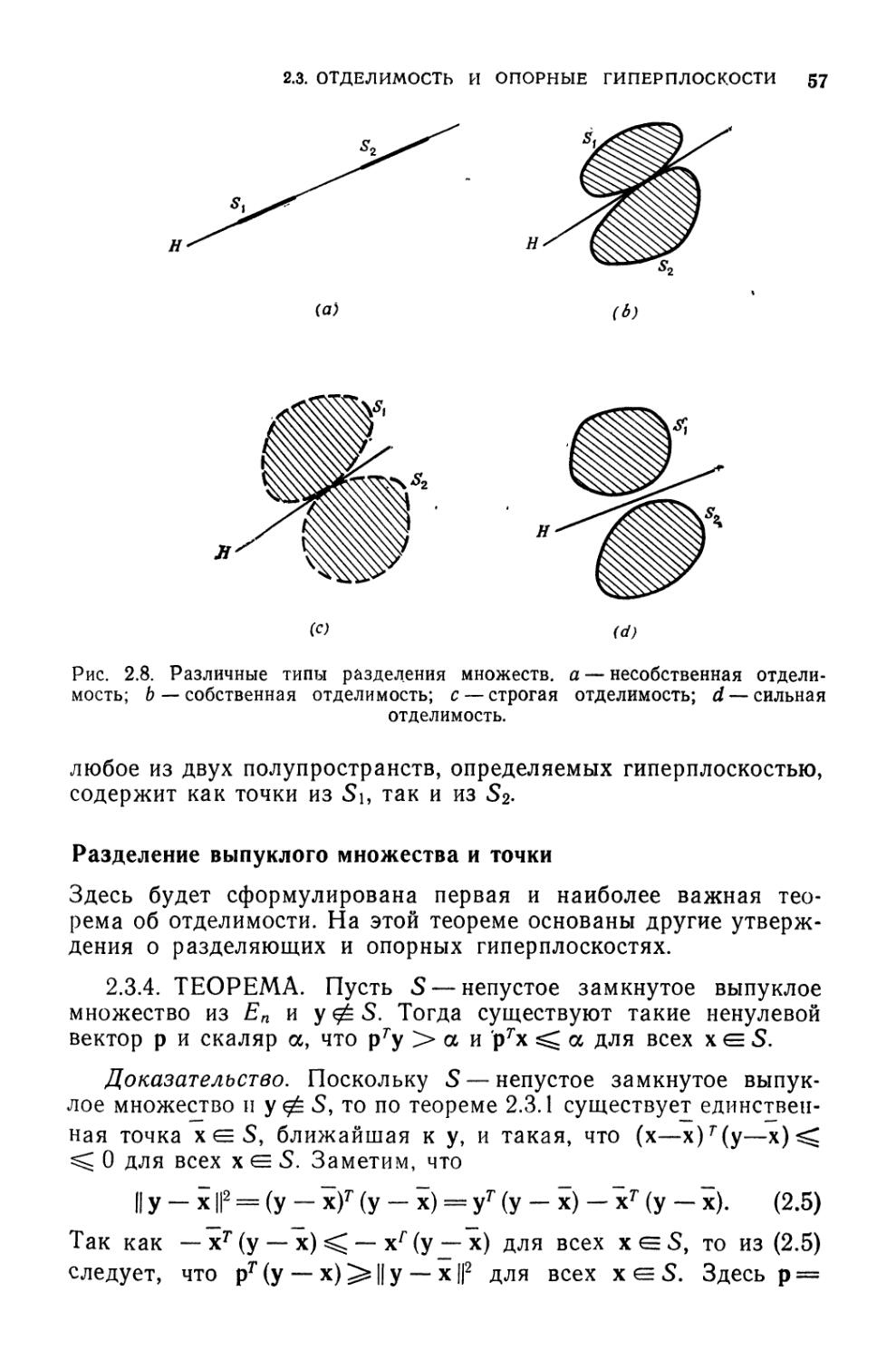

множеств и выпуклых функций. Во второй главе обсуждаются то-

топологические свойства выпуклых множеств, понятия опорной и

разделяющей гиперплоскостей, многогранные множества и их

свойства. Кроме того, здесь приводится краткий очерк линейного

программирования. В третьей главе рассмотрены свойства вы-

выпуклых функций, и в частности субдифференцируемость и усло-

условия существования минимума и максимума на выпуклом мно-

множестве. Здесь же описываются обобщения понятия выпуклой

функции и исследуется их взаимосвязь. Алгоритмы нелинейного

программирования, построенные для выпуклых функций, могут

быть использованы для решения задач более широкого класса,

содержащих псевдовыпуклые и квазивыпуклые функции.

Вторая часть (гл. 4—6) посвящена условиям оптимальности

и теории двойственности. В гл. 4 рассматриваются классиче-

классические условия оптимальности Ф. Джона и Куна — Таккера как

для задач с ограничениями-равенствами, так и для задач с ог-

ограничениями-неравенствами. В гл. 5 изучаются различные типы

условий регулярности. В гл. 6 с помощью функции Лагранжа

вводится понятие двойственности и исследуются условия опти-

оптимальности, связанные с седловыми точками. Обсуждаются тео-

теоремы двойственности, свойства двойственных функций и методы

решения двойственных задач. Существуют также и другие опре-

определения двойственности. Наиболее обнадеживающим с точки

зрения создания алгоритмов решения нелинейных задач пред:-

ПРЕДИСЛОВИЕ 9

ставляется определение двойственности по Лагранжу. Резуль-

Результаты, которые могут быть получены при разных подходах к

двойственности, оказываются сравнимыми. Поэтому, а также

в силу ограниченности объема монографии мы предпочли об-

обсуждать в книге двойственность по Лагранжу, а остальные под-

подходы ввели только в упражнениях.

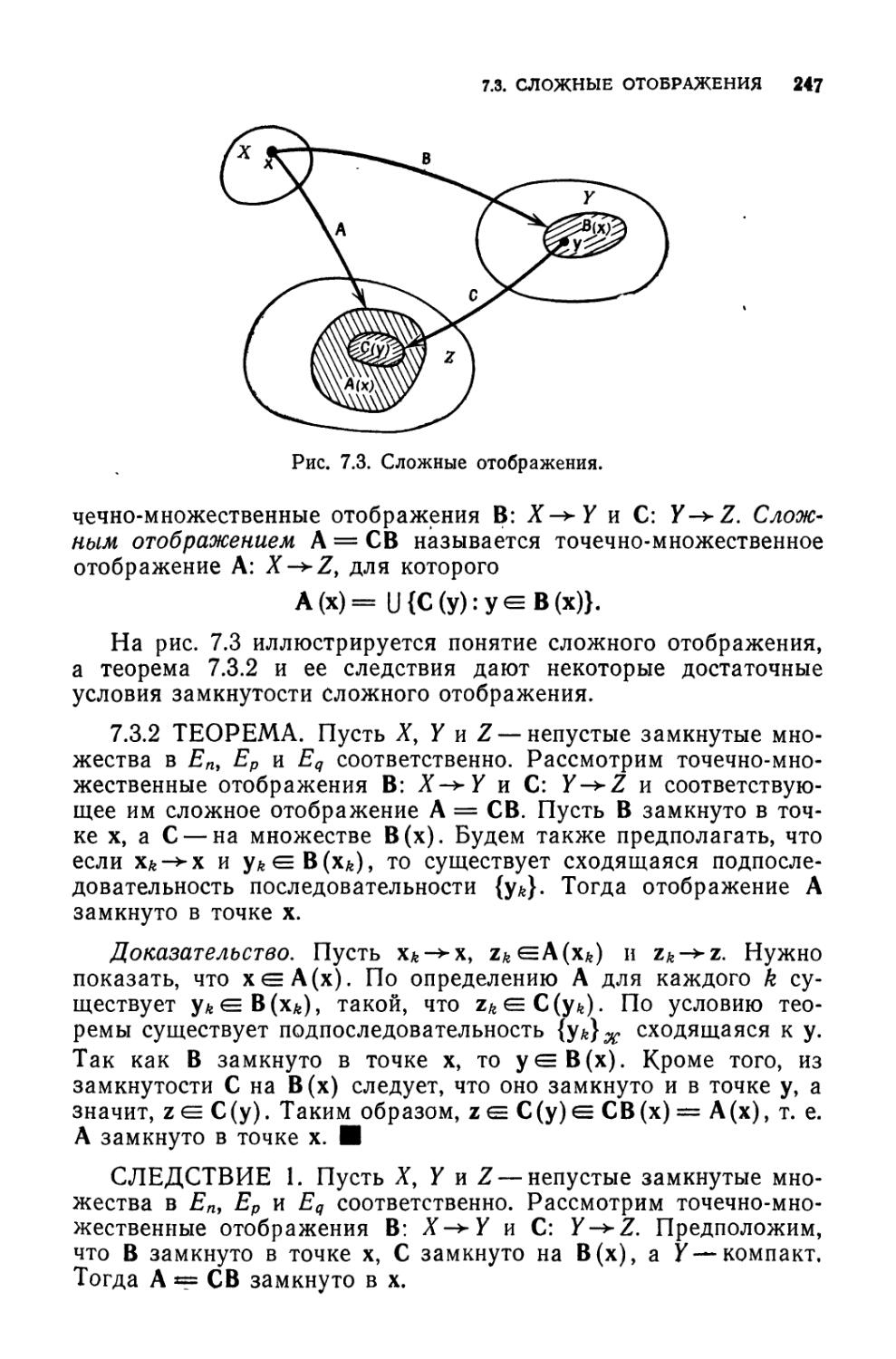

В третьей части, содержащей гл. 7—И, обсуждаются алго-

алгоритмы условной и безусловной оптимизации решения задач

нелинейного программирования. Глава 7 имеет дело исключи-

исключительно с теоремами сходимости. При этом алгоритмы рассма-

рассматриваются как точечно-множественные отображения. Эти тео-

теоремы используются для доказательства сходимости методов,

изложенных в последующих главах книги. Приведено также

краткое описание критериев, которые могут быть использованы

для оценки качества алгоритмов. Глава 8 посвящена безуслов-

безусловной оптимизации. Здесь обсуждаются различные методы одно-

одномерного поиска и методы минимизации функции нескольких

переменных. Отдельно излагаются методы, использующие и не

использующие производные. Рассмотрены методы, основанные

на понятии сопряженности векторов. В гл. 8—11 доказана схо-

сходимость всех описанных методов. Из-за ограниченности места

вопросы, связанные с порядком сходимости, кратко рассмотрен-

рассмотренные в гл. 7, более не обсуждаются. В гл. 9 приводятся методы

барьерных и штрафных функций для нелинейного программи-

программирования. При использовании этих методов задача сводится к

последовательности задач безусловной оптимизации. В десятой

главе рассмотрены методы возможных направлений, заключаю-

заключающиеся в том, что сначала ищется некоторое направление спуска

из допустимой точки, и затем новая допустимая точка находится

минимизацией целевой функции вдоль этого направления. Об-

Обсуждается оригинальный метод, предложенный Зойтендейком и

модифицированный затем для обеспечения сходимости Топки-

сом и Вейноттом. В гл. 10 представлены также такие разновид-

разновидности метода возможных направлений, как метод проекции гра-

градиента Розена, метод приведенного градиента Вулфа и выпук-

выпуклый симплексный метод Зангвилла. В гл. 11 рассматриваются

специальные задачи с линейными ограничениями, которые мо-

могут быть решены при помощи несильно модифицированного

симплекс-метода. В частности, здесь приводятся задачи квадра-

квадратичного, сепарабельного и дробно-линейного программирова-

программирования. Для решения задач квадратичного программирования ис-

используется описанный в этой главе алгоритм дополнительного

ведущего преобразования, принадлежащий Лемке.

Предлагаемую вниманию читателя книгу можно использо-

использовать и как справочник по нелинейному программированию, и

как руководство для занимающихся исследованием операций,

ПРЕДИСЛОВИЕ

управлением, прикладной математикой и инженерными дисцип-

дисциплинами, связанными с численными методами оптимизации. Ма-

Материал книги требует некоторой математической зрелости и зна-

знания линейной алгебры и методов вычислений. Для удобства

читателей в приложении А собраны основные математические

определения и утверждения, часто используемые в книге.

Книга может быть использована для подготовки курса

«Основы оптимизации» или «Вычислительные методы нелиней-

нелинейного программирования» по указанным ниже схемам. По ма-

материалам книг можно также построить двухсеместровый курс,

охватывающий обе темы.

1. Основы оптимизации

Этот курс предназначается для студентов, специализирую-

специализирующихся по прикладной математике, или для аспирантов факуль-

факультетов, где прикладная математика не является профилирующей

дисциплиной. Предполагаемое содержание курса схематически

приведено ниже. Курс может быть прочитан за один семестр.

Главу 5 об условиях регулярности можно опустить, не нарушая

непрерывности изложения. Кроме того, те, кто знаком с линей-

линейным программированием, могут пропустить § 2.6.

Глава

2

Глава

3

Глава

4

У*

Глава

5

S

ч

Глава

6

2. Вычислительные методы нелинейного программирования

Этот курс предназначен для студентов и аспирантов, инте-

интересующихся алгоритмами решения задач нелинейного програм-

программирования. Схема курса приведена ниже. Он может быть

прочитан за один семестр. Лица, заинтересованные главным

образом в приложениях, могут опустить гл. 7 и обсуждение

сходимости, проводимое в гл. 8—11.

Минимальные сведения из выпуклого анализа и условий

оптимальности, необходимые для изучения гл. 8—11, собраны

для удобства в приложении В. Первая глава, содержащая много

примеров качественных задач, которые могут быть формально

описаны задачами нелинейного программирования, будет хо-

хорошим введением к этому курсу. Однако если ее опустить, то

непрерывность изложения не нарушится.

Глава 1

Глава 7

* 7

Приложе-

Приложение В

t

Глава

Глава

9

Глава

10

Глава

\\

ПРЕДИСЛОВИЕ И

Авторы благодарят доктора Роберта Н. Лехрера (Robert N.

Lehrer, Director of the School of Industrial and Systems Engi-

Engineering) из Технологического - института (шт. Джорджия) за

поддержку при подготовке монографии. Авторы активно обсуж-

обсуждали различные вопросы с доктором Дж. Дж. Гудом (Jamie J.

Goode of the School of Mathematics) из Технологического ин-

института (шт. Джорджия). Ему принадлежит пример 7.3.3 замк-

замкнутости сложных отображений. Авторы глубоко признательны

ему за дружбу и сотрудничество. Наконец, авторы благодарят

г-жу Кэролин Пиерсма, г-жу Джоан Оуэн и г-жу Кай Уоткинс

за успешную расшифровку и перепечатку черновиков моно-

монографии, которые иногда выглядели так, будто бы они были на-

написаны по-арабски или на языке хинди.

Атланта, Джорджия М. Базара, /(. Шетти

1 января 1979 г.

1

Введение

Инженеры и специалисты по исследованию операций часто стал-

сталкиваются с необходимостью решения оптимизационных задач.

На практике встречаются разнообразные в содержательном

смысле задачи оптимизации. Это могут быть задачи проектиро-

проектирования, задачи распределения ограниченных ресурсов, задачи

расчета траектории полета ракеты и т. п. В недалеком прошлом

в задачах такого рода вполне приемлемыми считались решения

из довольно широкой области. В инженерном проектировании,

например, обычно задавался большой коэффициент надежности.

Однако с развитием производства все больше ужесточаются

требования, предъявляемые к приемлемому проекту. В других

областях деятельности, таких, как проектирование космических

кораблей, условия функционирования проектируемых систем

предъявляют экстремальные требования к характеристикам

проекта. Таким образом, существует очевидная потребность в

решении следующих важных вопросов. Каково наиболее эффек-

эффективное использование имеющихся ресурсов? Можно ли получить

более экономный в том или ином смысле проект? В каких пре-

пределах можно считать риск допустимым? Важность и актуаль-

актуальность этих проблем вызвали в последние три десятилетия ин-

интенсивные разработки моделей и методов оптимизации. Этому

способствовало также увеличение количества и быстродействия

вычислительных машин.

С другой стороны, развитие моделей и методов оптимизации

стимулировалось значительным увеличением размерности и

сложности оптимизационных задач, вызванным существенным

технологическим подъемом после второй мировой войны. Инже-

Инженеры и руководители производства оказались вынужденными

учитывать все существенные факторы и их взаимосвязи, влияю-

влияющие на качество принимаемых решений. Некоторые из этих

связей не всегда даже могли быть поняты и нуждались, таким

образом, в дополнительном анализе и проверяемых гипотезах.

Успехи в методах измерений и статистических методах про-

проверки гипотез существенно помогли в установлении взаи-

взаимодействия между различными компонентами исследуемых

систем.

14 ГЛ. 1. ВВЕДЕНИЕ

В настоящее время методы исследования операций довольно

широко применяются инженерами, экономистами, специали-

специалистами, ответственными за принятие решений в военной, куль-

культурной, административной и других областях. Это объясняется,

по-видимому, уже накопленным положительным опытом прак-

практического использования моделей и методов оптимизации. На

раннем послевоенном этапе применения исследования операций

в планировании и управлении производством, как правило, ис-

использовались методы линейного программирования и статисти-

статистического анализа. Теперь хорошо известны эффективные методы

и машинные программы для решения такого рода задач. В этой

книге рассматриваются нелинейные задачи, устанавливаются

важнейшие свойства их оптимальных решений и обсуждаются

различные вычислительные методы нелинейного программиро-

программирования.

В настоящей главе приводится постановка общей задачи не-

нелинейного программирования, а также рассматриваются некото-

некоторые простые практические задачи, описываемые моделями нели-

нелинейного программирования. Авторы стремились в этой главе

прежде всего показать читателю многочисленные источники

прикладных задач нелинейного программирования, не утруждая

его глубоким исследованием каждой конкретной задачи.

1.1. Постановка задачи и основное определения

Общая задача нелинейного программирования имеет вид

минимизировать f (x)

при условиях ?*

XGl

Здесь f, g\, ..., gm, hu ..., hi — определенные на Еп функции,

X — множество из Еп, х— вектор с компонентами х\, ..., хп.

Задача заключается в нахождении переменных х\, ••-, хп, удов-

удовлетворяющих ограничениям и отвечающих при этом минималь-

минимальному значению функции f(x).

Функцию f обычно называют целевой функцией, или крите-

критерием оптимальности. Каждое условие g*(x)^0, / = l, ..., т,

называют ограничением-неравенством или ограничением в фор-

ме неравенства, а условие вида й/(х) = 0, 1= 1, ..., /, — огра-

ограничением-равенством или ограничением в форме равенства. Век-

Вектор х е X, удовлетворяющий всем ограничениям, называют до-

допустимым решением, или допустимой точкой. Совокупность всех

допустимых точек образует допустимую область. Таким обра-

1.1. ПОСТАНОВКА ЗАДАЧИ И ОСНОВНЫЕ ОПРЕДЕЛЕНИЯ 15

зом, задача нелинейного программирования заключается в на-

нахождении такой допустимой точки х. для которой /(х)^/(х)

при всех допустимых решениях_х. Точка х называется оптималь-

оптимальным решением или просто решением задачи.

Ясно, что задача нелинейного программирования может быть

сформулирована как задача максимизации /(х), а ограничения-

неравенства записаны в виде g/(x)^0, ?—1, ..., пг. В спе-

специальном случае, когда целевая функция f(x) линейна и все

ограничения, включая соотношения, описывающие множество X,

могут быть представлены в виде линейных равенств и/или не-

неравенств, сформулированная выше задача называется задачей

линейного программирования.

В качестве примера рассмотрим следующую задачу:

минимизировать {хх — ЗJ + (х2 — 2J

при условиях х\— х2 — 3^0,

Целевая функция и три функции ограничений имеют вид

На рис. 1.1 изображена допустимая область. Задача заклю-

заключается в нахождении такой точки из допустимой области, для

которой (х\ — 3J + (х2 — 2J имеет наименьшее возможное зна-

значение. Заметим, что точки (xi,x2), удовлетворяющие равенству

(х\ — 3J + (х2 — 2J = с, лежат на окружности радиуса Vе

с центром в точке C, 2). Для каждого неотрицательного с та-

такая окружность называется линией уровня целевой функции, от-

отвечающей заданному значению с. Таким образом, задача заклю-

заключается в нахождении минимального с, при котором хотя бы

одна точка окружности принадлежит допустимой области. Ины-

Иными словами, нужно найти окружность наименьшего радиуса,

которая пересекала бы допустимую область. Как видно из

рис. 1.1, такая окружность наименьшего радиуса соответствует

с = 2 и пересекает допустимую область в единственной точке

B,^1). Поэтому B, 1) — оптимальное решение, и значение целе-

целевой функции в этой точке равно 2.

Использованный выше подход состоит в нахождении опти-

оптимального решения с помощью построения линии уровня целе-

целевой функции, отвечающей наименьшему значению, при котором

16 ГЛ. I. ВВЕДЕНИЕ

Рис. 1.1. Геометрический способ решения задачи нелинейного программиро-

программирования. / — линии уровня функции; 2 — оптимальная точка; 3 — допустимая

область.

она пересекает допустимую область. Очевидно, что такой гео-

геометрический способ решения подходит для очень простых задач

и практически неприменим в задачах, где число переменных

больше двух.

Обозначения

В книге приняты следующие обозначения. Векторы записы-

записываются малыми буквами латинского алфавита, набранными

жирным шрифтом, например х, у, z. Если специально не огово-

оговорено, то все векторы представляют собой векторы-столбцы. Век-

Вектор-строка получается транспонированием вектора-столбца. Так,

\т представляет собой вектор-строку (х\, ..., хп). Совокупность

всех векторов размерности п образует /2-мерное евклидово про-

пространство, которое обозначается через Еп. Матрицы записывают-

записываются заглавными латинскими буквами, набранными жирным

шрифтом, например А и В. Скалярные функции обозначаются

малыми латинскими или греческими буквами, такими, как /, g

и 0. Вектор-функции обозначаются теми же буквами, но на-

набранными жирным шрифтом, например g и ф. Скаляры обозна-

обозначаются малыми латинскими и греческими буквами (гД, а и т. п.

1.2. Примеры

В этом параграфе обсуждаются несколько задач, которые мо-

могут быть формально представлены в виде моделей нелинейного

программирования. В частности, рассматриваются задачи опти-

оптимизации, возникающие в следующих областях;

t.2. ПРИМЕРЫ 17

A. Оптимальное управление.

B. Проектирование строительных конструкций.

C. Проектирование механических конструкций.

D. Электрические цепи.

E. Управление водными ресурсами.

F. Распределение ресурсов в условиях неполной информации.

G. Размещение оборудования.

А. Задачи оптимального управления

Как будет показано ниже, задачу оптимального управления с

дискретным временем можно сформулировать как задачу нели-

нелинейного программирования. Кроме того, задачу оптимального

управления с непрерывным временем можно аппроксимировать

задачей нелинейного программирования. Таким образом, мето-

методы, обсуждаемые в дальнейшем в книге, могут быть использо-

использованы для решения задач оптимального управления.

Задача оптимального управления

с дискретным временем

Рассмотрим задачу оптимального управления с дискретным

временем продолжительности К периодов. К началу k-то пе-

периода система описывается вектором состояния yk-\ (вектором

фазовых переменных). Вектор управления и* изменяет к концу

6-го периода состояние системы от g^-i до ун в соответствии

с формулой

+ ( )

Применяя последовательность управлений ui, ..., U/c, полу-

получаем при начальном состоянии уо последовательность состояний

Уь •.., У/с, называемую траекторией. Этот процесс изображен

на рис. 1.2.

Последовательности управлений щ9 ..., и* и векторов со-

состояний уо, уь ..., у/с называют возможными или допустимы-

допустимыми, если они удовлетворяют следующим ограничениям:

у*е=Гб, 6=1, ..., /С,

иЛе=?/ь Л=1, ..., К,

..., У/с, «ь ¦-.

Здесь Уь ..., У/с, Uu ..•» Uк — заданные множества, ф — из*

вестная вектор-функция, обычно называемая функцией ограни-

ограничений на траекторию. Среди всех допустимых управлений и

траекторий выберем управление и соответствующую ему траек-

траекторию, которые оптимизируют некоторую целевую функцию.

18 ГЛ. 1. ВВЕДЕНИЕ

Уо

1

*

2

У? У*-1

k

У/с

Рис. 1.2. Построение траектории в задаче оптимального управления с дис-

дискретным временем.

Таким образом, задача оптимального управления с дискретным

временем формулируется в виде

минимизировать

при условиях

о(Уо, Уь ..., У/с, иь ..., ик)

У* = У*-1 + Фл(у*-ь Щ), k=l, ..., /С,

Yk^Yk, k=l, ..., /С,

f (Уо, Уь ..., У/о иь .-¦> vlk)^D.

Если обозначить через х вектор с компонентами уь ..., у^,

Ui, ..., ик и подобрать соответствующие вектор-функции g, h

и множество X, то сформулированную выше задачу можно пе-

переписать в виде определенной в § 1.1 задачи нелинейного про-

программирования.

Пример планирования производства и запасов. Проиллю-

Проиллюстрируем постановку задачи оптимального управления с ди-

дискретным временем на следующем примере. Предположим, что

некоторая компания производит определенный продукт, спрос

на который известен. Спрос на продукт в любой период времени

•может удовлетворяться как за счет продукции, хранимой на

складе к началу этого периода, так и за счет произведенной в

течение этого же периода продукции. Количество продукции,

производимое в каждом периоде времени, ограничено имеющи-

имеющимися производственными мощностями. Трудовые ресурсы не

ограничены. Чтобы обеспечить бесперебойную работу, произ-

производственный план должен быть составлен на несколько (напри-

(например, К) периодов времени.

Задача заключается в составлении плана производства на

К периодов, гарантирующего удовлетворение спроса на продук-

продукцию в каждом периоде при минимальных суммарных затратах.

Пусть Lk — число рабочих, используемое в производстве в k-м

периоде. Тогда и* = Lk — Lk-\ — изменение потребности в ра-

рабочей силе при переходе от (k— 1)-го к&-му периоду. Обозначим

через Ik запасы продукции в k-u периоде. Предполагается, что

затраты определяются нестабильностью в требуемой рабочей

силе — значениями иь для А = 1, ..., К — и затратами на под-

1.2. ПРИМЕРЫ 19

держание уровня запасов /* в каждом из планируемых пе-

периодов.

Чтобы сократить колебания в требуемой рабочей силе, целе-

целесообразно считать, что затраты на изменение Uk пропорциональ-

пропорциональны и\. Пусть при этом затраты на поддержание уровня запасов

lk пропорциональны величине запасов.

Требуется найти такие интенсивности труда Lk (требуемое

число рабочих) и такие запасы продукции h в каждом из пе-

периодов k — 1, ..., К, при которых удовлетворяется спрос d*, a

суммарные затраты минимальны. В этой задаче каждому пе-

периоду времени отвечают две фазовые переменные —уровень

запасов h и требуемое число рабочих Lk. Параметром управ-

управления является Uk — изменение требуемых трудовых ресурсов

(uk < 0 означает сокращение необходимой рабочей силы). За-

Задача может быть формализована следующим образом:

к

минимизировать X {fku\ "Ь cJk)

при условиях Lk = Lk_i + uk, k=l, ..., К,

h = h-i + pLk-\ — dky k = 1, ..., K,

Здесь /о — начальный запас продукции, Lo — начальное число

рабочих, нанятых компанией, ^-—известный спрос на продук-

продукцию в каждом из периодов, р — количество единиц продукции,

выпускаемых одним рабочим в течение одного периода, Ъ — мак-

максимальный объем производимой в одном периоде продукции,

определяемый ограниченными производственными мощностями.

Задача оптимального управления

с непрерывным временем

В задаче оптимального управления с дискретным временем

управляющие параметры используются в конечном числе фик-

фиксированных точек. Рассмотрим теперь задачу оптимального

управления с непрерывным временем, в которой управляющая

функция n(t) оказывает влияние на состояние объекта управле-

управления во всех точках заданного отрезка времени [О, Г]. При из-

известном начальном состоянии уо связь между функцией управ-

управления и(^) и функцией состояния системы у (t) описывается

следующим дифференциальным уравнением:

, 11@], /е[0, Т].

20 ГЛ. 1. ВВЕДЕНИЕ

Функция управления и функция состояния, описывающая

траекторию, называются допустимыми, если выполняются сле-

следующие условия:

уе=У, ug(/, *(y,u)eD.

Типичным примером множества допустимых управлений U яв-

является совокупность кусочно-непрерывных на отрезке [0, Т]

функций, таких, что а<и(/)<Ь при /е[0, Т]. При заданном

начальном состоянии у(О) = уо задача оптимального управления

может быть сформулирована следующим образом:

г

минимизировать \ а [у (/), и (/)] dt

о

при условиях у @ = <р [у (/), и (/)], / е= [0, Т],

Задачу оптимального управления с непрерывным временем

можно аппроксимировать задачей с дикретным временем. Пусть

отрезок планирования [0, Т] разбит на К периодов длительно-

длительности Д, т. е. /СД = Т. Обозначим у(&Д} через у*, а иFД)— через

и*. Тогда исходная задача аппроксимируется следующей:

к

минимизировать X <*(У/ь Щ)

при условиях Ул — Ул-п + фЛУа-ь u*), k = \, ..., /С,

ky k=ly ..., /С,

, Уь ..., У/с, «ь ..., U/c)^^.

Здесь начальное состояние уо задано.

Пример. Запуск ракеты. Рассмотрим задачу о запуске раке-

ракеты с поверхности земли до высоты у, которую ракета должна

достичь за время Г. Обозначим через уA) высоту, достигнутую

ракетой за время /, а через u{t) — силу, действующую на ра-

ракету в вертикальном направлении в момент t. Пусть масса ра-

ракеты равна т. Тогда уравнение движения имеет вид

1.2. ПРИМЕРЫ 21

Здесь y(t) —ускорение движения ракеты в момент времени t, a

g — ускорение свободного падения. Будем считать, что макси-

максимальная сила, прилагаемая к ракете в любой момент времени,

не провосходит Ь. Требуется вычислить минимальную энергию,

которую необходимо затратить для выведения ракеты на вы-

высоту у за время Т. Эта задача может быть сформулирована сле-

следующим образом:

минимизировать

при условиях

г

у

u{i)\di

{f) + mg = u{

| ы (/) К 6,

1). tt=

t<=

[0,

[0,

П

П

гдеу@) = 0.

Сформулированную задачу с одним дифференциальным

уравнением второго порядка можно переписать в эквивалентной

форме с двумя дифференциальными уравнениями первого по-

порядка с помощью следующей замены переменных. Пусть у\ = у,

f/2 = у. Тогда уравнение y+mg — u эквивалентно системе

уравнений

Ух в Уъ

g — и.

Таким образом, обсуждаемая задача принимает вид

г

минимизировать \\u{t)\dt

о

при условиях ух (t) = у2 (/), / е [0, Г],

МО =u{t)-mgy /e=[0, П

, Г],

Разделим отрезок [0, Т] на К интервалов длины А. Чтобы

Упростить запись, будем считать, что А=1. Обозначим силу,

Действующую на ракету, высоту полета над поверхностью и ско-

Рост ракеты в конце &-го периода соответственно через uk,

и у2> k- Тогда задачу оптимального управления полетом

22 ГЛ. I. ВВЕДЕНИЕ

ракеты можно аппроксимировать следующей задачей нелиней-

нелинейного программирования:

минимизировать

при условиях

к

iSi

У и k

Угл

1«*

г/i.o

г/ь/

l«ftl

-г/i.

1-1/2.

Кб,

= г/г,

к-1 = У2,к-Ь

k.i=uk~mg

о = О,

AJ — 1, • . .,

к == 1, . . .,

я,

Читателю, интересующемуся более подробным изложением

этой задачи, а также другими примерами задач оптимального

управления, можно рекомендовать книгу Luenberger [1969].

Пример. Строительство шоссе. Предположим, что требуется

проложить дорогу по неровной местности между двумя пунк-

пунктами, причем затраты на строительство пропорциональны ко-

количеству завезенного и вывезенного с трассы грунта. Пусть

Т — длина дороги, a c(t)—известная высота местности в точке

на расстоянии ?е[0, Т] от начального пункта трассы. Требуется

определить функцию */(/), описывающую высоту дороги в каж-

каждой ее точке t е [0, Т] и отвечающею минимальным затратам

на ее строительство. При этом предполагается, что наклон до-

дороги в любой точке трассы не должен превосходить величины

&ь т. е. \y(t) | <; &i для ^[0, Г]. Целесообразно также потре-

потребовать, чтобы скорость изменения наклона дороги не превышала

заданной величины Ь2, т. е. \y(t)\^b2 для t^[OyT]. Пусть

уровень дороги в начальном и конечном пунктах определяется

равенствами у@) = а и у(Т)=Ь. Задача формулируется сле-

следующим образом:

т

минимизировать \ | у (/) — с (t) | dt

о

при условиях | у (/) К &i, / е [0, Г],

/€=[0,Г],

Заметим, что параметром управления здесь является объем

грунта, вывезенный или завезенный в точку трассы на расстоя-

1.2. ПРИМЕРЫ 23

нии / от начального пункта, т. е. величина, пропорциональная

\y(t)-c(t)\.

Разделим теперь всю длину дороги на К интервалов длины

д каждый и положим ух == у, У2 = у. Для простоты будем счи-

считать, что А = 1. Обозначим с(k)y yx(k) и y2(k) через с*, #i,*.n

y2>k соответственно для ft=sl, ..., К. Тогда исходная задача

аппроксимируется следующей задачей нелинейного программи-

программирования:

к

минимизировать ? I У и k — ck I

при условиях уи k — yuk-i = У2, *-ь k = 1 > • • • > Ку

* = 0, 1, ..., К,

Более детальное рассмотрение этой задачи содержится в ра-

работе Citron [1969].

В. Проектирование строительных конструкций

Проектировщики строительных конструкций обычно много вни-

внимания уделяют проблеме совершенствования проектов, гаранти-

гарантирующих способность конструкции выдерживать требуемую на-

нагрузку. Понятие оптимальной конструкции определяется, как

правило, практикой и опытом проектировщиков. В последнее

время проектирование таких сложных конструкций, как, напри-

например, летательные аппараты, потребовало более подробного рас-

рассмотрения проблемы оптимальности проектов.

Основные подходы, используемые для минимизации веса

конструкций, основываются на математическом программирова-

программировании или других численных методах, используемых совместно с

методами структурного анализа. Линейное и нелинейное програм-

программирование и метод Монте-Карло являются основным аппаратом

численного анализа в задачах оптимального проектирования.

Проектирование сложных конструкций летательных аппара-

аппаратов обычно представляет собой многоэтапную процедуру, кото-

которая начинается с рассмотрения общих характеристик (эксплуа*

тационных качеств, производительности) системы и заканчи-

заканчивается детальным проектированием ее отдельных компонент.

Хотя все этапы проектирования в той или иной мере взаимосвя-

взаимосвязаны, накопленный опыт позволяет считать эти связи слабыми,

Так что в первом приближении ими можно пренебречь. Этот

24 ГЛ. I. ВВЕДЕНИЕ

Нагрузка. 1W

Высота хх

Сечение трубки у-у

L Расстояние между'точками

i опоры 2s

Рис. 1.3. Ферма.

вывод тем более справедлив, чем четче проведен предваритель-

предварительный структурный анализ, дающий основание для рационального

разбиения процесса проектирования на этапы.

Двухстержневая ферма. Рассмотрим один из этапов проек-

проектирования сложной строительной конструкции — проектирование

двухстержневой фермы минимального веса — и покажем, как

эта задача сводится к задаче нелинейного программирования.

Рассмотрим ферму, изображенную на рис. 1.3. Она состоит

из двух жестких полых трубок, скрепленных вместе на одном

конце. Вторые концы трубок зафиксированы в двух точках опо-

опоры, расстояние между которыми равно 2s. Задача проектиро-

проектирования заключается в выборе высоты, толщины стенок и сред-

среднего диаметра жестких трубок таким образом, чтобы ферма

была способна выдержать нагрузку в 2W и в то же время, что-

чтобы вес фермы был минимальным.

Обозначим средний диаметр трубок, толщину их стенок и

высоту фермы соответственно через хи х2 и Хз. Тогда вес фермы

определяется по формуле 2ярххх2 (s2 + *2I/2, где р — удельный

вес материала, из которого изготовлена трубка. Из содержа-

содержательных соображений при проектировании необходимо учиты-

учитывать следующие условия:

1. Из-за ограниченности габаритов конструкции высота фер-

фермы не должна превышать 6i, т. е. л:3 ^ Ь\.

2. Отношение среднего диаметра трубки к толщине ее сте-

стенок не должно превышать Ь2у т. е. Х\/х2 <с b2.

3. Напряжение сжатия в жестких трубках не должно превы-

превышать возможности материала, из которого изготовлены трубки.

Это условие формально записывается в виде неравенства

W (s2 + лф1/2 < b^x{x2xv где Ьг — некоторая константа.

1:2. ПРИМЕРЫ 25

4. Высота, диаметр и толщина стенок трубок должны быть

такими, чтобы трубки не изгибались под тяжестью груза, т. е.

должны удовлетворять неравенству W(s2 + *зK#2^*^4г1*з(*? ^" *!)»

где Ьа — известный параметр.

Таким образом, выбор оптимального проекта фермы пред-

представляет собой следующую задачу нелинейного программиро-

программирования:

минимизировать ххх2 (s2 + xf)m

при условиях #з — Ъ\ < О,

Х\ —

W

Х\у

С. Проектирование механических конструкций

В проектировании механических конструкций концепция опти-

оптимизации может быть использована совместно с традиционными

подходами статики, динамики и теории сопротивления материа-

материалов. В работах Asimow [1962], Johnson [1971] и Fox [1971] при-

приведены различные примеры .оптимального проектирования ме-

механических конструкций, использующего математическое про-

программирование. Как указывает Джонсон (Johnson [1971]), при

проектировании механизмов для высокоскоростных машин не-

невозможно исключить значительные динамические напряжения

и вибрации. Это значит, что необходимо проектировать некото-

некоторые механические элементы так, чтобы минимизировать эти

нежелательные воздействия. Следующий пример является. ил-

иллюстрацией применения нелинейного программирования для

проектирования двухопорнои цапфы.

Проектирование цапфы. На рис. 1.4 изображена двухопор-

ная цапфа с длиной каждой опоры L. Цапфа поддерживает

маховик веса IF, установленный на оси диаметра D. Требуется

определить L и D таким образом, чтобы минимизировать мо-

момент трения вращающейся оси при допустимом зазоре на смаз-

КУ- Смазка позволяет сохранить масляное покрытие между

цапфой и осью, служащее для уменьшения момента трения и,

следовательно, для ограничения рассеиваемой тепловой энер-

энергии. Это необходимо для увеличения срока действия опоры.

Пусть h0 — наименьшая толщина масляного покрытия при

26 ГЛ. 1. ВВЕДЕНИЕ

1

т

Цапфа *-

—>

I

—

Маховик

1

t

Рис. 1.4. Двухопорная цапфа.

установившемся режиме работы механизма. Имеет место нера-

неравенство

где Но — минимальная толщина масляного покрытия, предупреж-

предупреждающая контакт металла с металлом, б — радиальный зазор,

измеренный как разность между радиусом цапфы и радиу-

радиусом оси.

Другое ограничение на Ло налагается следующим неравен-

неравенством:

где е — эксцентриситет конструкции, определяемый как е =

= A —ho/8), а ё — заданный его верхний предел.

В зависимости от точки, к которой прикладывается вращаю-

вращающий момент на оси, природы силы вращения и отношения мо-

модуля приращения эластичности к максимальному напряжению

сдвига можно так определить константу ku что угол кручения

оси задается соотношением

I

kx6 *

Момент трения яля двух опор вычисляется по формуле

где k2 — константа, зависящая от вязкости применяемого масла,

(о —угловая скорость вращения. Из гидродинамических сооб*

ражений безопасная нагрузка на опоры определяется соотноше»

нием

1.2. ПРИМЕРЫ 27

где кг — константа, зависящая от вязкости масла, а

гт\ ('о\ - ______—— Гтг2 /1 _ /?2\ I 1 Лл211/2

vt/ \с? / **' * /1 2\2 L V ^ С? / | 1 >JC? I •

Очевидно, что вес маховика и нагрузка на опоры должны быть

связаны неравенством 2с ^ W.

Таким образом, при заданных б, #о и ё получаем типичную

задачу проектирования элемента механической конструкции:

найти D, L и Ао, такие, чтобы минимизировать момент трения,

не допуская выхода угла кручения оси за допустимый предел а.

Формально модель описывается следующим образом:

минимизировать —-. DaL

6 Vl— е

1 .

при условиях Т7Г^а'

Более подробное обсуждение этой задачи можно найти в ра-

работе Asimov [1962]. Можно построить также модель, в которой

минимизируется угол кручения оси при условии, что момент

трения не выходит из заданных пределов. В целевую функцию

можно включить также как момент трения, так и угол кручения

оси. Весовые коэффициенты, отражающие важность каждого

фактора, должны быть выбраны из содержательных сообра-

соображений.

D. Электрические цепи

Хорошо известно, что равновесное состояние электрической или

гидравлической цепи достигается при минимальных общих по-

потерях энергии. Деннис, по-видимому, был первым, кто исследо-

исследовал взаимоотношения между теорией электрических цепей, ма-

математическим программированием и двойственностью. Приве-

Приведенное ниже обсуждение этого вопроса основано на первой

работе Dennis [1959].

Электрическая схема может быть описана, например, п вет-

ветвями, связывающими m узлов. В дальнейшем будет рассматри-

рассматриваться цепь постоянного тока и предполагаться, что каждая

ветвь и узлы, которые она соединяет, содержат только один из

Перечисленных ниже элементов.

28 ГЛ. 1. ВВЕДЕНИЕ

¦i*

(о)

Рис. 1.5. Элементы электрической цепи, а — источник напряжения; Ь — диод;

с — сопротивление.

1) Источник напряжения, который поддерживает в ветви

постоянное напряжение vs независимо от тока в ветви cs. Такой

элемент поглощает мощность, равную — vscs.

2) Диод, который позволяет току в ветви течь только в од-

одном направлении и потребляет нулевую мощность независимо

от тока Са и напряжения va в ветви. Таким образом, для диода

имеем

0, vdcd = 0. A.1)

3) Сопротивление, на котором поглощается мощность. На

этой ветви ток сг и напряжение vr связаны равенством

Vr=*-rcn A.2)

г—величина сопротивления. Поглощаемая мощность равна

Эти три элемента схематически изображены на рис. 1.5. Те-

Течение тока на диаграмме показано от отрицательного полюса

ветви к положительному. Первый называется входным узлом,

а второй — конечным (выходным) узлом ветви. Если ток течет

в противоположном направлении, то соответственное направле-

направление будет отрицательным. Для диода оно недопустимо. То же

самое соглашение принято о знаке напряжения в ветви.

Цепь, состоящая из нескольких ветвей, может быть описана

с помощью матрицы N соединений узлов, номера строк которой

соответствуют узлам, а номера столбцов — ветвям. Элементы пц

матрицы N задаются как

!— 1, если узел / — вход /-й ветви,

1, если узел / — выход у-й ветви,

О в остальных случаях.

Рассмотрим цепь с несколькими источниками напряжения,

диодами и сопротивлениями. Обозначим через Ns матрицу сое-

соединений узлов для всех ветвей с источниками напряжения, че-

1.2. ПРИМЕРЫ 29

рез Nd —для всех ветвей с диодами и через NU —-для всех вет-

ветвей с сопротивлениями. Тогда, не теряя общности, можно пред-

представить матрицу N в виде

Соответственно вектор-столбец с, представляющий токи в вет-

ветвях, и вектор-столбец напряжений v можно записать как

С каждым узлом / связан узловой потенциал pi. Вектор-

столбец р узловых потенциалов можно также записать в виде

Равновесное состояние цепи достигается при выполнении

следующих трех основных законов.

Первый закон Кирхгофа, Сумма всех входящих в узел токов

равна сумме всех вытекающих из него токов. Этот закон можно

формально записать в виде Nc = 0, или

N5c5 + NDcD+N^ = 0. A.4)

Второй закон Кирхгофа. Разность потенциалов узлов, соеди-

соединяемых данной ветвью, должна быть равна напряжению в этой

ветви. Это можно формально записать в виде равенства Nrp =

= v, или

A.5)

Кроме того, имеются соотношения, представляющие собой ха-

характеристики электрических устройств. Из A.1) имеем для со-

совокупности диодов

vD>0, Сд>0, v?cD = O, A.6)

а из A.2) для сопротивлений —

v* = -Rc*f A.7)

где R — диагональная матрица с диагональными элементами,

равными значениям сопротивлений.

Соотношения A.4) — A.7) описывают равновесное состояние

схемы. Задача состоит в нахождении Vz>, V/?, сир, удовлетво-

удовлетворяющих этим соотношениям.

30 ГЛ. 1. ВВЕДЕНИЕ

Рассмотрим теперь задачу квадратичного программирова-

программирования, которая подробно разбирается в § 11.2:

минимизировать у cJJRc^ ~~ yscs

при условиях Nscs + NDcD + N^ = 0,

- cD <0.

Здесь требуется определить токи cs, Cd и cr в ветвях, которые

минимизируют сумму двух слагаемых. Первое слагаемое равно

половине мощности, поглощаемой сопротивлениями, а второе —

потери мощности на источнике напряжения. В § 4.3 показано,

что условия оптимальности для этой задачи можно записать

в виде

Nscs + NDcD + МдСд = 0,

Cjd, U0 > 0,

где u и u0 — векторы множителей Лагранжа. Легко проверить,

что если положить vd = Uo, p = и и учесть A.7), то эти условия

в точности совпадают с соотношениями A.4) — A.7), описываю-

описывающими равновесное состояние цепи. Заметим, что вектор множи-

множителей Лагранжа и есть в точности вектор потенциалов р в узлах.

С рассмотренной задачей связана другая, называемая двой-

двойственной задачей:

максимизировать — у

при условиях ?

Здесь G = R-1—диагональная матрица, составленная из зна-

значений проводимостей, vs — фиксированный вектор.

~ Величина v^Gv^ определяет мощность, поглощаемую сопро-

сопротивлениями. В последней задаче требуется найти распределение

напряжений в цепи \D и vr и вектор потенциалов р.

Условия оптимальности для этой задачи также совпадают с

A.4) —A.7). Кроме того, токи в ветвях являются множителями

Лагранжа.

1.2. ПРИМЕРЫ 31

Интересно отметить, что в силу теоремы 6.2.4 — основной

теоремы двойственности — оптимальные значения целевых функ-

функций этих задач совпадают, т. е.

, 1

Поскольку G = R и выполняются A.6) и A.7), это равенство

можно привести к виду

что представляет собой не что иное, как закон сохранения

энергии.

Существуют и другие применения математического програм-

программирования при решении задач, связанных с выработкой и рас-

распределением электрической энергии. Краткое обсуждение вме-

вместе с необходимыми ссылками приведено в комментариях в

конце главы.

Е. Управление водными ресурсами

Здесь представлена модель использования водных ресурсов для

выработки электроэнергии и для применения в сельском хозяй-

хозяйстве. Рассмотрим бассейн реки, схематически изображенной на

рис. 1.6.

Плотина, перегораживающая реку, создает благоприятные

условия для накопления объема воды, которую можно исполь-

использовать для выработки энергии и для нужд сельского хозяйства.

Предполагается, что с плотиной связана электростанция и что

вода для сельского хозяйства может передаваться от плотины

непосредственно или после выработки энергии через канал.

В этой задаче рассматриваются два класса переменных.

1. Параметры проекта: объем S водохранилища, пропускная

способность U канала для отведения воды на сельскохозяйст-

сельскохозяйственные нужды и мощность Е электростанции.

2. Параметры управления: объемы воды, направляемые на

нужды сельского хозяйства, на выработку энергии и прочие

цели.

Из рис. 1.6 видно, что для /-го периода могут быть опреде-

определены следующие параметры управления:

xf — объем воды, отведенной от плотины для нужд сель-

сельского хозяйства;

хра _ объем воды на выработку энергии с последующим

использованием в сельском хозяйстве;

*fM —- - объем воды на выработку энергии с последующим

Извращением в реку;

xf — объем воды, отведенной от плотины снова в реку.

32 ГЛ. 1. ВВЕДЕНИЕ

Плотина

Канал.

Сельекохозяй-

ственные

площади

Рис. 1.6. Бассейн реки.

Рассмотрим модель управления водными ресурсами с гори-

горизонтом планирования, равным N периодам. Обычно горизонт

планирования принимается равным времени окупаемости основ-

основных капиталовложений. Цель управления состоит в минимиза-

минимизации полных приведенных затрат на сооружение водохранилища,

электростанции и канала минус годовой доход от производства

энергии и орошаемого сельского хозяйства. Составляющие за-

затрат и доходов обсуждаются ниже.

Затраты на электростанцию. Затраты на электростанцию

равны

С(?) + ЕрД(Я), A.8)

где С(Е)— 3atpaTbi, связанные с сооружением электростанции

и линии передачи энергии, рассчитанных на мощность ?;

Се(Е) — ежегодные затраты на эксплуатацию, ремонт и замену

оборудования; Р/— коэффициент дисконтирования, который при-

приводит к текущему моменту затраты в периоде /. В работе Мо-

basheri [1968] описана природа функций С(Е) и Се(Е).

Дисконтированный доход от продажи энергии выражается

в виде

S Р/ [p,F, + Pd (/,

+ A - б)

Z

- Ps (Pi - //)]}

A.9)

1.2. ПРИМЕРЫ 33

где Fj — известный устойчивый спрос на энергию, которая мо-

может быть продана по ценам pf за 1 кВт, // — фактическое про-

производство энергии (в киловаттах). Коэффициент б равен 1, если

ffZ>Fj> и этот избыток энергии f}- — F}- может быть продан по

низким ценам ра за 1 кВт. С другой стороны, б = 0, если

// < F/, и с системы управления водными ресурсами взимается

штраф ps(Fj — f/), так как энергия должна быть приобретена

из других сетей.

Затраты на водохранилище и канал. Дисконтированные за-

затраты на строительство водохранилища и канала равны

Cr(S) + aCe(U), A.10)

где Cr(S) — затраты на водохранилище объема 5, Ce(U)—за-

Ce(U)—затраты на основной канал пропускной способности U. Здесь коэф-

коэффициент а оценивает срок службы канала по сравнению со сро-

сроком службы водохранилища.

Дисконтированные затраты на управление равны

?$}[r() ()} A.11)

Обсуждение структуры этих функций можно найти в работах

Mobasheri [1968] и Maass et al. [1967].

Доход от орошения. Урожай, полученный при орошении, вы-

выражается как функция R от количества воды, затраченной на

орошение в период /. Вид функции приведен в работе Minhas,

Parikh, Srinivasan [1974]. Таким образом, доход от сельского

хозяйства равен

Z^jR(xf + x^). A.12)

Здесь для простоты мы пренебрегаем водой, полученной от

дождей.

После того как были рассмотрены разные составляющие це-

целевой функции, перейдем к обсуждению ограничений.

Ограничения, связанные с производством энергии. Очевидно,

что количество вырабатываемой энергии не может превышать

энергетического потенциала водных ресурсов, т. е.

где \f)(s/) — гидростатический напор, создаваемый количеством

воды 5/, запасенным в водохранилище в период /, у — коэффи-

коэффициент превращения энергии, е —эффективность энергетической

системы. Природа функции г|) описана в работе O'Laoghaire,

Himmelblau [1974].

2 М. Базара, К- Шетти

34 ГЛ 1. ВВЕДЕНИЕ

Произведенная энергия не может превосходить производ-

производственных мощностей электростанции, так что

ft^djEeHj, A.14)

где а/ — коэффициент нагрузки, определяемый как отношение

среднесуточного производства энергии к максимальному суточ-

суточному производству, Я/ — количество часов эксплуатации си-

системы.

Наконец, мощность электростанции лежит в известных пре-

пределах, т. е.

?'<?<?". A.15)

Ограничения, связанные с водохранилищем. Если пренебречь

потерями от испарения, то объем воды уи составляющей сток

через плотину, должен равняться изменению в объеме, запасае-

запасаемом в водохранилище и реализованном для различных целей.

Это ограничение можно записать в виде равенства

в1+1~8; + х1 + ху + х™ + хГА = уг AЛ6)

Вторая группа ограничений устанавливает, что размеры во-

водохранилища достаточны и выбраны в требуемых пределах, т. е.

S>sh m A.17)

S'<S<S". A.18)

Ограничение, связанное с обязательным возвратом части

воды. Обычно необходимо точно установить некоторый объем

воды Af/, который требуется возвратить в реку. Это требование

обязательного возврата воды записывается в виде

xf + x™^Mr A.19)

Ограничение, связанное с пропускной способностью канала.

Последнее, что требуется учесть, это то, что пропускная способ-

способность канала V должна быть достаточной, чтобы обеспечить

удовлетворение сельскохозяйственных нужд. Формально это

ограничение имеет вид

xf + xfA^U. A.20)

Цель состоит в минимизации чистых затрат, равных сумме

выражений A.8), A.10) и A.11) минус доходы, определяемые

по формулам A.9) и A.12). Ограничения задачи задаются соот-

соотношениями A.13) — A.20) и требованием неотрицательности пе-

переменных.

1.2. ПРИМЕРЫ 35

F. Распределение ресурсов в условиях

неполной информации

Рассмотрим следующую задачу линейного программирования:

максимизировать сгх

при условиях Ах<Ь,

х>0,

где сих суть д-мерные векторы, b есть m-мерный вектор,

А = [аь ..., Sin]—матрица размера тХп. Эту задачу можно

интерпретировать как модель распределения ресурсов. Предпо-

Предположим, что имеется т ресурсов в количествах, задаваемых век-

вектором Ь. Столбец а/ матрицы А характеризует /-й способ произ-

производства, переменная х\ представляет собой интенсивность этого

способа производства, которая подлежит выбору. При исполь-

использовании /-го способа производства с интенсивностью х\ за-

затрачивается dijXj различных ресурсов. Следовательно, Ах =

п

= 2 а/Х/ <Ь. Если доход от /-го способа производства, исполь-

зуемого с единичной интенсивностью, равен с/, то общий доход

п

при интенсивностях я/, / = 1, ..., м, равен ? CjXj = cTx. Сле-

Следовательно, рассматриваемая задача может быть интерпретиро-

интерпретирована как задача распределения вектора ресурсов b между раз-

различными производственными способами таким образом, чтобы

получить максимально возможный суммарный доход.

Для некоторых практических задач такая детерминирован-

детерминированная модель неадекватна реальности, так как коэффициенты до-

дохода си ..., сп являются не фиксированными, а случайными

параметрами. Предположим, что с — случайный вектор с мате-

математическим ожиданием с = (си ..., сп)т и ковариационной ма-

матрицей V. Тогда значение целевой функции также будет случай-

случайной величиной (обозначим ее через г) с математическим ожи-

ожиданием с7х и дисперсией x7Vx.

Для того чтобы максимизировать ожидаемое значение z,

нужно решить следующую задачу:

максимизировать стх

при условиях А

которая является задачей линейного программирования и обсу-

обсуждается в § 2.6. С другой стороны, если требуется минимизировать

2*

36 ГЛ. 1. ВВЕДЕНИЕ

дисперсию 2, то нужно решить задачу

минимизировать xrVx

при условиях А

х>0,

которая является задачей квадратичного программирования и

обсуждается в § 11.2.

Критерии удовлетворительности

При максимизации ожидаемого дохода z мы полностью пре-

пренебрегали его рассеянием. С другой стороны, когда минимизи-

минимизировалась дисперсия, не принималось во внимание ожидаемое

значение 2. В реальных задачах может возникнуть потребность

иметь большое ожидаемое значение дохода и в то же время

малую дисперсию. Это многоцелевая задача. Имеются некото-

некоторые работы по исследованию таких задач (см. Zeleny [1974],

Zeleny, Cochrane [1973]). Существуют и другие подходы к одно-

одновременному изучению ожидаемых значений и их рассеяния.

Предположим, требуется, чтобы ожидаемое значение было не

меньше некоторого значения 2, чаею называемого желаемым

уровнем или уровнем удовлетворительности. Такая задача мо-

может быть сформулирована в виде

минимизировать xrVx

при условиях Ах^Ь,

СГХ > 2,

х>0,

которая снова является задачей квадратичного программи-

программирования.

Другой возможный подход состоит в следующем. Пусть а =

= Prob (crx ^ 2), т. е. а — вероятность того, что желаемый

уровень может быть достигнут. Очевидно, целесообразно макси-

максимизировать а. Предположим теперь, что вектор случайных па-

параметров с можно представить как функцию d + г/f, где d и f —

фиксированные векторы, а у — случайная переменная. Тогда

если frx > О, то

Prob (drx + yfTx > 2) == Prob (у

z

1.2. ПРИМЕРЫ 37

В этом случае задача максимизации а сводится к следующей:

минимизировать

при условиях

Это задача дробно-линейного программирования, методы реше-

решения которой обсуждаются в § 11.4.

Модель распределения ресурсов

при заданном отношении к риску

Описанные выше подходы к оптимизации дисперсий и ожи-

ожидаемых значений дохода не учитывают поведение индивидуумов,

не желающих рисковать. Например, индивидуум, который хочет

избежать риска, может предпочесть доход с ожидаемым значе-

значением дохода в 100 долларов и дисперсией 10 доходу с ожидае-

ожидаемым значением в 110 долларов и дисперсией 30. Индивидуум,

выбирающий ожидаемое значение дохода 100 долларов, менее

расположен к риску, чем тот, кто может выбрать альтернативу

с ожидаемым значением дохода 110 долларов. Эта разница в

отношении к риску может быть учтена введением полезности

денег для индивидуума.

Для большинства индивидуумов ценность дополнительного

доллара убывает при увеличении его полного чистого богатства.

Ценность, связанная с чистым богатством г, называется его по-

полезностью и. Часто бывает удобно так нормировать полезность,

чтобы и —0 при 2 = 0 и и-+\ при 2->оо. Функция и, назы-

называемая функцией полезности индивидуума, обычно неубываю-

неубывающая непрерывная функция. На рис. 1.7 изображены две типич-

типичные функции полезности для двух индивидуумов. Для инди-

индивидуума (а) увеличение дохода на Аг увеличивает полезность

на Аь а потери дохода Д-г уменьшают полезность на Дг. По-

Поскольку Д2 больше, чем Аь то этот индивидуум будет предпочи-

предпочитать меньшее рассеяние дохода. Такой индивидуум меньше рас-

расположен к риску, чем индивидуум (&), функция полезности ко-

которого также изображена на рис. 1.7.

Различные кривые типа кривых (а) и F), изображенных на

рис. 1.7, могут быть заданы в форме

u{z) = 1 — e~kz,

где k > 0 называют коэффициентом неприятия риска. Заметим,

что чем больше ft, тем индивидуум менее расположен к риску.

Предположим теперь, что текущее богатство равно нулю,

так что полное богатство равно доходу г. Предположим, что

38 ГЛ. I. ВВЕДЕНИЕ

2*= Полное богатство

1.7. Функции полезности.

с — нормально распределенный случайный вектор с математиче-

математическим ожиданием с и ковариационной матрицей V. Тогда z— нор-

нормальная случайная величина с математическим ожиданием z =

= стх и дисперсией о2 = —хт\х. Функция ср плотности и рас-

распределения дохода записывается в виде

Ф (z) = _ ехр (

Требуется максимизировать ожидаемое значение полезности,

задаваемое выражением

ехр (-Л* + y

J ехр (

dz =

- ехр (- kz + y

Следовательно, максимизация ожидаемого значения полезности

эквивалентна максимизации kz —jk2o2. Подставляя сюда

1.2. ПРИМЕРЫ 39

олучим следующую

тичного программирования:

вместо z н а2 их значения, получим следующую задачу квадра-

квадрамаксимизировать kcTx —г- k2xTWx

при условиях А^Ь

G. Размещение оборудования

На практике часто встречаются задачи оптимального размеще-

размещения центров производственной деятельности. К таким задачам

относятся задачи размещения станков или цехов на фабрике,

задачи размещения фабрик или складов, с которых продукция

может быть отправлена в торговые центры или потребителям,

задачи размещения пожарных или полицейских постов на тер-

территории города и др.

Рассмотрим простую ситуацию. Пусть задано расположение

п рынков и спрос на каждом из них. Спрос может быть удов-

удовлетворен из т складов с заданной емкостью. Требуется разме-

разместить склады так, чтобы общее расстояние, подсчитанное с ве-

весовыми коэффициентами, равными объемам товаров, перевезен-

перевезенных из складов на рынки, было минимальным. Более точно,

пусть

{*ь Уд — неизвестные координаты склада /, /=1, ..., т,

сг —емкость склада /, /=1, ..., т,

(a/, bj) — известные координаты рынка /, /=1, ..., п,

г/ —-известный спрос на рынке /, /=1, ..., п,

йц —расстояние от склада / до рынка у, /=1, ..., ш,

/= 1, ..., п,

Wn — объем продуктов, перевозимых со склада / на ры-

рынок /, / = 1, ..., т, j = 1, ..., п.

Задачу размещения складов и выбора объемов перевозок

можно сформулировать следующим образом:

т п «

минимизировать 2 2

п

При УСЛОВИЯХ 2*0

т

Z^// = r/, /= 1, ..., /г,

40 ГЛ. 1. ВВЕДЕНИЕ

В этой задаче неизвестными переменными являются тмц и йц,

гак что это задача нелинейного программирования. Могут быть

приняты различные способы измерения расстояния, например

йц = \Xi-ai\ + \ yt - bj |, dif = [(xt - ajf + {yt - Ь,J]™.

При этом будем получать нелинейные задачи с переменными

Хи ..., хт, у\, ..., ym, w\\, •-., wmn. Если расположение скла-

складов известно, т. е. известны д,ц, то искомыми останутся только

объемы перевозок wtj. Мы придем к транспортной задаче — част-

частной модели линейного программирования.

Упражнения

1.1. Рассмотрим задачу выбора портфеля ценных бумаг*). Вкладчик

должен выбрать портфель х = (хи *г, ..., хп)т, где Х\ — доля актива, вло-

вложенного в ценные бумаги вида__/. Доход от портфеля имеет среднее значение

стх и дисперсию xrVx. Здесь с — вектор средних значений доходов от каж-

каждого вида бумаг, V — матрица вторых моментов этих доходов. Вкладчик

хотел бы увеличить ожидаемый доход, уменьшая при этом рассеяние и, сле-

следовательно, риск. Портфель называется эффективным, если не существует

другого портфеля с большим ожидаемым доходом и меньшим рассеянием.

Сформулируйте задачу нахождения эффективного портфеля и предложите

процедуры выбора среди эффективных портфелей.

1.2. Прямоугольный сохраняющий тепло элемент длины L, ширины W и

высоты Я может использоваться для того, чтобы запасать тепловую энергию.

Коэффициенты потерь тепла из-за конвекции hc и из-за излучения hr за-

задаются соотношениями

Здесь kc, kr — константы, Т — температура сохраняющего тепло элемента,

А — площадь поверхности, Та — температура окружающей среды. Тепловая

энергия, запасаемая элементом, равна

где k — константа, V — объем элемента. Элемент в состоянии запасти по

крайней мере Q' единиц энергии. Условия размещения ограничивают размеры

элемента, так что

a) Сформулируйте задачу нахождения размеров L, W и Я, при которых

потери тепла минимальны.

b) Предположим, что константы kc и kr являются линейными функциями

от t — толщины изоляции. Сформулируйте задачу нахождения размеров L, W

и Я, при которых издержки на изоляцию минимальны.

1.3. Постройте модель ситуации, описанной в упр. 1.2, когда элемент, со-

сохраняющий тепло, является цилиндром с диаметром D и высотой Я.

1.4. Служебное помещение длиной 60 футов и шириной 35 футов должно

освещаться п электрическими лампами, каждая мощностью Wi Вт, i = 1, ...

..., п. Лампы должны быть расположены на высоте 7 футов от рабочей

4) Здесь слово «портфель» используется в том же смысле, что и в вы-

выражении «редакционный портфель» и т. п. — Прим. перев.

УПРАЖНЕНИЯ 41

поверхности. Пусть (xi, yi)—координаты i'-й лампы. Чтобы обеспечить до-

достаточное освещение, освещенность проверяется на уровне рабочей поверхно-

поверхности в узлах (а, Р) сетки, где

а=10/>, р = 0, 1 6; Р = 5<7, <7 = 0, 1 7.

Освещенность в точке (а, Р), получаемая от лампы мощности Wi Вт, рас-

расположенной в точке (xt, yi), равна

где k — константа, отражающая эффективность лампы. Общая освещенность

п

в точке (а, C) равна ^ Ei (a, Р). В каждой проверяемой точке требуется,

чтобы освещенность была в пределах от 2.6 до 3.2 единицы. Мощность ис-

используемых ламп выбирается в пределах от 40 до 300 Вт. Предполагается,

что Wi — непрерывные переменные.

a) Постройте модель, в которой минимизируется число используемых

ламп и определяется их размещение и мощность в предположении, что потери

от их установки и периодической замены являются функцией от числа ис-

используемых ламп.

b) Постройте такую же, как и в п. «а», модель, удовлетворяющую до-

дополнительному требованию одинаковой мощности всех ламп.

c) Определите значение k из специальной литературы. Проверьте, явля-

является ли освещение в вашей рабочей комнате в разумной степени близким

к тому, что получено в п. «Ь».

1.5. Семья с бюджетом Ь покупает п продуктов. Цена единицы /-го про-

продукта равна с/, а минимальное количество этого продукта, которое будет

куплено, — //. После того как эти минимальные количества продуктов потреб-

потреблены, оставшийся бюджет распределяется между продуктами. Часть щ от

оставшегося бюджета используется на покупку продукта /*. Поведение семьи

наблюдается в течение т месяцев с целью оценки величин /i, ..., In и

ai, ..., ап. Постройте регрессионную модель для оценки этих параметров,

если

a) требуется минимизировать сумму квадратов ошибок;

b) требуется минимизировать максимальное абсолютное значение ошибки;

c) требуется минимизировать сумму абсолютных значений ошибок;

d) Переформулируйте задачи из пп. «Ь» и «с», чтобы получить задачи

линейного программирования.

1.6. Некоторая сталелитейная компания производит коленчатые валы.

Предварительное исследование показывает, что средний диаметр вала может

принимать значения [mi или |х2, где jj-2 > M-i. Вероятность того, что среднее

значение равно juii, есть р. Чтобы проверить, является ли средним значением

M-i или |Лг, проводится выборка объема п и соответствующие диаметры

п

*и ..., хп записываются. Если х = — У.Х1 не больше некоторого фиксиро»

У-1

ванного К, то принимается гипотеза \х == |Л4. В противном случае принимается

гипотеза ^ = 1^2. Пусть f(x\\ii) и f(x\\i2)— плотность распределения выбо-

выборочного среднего, если математическое ожидание равно \Xi или (Лг соответ-

соответственно. Предположим, кроме того, что взыскиваемые издержки при приня-

принятии гипотезы м- = fJti, когда \х = м,2, равны а, а при принятии гипотезы

М- = \х2, когда \i = \iu равны |3. Сформулируйте задачу выбора К так, чтобы

ожидаемые общие издержки были минимальными. Покажите, как эта задача

может быть переформулирована, чтобы получить нелинейную задачу.

42 ГЛ. 1. ВВЕДЕНИЕ

1.7. Рассмотрим следующую задачу районного контроля над стоком реки.

Пусть п предприятий сбрасывают отходы в реку. Принятый текущий коэффи-

коэффициент сбрасывания отходов /-м предприятием равен (i/, / = 1, ..., п. Каче-

Качество воды проверяется на протяжении реки в т пунктах контроля. Наимень-

Наименьшее требуемое улучшение качества воды в пункте i равно 6/, i= 1, ..., m.

Пусть Xj — объем отходов, подлежащих очистке на предприятии /. Соответ-

Соответствующие затраты /-го предприятия равны //(*/). Обозначим через ац улуч-

улучшение качества воды в пункте контроля i для каждой единицы отходов,

очищенных на предприятии /.

a) Сформулируйте задачу улучшения качества воды с минимальными по-

потерями как задачу нелинейного программирования.

b) Пусть некоторые предприятия должны очищать значительные количе-

количества отходов, а другие только небольшую их часть или вовсе ничего. Пере-

Переформулируйте задачу так, чтобы добиться некоторой справедливости.

1.8. Лифт имеет в момент времени / вертикальное ускорение u(t). Пасса-

Пассажиры хотели бы подняться от цокольного этажа, находящегося на нулевой

высоте над уровнме моря, до шестнадцатого этажа, находящегося на высоте

50 м над уровнем моря, по возможности быстрее, но так, чтобы не испыты-

испытывать сильного ускорения. Предположим, что пассажир оценивает единицу вре-

времени в а долларов и готов заплатить в единицу времени сумму рм2(/),

чтобы избежать сильного ускорения Учитывая эти условия, сформулируйте

задачу определения ускорения «(/) лифта на участке от цокольного до шест-

шестнадцатого этажа как задачу оптимального управления. Можно ли сформули-

сформулировать эту проблему как задачу нелинейного программирования?

1.9. Рассмотрим задачу линейного программирования, состоящую в мини-

минимизации сгх при Ах ^ Ь, х ^ 0. Предположим, что компоненты с\ вектора

с — случайные величины, распределенные независимо друг от друга и от пере-

переменных X/, и что ожидаемые значения с\ равны с/, / = 1, ..., я.

a) Покажите, что минимальные ожидаемые потери получаются при реше-

решении задачи минимизации сгх при Ах ^ Ь, х ^ 0, где с — (сь ..., сп)Т.

b) Предположим, что некоторая фирма выпускает два продукта, затра-

затрачивая на их производство общий ресурс. Формально это выражается сле-

следующим образом:

3 + 4 20

где х}- — объем выпускаемого /-го продукта. Доход от выпуска единицы пер-

первого продукта является нормально распределенной случайной величиной со

средним значением 3 и дисперсией 2. Доход от выпуска единицы второго

продукта задается ^-распределением с двумя степенями свободы. Предпо-

Предположим, что случайные величины распределены независимо друг от друга

и что они не зависят от xi и Хг. Найдите объемы выпуска каждого продук-

продукта, при которых ожидаемый доход будет максимальным. Будет ли решение

другим, если дисперсия для первого продукта будет равна 4?

1.10. Пусть в каждом из п периодов известен спрос du ..., dn на неко-

некоторый продукт. Для удовлетворения спроса в /-м периоде может быть ис-

использован как произведенный в этом периоде, так и хранимый на складе

продукт. В /-м периоде выпускается х\ единиц продукта. При этом производ-

производственные затраты задаются функцией /(#/), / == 1, ,.., п. Выпущенный в не-

некотором периоде в избытке продукт можно хранить на складе. Емкость скла-

склада равна К, а стоимость хранения единицы продукта в течение одного пе-

периода равна с долларам. Сформулируйте задачу планирования производства

как задачу нелинейного программирования, считая заданным начальный за-

запас /о, хранимый на складе.

1.11. Некая промышленная фирма производит четыре различных про-

продукта. При этом один из видов необходимого сырья имеет ограниченное

предложение, и фирма может получить его в количестве не более R фун-

фунтов. Для выпуска одного фунта t-rc продукта используется щ фунтов этого

КОММЕНТАРИИ 43

сырья. Переменные издержки, включающие и затраты сырья, при производ-

производстве Xt фунтов /-го продукта равны кьх\, коэффициент ki известен. Про-

Продажная цена 1-го продукта равна Sr долларам за фунт. Постройте математи-

математическую модель планирования производства.

1.12. Предположим, что суточный спрос на /-й продукт равен rf/, / = 1,2.

Спрос удовлетворяется из запасов на складе, которые пополняются производ-

производством, как только запасы исчерпываются. Время производства и доставки про-

продуктов на склад предполагается несущественным. В течение каждого периода

может быть произведено Q/ единиц продукта при фиксированных организа-

ционых затратах в kj долларов и переменных затратах в c,Qj долларов. Пла-

Плата за хранение запасов равна h/ долларов за единицу продукта в день. Плата

за хранение взимается, исходя из среднего запаса за Т дней. Таким образом,

общие затраты, связанные с /-м продуктом, за Т дней равны Tdjkj/Qj +