Author: Цыпкин Я.З.

Tags: регулирование и управление машинами, процессами теория автоматического управления

Year: 1968

Text

Я. 3. и ы п к и н

..даптация

и обучение

в автоматических

Я. 3. цыпкин

Адаптация

и обучение

в автоматических

системах

ИЗД АТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1968

6.П2.151 Адаптация и обучение в автоматических

ц 96 системах, Я. 3. Ц ы л к п н, Главная

V7IK Г'> Ч) редакция физико-математической лите-

^ дп u_-ju ратуры изд-ва «Паука», М., 19(38, 400 стр.

Проблемы адаптации и обучения, которые

рассматриваются в кнше, являются

центральными в современной теории и технике

автоматического управления. Решение этих проблем

позволяет осуществлять оптимальное

управление сложными объектами, в условиях весьма

малoii априорной информации относительно

состояния управляемого объекта и его

характеристик.

В кише с единой общей точки зрения,

основанной на вероятностных итеративных методах,

обсуждаются разнообразные задачи адаптации

и обучения и приводятся эффективные пути их

решения. Рассмотрены алгоритмические методы

решения задач обучения опознаванию образов,

определения характеристик динамических

объектов, обнаружения и выделения сигналов па

фоне поче\', управления динамическими

объектами и условиях неопределенности. Развитый

подход применен также к решению задач

теории надежности, исследованию операции, теории

игр и поведения конечных автоматов.

Результаты общей теории иллюстрируются на

многочисленных; примерах;. Приводятся

формулировки нерешенных задач.

Табл. \. J Li л. !)(J. Пибл. 505 назв.

141-67

Предисловие

При написании книги, которая охватывала бы

проблемы обучения, самообучения и адаптации в

автоматических системах, возникает целый ряд трудностей.

Несмотря на относительную новизну этой проблемы,

число работ, так или иначе с ней связанных, довольно

велико, и составление даже краткого обзора этих работ

заняло бы много моста и потребовало бы большого

времени. По если бы эта трудность и была преодолена,

то все равно нас ожидало бы еще одно препятствие,

вызванное традицией, присущей, в частности, и теории

автоматического управления. Вот уже который год для решения

одних и тех же задач создаются различные методы,

которые после некоторого периода соревнования либо

забываются, .либо, как это чаще случается, продолжают мирно

сосуществовать. Если учесть еще, что самих задач также

немало, то можно себе представить состояние специалиста,

пытающегося разобраться в проблеме адаптации.

Подобное состояние пережил и автор, когда летом

1965 г. он занялся подготовкой доклада «Адаптация,

обучение и самообучение в автоматических системах»

к 3-му Всесоюзному совещанию по автоматическому

управлению (Одесса, сентябрь 1965 г.). Нужно было

искать выход из создавшегося положения. Такой выход

мог быть найден только в коренной ломке уже

упоминавшейся традиции. Вместо рассмотрения одних и тех же

задач различными методами была предпринята попытка

ПРЕДИСЛОВИЕ

рассмотреть различные задачи одним и тем же методом.

Вначале надежда на успех основывалась только на вере

в существование каких-то общих закономерностей,

которым должна подчиняться адаптация. Но после того

как удалось нащупать некоторые из этих

закономерностей, надежда превратилась в уверенность.

В основу развиваемого в этой книге общего подхода,

охватывающего разнообразные задачи адаптации, были

положены вероятностные итеративные методы.

За небольшой промежуток времени, прошедший с

момента выдвижения этого подхода, удалось не только

уточнить и развить ряд утверждений, но и обнаружить,

что результаты многих работ но адаптации и обучению,

как появившихся в самое последнее время, так и работ

прежних лет, которым по разным причинам не было

уделено достаточного внимания, подчиняются

закономерностям, вытекающим из этого общего подхода.

Раз пинаемый подход не только упрощает решение

известных задач, по и позволяет решать многие новые

задачи.

Разумеется, мы далеки от мысли, что излагаемый в

этой книге подход охватывает все работы по адаптации,

обучению и самообучению и тем более работы, в которых

эти термины только фигурируют. Возможно, что ряд

существенных работ остался вне поля зрения, но если это

и так, то не потому, что они неинтересны или неважны,

а потому, что пока еще нет более общей концепции,

которая могла бы охватить и их.

Оглавление книги дает о ней достаточно полное

представление, и вряд ли стоит заниматься подробным

пересказом ее содержания. Но о некоторых особенностях книги

сказать нужно.

Мы отказываемся от подробного доказательства многих

высказываемых положений. Сделано это по ряду причин.

ПРЕДИСЛОВИЕ

5

Во-первых, это сильно увеличило бы объем книги и

изменило задуманный стиль. Во-вторых, неизбежная при

этом перегрузка деталями и тонкостями помешала бы,

как нам кажется, выделить и подчеркнуть общие идеи

адаптации и обучения. Наконец, не все доказательства

имеют ту форму, которая совмещала бы общность с

краткостью, и, как ни грустно в этом сознаться, мы пока еще

не обладаем всеми без исключения нужными

доказательствами.

Автор пытался изложить все вопросы «настолько

просто, насколько это возможно, но не проще».

Наряду с изложением общих идеи и их применением

к разнообразным задачам современной теории управления

и смежных областей — теории надежности, исследования

операции, теории игр, теории конечных автоматов и т. п.,

в книге формулируются различные но важности,

сложности и конкретности задачи, ждущие своего решения.

В основном тексте книги почти полностью отсутствуют

ссылки на литературу, тем или иным образом связанную

с рассматриваемыми вопросами. Это сделано умышленно,

чтобы не прерывать изложения частыми ссылками. Зато

в конце книги помещен подробный обзор литературы

по адаптации и обучению. Помимо обзора, здесь делаются

различные дополнения и замечания, а полученные

результаты сопоставляются с известными ранее.

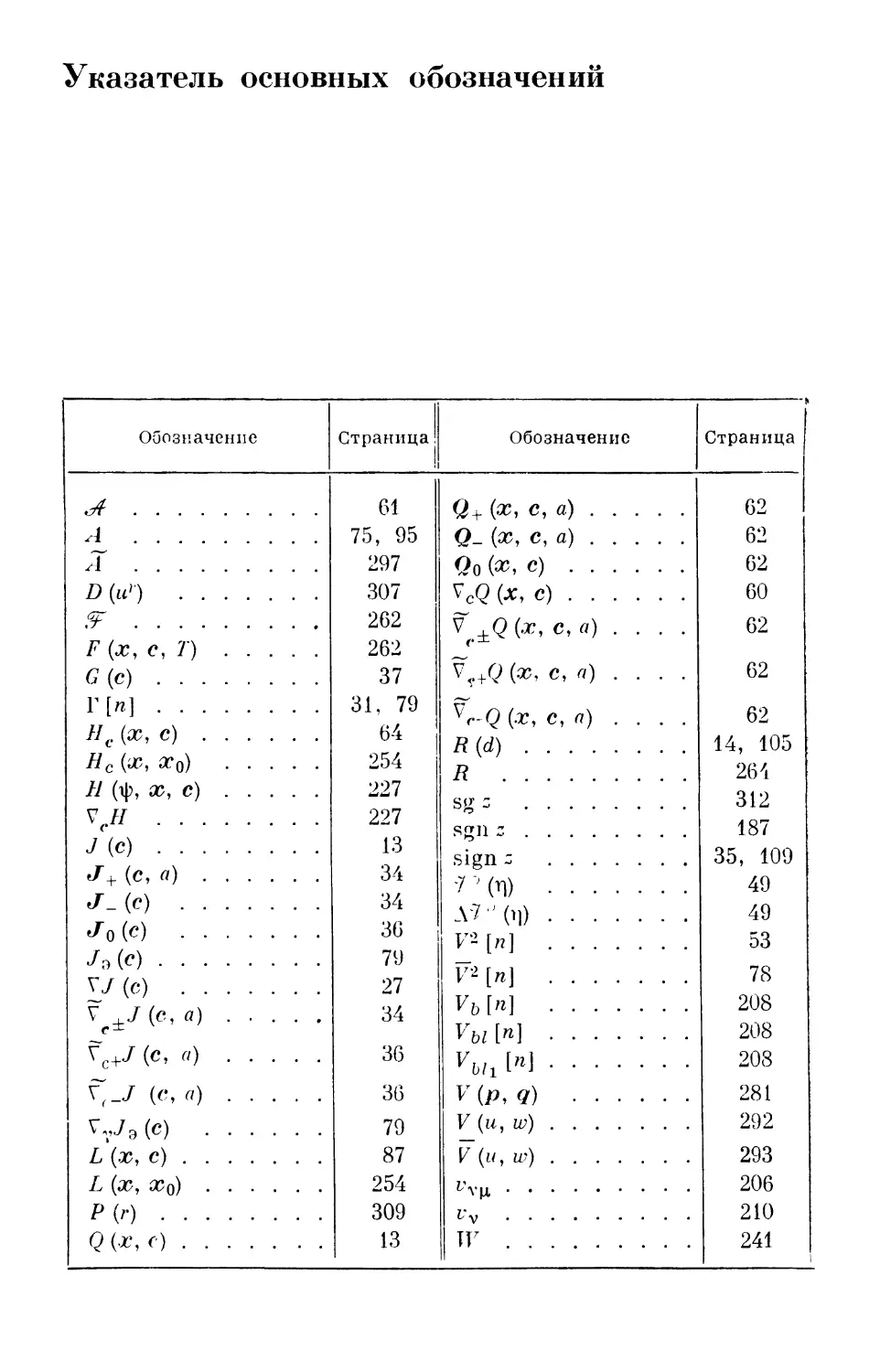

Указатель основных обозначений облегчит читателю

знакомство с любой из интересующих его глав по

применению адаптивного подхода независимо от чтения остальных

глав.

Эта книга не могла бы быть написана, если бы автор

не опирался на поддержку своих молодых сотрудников

Э. Аведьяна, И. Девятерикова, Г. Кельманса, П. Надеж-

дина, Ю. Попкова и А. Пропоя, которые не только

принимали активное участие в обсуждении результатов, но

6

ПРЕДИСЛОВИЕ

и оказали влияние на развитие и изложение многих из

рассмотренных в книге вопросов. За их инициативу и

энтузиазм, которые действовали так стимулирующе, автор

приносит им глубокую благодарность. Автор признателен

также 3. Кононовой за большую помощь при оформлении

рукописи книги.

Наконец, автору приятно отметить большое участие

В. Новосельцева, который при редактировании

рукописи сделал многое для того, чтобы книга приняла по

возможности завершенный вид.

Если при чтении книги у читателя возникнет либо

желание поспорить, либо стремление уточнить и развить

ряд положений, либо, наконец, намерение использовать

идеи адаптации для решения своих задач, т. е. если

в конечном итоге читатель не останется равнодушным,

то автор будет удовлетворен.

Институт автоматики и телемеханики Я. Цыпкин

Москва,

декабрь 1966 г.

Введение

В развитии теории автоматического управления можно

выделить три наиболее характерных периода, которые

удобно кратко назвать периодами детерминизма, стоха-

стичности и адаптивности.

В счастливые времена детерминизма как уравнения,

описывающие состояние управляемых объектов, так

и внешние воздействия (задающие и возмущающие)

предполагались известными. Такая полная определенность

позволяла широко использовать классический

аналитический аппарат для решения разнообразных проблем

теории управления. Особенно это относится к линейным

задачам, где безгранично господствующий принцип

суперпозиции существенно облегчал решение задач и создавал

полную иллюзию отсутствия принципиальных

затруднений. Эти затруднения возникли, конечно, как только

появилась необходимость в учете нелинейных факторов.

Но и в области нелинейных задач, несмотря на отсутствие

общих регулярных методов, были получены существенные

результаты, относящиеся как к анализу, так и к синтезу

автоматических систем.

Менее счастливое время наступило во второй период —

период стохастичности, когда в связи с учетом более

реальных условий работы автоматических систем было

установлено, что внешние воздействия, задающие, а

особенно возмущающие, непрерывно изменяются во времени

и заранее не могут быть определены однозначно. Часто

это относилось и к коэффициентам уравнений

управляемых объектов. Поэтому возникла необходимость в

привлечении иных подходов, учитывающих вероятностный

характер внешних воздействий и уравнений. Эти

подходы основаны на знании статистических характеристик

случайных функций (которые тем или иным путем должны

8

ВВЕДЕНИЕ

быть предварительно определены) и так же используют

аналитические методы, как и в счастливые времена

детерминизма.

Характерная особенность этих периодов развития

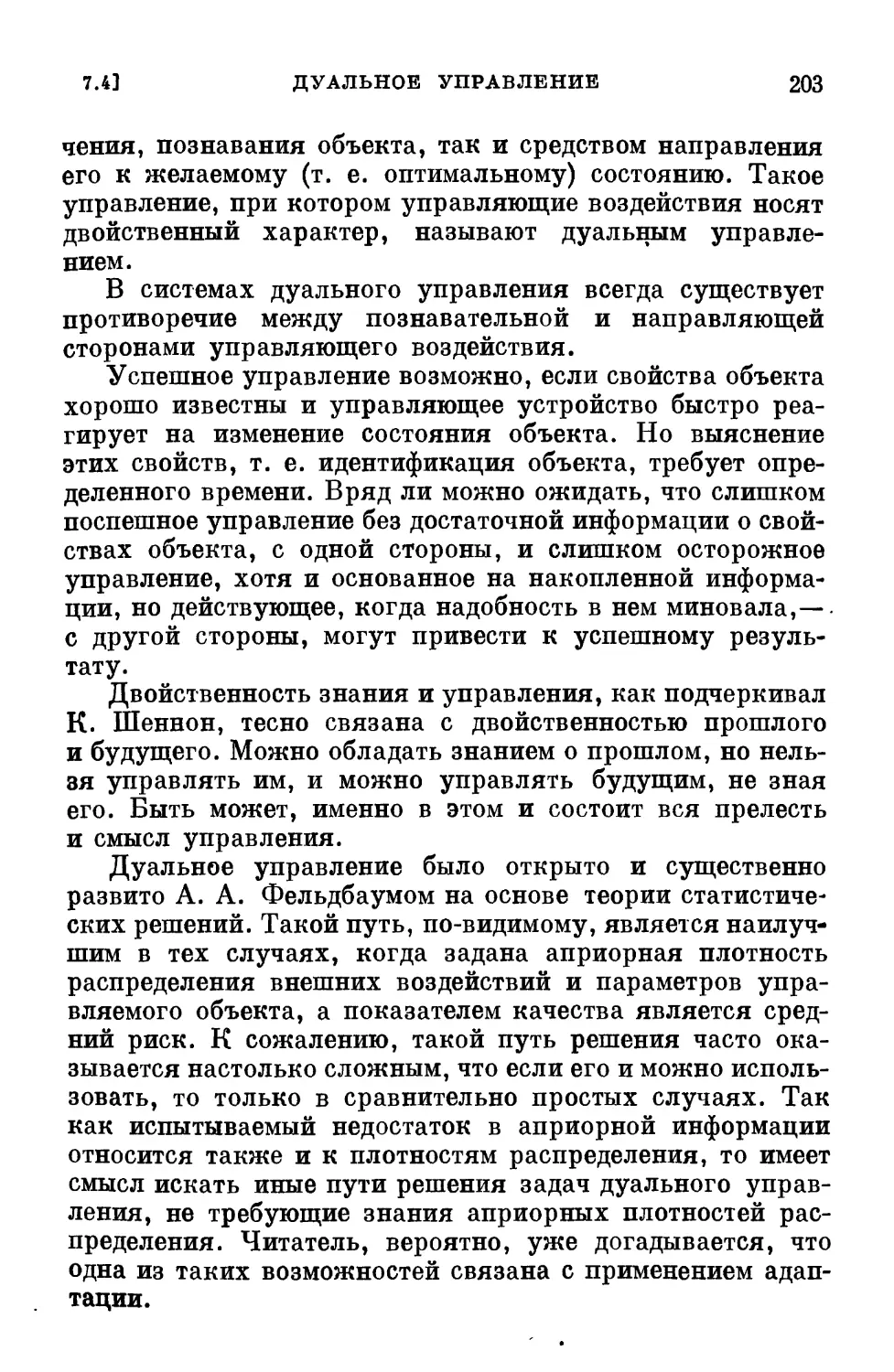

теории автоматического управления состоит в том, что

их методы и результаты непосредственно применимы

к автоматическим системам с достаточной информацией,

т. е. уравнения объекта и внешние воздействия либо их

статистические характеристики должны быть известны.

В нынешнее «многострадальное» (с точки зрения теории

автоматического управления) время с каждым днем мы все

больше убеждаемся, что в современных сложных

автоматических системах, работающих в самых разнообразных

условиях, уравнения управляемых объектов и внешние

воздействия (либо их статистические характеристики)

не только неизвестны, но по различным причинам мы даже

не имеем возможности заранее определить их

экспериментальным путем. Иначе говоря, мы сталкиваемся с

большей или меньшей начальной неопределенностью. Все

это хотя и затрудняет управление такими объектами, но

не делает это управление в принципе невозможным,

свидетельствуя лишь о наступлении нового, третьего периода

в теории управления — периода адаптивности.

Возможность управления объектами при неполной и даже весьма

малой априорной информации основана на применении

адаптации и обучения в автоматических системах, которые

уменьшают первоначальную неопределенность на основе

использования информации, получаемой в течение

процесса управления.

Не надо думать, что периоды детерминизма, стохастич-

ности и адаптивности сменяли друг друга подобно кадрам

в кино. Последующие периоды зарождались в недрах

предшествующих, и мы являемся свидетелями

сосуществования проблематики этих периодов.

На первой стадии каждого из перечисленных периодов

основной задачей была задача анализа автоматических

систем и выяснение их свойств. Затем возникли задачи

синтеза автоматических систем, удовлетворяющих

определенным требованиям. Естественно, появилось желание,

а часто и необходимость осуществить синтез оптимальной

в том или ином смысле системы.

ВВЕДЕНИЕ

9

Проблема оптимальности стала одной из центральных

в автоматическом управлении. И если еще не достигнуты

большие успехи в обосновании выбора и в формулировке

показателей качества, то нас могут утешать блестящие

результаты, связанные с проблемой оптимальности,

которые сконцентрированы в принципе максимума Понтряги-

на и методе динамического программирования Беллмана.

Хотя они и возникли на почве детерминистских задач,

но с определенным успехом начинают завоевывать

территорию стохастических и отчасти адаптивных задач.

Большим достижением периода стохастичности в этом

же направлении являются методы Колмогорова — Винера

и Калмана, которые в значительной мере исчерпали

линейные задачи синтеза.

К сожалению, период адаптивности не может

похвастаться столь блестящими результатами. Это

объясняется тем, что проблема адаптации и связанные с ней проблемы

обучения и самообучения еще очень молоды. Тем не менее

мы все чаще и чаще обнаруживаем их в разнообразных

задачах современной автоматики. Помимо основной,

упомянутой уже выше задачи управления объектами в

условиях неполной априорной информации или ее отсутствия,

т. е. в условиях начальной неопределенности, задачи

адаптации возникают при определении характеристик

объектов и воздействий, при обучении опознаванию

образов, ситуаций, при выработке и улучшении целей

управления и т. п«

Термины «адаптация», «самообучение», «обучение»

наиболее модны в современной теории автоматического

управления. К сожалению, как правило, эти термины не имеют

однозначного толкования, а зачастую не имеют просто

никакого толкования. Это создает благоприятную почву

для безудержных фантастических рассуждений, особенно

часто бытующих в популярной литературе по кибернетике,

а иногда проникающих и на страницы некоторых

технических журналов.

Тем не менее, если исключить этот обильный, но мало

содержательный поток «общих рассуждений», то можно

указать на целый ряд интересных подходов и результатов,

полученных в связи с решением перечисленных выше

задач.

10

ВВЕДЕНИЕ

Следует, однако, заметить, что до последнего времени

эти задачи рассматривались изолировано и независимо

одна от другой. Связи между ними почти не замечались,

хотя при более общем взгляде на проблемы адаптации,

обучения и самообучения все эти задачи оказываются

настолько тесно связанными, что приходится только

удивляться тому, что эта связь не была подчеркнута

ранее.

Основная наша цель состоит в обсуждении проблемы

адаптации, обучения и самообучения с некоторой единой

точки зрения, которая связала бы между собой задачи,

казавшиеся ранее разрозненными, и которая позволила

бы установить эффективные пути их решения.

Разумеется, на какое-либо осуществление этой цели

можно надеяться лишь при выполнении хотя бы двух

условий: наличия определенных, пусть условных, но

содержательных понятий адаптации, обучения и самообучения

и наличия некоторого математического аппарата,

адекватного этим понятиям.

Первое условие находится если не в наших руках, то,

по крайней мере, в руках комиссий по технической

терминологии и поэтому из многочисленных, порой

разноречивых определений мы надеемся либо выбрать более

или менее подходящее для нашей книги, либо, в крайнем

случае, прибавить еще одно определение. Что же касается

второго условия, то обычно удовлетворить ему

несоизмеримо4 труднее. Но, как это неоднократно случалось

в истории науки, адекватный математический аппарат,

хотя и в зародышевой форме, к счастью, существует.

Он содержится, с одной стороны, в сформировавшейся

к настоящему времени математической статистике, а с

другой стороны, в интенсивно развивающейся новой

математической дисциплине, известной под названием

математического программирования.

Математическое программирование разрабатывает

теорию и методы решения экстремальных задач и охватывает

как специальные разделы (вариационное исчисление,

принцип максимума Понтрягина, динамическое

программирование Беллмана, линейное и нелинейное

программирование), так и — как это можно понять сейчас — методы

стохастической аппроксимации. Последние методы,

ВВЕДЕНИЕ

И

к сожалению, мало использовавшиеся вне математической

статистики, играют существенную роль в интересующей

нас области.

Важно подчеркнуть, что математическое

программирование не связано с необходимостью описания условий

задачи в аналитическом, формульном виде, и поэтому

может охватить значительно более широкий круг задач,

чем те методы, с помощью которых пытаются получить

решение в замкнутой аналитической форме.

Алгоритмическая форма решения экстремальных задач дает

возможность использовать средства современной вычислительной

техники и не укладывать условия задачи в прокрустово

ложе аналитического подхода, что обычно уводит нас

далеко за пределы тех реальных задач, которые мы

действительно хотели бы рассмотреть.

Алгоритмы обучения и адаптации должны позволить

в условиях минимальной априорной информации

достигнуть оптимума в том или ином смысле. Поэтому прежде

всего мы должны познакомиться с проблемой

оптимальности и алгоритмическими методами решения этой

проблемы. Затем мы сможем обсудить понятия и методы,

характерные для проблемы адаптации ^обучения. И

только после этого, вооружившись единой точкой зрения

и подходом к интересующей нас проблеме, мы будем в

состоянии приступить к решению разнообразных задач.

Именно такая последовательность и принята в

настоящей книге.

Глава I

Проблема оптимальности

§ 1.1. Введение

Без преувеличения можно сказать, что проблема

оптимальности является центральной проблемой науки,

техники, да и повседневной жизни.

Что бы ни делал человек, он пытается это сделать как

можно лучше. Любые сколь-нибудь обоснованные выводы,

действия или, наконец, созданные устройства можно

рассматривать с некоторой точки зрения как оптимальные,

ибо мы предпочли их множеству других выводов,

действий или устройств, т. е. посчитали их лучшими.

При стремлении достигнуть цели сразу же возникают

три задачи. Первая задача — выбор и формулировка

цели. То, что при одних условиях является наилучшим,

может оказаться далеко не наилучшим в других условиях.

Выбор и формулировка цели зависят от очень многих

условий и нередко сопряжены с большими трудностями.

Очень часто мы знаем, чего хотим, но, к сожалению, наше

желание сформулировать точно не можем.

Однако как только цель выбрана, возникает вторая

задача—согласование цели с имеющимися

возможностями, т. е. учет ограничивающих условий, или, проще, учет

ограничений. Даже ясная формулировка цели еще не

является залогом возможности ее достижения, подобно

тому как мечты далеко не всегда в действительности

достижимы.

Наконец, после выбора цели и учета ограничений

возникает третья задача — реализация способа

достижения цели при учете ограничений. Именно в третьей

задаче выясняется истинная цена разнообразных

математических методов оптимизации, их могущество или

бессилие.

§ 1.2]

КРИТЕРИИ ОПТИМАЛЬНОСТИ

13

Таким образом, решение проблемы оптимизации

сводится к последовательному решению перечисленных выше

задач.

В этой главе мы рассмотрим с нужной нам степенью

детализации первые две задачи. Третьей же задаче

посвящены, по существу, все остальные главы книги.

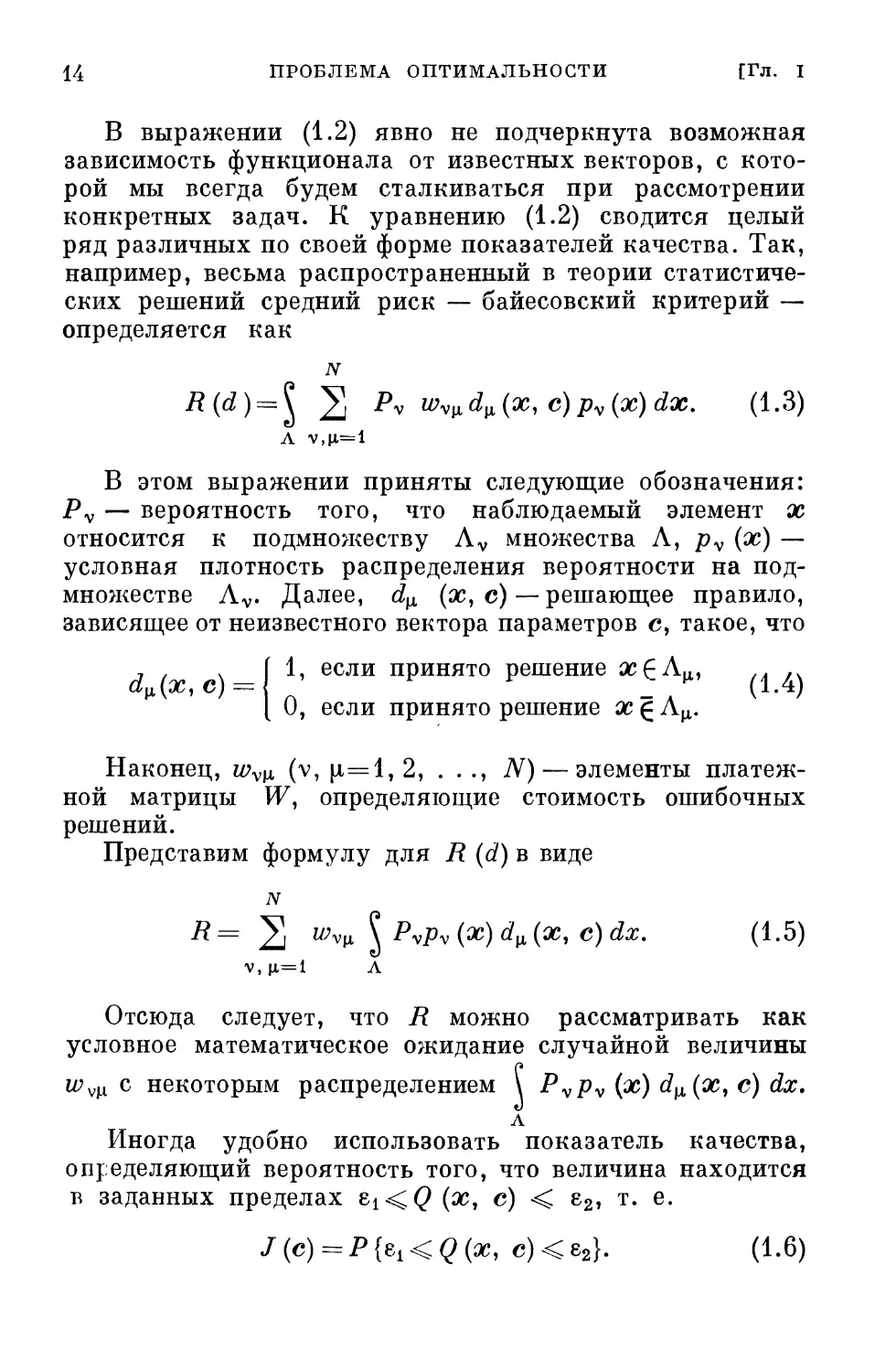

§ 1.2. Критерии оптимальности

Любая задача оптимизации может быть сведена к

выбору лучшего в некотором смысле варианта из большого

числа вариантов. Каждый из этих вариантов

характеризуется набором чисел (или функций). Качество того или

иного варианта определяется некоторым показателем —

численной характеристикой, определяющей близость

достижения поставленной цели при выбранном варианте.

Наилучший вариант соответствует экстремуму

показателя качества, т. е. минимуму или максимуму в

зависимости от конкретной задачи. Показатели качества обычно

представляют собой функционалы. Эти функционалы

можно рассматривать как функции, в которых роль

независимых переменных играют некоторые кривые или

векторы, характеризующие варианты. Функционал,

зависящий от вектора, представляет собой просто функцию

многих переменных. Мы далее будем рассматривать

в основном функционалы, зависящие от вектора, к

которым можно сводить функционалы, зависящие от функции,

на основе прямых методов вариационного исчисления.

В общей форме показатель качества можно

представить в виде условного математического ожидания

J(c) = ^Q(x, c)p(x)dx (1.1)

X

или кратко

J{c) = Mx{Q{x, с)}, (1.2)

где Q (х, с) — функционал вектора с = (си . . . , cN),

зависящий также от вектора случайных

последовательностей или процессов х = (хи . . . , хм), плотность

распределения которого равна р (х); X — пространство

векторов х. Здесь и далее все векторы представляются

столбцовыми матрицами.

14

ПРОБЛЕМА ОПТИМАЛЬНОСТИ

[Гл. I

В выражении (1.2) явно не подчеркнута возможная

зависимость функционала от известных векторов, с

которой мы всегда будем сталкиваться при рассмотрении

конкретных задач. К уравнению (1.2) сводится целый

ряд различных по своей форме показателей качества. Так,

например, весьма распространенный в теории

статистических решений средний риск — байесовский критерий —

определяется как

N

R(d) = l 2 Pv Wvlidlx(x,c)pv(x)dx. (1.3)

Л v,p,= l

В этом выражении приняты следующие обозначения:

Pv — вероятность того, что наблюдаемый элемент х

относится к подмножеству Av множества Л, pv (х) —

условная плотность распределения вероятности на

подмножестве Av. Далее, d^ (х, с) — решающее правило,

зависящее от неизвестного вектора параметров с, такое, что

d»{x, с) =

1, если принято решение х^А^ . ,

О, если принято решение х g А^.

Наконец, wv[X, (v, |л=1, 2, . . ., N) — элементы

платежной матрицы И7, определяющие стоимость ошибочных

решений.

Представим формулу для R (d) в виде

R= 2 ^уц \ PvPv(x)d[X(x, c)dx. (1.5)

v, \i=i Л

Отсюда следует, что R можно рассматривать как

условное математическое ожидание случайной величины

wvli с некоторым распределением \ Pvpv (х) d[l(xi с) dx.

А

Иногда удобно использовать показатель качества,

определяющий вероятность того, что величина находится

в заданных пределах 8!<(?(х, с) < е2, т. е.

J(e) = P {ех < Q (а>, с) < е2}. (1.6)

§ 1.3] ЕЩЕ О КРИТЕРИЯХ ОПТИМАЛЬНОСТИ 15

Вводя новую переменную, так называемую

характеристическую функцию

В(х, с) М- если 6l«?(*)C)<е2) (U)

[ 0 в иных случаях,

можно преобразовать (1.6) к виду

J(c) = Mx{Q(x, с)}, (1.8)

что совпадает по форме с (1.2).

Достижению цели соответствует минимум (например,

в случае (1.3)) или максимум (например, в случае (1.6)).

Поэтому функционалы часто называются также

критериями оптимальности.

§ 1.3. Еще о критериях оптимальности

Наряду с критериями оптимальности, представляемыми

в виде условного математического ожидания (1.2) путем

усреднения Q (х, с) по множеству, можно использовать

критерии оптимальности, определяемые усреднением

Q (х, с) по времени. В зависимости от того, представляет

собой х случайную последовательность {х [п], п =

= 0, 1, 2, . . .} или процесс {х (t); 0 < t << оо}, критерии

оптимальности можно записать соответственно в виде

7(c) = lim-^2 <?(*[»]. с) (I-9)

или

т

/ (с) = lim 4" \Q (х (0. с) dL (1-1°)

Для эргодических стационарных последовательностей

и процессов критерии оптимальности (1.9)-(1.10),

отличающиеся от критерия оптимальности (1.2) способом

усреднения (по времени или по множеству),

эквивалентны. Это значит, что выражения этих функционалов, если

бы их можно было получить в явном виде, всегда бы

совпадали. В любом другом случае критерии оптимальности

(1.9), (1.10) отличаются от (1.2). Но это обстоятельство

16

ПРОБЛЕМА ОПТИМАЛЬНОСТИ

[Гл. I

не должно служить препятствием к применению критериев

оптимальности вида (1.9) или их обобщений и тогда,

когда на каждом шаге (в каждый момент времени) вид

функции Q изменяется, т. е. когда

лг

Z(c) = lim4-2 Qn(x[n], с) (1.11)

ИЛИ

т

/(с) = lim 4r\Q{x{t), с, t)dt. (1.12)

Критерии оптимальности имеют или, по крайней мере,

должны иметь определенный физический или

геометрический смысл. Так, для систем автоматического

управления критерии оптимальности представляют собой

некоторую меру отклонения системы от желаемого или

предписанного состояния. Для задачи аппроксимации

функций критерии оптимальности характеризуют меру

уклонения аппроксимирующей функции от

аппроксимируемой. Выбор конкретного критерия оптимальности,

как правило, связан со стремлением найти компромисс

между желанием более точно описать поставленную цель

и возможностью получить более простое решение

соответствующей математической задачи.

§ 1.4. Ограничения

Если бы векторы х и с, входящие в функционал

критерия оптимальности, не были стеснены какими-либо

условиями, то проблема оптимальности, пожалуй, не

имела бы смысла.

Проблема оптимальности возникает именно тогда,

когда существуют взаимно противоречивые

ограничивающие условия, и достижение оптимальности состоит в

наилучшем удовлетворении этих условий, т. е. в выборе

такого варианта, когда критерий оптимальности достигает

экстремума.

Ограничивающие условия или просто ограничения,

выражающиеся равенствами, неравенствами или логиче-

§ 1.4]

ОГРАНИЧЕНИЯ

17

сними соотношениями, из всего множества вариантов

выделяют так называемые допустимые варианты, среди

которых и ищется оптимальный вариант.

Законы природы, описывающие те или иные явления и,

в частности, определяющие поведение различных систем,

представляют собой своеобразные ограничения. Этим

законам, выраженным в виде алгебраических,

дифференциальных, интегральных уравнений, подчиняются векторы

х и с.

Конкретный вид таких уравнений зависит от характера

и особенностей рассматриваемой задачи, так что с явной

записью различных уравнений мы будем часто встречаться

во многих главах настоящей книги. Ограничения этого

типа будем называть ограничениями первого рода. Иного

характера ограничения могут быть вызваны

ограниченностью ресурсов, энергии или иных величин, которые

в силу физической природы той или иной системы не могут

или не должны превосходить некоторых пределов. Эти

ограничения, которые мы будем называть ограничениями

второго рода, налагаются на компоненты вектора с

и выражаются в виде равенств

gv(c) = 0 (V=l, 2, ..., M<N) (1.13)

или неравенств

Мс)<0 (v = l, 2 ...,7^), (1.14)

где gy (с) — некоторые функции вектора с.

Часто ограничения могут относиться не к

мгновенным, а к средним значениям, и тогда (1.13) и (1.14)

заменяются равенствами или неравенствами математических

ожиданий соответствующих функций:

gv(c) = Mx{hv(x,c)} = 0 (v = l, 2, ..., Ж) (1.15)

или

gv(c) = Mx{hv(x, с)}<0 (v = l, 2, ...,71^). (1.16)

Таким образом, ограничения включают уравнения тех

или иных процессов и пределы изменения некоторых

функций от этих процессов.

Для автоматических систем—это уравнения движения

и пределы изменений управляемых величин и управляющих

^ Я. 3. Цыпкин

18

ПРОБЛЕМА ОПТИМАЛЬНОСТИ

[Гл. I

воздействий. В задаче аппроксимации ограничения

определяются характером аппроксимирующей функции.

К сожалению, в реальных физических задачах количество

ограничений, как правило, намного превышает то число,

при котором постановка оптимальной задачи остается

возможной и разумной.

Все эти ограничения сужают количество допустимых

решений, облегчая, казалось бы, определение

оптимального варианта, но само решение задачи при этом настолько

усложняется, что хорошо знакомые нам классические

методы становятся неприменимыми.

§ 1.5. Априорная и текущая информация

Априорная информация, или, как еще часто говорят,

начальная информация, представляет собой совокупность

заранее известных сведений о критерии оптимальности

и ограничениях. Критерий оптимальности является

выразителем тех требований, которые должны быть наилучшим

образом удовлетворены, а ограничения определяют наши

возможности. Таким образом, априорная информация

касается требований, предъявляемых к процессу,

характера уравнений процесса и значений параметров в этих

уравнениях и, наконец, свойств внешних воздействий

и самого процесса.

Априорная информация может быть получена в

результате предварительного теоретического или

экспериментального исследования. Она является исходной при

решении любых физических задач и, в частности, при

рассмотрении проблемы оптимальности.

Всякое описание реальной системы неизбежно приводит

к идеализации ее свойств и, несмотря на стремление

учесть основные характерные черты этой системы, вряд

ли можно надеяться на получение полной априорной

информации. Ведь полная априорная информация

означает абсолютно точное знание. Если же учесть еще и

наличие разнообразных помех, являющихся источником

неопределенности, то приходится заключить, что все

случаи, с которыми мы реально сталкиваемся,

соответствуют неполной априорной информации. Разумеется,

степень этой неполноты может быть различной. Она может

§ 1.6] ДЕТЕРМИНИРОВАННЫЕ И СТОХАСТИЧЕСКИЕ ПРОЦЕССЫ 19

быть достаточной либо недостаточной для формулировки

и решения проблемы оптимальности. При достаточной

априорной информации известны все необходимые

сведения о критерии оптимальности и ограничениях, т. е.

они могут быть выписаны в явной форме.

При недостаточной априорной информации

необходимые сведения относительно критерия оптимальности либо

ограничений, либо того и другого вместе, полностью

неизвестны.

Существенная особенность любых априорных сведений

состоит в том, что, будучи получены заранее, они затем

не только не обновляются, но вследствие различных

случайных изменений, всегда существующих в реальных

условиях, теряют свою достоверность. Степень полноты

априорной информации, т. е. объем априорной

информации, играет существенную роль в постановке и решении

проблемы оптимальности.

В отличие от априорной информации, текущая

информация извлекается в результате наблюдений за ходом

процесса или в результате экспериментов. Таким образом,

текущая информация в каждый момент времени

обновляется. Текущая информация, полученная в результате

специально поставленного предварительного

эксперимента, может использоваться для накопления

соответствующей априорной информации. Но наиболее важная

роль текущей информации состоит в компенсации

недостаточного объема априорной информации.

Априорная информация — это основа для

формулировки проблемы оптимальности. Текущая информация —

средство решения этой проблемы.

§ 1.6. Детерминированные и стохастические

процессы

Детерминированные процессы характеризуются тем,

что знание их в некотором интервале времени позволяет

полностью определить поведение этих процессов вне этого

интервала. Для детерминированного процесса заранее

задан критерий оптимальности, а ограничения первого

и второго рода известны. Стохастические процессы

характеризуются тем, что знание их на некотором интервале

2*

20

ПРОБЛЕМА ОПТИМАЛЬНОСТИ

[Гл. I

времени позволяет определить лишь вероятностные

характеристики поведения этих процессов вне этого

интервала.

Если эти вероятностные характеристики, например

плотности распределения, заранее заданы, то и в этом

случае можно определить в явной форме критерий

оптимальности и ограничения, которые представляют собой,

как это упоминалось выше, некоторые условные

математические ожидания.

Детерминированные процессы можно рассматривать

как частный случай стохастических процессов, плотность

распределения которых представляет собой импульсную

функцию Дирака, т. е. б-функцию: р (х) = б (х). При

этом условные математические ожидания, входящие

в критерий оптимальности (1.2) и ограничения (1.15),

(1.16), превращаются просто в детерминированные

функции, не зависящие от случайного вектора х.

Так, при р (х) = б (х) из (1.2), (1.15) и (1.16) с учетом

(1.1) легко получить для детерминированного процесса

следующие соотношения:

J(c) = Q(0, с), (1.17)

Sv(c)=-M0, с) = 0 (v = lf 2, ...,M<N) (1.18)

и

Мс) = М0, с><0 (v = l, 2, ..., Л/0, (1.19)

что соответствует ограничениям вида (1.13) и (1.14).

Из этого очевидного замечания следует, что

стохастические процессы отличаются друг от друга и, в частности,

от детерминированных процессов видом вероятностных

характеристик — плотностей распределения.

Объем априорной информации для

детерминированных процессов обычно больше, чем для стохастических,

поскольку для детерминированных процессов плотность

распределения заранее известна, тогда как для

стохастического процесса, как правило, ее еще нужно

определить.

Однако если плотность распределения тем или иным

способом предварительно определена и нам удалось

записать функционал и уравнения ограничений в явной

форме, то, несмотря на существенные идейные различия

§ 1.7]

ОБЫЧНЫЙ И АДАПТИВНЫЙ ПОДХОДЫ

21

между детерминированными и стохастическими

процессами, трудно установить сколь-нибудь заметные

расхождения в формулировке и решении проблемы

оптимальности для этих процессов.

Мы хорошо понимаем, что для детерминированных

процессов часто можно получить оптимальность для

каждого процесса в отдельности, как это имеет место,

например, в оптимальных по быстродействию системах.

В то же время для статистических процессов можно

обеспечить лишь оптимальность в среднем, но это скорее

относится к области идейных различий, нежели к

формулировке и решению проблемы оптимальности.

§ 1.7. Обычный и адаптивный подходы

Если функции распределения для стохастических

процессов известны и можно определить в явной форме

критерии качества / (<?), то, как мы уже упоминали,

стохастическая задача оптимизации ничем не отличается

от детерминированной. Так, динамическое

программирование в равной степени применимо как для

детерминированных, так и для стохастических задач.

При внимательном взгляде на результаты, полученные

в периоды детерминизма и стохастичности,

обнаруживается, с одной стороны, ясная до тривиальности, а с другой —

поражающая наше воображение тождественность

подходов при решении задач оптимизации.

В качестве наиболее яркого примера можно привести

стохастическую задачу фильтрации Винера —

Колмогорова, т. е. синтез линейной системы, оптимальной с точки

зрения минимума среднеквадратичной ошибки, и задачу

аналитического конструирования регулятора, т. е. синтез

оптимальной линейной системы с точки зрения минимума

интегральной квадратичной ошибки. Хотя эти задачи на

первых порах решались внешне различными способами,

оказалось, что с точностью до терминологии они изоморфны.

Стоит ли более подробно обсуждать этот вопрос?

Ведь раз J (с) представлено в замкнутой форме, то вид

функции распределения, от которой зависит J (с), вряд

ли имеет какое-либо принципиальное значение. Все такие

подходы мы будем называть обычными.

22

ПРОБЛЕМА ОПТИМАЛЬНОСТИ

[Гл. I

Существенно иная ситуация возникает, когда

функция распределения заранее неизвестна. Здесь уже

обычный подход теряет силу и необходим иной подход, который

позволил бы решить проблему оптимальности при

недостаточной априорной информации без предварительного

определения вероятностных характеристик. Такой

подход мы будем называть адаптивным.

В отличие от обычного подхода, при адаптивном

подходе для восполнения недостающей априорной

информации активно используется текущая информация.

Адаптивный подход может быть применен и в тех случаях,

когда применение обычного подхода хотя и возможно,

но сопряжено с большой работой по предварительному

определению функций распределения. Если же заранее

не ясно, с каким процессом мы имеем дело, с

детерминированным или случайным, и тем более неизвестны их

характеристики, то единственное разумное решение

связано с обучением и адаптацией в процессе

экспериментирования, т. е. с использованием адаптивного подхода.

§ 1.8. О методах решения проблемы оптимальности

После того как проблема оптимальности

сформулирована, т. е. после выбора критерия оптимальности,

выяснения и установления ограничений первого и второго

рода, наступает пора решения этой проблемы. И хотя

теперь принято говорить, что постановка проблемы

составляет от 50 до 80% успеха (в зависимости от

темперамента говорящего это), тем не менее оставшиеся

проценты часто настолько емки, что могут лишить нас этого

успеха вообще.

Решение проблемы оптимальности сводится к

определению такого вектора с = с* (его уместно назвать

оптимальным), который, удовлетворяя ограничениям,

доставлял бы функционалу

J(e) = Mx{Q(x, с)} (1.20)

экстремальное значение.

Следует отметить, что в большинстве интересующих

нас конкретных задач обычно нужно определить функции,

являющиеся экстремалями тех или иных функционалов.

§ 1.8] О МЕТОДАХ РЕШЕНИЯ ПРОБЛЕМЫ ОПТИМАЛЬНОСТИ 23

Процедура определения экстремалей часто

сопровождается большими трудностями. Чтобы обойти эти

трудности, можно использовать идеи прямых методов

вариационного исчисления: заменить искомые экстремали

комбинацией некоторых линейно независимых функций

с неизвестными коэффициентами. Благодаря этому

рассматриваемый функционал, зависящий от функции,

заменяется функционалом, зависящим от вектора. С подобными

примерами мы будем еще сталкиваться.

При наличии достаточной априорной информации

нам известно явное выражение функционала / (с) и

ограничений как для детерминированных, так и для

стохастических процессов. К функционалу / (с) мы можем

применять обычные подходы.

Обычные подходы весьма разнообразны и охватывают

аналитические и алгоритмические методы. Аналитические

методы на первый взгляд кажутся наиболее

привлекательными, так как они приводят к явному формульному

решению задач, но эта привлекательность достигается

весьма дорогой ценой, ценой резкого ограничения

возможностей. Эти методы пригодны для решения относительно

простых задач, которые часто могут быть

сформулированы лишь благодаря далеко идущей идеализации, иногда

настолько далекой, что фактически вместо поставленной

задачи решается совсем иная. Так, формулы для

вычисления корней алгебраических уравнений имеют весьма

простой вид для уравнений первой и второй степени.

Такие формулы можно написать для уравнений третьей

и четвертой степеней, хотя пользоваться ими уже

значительно сложнее. Наконец, подобных формул просто

не существует для уравнений, степень которых выше

четвертой. Но можно ли всегда быть довольным, решая

уравнение второй степени вместо уравнений высоких

степеней?

Различного рода приближенные аналитические методы,

например асимптотические, расширяют границы

применимости, но ненамного.

Алгоритмические методы, еще в недавнее время не

привлекавшие большого внимания, не дают явного

формульного решения задач, а лишь указывают алгоритм, т. е.

последовательность действий, операций, осуществление

24

ПРОБЛЕМА ОПТИМАЛЬНОСТИ

[Гл. I

которых приводит к искомому конкретному решению.

Алгоритмические методы возникли на почве численного

решения различного рода уравнений и теперь в связи

с широким применением вычислительных машин

приобретают доминирующее значение.

Алгоритмические методы дают не столько решение,

сколько способ нахождения этого решения с помощью,

например, рекуррентных соотношений. Это

обстоятельство существенно расширяет возможности

алгоритмического метода по сравнению с аналитическими методами.

Но даже в тех случаях, когда применение аналитических

методов принципиально возможно, иногда предпочитают

использовать алгоритмические методы, так как они дают

более быстрый и удобный путь получения искомого

результата. Вряд ли при здравом подходе для решения

системы линейных алгебраических уравнений высокого

порядка мы применим классическое правило Крамера, а

не воспользуемся одним из многочисленных итеративных

методов. Если функционал явно неизвестен, то обычные

подходы непосредственно неприменимы, и для устранения

неопределенности, вызванной малым объемом априорной

информации, следует использовать адаптивный подход.

Адаптивный подход связан преимущественно с

алгоритмическими, а точнее, итеративными методами. Подробно

об алгоритмических методах оптимизации мы будем

говорить в следующих двух главах.

§ 1.9. Заключение

В этой главе мы стремились в общих чертах

охарактеризовать проблему оптимальности, ее формулировку

и пути решения. Нам хотелось также обратить внимание на

различие и особенно на сходство проблем оптимальности

для детерминированных и стохастических процессов.

Мы отметили, что подход к решению проблемы

оптимальности определяется в зависимости от степени полноты

априорной информации. При достаточной априорной

информации используется обычный подход, при

недостаточной априорной информации — адаптивный. Впрочем,

как мы увидим далее, иногда адаптивный подход

оказывается предпочтительным даже в тех случаях, когда можно

§ 1.9

ЗАКЛЮЧЕНИЕ

25

применить и обычный подход. Такая ситуация возникает

тогда, когда априорная информация может быть

получена экспериментальным путем в результате обработки

тех или иных процессов. Примером такого рода может

служить определение плотностей распределения или

корреляционных функций, которые затем используются для

решения оптимальной задачи. Не лучше ли в этом случае

решать проблему оптимальности адаптивным путем, что

позволяет обойтись без получения этой априорной

информации и зачастую требует меньшего объема вычислений?

Чтобы освободиться от сильной идеализации и

переупрощения реальных задач, в качестве основного метода

мы изберем алгоритмический. Это дает нам возможность

получать эффективные алгоритмы решения проблемы

оптимальности и в сложных случаях, используя для

этой цели разнообразные средства вычислительной

техники.

Глава II

Алгоритмические методы оптимизации

§ 2.1. Введение

Алгоритмические методы решения проблемы

оптимальности, которые будут рассмотрены в этой главе,

относятся к типу рекуррентных. Эти методы включают

в себя различного рода итеративные процедуры,

связанные с применением последовательных приближений.

Благодаря идеям функционального анализа подобные

методы, первоначально применявшиеся лишь к решению

алгебраических уравнений, были распространены и на

дифференциальные и интегральные уравнения.

Наша ближайшая цель будет состоять не только

в систематизации и упорядочении довольно хорошо

разработанных разнообразных рекуррентных методов, но и в

выяснении их, если можно так выразиться, физического

смысла, или, точнее, их смысла с точки зрения

специалиста по автоматическому управлению. На протяжении

этой главы мы будем предполагать, что имеется

достаточная априорная информация, и поэтому при решении

проблемы оптимальности можно использовать обычный

подход. Приводимые результаты имеют не только

самостоятельное значение, но и будут использованы в

дальнейшем, когда по аналогии мы будем развивать

адаптивный подход. Мы увидим, что, несмотря на разнообразие

рекуррентных методов, все они могут быть сведены

к довольно простым схемам.

§ 2.2. Условия оптимальности

Для детерминированных и стохастических процессов

при достаточной априорной информации (а только этот

случай и будет рассматриваться в настоящей главе)

критерий оптимальности, т. е. функционал / (с), известен

§ 2.2]

УСЛОВИЯ ОПТИМАЛЬНОСТИ

27

в явной форме, известны также и ограничения. Вначале,

если не оговаривается противное, будем предполагать,

что ограничения второго рода отсутствуют, а ограничения

первого рода, как это часто бывает, исключены путем

подстановки в функционал. При этом, разумеется,

первоначальная размерность искомого вектора с

уменьшается.

Если функционал J (с) допускает дифференцирование,

то он достигает экстремума (максимума или минимума)

только при таких значениях с = {си с2, • • •» cn), Ддя

которых N частных производных , ' (v = 1, 2, ...

. . . , iV) одновременно обращаются в нуль, или, иначе

говоря, для которых градиент функционала

«с>-(^ ^?) <2-'>

обращается в нуль.

Векторы с, удовлетворяющие условию

V/(c) = 0, (2.2)

называются стационарными или особыми. Не все

стационарные векторы оптимальны, т. е. соответствуют нужному

экстремуму функционала. Поэтому условие (2.2) является

лишь необходимым условием оптимальности.

Можно было бы выписать и достаточные условия

экстремума в виде неравенств относительно определителей,

содержащих частные производные второго порядка

функционала по всем компонентам вектора. Однако вряд

ли это стоит делать даже в тех случаях, когда это не

требует громоздких выкладок и вычислений.

Часто, исходя непосредственно из условий физической

задачи, для которой построен функционал, удается

определить, чему соответствует стационарный вектор,-—

минимуму или максимуму. Особенно легко это устанавливается

в тех часто встречающихся и интересных для нас случаях,

когда имеется всего один экстремум.

Условия оптимальности выделяют лишь локальные

экстремумы, и если их много, то задача нахождения

абсолютного или глобального экстремума становится

28 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

очень сложной. Некоторые возможности решения этой

задачи мы обсудим несколько позже.

Сейчас же мы ограничимся тем случаем, когда

оптимальное значение вектора с* единственно, и для

определенности будем считать, что экстремальное значение

функционала представляет собой минимум.

§ 2.3. Регулярный итеративный метод

Уравнение оптимальности (2.2) в общем случае

представляет собой нелинейное уравнение, и надежда

получить его решение аналитическим путем отсутствует почти

всегда, за исключением множества, как любят говорить

математики, пресловутой «меры нуль». Правда, в случае

квадратичных критериев оптимальности и линейных

ограничений первого рода нелинейные уравнения (2.2)

превращаются в линейные, и появляется возможность

применить упомянутое выше правило Крамера.

Применительно к таким линейным задачам «множество меры

нуль» часто превращается в бедствие для читателей

специальных технических журналов.

До самого последнего времени теория оптимальности

строилась на этом элегантном с математической точки

зрения и очень шатком с точки зрения практических

задач основании.

Если еще заметить, что линейные аналитические методы

могут выдержать испытание лишь при решении

сравнительно простых задач малой размерности, то сразу

становится очевидной необходимость в развитии и

применении алгоритмических, или, точнее, итеративных методов,

не требующих столь сильных ограничений, которые к тому

же не вызываются сутью задачи.

Основная идея решения уравнения (2.2) с помощью

регулярных итеративных методов состоит в следующем.

Представим уравнение (2.2) в равносильной форме

c = c-yVJ(c), (2-3)

где у— некоторый скаляр, и будем искать оптимальный

вектор с = с* с помощью, последовательных приближений

или итераций:

с [п] = с [п -г-1] - у [п] V/ (с [п—\]). (2.4)

§ 2.4]

АЛГОРИТМЫ ОПТИМИЗАЦИИ

29

Значение у [п] определяет величину очередного шага

и зависит от номера шага и, вообще говоря, от векторов

с [т] (т = п — 1, п — 2, . . .). При выполнении

соответствующих условий сходимости, которые далее мы

кратко рассмотрим, для любого начального выбора с =

= с [0] оказывается, что

lime [п] = с*. (2.5)

Методы определения с*, основанные на соотношении

(2.4), и называются итеративными методами. Поскольку

выбор начального значения с (0) однозначно

предопределяет дальнейшее значение последовательности с [/г],

или, как можно еще говорить, предопределяет

решетчатую функцию с [п]1 то эти итеративные методы мы

назовем регулярными, в отличие от вероятностных, которыми

мы будем оперировать в гл. III. Различные формы

регулярных итеративных методов отличаются друг от друга

конкретным выбором у [п].

Регулярным итеративным методам посвящена огромная

литература. К сожалению, многие из источников

используют хотя и узаконенную, но различную терминологию.

Нам нужно находить именно оптимальные значения

вектора, так как мы занимаемся проблемой

оптимальности. Поэтому, быть может, нам удобнее будет

использовать ту терминологию, которая наиболее близка к

терминологии рассматриваемой проблемы и относится не

столько к итеративным методам, сколько к эквивалентным

им алгоритмам оптимизации. О них пойдет речь в

следующем параграфе.

§ 2.4. Алгоритмы оптимизации

Соотношение (2.4) определяет последовательность

действий, которые нужно осуществить, чтобы определить

оптимальный вектор с*. Поэтому уместно назвать (2.4)

алгоритмом оптимизации. Этот алгоритм оптимизации

можно рассматривать как рекуррентное уравнение. Вводя

обозначение первой разности

Ас [п — 1] = с [п] — с [п — 1], (2.6)

АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

легко представить алгоритм оптимизации в виде

разностного уравнения

Де[и —1] = —yln]VJ(e[n — l]). (2.7)

Наконец, суммируя обе части этого уравнения от О

до д, получим алгоритм оптимизации в виде суммарного

уравнения

с[/1]=с[0]- 2 vMV/(c[m»l]),

(2.8)

m=l

которое, в отличие от (2.4) и (2.7), включает начальное

значение, с (0). Таким образом, алгоритмы оптимизации

\йс[л-1]

Д.

с[п-1]

7\

Рис. 2.1.

:>

л ^/,-/7 ^j^jV^

0

ЛСу[п-

в)

cv[n-1J

Рис. 2.2.

могут быть представлены в трех формах: рекуррентной,

разностной и суммарной.

Рекуррентные, разностные или суммарные уравнения

соответствуют некоторым дискретным системам с обратной

§ 2.5]

ВОЗМОЖНОЕ ОБОБЩЕНИЕ

31

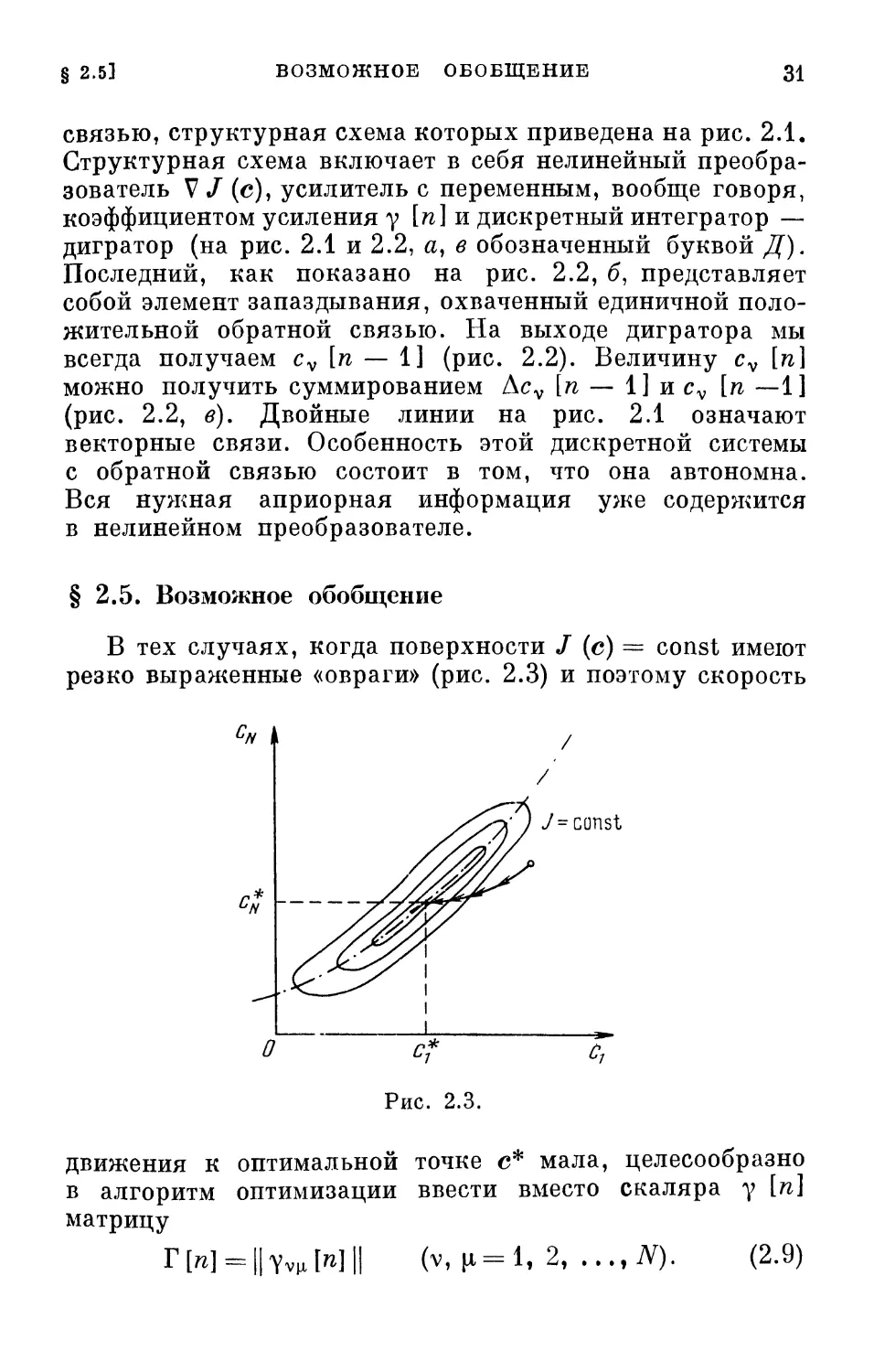

связью, структурная схема которых приведена на рис. 2.1.

Структурная схема включает в себя нелинейный

преобразователь V/ (с), усилитель с переменным, вообще говоря,

коэффициентом усиления у [п] и дискретный интегратор —

дигратор (на рис. 2.1 и 2.2, а, в обозначенный буквой Д).

Последний, как показано на рис. 2.2, б, представляет

собой элемент запаздывания, охваченный единичной

положительной обратной связью. На выходе дигратора мы

всегда получаем cv [п — 1] (рис. 2.2). Величину cv [п]

можно получить суммированием Acv [п —- 1] и cv [п —1]

(рис. 2.2, в). Двойные линии на рис. 2.1 означают

векторные связи. Особенность этой дискретной системы

с обратной связью состоит в том, что она автономна.

Вся нужная априорная информация уже содержится

в нелинейном преобразователе.

§ 2.5. Возможное обобщение

В тех случаях, когда поверхности / (с) = const имеют

резко выраженные «овраги» (рис. 2.3) и поэтому скорость

On

г*

О с* с7

Рис. 2.3.

движения к оптимальной точке с* мала, целесообразно

в алгоритм оптимизации ввести вместо скаляра у [п]

матрицу

rwHlYvuMH (v, (1=1, 2,..., iV). (2.9)

32 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

Рис. 2.4.

Тогда алгоритм (2.7) заменится на более общий алгоритм

Ас [п— 1] = — Г [п] V/ (с [п - 1]). (2.10)

В этом случае величины шагов по различным

компонентам различны и зависят друг от друга.

Выбор матрицы Г [п] можно, например, произвести

на основе того, что в некоторой окрестности точки

оптимума траектории парамет-

с к ? ров представляют собой

прямые линии, т. е.

Д/(с[Аг])= — Ы{с[п— 1]),

где к = const и

А/ (с [п]) =

= /(c[/i + l])-/(c[n]).

(2.11)

Геометрически

введению матрицы Г [п]

соответствует линейное

преобразование координат, при

котором эквипотенциальные линии преобразуются в

линии, близкие к концентрическим окружностям (рис. 2.4).

Структурная схема, соответствующая общему

алгоритму оптимизации, отличается от изображенной на

рис. 2.1 тем, что в ней вместо обычных усилителей

фигурирует «матричный» усилитель, в котором все выходы

и входы взаимно связаны друг с другом.

§ 2.6. Разновидности алгоритмов оптимизации

Выбор коэффициентов усиления матричного или

обычного усилителей определяет разновидности алгоритмов

оптимизации и соответствующих им дискретных систем.

Так, если Г [п] = Г — постоянная матрица, не

зависящая от п, то мы получим алгоритм оптимизации с

постоянным шагом и соответствующую дискретную систему

с постоянными коэффициентами усиления. Если Г [п]

зависит от п, то в этом случае получаем алгоритм

оптимизации с переменным шагом и соответствующую

дискретную систему с переменными коэффициентами усиления.

§ 2.0] РАЗНОВИДНОСТИ АЛГОРИТМОВ ОПТИМИЗАЦИИ 33

В частности, матрица Г [п] может быть периодична:

Г [п + л0] = Г [п].

В численных методах решения систем линейных

уравнений перечисленные выше алгоритмы называются

соответственно стационарными, нестационарными и

циклическими.

В обшем случае Г [п] может зависеть от векторов

с [т] (т = п — 1, п — 2, . . .). В этом случае приходим

к алгоритмам оптимизации с «нелинейным» шагом и

соответствующей дискретной системе с нелинейными

коэффициентами усиления.

К алгоритмам последнего типа относятся

релаксационные алгоритмы, в которых Г [п] на каждом шаге

выбираются так, чтобы уменьшалась какая-либо функция

ошибки с [п\—с*. Релаксационные алгоритмы

подразделяются на координатные, в которых матрицы Г [п]

подобраны так, что на каждом шаге меняются одна или

несколько компонент вектора с [л], и градиентные,

в которых

Т[п] = 1у[п], (2.12)

где / — единичная матрица, а у [л] — скаляр, зависящий

также и от координат вектора с. Так, к алгоритмам с

нелинейным шагом можно отнести известный алгоритм Ньютона

Дс [л —1] - - [W (с [n-i])]-1 V/ (с [л- 1]). (2.13)

Здесь

Г[л]--[?2/(с[л —l])]"1. (2.14)

Модификация алгоритма Ньютона

Дс [л- 1] = — [ W (с [О])]"1 V/ (с [п - 1]), (2.15)

где с [01 — некоторое начальное значение, представляет

собой алгоритм с постоянным шагом.

К релаксационным алгоритмам относится известный

алгоритм наискорейшего спуска

Дс [л— 1] = — у[п] V/ (с [л- 1]). (2.16)

Здесь у [л] на каждом шаге выбирается из условия

минимума функции

Y (Y) = / (с [л- 1] -yVJ (с [л- 1])). (2.17)

Итак, выбирая соответствующим образом Г [л] или у [л],

мы получаем различные известные алгоритмы.

3 Я. 3. Цыпкин

34 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ (Гл. И

§ 2.7. Поисковые алгоритмы оптимизации

Не всегда можно вычислить в явной форме градиент

функционала (2.1), а значит, и использовать все те

алгоритмы оптимизации, о которых шла речь выше.

Такая ситуация возникает, когда функционал / (с)

разрывен или недифференцируем, либо когда его

зависимость от с выражена в неявной форме. Этот последний

случай характерен для функционалов вида (1.5) и (1.8).

К нему же относятся функционалы, которые

формулируются с помощью логических операций.

В этих условиях, вероятно, единственная возможность

решения проблемы оптимизации связана с поисковыми

способами отыскания экстремума. Если мы не можем

заранее вычислить градиент, то нужно определять его

путем измерений. При поисковых способах и

осуществляется измерение величин, по которым косвенно

оценивается градиент. Существует большое разнообразие поис-

ковых способов, разработанных в основном в связи с

с построением экстремальных систем управления. Мы

здесь не будем рассматривать все поисковые способы,

а остановимся лишь на простейших классических, чтобы

оттенить некоторые принципиальные вопросы. После

их уяснения читатель без особых усилий сможет взять

на вооружение разнообразные поисковые способы, которые

были здесь опущены.

Введем обозначения векторов, компонентами которых

являются значения функционала при измененных

значениях векторов с:

J+(c, a) = (J{e + aex), . . ., J{c + aeN)), ^ ^

J- (с, а) — (J (e — aei), . . ., / (c — aeN)).

Здесь а — скаляр, ev — базисные векторы.

В простейшем случае

et = (l, 0,...,0)-,^-(0, 1, ...,0); . . .; eN = (0, 0, ..., 1).

(2.19)

Тогда градиент можно приближенно оценивать по формуле

J+{r"a)-J-(e'e) ~ Vc±J (с, а), (2.20)

§ 2.71

ПОИСКОВЫЕ АЛГОРИТМЫ ОПТИМИЗАЦИИ

Зо

определяющей так называемую разделенную разность.

Заменив в приведенном ранее общем алгоритме

оптимизации (2.4) градиент функционала его приближенным

значением (2.20), получим поисковый алгоритм

оптимизации

с [п] = с [и- 1] - у W Vr±/ (г [п - 1], а [п]). (2.21)

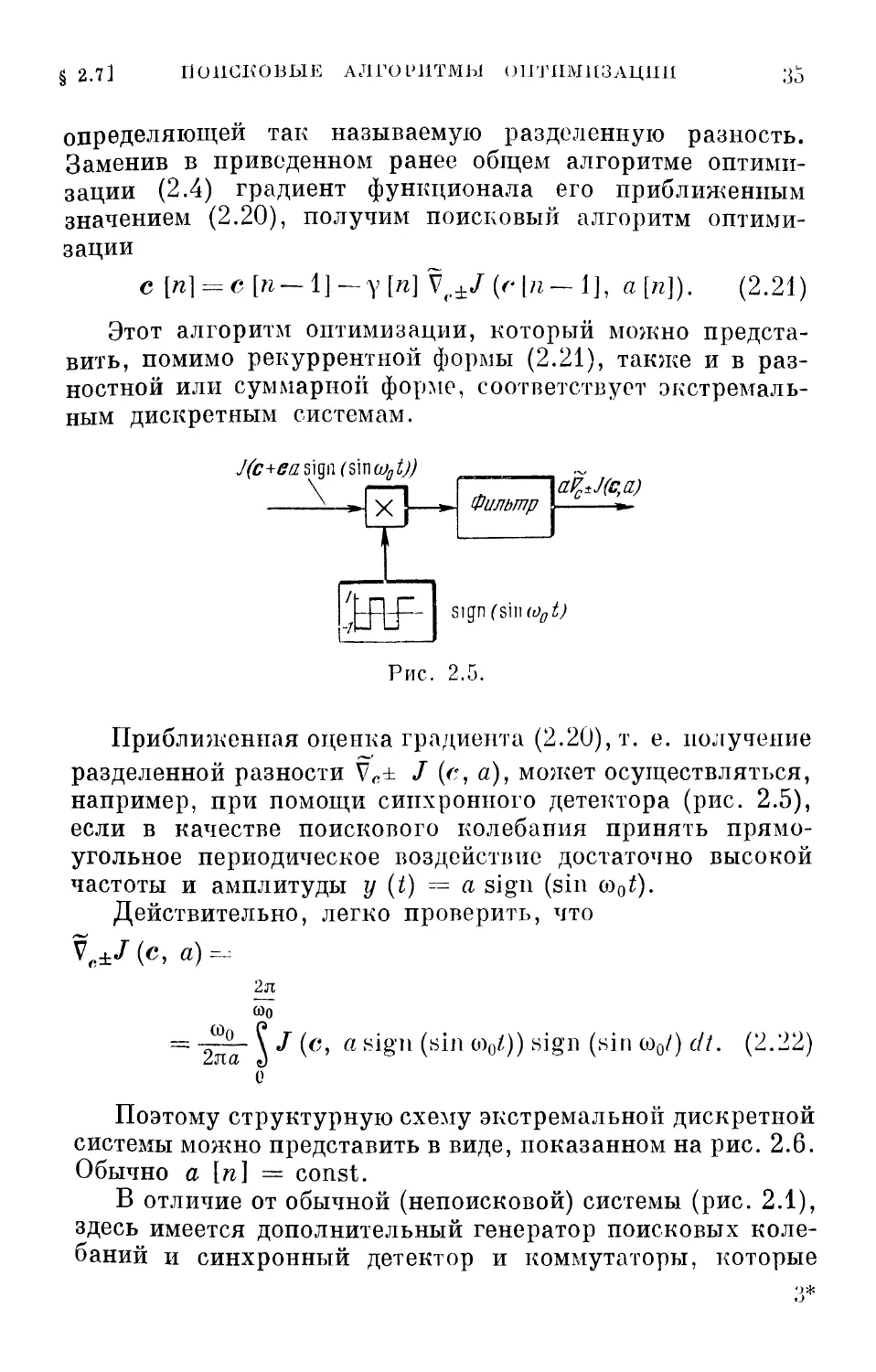

Этот алгоритм оптимизации, который можно

представить, помимо рекуррентной формы (2.21), также и в

разностной или суммарной форме, соответствует

экстремальным дискретным системам.

J(c+ffas]qn(s\\\(oet))

aPc±J(c,a)

щп(ът1о0Ь)

Рис. 2.5.

Приближенная оценка градиента (2.20), т. е. получение

разделенной разности Vc± / (с, а), может осуществляться,

например, при помощи синхронного детектора (рис. 2.5),

если в качестве поискового колебания принять

прямоугольное периодическое воздействие достаточно высокой

частоты и амплитуды у (t) = a sign (sin оэ0£).

Действительно, легко проверить, что

V„±/(c, а)-

ю0

2я

Щ

2ла

\ / (с, a sign (sin о)0/,)) sign (sin со0/) с//. (2.22)

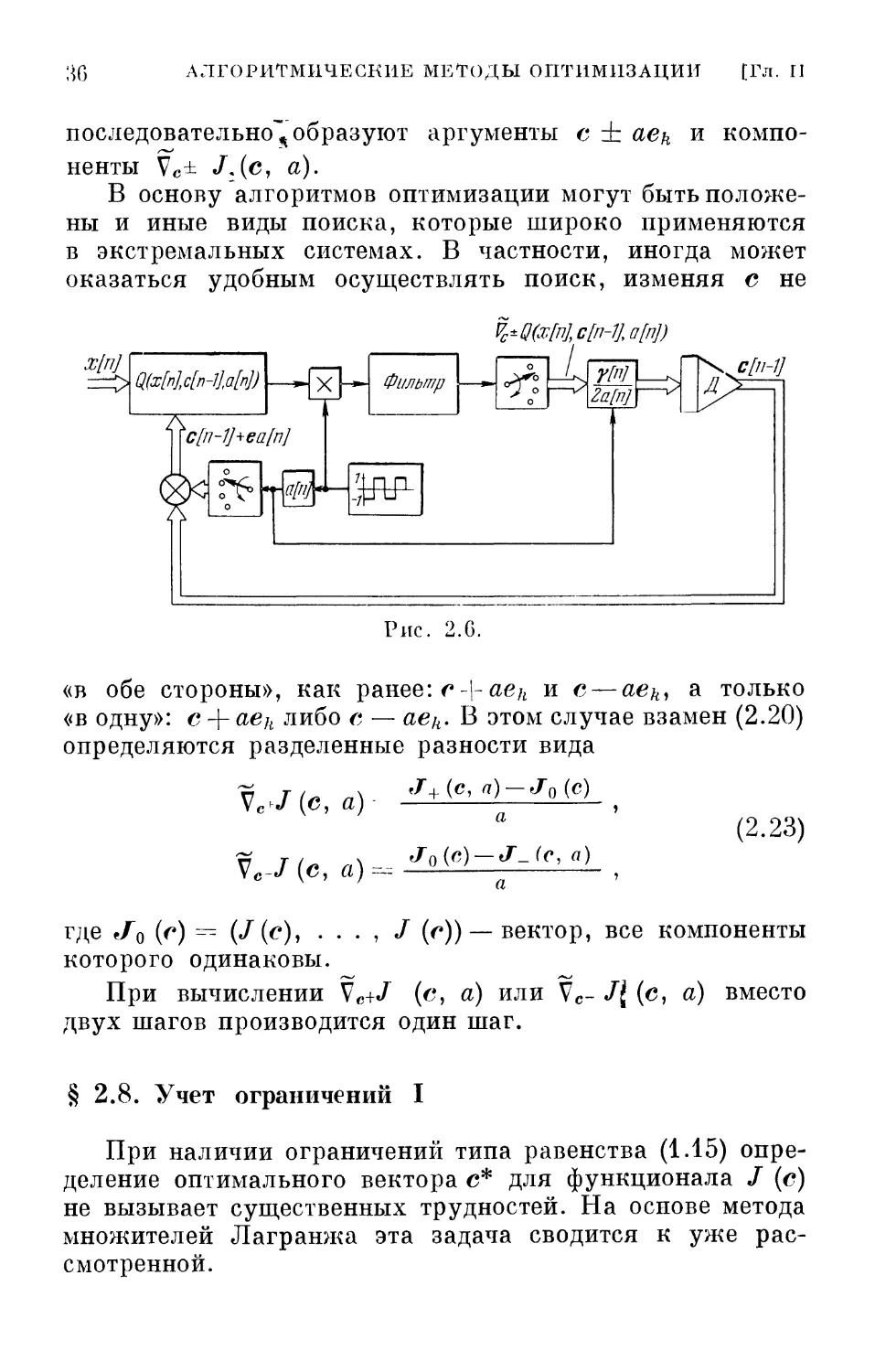

Поэтому структурную схему экстремальной дискретной

системы можно представить в виде, показанном на рис. 2.6.

Обычно а [п] = const.

В отличие от обычной (непоисковой) системы (рис. 2.1),

здесь имеется дополнительный генератор поисковых

колебаний и синхронный детектор и коммутаторы, которые

3*

;^G АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

последовательно^ образуют аргументы с ± аеи и

компоненты Vc± JAC> а)-

В основу алгоритмов оптимизации могут быть

положены и иные виды поиска, которые широко применяются

в экстремальных системах. В частности, иногда может

оказаться удобным осуществлять поиск, изменяя с не

х[п]

ЦШЛп-ЫФ

7\

'c[n-1J+ea[nJ

ге

X \—\ Фильтр

%±ЧШ,с[п-1],а[Ф

L I vfn] I А

°Г«

Ш-

Рис. 2.G.

«в обе стороны», как ранее: c\aeh и с— aekl а только

«в одну»: с + aek либо с — аед. В этом случае взамен (2.20)

определяются разделенные разности вида

J+(c, a) — J0(c)

(2.23)

Ve-/(c, а)

Vc^(c, а)

J0(c)-J-_(c, а)

где в/0 (<*) ~ (J(e)i - - - , J (г)) —вектор, все компоненты

которого одинаковы.

При вычислении Vc+^ (е, а) или Vc- /f (с, а) вместо

двух шагов производится один шаг.

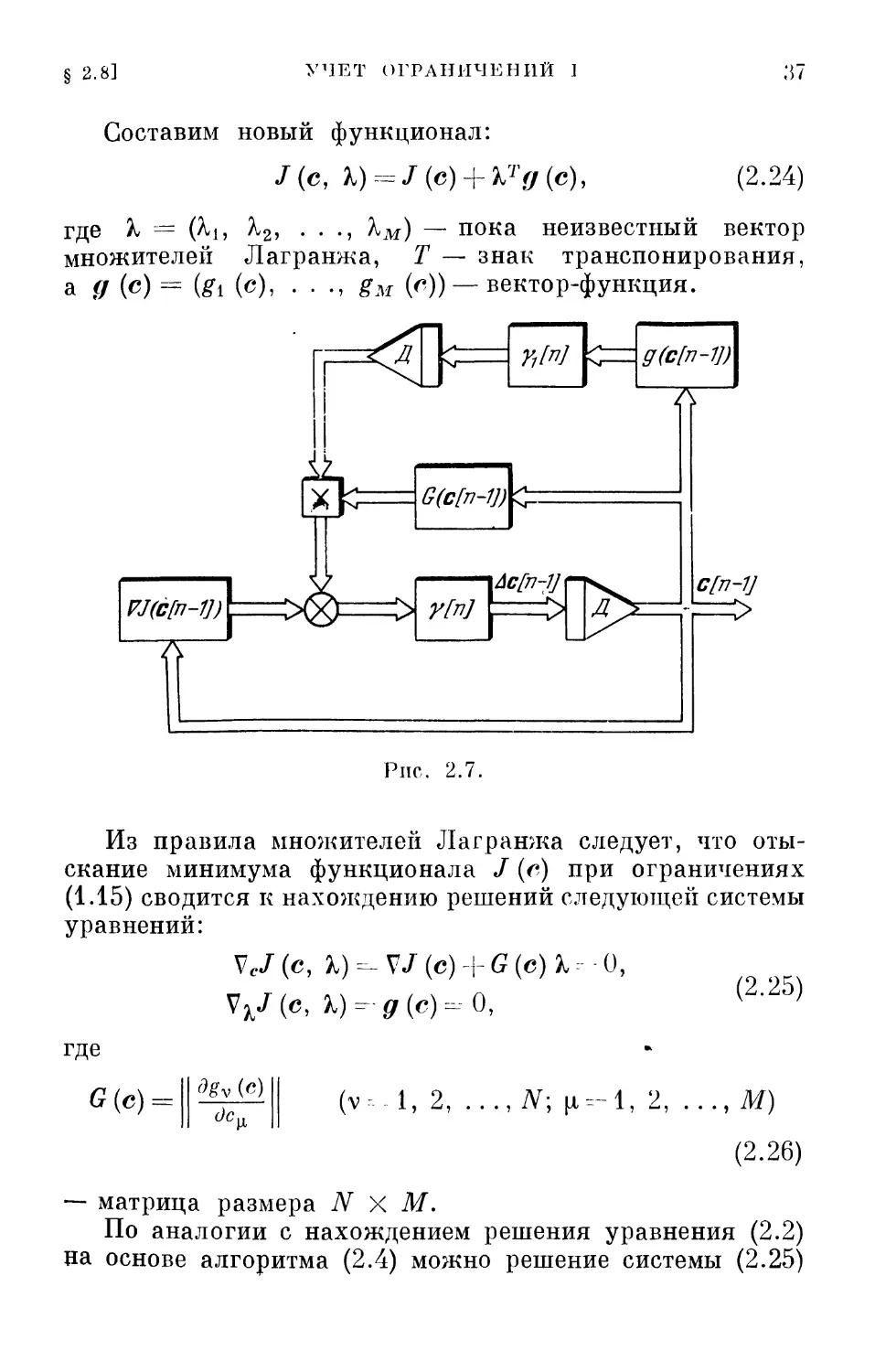

§ 2.8. Учет ограничений I

При наличии ограничений типа равенства (1.15)

определение оптимального вектора с* для функционала / (с)

не вызывает существенных трудностей. На основе метода

множителей Лагранжа эта задача сводится к уже

рассмотренной.

§ 2.8]

УЧЕТ ОГРАНИЧЕНИЙ I

Составим новый функционал:

/(с, X) = J(e) + bTg(c),

(2.24)

где % = (^ь ^25 • • •> ^м) — пока неизвестный вектор

множителей Лагранжа, Т — знак транспонирования,

а д (с) = (gi (с), - • •» £м И) — вектор-функция.

VJ(c[n-1])\

—Л

Г^Н

км

й^Н

#&/&-»

> >"/*7

Aefn-JJ

Д

Рнс. 2.7.

ff(c[n-Vy

7\

c[n-V

Из правила множителей Лагранжа следует, что

отыскание минимума функционала / (с) при ограничениях

(1.15) сводится к нахождению решений следующей системы

уравнений:

VcJ(c, %)=-VJ(c) + G{e)b=--0,

VkJ(c, Я)-fir (с) =--0,

(2.25)

где

G(c) =

3gv (с)

cJc„

(v-l, 2, ..., iV; (1=-1, 2,

,М)

(2.26)

— матрица размера N X М.

По аналогии с нахождением решения уравнения (2.2)

па основе алгоритма (2.4) можно решение системы (2.25)

38 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

определять с помощью алгоритмов

cl?i] = c[n-l\-y[n]XcJ(c[n-l], M'i-1]), (227)

l[n] = b[n—l]—yl[n]\bJ(c[n — l], k[n—l]),

или

а \п]-- r[/i-l]-yM[V/(r[«-l]) +

+ G(c[w —1])М« —1Ц, (2.28)

Ми]= ^[«-lJ-Yil"]flr(cfw-ll).

Наличие ограничений типа равенств несколько

усложняет структурную схему, соответствующую алгоритмам

оптимизации. В ней добавляются специальные контуры

для определения множителей Лагранжа (рис. 2.7).

Возможны и иные алгоритмы оптимизации, которые

отличаются иным определением множителей Лагранжа,

но мы их сейчас касаться не будем.

§ 2.9. Учет ограничении II

Ограничения типа неравенств не позволяют

использовать классические подходы, которые мы до сих пор широко

использовали. Для учета ограничений этого типа

приходится прибегать к новому математическому аппарату —

математическому программированию, возникшему

сравнительно недавно.

Условия оптимальности в этом случае даются теоремой

Куна — Таккера, которая представляет собой обобщение

метода Лагранжа на случай ограничений типа неравенств.

Теорема Куна — Таккера утверждает, что оптимальный

вектор г* удовлетворяет следующим условиям:

V,/ (г, Ь) = V/ {с) + G(e)b = 0; ^

д(е) ' 6=-0; Ь>0, 6>0; [ (2.29)

1тЬ-0. J

Условия записаны в векторной форме, 'к = (?ц, А,2» • • •

• • • i ^Mi), 6 = (Si, б2, . . • , 6Ml); неравенства к > 0,

6 > 0 означают, что все компоненты этих векторов

неотрицательны. Кроме того, предполагается, что ограниче-

§ 2.9]

УЧЕТ ОГРАНИЧЕНИЙ IT

39

ния (1.14) таковы, что существует вектор г, для которого

gv(e)<0 (v = l, 2, ..., М,). (2.30)

Это — известное в теории нелинейного

программирования условие регулярности Слейтера.

Условия (2.29) имеют простой смысл: если для

оптимального вектора с* несущественно какое-то ограничение,

:д

УМ

g(c[n-w

~к

G(c[n-1])

с[п-1]

Рис. 2.8.

т. е. gv (с*) <С 0 для какого-то v, то соответствующее

Xv — 0; если же Xv > 0, то в этом случае 8V = gv (г**) = 0.

Таким образом, множители Лагранжа можно

интерпретировать как некоторые оценки влияния ограничений

(1.14) на оптимальное значение вектора.

Заметим, что если функционалы J (с) и gv (с) (v =

= 1, 2, . . ., Afi) выпуклы, то теорема Куна— Таккера

дает необходимые и достаточные условия оптимальности.

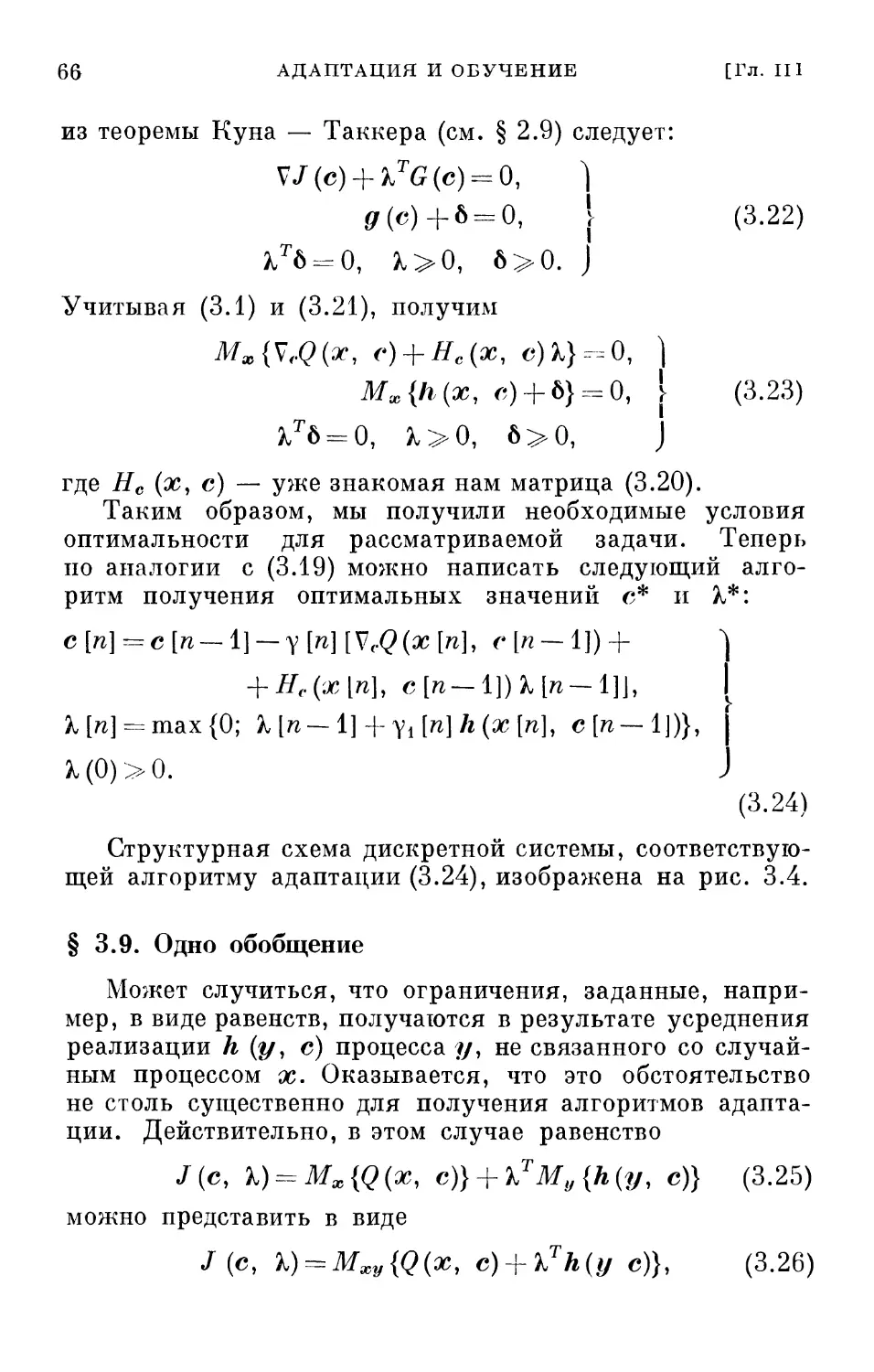

Применяя к (2.29) алгоритмы оптимизации, нетрудно

получить, что

с [п] = с [п — 1] — у [п] [ V/ (с \п — 1]) +

+ С(с[л-1])М,

I [п] = max {0, % \п - 1 ] + у, [п] д {с [п - 1])},

40] >о.

(2.31)

40 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

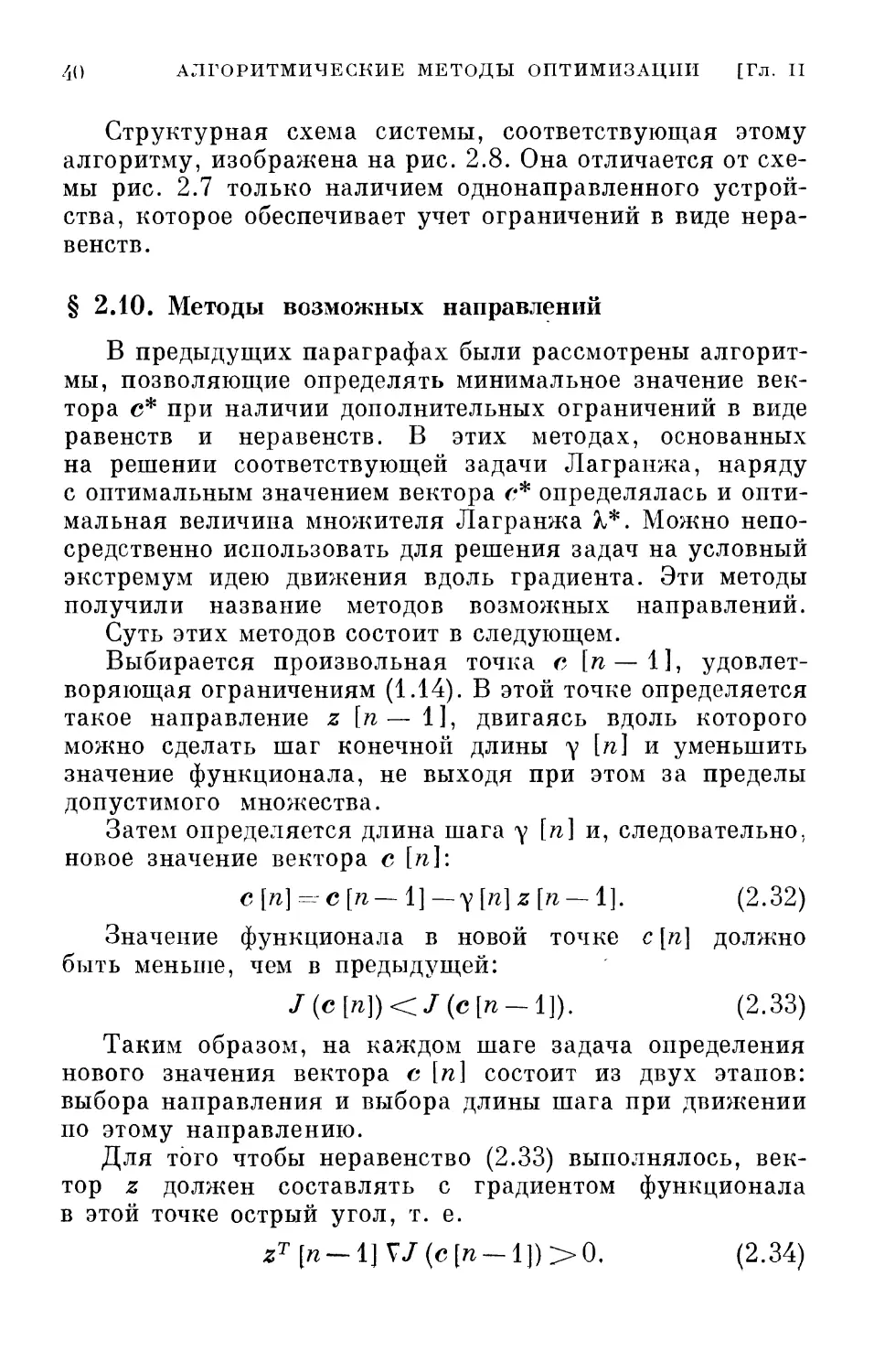

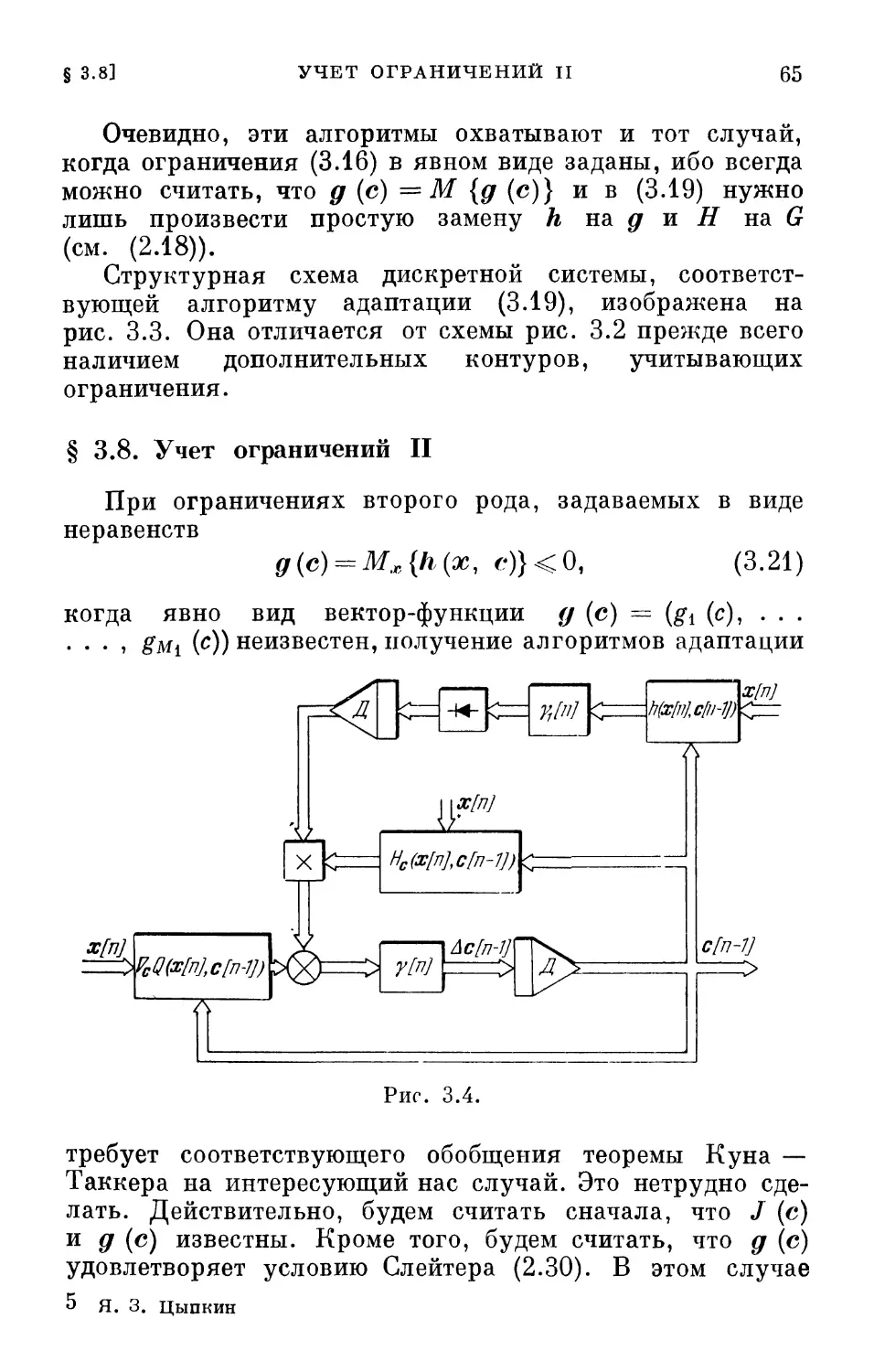

Структурная схема системы, соответствующая этому

алгоритму, изображена на рис. 2.8. Она отличается от

схемы рис. 2.7 только наличием однонаправленного

устройства, которое обеспечивает учет ограничений в виде

неравенств.

§ 2.10. Методы возможных направлений

В предыдущих параграфах были рассмотрены

алгоритмы, позволяющие определять минимальное значение

вектора с* при наличии дополнительных ограничений в виде

равенств и неравенств. В этих методах, основанных

на решении соответствующей задачи Лагранжа, наряду

с оптимальным значением вектора с* определялась и

оптимальная величина множителя Лагранжа %*. Можно

непосредственно использовать для решения задач на условный

экстремум идею движения вдоль градиента. Эти методы

получили название методов возможных направлений.

Суть этих методов состоит в следующем.

Выбирается произвольная точка с [п—1],

удовлетворяющая ограничениям (1.14). В этой точке определяется

такое направление z [п— 1], двигаясь вдоль которого

можно сделать шаг конечной длины у [п] и уменьшить

значение функционала, не выходя при этом за пределы

допустимого множества.

Затем определяется длина шага у [п] и, следовательно,

новое значение вектора с [п]\

с [л] = с [п—1]—у[п] z[n~ 1]. (2.32)

Значение функционала в новой точке с [п] должно

быть меньше, чем в предыдущей:

J(c[n])<J(c[n — l]). (2.33)

Таким образом, на каждом шаге задача определения

нового значения вектора с [п] состоит из двух этапов:

выбора направления и выбора длины шага при движении

по этому направлению.

Для того чтобы неравенство (2.33) выполнялось,

вектор z должен составлять с градиентом функционала

в этой точке острый угол, т. е.

zT\n--i} V/(c[w —1])>0, (2.34)

§ 2.11]

ОБСУЖДЕНИЕ

/j]

Направление, удовлетворяющее неравенству (2.34),

получило название возможного. Отсюда и название всех

методов такого рода.

Величина шага у [п] определяется так же, как и в

методе наискорейшего спуска, т. е.

J(c[n—l] — y[n]z[n—l]) = min J. (2.35)

Y

При этом, конечно, не должны нарушаться ограничения

(1.14).

Для частных задач методы возможных направлений

могут обеспечить нахождение экстремума за конечное

число шагов.

Нужно отметить, что многие эффективные алгоритмы

математического программирования (например, симплекс-

метод в линейном программировании) можно трактовать

как специальные случаи методов возможных направлений.

§ 2.11. Обсуждение

Алгоритмические методы определения экстремума,

о которых мы до сих пор говорили, имеют простой

«житейский» смысл. Его удобно пояснить на поведении

спелеолога, исследующего пещеру и пытающегося достичь

наибольшей глубины. Спелеолог может осветить или

обследовать характер местности лишь в непосредственной

близости от своего местонахождения. Как он будет

поступать в этих условиях? Очевидно, он прежде всего выберет

направление наиболее крутого наклона (т. е. направление

вдоль градиента). Затем он буде! двигаться в этом

направлении, пока это движение будет приводить к спуску, и,

наконец, он остановится тогда, когда любое направление

будет приводить к подъему. Места остановки и

представляют собой локальные минимумы. Если имеются

ограничения в виде равенств — узкие проходы,— то спелеологу

ничего не останется, как идти вдоль этих узких проходов

до тех пор, пока он не достигнет в них самого низкого

места.

Если же имеются ограничения в виде неравенств, т. е.

если спелеолог наталкивается на стену, то ему придется

идти вдоль стены вниз до тех пор, пока он не достигнет

такого места, откуда уже все направления ведут вверх.

42 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

Такое поведение спелеолога иллюстрирует основную

идею градиентных методов, выраженную и в алгоритме

оптимизации. Нужно подчеркнуть, что эти методы имеют

локальный характер. Спелеолог, достигнувший какого-

нибудь низкого места в пещере, не может быть уверен,

что даже неподалеку нет еще более низкого места.

Из нелокальных методов определения экстремума

наиболее интересным и эффективным является известный

метод оврагов. Мы, однако, на нем останавливаться не

будем не только потому, что он достаточно хорошо описан,

но и потому, что задачи, решаемые с его помощью, лежат

несколько в стороне от направления, которое будет

интересовать нас далее.

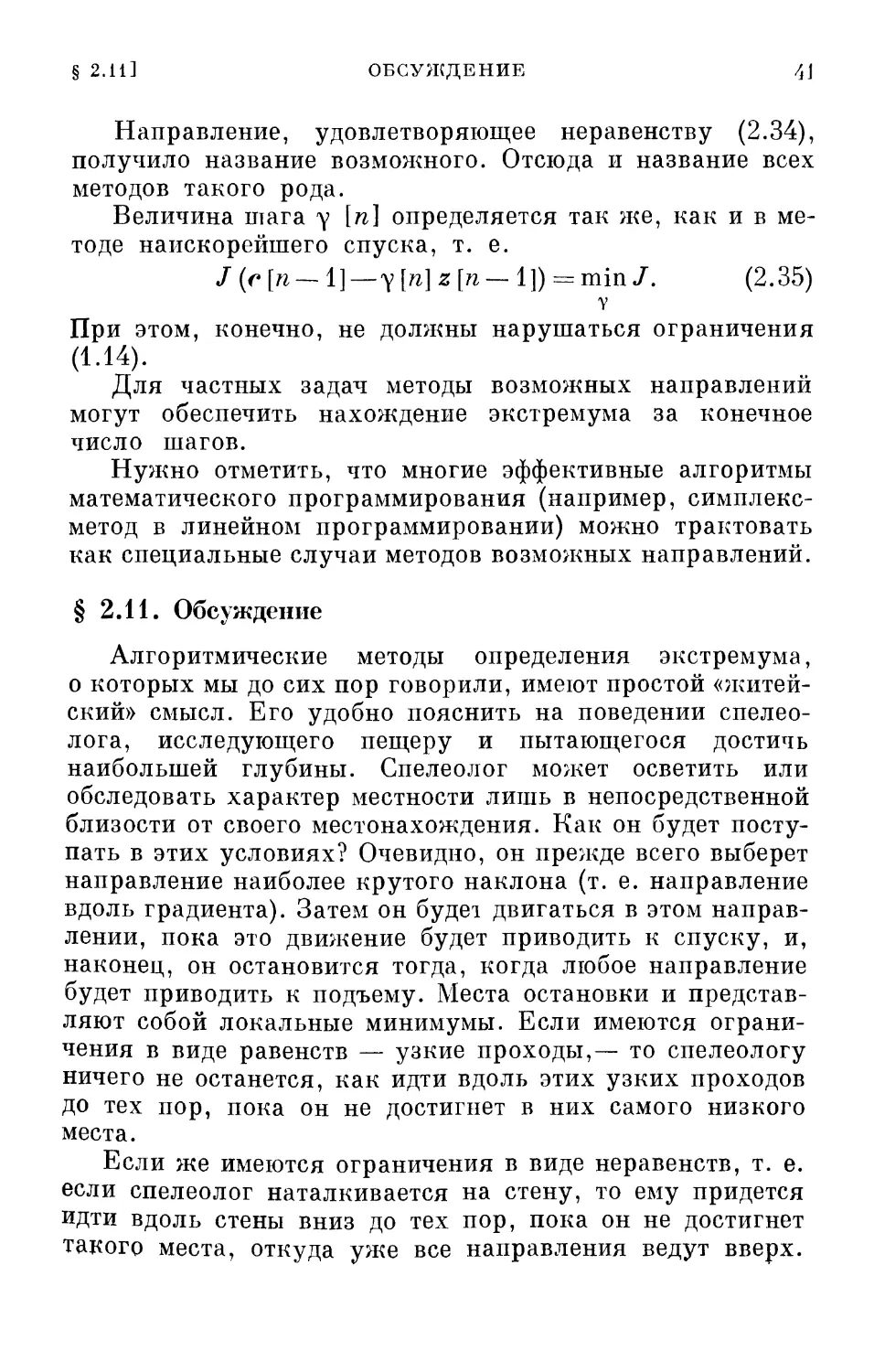

§ 2.12. Многошаговые алгоритмы оптимизации

Все алгоритмы оптимизации, которые мы до сих пор

обсуждали, относятся к одношаговым алгоритмам. Они

Рис. 2.9.

представляются в виде векторного разностного уравнения

первого порядка, и поэтому их можно назвать алгоритмами

первого порядка.

Если функционал J (с) имеет несколько экстремумов,

то одношаговые алгоритмы позволяют определить лишь

локальные экстремумы. Для определения абсолютного,

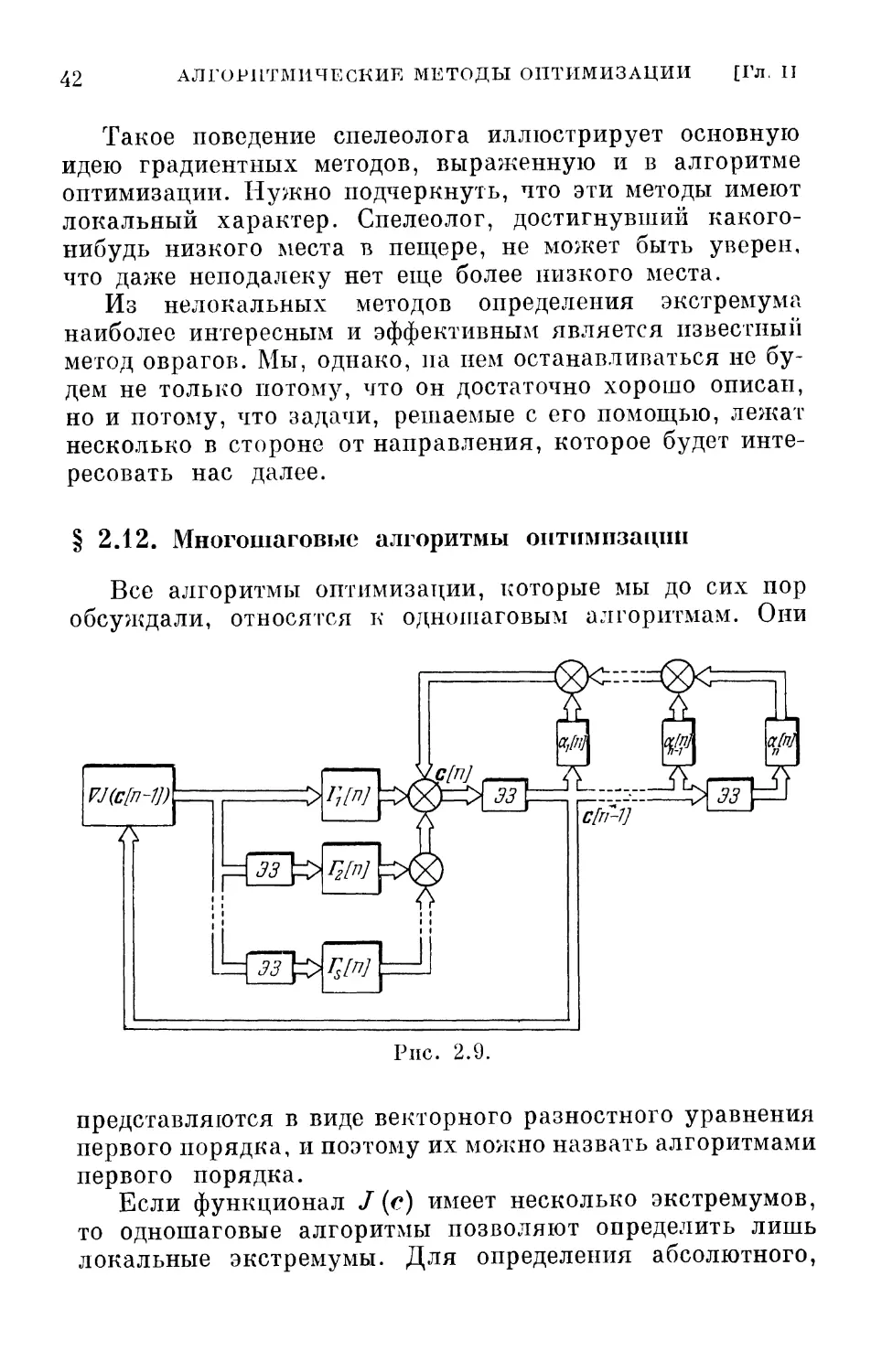

§ 2.12] МНОГОШАГОВЫЕ АЛГОРИТМЫ ОПТИМИЗАЦИИ 43

глобального экстремума можно попытаться применять

многошаговые алгоритмы оптимизации, например

алгоритмы вида

с [п] = 2 <*тс[п-т]— § rm[rclV/(С [71-1711) (2.36)

7П=1 771= 1

или

s si _

с\п\= 2 amc\n — m\ — Y[n]VJ( ^ атС[п — т\). (2.37)

тл=1 m=i

Алгоритмы (2.36), (2.37) тесно связаны между

собой. Один получается из другого несложной заменой

VJ(-)

~К

«М

\аЩ

Щ=^Щ^у^^,ф^1

х'тг^че

Clll-Sj

\ocj[n]\

-ВЫ.

\аМ

km

Рис. 2.10.

переменных. В этих алгоритмах коэффициенты ат и а,п не

произвольны, а удовлетворяют соотношениям

S

а»

1; У. am-l,

(2.38)

m=l

которые вытекают из того условия, что при замене с [т]

на с* должно выполняться равенство V/ (с*) =- 0.

Структурные схемы, реализующие алгоритмы (2.36) и (2.37),

показаны на рис. 2.9 и 2.10.

Многошаговые алгоритмы можно представить не только

в рекуррентной, но и в разностной форме. Для этого

достаточно воспользоваться известной в теории конечных

44 АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. II

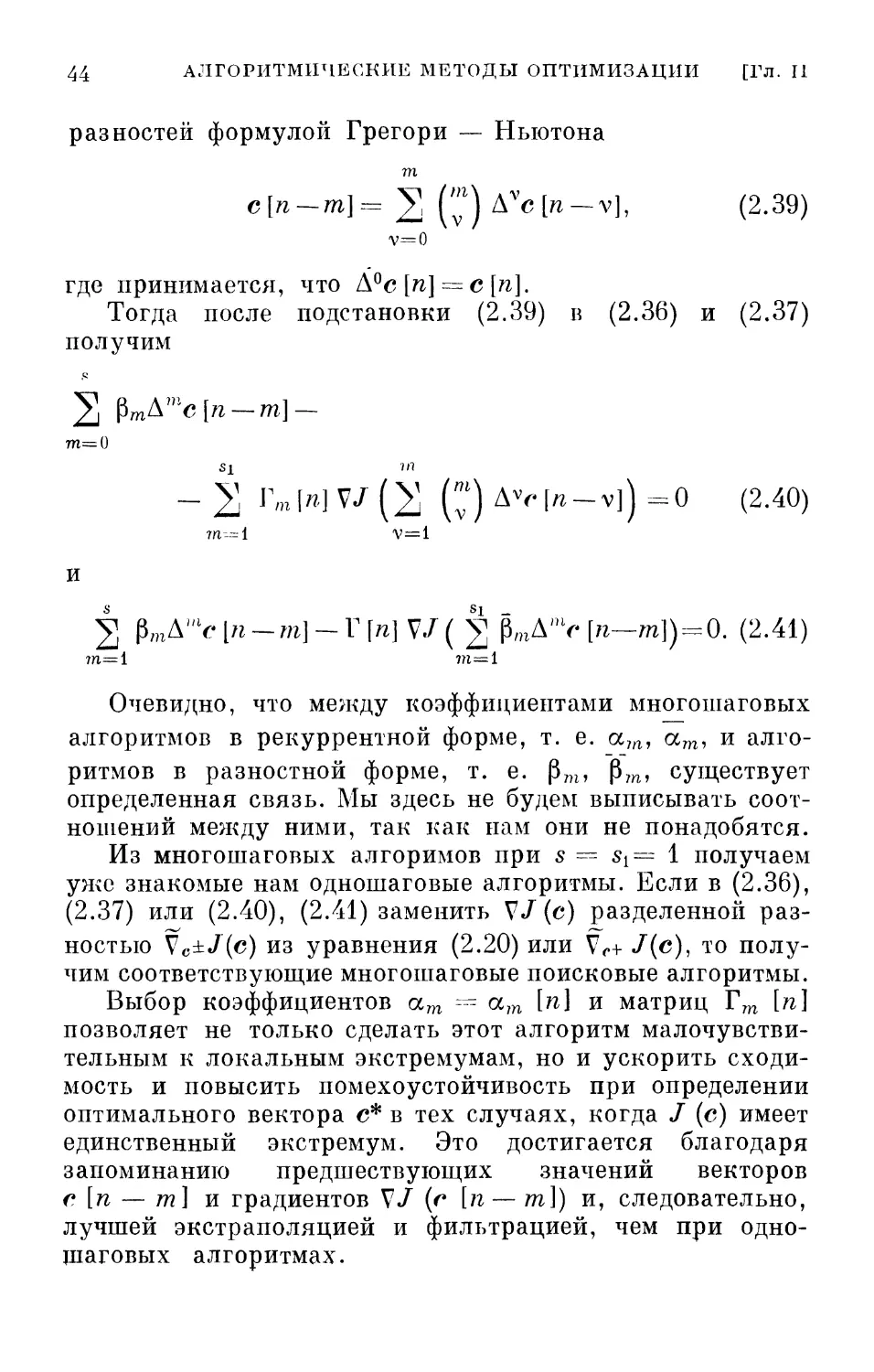

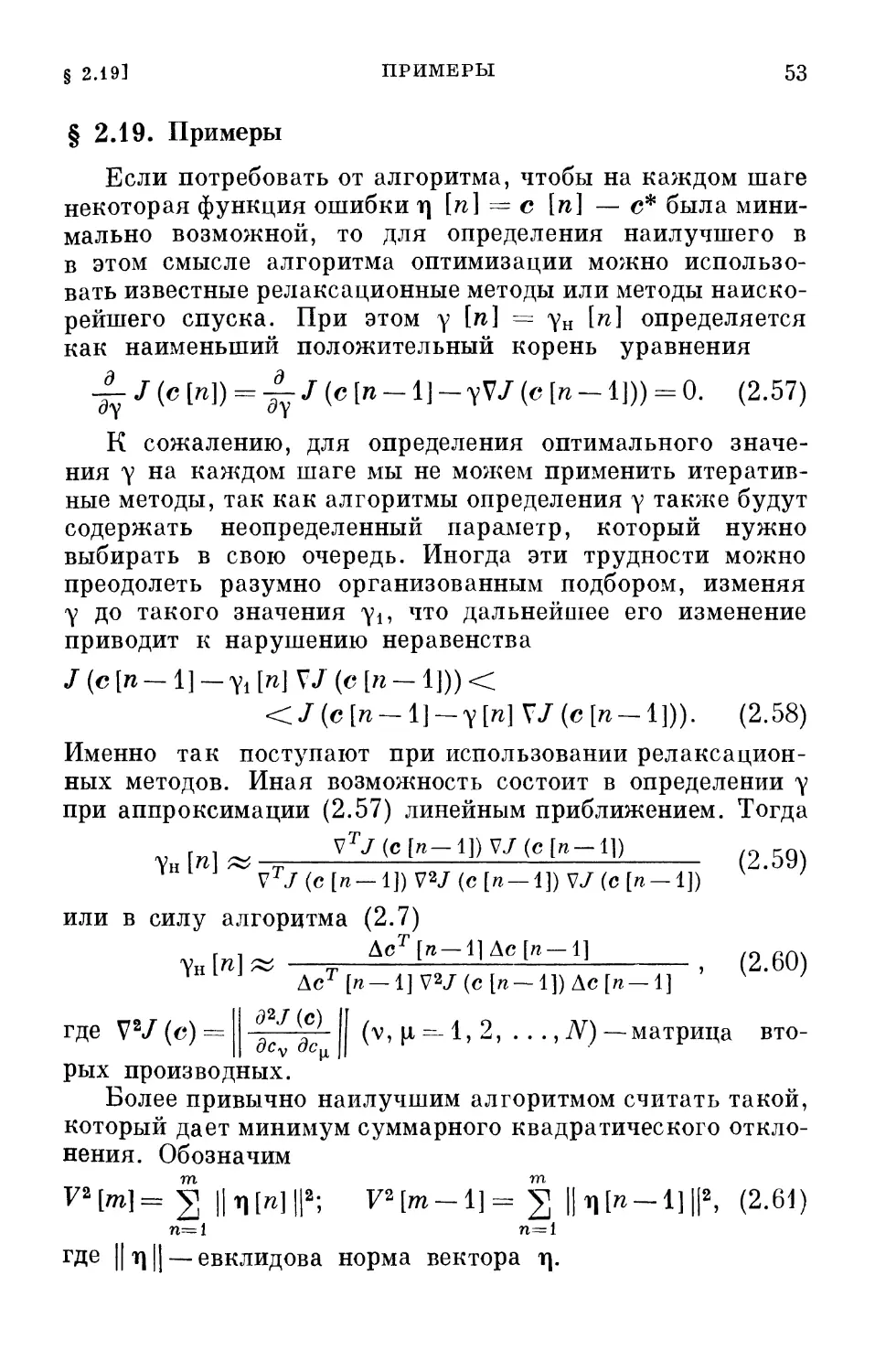

разностей формулой Грегори — Ньютона

т

с[п-т]= 2 (7) Avc[n-v], (2.39)

v=0

где принимается, что А°с [п] = с [п].

Тогда после подстановки (2.39) в (2.36) и

получим

771= О

si т

-23 Im[»]V/(2] (;i)AV[n-v])=0

m—i v=i

И

2 pmA'V^-m]-rH V/( § M> [^-^1) = 0. (2.41)

?П=1 771=1

Очевидно, что между коэффициентами многошаговых

алгоритмов в рекуррентной форме, т. е. ост, ат, и

алгоритмов в разностной форме, т. е. рт, рт, существует

определенная связь. Мы здесь не будем выписывать

соотношений между ними, так как нам они не понадобятся.

Из многошаговых алгоримов при s = s{= 1 получаем

уже знакомые нам одношаговые алгоритмы. Если в (2.36),

(2.37) или (2.40), (2.41) заменить V/(с) разделенной

разностью Vc±/(c) из уравнения (2.20) или Vr+ J{c), то

получим соответствующие многошаговые поисковые алгоритмы.

Выбор коэффициентов ат — ат [п] и матриц Гт [п]

позволяет не только сделать этот алгоритм

малочувствительным к локальным экстремумам, но и ускорить

сходимость и повысить помехоустойчивость при определении

оптимального вектора с* в тех случаях, когда / (с) имеет

единственный экстремум. Это достигается благодаря

запоминанию предшествующих значений векторов

е [п — т] и градиентов V/ {г [п — тХ) и, следовательно,

лучшей экстраполяцией и фильтрацией, чем при одно-

шаговых алгоритмах.

(2.37)

(2.40)

§ 2.13] НЕПРЕРЫВНЫЕ АЛГОРИТМЫ ОПТИМИЗАЦИИ 45

Физическую интерпретацию этих особенностей

многошаговых алгоритмов оптимизации мы дадим в следующем

параграфе. Нужно только отметить, что, к сожалению,

общие способы выбора коэффициентов ат и Гт [п] пока

неизвестны.

§ 2.13. Непрерывные алгоритмы оптимизации

Дискретным алгоритмам оптимизации, которые до сих

пор мы и рассматривали, можно поставить в соответствие

непрерывные алгоритмы оптимизации. Эти последние

алгоритмы получаются посредством предельного перехода

от разностных уравнений к дифференциальным. Так,

из (2.7) и (2.41) при Si = 1 после замены дискретного

времени п непрерывным временем t, а разностей —

производными получаем непрерывные алгоритмы

оптимизации.

Одношаговый алгоритм при этом определяется

уравнением

il|£L=_r(0V/(c(0), (2.42)

а многошаговые — уравнением

S

2 К^Р— - Г (I) V/ (с (/)). (2.43)

В отличие от дискретных, для непрерывных

алгоритмов по их самой природе не существует рекуррентной

формы и возможны лишь дифференциальные формы

(2.42), (2.43) и соответствующие им интегральные формы,

которые мы пока выписывать не будем.

Поскольку для непрерывных алгоритмов не

существует понятия конечного шага, то вместо одно- и

многошаговых алгоритмов удобнее их называть алгоритмами

первого и высших порядков. Можно указать на большое

число разновидностей непрерывных алгоритмов

оптимизации, хотя до последнего времени они были мало

распространены на практике. Это связано с тем, что дискретные

алгоритмы очень хорошо приспособлены как для ручного

счета, так и для счета на цифровых вычислительных

машинах. Непрерывные же алгоритмы непосредственно

\{\ АЛГОРИТМИЧЕСКИЕ МЕТОДЫ ОПТИМИЗАЦИИ [Гл. П

для ручного счета непригодны. Однако их можно

реализовать с помощью аналоговых вычислительных машин.

Собственно говоря, уже довольно давно непрерывные

алгоритмы типа (2.42) использовались для нахождения

решения систем конечных (алгебраических,

трансцендентных) уравнений на аналоговых вычислительных машинах.

И если рассматривать условия оптимальности как систему

конечных уравнений, то многие из приемов решения

конечных уравнений можно рассматривать как непрерывные

алгоритмы оптимизации.

Для выяснения особенностей алгоритмов более высоких

порядков и придания им определенного физического

смысла рассмотрим алгоритм оптимизации второго

порядка, который получается из (2.43) при 5=2:

Ро ^ + P. ^- + Г (О V/ (с (0) = 0. (2.44)

Если здесь положить ро = 0 и (^ — 1, то мы получим

алгоритм оптимизации первого порядка (2.42).

Уравнение (2.44) описывает движение тела («тяжелого

шарика») массы ро» обладающего коэффициентом вязкого

трения Pi и переменным коэффициентом упругости Г (t)

в потенциальном поле. Выбирая соответствующие

параметры «тяжелого шарика» (|30, Р^, мы придаем ему

возможность, с одной стороны, проскакивать небольшие

локальные минимумы и, с другой стороны, быстрее достигать

абсолютного глобального минимума. Разумеется, этот

вывод справедлив и для дискретных многошаговых

алгоритмов оптимизации, хотя для них физическая

интерпретация оказывается несколько иной.

Для читателя, вероятно, не представит затруднений

получить соответствующие непрерывные поисковые

алгоритмы оптимизации.

§ 2.14. Методы случайного поиска

Во всех регулярных итеративных методах поиска

минимума J (с) для получения текущей оценки с [п]

параметра с делается неслучайный шаг, однозначно

определяемый либо значением градиента V/ (с) при е = с [п],

либо значением самой функции J (г).

§ 2.15] СХОДИМОСТЬ И УСТОЙЧИВОСТЬ 47

В методах случайного поиска при переходе от с [п — 1 ]

к с [п] делается случайный шаг у£,, гДе £— единичный

случайный вектор, чаще всего равномерно

распределенный в тг-мерной единичной сфере; у — величина шага.

В этом случае

е[п] = с [п — 1] —

1у£[п], если /(с [л— l\—y$[n])<J(c[n— 1]), 4

[ 0, если J(c[n— 1] — y£[n\)>J(c[n~- 1]).

Существуют различные модификации алгоритма (2.45).

В этом алгоритме случайный шаг делается только в том

случае, если J (с [п]) < J (с [п— 1]), в противном

случае система остается в предыдущем состоянии с [п] =

= с [/г— 1]. В других алгоритмах, например, «с

наказанием случайностью» случайный шаг делается только

тогда, когда предыдущий шаг был неудачным, и т. д.

Наконец, если в регулярном градиентном алгоритме

величину у сделать случайной, то мы также получим

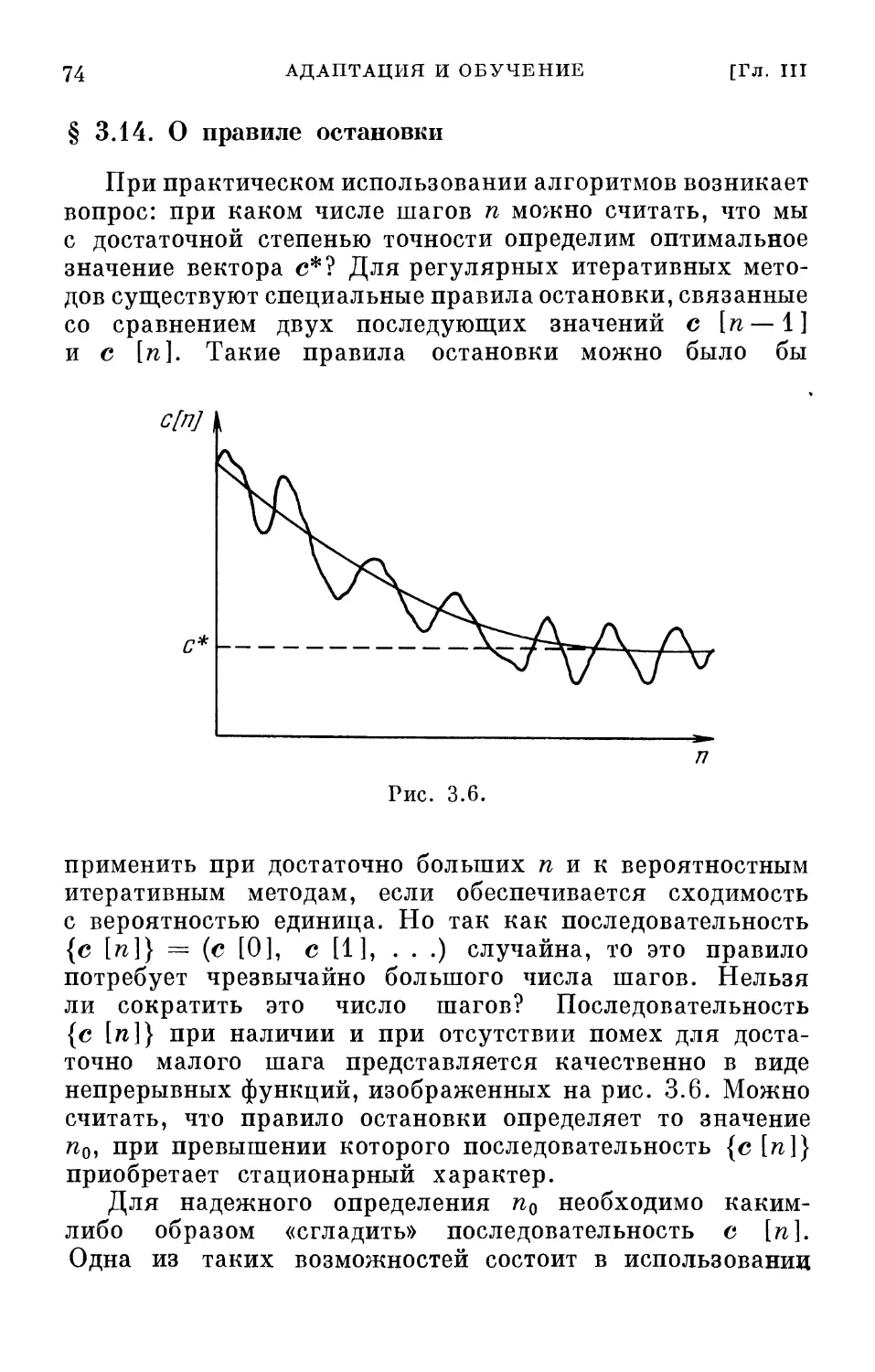

алгоритм случайного поиска: