Author: Цымбал В.П.

Tags: компьютерные технологии кибернетика кодирование теория информации

ISBN: 5-11-001943-6

Year: 1992

Text

В.П.ЦЫМБАЛ JL JJ Vi J If JL

ИНФОРМАЦИИ

.КОДИРОВАНИЕ

ББК 32.811я73

Ц94

УДК 681.325(075.8)

Рецензент д-р техн, наук

Ю. Г. Заренин (Киевский институт автоматики)

Редакция литературы по информатике и автоматике

Редакторы Л. И. Чмиль, Ж. Г. Давиденко

Цымбал В. П.

Ц94 Теория информации и кодирова-

ние : Учебник.— 4-е изд., перераб. и

доп.— К- : Вища шк., 1992.— 263 с.: ил.

ISBN 5-11-001943-6

Изложены основные положения теории инфор-

мации, теории и практики безызбыточного кодирова-

k ния, построения эффективных кодов, оптимальных

\ с точки зрения минимальной средней длины кодовых

\ слов.

\ Четвертое издание учебника (3-е изд.— 1982 г.)

\ дополнено описанием кодирования в информацион-

\ но-вычислительных сетях.

\ Для студентов экономических вузов.

и\п30000-243

Ц ББК 32.811я73

ISBN \11-001943-6 © Издательское объединение

\ «Вища школа», 1973

\ © В. П. Цымбал, 1992, с измене-

\ ииями

ПРЕДИСЛОВИЕ

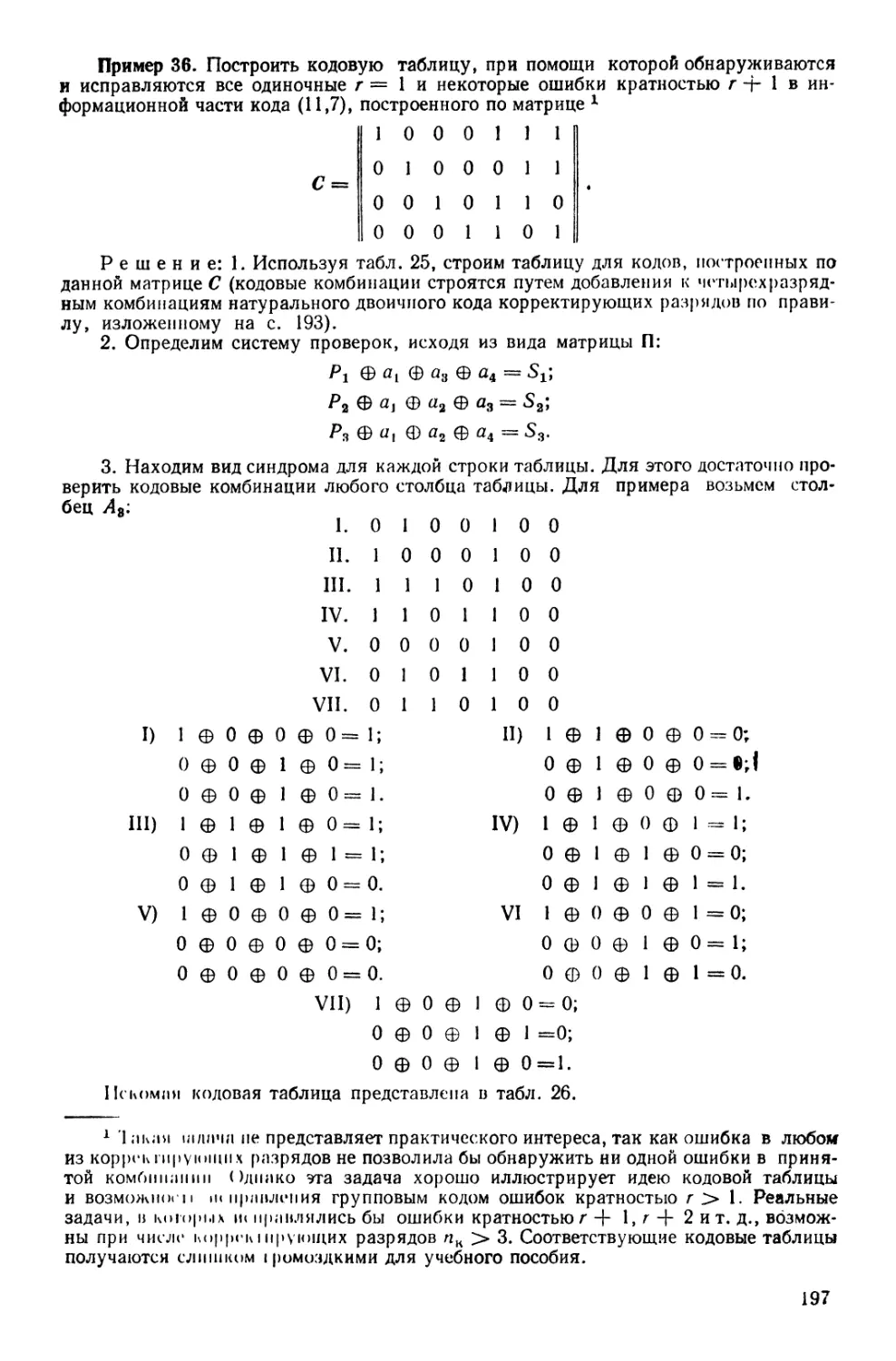

Теорией информации называется раздел кибер-

нетики, в котором математическими методами изучаются способы из-

мерения количества информации, содержащейся в каких-либо со-

общениях, и способы ее передачи.

Слово «информация» полисемично и поэтому неопределенно. С од-

ной стороны, информацией часто называют то, что никакой информа-

ции не несет, с другой — существует много слов, смысл которых тож-

дествен понятию «информация», знания, реакция, показания, сведения...

В настоящей книге под информацией подразумеваются лишь те

сведения, которые сокращают неопределенность, существовавшую до их

поступления. Сведения, не увеличивающие и не уменьшающие неопре-

деленность,существующую до их поступления, называются информаци-

онными шумами. Степень новизны информации может быть оценена по

вероятности появления того или иного сообщения. Поэтому вероятност-

ные и статистические методы — основа математического аппарата

теории информации. Несмотря на то, что в настоящее время статисти-

ческая теория информации получила признание и распространение,

это определение слишком узко, поскольку трудно перечислить все

области человеческих знаний, в которых могут быть использованы по-

ложения теории информации помимо теории передачи сообщений,

кроме того существуют нестатистические способы вычисления количе-

ства информации [17, 25, 40].

Дисциплина «Теория информации и кодирование» не может рас-

сматриваться без близких ей дисциплин: статистической теории связи,

теории потенциальной помехоустойчивости, теории кодирования.

Статистическая теория связи сформировалась в результате слия-

ния теории информации [12) и теории потенциальной помехоустойчи-

вости [28|. Теорию кодирования можно считать частью современной

теории информации [26], так как теоремы кодирования составляют

ее основное содержание. Теория кодирования изучает проблемы раз-

работки алгоритмов кодирования и декодирования, оценивает их

эффективность. Ее можно разделить на кодирование источников сооб-

щений (оптимальное кодирование, сжатие сообщений) и помехоустой-

чивое кодирование (обнаружение и исправление ошибок).

Одна из основных задач теории информации — максимальное ис-

пользование потенциальных возможностей каналов связи путем сов-

местной реализации оптимального кодирования источника и помехо-

устойчивого кодирования.

Теория потенциальной помехоустойчивости ставит, по существу,

ту же задачу, что и теория кодирования — стремление получить оп-

тимальную или субоптимальную (т. е. оптимальную при ряде ограни-

чений) обработку принимаемых сообщений; имеет тот же критерий оп-

тимальности — минимум вероятности ошибки при заданных ограни-

!•

3

чениях (скорость передачи, частота, мощность и другие); совпадают

также задача поиска способов обработки на приеме, расчет вероят-

ностей ошибок и нахождение видов сигналов, минимизирующих ошиб-

ки при передаче сообщений. Но теория кодирования имеет дело с дис-

кретными сигналами, формируемыми по заданному закону в конечное

множество кодовых комбинаций, а теория потенциальной помехо-

устойчивости связана с передачей непрерывных сигналов.

Теория кодирования по своей природе ближе к математическим

дисциплинам, а теория потенциальной помехоустойчивости — к ра-

диотехническим. Этим обусловлены различия в аппарате исследова-

ния: для первой это линейная алгебра, теория конечных полей, ком-

бинаторика, марковские цепи, для второй — теория вероятностей и

случайных процессов, математическая статистика: теория решений,

теория оптимального управления, т. е. дисциплины, используемые

при описании непрерывных процессов. Более глубокое различие

между теорией потенциальной помехоустойчивости и теорией коди-

рования заключается в том, что при оптимальном приеме, как прави-

ло, обрабатывается небольшое конечное число сигналов, а число

кодовых комбинаций мощных кодов необозримо. Следовательно, для

мощных кодов, которые являются наиболее эффективными, невозмож-

но построить устройство, генерирующее все комбинации в конечный

промежуток времени.

Согласно [27], «оптимальный прием — это «хорошая» обработка

«плохих» сигналов, а кодирование — «плохая» обработка «хороших»

сигналов». Иными словами, «теория кодирования начинается там,

где кончается оптимальная обработка». Разрыв между этими двумя

направлениями начинает существенно уменьшаться, хотя интерес

к теории кодирования преобладает.

Действительно, кодирование целесообразно за исключением тех

случаев, когда увеличение избыточности сообщения за счет корректи-

рующих элементов ведет к такому уменьшению длительности самого

элемента в канале связи, что вероятность ошибки не может быть ском-

пенсирована корректирующей способностью кода. Это бывает в слу-

чаях, когда накладываются жесткие ограничения на скорость передачи

сообщений, т. е. на длину сообщения во времени. В случаях, когда

вероятность ошибки не зависит от мощности сигнала, повысить до-

стоверность можно только за счет помехоустойчивого кодирования либо

многократного повторения сообщений. Это относится к коммутируе-

мым телефонным каналам, в которых большинство ошибок вызывает-

ся «дрожанием» контактов, к каналам с мощными импульсными поме-

хами и к каналам с переходными или взаимными помехами.

Интерес к теории информации и кодированию, а также к техни-

ческим проблемам, связанным с передачей, обработкой и хранением

информации, растет пропорционально увеличению объемов информа-

ции, что наблюдается во всех областях науки и техники. Открываются

новые классы кодов и областей их применения, совершенствуются

методы и устройства кодирования и декодирования. Расширяется об-

ласть применения теории кодирования, сфера смежных с ней задач,

еще не сформированных в самостоятельные дисциплины.

Глава

ОСНОВНЫЕ ПОНЯТИЯ И

ОПРЕДЕЛЕНИЯ

Любое отражение материального мира, которое мо-

жет быть зафиксировано живым существом или прибором, несет в се-

бе информацию.

Отражение результатов человеческой деятельности или понимания

окружающего мира может быть представлено в формализованном виде,

например в виде наборов букв или цифр. Такие формализованные на-

боры обычно называют данными. Данные, полученные от источника

информации, называют сообщением. Они становятся информацией

в момент их использования, поэтому не всяким данным суждено стать

информацией. Информацией становятся те сообщения, которые сни-

мают неопределенность, существовавшую до их поступления.

Теория информации занимается изучением количества информа-

ции в сообщениях безотносительно конкретного их содержания, так

как процесс формализации и механизации передачи информации не

предусматривает изменения содержания сообщений. ПредметОлМ изу-

чения теории информации являются вероятностные характеристики

исследуемых объектов и явлений, так как вероятность есть наиболее

удобная численная мера неопределенности, с уменьшением которой

и связан процесс получения информации. Неопределенность появле-

ния того или иного явления, неопределенность нахождения в том или

ином состоянии некоторой физической системы или ее отдельных эле-

ментов, неопределенность появления той или иной буквы в текстовом

сообщении можно представить при помощи вероятностных характе-

ристик символов некоторого абстрактного алфавита и изучать его

информационные характеристики безотносительно того физического

содержания, которое кроется за тем или иным символом. С помощью

такого абстрактного алфавита в теории информации моделируются вес

источники информации.

Теория передачи информации является частью теории информа-

ции. Предметом изучения теории передачи информации является по-

лучение оптимальных методов передачи сообщений.

Сообщения передаются при помощи сигналов, обладающих опре-

деленными физическими свойствами. В общем случае сигналом мо-

жет быть любое изменение начального состояния объекта, которое

способно вызвать реакцию человека или прибора. Различают сигна-

лы: зрительные (телевизионное изображение), звуковые (звонок),

электрические (положительные и отрицательные импульсы), радио-

сигналы и г д. Одни сигналы могут вызывать другие. Так, электри-

ческий сигнал может вызвать звуковой (в электрическом звонке), све-

товой сигнал — электрический (в фотоэлементе). Сигналы могут быть

взаимосвязаны в пространстве и во времени (звуковое кино).

5

Основными параметрами, характеризующими сигнал, являются:

длительность сигнала Тс, ширина частотного спектра Fc и средняя

мощность Рс. Для надежной передачи сигналов, как правило, необхо-

димо рассматривать эти характеристики во взаимосвязи друг с дру-

гом, так как они могут дополнять друг друга. Например, недостаток

мощности сигнала можно компенсировать за счет увеличения его

длительности, а расширение частотного спектра фактически является

увеличением длительности (по крайней мере является возможностью

увеличения длительности). Поэтому существует еще одна (собира-

тельная) характеристика, которая называется объемом сигнала Ус.

Длительность сигнала Тс — характеристика, показывающая вре-

мя нахождения сигнала в канале связи.

Частотный спектр сигнала Fc — характеристика, показывающая

полосу частот, при которой данный сигнал передается по данному ка-

далу связи. В качестве комментария к этой характеристике следует

сказать, что теоретически ширина спектра сигнала конечной длитель-

ности неограничена. Из практики магнитной записи мы знаем, что

чем шире диапазон частот используемой аппаратуры, тем выше ка-

чество записей. Но практически каждый конкретный вид передачи

имеет спектр частот, при котором искажения сигнала лежат в допус-

тимых пределах. Например, телефонные разговоры ведутся в диапа-

зоне от 300 до 3400 Гц и полоса частот/д = 3100 Гц является допусти-

мой для телефонных каналов.

Средняя мощность сигналов Рс — характеристика, показывающая

мощность, которую обеспечивает сигналу передающая аппаратура

и аппаратура восстановления сигнала в процессе его прохождения по

каналу связи. На практике в качестве энергетической характеристики

сигнала берут отношение средней мощности сигнала Рс к средней мощ-

ности помехи Рп и называют его динамическим диапазоном

De = logPc/Pn.

Объем сигнала Vc — собирательная характеристика, показывающая

в обобщенной форме условия, которые должен обеспечивать канал

связи для качественной передачи сигналов

Vc = TCFCDC.

Аналогичная характеристика существует и для канала связи, она

называется емкостью канала связи

VK = TKFKDK,

”.д Тк — время использования канала связи; FK — полоса частот,

обеспечиваемая при передаче сигналов по данному каналу связи;

DK—динамический диапазон уровней сигналов, который спосооен

обеспечивать данный капал связи.

Качественное прохождение сигнала гарантируется при

тс < Тк;

Dc Da.

6

Это условие полного согласования сигнала с каналом связи. Со-

временная аппаратура передачи данных часто позволяет согласовывать

сигнал с каналом связи даже в случае, когда не соблюдаются все три

вышеуказанных условия, но для этого необходимо выполнение усло-

вия, без которого невозможна качественная передача сигналов: Vc VK.

С точки зрения положения во времени и в пространстве сигналы де-

лятся на статические и динамические. Статическими называются

сигналы, отображающие устойчивые изменения состояния объекта (триг-

геры и ячейки памяти в вычислительной машине, фотографии, маг-

нитные ленты и перфоленты и т. д.). Динамическими называются сиг-

налы, отображающие непрерывные изменения состояния объекта либо

процессы при переходе от одного устойчивого состояния в другое.

К динамическим сигналам относятся все виды электромагнитных коле-

баний (световые, радиосигналы) и упругие колебания среды (распро-

странение звука в воде, твердом теле и т. д.).

По структуре сообщения сигналы делятся на непрерывные и ди-

скретные. Если сигнал (сообщение) в конечном интервале амплитуд

принимает произвольное количество значений, то он (оно) называется

непрерывным. Например, сигналы в аналоговых устройствах, откло-

нение стрелки барометра при изменении давления, модуляция несущей

в телефонном канале под влиянием речи говорящего в микрофон або-.

нента и т. д. Если сигнал (сообщение) в конечном интервале амплитуд

принимает ограниченное количество значений, то он (оно) называется

дискретным.

Дискретные сигналы как средство передачи информации нашли

более широкое применение, чем непрерывные. Это объясняется тем,

что дискретные сигналы в меньшей степени подвержены влиянию по-

мех в каналах связи, искажение дискретного сигнала легче обнару-

жить, чем искажение непрерывного, и, главное, дискретные сигналы

легко обрабатываются на электронных вычислительных машинах

(ЭВМ) и отображаются устройствами цифровой индикации.

Возможность передачи непрерывных сообщений при помощи ди-

скретных сигналов была доказана академиком В. А. Котельниковым

еще в 1933 г. Согласно теореме Котельникова, или теореме отсчетов,

если функция непрерывна и ее частотный спектр не содержит состав-

ляющих с частотой, превышающей F, то она полностью определяется

совокупностью ординат, отстоящих во времени друг от друга на I/2F.

Физический смысл теоремы отсчетов заключается в следующем.

Предположим, требуется передать значение непрерывной функции

v (/) (рис. 1) при помощи дискретных сигналов. Это можно сделать,

передавая через определенные интервалы времени Д/ значения функции

v (/). Чем короче эти интервалы, тем точнее будет передана функция

v (/). Передача непрерывных функций при помощи конечного числа

значения (уровней) называется квантованием, а минимальный отрезок

времени между соседними уровнями — шагом квантования. Спраши-

вается, какой минимальный интервал А/(шаг квантования) необходим

для точной передачи функции и (/)?

Из-за несовершенства аппаратуры, условий работы, которые обыч-

но отличаются от идеальных, и других причин невозможно передать

7

Рис. 1. Отображение непре-

рывного сигнала дискретны-

ми значениями.

весь спектр частот, а следовательно, абсолютно точно передать и не-

прерывную функцию. Так же, как невозможно абсолютно точно пере-

дать мысль, каким бы богатым не был словарный запас человека:

мысль — непрерывна, словарь — дискретен. Однако чем больше сло-

варный запас, тем точнее можно высказать мысли. Аналогично, чем

большим числом квантов передавать функцию, тем точнее можно ее

воспроизводить. Теорема Котельникова отвечает на вопрос, каким

должен быть выбран шаг квантования — интервал отсчетов, чтобы

непрерывную функцию передать при помощи дискретных сигналов.

Согласно теореме, функция с ограниченным спектром полностью

определяется своими значениями, отсчитанными через интервалы

\t~ H2F, где F — ширина спектра. От-

счеты берутся тем чаще, чем шире спектр

функции. Таким образом, тактовая частота

следования импульсов [0 = = 2F, где

F — верхняя граница спектра. Справедли-

вость теоремы легко воспринимается ин-

туитивно: если в спектре отсутствует час-

тота выше F, то за время, равное половине

периода самой высокой из частот спектра,

функция не успеет заметно измениться.

Единичные элементы дискретных сооб-

щений называются дискретными посылка-

ми. Они могут обладать различными физическими свойствами, кото-

рые позволяют однозначно отличать их друг от друга, Эти свойства

называются качественными признаками. Наиболее распространенными

качественными признаками дискретных сигналов являются полярный,

амплитудный, временной и частотный.

Полярный признак. Качеством одной посылки является положительный, а ка-

чеством другой — отрицательный импульсы (рис. 2, а, б). Число качеств т = 2.

Полярные признаки могут выделяться при помощи триодов разной проводимости,

поляризованных реле, диодных сборок и т. д.

Амплитудный признак. Качеством каждой посылки является амплитуда. Теоре-

тически амплитудных признаков может быть бесконечное множество (рис. 2, ^в),

практически же используют только два: наличие и отсутствие сигнала (рис. 2, г).

Это вызвано тем, что помехи в канале связи часто искажают часть импульса, вслед-

ствие чего возможен прием ложной информации. Амплитудные признаки выделяют при

помощи различных пороговых устройств на стабилитронах, реле различной чувстви-

тельности, тиратронах с холодным катодом и т. д.

Временной признак. Качеством посылки является ее длительность (рис. 2, д).

Число качеств т 2. Удлинение элементарной посылки — это распространенное

средство защиты от помех. Выделяют временные признаки при помощи интегрирую-

щих цепей, одновибраторов, реле времени и т. д.

Частотный, признак. Качеством посылки служит частота ее заполнения (рис. 2,

е, ж). Выделяют частотные признаки преимущественно при помощи как электриче-

ских, так и электромеханических резонансных фильтров.

Часто при передаче сообщений используют одновременно несколько качественных

признаков, что позволяет с большей уверенностью отличать истинный сигнал от

ложного. Такие сообщения обладают большей помехоустойчивостью — свойством

сохранять истинные значения при наличии помех в капало связи.

Одними из наиболее распространенных способов передачи сообщений со смешан-

ными признаками являются частотно-временные. К ним относятся сообщения, состоя-

8

щие из многочастотных посылок с фиксированной длительностью. Элементарные

посылки идут друг за другом последовательно во времени. Число таких качеств

7< = mq + mB, (1)

где тч и тв — количество соответственно частотных и временных признаков.

На рис. 2, з представлена одна из комбинаций при тч = 3, пч = 2 и пв == 3,

где пч — количество частот в посылке; пв — количество посылок в комбинации.

пппп п п п п

е

Рис. 2. Качественные признаки дис-

кретных сигналов.

3

Для передачи частотного набора качественных признаков во времени и простран-

стве используется процесс модуляции — изменения параметров регулярного физи-

ческого процесса (например, гармонического колебания), осуществляющегося во вре-

мени в соответствии с текущими значениями сигнала. Различают частотную, фазовую,

амплитудную и импульсную модуляции (в последнем случае модулируется импульс-

ная несущая). На рис. 3 представлены примеры отображения отдельных чисел и

их наборов при помощи модулированных сигналов.

I J I 4 I / О 1 4 О

е

Рис. 3. Отображение отдельных чисел модулиро-

ванными сигналами:

а — частотная (ортогональная) модуляция, б — фа-

зовая модуляция; в — импульсная модуляция; г —«

представление числа 3430140 частотно-модулирован-

ными сигналами; д, е, ж — представление чисел

221, 201 и 021 амплитудно-модулированными сиг-

налами.

jr Как правило, число однозначно различимых сигналов, предназна-

ченных для передачи сообщений, значительно меньше количества сим-

волов алфавита, описывающего источник сообщений. Во всех случаях,

когда число символов исходного алфавита больше числа однозначно

Рис. 1. Отображение непре-

рывного сигнала дискретны-

ми значениями.

весь спектр частот, а следовательно, абсолютно точно передать и не-

прерывную функцию. Так же, как невозможно абсолютно точно пере-

дать мысль, каким бы богатым не был словарный запас человека:

мысль — непрерывна, словарь — дискретен. Однако чем больше сло-

варный запас, тем точнее можно высказать мысли. Аналогично, чем

большим числом квантов передавать функцию, тем точнее можно ее

воспроизводить. Теорема Котельникова отвечает на вопрос, каким

должен быть выбран шаг квантования — интервал отсчетов, чтобы

непрерывную функцию передать при помощи дискретных сигналов.

Согласно теореме, функция с ограниченным спектром полностью

определяется своими значениями, отсчитанными через интервалы

A/™ 1/2F, где F — ширина спектра. От-

счеты берутся тем чаще, чем шире спектр

функции. Таким образом, тактовая частота

следования импульсов f0 = = 2F, где

F — верхняя граница спектра. Справедли-

вость теоремы легко воспринимается ин-

туитивно: если в спектре отсутствует час-

тота выше F, то за время, равное половине

периода самой высокой из частот спектра,

функция не успеет заметно измениться.

Единичные элементы дискретных сооб-

щений называются дискретными посылка-

ми. Они могут обладать различными физическими свойствами, кото-

рые позволяют однозначно отличать их друг от друга, Эти свойства

называются качественными признаками. Наиболее распространенными

качественными признаками дискретных сигналов являются полярный,

амплитудный, временной и частотный.

Полярный признак. Качеством одной посылки является положительный, а ка-

чеством другой — отрицательный импульсы (рис. 2, а, б). Число качеств т = 2.

Полярные признаки могут выделяться при помощи триодов разной проводимости,

поляризованных реле, диодных сборок и т. д.

Амплитудный признак. Качеством каждой посылки является амплитуда. Теоре-

тически амплитудных признаков может быть бесконечное множество (рис. 2, 'в),

практически же используют только два: наличие и отсутствие сигнала (рис. 2, г).

Это вызвано тем, что помехи в канале связи часто искажают часть импульса, вслед-

ствие чего возможен прием ложной информации. Амплитудные признаки выделяют при

помощи различных пороговых устройств на стабилитронах, реле различной чувстви-

тельности, тиратронах с холодным катодом и т. д.

Временной признак. Качеством посылки является ее длительность (рис. 2, д).

Число качеств т 2. Удлинение элементарной посылки — это распространенное

средство защиты от помех. Выделяют временные признаки при помощи интегрирую-

щих цепей, одновибраторов, реле времени и т. д.

Частотный, признак. Качеством посылки служит частота ее заполнения (рис. 2,

е, ж). Выделяют частотные признаки преимущественно при помощи как электриче-

ских, так и электромеханических резонансных фильтров.

Часто при передаче сообщений используют одновременно несколько качественных

признаков, что позволяет с большей уверенностью отличать истинный сигнал от

ложного. Такие сообщения обладают большей помехоустойчивостью — свойством

сохранять истинные значения при наличии помех в канале связи.

Одними из наиболее распространенных способов передачи сообщений со смешан-

ными признаками являются частотно-временные. К ним относятся сообщения, состоя-

8

щие из многочастотных посылок с фиксированной длительностью. Элементарные

посылки идут друг за другом последовательно во времени. Число таких качеств

Д’ = тч + тв, (1)

где тц и тв — количество соответственно частотных и временных признаков.

На рис. 2, з представлена одна из комбинаций при тч = 3, пч = 2 и пв = 3,

где пч — количество частот в посылке; пв — количество посылок в комбинации.

пппп п п пл

е

Рис. 2. Качественные признаки дис-

кретных сигналов.

3

Для передачи частотного набора качественных признаков во времени и простран-

стве используется процесс модуляции — изменения параметров регулярного физи-

ческого процесса (например, гармонического колебания), осуществляющегося во вре-

мени в соответствии с текущими значениями сигнала. Различают частотную, фазовую,

амплитудную и импульсную модуляции (в последнем случае модулируется импульс-

ная несущая). На рис. 3 представлены примеры отображения отдельных чисел и

их наборов при помощи модулированных сигналов.

I J I 4 I / О 1 I 4 О

Рис. 3. Отображение отдельных чисел модулиро-

ванными сигналами:

а — частотная (ортогональная) модуляция; б — фа-

зовая модуляция; в — импульсная модуляция; г —•

представление числа 3430140 частотно-модулирован-

ными сигналами; д, е, ж — представление чисел

221, 201 и 021 амплитудно-модулированными сиг-

налами.

jr Как правило, число однозначно различимых сигналов, предназна-

ченных для передачи сообщений, значительно меньше количества сим-

волов алфавита, описывающего источник сообщений. Во всех случаях,

когда число символов исходного алфавита больше числа однозначно

различимых качественных признаков т2, являющихся непосред-

ственным переносчиком сообщений, для однозначного представления

сообщений необходим процесс кодирования.

Код — универсальный способ отображения информации при ее

хранении, передаче и обработке в виде системы однозначных соответ-

ствий между элементами сообщений и сигналами, при помощи кото-

рых эти элементы можно зафиксировать [39, г. 1, с. 459]. Добавим

к этому, что кодирование всегда может быть сведено к однозначному

преобразованию символов одного алфавита в символы другого. При

этом код есть правило, закон, алгоритм, по которому осуществляется

это преобразование.

Абстрагируясь от конкретного физического содержания, подлежа-

щие формальному описанию события независимо от того, являются

ли они явлением природы, состоянием системы или буквами языкового

алфавита, будем обозначать символами некоторого абстрактного ал-

фавита А {аь а2, ..., От^ и называть первичным алфавитом. Таким

образом, первичный — это исходный, кодируемый алфавит. Абстракт-

ным будем называть алфавит, за символами которого не кроется кон-

кретное содержание. Число качественных признаков (ими могут быть

произвольные однозначно различимые наборы символов, буквы алфа-

витов различных языков либо произвольная буква с разным набором

индексов при ней) абстрактного первичного алфавита обозначим — т±.

Набор однозначно различимых качественных признаков, облада-

ющих необходимыми физическими свойствами для перемещения симво-

лов первичного алфавита в пространстве и во времени, будем обозна-

чать В {blt b2, ..., Ьт2} и называть вторичным алфавитом. Таким обра-

зом, вторичный — это алфавит, при помощи которого символы

первичного алфавита преобразуются в ту форму, в которой они обра-

батываются либо перемещаются. Число качественных признаков вто-

ричного алфавита обозначим т2.

Во всех случаях, когда т± > т2, необходим процесс кодирования.

Для равномерных (равномерными называются коды, все комбинации

которых имеют одинаковую длину; они рассматриваются в главе 9)

безызбыточных кодов, у которых тх является целой степенью т2,

соотношение между тх и т2 имеет вид

тг ~ т”,

где п — длина комбинаций кода во вторичном алфавите. Число сим-

волов, букв, в общем случае, однозначно различимых качественных

признаков т2, составляющих вторичный алфавит, определяют основа-

ние кода. Так, в коде Морзе, вторичный алфавит которого составляют

тире, точка и пауза, основание — три, сам код Морзе относится к тро-

ичным кодам.

В более общем случае, закон преобразования символов алфавита

щ в кодовые комбинации, составленные из алфавита т2, может быть

представлен в виде

тх m2.

10

Код представляет собой полный набор всех возможных комбина-

ций символов вторичного алфавита, построенных по данному закону-

Комбинации символов, принадлежащие данному коду, называются

кодовыми словами. В каждом конкретном случае могут быть использо-

ваны все либо часть кодовых слоев, принадлежащих данному коду.

Тем более, что существуют «мощные коды», все комбинации которых

практически невозможно отобразить. Поэтому под словом «код» под-

разумеваем прежде всего закон, по которому производится преобразо-

вание, в результате которого получаем кодовые слова, полный набор

которых принадлежит данному коду, а не какому-то другому, построен-

ному по иному закону.

Символы вторичного алфавита независимо от основания кода явля-

ются лишь переносчиками сообщений. Сообщением при лом является

буква первичного алфавита безотносительно конкретного физического

либо смыслового содержания, которое она отражает.

В случае необходимости передачи сообщений символам вторичного

алфавита ставятся в соответствие конкретные физические качественные

признаки. Процесс воздействия на закодированное сообщение с целью

превращения его в сигнал называется модуляцией. Сигналы

служат переносчиками информации в пространстве и во времени.

Основной задачей теории информации и кодирования как самостоя-

тельной дисциплины является оптимальное использование информа-

ционных характеристик источников сообщений и каналов связи для

построения кодов, обеспечивающих заданную достоверность переда-

ваемой информации с максимально возможной скоростью и минималь-

но возможной стоимостью передачи сообщений. Частными задачами

при этом являются: проблемы измерения количества информации,

изучение свойств информации, исследование взаимодействия систем

и элементов систем методами теории информации, решение задач

яр икладного характера.

Выводы: 1. Не следует путать понятия «информация» и «знание».

Создание информации со стороны источника рассматривается как

цепь случайных событий и при исследовании ансамблей сообщений

используется математический аппарат теории вероятностей.

2. Информация от источника к адресату передается при помощи

сигналов, которые могут быть «прочитаны» благодаря тому, что ад-

ресату известен закон формирования сообщений из данных сигналов.

3. Теория информации оперирует не с конкретными смысловыми

сообщениями, не с физическими источниками информации и реальны-

ми каналами связи, а с их математическими моделями, цель изучения

которых,—создание реальных информационных систем, передающих

данные с максимальной точностью при минимальных затратах.

н

Глава

МОДЕЛЬ СИСТЕМЫ ПЕРЕДАЧИ

ИНФОРМАЦИИ.

КАНАЛЫ СВЯЗИ

Сообщения передаются от объекта к адресату при

помощи совокупности технических средств, образующих систему

передачи информации. Сколько существует методов отображения ин-

формации, столько можно создать и способов ее передачи. Поэтому,

говоря в дальнейшем о модели системы передачи информации, будем

иметь в виду ее наиболее общий вид (рис. 4). К системам передачи ин-

формации относится и почта, и телевидение, и сигнализация при помо-

щи костров.

В качестве примера рассмотрим работу одноканальной системы

передачи информации (рис. 4, а), в которой объект — скрипач в радио-

студии, адресат — слушатель. Первичным преобразователем являет-

ся микрофон. Сигнал с микрофона через систему усилителей и модуля-

тор поступает на передатчик. Затем через приемник демодулированный

и усиленный сигнал попадает к адресату. Шифратор и дешифра-

тор в данной системе представлены в неявном виде, так как с некоторы-

ми допущениями шифратором можно было бы, например, считать ком-

позитора, кодом — ноты, а дешифратором — элементы слухового и

эмоционального восприятия слушателя. Такое допущение сделано с

целью подчеркнуть условность общей модели системы передачи инфор-

мации.

В простейших каналах связи приемник, передатчик и преобразо-

ватель мощности могут быть совмещены. Например, телефон (или те-

леграф): сигналы от микрофона (или телетайпа) передаются непо-

средственно по проводной линии связи.

Для многоканальной системы передачи информации характерны

устройства объединения и разделения сигналов (рис. 4, б). Предпо-

ложим, требуется передать информацию о состоянии доменных печей.

Первичные преобразователи (например, датчики температуры и уров-

ней, газоанализаторы) передают информацию ЭВМ, которая ее обраба-

тывает и затем в определенной последовательности передает на модуля-

тор. В данном случае ЭВМ играет роль устройства объединения и шиф-

ратора. Адресатом является световое табло, на котором доменные печи

обозначены условными символами. Рядом с символом домны в соответ-

ствующих ячейках появляются цифры, отражающие информацию о

времени загрузки, проценте содержания кислорода, количестве вы-

плавленного металла и т. д.

Многоканальная система допускает построение кодирующих уст-

ройств до устройства объединения, а декодирующих—после устрой-

ства разделения. Однако ее следует пытаться строить так, как пока-

зано на рис. 4, б, что приводит к существенной экономии аппаратуры.

Многоканальная система не обязательно подразумевает передачу

информации по нескольким проводам или на нескольких несущих.

Не следует путать канал связи и линию связи. Канал связи — сово-

купность технических средств, предназначенных для передачи инфор-

12

мации от объекта к адресату; линия связи — среда, в которой распро-

страняются сигналы, несущие информацию. Для повышения пропуск-

ной способности линий связи по ним могут передаваться сообщения

от нескольких источников одновременно. Такой прием называется

уплотнением. В этом случае сообщения от каждого источника пере-

даются по своему каналу связи, хотя линия связи у них общая.

Рис. 4. Обобщенная модель системы передачи информации:

а — одноканальная; б — многоканальная

Различают каналы связи дуплексные и симплексные. Канал связи

между пунктами А и Б называется дуплексным, если он обеспечивает

возможность передачи информации как от пункта А к 5, так и от Б

к Л. Если канал связи обеспечивает возможность передачи только

в одном направлении (от А к Б или от Б к Л), то он называется

симплексным.

Вполне возможно, что у одного объекта может быть несколько ад-

ресатов, например, в системах телеуправления, телеизмерения и теле-

сигнализации. В зависимости от структуры связи объекта с адресата-

ми каналы связи могут быть: последовательными — однофидерная

линия связи проходит через каждый адресат Лх — Лб (рис. 5, а);

13

радиальными — каждый из адресатов — Л5 соединен с (объектом

отдельной однофидерной линией (рис. 5, б); кустовыми — оДнофидер-

ные линии соединяют с объектом по нескольким адресам; ч^сло линий

связи больше или равно двум (рис. 5, в)\ древовидными — бднофидер-

ные линии непосредственно не соединяются с объектом, аг подключа-

ются к нему через отдельную линию; число линий связи больше или

равно трем (рис. 5, г).

В зависимости от линии связи каналы связи делятся на проводные

(металл), радио (воздух), оптические (световой луч), гидроакустиче-

ские (вода).

Передача информации при помощи проводов — наиболее древнее и по сей день

наиболее распространенное средство связи объекта с адресатом. Проводные каналы

связи бывают одностороннего (симплексный) и двустороннего (дуплексный) действий.

Проводные каналы связи используются обычно в диапазоне от долей герца до

12 кГц. Ограничение частотного диапазона проводного канала связи обусловлено тем,

что с увеличением частоты возрастает активное сопротивление провода под влиянием

поверхностного эффекта. Максимальная протяженность проводного канала связи

определяется затуханиями в нем, которые, в свою очередь, зависят от параметров

линии связи: активного сопротивления, индуктивности, емкости и проводимости изо-

ляции проводов. Эти параметры меняются в зависимости от времени года (активное

сопротивление зимой — минимальное, летом — максимальное), расстояния между

проводами (чем больше расстояние, тем больше емкость), диаметра проводов (чем

больше диаметр, тем больше индуктивность), влажности воздуха (чем больше влаж-

ность, тем больше проводимость изоляции проводов). Поэтому при передаче инфор-

мации на большие расстояния возникает необходимость в промежуточной аппаратуре,

которая осуществляла бы усиление и частичную регенерацию импульсов, а также

коррекцию их частотных искажений.

В настоящее время для передачи информации применяют телефонные и телеграф-

ные каналы, в которых дополнительная аппаратура установлена лишь на передаю-

щем и приемном концах. При этом чаще стараются использовать подземные (кабель-

ные) каналы связи, так как они меньше зависят от внешних условий и имеют стабиль-

ные параметры. Кроме того, у кабелей значительно лучше частотные характеристики.

Разработаны специальные коаксиальные кабели, которые могут использоваться в

диапазоне 60...12 000 кГц, что позволяет передавать по ним даже телевизионные

программы.

Для передачи информации используют также линии электропередачи (ЛЭП).

К достоинствам ЛЭП следует отнести высокую прочность конструкций, а также

строгий надзор за ними, меньшую возможность случайных повреждений; к недостат-

кам — ЛЭП могут отключить и планово, и аварийно, и для проверки новых под-

станций.

Особенности передачи информации по радиоканалу определяются преимуще-

ственно выбранным рабочим диапазоном частот (табл. 1).

Длинноволновый (ДВ) диапазон. Длинные волны хорошо огибают Землю и сравни-

тельно слабо поглощаются ею. Кроме того, на распространение длинных волн ионо-

сфера практически не влияет, и, следовательно, условия их распространения заметно

не изменяются в течение суток Длинные волны хорошо отражаются от самого нижнего

ионизированного слоя атмосферы, и на больших расстояниях напряженность прост-

ранственной волны оказывается больше напряженности поверхностной. Однако для

передачи сигналов в этом диапазоне необходимо применять высокие антенны, так как

к. п. д. последней зависит от соотношения ее размеров и длины волны, либо мощные

передатчики, чтобы компенсировать низкий к. п. д. антенны. Самый большой недоста-

ток длинноволнового диапазона — низкая пропускная способность и низкая помехо-

защищенность от природных и промышленных помех.

Средневолновый (СВ) диапазон. Средние волны распространяются в виде как по-

верхностных, так и пространственных волн. Днем пространственные волны испыты-

ваю! сильное поглощение при отражении от ионосферы, поэтому для связи основную

роль играют поверхностные волны. Ночью поглощение при отражении от ионосферы

резко уменьшается, поэтому связь обеспечивается пространственными волнами,

14

В результате интерференции пространственных и поверхностных волн в местах приема

с наступлением темноты наблюдаются значительные замирания сигналов с периодом

в несколькб секунд. Устойчивость связи СВ диапазона в значительной степени зависит

от времени года и фазы солнечной активности (при одинаковых размерах). К. п. д.

антенн для , передачи в СВ диапазоне значительно выше, чем в ДВ диапазоне.

Коротковолновый (КВ) диапазон. Короткие волны распространяются в виде

как поверхностных, так и пространственных волн. Поверхностные волны испытывают

сильное поглощение Землей. Поэтому связь в КВ диапазоне осуществляется преиму-

щественно пространственными волнами. Благодаря способности многократного отра-

жения от ионосферы волны КВ диапазона могут распространяться на значительные

расстояния. Устойчивость связи в КВ диапазоне сильно зависит от процессов, про-

исходящих в й^носфере, в связи с чем наблюдаются глубокие замирания сигналов

длительностью от десятых долей секунды до нескольких секунд. Качество связи

меняется в течение дня, месяца и года, а также в течение цикла солнечной активности.

Таблица 1. Характеристики диапазонов радиоволн

Диапазон Длина волны, м Полоса частот Дальность распространения волны, км

дв 3000...10 000 30... 100 кГц 500...1000

, св 200... 3000 1С0... 1500 кГц 1000...15 000

кв 10...50 б...30 МГц Свыше 15 000

УКВ 1...10 30...300 МГц 60...300

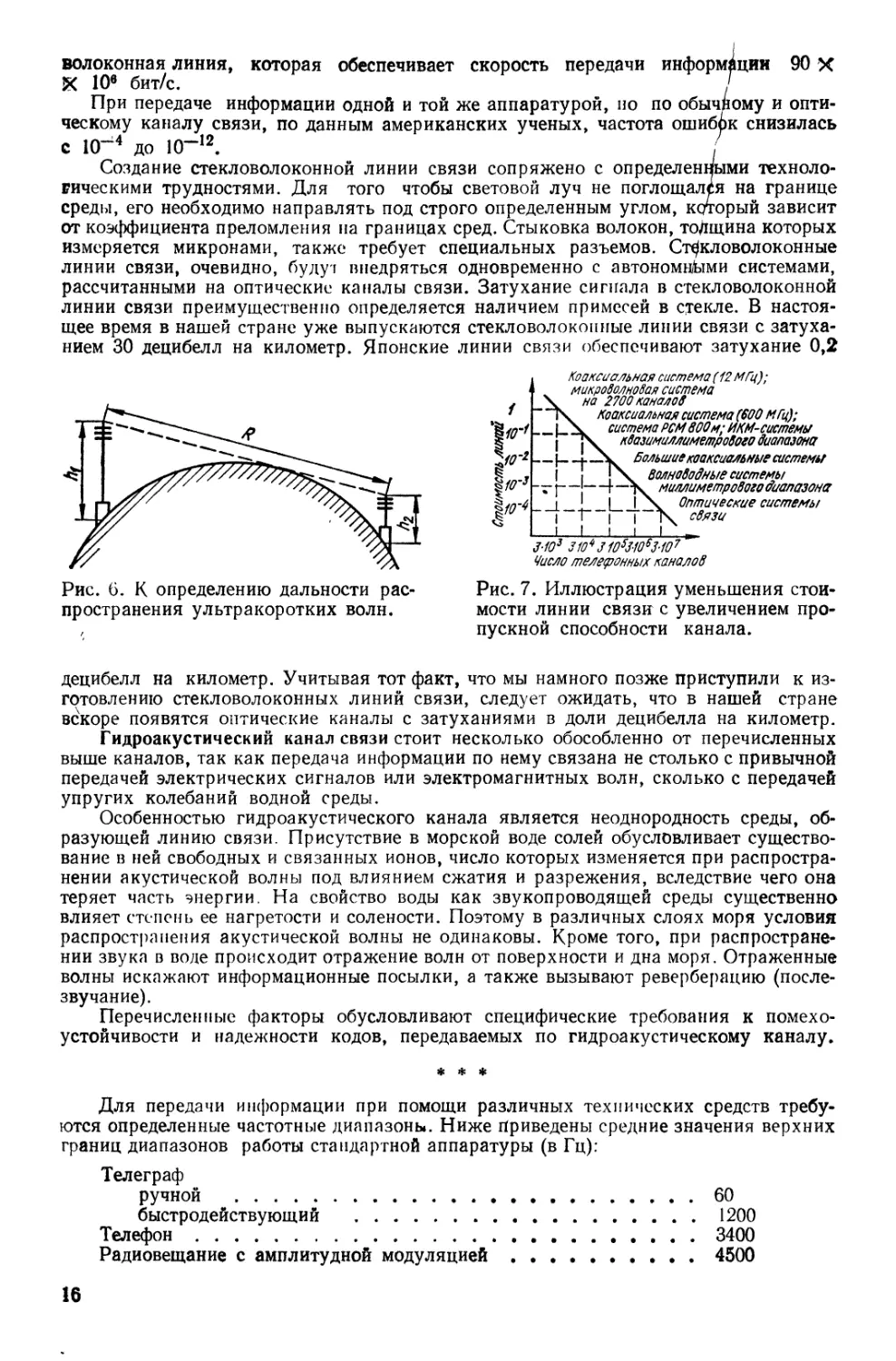

Ультракоротковолновый (УКВ) диапазон. Дальность дифракционного распро-

странения ультракоротких волн лишь незначительно превышает расстояние прямой

видимости (рис. 6) и приблизительно равна

r ~4 (/л; + (2)

где и h2 — высота подъема соответственно передающей и приемной антенны.

В ультракоротковолновом диапазоне работают радиорелейные линии связи.

Радиорелейные линии очень надежны, что обеспечивается резервированием аппарату-

ры, применением автоматики и телемеханики. При использовании радиорелейной ли-

нии могут возникнуть помехи, вызванные близостью телевизионного диапазона.

Поэтому конечные пункты радиорелейных линий следует выносить за пределы города

а оттуда передавать информацию по кабелю.

Оптический канал связи создается за счет очень узкого луча света, регенерируе-

мого квантовым генератором — лазером Слово лазер составлено из первых букв

английского названия принципа, по которому работает квантовый генератор: light

amplification by stimulated emission of radiation. Достоинством оптического канала

являются следующие его свойства: высокая концентрация энергии в пространстве

(при мощности излучения 10 кВт лазерный луч можно увидеть невооруженным гла-

зом на расстоянии 0,1 светового года); колоссальная плотность энергии (в середине

лазерного луча плотность энергии составляет 1016 Вт/м2, а на Солнце — 108 Вт/м2);

огромная пропускная способность. Последнее свойство представляет интерес для

создания информационных систем с оптическим каналом связи.

Известно, что пропускная способность канала связи прямо пропорциональна

рабочей полосе частот. Лазер может обеспечить ширину полосы порядка 1012... 1014 Гц

(для сравнения напомним: на красном участке оптического спектра частота световых

колебаний равна 4 • 104 Гц), что позволяет разместить только в этом диапазоне около

биллиона телефонных каналов. Другими словами, оптический канал связи может

обеспечить одновременную передачу всех телефонных разговоров на всех телефонных

станциях мира.

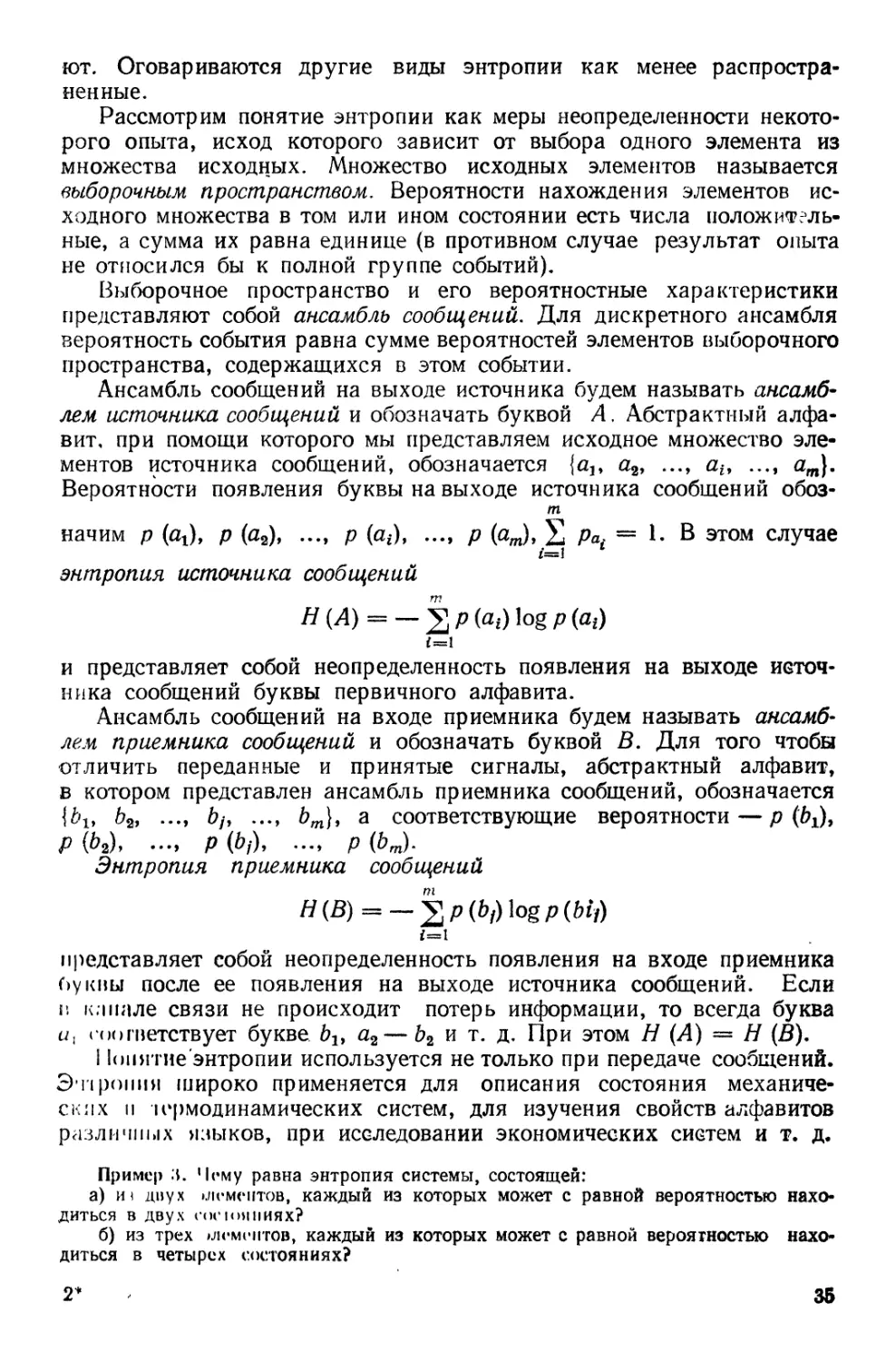

Сама по себе оптическая линия связи — дорогая. Но если учесть огромное число

каналов свя ш, которое может быть организовано при помощи одной оптиче-

ской линии сняли, то стоимость одного канала будет одна из самых низких, что

иллюстрируется рис. 7 [4].

Свойства оптического канала связи нашли практическое использование в стек-

ловолоконных линиях передачи. В настоящее время в США эксплуатируется стекло-

15

волоконная линия, которая обеспечивает скорость передачи информации 90 X

X 10е бит/с.

При передаче информации одной и той же аппаратурой, во по обычному и опти-

ческому каналу связи, по данным американских ученых, частота ошибок снизилась

с 10~4 до 10“12. /

Создание стекловолоконной линии связи сопряжено с определенными техноло-

гическими трудностями. Для того чтобы световой луч не поглощалёя на границе

среды, его необходимо направлять под строго определенным углом, который зависит

от коэффициента преломления на границах сред. Стыковка волокон, толщина которых

измеряется микронами, также требует специальных разъемов. Стекловолоконные

линии связи, очевидно, буду! внедряться одновременно с автономными системами,

рассчитанными на оптические каналы связи. Затухание сигнала в стекловолоконной

линии связи преимущественно определяется наличием примесей в стекле. В настоя-

щее время в нашей стране уже выпускаются стекловолоконные линии связи с затуха-

нием 30 децибелл на километр. Японские линии связи обеспечивают затухание 0,2

Рис. 6. К определению дальности рас-

пространения ультракоротких волн.

Коаксиальная система (12 МГц);

микроволновая система

на 2700 каналов

Коаксиальная система (600 МГц);

система РСМ800м; И КМ- системы

квазимиллиметрового диапазона

Большие коаксиальные системы

Волн вводные системы

миллиметрового диапазона

Оптические системы

связи

1

Л:

З-Ю3 ЗЮ4 31053-1053-107

Число телефонных каналов

Рис. 7. Иллюстрация уменьшения стои-

мости линии связи с увеличением про-

пускной способности канала.

децибелл на километр. Учитывая тот факт, что мы намного позже приступили к из-

готовлению стекловолоконных линий связи, следует ожидать, что в нашей стране

вскоре появятся оптические каналы с затуханиями в доли децибелла на километр.

Гидроакустический канал связи стоит несколько обособленно от перечисленных

выше каналов, так как передача информации по нему связана не столько с привычной

передачей электрических сигналов или электромагнитных волн, сколько с передачей

упругих колебаний водной среды.

Особенностью гидроакустического канала является неоднородность среды, об-

разующей линию связи. Присутствие в морской воде солей обусловливает существо-

вание в ней свободных и связанных ионов, число которых изменяется при распростра-

нении акустической волны под влиянием сжатия и разрежения, вследствие чего она

теряет часть энергии. На свойство воды как звукопроводящей среды существенно

влияет степень ее нагретости и солености. Поэтому в различных слоях моря условия

распространения акустической волны не одинаковы. Кроме того, при распростране-

нии звука в воде происходит отражение волн от поверхности и дна моря. Отраженные

волны искажают информационные посылки, а также вызывают реверберацию (после-

звучание).

Перечисленные факторы обусловливают специфические требования к помехо-

устойчивости и надежности кодов, передаваемых по гидроакустическому каналу.

* * *

Для передачи информации при помощи различных технических средств требу-

ются определенные частотные диапазоны. Ниже Приведены средние значения верхних

границ диапазонов работы стандартной аппаратуры (в Гц):

Телеграф

ручной ...............................................60

быстродействующий ....................................1200

Телефон................................................. 3400

Радиовещание с амплитудной модуляцией................... 4500

16

Фототелеграф ............................................. 5500

Трехканальная аппаратура связи ........................... 30 000

Радиовещание с частотной модуляцией ......................75 000

12-канальная аппаратура связи ............................ 150 000

Телевидение...............................................8 000 000

Радиолокация .............................................10 000 000

Не всякая линия связи может обеспечить требуемый частотный диапазон выбран-

ного средства передачи информации, что видно из следующей таблицы, в которой по-

лоса частот дана в кГц:

Междугородная проводная линия связи ..................... 5

Кабель

ВЧ ..................................................150

коаксиальный ......................................... 4000

Радиорелейная линия ...................................... 500 000

Линия оптической связи ................................... 40 000 000 000

Построение систем связи в каналах связи с замиранием и рассея-

нием сигналов, несущих информацию, может быть осуществлено с по-

следовательной или параллельной их посылкой.

Практически все реальные каналы связи характеризуются рас-

сеянием энергии передаваемого сигнала либо по времени, либо по

частоте, либо и по времени и по частоте. В терминах частотно-времен-

ного описания рассеяние энергии означает, что принимаемый сигнал

занимает на частотно-временной плоскости большую площадь по

сравнению с переданным. Кроме рассеяния энергии в ряде каналов

(коротковолновые, каналы с тропосферным рассеянием, гидроакусти-

ческие) наблюдаются замирания сигналов, выражающиеся в том, что

различные элементарные компоненты (из которых состоит сигнал) име-

ют различные и случайные коэффициенты передачи в канале.

Наличие замираний и рассеяния заметно осложняет задачу постро-

ения эффективных систем связи в такого рода каналах. К настоящему

времени еще не сформировался единый подход к решению этой задачи.

Не можно выделить два направления, условно называемые параллель-

ным и последовательным (или многочастотным и одночастотным).

Исторически первым сформировался параллельный подход. Его

идея состоит в следующем. Рассеяние энергии рассматривается как

нежелательное явление и для его исключения вводятся защитные ин-

тервалы (по времени и частоте) между соседними передаваемыми

сигналами. Введение защитных интервалов приводит к снижению

скорости передачи (за счет неплотной упаковки сигналами отведенной

для передачи частотно-временной области), поэтому длительность сиг-

нала и его полосу выбирают так, чтобы они были намного больше со-

ответствующих защитных интервалов. Реализация этой идеи, например,

в коротковолновом канале с рассеянием по времени 1 мс и по частоте

2 Гц означает, что длительность сигнала должна быть порядка 10 мс и

больше, а ширина полосы — от 20 Гц и выше. При работе в полосе

стандартного телефонного канала (3100 Гц) отведенную полосу сле-

дует разбил» примерно на 30 подканалов и вести передачу многочас-

тотными (30 частот) сигналами. В этом и состоит по существу парал-

лельный подход. Сформированные таким образом каналы можно счи-

тать однолучевыми. Передачу в каждом подканале целесообразно

17

вести с использованием относительной фазовой телеграфии (ОФТ),

позволяющей при использовании оптимального некогерентного при-

ема избежать изменения параметров подканала.

Воздействие канала на сигнал при описанном подходе сводится

к тому, что каждая компонента многочастотного сигнала (точнее ее

синфазная и квадратичная составляющие) умножается на свой слу-

чайный коэффициент передачи (и, конечно, добавляется аддитивный

шум; см. гл. 13).

Таким образом, канал может быть представлен в виде частотно-

временной матрицы случайных коэффициентов с тем или иным ха-

рактером зависимости по времени и частоте. Размерность матрицы по

частоте совпадает с числом составляющих многочастотного сигнала,

размерность по времени — с длиной передаваемой комбинации (чис-

лом последовательно передаваемых сигналов). Теоретический анализ

предельной помехоустойчивости в случае независимых подканалов

содержится в 1231, конкретные инженерные алгоритмы рассмотрены

в [13]. Анализ систем связи с зависимыми подканалами содержится

в [27]. Вопросы инженерной реализации многочастотных моделей рас-

смотрены в работе [14].

Последовательный подход начал формироваться на рубеже 60-х

и 70-х годов. Согласно этому подходу передача ведется сигналами,

спектр которых занимает всю отведенную полосу частот. Период сле-

дования выбирается в зависимости от требуемой скорости передачи.

При достаточно большой скорости передачи рассеяние энергии по вре-

мени приводит к появлению межсимвольной интерференции. Напри-

мер, в типовом коротковолновом канале интерференция появляется

при скорости порядка 800 символов в секунду (при работе в полосе

3100 Гц). В этих условиях приемнику для эффективной работы не-

обходимо иметь информацию о текущем состоянии канала, которую

можно получить, например, периодическим тестированием канала.

Наличие такой информации позволяет использовать в последователь-

ных системах обычную фазовую модуляцию вместо ОФТ.

Обработка принятых сигналов в последовательных системах вклю-

чает два этапа: а) демодуляцию по высокой частоте; б) компенсацию

межсимвольной интерференции. Первый этап реализуется с помощью

подстраиваемого (в зависимости от состояния канала) фильтра, согла-

сованного либо со всем сигналом, либо с его частью.

Второй этап реализуется либо нелинейным компенсатором с об-

ратной связью по решению, либо процессором Витерби [211 (см. гл. 14).

При сопоставлении указанных подходов наибольший интерес

представляют такие характеристики, как помехоустойчивость и слож-

ность реализации. Проведенный В. А. Таубиным |33| сравнительный

анализ помехоустойчивости показал, что в отсутствие кодирования,

т. е. на уровне модема (модулятора—демодулятора) последователь-

ный подход обеспечивает выигрыш по вероятности ошибки на несколь-

ко порядков. Введение кодирования уменьшает разрыв между обо-

ими подходами. Это объясняется тем, что дискретный подканал, фор-

мируемый параллельным модемом, имеет более слабую память по

сравнению с каналом, формируемым последовательным модемом,

18

вследствие чего коды, исправляющие независимые ошибки (а на прак-

тике приходится только ими и ограничиваться), оказываются более

эффективными в параллельной системе. Однако и при использовании

кодирования последовательный подход оказывается предпочти-

тельнее.

Основные недостатки параллельного подхода с точки зрения реа-

лизации следующие: наличие большого числа разделительных фильт-

ров; большой пик-фактор (отношение максимальной мощности сигна-

ла к его средней мощности) излучаемого сигнала (он равен Vп, где

п — число подканалов). Последнее обстоятельство означает, что

передатчик должен иметь большой запас линейности (отношение мак-

симального уровня сигнала, при котором нелинейные искажения ук-

ладываются в заданные нормы, к номинальному уровню) или, дру-

гими словами, большой динамический диапазон.

«Узким местом» последовательного подхода является сложность

компенсатора межсимвольной интерференции. Так, в канале с времен-

ным рассеянием 1 мс процессор компенсатора должен выполнить 16

операций за тактовый интервал, что при скорости 2400 бод составляет

4 • 104 операций в секунду. В настоящее время реализация такого

компенсатора представляет определенные трудности, однако, учитывая

стремительное развитие микроэлектронной техники и технологии,

представляется вероятным, что в самом ближайшем будущем вопрос

о сложности компенсаторов не будет играть существенной роли.

Построение систем связи в каналах связи с помехами может быть

осуществлено с применением решающей обратной связи (РОС) либо

с коррекцией ошибок на приемном конце при помощи специальных

кодов. Эти вопросы будут рассмотрены ниже после усвоения ряда

необходимых понятий (см. гл. 14 и 15).

В заключение следует отметить, что в буквальном смысле слова

одинаковых каналов связи нет, как нет одинаковых отпечатков паль-

цев. Но большинство из каналов связи поддается довольно точному

описанию при помощи конечного числа математических моделей. Сле-

дует отличать процессы, связанные с источником сообщений, от про-

цессов, происходящих в канале связи. Соответственно различаться

будут и модели, описывающие источник и канал. Кодирующие и де-

кодирующие устройства для источника и канала связи могут также

отличаться, так как одной из основных задач шифратора для источни-

ка является представление выхода источника наиболее короткой по-

следовательностью символов, а одной из основных задач шифратора

и дешифратора для канала связи — надежная передача данных, по-

ступающих в канал связи.

Архитектура телеобработки данных дает представление о взаимо-

связях конструктивных блоков в системах, предназначенных не только

для передачи, но и обработки данных.

Дистанционная обработка данных не противоречит обобщенной

модели системы передачи данных, но для нее характерен ряд особен-

ностей, например, наличие программного обеспечения.

Архитектурная взаимоувязка конструктивных блоков имеет много

вариантов. Наиболее распространенные из них представлены на рис. 8.

19

АП

АП

АП

АП

АП

АП

а

ЭВМ

М

АП

ЭВМ

Устройство

сопряжения

сканалом

Устройство —

ЭВМ - сопряжения — М

сканалом *-—

м

।

*2

АП

Мг —

НМ*

АП

МП -

ЭВМ

д

м

м

ЭВМ \\МикроЭВМ

м

ЗВМ

ЭВМ \\МикроЭВМ

М

6

Видеотерминал

Видео-

телефон

Терминал

Аналоговый

телефон

Цифровой телефон

базы банных

Перекачка

файлов

Рис. 8. Варианты организации сети теледоступа:

а — выделенный; 6 — коммутируемые телефонные и телеграфные каналы

связи, в — цифровая сеть интег[ ального обслуживания. М — модемы; МПД —

мультиплексоры передачи данных; ПТД — процессоры телеобработки дан-

ных; АП — абонентские пункты.

В сетях телеобработки данных теледоступ организовывается как

с помощью двустороннего обмена данными между одной и несколь-

кими ЭВМ, так и обращением к ЭВМ с одного или нескольких абонент-

ских пунктов.

Поскольку организация теледоступа требует загрузки в оператив-

ную память, кроме операционной системы, еще и поискового пакета

.20

и телемонитора, то в качестве основной ЭВМ рекомендуется исполь-

зовать ЭВМ с объемом оперативной памяти не менее 1 мбайта. Для того

чтобы ЭВМ сети могли взаимодействовать друг с другом, они должны

быть программно совместимыми (гомогенными). Для обеспечения

этих условий в качестве хост ЭВМ-сети теледоступа можно рекомендо-

вать универсальные ЭВМ: ЕС-1033, ЕС-1035, ЕС-1040, ЕС-1046,

ЕС-1046, ЕС-1050, ЕС-1055 М, ЕС-1060, ЕС-1061, ЕС-1065, ЕС-1066,

ЕС-1067 и терминальную ЭВМ ЕС-1008.

Сеть абонентских пунктов строится с использованием как выделен-

ных, так и коммутируемых сигналов связи.

Для выделенных каналов связи (рис. 8, а) наиболее типичным яв-

ляется использование в качестве устройства сопряжения с каналом

связи стандартной аппаратуры ЕС-7920-11, которая позволяет орга-

низовывать двусторонний обмен данными с 16 дисплеев. В качестве

модема рекомендуется использовать ЕС-8010.

Для телеграфной сети общего пользования (сеть ПД-200) в ка-

честве терминала в настоящее время наиболее распространен

ЕС-8534 (ТАП 34). Стыковку с сетью ПД-200 обеспечивает устройство

для подключения к сети УПСТГ ТТХ-300 мультиплексора передачи

данных (МПД) ТМХ-2410 и групповое согласующее устройство между

мультиплексором и сетью ГУПСТГ-1250.

Для наиболее распространенной коммуникационной среды — теле-

фонной с^ти общего пользования (ТФ-ОП) сопряжение ЭВМ с каналом

связи осуществляется при помощи мультиплексоров передачи данных

ЕС-8403 на 4 входа, МПД-IA на 16 входов, процессоров телеобработ-

ки данных (ПТД/ЕС—8371/ЕСТЕЛ 4.1 на 352 входа или более совер-

шенных ЕСТЕ Л 4.3, 4.4), набора модемов ЕС-8001, ЕС-8002, ЕС-8009,

ЕС-8010, ИЗОТ-8015, СМ-8107, КН-1200, которые обеспечивают под-

ключение различных типов абонентских пунктов (АП), работающих

в диапазоне скоростей 300...4800 бит/с по ТФ-ОП. Электрический ин-

терфейс оконечных устройств с аппаратурой передачи данных следует

осуществлять в соответствии с требованиями ГОСТ 18145-81 (рекомен-

дация международного консультативного комитета по телефонии и

телеграфии V.24) — стык С2 с возможностью обеспечения автомати-

ческого соединения в сети ТФ-ОП в соответствии с рекомендаци-

ей V.25.

В качестве абонентских пунктов могут быть использованы терми-

нальные устройства, поддерживаемые стандартными средствами сис-

темной телеобработки: VT-340, VDT-52130, VDT-52103, VDT-52106;

алфавитно-цифровые дисплеи ЕС-7168, ВТА-2000-15, СМ-7209, «Элек-

троника 15 ИЭ-00-013»; микроЭВМ «Искра-1030», «Электроника-60»,

Робо1 роп-1715, ЕС-1840, ЕС-1841; диалого-вычислительные ком-

плексы типа ДВК-2, 3, 4...; миниЭВМ «Искра-226», «Искра-250», «Лаб-

там-3000», терминальных комплексов типа СМ-1300.

В качестве программного обеспечения используется операционная

система версии ЕС ОС.6.1 и выше, телемонитор КАМА, поисковые

пакеты типа «I ЮИСК-1.2», «ДИАЛОГ-2» для реализации файловой

технологии (обработка документальной, текстовой информации) и

пакеты типа «ДИСОД» для реализации банковской технологии (обра-

21

ботка фактографической и других видов структурируемой информа-

ции).

Для использования в сети теледоступа гетерогенных (программно-

неоднородных) вычислительных комплексов на базе наиболее распро-

страненных в нашей стране СМ ЭВМ и ЕС ЭВМ можно предложить

следующую конфигурацию:

Терминалы — ЕС-7168 (VT-340), ВТА-2000-03, ВТА-2000-15,

СМ-7209, ЕС-8501М, VDT-52130, 15 ИЭ-00-013.

Модемы — ЕС-8001, ЕС-8005.

Межмашинный обмен между ЭВМ СМ-4, СМ-1420, СМ-1425 и

ЕС ЭВМ может быть реализован на базе устройства сопряжения

УСВМ А7 1118 и стандартного терминального оборудования СМ ЭВМ,

имеющего стык С2 для сопряжения с каналами связи. Операционная

среда ОС РВ 2.0. Для выполнения обмена со стороны ЕС ЭВМ иници-

ируется программа системного вывода (WTR) или утилита GENER.

На рис. 8, в, на котором показаны различные виды услуг, представ-

ляемые цифровой сетью интегрального обслуживания, показано, как

надо соединять двухмашинные вычислительные комплексы, у которых

микроЭВМ разгружают ЭВМ общего назначения от работы с ка-

налом связи, например, осуществляют сборку-разборку пакетов в

сетях с коммутацией пакетов.

Выводы: /. Информация передается от объекта к адресату при

помощи совокупности технических средств, образующих систему

передачи информации. При этом канал связи относится к средствам

передачи информации, а линия связи представляет собой среду, в ко-

торой распространяются сигналы.

2. В зависимости от линии связи каналы связи бывают проводные,

радио, оптические и гидроакустические.

3. Чем шире полоса частот канала связи, тем большее количество

сообщений может быть по нему передано одновременно.

4. С точки зрения возможности одновременной передачи макси-

мального количества сообщений наиболее перспективным является

оптический канал связи.

3

Глава

КОЛИЧЕСТВЕННАЯ ОЦЕНКА

ИНФОРМАЦИИ.

ЕДИНИЦЫ КОЛИЧЕСТВА

ИНФОРМАЦИИ

Из основной и частных задач теории информации

и кодирования вытекают следующие технические и экономические

проблемы: изыскание способов передачи информации при возможно

меньших временных и энергетических затратах; повышение достовер-

ности передачи, т. е. изыскание средств защиты систем передачи ин-

формации от влияния внешних физических факторов (помех, затуха-

ний в линии связи, аппаратурных отказов); определение рентабель-

ности выбора способа передачи информации и метода кодирования.

22

В дальнейшем будет показано, что существует принципиальная

возможность запроектировать устройство со сколь угодно малой веро-

ятностью ошибки. Но практические последствия данного решения мож-

но оценить, лишь предварительно ознакомившись с некоторыми

понятиями и методами, позволяющими производить оценку эффектив-

ности систем связи. Для этого, прежде всего, необходимо уметь изме-

рять количество и скорость передачи информации по каналам связи.

Попробуем проследить, от чего зависит количество информации.

Для примера рассмотрим известную задачу о передаче места нахожде-

ния фигуры на шахматной доске. Ее можно решить одним из двух спо-

собов: закодировать каждую клетку или передать номера вертикали и

горизонтали. В первом случае необходимо иметь коД, отображающий

64 знака (в двоичной системе его комбинации будут состоять из шести

элементов), а во втором случае—код, отображающий всего восемь

знаков (в двоичной системе его комбинации будут состоять из трех

элементов), но для передачи места нахождения фигуры потребуется

два сообщения (номер по горизонтали и номер по вертикали). Коли-

чество информации, переданное тем и другим способом, будет одина-

ково. Следовательно, количество информации, содержащейся в источ-

нике информации, не зависит от способа ее передачи. Длина сообщения

для передачи полной информации о координате клетки также будет

одинакова (6 двоичных элементов). Длина сообщений при разных

способах передачи была бы различной, если бы и число качественных

признаков вторичного алфавита было бы различным Например, если

число дискретных качественных признаков вторичного алфавита —

64, то длина любого сообщения о координате клетки будет состоять

из одной дискретной посылки. Если для второго способа передачи

информации в рассмотренном выше примере будет использовано два

качественных признака, то, как мы уже знаем, длина сообщения будет

равна шести, если же во вторичном алфавите будет восемь качествен-

ных признаков, то длина всего сообщения будет равна двум дискрет-

ным посылкам и т. д. Естественно, количество информации во всех

случаях, когда речь будет идти о координате одной и той же клетки,

будет одно и то же.

Количество информации будет увеличиваться при увеличении числа

сообщений, несущих информацию о координатах новых клеток, т. е.

будет удовлетворять условию аддитивности: при передаче сообщений

одним и тем же методом, одной и той же аппаратурой, по одному и

тому же каналу связи количество информации тем больше, чем боль-

шее число символов мы передаем. Действительно, чем больше слов

в телеграмме, тем естественнее ожидать от нее большего количества

информации; чем больше количество строк в телевизионной развертке,

тем выше качество изображения; чем больше частных значений ис-

ходной функции будет передано, тем точнее она может быть воспроиз-

ведена. Не следует при этом путать термины количество и ценность

информации. С точки зрения теории информации в телеграмме «Ба-

бушка здорова. Целую, Федя» информации может быть больше или

меньше, чем в телеграмме «На Марсе есть жизнь» в зависимости от

того, в каком из сообщений было больше исходной неопределенности

23

для адресата. Теория информации непосредственно не занимается

определением ценности информации, хотя уже есть интересные рабо-

ты в этом направлении [7, 15, 17, 25, 35, 40].

Способ получения сообщения влияет на количество принятой ин-

формации. Неопределенность относительно температуры утюга может

быть снята как путем прикосновения пальца к утюгу;так и путем пере-

дачи на расстояние соответствующего кодирования сообщения. То

же сообщение можно передать по каналу связи с помехами и без

помех и т. д. При этом возможна различная полнота информации.

Однако способ передачи — получения информации не может служить

характеристикой последней, так как количество информации, содер-

жащееся в ее источнике, не зависит от способов кодирования и пере-

дачи.

Количество информации / вычисляют как произведение устра-

ненной неопределенности Н, снимаемой одним сообщением, на число

сообщений k. Так как сообщением является буква первичного алфа-

вита, то k можно рассматривать как число символов первичного алфа-

вита.

Мерой неопределенности Н в теории информации является энт-

ропия.

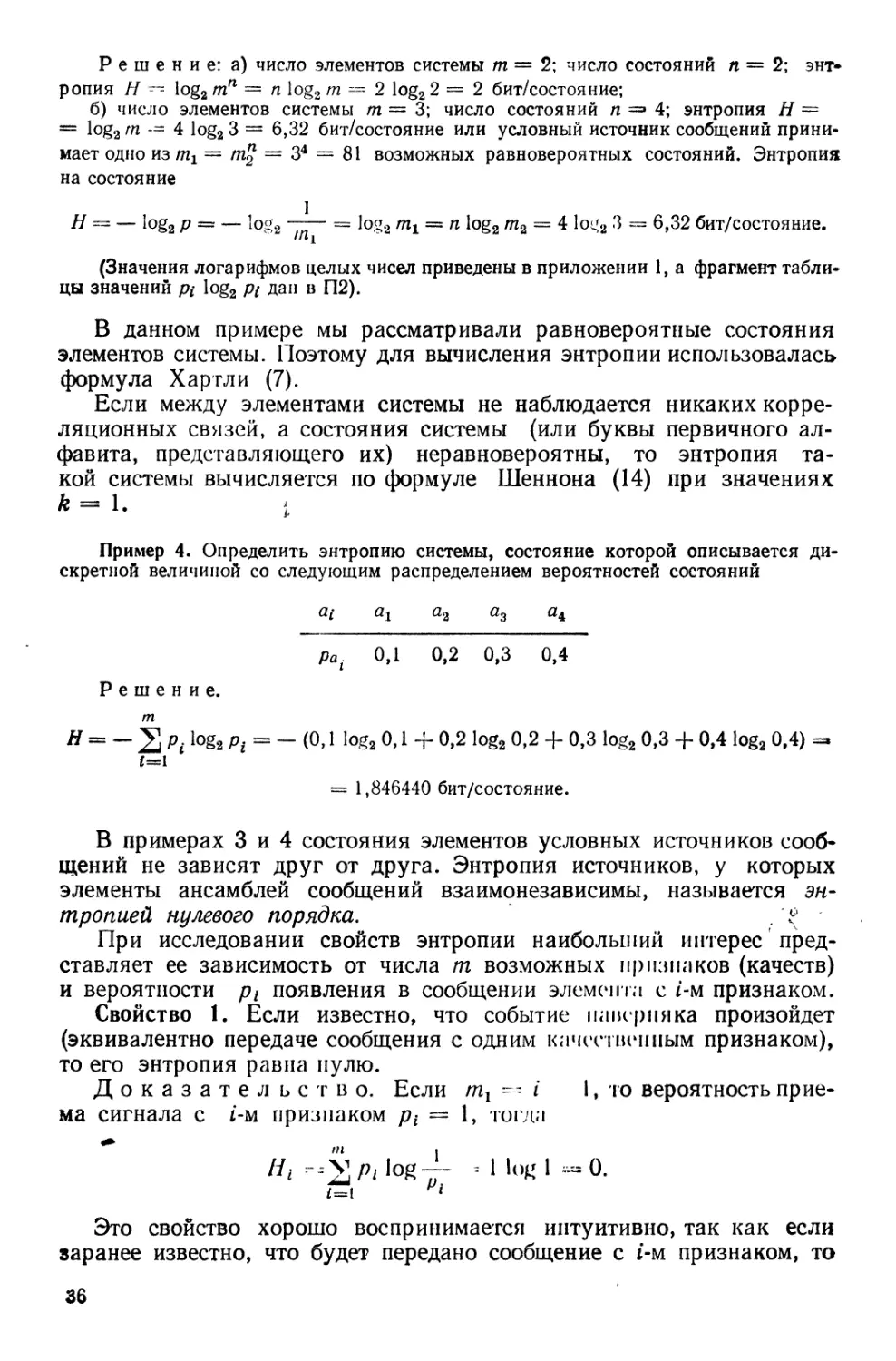

Если исходный ансамбль сообщений А может быть представлен

конечным множеством символов абстрактного алфавита (аъ а2, ...» at)

с распределением вероятностей (рь р2, ..., pf), то энтропия есть вели-

чина, характеризующая источник сообщений в целом и представляет

собой среднюю неопределенность появления на выходе источника од-

ного из сообщений исходного ансамбля. Но так как исходный ансамбль

может быть выражен через символы некоторого абстрактного алфави-

та, который мы назвали первичным, то справедливо следующее опре-

деление.

Определение 1. Энтропия представляет собой удельную

неопределенность на символ первичного алфавита и характеризует

алфавит в целом.

Опр е деление 2. Информацию несут в себе те сообщения, кото-

рые снимают неопределенность, существовавшую до их поступления.

Эти сообщения могут представлять собой как результат отдельного

или группы опытов, так и буквально принятые сообщения.

Информация всегда есть результат разности априорной и апосте-

риорной энтропий.

В самом упрощенном виде это можно понимать в том смысле, что

до опыта (апостериори) была некоторая неопределенность его исхо-

да Нг. После опыта (априори) стала неопределенность II2. Чем меньше

апостериорная неопределенность, т. е. чем больше разность между

Нг и Н2, тем большее количество информации было получено.

Например, чтобы усвоить тезис, что информация есть разность

энтропий, рассмотрим элементарный опыт, целью которого является

определение пола первого вышедшего из троллейбуса человека. Трол-

лейбус в этом случае является источником сообщений Л. Исходный

ансамбль сообщений в первичном алфавите может быть представлен

как А {м, ж}, тогда априорная неопределенность этого источника со-

24

общений Н (Л). Если произойдет событие В —из двери троллейбуса

выйдет человек, то апостериорная неопределенность может быть пред-

ставлена как Н (A/В), т. е. информацию, содержащуюся в источнике

Л, мы можем получить при свершении события В. Таким образом,

после того как из двери троллейбуса выйдет человек, апостериорная

неопределенность станет равной нулю и в результате опыта получим

количество информации, равное собственной информации, содержа-

щейся в одном из событий исходного ансамбля сообщений. Это собы-

тие можно представить в'виде человека, который первым появится

на выходе троллейбуса, для нашего опыта являющегося источником

сообщений, но мы об этом еще не знаем, так как не произошло событие

В (дверь еще не открылась).

Аналогичные рассуждения могут быть экстраполированы и на все

подобные опыты, имеющие только два равновероятных исхода (на-

пример, бросание монеты). Во всех подобных случаях апостериорная

неопределенность равна нулю. Но, если бы после бросания монеты она

стала на ребро или у троллейбуса сломалась и не открылась дверь,

то апостериорная неопределенность равнялась бы априорной и коли-

чество полученной информации равнялось нулю, так как не выполня-

лось главное условие: не произошло событие В. В этом случае

И (AiB) - Н (А) и

/(А, В) =//(А) —//(А) = 0.

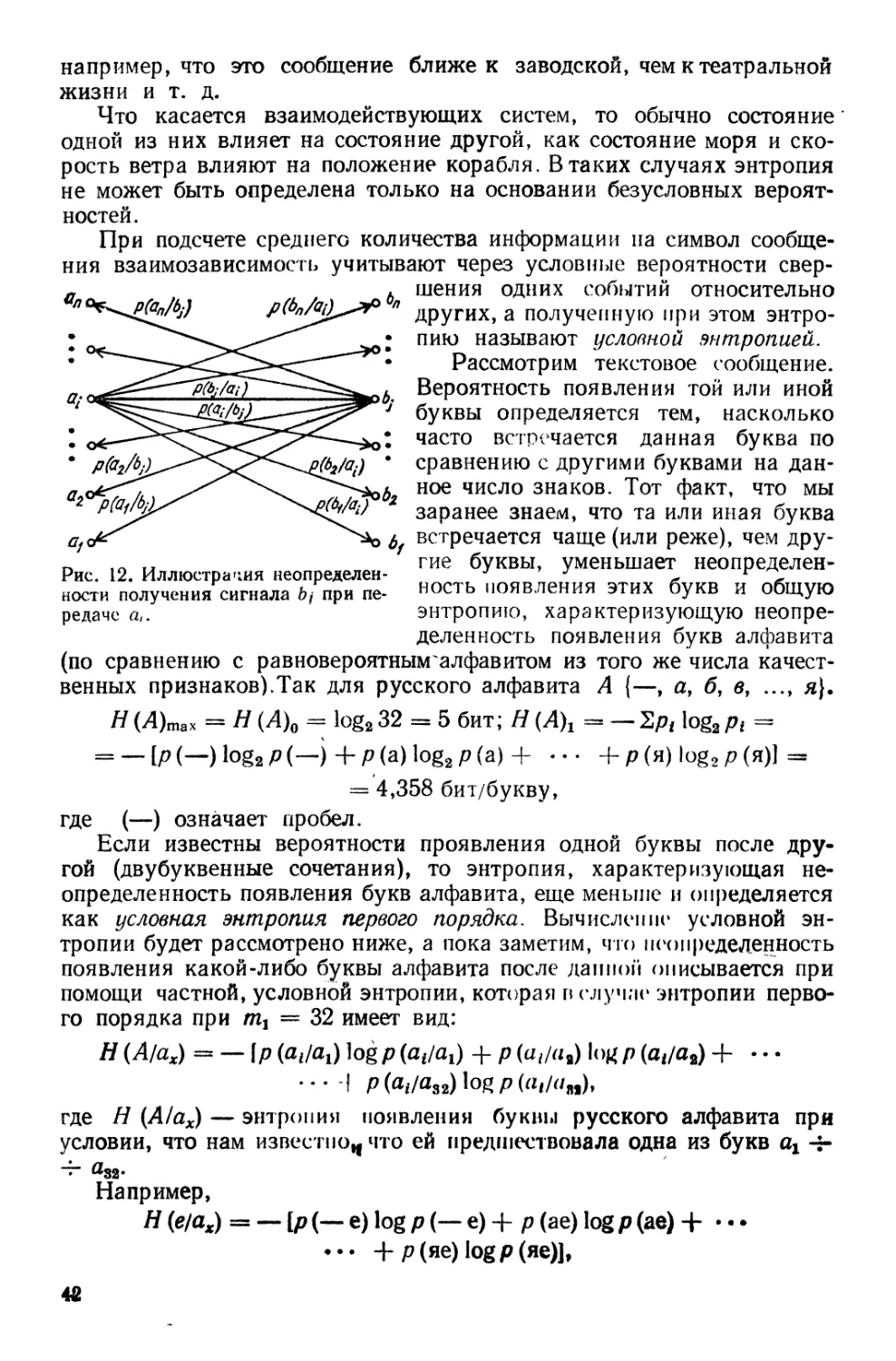

Если обозначить А {аъ а2, ..., amt}, исходный ансамбль сообщений в

первичном алфавите; В {Ьъ Ь2, ..., множество кодовых слов, с по-

мощью которых мы кодируем символы ансамбля А во вторичном

алфавите, то Н (A/В) может быть результат неоднозначного кодиро-

вания или результат потерь информации при передаче по каналу

связи. В общем случае Н(А/В} можно интерпретировать как коли-

чество информации, недостающей наблюдателю для полного, снятия

неопределенности, оставшейся после того, как этот наблюдатель

установил, что произошло событие В.

Обозначение Н (А!В} применяется для условной энтропии, которая

рассмотрена в гл. 5. Там же подробно изложены способы вычисления

Н (МВ). Таким образом (пока без строгих доказательств), средняя

взаимная информация / (А, В) равна разности между энтропией

А и условной энтропией А при заданном В:

/(А; В) = Н(А) — Н (А/В). (3)

Если ансамбль В составлен так, что осуществляется однозначное

соответствие аг <— Ьг\ а2 ч- &2; ...; ат Ьт при передаче не происхо-

дит потерь в канале связи, то приход любой буквы ансамбля В снимает

всякую неопределенность относительно того, что именно передава-

лось. Тогда неопределенность вида Н (A/В) равна нулю. В этом слу-

чае при независимых составляющих ансамбля

Дз = kH (А). (4)

Казалось бы, что информация и неопределенность должны быть свя-

заны обратной зависимостью. Но информацию мы рассматриваем

25

как меру снятой неопределенности. С приходом каждого нового сооб-

щения (символа первичного алфавита) общая неопределенность, су-

ществовавшая до его поступления, в среднем уменьшается на вели-

чину энтропии, присущей этому алфавиту.

Энтропия есть функция вероятности р. Чем больше вероятность

события, тем меньше неопределенность относительно того, произо-

йдет оно или нет. Нулевая или близкая к нулю вероятность может рас-

сматриваться как большая вероятность того, что событие не произо-

йдет. В этом случае также не будет особой неопределенности относи-

тельно факта свершения события р = 1 и р 0.

На даном этапе изложения мы еще не можем обосновать закон,

описывающий изменение энтропии в интервале от р ~ 0 до р — 1.

С полной уверенностью можно лишь утверждать, что максимум этого

значения для двух событий будет в точке рх = р2 = 0,5, т. е. когда

наиболее трудно предсказать результат свершения любого из них.

Очевидно также, что увеличение вероятности любого из двух априор-

но равновероятных событий будет уменьшать общую неопределенность.

При рх -> 1; р2 -> 0 (и наоборот), Н -> 0 в обоих случаях. Приведен-

ные рассуждения позволяют предполагать, что И = f (р) и функция

эта выпуклая. С другой стороны, эти же рассуждения делают очевид-

ным тот факт, что любое отклонение от равновероятного состояния,

независимо от числа событий, уменьшают энтропию Н (Л), где А ss

= {«i ..., ат} — алфавит, при помощи которого эти события отобра-

жаются. А это, в свою очередь, позволяет нам сформулировать сле-

дующее утверждение.

Утверждение 1. Для априорно равновероятных событий количество

информации, которое мы получаем в результате свершения этих

событий, уменьшается с увеличением вероятности любого из со-

бытий.

Следствием утверждения является то, что информация, заключен-

ная в данном событии А, находится в обратно пропорциональной

функциональной зависимости от вероятности р (А):

(5)

\ Ра /

Выражение (5) справедливо при условии, что уменьшение вероят-

ности свершения события А рассматривается как увеличение вероят-

ности несвершения этого события рд, тогда (5) может выглядеть так:

Ia = ИРа),

при этом обязательно рл + рд = 1.

Теорема 1. Если информация является функцией вероятности,

то эта функция может быть только логарифмической.

Доказательство. Согласно iсорив вероятностей, если

а1У а2, ат — попарно несовместимые случайные события, то вероят-

ность появления одного из них равна сумме их вероятностей:

/>(«!, а2, ... ,ат) = р («J Ьр(а2)+ ••• + (рат).

26

но только логарифмическая функция удовлетворяет условию

f [р (01) Р (О2) Р («Л = f [р (01)1 + f [р (а2)1 + • • • +

+ f(P («т)1.

так как логарифм произведения равен сумме логарифмов сомножи-

телей.

Логарифмическая мера количества информации была предложена

в 1928 г. американским ученым Р. Хартли. При выводе логарифми-

ческой меры количества информации Р. Хартли мог пользоваться сле-

дующими рассуждениями.

Число сообщений N, которое можно получить, комбинируя т

символов алфавита по п элементов в сообщении,

N = тп- (6)

Например, комбинируя два символа, можно передать восемь сообще-

ний при п ~ 3, шестнадцать — при я = 4, тридцать два — при п --

= 5 и т. д. Таким образом, число сообщений N, а вместе с ним и коли-

чество передаваемой информации находятся в экспоненциальной зави-

симости от количества элементов в сообщении. Поэтому N нельзя

непосредственно использовать как меру количества информации.

Р. Хартли предложил в качестве меры количества информации

принять логарифм числа возможных последовательностей символов:

1 = logAf = logm" = п logm. (7)

Основание логарифма зависит от выбранной единицы количества

информации. В выражениях, где могут быть использованы произволь-

ные логарифмы, основание логарифма не ставится.

Такое представление меры количества информации соответствует