Author: Мешалкин Л.Д. Айвазян С.А. Енюков И.С.

Tags: теория вероятностей математическая статистика комбинаторный анализ теория графов экономика статистика

Year: 1985

Text

S.A.Aivazyan

I.S.Yenyukov

L.D.Meshalkin

APPLIED

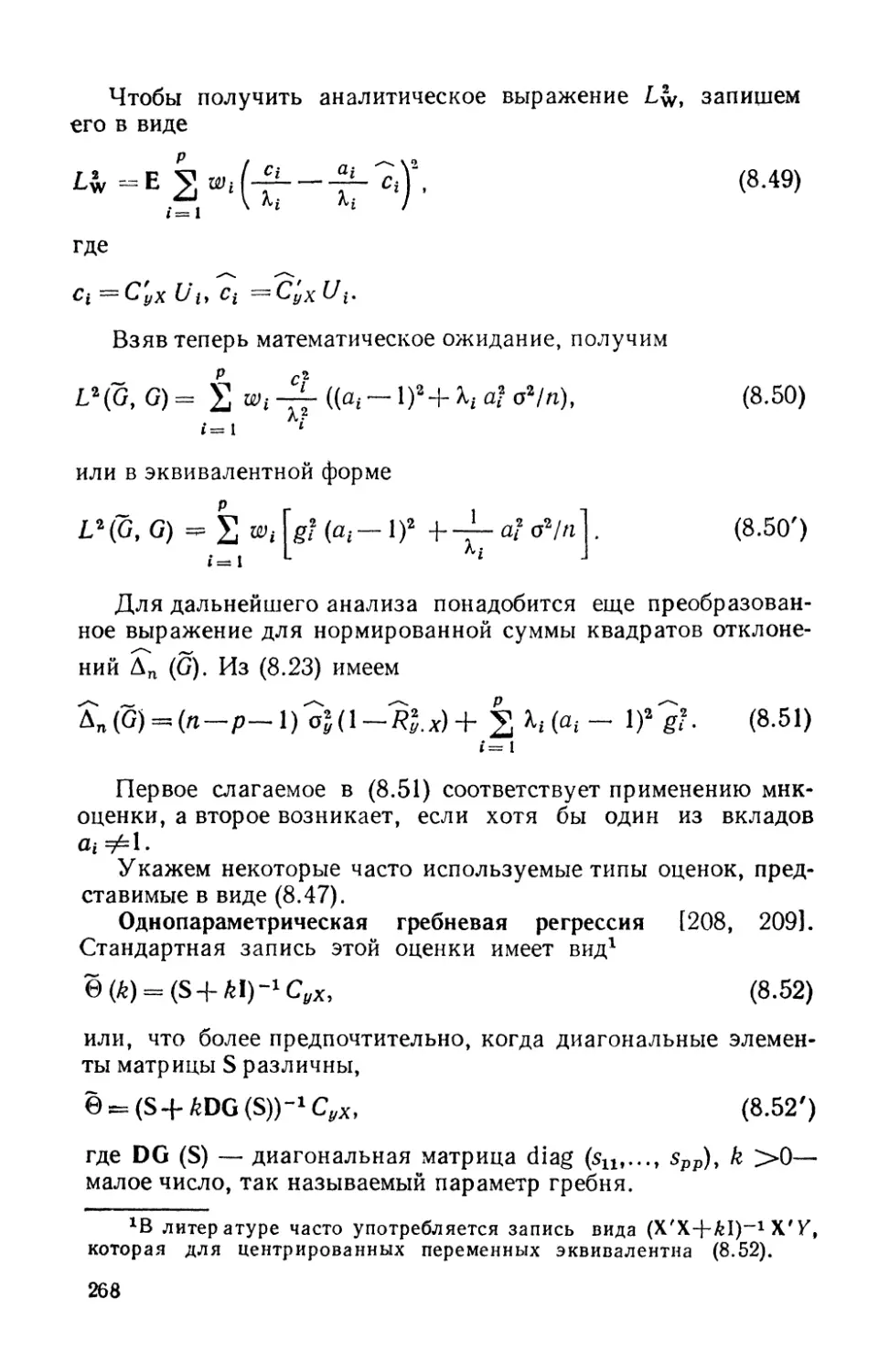

STATISTICS

STUDY

OF RELATIONSHIPS

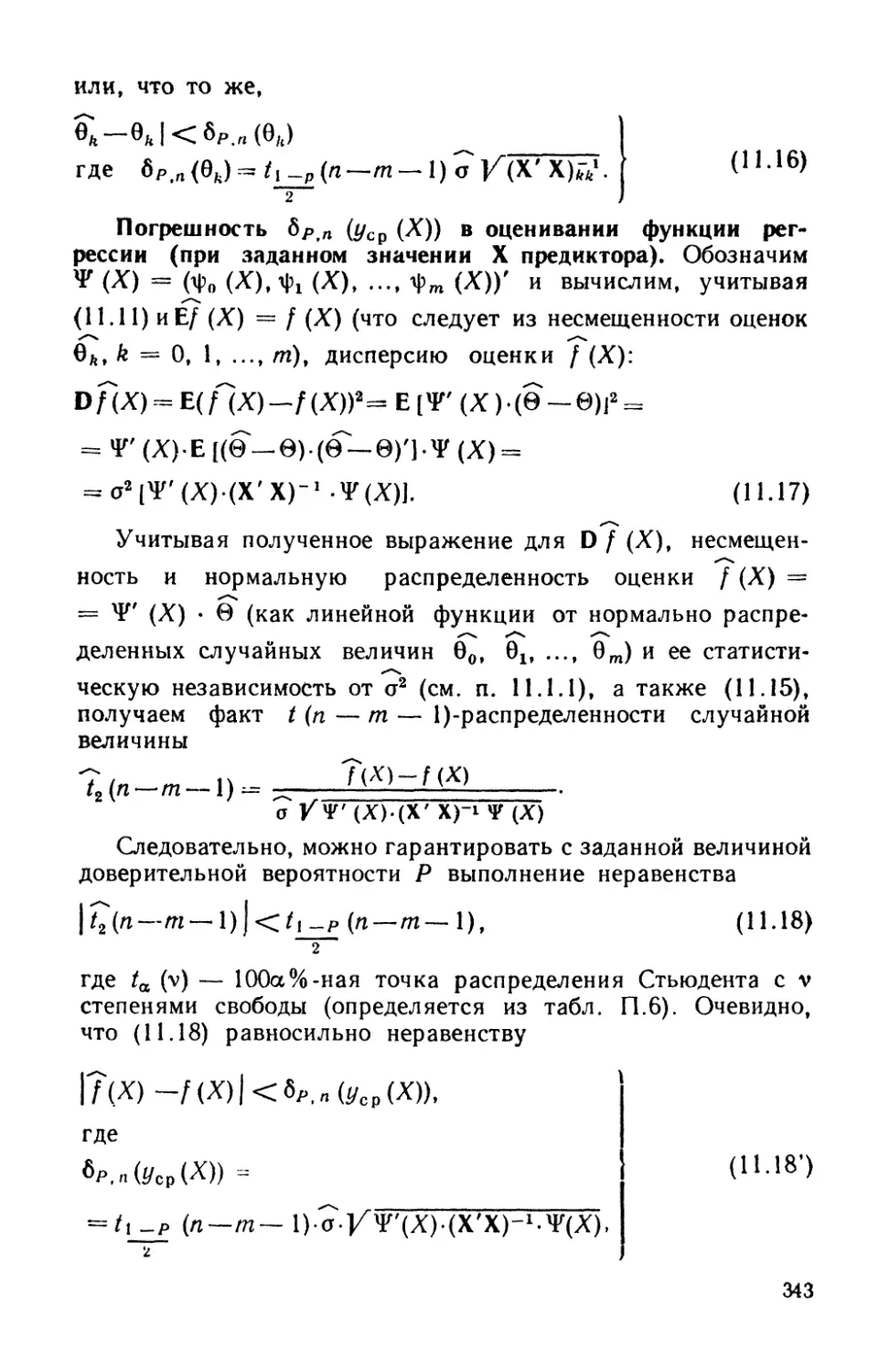

Reference

edition

Edited by

prof. S.A.Aivazyan

Finansy i statistika

Moscow

1985

С.А.Айвазян

И.С.Енюков

Л.Д.Мешалкин

ПРИКЛАДНАЯ

СТАТИСТИКА

ИССЛЕДОВАНИЕ

ЗАВИСИМОСТЕЙ

Справочное

издание

Под редакцией

проф. С.А.Айвазяна

Москва

Финансы и статистика

1985

БI 22Л 72

All

Рецензенты Е. Г. Ясин, А. И. Орлов

Айвазян С. А. и др.

АН Прикладная статистика: Исследование зависи-

зависимостей: Справ, изд. / С. А. Айвазян, И. С. Енюков,

Л. Д. Мешалкин; Под ред. С. А. Айвазяна. — М.:

Финансы и статистика, 1985. — 487 с, ил.

В пер. I p. 70 к. 13 000 экз.

Данная книга является логическим продолжением справочного

издания «Прикладная статистика: Основы моделирования и первич*

пая обработка данных», вышедшего в 1983 г. В ней рассматривают-

рассматриваются методы корреляционного, регрессионного и дисперсионного ана-

анализа. Приводятся их алгоритмы и обзор программного обеспечения.

Для статистиков, экономистов, социологов, программистов.

1702060000-017 ББК 22.172

010@1)—85 66~~84 5173

© Издательство «Финансы и статистика», 1985

ПРЕДИСЛОВИЕ

Вниманию читателя предлагается книга, продолжающая1 ре-

реализацию замысла авторов: создать многотомное справочно-

пособие по современным математическим методам статистиче-

статистической обработки данных, включающее в себя одновременное ос-

освещение необходимого математического аппарата, соответст-

соответствующего программного обеспечения ЭВМ и рекомендаций по

преодолению вычислительных трудностей, связанных с ис-

использованием описываемых методов и алгоритмов. Книга

адресована специалистам различных сфер человеческой дея-

деятельности, использующим методы математической статистики

и анализа данных в своей работе.

Для понимания материала книги читателю достаточно об-

обладать математической подготовкой в объеме программ эко-

экономического или технического вуза либо ознакомиться с ба-

базовыми понятиями теории вероятностей и математической ста-

статистики, описанными в первом томе справочного издания [141.

В свою очередь освоение материала предлагаемой книги мо-

может служить надежной и удобной базой для более глубокого

проникновения в предмет исследования, основанного на изу-

изучении специальных монографий и журнальных статей.

Тема книги, бесспорно, центральная во всем справочном

издании. Она является таковой как по глубине и разнообра-

разнообразию разработанного к настоящему времени математического

аппарата, так и по удельному бесу использования описывае-

описываемых методов и моделей в практических разработках разнооб-

разнообразного профиля.

ХВ 1983 г. вышла в свет книга: А й в а з я н С. А., Е н ю к о в И.С,

Мешалки н Л. Д. Прикладная статистика: Основы моделирования

и первичная обработка данных. — М.: Финансы и статистика. В ней, в

частности, определена прикладная статистика как самостоятельная

научная дисциплина, разрабатывающая и систематизирующая поня-

понятия, приемы, математические методы и модели, предназначенные для

организации и обработки статистических данных с целью их удобно-

удобного представления, интерпретации и получения научных и практических

выводов (см. с. 19).

Главная цель, которую ставили перед собой авторы,

оснастить исследователя, использующего в своей работе ста-

статистические методы, инструментарием, необходимым для реше-

решения ключевой проблемы всякого исследования: как на осно-

основании частных результатов статистического наблюдения за

анализируемыми событиями или показателями выявить и опи-

описать существующие между ними взаимосвязи. Именно эта

проблема, проблема статистического исследования зависимо-

зависимостей, оказывается главной в решении таких типовых задач

практики, как нормирование, прогноз, планирование, диаг-

диагностика, оценка труднодоступных для непосредственного на-

наблюдения и измерения характеристик анализируемой систе-

системы, оценка эффективности функционирования или качества

объекта, регулирование параметров процесса или системы.

Авторы стремились к объективно сбалансированному пред-

представлению материала как по структуре книги, так и по ее со-

содержанию. Однако широта и разноплановость затронутой

проблемы не позволяют им претендовать на всеобъемлющий

охват темы. Так, например, относительно узко представлена

в данном томе тематика статистического анализа динамиче-

динамических зависимостей', не дано описания весьма полезного, в оп-

определенных типах задач, аппарата логических решающих

правил1; не вошел в книгу материал, посвященный актуальной

в прикладном плане (особенно в задачах управления техноло-

технологическими процессами) тематике планирования регрессионных

экспериментов.

Книга состоит из введения и четырех разделов.

Введение играет особую роль в понимании описываемых в

дальнейшем методов и логики всей книги в целом. Можно ска-

сказать, что в нем в доступной для неискушенного читателя фор-

форме представлены содержание и логические связи всех частей

книги. Приводятся основные постановки задач и «адреса»

(в книге) их решения. Изложение проиллюстрировано про-

простыми примерами. Поэтому сравнительно слабо подготовлен-

подготовленному читателю рекомендуем не пожалеть времени на чтение

введения.

Раздел I посвящен методам и приемам, позволяющим от-

ответить на вопросы, имеется ли вообще какая-либо связь между

исследуемыми переменными, как измерить их тесноту и ка-

какова структура связей между показателями исследуемого на-

набора? При этом под структурой понимается характер всевоз-

всевозможных попарных двоичных взаимоотношений рассматривае-

1 Читатель может познакомиться с этим аппаратом статистического

исследования зависимостей, например, по книге [76}.

мых признаков (по типу «связь есть» или «связи нет»), но не

форма зависимости одного от другого. Методы, описанные в

данном разделе, составляют содержание корреляционного ана-

анализа.

Раздел II содержит описание методов и моделей, позволяю-

позволяющих исследовать вид зависимости интересующего нас «вы-

«выходного» (или «результирующего») количественного показате-

показателя от набора объясняющих переменных количественной при-

природы (регрессионный анализ). В отдельной главе (гл. 12) рас-

рассмотрен случай, когда роль объясняющей переменной играет

«время».

В разделе III решаются те же задачи, что и в разделе II,

но в ситуации, когда в качестве объясняющих переменных вы-

выступают неколичественные или одновременно неколичественные

и количественные признаки {дисперсионный и ковариационный

анализ).

И наконец, в раздел IV включены глава, посвященная

описанию методов статистического анализа так называемых

систем одновременных эконометрических уравнений (т. е. на-

набора одновременно выполняющихся соотношений, в которых

одни и те же переменные могут участвовать в разных соотно-

соотношениях: и в роли результирующего показателя, и в роли пред-

предсказывающей переменной), и глава, в которой дается обзор

наиболее интересного отечественного и зарубежного програм-

программного обеспечения методов статистического исследования за-

зависимостей.

Научная и педагогическая деятельность авторов, послу-

послужившая основой реализации предлагаемого издания, про-

проводилась в Центральном экономико-математическом институ-

институте АН СССР, в Московском государственном университете

им. М. В. Ломоносова и в Центральной научно-исследователь-

научно-исследовательской лаборатории 4-го Главного управления при Министерст-

Министерстве здравоохранения СССР.

Книга написана: С. А. Айвазяном — предисловие, введе-

введение, гл. 1,2, 5, 6, 11, выводы к гл. 9, введение и выводы к

гл. 12, § 13.5 и приложение; Л. Д. Мешалкиным — гл. 3, 4,

7 (без § 7.5, 7.6 и п. 7.2.5), 10, 13 (без § 13.5); И. С. Енюковым —

гл. 8, 15; В. В. Федоровым — гл. 9 (без § 9.6, 9.7 и п. 9.5.4),

12 (без введения и выводов), § 7.5 и 7.6; Ю. М. Кабановым —

гл. 14 (без §14.6); Е. 3. Демиденко — п. 9.5.4; § 9.6, 9.7,

14.6; А. М. Шурыгиным — п. 7.2.5.

Авторы выражают глубокую благодарность А. И. Орло-

Орлову и Е. Г. Ясину, взявшим на себя труд отрецензировать ру-

рукопись книги. Их критические замечания, бесспорно, способ-

способствовали повышению качества данного издания. Авторы при-

знательны также В. Н. Вапнику, предоставившему им мате-

материалы для написания п. 6.3.1, а также А. Б. Успенскому,

Е, 3. Демиденко, А. М. Шурыгину, Арк. И. Верескову и

О. В. Лепскому, участвовавшим в обсуждении отдельных ча-

частей рукописи, а также и Л. Ю. Метт, вложившей большой труд

в оформление рукописи.

Положительную роль в замысле и содержании книги сы-

сыграли постоянные контакты авторов со своими коллегами по

научному семинару «Многомерный статистический анализ и

вероятностное моделирование реальных процессов» (действую-

(действующему в рамках Научного совета АН СССР по комплексной

проблеме «Оптимальное планирование и управление народ-

народным хозяйством» и Совета по автоматизации научных иссле-

исследований при Президиуме АН СССР), а также по Всесоюзному

научно-методическому семинару «Вычислительные вопросы

математической статистики», действующему в Московском го-

государственном университете им. М. В. Ломоносова под руко-

руководством Ю. В. Прохорова.

С. А. Айвазян

Введение. статистическое исследование

ЗАВИСИМОСТЕЙ СОДЕРЖАНИЕ, ЗАДАЧИ,

ОБЛАСТИ ПРИМЕНЕНИЯ

В.1. Предварительное обсуждение задач

Любой закон природы или общественного развития может быть

выражен в конечном счете в виде описания характера или струк-

структуры взаимосвязей (зависимостей), существующих между изу-

изучаемыми явлениями или показателями (переменными величи-

величинами или просто переменными). Если эти зависимости: а) сто-

хаотичны по своей природе, т. е. позволяют устанавливать

лишь вероятностные логические соотношения между изучае-

изучаемыми событиями А и 5, а именно соотношения типа «из факта

осуществления события А следует, что событие В должно

произойти, но не обязательно, а лишь с некоторой (как пра-

правило, близкой к единице) вероятностью Р»; б) выявляются на

основании статистического наблюдения за анализируемыми

событиями или переменными, осуществляемого по выборке из

интересующей нас генеральной совокупности [14, п. 5.4.2),

то мы оказываемся в рамках проблемы статистического ис-

исследования зависимостей. Соответствующий математический

аппарат, будучи таким образом нацеленным в первую очередь

на решение основной проблемы естествознания: как по отдель-

отдельным, частным наблюдениям выявить и описать интересующую

нас общую закономерность? — занимает, бесспорно, централь-

центральное место во всем прикладном математическом анализе.

Перед тем как перейти к формулировке общей и частных

задач статистического исследования зависимостей, условим-

условимся описывать функционирование изучаемого реального объек-

объекта (системы, процесса, явления) набором переменных (рис. В.1),

среди которых:

jcA), xB), ..., х(р) —так называемые «входные» переменные,

описывающие условия функционирования (часть из них, как

правило, поддается регулированию или частичному управле-

управлению); в соответствующих математических моделях их назы-

называют независимыми, факторами-аргументами, экзогенными,

предикторными (или просто предикторами, т. е. предсказателя-

предсказателями), объясняющими (в книге мы будем использовать в основ-

основном два последних термина);

y{l), t/2\ ..., //<m>—выходные переменные, характери-

характеризующие поведение или результат (эффективность) функцио-

функционирования', в математических моделях их называют зависи-

зависимыми, откликами, эндогенными, результирующими или объяс-

объясняемыми (в книге используются в основном два последних

термина);

еA>, еB>, ..., е<т> —латентные (т. е. скрытые, не под-

поддающиеся непосредственному измерению) случайные юстаточ-

нысу> компоненты, отражающие влияние (соответственно на

случайные г?

факторы, L

не под да- у.

Ю Щ11 ЕС Я (тА

учету I

объясняю-

объясняющие пере-

переменные

(предик-

торные)

Анализируемая реальная система

(объект)

Механизм преобразования вход-

входных переменных 6 результирую-

результирующие показатели

резуль-

щие пе-

у >щие

~~-~,(т)\ реме

Рис. В.1. Общая схема взаимодействия переменных при статистиче-

статистическом исследовании зависимостей

У{1\ У{2)> ••-, У{т)) неучтенных «на входе» факторов, а также

случайные ошибки в измерении анализируемых показателей

(в математических .моделях мы их, как правило, будем имено-

именовать просто «остатками»).

Тогда общая задача статистического исследования зависи-

зависимостей (в терминах изучаемых показателей) может быть сфор-

сформулирована следующим образом:

по результатам п измерений

исследуемых переменных на объектах (системах, процессах)

анализируемой совокупности построить такую {вектор по-

позначную) функцию

(B.2)

10

которая позволила бы наилучшим (в определенном смысле) об-

образом восстанавливать значения результирующих (прогнози-

(прогнозируемых) переменных У = (у{1), #<2), ..., */(т))' по заданным зна-

значениям объясняющих (предикторных) переменных X = A

2 Ю'1

х\ ..., х).

Данная формулировка задачи нуждается в уточнениях.

В частности, прежде всего мы должны ответить на следующие

вопросы:

120*

100

80

60

20

/и.

в,'?

•/

V

/*

О 40 М 120 160 200 х,ру§.

Рис. В.2. Графическое представление результатов

обследования 40 семей по их среднедушевому до-

доходу (Xi) и среднедушевым денежным сбереже-

сбережениям (//,-)

а) каково математическое выражение (или структура мо-

модели [14, с. 68—73]) искомой зависимости между Y и Х> запи-

записанное в терминах У, X,f(X) И? = (еA),.еB), .... е<т>)?

б) в соответствии с каким именно критерием качества ап-

аппроксимации значений У с помощью функции f (X) мы будем

1Здесь и далее штрих при векторе или матрице означает операцию

их транспонирования. В данном случае это означает, что Y и X — соот-

соответственно т- и р-мерные вектор-столбцы.

11

определять наилучший способ восстановления значений ре-

результирующих показателей по заданным значениям объясняю-

объясняющих переменных?

в) с какой именно прикладной целью мы проводим все на-

наше исследование, т. е. для решения каких конкретных задач

мы собираемся использовать построенную в результате ис-

исследования функцию f (X)?

Прежде чем обсуждать эти вопросы, рассмотрим пример.

Пример В.1. Анализируется «поведение» двумерной

случайной величины (?, ц), где I (руб.) — среднедушевой до-

доход и ц (руб.) — среднедушевые денежные сбережения в се-

семье, случайно извлеченной из рассматриваемой совокупности

семей, однородной по своему потребительскому поведению

(см., например, [128]). В табл. В.1 и на рис. В.2 представлены

исходные статистические данные вида (В.1), характеризующие

среднедушевые величины дохода (xit руб.) и денежных сбе-

сбережений (yh руб.) за определенный отрезок времени, а именно

за месяц, в каждой (/-и, / = 1,2, ..., п) обследованной семье рас-

рассматриваемой совокупности семей (в данном условном примере

объем п статистически обследованной совокупности семей рав-

равнялся 40). В этом примере имелась возможность при отборе

исходных данных (выборки) контролировать значения предик-

торной переменной Н (условия активного эксперимента [14,

с. 121]), что позволило, в частности, разбить статистически об-

обследованные семьи на четыре равные по объему группы по

доходам.

Мы видим, что даже в пределах каждой из этих групп ве-

величины среднедушевых сбережений семей подвержены неко-

некоторому неконтролируемому разбросу, обусловленному влия-

влиянием множества не поддающихся строгому учету и контролю

факторов (т. е. налицо упомянутый выше стохастический ха-

характер зависимости между х и у). Однако это еще не значит,

что расположение точек (х(, //,), являющихся геометрическим

изображением результатов обследования семей по доходу и

сбережениям, должно быть совершенно хаотичным и не долж-

должно обнаруживать некоторой вполне определенной тенденции,

характеризующей зависимость денежных сбережений в се-

семье (ц) от ее среднедушевого дохода (?). При исследовании по-

подобных зависимостей встают следующие основные вопросы

(в скобках после вопроса указываются главы, параграфы или

пункты настоящей книги, ему посвященные).

1. Как исходя из конкретных прикладных целей исследо-

исследования определить смысл, в котором понимается исследуемая

зависимость? (В.2, § 5.3.)

2. Имеется ли вообще какая-либо связь между исследуе--

12

мыми переменными (а в случае многих переменных — какова

структура этих связей?) и как измерить тесноту этой связи?

(Гл. 1-4.)

3. Каков общий математический вид искомой связи между

г| и ?, т. е. как определяется общая структура соответствую-

соответствующей математической модели? (Гл. 6.)

4. Как, отправляясь от принятой общей структуры моде-

модели, провести необходимую вычислительную обработку исход-

исходных данных (В.1) с целью получения конкретного вида

зависимости ц от ?, что позволит в данном случае производить

количественную оценку неизвестных денежных сбережений

семьи по заданной величине ее среднедушевого дохода?

(Гл. 7—10, 13, 14.)

5. Поскольку наши выводы основаны на обработке огра-

ограниченного ряда наблюдений, то их количественные характери-

характеристики, естественно, подвержены (при повторениях соответст-

соответствующих выборочных обследований) некоторому случайному

разбросу. Как оценить степень точности наших выводов?

(Гл. 11.)

6. Как решать все вопросы в ситуациях, когда среди объяс-

объясняющих (предикторных) переменных могут быть и неколиче-

неколичественные? (Гл. 13.)

7. И наконец, если при сборе исходной статистической

информации мы находимся в условиях активного эксперимента

[14, с. 12], то как, при заданных затратах на наблюдения,

оптимально выбрать матрицу плана [14, с. 26, 68], т. е. как

определить те значения объясняющих (предикторных) пере-

переменных и то распределение заданного общего числа наблюде-

наблюдений между этими значениями, которые являются в некотором

смысле наиболее выгодными с точки зрения достижения наи-

наивысшей точности наших статистических выводов?

Вернемся к нашему примеру и попробуем ответить на не-

некоторые из поставленных здесь вопросов, в том числе на прин-

принципиальные вопросы а), б) и в), ответы на которые позволяют

уточнить общую формулировку задачи статистического ис-

исследования зависимостей, данную выше.

Начнем «с конца», т. е. с уточнения конечных прикладных

целей исследования (см. вопросы 1, а также а) и в)). Известно,

что из двух анализируемых характеристик материальной со-

состоятельности семьи характеристика денежных сбережений

(ц) относится к категории статистически труднодоступных:

содержащиеся в ежегодных и единовременных выборочных

семейных бюджетных обследованиях ЦСУ [85] сведения о сбе-

сбережениях, как правило, непредставительны. Поэтому главной

конечной целью нашего исследования (опирающегося, как мы

13

Среднедуше-

Среднедушевой доход,

руб.

Среднеду-

Среднедушевые сбе-

сбережения Т)

Средние сбе-

сбережения для

семеГ{ дан-

данной гр\ ппы

ратпческое

отклонение

s и коэффи-

коэффициент вари-

вариации I7 сбе-

сбережен и ii для

семе Л дан-

данной ггл лпы

по доходам

Ух =15,2

1/з =18^5

1/4 =14,9

Уъ =24,1

1/6 =10,3

1/7 =14,2

1/8 =31,0

1/э =20,4

10

-6,4 .

j/us=70,l

у« = 4з'.О

у" = 18',9

/=11

/ 20

г 9 .-«— ~ l ' 2

= 16,0

будем всегда предполагать, на достоверную и репрезентатив-

репрезентативную выборку исходных данных) является возможность вос-

восстановления (прогноза):

удельной (т. е. в расчете на одного члена семьи за опре-

определенный отрезок времени) величины денежных сбережений

в конкретной семье (у (л:)) по заданному значению ее среднеду-

среднедушевого дохода х\

удельной величины средних денежных сбережений (#ср (х))

в семьях данной группы х по доходам.

14

Таблица B.I

Среднедуше-

Среднедушевой доход,

руб.

Среднеду-

Среднедушевые сбе-

сбережения г\

Средние сбе-

сбережения для

семей дан-

данной группы

Среднеквад-

ратическое

отклонение

s и коэффи-

коэффициент вариа-

вариации V сбе-

сбережений для

семей дан-

данной группы

по доходам

у21 =49,6

1/22^69,4

!/2з = 77,8

1/24=43,0

</25 = 31,8

^/26^62,6

I/27=l00,2

1/28 = 68,8

у29 г~г78,0

i/:{Oac29,6

1 30

«isS^61-1

/—21

/ 1 3°

A/ Y^yi-yiA)J-

«=21

s:22,6

F(x3°)^37%

*3i ~ хгг = • • ¦ —

r/^L-= 125,5

l/;.2= 88,3

^..= 62,0

//34= 58,8

//35= 84,0

Узв= 79,0

</з7= 95,5

Узв = 120,8

Узв= 98,1

1Ао= 29,7

1 40

/=31

s(xj)ss

/ 1 40

-у -г2(у|~Ид:|))|°

/=31

==28,9

7D)=^34 %

Этой цели мы сможем достигнуть, если сумеем математи-

математически описать закономерность изменения условных теоретиче-

сжих средних значений ус9 (х) = Е (т] | ? = хУ в зависимости

1Здесь и далее используются терминология и обозначения [14]. В

частности, знаком Е обозначается операция теоретического осред-

осреднения, а знаком D — операция вычисления дисперсии случайных ве-

величин, стоящих за ними. Вертикальная черта разделяет случайную

величину, над которой производится операция осреднения или вычис-

вычисления дисперсии, и условие, при котором эта операция производится.

15

от х, а также изучить характер случайного разброса денеж-

денежных сбережений у (х) отдельных семей данной группы х по

доходам относительно своего среднего значения уср (х) (при

любом интересующем нас значении среднедушевого дохода х).

Это естественным образом приводит нас к необходимости рас-

рассмотрения математической модели вида

т, = /(*) + е, (В.З)

в которой остаточная компонента е отражает случайное от-

отклонение денежных сбережений наугад выбранной отдельной

семьи с доходом ? = х от среднего значения уср (х) =

= Е (т] 11 = х) этих сбережений, подсчитанного по всем се-

семьям данной группы по доходам, а функция / (х) описывает

характер изменения условного среднего уср (х) (при g = x) в за-

зависимости от изменения х, если дополнительно прийти к со-

соглашению, что характер случайного разброса величин у (х) =

^ (Л I 5 ~ х) относительно своих средних #ср (л;) таков, что

Е (е | g = х) = 0 при всех х.

Таким образом, из (В.З) мы непосредственно получаем

уср(х) = Е(т,|?-**)«/(*). (В.4)

Чтобы покончить с вопросами 1, а) ив), остается уточнить

общую структуру модели, т. е. определить, в каком классе

F функций f (x) мы будем производить аппроксимацию искомой

зависимости уср (х).

В нашем случае, учитывая однородный (по характеру по-

потребительского поведения) состав исследуемой совокупности

семей, естественно исходить из гипотезы об одинаковой

(в среднем) склонности семей к сбережениям, выражающейся,

в частности, в том, что все семьи начиная с некоторого «по-

«порогового» уровня дохода, склонны отделять в сбережения в

среднем одинаковую долю дохода. Математически, как легко

понять, это выразится в виде

Уср (х) = е0 + е^, (в.5)

где Во и 0t — некоторые константы (неизвестные параметры

модели). Так что

F = {60 + В^}, (В.6)

где под {/(л:; В)} понимается семейство всех тех функций

/ (лс; 6), которые могут быть получены при подстановке вме-

вместо в ее различных конкретных значений (в — векторный па-

параметр).

Такой выбор «класса допустимых решений» F= {/ (х)}

подтверждается и характером расположения совокупности то-

16

чеКг являющихся геометрическим изображением исходных

данных в наймем примере (см. на рис. В.2 расположение «кре-

«крестиков», ординаты которых определяются экспериментально

подсчитанными, т. е. вычисленными на основании имеющихся

выборочных данных, условными средними у (xf), i = 1,

2, 3, 4I.

И наконец, следует уточнить, в соотяртствии с каким имен-

именно критерием качества аппроксимации неизвестных величин

среднедушевых семейных денежных сбережений у (х) и t/cp (x)

с помощью функции Во + 0i* мы будем определять наилуч-

наилучший способ прогноза */ср (х) по х. Наиболее обоснованное и

точное решение этого вопроса опирается на знание вероятност-

вероятностной природы (а именно типа закона распределения вероятно-

вероятностей) остатков е в модели (В.З). Так, например, известно [14,

с. 281], что если предположить, что при любых значениях х

распределение вероятностей остатков г описывается @, а2)-

нормальным законом (т. е. нормальным законом со средним

значением, равным нулю, и с некоторой, вообще говоря, не-

неизвестной, но постоянной, т. е. не зависящей от х дисперсией

а2) и что остатки г (хг), i = 1, 2, ..., я, характеризующие

различные наблюдения, статистически независимы, то наи-

наименьшая ошибка прогноза */ср (х) с помощью модели / (х) ? F

(т. е. функция / (х) подбирается из класса F) обеспечивается

требованием метода наименьших квадратов

АЛ/) = S (»,-/(*i))f-*min. (B.7)

В нашем примере явно нарушено условие постоянства

дисперсии остатков (см. табл. В.1), т. е. условная дис-

дисперсия D (в| I = х) = D (л — Во — er6| I = х) = a2 (jc) су-

существенно зависит от значения х. Можно устранить это

нарушение, поделив все анализируемые величины, откла-

откладываемые по оси т}, а ^.ледовательно, и остатки в (х)г на

значения s (x) (являющиеся статистическими оценками для

а (#)), т. е. перейдя к анализу остатков Г(дс) = в (x)/s (x).

Тогда можно показать (с помощью методов, описанных,

Юбращаем внимание читателя на разницу в смысле и обозначениях

экспериментальных (выборочных) и теоретических условных средних

соответственно у (х) и #ср (х). Строго говоря, на практике теоретичес-

теоретических средних мы никогда знать не можем, однако мы опираемся в своем

исследовании^на тот факт, что в соответствии с законом большие чисел

114, с. 231] f(x) -*• уср (х) (по вероятности), когда число наблюдений,

по которым подсчитано у (х)и стремится к бесконечности.

17

например, в [14, § 11.1]), что гипотеза о @; а2)-нормальном

характере распределения остатков е (х) не противоречит имею*

щимся в нашем распоряжении данным (представленным в

табл. В.1) и, следовательно, требование (В.7) приводит к не-

необходимости решения экстремальной задачи вида

Дп (f) = Ап (90, 9,) = У »'-"•-**' -> min , (B.7')

~* \ S(X) / в в

2

.= 1 ч s(xt) ) e..et

т. е. к системе из двух линейных уравнений с двумя неизвест-

неизвестными (90 и Эх):

1 = 1 (В.7")

Решение системы (В.7") дает нам в качестве оценок 0О и 8Х

для неизвестных параметров соответственно 90 и Qt выраже-

выражения:

) (

х f 2

B

2

2 «-2(л:«-)-Уг 2

Расчет по этим формулам с использованием данных табл.

В.1 дает нам решение задачи 4:

ei = 0,685;

(Го = —40,360,

18

так что статистическая оценка искомой зависимости средней

величины среднедушевых семейных сбережений ycv (х) от зна-

значения среднедушевого дохода семей данной доходной группы

х имеет в этом случае вид

?р(*) = —40,36 + 0,685- х.

При другой статистической природе остатков 8 или при от-

отсутствии достаточной информации о типе их вероятностного

распределения возможен иной, чем по (В.7), выбор критерия

качества аппроксимации Ап (см. гл. 7). Отметим, однако, что

наиболее широкое распространение в статистической прак-

практике именно критерия наименьших квадратов (В.7) подкрепле-

подкреплено рядом исследований [15, 196]. В них обосновываются хоро-

хорошие прогностические свойства моделей, полученных в соот-

соответствии с (В.7) и в ситуациях, характеризующихся различ-

различными отклонениями от нормальности и взаимной независимо-

независимости остатков е (л:).

Заканчивая обсуждение примера В.1 и возвращаясь к об-

общему описанию задач статистического исследования зависи-

зависимостей,.отметим, что функции f (X) = Е (rj 11 = X), описываю-

описывающие поведение условных средних результирующего показате-

показателя г| (вычисленных при значениях предикторных переменных

?, зафиксированных на уровне I = X) в зависимости от изме-

изменения X, принято называть функциями регрессии (подробнее

о различных определениях функции регрессии см. в гл. 5).

В.2. Какова конечная прикладная цель

статистического исследования зависимостей?

С этого вопроса должно начинаться любое статистическое

исследование зависимостей1. Ведь от ответа на этот вопрос

существенно зависят план исследования, выбор общей струк-

структуры математической модели, интерпретация получаемых ста-

статистических характеристик и выводов и т. д.

1Опыт вынуждает констатировать наличие большого числа при-

прикладных исследовательских работ (статей, диссертаций, научных отче-

отчетов и т. д.), в которых этот тезис, казалось бы, тривиальный и очевидно

справедливый, предается забвению. В подобных работах строятся раз-

различные модели, проводится большое число вычислений, анализируются

статистические свойства полученных характеристик и т. п., но все это

в конечном счете как бы «повисает в воздухе», вызывает у компетент-

компетентного читателя вопросы: «ну и что?» или «зачем это нужно?», поскольку

остается неясным, как и для решения каких именно конкретных приклад-

прикладных задач предполагается использовать результаты проделанных мате-

математических упражнений

19

Итак, для чего же строятся математические модели типа

(В.З), описывающие статистические зависимости между ис-

исследуемыми переменными: результирующими показателями

Y = (у{1\уB\ ...,#(w)) , с одной стороны, и соответствующими

объясняющими (предикторными) переменными X = (хA), хB),

..., *(р))» с другой стороны?

Выделим три основных типа конечных прикладных целей

подобных исследований, расположив их как бы по нараста-

нарастанию глубины проникновения в содержательную сущность

анализируемой конкретной задачи.

Тип 1: Установление самого факта наличия (или отсутст-

отсутствия) статистически значимой связи между Y и X. При такой

постановке задачи статистический вывод имеет двоичную (аль-

(альтернативную) природу — «связь есть» или «связи нет» — и со-

сопровождается обычно лишь численной характеристикой (из-

(измерителем) степени тесноты исследуемой зависимости. Выбор

формы связи (т. е. класса допустимых решений F и конкрет-

конкретного вида функции f (X) в модели (В.З)) и состава предикто-

предикторов X играет подчиненную роль и нацелен исключительно на

максимизацию величины этого измерителя степени тесноты

связи: исследователю часто не приходится даже «добираться»

до конкретного вида функции f (X) и тем более он не претен-

претендует на анализ причинных влияний переменных X на резуль-

результирующие показатели.

Тип 2: прогноз (восстановление) неизвестных значений ин-

интересующих нас индивидуальных (Y (X) = (г\ | ? = X)) или

средних (Уср (X) = Е (rj | ? = X) значений исследуемых ре-

результирующих показателей по заданным значениям X соот-

соответствующих (предикторных) переменных. При такой поста-

постановке задачи статистический вывод включает в себя описание

интервала (области) Ар (X) вероятных значений прогнози-

прогнозируемого показателя Уср (X) или Y (X) и сопровождается вели-

величиной доверительной вероятности Р, с которой гарантируется

справедливость нашего прогноза, формализуемого с помощью

утверждения вида {Y (X) g Ар (X)} или {Уср (X) g Лр (X)}.

Как и в предыдущем случае, выбор формы связи (т. е. класса

допустимых решений F и конкретного вида функции f (X)

в модели (В.З)) и состава предикторов X играет подчиненную

роль и нацелен исключительно на минимизацию ошибки по-

получаемого прогноза. Однако в данном случае (в отличие от

предыдущего) исследователь существенно использует значе-

значения функции f (Х)у которые являются отправной точкой при

построении прогнозных интервалов (областей) АР(Х). Послед-

Последние обычно определяются в форме множества всех тех значе-

значений Yy которые удовлетворяют неравенствам

20

f (X) - ep(X, n) ^ Y < f (X) + ep(X, n), (B.8)

где ep(X, л) — гарантируемая (с вероятностью не меньшей

заданного значения Р) максимальная величина ошибки прог-

прогноза1. Таким образом, исследователя интересуют в данном слу-

случае лишь значения функции f (X), но не ее структура, опре-

определяющая, в частности, соотношение удельных весов влия-

влияния объясняющих переменных jcA\ x{2\ ..., х(р) на каждый

из результирующих показателей y{k) (k = 1, 2, ..., m). Так,

например, если при статистическом оценивании неизвестной

истинной зависимости

/(X)-f/cP(x<1), *<2>)=1+3*<1> + 5;с<2> (В.9)

исследователю удалось получить оценку функции f (X) в

виде

и при этом было установлено, что объясняющие переменные

A и хB> связаны между собой «почти функциональной»

2

линейной зависимостью2

2x<2\ (В. 10)

то функция / (X) будет обладать хорошими прогностическими

свойствами, несмотря на существенное отличие ее коэффици-

коэффициентов при x(I> и х{2) от соответствующих коэффициентов

истинной функции / (X). (Обращаем внимание читателя на

тот факт, что коэффициенты при х{2) в функциях / (X) и

/ (X) отличаются даже по знаку!) При подстановке заданных

значений объясняющих переменных л:A) и *B> в правые ча-

части (В.9) и (В.9'), при условии, что эти значения связаны при-

приближенным соотношением (В. 10), мы будем получать совпа-

совпадающие (или приближенно совпадающие) результаты / (X)

и / (X), характеризующие усредненную величину уср (X) ис-

исследуемого результирующего показателя.

Тип 3: выявление причинных связей между объясняющими

переменными X и результирующими показателями Y, частичт

1Напоминаем читателю, что (, е и К являются m-мерными векто-

векторами (см. (В.2)), так что запись (В.8) означает справедливость т соот-

соответствующих покомпонентных неравенств.

гГоворя о «почти функциональной» линейной зависимости между

*О> и х<2>, мы имеем в виду близость к единице (по абсолютной величи-

величине) коэффициента корреляции между этими переменными [14, с. 155].

21

нов управление значениями Y путем регулирования величин

объясняющих переменных X. Такая постановка задачи претен-

претендует на проникновение в «физический механизм» изучаемых

статистических связей, т. е. в тот самый механизм преобразо-

преобразования «входных» переменных X и в в результирующие пока-

показатели Y (см. рис. В.1), который в большинстве случаев ис-

исследователь, не будучи в состоянии его конструктивно опи-

описать, вынужден именовать (следуя сложившейся кибернети-

кибернетической терминологии) «черным ящиком».

И при выявлении причинных связей, и при намерении ис-

исследователя использовать модели типа (В.З) или (В.4) для уп-

управления значениями результирующих показателей Ycp (X)

или Y (X) путем регулирования величин объясняющих пере-

переменных X на первый план выходит задача правильного оп-

определения структуры модели (т. е. выбора общего вида функ-

функции f (X)), решение которой обеспечивает возможность количе-

количественного измерения эффекта воздействия на Y (X) каждой из

объясняющих переменных *A), *B>, ..., х^р) в отдельности.

Однако как раз это место (правильный выбор общего вида

функции f (X)) и является самым слабым во всей технике ста-

статистического исследования зависимостей: к сожалению, не

существует стандартных приемов и методов, которые образовы-

образовывали бы строгую теоретическую базу для решения этой важ-

важнейшей задачи (некоторые рекомендации по проведению этого

этапа исследования содержатся в гл. 6).

Заметим, что исследователи, пожалуй, чаще других ста-

ставят перед собой именно цели типа 3. И в таких прикладных

задачах, как управление качеством продукции с помощью ре-

регулирования хода технологических процессов [95, 47], прог-

прогноз и анализ объемов произведенной продукции по затратам на

трудовые ресурсы и капитальные вложения [31, 152], построе-

построение интегральных целевых функций, описывающих эффектив-

эффективность функционирования экономических единиц (предприятий,

семей) по набору частных характеристик [9, 11, 128] и др.,

это вполне оправдано. Однако, к сожалению, далеко не всег-

всегда целевые установки исследователей подкреплены объектив-

объективными возможностями их реализации.

В.З. Математический инструментарий

Методы статистического исследования зависимостей состав-

составляют содержание отдельных частей многомерного статистиче-

статистического анализа, который можно определить [8, с. 731] как раз-

22

дел математической статистики, посвященный построению

оптимальных планов сбора, систематизации и обработки мно-

многомерных статистических данных типа (В.1), нацеленных в

первую очередь на выявление характера и структуры взаимо-

взаимосвязей между компонентами исследуемого многомерного при-

признака (X, Y) и предназначенных для получения научных и

практических выводов. При этом среди р + т компонент ис-

исследуемого многомерного признака (X, Y) могут быть: ко-

количественные, т. е. скалярно измеряющие в определенной шка-

шкале степень проявления изучаемого свойства объекта (денеж-

(денежный доход и сбережения семьи, объем валовой продукции,

численность работников на предприятии и т. п.); порядковые

(или ординальные), т. е. позволяющие упорядочивать анализи-

анализируемые объекты по степени проявления в них изучаемого

свойства (уровень жилищных условий семьи, квалификацион-

квалификационный разряд рабочего, уровень образования работника и т. п.);

классификационные (или номинальные), т. е. позволяющие раз-

разбивать обследованную совокупность объектов на не поддаю-

поддающиеся упорядочиванию однородные (по анализируемому свой-

свойству) классы (профессия работника, мотив миграции семьи,

отрасль промышленности и т. п.). Разделы многомерного ста-

статистического анализа, составляющие математический аппарат

статистического исследования зависимостей, формировались

и развивались с учетом специфики анализируемых моделей,

обусловленной природой изучаемых переменных. Соответст-

Соответствующая специализация этих разделов отражена в табл. В.2.

В ней же указаны главы данной книги и другие литературные

источники, посвященные описанию указанных разделов.

Из табл. В.2 видно, что данная книга не охватывает мето-

методов исследования зависимостей неколичественного или сме-

смешанного (разнотипного) результирующего показателя ОТ ко-

количественных или смешанных объясняющих переменных:

объемность и специфичность указанной темы обусловливают

целесообразность посвящения ей специального издания.

Кроме того, принцип систематизации различных схем, при-

принятый в табл. В.2, не приспособлен для выделения одного важ-

важного (особенно в области социально-экономических приложе-

приложений) случая, когда связи между количественными перемен-

переменными X и У описываются системой одновременных уравнений,

в которых одни и те же переменные могут играть одновремен-

одновременно (в различных уравнениях системы) и роль результирующих,

и роль объясняющих. Этому посвящена теория одновременных

эконометрических уравнений, основные результаты которой

представлены в гл. 14.

23

Таблица В.2

п/п

1

2

3

4

5

6

7

Природа результирующих

показателей

Количественная

Количественная

Количественная

Количественная

Неколичественная (по-

(порядковые, или ординаль-

ординальные, переменные)

Неколичественная (клас-

(классификационные, или но-

номинальные, переменные)

Смешанная (количест-

(количественные и неколичествен-

неколичественные переменные)

Природа объясняющих пе-

переменных (предикторов)

Количественная

Единственная количест-

количественная переменная, ин-

интерпретируемая как

«время*

Неколичественная (орди-

(ординальные или номиналь-

номинальные переменные)

Смешанная (количест-

(количественные и неколичествен-

неколичественные переменные)

Неколичественная (орди-

(ординальные и номинальные

переменные)

Количественная

Смешанная (количест-

(количественные и неколичествен-

неколичественные переменные)

Название обслуживающих

разделов многомерного

статистического анализа

Регрессионный и корреляци-

корреляционный анализ

Анализ временных рядов

Дисперсионный анализ

Ковариационный анализ,

модели типологической рег-

регрессии

Анализ ранговых корреля-

корреляций и таблиц сопряженно-

сопряженности

Дискриминантный анализ,

кластер-анализ, таксоно-

таксономия, расщепление смесей

ПЯРППРПРЛИНИИ

Аппарат логических решаю-

решающих функций

Главы книги,

посвященные

данным

разделам

1, 4, 5, 6,

7, 8, 9, 10,

11, 14

12

13

13

2,3

—

—

Другая литература,

посвященная

данным разделам

[10, 17, 20, 25, 34,

43, 44, 46, 47, 50,

65, 77, 93, 103,

106, 119]

[18, 21, 28, 41, 66,

80, 144]

[66, 148]

[4, 6, 19, 82]

[23, 65, 67]

[11, 19,20, 48,

58, 66]

[76]

B.4.

Некоторые типовые задачи практики

Накопленный опыт практического использования аппарата ста-

статистического исследования зависимостей позволяет выделить

те типы основных прикладных направлений исследований,

в которых этот аппарат работает особенно часто и плодотво-

плодотворно. Если попытаться расщепить общую проблему оптималь-

оптимального управления сложной системой (т. е. центральную проб-

проблему кибернетики) на основные составляющие (рис. В.З), то

Проблема оптимального упрабления

сложной системой

Нормиро-

Нормирование

Прогноз,

планиро-

Вание,

диагнос-

диагностика

Оценка трудно-

труднодоступных для

непосредствен-

непосредственного наблюде-

наблюдения и из мер е-

ния парамет-

параметров системы

Оценка

эффектив-

эффективности

функцио-

функционирования

(или каче-

качества)

системы

Оптималь-

Оптимальное регу-

регулирование

парамет-

параметров функ-

ционирова-

ционирования систе-

системы

Исходные статистические данные

(информационная база)

Рис. В.З. Основные направления практического использования аппа-

аппарата статистического исследования зависимостей и центральная

проблема кибернетики

в качестве этих составляющих как раз и фигурируют именно

те направления прикладных исследований, в разработке ко-

которых существенную роль играет математический аппарат

статистического исследования зависимостей.

Естественность предложенного здесь расщепления общей

проблемы оптимального управления сложной системой легко

пояснить практически на любом примере принятия управлен-

управленческого решения. Остановимся, скажем, на примере принятия

управленческого решения руководителем производственного

или учрежденческого подразделения при зачислении в штат

нового сотрудника. Основываясь на знании необходимой ин-

информационной базы (в данном случае это целевые установки

и возможности подразделения и основные сведения о прини-

принимаемом сотруднике), лицо, принимающее решение (ЛПР),

25

должно последовательно проанализировать и решить следую-

следующие задачи:

а) определить нормативные требования к деятельности

сотрудников, т. е. пронормировать их труд (направление I

на рис. В.З);

б) спрогнозировать возможности сотрудника и, сопоста-

сопоставив их с основными целевыми установками подразделения,

спланировать его деятельность, включив ее в план общего

фронта работ, выполняемых подразделением (направление

И);

в) при прогнозировании потенциальных возможностей но-

нового сотрудника (а в ряде случаев — и при последующей

оценке эффективности его деятельности) весьма существен-

существенным оказывается умение оценить ряд таких не поддаю-

поддающихся непосредственному измерению его качеств, как инициа-

инициативность, творческая активность, дисциплинированность, тру-

трудолюбие, обязательность, «контактность» с другими членами

коллектива и т. п. (направление III);

г) в некоторых (особенно непроизводственных) областях

деятельности человека оценка эффективности его работы (без

которой невозможно оптимальное управление) сводится к

весьма трудной задаче построения агрегированного показате-

показателя (латентного, т. е. скрытого, непосредственно не измеряе-

измеряемого) ее качества (направление IV);

д) и наконец, опираясь на решение задач а)—г) и на воз-

возможность регулирования параметров (в данном случае стиму-

стимулирующего и «штрафного» характера), от которых в определен-

определенной мере и в соответствии с некоторой, как правило, статисти-

статистической закономерностью зависит уровень эффективности ра-

работы сотрудника, ЛПР осуществляет такую «настройку» зна-

значений этих параметров, которая обеспечивает, по возможности,

оптимальный режим функционирования всей системы, т. е.

вверенного ему подразделения (направление V).

Остановимся кратко на роли методов статистического ис-

исследования зависимостей в разработке каждого из упомяну-

упомянутых направлений.

S. Нормирование. Общая схема формирования нормативов

с использованием методов статистического исследования за-

зависимостей может быть представлена следующим образом.

Нормативный показатель играет в моделях типа (В.З)—(В.4)

роль результирующей (объясняемой) переменной у, а факто-

факторы, участвующие в расчете нормативного показателя, — роль

объясняющих (предикторных) переменных хA>, л:B), ..., х{р).

Предполагается, что привлечение для расчета норматива у

полной системы определяющих его факторов, т. е. такой си-

26

стемы, с помощью которой возможно детерминированное

(однозначное) определение величины */, либо принципиально

невозможно, либо нецелесообразно из-за чрезмерного услож-

усложнения расчетных формул. Поэтому анализируется связь между

у и (xA>, хB\ ..., х{р>) вида

у = f (х<гК х<2\ ..., *0»; в) + е, (В.11)

где 8 — остаточная случайная компонента, обусловливающая

возможную погрешность в определении норматива у по из-

известным значениям факторов хA\ х<2), ..., х{р\ а / (X; G) —

функция из некоторого известного параметрического семейст-

семейства F ={/ (X; 6)}, в?Л, однако численное значение входя-

входящего в ее уравнение параметра Э (вообще говоря, векторно-

векторного) неизвестно. С целью подбора «подходящего» значения в

проводится контрольный эксперимент (наблюдение), в резуль-

результате которого исследователь получает исходные статистиче-

статистические данные вида (В.1). Далее на основании этих данных

проводится необходимый статистический анализ модели

(В. И) с целью получения оценки в неизвестного параметра в

и анализа точности полученной расчетной формулы КСр (X) =

= / (X; в), в которой величина условной (экспериментальной)

средней Кср (X) интерпретируется как средний нормативный

показатель при значениях определяющих факторов, равных X.

Данный подход использовался, в частности, при разработ-

разработке методик расчета численности служащих (по различным их

функциям) на промышленном предприятии отрасли по набору

технико-экономических показателей, характеризующих пред-

предприятие, при построении автоматизированных систем норми-

нормирования ремонтных работ [82] и в других областях (см., на-

например, ГОСТ 22015—76 «Качество продукции. Нормирова-

Нормирование и статистическая оценка качества металлических мате-

материалов и изделий по механическим характеристикам»).

II. Прогноз, планирование, диагностика. Отправляясь от

общей формулировки задачи статистического исследования

зависимостей (см. § В. 1) и от ее модельной записи (В. И),

определим в качестве результирующей переменной у интере-

интересующий нас прогнозируемый (планируемый, диагностируе-

диагностируемый) показатель, а в качестве объясняющих (предикторных)

переменных хA), х{2\ ..., х(р) — сопутствующие факторы,

значения которых содержат основную информацию о величине

этого показателя1. Наличие остаточной случайной компоненты

ХВ моделях прогноза и планирования в качестве одного из объяс-

объясняющих факторов *(*) вводится в явном виде «длина прогноза», или

«горизонт планирования», / (в единицах времени).

27

8, как и прежде, отражает тот факт, что переменные л*A\ х{2\

.., х{р) содержат не всю информацию об //, и обусловливает

неизбежность погрешности в определении прогнозируемого

(планируемого, диагностируемого) показателя по известным

значениям объясняющих факторов х{1\ хB), ..., х{р). Исход-

Исходные статистические данные вида (В.1) исследователь получа-

получает, регистрируя одновременно значения у и (хA), ..., х{р)) на

анализируемых объектах в прошлом (в базовом периоде) или

на других объектах, но однородных с анализируемыми.

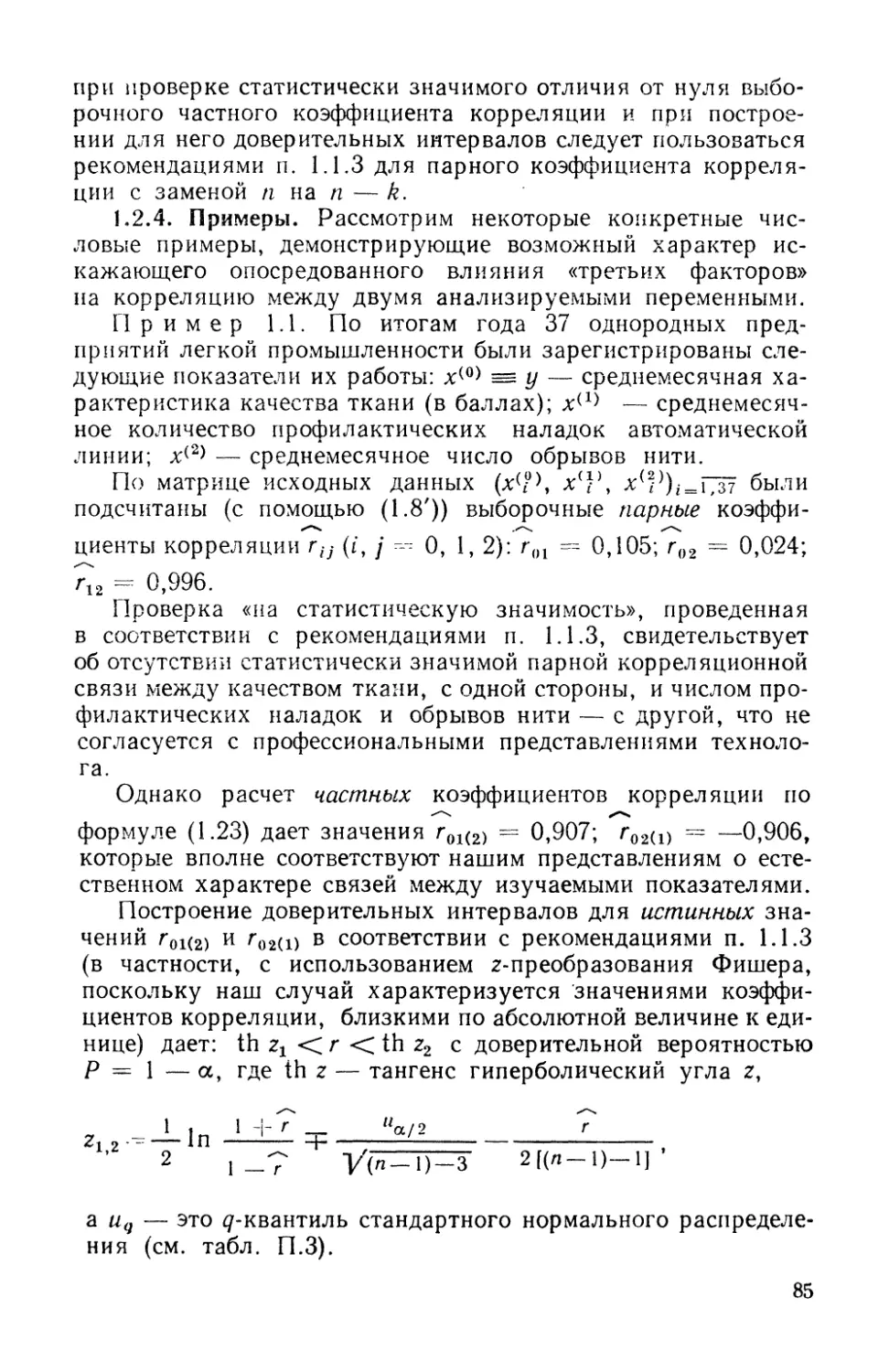

Имеется обширная литература по решению задач прогно-

прогноза, планирования и диагностики с использованием аппарата

статистического исследования зависимостей [4, 29, 31, 47, 80,

93, 128, 144, 152, 1631. В табл. В.З приведены примеры не-

некоторых типичных задач этого направления прикладных ис-

исследований.

Можно было бы продолжить перечень примеров табл. В.З,

заполнив их аналогичными, задачами из энергетики (задача

оперативного и долгосрочного прогноза потребления электро-

электроэнергии), гидрологии, социологии, физики и других областей

деятельности человека.

III. Оценка труднодоступных для непосредственного на-

наблюдения и измерения параметров системы. Восстановление

возраста археологической находки по ряду косвенных призна-

признаков; прочности бетона с помощью косвенных (неразрушающих)

методов контроля (например, по отношению диаметров отпе-

отпечатков на поверхности испытуемого образца бетона и на воз-

воздействующем на него эталонном молотке [161); денежных сбе-

сбережений семьи по ее доходу (в среднедушевом исчислении) —

во всех этих ситуациях исследователь вынужден иметь дело

с показателями, труднодоступными для непосредственного из-

измерения (они выделены в тексте курсивом). Очевидно, для того

чтобы иметь принципиальную возможность статистически вы-

выявить связь, существующую между труднодоступным показа-

показателем у и косвенно связанными с ним, но легко поддающими-

поддающимися наблюдению и измерению признаками Л'A), хB>, ..., х(р\ ис-

исследователю необходимо располагать исходными статистиче-

статистическими данными вида (В.1), которые получают с помощью спе-

специально организованного контрольного эксперимента или на-

наблюдения [16]. После того как эта связь выявлена (и оценена

степень ее точности), она используется для косвенного опре-

определения значений труднодоступных показателей лишь по зна-

значениям объясняющих переменных х{1\ х{2\ ..., х{рК

IV. Оценка эффективности функционирования (или каче-

качества) анализируемой системы. Пытаясь оценить (в целом)

эффективность деятельности отдельного специалиста, подраз-

28

деления или предприятия, проранжировать страны по неко-

некоторому интегральному качеству (например, по степени про-

прогрессивности структуры их фондов потребления или всего

национального дохода [111), наконец, проставить балльные

оценки спортсмену — участнику командных соревнований в

игровых видах спорта за качество его игры в определенном

цикле [11], мы каждый раз, по существу, решаем (на интуи-

интуитивном уровне) одну и ту же задачу: отправляясь в своем ана-

анализе от набора частных показателей хA>, х{2\ ..., х<р\ каж-

каждый из которых может быть измерен и характеризует какую-

нибудь одну частную сторону понятия «эффективность», мы

их как бы взвешиваем (т. е. внутренне оцениваем удельный

вес их влияния на общее, агрегированное, понятие эффектив-

эффективности) и выходим на некоторый скалярный агрегированный

показатель эффективности у. Этот показатель — латентный

(скрытый), так как он принципиально не поддается непосредст-

непосредственному измерению (не существует или нам не известна объек-

объективная шкала, в которой он мог бы быть измерен). Но он с

некоторой точностью восстанавливается по значениям частных

показателей эффективности х{1\ л'B), ..., xipK Это значит, что

между латентным агрегированным показателем у и набором

частных критериев эффективности хA), хB), ..., х{р) сущест-

существует статистическая связь типа (В.И).

Главная особенность (и трудность) описываемой ситуации

заключается в том, что при получении (сборе) исходной ста-

статистической информации вида (В.1) значения результирую-

результирующего показателя у могут быть получены только с помощью спе-

специально организованного экспертного опроса (значения ча-

частных критериев эффективности х{1\ хB>, ..., х{р\ как пра-

правило, поддаются непосредственному измерению). Форма экс-

экспертной информации о значениях у может быть различной

(балльные оценки, упорядочения, парные сравнения [11]).

Но только располагая наряду со статистической информацией

об X = (хA\ хB), ..., х(рУ>У одной из форм соответствующей

экспертной информации об у, мы можем статистически по-

построить некоторую аппроксимацию */ср (X) = / (X; в) для

агрегированного критерия эффективности функционирования

системы и использовать ее затем в качестве формализованно-

формализованного метода оценки интегрального понятия эффективности (т. е.

уже без привлечения экспертов, а лишь по частным критериям

хA\ х{2\ ..., х^). Такая модифицированная форма исполь-

использования аппарата статистического исследования зависимостей

предложена в [91, развита в [68] и носит название эксперты-

статистического метода построения неизвестной целевой

функции.

2$

со

о

Таблица В.З

с

с

'<

I

1

2

3

Содержание задачи

2

Прогноз и планирование

объема выпускаемой про-

продукции по факторам про-

производства (построение

производственных функ-

функций)

Прогноз урожайности

сельскохозяйственных

культур по климатиче-

климатическим факторам и факто-

факторам сельскохозяйствен-

сельскохозяйственного производства

Прогноз производитель-

производительности труда, анализ ее

динамики

Прогнозируемый

(планируемый,

диагностируемый)

показатель У

3

Объем валовой

продукции

Урожайность

Производитель-

Производительность труда

Предсказывающие

(объясняющие)

переменные

*<»>,*<'> дг(Р)

4

л:A) — затраты на труд;

*B) — затраты на капи-

капитальные вложения;

*C) — время (номер го-

года)

.vA)— сумма весенних

«активных температур»;

*B) — количество весен-

весенних осадков;

хC) — механовооружен-

ность;

*D) — затраты на удобре-

удобрения

х<1) — фондовооружен-

фондовооруженность;

хB) — энерговооружен-

энерговооруженность;

л'C) — время (могут при-

привлекаться и другие фак-

факторы с учетом специали-

специализации производства)

Аналитическая запись общего

вида исследуемой зависимости

(один из вариантов)

5

Уср(*)-0о(А:A)H1 X

X (*(*>)*. ев-*C)

Уср(*) = 00- П (*(Л)Л

или

Та же, что и в п. 1

Литература,

посвященном

данной

задаче

6

[31, 47, 80

126, 152]

[65]

[144]

4

5

6

7

Прогноз объемов потреб-

потребления продукции или ус-

услуг определенного вида

(построение кривых Эн-

геля)

Анализ динамики нацио-

национального дохода и взаи-

взаимосвязей его основных

составных частей

Техническая диагностика

Медицинская диагности-

диагностика

Удельная величина

спроса (потребле-

(потребления) товаров или

услуг определен-

определенного вида

yt1) — доход в го-

году /;

yt2) — фонд пот-

потребления в году /

Показатель техни-

технического состояния

системы или про-

процесса

Наличие («тя-

(«тяжесть») заболева-

заболевания

х — среднедушевой до-

доход

Xt — капиталовложения

(инвестиции) в году t

Значения параметров си-

системы или процесса, кос-

косвенно характеризующих

различные частные ас-

аспекты ее технического

состояния

Результаты медико-био-

медико-биологических анализов и

тестирование пациентов

логистическая кривая

F2 > 0)

«//B>-б0+е1г/,A>-г-е(

(е* — остаточная случайная

компонента)

Зависит от специфики задачи

Зависит от специфики задачи

[128]

[29, 31, 80]

[5, 1451

[163]

Продолжение табл. ?.3

с

с

1

8

9

10

Содержание задачи

2

Геологический прогноз

(месторождений)

Прогноз и планирование

конструкционных и тех-

технико-экономических ха-

характеристик проектиру-

проектируемого сооружения

Прогноз и планирование

надежностных характе-

характеристик отдельных узлов

и элементов сложного из-

изделия

Прогнозируемый

(планируемый,

диагностируемый)

показатель у

3

Наличие (уровень)

рудоносности вг ис-

исследуемом месте

Конструкционные

и технико-эконо-

технико-экономические характе-

характеристики проекти-

проектируемого сооруже

ния

Долговечность

(продолжитель-

(продолжительность жизни до

разрушения) эле-

элемента

Предсказывающие

(объясняющие)

переменные

*(!), *B) $х{р)

4

Процентное содержание

эяда сопутствующих

элементов в исследуемом

месте, их динамика в

«геологическом» времени

Исходные параметры ме-

места и условий строитель-

строительства, нормативные зада-

задания по основным резуль-

результирующим показателям

проектируемого соору-

сооружения

х — величина эксплуата-

эксплуатационного напряжения

Аналитическая запись общего

вида исследуемой зависимости

(один из вариантов)

5

Зависит от специфики задачи

Зависит от специфики задачи

j/cPW = e0+elv*-e'

(в, > 0)

Литература,

посвященная

данной

задаче

6

[4]

[10, 125]

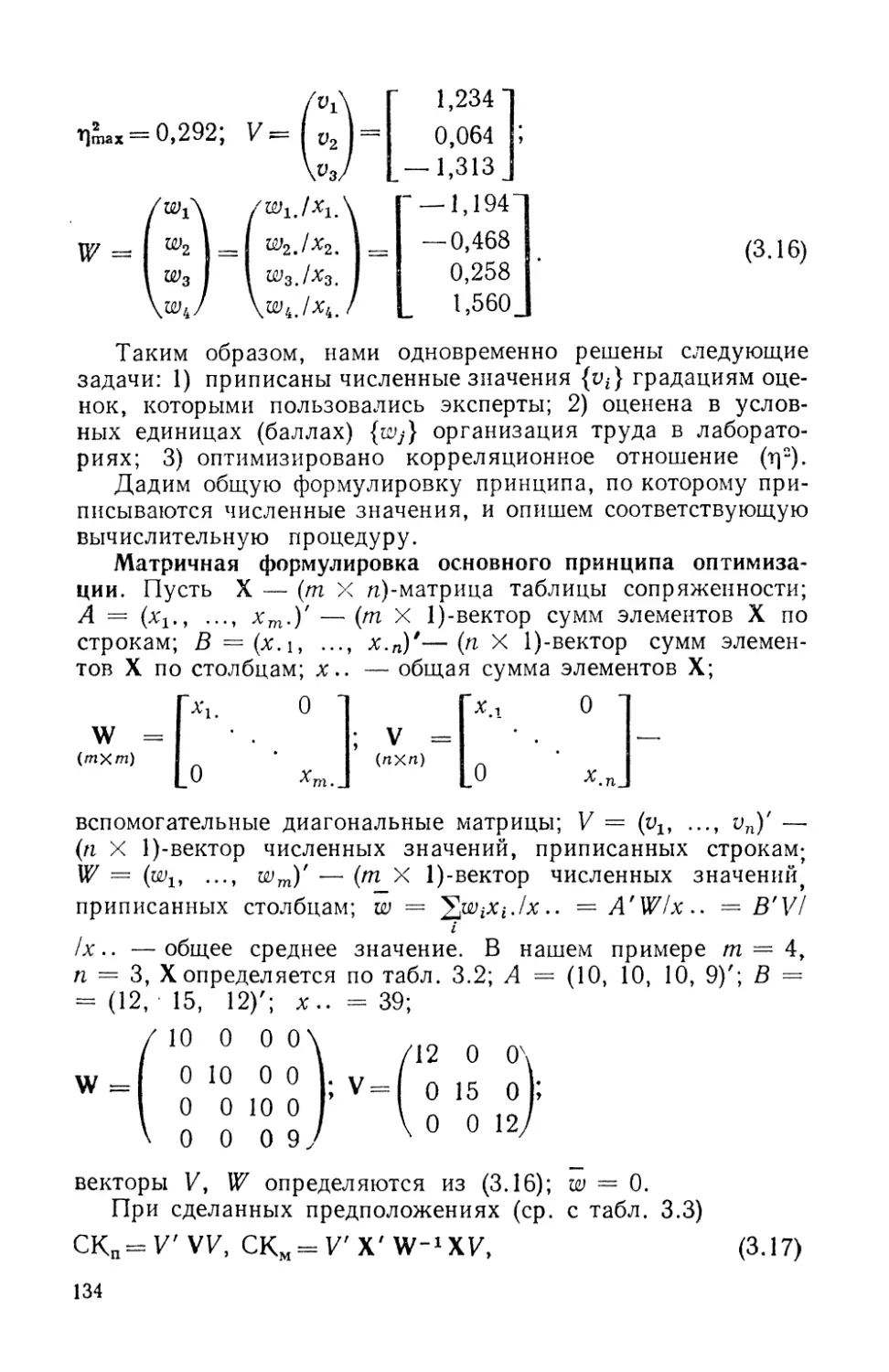

В описанную схему вкладывается широкий класс задач

теории и практики измерения комплексного понятия «каче-

«качество» сложного'изделия (т. е. квалиметрии [5]): в этих задачах

у интерпретируется как агрегированный (комплексный) пока-

показатель качества изделия, а *A>, х{2\ ..., *(р> — как отдельные

частные характеристики его качества (надежность, экономич-

экономичность, удобство пользования, эстетический вид и т. п.). В ка-

качестве параметрических семейств F = {/ (X; в)}, привлекае-

привлекаемых при статистическом анализе задач данного типа, чаще дру-

других используются функции линейные

f(X; в)-ео + е1%п> + ...+ер;с«» (ВЛ2)

и степенные

/(X; Q) = %{xi»f*{xW)**...(xM)*p (B.13)

последняя особенно характерна для задач квалиметрии).

Остается отметить, что и традиционные подходы аппарата

статистического исследования зависимостей (классический ре-

регрессионный анализ, метод наименьших квадратов и т. п.)

широко используются в практике оценки технического уров-

уровня и качества продукции. Это, в частности, отражено и в со-

соответствующей официальной документации (см., например,

РД 50—149—79: Методические указания по оценке техниче-

технического уровня и качества промышленной продукции. Основные

положения; ГОСТ 22732—77: Методы оценки уровня каче-

качества промышленной продукции и др.).

V. Оптимальное регулирование параметров функциониро-

функционирования анализируемой системы. Рассмотрим пример [10].

При анализе производительности мартеновских печей на одном

из заводов исследовалась, в частности, зависимость между про-

производительностью в тонно/часах (для исключения влияния за-

задержек и простоев часовая производительность мартеновской

печи определялась как частное от деления массы плавки на

продолжительность периода от начала завалки до выпуска) и

процентным содержанием углерода в металле по расплавле-

расплавлении ванны (пробу брали через час после первого скачивания

шлака). Результаты замеров по 130 плавкам (т. е. объем п

обрабатываемой статистической выборки вида (В.1) равен 130)

приведены на рис. В.4. Очевидно, величины производительнос-

производительности (yt) и процентного содержания углерода (xt) подвержены не-

некоторому неконтролируемому разбросу, обусловленному влия-

влиянием множества не поддающихся строгому учету и контролю

факторов. Другими словами, последовательность пар чисел

?*ь Уд> i• = 1» 2, ..., 130, представляет в данном случае ре-

Зак. 24* 33'

У,т/ч

18 f

17

Iff

15

зультаты 130 независимых наблюдений двумерной случайной

величины (?, г)). Однако сквозь кажущуюся хаотичность рас-

расположения точек (xi, iji) на рис. В.4 просматривается вполне

определенная закономерность зависимости условного средне-

среднего значения производительности уСр (х) = Е (г)|? = х) от

величины процентного содержания углерода х. Поэтому, рас-

располагая статистической зависимостью уСХ) (х), мы можем дать

рекомендации технологу по оптимальному (с точки зрения мак-

максимизации производительности)

управлению процессом выплав-

выплавки: поддерживать процентное

содержание углерода в пределах

0,6—1,0%.

Мы не случайно начали с

этого примера. Использование

методов статистического иссле-

исследования зависимостей в задачах

оптимального регулирования хо-

хода технологического процесса и

построения соответствующих ав-

автоматизированных систем управ-

управления технологическими процес-

процессами (АСУТП) можно отнести к

примерам грамотных и относи-

относительно распространенных акту-

актуальных приложений этого аппа-

аппарата [47, 145]. Общая схема

таких приложений предусматривает (в дополнение к приве-

приведенному выше частному примеру ): а) одновременное рассмот-

рассмотрение . нескольких результирующих показателей у^г\ #B\...,

у(т> (производительность, качество продукции, расход сырья

и энергии и т. п.) и многих регулируемых параметров техно-

технологического процесса хA), х{2\ ..., х(р>; б) возможность сбора

исходной статистической информации вида (В. 1) в условиях

активного эксперимента (см. § В.1, задача 7).

Менее освоенным (но не менее правомерным и актуальным)

является этот подход в задачах оптимального регулирования:

характеристик социально-экономического поведения лю-

людей и целых коллективов в ситуациях, когда существует прин

ципиальная возможность выявления статистических связей

между этими характеристиками и набором объясняющих (и

хотя бы частично регулируемых) факторов [40, 128];

характеристик курса медицинского лечения;

структуры и объемов нагрузок и видов заданий в процес-

процессе профессиональной подготовки специалистов.

0,2 0,4 0}6 0,8 1,0 1,2 1,4 х,%

Рис. В.4. Зависимость про-

производительности ( г/, т/ч)

от процентного содержания

углерода (х, %) в металле

до расплавления

34

В.5. Основные типы зависимостей

между количественными переменными

При изучении взаимосвязей между анализируемыми количест-

количественными показателями следует установить, к какому именно

типу зависимостей относится исследуемая схема. Под типом

зависимости мы подразумеваем в данном случае не аналитиче-

аналитический вид функции Кср (X) — / (X; 0) в моделях вида (В. 11)

(о выборе общего аналитического вида функции / (X; в) см.

гл. 6), а природу анализируемых переменных (X, у) и соот-

соответственно интерпретацию функции / (X; в) в каждом конкрет-

конкретном случае.

Зависимость между неслучайными переменными (схема А).

В этом случае результирующий показатель */детермипированно

(т. е. вполне определенно, однозначно) восстанавливается по

значениям неслучайных объясняющих переменных X =

= (хA\ х{2\ ..., х(р)), т. е. значения у зависят только от со-

соответствующих значений X и полностью ими определяются.

Это — обычная схема чисто функциональной зависимости

между неслучайными переменными, когда у является некото-

некоторой функцией от р переменных X (т.е. у — f (X)), что является

вырожденным случаем зависимостей вида (В. 11), когда оста-

остаточная случайная компонента е равна нулю (с вероятностью

единица).

Известно, например, что возраст дерева у (в годах) можно

однозначно восстановить по числу колец х на срезе его ство-

ствола, а именно у = х. Примеры адекватного описания реальных

зависимостей с помощью чисто функциональных (нестохастиче-

(нестохастических) связей, к сожалению, крайне редки в практике исследо-

исследований. Кроме того, при проведении их анализа нет необхо-

необходимости использовать методы вероятностно-статистической

теории. Поэтому в дальнейшем изложении мы не будем больше

возвращаться к этому типу зависимостей.

Регрессионная зависимость случайного результирующего

показателя г) от неслучайных предсказывающих переменных

X (схема В). Природа такой связи может носить двойственный

характер: а) регистрация результирующего показателя г| не-

неизбежно связана с некоторыми случайными ошибками измере-

измерения е, в то время как предикторные (объясняющие) перемен-

переменные X = (хA), хB\ ..., х(р))' измеряются без ошибок (или ве-

величины этих ошибок пренебрежимо малы по сравнению с со-

соответствующими ошибками измерения результирующего по-

показателя); б) значения результирующего показателя г) за-

зависят не только от соответствующих значений X, но и еще от

2* 35

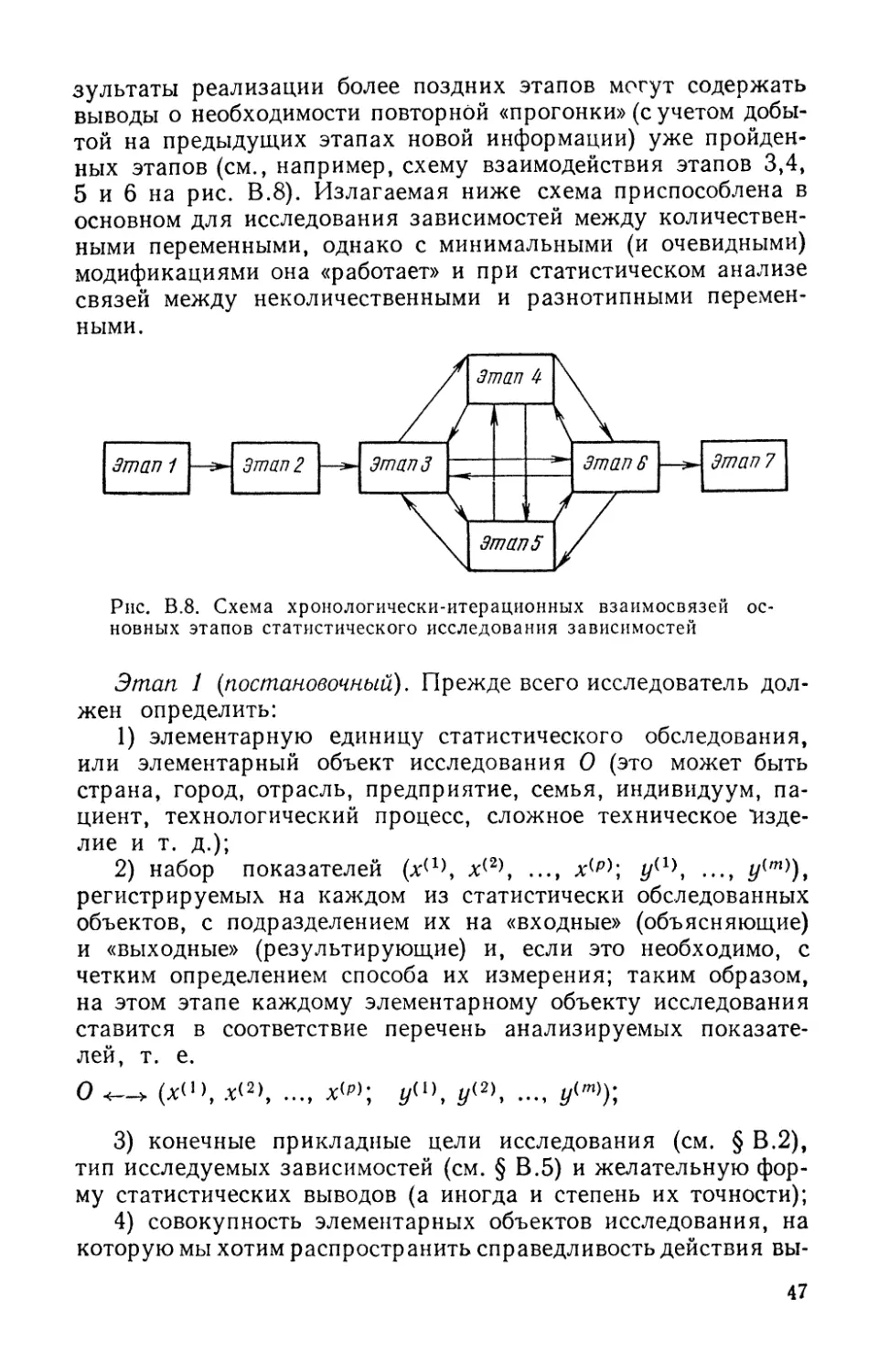

ряда неконтролируемых факторов, поэтому при каждом фик-

фиксированном значении X* соответствующие значения резуль-

результирующего показателя г) (X*) = (г\\Х = X*) неизбежно под-

подвержены некоторому случайному разбросу.

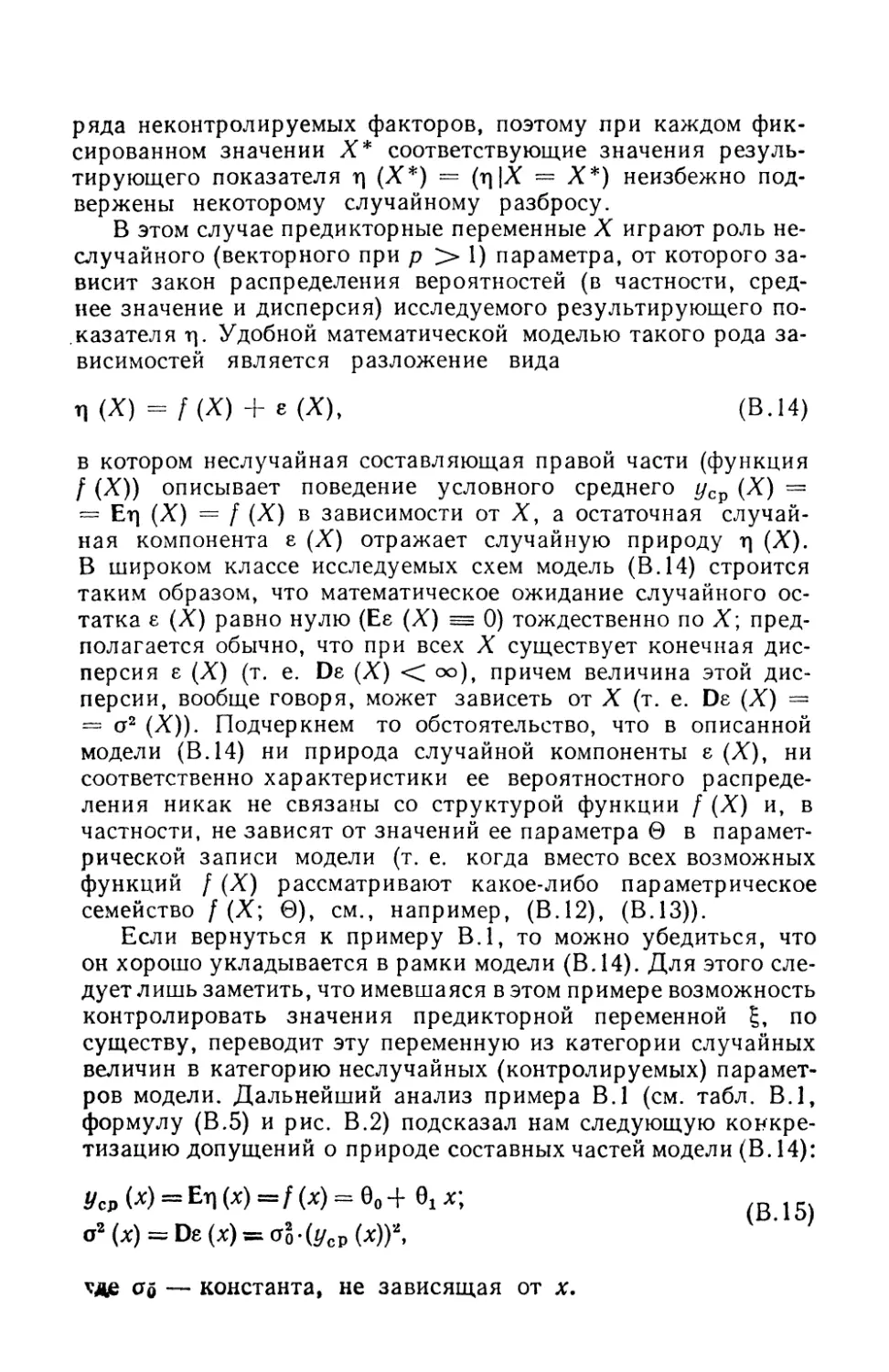

В этом случае предикторные переменные X играют роль не-

неслучайного (векторного при р > 1) параметра, от которого за-

зависит закон распределения вероятностей (в частности, сред-

среднее значение и дисперсия) исследуемого результирующего по-

показателя т]. Удобной математической моделью такого рода за-

зависимостей является разложение вида

ц(Х) = /(Х) + е(Х), (В. 14)

в котором неслучайная составляющая правой части (функция

/ (X)) описывает поведение условного среднего уСр (X) —

= Erj (X) = / (X) в зависимости от X, а остаточная случай-

случайная компонента 8 (X) отражает случайную природу rj (X).

В широком классе исследуемых схем модель (В. 14) строится

таким образом, что математическое ожидание случайного ос-

остатка е (X) равно нулю (Ее (X) = 0) тождественно по X; пред-

предполагается обычно, что при всех X существует конечная дис-

дисперсия е (X) (т. е. De (X) < оо), причем величина этой дис-

дисперсии, вообще говоря, может зависеть от X (т. е. De (X) =

= а2 (X)). Подчеркнем то обстоятельство, что в описанной

модели (В. 14) ни природа случайной компоненты е (X), ни

соответственно характеристики ее вероятностного распреде-

распределения никак не связаны со структурой функции / (X) и, в

частности, не зависят от значений ее параметра в в парамет-

параметрической записи модели (т. е. когда вместо всех возможных

функций / (X) рассматривают какое-либо параметрическое

семейство /(X; G), см., например, (В.12), (В.13)).

Если вернуться к примеру В.1, то можно убедиться, что

он хорошо укладывается в рамки модели (В. 14). Для этого сле-

следует л ишь заметить, что имевшаяся в этом примере возможность

контролировать значения предикторной переменной ?, по

существу, переводит эту переменную из категории случайных

величин в категорию неслучайных (контролируемых) парамет-

параметров модели. Дальнейший анализ примера В.1 (см. табл. В.1,

формулу (В.5) и рис. В.2) подсказал нам следующую конкре-

конкретизацию допущений о природе составных частей модели (В. 14):

Ус» (х) = Ел (*) = / (х) = 60 + Q, х\ j 5

— константа, не зависящая от х.

Пример В.2. В табл. В.4 и на рис. В.5 представлены

результаты усталостных испытаний алюминиевых сплавов

1125], т. е. набор сорока пар (xit t/i)y i = 1,2, ..., 40, экспери-

экспериментальных значений величин х и г\ соответственно.

Если при сборе выборочных данных, составляющих дву-

двумерную систему наблюдений, производится по нескольку на-

наблюдений при каждом фиксированном значении аргумента,

а также в случае разбиения диапазона переменной — аргу-

аргумента на интервалы группирования Л/А>), в общую схему обо-

обозначений двумерной системы наблю-

наблюдений (В.1) целесообразно внести

некоторые изменения.

Так, если к — число различных

фиксированных значений предиктор-

ной переменной (или количество ин-

интервалов группирования Д(^, на ко-

которые разбит весь обследованный диа-

диапазон этой переменной), а /л,- (/ = 1,

2, ..., к) — количество наблюдений,

произведенных при /-м фиксирован-

фиксированном значении аргумента (или количе-

количество наблюдений, попавших в /-и ин-

интервал разбиения Д(*-*), то результаты

наблюдений удобнее снабдить двумя

индексами, т. е. записать в виде (jcfy,

уи), где i ¦=; 1, 2, ..., ft, a /=* 1, 2,..,

mf. Здесь первый индекс (/) обозначает

порядковый номер фиксированного

значения независимой переменной

(или порядковый номер интервала

группирования), а второй индекс (/•)—

порядковый номер наблюдения, про-

произведенного приданном 1-мфиксированном значении аргумен-

аргумента (или порядковый номер наблюдения, попадающего в /-й ин-

интервал группирования). Так, например, под (x:ib, y:ib) пони-

понимается результат пятого по порядку наблюдения, произведен-

произведенного при третьем фиксированном значении аргумента (или по-

попадающего в третий интервал группирования Д^). В наших

рассмотрениях будут фигурировать также величины х°\у х\,

..., х°, представляющие собой последовательность различных

фиксированных значений аргумента, при которых производи-

производились наблюдения (или средние точки интервалов группирова-

группирования Д^), а также условные средние зависимой переменной

7 1

7,0

В, 5

6,0

5,0

5,0

Ь,5

•

t

|

-

i

1

•

•

•

i

•

1

•

г

1

1

•

1Л

1,5 X

Рис. В.5. Графиче-

Графическое представление

результатов устало-

усталостных испытаний

алюминиевых спла-

сплавов

37

I

1

2

3

4

i

1

2

3

4

1,28

1,30

1,40

1,48

6,85

6,52

5,52

4,73

mi

10

10

10

10

Уц

6,91

6,60

5,52

4,78

УЦ

6,34

5,95

5,23

4,55

У(8

6,91

6,62

5,53

4,78

G,34

6,04

5,27

4,65

у*

7,02

6,64

6,60

4,84

6,41

6,11

5,32

4,65

7,12

' 6,71

5,78

4,86

Табл

Уи

6,42

6,31

5,39

4,68

Уг

6,71

6,39

5,46

4,72

и да В.4

У'гь

6,80

6,36

5,40

4,72

0,091

0,076

0,020

0,009

= У> = [У и +yi2 +... + yim.Y

mi

характеризующие средние значения результирующего показа-

показателя при каждом фиксированном значении аргумента jc? (или

средние значения в каждом отдельном интервале группирова-

группирования Д(*;).

Очевидно, что в ситуациях, когда производится по несколь-

нескольку наблюдений при каждом фиксированном значении аргу-

аргумента, мы будем иметь

Л11 — Л12 — •'• — ^Irrti — Л1,

X2i = Х22 =-=... = Х2т2 = -^2 И Т. Д.

В качестве результирующего показателя — случайной пе-

переменной г] в нашем примере рассматривается характеристика

долговечности образца — нормированная величина лога-

логарифма числа циклов N до разрушения образца, а в качестве

неслучайной предикторной переменной х — логарифм со-

соответствующей величины эксплуатационного напряжения V,

Н/мм2 (кг/мм2). Очевидно, долговечность^ образца зависит

также от целого ряда неконтролируемых факторов (случайное

варьирование условий эксперимента, свойств самих образцов

и т. п.), поэтому при каждом уровне напряжения характери-

характеристики долговечности будут подвержены некоторому случайно-

случайному разбросу около своего среднего.

38

Расположение экспериментальных точек (xit у{) на рис. В.5

указывает на систематическую закономерность в поведении

условных средних yt =?- v уи в зависимости от номера /,

i j— I

т. е. от величины х\ их расположение близко к прямолинейно-

прямолинейному. Это приводит к гипотезе о целесообразности представле-

представления исследуемой случайной величины выражением (В. 15).

Первыми шагами исследователя может быть приближенная

оценка прямой уСр (х) — 0о -}- 02Л', а также меры случай-

случайного разброса индивидуальных значений г\ вокруг этой

прямой, характеризующейся в первом приближении только-