Text

Дж. Пирс

СИМВОЛЫ

СИГНАЛЫ

ШУМЫ

ЗАКОНО МЕРНОСТИ И ПРОЦЕССЫ

ПЕРЕДАЧИ ИНФОРМАЦИИ

Ϊ

КНИГА ПИРСА

ПРЕДНАЗНАЧЕНА ДЛЯ ВСЕХ, КОГО

ВОЛНУЮТ ПУТИ И СУДЬБЫ

НАУЧНЫХ ДОСТИЖЕНИЙ.

С ИНТЕРЕСОМ, А ВОЗМОЖНО,

II С ПОЛЬЗОЙ ЕЕ МОЖЕТ

ПРОЧЕСТЬ МАТЕМАТИК, ФИЗИК,

ХИМИК, БИОЛОГ. ВЕРОЯТНО,

II ЛИНГВИСТ. ПСИХОЛОГ,

МУЗЫКАНТ ИЛИ ХУДОЖНИК

ВЫЯСНЯТ, УДОВЛЕТВОРИТ ЛИ

ШЕННОНОВСНАЯ ТЕОРИЯ ПН·

ФОРМАЦИИ ИХ ЗАПРОСЫ.

ВОЗНИКАЮЩИЕ ПРИ

РЕШЕНИИ ТОЙ ИЛИ ИНОЙ

ИНФОРМАЦИОННОЙ ПРОБЛЕМЫ.

СПЕЦИАЛИСТ В ОБЛАСТИ ТЕ-

ЧГ1Ш И ТЕХНИКИ СВЯЗИ НЕ

ОТКАЖЕТ СЕБЕ В

УДОВОЛЬСТВИИ ПОСПОРИТЬ С УМНЫМ

И ЗАДИРИСТЫМ АВТОРОМ

а выяснить его точку

ЗРЕНИЯ НА НЕКОТОРЫЕ

ВОПРОСЫ.

ДАЖЕ ЛЮБОЗНАТЕЛЬНЫЕ

ШКОЛЬНИКИ СМОГУТ ВО

МНОГОМ РАЗОБРАТЬСЯ И

ПОЛУЧИТЬ БОЛЬШОЕ

УДОВОЛЬСТВИЕ ОТ ПРИОБЩЕНИЯ К

САМЫМ СОВРЕМЕННЫМ

НАУЧНЫМ ПРОБЛЕМАМ.

Дж-ITupc

СИМВОЛЫ

СИГНАЛЫ

ШУМЫ

ИЗДАТЕЛЬСТВО

«МИР»

J. JR. Pierce

SYMBOLS, SIGNALS and NOISE:

THE NATURE AND PROCESS

OF COMMUNICATION

HUTCHINSON OF L OND OJV

1962

Дою. Пирс

СИМВОЛЫ, СИГНАЛЫ, ШУМЫ

ЗАКОНОМЕРНОСТИ И ПРОЦЕССЫ

ПЕРЕДАЧИ ИНФОРМАЦИИ

ИЗДАТЕЛЬСТВО

«М И Р»

м осмва · 1967

УДК 519.92

Перевод с английского

Б. J5. ТОПЕЛЬБЕРГА

Под редакцией

д-ра техн. наук

Проф. Б. Я. МИТЯШЕВА

Редакция литературы по физике

Индекс 2-2-1

ПРЕДИСЛОВ ШЕ

РЕДАКТОРА

ПЕРЕВОДА

Перед вами научно-популярная книга, которая

рассказывает о возникновении, развитии, методах и

достижениях современной математической теории связи,

называемой еще теорией информации. Автор книги американский

ученый Джон Пирс хорошо известен в среде специалистов

по. его научным работам в области радиоэлектроники и ее

приложений. Вместе с тем он зарекомендовал себя и как

талантливый популяризатор науки. В 1961 году в

русском переводе появилась его книга «Электроны, волны

и сообщения» (Физматгиз, М., 1961), встреченная нашими

читателями с большим интересом, а сейчас готовится

перевод его новой книги «Квантовая электроника» (изд-во

«Мир»). Научно-популярные книги Джона Пирса

обладают тем блеском, который придает хорошее знание

предмета, не покидающее автора чувство юмора и присущее

ему педагогическое мастерство.

Книга «Символы, сигналы, шумы»— дань научному

нодвигу Клода Шеннона, сформулировавшего в 1948 году

основы математической теории связи в достаточно общем

виде и.получившего первые в этой областц фундаменталь-

5

ные результаты. К этому времени электрическая и

радиосвязь глубоко проникли в нашу жизнь. Ученые и

инженеры активно и настойчиво разрабатывали все более

эффективные и надежные средства связи, и перед ними

возникали технические и теоретические проблемы,

которые долгое время не находили разрешения. Но чтобы

оценить достигнутое и найти пути совершенствования,

требовался достаточно широкий и общий подход к проблеме.

Джон Пирс начал свою научную деятельность именно

в области техники связи, и весь процесс становления

математической теории связи происходил у него на глазах

и при его непосредственном участии. Трудности четкой

формулировки и решения проблемы так велики, а

найденный Шенноном путь столь эффектен и столь много обещает,

что автор не перестает восхищаться достигнутым. Это

восхищение он стремится передать и читателю.

Современная теория связи обладает общностью,

присущей любой математической теории. Это отразилось

в ее другом названии — теория информации. Как

математическая теория, теория информации приобрела и

самостоятельное значение, независимое от техники связи.

Однако термину «информация» в этой теории придается

конкретное содержание, допускающее введение

количественной меры. Именно поэтому основной областью

приложений результатов теории остается техника связи.

Далеко не все, что может быть связано со словом

информация, подвластно шенноновской теории. Недооценка

или непонимание этого обстоятельства привели к излишне

эмоциональному приему новой теории при ее появлении.

Все мы в чем-то информированы и передаем эту

информацию другим, и нам очень приятно сознавать, что на этот

счет есть теория. Когда же возлагаемые на теорию

надежды в большинстве не сбылись, она подверглась

поспешной и столь же незаслуженной критике. Автор книги

прилагает немало усилий, чтобы читатель оценил теорию

информации по достоинству такой, какова она есть, понял

б

бы ее основы, методы, достижения и возможности. Он

излагает и свою точку зрения на возможности

приложений теории в таких областях, как лингвистика,

психология и искусство. Здесь теория информации предстает

в добротном изложении, эффективно освобождающем

от иллюзий.

Книга написана в свойственной Джону Пирсу манере.

Это математическая теория связи в популярном

изложении, а не только разговоры о ней. Для чтения специальных

знаний в области техники связи не требуется, необходимо

лишь настойчивое желание понять и разобраться.

Предполагается, что читатель имеет необходимое образование,

но при этом имеется в виду, что то, чему учат в школе,

легко забывается. Автор беседует с читателем, заставляя

его думать, возражать и, наконец, логически приходить

к основным утверждениям теории. Делается это мягко,

но настойчиво. Порой автор тащит читателя почти

насильно, но затем читатель у^ке сам прочитывает увлеченно

страницу за страницей, которые будят любопытство и

манят неизведанным. Не нужно удивляться наличию

повторений. Благодаря им нужный материал всегда под рукой,

а отдельные главы приобретают известную

самостоятельность.

Книга предназначена для всех, кого волнуют пути

и судьбы научных достижений. С интересом, а возможно,

и с пользой ее может прочесть математик, физик, химик,

биолог. Вероятно, и лингвист, и психолог, и музыкант или

художник выяснят, удовлетворит ли шенноновская теория

информации их запросам, возникающим при решении той

или иной информационной проблемы. Специалист в

области теории и техники связи не откажет себе в удовольствии

поспорить с умным и задиристым автором и выяснить

его точку зрения на некоторые вопросы. Даже

любознательные школьники смогут во многом разобраться и

получить большое удовольствие от приобщения к самым

современным научным проблемам.

7

Еще в рукописи книгу читали многие крупные

специалисты по теории информации, в том числе и ее

основоположник Клод Шеннон. Автор получил множество

советов и замечаний, выслушал критику и возражения. Многое

он учел и принял, и, однако, книга сохранила цельность

и оригинальность. Некоторые высказывания и

рассуждения автора и у наших читателей могут вызвать желание

поспорить, возразить и не согласиться. Этому

способствует полемический, критичный стиль самого автора, так

захватывающий читателя, что настороженность и

здоровые сомнения становятся привычными, и ему уже не

составит труда не принимать на веру безоговорочно все

утверждения автора, а составить собственное мнение.

Профессор Б. Митяшев

ОТ АВТОРА

Предложение Джеймса Ньюмена написать книгу

о математической теории связи меня очень обрадовало.

Ведь все мои научные работы возникли под влиянием

того или иного аспекта проблемы связи, и мне,

естественно, хотелось поделиться тем, что на мой взгляд интересно,

а что и спорно в этой важной области науки.

Такую книгу вряд ли можно было бы написать, не

появись в 1948 году работа Шеннона «Математическая

теория связи». Многие проблемы связи, годами

волновавшие инженеров, нашли в ней свое логическое

завершение. На базе этой теории, которую называют еще теорией

информации, на месте многих разрозненных проблем

и идей, взаимозависимость которых не была как следует

осмыслена, возникла широкая, но четко определенная

область. И мне хочется здесь отдать Шеннону должное.

Мне кажется, что излагать математическую теорию

связи следует именно в том виде, как ее формулирует

Шеннон. Наш рассказ о теории информации должен быть

шире, чем у Шеннона, в том смысле, что мы здесь должны

поговорить о правильном ж неправильном применении

9

этой теории в различных областях науки и техники,

но в отличие от Шеннона мы должны меньше использовать

математику.

Вот тут нас и подстерегает трудность. Меньше

математики — это можно, а вот совсем исключить математику

нельзя. Ведь теория информации — теория

математическая. Опираясь на несколько основных положений,

которые определяют, с чем она будет иметь дело, теория делает

дальнейшие логические выводы. В математических

теоремах, одновременно удивительных и важных, и

заключается вся прелесть теории информации. Говорить же

о ней, не раскрывая ее истинного математического

содержания,— все равно, что бесконечно долго рассказывать

о замечательном композиторе, не дав ни разу послушать

звуков его творений.

Как же мне следовало поступить? Мне казалось, что

книгу нужно сделать самостоятельной, т. е. такой, чтобы

математические рассуждения в ней можно было понять,

не прибегая к другим книгам и не создавая особого

раздела, в котором были бы изложены некоторые разделы

элементарной математики, скажем алгебра. Означало ли это,

что я должен был вообще избегать математических объдо.-

нений? Не обязательно, но любые математические

выражения нужно было объяснить наиболее понятным способом.

Я попытался сделать это и в тексте, и в приложении.

Пользуясь и текстом книги, и приложением, даже не

очень подготовленный читатель сможет преодолеть

основные трудности. Но какую степень трудности

математических доказательств можно допустить? Я решил,

сознательно идя на то, что будут упущены некоторые очень

важные моменты, придерживаться изложения более

легкого по сравнению, скажем, с наиболее трудными местами

книги Ньюмена «Мир математики». В очень трудных

местах я просто указывал основные свойства

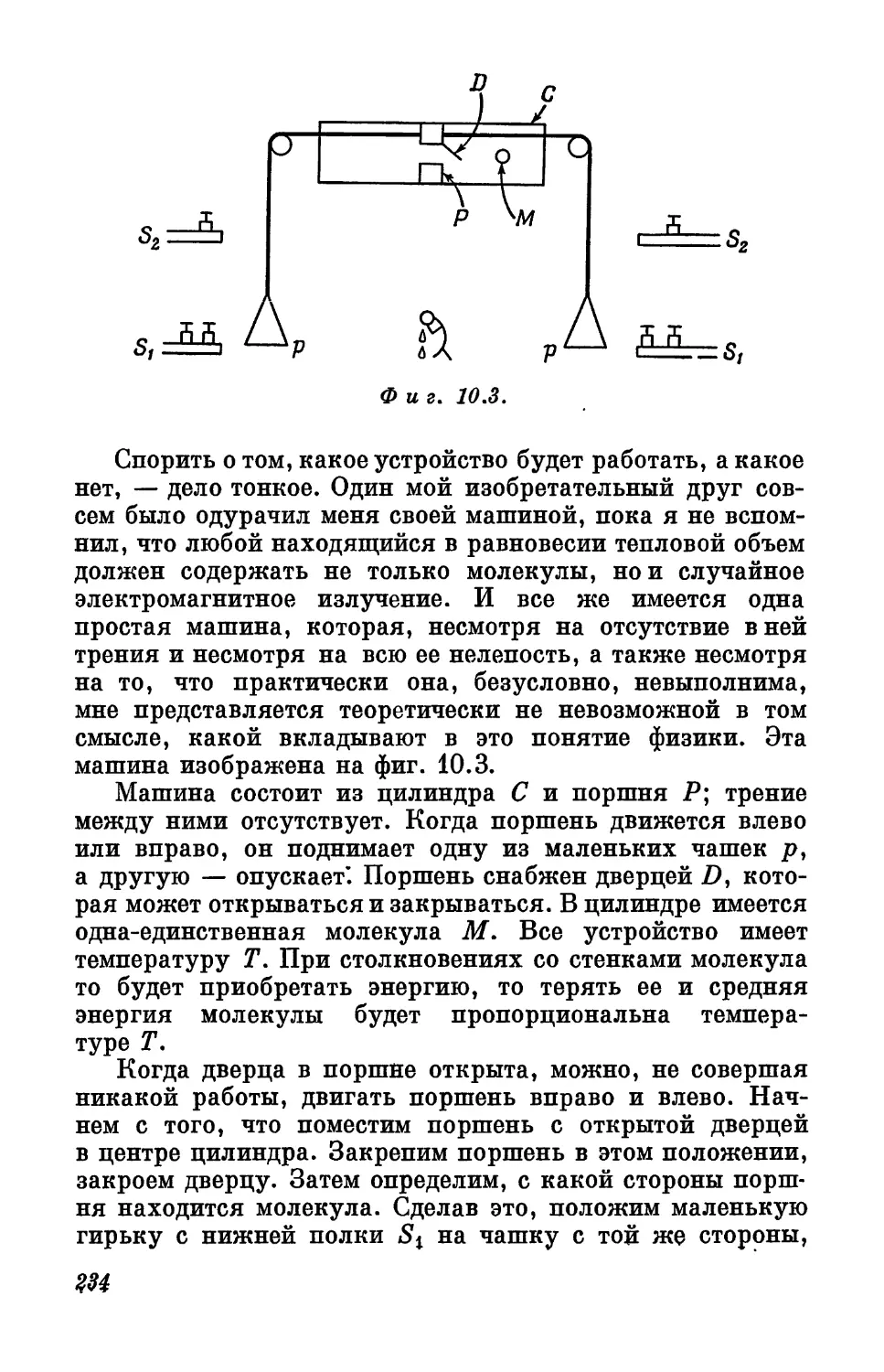

используемого математического выражения и не вдавался в его

сущность.

10

И все же эта книга содержит разделы, трудные для

читателя, плохо знающего математику. Таким читателям

я советую просто бегло проглядеть эти разделы,

попытавшись уловить все, что удастся. А потом, прочтя всю

книгу, читатель сам поймет, зачем понадобилось

включать в книгу эти трудные разделы. И тогда, если он

захочет, он сможет вернуться к ним снова, чтобы теперь уже

по-настоящему понять их. Но если бы я не включил эти

трудные разделы в книгу, а читатель захотел бы понять,

откуда все получается, он был бы поставлен в тупик.

Насколько мне известно, другие книги по

математической теории связи либо слишком примитивны, либо

слишком трудны. Я мог бы также заметить, что отдельные

вопросы в них изложены нечетко, а некоторые и просто

неверно.

Продолжая в том же духе, я, вероятно, вызову

справедливый вопрос: да стоит ли вообще теория

информации стольких хлопот? Я могу только ответить, что в той

же степени, в какой важен весь мир науки и техники,

важна и эта теория, так как она составляет значительную

часть этого мира. От того, что именно любознательный

читатель захочет узнать об этом мире и о теории

информации, зависит, стоит ли она того времени, которое

потребуется затратить, чтобы получить какое-то представление

о ней. В результате математическая теория связи должна

предстать перед читателем не чем-то совершенно чуждым

и недоступным пониманию, но и не слишком упрощенным,

о чем можно рассказать без труда в нескольких словах.

Написать эту книгу было нелегким делом. Она,

конечно, никогда не увидела бы свет, если бы не работа Клода

Шеннона, который не только вдохновил меня на этот

труд, но прочел рукопись и порекомендовал сделать

несколько существенных изменений. Давид Слепян еще

более энергично вытряхнул из меня привычку ошибаться

и путаться. Е. Гильберт предостерег от ошибок в

некоторых примерах, а Милтон Баббит внес успокоение в мою

11

душу относительно содержания главы «Теория

информации и искусство». П. Бриккер, Г. Дженкинс и Р. Шепард

консультировали меня в области психологии, однако

ту точку зрения, которую я в конце концов принял,

приписывать им ни в коем случае не следует. М. Мэтьюз

составил программу для вычислительной машины в

главе 11. Б. Манделброт помог мне в работе над главой 12.

Дж. Руньон внимательно прочел рукопись, а Э. Уолмен

обнаружил ужасное количество ошибок в тексте и внес

много ценных предложений. Читатель обязан Джеймсу

Ньюмену тем, что я смог дать некоторые выводы в конце

отдельных, глав, а также тем, что хоть напоследок

я сделал попытку немного яснее изложить некоторые

трудные места. Но, кроме всего, я чрезвычайно обязан

Ф. Кастелло, которая сумела выйти с честью из того

хаоса, который царил в период подготовки рукописи

и обработки рисунков.

Глава первая

МИР

и

ТЕОРИЯ

В 1948 году Клод Шеннон опубликовал статью под

названием «Математическая теория связи»; в 1949 году

она появилась уже в виде книги. До этого отдельные

ученые время от времени пытались создать

математическую теорию связи. А сейчас, двенадцать лет спустя, эта

теория, или теория информации, как ее иногда

называют, -является признанной областью исследования.

По математической теории связи опубликовано довольно

много книг и проведено несколько международных

симпозиумов и конференций. Институт радиоинженеров

13

имеет в своем составе группу специалистов по теории

информации, чьи ученые «Труды» (Transactions)

появляются ежеквартально, а журнал «Information and Control»

посвящен главным образом математической теории связи.

Все мы говорим слова «связь» и «информация» и едва ли

недооцениваем их значение. Современный философ А. Айер

толкует о большом значении и важности связи в нашей

жизни. По его словам, мы передаем не только

информацию, но и «знания, ошибки, мнения, идеи, опыт,

желания, приказы, эмоции, чувства, настроения. Можно

передать тепло и движение, а также силу, слабость

и болезнь». Он приводит и другие примеры и

рассуждает о разнообразных проявлениях и загадочных

свойствах связей в человеческом обществе.

Поскольку связь так разнообразна и важна,

правильная и полезная теория связи, естественно,

чрезвычайно ценна для нас.

Если же мы к слову теория добавим слово

математическая со всем его строгим и магическим смыслом, то

теория становится почти неотразимо привлекательной. Быть

может, всего несколько формул помогут решить все наши

проблемы связи и мы из рабов дезинформации станем

хозяевами информации. К сожалению, наука идет иным

путем. Около 2300 лет назад другой философ, Аристотель,

попытался в своей «Физике» дать определение движению,

понятию столь же универсальному, как и связь.

Аристотель определил движение как осуществление

(поскольку оно потенциально существует) того, что

потенциально существует. Он включил в понятие

движения увеличение и уменьшение того, что может быть

увеличено или уменьшено, что может возникнуть и

исчезнуть и может быть создано. Он говорил о трех

категориях движения: о величине, воздействии и месте. По его

словам, он нашел столько типов движения, сколько

имеется значений слова «быть».

Здесь мы видим движение во всем многообразии.

Возможно, это многообразие нас несколько смущает,

так как на разных языках связь слов различна, и мы

не обязательно свяжем движение со всеми изменениями,

о которых говорил Аристотель.

Однако какой же загадочной была, наверно, для

последователей Аристотеля сущность движения! Она

оставалась загадкой свыше двух тысячелетий, пока Ньютон

14

Не провозгласил закойы, йа основе которых до сих пор

инженеры конструируют машины, а астрономы изучают

движения звезд, планет и спутников. Правда, позднее

физики обнаружили, что законы Ньютона — это частный

случай более общих законов и что применимы они только

при скоростях, много меньших скорости света, и при

масштабах явлений, намного больших масштабов

явлений в атоме. И все же законы Ньютона —живая часть

нашей физики, а не памятник истории. И поскольку

движение — важная часть нашего мира, мы, конечно,

должны знать законы движения Ньютона. Вот они:

1. Тело продолжает оставаться в покое или двигаться

с постоянной скоростью по прямой линии до тех пор, пока

на него не подействует сила.

2. Изменение скорости тела происходит в направлении

действия силы, а величина изменения пропорциональна

силе, действующей на тело, умноженной на время, в

течение которого действует сила, и обратно пропорциональна

массе тела.

3. Всякий раз, когда первое тело прикладывает силу

ко второму телу, второе тело прикладывает равную и

противоположно направленную силу к первому телу.

К этим законам Ньютон добавил всемирный закон

тяготения:

4. Две частицы вещества притягивают друг друга

с силой, действующей по линии соединения, причем эта

сила пропорциональна произведению масс частиц и

обратно пропорциональна квадрату расстояния между ними.

Законы Ньютона произвели революцию в науке

и в философии. Используя их, Лаплас показал, что

Солнечная система представляет собой вполне объяснимый

механизм. Они послужили основой самолетостроения

и ракетостроения и такой науки, как астрономия. Но этих

законов оказалось недостаточно, чтобы ответить на многие

вопросы, связанные с понятием движения, которые

рассматривал Аристотель. Законы Ньютона решили проблему

движения в его формулировке, но не движения во всех

15

значениях, какие могли быть приданы этому слову в

Греции в IV столетии до нашей эры или в Англии спустя

двадцать столетий.

Наша речь приспособлена к нашим повседневным

нуждам, а быть может, к понятиям наших предков. Мы

не можем для каждого отдельного · предмета и каждого

отдельного понятия иметь разные слова. Если бы это

было возможно, мы накопили бы такое количество слов,

что общение между людьми стало бы немыслимым!

Чтобы возник язык вообще, необходимо, чтобы многие

вещи или многие явления назывались одним словом.

Вполне естественно говорить, что человек и лошадь

бегут (хотя мы предпочтем, пожалуй, сказать, что лошадь

скачет), бегут часы, бегут мысли, бежит ручей.

Сходство этих выражений обусловлено особенностями

нашего языка, а не сходством физических явлений,

которые этими выражениями описываются. Абсурдно было бы

искать некую простую, стройную и одновременно

полезную научную теорию бега, охватывающую и бег времени,

и бег мыслей. И, конечно, не менее абсурдной выглядела

бы попытка охватить одной теорией все виды движения,

рассмотренные Аристотелем, или все виды связи и

информации* открытые впоследствии учеными.

В повседневной речи мы употребляем слова так, как

нам это удобно. Науку, за исключением лингвистики,

не интересуют слова сами по себе и их взаимосвязь. Она

занимается более реальными вещами, например

исследованием человека и его деятельности, которые можно

объединить и понять. Такое понимание заключается в

способности видеть общую закономерность в сложных и, на

первый взгляд, различных явлениях (скажем, движение

планет и движение скользящего по льду фигуриста), а затем

описать их как можно проще и точнее.

Слова, используемые в таких научных описаниях, как

правило, берутся из повседневного словаря. Так, Ньютон

использовал слова: сила, масса, скорость и притяжение.

Но эти слова в науке приобрели особый, более узкий,

а часто даже новый смысл. Нельзя применять законы

Ньютона, рассуждая о силе обстоятельств, массе способов,

притягательной силе Бриджит Бардо. Точно так же слова

«связь» и «информация» можно говорить в разных случаях,

но это отнюдь не значит, что везде, где встречаются эти

слова, можно пользоваться математической теорией связи.

16

Правильная научная теория редко, если вообще это

бывает когда-нибудь, предлагает решение насущных

проблем. Почти не бывает, чтоб она давала ответы на все

наши многочисленные вопросы. Теория, как правило,

не обосновывает наши идеи и предположения, а обычно

полностью от них отказывается или, в лучшем случае,

оставляет их такими, какие они есть. Теория обычно

предлагает какой-либо новый и оригинальный способ

обобщения нашего опыта и указывает, какие выводы можно

из него сделать. Именно с этой точки зрения в этой книге

рассматривается математическая теория связи.

Когда из нашего опыта выделено то, что можно

обобщить, и когда это обобщение выполнено и сделаны

соответствующие выводы, только тогда мы имеем теорию

какого-либо вопроса. Так, на законах движения Ньютона

строится важная область теоретической физики,

называемая механикой. Сами законы — это еще не теория,

они составляют лишь ее основу, подобно тому как

аксиомы, или постулаты, составляют основу геометрии. В

теории содержатся не только предположения, но и

математическая обработка логических выводов, которые

необходимо следуют из этих предположений. Если теория

верна, то ее выводы, разумеется, должны правильно

отражать сложные явления природы, если же она неверна,

то ее выводы бесполезны.

Идеи и предположения определяют общность теории,

т. е. определяют, насколько широк круг явлений, к

которым она применима. Так, законы Ньютона, например,

имеют самый общий характер — они объясняют

движение планет, свойства маятника, поведение любых

механизмов и машин. Однако свойства радиоволн они не

объясняют.

Уравнения Максвелла * имеют самый общий

характер — они объясняют все (неквантовые) электрические

* В 1873 году Джеймс Клерк Максвелл впервые в своем труде

«Электричество и магнетизм» изложил и полностью объяснил

законы природы, связывающие электрическое поле, магнитное .поле

и электрический ток. Он показал, что должны существовать

электромагнитные волны (радиоволны), скорость распространения

которых равна скорости света. Позднее Герц обнаружил эти волны

экспериментально, а сейчас известно, что свет представляет собой

тоже электромагнитные волны. Уравнения Максвелла — это

математическая формулировка его теории электричества и магнетизма

и основа всей науки об электричестве.

17

явления. Одна из ветвей электротехники, называемая

теория цепей, занимается исследованием свойств

электрических цепей, состоящих из идеализированных

элементов трех видов: сопротивлений (устройств в виде катушек,

намотанных тонким плохо проводящим проводом, или

металлических или углеродных пленок, препятствующих

прохождению электрического тока), катушек

индуктивности (катушек, намотанных медным проводом, иногда

с сердечником из магнитного материала) и конденсаторов

(тонких металлических листиков, разделенных

диэлектриком — слюдой или пластмассой; первым конденсатором

была лейденская банка). Поскольку теория цепей

описывает лишь электрические свойства цепей, состоящих

из нескольких идеализированных элементов, то физики

считают, что она имеет менее общий характер, чем

уравнения Максвелла, которые охватывают электрические

свойства любых физических элементов и даже свойства

радиоволн.

~ Конечно, чем более общий характер имеет теория,

объясняющая широкий круг явлений, тем она сильнее

и лучше. Более общую теорию всегда можно применить

для исследования простых случаев. Вот почему физики

искали единую теорию поля, которая охватила бы и

законы механики, и законы гравитации, и все электрические

явления. На первый взгляд кажется, что все теории можно

расположить в порядке общности, по возможности

установив то место, которое занимает математическая теория

связи.

К сожалению, все не так-то просто. С одной стороны,

теория цепей имеет менее общий характер, чем

уравнения Максвелла, а с другой — более общий характер,

так как все математические выводы теории цепей

справедливы и для колебательных систем, составленных

из механических элементов, и для колебательных систем,

составленных из идеализированных электрических

элементов. Если применить теорию цепей к механике^ то

пружина будет соответствовать конденсатору, масса —

индуктивности, а амортизатор, или демпфер (какой

ставят на дверь, чтобы она не хлопала),— сопротивлению.

Теорию цепей можно было бы применить для объяснения

свойств механических систем, именно так она и

используется в акустике. Тот факт, что теория цепей появилась

в результате изучения идеализированных электрических

18

систем, скорее просто историческая случайность, а не

неизбежность.

Поскольку все математические результаты теории

цепей применимы как к механическим, так и к

электрическим идеализированным системам, то мы можем сказать,

что теория цепей в некотором смысле является более общей,

чем уравнения Максвелла, совсем неприменимые к

механическим системам. Но, с другой стороны, уравнения

Максвелла являются более общими, чем теория цепей,

так как они применимы ко всем электрическим системам,

а не только к определенному классу идеализированных

электрических цепей.

Полностью объяснить этот факт не представляется

возможным, поэтому придется просто допустить, что это

так. Все же мы попытаемся разобраться в этом

противоречии. Одни теории — чисто физические теории. К ним

относятся законы Ньютона и уравнения Максвелла.

Законы Ньютона имеют дело с явлениями механическими,

а уравнения Максвелла — с электрическими. Теория

цепей — чисто математическая теория. Использованные

в ней выражения могут иметь самый разнообразный

физический смысл. Эта теория может сказать много

интересного о различных физических явлениях, как

о механических, так и об электрических колебаниях.

Часто математическая теория представляет собой

лишь ветвь одной или нескольких физических теорий.

Она может быть изящным математическим изложением

некоторых вопросов какой-либо общей физической

теории. Именно таким изложением некоторых физических

свойств, общих и для механических, и для

электрических устройств, является теория цепей. В одном

из разделов математики — теории потенциала —

рассматриваются вопросы, одинаково важные для

исследования и электрических полей, и магнитных полей, и полей

тяготения, и даже, в известной степени, для аэродинамики.

Но не все математические теории берут свое начало

в физике. Есть теории, математические уже по своему

происхождению. При изучении материального мира мы

часто пользуемся такими теориями. Одной из них

является арифметика. Пусть имеется группа любых предметов

или объектов — яблок, собак или людей. Припишем

каждому предмету определенное число: одному —

единицу, другому — 2 и т. д. Если окажется, что первых

19

16 чисел достаточно для обозначения всех предметов

группы, то можно с уверенностью сказать, что эту группу

можно разделить на две равные части по 8 предметов

(ибо 16 : 2 = 8) и что эти предметы можно расположить

в виде квадрата — 4 ряда по 4 предмета (16 = 4 X 4).

Далее, если расположить предметы в один ряд,

то число способов, которыми это можно сделать,

будет равно 2 092 278 988 800, что соответствует

2 092 278 988 800 различным возможным

последовательностям целых чисел от 1 до 16. Если бы предметов

оказалось не 16, а 13, то нашу группу, очевидно, нельзя

было бы разделить ни на какое число равных групп,

так как 13 — число простое, и его нельзя представить

в виде произведения сомножителей. Может показаться,

что эти результаты совсем не зависят от свойств предметов.

Поскольку числами можно обозначать любые предметы,

постольку будут верны результаты сложения, вычитания,

умножения, деления чисел, а также результаты,

получаемые при расположении чисел в различной

последовательности. Связь между числами и предметами кажется

нам такой естественной, что мы легко можем упустить

из виду, что сама арифметика — теория математическая,

и ее, как и всякую математическую теорию, можно

применять лишь тогда, когда свойства чисел соответствуют

свойствам материального мира.

^Физики говорят, что можно сосчитать общее

количество элементарных частиц, например электронов, но

нельзя каждой частице приписать определенный номер,

так как частицы эти неразличимы в буквальном смысле.

Поэтому нельзя говорить и о расположении частиц в

различном порядке, тогда как с числами вполне можно это

сделать. Этот вывод очень важен для одной из областей

физики, называемой статистической механикой. Заметим

еще, что другая математическая теория, геометрия

Евклида, прекрасно служит топографам и

мореплавателям, но есть все основания полагать, что геометрия

Евклида не совсем точна, когда дело касается астрономических

явлений.

По каким же признакам можно классифицировать

теории? Теория может быть узкой или общей для той

области, где она используется. Теория еще может быть

строго физической или строго математической. Строго

физическая теория очень полно описывает некоторый

20

ограниченный круг физических явлений. Теория

становится более математической, или абстрактной, когда

она имеет дело с идеализированным классом явлений

или только с какой-то одной стороной явления. Законы

Ньютона — строго физические законы, так как с их

помощью можно полностью описать такие механические

явления, как движение планет и свойства маятника.

Теория цепей — более математическая теория, так как она

полезна при исследовании самых разнообразных

идеализированных физических явлений. Арифметика — сугубо

математическая и абстрактная наука. Она одинаково

управляется с одним общим свойством многих физических

объектов — наличием числового значения; для нее все

равно, какие объекты обладают этим свойством — собаки,

люди или электроны (вспомним, что электроны

неразличимы). Арифметика полезна даже при составлении

календарей.

Пользуясь нашими определениями, теорию

информации можно назвать теорией математической и общей.

Хотя эта теория возникла из изучения электрической

связи, она решает проблемы методами общими и

абстрактными. Пользуясь понятиями «выбор» и

«неопределенность», эта теория вводит универсальную единицу

измерения информации — бит. Один бит информации

получается в результате осуществления одной из двух

равновероятных возможностей, причем под этими

возможностями могут пониматься передаваемые сообщения или числа.

Теория информации и говорит нам, сколько битов

информации можно передать в секунду по идеальному и

неидеальному каналу связи в зависимости от их свойств. Теория

информации говорит, как измерить скорость, какой

источник сообщений, например говорящий или пишущий

человек, создает информацию. Она говорит, как лучше

представить, или как эффективнее закодировать,

сообщения от данного источника для передачи по данному

каналу, например по электрической цепи, а также

говорит нам, когда можно избежать ошибок при передаче.

Теория информации исследует вопросы в очень общем

и абстрактном виде, поэтому часто бывает трудно

использовать знания, которые она дает для решения конкретных

практических задач. Но именно благодаря абстрактной

математической форме эта теория имеет широкую область

примецения. Оца полезна в лингвистике, при изучении

91

электрической и механической передачи сообщений,

работы машин и, быть может, поведения людей. Кое-кто

из читателей, наверно, догадывается, что она очень важна

и для физики. Об этом мы поговорим попозже.

Но теория информации в том виде, в каком ее дал

Шеннон, в основном — математическая теория.

Основные положения ее формулируются на языке математики

и могут иметь самый различный физический смысл.

Пользоваться теорией информации могут и инженеры, и

психологи, и физики, однако она остается теорией

математической, а не физической, психологической или

инженерной.

Нелегко донести математическую теорию до широкой

публики. Поскольку теория информации есть теория

математическая, то было бы смешно утверждать, что о ней

можно рассказать, полностью избежав математики. Но

пусть наш читатель не пугается формул и уравнений, они

точно отображают те идеи, которые описываются и

словами. Чтобы помочь незнакомому с математикой

читателю правильно понять уравнения, я включил в книгу

приложение, в котором даны все математические

обозначения.

Я отдаю себе отчет в том, что часто со словом

«математика» в памяти всплывают малоприятные картины

умножения, деления, извлечения корней и наиболее горькие

минуты учебы в школе. Но такое представление о

математике — заблуждение, ибо главное в ней не разные

трюки и манипуляции с формулами, а теоремы и

доказательства. Возможно, читатель сталкивался с теоремами

π доказательствами в геометрии, а может, и совсем их

не встречал; как бы то ни было, самое важное и в чистой

математике, и в прикладной — это теоремы и

доказательства. И в теории информации важные выводы тоже

изложены в виде математических теорем, и это действительно

теоремы, ибо можно доказать их правильность.

Математики начинают с того, что вводят определение

и делают некоторые допущения, а затем с помощью

математических рассуждений или доказательств показывают

справедливость некоторых положений или теорем.

Именно так поступил Шеннон в своей работе «Математическая

теория связи». Правильность теоремы зависит от

обоснованности сделанных предположений и от строгости

рассуждений при ее доказательстве.

22

Фиг. 1.1.

Все это довольно отвлеченно. Сущность теоремы

и доказательства лучше всего, конечно,

продемонстрировать на примере. Но не могу же я требовать от

неискушенного читателя, чтобы он взял на абордаж трудные

теоремы теории информации и притом вникал во все

подробности. Чтобы действительно донять доказательства

таких теорем, даже для тех, кто имеет некоторую

математическую подготовку, потребуется немало времени

и сосредоточедного внимания. В лучшем случае мы только

можем попытаться уловить смысл и значение этих

теорем.

Я хочу здесь привести несколько примеров более

простых математических теорем и их доказательств.

Первый пример — игра, которая называется еекс.

Теорема, которую мы докажем, заключается в том, что игрок,

делающий первый ход, может выиграть.

В гекс играют на доске, состоящей, скажем, из 49

шестиугольных клеток (фиг. 1.1); на них можно ставить

фишки. Один из игроков играет черными фишками и

старается разместить их так, чтобы создать путь между

черными полями слева и справа, причем путь может быть

какой угодно извилистый. Другой игрок играет белыми

фишками и в свою очередь старается создать такой же

путь, но из белых фишек и между белыми полями сверху

и снизу. Ходы делаются игроками поочередно, и за один

ход разрешается доставить одну фишку. Конечно, один

23

из игроков должен начинать. Будем называть его первым

игроком.

Чтобы доказать, что первый игрок может выиграть,

покажем сначала, что игра обязательно закончится

победой одного из игроков.

Теорема I. Один из игроков обязательно выигрывает.

Рассуждение. В некоторых играх, скажем

в шахматы или в крестики-нолики, может случиться, что

никто не победит, т. е. игра закончится вничью. В других

играх, например в орлянку, один из игроков обязательно

выигрывает. Доказательство нашей теоремы будет состоять

в том, чтобы показать, что если каждая клетка доски

занята черной или белой фишкой, то должен быть

непрерывный путь из черных фишек между черными полями

или из белых фишек между белыми полями, причем

в первом случае не будет существовать никакого пути

из белых фишек между белыми полями, а во втором —

лз черных фишек между черными полями, т. е. должны

выиграть либо белые, либо черные.

Доказательство. Предположим, что каждая

клетка заполнена черной (на рисунке они соответственно

зачернены) или белой фишкой. Начнем от левого верхнего

угла доски (точка / на фиг. 1.2) и проследим границу

между белыми и черными шестиугольниками. Будем

двигаться так, чтобы черные были справа, а белые — слева.

Φ и е. 1.2.

24

""··.·»

Фиг. 1.3.

Проведенная таким образом граница будет менять

направление либо в углах на краю доски, либо в вершинах,

в которых сходятся стороны шестиугольников. И в том,

и в другом случае граница может менять направление

только двумя способами (фиг. 1.3). Либо справа будут

два черных шестиугольника, а слева один белый

(фиг. 1.3, а), либо слева будут два белых

шестиугольника, а справа один черный (фиг. 1.3, б). Отметим, что

в любом случае будет непрерывный черный путь справа

от границы и непрерывный белый путь слева от границы.

Отметим также, что ни в одном случае не может быть

самопересечения или слияния границы, так как через

вершину можно пройти только в одном направлении,

чтобы черное было справа, а белое — слева. Легко видеть,

что все сказанное относится и к границе между черными

полями и белыми шестиугольниками, и к границе

между белыми полями и черными шестиугольниками,

и к границе между черными и белыми

шестиугольниками. Таким образом, слева от границы должен

быть непрерывный путь из белых шестиугольников к

верхнему белому полю, а справа от границы — непрерывный

путь из черных шестиугольников к левому черному

полю. Граница не может иметь самопересечений,

следовательно, она не может кружить бесконечно, а в конце

концов достигнет либо черного, либо белого поля. Если

граница достигнет черного или белого поля и в соответствии

с нашим условием черное будет справа, а белое —- слева,

то в любом месте, за исключением точки // или точки ///,

границу можно продолжить, причем черное будет справа,

а белое — слева. Следовательно, граница достигнет либо

точки //, лдбо точки /77. Если граница достигнет точки //

U

(см. фиг. 1.2), то черные шестиугольники справа от

границы, соединенные с левым черным полем, соединятся

и с правым черным полем, а белые шестиугольники,

находящиеся слева от границы, соединятся только с верхним

белым полем, и черные выиграют. Невозможно, чтобы

победили одновременно и белые, так как непрерывная

цепь соприкасающихся черных фишек от левого поля

к правому помешает создать непрерывный путь из белых

фишек от верхнего поля до нижнего. Рассуждая так же,

легко видеть, что если граница достигнет точки ///, то

выиграют белые.

Теорема И. Игрок, делающий первый ход, может

выиграть.

Рассуждение. Слово может означает, что

существует способ выиграть, при условии, конечно, что

игрок сообразит, как это сделать. Способ выиграть

состоит в том, что нужно сделать определенный первый ход

(вполне возможно, по-видимому, сделать и иной первый

ход, но знать их все совершенно необязательно) и иметь

какую-то схему, формулу, инструкцию или рецепт

(называйте, как хотите), дающие возможность ответить

правильным ходом на ход противника на любом этапе игры. Если

первый игрок будет следовать этому рецепту, то он

выиграет независимо от того, какие ходы будет делать

противник.

Доказательство. Либо должен существовать

такой метод игры, следуя которому первый игрок

обязательно выиграет, либо независимо от того, как играет

первый игрок, его противник всегда может найти ход,

который не даст первому выиграть, т. е. выиграет второй

игрок. Предположим, что второй игрок действительно

имеет надежный рецепт для победы. Пусть первый игрок

сделает любой первый ход, а затем после первого хода его

противника применит рецепт, по предположению,

позволяющий второму игроку победить. Если первому игроку

на каком-то ходу потребуется поставить фишку на уже

занятую ранее клетку, пусть он поместит ее на любое

незанятое место. Так или иначе нужная клетка будет

занята. Таким образом, первый игрок имеет на доске

лишнюю фишку, ему она помешать не может, а

помешает лишь его противнику занять эту клетку.

Следовательно, первый игрок может занять клетки, согласно

20

рецепту, и должен выиграть. Это противоречит

первоначальному предположению, что может выиграть второй

игрок, и, следовательно, наше предположение неверно, т. е.

именно первый игрок должен иметь возможность выиграть.

Пуристы от математики едва ли сочтут эти

доказательства строгими. Еще одна любопытная деталь:

доказательство теоремы II не конструктивно. Иными словами, оно

не показывает первому игроку метод выигрыша, хотя

и говорит, что в принципе он может выиграть. Пример

конструктивного доказательства будет дан несколько

позже. А сейчас не мешало бы немного пофилософствовать

о том, что такое теоремы и зачем их нужно доказывать.

Строгая формулировка какой-либо задачи содержит

в себе предпосылки математических теорем. Как только

сформулированы правила игры в гекс, из них необходимо

вытекает, что первый игрок может выиграть, подобно

тому как, теоремы геометрии Евклида — необходимое

следствие ее аксиом.

При достаточном уме и интуиции можно сразу увидеть

правильность теоремы. Говорят, что молодой Ньютон

считал теоремы евклидовой геометрии очевидными и

терпеть не мог их доказывать.

Хотя обычно математики могут подозревать или

угадывать правильность того или иного положения, для

уверенности они всегда должны доказывать теоремы. Сам

Ньютон понял важность доказательства и, пользуясь

методами Евклида, вывел много новых теорем.

Безошибочное знание не приходит к математикам

сразу. Постепенно, шаг за шагом, трудолюбиво

доказывая одну теорему за другой, подходят они к знанию.

Более того, им приходится доказывать теоремы еще и для

того, чтобы убедить в их правильности других.

♦

У

.1

1

-*—дг—**|

Фиг. 1.4.

27

ГхП

Иногда математику приходится доказывать теорему

для того, чтобы самому убедиться в ее правильности, ибо

может показаться, что она противоречит здравому смыслу.

В качестве примера возьмем следующую задачу. Имеется

квадрат со стороной 1 см (фиг. 1.4). Любую точку этого

квадрата можно задать с помощью двух чисел: у (высота

точки над основанием квадрата) и χ (расстояние точки от

левой стороны квадрата). Каждое из этих чисел будет

меньше единицы. Пусть точка Ρ имеет следующие координаты:

χ =0,547000 ... (далее идет бесконечная последовательность

нулей).

у = 0,312000 ... (далее идет бесконечная последовательность

нулей).

Предположим, что точкам квадрата поставлены в

соответствие точки на отрезке прямой линии, причем каждой

точке на отрезке соответствует только одна точка квадрата,

а каждой точке квадрата— только одна точка на отрезке.

Если это так, то говорят, что получено взаимно

однозначное отображение квадрата на отрезок.

Теорема. Квадрат единичной площади можно

отобразить взаимно однозначно на отрезок единичной длины *.

Доказательство. Возьмем число у, и пусть

первая цифра этого числа будет первой цифрой числа х\

вторая — третьей, третья — пятой и т. д. Затем возьмем

число χ (расстояние точки Ρ от левого конца отрезка),

и пусть первая цифра этого числа будет второй цифрой

числа х\ вторая — четвертой, третья — шестой и т. д.

Пусть х' будет расстоянием точки Р' от левого конца

отрезка. Тогда точка Р' будет взаимно однозначным

отображением точки Ρ квадрата на отрезок.

Очевидно, что при изменении χ ж у изменится х\ а при

изменении х' изменится χ ж у. Каждой точке ж, у квадрата

соответствует только одна точка х' отрезка, а каждой

точке х' отрезка соответствует только одна точка х, у

квадрата, что отвечает требованию взаимно

однозначного соответствия **.

* Размер квадрата и отрезка значения не имеет, ограничение

сделано для удобства.

** При этом способе доказательства возникают большие

трудности, правда разрешимые при рассмотрении таких чисел, как

1/2, поскольку Vo можно записать в виде 0.500000,.. и в виде

0,499999...

98

Пользуясь приведенным выше примером, получаем

χ = 0,547000 ...,

у = 0,312000 ...,

х' = 0,351427000 ...

Следует отметить, что большинство точек

изображается числами, состоящими из бесконечного ряда цифр,

и этот ряд не становится последовательностью нулей

и никогда не повторяется.

Здесь мы имеем пример конструктивного

доказательства. Мы показали, что можно взаимно однозначно

отобразить каждую точку квадрата в точку на отрезке, задав

точный рецепт, как это сделать. Многие математики

предпочитают конструктивные доказательства

неконструктивным, а математики интуиционистской школы вообще

отвергают неконструктивные доказательства при

рассмотрении бесконечных множеств, где невозможно исследовать

отдельно каждый элемент множества на какое-либо

свойство.

Разберем теперь другое свойство отображения точек

квадрата на отрезок прямой. Представим, что вдоль

отрезка движется указатель, а по поверхности квадрата

одновременно с первым движется второй указатель.

Второй указатель показывает точки квадрата,

соответствующие точкам отрезка, которые в данный момент показывает

первый указатель. Может показаться (далее мы докажем,

что это не так), что при медленном и плавном движении

первого указателя второй указатель будет медленно

и плавно двигаться по поверхности квадрата. Все точки

отрезка, расположенные очень близко друг от друга,

казалось бы, будут соответствовать также очень близким

точкам на поверхности квадрата. Если передвинуть

первый указатель вдоль отрезка на малое расстояние, то

второй указатель тоже передвинется на малое

расстояние по поверхности квадрата, а если первый указатель

передвинуть на еще меньшее расстояние, то и второй

указатель передвинется на меньшее расстояние, и т. д. Если бы

это было так, мы могли, бы сказать, что взаимно

однозначное отображение точек квадрата в точки на отрезке

непрерывно.

Однако оказывается, что взаимно однозначное

отображение точек квадрата в точки на отрезке не может быть

29

непрерывным. Когда мы двигаемся вдоль какой-то

кривой, принадлежащей квадрату, точки этой кривой,

отображенные на отрезок, непременно окажутся хаотически

разбросанными, и это будет верно не только для

описанного способа отображения, но и для какого угодно

взаимно однозначного отображения. Любое взаимно

однозначное отображение квадрата на отрезок прямой разрывно.

Теорема. Любое взаимно однозначное отображение

квадрата на отрезок прямой должно быть разрывным.

Доказательство. Предположим, что взаимно

однозначное отображение непрерывно. Тогда все точки,

принадлежащие некоторой кривой АВ (фиг. 1.5), должны

отобразиться в точки, находящиеся между

соответствующими точками А' и В'. Если бы они не попали между

этими точками, то при движении вдоль кривой нам

пришлось бы либо прыгать от одного конца отрезка к другому

(разрывное отображение), либо пройти дважды через

одну и ту же точку отрезка (отображение не взаимно

однозначное). Выберем произвольно точку С слева от

отрезка А'В' и точку D' справа от А'В' и найдем

соответствующие точки квадрата С и D. Проведем между

точками С и D кривую так, чтобы она пересекла кривую

АВ. В месте пересечения она будет иметь точку, общую

с кривой АВ; следовательно, эта точка кривой CD должна

отобразиться в точку, лежащую между А' ж В', а. все

другие точки, не принадлежащие кривой АВ, должны

отобразиться в точки, лежащие вне А'В'. Это

противоречит предположению о непрерывности отображения, и,

следовательно, отображение не может быть непрерывным.

В дальнейшем мы увидим, что теорема о возможности

отображения точек квадрата на отрезок прямой и теорема

о разрывности такого отображения важны для теории

информации и будут нами использованы; теоремы же

об игре в гекс использоваться не будут.

Математика— это метод постепенного выяснения

некоторых положений, скрытых в поставленной задаче

и не сразу бросающихся в глаза. Обычно, используя

математику, нужно сначала найти эти положения, а затем

проверить их доказательством. Здесь мы сталкиваемся

с узловой проблемой: доказательства, удовлетворяющие

математиков прошлого, часто совсем не удовлетворяют

современных математиков.

30

Χ

С' А' В' D'

Фиг. 1.5.

Как-то один раздражительный и не очень крупный

математик в своей рецензии на работу Шеннона

«Математическая теория связи», усомнился в строгости

математических доказательств автора. Тем не менее теоремы

Шеннона верны, а доказательства были даны такие, что

удовлетворяют даже математиков, помешанных на строгости.

Те простые доказательства, которые я привел выше для

иллюстрации математических методов, не совсем строги

и могут подвергнуться критике со стороны пуристов. .

• В этой главе я попытался проиллюстрировать

характер математического рассуждения и дать некоторое

представление о том, что такое теорема и как она может быть

доказана. Усвоив это, мы приступим к математической

теории связи, к ее теоремам, которые мы уже не будем

доказывать, а также к связанным с ними аспектам,

уходящим далеко за пределы того, что можно установить

с математической определенностью.

Как я говорил выше, теория информации в том виде,

в каком ее изложил Шеннон, рассматривает очень широко

и абстрактно некоторые важные вопросы связи и передачи

информации, но это вовсе не значит, что ее можно

применять всюду, где только встречаются слова связь и

информация в их многочисленных обиходных значениях. Теория

информации имеет дело только с теми аспектами связи,

которые можно обобщить и которые имеет смысл

обобщать, подобно тому как законы Ньютона имеют дело

только с движением механическим, а не со всеми, в корне

отличными друг от друга явлениями, которые имел в виду

Аристотель, используя слово движение.

Чтобы успешно развиваться, наука должна пробовать

все возможное. У нас нет оснований считать, что можно

31

объединять факты и понятия, для которых используются

общие слова. Общее нужно искать не в словах, а в

явлениях, в нашем опыте. Теорию же мы получаем тогда,

когда удается установить взаимоотношение явлений.

Законы движения Ньютона — это теория, которую можно

использовать при исследовании механических явлений.

Уравнения Максвелла — это теория, которую можно

использовать при исследовании электрических явлений.

Теорию цепей можно использовать при исследовании

систем, состоящих из простых электрических или

механических элементов. Арифметику можно использовать

при подсчетах количества людей, камней, звезд и т. д.,

а геометрию — при измерении Земли, моря или галактик.

В отличие от законов движения Ньютона и уравнений

Максвелла, имеющих дело с определенными физическими

явлениями, теория информации абстрактна, так как ее

можно применять ко многим видам связи — письменным,

акустическим или электрическим. Эта теория имеет дело

с важными, но абстрактными сторонами связи. От ясных

и определенных предположений она переходит к теоремам

об источниках информации и к теоремам о каналах связи.

Это делает ее существенно математической, и, чтобы ее

понять, нужно усвоить мысль о том, что теорема — это

утверждение, которое нужно доказать, т. е. установить,

что данное утверждение есть необходимое следствие ряда

исходных предположений. Эта мысль — сердце

математики.

Глава вторая

ЖСТОКЖ

ТЕОРИИ ИНФОРМАЦИЯ

Историю воспринимают по-разному. Одни изучают

древние времена, чтобы найти некую универсальную

мировую систему, в неизбежном развитии которой можно

увидеть не только прошлое, но и прообраз будущего. Другие

ищут в прошлом секрет успеха для настоящего.

Некоторые, например, полагают, что по опыту сделанных

в прошлом научных открытий можно научиться

совершать новые. Некий мудрец глубокомысленно заметил,

что из истории мы лишь узнаём, что мы из нее ничего не

33

узнаем, а Генри Форд — тот прямо заявлял, что

история— это чушь.

Все это далеко и от меня, и от темы моей книги. И все

же я хотел бы сказать, что из истории науки можно сделать

по крайней мере два вывода.

Первый вывод — наиболее общие и яркие научные

открытия были сделаны не в природных условиях, а в

результате изучения явлений в приборах, созданных руками

человека, или, если хотите, созданных техникой. И это

потому, что явления, воспроизведенные человеком в

машинах или приборах, упрощены и упорядочены по

сравнению с природными и разобраться в них много легче.

Так, создание паровой машины, в которой явления,

связанные с теплотой, давлением, парообразованием и

конденсацией, происходят в простой и упорядоченной форме,

послужило основным стимулом развития весьма мощной

и общей науки — термодинамики. Это особенно хорошо

иллюстрируется работой Карно *. Наши познания в

аэродинамике и гидродинамике в основном обязаны не

наблюдениям за поведением птиц и рыб, а исключительно

бурному развитию самолетостроения и кораблестроения.

Большую часть наших знаний об электричестве мы

получили, изучая изобретения человека, а не вспышки молний.

Так и корни широкой и изящной теории связи,

созданной Шенноном, мы увидим в простых и понятных явлениях

телеграфии.

Второе, чему нас может научить история,— это то,

с какой трудностью дается понимание. Сегодня законы

Ньютона кажутся простыми и почти очевидными, а были

времена, когда эти законы никому и во сне не снились,

времена, когда самые выдающиеся люди имели весьма

смутное представление о том, что такое движение. Даже

сами первооткрыватели сейчас иногда нам кажутся

невероятными чудаками. Думалось, что Максвелл в своем

трактате по электричеству и магнетизму прямо и смело

заявит о своем открытии. А трактат загроможден такой

массой мелких вопросов, казавшихся в свое время

важными, что неискушенному читателю пришлось бы долго

докапываться до самого открытия, чтобы осмыслить его

* Карно (1796—1832) первый предложил использовать

идеальное расширение газа (цикл Карно) для извлечения максимально

возможной механической энергии из тепловой энергии пара.

34

в привычных теперь выражениях. Правда, Максвелл

впоследствии довольно ясно изложил свои идеи.

Итак, изучение зарождения научных идей поможет

нам немного лучше оценить сделанные с таким трудом

открытия. Мы часто читаем о том, как в прошлом

исследователи останавливались у самого порога открытия,

не умея сделать решительный шаг. Нам иногда даже

хочется помочь им, подсказать; ведь они были так близки

к решению и, право, должны были прийти к основному

выводу. Но это, увы, та самая западня, в которую

попадают очень многие и в своей личной жизни. Решая задачу,

о которой имеешь лишь самое общее представление, часто

думается, что понятно все и до конца.

Итак, чем лучше мы разберемся в том, как зарождалась

идея, что было известно до ее появления, и как была

достигнута ясность и единство, тем легче будет понять ее

истинное содержание. Но для этого нужно проследить

действительный путь открытия, а не тот, каким оно

должно или могло быть сделано, и постараться посмотреть

на него (если это можно сделать) глазами не

современного человека, а так, как это могли сделать в те времена.

Поиски истоков математической теории связи могут

завести в непролазное болото. Мне бы очень хотелось

избежать этого вообще, но ведь другие авторы постоянно

толкают на этот путь своих читателей. Мне же остается

только надеяться, что с помощью приведенного мною

здесь путеводителя читателю все же удастся выбраться

невредимым.

В термодинамике и в статистической механике

используется некая величина, называемая энтропией. Понятие

это есть и в математической теории связи, или теории

информации. Но термодинамика и статистическая

механика старше теории информации. Кроме того, в статье,

опубликованной в 1929 году, Л. Сциллард применил

понятие информации для решения одного физического

парадокса. Отсюда можно было бы сделать вывод, что

теория информации каким-то образом возникла из

статистической механики.

Эта простая, но противоречивая мысль запутала даже

специалистов. На самом же деле математическая теория

связи возникла в результате попытки решить некоторые

проблемы электросвязи. Энтропия в теории связи была

названа так только вследствие математической анало-

3δ

гии с энтропией, используемой в статистической

механике. Однако содержание этих двух понятий совершенно

различно.

В термодинамике энтропия некоторого количества

газа, как и энергия, зависит от его температуры, объема

и массы, а также от того, что это за газ. Если поместить

газ в теплоизолирующий цилиндр и позволить ему

медленно расширяться, толкая поршень, то газ начнет

охлаждаться, теряя часть своей тепловой энергии. Эта

энергия проявится в виде работы, проделанной поршнем,

скажем, на поднятие груза, который и запасет энергию,

потерянную газом.

Этот процесс — обратимый. Под этим понимается

следующее: если производить работу, медленно толкая

поршень назад, в направлении, противоположном давлению

газа, сжимая его таким способом до первоначального

состояния, то будут в точности восстановлены его

энергия, давление и температура. В таком обратимом процессе

энтропия газа остается постоянной, тогда как энергия

изменяется.

Итак, энтропия — это показатель обратимости

процесса. Если энтропия неизменна, то процесс обратимый.

В приведенном примере тепловую энергию газа можно

неоднократно преобразовывать в механическую энергию

поднятого груза, и обратно.

Большинство физических явлений не обладает

свойством обратимости. Необратимые явления всегда

сопровождаются возрастанием энтропии. Предположим, что

теплоизолирующий цилиндр разделен перегородкой на две

части и что по одну сторону перегородки имеется газ,

а по другую газа нет. Представим себе далее, что

перегородка вдруг исчезла, так что газ распространился по

всему объему. В этом случае тепловая энергия не изменится,

а энтропия возрастет.

До того как была убрана перегородка, тепловая

энергия газа еще могла быть преобразована в механическую

энергию, если пропускать газ в пустую часть цилиндра

через небольшое устройство. А убрав перегородку и

получив в результате увеличение энтропии, мы этого сделать

уже не можем. Можно привести и другие примеры, когда

энтропия возрастает, а энергия остается постоянной.

Это происходит, например, когда тепло течет от горячего

предмета к холодному. До выравнивания температур еще

36

можно было бы, используя разность температур,

совершить работу. После выравнивания температуры

превратить часть тепловой энергии в механическую уже

невозможно.

Таким образом, увеличение энтропии означает

уменьшение той части тепловой энергии, которая может быть

преобразована в механическую. Возрастание энтропии

означает уменьшение той части энергии, которую можно

использовать.

Хотя в термодинамике определяется понятие

энтропии, в ней не дается ее физический смысл применительно,

например, к положениям и скоростям молекул. Для

некоторых случаев это делает статистическая механика.

Вообще говоря, физический смысл энтропии состоит

в том, что увеличение энтропии означает уменьшение

упорядоченности. Но если спросить, что такое

упорядоченность, то придется до известной степени приравнять

значение этого слова к значению слова знание. Даже очень

сложное расположение молекул вряд ли может быть

беспорядочным, если известно положение и скорость

каждой. Беспорядок в том смысле, в каком он

используется в статистической механике,— это

непредсказуемость, основанная на отсутствии знания положений и

скоростей молекул. Обычно недостаток такого знания испы-

тывается тогда, когда совокупность положений и

скоростей очень сложна.

Возвратимся к рассмотренному нами примеру с

цилиндром. Когда молекулы находятся по одну сторону

перегородки, и мы это знаем, энтропия меньше, чем когда

молекулы распределены по обе стороны перегородки.

Естественно, о положении молекул мы знаем больше

тогда, когда известно, что они находятся по одну

сторону перегородки, чем тогда, когда известно, что они

находятся где-то внутри цилиндра. Чем детальнее наши

знания о состоянии физической системы, тем меньше

неопределенность (расположения молекул, например)

и тем меньше энтропия. И наоборот, чем больше

неопределенность, тем больше энтропия.

Итак, энтропия в физике связывается с возможностью

превращения тепловой энергии в механическую. Если

во время какого-то процесса энтропия не меняется, то

этот процесс обратимый. Если энтропия возрастает, то

уменьшается та часть энергии, которую можно исполь-

37

зовать. В статистической механике под увеличением

энтропии понимается уменьшение упорядоченности или,

если хотите, уменьшение нашего знания о системе.

Приведенных мною примеров явно недостаточно, чтобы

глубоко понять, что такое энтропия в физике, но, как

мне кажется, я вполне достаточно сказал об ее сущности

и об ее важности.

Давайте теперь рассмотрим, как и с какой целью

используется понятие «энтропия» в теории информации,

где оно приобретает совершенно иной смысл.

В математической теории связи рассматривается

источник сообщений, например человек, который в

определенной ситуации может создать любое из множества

возможных сообщений. Количество информации, которое

несет в себе сообщение, возрастает при увеличении

количества неопределенности относительно того, какое

сообщение из всех возможных будет выбрано. Одно из десяти

возможных сообщений несет в себе меньшее количество

информации, чем одно из миллиона. Энтропия в

математической теории связи есть мера этой неопределенности,

и эта неопределенность, или (что то же самое) энтропия,

берется в качестве меры количества. информации,

которое несет в себе сообщение от данного источника. Чем

больше известно о том, какое сообщение будет создано

источником, тем меньше неопределенность, тем меньше

энтропия и тем меньше количество информации.

Как видите, в основу понятий «энтропия в физике»

и «энтропия в математической теории связи» легли

совершенно различные идеи, и каждая из них имеет

самостоятельный смысл. Тем не менее обе эти энтропии можно

описать сходными математическими выражениями,

используя термин «неопределенность». Но существует ли в

действительности какая-либо связь между этими двумя энт-

ропиями и соответственно между физикой и

математической теорией связи?

Кое-кому из математиков и физиков очень хотелось бы

доказать, что математическая теория связи и ее

энтропия чрезвычайно важны для статистической механики.

Вопрос этот запутанный и запутывающийся дальше.

Путаница еще усугубляется, когда рассматривается не одно,

а несколько значений слова информация. Иногда

информацию, например, связывают не с неопределенностью

и разрешением неопределенности, а с одним из наиболее

38

употребительных оттенков значения слова информация —

знанием.

Мы рассмотрим взаимоотношения между

математической теорией связи и физикой в главе 10, когда уже будем

иметь некоторое представление о теории информации.

Здесь же мне хочется лишь заметить, что попытки

соединить математическую теорию связи и физику были скорее

любопытны, нежели полезны. Вполне естественно, что

эти попытки ни к чему не привели.

Математическая теория связи возникла в результате

изучения электросвязи, а не статистической механики,

а некоторые из ее наиболее важных идей относятся к тому

времени, когда электросвязь только зарождалась.

Совершая трансатлантическое путешествие в 1832 году,

Сэмюэль Морзе начал разработку первого электрического

телеграфного аппарата. В своем первоначальном виде

телеграф Морзе был намного сложнее известного нам

теперь. Тогда на бумажной ленте выводились короткие

и длинные линии и определенная последовательность

этих линий обозначала не букву, а число. Каждое число

соответствовало какому-то слову в кодовой таблице,

составленной Морзе в 1837 году. Это (как мы убедимся позже)

эффективный, но довольно грубый метод кодирования.

Затем Морзе в совместной работе с Альфредом Вайлом

отказался от этого метода кодирования, и в 1838 году

появился новый код, известный теперь как азбука Морзе.

В этом коде буквы алфавита изображаются паузами,

точками и тире. Пауза — это отсутствие электрического тока,

точка — короткий импульс тока, тире — более длинный.

Буквам алфавита очень остроумно были сопоставлены

комбинации точек и тире. Короче других, одной точкой,

была обозначена буква Е, наиболее употребительная

в английском языке, да и вообще чаще встречающиеся

буквы были обозначены короткими комбинациями точек

и тире, а редко встречающиеся— длинными.

Поразительно то, что при этом не использовались таблицы

относительной частоты повторения букв в английском тексте

и даже не делалось попыток составить такие таблицы.

Относительная частота различных букв была оценена

простым подсчетом литер в разных ячейках наборной кассы!

Мы вправе спросить: не позволит ли другое

соответствие между точками, тире, паузами и буквами еще

быстрее передавать текст по телеграфу? Современная теория

39

Посланный

1ятый

Время —**

Фиг. 2.1.

говорит, что выиграть в скорости можно каких-то 15%.

Так что Морзе с успехом справился с поставленной

задачей, и на примере его азбуки можно увидеть, как много

значит метод преобразования сообщений в электрические

сигналы. Именно это и есть один из центральных

вопросов математической теории связи.

В 1843 году конгресс США принял законопроект об

ассигновании денег на строительство телеграфной линии

между Вашингтоном и Балтиморой. Морзе начал

прокладывать кабель под землей, но столкнулся с трудностями,

от которых потом в еще большей степени страдали

подводные телеграфные линии. Задачу он решил, подвесив

провода на столбах.

Но трудность, с которой Морзе столкнулся при

прокладке подземной линии, осталась. Оказалось, что

различные линии передач, одинаково хорошо проводящие

постоянный электрический ток, не обязательно подходят

для электросвязи. Если по подводному или подземному

кабелю посылать точки и тире слишком быстро, то на

приемном конце они сольются. Если послать короткий

импульс, полученный резким включением и выключением

тока (фиг. 2.1), то на приемном конце подъем и спад тока

будут более длинными, сглаженными. Импульс станет

более длительным и может совпасть с другим импульсом

(например, отсутствием тока). Так что, даже если передан

ясный и четкий сигнал, можно принять какие-то

непонятные подъемы и спады тока, которые не поддаются

расшифровке (фиг. 2.2).

40

I

Конечно, если точки, паузы и тире будут достаточно

длительные, то ток на приемном конце больше будет

соответствовать переданному току, но это замедлит

скорость передачи. Ясно, что есть какая-то граничная

скорость передачи, зависящая от свойств линии. Для

подводных линий эта скорость чрезвычайно мала, и это

сильно заботит телеграфистов, но зато для воздушных

линий она так велика, что, естественно, их совершенно

не беспокоит. Уже на заре телеграфии было известно

это ограничение, очень существенное для

математической теории связи.

Несмотря на ограничение скорости, все же есть

способы увеличить количество букв, которое может быть

передано по данной линии за определенный промежуток

времени. Для передачи тире требуется в три раза больше

времени, чем для передачи точки. Вскоре стало ясно,

что экономии времени можно добиться с помощью

двухполюсной телеграфии. Чтобы понять ее принцип,

представим себе, что на приемном конце, между телеграфным

проводом и землей, включен гальванометр — прибор,

обнаруживающий малые токи и указывающий их

направление. Чтобы передать точку, плюс батареи с помощью

ключа соединяется с проводом, а минус — с землей. При

этом стрелка гальванометра повернется вправо. При

передаче тире ключ соединяет минус батареи с проводом,

а плюс — с землей; стрелка гальванометра

поворачивается влево. Иными словами, ток одного направления

(в провод) обозначает точку, а ток другого направления

(из провода) — тире. Полное отсутствие тока (батарея

не присоединена) обозначает паузу. В существующей

двухполюсной телеграфии вместо гальванометра

используется самая различная аппаратура.

Посланный ток

slnT~ЧЛГЧГ111-

Принятый ток

Фиг. 2.2.

41

В однополюсной телеграфии код строится из двух

элементов: ток и отсутствие тока; мы можем их

обозначать 1 и 0. В двухполюсной телеграфии имеются три

элемента: прямой ток, или ток, направленный в провод,

отсутствие тока и обратный ток, или ток, направленный

из провода. Обозначим их соответственно +1, 0, —1.

Знаки плюс или минус указывают направление тока,

а число 1 выражает силу тока, которая в данном случае

одинакова для обоих направлений.

В 1874 году Томас Эдисон пошел еще дальше. В своей

квадруплексной (учетверенной) телеграфной системе он

применил не только два разных направления, но и два

разных значения силы тока. Он использовал изменение

силы тока без изменения его направления для передачи

одного сообщения, а изменение направления тока без

изменения его силы — для передачи другого сообщения.

Если предположить, что токи отличаются на одну и ту же

величину (например, на две единицы), то все четыре тока

можно записать так: +3, +1, —1,-3. Сообщение на

приемном конце можно расшифровать g помощью табл. 1.

Пример такого кодирования двух независимых

сообщений с использованием чередования четырех различных

значений тока показан на фиг. 2.3.

Очевидно, что количество информации, которое можно

передать по линии, зависит не только от того, с какой

скоростью будут передаваться последовательные символы

(последовательные значения тока), но и от того, из какого

числа различных символов (различных значений тока)

будет производиться выбор. Если в качестве символов

взять только два значения тока, +1 и 0 или, что дает

такую же эффективность, +1 и —1, то в данный момент

можно послать только один из двух возможных символов.

Таблица 1

Переданный ток

+3

+1

-1

-3

Первое сообщение

Включено

Выключено

»

Включено

Второе сообщение

Включено

»

Выключено

»

42

Сообщение

Включено ι 1 I-

7 Г

Выключено—* 1—1

Включено

Выключет

J

ι

Ток

+ 3

+ 1

-3

ъ

Фиг. 2.3.

Однако мы уже видели, что если есть возможность

выбора любого из четырех значений тока (любого из

четырех символов), то с их помощью можно передать два

независимых кусочка информации: 0 или 1 в первом

сообщении и 0 или 1 во втором сообщении. Итак, при данной

скорости передачи символов четыре значения тока

позволяют послать два независимых сообщения так же быстро,

как два значения тока позволяют послать только одно

сообщение. С помощью четырех значений тока можно

передать за минуту в два раза больше букв, чем с помощью

двух значений.

Использование большого количества символов может

привести к трудностям. Мы уже отмечали, что точки и тире,

посланные по подводному кабелю, растягиваются и

сливаются, так что на приемном конце мы видим не один

символ, а несколько (см. фиг. 2.2). При этих условиях

легче опознать элементы простой системы символов 1, О

или +1, —1, чем более сложной: +3, +1, —1, —3.

Но возможность различать сложные сигналы

ограничивают еще и другие явления. Так, во время магнитных

бурь в телеграфных линиях и подводных кабелях

появляются побочные сигналы *. А при более тщательном

* Изменяющееся магнитное поле Земли наводит токи в кабеле.

Изменение магнитного поля Земли вызывается, по-видимому,

потоками заряженных частиц, возникающими в результате процессов,

происходящих на Солнце.

43

исследовании, скажем с помощью современных

чувствительных электронных усилителей, можно заметить, что

в проводах всегда имеются небольшие нежелательные

токи. Это явление сродни хаотическому броуновскому

движению крошечных частичек, которое можно

наблюдать под микроскопом, а также колебаниям молекул

воздуха, да и всей остальной материи, которые мы

связываем с представлением о тепле и температуре. Побочные

токи, которые называют шумами, имеются всегда и

накладываются на передаваемый сигнал.

Таким образом, даже если бы удалось избежать

взаимных помех между символами, т. е. слияния точек и пауз,

все равно шум искажал бы принятый сигнал и затруднял

различение символов. Можно, конечно, преодолеть

влияние шума, увеличив ток, а следовательно, и мощность

передаваемого сигнала. Однако и здесь имеются

ограничения. Для передачи по подводному кабелю большого тока

нужно большое напряжение, а оно может разрушить

изоляцию кабеля и привести к короткому замыканию.

Возможно, что именно большое напряжение и послужило

причиной повреждения первого трансатлантического

телеграфного кабеля в 1858 году.

Уже первые телеграфисты интуитивно довольно

хорошо понимали, что шумы, или помехи, трудность

различения сигналов, а также максимально допустимая мощность

ограничивают скорость передачи. Однако требовалась

не интуиция, а нечто большее. Необходим был строгий

математический анализ.

К решению таких проблем математику стали

применять довольно давно, но лишь в последние годы было

получено их полное решение. В 1855 году Уильям Том-

сон, ставший позднее лордом Кельвином, точно вычислил,

какова будет форма принятого тока, если по подводному

кабелю передавать точку или паузу. Еще более мощное

наступление на эти проблемы началось после изобретения

в 1875 году Александром Грэхемом Беллом телефона.

Если в телеграфии используются сигналы типа

включено — выключено и скорость их передачи невелика, то

в телефонии используются токи, сила которых изменяется

плавно и может принимать любые значения в довольно

широком диапазоне, а скорость изменения силы тока

в несколько сот раз больше скорости ручной

телеграфии.

44